Dr. Tim Ball

Ockhams Rasierer folgt dem Prinzip „Objekte sollen nicht öfter multipliziert werden als notwendig“. Er wird normalerweise bei der Entscheidungsfindung zwischen zwei konkurrierenden Möglichkeiten angewendet und zeigt, dass die einfachste Lösung höchstwahrscheinlich die richtige Lösung ist. Man kann das auch in der Debatte über das Klima und die Brauchbarkeit von Computer-Klimamodellen anwenden. Ein alter Witz über die Behauptungen von Ökonomen lautet, dass diese versuchen, die Fluthöhe mit dem Vermessen einer einzigen Welle zu bestimmen. Reicht hier die Vereinfachung zu weit? Es ist ähnlich der IPCC-Ziele zu versuchen, mit der Messung nur einer einzigen Variablen, CO2, die Klimaentwicklung vorherzusagen. Dem entgegengesetzt betrachten Personen, die herausfinden wollen, was mit den IPCC-Klimamodellen falsch läuft, eine ganze Bandbreite von Faktoren, wenn das Scheitern mit einer einzigen Sache zu erklären ist, nämlich unzureichenden Daten, um ein Modell zu konstruieren.

Bild rechts (Abbildung 1): Wigley und H.H.Lamb, Gründer der CRU. Quelle

IPCC-Computer-Klimamodelle sind die Zugpferde bei der Irreführung der Öffentlichkeit hinsichtlich AGW mit der Behauptung, dass menschliches CO2 die globale Erwärmung verursacht. Sie erzeugen die Ergebnisse, für die sie konstruiert worden sind.

Das Akronym GIGO (Garbage In, Garbage Out) reflektiert den Umstand, dass die meisten an Computermodellen Arbeitenden das Problem kannten. Einige schlagen vor, dass es in der Klimawissenschaft tatsächlich steht für Gospel In, Gospel Out [etwa: Prinzip hinein, Prinzip heraus. Ich belasse es wegen der vielen Bedeutungen beim Original. Anm. d. Übers.]. Die Gospel Out-Ergebnisse sind die IPCC-Vorhersagen (Projektionen), und sie sind konsistent falsch. Das ist für mich keine Überraschung, weil ich von Anfang an die Unzulänglichkeit der Modelle betont habe. Ich habe beobachtet, wie die Klimamodellierer die Klimakonferenzen als Präsentatoren von Schlüsselbemerkungen gekapert und dominiert haben. Es waren Modellierer, die die CRU dominiert haben und mittels der CRU auch das IPCC. Die Gesellschaft ist immer noch fasziniert von Computern, so dass sie diesen eine Aura der Genauigkeit und Wahrheit zugebilligt wird, die durch nichts gerechtfertigt ist. Pierre Gallois erklärt dazu:

Falls man Albernheiten in einen Computer füttert, kommt nichts außer Albernheiten heraus. Aber diese Albernheiten hier sind durch eine sehr teure Maschine gelaufen und wurden irgendwie geadelt, und niemand wagt es, sie zu kritisieren.

Michael Hammer fasst es so zusammen:

Es ist wichtig, sich daran zu erinnern, dass der Modelloutput vollständig und exklusiv bestimmt wird durch die in den Input-Fragen enthaltenen Gleichungen. Der Computer bewirkt kein Hinterfragen, bringt keine neuen Informationen und keine größere Sicherheit im Output. Er liefert nur Rechenleistung.

Es ist ein guter Artikel, der jedoch den wichtigsten aller Punkte nicht anspricht, nämlich dass ein Modell nur so gut ist wie die Struktur, auf dem es konstruiert wurde, nämlich Wetteraufzeichnungen.

Die IPCC-Lücke zwischen Daten und Modellen beginnt

Dieses Auslassen ist keine Überraschung. Der CRU-Gründer Hubert Lamb definierte das grundlegende Problem, und sein Nachfolger Tom Wigley besorgte die Transition zum größeren Problem von politisch dirigierten Klimamodellen.

Der Grund von Lamb, die CRU zu gründen, wird auf Seite 203 seiner Autobiographie genannt mit dem Titel: Through all the Changing Scenes of Life: A Meteorologists Tale”:

„…es war klar, dass die erste und größte Notwendigkeit darin bestand, die Fakten von Aufzeichnungen des natürlichen Klimas aus der Vergangenheit zu etablieren, bevor irgendwelche Nebeneffekte menschlicher Aktivitäten wichtig geworden sein könnten“.

Lamb wusste, was los war, wenn er kryptisch schreibt:

„Mein direkter Nachfolger Professor Tom Wigley war zuallererst an den Aspekten einer Veränderung des Weltklimas interessiert als Folge menschlicher Aktivitäten, primär durch das Verbrennen von Holz, Kohle, Öl und Gasvorräten…“ – „Nach nur wenigen Jahren wurde fast die gesamte Arbeit an der historischen Rekonstruktion von Klima- und Wettersituationen der Vergangenheit, die die CRU zunächst so bekannt gemacht hatte, aufgegeben“.

Lamb erklärte des Weiteren, wie eine Zuwendung der Rockefeller Foundation zu einem völligen Fehlschlag wurde:

„…eine verständlicherweise unterschiedliche wissenschaftliche Beurteilung zwischen mir und dem Wissenschaftler Dr. Tom Wigley, den wir damit beauftragt haben, die Verantwortung für die Forschung zu übernehmen“.

Wigley trieb die Anwendung von Klimamodellen voran, aber Lamb wusste, dass diese nur so gut waren wie die Daten, die für ihre Konstruktion verwendet worden waren. Lamb liegt immer noch richtig. Die Modelle beruhen auf Daten, die entweder gar nicht existieren oder hinsichtlich aller Messungen ungeeignet sind.

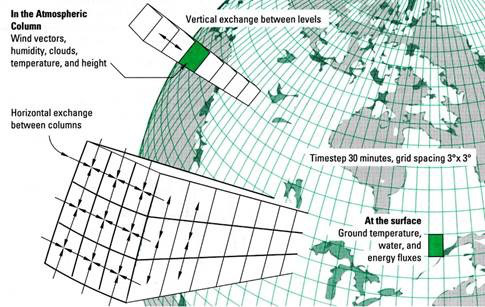

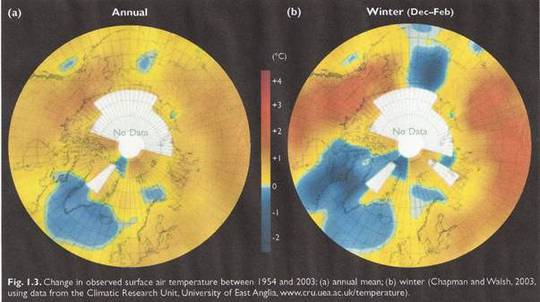

Abbildung 2

Das Konstrukt von Klimamodellen

Modelle reichen von einfachen maßstäblich verkleinerten Kopien mit erkennbaren individuellen Komponenten bis zu Abstraktionen wie mathematische Formeln, die weit entfernt sind von der Realität, wobei Symbole die individuellen Komponenten repräsentieren. Abbildung 2 ist ein einfaches schematisches Modell mit den für ein Computermodell notwendigen Gliederungen. Der Abstand der Gitterpunkte (gezeigt hier 3° mal 3°) variiert, und es wird behauptet, dass eine Reduktion des Abstandes der Gitterpunkte verbesserte Genauigkeit liefert. Das spielt aber keine Rolle, weil es so wenige Stationen mit angemessener Länge oder Zuverlässigkeit gibt. Die mathematische Gleichung für jeden Gitterpunkt kann nicht genau sein.

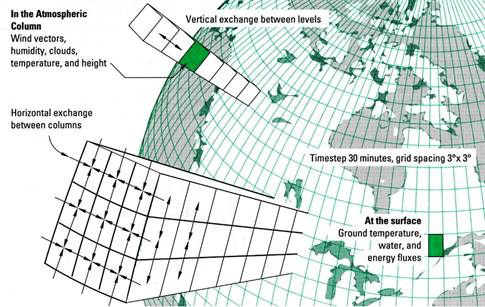

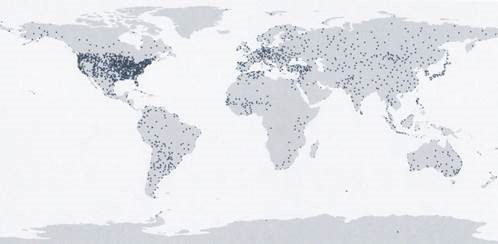

Abbildung 3: Anzahl der Stationen nach NASA GISS

Diese Karte ist betrügerisch, weil jeder Punkt eine einzelne Wetterstation repräsentiert, aber im Maßstab der Karte jeweils ein paar Hundert Quadratkilometer überdeckt. Aber unabhängig davon ist es Realität, dass es in riesigen Gebieten der Welt überhaupt keine Wetterstationen gibt. Möglicherweise gibt es an über 85% der Gitterpunkte keine Daten. Das tatsächliche Problem ist sogar noch größer als NASA GISS, vielleicht unwissentlich, und wird in Abbildung 4 illustriert:

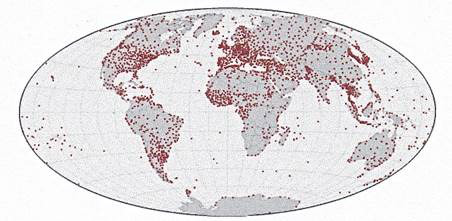

Abbildung 4

Abbildung 4(a) zeigt die Länge der Aufzeichnung. Nur 100 Stationen reichen 100 Jahre zurück, und fast alle von ihnen liegen in dicht besiedelten Gebieten im Nordosten der USA oder Westeuropa und sind Schauplatz des städtischen Wärmeinseleffektes (UHI). Abbildung 4(b) zeigt den Rückgang der Anzahl von Stationen um das Jahr 1960. Teils erfolgte dieser Rückgang wegen der vermuteten besseren Abdeckung durch Satelliten. Effektiv war das aber erst 2003-2004 der Fall. Die Messungen an der Erdoberfläche blieben der Standard für die IPCC-Berichte. Abbildung 5 zeigt eine von der CRU erstellte Karte für den Arctic Climate Impact Assessment (ACIA)-Bericht [etwa: Bericht zur Abschätzung von Klimaauswirkungen in der Arktis].

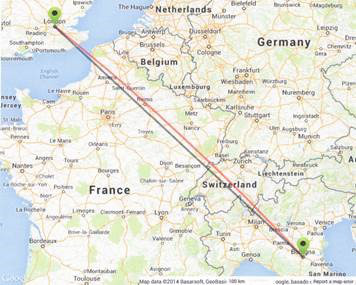

Abbildung 5.

Es ist eine stereographische Projektion über den Zeitraum 1954 bis 2003 und zeigt für den Arktischen Ozean (14 Millionen km², also fast die Größe von Russland) „no data“. Trotz des signifikanten Rückgangs der Anzahl von Stationen in Abbildung 4(b) zeigt die Graphik 4(c) nur einen leichten Rückgang der abgedeckten Gebiete. Dies liegt daran, dass man annimmt, dass jede Station einen Umkreis von 1200 km um die Station repräsentiert. Das ist absurd. Man zeichne einen Kreis mit einem Radius von 1200 km um irgendeine Station an Land oder auf See und schaue, was darin eingeschlossen ist. Die Behauptung ist sogar noch dümmer, wenn der Umkreis teilweise Wasser überdeckt.

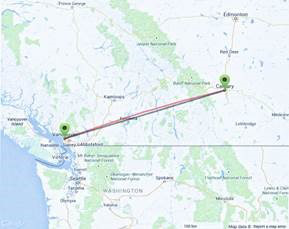

Abbildung 6a zeigt den direkten Abstand zwischen Calgary und Vancouver, der 670 km beträgt und in etwa auf der gleichen geographischen Breite liegt.

Abbildung 6a

Abbildung 6b: Distanz zwischen London und Bologna 1154 km.

Abbildung 6c: Distanz zwischen Trondheim und Rom 2403 km. Man beachte, dass dieser Kreis mit Durchmesser 2400 km fast ganz Europa einschließt.

Ein Beispiel der Probleme, die sich aus der 1200-km-Behauptung ergeben, zeigte sich vor ein paar Jahren in Saskatchewan. Der Ombudsmann der Provinz suchte meinen Rat hinsichtlich Behauptungen einer Frostversicherung, die sinnlos schienen. Die Landwirtschafts-Versicherung der Regierung entschloss sich, Versicherungen gegen Frost anzubieten. Jeder Landwirt wurde aufgefordert, die nächstliegende Wetterstation als Basis für Entscheidungen heranzuziehen. Schon im allerersten Jahr kam es zu Frost bereits Ende August. Mittels der Aufzeichnungen von Wetterstationen erhielt die Hälfte aller Landwirte keinen Ausgleich, weil ihre Station +0,5°C gemessen hatte, obwohl sie alle von „schwarzem Frost“ betroffen waren. Die Bezeichnung „schwarzer Frost“ deswegen, weil vormals grüne Blätter nach dem Frost schwarz waren. Die andere Hälfte wurde ausbezahlt, obwohl es dort keine Beweise für physischen Frost gab, die Station aber eine Temperatur von -0,5°C angezeigt hatte. Der Ombudsmann konnte dieses Missverhältnis und die Ungenauigkeit der Temperaturmessungen nicht glauben, vor allem in einem nahezu isotropen Gebiet. Vor allem, nachdem ich darauf hingewiesen hatte, dass die Temperaturmessungen von einer Stevenson Wetterhütte (Screen) stammten, zumeist 1,25 bis 2 m über Grund und damit über dem Getreide. Die Temperaturen unterhalb dieses Niveaus sind markant unterschiedlich.

Empirischer Test der Temperaturdaten

Eine Gruppe, die ein Kartographie-Projekt durchführte und dabei versuchte, Daten für die praktische Anwendung zu verwenden, brachte die Unzulänglichkeit der Temperaturaufzeichnung ans Licht:

Die Story dieses Projektes beginnt mit Kaffee, wir wollten Karten erstellen, die zeigten, wo in der Welt Kaffee am besten gedeiht und wohin er nach der Ernte geht. Wir erkundeten Daten der weltweiten Kaffeeproduktion und besprachen, wie man die optimalen Wachstumsgebiete auf der Grundlage entscheidender Umweltbedingungen kartographieren könnte: Temperatur, Niederschlag, Höhe, Sonnenlicht, Wind und Bodenqualität.

Den ersten extensiven Datensatz, den wir finden konnten, enthielt Temperaturdaten vom National Climatic Data Center NCDC der NOAA. Also begannen wir eine Karte der Erde zu zeichnen auf der Grundlage der historischen monatlichen Temperatur. Der Datensatz enthielt Messungen bis zum Jahr 1701 zurück von über 7200 Wetterstationen auf der ganzen Welt.

Jede Klimastation konnte an einem bestimmten Punkt auf dem Globus platziert werden aufgrund der geographischen Koordinaten. Nordamerika und Europa wiesen dicht gedrängt Messpunkte auf, während die räumliche Verteilung von Stationen in Südamerika, Afrika und Ostasien ziemlich spärlich ist. Die Stationsliste veränderte sich von Jahr zu Jahr, wobei einige Stationen neu online gingen und andere verschwanden. Dies bedeutete, dass man nicht einfach die Temperatur an einem bestimmten Punkt mit der Zeit plotten konnte.

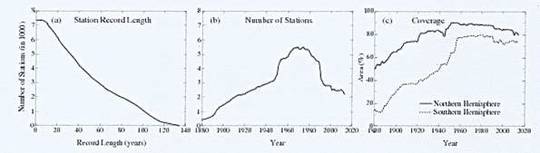

Abbildung 7

Die von ihnen erstellte Karte illustriert die Lücken sogar noch stärker, aber das war nicht das einzige Phänomen.

An dieser Stelle hatten wir eine Karte mit einer passablen Approximation der globalen Temperatur (Abbildung 7), aber es war schwierig, Daten hinsichtlich Niederschlag, Höhe über NN, Sonnenlicht, Wind und Bodenqualität zu finden. Die Temperaturdaten allein lieferten uns keine überzeugende Story.

UK mag genaue Temperaturmessungen haben, aber das ist ein kleines Gebiet. Viel größere Länder weisen ungeeignete Instrumentation und Messungen auf. In den USA gibt es möglicherweise das beste, mit Sicherheit aber das teuerste Netzwerk. Forschungen von Anthony Watts zeigten, dass die US-Aufzeichnungen nur 7,9 Prozent Wetterstationen mit einer Genauigkeit unter 1°C aufweisen.

Daten bzgl. Niederschlag sind das größere Problem

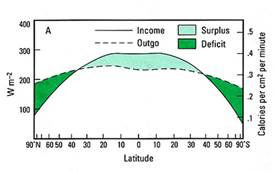

Wasser in allen Aggregatzuständen ist kritisch für den Energietransport durch die Atmosphäre. Der Transfer von zusätzlicher Energie aus den Tropen, um Defizite in Polargebieten auszugleichen (Abbildung 8) erfolgt zum größten Teil in Gestalt latenter Wärme. Niederschlag ist lediglich eine Art, diese grundlegende Variable zu messen.

Abbildung 8

Es ist eine nur sehr schwer genau zu messende Variable, und die Aufzeichnungen sind räumlich und zeitlich völlig ungeeignet aufgelöst. Ein Beispiel dieses Problems zeigte sich in Versuchen, Computermodelle zu verwenden, um den afrikanischen Monsun vorherzusagen (Science, 4. August 2006):

Alessandra Giannini, eine Klimawissenschaftlerin an der Columbia University: „Einige Modelle sagen eine nassere Zukunft vorher, andere eine trockenere. Sie können nicht alle richtig sein“.

Ein ausgemachter Schuldiger hierfür war die Unzulänglichkeit der Daten.

Ein offensichtliches Problem ist das Fehlen von Daten. Das afrikanische Netzwerk von 1152 Wetterstationen, die Daten in Echtzeit übermitteln und Eingang in internationale Klimaarchive finden, enthält nur ein Achtel der minimalen Stationsdichte, wie sie von der WMO verlangt wird. Außerdem fallen die tatsächlich bestehenden Stationen oftmals aus.

Wahrscheinlich erfüllen nur sehr wenige Gebiete die von der WMO vorgegebene Dichte. Das Problem ist komplexer, weil sich die Temperatur relativ einheitlich ändert, allerdings mit Sicherheit nicht in einem Radius von 1200 km. Die Niederschlagsmenge jedoch variiert schon im Abstand einiger Meter. Viel Niederschlag wird von Schauern geliefert aus sich im Tagesverlauf entwickelnden Cumulus-Wolken. Viele Farmer in den USA sind bestens vertraut damit, dass Teile ihrer Ländereinen einen Wolkenbruch abbekommen, während es in anderen Teilen trocken bleibt.

Temperatur und Niederschlagsmenge, die beiden wichtigsten Variablen, sind vollkommen ungeeignet, um die Bedingungen zu schaffen und damit die Formel für irgendein Gitterpunktsnetz im Modell. Im jüngsten Zustandsbericht des IPCC, AR5, heißt es in zwei klassischen Understatement-Bemerkungen:

Die Fähigkeit der Klimamodelle, die bodennahe Temperatur zu simulieren, hat sich in vielen, aber nicht allen wichtigen Aspekten verbessert relativ zu der Erzeugung der Modelle wie im AR 4 beschrieben.

Die Simulation großräumiger Verteilungen des Niederschlags hat sich seit dem AR 4 etwas verbessert, obwohl die Modelle hinsichtlich des Niederschlags weiterhin viel schlechter sind als hinsichtlich der Temperatur.

Aber die Atmosphäre ist dreidimensional, und die Anzahl der Daten über der Oberfläche ist fast nicht existent. Nur ein Beispiel soll diese Probleme hier illustrieren. Es gab einmal alle 60 Meter Instrumente an einem 304 Meter hohen Turm außerhalb der städtischen Wärmeinsel der Stadt Winnipeg. Die Änderungen auf dieser kurzen Distanz waren bemerkenswert und zeigten viel mehr Inversionen als wir erwartet hatten.

Mancher glaubt, dass die Parametrisierung erfolgt, um grundlegende Daten wie Temperatur und Niederschlag zu ersetzen. Das ist nicht der Fall. Es ist eine Methode, um Prozesse zu ersetzen, die zu kleinräumig oder zu komplex sind, um physikalisch durch einen vereinfachten Prozess im Modell repräsentiert werden zu können.

Selbst dann räumt das IPCC Grenzen und Varianzen ein:

Die Differenzen zwischen Parametrisierungen sind eine wichtige Ursache, warum sich die Ergebnisse von Klimamodellen unterscheiden.

Daten für die dynamische Atmosphäre sogar noch unzulänglicher

Sie „füllen“ die Lücke mit der Behauptung der 1200 km, was zeigt, wie bedeutungslos das alles ist. Sie haben wenige oder gar keine Daten in irgendeinem der Kreise, und doch sind diese die mathematischen Fundamente der Computermodelle. Wahrscheinlich gibt es Daten zwischen der Oberfläche und der freien Atmosphäre nur für etwa 10% des atmosphärischen Volumens. Diese Bemerkungen gelten für eine statistische Situation, aber die Volumina ändern sich konstant täglich, monatlich, jahreszeitlich und jährlich in einer dynamischen Atmosphäre, und all dies ändert sich mit dem Klimawandel.

Ockhams Rasierer zeigt, dass jede Diskussion über die Komplexität der Klimamodelle einschließlich der Verfahren, Prozesse und Prozeduren irrelevant ist. Sie können nicht funktionieren, weil die einfache Wahrheit lautet, dass die Daten, das Fundament der Modelle, vollständig unzulänglich sind. Tolstoi hat über das Phänomen einer einfachen Wahrheit Folgendes gesagt:

Ich weiß, dass die meisten Menschen einschließlich jener, die Problemen größter Komplexität entspannt gegenüber stehen, selten auch nur die einfachsten und offensichtlichsten Wahrheiten akzeptieren können, falls diese sie dazu zwingen würden, die Fehlerhaftigkeit von Schlussfolgerungen einzuräumen, die sie so erfreut ihren Kollegen erklärt haben, die sie stolz gelehrt haben und die sie Faden für Faden mit ihrem Leben verwoben haben“.

Eine andere einfache Wahrheit lautet, dass ein Modelloutput niemals als Basis für irgendetwas benutzt werden sollte, und schon gar nicht für die globale Energiepolitik.

Link: http://wattsupwiththat.com/2014/10/16/a-simple-truth-computer-climate-models-cannot-work/

Übersetzt von Chris Frey EIKE

Ist etwas off topic, aber doch bemerkenswert. ich möchte auf die Veröffentlichung von J.Mclean aufmerksam machen, welche die Erwärmung seit 1950 auf ENSO-Ereignisse und die Änderung der Bewölkung zurückführt: Late Twentieth-Century Warming and Variations in Cloud Cover

Dieser Artikel ist über WUWT zu finden.

Bitte nicht wegen der Globaltemperatur schreiben. Ich weiß, daß diese extrem problematisch ist.

MfG

Zum Teufel mit den Klimamodellen.

Schon seit Anfang der 1990er Jahre interessiere ich mich für diese Klimamodelle. Den ersten kompletten Bericht über solche „Berechnungen“ war 1992 in der Wissenschafts-Sendung „Sonde“ auf Süd-West-3. Es sind keine richtigen Computerberechnungen, sondern Simulationen. In einem Computer kann man vorne eintippen, was hinten rauskommen soll, und so ist es auch hier gelaufen. Das Wunschdenken der „Klimaforscher“ war es, dass das Klima wärmer wird, also haben die das so programmiert, dass auch ein wärmeres Klima dabei rauskommt. Fertig ist die Klimaforschung!

Es sind eben nur Filme. Die hätten auch zu den Walt-Disney-Studios gehen können, und fragen, ob die nicht einen interessanten Zeichentrickfilm über in wärmeres zukünftiges Klima machen wöllten. Selbstverständlich ist in den Simulationen ein wärmeres Klima immer ein schlechtes Klima. 🙂

International gibt es ca. 20 Modelle auf irgendwelchen Supercomputern. Da keine dieser Vorhersagen bis auf den heutigen Tag eingetroffen ist, sind alle Computermodelle falsch. Basta.

zu #2 F.Blücher

„Bei Klimamodellen drängt sich mir immer der Vergleich mit ökonomischen Modellen auf.“

Sie tun den Ökonomen aus der BWL Unrecht. Und die VWL erhebt nicht den Anspruch korrekte Zukunftsprognosen in einem Feld von irrational Handelnden Menschen und Menschenclustern erstellen zu können.

Zudem gibt es das, was Sie mit Klimamodell bezeichnen nicht. Klimamodel ist ein für das unwissende Volk geschaffener Begriff, dessen Ursprung nicht in der Wissenschaft zu finden ist, sondern der Journaille.

Am Anfang standen in der Meteorologie Versuche die Strömung der Atmosphäre vorherzusagen und die Bewegungsgleichungen zu lösen. Erst per Hand, was mißlang – wegen des Courant-Friedrichs-Lewy-Kriteriums -, dann per Computer. Irgendwann konnte man mit den in den 70er Jahren verfügbaren „Super-Computern“ (z.B. der Cyber-76) numerische Vorhersagen mit dem baroklinen Modell erstellen und die Sturmflut von 1976 tatsächlich aus den Anfangsbedingungen der Vortage „vorhersagen“. Wer jetzt wissen möchte, wie gut die numerischen Vorhersagen sind, möge sich die Seite „wetterzentrale.de“ anschauen.

Dann kamen die Meteorologen auf die Idee mit diesen Wettervorhersagemodellen die globale Zirkulation über lange Zeiträume zu simulieren, denn viele langfristig auftretende Wetterphänomene – wie z.B. die NAO oder die atlantische Blockierung – konnte man mit synoptischen und anderen Methoden nicht erklären. Als es dann gelang die Wettervorhersagemodelle stabil über Monate und Jahre laufen zu lassen und mit den immer schnelleren Parallelrechnern schnell genug zu sein, daß innerhalb akzeptabler Rechenzeiten auch „Klimazeiträume“ (mindestens 30 Jahre laut WHO) wurde der Begriff „Klimamodell“ für dieses GCM (Global oder General Circulation Models) verwendet. Der Rest ist dann ein Selbstläufer, wenn man behauptet das Klima der Zukunft mit solchen Rechenkonstrukten „vorhersagen“ zu können. Ob es geht, kann man z.B. in der Beschreibung des ECHAM5 (Bewertung des Modeloutputs im Vergleich zur Realität) selbst nachprüfen. Einstieg hier: http://tinyurl.com/35e2j4m

Bei Klimamodellen drängt sich mir immer der Vergleich mit ökonomischen Modellen auf. Man kann mit einem einfachen, linearen Kalkulationsmodell den Gewinn eines Unternehmens per 31.12.2020 auf zwei Stellen nach dem Komma genau berechnen. Aber niemand, der das Ergebnis sieht, glaubt daran, dass es wirklich so eintritt. Es ist eben nur Theorie. Dabei ist die Berechnung im Vergleich zum Klimamodell ganz einfach und überschaubar. Es reicht eine einzige nicht ausreichend bestimmbare Variable und alles ist nur noch Unfug.

Mich interessiert allerdings eines:

Die Gitterelemente sind einerseits sehr lang und breit (-zig km) müssen aber aufgrund der Höhenauflösung sehr dünn sein (wenige hundert Meter). Stört das die Simulation nicht?