„Die Anti-Atom-Hysterie ist im globalen Maßstab unbedeutend“

Sehr geehrter Herr Dr. Huke, unlängst wurden hier bereits einige Merkmale des Dual-Fluid-Reaktors (DFR) beschrieben. Wie kam es zur Idee des DFR? Gab es den ominösen „Heureka-Effekt“ der Erfinder, gab es ein besonderes Ereignis oder spielte Meister Zufall eine Rolle?

Der DFR ist als Projekt im Institut für Festkörper Kernphysik Berlin (IFK) entstanden. Dieses beschäftigt sich mit der Erforschung und Nutzung von Kernreaktionen und wurde als Initiative von Kernphysikern und Ingenieuren gegründet, weil staatliche Forschungseinrichtungen aus ideologischen Gründen großflächig liquidiert wurden. Als Nächstes musste ein wirtschaftlich verwertbares Projekt her, weil natürlich auch kein Geld für kernphysikalische Grundlagenforschung zu bekommen war. So begab es sich, dass etwa um 2009 insbesondere in Amerika durch die verordnete Abschaltung mehrerer Forschungsreaktoren die so genannte Molybdänkrise eintrat mit Folgen für die Versorgung nuklearmedizinischer Einrichtungen. Forschungsreaktoren stellen deren Versorgung mit dem Marker Technetium-99m, dessen Vorläufernuklid Molybdän-99 ist, sicher. Technetium-99m ist unentbehrlich etwa für die genaue Lokalisierung von Tumoren als Voraussetzung für deren chirurgische Entfernung oder Vernichtung. Zu der Zeit bestanden aber Bedenken, weil die Forschungsreaktoren mit hochangereichertem Uran arbeiteten, denen Proliferationsmöglichkeiten unterstellt wurden, das heißt die Weitergabe nuklearen Materials mit der Möglichkeit des Missbrauchs zur Waffenproduktion.

Kreatives Joggen

So entstand ein gefährlicher Engpass, weswegen alternative Herstellungsverfahren für Molybdän-99 angefragt wurden. Molybdän-99 hat eine Halbwertszeit von 66 Stunden und zerfällt zu Technetium-99m mit einer Halbwertszeit von 6 Stunden. Eine Lagerung oder Bevorratung ist also nicht möglich. Dr. Ruprecht aus unserem Institut kehrte zu dieser Zeit vom kanadischen Kernforschungszentrum TRIUMF aus Vancouver zurück mit der Anregung von Professor Hussein im Gepäck, dafür eine Lösung zu entwickeln. Die Lösung der Aufgabe, möglichst effizient Molybdän-99 durch Kernreaktionen zu erzeugen und rasch zu extrahieren, führte zum DFR. Die grundlegende Lösungsidee, das Dual-Fluid Prinzip, kam mir während des Joggens im Wald. Das war der gefragte Heureka-Moment. Die genauere quantitative Untersuchung und Weiterentwicklung führte zu der Erkenntnis, dass dies gleichzeitig den mit Abstand effizientesten Kraftwerksreaktor darstellt, der mit heutiger industrieller Technik baubar ist.

Welches ist das überzeugendste Argument für den DFR?

Es gibt viele Kernkraftwerkskonzepte. Der Grund, weshalb ein neues, eben dieses gebaut werden sollte, ist zuvorderst ein wirtschaftlicher, damit aber auch ein Argument des Naturschutzes. Der DFR ist das erste Kernkraftwerkskonzept, das das gigantische Potential der stärksten Naturkraft zu einem großen Anteil nutzen kann. Damit ist der DFR in der Lage, die fossilen Kraftwerke im Wettbewerb zu verdrängen und den Kraftwerksmarkt aufzurollen. Der Punkt ist, dass wir in Europa eine politische Strategie verfolgen, um Energie teurer zu machen und über den höheren Preis den Energieverbrauch abzusenken. Auf weltweiter Ebene wird sich das nicht durchsetzen, denn eine solche staatlich erzwungene Verteuerung kann nirgends auf Dauer durchgehalten werden. Wir sollten einfach zur Kenntnis nehmen, dass derzeit fast zweitausend Kohlekraftwerke geplant werden. Und dass Kohle nach Angaben einer Lancet-Studie die tödlichste aller Stromerzeugungsformen ist infolge von Unfällen bei ihrer Förderung und Verstromung. Wo es aber keine Nachreiter gibt, verpufft unsere angemaßte Rolle als Vorreiter. Nur mit preisgünstigerer Energie, die gleichzeitig umweltweltfreundlich ist, erfüllen sich die Nachhaltigkeitsziele der UN fast von selbst. Das kann der DFR leisten.

…………………………………………………………………………………………………………………………

…………………………………………………………………………………………………………………………

Woraus leiten Sie Ihren Optimismus ab, dass dies mit dem DFR anstelle anderer Bauweisen gelingen könnte?

Alvin Weinberg, der Erfinder und Mitentwickler der meisten heute noch bedeutsamen Reaktorkonzepte, wie auch des Druckwasserreaktors, formulierte es so: Der Kardinalfehler der ersten nuklearen Ära war die auf Entscheidung der US-Regierung weltweit durchgedrückte Einführung der Leichtwasserreaktortechnologie (LWR) anstatt der bereitstehenden Salzschmelze-Reaktortechnologie. Die LWR-Kraftwerke sind aufgeblähte U-Boot-Motoren mit allen Nachteilen der auf die speziellen Bedürfnisse des Militärs zugeschnitten Technik für die kommerzielle Nutzung. Das beinhaltet insbesondere die unzureichende Wettbewerbsfähigkeit und hässliche Havariemöglichkeiten. Deshalb liegt der Anteil nuklearer Elektrizität im Weltmarkt nun schon jahrzehntelang bei nur zehn Prozent, was sich auch mit den Neubauprojekten nicht ändert.

Global unbedeutende Anti-Atom-Hysterie

Die Anti-Atom-Hysterie ist daneben im globalen Maßstab unbedeutend. Dazu kommt noch, dass nur etwa ein Prozent des geförderten Urans genutzt werden kann und dadurch ein Atommüllproblem entsteht. Dies alles gibt es beim DFR nicht – im Gegenteil kann hier auch noch der Abfall der LWRs als Brennstoff genutzt werden. Hinzu kommt das Naturschutzargument. Durch seine hohe Effizienz der Nutzung von Uran und Thorium kann der DFR fossile Kraftwerke aus dem Markt drängen und Synthetikkraftstoffe für Verbrennungskraftmaschinen wettbewerbsfähig im Vergleich zu Erdölprodukten herstellen, auch CO2-frei.

Tatsächlich erneuerbar

Dadurch entfiele der größte Teil des Energiebergbaus und damit auch der größte Teil des Bergbaus, da die nuklearen Brennstoffe hochergiebig sind und zudem so genutzt mehrere hundert Millionen Jahre reichen, wodurch die Kernenergie nach der einzig harten Definition auch erneuerbar ist. Die Nutzenergieproduktion wird hoch konzentriert und beansprucht viel weniger Naturräume. Sinkende Energiekosten erlauben es, den Materialkreislauf zu schließen und ermöglichen so den Einsatz neuer, aufwendigerer Technologien, was einen neuen Industrialisierungsschub bewirken und die langanhaltende Wachstumskrise überwinden würde.

Der DFR existiert bisher nur auf dem Papier, der Weg zur ersten funktionsfähigen Anlage ist weit und der Teufel steckt bekanntlich im Detail. Sprechen wir über mögliche Probleme bei der Realisierung. Ist ein flüssiger Kernbrennstoff im Handling nicht prinzipiell risikoreicher als ein fester?

Im Reaktor bestrahlter Kernbrennstoff stellt auf Grund der starken Radioaktivität der erzeugten Spaltprodukte eine potentielle Gefahr dar. Das Handling mit seinem Risiko beinhaltet den gesamten Brennstoffkreislauf. Bei Flüssigbrennstoff-Reaktoren findet mit Ausnahme der Anlieferung des ungefährlichen Brutstoffs das gesamte Handling innerhalb des Kraftwerkscontainments statt. Bei Festbrennstoff-Reaktoren ist der Brennstoffkreislauf verteilt, wozu Transporte hochradioaktiven Materials im öffentlichen Raum gehören (Castor-Transporte) sowie Wiederaufarbeitungsanlagen, wo der feste Brennstoff ebenfalls freigesetzt wird als Flüssigkeit und/oder Gas.

Fest oder flüssig?

Zudem sind Brennelemente-Fertigungsanlagen mit stärker radioaktivem Recyclingbrennstoff erforderlich. Das Handling in einem Flüssigbrennstoff-Kraftwerk ist insgesamt weniger risikoreich, weil viel weniger manuell eingegriffen werden muss als beim Festbrennstoffkreislauf. Allerdings existiert praktisch noch kein Brennstoffkreislauf für feste Brennelemente, da dieser in großem Stil Festbrennstoff-Brutreaktoren und Kapazitätsdeckung mit Wiederaufarbeitungsanlagen benötigt. Dies ist letztendlich bereits Technologie der Generation IV. Derzeit wird der Festbrennstoff der LWR-Kraftwerke einfach zeitlich unbeschränkt zwischengelagert, was nicht nachhaltig ist und das Müllproblem steigert, aber weniger Handling benötigt.

Salzlösungen wirken aggressiv auf die Materialen des Reaktors, dazu kommt eine hohe Temperatur. Sind die Vorstellungen zum zu verwendenden Material ausgereift, gibt es hier die Gefahr unkalkulierbarer Kostensteigerung?

Hier liegt ein häufiges Missverständnis vor: Salzschmelzereaktoren arbeiten nicht mit einer Salzlösung. Es gab einen solchen Reaktortyp in der Anfangsphase der Reaktorentwicklung, der sogenannte homogene Reaktor, wo Brennstoffsalz in Wasser gelöst war. Dieser Reaktortyp ist für die Kraftwerksanwendung ungeeignet.

In einem Wasser-Salz-Gemisch katalysieren die Salzionen die Oxidation von Metall mit dem Sauerstoffatom aus dem Wassermolekül. Im Salzschmelzereaktor wird reines Salz, das heißt ohne Lösungsmittel, erhitzt, bis es schmilzt. Die Strukturmetalle können schlicht aus Mangel an Sauerstoff nicht oxidieren. Dennoch können auch flüssige Salze, die ohnehin erst bei hohen Temperaturen flüssig werden, Metallkomponenten angreifen. Bereits relativ gering veredelte Metalllegierungen sind in der Lage, dem standzuhalten.

Ungelöstes Salz als Lösung

Dies wurde beim erfolgreichen Salzschmelzereaktorexperiment am Oak Ridge National Laboratory unter Leitung von Alvin Weinberg bereits gezeigt und ist der umfangreichen Dokumentation des Experiments zu entnehmen, sie ist online verfügbar. Heute können hochwiderstandsfähige Refraktärmaterialien (unempfindliches Material – FH) zu Komponenten gefertigt und gefügt werden. Diese Baubarkeit war bereits Teil des Grundentwurfs des DFR. Grundsätzlich gilt allerdings, dass es bei jeder großtechnischen Neuentwicklung zu unvorhersehbaren Detailproblemen kommen wird, die mit zusätzlichem Aufwand gelöst werden müssen. Das liegt in der Natur der Sache, andernfalls wäre es nicht innovativ.

An wärmeübertragenden Flächen kommt es speziell bei Verwendung von Salzen oft zu Belagbildung und Inkrustationen, die den Wärmeübergang verschlechtern und im Extremfall zur Funktionsunfähigkeit führen können.

Da keine Salzlösung verwendet wird, gibt es so etwas nicht. Allerdings entstehen im Salzschmelzebrennstoff Spaltproduktelemente, die bei den vorhandenen Temperaturen keine stabilen Salze bilden und als Metallatome im Salz gelöst sind. Beim Salzschmelze-Reaktorexperiment wurde eine Ablagerung solcher Quasi-Edelmetalle beobachtet. Jedoch stehen dort aufgrund des chemischen Massenwirkungsgesetzes Ablagerung und Wiederauflösung im Gleichgewicht, so dass nur eine gleichbleibend dünne Schicht entsteht. Genau das wurde beim Weinberg-Reaktor so auch festgestellt und der Betrieb wurde dadurch nicht beeinträchtigt. An dieser Stelle sei daran erinnert, dass der DFR in zwei Flüssigbrennstoffvarianten entwickelt wird: Der DFR/s mit einem Actinoid-Chlorid-Gemisch als Salzbrennstoff und der DFR/m mit einer Actinoid-Metalllegierung als Flüssigmetall-Brennstoff. Letzterer hat noch mal eine deutlich vergrößerte Lösbarkeit für edlere Metalle.

Wie aufwändig sind die Aufbereitung des flüssigen Brennstoffs während des Betriebs, die Zuführung „frischen“ Materials und die Abführung der Spaltprodukte? Mit welchen Technologien erfolgt die exakte Mischung des Brennstoffs?

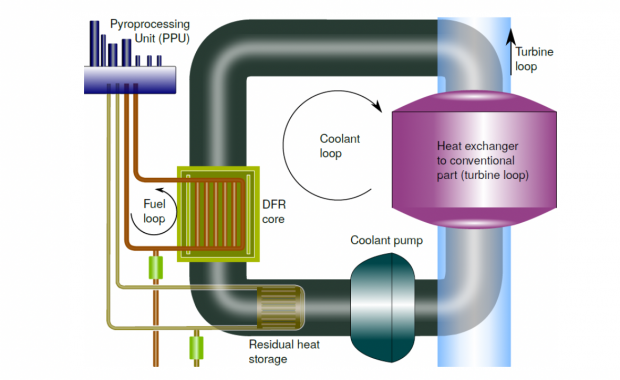

Im Kraftwerkscontainment befindet sich die gekapselte pyrochemische Verarbeitungseinheit (PPU), eine nukleare fraktionierte Destillationsanlage, wo die Brennstoff-Flüssigkeit gefiltert wird. Dies geschieht durch das thermische Stofftrennungsverfahren der Rektifikation (eine so genannte Gegenstromdestillation – FH), welche in der chemischen Industrie und Metallurgie bereits seit Jahrzehnten eingesetzt wird. Sie trennt das Metallchloridsalz-Gemisch durch Verdampfen mit sehr hoher Reinheit in ihre Komponenten auf. Eine Isotopentrennung findet prinzipbedingt nicht statt. Die Spaltprodukte werden abgetrennt und aus den ebenfalls aufgetrennten Actinoidchloriden wird sodann eine Salzkombination für den Reaktor angemischt, einfach durch Stoffmengenmessung und Mischung. Diesem Gemisch wird ebenfalls frischer Brutstoff, Uran oder Thorium, als Chlorid zugemischt, um die abgetrennten Spaltprodukte zu ersetzen.

Konzentrierte Kraft

Ein DFR-Kraftwerk mit 1,5 Gigawatt elektrischer Leistung verbraucht 1200 Kilogramm Actinoide pro Jahr. Das ist etwa das Volumen einer Bierkiste. Für den DFR/m müssen nur zwei einfache Konversionsschritte zwischengeschaltet werden. Unter den bekannten Kernbrennstoff-Verarbeitungsverfahren ist dies das einfachste.

Etwas komplizierter wird es, wenn die abgebrannten Brennelemente der heutigen Kernkraftwerke verwertet werden sollen. Dann müssen erst die Brennelemente zerlegt und die Oxidkeramikpellets in Chloride umgewandelt werden. Das hat das IFK in einer im Juli veröffentlichten Studie dargelegt, die vom BMWi finanziert wurde und auf unserer Webseite abrufbar ist. Ein deutscher Reaktor bisheriger Bauart mit 1,4 Gigawatt erzeugt in seiner erzwungenermaßen verkürzten Laufzeit von 40 Jahren 1.000 Tonnen Schwermetalle. Damit könnte ein einzelner 1,5 Gigawatt-DFR 800 Jahre lang betrieben werden. Der Abbau der langlebigen Transurane im Abfall wäre schon innerhalb von 20 Jahren erledigt. Die weiteren 780 Jahre kämen vom übrigen bisher nicht genutzten Uran. Insgesamt könnte eine DFR-Flotte mit den abgebrannten Brennelementen Deutschland etwa 70 Jahre lang in Sektorenkopplung (einschließlich Wärme und Verkehr) vollversorgen. Mit dem bei der Urananreicherung zuvor angefallenem abgereicherten Uran ungefähr 700 Jahre. Realistisch betrachtet werden wir dafür nie wieder Uran abbauen müssen, denn innerhalb dieser Zeit dürfte das Problem der Kernfusion befriedigend gelöst sein.

Was wäre der GAU, der größte anzunehmende Unfall, der mit diesem Reaktorprinzip passieren könnte?

Der Reaktor wird durch einfachste physikalische Regelkreise gesichert, das heißt, eine Maschinerie und computerisierte Schutzsysteme sind im nuklearen Kreis nicht erforderlich. Der Reaktor ist inhärent passiv sicher, im nuklearen Teil gibt es auch keine beweglichen Teile wie Ventile oder mechanische Pumpen, die potentiell störanfällig sind. Unfallszenarien wie Kritikalitätsunfall (ungewollte Leistungsexpansion – FH) und havariemässige Überhitzung wegen Ausfall der Kühlkreislaufpumpen oder Kühlmittelverlust sind prinzipbedingt ausgeschlossen. Der GAU bestünde vornehmlich aus einem Bruch der Brennstoffrohrleitung am oder im Reaktorkern durch Materialversagen oder Gewalteinwirkung.

Was wäre, wenn?

Dem Bruch durch Materialversagen wird durch Online-Überwachung der Reaktorstruktur mittels Neutronentomographie vorgebeugt. Sollte es dazu kommen, läuft Brennstoffflüssigkeit aus oder vermischt sich mit dem Kühlmittel. Im ersten Fall gibt es eine Auffangwanne mit passiver Wärmeabfuhr im Lagerraum der Brennstofftanks, im zweiten Fall kann das kontaminierte Kühlmittel auch in der PPU gereinigt werden.

Austretender Brennstoff steht nicht unter Druck, daher wird kein radioaktives Material versprüht. In beiden Fällen verliert der Brennstoff sofort seine kritische Geometrie und die Kettenreaktion bricht ab. Aufgrund der kleinen Abmessungen und der Konstruktion kann der Reaktorkern als Ganzes ausgetauscht werden. Dieser Fall wäre also nicht mal ein wirtschaftlicher Totalschaden.

Um für das Leben in der Umgebung gefährliche Mengen Radioaktivität auszuwerfen, bedürfte es massiver Gewalteinwirkung. Der nukleare Teil befindet sich in einem armierten Stahlbetonwürfel mit einer hinreichend großen Wandstärke. Militärischer Beschuss von außen oder terroristische Sprengstoffdetonation im Innern reichen nicht aus. Dazu bedarf es eines Bunkerknackers, einer Lenkwaffe, die in der Lage ist, eine solche Armierung zu durchschlagen. Das alleine reicht allerdings auch nicht aus. Sie müsste zusätzlich mit einem Nuklearsprengkopf bestückt sein, um gefährliche Mengen Radioaktivität auswerfen zu können. Das könnte sich nur im Fall eines Atomkriegs der Großmächte ereignen, dann sind havarierte Kernkraftwerke wirklich kein vordringliches Problem mehr.

Welches Echo zum DFR erreichte Sie bisher, international und aus Deutschland?

Es gab die verschiedensten Reaktionen in den letzten sechs Jahren. Wir betrieben dies zunächst als akademisches Entwicklungsprojekt. Nachdem ausreichender Patentschutz gegeben war, gingen wir den üblichen wissenschaftlichen Weg. Das Konzept und Ergebnisse der physikalischen Simulationen wurden in wissenschaftlichen Fachzeitschriften und auf Konferenzen veröffentlicht. Inzwischen haben wir zahlreiche Blindbegutachtungsverfahren erfolgreich hinter uns gebracht. Nach berechtigter anfänglicher Skepsis ist das Konzept bei der internationalen wissenschaftlichen Community allgemein anerkannt, was sich auch am großen Interesse an wissenschaftlicher Kooperation zeigt. Die Finanzierung solcher Kooperationen ist aber noch ein Problem.

Daneben werden wir häufig von Leuten mit unterschiedlichstem Hintergrund kontaktiert. Da werden Fragen gestellt, Vorschläge gemacht, die wir manchmal aufgreifen können, es wird Hilfe angeboten sowie nach Investitionsmöglichkeiten für technikbegeisterte, risikobereite Kleinanleger gefragt. Mittelständische Unternehmer unterstützen uns gelegentlich mit signifikanten Geldbeträgen, die es uns ermöglichen, weiterzumachen. Diesen und den Kleinspendern sei auch an dieser Stelle gedankt. Wir hatten auch mehrfach Kontakte zu den Führungsspitzen großer Konzerne. Dort beobachteten wir, dass diejenigen, die über ausreichendes Fachwissen verfügen, das Projekt überwiegend befürworteten, aber unterhalb der Ebene agierten, die über das Geld entscheidet. Auf der Entscheiderebene ist hingegen kaum Fachwissen vorhanden, kaum Innovationswille, bis hin zu einer erschütternden Unterwürfigkeit gegenüber der herrschenden Energiewende-Doktrin.

…………………………………………………………………………………………………………………………

Das Institut

Institut für Festkörper Kernphysik Berlin gGmbh, Berlin

Gegründet von Prof. Dr. Konrad Czerski, Dipl.-Ing. Stephan Gottlieb, Dr. Armin Huke, Dr. Götz Ruprecht, 2009

Arbeitsgebiete sind Grundlagenforschung zu Kernreaktionen, Angewandte Forschung nukleare Energetik, Entwicklung des DFR

Bisherige Forschungsergebnisse: Experimentelle und theoretische Untersuchungen zu Kernreaktionen, Evaluierung der Energieökonomie von Kraftwerkstechnologie, Entwicklung des DFR

Forschungskooperationen bestehen mit der Universität Stettin, dem Lehrstuhl Kerntechnik der TU München und dem Nationalen Zentrum für Kernforschung Warschau.

…………………………………………………………………………………………………………………………

Aller Anfang ist schwer

Wir haben zudem weit verzweigende, parteiübergreifende Kontakte in die Politik. Darauf legen wir besonderen Wert, da wir auch eine politische Debatte führen müssen, wenn wir die Kerntechnik in den öffentlichen Diskurs zurückholen wollen. Die Argumentationsrichtung war anfangs die Beseitigung des nuklearen Abfalls durch Partitionierung und Transmutation unter Vermeidung eines geologischen Endlagers. In diesem Jahr kam mit der immer weiter um sich greifenden Erkenntnis, dass die Energiewende in dieser Form scheitern wird und der Debatte um einen Klimanotstand die Diskussion um die Notwendigkeit zu alternativen Energiestrategien auf. Eine Kurskorrektur zur Kernenergie wird es geben, wenn der Ruf aus der Bevölkerung laut genug wird. Das beginnt derzeit an vielen Stellen, und gerade Flüssigbrennstoff-Reaktoren mit ihrer passiven Sicherheit und der Lösung der Atommüllfrage kehren in die öffentliche Diskussion zurück.

Dann gibt es hierzulande noch die übliche Bedenkenträgerei, die zum Teil auch von Betriebspersonal aus der alten Kerntechnik stammt. Deren Unterstellungen konnten wir bisher leicht entkräften, da es am Verständnis des DFR-Konzeptes mangelte.

Es existieren für den DFR Verfahrenspatente in Deutschland und international, darunter in Ländern, die der Kernkraft deutlich aufgeschlossener gegenüberstehen als Deutschland. Müsste das internationale Echo auf Ihre Erfindung im Ausland nicht positiver sein als bei uns?

Nur bedingt. Auch international hat die Einführung neuer Kernkraftwerkskonzepte einen schweren Stand. Der Hauptgrund dafür ist das Vorurteil, dass Kernkraft allgemein teuer ist. Das resultiert, wie oben erläutert aus den hohen Kosten der LWR-Kraftwerke der laufenden Generation II. Die Generation III(+), ebenfalls LWR, ist sogar noch teurer, weil jede denkbare Sicherheitstechnik auf gesellschaftliche Anforderung hin auch eingebaut werden muss. Die EPR-Baustellen von Areva (Druckwasserreaktoren der Generation III+) sind ein finanzielles Desaster, was noch vom französischen Staat abgesichert wird. Aber auch die Konkurrenz steht nicht viel besser da. Die Generation III kommt kaum in einen Markt, in dem die fossilen Kraftwerke wegen geringerer Erzeugungskosten unangefochten dominieren.

Dennoch haben die Herstellerkonzerne noch nicht genug Leidensdruck, um neue Wege zu gehen und das Veraltete fallen zu lassen. Obendrein stellt Kerntechnik meist auch nur eine mehr oder weniger kleine Sparte in den Großunternehmen dar. Unter dem Vorurteil, welches für die LWRs ein berechtigtes ist, leiden auch die diversen kleinen Firmen in Amerika, die den klassischen Salzschmelzereaktor in verschiedenen Varianten entwickeln. Allerdings entwickeln diese Firmen SMRs (Small Modular Reactors), also Kleinreaktormodule, einem durch die dortige Politik vorgegebenen Trend folgend. Es gibt jedoch den Skalierungseffekt, das heisst, je kleiner so eine Anlage ist, desto höher werden die spezifischen Erzeugungskosten. SMRs haben so hohe Erzeugungskosten, dass sie nur für netztopographische Inselanwendungen geeignet sind und häufig auch nur dann, wenn eine kontinuierliche Versorgung mit Diesel für Generatoren nicht gewährleistet werden kann, etwa bei im arktischen Winter isolierten Siedlungen.

Loriots Idee ohne Chance

Damit ist man auf dem allgemeinen Kraftwerksmarkt auch nicht konkurrenzfähig, selbst wenn ein mobiles Kleinkernkraftwerk technisch attraktiv ist. Hinzu kommt, dass man inklusive Entwicklungs- und Genehmigungskosten selbst bei kleinen Demonstrationsreaktoren für Bau und Betrieb über eine Milliarde Euro benötigt. Verbrennungskraftmaschinen lassen sich voll funktionsfähig im Spielzeugformat für Kinder bauen. Kernreaktoren haben da untere Schranken, bedingt durch die kritische Masse zur Kettenreaktion, insbesondere auch was die Kosten für den Spaltstoff angeht. Das Spielzeugatomkraftwerk aus Loriots Weihnachtssketch mit Neutronenbeschleuniger und Uranstab ist leider nicht machbar. Um diese Hindernisse zu durchbrechen sind wir zu neu und unsere Wirkungsmöglichkeiten und unsere Bekanntheit noch nicht groß genug.

Bereits für eine erste Anlage wären erhebliche finanzielle Mittel notwendig. Wie hoch wäre eine nötige Anschubfinanzierung für Projektierung, Planung und Bau und wäre die Wahrscheinlichkeit einer Realisierung in einem Land mit hoher Verfügbarkeit von Risikokapital wie den USA nicht deutlich höher?

Ein solches technisches Entwicklungsgroßprojekt hin zu einem kommerziellen Produkt wird in mehreren Phasen realisiert, wobei der Geldbedarf von Phase zu Phase stark ansteigt. Der Geldfluss bestimmt auch die Geschwindigkeit. Für eine Kommerzialisierung ist Geschwindigkeit von Bedeutung. Die Planung der Phasen bis hin zu Modulen und Arbeitspaketen für die erste gut kalkulierbare Phase sind durchgeführt. In diesem Jahr erstellten wir einen Investitionsplan für ein Geschäftsmodell nach den im Risikokapitalgeschäft üblichen Anforderungen für die Entwicklung eines SMR-Kraftwerks mit einer elektrischen Leistung von gut 300 MW. Dies ist die kleinste sinnvolle Leistung, mit der noch ein entscheidender Wettbewerbsvorteil gegenüber fossilen Großkraftwerken erzielt werden kann. Das ist enorm wichtig für eine schnelle Marktdurchdringung. Der Finanzbedarf ist Anfangs geringer und steigert sich dann rasch, wobei neben den eigentlichen Entwicklungskosten die sehr beträchtlichen Kosten für das begleitende Genehmigungsverfahren zu Buche schlagen werden.

Alles hat seinen Preis

Die erste Phase besteht aus Komponententests und Sicherheitsanalysen nach den Anforderungen der Genehmigungsbehörden und ist mit 40 Millionen Euro veranschlagt. Die zweite Phase besteht aus einer nicht-kritischen Testanordnung und der konkreten Konstruktionsplanung des Testreaktors, sie wird etwa 300 Millionen Euro kosten. In der dritten Phase wird der Testreaktor gebaut und zum Kraftwerksbetrieb gebracht. Hier werden etwa vier bis fünf Milliarden Euro erforderlich sein. Danach erfolgen die Vorserienfertigung mit Auslieferungsbeginn und der Aufbau der Serienproduktionslinien. Das Investitionsvolumen hierfür wird voraussichtlich in der Größenordnung von 10 bis 15 Milliarden Euro liegen, und wir hoffen, es zum größeren Teil kreditfinanzieren zu können. Diesen Kosten steht ein weltweites Investitionsvolumen im Kraftwerksmarkt bis 2050 im Bereich von mehreren Billionen Euro gegenüber. Die Größenordnungen im Kraftwerksgeschäft sind ganz andere, was aber auch neben den zuvor dargelegten besonderen Hürden für Kernkraftwerksprojekte die Akquirierung allgemein so schwierig macht.

Kapital ist beweglich und nicht an den Umsetzungsstandort gebunden, wobei wir natürlich nicht auf Deutschland als Standort angewiesen sind. Wir begannen erst in den letzten Monaten mit der Verbreitung des Investitionsplans. Dabei handelt es sich nicht um eine breite Streuung, sondern über geeignete Kanäle gezielt potenzielle Investitionsinteressenten mit dem nötigen Vermögen zu erreichen. Das ist eine langwierige, schwierige Tätigkeit. In den USA haben wir noch keine solchen Kontakte aufbauen können.

Alles in allem also ein Aufwand etwa in Höhe der deutschen EEG-Umlage eines halben Jahres, dafür mit globaler Zukunftsperspektive für emissionsarme Stromproduktion.

Welche Bedingungen müssten erfüllt sein, dass Deutschland an dieser Stelle tatsächlich ein „Vorreiter“ werden könnte? Von wem könnte es Unterstützung geben, welche Wege wären zu gehen, um die in Deutschland manifeste Atomphobie zu überwinden?

Wir beschreiten nunmehr drei parallele Wege zum Aufbau eines DFR-Kraftwerksbauers. Speziell für Deutschland bieten wir die zuvor skizzierte Möglichkeit der Entsorgung des nuklearen Abfalls mittels Partionierung und Transmutation im DFR an, womit ein geologisches Endlager obsolet würde. Dies wird durch die im Sommer veröffentlichte Studie immer bekannter und die Forderung, dies zumindest in einer Demonstrationsanlage zu erproben, wird lauter. Jede Kommune, die als möglicher Standort für ein Endlager in den Fokus gerät, wird sich mit Hinweis darauf zur Wehr setzen.

Zur Finanzierung wurde der Altlastenentsorgungsfond mit 32 Milliarden Euro geschaffen. Anders als bei der Endlagersuche und dessen Bau würde nur ein Bruchteil dieser Summe für die DFR-Entwicklung ausreichen, der Rest könnte zurückgegeben werden. Um diesen Weg der DFR-Finanzierung zu beschreiten, müssen entsprechende Forderungen an die Regierung noch lauter werden. Hier sehen wir mehr und mehr Stimmen am Werk, nicht zuletzt von Kritikern der Energiewende und der mit ihr verbundenen, großflächigen Naturzerstörung. Flüssigbrennstoff-Reaktoren wären eine echte Alternative zu Kohle- und Gaskraftwerken, diese Erkenntnis setzt sich langsam durch.

Der zweite Weg ist die Anwerbung von Risikokapital für die Entwicklung des DFR für den weltweiten Verkauf. Hier beginnen wir derzeit zunächst in Deutschland. Sollte das nötige Risikokapital zusammenkommen, ist allerdings auch dann für den Bau einer Testanlage eine positive Begleitung durch Behörden und Politik notwendig. Ansonsten müsste eben im Ausland gebaut werden, einschließlich der Fabrikationsanlagen.

Der dritte Weg ergänzt den zweiten gewissermaßen. Wir bekommen schon seit Jahren vermehrt Anfragen, wie Kleinanleger in das Projekt investieren können. Hierfür sind die bürokratischen Hürden staatlicherseits besonders hoch. Eigentlich sollte jedem klar sein, dass es sich um eine Risikokapitalanlage handelt, wo eben auch Totalverlust möglich ist. Für eine Publikumsgesellschaft für Kleinanleger muss man einen von der Bundesanstalt für Finanzdienstleistungen (BaFin) zu genehmigenden Prospekt erstellen, wo dies genau und rechtssicher erklärt ist. Dafür bedarf es einer beträchtlichen Arbeit von Fachanwälten und Steuerrechtsexperten mit dementsprechendem Kostenaufwand, den sich eigentlich nur große Stakeholder leisten können. Zudem kann die BaFin den Genehmigungsprozess hinauszögern. Allerdings bekommen wir immer mehr qualifizierte Hilfsangebote von Leuten, die von dem Projekt begeistert sind oder damit aktiv zu einer emissionsfreien Energieversorgung beitragen möchten. Einige davon arbeiten bereits im Team mit und verfügen über entsprechende Qualifikation und Kontakte. Durch eine Publikumsgesellschaft können sehr viele Leute an dem Projekt teilhaben, die wiederum eine Avantgarde für die notwendige energiepolitische Korrektur bilden.

Die Mauer in den Köpfen

Die Atomphobie ist keineswegs so manifest wie häufig dargestellt. Das Spiel seit den 1970er Jahren läuft so, dass eine kleine, extremistische Minderheit die Gesellschaft mit ihrer Ideologie vor sich hertreibt. Die Schäden an der allgemeinen Wohlfahrt werden mittlerweile so groß und offensichtlich, dass der Anti-Atom-Propaganda immer weniger geglaubt wird und neuer Realitätssinn einkehrt. Unter Profis weiß man schon lange, dass wegen der Tücken der Umgebungsenergien die fossilen Energieträger nur überwunden werden können durch moderne, sichere, skalierbare und preisgünstige Konzepte der Kernenergie.

Sollte es tatsächlich zu einem umsetzbaren Projekt kommen, was wären aus Ihrer Sicht die ersten Schritte?

Kommt die Finanzierung für Phase 1 zustande, beginnt die Standortauswahl, die Personaleinstellung und der Laboraufbau für die Tests. Die notwendigen Kontakte haben wir, auch durch unser Netzwerk mit unseren akademischen Kooperationspartnern. Da können wir auf qualifiziertes Personal zurückgreifen. Weiteres befindet sich in der Ausbildung: Am nationalen Kernforschungszentrum in Warschau arbeiten seit diesem Jahr fünf Doktoranden an der Entwicklung des DFR. Zwei weitere aus Deutschland promovieren an der Universität Stettin, da es hierzulande keine ausreichenden Möglichkeiten mehr gibt, um in Kernphysik und -technik einen Abschluss zu erwerben. Mit einem Spezialanbieter für Hochleistungskeramiken sind wir schon für einen Standort für die Teststände in Phase 1 im Gespräch, und auch mit den Lieferanten für die Teststandskomponenten haben wir schon Kontakt. Nach entsprechender Finanzierung könnten wir mit Phase 1 also sehr zügig loslegen.

Herr Doktor Huke, vielen Dank für das Gespräch und viel Erfolg für den Fortgang Ihres Projekts.

Anmerkung der EIKE-Redaktion: