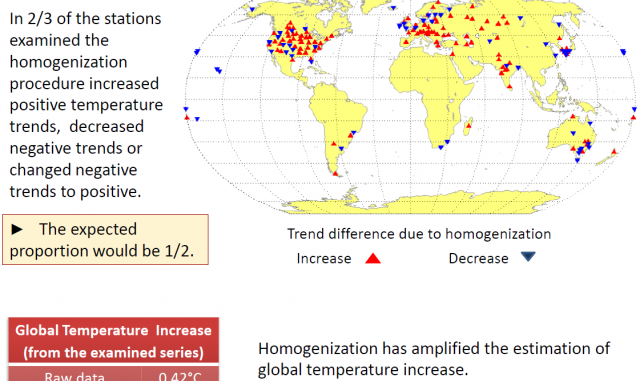

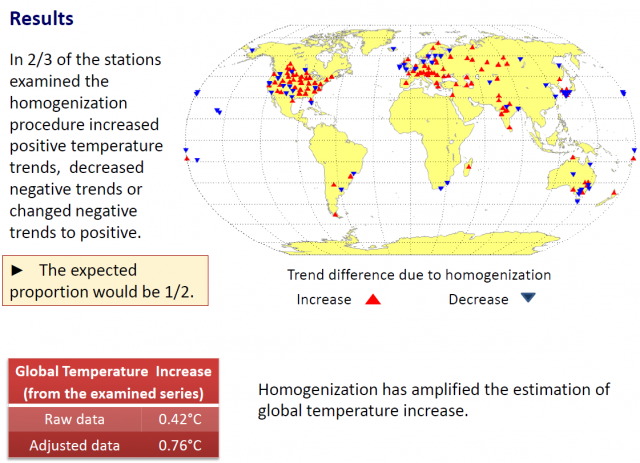

Aus der „habe-ich-doch-gesagt-Abteilung“ stammt diese kürzlich auf dem Treffen der European Geosciences präsentierte Studie. Die Autoren Steirou und Koutsoyiannis fanden nach der Berücksichtigung von Fehlern bei der Homogenisierung heraus, dass die globale Erwärmung während des vorigen Jahrhunderts nur etwa halb so groß war (0,42°C) wie vom IPCC behauptet (0,7 bis 0,8°C).

Übersetzungen der Bildinschriften:

Results (Ergebnisse):

Bei zwei Drittel aller untersuchten Stationen erzeugte der Homogenisierungsprozess zunehmende positive Temperaturtrends, abnehmende negative Trends oder Veränderungen des Trends von negativ zu positiv.

Das zu erwartende Verhältnis müsste ½ sein.

Die Homogenisierung hat die Abschätzung der globalen Temperaturzunahme verstärkt.

Hier kommt der Punkt, den ich wirklich liebe: an 67% der untersuchten Wetterstationen wurden fragwürdige Anpassungen der Rohdaten vorgenommen. Dies führte zu:

„…verstärkten positiven Trends, abgeschwächten negativen Trends oder Trends, die von negativ zu positiv geändert wurden“, während „das zu erwartende Verhältnis 1 zu 2 sein müsste (50%)“.

Und…

„die bis heute angewandten Praktiken der Homogenisierung sind hauptsächlich statistisch und nicht gut durch Experimente belegt. Sie werden nur selten durch Metadaten gestützt. Man kann sagen, dass sie oft zu falschen Ergebnissen führen: natürliche Erscheinungen hydroklimatischer Zeitreihen werden als Fehler betrachtet und angepasst“.

Das Abstract der Studie und meine hilfreiche Visualisierung der Daten-Homogenisierung folgt hier:

Untersuchung der Methoden für hydroklimatische Datenhomogenisierung

Steirou, E., and D. Koutsoyiannis, Investigation of methods for hydroclimatic data homogenization, European Geosciences Union General Assembly 2012, Geophysical Research Abstracts, Vol. 14, Vienna, 956-1, European Geosciences Union, 2012.

Wir untersuchen die angewendeten Methoden zur Anpassung von Inhomogenitäten von Temperatur-Zeitreihen im Zeitraum der letzten 100 Jahre. Basierend auf einer systematischen Studie der wissenschaftlichen Literatur klassifizieren und evaluieren wir beobachtete Inhomogenitäten in historischen und aktuellen Zeitreihen ebenso wie die entsprechenden Methoden. Es stellt sich heraus, dass diese Methoden hauptsächlich statistischer Natur sind, nicht gut durch Experimente gerechtfertigt sind und nur selten von Metadaten gestützt werden. In vielen der untersuchten Fälle sind die vorgeschlagenen Korrekturen nicht einmal statistisch signifikant.

Aus der globalen Datenbasis GHCN-Monthly Version 2 untersuchen wir alle Stationen, die sowohl Roh- als auch adjustierte Daten enthalten, die bestimmten Kriterien der Kontinuität und Verteilung über den Globus entsprechen. Wegen der großen Zahl verfügbarer Stationen in den USA wurden die Stationen nach geeigneten Beispielen ausgewählt. Insgesamt haben wir 181 Stationen weltweit analysiert. Für diese Stationen berechneten wir die Differenzen zwischen den angepassten und nicht-angepassten linearen 100-Jahre-Trends. Es stellte sich heraus, dass in zwei Drittel aller Fälle die Homogenisierungs-Prozedur die positiven Temperaturtrends hat weiter zunehmen, die negativen Temperaturtrends abnehmen lassen.

Eine der gebräuchlichsten Methoden zur Homogenisierung, ‚SNHT for single shifts‘ war auf synthetische Zeitreihen mit bestimmten statistischen Charakteristiken angewendet worden, gelegentlich mit Verschiebungen (offsets). Die Methode war befriedigend, wenn man sie auf normal verteilte unabhängige Daten anwendet, aber nicht auf Daten mit einer langzeitlichen Persistenz.

Obige Ergebnisse lassen einige Zweifel bei der Verwendung von Homogenisierungs-Verfahren aufkommen und deuten darauf hin, dass der globale Temperaturanstieg im vorigen Jahrhundert zwischen 0,4°C und 0,7°C lag, wobei diese zwei Werte aus Roh- und adjustierten Daten abgeleitete Schätzungen sind.

Schlussfolgerungen

1. Die Homogenisierung ist erforderlich, um Fehler in klimatischen Zeitreihen zu entfernen.

2. Die bis heute verwendeten Methoden der Homogenisierung sind hauptsächlich statistischer Natur, nicht gut durch Experimente belegt und selten durch Metadaten gestützt. Man kann zeigen, dass sie oftmals zu falschen Ergebnissen führen: natürliche Erscheinungen in hydroklimatischen Zeitreihen werden als Fehler angesehen und korrigiert.

3. Während die Homogenisierung erreichen soll, dass die bestehenden vieljährigen Trends im gleichen Verhältnis zu- oder abnehmen sollen, ist es in Wirklichkeit so, dass in 2/3 aller Fälle der Trend nach der Homogenisierung zunimmt.

4. Obige Ergebnisse wecken Zweifel an den Methoden der Homogenisierung und deuten darauf hin, dass die globale Temperaturzunahme während des vorigen Jahrhunderts kleiner als 0,7°C bis 0,8°C ist.

5. Es ist eine neue Homogenisierungspraxis erforderlich, die auf Experimenten, Metadaten und besserer Erfassung der stochastischen Charakteristika hydroklimatischer Zeitreihen basiert.

- Presentation at EGU meeting PPT as PDF (1071 KB)

- Abstract (35 KB)

h/t to “The Hockey Schtick” and Indur Goklany

=============================================================

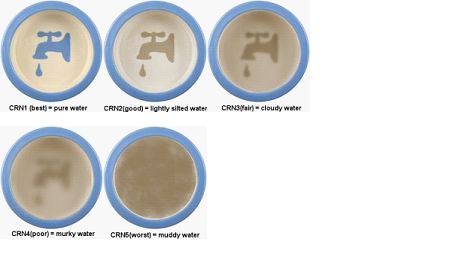

Hier folgt ein anschauliches Beispiel, den Homogenisierungsprozess anschaulich zu machen. Man stelle ihn sich wie die Messung der Verschmutzung von Wasser vor. Hier folgt eine einfache Tafel mit einer Qualitätsbewertung von CRN-Stationen (CRN station quality ratings) und wie das aussehen könnte, wenn man die Trübung durch Wasserverschmutzung mit einer Bewertung von 1 bis 5 (beste <-> schlimmste Note) versieht:

Bei der Homogenisierung werden die Daten gegen nahe gelegene Nachbarstationen innerhalb eines bestimmten Radius’ gewichtet. Und so könnte eine Station mit der Wertung „1“ mit den Daten benachbarter Stationen verschmutzt werden und mit einem neuen Wert aufwarten, „2,5“. Selbst Einzelstationen können viele andere Stationen bei den Homogenisierungs-Methoden von GISS und NOAA beeinflussen, denen die Bodentemperaturen in den USA hier und hier unterzogen werden.

In obiger Karte wird eine Glättung durch Homogenisierung angebracht, indem Stationen neben Stationen mit Fragezeichen gewichtet werden. Was würden Sie hinsichtlich der Werte (der Trübung) erwarten? Und wie nah wären diese zwei Werte an den fraglichen beiden Stationen, je eine an der Ost- und an der Westküste? Jeder Wert läge näher an einem geglätteten zentralen Mittel, das auf der Wertung der benachbarten Stationen basiert.

Aktualisierung: Steve McIntyre stimmt dem in einem neuen Beitrag zu, wenn er schreibt:

Wenn schließlich Referenzinformationen benachbarter Stationen verwendet werden, tendiert der Prüfgegenstand dazu, Anpassungsfehler zu erzeugen: das „schlimmer-Nachbar-Problem“. In diesem Falle wurden die Klimasignale nach der Anpassung bei benachbarten Stationen immer ähnlicher, selbst wenn der mittlere Bias des gesamten Netzwerkes nicht reduziert worden ist.

Gepostet von Anthony Watts

Übersetzt von Chris Frey EIKE

Die Hälfte der Erwärmung kommt aus der Homogenisierung heißt hier die Überschrift. Nach der Veröffentlichung weiter oben, sieht man, dass wohl nahezu die ganze ERwärmung aus der Falschhomogenisierung kommt. Ein bewußter Handwerkerfehler bei der Behandlung der Daten.

Ich blicke auf 55 jahre eigene Erinnerungen in der freien Natur zurück. Schon immer hat der Mai die Bäume dort grün gemacht, am 1.Mai gabs Maikäfer und im März spannt der Bauer die Traktoren ein. Nur, diese Liedchen sind 200 Jahre alt und heute ist es noch genauso. Nur in den Wärmeinseln der Städte macht der April die Bäume grün. Die Temperaturen gehen mal für Jahrzehnte rauf, dann wieder runter, sonst ist alles gleich auf diesem Planeten. Die Katastrophe existiert nur im Kopf einer c02-erwärmungsgläubigen geldgierigen Gruppe.

Lieber Hr. Urbahn,

ihnen ist aber schon klar, dass Watts Vorabdruck noch nicht einmal bei einem wiss. Journal eingereicht ist?

Aber wozu auch ein peerreview abwarten. Ich bin mir sicher, ein wahrer Skeptiker wird auch so ganz schnell zwischen gut und schlecht unterscheiden können (sowohl bei Watts als auch bei BEST). 😉

Lieber Herr Limburg,

hat es einen Grund, warum Sie meine Fragen nicht freischalten? Sie dürften von allgemeinem Interesses sein.

Liebe admin,

ich möchte auf die Arbeit von A. Watts hinweisen, die auch auf WUWT abrufbar ist. Danach ist der Temperaturanstieg für die USA nach NOAA doppelt so hoch wie für die guten Wetterstationen in den USA (siehe das Projekt Wetterstationen von A. Watts). Und damit jetzt keiner von unseren speziellen AGWlern auf die BEST-Studie hinweist. diese ist bis heute noch in keinem Journal erschienen und soweit ich gelesen habe von R. Mckytric als Reviewer abgelehnt worden als nicht geeignet zur Veröffentlichung.

MfG

H. Urbahn

Zwei Medienmeldungen von Mai 2012 in der Südwestpresse:

1) „Der Frühling war 2,1 Grad zu warm und brach im April viele Temperaturrekorde“

2)“Die Spargelernte fällt wegen der Aprilkälte diesmal geringer aus“.

Meldung 1 kommt DWD als Ergebnis seiner Messstationen, die vorwiegend in den Wärmeinseln stehen. Meldung 2: die Spargelfelder liegen nicht neben der Kirche, sondern in der freien Fläche.

Es gibt bezüglich den Messungen ein Einfluss durch die Biologie des Gebietes.

Im Regenwald beträgt der Tag-Nacht-Unterschied 10 Grad C, in der Wüste fast 40 Grad. Wenn der Wald einem Feld weichen muss, gibt es schon andere Temperaturunterschiede, die von den Wetterstationen nicht beachtet werden.

@ NicoBaecker #25

„Nur Zahlen zählen, alles andere ist substanzloses Spekulieren.“

Dann aber ganz schnell ran an Speck. Die Quelle habe ich genannt, die Daten gibt es gratis. Nehmen Appanoose county in Iowa und homogenisieren Sie die Daten der Station Centerville anhand der Daten der angrenzenden Counties. Die Station mit der COOP-Stationsnummer 131354 existiert bereits seit 1915.

Sowas muß doch für Sie ein Leckerbissen sein, um Ihre überragenden Fähigkeiten (Ihre Ansicht) im Fach Meteorologie zu demonstrieren.

@ V. Venema #19

Ich habe Ihnen rein willkürlich eine Station in Iowa herausgesucht, deren Metadaten einschließlich Karte und Satellitenbild Sie hier finden können:

http://tinyurl.com/btby5tr

Die Stationsnummer COOP ist 130112 und der Name ist Albia in Monroe County.

Seit mindestens 1948 liefert sie Daten und ist zweimal umgezogen.

Im Nachbarcounty Appanoose gibt es dann zwei Stationen in Centerville, an der man ggfs. mal den UHI-Effekt incl. Fluhafen prüfen kann. Stationsnummer ist 131354.

Die Station ist übrigens diverse Mal umgezogen.

Sie werden unter dieser Seite alle Stationen des COOP-Systems abrufen und einsehen können. Die Software ist etwas gewöhnngsbedürftig, aber die Metadaten brauchbar, um Stationen zu überprüfen. In manchen Counties gibt es auch noch mehr Stationen. Die Temperaturreihen aller COOP-Stationen können Sie hier herunterladen: http://tinyurl.com/ck7gqt3

Irgendwo gibt es da noch ein komplettes Stationsinventory aller Stationen mit Angaben von wann bis wann die Stationen wo existiert haben, welches Equipment benutzt wurde … .

Ohne zuverlässige Referenzstation(en) der Nähe ist eine Homogenisierung m.E. nicht möglich.

Deshalb halte ich die Methode Rohdaten zu verwenden und möglichst alle Stationen zu involvieren, für die bessere, wenn eine Vielzahl von Stationen existiert, wie z.B. in Iowa mehr als 100 braucbare Stationen. Wer dann irgendwelche Anomalien finden will, sollte jährliche Isothermen zeichnen. Da kann man eine Menge draus erkennen, ob sich bei einer Station was signifikannt geändert hat.

Lieber Herr Limburg,

koennen Sie nun Ihre Behauptungen mit Sparks et al. oder anderen Arbeiten beweisen?

Sehr geehrter Herr Limburg, wenn ich mich mal kurz in die Diskussion mit NicoBaecker reinhänge:

„Nochmals wiederholt: Der Fehler löscht sich doch nur dann aus, wenn diese Bedingung, die sie oben implizit aufgestellt haben, bei allen Messungen an einer nur gleichnamigen – aber sonst beliebig veränderten- Station, erfüllt ist. Wenn nicht, und das ist die Regel, dann nicht. Sollte es anders sein, muss das für jede Station bewiesen werden.“

Man kann den Effekt rein mathematisch aufschreiben. Wie verändern sich die Varianzen bei der Summe aus zwei Zufallszahlen?

Var(a+b)= Var(a)+Var(b)+2*Cov(a,b)

Bei der Differenz ist es analog:

Var(a-b)= Var(a+(-b))= Var(a)+Var(-b)+2*Cov(a,-b)= Var(a)+Var(b)-2*Cov(a,b)

Damit dürfte auch klar sein, wann sich Fehler vergrößern und wenn sie sich reduzieren.

Hallo Herr Limburg,

#22: „Wie schon so oft erwähnt, das klingt plausibel, ist aber nur unter einer einzigen Voraussetzung gültig: Der Fehler muss dazu in Richtung und Größe bei jeder Messung identisch sein. Das ist er aber bei den Langzeitreihen und den vorgegebenen Messumständen so gut wie nie!“

Wenn die beiden Fehler in Betrag und Richtung nicht identisch sind sondern nur ähnlich, dann reduziert sich der Fehler entsprechend weniger. Je nach Ausprägung der Fehler kann es eine Auslöschung bis hin zum kompletten Aufaddieren der Fehler kommen. Logisch.

„Oder meinen Sie, dass die Tagesmittel die 1920 bestimmt wurden, unter denselben Bedingungen gemessen wurden, wie die Tagesmittel der (nur) gleichnamigen – sonst aber anderen- Station an jedem Tag von 1961 bis 1990?“

Nein, das habe ich auch nicht behauptet. Gerade weil die Meßbedingungen 1920 in der Regel andere sein können als 1961-90, ist eine Homogenisierung der Daten sinnvoll. Ich bezog mich darauf, dass man pauschal da keine Antworten liefern kann, sondern immer genau hinschauen muss, wie die Meßfehler verteilt sind und wie statistisch unabhängig diese Fehler zueinander sind (Stichwort Kovarianz).

„Bei der grundsätzlichen Betrachtung kommt es in diesem Zusammenhang nicht auf die Verteilung an. Wenn ich eine Temperatur von 50 °F auf 1 °F genau messe, dann ist der Fehler eben ± 0,5 °F. Ziehe ich von den 50 °F den nächsten Wert von 48 °F ab, wieder mit ± 0,5 °F bestimmt, dann bleiben 2 °F ± 0,5 °F übrig.“

Da muss ich Ihnen leider widersprechen. Solange man keine Angabe macht, wie die beiden Fehler miteinander gekoppelt sind, kann man auch nicht sagen, wie sich der Fehler bei der Subtraktion auswirkt. Angenommen die beiden Fehler sind statistisch unabhängig voneinander, dann addieren sich die Varianzen auf. Sind sie es nicht, dann spielt die Kovarianz der beiden Fehler mit rein und kann je nachdem eine verstärkung oder eine Reduzierung des ursprünglichen Fehlers führen.

„D.h. der Fehler wird ist jetzt ± 1/4 der Differenz, zuvor lag er bei 1/100 des Wertes. Sein Gewicht hat sich unzweifelhaft vergrößert, hier auf das 25 fache.“

Ohh, ohh. Sie machen es jetzt Herrn Leistenschneider nach. Sie bilden Temperaturquotienten und beachten gar nicht, dass das Ergebnis von der verwendeten Einheit abhängt (°C, °F, K,…). Bei Fahrenheit liegt der Nullwert nicht am thermischen Nullpunkt sondern bei 255,37 Kelvin. Angenommen Sie hätten nicht 50°F und 48°F genommen, sondern 2°F und 0°F, dann bekommen Sie mit dem Temperaturquotienten Riesenwerte heraus.

„Zur Homogeniserung: Wie schon oft erwähnt, beschränkt sich diese Homogenisierung wg. des Riesenaufwandes auf wenige Gebiete und kurzen Zeiten an wenigen Stationen. Ob das Ergebnis stimmt könnte man wieder nur mit Kontrollversuchen unter sonst gleichen Bedingungen erfahren. Das geht aber nicht.“

Warum sollte das nicht gehen? Ich weiss im Einzelnen nicht, wie man für gewöhnlich die Daten konkret homogenisiert. Aber diese Kontrollversuche könnte man durch eine Dreiteilung der Meßstationen bekommen. Beim Einlernen von adaptiven Systemen zum Beispiel behilft man sich damit, dass man einen Teil der Daten zum Einlernen benutzt, einen Teil zum validieren, um die Parameter und Koeffizienten zu optimieren und den letzten Teil um zu testen, ob das System auch mit bisher unbekannten Daten zurechtkommt. Man könnte also auch hier die Meßstationen in drei Gruppen einteilen. Die erste Gruppe sind Referenzstationen, die zweite Gruppe sind die Stationen, die man homogieren will und die dritte Gruppe wäre dann die, mit der man die Homogenisierung testet. Zumindestens so könnte man es mal probieren. Welche Techniken tatsächlich verwendet werden, weiss ich nicht.

„Und damit besteht die Gefahr, dass die Kontrollstation der „kontaminierten“ Station ihr Signal aufprägt, dieses also zerstört. Also das, was man eigentlich bestimmen wollte.“

Klar, die Gefahr besteht, genauso wie man mit Techniken der Rauschreduzierung wieder andere Artefakte reinbekommen kann oder das eigentliche Signal reduziert. Hat ja auch keiner gesagt, dass sowas immer von Erfolg gekrönt sein muss. ;o)

„Ich muss aber zugeben, dass ich – außer der ehrlichen Angabe wesentlich breiterer Unsicherheitsbänder bei den globalen Temperaturgängen- auch keine bessere Methode kenne.“

Kein Problem. Das Internet ist ja dazu da, mehr zu erfahren, als man selbst weiss.

Lieber Herr Limburg,

Kommentar:

„Daran zweifelt doch niemand. “

ok, ich nagelere Sie das nächste mal darauf fest.

„Der Fehler löscht sich doch nur dann aus, wenn diese Bedingung, die sie oben implizit aufgestellt haben, bei allen Messungen an einer nur gleichnamigen – aber sonst beliebig veränderten- Station, erfüllt ist.“

Auch klar. Daher ist ja auch das Homogenisieren notwendig. Das ist nicht fehlerfrei, aber wenn Sie meinen, dass die dabei angegebenn Fehler falsch oder zu klein sind, so geben Sie Ihre Resultate an. Behauptungen alleine helfen da nichts. Sie müssen einfach Daten liefern.

„Ich zitiere dazu [Köppen, 1913]:

Die Aufgabe, eine allgemeine, einheitliche Aufstellung der Thermometer zu schaffen, die wenigstens die mehrjährigen Mittel der Lufttemperatur für alle Termine mit einer Genauigkeit von 0,1 oder auch 0.2°, ohne systematische Fehler, liefern würde, ist noch nicht gelöst.“

Das war 1913 Köppens Einschätzung.

„[SPARKS, 1972] in seiner sehr umfassenden Untersuchung von 1972 feststellt. Andere Autoren nach ihm wiederholen dies ebenso.“

Zitieren Sie bitte, wie groß die Fehler sind, die diese Autoren für die Angabe eines Jahresmittels von Stationen abschätzen. Nur Zahlen zählen, alles andere ist substanzloses Spekulieren.

Lieber Herr Limburg, #21 Kommentar:

„Das ist richtig. Jedoch, wie schon erwähnt, ist die Fehlerreduktionsfähigkeit der Anomalienbildung ein weit verbreiteter Irrglaube“

Immerhin fallen bei der Anomalie, wenn sie durch Abzug des Instrumentenmittels gebildet wurde, konstante systematische Fehler fort.

„Zudem wird durch die Differenzenbildung der jeweilige absolute Fehler bezogen auf die (nun kleine) Differenz schlicht größer, sein Gewicht damit deutlich höher. „

Sie meinen den relativen Fehler? Wenn ich einen Fehler von 0,5 °C bei einem Mittelwert der absoluten Temperatur von 10°C habe, die Anomalie aber auf 8°C bezogen wird und somit 2 °C beträgt, wäre der relative Fehler der absoluten Temperatur 0,5/10 = 0,05, der relative Fehler in der Anomalie aber 0,5/2 = 0,25 also 5x größer?

Haben Sie schon mal in der meteorologischen Fachliteratur einen Autoren gesehen, der einen Temperaturfehler auf der Celsiusskala relativ angegeben hat?

Ich nicht!

Und der Grund ist einfach, weil ein relativer Fehler auf einer Celsiusskala sowieso sinnlos ist. Sinn macht der nur auf der Kelvin-Skala, wo eben die Null auch physikalisch das Ende der Temperatur ist.

Lieber Herr Limburg,

„Denn Änderungen oder Anomalien folgen genauso wie alle anderen gekoppelten Daten, den Regeln der Metrologie und der Fehlerfortpflanzung. Insofern ist der weit verbreitete Glaube an die Fehlerkompensationsfähigkeit der Anomalienbildung ein – wenn auch weitverbreiteter- Irrglaube.“

Anomalien sind gegenüber der Orographie unempfindlicher als absolute Temperaturen. Daher ist aus diesen einfacher und genauer ein globales Mittel zu bilden. Das hat natürlich auch etwas mit Fehlerechnung zu tun, im wesentlichen bei der Fehlerrechnung für die Kartierungsinterpolation.

Lieber Herr Limburg,

„Das geht aber auch nur hinreichend genau, wenn man die Absolutwerte genau genug bestimmen kann. Und das kann man eben nicht.“

Gegenbespiel: eine Temperaturskala in einem Thermometer ist um einne konstanten Wert verschoben. Ein systematischer Fehler liegt also vor, der durch ein Vergleichsinstrument entdeckt werden könnte. Die Anomalien der beiden Instrumente (andere Fehler ausgeschlossen) wären dennoch identische Messwerte.

#20: „“Man möchte nur die Temperaturänderung bestimmen.“

Das geht aber auch nur hinreichend genau, wenn man die Absolutwerte genau genug bestimmen kann. Und das kann man eben nicht.“

Warum Herr Limburg? Wenn es sich um eine Wetterstation mit einem systematischen Fehler handelt, können Sie die Temperaturanomalie besser ermitteln als die absoluten Temperaturen. Das jeweilige Offset subtrahiert sich raus.

„Denn Änderungen oder Anomalien folgen genauso wie alle anderen gekoppelten Daten, den Regeln der Metrologie und der Fehlerfortpflanzung.“

Bei der Fehlerfortpflanzung setzt man die entsprechenden Fehlerwerte ein. Wenn Sie wissen, dass man eine fehlerhafte Meßstation hat, die einen systematischen Fehler besitzt, der über die Zeit konstant bleibt, dann fällt der nach der Subtraktion, die zur Anomaliebildung herangezogen wird, weg. Systematische Fehler können sein, falsche Bodenhöhe, falsche Stationsbehausung, falsche Uhrzeiten zur Messung usw. Diese Fehler sind bei Temperaturdifferenzen weniger kritisch als für die Bestimmung des absoluten Wertes. Ähnliches kennt man auch aus der Längenmessung. Da ist es auch einfacher und genauer Streckendifferenzen zu messen als absolute Strecken.

#21: „Jedoch, wie schon erwähnt, ist die Fehlerreduktionsfähigkeit der Anomalienbildung ein weit verbreiteter Irrglaube und gilt nur für sehr wenige eng begrenzte Fälle. Und so gut wie nie für Zeitreihen, in denen die Fehler während der Beobachtungsdauer auftreten. Was fast immer der Fall ist. Darüber habe ich schon mal berichtet.“

Genau aus dem Grund wird ja Temperaturhomogenisierung betrieben, weil Meßfehler sich über die Zeit ändern können. Dann kann man den Fehler entsprechend kleiner gestalten. Das ist auch der Grund warum ich nicht verstehe, dass laut Paper die Temperaturdifferenzen vor und nach der Homogenisierung gleich sein sollen.

„Zudem wird durch die Differenzenbildung der jeweilige absolute Fehler bezogen auf die (nun kleine) Differenz schlicht größer, sein Gewicht damit deutlich höher.“

Pauschal ist das so nicht richtig. Es kommt auf die Verteilung des jeweiligen Fehlers an und ob die Fehlergrößen zueinander statistisch unabhängig ist. Ich weiss, das klingt wie Korinthenkackerei, aber mit diesen Feinheiten müssen sich Statistiker eben rumschlagen.

Michael Limburg, Sie haben recht der Text im Abstrakt ist etwas subtiler als vorher von mir dargestellt. Der Text in dem Vortrag suggeriert zumindest, dass es nur eine parallele Messung (in Kremsmünster) gegeben hat in der ganze Geschichte der Klimatologie:

„Homogenization results are usually not supported by metadata or experiments (a known exception in literature is the experiment at the Kremsmünster Monastery, Austria).“

Ich finde es schade, dass ich noch keine Ähnliche Aussage zu den offensichtlichsten Fehler in diesem Post gehört haben. Wenn das nicht mal möglich ist, ist eine produktive Diskussion hier wohl nicht möglich.

Was die Aussage Ihrer ersten Absatz (Auch wird das Problem … machen zu können) sein sollte verstehe ich nicht. Natürlich werden auch zeitlich hochaufgelösste Messungen gemacht die sehr hilfreich sind um die Unterschiede zwischen Messsystemen zu verstehen. Der erste solcher Messung die ich kenne sind Kreil (1854a und 1854b).

Die zweite und dritte Absatz gehen von der falsche Annahme aus, dass man versuchen wurde die mittlere globale Temperatur zu Messen. Das ist aber innerhalb einer Grad nicht möglich, vor allem mit den beschränkten alten Messungen nicht. Das Ziel der Homogenisierung ist bescheidener. Man möchte nur die Temperaturänderung bestimmen.

Thomas Heinzow, ich teile Ihre Meinung zu Agrarsprit zu 100%. Autos auf Lebensmittel fahren zu lassen ist ein Unding. Alles gute.

Kreil K, 1854a. Mehrjährige Beobachtungen in Wien vom Jahre 1775 bis 1850. Jahrbücher der k.k. Central-Anstalt für Meteorologie und Erdmagnetismus. I. Band – Jg 1848 und 1849, 35-74.

Kreil K, 1854b. Mehrjährige Beobachtungen in Mailand vom Jahre 1763 bis 1850. Jahrbücher der k.k. Central-Anstalt für Meteorologie und Erdmagnetismus. I. Band – Jg 1848 und 1849, 75-114.

Thomas Heinzow: „Richtig, aber man sollte es nicht unterlassen die alte Meßmethode parallel zur Neuen über mindestens zwei Jahre (besser zehn Jahre) weiter zu betreiben.“

Genau solche Studien sind sehr wichtig. Das es solche Studien nicht gibt, ist einer der falsche Behauptungen in dem Abstrakt von Steirou, und Koutsoyiannis. Ich habe hier unten einige gelistet. Ich glaube, alleine die Titel schon entkräften diese Behauptung ausreichend.

Der WMO Empfehlung ist es bei jede Änderung einige Jahren parallele Messungen zu machen, was leider nicht oft genug gemacht wird. Oft auch weil man nicht einige Jahren im voraus weiß, dass sich die Messbedingungen ändern.

Margary, I.D., 1924. A comparison of forty years’ observations of maximum and minimum temperatures as recorded in both screens at Camden Square, London. Q.J.R. Meteorol. Soc., 50:209-226 and 363.

Marriott, W., 1879. Thermometer exposure — wall versus Stevenson screens. QJ.R. Meteorol. Soc., 5:217-221.

Brandsma, Theo. Parallel air temperature measurements at the KNMI-terrain in De Bilt (the Netherlands) May 2003-April 2005, Interim report, 2004. http://wap.knmi.nl/onderzk/klimscen/papers/Hisklim7.pdf

Van der Meulen, J.P. and T. Brandsma. Thermometer screen intercomparison in De Bilt (The Netherlands), Part I: Understanding the weather-dependent temperature differences) Int. J. Climatol, 28, pp. 371-387, doi: 10.1002/joc.1531, 2008.

Nordli, P. Ø. et al. The effect of radiation screens on Nordic time series of mean temperature. International Journal of Climatology 17(15), doi: 10.1002/(SICI)1097-0088(199712)17:153.0.CO;2-D, pp. 1667-1681, 1997.

Böhm, R., P.D. Jones, J. Hiebl, D. Frank, M. Brunetti,· M. Maugeri. The early instrumental warm-bias: a solution for long central European temperature series 1760–2007. Climatic Change, 101, pp. 41–67, doi: 10.1007/s10584-009-9649-4, 2010.

Brunet, M. Asin, J. Sigró, J. Bañón, M. García, F. Aguilar, E. Palenzuela, J.E. Peterson, TC. Jones, PD. 2011. The minimisation of the “screen bias” from ancient Western Mediterranean air temperature records: an exploratory statistical analysis. Int. J. Climatol., 31: 1879-1895 DOI: 10.1002/joc.2192.

Parker, D.E. Effects of changing exposure of thermometers at land stations. Int. J. Climatol., 14, pp. 1–31, 1994.

@ V. Venema #16

Ich habe nichts gegen Homogenisierung, also Korrektur offensichtlicher systematischer Meßfehler aus den bekannten Gründen.

„Deswegen kenne ich mich inzwischen mit den Homogenisierungsverfahren einigermaßen aus und kann sagen, dass die Studie die in diesem Post beschrieben wird Fehler enthält einige davon sind auf meinem Blog beschrieben.“

Eine Homogenisierung aufgrund des UHI darf nie zu einer positiven Trenderhöhung führen. (Beispiel HH-Fuhlsbüttel oder Hamburg-St. Pauli, Station des ehrwürdigen Seewetteramtes und Reichsseewarte des Kaiserreichs)

Gibt es bestimmt auch in den Niederlanden.

„Sowohl das Artikel von der Amerikanische Wetterdienst als von Anthony Watts kommen zu der Folgerung, dass der Trend in der Mittlere Temperatur nach Homogenisierung nicht mehr von der Qualität der Stationen abhängig ist. “

Bei neben einer Klimaanlagenentlüftung, auf einem asphaltiertem Parkplatz oder direkt neben einem Haus platzierten Meßeinrichtung, bin ich anderer Ansicht.

„Wenn Sie sich stark machen möchten für mehr und bessere Klimastationen und eine verstärkte Digitalisierung alter Klimadaten finden Sie die Klimatologen an Ihre Seite. Am Moment wird das Messnetz sogar von der Politik abgebaut. Bitte schreiben sie ihre Bundestagsabgeordnete.“

Das ist wegen deren Beratungsresistenz leider sinnlos.

Danke für die Quellen, ich werde Sie mir anschauen.

Das Grundproblem sind jedoch nicht die Landstationen, sondern die Messungen in den Polargebieten und den Ozeanen, wo es quasi keine Stationen mehr gibt. Früher gab es noch für den Flugverkehr stationäre Wetterschiffe auf den Ozeanen, jetzt gibt es die nicht mehr und damit keine repräsentativen kontinuierlichen standardisierten Messungen und Radiosondenaufstiege.

Aber das ist politisch so gewollt, denn je geringer das Wissen der Wissenschftler ist, desto mehr Spielraum bleibt für politische Glaubenssätze und das Primat der Politik zur Dominierung der Wissenschaften.

Es ist wissenschaftlich (zuletzt die Leopoldina) erwiesen, daß die Nutzung von aus Nutzpflanzen zur Ernährung der Menscheit (und des Viehs) gewonnener Alkohol zur Benzinbeimischung ökologisch schädlich ist und auch ökonomisch keinen Sinn macht und den Bürger belastet und netto Arbeitsplätze kostet.

Das hindert die Politiker trotzdem nicht daran, diejenigen, die sich dem E-10 bewußt aus ebendiesen Gründen verweigern, mit einer Strafsteuer zu belegen.

Alles Gute für Ihre Studie.

@ V. Venema #12

„Wenn einen ganzen Netzwerk dann nach und nach auf Wetterhütten mit einem besseren Strahlungsschutz umgestellt wird, wird man in den Rohdaten einen Temperaturabnahme sehen, diese ist aber ein Artefakt und sollte korrigiert werden.“

Richtig, aber man sollte es nicht unterlassen die alte Meßmethode parallel zur Neuen über mindestens zwei Jahre (besser zehn Jahre) weiter zu betreiben. Nur so läßt sich halbwegs sicher feststellen, welche tatsächlichen Auswirkungen der technische „Fortschritt“ in Abhängigkeit von Sonnenscheindauer, Wolkenlosigkeit und mittler Windgeschwindigkeit hat, um nur einige der relevanten Parameter zu nennen.

@Thomas Heinzow

Ich bin kein Klimatologe und kann ihre viele Fragen zu den Messstationen so nicht beantworten. Ich weiß aber als Holländer, dass auch Holländische Stationen im GHCN verwendet werden und das der DWD etwa Tausende Temperaturstationen betreut.

Die COST Action HOME hat mir gebeten ihre Homogenisierungsverfahren zu überprüfen weil ich kein Klimatologe bin. Deswegen kenne ich mich inzwischen mit den Homogenisierungsverfahren einigermaßen aus und kann sagen, dass die Studie die in diesem Post beschrieben wird Fehler enthält einige davon sind auf meinem Blog beschrieben. Und jeder der denken kann sollte sehen dass der Titel: „Die Hälfte der globalen Erwärmung kommt aus der Homogenisierung von Wetterstationsdaten“ nicht mal passt zu den Folgerungen der Studie, die nur wenn auch falscherweise behauptet, dass der Trend kleiner als 0.7 °C pro Jahrhundert ist, aber nirgendwo, dass es die Hälfte von 0.7 °C pro Jahrhundert ist.

Jeder hätte gerne bessere Klimadaten, aber Homogenisierung wird gerade gemacht um die Probleme die Sie beschreiben zu entfernen von den globalen Temperatur Trend. Sicherlich kennen sie die Webseite von Anthony Watts, surfacetemperature.org, wo er die Qualität der Amerikanische Messstationen beurteilt hat. Sowohl das Artikel von der Amerikanische Wetterdienst als von Anthony Watts kommen zu der Folgerung, dass der Trend in der Mittlere Temperatur nach Homogenisierung nicht mehr von der Qualität der Stationen abhängig ist.

Wenn Sie sich stark machen möchten für mehr und bessere Klimastationen und eine verstärkte Digitalisierung alter Klimadaten finden Sie die Klimatologen an Ihre Seite. Am Moment wird das Messnetz sogar von der Politik abgebaut. Bitte schreiben sie ihre Bundestagsabgeordnete.

Title: On the reliability of the US surface temperature record

Author(s): Menne Matthew J.; Williams Claude N. Jr.; Palecki Michael A.

Source: JOURNAL OF GEOPHYSICAL RESEARCH-ATMOSPHERES Volume: 115 Article Number: D11108 DOI: 10.1029/2009JD013094 Published: JUN 8 2010

Title: Analysis of the impacts of station exposure on the US Historical Climatology Network temperatures and temperature trends

Author(s): Fall Souleymane; Watts Anthony; Nielsen-Gammon John; et al.

Source: JOURNAL OF GEOPHYSICAL RESEARCH-ATMOSPHERES Volume: 116 Article Number: D14120 DOI: 10.1029/2010JD015146 Published: JUL 30 2011

@ V. Venema #12

Sehr geehrter Herr Venema,

ich habe die die vier norddeutschen Stationen (Lübeck eingeschlossen) genannt, weil ich sie alle persönlich kenne. Schleswig, Schleswig Jagel und HH-Fuhlsbüttel sind Teil des GHCN. Es macht m.E. keinen Sinn zwei Stationen in die Berechnung aufzunehmen, die nur wenige Kilometer voneinander entfernt sind, außer man möchte Homogenisierung betreiben und bestimmte Effekte bestimmen, die sich aus der geographischen Lage ergeben, wie z.B. den Seewindeinfluß der Schlei auf Schleswig-Stadt.

„auch weitere Stationen in Deutschland sind durchaus noch brauchbar, wie auch Stationen in Holland, Dänemark und vielleicht sogar Schweden.“

Ja, aber die findet man nicht in der GHCN-Liste.

„Der Deutscher Wetterdienst hat viel mehr Stationen und kann damit eine wesentlich bessere Qualität erreichen“

Leider nicht, denn im Freiwilligennetz gibt es m.W. keine kontinuierlichen Stationsmessungen über mehr als fünf Jahrzehnte.

Die technische Ablesegenauigkeit eines Thermometers ist nur dann irrelevant, wenn eine Normalverteilung der Abweichungen gegeben ist. Die ist aber bei menschlichen Ablesern eines Min-Max-Thermometers nicht gegeben. Allerdings dürften sich diese Fehler bei 91 Stationen, wie ich sie in Iowa genutzt habe, in etwa aufheben.

„Auch wenn die mittlere globale Temperatur zunimmt kann es in einzelne Regionen zu zu Temperaturabnahmen kommen, zum Beispiel durch eine Änderung der Zirkulation.“ Das bestreitet niemand, aber die Änderung der Zirkulation betrifft auch die Nachbargebiete, wobei die Zirkulationsänderung erst einmal zu beweisen ist.

Die Essenz aus Ihrem zutreffenden Einwand ist jedoch: Lokale Extrema oder Anomalien beweisen nichts, sofern nicht deren Ursache genau festgestellt wurde.

Im Fall der Station HH-Fuhlsbüttel ist die Ursache der Erwärmung dingfest gemacht: Die Stadt ist drumrum gewachsen und der Flughafen hat weitere Flächen asphaltiert und betoniert.

Was hat also die Station HH-Fuhlsbüttel im GHCN zu suchen?

Sie können sich die Stationen und Stationsdaten des GHCN und COOP hier ansehen:

http://tinyurl.com/2eg5r5

Sie werden dann sehen – es gibt da eine Satellitenbildfunktion -, wie schlecht so manche (die überwiegende Zahl) Wetterhütte aufgestellt wurde, die Sie homogenisieren wollen oder sollen.

Schauen Sie sich mal die DWD-Station Bremerhaven Doppelschleuse an. Ist die repräsentativ für die Umgebung? Kann man die homogenisieren?

Hallo Herr #12: Victor Venema ,

wir warten alle noch gespannt auf die versprochenen „Strohmann-Argumente“

mfG

Die eine Hälfte der Erwärmung kommt von der falschen Homogenisierung, die andere kommt von den großflächig geschaffenen Wärmeinseln in den letzten 130 jahren, wo inzwischen alle Messstationen stehen. Damit bleibt für eine eigentliche Klimaerwärmung nichts mehr übrig. Das zeigt uns auch das über 200 Jahre alte Mailied: Komm lieber Mai und mache die Bäume wieder grün oder das Märzlied: Im Märzen der Bauer die Rößlein einspannt. Die Rösser sind inzwischen Traktoren, aber der März als Saatmonat ist geblieben. Die behauptete Klimaerwärmung fand nur bei neuen wärmeren Messstandorten und in den Computern statt. Aber so läuft das immer, wenn vermeintliche Wissenschaftler alle Arbeit am Schreibtisch erledigen, fanatisch kurvengläubig sind und die Realität der Natur nicht mehr sehen. Die C02-Erwärmungsverkünder sind wissenschaftliche Dilettanten.

Herr U. Langer hat eine Wikipedia-Seite zu Strohmann-Argumente verlinkt. Sehr passend dazu lieft er 3 Strohmann-Argumente und ein Meta-Strohmann-Argument. Jeder der mein Post ließt, wird folgern, dass seine Darstellung des Inhaltes nicht stimmt.

Thomas Heinzow spricht ein wichtiger Problem an, man braucht genug Stationen um eine gute Qualität zu erreichen. Ich bin kein Klimatologe und habe mich den GHCN Datensatz noch nicht angeschaut. Drei Stationen in Nord Deutschland sind wenig, es gibt aber keine Notwendigkeit sich auf Nord Deutschland zu beschränken, auch weitere Stationen in Deutschland sind durchaus noch brauchbar, wie auch Stationen in Holland, Dänemark und vielleicht sogar Schweden.

Der Deutscher Wetterdienst hat viel mehr Stationen und kann damit eine wesentlich bessere Qualität erreichen auch ist viel Meta-Data nur auf Deutsch verfügbar (wann Stationen umgezogen sind, wann Instrumente ausgetauscht wurden, usw.). Früher hat der CRU Datensatz deswegen Daten benutzt die von den Nationalen Wetterdienste homogenisiert waren. Mit diesen besseren Daten hatten die Klima-Skeptiker aber auch wieder Probleme, weil sie den Rohdaten und Algorithmen nachprüfen möchten.

Mit dem Urban Heat Island Effekt habe ich mich noch nicht beschäftigt. Dazu gibt es eine sehr große Literatur, die ich noch kaum gelesen habe. Ich weiß nur, dass meine Kollegen Klimatologen sich wundern und viele andere Inhomogenitäten als eigentlich viel wichtiger sehen.

Das die Temperatur nur in Fahrenheit abgelesen wird ist kein Problem, wie S. Hader auch schon erklärt. Ein Würfel wird auch nur in ganze Einheiten abgelesen, aber es lässt sich natürlich trotzdem bestimmen ob ein Würfel gezinkt ist und der Durchschnitt zum Beispiel 3.75 ist.

Auch wenn die mittlere globale Temperatur zunimmt kann es in einzelne Regionen zu zu Temperaturabnahmen kommen, zum Beispiel durch eine Änderung der Zirkulation.

@S. Hader. Sie haben Recht, die Studie nennt keine Gründe warum eine 50:50 Verteilung notwendig ist. Und diese Annahme ist auch einfach falsch aus dem von Ihnen genannten Gründen.

@Emil Thomas. Es ist sehr wohl möglich ist, dass in einer ganzen Region mit mehreren Stationen der Trend sich ändert. Eine Änderung von einem negativen Trend auf eine Positivem ist davon nur einem Beispiel. Das wichtigste Beispiel ist, dass früher die Temperatur zu hoch gemessen waren weil sie nicht ausreichend gegen Strahlung (Sonne und Wärme) geschützt waren (Böhm et al., 2010). Wenn einen ganzen Netzwerk dann nach und nach auf Wetterhütten mit einem besseren Strahlungsschutz umgestellt wird, wird man in den Rohdaten einen Temperaturabnahme sehen, diese ist aber ein Artefakt und sollte korrigiert werden.

Böhm, R., P.D. Jones, J. Hiebl, D. Frank, M. Brunetti,· M. Maugeri. The early instrumental warm-bias: a solution for long central European temperature series 1760–2007. Climatic Change, 101, pp. 41–67, doi: 10.1007/s10584-009-9649-4, 2010.

#1: Th. Hahn sagt:am Dienstag, 24.07.2012, 14:26

Wie sagte doch schon der „Weltmann und Politiker“ Winston Churchill: Traue keiner Statistik, die Du nicht selbst gefälscht hast.

########## ##########

Ist zwar off topic, dennoch eine keine Anmerkung.

Sie unterliegen hier wohl einem urban myth:

Der Spruch ist nicht von Churchill, sondern wahrscheinlich vom Propagandaminister seines Deutschen Gegenspielers in den frühen 40er Jahre des vergangenen Jahrhunderts.

Eines kann trotz aller Homogenisierungen nicht sein: Dass eine ganze Region mit mehreren Stationen und verschiedenen Messinstrumenten von einem zuvor negativen zu einem nachher positiven Trend wechselt.

Da muss was falsch laufen!

„Neue Studie: Die Hälfte der globalen Erwärmung kommt aus der Homogenisierung von Wetterstationsdaten“

==========================================

Das ist aber zu wenig gesagt. Die ganzen Berechnungen der „globalen Erwärmung“ haben mit echter Wissenschaft extrem wenig zu tun. Man muss sich nur ihre ganzen Methoden anschauen, für die es anscheinend keine Wissenschaftliche Begründung gibt.

#5: „Der schlechteste (ungenaueste Meßwert) bestimmt hierbei die Genauigkeit des Endergebnisses z.B. bei Mittelwert oder Trendberechungen.

Um eine Genaugkeit von einer Kommastelle auszuweisen ist es erforderlich die Rohdaten mindestens mit 2 Nachkommastellen zu erfassen und zu verrechnen. Von wiederkehrender Kalibrierung der Messgeräte ganz zu schweigen.“

Sehr geehrte(r) F.Westerbarkey, das ist nicht zwingend notwendig, wenn Sie den Mittelwert aller Meßwerte bestimmen wollen. Es hängt stark von der Art und Verteilung der Meßfehler ab. Wenn diese unabhängig voneinander mittelwertfrei verteilt sind, dann kann man mit einer entsprechend hohen Anzahl von Meßgeräten sich beliebig nahe dem wahren Meßwert annähern. Anders sieht es schon aus, wenn die Meßfehler nicht unabhängig voneinander und/oder nicht mittelwertfrei sind. Dann wird durch die Mittelung immer noch ein systematischer Restfehler übrig bleiben. Allerdings kann man evtl. noch ziemlich gut Temperaturanomalien bestimmen.

Ein wesentliches Problem ist, dass unkorrigierte Rohdaten über einen längeren Zeitraum nicht mehr genau das messen, was sie am Anfang messen sollten. Randbedingungen ändern sich, selbst die Bebauung um die Stationen haben ihren Einfluß. Die Homogenisierung der Daten ist schon notwendig. Allerdings verstehe ich nicht, warum man laut dem Paper von einer 50:50-Verteilung der Trendänderung ausgehen muss. Wenn die systematischen Fehler vor der Homogenisierung eher zu falsch hohen Messwerten in der Vergangenheit geführt haben, dann muss nicht zwangsläufig eine 50:50-Verteilung rauskommen. Zu behaupten, der Temperaturanstieg aus den unkorrigerten Daten müsse genauso hoch sein, wie der korrigierten Daten, ist schon etwas absurd.

Was ich bei meinen bisherigen Recherchen herausgelesen habe, ist eine hohe Relevanz der Homogenisierungsmethoden. Das kennt man auch aus anderen Fachgebieten, die Normierung der Daten ist nicht unwesentlich und kann die Qualität der Aussagen mitentscheiden. In dem Zusammenhang wäre es doch mal wünschenswert, wenn man hier einen Artikel über den Stand der Technik der Homogenisierungsmethoden bringen würde. Es gab schon vielerlei Kritik an den Methoden, ohne diese konkret zu nennen. Ich finde schon, man sollte zumindestens kennen, was man kritisiert. :o) Die Ausführungen im Artikel mit dem Beispiel der Wasserqualität ist da noch recht oberflächlich. Homogenisierung mit Glättung gleichzusetzen ist zudem irreführend. Also wann gibt es einen entsprechenden ausführlichen Artikel zu dem Thema? (Oder gab es den schon?)

MfG

S.Hader

Sehr geehrter Herr Verema,

ich zitiere Sie indirekt: „Die allmähliche Veränderung der Stationsumgebung, die Verlegung von Stationen und Neuerungen in der Messtechnik verfälschen also die langjährigen Klimamessreihen. „Will man die tatsächliche Entwicklung des Klimas einschätzen, müssen diese nicht-klimatischen Effekte von den echten Klimasignalen getrennt werden“, sagt Dr. Venema. Hierzu werden die sehr kleinen Differenzen der Messreihen benachbarter Stationen ausgewertet“ (http://tinyurl.com/ca6kjxu).

Wer dann genau nachschaut findet drei Stationen in Norddeutschland, die seitens des GHCN verwendet werden, nämlich Schleswig-Stadt (Radiosondenstation des DWD), Schleswig-Jagel = Bundeswehrflugplatz und Hamburg-Fuhlsbüttel.

Bei HH-Fuhlsbüttel handelt es sich um eine Station, die langsam aber sicher von der Stadt umschlossen wurde und in deren Nähe umfangreiche Betonierungsarbeiten im Laufe der Zeit stattfanden. Damit ist diese Station als ungeeignet einzustufen, denn es gibt in der Nähe auch keine Referenzstationen, die es ermöglichen würden den Stadteffekt herauszurechnen. Der wämste Ort in S.-H. ist bei Ostwetterlagen meist Lübeck, denn die Wettermeßhütte steht direkt hinter dem Vorfeld und der schwarzen Landebahn.

Wer also die lokalen Effekte aufgrund von Urbanisierung oder Umzug einer Station herausrechnen will, benötigt präzise örtliche Kenntnisse.

Diese wurden m.W. jedoch nicht in Bezug auf die Stationen in Schleswig genutzt.

Persönlich halte ich z.B. zur Bestimmung der Mitteltemperaturänderungen in den USA für sinnvoll auf die Masse der Messungen zu vertrauen, die Fehler ausgleichen, denn es gibt nicht den Satz, daß Fehler nur in eine Richtung passieren.

Dementsprechend ergibt sich bei Auswertung der COOP-Daten eine Verringerung der Mitteltemperaturen im Cornbelt seit 1941 bis in die siebzieger Jahre und danach ein Anstieg bis 2010, der jedoch nicht dazu führte, daß die Mitteltemperaturen der jeweiligen Staaten die der 1940er Jahre überschritten haben.

Bei der in den USA üblichen Methode die Temperaturen auf 5/9 K (=1°F) genau zu messen (publizieren), erübrigt sich m.W. und m.E. jedwede nachträgliche Anpassung, es sei denn daß gravierende Fehler bei der Positionierung der Station vorliegen, wie z.B. Umzug in ein Klärwerk, neben den Auslaß einer Klimaanlage oder direkt auf einem Parkplatz.

91 Stationen in Iowa zeigen einen linearen negativen Temperaturtrend seit 1941 und 64 in Nebraska ebenfalls.

Wie erklären Sie diese Tatsache aufgrund der publizierten der Daten der NOAA bzw. COOP?

Sehr geehrter Herr Venema,

Sie haben als Gegenargumentation auf folgenden Artikel verlinkt:

http://tinyurl.com/73mlslr

Nur so einige Beispiele aus dem von Ihnen verlinkten Artikel:

– Es wird kritisiert, dass so kurze Artikel wie der hier behandelte für wissenschaftliche Aussagen ungeeignet sind! Im Endeffekt wird also ausgesagt, dass der Gehalt eines Artikels von der Länge abhängt!

– Aus der Kritik an der derzeitigen Praxis der Homogenisierung wird abgeleitet, dass die „Klimaskeptiker“ gegen Homogenisierung sind. Und aus dieser Verdrehung wird ihnen dann das Recht abgesprochen, Argumente gegen die vorherrschende Praxis der Homogenisierung zu äußern, weil sie an anderer Stelle der Meinung sind, dass der Wärmeinseleffekt stärker bei der Homogenisierung beachtet werden soll.

– Der Autor lehnt den Artikel ab, weil er auf wattsupwiththat.com erschienen ist. Er begründet seine Ablehnung damit, dass alle Artikel auf wattsupwiththat.com schwerwiegende Fehler enthalten, wobei er sich selbst als Kenner der Materie darstellt! Daraus schlussfolgert der Autor, dass Klimaskeptiker wenig Interesse an der Wahrheit hätten.

usw. usf.

Halten Sie Herr Venema als Klimawissenschaftler solche Art der Argumente für wissenschaftlich korrekt? Das geht wohl eher in diese Richtung: http://tinyurl.com/c3t3v2h

Haben Sie in dem von Ihnen verlinkten Artikel im Gegensatz zu obigen Beispielen auch Gegenargumente zum Thema gefunden, denen man Wissenschaftlichkeit bescheinigen könnte?

MfG

Als alter Messknecht fällt mir dazu nur der Spruch ein: Wer viel misst, misst viel Mist !

Temperaturdaten (wie auch Meßdaten im allgemeinen) sollten immer zusammen mit der Fehlertoleranz des Meßgerätes kommuniziert werden z.B. 20,1 (+/- 0,2).

Der schlechteste (ungenaueste Meßwert) bestimmt hierbei die Genauigkeit des Endergebnisses z.B. bei Mittelwert oder Trendberechungen.

Um eine Genaugkeit von einer Kommastelle auszuweisen ist es erforderlich die Rohdaten mindestens mit 2 Nachkommastellen zu erfassen und zu verrechnen. Von wiederkehrender Kalibrierung der Messgeräte ganz zu schweigen.

Ich arbeite als Wissenschaftler in Bonn an der Homogenisierung von Klimadaten und wurde gerne die andere Seite beleuchten:

http://tinyurl.com/73mlslr

Eine Zeitlinie der Blog Diskussion finden Sie unter:

http://tinyurl.com/dxf9zrf

Erwärmung? Ja wo ist sie denn?

Nimmt man die 201 COOP-Stationen für die Staaten Illinois,Indiana und Iowa, dem wichtigsten Futtergetreideanbaugebiet der Welt, die in den üblichen Grenzen fortlaufende fast flächendeckende Temperaturmessungen (Tmin, Tmax) abgeliefert haben, und bildet das jährliche arithmetrische Mittel ohne Flächengewichtung, ergibt sich für die Periode von 1941 bis 2010 ein Polinom mit folgenden Koeefizienten:

y = 2E-10×6 – 6E-08×5 + 6E-06×4 – 0,0002×3 + 0,0032×2 – 0,0512x + 11,366

Man kann natürlich auch ganz simpel eine linerae Regression vornehmen und kommt dann auf folgende Koeffizienten: -0,0069x + 10,867

Fazit:

Es ist also im Herzen des Cornbeltes der USA nicht wärmer geworden.

Interessanter ist jedoch die Niederschlagsänderung in dem Gebiet.

Für den Niederschlag ergeben sich dann folgende Koeffizienten:

y = -4E-11×6 + 4E-08×5 + 4E-06×4 – 0,0011×3 + 0,0688×2 – 1,5211x + 47,175

Wobei der Niederschlag in Inch angegeben ist und es sich um eine Mittelung des Niederschlags von Oktober bis September des nächsten Jahres handelt.

Was ist wichtiger für den Nutzpflanzenwuchs: Die Temperatur oder der Niederschlag?

Ich weiß gar nicht, was es an sorgfältig gemessenen Daten von Stationen, die einem bestimmten Standard entsprechen, zu homogenisieren geben könnte. Wenn Daten homogenisiert, also manipuliert werden, dann beweist das doch nur, daß die jeweilige Meßstation dem erforderlichen Standard nicht entspricht, oder daß nicht sorgfältig gemessen wurde. Für mich wird durch eine Manipulation der Meßdaten, wie immer man sie nennen und begründen mag, jegliche Glaubwürdigkeit zerstört. Meßdaten, die nicht einwandfrei gewonnen wurden, dürfen nicht verwendet werden.

Wie sagte doch schon der „Weltmann und Politiker“ Winston Churchill: Traue keiner Statistik, die Du nicht selbst gefälscht hast.

Vor mehr als 30 Jahren im Mathe- Fortgeschrittenen- Kursus hat unser Lehrer an der Tafel bewiesen, dass 3 gleich vier ist. Und das Ganze mit relativ wenig Rechenschritten. Ich vermute mal, seit dieser Zeit haben sich die Rechen“künste“ ein wenig verbessert, so dass Außenstehende das Ganze gar nicht mehr nachvollziehen können. Und das ist wahrscheinlich genau so gewollt, damit alles als „alternativlos“, aber auf jeden Fall vom Menschen verursacht und höchst gefährlich, dargestellt werden kann.

Wie ist doch noch mal der Sinnspruch des Englischen Hosenbandordens? Ein Schelm, wer Arges dabei denkt!