Das UBA behauptet in seiner jüngsten Broschüre „Und sie erwärmt sich doch“, dass sich Wetter und Klima so fundamental unterscheiden, dass die üblichen und akzeptierten Begrenzungen bei der Vorausberechnung zukünftiger Wetterentwicklungen bei der Berechnung von Klimaprognosen nicht gelten. Autor Dr. Rupert Reiger hat sich mit dieser Aussage beschäftigt und stellt fest. Sie ist falsch!

1) Aus:

“Und sie erwärmt sich doch – Was steckt hinter der Debatte um den Klimawandel?”

http://www.umweltdaten.de/publikationen/fpdf-l/4419.pdf

Die Kernaussage aus obigem Link:

Zum besseren Verständnis dieser Thematik gehen wir auf einen wesentlichen Unterschied zwischen Wettervorhersage und Klimamodellierung ein. Bei der modellgestützten Wettervorhersage wird von einem Anfangszustand mit Hilfe eines physikalischen Gleichungssystems schrittweise in die Zukunft gerechnet. Dabei müssen die meteorologischen Größen (wie beispielsweise Druck, Wind und Temperatur) zum Anfangszeitpunkt der Simulation sehr genau bestimmt werden. Denn bereits kleine Änderungen in diesem Anfangszustand der Atmosphäre können große Änderungen in der Vorhersage bewirken (Anmerkung: Das ist „deterministisches Chaos“).

…

Bei der Klimamodellierung ist die Herangehensweise anders:

Das Ergebnis von Klimasimulationen hängt weniger vom Anfangszustand der Atmosphäre, sondern vielmehr von den Randbedingungen im Simulationszeitraum ab. Zu den Randbedingungen zählen die zeitliche Entwicklung der atmosphärischen Konzentrationen von Treibhausgasen, die zeitliche Änderung der Solarstrahlung, die zeitliche Änderung der Beschaffenheit der Erdoberfläche und weiteren Faktoren. Diese Einflussfaktoren sind für die Zukunft meist nicht genau bekannt, aber sie können im Rahmen von Szenarien vorgegeben werden. Fachleute nutzen derartige Szenarien und rechnen dann mit den Klimamodellen verschiedene Fälle durch.

Ende des Zitats.

Zu dem eine kurze Erläuterung:

Wie kann man nun Chaos unter anderem definieren?

Man gibt einen Anfangszustand, im einfachsten Fall eine Zahl, z.B. einen Temperaturwert, in eine Formel ein und berechnet aus diesem Anfangszustand den nächsten.

Diesen nächsten gibt man nun in dieselbe Formel ein und berechnet den übernächsten, das nennt sich Iteration und das Ergebnis nennen wir Trajektorie. Und so iterieren wir weiter und generieren so eine Zahlenreihe, solange wir wollen. Meist macht man das mit einem gewissen Sinn unterlegt, wie die Berechnung von Temperaturreihen und obige Formel ist eben so gestrickt, dass sie das widerspiegelt.

Nun muss dabei nichts Schlimmes passieren, kann aber. Hier kommen die sensiblen Anfangsbedingungen ins Spiel, die Chaos kennzeichnen.

Ändert man obigen Startwert ein bisschen, sagen wir ein Millionstel ab, und iteriert ein zweites Mal, so laufen die Zahlen ein paar Iterationen ähnlich zum ersten Versuch, beginnen dann aber sehr schnell voneinander abzuweichen, bis die zwei Reihen nichts ähnliches mehr gemeinsam haben. Auf dem Rechner lassen sie beide Reihen wieder reproduzieren, sind also deterministisch, aber untereinander bleiben die zwei Zahlenreihen nach ein paar Iterationen nicht mehr vergleichbar. Übrigens, lässt man beide Zahlenreihen auf einem anderen Prozessor mit einer anderen internen Zahlenrepräsentation laufen, passt schon wieder nichts mehr.

Beim Wetter müssen wir nun diese eindimensionale Zahlenreihe auf drei Dimensionen erweitern, dargestellt durch ein dreidimensionales Gitter, das Raumelemente definiert. Und man schaut sich auf diesen nicht nur die Temperatur an sondern alles was beim Wetter eine Rolle spielt, wie Vektoren, die den Wind repräsentieren, usw., usw.

Doch der Einfachheit halber wieder zum eindimensionalen Fall: Kleinste Differenzen der Eingangswerte beginnen also plötzlich bei der Iteration auseinanderzulaufen und zwar tun sie das exponentiell, also maximal schnell. Genau diese „exponentielle Divergenz der Trajektorien“ definiert Chaos.

Für das Wetter heißt das, man kann es nur ein paar Tage vorausberechnen, dann ist Schluss und zwar total Schluss.

Übrigens, will man berechnete Werte und Messwerte anpassen, ist es oft gut möglich, die Parameter obiger Formel so zu fitten, dass Messwerte und berechnete Trajektorie passen … zurück in die Vergangenheit. Um ab heute in die Zukunft zu rechnen hilft das, natürlich unter der Annahme, dass das Model perfekt ist, genau … nix. Es hat sich nichts zu oben geändert.

Im Gegensatz tu einer weiteren Aussage aus obigem Link, Zitat: „Um die Wettervorhersage wesentlich präziser zu gestalten, bräuchten die Fachleute ein dichteres Beobachtungsnetz mit geringeren Abständen zwischen den Stationen“ hilft so eine Präzisierung der Eingangswerte auf Grund der exponentiellen Divergenz der Trajektorien nur minimal. Das heißt, macht man das Netz zehn Mal präziser, das heißt man hat 1000 mal mehr Raumelemente und auch 1000 mal mehr Messstationen und macht man auch die Messwerte zehn Mal präziser, so kann man in keinster Weise zehn Mal weiter in die Zukunft rechnen sonder sagen wir mal anstelle von fünf Tagen fünf Tage und ein paar Stunden.

Nun kann man sich noch überlegen: Wie schnell exponentiell laufen Trajektorien auseinander, oder wie groß ist der Exponent der exponentiellen Divergenz? Das kann man heraus rechnen durch Mittelung über eine begrenzte und vernünftige Anzahl der Iterationen, das ist der Lyapunov Exponent. Ist der positiv, explodiert die Divergenz exponentiell und es gibt Chaos.

Aus „Und sie erwärmt sich doch“ entnehmen wir nun, dass Wetter auf kurzen Zeitskalen (paar Tage) chaotisch ist, beim Klima macht das aber nichts, weil sich Chaos auf der Skala von Jahrhunderten bis Jahrhunderttausenden heraus mittelt, z.B. genauso wie man Mitteln kann oder Rauschen abschneiden kann, wie beim Rausch (oder noise) Knopf beim alten Analogradio. Darum kann man mit Randbedingungen arbeiten. Das ist nun nicht einsichtig.

Dazu:

2) Aus:

Weather, Chaos, and Climate Change

http://www.drroyspencer.com/2009/03/weather-chaos-and-climate-change/

Zitiert und übersetzt in Teilen aus obigem Link:

… es kann jedes auf kleinsten Raumskalen nicht durch Messung erfasste Wetter große Unterschiede in der Vorhersage des Wetters verursachen. Das ist das klassische Beispiel chaotischer, nicht-linearer Variabilität, die atmosphärischer Dynamik inhärent ist. …

Mathematisch gesagt ist das die sensitive Abhängigkeit von Anfangsbedingungen (sensitive dependence on initial conditions).

Im Gegensatz dazu sei die Vorhersage einer globalen Erwärmung möglich, da sie auf kleinen Änderungen der Regeln beruht, nach denen die Atmosphäre sich verhält. Das zusätzliche Kohlendioxid, das wir in die Atmosphäre abgeben, ändert den Treibhauseffekt etwas, was wiederum den Mittelwert des Wetters oder das Klima mehr oder weniger ändert. Mathematisch betrachtet ist das eine Änderung der Randbedingungen (change in boundary conditions).

…

Bei näherer Betrachtung musste ich erkennen, dass die zwei Arten der Variabilität – Wetter und Klima – überhaupt nicht so unterschiedlich sind. Der einzige wesentliche Unterschied zwischen beiden ist nur die Zeitskala.

So mag mancher argumentieren, dass die Variabilität der Klimas ein ebenfalls so gutes Beispiel für Chaos wie die Variabilität des Wetters ist. Mathematisch gesagt, die „sensitive Abhängigkeit von Anfangsbedingungen“ was wir mit Chaos assoziieren kann man genauso „sensitive Abhängigkeit von sich kontinuierlich ändernden Randbedingungen“ nennen. In der Tat unterscheidet die Natur nicht zwischen der Änderung von Anfangsbedingungen und Randbedingungen … es ist alles Wandel.

… Z.B. wird eine chaotische Änderung von Niederschlagsmustern im Pazifik dessen Salzgehalt ändern. Dies wird im Laufe der Zeit dann wiederum die Zirkulation des Wassers in die Tiefsee ändern, was wiederum über hundert Jahre als eine Änderung des Oberflächenwassers auftauchen wird und wiederum das Wetter beeinflussen wird.

Sind das Änderungen von Anfangsbedingungen oder Randbedingungen?

…

Die Klimaleute nehmen an, so etwas (Chaos) gibt es nicht in der Variabilität des Klimas … zumindest nicht auf Zeitskalen jenseits von zehn Jahren. In der Tat glauben sie, Chaos existiert nur beim Wetter, nicht beim Klima. Aber diese Sicht ist total willkürlich und es gibt eine Fülle an Hinweisen, dass dieses einfach falsch ist. Chaos existiert auf allen Zeitskalen.

3) Aus:

The Chaos theoretic argument that undermines Climate Change modelling

http://wattsupwiththat.com/2011/06/13/the-chaos-theoretic-argument-that-undermines-climate-change-modelling/

Zitiert und übersetzt in Teilen aus obigem Link:

Das Argument, welches Gläubige in den Klimawandel benutzen ist, dass wir das Chaos (des Wetters) wie Rauschen (noise) behandeln können, also raus mitteln können.

…

Es gibt hierzu viele Beispiele aus der Elektronik und anderen Bereichen. Es ist verständlich, dass Klimamodellierer hoffen, dass das auch für Chaos gilt. In der Tat, sie behaupten, dass das geht so.

…

Also, kann man Chaos heraus mitteln? Wenn ja, dann müssten wir erwarten, dass Langzeitmessungen des Wetters kein Chaos zeigen.

…

Als ein Team italienischer Forscher mich fragte, meine Chaosanalysis-Software auf eine Zeitreihe von über 500 Jahre gemittelter Wintertemperaturen anzuwenden ergab sich die Möglichkeit, dieses zu testen.

…

(Das Ergebnis ist) um es umgangssprachlich auszudrücken, der gemessene Lyapunov Exponent war 2.28 Bits pro Jahr. Der Fehler einer Temperaturvorhersage vervierfacht sich jährlich. Was bedeutet das? Chaos mittelt sich nicht raus. Wetter ist auch auf der Skala von hunderten von Jahren chaotisch.

…

So, um zusammenzufassen, Klimaforscher haben Modelle auf der Basis ihres Verständnisses von Klima konstruiert, die man anpassen, kalibrieren kann; sie bestätigen ihre Modelle indem sie auf sehr lange Zeitskalen schauen, aber wir wissen, dass auch das Klima (nicht nur das Wetter) chaotisch ist. Sie wissen nicht, sind ihre Modelle zu einfach, zu komplex, oder genau richtig, denn auch wenn sie perfekt wären, wenn das Wetter auch auf diesen Zeitskalen chaotisch ist, können sie ihre Modelle nicht der echten Welt anpassen, denn der kleinste Fehler in den Anfangsbedingungen würde total andere Ergebnisse liefern.

Alles was sie sagen können ist:“Wir haben Modelle gebaut, welche wir bestens versucht haben an die reale Welt anzupassen (an die Vergangenheit mit den vielen Parametern gut anzufitten, die Vergangenheit gut zu reproduzieren), aber wir können nicht beweisen, dass sie richtig sind. Wir erkennen an, dass kleine Fehler in unseren Modellen wesentlich unterschiedliche Vorhersagen (im Unterschied zu oben jetzt in die Zukunft) machen und wir können nicht sagen ob wir Fehler haben oder nicht.“ In unseren Modellen“ scheinen die Verhältnisse, wie wir sie publiziert haben, richtig“.

Es ist meine Ansicht, dass Regierungspolitiker nicht auf der Basis dieser Modelle handeln sollen. Es besteht die Wahrscheinlichkeit, dass sie so viel Ähnlichkeit mit der echten Welt gemein haben wie The Sims, oder Half-life.

Eine abschließende Bemerkung, es gibt andere Wettervorhersagen, dass das Klima von der Variabilität der Sonnenstrahlung abhängt. (Das kann natürlich sein, aber) nichts bestätigt oder verneint diese Hypothese, denn Langzeitbeobachtungen der Sonnenflecken haben gezeigt, dass die Sonnenaktivität auch chaotisch ist.

4)

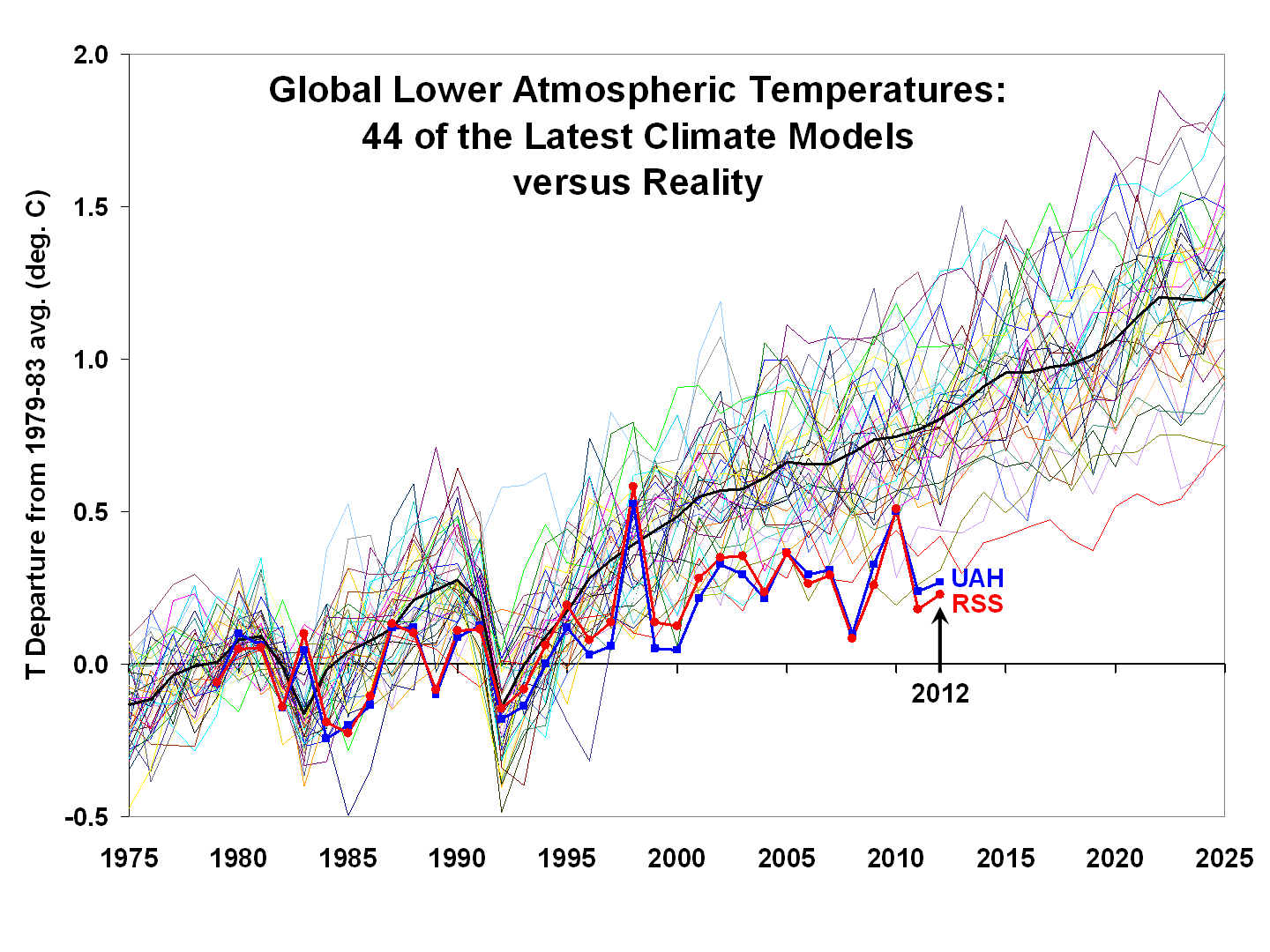

Zum prinzipiellen der Klimamodelle à la „Anpassen an die Vergangenheit ja, Prognose vorwärts nein“: Für diejenigen, die lesen können, Text hier:

http://www.drroyspencer.com/2013/04/global-warming-slowdown-the-view-from-space/

ansonsten Bild (s. oben rechts) hier:

http://www.drroyspencer.com/wp-content/uploads/CMIP5-global-LT-vs-UAH-and-RSS.png

Dr. Rupert Reiger arbeitet da in einem Forschungszentrum der Luft- und Raumfahrtindustrie an Software und Algorihmen.

Zuerst erschienen bei ACHGUT hier

Sehr geehrter Herr Baecker,

ich habe Ihren Rat befolgt und mich in der wissenschaftlichen Literatur umgesehen. Für die Datensätze, von denen Sie sprachen, habe ich aber nirgendwo eindeutige Nachweise gefunden. Und die „robusten Modelloutputs“ liegen halt einfach seit 15 Jahren zu hoch, so ist das nun mal.

Vielleicht können Sie mir auf die Sprünge helfen und mir ein Paper nennen, daß den eindeutigen Nachweis dafür erbringt, daß das „forcing“ des Kohlendioxids in der Atmosphäre wirklich zur Erhöhung der Globaltemperatur von 2 – 8 Grad innerhalb von 35 bis 80 Jahren führt, wie in vielen dieser Veröffentlichungen angegeben. Ich habe einen solchen Nachweis nämlich auch nach langem Suchen nicht gefunden. Eher ist es so, daß es eine Vielzahl von möglichen Erklärungen für den Verlauf der Globaltemperatur gibt, die nicht weniger plausibel sind als die Kohlendioxidkonzentration, und dem gegenwärtigen Verlauf wesentlich besser entsprechen.

Mit freundlichen Grüßen,

M. Stock

#97: Dr.Paul sagt am Freitag, 02.08.2013, 16:50

„Peter Georgiev (#4), Paul und andere sollten mal erklären, …“

Sie unterschlagen wieder das Wesentliche:

@ #85: Ebel sagt am Freitag, 12.07.2013, 08:59

„Die Bewegungsgleichungen der Gasteilchen sind gut bekannt – aber trotzdem sind die Bewegungen chaotisch.“

Die Chaoserscheinungen werden doch immer als Begründung vorgeschoben, warum das Klima nicht berechenbar ist – wieso gibt es dann Gasgesetze, wo doch die Molekülbewegegungen (analog Wetter) chaotisch sind.

Das Sie das nicht beaantworten können, wußte ich schon vorher:

@ #85: Ebel sagt am Freitag, 12.07.2013, 08:59

„Ich vermute, da kommen keine Erklärungen oder neuer Unsinn – weil nämlich Gasgesetze und Klima ähnliche Zusammenhänge mit dem Chaos haben.“

Und genau diese Vermutung haben Sie mit Ihrem Unsinn bestaätigt:

#97: Dr.Paul sagt am Freitag, 02.08.2013, 16:50

„Damit Treibhauskünstlern die Möglichkeit genommen wird,

von „isothermer Atmosphäre“ ohne sog. „Treibhausgase“ zu schwafeln.“

Paul ist eben schlauer als hervorragende Physiker – die eine Atmosphäre ohne Treibhausgase als isotherm erkennen.

MfG

#85: Ebel fragt:

„Peter Georgiev (#4), Paul und andere sollten mal erklären, wieso es Gasgesetze gibt (pV = mRT).“

Antwort:

Damit Treibhauskünstlern die Möglichkeit genommen wird,

von „isothermer Atmosphäre“ ohne sog. „Treibhausgase“ zu schwafeln.

mfG

@#95: Ebel,

Sie werden es wohl nie kapieren!

Hinsichtlich der Berechnung des Treibhauseffekts legt auch der IPCC ein „Schicht- oder Kaskadenmodell“ zugrunde. Nach diesem Modell findet innerhalb der Atmosphäre eine ständige Absorption (Minderung von I gemäß dem Lambert-Beer-Gesetz und eine Emission (L) statt. Diesem fiktiven Strahlungstransport liegt die Schwarzschild-Gleichung zugrunde, die ursprünglich entwickelt wurde, um das Verhalten von Atomen in einer Sternenatmosphäre zu beschreiben.

Die weit überzogene strahlungsfixierte Treibhausgashypothese setzt eine nahezu „100%ige Molekülfluoreszenz“ voraus, die so nicht existiert – auch nicht im IR-Bereich. Während angeregte Atome nur unter Emission von Strahlung in den Grundzustand zurückkehren können, erfolgt die Relaxation bei Molekülen wegen der Rotations- und Schwingungsfreiheitsgrade meist strahlungslos gemäß den Prinzipien des Jablonski-Diagramms. Deshalb kann man ihre gesamte Argumentation in die Tonne treten.

Sie haben halt einfach keine Ahnung und plappern unverstandene Dinge nach die versuchen alles mit Strahlung zu erklären. Das funzt aber nicht.

#94: D. Glatting sagt am Donnerstag, 01.08.2013, 10:17

„Wenn der Ansatz, so wie das Strahlungs- Schalenmodell des IPCC, dass sich überhaupt nicht auf Planetenatmosphären anwenden lässt, vollkommen falsch ist, kann auch hinten nur Mist raus kommen. “

Schwarzschild war bestimmt nicht Mitglied des IPCC, denn er ist schon 1916 gestorben. Er schreibt http://tinyurl.com/schwara „Im Vordergrunde der Betrachtung stand bisher allgemein das sog. adiabatische Gleichgewicht, wie es in unsrer Atmosphäre herrscht, wenn sie von auf- und absteigenden Strömungen gründlich durchmischt ist.“

Mit unserer Atmosphäre ist die Atmosphäre der Erde gemeint. Heute heißt der Bereich mit adiabatischen Gleichgewicht „Troposphäre“. Über der Troposphäre ist eine Schicht mit Strahlungsgleichgewicht – heute Stratosphäre genannt. Die Gründe für den Übergang von der Stratosphäre in die Troposphäre hat Schwarzschild dargelegt. Die Schichtung der Atmosphäre in Troposphäre und Stratosphäre wurde gerade um diese Zeit entdeckt, wie bei Gold http://tinyurl.com/GoldTro zu lesen ist.

Aber das Verstehen von wissenschaftlichen Papern (Schwarz und Gold) scheint Ihnen schwer zu fallen, da ich schon oft auf diese Paper aufmerksam gemacht habe – aber Ihre Kenntnisse sind noch nicht besser geworden.

Nach den Ausführungen von Schwarzschild ist bei zunehmender Treibhausgaskonzentration das Ansteigen der Tropopause zu erwarten – und das wird auch gemessen.

MfG

@#91: M. Stock,

das ist immer das Gleiche. Die Treibhauskünstler stellen aufgrund des CO2 Antriebes Modelle auf, die aufgrund des höheren Antriebes (Forcings)höhere Temperaturen liefern. Doch sobald sie genötigt werden diese CO2 Antriebe zu rechtfertigen kommt es zur postnormalen Physik der Herren Kiehl und Trenberth oder noch schlimmer zur dialektischen Physik eines Herrn Ebel.

Wenn der Ansatz, so wie das Strahlungs- Schalenmodell des IPCC, dass sich überhaupt nicht auf Planetenatmosphären anwenden lässt, vollkommen falsch ist, kann auch hinten nur Mist raus kommen.

Der Antrieb ist Falsch und damit auch alle Modelle, die darauf aufbauen auch falsch.

Lieber Herr Stock, #91

Wenn Sie sich mal in der wissenschaftlichen Literatur umsehen würden, so würden Sie merken, daß die Annahmen in dem paper nicht willkürlich sind, sondern auf Datensätzen beruhen, die nur in Details vor einander abweichen. Die Zeitverläufe der forcings sind im paper ja abgebildet. Sie werden wohl kaum behaupten können, daß diese Verläufe physikalisch willkürliche Annahmen seien. Die „estimates“und „assume“ sind also nicht willkürlich, sondern greifen auf verifizierte Datensätze zurück.

„Trotzdem paßt das dann für die letzten 10-15 Jahre nicht mehr zusammen, und obwohl das Papier aus dem Jahr 2012 ist, wird das Ganze nur bis 2008 betrachtet, wahrscheinlich damit es nicht zu peinlich wird.“

Nun, eine exakte Lösung wäre auch zu viel verlangt und im Hinblick auf die Untersuchung offensichtlich auch nicht nötig, wie Sie sehen, denn eine Grossteil des Temperaturverlaufs wird ja physikalisch richtig modelliert.

„Schließlch wird dann mit großem Brimborium dargestellt, warum die Diskrepanz der letzten Jahre durch Oszillationen und statistisches Rauschen verursacht werden, die den nicht in Frage zu stellenden menschlichen Einfluß nur kurzfristig überdecken.“

Das stimmt so nicht. Sie sehen, daß die QPO (signifikantes Rauschen) und das stochastic noise (nicht signifikant) in jedem Zeitintervall für einen Anteil des Temperaturtrends verantwortlich ist. Je länger das Zeitintervall desto geringer, denn es handelt sich ja um quasi-Perioden. Die letzten Jahre fallen da nicht besonders ins Auge. Ich habe Ihnen den link gegeben, weil Sie nicht verstanden haben, was interne Klimavariabilität ist. Das im paper benutzte SCM ist immerhin so komplex (mit Ozeanstruktur etc.), daß es das chaotische Rauschen im realen Klimasystem zumindest auf der hier relevanten Zeitskala hinreichend genau widergeben kann und zeigt, daß die in den letzten Jahren zu beobachtende Stagnation zumindest nicht ungewöhnlich ist, wenn man eben auch das Rauschen mit berücksichtigt.

„Das kann so sein, aber die zugrundeliegenden Berechnungen basieren auf so vielen ungesicherten Annahmen, daß es eben auch genauso ganz anders sein kann.“

Ja, eben nicht! Ein Teil des papers beschreibt doch gerade, wie „robust“ der Modelloutput auf Streuung in den Eingangsdaten ist. Und welche der Annahmen sind da nun Ihrer Meinung nach nicht hinreichend gesichert, und woran machen Sie das fest?

#91: „Da ist dann viel von „assume“ und „estimate“ die Rede, und darüber hinaus werden aus dem mittlerweile wohl unendlichen Fundus von Papieren, die dieselbe Richtung vertreten, einzelne herausgegriffen.“

Sehr geehrter Herr Stock, ich würde mich jetzt nicht sehr an dem estimate(=schätzen) festbeißen. In der Statistik spricht man sehr häufig von Schätzungen, selbst wenn man den Mittelwert einer Stichprobe berechnen will.

Sehr geehrter Herr Baecker,

herzlichen Dank für Ihren Link, ich habe mir das mal durchgelesen. Ich weiß natürlich nicht, ob Stil und Inhalt dieses Papiers typisch für die heutige Klimaforschung sind. Wenn das so sein sollte, dann werde ich dadurch in meiner Skepsis nur bestärkt.

Das erste, was auffällt, ist die Tatsache, daß im „Abstract“ und der „Introduction“ eine Unmenge politischer Bewertungen enthalten sind. Das ist für eine wissenschaftliche Veröffentlichung im Bereich der Physik ein Unding und läßt den Verdacht zu, daß die Autoren bei Ihrer Forschung keinen ergebnisoffenen Ansatz verfolgen, sondern ein ganz bestimmtes Ergebnis wissenschaftlich verbrämen wollen. Mir ist nicht klar, warum die Autoren auf diese Weise selbst ihre Glaubwürdigkeit in Frage stellen.

Im weiteren Verauf kommt dann eine Erklärung, auf welchen Annahmen die Eingangswerte basieren, mit denen die Autoren ihr vereinfachtes Klimamodell füttern. Da ist dann viel von „assume“ und „estimate“ die Rede, und darüber hinaus werden aus dem mittlerweile wohl unendlichen Fundus von Papieren, die dieselbe Richtung vertreten, einzelne herausgegriffen. Wenn man versucht, diesem Literaturverzeichnis nachzugehen, stellt sich das als russische Puppe dar, in dem eine „assumption“ auf den nächsten „estimate“ aufbaut, und es ist mit endlchem Zeitaufwand nicht mehr herauszufinden, was da wirklich gesichert ist und was eben nicht.

Schließlich wird umfangreich auf die „radiative forcings“ eingegangen, wobei die dann überwiegend als vorgegeben („prescribed“) bezeichnet werden. Mit diesen „forcings“ und gewählten Anfangsbedingungen wird dann das Modell gefüttert, welches man für verschiedene Szenarien (hier wohl richtigerweise als „guesses“, also Vermutungen oder geratene Werte bezeichnet) so lange iterieren läßt, bis die virtuellen zu den gemessenen Temperaturen passen. Dabei vergleichen die Autoren dann interessanterweise alte, geratene Werte mit neuen, geratenen Werten („comparing the RMSE values obtained for the new guess to those for the old guesses“).

Trotzdem paßt das dann für die letzten 10-15 Jahre nicht mehr zusammen, und obwohl das Papier aus dem Jahr 2012 ist, wird das Ganze nur bis 2008 betrachtet, wahrscheinlich damit es nicht zu peinlich wird. Schließlch wird dann mit großem Brimborium dargestellt, warum die Diskrepanz der letzten Jahre durch Oszillationen und statistisches Rauschen verursacht werden, die den nicht in Frage zu stellenden menschlichen Einfluß nur kurzfristig überdecken. Das kann so sein, aber die zugrundeliegenden Berechnungen basieren auf so vielen ungesicherten Annahmen, daß es eben auch genauso ganz anders sein kann. Die Zusammnefassung des Papiers ist dann wieder eine politische Stellungnahme, in der die auf völlig ungesicherten Vermutungen basierenden Rechenspiele als „Erkenntnisse“ verkauft werden.

Ich kann mich irren, aber meine Vermutung ist, daß wir zum Ende dieses Jahrzehnts Probleme haben werden, Mülleimer zu finden die groß genug sind um die Unmengen von „wissenschaftlichen“ Papieren dieser Art aufzunehmen. Es mag vielleicht „erkenntnistheoretisch irrelevant“ sein, aber ich bin da eher der Meinung von Herrn Estermeier ….

Mit freundlichen Grüßen,

M. Stock

Herr Estermeier,

wenn Sie meinen, dass Modelle in den Naturwissenschaften nur Spielerei sind, bitte. Fuer Atomphysiker z.? sind Atommodelle ungemein hilfreich, um Beobachtungen mit theoretischen Berechnungen in Einklang zu bringen und mithin ueberhaupt erst naturwissenschaftlich Denken zu koennen. Aber Leute, die damit nichts am Hut haben, mag das anderes erscheinen. allerdings ist letzteres erkenntnistheoretisch voellig

irrelevant, was der Laien davon haelt.

PS was hat Ihr Theme eigentlich mit meinem link zu tun?? M.E. nichts!

Hallo M.Stock

Mir scheint, wir haben beide eine falsche(?) Vorstellung zu Modellanwendungen. Laut Herrn Baecker braucht man sowas nicht, um brauchbare Ergebnisse für praktische Anwendungen zu simulieren. Vielmehr handelt es sich hier sozusagen um eine Spielwiese für Theoretiker die verzweifelt nach einer Weltformel suchen.

Lieber Herr Stock,

Das Verhaeltnis von Klimavariabilitaet und Treibhausgastrend wird in diesem paper verstaendlich geklaert

http://tinyurl.com/RingSchlesinger2012

Lieber Herr Stock,

„Der von Ihnen hier eingeführte Begriff „Szenarien“ beschreibt ja wohl bestimmte Anfangsbedingungen und deren Veränderungen für die Eingangsgrößen eines Modells.“

ich habe nach wie vor den Eindruck, dass Sie trotz mehrmaliger Erklaerung immer noch die gleichen fehlerhaften Vorstellungen wie am Anfang wiederholen und immer noch nicht verstanden haben, worauf ein Klimamodell ueberhaupt basiert und was eigentlich zu klaeren ist, wenn man den Einfluss des CO2 aufs Klima ermitteln will.

Nochmal: Die Szenarien spielen fuer die Modellgenauigkeit gar keine Rolle, weil man damit das Modell nicht validiert. Das macht man nur mit den realen Daten der Vergangenheit. Die Modellgenauigkeit haengt daher nicht von den Szenarien ab. Szearien werden alleine fuer moeglichen Zustaende in der Zukunft betrachtet, indem man das da realen Daten validierte Modell einfach mit den Szenariendaten fuettert. Das Ergebnis beschreibt natuerlich auch bestenfalls nur ein Klima der Zukunft und nicht das messbare Also bitte, versuchen Sie es nochmal zu verstehen auf Basis der bisherigen Erklaerungen.

„Wenn Sie sagen „Den Einfluß des anthropogenen Treibhausgasanstiegs wurde wie gesagt ermittelt, indem man den Anstieg unrealistisch auf Null setze, dann weicht das Modell signifikant von der Realität ab.“ dann wäre natürlich die Frage, in welche Richtung. Liegen die Modellausgabewerte dann unterhalb statt oberhalb der Meßwerte?“

Unterhalb, die Modellergebnisse ohne diesen Klimafaktor zeigen nur den Einfluss der restlichen ueberlagert von der immer auftretenden natuerlichen Variabilitaet, die ja durch die interne chaotische WW zustande kommt. Die Ergebnisse finden Sie u.a. in den IPCC reports oder der wissenschaftlichen Literatur, aus der auch die Regensburger Graphik stammt. Im uebrigen gibt es weitere und signfikantere Methoden zum Nachweis des anthropogenen Einflusses.

Sehr geehrter Herr Baecker,

also wenn schon mein Unverständnis nicht mehr glaubwürdig ist, dann ist bei mir wohl Hopfen und Malz verloren 😉

Ich nehme Sie nicht auf den Arm, sondern habe eben nur ein anderes Verständnis davon, was ein Modell leisten können sollte und sehe es aufgrund meiner Erfahrungen als sehr problematisch an, wenn dessen Ausgaben auf der Zeitachse zunehmend von der Realität abweichen. Der von Ihnen hier eingeführte Begriff „Szenarien“ beschreibt ja wohl bestimmte Anfangsbedingungen und deren Veränderungen für die Eingangsgrößen eines Modells. Wenn diese Eingangswerte realistisch gewählt sind, dann ist das (zumindest für die Modelle mit denen ich zu tun habe) durchaus ein zielführender Weg, die Qualität eines Modells zu bestimmen.

Nichts anderes wurde offenbar von diesem John Christy für 44 Klimamodelle gemacht, und die Ergebnisse sind eben so, wie sie sind. Die Aussage von Roy Spencer („the few models which support weaker warming through 2012 are usually those with lower climate sensitivity“) erinnert mich eben an das von mir beschriebene Fehlverhalten von Modellen, welches zu einer sich progressiv vergrößernden Divergenz zwischen Modell und Realität führt.

Wenn Sie sagen „Den Einfluß des anthropogenen Treibhausgasanstiegs wurde wie gesagt ermittelt, indem man den Anstieg unrealistisch auf Null setze, dann weicht das Modell signifikant von der Realität ab.“ dann wäre natürlich die Frage, in welche Richtung. Liegen die Modellausgabewerte dann unterhalb statt oberhalb der Meßwerte?

Ich will Ihnen aber auch nicht zumuten, sich noch länger mit mir rumzuärgern. Da es Ihnen wie ich vermute wichtig ist, das letzte Wort zu haben, dürfen Sie mir jetzt gerne noch einmal alles unterstellen, was Sie für zielführend halten, um andere Leser endgültig von meiner Unfähigkeit zu überzeugen.

Mit freundlichen Grüßen,

M. Stock

Peter Georgiev (#4), Paul und andere sollten mal erklären, wieso es Gasgesetze gibt (pV = mRT). Die Bewgungsgleichungen der Gasteilchen sind gut bekannt – aber trotzdem sind die Bewegungen chaotisch. Geringe Änderungen in den Anfangsorten und Anfangsgeschwindigkeiten ergeben nach kurzer Zeit völlig andere Verteilungen in den Orten und Geschwindigkeiten – und trotzdem gelten die Gasgesetze.

Vielleicht erklären Georgiev, Paul und andere mal diesen scheinbaren Widerspruch bzw. warum treffen Eure Erklärungen zum Chaos nicht für die Molekülbewegung zu?

Ich vermute, da kommen keine Erklärungen oder neuer Unsinn – weil nämlich Gasgesetze und Klima ähnliche Zusammenhänge mit dem Chaos haben.

MfG

Lieber Herr Stock,

ich sehe, Sie haben immer noch jcht verstanden, dass die Szenarien ueberhaupt nichts mit der Physik zu tun haben. Die Modellqualitaet wird ohne Szenarien bestimmt. Ausserdem werden Sie sehr wohl eine quantiative Abschaetzung machen werden muessen, um die Modellqualitaet objektiv beurteilen zu koennen. Unabhaengig davon machen das die Modellierer auch. Aber das scheint Sie ja nicht zu interessieren. Wenn Sie sich aber ein eineges Bild machen wollen ohne, dass Sie dieses nach objektiven Kriterien bewerten wollen, so koennen Sie das fuer sich ruhig machen. dafuer waere ich eher noch ein Stoerfaktor, wenn ich Ihnen reinrede, was man alles fuer ein objektives Bild braeuchte, was Sie aber gar nicht haben wollen.

Wenn Sie mich auf den Arm nehmen wollen, so sagen Sie es doch bitte gleich. Ihr Unverstaendnis ist nicht mehr glaubwuerdig.

Sehr geehrter Herr Baecker,

Ihre Rechnungen sind nicht falsch, aber Statistik hilft bei der Modellierung ja nicht weiter. Worauf es ankommt, haben Sie im letzten Absatz geschrieben:

„Die Herausforderung ist nun, zu bestimmen, ob die Modellierung der Klimafaktoren und insbesondere des durch die Treibhausgase physikalisch hinreichend genau ist.“

Dem ist nichts hinzuzufügen ….

Mit freundlichen Grüßen,

M. Stock

Sehr geehrter Herr Baecker,

was Ihre Annahmen und Vermutungen betrifft, meine ich beispielsweise „Szenarien einer plausiblen Fortsetzung“, mit Abschätzungen beziehe ich mich z.B. auf „kann man quantitativ aufgrund der Physik abschätzen“. Das klingt sehr spekulativ und ist vielleicht so, vielleicht aber auch ganz anders. Es gibt ja eine ganze Reihe von Wissenschaftlern, die Ihre Überzeugung, daß die „primäre Strahlungswirkung des CO2“ zwangsläufig zu einer Erhöhung der Globaltemperatur von mehreren Grad innerhalb der nächsten 50 Jahre führen wird eben nicht teilen, und ganz andere Hypothesen vertreten.

Ansonsten bedanke ich mich für Ihre Arbeitsanweisung 😉 Ich habe aber gar nicht vor, „das Verhältnis in % zwischen Abweichung und durch das Modell simulierten Beobachtungen nach einem mathematischen Verfahren meiner Wahl zu quantifizieren“. Das ist Aufgabe der Modellierer, ich schaue mir das Ergebnis der Modelläufe auf der Basis unterschiedlicher „Szenarien“ an, und spiegele das was ich sehe an meinen Erfahrungen. Nach diesen Erfahrungen hatten Sie mich ja gefragt, aber ich dachte mir schon, daß Ihnen die Antwort nicht gefällt.

Meine Analogie mit dem Modellfehler in der Gier/Rollkopplung sollte darauf hinweisen, daß schon kleine Fehler in einer Modellierung zu extremen Abweichungen führen können, die sich nicht wieder „wegmitteln“. Dies gilt umso mehr, je stärker das zu modellierende System von Nichtlinearitäten bestimmt wird, von chaotischen Anteilen gar nicht zu reden. Daher ist eine äußerst kritische Betrachtung der Modellergebnisse absolut unabdingbar, wenn man nicht Gefahr laufen will, völligen Unsinn zu produzieren. Sie können das solange hin und her drehen, wie Sie wollen: Ein nicht zusammenpassender Trend zwischen Fiktion (Modell) und Realität (Meßwert) ist ein Alarmsignal erster Ordnung, und keine Nebensächlichkeit, die sich dann schon irgendwann von selbst wieder „richtet“. Wenn man die Ursache dafür nicht eindeutig und nachvollziehbar erklären kann, dann ist das Modell eben nichts wert, so einfach ist das.

Zumindest in der realen Welt. In welcher Welt die Klimamodellierung stattfindet, ist mir noch nicht so ganz klar.

Mit freundlichen Grüßen,

M. Stock

Lieber Herr Stock,

gucken Sie sich nochmal die Abb. 7 in Ihrem link http://tinyurl.com/llsge7l an.

Den gemessenen globalen mittleren Temperaturverlauf kann man mal grob als linearen Anstieg über 100 Jahre um 1 Grad (erwartete Physik des anthropogenen Treibhausgasanstieg auf die Temperatur) + Überlagerung von jährlichen Schwankungen (internes Rauschen des Klimasystems) um 0,3 Grad nachbilden, um mal was einfach rechnen zu können.

Die Schwankungen erzeuge ich durch die Funktion 0.3*2*[ZUFALLSZAHL()-0.5] in Excel, den linearen Anstieg durch 0.01*x, x= Jahr (1…100). Die Temperatur ist dann also T(x) = 0.01*x + 0.3*2*[ZUFALLSZAHL()-0.5].

Zu jedem x wird mit dem Zufallsgenerator eine Zufallszahl (Rechteckverteilung) aus dem Intervall [-0,3,+0,3] erzeugt. Wenn man das n-mal macht, bekommt man Scharen i=1,…,n von unterschiedlichen Temperaturreihen Ti (x), unterschiedlich, weil bei jedem i an der Stelle x eine neue Zufallszahl aus [-0,3,+0,3] gewürfelt wird. Die Ti (x) sind also unterschiedlich und die Differenz der jährlichen Temperaturwerte zweier Ti hat ein Sigma von 0,26. Nehmen wir T1 als Temperaturreihe der realen, gemessenen Temperatur. Die anderen Temperatureihen können als Modellierungen von T1 aufgefaßt werden. Der Fehler zwischen T1 und Ti ist nicht Null, jährlich streut die Differenz auch mit einem Sigma von 0,26. Aber der Korrelationskoeffizient zwischen T1 und Ti beträgt 56% und die beiden Reihen sind über 99% signifikant korreliert. Das liegt einfach daran, daß die Steigung gegenüber der Schwankung über die 100 Jahre so dominiert, daß alle Kurven einen gleichsinnigen langfristigen Verlauf haben. Ein solches Modell wäre also sehr gut. Nun gucken Sie einfach mal auf die Regensburger Graphik. Da sehen Sie wie gut das Modell die Realität wiedergibt. Ich sehe nicht, daß dies schlecht wäre. Den Einfluß des anthropogenen Treibhausgasanstiegs wurde wie gesagt ermittelt, indem man den Anstieg unrealistisch auf Null setze, dann weicht das Modell signifikant von der Realität ab. Der Rest an Einflußfaktoren, die ebenfalls natürlich ihre Trends zeigen, reicht nicht aus, um die beobachtete Kurven zu erklären.

Die Herausforderung ist nun, zu bestimmen, ob die Modellierung der Klimafaktoren und insbesondere des durch die Treibhausgase physikalisch hinreichend genau ist. Daß dies nicht trivial ist, erkennen Sie daran, wenn Sie die Steigung der „Modellrealisationen“ mit i größer 1 von 0.01 abweichen lassen. Man erkennt in den verrauschten Ti erst dann einen signifikanten Unterschied, wenn die Steigung arg von 0.01 abweicht. Sie sehen aber auch, daß es dabei ankommt, daß die Temperaturreihen möglichst lang sind, die man miteinander vergleicht. Alleine einen Zeitabschnitt zu vergleichen, ist Unsinn.

Lieber Herr Stock,

„Ihre Ausführungen, warum die Globaltemperatur doch aufgrund des steigenden CO2-Partialdrucks in der Atmosphäre immer weiter steigen muß […], basieren mir auf zu vielen Annahmen, Vermutungen und Abschätzungen von Größenordnungen, die nicht unbedingt richtig sein müssen.“

Welche meinen Sie, ich habe bislang noch gar keine Annahmen, Vermutungen und Abschätzungen konkret benannt und Sie haben nicht danach gefragt?

„(obwohl das nun schon seit vielen Jahren nicht der Fall ist)“

Ich habe Sie schon mehrmals aufgefordert einfach mal das Verhältnis in % zwischen Abweichung und durch das Modell simulierten Beobachtungen nach einem mathematischen Verfahren Ihrer Wahl zu quantifizieren. Daß eine Abweichung immer besteht, ist klar, aber um die Relevanz zu bewerten, muß man Zahlen liefern.

„Wenn ein Flugmechanikmodell (Klimamodell) einen Fehler bezüglich der Zeitkonstanten oder der Verstärkungsfaktoren der Gier/Rollkopplung (CO2-Antrieb) enthält, dann wird der Hängewinkel des Flugzeugs (Globaltemperatur) nach einem geflogenen Manöver von der Realität (Temperaturmeßwert) abweichen, und da mittelt sich gar nichts raus.“

Wie kommen Sie darauf, daß Ihre Analogie Aussagen über die physikalischen Vorgänge beim Klima liefern kann?

Das erscheint mir recht willkürlich. Mehr CO2 führt primär erstmal einfach nur zu einer Reduktion der Energieabgabe der Erde ins All. Das ist kein Verstärkungsprozeß oder eine Rückkopplung oder was immer Sie da per Analogie verknüpfen wollen.

Wenn Sie aber eine Analogie haben wollen, so vielleicht damit: das CO2 wirkt wie eine zeitlich festgelegte Gewichtszunahme des Flugzeugs (wie auch immer das technisch umgesetzt werden kann).

„Wenn die Abweichungen von Modellausgaben und Meßwerten größer werden, nachdem man eine neue Rück- oder Gegenkopplung eingebaut hat (und da denke ich an das CO2, denn vor 1980 war das wohl in keinem Klimodell drin)“

Das CO2 ist kein „Korrekturglied“ im Klimamodell. Man passt da auch überhaupt nichts an oder erfindet unphysikalische Rückkopplungen. Die Wirkung des CO2 ist im Modell ziemlich einfach darzustellen. Die Schwächen der Modelle liegen – ich wiederhole mich erneut – nicht bei der primären Strahlungswirkung des CO2, denn diesen Effekt kann man in Feldstudien sehr gut überprüfen.

Wenn man ein Klimamodell für die Vergangenheit rechnen, so wird dort diejenige CO2-Menge als Parameter vorgegeben, die in dem zu berechnenden Zeitraum de facto (gemessen) vorlag. Das ist keine „Spielschraube“, an der man tuned. Das habe ich Ihnen aber schon mehrmals erklärt. Sie scheinen etwas in Ihren Analogien verstrickt zu sein? Lösen Sie sich mal davon und betrachten die Klimaphysik alleine.

Sehr geehrter Herr Baecker,

ich rechne selbst keine Modelle, sondern liefere Datengrundlagen dazu und validiere sie anschließend. Es handelt sich dabei um Flugmechanikmodelle für Flächenflugzeuge für die Verwendung in der Flugsimulation. Die Modelle basieren auf bekannten Gesetzmäßigkeiten der Aerodynamik, den Ergebnissen einer Parameteridentifikation im Flug sowie den ermittelten oder errechneten Massenträgheiten. Diese Modelle haben einen linearen/gemäßigt nichtlinearen Bereich (normale Flugzustände), einen hoch nichtlinearen Bereich (teilweise oder ganz abgelöste Strömung) sowie einen chaotischen Bereich (Flattereffekte). Die beiden letzteren Bereiche sind nur mit extremen Aufwand bzw. im chaotischen Fall gar nicht mehr modellierbar.

Ihre Ausführungen, warum die Globaltemperatur doch aufgrund des steigenden CO2-Partialdrucks in der Atmosphäre immer weiter steigen muß (obwohl das nun schon seit vielen Jahren nicht der Fall ist), basieren mir auf zu vielen Annahmen, Vermutungen und Abschätzungen von Größenordnungen, die nicht unbedingt richtig sein müssen. Mal ein Beispiel, das nur auf einer schlechten Modellierung einer Nichtlinearität basiert, da brauchen wir die Chaostheorie gar nicht erst zu bemühen:

Wenn ein Flugmechanikmodell (Klimamodell) einen Fehler bezüglich der Zeitkonstanten oder der Verstärkungsfaktoren der Gier/Rollkopplung (CO2-Antrieb) enthält, dann wird der Hängewinkel des Flugzeugs (Globaltemperatur) nach einem geflogenen Manöver von der Realität (Temperaturmeßwert) abweichen, und da mittelt sich gar nichts raus. Mit jedem gleich geflogenen Manöver wird die Abweichung größer. Ab einem bestimmten Hängewinkel fliegt Ihr Flugmechanikmodell (Klimamodell) dann ohne zusätzliche Steuereingaben (evt. sogar perfekt gerechnet) zügig dem Erdboden (dem Hitzetod) entgegen. Auf das Glück, daß ein solcher Fehler nur in einem Bereich eintritt, in dem die statische und dynamische Stabilität des Luftfahrzeugs (Gegenkopplungseffekte des Klimas) den Fehler auf längere Sicht wieder zu Null machen, können Sie sich dabei nicht verlassen. Das wird nur in den seltensten Fällen so sein.

Wenn die Abweichungen von Modellausgaben und Meßwerten größer werden, nachdem man eine neue Rück- oder Gegenkopplung eingebaut hat (und da denke ich an das CO2, denn vor 1980 war das wohl in keinem Klimodell drin), dann muß man als Modellierer schon dialektisch geschult sein, um das auf völlig andere Ursachen zu schieben. Der natürliche Feind des Modellierers ist der Meßwert 😉

Mit freundlichen Grüßen,

M. Stock

Lieber Herr Stock, #77

„wenn es bei der Abweichung zwischen den Modellen und der Realität von 0,3 Grad bis zum Jahr 2050 (oder von mir aus bis 2100) bleibt, könnte man das im Vergleich zu 4 Grad in der Tat vernachlässigen. Allerdings haben Sie mir ja als Fehler angekreidet, den eindeutig flachen bis negativen Trend der gemessenen Temperaturen in die Zukunft fortzuschreiben, während Sie jetzt dasselbe machen.“

Der Unterschied ist: Sie haben einen Trend fortgeschrieben, ich hingegen das Spektrum der Schwankungsbreite der natürlichen Klimavariabilität. In der Tat kann man letzteres nicht so ohne weiteres. Aber man hat eben nachgeprüft, wie sich die interne Klimavariabilität in der Vergangenheit verhalten hat und in welchen Grenzen sich diese aufgrund physikalischer Restriktionen überhaupt bewegen kann. Aus der Klimaphysik und dem check in der Vergangenheit sieht man, daß es keinen klimainternen Prozeß gab, der die von außen eingeprägt Ursache, die zu einer Temperaturerhöhung von einigen Grad in 100 Jahren führt, kompensieren könnte. Die internen Klimaschwankungen auf der gleichen Zeitskala sind zu klein.

„Allerdings tun Sie das mit einem ansteigenden Trend“

Vorsicht: Der Trend für die Zukunft folgt wie schon mehrmals erklärt aus der Modellphysik + CO2-Szenario mit weiterer Akkumulation von Treibhausgasen in der Atmosphäre und NICHT einer Extrapolation in die Zukunft!

Die 4 Grad plus (bleiben wir mal bei diesem Wert als Beispiel) resultieren aus dem Modell wenn es mit den Randbedingungen gefüttert wird, die bis dorthin das Klima determinieren. Sagen wir mal das Modell wurde 2010 zu Ende entwickelt und berechnet das Klima von 1900 bis 2100. Dann stammen die Randbedingungen bis 2010 (oder ein paar Jahre weniger) aus den Messungen, die Randbedingungen ab 2010 (oder ein paar Jahre vorher) aus Szenarien einer plausiblen Fortsetzung derselben in die Zukunft. Wenn dasselbe Modell mit den Randbedingungen gefüttert wird, die bis heute das Klima determinieren, so folgt daraus natürlich wie beobachtet ein kleinerer Temperaturanstieg. Nichts sehen sie ja auf der Regensburger Graphik.

„müssten sich die gemessene Globaltemperatur ja nunmehr zügig nach oben entwickeln. Tut sie aber gegenwärtig nicht.“

„Müsste“, aber nicht „ungestört“ monoton! Ihre Behauptung, man müsse diesen Anstieg auch auf Zeitskalen von 10-20 Jahren aus dem Rauschen filtern können, ist eben nur Ihre Behauptung, wobei Sie bislang überhaupt keine physikalischen Gründe für Ihre Behauptung vorgebracht haben. Die Klimawissenschaft sieht dies aus bereits beschriebenen Gründen anders und differenziert.

„Und das „Durchrutschen der feinen Effekte“ sind selbstverständlich Fehler in den Modellen, was denn sonst.“

Ich habe nichts anderes behauptet! Aber wie gesagt, diese Fehler kann man quantitativ aufgrund der Physik abschätzen und sind auf der Zeitskala von 50-100 Jahren gegenüber dem Signal zu vernachlässigen. Die Fehler dadurch können keine Abweichung von ein paar Grad pro 100 Jahre hervorrufen und das Signal kompensieren. Anderes sieht es wie gesagt auf der Zeitskala von 1- 20 Jahren aus.

„Zudem haben diese bei der Modellierung eines teils chaotischen Systems wie dem Klima ggf. dramatische Auswirkungen.“

Meinen Sie die chaotische Dynamik der Atmosphäre beim Wetter? Das wird ja per Definition beim Klima weggemittelt. Das Klima ist in Realität ja auch nicht auf einer Zeitskala von einigen Jahrzehnten chaotisch, sondern stabil. Allerdings diskutiert man, ab welchen Randbedingungen das Klima aus der gegenwärtig und die letzten paar Jahrtausenden dynamisch stabilen Lage kippt und chaotisch werden kann (tipping points).

„Wenn eine Quantifizierung der möglichen Fehler im Rahmen einer Modellvalidierung möglich ist, dann haben die Modelle eine definierte Schwankungsbreite bezüglich der Ausgabewerte aufgrund dieser Fehler. Diese Schwankungsbreiten (gern auch für verschiedene Szenarien) müßten seriöserweise mit angegeben werden, damit man sich ein Bild über die Eintrittswahrscheinlichkeit der Modellausgaben machen kann. Solche Angaben habe ich aber bisher nicht gefunden.“

Ich gebe Ihren völlig recht. Die Auswirkungen von Fehlern oder Vereinfachungen der Modellphysik oder Grenzen der Numerik in Modellen müssen ermittelt worden sein. Wenn Sie nichts gefunden habe, so liegt das wohl daran, daß Sie nicht intensiv genug recherchiert haben. In der Regensburger Referenz werden diese nicht angegeben, weil das die Graphik überfrachten würde. Aber jedes Modell ist dokumentiert, Sie müssen dort nachgucken. Teilweise wurden diese Ergebnisse auch publiziert.

Herr Stock,

ich habe Ihnen nun schon viele Erklärungen geliefert. Ich habe aber immer noch den Eindruck, daß Sie überhaupt keine realistische Vorstellung von den Modellen entwickeln können. Können Sie mir mal anders herum erklären, wie die Modelle funktionieren, die Sie rechnen? Mir scheint, Sie übertragen da blindlings zu viel aus Ihren Erfahrungen

Sehr geehrter Herr Baecker,

wenn es bei der Abweichung zwischen den Modellen und der Realität von 0,3 Grad bis zum Jahr 2050 (oder von mir aus bis 2100) bleibt, könnte man das im Vergleich zu 4 Grad in der Tat vernachlässigen. Allerdings haben Sie mir ja als Fehler angekreidet, den eindeutig flachen bis negativen Trend der gemessenen Temperaturen in die Zukunft fortzuschreiben, während Sie jetzt dasselbe machen. Allerdings tun Sie das mit einem ansteigenden Trend, der momentan nachweislich gar nicht existiert, denn damit sich der Abstand zwischen den Modellen und der Realität bis zum Jahr 2100 nicht weiter vergrößert, müssten sich die gemessene Globaltemperatur ja nunmehr zügig nach oben entwickeln. Tut sie aber gegenwärtig nicht.

Und das „Durchrutschen der feinen Effekte“ sind selbstverständlich Fehler in den Modellen, was denn sonst. Zudem haben diese bei der Modellierung eines teils chaotischen Systems wie dem Klima ggf. dramatische Auswirkungen. Wenn eine Quantifizierung der möglichen Fehler im Rahmen einer Modellvalidierung möglich ist, dann haben die Modelle eine definierte Schwankungsbreite bezüglich der Ausgabewerte aufgrund dieser Fehler. Diese Schwankungsbreiten (gern auch für verschiedene Szenarien) müßten seriöserweise mit angegeben werden, damit man sich ein Bild über die Eintrittswahrscheinlichkeit der Modellausgaben machen kann. Solche Angaben habe ich aber bisher nicht gefunden.

Diese Modelle beeindrucken mich daher nach wie vor nicht. Daß der CO2-Anstieg „keinen Nulleffekt aufs Klima hat“, kann man erst einmal so stehen lassen. Bei der Beantwortung der Frage, wie groß dieser Einfluß ist, und vor allem ob er im Verhältnis zu anderen Einflußgrößen relevant ist, helfen die Modell aber aufgrund ihrer mangelnden Genauigkeit meiner Meinung nach nicht weiter. Genau auf diese Modelle stützt sich aber die These vom menschengemachten Klimawandel. Wenn die Entwicklung noch ein paar Jahre so weitergeht wie momentan, dann wird diese These in der Öffentichkeit aber nicht mehr haltbar sein.

Wenn ich ein Entwickler für Klimamodelle wäre, dann würde ich sehr schnell versuchen, die gegenwärtige Diskrepanz schlüssig und nachvollziehbar zu erklären und mein Modell der Wirklichkeit anzupassen. Wenn das nicht geschieht, dann werden die Erklärungen für das Auseinanderdriften von Modellen und Realität eben von Leuten wie Roy Spencer geliefert 😉

Mit freundlichen Grüßen,

M. Stock

Lieber Herr Stock, #75

„Was nun die Klimamodelle betrifft: Ich kenne keine definierten Qualitätskriterien dafür, und das ist wohl schon Teil des Problems. Wenn die Erde mit einer Temperaturerhöhung von 4 Grad in der Katastrophe versinken soll, dann sollten Modelle, welche die von mir genannten billionenschweren Ausgabenprogramme und den Umbau der Gesellschaft rechtfertigen sollen, die zukünftige Temperaturentwicklung schon mit hinreichender Genauigkeit vorhersagen können“

Die Situation ist doch eine ganz andere.

Die Modelle sollen nicht bestätigen, daß die Erde in Zukunft wärmer wird (wozu dann noch, wenn man es eh schon wüßte?), sondern das Resultat der Modelle ist, daß sich das Klima der Erde bei nicht unplausiblen Szenarien der zukünftigen Treibhausgasentwicklung dann so entwickeln wird. Grundlage dafür ist, daß die Modelle die Klimazustände eines weiten Spektrums von Randbedingungen hinreichnd genug reproduzieren.

Wie Sie an der Regensburger Graphik sehen können, geben die Modelle den beobachtbaren Temperaturanstieg bis auf Abweichungen von plus minus 0,3 ° in etwa wieder. Wenn bis 2100 das CO2 exponentiell folgend auf 1000 ppm weiter steigen würde (Szenario!), so folgt aus den Modellen, daß die Temperatur um rund 2-4 °C steigen würde. Da machen die 0,3°C Abweichungen grundlegend nichts aus.

„und da halte ich +/- 2% wie bei technischen Systemen für einen guten Wert.“

Kann ja sein, daß Sie auf diese Genauigkeit Ihres Modell angewiesen sind. Aber in unserem Fall mit dem Klima ist für die Politik doch in erster Näherung nur entscheidend, ob sich das Klima bei einer solchen CO2-Entwicklung in einen kritischen Bereich bewegt oder nicht. Und dies ist nach Einschätzung der Experten eben bei 2-4 °C plus/minus 0,3°C anscheinend zumindest so riskant, daß man sich zu Maßnahmen zur Ursachenvermeidung entschlossen hat.

Die Wissenschaft hätte es natürlich noch genauer, und dafür forscht man ja auch weiter.

„Was die Fehlerhaftigkeit der Modelle betrifft, widersprechen Sie sich zudem: Zum einen sprechen Sie von „Computerbedingte limitierung der Modellphysik: Man kann nicht die Bildung jedes Regentropfens durchrechnen, sondern muss vereinfachen, und damit rutschen feine Effekte eben durch.“, andererseits sagen Sie „ich verstehe nicht, was daran offensichtlich fehlerbehaftet sein soll“.“

Wo soll da ein Widerspruch sein? Die Fehler durch „Durchrutschen der feinen Effekte“ quantifiziert man ja bei der Modellvalidierung. Außerdem läßt sich auch auf Basis der Physik und Feldforschung im realen Klimasystem abschätzen, wie groß ein Fehler durch eine Vereinfachung eines physikalischen Prozesses ist.

„und das Nullsetzen des anthropogen bedingten Treibhausgasanstiegs dazu führt, daß „das so modellierte Klima auch nicht zum beobachteten passt“, dann gibt es mit diesen Modellen insgesamt ein größeres Problem, meinen Sie nicht auch?“

Wieso? Auch ohne Modell erwartet man doch schon mit einfachen physikalischen Abschätzungen, daß der anthropogen bedingte Treibhausgasanstieg keinen Nulleffekt aufs Klima hat.

„Wenn das nicht mit endlichem Aufwand behebbar ist“

Der Aufwand, das Klima auch kurzfristiger und genauer als plus minus 0,3 °C pro Jahr vorhersagen zu können, ist definitiv sehr aufwändig, denn gerade die interne Klimavariabilität ist wie gesagt computerresourcen-fressend. Die Klimawirkungen der treibhausgas-bedingten physikalischen Prozesse zu berechnen, sind dagegen vergleichsweise einfach.

Sehr geehrter Herr Baecker,

was meine einleitenden Sätze betrifft, so bezog ich mich auf keine „Passage“, sondern darauf, daß Sie Ihren Diskussionspartnern durch die Wortwahl in jedem dritten Satz Unwissenheit, Unverstand oder Unfähigkeit unterstellen und diese wie kleine Kinder behandeln. Das nimmt sich natürlich jeder zu Herzen, und das ist von Ihnen ja auch beabsichtigt. Je nach Temperament läßt sich das Gegenüber dann durch die andauernden Provokationen früher oder später zu unfreundlichen Reaktionen hinreißen, was Sie dann postwendend zur Bestätigung Ihrer Geringschätzung umdeuten können 😉 Das ist ein bekanntes psychologisches Spielchen, welches aber nur solange funktioniert, bis das Opfer es erkennt.

Was nun die Klimamodelle betrifft: Ich kenne keine definierten Qualitätskriterien dafür, und das ist wohl schon Teil des Problems. Wenn die Erde mit einer Temperaturerhöhung von 4 Grad in der Katastrophe versinken soll, dann sollten Modelle, welche die von mir genannten billionenschweren Ausgabenprogramme und den Umbau der Gesellschaft rechtfertigen sollen, die zukünftige Temperaturentwicklung schon mit hinreichender Genauigkeit vorhersagen können, und da halte ich +/- 2% wie bei technischen Systemen für einen guten Wert. Das kann man Verneinen, aber dann frage ich mich, was mit den hohen Summen für die Klimaforschung (allein für Deutschland: http://tinyurl.com/p649jqn) denn eigentlich so gemacht wird.

Was die Fehlerhaftigkeit der Modelle betrifft, widersprechen Sie sich zudem: Zum einen sprechen Sie von „Computerbedingte limitierung der Modellphysik: Man kann nicht die Bildung jedes Regentropfens durchrechnen, sondern muss vereinfachen, und damit rutschen feine Effekte eben durch.“, andererseits sagen Sie „ich verstehe nicht, was daran offensichtlich fehlerbehaftet sein soll“.

Vereinfacht gesagt ist daran wahrscheinlich genau das fehlerhaft, was Sie einen Satz vorher gesagt haben 😉 Wenn das nicht mit endlichem Aufwand behebbar ist und das Nullsetzen des anthropogen bedingten Treibhausgasanstiegs dazu führt, daß „das so modellierte Klima auch nicht zum beobachteten passt“, dann gibt es mit diesen Modellen insgesamt ein größeres Problem, meinen Sie nicht auch?

Und wenn schließlich die Ausgabewerte der Modelle für die Globaltemperatur so abweichen wie in der Spencer-Grafik beschrieben, dann stellen diese Modelle für mich eben keine brauchbare Grundlage dafür dar, eine Klimakatastrophe zu verkünden.

Mit freundlichen Grüßen,

M. Stock

P.S.: Captcha: „schnee“ 😉

#72: Hallo Herr M. Stock, ich bewundere Ihre Geduld, wie oft Sie Herrn Baecker nun vorgeführt haben bei seinem Versuch, die Quadratur des Kreises zu erfinden.

Herr Baecker versteht nichts von Physik

und der Informatiker Hader nichts von Statistik und Chaostheorie.

Trotzdem bestehen beide auf der Fortführung der billionenschwerden Ausgabenprogramme, wie Sie richtig mehrfach betonen.

Es ist also keine akademische Frage,

dieses sachlich unbegründbare Verhalten muss noch deutlicher an den Pranger gestellt werden!

mfG

Lieber Herr Stock,

„funktioniert natürlich ganz gut, ist aber auch nicht völlig undurchschaubar ….“

ich darf Sie daran erinnern, dass Sie diese Passage einem anderen Beitrag von mir entnahmen und ich keine Kenntnis davon hatten konnte, dass Sie sich das zu Herzen nehmen.

„Was die Klimamodelle betrifft, so hatte mir schon gedacht, daß ich mich gar nicht unmißverständlich genug ausdrücken kann. Das „Verstärkungsfaktoren innerhalb des Modells zu Null setzen“ war natürlich nicht als „Flickschusterei“ gedacht, sondern lediglich als Testfall zur Lokalisierung eines fehlerhaften Modellverhaltens.“

Nun, man hat den beobachtbaren anthropogen bedingten Treibhausgasanstieg zu Null gemacht und das Modell nochmal unter diesen nicht realisierten Randbedingungen laufen lassen mit dem Ergebnis, dass das so modellierte Klima auch nicht zum beobachteten passt.

„Nach Ihrer Aussage habe ich jetzt aber verstanden, daß sich die „Szenarien“ auf die Modelleingangsgrößen beziehen, das war mir bisher noch nicht klar.“

Habe ich aber schon mehrmals erklaert…macht aber nichts, besser spaeter als nie (auch in der Hinsicht sind Sie anderen Teilnehmern hin voraus ‚-)

„Das Resultat ist dann wohl das, was sich in der Grafik von Spencer ausdrückt. Damit erfüllen diese Modelle (angesichts der weitreichenden Entscheidungen, die darauf basieren) eindeutig nicht die Qualitätskriterien, die an Modelle für technische Systeme gestellt werden.“

Wo haben Sie definierte Qualitaetskriterien fuer Klimamodelle gesehen? Vergleichen Sie das mit den 2% Ihrer Systeme? Das gilt doch nur fuer Ihre Systeme.

“ Die Ursache dafür ließe sich aber durch das Verändern der Verstärkungsfaktoren wie von mir beschrieben quantifizieren,“

dazu hatte ich eigentlich schon etwas geschrieben. Es gibt keine Verstaerkungsfaktoren, an denen man nach belieben drehen kann und das waere auch nicht physikalisch sinnvoll. Der Weg zu genaueren Modelle ist prinzipiell bekannt.

“ Ist Ihnen bekannt, ob eine solche Quantifizierung (d.h. welche Eingangsgrößen sind für welches Ausmaß der Abweichung der Globaltemperatur verantwortlich) für diese Modelle stattfindet?“

Sie haben das immer noch nicht verstanden, die Eingangsgroessen sind nicht dominant fuer die Abweichung verantwortlich, sondern die Computerbedingte limitierung der Modellphysik: Man kann nicht die Bildung jedes Regentropfens durchrechnen, sondern muss vereinfachen, und damit rutschen feine Effekte eben durch.

„Ich vermag nämlich immer noch nicht zu erkennen, wie man auf der Basis offensichtlich fehlerbehafteter Modelle billionenschwere Ausgabenprogramme und den Umbau der Gesellschaft rechtfertigen kann.“

ich verstehe nicht, was daran offensichtlich fehlerbehaftet sein soll, denn das Klima laesst sich ja weitgehend bis auf die Einige Zehntelgrad Abweichungen auf und ab modellieren. Geben Sie doch einfach mal die Varianz an, die Das Modell gegenueber der Realitaet nicht erklaert und nennen Fakten. Bislang auessern Sie sich nur auf subjektive Basis.

Sehr geehrter Herr Baecker,

na, immerhin habe ich das Glück, daß für Sie meine Fähigkeit zu gemäßigten Reaktionen auf Ihre unterschwelligen Botschaften vor meinen fachlichen Fähigkeiten rangiert 😉 Also dazu nur soviel: Die Masche, persönliche Geringschätzung in vordergründig sachliche Informationen zu verpacken und die dadurch bewußt provozierten Reaktionen dann voller Entrüstung zu beklagen, funktioniert natürlich ganz gut, ist aber auch nicht völlig undurchschaubar ….

Was die Klimamodelle betrifft, so hatte mir schon gedacht, daß ich mich gar nicht unmißverständlich genug ausdrücken kann. Das „Verstärkungsfaktoren innerhalb des Modells zu Null setzen“ war natürlich nicht als „Flickschusterei“ gedacht, sondern lediglich als Testfall zur Lokalisierung eines fehlerhaften Modellverhaltens. Welche Maßnahmen im Anschluß an eine solche Analyse ergriffen werden, steht auf einem ganz anderen Blatt.

Nach Ihrer Aussage habe ich jetzt aber verstanden, daß sich die „Szenarien“ auf die Modelleingangsgrößen beziehen, das war mir bisher noch nicht klar. Also wird der Verlauf der anthropogenen Emissionen und der natürlichen Klimafaktoren so verändert, wie man das für die Zukunft erwartet. Das ist erst einmal OK, mit den langen Meßreihen aus der Vergangenheit sollte das ja mit hinreichender Wahrscheinlichkeit möglich sein. Die diesbezüglichen Annahmen lassen sich variieren, und dann schaut man sich das Ergebnis an.

Das Resultat ist dann wohl das, was sich in der Grafik von Spencer ausdrückt. Damit erfüllen diese Modelle (angesichts der weitreichenden Entscheidungen, die darauf basieren) eindeutig nicht die Qualitätskriterien, die an Modelle für technische Systeme gestellt werden. Die Ursache dafür ließe sich aber durch das Verändern der Verstärkungsfaktoren wie von mir beschrieben quantifizieren, zudem die Klimamodelle nach Ihrer Aussage keine unübersehbare Zahl von Eingangsvariablen haben. Ist Ihnen bekannt, ob eine solche Quantifizierung (d.h. welche Eingangsgrößen sind für welches Ausmaß der Abweichung der Globaltemperatur verantwortlich) für diese Modelle stattfindet?

Ich vermag nämlich immer noch nicht zu erkennen, wie man auf der Basis offensichtlich fehlerbehafteter Modelle billionenschwere Ausgabenprogramme und den Umbau der Gesellschaft rechtfertigen kann.

Mit freundlichen Grüßen,

M. Stock

zu #70 Baecker, Nico:

„Im übrigen halte ich Klimawissenschaftler nicht für Koryphäen, das sind ganz normale Wissenschaftler, und die Klimawissenschaft ist so normal ist wie jede andere Wissenschaft,“

mein Kommentar:

also „ganz normal“ würde ich die nicht nennen,

denn dazu müssten Sie doch etwas mehr von Physik verstehen und auch ganz normal rechnen können.

Sie als Experte werden sicher sofort auf dem ersten Blick erkennen,

was in diesem bekannten Strahlungschema von Kiel und Trendberth völlig falsch ist,

also physikalisch unmöglich in der Realität:

http://tinyurl.com/lrvupp

Tipp:

es sind gleich mehrere Fehler

mfG

Lieber Herr Stock, #69

„Ansonsten vergleichen wir jede Ausgabe des Modells aufgrund von Variationen der Eingangsgrößen einfach mit der Realität. Damit können wir das Systemverhalten über einen definierten Zeitraum tatsächlich vorhersagen, und das ist der Sinn eines Modells.“

So macht man es ja auch mit dem Klimamodellen. Aber da kann man die Eingangsgrößen nun mal leider nicht frei variieren, sondern ist auf die Variationen angewiesen, die uns die Natur in der Vergangenheit lieferte.

„Nur noch kurz zu den „Szenarien“: In einem technischen System, dessen Reaktion auf die Änderung der Eingangsgrößen meßbar ist, ist das, was Sie „Szenarien“ nennen, höchstens für die Beurteilung der Stabilität von Bedeutung. „

Nun, wie gesagt die Szenarien der Eingangsgrößen haben mit dem Modell nichts zu tun.

Das Szenario höherer Treibhausgasmengen resultiert daraus, daß man davon ausgehen kann, daß diese in Zukunft weiter steigen werden. und dies wird einfach als Eingangsgröße ins Modell für die zukünftige Klimaentwicklung einspeist.

„Wir benutzen den Begriff „Szenario“ daher gar nicht, und ich habe den Eindruck, daß er bei den Klimamodellen dazu mißbraucht wird, die falschen Modellergebnisse aufgrund eines nicht in der Wirklichkeit überprüfbarem Modellverhaltens zu beschönigen.“

Ich verstehe nicht. Die Szenarien haben wie schon erklärt überhaupt nichts mit der Modellvalidierung zu tun. Denn dafür vergleicht man ja die Modellergebnisse mit den Beobachtungsdaten, wenn das Modell mit Eingangsgrößen gefüttert wurde, die tatsächlich auch auftraten. Das sind dann natürlich keine Szenarien, sondern real eingetroffene. Wenn man das Klimamodell lang genug zurück in die Klimavergangenheit betreibt, so kann man auch Eingangsgrößen finden, die nahe an den Szenarien für die nahe Zukunft sind, denn erhöhte Treibhausgasmengen gab es ja auch schon natürlich bedingt in der Erdvergangenheit. Somit kann man das Modell auch für die Eingangsgrößen der Szenarien näherungsweise validieren, obwohl das Szenario in der Realität (noch) nicht eingetreten ist.

Wie Sie auf „beschönigen“ kommen, kann ich nicht nachvollziehen. Die Szenarien haben gar keine Auswirkung auf den Aufbau des Modells.

„Daß das Klima die Vergleichsmöglichkeit mit der Realität erst im Nachhinein erlaubt, ist natürlich klar. Wenn aber dann eine Divergenz zwischen Modellergebnis und Messungen festgestellt wird, würde ich (als technische Amöbe) einzelne Verstärkungsfaktoren innerhalb des Modells zu Null setzen und dadurch quantifizieren, wie die Abweichung zu erklären ist.“

So ein Klimamodell wird aber nicht nach try-and-error optimiert. Ich kenne viele Simulanten, die eine Simulationssoftware physikalisch nicht verstehen und daher versuchen, an irgendwelchen tune-Parametern so lange herumzudrehen, bis das Ergebnis paßt. Und dabei kann es passieren, daß die Schräubchen zum Schluß an physikalisch völlig unsinnigen Positionen stehen, aber die Kurven übereinstimmen. Das ist offensichtlich Unsinn.

Bei der Klimamodellierung gibt es keine tune-Parameter für die Temperatur. Diese resultiert deterministisch aus der prognostischen Gleichung für die Temperatur und da fließen nur die Energieströme und ein paar physikalische Konstanten ein. Die Energieflüsse resultieren wiederum aus Bilanzgleichungen. Da läßt sich auch nicht viel tunen, denn es bestehen natürlich Erhaltungssätze (Energieerhaltung etc.). Tunen lassen sich aber Teilprozesse, die gesondert modelliert und validiert werden, z.B. Wolkenbildung oder der Energietransport durch Treibhausgase. Wenn diese Teilmodelle funktionieren, werden sie ins Gesamtmodell implementiert und liefern Parameter, die wieder Eingangsgrößen für andere Teilmodelle sind.

„Sollte sich dann ein bestimmter Parameter als für die Abweichung überwiegend verantwortlich herausstellen, dann würde ich hoffen, daß mir Jemand den Arbeitsauftrag erteilt, den Grund dafür herauszufinden.“

Solche „Flickschusterei“ ist nicht zielführend. Wie gesagt, im Prinzip ist die beobachtbare Abweichung im Klimamodell ja klein im Vergleich zu dem, wie das Modell das reale Klima wiedergibt (siehe Regensburger Graphik). Und außerdem vermutet man schon die Ecke, wo die Ursachen davon zu finden sind, nämlich in Schwächen der Modellierung der internen Klimavariabilität, denn diese erfordert ins Besondere eine hohe Raum- und Zeitauflösung der Prozesse, was bekanntlich der begrenzende Faktor bei Klimamodellen ist.

Und wie schon gesagt, aus den Schwächen in der Modellierung der internen Klimavariabilität läßt sich natürlich nicht schlußfolgern, wie das Modell auf ein Szenario mit höheren Treibhausgasmengen reagiert. Denn die Physik der Treibhausgase erfährt dadurch im Modell ja keine Änderung.

„hierbei ist es erst einmal egal, ob es sich um ein Verstärkungs- oder ein Stabilitätsproblem handelt (Langzeit/Kurzzeit).“

Das Modell ist natürlich nicht numerisch instabil. Und Verstärkungsfaktoren, an denen man einfach so ohne Sinn und Verstand herumdrehen kann, um einen passenden output zu bekommen, gibt es nicht. Und wenn es die gäbe, so sollte man das Herumspielen daran tunlichst nur tun, wenn es physikalische Gründe dafür gibt.

„da ich mir ziemlich sicher bin, daß Sie mich nicht zu den „Ausnahmen“ unter den Technikern zählen, will ich Ihre kostbare Zeit nun wirklich nicht mehr länger in Anspruch nehmen. Diese können Sie ja sinnvoller im technischen Diskurs mit Koryphäen ihresgleichen verbringen.“

Bislang habe ich die Diskussion mit Ihnen nicht als Zeitverschwendung gesehen. Sie haben immerhin die Fähigkeit, weitgehend sachlich bleiben. Und damit haben Sie schon mal eine Fähigkeit, die Voraussetzung für eine Diskussion ist, die noch vor den fachlichen Fähigkeiten rangiert. Im übrigen halte ich Klimawissenschaftler nicht für Koryphäen, das sind ganz normale Wissenschaftler, und die Klimawissenschaft ist so normal ist wie jede andere Wissenschaft, wenn man mal hinter die Kulissen guckt und sich nicht vom populistischen Gequarke ablenken läßt. Sie müssen freilich noch lernen, daß Klimamodellierer nicht blinde Anwender einer Simulationssoftware sind, sondern der Sinn des Modelle ist, ein in Details physikalisch konsistentes Abbild des realen Klimas zu liefern und nicht nur eine einzige Meßkurve nachzubilden.

Sehr geehrter Herr Baecker,

da ich mir ziemlich sicher bin, daß Sie mich nicht zu den „Ausnahmen“ unter den Technikern zählen, will ich Ihre kostbare Zeit nun wirklich nicht mehr länger in Anspruch nehmen. Diese können Sie ja sinnvoller im technischen Diskurs mit Koryphäen ihresgleichen verbringen.

Nur noch kurz zu den „Szenarien“: In einem technischen System, dessen Reaktion auf die Änderung der Eingangsgrößen meßbar ist, ist das, was Sie „Szenarien“ nennen, höchstens für die Beurteilung der Stabilität von Bedeutung. Ansonsten vergleichen wir jede Ausgabe des Modells aufgrund von Variationen der Eingangsgrößen einfach mit der Realität. Damit können wir das Systemverhalten über einen definierten Zeitraum tatsächlich vorhersagen, und das ist der Sinn eines Modells.

Wir benutzen den Begriff „Szenario“ daher gar nicht, und ich habe den Eindruck, daß er bei den Klimamodellen dazu mißbraucht wird, die falschen Modellergebnisse aufgrund eines nicht in der Wirklichkeit überprüfbarem Modellverhaltens zu beschönigen. Daß das Klima die Vergleichsmöglichkeit mit der Realität erst im Nachhinein erlaubt, ist natürlich klar. Wenn aber dann eine Divergenz zwischen Modellergebnis und Messungen festgestellt wird, würde ich (als technische Amöbe) einzelne Verstärkungsfaktoren innerhalb des Modells zu Null setzen und dadurch quantifizieren, wie die Abweichung zu erklären ist. Sollte sich dann ein bestimmter Parameter als für die Abweichung überwiegend verantwortlich herausstellen, dann würde ich hoffen, daß mir Jemand den Arbeitsauftrag erteilt, den Grund dafür herauszufinden. hierbei ist es erst einmal egal, ob es sich um ein Verstärkungs- oder ein Stabilitätsproblem handelt (Langzeit/Kurzzeit).

Bis dieser Grund gefunden und das Problem behoben ist, würde das Modell von uns als nicht relevant betrachtet werden. Mit Sicherheit würden keine darauf basierenden Entscheidungen getroffen. Genau da ist der Unterschied zu Klimamodellen, für die ein solches Problem nachweislich besteht, diese Tatsache aber seitens der von „Klimawissenschaftlern“ manipulierten Politik nicht erkannt wird.

Mit freundlichen Grüßen,

M. Stock

Lieber Herr Stock, #67

Danke für Ihre Ausführungen.

„Ich nehme an, daß Klimamodelle grundsätzlich auch so funktionieren“

Ja, so ist es.

„Wie die Klimamodellierer ihre Modelle mit der Wirklichkeit vergleichen, weiß ich natürlich nicht.“

Den Test kann man natürlich nur mit Klimaten der Vergangenheit machen, denn nur dafür gibt es bestenfalls Meßdaten. Und darauf basiert auch die Modellvalidierung der Klimamodellierer, indem sie die outputs mit den beobachteten Meßdaten bei gleichen Randbedingungen vergleichen.

„Offensichtlich ist es aber so, daß verschiedenste Modelle unter (ab einem definierten Zeitpunkt) festgelegten Anfangsbedingungen bezüglich eines bestimmten Ausgabewertes, nämlich der Globaltemperatur, zunehmend in die gleiche Richtung abweichen.“

Das ist richtig. Und den diskutierten Grund habe ich Ihnen ja genannt. Es kann sein, daß die Modelle die dekadische Klimavariabilität auf der Zeitskala nicht richtig hinbekommen. Dennoch können Sie selber anhand der Regensburger Graphik sehen, wie genau die Modelle das Klima hinbekommen. Die von Ihnen kritisierte Abweichung ist klein gegenüber der erreichten Genauigkeit.

„Daß es nicht sinnvoll ist, aus den verschiedenen Kurven dann einen statistischen Mittelwert bilden zu wollen, habe ich herausgefunden.“

Ja, richtig. Der Emsemblemittelwert muß nicht der optimale Schätzwert sein.

„Falls die Klimamodelle, wie Sie sagen, „durch Fortschreibung der Entwicklungen der Vergangenheit“ (was klar ist) auch durch „Szenarien für ihre zukünftige Entwicklung“ kontinuierlich angepaßt werden müssen“

Sie haben das immer noch nicht verstanden. Die Modelle werden verbessert, indem man physikalische Teilprozesse genauer modellieren kann. Dies überprüft man jedoch stets durch den Vergleich mit den Meßdaten, die natürlich nur für die Vergangenheit vorliegen.

Mit den Szenarien der Randbedingungen für die Zukunft hat dies gar nichts zu tun. Die Szenarien sind das Ergebnis der Abschätzung der zukünftigen Entwicklung von anthropogenen Emissionen und der Fortsetzung der natürlichen Klimafaktoren.

„ „Szenarien“ in ein Modell einzubauen, klingt schon nach Voodoo. Kann es sein, daß diese „Szenarien“ besagen, daß es in jedem Fall wärmer werden muß?“

Wieso Voodoo? Sie spielen mit Ihrem Modell doch wohl auch Szenarien durch, indem Sie das Modell mit verschiedenen Randbedingungen betreiben und die Reaktion des outputs darauf betrachten. Nichts anderes macht man mit den Klimamodellen auch. Der Unterschied ist nur, daß man nur die Szenarien von Randbedingungen auch mit Beobachtungsdaten vergleichen kann, die auch in der Vergangenheit real eingetroffen waren. Denn leider lassen sich mit dem realen Klima keine Experimente anstellen.

Wärmer wird es nur, weil die Szenarien von mehr Treibhausgasen in der atmosphäre

„Wie auch immer – Meiner Ansicht nach produzieren die Klimamodelle kein hinreichend genaues Ergebnis und sind damit nach meinem Verständnis keine Grundlage, auf der überhaupt eine Vorhersage möglich ist.“

Wir hatten aber schon geklärt, daß es sich dabei nicht um Vorhersagen handelt, sondern um Szenarien. Eine Vorhersage wäre es dann, wenn Sie sicher angeben könnten, welches Szenarien in Zukunft auch wirklich eintrifft. Was man heute weiß, ist jedoch jedes Anstiegsszenario der Emissionen von der ökonomischen Entwicklung her wahrscheinlicher als ein Szenario, welches eine abrupte Reduktion der Treibhausgase in der Atmosphäre vorsieht.

„Ach so, nur nebenbei: Wie Sie erkennen können, bin ich kein Klimawissenschaftler. Da Sie an anderer Stelle in diesem Forum schrieben, Sie hielten Techniker hinsichtlich ingenieurswissenschaftlicher Themen für inkompetent, und würden diesen nur Arbeitsanweisungen geben, hätte ich natürlich vollstes Verständnis dafür, wenn Sie die Diskussion mit mir an dieser Stelle beenden. Ich möchte Sie keinesfalls dazu verleiten, gegen Ihre Grundüberzeugungen zu handeln ;-)“

Eine Ergänzung meiner Überzeugung war es leider nicht wert, freigeschaltet zu werden, ich schrieb noch sinngemäß: es gibt auch Techniker, die über tiefergehendes Grundwissen verfügen und deren Fähigkeiten und Wissen ich schätze. Meine Aussage gilt nur für die Mehrheit und resultiert aus meinen Erfahrungen. Zu meinen Erfahrungen zählen aber auch die Ausnahmen, und daher handele ich nicht nach einer generellen Grundüberzeugung, sondern nach der Lage im Einzelfall.

Sehr geehrter Herr Baecker,

die Modelle, mit denen ich manchmal zu tun habe, sind (vermutlich) wesentlich einfacher aufgebaut als Klimamodelle und haben auch eine recht begrenzte Zahl von Ein/Ausgangsvariablen. Diese Modelle können aufgrund vorgegebener Anfangsbedingungen einen Systemzustand abbilden und reagieren auf Änderung der Eingangsvariablen entsprechend. Es gibt innerhalb der Modelle Nichtlinearitäten und Begrenzungen, und natürlich wird auch das Zeitverhalten modelliert. Läßt man die die Eingangsvariablen ab einem bestimmten Zeitpunkt konstant, so kann man das Zeitverhalten des Modells beobachten. Da diese Modelle das Verhalten existierender Systeme beschreiben, können wir die Modellqualität durch Messungen mit identischen Anfangsbedingungen und Änderungen in der Wirklichkeit verifizieren. Wenn die Ausgabewerte des Modells von der Realität um mehr als +/- 2% abweichen, ist das Modell nicht tauglich und muß überarbeitet werden.

Ich nehme an, daß Klimamodelle grundsätzlich auch so funktionieren, allerdings wesentlich komplexer sind. Wie die Klimamodellierer ihre Modelle mit der Wirklichkeit vergleichen, weiß ich natürlich nicht. Offensichtlich ist es aber so, daß verschiedenste Modelle unter (ab einem definierten Zeitpunkt) festgelegten Anfangsbedingungen bezüglich eines bestimmten Ausgabewertes, nämlich der Globaltemperatur, zunehmend in die gleiche Richtung abweichen. Daß es nicht sinnvoll ist, aus den verschiedenen Kurven dann einen statistischen Mittelwert bilden zu wollen, habe ich herausgefunden. Am grundsätzlichen Problem der sich vergrößernden Abweichung ändert sich aber dadurch nichts. Falls die Klimamodelle, wie Sie sagen, „durch Fortschreibung der Entwicklungen der Vergangenheit“ (was klar ist) auch durch „Szenarien für ihre zukünftige Entwicklung“ kontinuierlich angepaßt werden müssen, so liegt das Problem wohl in Letzterem. „Szenarien“ in ein Modell einzubauen, klingt schon nach Voodoo. Kann es sein, daß diese „Szenarien“ besagen, daß es in jedem Fall wärmer werden muß?

Wie auch immer – Meiner Ansicht nach produzieren die Klimamodelle kein hinreichend genaues Ergebnis und sind damit nach meinem Verständnis keine Grundlage, auf der überhaupt eine Vorhersage möglich ist. Eigentlich wäre mir das egal, aber genau zu solchen Vorhersagen werden die Klimamodelle ja benutzt.

Ach so, nur nebenbei: Wie Sie erkennen können, bin ich kein Klimawissenschaftler. Da Sie an anderer Stelle in diesem Forum schrieben, Sie hielten Techniker hinsichtlich ingenieurswissenschaftlicher Themen für inkompetent, und würden diesen nur Arbeitsanweisungen geben, hätte ich natürlich vollstes Verständnis dafür, wenn Sie die Diskussion mit mir an dieser Stelle beenden. Ich möchte Sie keinesfalls dazu verleiten, gegen Ihre Grundüberzeugungen zu handeln 😉

Mit freundlichen Grüßen,

M. Stock

Lieber Herr Stock,

„nein, ich habe nicht behauptet, Klimamodelle würden die Temperatur aus dem Temperaturverlauf der Vergangenheit in die Zukunft „extrapolieren“.“

Koennen Sie mir trotzdem erklaeren, wie Se urspruenglich glaubten, wie Klimamodelle das Klima der Zukunft berechnen, mich wuerde mal Ihre Vorstellung interessieren?

„Nach Ihrer Darstellung sind diese Modelle aber grundsätzlich gar nicht dazu geeignet, Voraussagen für die Zukunft zu treffen, denn Sie sagen ja, es wäre „allgemein falsch“, aus dem gegenwärtigen Trend eines Globaltemperaturverlaufs einen Trend für die Zukunft abzuleiten.“

Und haben Sie nun nach meinen Erklaerungen verstanden, wie Szenarien fuer das Klima der Zukunft berechnet werden? Der obige Satz verwundert mich naemlich. Denn Ihre obige Schlussfolgerung folgt mitnichten aus meinen Erklaerungen, denn das „allgemein falsch“ bezog sich ja explizit auf die Extrapolation und nicht auf die Methode der Klkmamodelle, wie Sie in meinen Auffuehrungen nachlesen koennen.

Sehr geehrter Herr Baecker,

nein, ich habe nicht behauptet, Klimamodelle würden die Temperatur aus dem Temperaturverlauf der Vergangenheit in die Zukunft „extrapolieren“. Diesen Begriff haben Sie hier eingeführt, aus welchem Grund auch immer. Vielleicht lesen Sie nochmal nach, bevor das zu einer fixen Idee bei Ihnen wird.

Was die Abweichungen betrifft, so ist deren Größenordnung tatsächlich für die letzten 15 Jahre noch nicht so signifikant, daß man die Klimamodelle deswegen verwerfen müßte. Nach Ihrer Darstellung sind diese Modelle aber grundsätzlich gar nicht dazu geeignet, Voraussagen für die Zukunft zu treffen, denn Sie sagen ja, es wäre „allgemein falsch“, aus dem gegenwärtigen Trend eines Globaltemperaturverlaufs einen Trend für die Zukunft abzuleiten.

Nach dem was ich so nachgelesen habe deutet Einiges darauf hin, daß Sie diesbezüglich Recht haben. Insofern haben die Prognosen (oder was immer das sein soll) des Weltklimarates über eine stetig steigende Erwärmung für die Zukunft kein brauchbares Fundament.

Die Regensburger Grafik ist für mich deshalb etwas seltsam, weil sie beispielsweise für das Jahr 2010 eine Temperaturanomalie von +0,78 Grad zeigt, was durch keine einzige Messung, die ich finden konnte, bestätigt wird. Wenn man diesen Wert auf das realistische Mittel der Meßwerte von ca. 0,5 Grad reduziert, dann fallen die Modellwerte auch dort ebenfalls in Kürze nach unten heraus. Das hat es zwar früher auch schon gegeben, aber da hat sich offenbar noch noch niemand die Mühe gemacht, die Grafiken in dieser Art zu verändern.

Mit freundliche Grüßen,

M. Stock