Steven Michelbach, Geograph

Bereits Anfang des 20 Jahrhunderts war die Klimaerwärmung Gegenstand umfassender Untersuchungen. Forscher sprachen schon 1930 von einer regelrechten „Klimaverwerfung“. Ab 1940 setzte eine markante und völlig unerwartete Abkühlung ein. Tausende von Forschern suchten eine Erklärung dafür, ob Atomwaffentestversuche oder das CO2 aus der Nutzung fossiler Brennstoffe verantwortlich war. Als Forschungsergebnis stand 1967 schließlich fest: „Die Sonne ist jene Kraft, die Schwankungen und Pendelungen unseres Klimas verursacht. Sie hält den Motor in Gang, der für die Zirkulationssysteme der Atmosphäre und Meere verantwortlich ist. Schwankungen der Sonnenaktivität schlagen sich direkt auf Wetter und Klima in allen Regionen der Erde nieder.“

Irgendwie geriet dieses Wissen in Vergessenheit oder wurde verdrängt. Ab 1980 war plötzlich die CO2-Treibhaustheorie wieder in der Diskussion und beschäftigt die Klimaforschung inzwischen aufs Heftigste. Fast panikartig blickt man in eine vermeintlich bedrohliche Zukunft und ist von jeder Form von eventuellen Rekorden wie Hitzerekorden fasziniert und schockiert. In aller Eile wird die Energieversorgung einer ganzen Nation in großer Hektik umgekrempelt.

Eine alte Weisheit aber besagt, man soll den Fluss überqueren und dabei die Steine unter seinen Füßen spüren. Bezogen auf den Klimawandel und die Energiewende gilt dies ebenso. Jeder gewissenhafte Unternehmer prüft ständig die Betriebsbilanz. Immer wieder schaut er auch zurück, ob die Grundlagen für einmal getroffene Entscheidungen noch haltbar sind.

Im Hinblick auf Klimaveränderungen ist seit Jahrhunderten bekannt, dass es natürliche Schwankungen gibt. Gerade deshalb ist es zwingend erforderlich, die Entwicklung konzentriert zu verfolgen. Dabei darf der Blick zurück im Maßstab einzelner Klimaperioden nicht vernachlässigt werden. Auch das vorhandene Datenmaterial muss wiederholt gesichtet und überprüft werden, ob die verwendeten Daten überhaupt noch repräsentativ sind. Hier scheint es erheblichen Arbeitsbedarf im deutschen Klimadatenfundus zu geben. Manche Stationen zeigen einen vermeintlichen Temperaturanstieg durch globalen Klimawandel. Benachbarte Stationen belegen 100 Jahre Stagnation der Temperatur. Was ist da los? Spiegeln sich hier nur Veränderungen im näheren Umfeld in den Daten wider mit der Folge einer notwendigen und konsequenten Disqualifikation der Station, oder entspricht das Gemessene tatsächlich einer natürlichen Entwicklung. Am Beispiel der Extremwerte verschiedener Wetterstationen von der Zugspitze, über den Hohenpeißenberg bis hinunter nach Schwerin in Ostseenähe wird aufgezeigt, welche Kraft tatsächlich für den Klimawandel im deutschen Temperaturdatensatz verantwortlich ist: der Mensch oder die Sonne.

Allgemeiner Einfluss der Sonne auf die Temperatur

Der heiße Sommer 2015 hat gezeigt, wie Rekordtemperaturen tatsächlich zustande kommen. Es sind klare, wolkenlose Tage an denen es zu den vermeintlichen neuen deutschen Temperaturrekorden kam. CO2 in der Atmosphäre soll für diese Rekorde verantwortlich gewesen sein.

Allerdings nur tagsüber, denn an der Rekordstation in Kitzingen lag vor und nach diesem Rekord (05.07. 2015 und wiederholt am 7.08.2015) die Minimumtemperatur in den Nächten um ca. 25 °C niedriger als tagsüber. Trotz hoher CO2-Konzentrationen kann es also innerhalb von 12 Stunden zu einem Wärmeverlust von ca. 25 °C kommen. Kann CO2 tatsächlich nur tagsüber Temperaturrekorde erzeugen, nachts dagegen aber weitgehend wirkungslos sein? Nein! 140 Jahre Klimaforschung in Deutschland haben immer wieder den Einfluss der Sonne auf das Temperaturgeschehen weltweit nachgewiesen. Solche Hitzetage bei klarem Himmel sind eindeutig einer sehr hohen Sonneneinstrahlung geschuldet. In den Nächten fehlt die Einstrahlung und mangels schützender Wolkendecke purzeln die Temperaturen dann „in den Keller“. Die Klimakunde nennt dies „Steppenklima“, wie es schon lange für den unterfränkischen Raum bekannt ist.

Doch nicht nur hier, überall auf der Erde kann man den Einfluss der Sonne auf die Temperatur am eigenen Leib spüren. Ist man direkt der Sonne ausgesetzt, ist an einem klaren Tag ein kräftiger Sonnenbrand aufgrund der intensiven UV-Strahlung unausweichlich. Dies passiert im Hochgebirge, auf dem flachen Land und am Meer. 90 % der Masse der Atmosphäre befinden sich in den unteren 20 km. Ein Teil der auf der Erde eintreffenden Sonnenenergie wird durch Wolken, Luft und Boden (hier besonders von Schnee) zu 30 % wieder in den Weltraum reflektiert. Die restlichen 70 % werden absorbiert: rund 20 % von der Atmosphäre, 50 % von der Erdoberfläche (Kontinente und Ozeane). Wenn also 50 % der Sonnenenergie bis auf die Erdoberfläche gelangen, dann ist das Auftreten eines Sonnenbrandes verursacht durch einen Teil dieses Strahlungsmixes, dem UV-Anteil, verständlich. Entsprechend müssten dann aber auch die bekannten Strahlungsschwankungen der Sonne direkt auf der Erdoberfläche im Lebensraum des Menschen wirksam werden und dort festgestellt werden können. Es verwundert schon, warum dann der Einfluss der Sonne auf das Klima so gering sein soll, wie in den Rechenmodellen des PIK e.V. und des IPCC suggeriert wird.

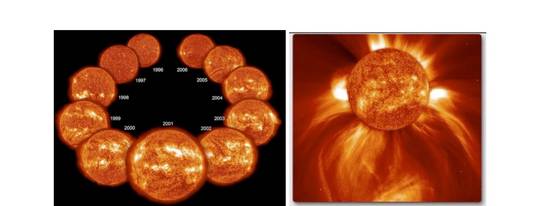

Jahrzehntelange Solarforschung hat ergeben, dass einzelne Anteile der Energieabstrahlung der Sonne sich dabei in durchaus respektablen Schwingungsbreiten oder Amplituden verändern. Die UV-Strahlung schwankt bis um 40 %, bei der Röntgenstrahlung sollen es sogar über 100 % sein, Faktor 2 (!). Die Sonnenfleckenzahl kann zwischen Null und maximal 500 Stück pro Tag variieren. Ähnliches gilt für solare Massenauswürfe, den Sonneneruptionen. Dabei verändert sich auch das Magnetfeld (Ursache der Sonnenflecken und –eruptionen) und auch der Sonnenwind. Wer sich die neuen Fotos der NASA der Raumsonde SDO (Solar Dynamics Observatory) z.B. auf der Webseite der NASA ansieht, kann erkennen, was es bedeutet, wenn im Sonnenmaximum bei hunderten von Sonnenflecken unglaublich große und spektakuläre Energiefreisetzungen stattfinden. Diese beeinflussen zwangsweise auch die Erde. Denn die kleine Erde ist ja gerade nur wenige 107 Sonnendurchmesser von ihrem riesigen Mutterstern entfernt und somit dem riesigen Solarreaktor direkt ausgeliefert.

Link zum Video 5 Jahre Solar Dynamics Observatory SDO: https://www.nasa.gov/content/goddard/videos-highlight-sdos-fifth-anniversary

und http://spaceplace.nasa.gov/review/solar-tricktionary/solarcycle.en.jpg

Abbildung 1: Schwankende Sonnenaktivität zwischen solarem Minimum (1996 und 2006) und Maximum 2001

140 Jahre Klimaforschung in Deutschland

Auf eike-klima-energie.eu, auf kaltesonne.de und vielen anderen nationalen und internationalen Webseiten wird intensiv über die Aktivitätszyklen der Sonne berichtet, beispielhaft seien die Arbeiten von Dr. Theodor Landscheidt (1) und von Raimund Leistenschneider genannt (2). Weniger bekannt oder für viele fast vergessen sind dagegen die Forschungen über den Einfluss der Sonne auf das Klima, die noch vor dem Paradigmenwechsel zum CO2 als Klimaantreiber in den 80 Jahren des 20. Jahrhunderts stattfanden. Herausragende Klimaforscher waren damals Prof. Dr. Julius Hann, Prof. Dr. Wladimir Peter Köppen und Prof. Dr. Artur Wagner, siehe Abbildung 2.

So berichtet Prof. Dr. Julius Hann (3), Universät Wien, in seinem „Handbuch der Klimatologie“ schon 1908 von intensiven Untersuchungen über den Einfluss der schwankenden Sonnenaktiviät auf das Klima. Insbesondere beim Verlauf der Temperatur konnten damals schon zyklische Veränderungen im Rhythmus des 11-jährigen Sonnenzyklus nachgewiesen werden. Er verweist dabei neben vielen anderen Autoren auch auf die Forschungen von Prof. Dr. Wladimir Peter Köppen in der Meteorologischen Zeitschrift Ausgabe 1873, S. 241 und 257: Über mehrjährige Perioden der Witterung insbesondere über die 11-jährige Periode der Temperatur. Köppen war bekanntlich ein deutscher Geograph, Meteorologe, Klimatologe und Botaniker. Er veröffentlichte über 500 Publikationen, die sich zumeist mit den Klimaverhältnissen der Ozeane und Kontinente beschäftigten, jedem Klimawissenschaftler aus vielen Bereichen der Klimakunde bekannt.

Abbildung 2: Bekannte Meteorologen, die sich für die deutsche Klimaforschung vor 100 Jahren verdient gemacht haben.

Kritiker werden gleich aufwerfen, dass man damals ohne Computer und Rechenmodelle solche Zusammenhänge gar nicht zweifelsfrei hat untersuchen können. Bestätigt wurde die Klimabeeinflussung durch die Sonne auch durch die Arbeit von Professor Dr. Artur Wagner, der 1940 das gesamte damalige Wissen über Klimaänderungen und Klimaschwankungen zusammengetragen hat (4). Hintergrund der in diesem Werk veröffentlichten Klimaforschungen war folgender:

Auszug aus dem Vorwort von Prof. A. Wagner zu Klimaänderungen und Klimaschwankungen 1940

„Seit Beginn unseres Jahrhunderts wird eine Änderung verschiedener Klimaelemente immer auffälliger. Es scheint an der Zeit zu sein, die zahlreichen Einzelarbeiten, welche kleinere Gebiete der Erde und einzelne Klimaelemente oder kürzere Zeitintervalle betreffen, zusammenzufassen und die Ergebnisse übersichtlich darzustellen. So gelangt man zu der Feststellung, dass das, was man im landläufigen Sinne als Klima bezeichnet, nichts Unveränderliches ist, sondern recht merklichen Abwandlungen im Laufe von Jahrzehnten und Jahrhunderten unterworfen ist… Die Eisbedeckung der Meere in hohen Breiten nimmt ebenso ab wie die der hohen Gebirge auf der ganzen Erde, die Temperatur des Meerwassers nimmt zu, ja sogar im Tier- und Pflanzenleben lassen sich bereits eindrucksvolle Änderungen nachweisen.“ (4).

Mit den von ihm zitierten 184 Forschungsarbeiten versuchte er die markante Erwärmung, die sich bereits ab Anfang des 19. Jahrhunderts abzeichnete und zu Beginn des 20. Jahrhunderts zu deutlichen Änderungen in den Polarregionen führte, zu erklären. A. Schmauss (1932, zitiert in 3) soll geradezu von einer „Klimaverwerfung“ gesprochen haben. So betrug im Mittel von 7 Orten in Deutschland mit sehr langen Temperaturreihen die Abweichung der Jahresmitteltemperatur 0,9 °C von –0,29 (1891-1895) bis +0,61 °C (1931-1935). In Anbetracht des schon damals über 100 Jahre andauernden Klimawandels mit ansteigenden Temperaturen hat die Internationale Klimakommission empfohlen, den Betrachtungszeitraum für Klimaaussagen auf maximal 30 Jahre zu beschränken und eben nicht möglichst langjährige Beobachtungen zugrunde zu legen. Dies würde einmal die gesetzmäßige Verteilung der Klimaänderungen über der ganzen Erde von Epoche zu Epoche viel klarer erfassen und genauere Aussagen über die Klimaentwicklung ermöglichen. Zusätzlich könnte so die statistische Aussage im Hinblick auf Extremwerte verbessert werden, für sicherere Vorgaben bei Prognosen und Planungen.

Professor Wagner verweist hier wiederum auf die umfangreichen Arbeiten von Prof. W. Köppen zum solaren Einfluss auf die Temperaturen der Erde. Seine Auswertungen von über 100 Jahren Klimaforschung ergaben damals, dass aufgrund der 11-jährigen solaren Schwankung eine die ganze Erde erfassende Schwankung der Temperatur von 0,36 °C resultiert. In einzelnen Regionen können die Abweichungen dabei durchaus größer sein, von bis zu 0,73 °C Temperaturunterschied zwischen Fleckenminimum und –maximum wird berichtet. Der Einfluss der Sonne auf die Temperaturen der Erde wurde zwar eindeutig erkannt, aber es war klar, dass mit den damaligen Mitteln die Wirkungszusammenhänge nicht abschließend gesichert festgestellt werden konnten.

Nach weiteren zwei Jahrzehnten Klimaforschung erschienen 1967 die Forschungsergebnisse von Dr. Hans von Rudloff über die „Schwankungen und Pendelungen des Klimas in Europa seit dem Beginn der regelmäßigen Instrumentenbeobachtungen“ (5) (Leider konnte von Dr. Rudloff kein Foto gefunden werden). Dr. Rudloff hat dazu Beobachtungen und Messungen aus über 300 Jahren zusammengetragen. Hintergrund seiner Arbeit war, dass es nach der Klimaerwärmung bis etwa 1940 zu einer markanten Klimaabkühlung kam. Die Weltgemeinschaft machte sich Sorgen, dass eventuell die Atomwaffentestversuche einen Einfluss auf das Klima haben könnten. „Die Besorgnis weiter Bevölkerungskreise über die Atom-Versuche und ihre eventuellen Auswirkungen auf das Großwettergeschehen wurde durch die seit etwa 1950 zu beobachtende „Klimaverschlechterung“ erheblich genährt. Dass wir uns aber zwischen 1920 und 1953 innerhalb eines säkularen Klimaoptimums befanden, wurde allzu rasch vergessen. Erscheinungen wie der in Süddeutschland extrem trockenheiße Juli 1964 sollten dieser verbreiteten Ansicht der „Klimaverschlechterung infolge Atom-Versuchen“ einen gewissen Einhalt gebieten“, so Rudloff in seinem Vorwort.

Insgesamt ergaben seine Auswertungen der umfangreichen Literatur (1114 Literaturzitate (!)),

dass in jedem Zeitalter mit außergewöhnlichem Verhalten des Wetters zu rechnen ist. So zeigten sich im nördlichen Teil Europas selbst in längeren Abschnitten Temperaturschwankungen, die auf

die Tier- und Pflanzenwelt deutliche Auswirkungen hatten. Die optimalen Wärmeverhältnisse beobachtete man im Norden Europas zwischen 1920 und 1953. Danach gingen in vielen Teilen Europas die Temperaturen zurück, gleichzeitig nahmen die Niederschläge zu. Es war wichtig zu erfahren, dass solche Schwankungen auch in früheren Jahrhunderten auftraten, als es weder Industrie noch Autoabgase gab und Atomwaffentests stattfanden.

„Wie wir heute wohl abschließend feststellen können, übte auch die Industrialisierung durch die Veränderungen im CO2 und SO2-Gehalt der Atmosphäre keinen entscheidenten Einfluss auf den Ablauf unseres Klimas aus… Man wird wohl nicht fehlgehen in der Annahme, dass die Hauptursache der Schwankungen und Pendelungen unseres Klimas in dem von Strahlung, Land- und Meeresverteilung in Gang gehaltenen Zirkulationssystem unserer Atmosphäre zu suchen ist. Die Sonne ist dabei die Kraft, die diesen Motor Zirkulation in Bewegung hält.“ (Dr. Hans von Rudloff, 1967 (5)).

Beim Studieren dieser „alten“ aber dennoch hochaktuellen Werke war der Autor dieses Artikels mehrfach sprachlos. Vor mehr als 6 Jahren begann er selbst sich vertiefter in die Problematik des „Klimawandels“ einzuarbeiten. Seit einigen Jahren werden eigenständige Auswertungen von deutschen und internationalen Klimadatenreihen vorgenommen. Dabei ist der eindeutige Zusammenhang zwischen den solaren Zyklen und zyklischen Schwankungen in verschiedenen Temperaturmessreihen aufgefallen. Auf kaltesonne.de wurde bereits zu diesem Thema „Solares Paradoxon Deutschlands, Teil I“ berichtet (6). Es war wie eine Offenbarung über 100-jährige Literatur in den Händen zu halten, in der sogar der bekannte Professor Köppen schon 1873 vom Einfluss solarer Zyklen auf Schwankungen der Temperatur in verschiedenen Regionen der Erde berichtete.

Mit dem Solaren Paradoxon Deutschlands – Teil II soll hier explizit noch einmal aufgezeigt werden, dass gerade in Deutschland seit über 140 Jahren der Einfluss solarer Aktivitätszyklen auf zyklische Veränderungen der Temperatur hinlänglich bekannt ist. Außer beim PIK e.V. in Potsdam. Dass der solare Einfluss auch heute noch wirksam ist, wird an den nachfolgenden Beispielen erläutert.

Abbildung 3: Die Entwicklung der Wintertemperaturen der Wetterstation Zugspitze im Einfluss der Solarstrahlung.

Abbildung 3 zeigt die Entwicklung der Wintertemperatur auf der Zugspitze im Zusammenhang mit dem Verlauf der Solarstrahlung. Die Temperatur ist hier als 5-jähriges gleitendes Mittel aus den Mittelwerten der Monate Januar bis März errechnet. Deutlich ist zu erkennen, dass sich die solaren Aktiviätsschwankungen häufig direkt in Temperaturänderungen niederschlagen. Nur in der Abkühlungsphase der 60er und 70er Jahre kam der Rhythmus „aus dem Tritt“. Die Solarstrahlung ist ja auch nur einer von mehreren solaren Parametern, die temperaturverändernd auf die Erde wirken. Ein völliger Gleichlauf zwischen Solarstrahlung und Temperatur ist bei der Komplexität des Wetters ohnehin nicht zu erwarten.

Weiter ist zu erkennen, dass die „Klimaerwärmung“ der Zugspitze bezogen auf das Winterhalbjahr bereits Vergangenheit ist, dies gilt auch für andere Alpengipfel. Nach einem singulären Erwärmungspeak um 1990, gingen die Wintertemperaturen wieder zurück und liegen bereits heute wieder auf dem Niveau der Winter vor 1980. Der Temperaturpeak um 1990 geht auf eine bekannte, markante Umstellung der Nordatlantischen Oszillation NAO Ende der 80er Jahre zurück.

Doch auch in den Sommermonaten verhält sich das Temperaturgeschehen in Deutschland paradox zu den Theorien des PIK e.V.. Steigen wir dazu von der Zugspitze hinab auf den 988 m hohen Hohenpeißenberg zum meteorologischen Observatorium des Deutschen Wetterdienstes. Abbildung 4 zeigt die Temperaturentwicklung der Wetterstation Hohenpeißenberg am Beispiel der kältesten Nächte im August im Zeitraum von 1893 bis 2015. Das Klimageschehen erscheint für den sehr langen Zeitraum sehr komplex. Für einen besseren Überblick wurde nachfolgend in Abbildung 5 der Zeitraum 1940 bis 2015 „herausgezoomt“.

Abbildung 4: Klimawandel am Beispiel der August-Min-Temperaturen der Wetterstation Hohenpeißenberg im Einfluss der Sonnenaktivität und dem Index der NAO 1893 bis 2015.

Im Hinblick auf die oben genannten Forschungsarbeiten der Autoren Prof. Hann, Prof. Köppen, Prof. Wagner und Dr. Rudloff, Hinweise unten in den Abbildungen 4 und 5, bot es sich zunächst an, den gesamten vorhandenen Datensatz auszuwerten. Gemeinsam mit der Temperatur der kältesten Nächte im August ist noch der Verlauf der Nordatlantischen Oszillation NAO und eine Sonnenaktivitätszahl S4 aufgeführt. Für diese Kennzahl wurden die solaren Faktoren: Solarstrahlung, Sonnenstürme, geomagentischer Index und Sonnenfleckenzahl bezogen auf ihr jeweiliges Minimum und Maximum auf Werte zwischen Null und Eins normiert und der Mittelwert daraus gebildet. Die Sonnenaktivitätszahl erlaubt damit die Darstellung mehrere solarer Faktoren in einer einzigen Kennlinie. Die genaue Vorgehensweise führt an dieser Stelle zu weit und wird deshalb im Anlage 1 erläutert.

Gleiches gilt für die Darstellung des Index für die Nordatlantische Oszillation NAO. Um die Daten in einem Diagramm zusammen mit der Temperatur und der Sonnenaktivitätszahl darstellen zu können, wurde der NAO Index ebenso auf Werte zwischen Null und 1 umgerechnet, in Anlage 1.

Verfolgt man nun den Verlauf der Nachttemperaturen Min im August, in Abbildung 4 dargestellt als 5-jähriges gleitendes Mittel, fällt das zyklische Verhalten aller Parameter auf. Zehn von zwölf solaren Zyklen spiegeln sich in entsprechenden Zyklen der Temperatur wider. Bis 1945 erfolgte ein Anstieg der Temperatur, der ja auch Auslöser für Professor Wagner war, die Ursachen einer Klimaerwärmung zu erforschen. Im gleichen Zeitraum stieg auch die Sonnenaktivität an, wie am Verlauf der Sonnenaktivitätszahl gut zu erkennen ist. Bis etwa 1980 kam es dann zu der Abkühlungsphase, die Dr. Rudloff zu seinen Forschungen zu den Schwankungen und Pendelungen des Klimas veranlasste. Die Abkühlung dauerte bis in die 80er Jahre. In diesem Jahrzehnt hatte auch die NAO eine Schwächephase. Gleichzeitig gab es einen Rückgang der Minima bei der Sonnenaktivitätszahl (1955 und 1965) und einen schwachen Sonnenzyklus in den 70er Jahren.

Abbildung 5: Klimawandel am Beispiel der August-Min-Temperaturen der Wetterstation Hohenpeißenberg im Einfluss der Sonnenaktivität und dem Index der NAO 1940 bis 2015.

Abbildung 5 zeigt die Entwicklung für die zweite Hälfte des 20. Jahrhunderts. Ausgehend von dem Tiefpunkt der 70er Jahre schaukelten sich die Min-Temperaturen der Nächte im August immer höher und erreichten Anfang 2000 ein Maximum bezogen auf das 5-jährige gleitende Mittel. Es ist zu erkennen, dass die zyklischen Veränderungen der Temperatur seit 1950 bei 7 Zyklen ohne Unterbrechung im gleichen Rhythmus wie die solaren Zyklen verliefen. Vergleicht man drei Jahre um das solare Maximum mit drei Jahren um das Minimum, ergibt sich bei der Min-Temperatur für den Monat August ein Anstieg um das solare Maximum von ca. +1,3 °C. W. Köppen hat, wie oben beschrieben, aufgrund der 11-jährigen solaren Schwankung eine die ganze Erde erfassende Schwankung der Temperatur von 0,36 °C festgestellt (4). In einzelnen Regionen können die Abweichungen dabei durchaus größer sein, mit bis zu 0,73 °C. Am Hohenpeißenberg beträgt die Schwankung der August-Min-Temperatur in der Phase einer sehr aktiven Sonne zwischen 1950 und 2015 sogar erstaunliche 1,3 °C.

Im Hintergrund der Graphik ist zwischen 1965 und 1995 auch bei der NAO der solare Rhythmus immer wieder erkennbar. Da es weniger wahrscheinlich ist, dass die Menschheit von der kleinen Erde aus der Sonne ihren „hektischen vermeintlich klimaschädlichen“ Rhythmus aufzwingen könnte, muss es wohl umgekehrt sein. Die Sonnenzyklen wirken sich eindeutig auf dem Hohenpeißenberg auf die Nachttemperaturen im August aus und das über 6 Jahrzehnte lang und nicht nur dort. Mit dem bekannten Einbruch der Sonnenaktivität seit ca. 10 Jahren, ist die NAO in den kälteren Modus zurückverfallen und die Nächte im August werden wieder kälter.

Es scheint, dass für die Erklärung der Klimaentwicklung in Deutschland die Theorie „CO2 führt zum Treibhaus Erde“ gar nicht benötigt wird. Ein Einfluss des CO2 mit seinem exponentiellen Anstieg auf die Temperaturentwicklung in Deutschland ist überhaupt nicht erkennbar!

In Anbetracht dessen wird ein besonderer Ausschnitt der jüngeren Klimageschichte Deutschlands vorgestellt. Begeben wir uns dazu vom Hohenpeißenberg in die Niederungen der Klimaforschung nach Potsdam.

Abbildung 6 zeigt die Entwicklung der Extremwerte für die heißesten Tage und kältesten Nächte im Monat August für Potsdam zwischen 1893 und 2015 im Vergleich zur Temperaturentwicklung in Schwerin. Links oben in Abbildung 6 erkennt man für den gesamten Messzeitraum für Potsdam einen Anstieg der Messwerte für beide Messgrößen. Ist daraus schon tatsächlich auf einen Klimawandel mit Klimaerwärmung zu schließen? Analysiert man den Messzeitraum zwischen 1923 und 1989 so fällt allerdings auf, dass die Temperatur der heißesten Tage zunimmt, die der kältesten Nächte dagegen abnimmt. Gleichzeitig Erwärmung und Abkühlung? Ein Blick auf das Temperaturgeschehen der Wetterstation Schwerin (200 km Entfernung) zeigt zwar für den gesamten Messzeitraum 1890 bis 2015 ebenso einen Trend der Erwärmung, im Zeitraum zwischen 1890 und 1989 herrscht aber fast 100 Jahre eine Stagnation der Temperatur der heißesten Tage und kältesten Nächte. Kein Klimawandel über 100 Jahre!

Wie am Beispiel der Wetterstation Zugspitze in Abbildung 3 bereits erläutert wurde, hat es zwischen 1985 und 1990 ein markantes Erwärmungsereignis durch die NAO gegeben. Vor diesem Ereignis war in Schwerin von einer Klimaänderung allerdings 100 Jahre lang überhaupt nichts zu spüren. Was lies dann aber in Potsdam ab 1923 die Temperaturen auf dem Telegrafenberg extremer werden, tagsüber heißer und nachts kälter? Könnte es sein, dass zu Beginn der Messungen die Wetterstation Potsdam auf dem Telegrafenberg zunächst in einer relativ kleinen Waldlichtung gelegen hat? Der umliegende, schützende Wald milderte damals die Temperaturextreme ab, weniger heiß tagsüber, weniger kalt in den Nächten. Mit der baulichen Entwicklung der meteorologischen Forschungseinrichtungen, der Ausdehnung der Waldlichtung, dem Bau von Erschließungsstraßen, die ehemalige geschotterte Waldwege ersetzten, die Umzäunung des Messgeländes mit einem schwarz gestrichenen Jägerzaun etc., letztlich die gesamte bauliche

Abbildung 6: Das Klimapendel schlägt zurück. Der Verlauf der Minimumtemperaturen im August zwischen 1890 und 2015 der Wetterstationen Potsdam und Schwerin. Seit 1989 zeigt sich ein deutlicher Trend der Abkühlung.

Erschließung könnte die extremeren lokalen Klimabedingungen auf dem Telegrafenberg bei Potsdam ausgelöst haben. Insgesamt ein Beispiel für viele Wetterstationen, bei denen Änderungen im lokalen Umfeld einen Trend zu wärmeren Temperaturen beim lokalen Kleinklima ausgelöst haben. Viel häufiger als das Beispiel dieser in klimatischer Sicht veränderten Waldlichtung ist die Problematik des Stadt-Land-Effektes bei vielen Wetterstationen. Anmerkungen zum Wärmeinseleffekt in deutschen Wetterdaten hat der Autor im Sommer diesen Jahres bereits hier geäußert: http://www.eike-klima-energie.eu/climategate-anzeige/waermeinseleffekt-in-deutschen-wetterdaten/

Beim Sport reichen manchmal schon wenige Millimeter zur Disqualifikation. Bei der Klimadatenmessung dürfen scheinbar alle „mitlaufen“, egal wie stark das Umfeld von Stationen im Laufe langjähriger Messreihen gegenüber ihrem Startzustand verändert wurde. Welcher neutrale Schiedsrichter entscheidet bei der Klimadatenmessung über einen Ausschluss vom Wettkampf? Wieviel Wärmeinseleffekt darf eine Station in den Gesamtdatensatz von Deutschland einbringen und damit einen CO2-bedingten Klimawandel vorgaukeln ohne Disqualifikation?

Die klimawirksame Umstellung der Nordatlantischen Oszillation NAO hin zu einem sehr „wärmefördenden“ Modus für Mitteleuropa geschah um 1988. In den Graphiken in Abbildung 6 unten ist offensichtlich zu sehen, dass die NAO-bedingte Erwärmung Deutschlands nicht lange anhielt. Seit 1990, seit 27 Messjahren, setzte sowohl in Potsdam als auch in Schwerin für die heißesten Tage im August ein Temperaturrückgang ein: Potsdam –0,6 °C; Schwerin – 1,7 °C. In Potsdam stagniert die Temperatur der kältesten Nächte, in Schwerin betrug der Rückgang –0,3 °C.

Dem Kritiker mag dies marginal erscheinen, zudem sind es nur einzelne Tage im August! Die Überraschung wird aber noch größer, wenn man die Entwicklung der Wintertemperaturen in Potsdam analysiert, siehe Abbildung 7. Dargestellt ist das Mittel der kältesten Nächte der Monate Januar bis März für den gesamten Messzeitraum. Es ist gut zu erkennen, dass die kältesten Nächte im Winter eindeutig parallel mit der NAO verlaufen. Um 1988 war das Maximum im Wärmemodus der NAO. Seither sind in Potsdam, und nicht nur da, die Temperaturen der kältesten Winternächte wieder markant gefallen, nämlich –2,8 °C in 27 Messjahren. J. Kowatsch z.B. in Leistenschneider et al. (7) hat bereits auf die immer kälter werdenden Winter in Deutschland aufmerksam gemacht.

Abbildung 7: Klimawandel durch den Einfluss der NAO am Beispiel der Winterminima-Temperatur der Monate Januar bis März (gemittelt) der Wetterstation Potsdam.

Die kältesten Nächte sowohl in den Sommermonaten als auch in anderen Jahreszeiten sind auf bestimmte Wetterlagen zurückzuführen. Vermutlich sind es klare Nächte bei Nord- bis Nord-Ost-Wetterlage, die diese Minimumtemperaturen verursachen. Möglicherweise wird hier die Abkühlung des Nordatlantiks bereits in Deutschland erkennbar und draußen im Freien auch spürbar.

Mit einer Analyse des heißen Sommers 2015 wird abschließend aufgezeigt, wie paradox sich die Klimadiskussion in Deutschland insgesamt darstellt. Abbildung 8 zeigt die Augusttemperaturen der langen Messreihe des Deutschen Wetterdienstes. Es ist bekannt, dass erst ab 1880 das deutsche Messnetz vereinheitlicht wurde und die offizielle Messreihe deshalb erst ab diesem Datum startete. Dennoch sind die früheren Werte ebenso fachkundig gemessen und taugen deshalb für die Beurteilung der langfristigen Entwicklung. Es geht hier ja nicht um Nyancen von Zehntelgrad. In die Graphik ist unten der Verlauf der Sonnenaktivität am Beispiel der Sonnenfleckenzahlen eingefügt.

Abbildung 8: Klimawandel in Deutschland im Einfluss der Sonnenaktivität am Beispiel der langjährigen Messreihe der August-Temperaturen. Starke Sonne führt zu Temperaturanstieg, schwache Sonne zu Temperaturückgang! Ist das der Grund, warum der wissenschaftliche Beweis, dass CO2 einen Treibhauseffekt mit Klimaerwärmung verursachen soll, bis heute nicht erbracht wurde?

Die Auswertung geschah ohne Großcomputer im Unterschied zu den Klimauntersuchungen am PIK e.V. in Potsdam. Die Länge der Erwärmungs- und Abkühlungsperioden wurde nach Augenschein und unter Berücksichtigung der solaren Aktivität vorgenommen. Für Kritiker wahrscheinlich rein unwissenschaftliches „cherrypicking“. Für diejenigen, die eine Erklärung der tatsächlichen Ursachen für den Klimawandel suchen, ein weiterer Schritt, ein weiteres Indiz dafür, was wirklich passiert. Kritiker mögen im Gegenzug versuchen über den Verlauf der CO2-Konzentration der Atmosphäre eine bessere und überzeugendere Erklärung für die Temperaturentwicklung Deutschlands seit 1760 abzugeben.

Die erste Analyse der mittleren Augusttemperaturen ergab zunächst ein wirres, scheinbar ungeordnetes Auf und Ab. Aber immerhin war deutlich zu erkennen, dass es wärmere und kältere Phasen gab. Mit viel Aufwand ohne PC haben die Klimaforscher vor 100 Jahren gut erkannt, dass man den Zeitraum für die Beurteilung des Klimas und der Klimavariabilität einer Region zeitlich begrenzen muss, um genauere Aussagen für Klimaentwicklungen zu erhalten. Wie oben bereits erwähnt, hat die Internationale Klimakommission deshalb empfohlen den Betrachtungszeitraum für Klimaaussagen auf 30 Jahre zu beschränken, beginnend mit der Periode 1901 bis 1930. Wer diese 30-Jahresperiode einmal in Gedanken über den gesamten Zeitraum jahreweise verschiebt, erkennt die Variabilität der deutschen Augusttemperaturen und damit die Erkenntnisse bezüglich eines bestimmten Klimazustandes. Das eine „Klima für Deutschland“ gibt es wahrlich nicht, es gibt nur die ständige Variabilität innerhalb statistischer Extremwerte. Und diese verändern sich, je länger der Betrachtungszeitraum gewählt wird. Um einen Klimawandel überhaupt gesichert feststellen und beurteilen zu können, benötigt man mindestens zwei Messperioden also 60 Jahre!

Erst wenn man die Augusttemperaturen mit dem Verlauf der Sonnenaktivität koppelt, klärt sich das ungeordnete Verhalten und es zeigt sich der bedeutende Einfluss der Sonne auf unser Klima. Vereinfacht wurden die Sonnenzyklen in starke und schwache aufgetrennt. Dies ist durch die eingezogene orange-blaue Linie rein per Augenschein geschehen. Je länger man dieses Auf und Ab der Sonnenaktivität betrachtet, könnte man sehr vereinfacht meinen, dass die Sonne nur zwei Betriebszustände kennt; entweder deutlich überdurchschnittlich (Vollgas-Autobahn) oder deutlich unterdurchschnittlich (Gemächlich-Landstraße). Es scheint darüber hinaus selten der Fall einzutreten, dass nur ein Zyklus unter- oder überdurchnittlich ist. Meistens sind es drei, vier oder gar fünf in etwa gleichgeartete Zyklen. Phasen mit aktiver Sonne mit hohen Sonnenfleckenzahlen wurden mit der Farbe Orange belegt, schwache Phasen mit Blau.

Verfolgt man nun ab 1760 das Temperaturgeschehen in Deutschland für den Monat August im Vergleich mit der Sonnenaktivität, so fällt auf, dass es in Phasen überdurchschnittlicher Sonnenaktivität zu einer Erwärmung im Sommer kam, ansteigender Temperaturtrend. Immer, wenn die Sonne schwächer war und die Sonnenfleckenzahlen zurückgingen, kam es dann nachfolgend zu einer Temperaturabkühlung. Die Trends der einzelnen Erwärmungs- und Abkühlungsphasen wurden berechnet.

Weiter fällt auf, dass bis 1980 langfristig zwar ein Auf und Ab der Temperatur erfolgte. Würde man für den langen Zeitraum von 220 Jahren von 1760 bis 1980 einen Trend berechnen, so wäre der wenig ausgeprägt. Dies zeigten ja auch die Extemwerte für den Monat August der Wetterstation Schwerin über fast 100 Jahre zwischen 1890 und 1989. Erst ab ca. 1990 stiegen die Augusttemperaturen in Deutschland überdurchschnittlich an und erreichten Spitzenwerte um 2000.

Kritiker sehen hier endlich den Einfluss des CO2. Klimarealisten fällt allerdings auf, dass um 1970 der 20. solare Zyklus unterdurchschnittlich war, aber eben nur dieser. Eine längere Abkühlungsphase über mehrere Jahrzehnte wie in den 200 Jahren zuvor ist ausgeblieben. Ab ca. 1980 haben deshalb drei überdurchschnittlich starke solare Zyklen, die den drei starken Zyklen zwischen 1940 und 1960 nachfolgten, zu einer deutlichen Temperaturerhöhung geführt, die bekannte Phase der Klimaerwärmung. Wie oben ausgeführt, passt in die Erwärmung nach 1990 auch die Entwicklung der NAO. Für die letzten Jahre ab ca. 2000 muss auch für die lange Messreihe der Augusttemperaturen in Deutschland diagnostiziert werden, dass bereits ein deutlicher Abkühlungstrend eingesetzt hat. An diesem Trend hat selbst der heiße Sommer 2015 nichts geändert. Auch für den längeren Zeitraum ab 1990, 25 Jahre, ist die Temperaturentwicklung negativ. Es wird eindeutig wieder kälter!

So wie eine Schwalbe noch keinen Sommer macht, so machen einzelne Temperaturrekorde noch keinen Klimawandel. Analysiert man die Temperaturen der Rekordstation Kitzingen im Sommer 2015 genauer, so erkennt man, dass den heißen Tagestemperaturen vergleichsweise niedrige Nachttemperaturen gegenüber stehen. Die Differenz zwischen Tagesmaximimum 40,3 °C (Deutschlandrekord) und den Nachttemperaturen mit ca. 15 °C um diese Rekordtage herum beträgt fast 25 °C, siehe oben. Wenn Kohlenstoffdioxid tagsüber für diese Rekordtemperaturen verantwotlich sein soll, wieso hält es dann nicht auch in den Nächten die Wärme zurück? Wie könnte in der kleinen Waldlichtung in Potsdam das CO2 nur tagsüber für eine Erwärmung sorgen, nachts aber unwirksam sein und statt dessen eine Abkühlung zulassen, wie es im Zeitraum zwischen 1923 und 1988 in Potsdam passierte? Es bleibt festzustellen: Im deutschen Temperaturdatensatz gibt es Stationen, die man eigentlich disqualifizieren müsste. In der Summe aus „Guten“ und „Schlechten“ gibt es keine halbgute, sondern doch nur eine schlechte „Mannschaftsleistung“, ein falsches Ergebnis im Hinblick auf die Erkenntnis über den Klimawandel.

Bereits 1967 hat Dr. Rudloff den Einfluss der Sonnenaktivität auf die Sommertemperaturen in Mitteleuropa am Beispiel der Wetterstation Basel-Binningen für die Phase 1750 bis 1960 aufgezeigt (in (5), Seite 254), siehe Abbildung 9. Sie deckt sich genau mit dem in Abbildung 8 dargestellten Verlauf der Augusttemperaturen in Deutschland. Das sind über 250 Jahre solarer Einfluss auf die Temperatur in Deutschland und damit in Mitteleuropa.

Abbildung 9: Wirkung variabler Sonnenaktivität auf Sommertemperaturen und Niederschlag in Mitteleuropa nach H. Rudloff (in (4), S. 254)

Wie die moderne Solarforschung festgestellt hat, ist die Sonnenaktivität seit ca. 10 Jahren stark eingebrochen. Die Entwicklung der solaren Prozesse deutet an, dass mindestens die nächsten zwei Zyklen ebenfalls unterdurchschnittlich ausfallen werden. Aus 250 Jahren Temperaturentwicklung im Einklang mit der Sonne bleibt daraus nur die eine Schlussfolgerung: Das Klimapendel schlägt zurück, die Erwärmung ist vorbei, die Abkühlung hat bereits eingesetzt und wird wahrscheinlich mehrere Jahrzehnte andauern. An dieser Entwicklung hat selbst der heiße Sommer 2015 nichts ändern können. Die aktuelle Entwicklung in der Arktis lässt daran keine Zweifel.

Aktuelle Klimafakten einer Abkühlung der arktischen Polarregion

Abkühlung des Nordatlantiks, Zunahme der Schneebedeckung auf Grönland, Wachstum des arktischen Meereises (Maximum der letzten 10 Jahre, ohne die Küstenregionen betrachtet), Maximum der Eisbedeckung auf der Hudson Bay, schneereiche und kalte Winter im Osten Kanadas und der USA, Zunahme der Schneebedeckung der gesamten Nordhemisphäre im Winterhalbjahr, starke Abkühlung der Winter in den Hochalpen und in Deutschland insgesamt, Abkühlung der kältesten Nächte in den Sommermonaten in Deutschland um mehrere Grad seit Anfang 2000, kältester Sommer 2015 in Nordeuropa seit über 60 Jahren…

Fazit und Bewertung

Die Analyse der Entwicklung der Extremwerte von Wetterstationen zwischen Zugspitze und Ostsee zu verschiedenen Jahreszeiten hat gezeigt, dass nicht ein zusätzlicher Wärmeschub aufgrund eines vermeintlich CO2-bedingten Treibhauseffektes für die Klimaentwicklung in Deutschland verantwortlich war. Es war das Fehlen von Kälte aus der Polarregion. 5 Jahrzehnte mit starker Sonnenaktivität, führten zu einem Zurückschmelzen des Polareises. Die schnee- und eisbedingte Albedo veringerte sich. Die Polarregionen wurden weniger kalt. Eine Umstellung der Nordatlantische Oszillation NAO war die Folge. Dieser Zustand führte zu weniger kalten Wintern und weniger kalten Extremtemperaturen einzelner Monate auch in Mitteleuropa, allerdings nur für wenige Jahre. Dieser Prozess hat sich seit ca. 25 Jahren wieder umgekehrt.

Bei alleiniger Betrachtung von langjährigen Temperaturmittelwerten war der Schluss falsch, dass eine allgemeine globale Erwärmung stattfand und diese auch in Mitteleuropa relevant wäre. Wie bereits vor 100 Jahren in der deutschen Klimaforschung darauf hingewiesen wurde, erkennt man bei fundierter Analyse der 30-Jahresperioden und ihrer Extremwerte die tatsächliche Klimaentwicklung wesentlich klarer. Die Analyse der Extremwerte des Monats August und der Wintertemperaturen von Wetterstationen zwischen Zugspitze und Ostsee (Schwerin) zeigt seit 25 Jahren einen klaren Trend zu kälteren Temperaturen.

Die Deutsche Klimaforschung hat schon vor 1970 den Zusammenhang zwischen Klima und Sonnenaktivität klar erkannt. Bereits Dr. Rudloff betonte, dass die Sonne die Kraft ist, die Schwankungen und Pendelungen unseres Klimas verursacht. Sie hält den Motor in Gang, der für die Zirkulationssysteme der Atmosphäre und Meere verantwortlich ist. Schwankungen der Sonnenaktivität schlagen sich direkt auf Wetter und Klima in allen Regionen der Erde nieder. Die weitere Temperaturentwicklung in Deutschland zwischen 1970 und 2015 lässt sich ebenso allein mit dem Verlauf der Sonnenaktivität und der Nordatlantischen Oszillation NAO erklären. Eine Hinzuziehung des Kohlenstoffdioxids CO2 für weitere Erklärungsversuche ist nicht von Nöten. Entsprechend ist ein Einfluss des CO2 auf das Klima in Mitteleuropa nicht erkennbar und deshalb auch nicht gegeben. Deutschland muss sich nicht auf eine weitere Klimaerwärmung einstellen. Mit dem Einbruch der Sonnenaktivität droht eindeutig eine jahrzehntelange Klimaabkühlung mit allen negativen Begleiterscheinungen.

Die Klimaentwicklung der Zugspitze zeigt eindrücklich, dass die aktuelle Referenzperiode 1991 bis 2020 bisher komplett von einem markanten Abkühlungstrend beherrscht wird, sowohl bei den heißesten Tagen im August wie auch bei den kältesten im Winter von der Zugspitze bis hinab zu Ostsee. Es wäre fahrlässig diese Entwicklung zu ignorieren.

Nach der hier vorgestellten Analyse deutscher Klimadaten liegen die tatsächlichen Beweggründe für die Klimakonferenz in Paris zur Begrenzung der globalen Erwärmung durch Reduzierung der atmosphärischen CO2-Konzentration im Dunkeln…

Literatur

(1) Th. Landscheidt: Sonnenaktivität als dominanter Faktor der Klimadynamik. http://www.schulphysik.de/klima/landscheidt/sonne1.htm

(2) Leistenschneider, R. (2011): Dynamisches Sonnensystem – Die tatsächlichen Hintergründe des Klimawandels. Teile 1 bis 8. http://www.eike-klima-energie.eu.

(3) Hann, Julius (1908): Handbuch der Klimatologie. Band I: Allgemeine Klimalehre. Verlag von Engelhorn, Stuttgart.

(4) Wagner, Artur (1940): Klimaänderungen und Klimaschwankungen. Die Wissenschaft Band 92, Friedrich Vieweg und Sohn, Braunschweig.

(5) Rudloff, Hans v. (1967): Die Schwankungen und Pendelungen des Klimas in Europa seit dem Beginn der regelmäßigen Instrumenten-Beobachtungen (1670). Friedrich Vieweg und Sohn, Braunschweig.

(6) Michelbach, S. (2015): Solares Paradoxon Deutschlands, Teil I: Solare Zyklen in der deutschen und der globalen Temperaturmessreihe. http://www.kaltesonne.de

(7) Leistenschneider, R.; Kowatsch, J.; Kämpfe, S. (2015): Sommer 2015 – Die Sonne ist an allem schuld! http://www.eike-klima-energie.eu.

Anlage 1 Berechnung der Sonnenaktivitätszahl S4

Die Sonnenaktivitätszahl wurde hier eingeführt, um mehrere solare Parameter in einer Größe zu vereinigen. Damit ist die Darstellung der Sonnenaktivität im Vergleich mit anderen Messgrößen wie der Temperatur oder der Nordatlantischen Oszillation NAO in einem Diagramm möglich.

Als solare Parameter wurden die Solarstrahlung, die Anzahl der Sonnenstürme, das Solare Magnetfeld als „heliospheric magnetic field“ nach NOAA J. Lean, und die Anzahl der Sonnenflecken gewählt. Da jeder Parameter seine eigene Dimension besitzt, mussten sie zunächst auf Werte zwischen Null und Eins „normiert“ werden. In Anlehnung an ihre jeweiligen Minima und Maxima wurden folgende Werte als Null und Eins definiert.

Durchführung der Normierung für die Sonnenaktivitätszahl

|

Solarstrahlung Sin |

Anzahl der Sonnenstürme Stn |

heliospheric magnetic field HMF Bn |

Anzahl der Sonnenflecken SSn |

|

Minimum der Messreihe: 1364,3 W/m² gewählt: 1358 W/m² |

Minimum der Messreihe: gewählt: 0 |

Minimum der Messreihe gewählt: 4 |

Minimum der Messreihe 0 gewählt: 0 |

|

Maximum der Messreihe: gewählt: 1367 W/m² |

Maximum der Messreihe: 71 gewählt: 80 |

Maximum der Messreihe 9,48 gewählt: 10 |

Maximum der Messreihe 191 gewählt: 200 |

Beispiel

Anzahl der Sonnenflecken = 85,2

die normierte Sonnenfleckenzahl beträgt dann (85,2 – Min)/Max = (85,2-0)/200 = 0,456

Berechnungsformel für die Sonnenaktivitätszahl S4

Da nach R. Leistenschneider das solare Magnetfeld womöglich einen stärkeren Einfluss auf die Temperatur hat als die anderen Parameter, wurden in nachfolgender Formel eine entsprechende Gewichtung vorgenommen.

Sonnenaktivitätszahl S4 = 0,2xSin + 0,2xStn + 0,4xHMF Bn + 0,2xSSn

Um den Index der NAO in einem Diagramm zusammen mit der Sonnenaktivitätszahl und der Temperatur darzustellen war es aus programmtechnischen Gründen erforderlich, auch diese Größe in Werte zwischen Null und Eins umzurechnen. Dazu wurden als Minimumwert –6 und als Maximum +6 gewählt und daraus die normierten Werte wie im Beispiel für die Sonnenflecken, siehe ob

Lieber Herr Bäcker #116,

sie schreiben:

„Die Klimamodelle machen keine Annahmen, sondern stecken nur bekannte Zusammenhänge rein.“

Das ist irreführend. Jede Differentialgleichung mit der man versucht die Wirklichkeit zu beschreiben ist eine Annahme. Das Klimamodell ist die Annahme, also auch viele Zusammenhänge die drin stecken, auch wenn sie die mit dem Adjektiv „bekannt“ versehen.

Was sie mit „bekannter Zusammenhang“ bezeichnen ist eine Annahme. Das sollte gerade einem Naturwissenschaftler bewusst sein. Das ist aber vielleicht auch das Problem in der Klimadebatte. Viele Annahmen werden als sichere Fakten verkauft. Als Beispiel. Die ideale Gasgleichung ist ein bekannter Zusammenhang. Nichtsdestotrotz nur eine Annahme.

Sorry, aber was sie betreiben liest sich für mich wie eine Pseudodiskussion die Laien aufs Glatteis führen soll.

Lieber Herr Landvoigt,

„Heutige Klimamodelle machen auch annahmen über Wirkzusammenhänge, die man nicht hinreichend kennt.“

Eben das ist ja falsch. Die Klimamodelle machen keine Annahmen, sondern stecken nur bekannte Zusammenhänge rein. Sie verstehen einfach immer noch nicht, wie physikalischen Modellle arbeiten und setzen fälschlicherweise Parametriesieren mit Annehmen von Hypothesen gleich!

#108: NicoBaecker sagt:

nochmal eine Bemerkung von mir als Naturwissenschaftler.Sie habe doch die Epizykel-Fits für die Planetenbewegung genannt. Bei der Untersuchung von Herrn Michelbach und anderen Untersuchungen über mögliche Korrelationen von Sonnenaktivität zum Klima handelt es sich ebenfalls um nichts anderes als Fits zwischen Beobachtungsdaten. Das Vorgehen da ist durchaus mit dem Ptolemäischen Ansatz vergleichbar.

—————

Sehr geehrter Herr Baecker

Wegen ihrer Erinnerung an anderer Stelle greife ich diesen Faden nochmals auf.

Die Methode, nach Fits zu suchen, ist durchaus eine wissenschaftliche im deduktiven Sinn. Sie ist nicht die einzige Methode und synthetische, induktive Methoden haben parallel auch ihre Berechtigung. Bei beiden Ansätzen muss natürlich die Prüfung der Plausibilität erfolgen, ohne die es ansonsten eine leere Übung wäre.

————— #108: NicoBaecker sagt:

Die GCMs heben sich vo diesen Fits ab, indem sie auf Basis der Physik arbeiten.

—————

Während ie Plausibilitäet im deduktiven Verfahren die Übereinstimmung mit bekannten Gesetzen suchen muss, ist die empirische Bestätigung in induktiven Verfahren ein Muss. Und da mangelt es bei den GCMs. Die übrigens sehr wohl auch mit Fits arbeiten, um die Parameter abzuschätzen.

————— #108: NicoBaecker sagt:

Sie können also leicht folgende Analogie machen:

A) Fit von Epizykeln an Planetenpositionsdaten = Korrelationen zwischen Sonnenaktivitätsdaten und Klimadaten

B) Himmelsmechanishce Berechnung der Planetenpositionen auf Basis der Physik (newtonsche Mechanik) = heutige Klimamodelle

—————

Das ist in der Zuspitzung schlicht irreführend. Zum Zeitpunkt des Epizyklusodells war das heuittige Verständnis nicht existent. Man suchte eine Ableitung aus der Beobachtung und kam durchaus nachvollziehbar zu einer falschen Lösung.

Heutige Klimamodelle machen auch annahmen über Wirkzusammenhänge, die man nicht hinreichend kennt. Es ist eher anzunehmen, dass sie ebenso daneben liegen wie das Epizyklenmodell.

————— #108: NicoBaecker sagt:

Die Modellierung auf Basis physikalischer Gleichungen (B) (inkl. Parametrisierung komplexer Prozesse durch einfachere Ersatzprozesse) betrachte ich als Physiker als Fortschritt – auch erkenntnistheoretisch.

—————

Der Erkenntnisfortschritt ist unbestritten, aber der Verleich unpassend. Denn der Erkenntnisfortschritt ist der gesamten Entwicklung der Wissenschaften geschuldet, nicht dem hier eingesetzten Verfahren. Tatsächlich leistete das Epizyklen-Modell erstaunliches. Hierzu war ebenso eine ausgefeilte Mathemathik erforderlich, denn ansonsten hätte man die Planetenpositionen nicht so exakt vorhersagen können.

Lieber Herr Lnadvoigt,

schade, daß Sie sich nicht mehr zu dieser interessanten diskussion melden. Ich hatte wirklich die Hoffnung, etwas substanzielles von der Fraktion der Skeptiker erfahren zu können.

Lieber Herr Landvoigt,

„Sie haben den Punkt offensichtlich nicht verstanden. Prägendes Verständnis des Weltbildes wirkt nicht nur auf Denker oder Wissenschaftler oder das gemeine Volk, sondern prägt die Kultur und damit in der Rückkopplung auch wissenschaftliche Auffassungen.“

Ich habe den Punkt wahrscheinlich besser als Sie selber verstanden. Deshalb fragte ich Sie ja auch mehrfach schon, aber bislang ergebnislos danach, ob Ihr Problem mit den GCMs ein spezielles ist oder ob es daran verknüpft ist, daß Ihnen unser gegenwärtiges natuwissenschaftlich-technisch geprägtes Weltbild, welches seit rund 300 Jahren davon ausgeht, daß der Mensch selbst durch sein Denken die Natur erkennen kann, nicht ausreichend erscheint, um das Klimasystem zu verstehen.

Daher die oben gestaffelten Fragen a) bis c). Sie eiern mir zu sehr herum, und ich möchte mal den Punkt klären, ob Sie ein Problem mit der naturwissenschaftlichen Methodik der Modellbildung an sich haben. Dann wäre Ihr „Klimamodellproblem“ nur die Auswirkung genereller Vorbehalte. Verstehen Sie mich, und können Sie mir Ihre Position einfach mitteilen, indem Sie die Fragen beantworten?

Lieber Herr Landvoigt, #110

auch zum exkurs muß ich Widerspruch leisten und Sie korrigieren. Aber dazu auch bei passenderer Gelegenheit.

Aber mir ist wichtiger, Ihre Meinung zu #108, #103, #105 und #100 (etwa in der Reihenfolge) zu erfahren.

PS: Falls diese Diskussion zu langatmig wird, wären Sie auch an einer Fortführung abseits per email interessiert?

Lieber Herr Landvoigt, #109/110

die Diskussion mit Ihnen unter diesem Artikel finde ich wie gesagt interessant. Ich möchte nun gar nicht neue Themen aufreißen und mich an dieser albernen Diskussion um den jüngsten Stehlik et al. Artikel beteiligen.

Herr Stehik hat das Grundlagenwissen der Physik völlig verloren und daher weiß man nie, was für falsche Schlüsse er aus Erklärungen, die man ihm liefert, zieht.

Ich müßte mir Ihre, Stehliks und Kramms Kommentare noch einmal im Detail durchlesen, um zu einem abschließenden Urteil über die Debatte zwischen Ihnen und Stehlik bzw. Kramm zu kommen.

Da mir aber die angefangene Diskussion mit Ihnen hier jedoch wichtiger ist, möchte ich die Diskussion über die IR-Spektren nicht fortführen. Nur soviel: Wie ich schon öfter detailliert vorgerechnet habe, geht das Plancksche Strahlungsgesetz auch bei dem thermischen Emissionsspektum jedwegen Stoffes inkl. Gase ein. Denn dieses beschreibt ja die Energieverteilung thermischer Photonen ganz allgemein.

Ehr geehrter Herr Baecker

Auch wenn es hier ein Exkurs ist, so doch ein reizvoller:

———- #98: NicoBaecker sagt:

„Das, was wir heute Naturgesetze nennen, war keineswegs stets Wissen der Menschheit. … Das mechanische Weltbild wurde mit der Entwicklung der modernen Naturwissenschaften allmählich zum Standard. Laplace drückte es am markantesten aus.

Dieses Weltbild bekam aber mit den Relativitätstheorien bereits erhebliche Risse und wurde durch die Quantenmechanik weitgehend auf den Kopf gestellt. Einige Menschen wollen dies auch nach hundert Jahren nicht zu Kenntnis nehmen.“

Das ist populistischer Quark, so einfach war die Wissenschaftshistorie nicht. Das „mechanistische Weltbild“ war ein „Ideal“ Anfang es 19. Jahrhdts.: Man hatte die Hoffnung, daß sich auch irdische Bewegungsprozesse so elegant und exakt wie die Planetenbewegung vorhersagen lassen. Aber zur gleichen Zeit, wurden dieselben Forscher mit neuen Entdeckungen wie der Elektrizität konfrontiert.

———-

Elektrizität erschüttert das mechanistisch-deterministische Weltbild nicht, sonder erweitert es lediglich. Es gibt in der Elektrizität nichts, was sich am vorherigen Weltbild revidieren müsste.

Meinen sie wirklich, dass sich meine Deutung mit dem Begriff ‚populistischer Quark‘ beschreiben ließe? Ich dachte immer, dass sie vielleicht in manchem anderer Meinung sind, hielt sie aber nicht solchen Nonsens für fähig.

———- #98: NicoBaecker sagt:

Das mechanistische Weltbild war niemals in Stein gemeißelt. Was da „Risse“ durch RT und QM bekam wäre dann auch nicht das mechanistische Weltbild, sondern die klassische Physik knapp 100 Jahre später.

———-

Sie haben den Punkt offensichtlich nicht verstanden. Prägendes Verständnis des Weltbildes wirkt nicht nur auf Denker oder Wissenschaftler oder das gemeine Volk, sondern prägt die Kultur und damit in der Rückkopplung auch wissenschaftliche Auffassungen.

———- #98: NicoBaecker sagt:

Die „Risse“ haben auch nur die zu beklagen, die unbedingt die Physik abschließen wollen und ein Weltbild damit gründen wollen.

———-

Ich weiß nun nicht, wer diese Risse beklagt. Ich stelle lediglich fest, dass es sie gibt und festgefügte Vorstellungen aufbricht. Ich begrüße das ausdrücklich!

Sie meinen vermutlich die Fraktion jener, die mit der Parole aufschlagen ‚Science is settled!‘

———- #98: NicoBaecker sagt:

Für die Physik sind solche „philosophischen Überbauten“ völlig irrelevant, denn die Laplacesche Himmelsmechanik ist heute so gültig und genau wie sie immer schon war. Durch die Relativitätstheorien (RT) und Quantenmechanik (QM) hat sich daran nichts geändert, diese beiden Theorien beschreiben ja Effekte, mit denen man zu Laplace Zeiten gar

nicht durch empirische Beobachtungen konfrontiert war.

———-

Laplace ist nicht nur durch seine Himmelsmechanik, sondern durch seinen ‚wissenschaftlichen‘ Determinismus, der sich im Laplaceschen Dämon niederschlägt, in die Geschichte und Philosophie eingegangen. Ihre Ansicht, dass die Physik nicht das Weltbild präge, halte ich für reichlich uninformiert.

#107: NicoBaecker sagt:

wenn ich mir Ihre Beiträge zum Stehlik, Eichten, Hüne-Artikel ansehe, frage ich mich, ob Ihr Problem vielleicht größtenteils darin liegt, daß Sie sich einfach verzetteln und nicht die Zeit nehmen, mal systematisch zu arbeiten. Sie haben nun eine Debatte mit vielen ausgelöst, nur weil Sie ein paar Diagramm nicht richtig verstehen und die Kommentare dazu auch noch misssverstehen.

————–

Sehr geehrter Herr Baecker

Es fällt mir schwer, den Sinn ihrer Aussage zu verstehn. Selbst wenn ich nicht in Verteidigung meiner Aussagen gehen will und es als gut gemeinte Hinweise deuten wollte, dass ich mich verrennen würde, so habe ich dennoch das Argument nicht erkennen können: Welche Diagramme sollte ich nicht richtig verstanden haben? Und wie wären diese korrekt zu verstehen?

————– #107: NicoBaecker sagt:

Was Herr Kramm z.B. schreibt, ist richtig, …

————–

… und zwar konkret?

————– #107: NicoBaecker sagt:

auch Herr Stehlik hat recht, wenn er schreibt, daß man die IR-Emissionspektren von jeden beliebigen Stoff (z.B. Gase) i.a. nicht hinreichend durch Planck-Strahler beschreiben kann.

————–

Das war meine Aussage. Herr Dr. Stehlik schrieb dagegen in Antwort auf meinen Text:

————— #13: Dr. Gerhard Stehlik sagt:

(3) „Die unterschiedlichen Elemente lassen sich aus den Spektren im jeweiligen Bedingungskontexten hervorragend erkennen und interpretieren.“

Solche „unterschiedlichen Elemente“ sind im „Schwarzen Strahler“ nicht vorgesehen. Sie stehen im völligen Wiederspruch zur Formel von Max Planck (also nach Abb. 2.)

… und jedes hier nicht gezeigte IR-Spektrum eines beliebigen chemischen Stoffes rein gar nichts mit einem kontinuierlichen „Schwarzen Strahler“ nach Max Planck zu tun hat.

—————

Sind sie ebenso wie Dr. Stehlik der Ansicht, dass das mit den Erkenntnissen der Physik im Einklang steht? Sollte man Planck wirklich in die Tonne treten? Das müsste man, wenn die Formael nichts mit den realen Stoffen zu tun hätte.

Im Übrigen haben sie in diesem Thread ja durchaus die kritische Konsequenz des Artikels zutreffend benannt. Mir bleibt darum ihre Aussage hier völlig unklar.

Lieber Herr landvoigt,

nochmal eine Bemerkung von mir als Naturwissenschaftler.Sie habe doch die Epizykel-Fits für die Planetenbewegung genannt. Bei der Untersuchung von Herrn Michelbach und anderen Untersuchungen über mögliche Korrelationen von Sonnenaktivität zum Klima handelt es sich ebenfalls um nichts anderes als Fits zwischen Beobachtungsdaten. Das Vorgehen da ist durchaus mit dem Ptolemäischen Ansatz vergleichbar. Die GCMs heben sich vo diesen Fits ab, indem sie auf Basis der Physik arbeiten. Sie können also leicht folgende Analogie machen:

A) Fit von Epizykeln an Planetenpositionsdaten = Korrelationen zwischen Sonnenaktivitätsdaten und Klimadaten

B) Himmelsmechanishce Berechnung der Planetenpositionen auf Basis der Physik (newtonsche Mechanik) = heutige Klimamodelle

Die Modellierung auf Basis physikalischer Gleichungen (B) (inkl. Parametrisierung komplexer Prozesse durch einfachere Ersatzprozesse) betrachte ich als Physiker als Fortschritt – auch erkenntnistheoretisch.

Wie sehen Sie das?

Lieber Herr Landvoigt,

wenn ich mir Ihre Beiträge zum Stehlik, Eichten, Hüne-Artikel ansehe, frage ich mich, ob Ihr Problem vielleicht größtenteils darin liegt, daß Sie sich einfach verzetteln und nicht die Zeit nehmen, mal systematisch zu arbeiten. Sie haben nun eine Debatte mit vielen ausgelöst, nur weil Sie ein paar Diagramm nicht richtig verstehen und die Kommentare dazu auch noch misssverstehen. Was Herr Kramm z.B. schreibt, ist richtig, auch Herr Stehlik hat recht, wenn er schreibt, daß man die IR-Emissionspektren von jeden beliebigen Stoff (z.B. Gase) i.a. nicht hinreichend durch Planck-Strahler beschreiben kann. Der Haken bei seiner Argumentation liegt natürlich tiefer, indem er nämlich diese Behauptung den in seinem Artikel angegriffenen Herren unterstellt. Was m.E. eine absurde Unterstellung ist.

@ #104 Pseudonym NicoBaecker

„Die mit heutiger Parametrisierung und grid-cell-Größe erzielbare Genauigkeit sehen Sie ja an den Ergebnissen der heutigen Modelle.“

Sie offensichtlich nicht, denn 2 bis 6 °F Differenz für einen 70-jährigen lokalen Vergleich zwischen gemessener Realtität (Hier tägliches TMAX) und dem Hindcast des CMIP5-Modells GFDL-ESM2G sagen alles über die Fähigkeiten dieser General-Circulation-Models (Earth-System-Models) aus = Dringend Verbesserungsbedürftig in der Auflösung. Beim Niederschlag sieht es noch schlechter aus.

Wie konnte eine Lufthansa-Crew beim Nachtflug den Airport von Manchester treffen?: „We are just passing the City of Bremen.“ Blick aus dem Fenster: Unter mir der Flugplatz Bremerhaven-Luneort. Abweichung der Positionsangabe von der Realität: 60 km. In etwa so sehen die Ergebnisse der GCM aus.

Lieber Herr Landvoigt, #102

Hier gibt es eine Passage, in der Sie sich m.E. widersprechen. Vielleicht reflektieren Sie auch mal persönlich ob Ihnen noch klar ist, was die Punkte in dieser Diskussion mit mir eigentlich sein sollen, oder ob Sie lieber nur schwätzen wollen.

Ich nenne Ihnen meine Punkte, die ich von Ihnen wissen will.

a) Glauben Sie, daß sich GCMs grundlegend von anderen physikalischen Modellen zu komplexen Abläufen unterscheiden? Wenn ja, ganz konkret bitte mit Beispielen antworten, worin und warum? Denken Sie daran an meine Beispiele für andere physikalische Modelle (Atommodelle mit Hartree-Fock-Näherungen, Approximationen für die Störungsrechnung bei der Planetenbewegung durch Gauß (und viele andere Astronomen), Gebäudestatik durch finite Elemente o.ä., und die Ignoranz der Quantenmechanik und Relativitätstheorien dabei. Sie müssen Gründe nennen, die die Methodik bei GCM methodisch grundlegend von diesen Beispielen unterscheiden! Bedenken Sie: alle diese Beispiele parametrisieren ebenfalls komplexe Prozesse durch vereinfachende Ersatzprozesse.

b) Wenn Sie a) beneinen, glauben Sie, daß sich komplexe physikalische Prozesse grundsätzlich nicht befriedigend mit Modellen beschreiben lassen?

c) Wenn Sie auch b) verneinen, was ist dann Ihr Problem?

Nun zur Passage:

a)„———– #98: NicoBaecker sagt:

Über praktizierte wissenschaftliche Methoden, um eine konkrete wissenschaftliche Frage zu behandeln, kann man freilich erkenntnistheoretische Debatten starten. Aber solange diese Debatten keine konkreten Erkenntnisse zur behandelten wissenschaftlichen Frage liefern, sind sie für die Frage wissenschaftlich nicht zielführend.

———–

Das ist ein Beispiel für das Ausblenden grundlegender Fragen. Aus der Wissenschaftstheorie und Erkenntnistheorie wissen wir, dass vieles, was man für selbstverständlich hält gar nicht selbstverständlich ist.“

Die grundlegende Frage beim Klimamodellieren ist das Klima quantitativ zu beschreiben (das ist die wissenschaftliche Fragestellung)! Und die ist jedem Modellierer bewußt. Das bitteschön wollen Sie denen doch wohl nicht absprechen. Wenn doch, so belegen Sie das.

Als selbstverständlich wird dabei angenommen, daß man die Naturgesetze auch im Klimasystem gelten. Dieselbe Selbstverständlichkeit hat auch der Modellierer der Baustatik oder für Atome!

Da also die Fragestellung klar ist, also nochmals meine Frage an Sie zurückgespielt: Was liefert die Erkenntnistheorie konkret zur Beantwortung der oben erneut ins Gedächtnis geholten wissenschaftlichen Fragestellung, was die Wissenschaft mit ihren eigenen Methoden (konkret hier physikalischen Modellen) nicht vermag?

Ich sehe da beim besten Willen nicht, wie die Erkenntnistheorie unterstützen kann, wenn ein Statikmodell die Statik eines Hauses vorrechnet. Auch die Überprüfung der Gültigkeitsgrenzen des Modells ist schließlich – wie schon mehrmals betont – in die Modellentwicklung integriert.

Ich habe den Eindruck, Sie verallgemeinern schlechte Erfahrungen, die Sie mit komplexen Projekten gemacht haben. Bedenken Sie, daß physikalische Modelle, die man nicht testet, wohl von jedem Modellierer als Schrott angesehen werden und daß dies kaum mit seinem Arbeitsziel vereinbar ist. Bedenken Sie auch, daß die Arbeitsteilung bei der Modellierung gar nicht so groß ist, wie Sie es vielleicht befürchten (Stichwort: Betriebsblindheit, so groß ist der „Ameisenhaufen“ gar nicht).

b)„———– #98: NicoBaecker sagt:

Sie können gerne an den anerkannten Verfahren, physikalische Modelle zu entwickeln, um komplexe Prozesse zu verstehen, herummäkeln. Aber solange Sie kein revolutionierend besseres Verfahren zur Erklärung komplexer Prozesse vorstellen, wird man daran festhalten.

———–

Es geht nicht ums herummäkeln, sondern um die Unmöglichkeit, angesichts des mehrdimensionalen Nichtwissens, zuverlässige Ergebnisse zu erzielen. „

Schon, aber Sie haben bislang trotz Aufforderung überhaupt gar nicht gezeigt, daß dies bei den GCMs zutrifft. Wissen Sie denn überhaupt, was die Wissenschaft als „zuverlässiges Ergebnis“ eines heutigen GCMs einstuft? Und woher wollen Sie wissen, daß ein potentielles „mehrdimensionalen Nichtwissen“ überhaupt relevant ist?

Das hängt doch logischerweise davon ab, was man sich als Genauigkeitsziel des Modells vorgenommen hat, oder?

Nehmen Sie das Baustatikmodell. Die Baustatiker haben 10 verschiedene Modelle gebastelt, die Gebäudeschwankungen bei bestimmt definierten Testbedingungen zwischen 15 und 20 cm vorhersagen. Nun wird im Test bei diesen Bedingungen eine Schwankung von 20,5 cm gemessen. Sind die Modelle also alle für den Eimer? Vielleicht wissen die Modellierer sogar, warum Ihre Modelle dieses Testergebnis alle unterschätzen und vielleicht ist diese Abweichung sogar als potentieller „Schönheitsfehler“ in Kauf genommen worden, weil die Modelle dann 20 mal einfacher sind als eines, welches diese Abweichung „im Griff“ hat.

Nehmen Sie mal das von Ihnen zitierte paper von Mauritzen et al. Sie sehen da, welche Parameter zum Tunen benutzt wurden und wie sich diese in den verschiedenen Modellen unterscheiden. Das sind keine irrwitzigen Unterschiede und zudem keine physikalisch absurden Zahlen (ich habe den Eindruck, Sie wollten gerne unterstellen, Tunen würde physikalischem Unsinn gleichkommen, vielleicht erklären Sie sich mal explizit dazu, um mich von diesem Eindruck zu befreien). Die globale Mitteltemperatur liegen bis 1,2 K auseinander, als Klimasensitivität kommen Werte zwischen 2,8 bis 3,5 K raus. Sind diese Modelle nun „zielführend“ und genau genug oder nicht?

„Die Erkenntnis, dass ein Lösungsversuch eben nicht zielführend ist,“

Gut, aber woher wollen Sie wissen, ob das hier der Fall ist, wenn Sie das Ziel der nicht kennen? Sind Sie sich sicher, daß Sie es sich nicht zu einfach machen, und einfach die Möhre (das Ziel) einfach mal etwas höher hängen? Mit „moving targets“ kann an alles als „nicht zielführend“ umdefinieren.

c)„———– #98: NicoBaecker sagt:

Physikalische Modelle nutzt man in den Ingenieurswissenschaften wie auch sonst in der Physik, …

———–

…. und das ist im Allgemeinen auch gut so.“

Wenn ich also diesen Kommentar mit Ihrem Kommentar zu a) kombiniere, heißt das, daß Sie es im Allgemeinen gut finden, wenn bei der Erstellung von physikalischen Modellen der Ingenieurswissenschaften und der Physik erkenntnistheoretische und grundlegende Fragen ausgeblendet werden… also wie nun? Es wird Zeit, daß Sie mal konkret werden und bitte die Fragen a) bis c) oben beantworten.

„———– #98: NicoBaecker sagt:

… die GCMs in den Klimawissenschaften sind methodisch in einer Linie mit diesen, und zu den Naturgesetzen, die wir heute kennen, gibt es keine Alternative Beschreibungen der Natur, die treffender wären.

———–

Sie scheinen das Problem nicht verstanden zu haben. Wie können sie unter diesen Umständen überhaupt ein GCM beurteilen?“

Welche Umstände meinen Sie?

Ich habe doch schon weiter oben öfter beschrieben, wie ein GCM beurteilt wird. Was haben Sie daran auszusetzen?

Und welche bessere Alternative hätten Sie denn anzubieten – den Kopf in den Sand stecken oder Glaskugellesen?

„———– #98: NicoBaecker sagt:

Wenn Sie eine fundamentalistische Diskussion über die heutigen naturwissenschaftlichen Methoden eröffnen wollen, so tun Sie das. …

———–

Es gibt einen massiven Unterschied zwischen fundamentalen und fundamentalistischen Argumenten:

Fundamentale Fragestellungen adressierend grundlegende Probleme. Fundamentalistisch ist, wenn man das Fundament eben nicht in Frage stellt, sondern als gegeben voraussetzt.“

Nun, ich meine wie gesagt eine fundamentalistische Diskussion über die heutigen naturwissenschaftlichen Methoden. Das Fundament wäre hier die Überzeugung, daß diese zu Erkenntnissen führen, die der „Wahrheit“ näherkommen. Ich als Naturwissenschaftler bin natürlich davon überzeugt, daß dem so ist.

Bei Ihnen weiß ist nicht, ob Sie auch dieses Fundament unter sich fühlen…

„Nochmals: Die Probleme von hochkomplexen Simulationen, in denen viele Zusammenhänge nicht testbar sind und Parameter abgeschätzt werden, hat nicht mit dem Grundtypus der Modellbildung im Allgemeinen zu tun. Das hätte ihnen, nachdem isch es ausdrücklich gefühlte 50 mal erklärt habe, eigentlich klar sein müssen.“

Klar, aber nun liefern Sie doch bitte auch den konkreten Beweis dafür, daß dies für die GCMs de facto auch zutrifft. Ich sehe dies überhaupt nicht! Ihr Mauritzen-Paper zeigt doch sehr schön, wie getunt wird. Was soll da nicht testbar oder gar „subtil“ abgeschätzt sein?

Nochmals: bei GCMs geht man nicht grundlegend anderes als bei anderen physikalischen Modellen vor. Ihre Erfahrungen mit irgendwelchen hochkomplexen Simulationen können Sie nicht einfach ohne konkrete Beweise verallgemeinern. Ich bitte Sie zudem, meine Fragen a) bis c) zu beantworten, um Mißverständnisse bei mir über Ihren Standpunkt ausschließen zu können.

Lieber Herr Landvoigt, #102

„Wenn GCM mit Grid Cells arbeiten, deren Kantenlänge meist über 100 km sind, muss mit Durchschnittsannahmen gearbeitet werden, die auf mehr oder minder guten Schätzungen basiert. In wie weit man dann noch von realitätsnahen Abbildungen sprechen kann, die ein langfristiges Verhalten im Bereich von 0,01 Grad beschreiben, kann ich mir nicht vorstallen. Wie sollte man dies auch nur für eine einzige Zelle testen können? Die Inputs gehen über die Zellgrenzen hinaus und lassen eine Überprüfung der Modellierung gar nicht mehr zu.“

Der Punkt ist, daß Sie diese Genauigkeit ja nicht brauchen für die angestrebte bzw. heute überhaupt denkbare Genauigkeit von Klimamodellen. Das brauchen ja nicht mal Wettermodelle.

Die mit heutiger Parametrisierung und grid-cell-Größe erzielbare Genauigkeit sehen Sie ja an den Ergebnissen der heutigen Modelle.

Lieber Herr Landvoigt, #102

den Unterschied zwischen induktiv und dekuntiv kenne ich. Die Naturgesetze werden induktiv entdeckt. Wie scon gesagt, physikalische Modelle, einschließlich der heutigen Klimamodelle sind aber logischerweise deduktiv: sie basieren nur auf die bekannten Naturgesetze.

„Wollte ich ihnen konkrete Erfahrungen erläutern, würden sie sie entweder ohne nähere Details nachvollziehen können, da sie bei ihrer selbstkritischen Betrachtung eigentlich die gleichen Erfahrungen gemacht haben müssten, oder aber sie verstehen dies mangels gemeinsamer Erfahrung trotz Erläuterungen nicht. “

Ich meinte konkrete Beispiele aus der Klimamodellforschung und nicht aus Ihrer Arbeitswelt, über die diskutieren wir ja nicht.

Zu Ihrer Textstelle:

„Wenn Sie schreiben: ‚Heutige Modelle in der Physik basieren immer aus Sätzen von physikalischen Gleichungen, die entweder direkt verwendet oder durch Approximationen allgemeiner Naturgesetze gewonnen werden.‘

… dann ist mir nicht klar, ob sie wirklich meinen, dass es sich bei den Modellen ausschließlich um die konsequente Anwendung der bekanntnen Naturgesetze wären und sonst nichts.“

Ja, aber der Punkt ist natürlich – und das ist nun wirklich wichtig zu begreifen – daß physikalische Modelle immer nur einen Teil der Gesamtheit aller Naturgesetze abbildet. Ich hatte Ihnen schon die Beispile der Statikmodelle für Gebäude oder Atommodelle genannt, und die GCMs betrifft dies auch. Der Ausgangspunkt ist die Untersuchung welche Naturgesetze einflußreich sind und welche weniger (quantitativ). Ein Modell berücksichtigt immer nur eine relevante Teilmenge der Naturgesetze oder parametrisiert komplexe Zusammenhänge durch Ersatzprozesse. Beispile dafür sind genannt: Gauß‘ Näherung für die Gravitationswirkung der Asterioden, die Vernachlässigung der RT bei der Statik, die Parametrisierung von sub-grid Prozessen bei GCMs, die Hartree-Fock-Näherungen bei Mehrelektronenatomen,…

„Denn wenn dies möglich wäre, würde es notwendig nur ein Klimamodell geben.“

Nein, denn es gibt viele mögliche Realisierungen physikalischer Modelle.

„Die Existenz unterschiedlicher Modelle zeigt aber, dass die modellierer Freiheitsgrade hatten, die eben nicht durch Naturgesetze determiniert sind.“

Es gibt die Freiheitsgrade durch die Vereinfachung der Prozesse. Wie gesagt, man muß natürlich testen, ob diese Näherungen gut genug sind, um den komplexen Prozeß zu ersetzen. Zur Verifikation dieser gehören auch Messungen.

Sehr geehrter Herr Baecker

Auch ich will ihnen ausdrücklich Respekt zollen. Auch wenn ich punktuell mit Ihrer Diktion nicht immer glücklich war, so erkenne ich an, dass sie vor allem einen sach- und argumentbezogenen Stil pflegen, und das ist weit mehr, als man von vielen Kommentatoren sagen kann. Auch wenn man unterschiedlicher Meinung ist, so kann man sich doch persönlich durchaus schätzen.

———– #98: NicoBaecker sagt:

Zum Thema „betriebsblind“, Sie schrieben „Eine Rückbesinnung auf die Grundkonzepte findet selten bis nie statt.“. Können Sie mal mal erklären, welche die „Grundkonzepte“ und die fehlende „Rückbesinnung“ bei den GCMs sind?

———–

Eben das gesagte: Man will möglichst zutreffend die Realität nachbilden und somit das Verhalten der Sachverhalte verstehen. Dabei muss man sich stets der Grenzen des Vorhabens bewusst bleiben.

Ich habe den Eindruck, dass dies zwar, sofern es Thematisiert wird, auch weitgehend dissensfrei kommuniziert wird, aber in der Praktischen Arbeit wieder vollständig ausgeblendet wird.

———– #98: NicoBaecker sagt:

Und nennen Sie doch bitte die „grundlegende Irrtümer“, die man bei Modellen auf Basis physikalischer Gleichungen Ihrer Meinung nach annimmt. Ihr Vorwurf, daß die Modellierer „den Wald vor Bäumen nicht mehr sehen“ würden, müssen Sie mir nochmal erläutern.

———–

Bitte auf die Diktion achten: Es gibt keine grundlegenden Probleme allgemeiner Art, wenn man physikalische Befindlichkeiten mit Gleichungen, sofern man sich des Abstraktionscharakters bewusst bleibt.

Grundsätzliche Probleme entstehen bei der Simulation komplexer Systeme im Gegensatz zu einfachen und testbaren Zusammenhänge. Denn komplexe Probleme, deren Einflussfaktoren sowohl qualitativ nicht vollständig bekannt sind, deren quantitative Effektkopplungen nicht geklärt ist und deren Rückkopplungsparameter in vielfältiger Weise als Funktion des Ortes und der Zeit verstanden werden müssen, lassen keine zuverlässige Abbildung mehr zu.

Wir können uns vielleicht vorstellen, was die Vorgänge über einem See bei Windstille, Temperatur 22 Grad, rel. Luftfeuchte 60% und wolkenloser Himmel und Sonnenstand 45 Grad ausmacht. Dann können wir halbwegs zuverlässig ausrechnen, wie hoch die Verdunstung und Konvektion sein kann. Aber schon bei variierenden Parametern, z.B. Wind und Wolkenbedeckung wird es ungleich schwieriger bis unmöglich, eine zutreffende kleinräumige Simulation zu fahren. Bei wechselnden Bodeneigenschaften um so mehr.

Wenn GCM mit Grid Cells arbeiten, deren Kantenlänge meist über 100 km sind, muss mit Durchschnittsannahmen gearbeitet werden, die auf mehr oder minder guten Schätzungen basiert. In wie weit man dann noch von realitätsnahen Abbildungen sprechen kann, die ein langfristiges Verhalten im Bereich von 0,01 Grad beschreiben, kann ich mir nicht vorstallen. Wie sollte man dies auch nur für eine einzige Zelle testen können? Die Inputs gehen über die Zellgrenzen hinaus und lassen eine Überprüfung der Modellierung gar nicht mehr zu.

Wenn ich in komplexen Projekten gearbeitet habe die ich nicht mehr überschauen kann. Konnte ich genau dann erfolgreich arbeiten, wenn ich mich auf meine Teilaufgabe konzentrierte. Also bewusst auf Betriebsblindheit hinsichtlich des Gesamtzieles schaltete. Und das ist schlicht ein Stück Notwendigkeit. Selbiges habe ich nicht nur bei mir, sondern ausnahmslos bei anderen Teammitgliedern beobachtet.

———– #98: NicoBaecker sagt:

Auch diesen Vorwurf werte ich als Vorwurf, die Leute seien zu blöde. Also zu blöde, selber zu sehen, was sie eigentlich machen und was sie daraus schließen dürfen. Bitte erläutern Sie Ihren Vorwurf mal an konkreten Beispielen.

———–

Ich könnte derartige Erfahrungen zu Hauf berichten, müsste aber dazu zu tief ins Detail gehen. Zuweilen stellt man sich auch kritische Rückfragen, die an dem Sinn des Projektes oder der Tätigkeit zweifeln lassen. Aber was soll man damit anfangen? Zumeist kann man dies gar nicht operationalisieren.

Wollte ich ihnen konkrete Erfahrungen erläutern, würden sie sie entweder ohne nähere Details nachvollziehen können, da sie bei ihrer selbstkritischen Betrachtung eigentlich die gleichen Erfahrungen gemacht haben müssten, oder aber sie verstehen dies mangels gemeinsamer Erfahrung trotz Erläuterungen nicht. Falls ihnen diese Beobachtungen wirklich so fremd sind, würde mich ernsthaft interessieren, wie bei Ihren Arbeiten die Konzentration auf Sachthemen funktioniert, oder ob sie keine fundamentalen Zweifel kennen.

Darum erscheint mir der Vorwurf, irgend jemand sei blöde, weil er eben nur seinen Job tut, unpassend. Angesichts der umfassenden kritischen Design-Entscheidungen, die man bei der Bearbeitung Komplexer Projekte, wie z.B. einem GCM, ist es m.E. gar nicht möglich, ein konsistent zielkonformes Arbeiten in der realen Welt durchzuführen.

———– #98: NicoBaecker sagt:

Über praktizierte wissenschaftliche Methoden, um eine konkrete wissenschaftliche Frage zu behandeln, kann man freilich erkenntnistheoretische Debatten starten. Aber solange diese Debatten keine konkreten Erkenntnisse zur behandelten wissenschaftlichen Frage liefern, sind sie für die Frage wissenschaftlich nicht zielführend.

———–

Das ist ein Beispiel für das Ausblenden grundlegender Fragen. Aus der Wissenschaftstheorie und Erkenntnistheorie wissen wir, dass vieles, was man für selbstverständlich hält gar nicht selbstverständlich ist.

Wenn also das Ergebnis der Erkenntnistheorie Zweifel an den Methoden belegt, mag man das als Störfaktor schlicht ausblenden. Und dann haben wir bereits eine Triebkraft der Betriebsblindheit.

———– #98: NicoBaecker sagt:

Sie können gerne an den anerkannten Verfahren, physikalische Modelle zu entwickeln, um komplexe Prozesse zu verstehen, herummäkeln. Aber solange Sie kein revolutionierend besseres Verfahren zur Erklärung komplexer Prozesse vorstellen, wird man daran festhalten.

———–

Es geht nicht ums herummäkeln, sondern um die Unmöglichkeit, angesichts des mehrdimensionalen Nichtwissens, zuverlässige Ergebnisse zu erzielen. Die Erkenntnis, dass ein Lösungsversuch eben nicht zielführend ist, ist dann eben hilfreicher als ein ‚weiter so‘ ohne begründete Aussicht auf Erfolg. Sie liefern gerade hervorragende Gründe der Betriebsblindheit.

———– #98: NicoBaecker sagt:

Physikalische Modelle nutzt man in den Ingenieurswissenschaften wie auch sonst in der Physik, …

———–

…. und das ist im Allgemeinen auch gut so.

———– #98: NicoBaecker sagt:

… die GCMs in den Klimawissenschaften sind methodisch in einer Linie mit diesen, und zu den Naturgesetzen, die wir heute kennen, gibt es keine Alternative Beschreibungen der Natur, die treffender wären.

———–

Sie scheinen das Problem nicht verstanden zu haben. Wie können sie unter diesen Umständen überhaupt ein GCM beurteilen?

———– #98: NicoBaecker sagt:

Wenn Sie eine fundamentalistische Diskussion über die heutigen naturwissenschaftlichen Methoden eröffnen wollen, so tun Sie das. Aber bitte seien Sie dann auch so

konsequent und greifen es allgemein an, denn diese Diskussion würde nicht nur die Klimamodelle infrage stellen, sondern jedes physikalische Modell: von Modellen zur

Berechnung von Elektronenniveaus in Atomen bis hin zur Statik von Gebäuden.

———–

Es gibt einen massiven Unterschied zwischen fundamentalen und fundamentalistischen Argumenten:

Fundamentale Fragestellungen adressierend grundlegende Probleme. Fundamentalistisch ist, wenn man das Fundament eben nicht in Frage stellt, sondern als gegeben voraussetzt.

Nochmals: Die Probleme von hochkomplexen Simulationen, in denen viele Zusammenhänge nicht testbar sind und Parameter abgeschätzt werden, hat nicht mit dem Grundtypus der Modellbildung im Allgemeinen zu tun. Das hätte ihnen, nachdem isch es ausdrücklich gefühlte 50 mal erklärt habe, eigentlich klar sein müssen.

———– #98: NicoBaecker sagt:

„Hier unterliegen sie einem methodischen Fehler.“ Welcher da wäre?

Ich habe gar nicht in induktiv und deduktive unterschieden. Wenn Ihnen das aber wichtig ist, erkläre ich es Ihnen: Physikalische Modelle sind offensichtlich deduktiv, die GCMs eingeschlossen, denn sie basieren auf bekannten und erprobten Gesetzen.

———–

Wenn Sie schreiben: ‚Heutige Modelle in der Physik basieren immer aus Sätzen von physikalischen Gleichungen, die entweder direkt verwendet oder durch Approximationen allgemeiner Naturgesetze gewonnen werden.‘

… dann ist mir nicht klar, ob sie wirklich meinen, dass es sich bei den Modellen ausschließlich um die konsequente Anwendung der bekanntnen Naturgesetze wären und sonst nichts. Denn wenn dies möglich wäre, würde es notwendig nur ein Klimamodell geben. Die Existenz unterschiedlicher Modelle zeigt aber, dass die modellierer Freiheitsgrade hatten, die eben nicht durch Naturgesetze determiniert sind. Wem dieser Sachverhalt offensichtlich ist, wird meinen, Sie wollten hier jemanden hinters Licht führen.

Das es sich natürlich auch um Naturgesetze und Gleichung handelt, die zum Einsatz kommen, wirkt so, dass sie stets betonen, dass ein Auto aus Blech besteht. Wer ihnen dann sagt, dass dies zwar eine notwendige, aber nicht hinreichende Bedingung sei, möchte nicht weitere Referate über die Rolle des Blechs im Automobilbau hören.

Hinsichtlich der Bedeutung von induktiven und deduktiven Arbeiten empfehle ich zur Einführung http://tinyurl.com/j2kb4lo und http://tinyurl.com/hbw5fvm – dann ersparen sie sich auch das Kopfschütteln bei ihren Lesern.

#97: Franz Zuber sagt:

Aus jedem Ihrer Sätze geht hervor, dass Sie weder von Wissenschaftstheorie noch von Erkenntnistheorie auch nur eine ungefähre Ahnung haben.

————-

Was soll hier irgend jemand mit einem argumentfreiem Satz wie diesem anfangen? Wollen sie eine Demonstration geben, was ad hominem Attacken sind? Dies gibt es ansonsten bereits zur genüge und sind darum vollständig überflüssig.

————- #97: Franz Zuber sagt: