Fussnoten

Ein Un-Denk-Beispiel: Die Energiewende

Das un-verstandene Thema der Energie

Die mehr oder weniger (un-)anschauliche Terminologie der Energie

Das Problem der Energiebilanz, der Energie-Dichte pro Masse und pro Zeit-Einheit

Die Desertec- Energie im Minus

Eine Milchmädchen-Rechnung von Energie, Kraft und Arbeit

Warum eine Tonne TNT weniger Energie hat als eine Tonne Kerosin

Und noch ein paar Un-Denk-Beispiele von Volumen, Gewicht, und Masse

Fussnoten

Ca. 1/3 dieses Textes besteht aus Fussnoten. Wenn im Haupttext ein Punkt noch weiter auszuführen ist, aber es den Gang der Gedanken im Haupttext nicht allzu sehr stören soll, wird das in die Fussnote gepackt. Weiterhin sind die Fussnoten ein guter Platz, um die x-Hundert www-Adressen zu verstecken, die im Haupttext recht unschön anzusehen sind.

Ein Un-Denk-Beispiel: Die Energiewende

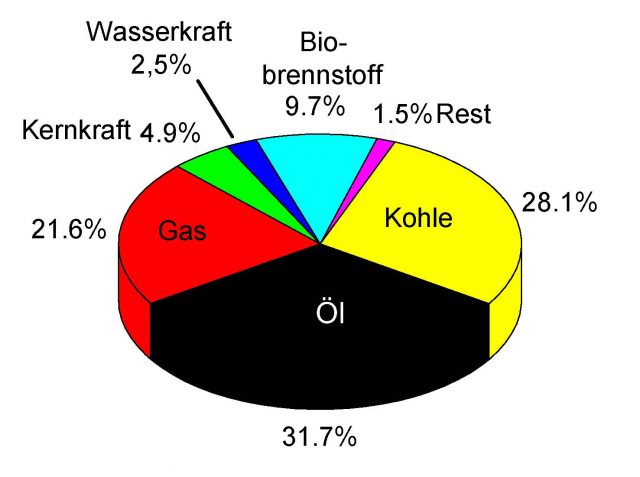

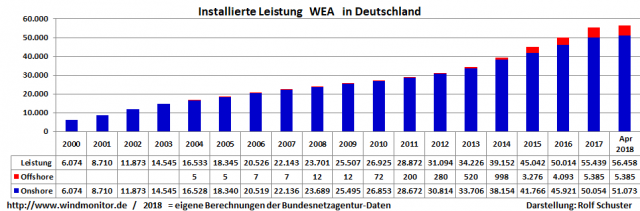

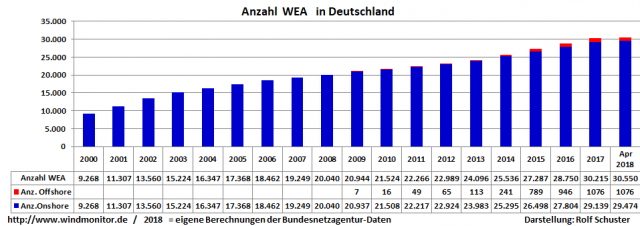

Ich führe hier einmal als Paradebeispiel für heutiges Un-Denken die Diskussion um die Energiewende an: Ein wahnwitziger Plan, Deutschland als das Welt-weite Vorzeigeland der schönen neuen Energien. So dass Deutschland nun endlich einmal im positivem Sinn weltführend sein sollte.[1]Leider wurde dieser Plan so umgesetzt, dass die deutschen Landschaften mit riesigen Wind-Rotoren verspargelt wurden, und die Deutschen als Versuchskaninchen dafür, europaweit fast die höchsten Kosten für Strom bezahlen müssen, und einige Millionen, denen der Strom abgestellt worden ist, und man sie damit energetisch ins 18. Jh. zurück geschickt hat.[2]Weil die verantwortlichen Politiker und die Medien einige Grundprinzipien der Energie nicht verstanden haben, obwohl die federführende Bundeskanzlerin auch noch Physikerin ist..[3]/[4]Ich behaupte hier nicht, dass man alles bei der Fossil- und Atom- Energie belassen sollte, so wie es ist. Was aber unter anderem historisch vergessen wird, ist dass alle bisherigen Energie-Wenden der Menschheit, also von Holz zu Kohle, und von Kohle zu Elektrizität und zu Öl und Gas, jeweils mindestens 50 bis 100 Jahre gebraucht haben, denn die Umstellung aller Energie-Infrastrukturen ist extrem aufwendig und kapital-Intensiv. So etwas darf man daher nicht in 20 Jahren versuchen.

Das un-verstandene Thema der Energie

Das Erste, und in der Normalbevölkerung eher un-verstandene Thema ist das der Energie selber. Im Alt-Griechischen heisst es en-ergeiaoder en-ergon„Das, was imstande ist, Werke zu erzeugen“ (ergon ist das Werk, die gemachte Arbeit, engl. Work).[5]Aber leider ist nach der Physiker-Interpretation die Energieetwas, das sich zwar in der Form ändern kann, aber in sich immner gleich bleibt.

Energy is a conserved quantity;[6]the law of conservation of energy states that energy can be converted in form, but not created or destroyed. Siehe: https://en.wikipedia.org/wiki/Energy

Der Begriff „conserved quantity“ ist schon wieder erstmal irreführend. Denn es hat überhaupt nichts damit zu tun, ob und wie man die Energie konservieren (=irgendwo/-wie speichern) kann. Und die Vorstellung von Energie im volkstümlichen Sinne ist eher das Energie-Potential, um (irgend) eine Arbeit zu leisten.[7]Und das wäre eigentlich die Kraft, im Alt-Deutschen Sinne. Siehe:

Potential energy: https://en.wikipedia.org/wiki/Potential_energy

Wenn man das Wort Energie-Erzeugung gebraucht, ist es ein Denkfehler, weil Energie nie erschaffen werden kann, und nie vernichtet werden kann. Deshalb ist der Begriff Erneuerbare Energien ebenfalls aus demselben Grund irrefürend. Was in der Energiewende- Un-Diskussion weiterhin allzu oft nicht verstanden wird, sind die Themen der Energie-Dichte pro Zeit-Einheit (=Kraft) und pro Volumen und Gewicht, der Energie-Gewinnung, der thermodynamischen Differenz, der Energie-Verfügbarkeit bzw. Speicherung, sowie ihre Verteilung bzw. der Transport der Energieträger. Dazu kommen alle gesellschaftlichen (Kapital-) und die Umwelt-Kosten. Ein Vortrag von David MacKay beleuchtet einige dieser Apekte sehr gut, vor allem mit guten graphischen Darstellungen:

https://www.youtube.com/watch?v=E0W1ZZYIV8o&t=748s

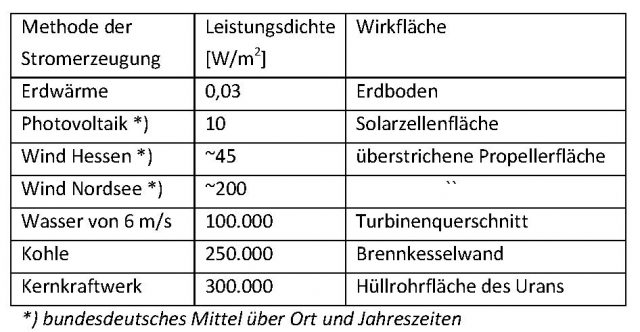

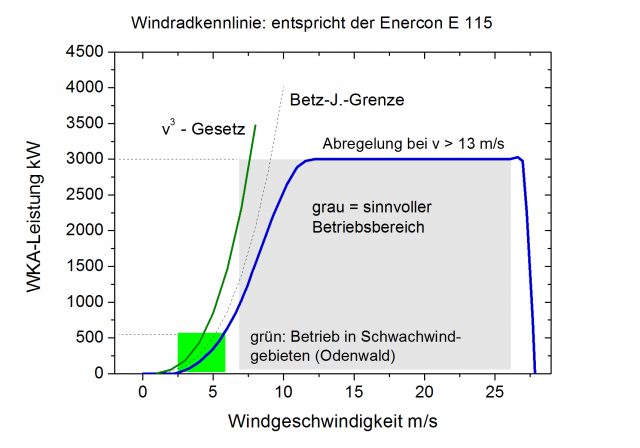

Ein treffendes Beispiel in seinem Vortrag ist in Min. 2:57 die Berechnung, dass man für den Betrieb von Autos mit reinem Biokraftstoff eine Fläche von 8 km Breite entlang von XYZ*100.000 Km dicht befahrenen Autobahnen und Strassen bräuchte, um die Energiepflanzen anzubauen. Noch nicht einberechnet wäre dabei die Energie, die man bräuchte, um mit intensiver Landwirtschaft die Pflanzen zu säen, zu kultivieren, zu ernten, und zu aufbereiten. Das gibt uns erst einmal einen Denk-Anstoss, was das Grundproblem von Bio-Kraftstoffen ist. Der Platzbedarf der Erneuerbaren Energien ist ein wesentlicher Faktor. In Min. 7:47 sagt er, Bio-Kraftstoffe erzeugen nur 0,5 Watt pro Quadratmeter (0,5 W/m**2). Windenergie erzeugt 2,5 W/m**2 (Min 8:12), Sonnenenergie erzeugt 5-20 W/m**2 (Min 8:40). Atomkraft erzeugt 1000 W/m**2 (Min 10:40). Nicht zu vergessen ist aber der Platz- und Energie-Bedarf des Abbaus des Urans, oder der Kohle. Nicht zuletzt kommen die ökologischen Kosten noch dazu.

Die mehr oder weniger (un-)anschauliche Terminologie der Energie

Dass die Herren (und ein paar Damen) Physiker mit ihren Joule und Newton arbeiten, hilft auch nicht viel weiter zum Allgemeinverständnis der Energie. Leider gibt es hier die Denk-Falle der Un-anschaulichen Terminologie. Es ist also auch ein Problem der (nicht so) ethischen Physiker-Welt-Gemein-Schaft, die ihre Terminologie nach Gusto über ihre Kultur-Heroen verteilt.[8]Ich habe darüber eine ziemlich umfangreiche Diskussion geführt: „The Ethics of Terminology“[9]Was es für die Fachleute einer Wissenschaft einfacher macht, darüber zu sprechen, fördert nicht gleichermassen das Verständnis der Laien, aber eher umgekehrt. Das ist leider bei der Energie ganz besonders der Fall. Die erste Denkfalle im Bereich der Energie ist, um es kurz zu sagen, die völlig unanschauliche Definition der Physiker, dass die Energie immer gleich bleibt. Aber es ist entscheidend für den Energie-Transfer von Wärme in Wasser, wieviel Wärme-Menge pro Zeiteinheit umgewandelt und transferiert wird. Das noch viel schlimmere Grundproblem (der Energie) dahinter ist wiederum, dass für die allermeisten Physiker (bzw. ihre Formeln) die Zeit reversibel ist. Und wenn man Energie denkt, muss man dringend Thermodynamik denken, und das ist ziemlich schwierig. Und nur die Thermodynamiker arbeiten mit der Zeit als wesentliche irreversible Grösse.[10]Das alles macht das allgemeine Verständnis der Energie so schwierig. Denn für einen Kohle-Minen-Arbeiter ist es intuitiv sehr klar, dass wir mehr körperliche Energie (=Kraft) brauchen, um 10 kg Kohle in 1 Sec. zu heben, als wenn wir dafür eine Minute Zeit haben. Ein analog umgekehrtes Beispiel ist der Hebel und der Flaschenzug. Denn hier können wir die Kraft über mehr Zeit, bzw. über die Länge des Seils verteilen. Womit dann ein paar 100 bis 1000 Menschen (mit jeweils 0,1 PS-Kräften) auch einen 1000- Tonnen-Obelisken irgendwohin ziemlich weit vom Herstellungsort bringen können, und dann sehr präzise auch noch aufrichten. Wie sie das im alten Ägypten damals genau machten, weiss leider heute Niemand mehr. Insofern sind die Begriffe der Kraft und der Arbeit intuitiv besser zu verstehen als das esoterische und vollkommen irreale Konstrukt der Energie der Physiker. Es ist:

1) Die Kraft (in Form von Watt) ist das, was man braucht, um eine Arbeit zu verrichten,

2) die Arbeit braucht dann noch xyz* (Minuten, Stunden oder Tage-werke), der Kraft.

und am Ende der Arbeit steht:

3) das Werk (Ergon).

Die Moral von der Geschicht‘ ist: Lasse keine Politiker oder Parlamentarier über Energie-Technologie entscheiden, die nicht wenigstens einen Uni-Abschluss in Physik, Thermodynamik, oder Energie-Technik, sowie ein paar Jahre Praxis darin, haben. Deshalb: Rauschebart- Turnschuh- Linksgrün- Aktivisten mit viel „Dampf“ im Hirn sind da nicht zu gebrauchen.

Das Problem der Energiebilanz, der Energie-Dichte pro Masse und pro Zeit-Einheit

Die Energiebilanz von Kraft-Stoffen ist sehr unterschiedlich, angefangen mit dem Aufwand (= Kapital und Energie) für ihre Gewinnung aus der Erde oder aus dem Sonnenlicht und ihre Aufbereitung. Die Atom-Kern-Fission mit dem Brennstoff Uran hat die höchste potentielle Energiedichte (=Energie-Potential) pro Volumen und pro Gewicht. Allerdings hat es auch die höchsten Kosten, um die ausgebrannten Reste des fissilen Brenn-Materials irgendwo zu entsorgen, und zwar für ca. 100.000 Jahre.

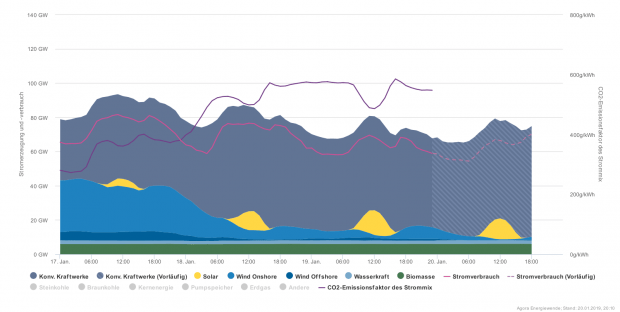

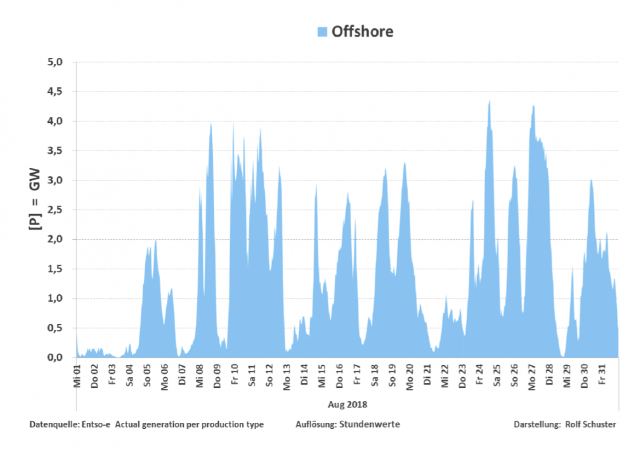

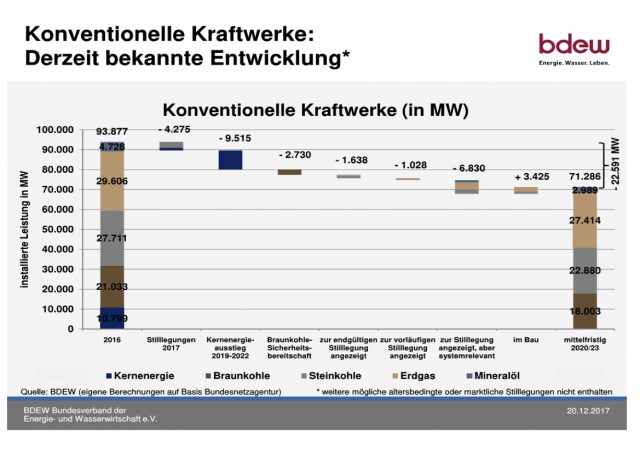

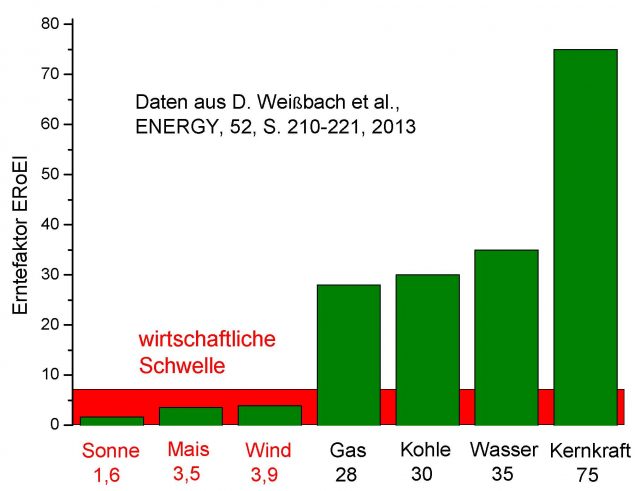

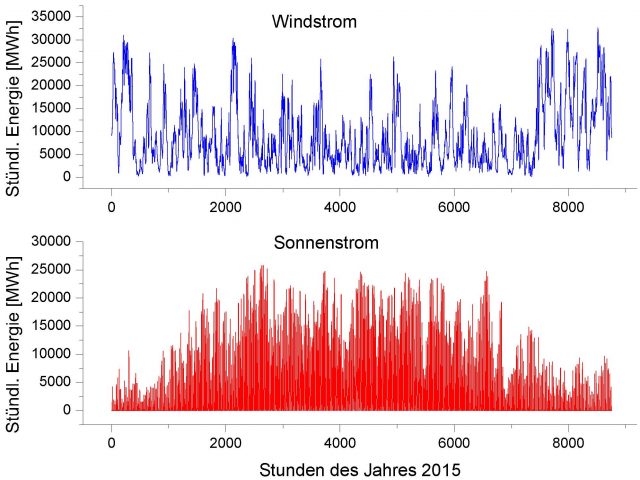

Fossile Kraftstoffe wie Kohle,[11]Öl und Methan-Gas haben recht unterschiedliche Kosten für die Gewinnung[12]und eine geringere aber immer noch hohe Energiedichte pro Volumen und pro Gewicht. Bei den erneuerbaren Energien, also Wind und Sonne, verschlechtert sich die Energiebilanz durch die hohen anfänglichen Investitionskosten, durch den hohen Platzbedarf, und die hohen Schwankungen im Output, die wiederum extrem hohe Speicherkosten nach sich ziehen.

Einzig die Wasserkraft aus Stauwerken hat eine hohe Energiedichte und Speicherbarkeit, aber erhebliche ökologische und politische Folgekosten. Denn ein grosser Staudamm setzt erst einmal grosse, vorher meist besiedelte Flächen unter Wasser, und zerstört das Ökosystem der Fische, etwa im Fall der Lachse, die in ihrem Lebens-Zyklus meistens die Flüsse herauf- und herab- wandern wollen, aber an einem Staudamm nicht weiter kommen.[13]Weiterhin geraten durch das aufgestaute Wasser öfter einmal die Berghänge entlang der Speicherseen ins Rutschen.[14]Die Masse des aufgestauten Wassers kann Auslöser für Erdbeben sein. Politisch ist es problematisch, weil ein Staudamm stromaufwärts, die stromabwärts gelegenen Anrainer in Wasser-Probleme bringt. Siehe den Nil und die Ströme Asiens, wo das Problem besonders verschärft auftritt.

Die Herangehensweise der deutschen Bundesregierung, erst einmal nur die Erzeugung der erneuerbaren Energien zu fördern, ohne sich um die Speicherung und Verteilung derselben zu kümmern, war also, das Pferd von hinten aufzuzäumen, und hat zu ungeheuren (und besser vermeidbaren) Kosten für die Bevölkerung Deutschlands geführt. Es hatte auch niemand daran gedacht, dass die Chinesen die Technik so schnell kopieren konnten, so dass die Deutschen Industrien damit nicht mehr konkurrenzfähig, also weg vom Markt waren. Der Strompreis in Deutschland ist europaweit einer der höchsten.[15]Da es nur für bestimmte Gross-Industrien Strompreis-Rabatte gibt, leidet vor allem die deutsche mittelständische und Klein-Industrie darunter, und damit die gesamte Wirtschaftskraft Deutschlands. Wieso eine Bundeskanzlerin als Physikerin so etwas veranlasst hat, ist völlig unverständlich.[16]/[17]

Natürlich hat die Mainstream-Presse von diesen physikalischen Hintergründen wenig Ahnung, weil die meisten Journalies eher Schwach-Mathikersind.[18]Sie beten nur irgendetwas nach, was ihnen von den grün-wolkigen Interessen-Gruppen vorgebetet oder vorgeflötetet wird. Ungefähr so ist es auch bei den Links-Grünen Parteigenossen, von denen die meisten ziemlich wolkige (Cloud-) Vorstellungen von Energie haben. Eine nette nicht ganz ernst gemeinte Satire dazu gibt es in diesem Artikel.[19]Denn der kritische Faktor der Erneuerbaren Energien ist die Energie-Speicherung. Diese ist zwar mit vielen Technologien möglich, aber energetisch sehr teuer. Denn es vermindert entscheidend den Wirkungsgrad. Etwa wenn man Wasserstoff aus Wasser erzeugt.[20]Aufgrund der sehr hohen Verluste der Konversion, und natürlich der hohen Kapital-Kosten der Speicher- und Transport-Technologien muss das in der Energiebilanz negativ einberechnet werden.

Weiter ausser Acht gelassen in der Energie-Debatte sind die ökologischen Kosten der Erneuerbaren Energien. U.a. sind da seltene Elemente, wie Kobalt, seltene Erden wie Neodym für die Magneten der Windturbinen, die erstens knapp sind, und deren Gewinnung hohe Umweltkosten verursacht. Wer macht für alle diese Faktoren schon vernünftige Kalkulationen? Eine WWW-Seite, die das spezifisch thematisiert, ist eike-klima-energie. Dort stehen auch Artikel, die von Fachleuten geschrieben sind: [21]

https://eike.institute/

Ich füge hier auch noch ein paar Videos aus dem Youtube zu dem Themenbereich an.[22]

Die Desertec- Energie im Minus

Ein gutes Beispiel für unerwartete Folgekosten ist die Photovoltaik (PV) in den grossen Wüstengebieten, wo es viel Platz und Sonne zur meisten Zeit des Jahres gibt. Das war einmal eine Idee ähnlich wie bei Desertec,[23]/[24]die aber schnell untergegangen ist. Denn in der Wüste gibt es viel Sand, und Sandstürme (=Sandstrahlgerät mit 100 bis 300 km/h, der Beschleunigung des Sandes, in der Grössenordnung von Kilo- bis Megatonnen,[25]und das manchmal tagelang), und die lassen die schönen PV-Anlagen sehr schnell sehr alt aussehen. Vor allem aber ist es sehr staubig, so dass kein Sonnenlicht mehr auf die PV-Paneele durchkommt.[26]Dazu kommen natürlich auch die Terroristen, die man bei 10 bis 100 km**2 pro Anlage kaum davon abhalten könnte, dauernd hier und da ein paar Bomben reinzuschiessen. Die Stromleitungen, etwa von der Sahara nach Europa wären aufgrund der Leitungsverluste ebenfalls nicht rentabel. Käme vielleicht noch als denkbare Alternative etwa die Erzeugung von Wasserstoff, aber in der Wüste gibt es kein Wasser dafür. Dafür müsste man erst riesige Wasser-Entsalzungsanlagen bauen, und dann Pipelines zu den PV-Anlagen bauen. Und die Wasserstoff-Tanker, um das nach Europa zu verschiffen, sind auch nur ziemlich aufwendig zu realisieren.[27]Usw. usf. Das sind alles extreme Wirkungsgrad-Vernichter so dass man vielleicht 1-5 % der erzeugten PV-Energie zum Verbraucher schicken kann, bei ungeheuren Kapital-Investitionen. Die Sonne und der Wind geben uns ihre Energie ganz bestimmt nicht umsonst.[28]

Eine Milchmädchen-Rechnung von Energie, Kraft und Arbeit

Nehmen wir einmal ein sehr vereinfachtes alternatives Energie-Vorstellungs-System, bei dem wir nur eine ungefähre, also nicht so exakte Umrechnung von (Kilo-) Watt gegen Wärme in einem Liter Wasser machen. In der einfachsten Form haben wir die Übertragung von Wärme aus einer Energie-Quelle (=Brennstoff) in eine Energie-Senke (=Wasser): Eine Badewanne mit 100 L Wasser (=Energie-Senke), das man von 0 auf 100 Grad innerhalb von 10 Minuten = 600 Sekunden erhitzt. Das ist vielleicht für jeden Menschen allgemein verständlich, und kann theoretisch von einem (sehr grossen) Gas-Durchlauf-Boiler (=Energie-Quelle) erreicht werden.[29]Der Code dafür würde etwa lauten: L100G100/Sec600 oder L(iter)100 * G(rad)100, pro Sekunden 600. Da wir aber das Wasser nur portionenweise (im Durchlauf) erhitzen, wollen wir in diesem Falle 1 Liter in 6 Sec., auf 100 Grad erwärmen. Ein Ein-Liter Kochtopf mit ca. 1000 Watt hätte den Code L1G100/Sec600. Es ist anschaulich zu verstehen: Wenn der Kochtopf bei 1.000 Watt (=Kraft) für 1 Liter Wasser, dafür 600 Sekunden oder 10 Minuten (=10 Kilowatt-Minuten =Arbeit) braucht, dass die Gas-Therme für die Badewanne aber 100.000 Watt (=Kraft) braucht, um 100 Liter in derselben Zeit von 10 Min. zu erhitzen. Die Energiedichte pro Zeiteinheit (=Kraft) ist der schwierigste Faktor für das Verständnis, weil es umgekehrt proportional zur Zeit ist. Wenn wir nun 100 Liter Wasser auf 100 Grad, in 6 Sekunden erhitzen wollen, braucht man eine noch viel höhere Energiedichte (=Watt, bzw. Kraft). Das lässt sich etwa mit dem Code L100G100/Sec6 anschaulich machen. Auch wenn wir am Ende doch nur 100 Liter Wasser mit 100 Grad Wärmemenge haben. Für den Wärme-Transfer wäre das mit chemischer Energie nur mit einem Raketenmotor zu erreichen. Und wenn wir es noch weiter treiben wollen, dann wäre eine kleine Atombombe in der Lage, das auch für 1.000.000 Liter in 1/1000 Sec zu schaffen.[30]/[31]/[32]/[33]

Analog, aber komplizierter ist die Formel, um eine Wohnung von 100 m**2 und 3 m hoch (=300 m**3 =QM), von 0 auf 20 Grad zu bringen, wenn man das in einer Stunde aufheizen will. Der Code QM300G20/Sec3600 symbolisiert das, ist aber energetisch sehr viel schwieriger zu berechnen, weil die Wände ja auch erstmal kalt sind, und dann fliesst die Wärme ja durch alle Ritzen und Fenster wieder ab. Und die gespeicherte Energie in Form von Wasserdampfin der Luft ist die darin noch gar nicht berücksichtigte Calorische Komponente dieser Rechnung.[34]/[35]

Ebenso kann man die Einheit PS oder Pferdestärke anschaulich machen: L100CM100/Sec1. Das wären 100 Liter Wasser (=100 Kg), die man 100 Centimeter (=CM) in 1 Sekunde gegen die Erd-Schwerkraft hochheben möchte.[36]Das entspricht ca. 1,33 PS oder ca. 1000 Watt. Der Code M60*(L100CM100/Sec1) wäre also ungefähr eine Kilowattstunde.

Die Energie-Dichte pro Zeiteinheit (=Kraft) ist äquivalent zu der Beschleunigung. Um ein Auto von 1000 kg von 0 auf 100 km/h zu beschleunigen, braucht es mehr Beschleunigung innerhalb von 10 Sec, als wenn wir uns dafür 100 Sec nehmen. Was dann in den Automobil-Journalen an oberster Stelle steht. Paradox und schwer verständlich dabei ist nur, dass das Auto mit 1000 Kg bei 100 km/h dieselbe kinetische Energie hat, egal ob es dafür 10 Sec. oder 100 Sec. gebraucht hat. Wie kommt das zustande? Dass für dieselbe kinetische Energie, die im Endeffekt (nach dem Ende der Arbeit) noch verfügbar ist (=Kraft), doch ganz verschiedene Mengen Energie gebraucht werden, um das zu erzeugen, wenn wir das in 10 Sec. oder in 100 Sec. machen wollen?

Ein anderes und etwas weiter hergeholtes Beispiel für eine (nicht so) anschauliche Darstellung wäre die Auflösung von Zeno’s Paradox von Achilles und der Schildkröte. Das Paradox entsteht nämlich durch eine Verkettung von irrealen Annahmen, was in der Computerei als GIGO-Prinzip bekannt ist (Garbage in, Garbage out). Siehe:

http://www.noologie.de/zeno01.htm

Warum eine Tonne TNT weniger Energie hat als eine Tonne Kerosin

Eine Tonne (= 1000 Kg) TNT hat weniger thermische Energie als eine Tonne Kerosin (oder Diesel was hier praktisch äquivalent ist). Auch wenn der Knall-Effekt der Explosion von einer Tonne TNT erheblich grösser aussieht als bei Kerosin. Warum ist das so? Weil eine Tonne Kerosin für die Energie-Erzeugung dazu noch Sauerstoff (=Oxydans) braucht, und davon ziemlich viel. Das ist in etwa die Gleichung für die Raketen-Motoren im Volumen-Verhältnis ca. 1:1.3 bis 1:3 bei den Saturn-Raketen.[37]Leider gibt es in den meisten www-Quellen keine Angabe zum Gewicht, nur zum Volumen. Aber für 1000 Liter Kerosin brauchen wir ca. 1300 Liter LOX (Liquid) Oxygen in der Rakete, um das auch gut zu verbrennen. „LOX is denser than kerosene or liquid hydrogen“.[38]LOX hat etwa 1.14 g/ml. Kerosin hat ca. 0.82 g/ml.In einer Tonne TNT muss das Oxydans im Äquivalent von 1-4 Tonnen Oxygen in der Mischung schon chemisch eingebunden mit dabei sein, sonst geht das Feuerwerk gar nicht los. Und daher enthält TNT proportional weniger verwertbaren Brennstoff in Form von CH-xy Carbohydraten =Toluol.[39]Die Energiedichte der potentiellen Energie bei Brennstoffen, also hier im Falle Kerosin, ist ebenfalls variabel, und zwar sowohl nach Volumen, wie nach Gewicht, was sehr unterschiedlich sein kann. Liquid H2 (=Wasserstoff) hat zwar die grösste potentielle Energiedichte pro Gewicht, aber die geringste pro Volumen. Alle diese Faktoren sind sehr wichtig in der Raketentechnik, aber im Fall der Auto-Industrie ist das für Liquid H2 ein Kill-Faktor.[40]Wenn ein Explosiv-Stoff mechanisch aus 2 Komponenten Oxydiser:Brennstoff gemischt wird, ist es besser zu sehen, in welchem Verhältnis man Oxydiser und Kraftstoff mischen muss.[41]Als Beispiel nehmen wir den Energiemix von Ammonium-Perchlorat oder Ammonium-Nitrat mit Diesel, =ANFO, oder einem anderen Hydrocarbon. Dort ist das Verhältnis sogar 94 % Oxydans zu 6 % Brennstoff:

It consists of 94% porous prilled ammonium nitrate (NH4NO3) (AN), which acts as the oxidizing agent and absorbent for the fuel, and 6% number 2 fuel oil (FO). ANFO has found wide use in coal mining, quarrying, metal mining, and civil construction in applications where its low cost and ease of use may outweigh the benefits of other explosives, such as water resistance, oxygen balance, higher detonation velocity, or performance in small-diameter columns. ANFO is also widely used in avalanche hazard mitigation.

https://en.wikipedia.org/wiki/ANFO

https://en.wikipedia.org/wiki/ANFO#Malicious_use

https://en.wikipedia.org/wiki/Ammonium_perchlorate

Bei einer Batterie ist es ganz analog zu dem Beispiel von TNT. Denn auch in einer Batterie muss das energetische Äquivalent von O2 schon mit hinein gespeichert sein, und daher bekommen wir aus einer Tonne Batterie nie soviel Energie heraus, wie aus einer Tonne Kerosin.[42]

Wir fassen also zusammen: Für die Energie-Physiker ist nur der Calorische Energiewert des Brennstoffs relevant, wobei man ausser Acht lässt, dass es einen grossen Unterschied macht, ob das Verbrennen in 100 Minuten oder in 0,001 Sekunden stattfindet. Das eine grosse Denkbremse des physikalischen Energie-Denkens, die schwer zu überwinden ist. Und das überlassen die Theoretischen Physiker dann lieber den Ingenieuren, die schon wissen, wo die Unterschiede liegen, und wie man damit umgehen muss. Und das Alles eher trotz der Formeln der Theoretischen Physik. Es geht also um die Prozess-Geschwindigkeit, also Energie-Menge und Dichte pro Zeit-Einheit. Dies nennt man anderswo auch die Kraft. Aber das ist keine physically correcte Weise zu denken.

Und noch ein paar Un-Denk-Beispielevon Volumen, Gewicht, und Masse

Die allzu-vielen „Doku“-Videos von N24 (und noch viele weitere auf dem US-Ami-Youtube) geben uns ein noch paar gute Beispiele für Un-Denk-Methoden. So werden Volumen-Angaben immer in x* Olympic Swimming Pools gemacht, wobei keiner weiss, wieviel Volumen ein Olympic Swimming Pool eigentlich hat.[43]Oder noch besser: Diese Talsperre hat x Millionen bis Milliarden Liter Wasser. Den Begriff Kubik-Meter oder Kubik-Kilometer kennt dort niemand. Hier ist vor allem die Denkfalle enthalten, die für die Journalies meist zu schwierig ist: Die Masse wächst im Kubik zur linearen Ausdehnung. Höhen werden immer gerne mit x übereinander gestapelten US-School-Bussen dargestellt, wobei nur die US-Amis sich vorstellen können, wie lang ein US-School-Bus ist. Gewichte werden prinzipiell mit x mal SUV’s dargestellt, was für jeden US-Ami natürlich sofort einsichtig ist. Desweiteren redet man auch immer von x mal Football-Pitches, anstatt von x mal 100 Meter. Das wohl allerschlimmste Beispiel ist, dass kein Journalie eine Exponential-Funktion denken kann.[44]Der meiste Rest der Menschheit leider auch nicht. Etc. pp. Es gibt nur endlich viel Intelligenz im Universum, aber unendlich viele Arten, um etwas un-intelligent bzw. un-anschaulich darzustellen.

[1]… und am Deutschen Ingenieur-Wesen sollte nun endlich einmal die Welt genesen.

[2]https://www.zeit.de/2017/49/strom-abstellen-deutschland-betroffene

https://www.shz.de/deutschland-welt/wirtschaft/armut-in-deutschland-330-000-haushalten-wurde-der-strom-abgestellt-id16249901.html

[3]https://eike.institute/2014/12/01/abschied-von-der-versorgungssicherheit-deutschlands-stromversorgung-ist-nicht-mehr-zu-retten/

[4]https://www.journalistenwatch.com/2018/11/19/wenn-sonne-rechnung/

Zitat daraus:

Ich wage mal eine Prognose. Wenn wir nicht vorher einen katastrophalen Blackout hinlegen, dann landen wir in fünf Jahren bei einem Strompreis von 50 Cents pro Kilowattstunde. Dann sind wir nicht nur Strompreis-Europameister, dann sind wir endlich wieder Weltmeister. Nicht im Fußball, aber im Strompreis. Das gerne gebrachte Opfer wäre dann für eine deutsche Durchschnittsfamilie so um 4000 Euro pro Jahr. Das sind etwa 1300 Kugeln bestes Schokoeis von Berthillion, also mehr als 100 Kugeln im Monat. Nicht zu sprechen von den 4000 Kugeln Normaleis pro Jahr, das wären dann täglich 11 Kugeln – Bon Appetit.

[5]Hier liegt die erste Denkfalle: Die Kraft ist das, was nötig ist, um die Arbeit zu machen. Das Werk, also die getane Arbeit ist das Endprodukt. Und das weiss jeder Arbeiter in der Kohlemine, dass er am Morgen meistens mehr Kraft hat, als am Abend.

[6]https://en.wikipedia.org/wiki/Conservation_law

[7]https://de.wikipedia.org/wiki/Akt_und_Potenz

[8]Watt ihr Volt:

Wie ich es einmal in einem Vortrag gesagt habe: Wenn ein „Visiting Anthropologist“ vom fernen

Stern Marsupial der Grünen Männchen auf einer Irdischen (=terrestrischen) Physiker-Tagung

als Beobachter dabei wäre, würde er denken, dass man hier eine Heilige Messe zu Ehren der Schutzheiligen,

dem Hl. St. Newton, dem Hl. St. Joule, dem Hl. St. Watt, dem Hl. St. Ampere, und dem Hl. St. Ohm, celebriert,

dazu mit ein paar Weihrauch- Ovationen für den Ober-Heiligen St. Einstein.

Ich würde mich sehr wundern, wenn nicht bald eine Physiker-Kongregation beschliesst,

eine Physikalische Einheit als „Einstein“ zu benennen. Mein Wunschkandidat dafür wäre:

Das Quantum Dunkle Materie, die 90% des Universums ausmacht, und die noch niemand

je gesehen oder gemessen hat. Das wäre der ewigen Ehre des Einsteins wohl angemessen.

[9]http://www.noologie.de/symbol09.htm

http://www.noologie.de/noo04.htm#Heading234

Diese Diskussion geht bis auf C.S. Peirce zurück.

[10]Was sie aber zu einer Paria-Gemeinde der Sieben Aufrechten des Fähnleins macht, die von allen anderen

gestandenen Physikern im Gefolge von Einstein abhorresziert werden

Siehe dazu: Dieter Straub und sein Buch: Das Glasperlenspiel.

https://www.unibw.de/thermodynamik/modulseiten/modulseite_mitarbeiter/ehemalige-mitarbeiter

https://trauer.sueddeutsche.de/traueranzeige/dieter-straub-1934

Hier ist eine ausführliche Widmung des Werks von Dieter Straub:

http://teutonika.de/?p=6614

https://www.springer.com/de/book/9783034861519

https://www.ekkehard-friebe.de/Waibel.html

https://www.ekkehard-friebe.de/start.html

https://d-nb.info/104384726X/34

[11]Die Förderung von Braunkohle in Deutschland hat 1794.9 km**2 belegt, die aber z.T wieder renaturiert wurden.

https://www.cleanenergywire.org/factsheets/germanys-three-lignite-mining-regions

https://www.worldenergy.org/data/resources/country/germany/coal/

Nach der Quelle werden 129 Millionen Tonnen pro Jahr in Deutschland abgebaut.

[12]Die Förderung von Öl-Sanden in Kanada ist die wohl kapital-intensivste und ökologisch katastrophalste

Energie-Technik weltweit. Das Fracking in den USA steht dem nicht sehr viel nach.

[13]Bestes Beispiel: Der Columbia-River Dam.

https://www.nwcouncil.org/reports/columbia-river-history/damsimpacts

https://www.nrdc.org/stories/columbia-snake-river-basin-salmon-are-losing-their-way

[14]Bestes Beispiel: Der Vayont-Staudamm in Nord-Italien.

https://en.wikipedia.org/wiki/Vajont_Dam

At 10:39 p.m., a massive landslide of about 260,000,000 cubic metres (340,000,000 cu yd) of forest, earth, and rock fell into the reservoir at up to 110 kilometres per hour (68 mph), completely filling the narrow reservoir behind the dam. The landslide was complete in just 45 seconds, much faster than predicted, and the resulting displacement of water caused 50,000,000 cubic metres (65,000,000 cu yd) of water to overtop the dam in a 250-metre (820 ft) high wave.

Das waren 0,05 Cubic Kilometer.

1 Cubic kilometer is equal to a volume with sides 1000 x 1000 x 1000 meters. 1 km**3 = 1,000,000,000 m3.

https://www.unitconverters.net/volume/cubic-meter-to-cubic-kilometer.htm

[15]https://www.journalistenwatch.com/2018/11/19/wenn-sonne-rechnung/

[16]Ausser eben, dass diese Bundeskanzlerin sich vielleicht damit positionieren wollte,

dass: „An dem Deutschen Ingenieur-Wesen soll irgendwann einmal die Welt genesen“.

Dafür bekommt sie aber sicher bald einen hohen Posten bei der UN.

[17]In der ehemaligen DDR war man in Thermodynamik weltweit Spitzenklasse.

Das war vor allem an der Hochschule Zittau. Die kümmerten sich um all die

Braunkohle- Industrien, von denen die DDR existenziell abhing. Die Frau Merkel hätte sich

damals wohl besser ein wenig öfter in Zittau umgetan. Energie hat mehr mit Thermodynamik

zu tun, als mit Quanten-Theorie.

http://de.plagipedi.wikia.com/wiki/Merkel,_Angela:_Untersuchung_des_Mechanismus_von_Zerfallsreaktionen_mit_einfachem_Bindungsbruch_und_Berechnung_ihrer_Geschwindigkeitskonstanten_auf_der_Grundlage_quantenchemischer_und_statistischer_Methoden_(Dissertation)

https://www.zeit.de/2005/29/B-Merkel

https://f-m.hszg.de/fakultaet/fachgruppe-energietechnik/technische-thermodynamik.html

https://f-m.hszg.de/personen/mitarbeiter/prof-dr-ing-bernd-haschke.html

http://www.thermodynamik-zittau.de/

[18]Im Lehrplan der Journalistenschulen kommt Energie-Technik nicht vor.

[19]https://www.achgut.com/artikel/danke_angela_und_annalena_und_e.on

Es wäre interessant, nachzurecherchieren, welche von den Grünen Klima- und Energie-Protagonisten

einen Doktor in Physik, Thermodynamik, oder Energie-Ingenieur haben.

[20]Bei Wasserstoff ist Speicherung nur im Flüssig-Zustand praktikabel, aber die Energiekosten, um

Flüssig- Wasserstoff herzustellen, sind enorm. Denn das, was man an Energie hereingesteckt hat,

um ihn zu verflüssigen, bekommt man nie wieder heraus. Das ist nur in der Raketen-Technik eine Option.

Eine ziemlich gute Diskussion der Energie-Effizienz der Wasserstoff-Energie ist hier:

https://www.youtube.com/watch?v=f7MzFfuNOtY

Das folgende ist eher journalistisch-euphemistisch, und verschweigt die Fragen der Effizienz:

https://www.youtube.com/watch?v=c2yraQkMsJs

Ein anderer euphemistischer Bericht von Arte erwähnt ebenfalls nirgendwo diese Kosten.

https://www.youtube.com/watch?v=–4J-KuBMTM

Aber wenigstens gibt es in 12:00 eine Alternative Speichermethode von mcphy.com.

Hier ist es Magnesium-H2- Schwamm (oder ist es Magnesium-Hydrat?).

Siehe dazu die Website von mcphy.com. Auch hier komnt man über euphemistische Darstellungen nicht hinaus.

https://mcphy.com/en/

[21]Horst-Joachim Lüdecke; Prof. Dr. rer.nat. Physiker:

https://eike.institute/?s=L%C3%BCdecke

https://eike.institute/2018/11/05/erneuerbar-sind-nur-illusionen-die-zukunftstechnologie-windkraft-steht-vor-unloesbaren-problemen-teil-1/

https://eike.institute/2018/11/06/erneuerbar-sind-nur-illusionen-die-zukunftstechnologie-windkraft-steht-vor-unloesbaren-problemen-teil-2/

https://eike.institute/2014/11/20/eike-8-ikek-praezises-klima-timing-ueber-die-letzten-2500-jahre-prof-dr-horst-joachim-luedecke/

https://eike.institute/2013/09/18/die-deutsche-physikalische-gesellschaft-dpg-rezensiert-die-buecher-kampf-um-strom-von-prof-claudia-kemfert-im-vergleich-mit-energie-und-klima-von-prof-horst-joa/

https://eike.institute/2011/10/13/anmerkungen-zu-herrn-prof-dr-luedeckes-charakterisierung-der-medien-und-der-politik/

https://eike.institute/2008/08/21/prof-luedecke-offener-brief-zu-vielen-beitraegen-im-ehemals-liberalen-handelsblatt/

https://eike.institute/2018/10/13/ist-afrika-klueger-als-deutschland/

https://eike.institute/2016/08/11/glueckliche-schwarze-im-schein-einer-solarlampe-als-neokolonialer-traum-2/

[22]Ein ganz guter US-Ami-Vortrag zur Klimageschichte über xyz-Millionen Jahre ist von

Dan Britt – Orbits and Ice Ages: The History of Climate.

Was an diesem Video bemerkenswert ist: Das perfekte Mixing des Vortragenden

mit all seinen Fotos und Charts, was Media-technisch ziemlich anspruchsvoll ist.

https://www.youtube.com/watch?v=Yze1YAz_LYM&t=118s

Ditto: Climate (Paleoclimate) and Archaeology/History

https://www.youtube.com/watch?v=JD-MSrgPdFQ

Auch ganz nett: A Funny Thing Happened on the Way to Global Warming

Steven F. Hayward, Pepperdine University

https://www.youtube.com/watch?v=RZlICdawHRA

Bei den Amis glaubt man öfter, dass man versehentlich in eine eine Dampf-Plauderei von Billy Graham

hereingeraten ist, der gerade dummerweise das falsche Buch zum Zitieren mitgenommen hat.

Und der alle 10 Sekunden extrem laut und hörbar „ahhh“ und „oohhh“ macht, als hätte er gerade einen Orgasmus.

Oder noch schlimmer, es ist fast so, wie wenn Otto Waalkes uns eine Nachhilfe-Stunde in Klimatologie gibt.

Richard Alley – 4.6 Billion Years of Earth’s Climate History: The Role of CO2

https://www.youtube.com/watch?v=ujkcTZZlikg

[23]Dort wollte man aber thermische Solaranlagen bauen, also Kollektoren, die die Hitze einfangen

und konzentrieren. Die Energie-Speicherung sollte entweder mit einem Öl,

(=wenig Dichte und sehr grosse Behälter) oder mit ultraheissen (=verflüssigten) Salzen

(=viel Energie-Dichte =höhere Temperaturen) geschehen.

Letztere ist technisch zwar interessant, aber ultraheisse Salze sind extrem korrosiv und entsprechend

schwer technisch zu handhaben. Z.B. wenn man ca. 1.000 km vom nächsten Techniker-Büro entfernt ist.

Und wehe (=lat. vae victis), wenn ein thermischer Salz-Speicher-Behälter

einmal kalt=fest wird. Dann geht gar nichts mehr, wenn das Salz sich auch noch

in allen Rohrleitungen verfestigt.

[24]https://www.ecomena.org/desertec/

https://www.nature.com/news/sahara-solar-plan-loses-its-shine-1.11684

https://www.nature.com/news/2009/090121/full/457362a.html

https://www.chinadialogue.net/article/show/single/en/7558-Desertec-s-plan-for-Saharan-sun-to-power-Europe-burns-out

[25]Nehmen wir einmal als Positiv-Beispiel die Un-Mengen von Sand, die von der Sahara

in alle Welt geweht werden, so dass in den Alpen an bestimmten Tagen der Schnee braun ist,

von Sahara-Sand, und das Amazonas-Becken soviel davon abbekommt, dass es davon seine

Fruchtbarkeit bezieht. Wenn es da keinen Sahara-Sand gäbe, wäre das Amazonas-Becken eine kahle Wüste.

Das sind Kilo-Tonnen und Mega-Tonnen von Sand.

[26]Und das Wasser, um die Paneele immer wieder abzuwaschen, ist ja auch knapp.

[27]Bei Flüssig-Methan ist das praktikabel, aber für Flüssig-Wasserstoff braucht es viel tiefere Temperaturen

= (–252.882 °C). Und bei der Energie pro Cubic Meter sieht das noch viel schlimmer aus,

weil H2 ein gewaltiges Volumen benötigt. Siehe:

https://en.wikipedia.org/wiki/Hydrogen_economy

https://en.wikipedia.org/wiki/Hydrogen_economy#Electrolysis_of_water

https://en.wikipedia.org/wiki/Hydrogen_economy#Liquid_hydrogen

[28]https://www.journalistenwatch.com/2018/11/19/wenn-sonne-rechnung/

[29]Realistisch wären eher 30 Minuten, aber hier ist die Einheit 10 leichter begreiflich.

Es wird bei diesem Milchmädchen- Beispiel auch unterschlagen,

dass das Wasser aus der Leitung schon ca. 10 Grad warm ist, und zum Baden wird es nur auf

- 40 Grad erhitzt. Die Temperatur-Differenz ist also nur 30 Grad.

Deshalb braucht Jedermann/Jedefrau auch keine 100.000 Watt für ein Bad in der Wanne.

[30]Dann gibt es noch ein paar Zahlenspielereien: 1.000.000 Liter werden in 1000 Kubikmeter umgerechnet.

Das klingt auf einmal viel handlicher. Es sind auch 1000 metrische Tonnen, also eine Kilotonne.

Es ist auch 0.4 Olympic Swimming Pool (der 2.500.000 Liter oder 2.500 Kubikmeter hat).

Die Hiroshima-Bombe hatte 10 – 15 Kilotonnen TNT-Äquivalent Sprengkraft.

https://en.wikipedia.org/wiki/Little_Boy

https://en.wikipedia.org/wiki/Nuclear_weapon_yield

Die minimale Sprengkraft einer Fissions-Bombe liegt wohl sogar herunter bis zu 10 – 20 Tonnen TNT Äquivalent.

http://dc.medill.northwestern.edu/blog/2018/02/09/exactly-low-yield-nuclear-weapon/#sthash.RFNoESzv.dpbs

https://www.quora.com/What-is-the-minimum-yield-of-a-nuclear-bomb-How-small-can-we-make-a-nuclear-explosion

[Minimum weight of a fission core] It depends upon the fissionable material, but roughly 11–30lbs. It’s possible to make a backpack weapon of about 50–70 pounds and it’s ‘rumoured’ that the Russians tried to make one or more of them. That would (I am guessing) result in an explosion on the scale of 10–20 Tons of TNT. Which is a lot but it’s not all that impressive. Usually we measure weapons by the kiloton (1000 tons). Furthermore there is a sort of maximum value of practical nuclear weapons, because they get very heavy. So for example, US W-80 cruise missile yields 150kt.

[31]Hier sieht man auch sehr schön den Irrtum, der in der Mainstream-Presse hundertfach wiederholt wird,

wenn die Journalies schreiben, dass ein Hurrican x mal soviel Energie hat wie eine H-Bombe.

Was die aber geflissentlich vergessen, bzw. sich gar nicht vorstellen können ist, dass das Eine etwa eine

Woche braucht, das Andere aber nur 1/1000 Sec. So entscheidend ist der Faktor der Energie-Dichte.

[32]Eine noch gewaltigere Energiemenge wäre der Einschlag eines Meteors, wie etwa der des Kraters

Chicxulub, vor ca. 66 Millionen Jahren. Ich führe das Beispiel deswegen an, weil Meteore meistens

nicht senkrecht zur Erde fallen, sondern meist tangential, und sie bestehen meistens aus mehr oder weniger lockerem

Gestein. Wenn sie tangential zur Erde fallen, verteilt sich ihre Anfangs-Energie ersteinmal durch eine

xyz-Kilometer Reise durch die Atmosphäre, wobei viele Meteore wegen der Hitze schon in Stücke zerfallen,

bevor sie auf die Erde bzw. ins Wasser fallen. Und bei der Reise durch die Atmosphäre, würde ein solcher Meteorit bei seinem Einsturz auch x-Millionen Quadratkilometer Waldlandschaft in ein Flammendes Inferno verwandeln.

Siehe das Tunguska Event.

https://en.wikipedia.org/wiki/Tunguska_event

Im Falle von Wasser würden die Bruchstücke ihre kinetische Energie hauptsächlich durch das Verdampfen des Wassers weiter verteilen. Daher ist das Thema wiederum die Energiedichte pro Zeiteinheit. Denn so verteilt sich

ihre gewaltige Energie auf diverse Minuten (bei ca. 10.000 km/h). Und nicht auf 0,xyz Sekunden.

Weiterhin wäre so ein Einsturz-Krater nicht kreisförmig, sondern ein sehr lang gezogenes Ellipsoid.

https://en.wikipedia.org/wiki/Chicxulub_crater

http://large.stanford.edu/courses/2015/ph240/xu2/

http://jgs.lyellcollection.org/content/162/4/591

[33]Als kleine Anekdote dazu: Der deutsche Sci-Fi Autor Hans Dominik hat in einem seiner Werke

das Wundermittel Dynotherm „erfunden“. Eine Prise davon, und man konnte damit ein ganzes Schwimmbad

= 2.500.000 Liter oder 2.500 Kubikmeter zum Kochen bringen. Das hätten wir heute auch gerne.

https://books.google.de/books?id=6XEPDAAAQBAJ&pg=PT1919&lpg=PT1919&dq=Dominik+Dynotherm&source=bl&ots=VpZkpAhylh&sig=RlLdizuFRy0b4PH1y2ONBTPHx8o&hl=de&sa=X&ved=2ahUKEwjdzbLb5b3eAhWOL1AKHYHuCysQ6AEwCHoECBsQAQ#v=onepage&q=Dominik%20Dynotherm&f=false

[34]Siehe dazu auch das Häuser-Dämm-Problem der Politik. Denn man hat hierbei die Rechnung ohne den Wirt

gemacht. Der Wirt ist hier der Wasserdampf, der in der Luft eine erhebliche Menge Energie speichert.

Wenn das Haus gegen den Luftaustausch abgedichtet ist, was es nie vollkommen sein kann, kondensiert sich der

Wasserdampf an den unmöglichsten Stellen, und das heisst: Schimmel und Verrottung des Mauerwerks.

[35]Siehe auch: Warum der Wasserdampf die Haupt-Energiequelle eines Hurricans ist.

[36]https://en.wikipedia.org/wiki/Horsepower

75 kg × 9.80665 m/s2 × 1 m / 1 s = 75 kgf·m/s = 1 PS. This is equivalent to 735.499 W,

analog

100 kg × 9.80665 m/s2 × 1 m / 1 s = 100 kgf·m/s = 1.33 PS. This is equivalent to 9782 W.

[37]https://history.nasa.gov/SP-4206/ch7.htm

A tank with over 730 000 liters (200 000 gallons) of RP-1

With a capacity of 1 204 000 liters (331 000 gallons), the LOX tank …

Liquid hydrogen was only one half as dense as kerosene.

[38]https://space.stackexchange.com/questions/10649/what-are-the-criteria-to-put-the-oxygen-tank-above-or-below-the-fuel-tank-for-a

https://en.wikipedia.org/wiki/RP-1

Soviet and Russian rocket-grade kerosenes are very similar to RP-1 and are designated T-1 and RG-1. Densities are higher, 0.82 to 0.85 g/ml, compared to RP-1 at 0.81 g/ml. …

chemically, a hydrocarbon propellant is less efficient than hydrogen fuel because hydrogen releases more energy per unit mass during combustion, enabling a higher exhaust velocity. This is, in part, a result of the high mass of carbon atoms relative to hydrogen atoms.

http://www.braeunig.us/space/propel.htm

„liquid hydrogen has a very low density (0.071 g/ml)“

Liquid hydrogen therefore, requires a storage volume many times greater than other fuels. Despite these drawbacks, the high efficiency of liquid oxygen/liquid hydrogen makes these problems worth coping with when reaction time and storability are not too critical. Liquid hydrogen delivers a specific impulse about 30%-40% higher than most other rocket fuels.

http://www.braeunig.us/space/propel.htm#tables

[39]https://en.wikipedia.org/wiki/Toluene

TNT hat die User-freundliche Eigenschaft, wenn man es an freier Luft mit einer Kerze anzündet, dass es einfach verbrennt, aber nicht explodiert.

[40]Siehe hier noch einmal: https://www.youtube.com/watch?v=f7MzFfuNOtY

Noch genauer ist es bei:

https://en.wikipedia.org/wiki/Hydrogen_economy

https://en.wikipedia.org/wiki/Hydrogen_economy#Liquid_hydrogen

Alternatively, higher volumetric energy density liquid hydrogen or slush hydrogen may be used. However, liquid hydrogen is cryogenic and boils at 20.268 K (–252.882 °C or –423.188 °F). Cryogenic storage cuts weight but requires large liquification energies. The liquefaction process, involving pressurizing and cooling steps, is energy intensive.[62] The liquefied hydrogen has lower energy density by volume than gasoline by approximately a factor of four, because of the low density of liquid hydrogen — there is actually more hydrogen in a liter of gasoline (116 grams) than there is in a liter of pure liquid hydrogen (71 grams). Liquid hydrogen storage tanks must also be well insulated to minimize boil off.

Aus Zitat [62]:

The situation is much worse than this, however, because before the hydrogen can be transported anywhere, it needs to be either compressed or liquefied. To liquefy it, it must be refrigerated down to a temperature of -253°C (20 degrees above absolute zero). At these temperatures, fundamental laws of thermodynamics make refrigerators extremely inefficient. As a result, about 40 percent of the energy in the hydrogen must be spent to liquefy it. This reduces the actual net energy content of our product fuel to 792 kcal. In addition, because it is a cryogenic liquid, still more energy could be expected to be lost as the hydrogen boils away as it is warmed by heat leaking in from the outside environment during transport and storage.

[41]Man muss bei den www-Quellen darauf achten, ob nun Volumen oder Gewicht im Verhältnis angegeben wird. Nehmen wir der Einfachheit halber an, dass man technisch meistens mit Gewicht arbeitet, weil das leichter abzumessen ist, als Volumen.

[42]Und das ganz kleine, und leicht zu übersehende Problem ist: Je effizienter eine Batterie ist, desto mehr verhält sie sich im Falle eines Unfalls eher in Richtung TNT. D.h. sie setzt im ungünstigsten Falle alle ihre gespeicherte Energie auf einmal um. Wenn Tesla also seine Batterien um eine Grössenordnung besser (=energiedichter) macht, dann brennt ein Auto nicht einfach, sondern es explodiert. Und zwar bei irgendeinem Unfall, wenn die Batterie falsch zusammen gequetscht oder durchbohrt wird. Auch jetzt schon ist das ein grösseres Problem für die Feuerwehr, vor allem aber dann, wenn xyz Millionen Elektro-Autos auf den Strassen herumfahren. Da das Wasser zum Löschen auch ein guter Strom-Leiter ist, ist es ziemlich gefährlich für den Feuerwehr-Mann, ein brennendes Elektro-Auto mit Wasser abzuspritzen.

Siehe auch:

https://www.welt.de/wirtschaft/article184056942/Wer-auf-das-guenstige-Batterieauto-hofft-muss-noch-lange-warten.html

[43]Natürlich weiss Google das alles besser: Es sind 2.500.000 Liter oder 2.500 m**3.

http://www.patagoniaalliance.org/wp-content/uploads/2014/08/How-much-water-does-an-Olympic-sized-swimming-pool-hold.pdf

[44]https://patriceayme.wordpress.com/?s=exponential

https://patriceayme.wordpress.com/2018/04/23/super-earths-or-how-the-exponential-function-can-matter/

https://en.wikipedia.org/wiki/Exponential_function