Die Klimaschau von Sebastian Lüning: Fluß-Hochwässer haben in den letzten 50 Jahren global abgenommen

Die Treibhaushypothese:

Um den Strahlungshaushalt der Erde zu erklären, entwickelte Bruce Barkstorm eine aus Satellitenmesswerten abgeleitete Modellhypothese 1 einer atmosphärischen Gegenstrahlung von 327 W/m². Diese Strahlung, auch als Backradiation bezeichnet, soll in seiner Vorstellung aus der Atmosphäre in Richtung Erdoberfläche wirken. Sie wäre damit der langwelligen Abstrahlung der Erdoberfläche entgegen gerichtet. B. Barkstorm war in den 1980ger Jahren der Chefingenieur beim Bau des Satelliten ERBS, ein Teil des NASA ERBE-Programms. Die Wissenschaftler J. K. Kiehl und K. E. Trenberth übernahmen von Barkstorm 1997 in ihrer Studie „Earth’s Annual Global Mean Energy Budget“ 2 sowohl die Strahlungsverteilung als auch die Treibhaushypothese der Gegenstrahlung. In KT97 beträgt die Gegenstrahlung 3W/m² weniger und damit 324 W/m². Im Unterschied zu Barkstorm verfeinerten Kiehl und Trenberth ihr Erklärungsmuster in der Modellierung um die Zuordnung des Treibhaus- „Effektes“ der Gegenstrahlung auf einzelne unsymmetrische, atmosphärische Gase.

In der Modellhypothese KT97 verbleiben aus der gesamten, direkten Sonnenwirkung von 1367W/m2 (TSI) im rechnerischen Mittel lediglich 66 W/m² als wärmewirksamer, langwelliger Abstrahlungsanteil (LW) für die Erde übrig. Die Summe von erwärmender Sonnenwirkung als langwellige Abstrahlung von 66 W/m² (17%) und atmosphärische Gegenstrahlung 324 W/m² (83%) sollen so gemeinsam die durchschnittliche mittlere Globaltemperatur der Erde von ca. 15 °C mit 390 W/m² (100%) bei dieser Hypothese bilden, FIG.7. rechts. 83% entsprechen einer erwärmenden Wirkung von < 1% der im Molekülaufbau unsymmetrischen, atmosphärischen Gase (Wasserdampf, Kohlendioxid, Methan, Distickstoffoxid, Ozon,..). Die solare Einstrahlung von 1367 W/m² auf die Kreisfläche (r² π) projiziert, mit r = Erdradius, entspricht dem Durchschnittswert einer Abstrahlung von rund 342 W/m² (1367 W/m² / 4) auf der gesamten Erdkugeloberfläche (4 π r²).

Die von der Erdoberfläche in FIG.7 absorbierte Strahlung im Mittel errechnet sich somit zu 168 W/m².

Von der vom Boden absorbierten Strahlung gehen in die Atmosphäre nach Abzug von Latent Heat (verborgene Wärme oder Umwandlungsenthalpie) und Sensible Heat (Konvektion) als langwellige Strahlung 66W/m² (LW).

Diese 66 W/m² sind explizit in der Studie KT97 in TABLE 1 3 erfasst. In der Zeichnung FIG. 7 sind die 66 W/m² grafisch nicht dargestellt. Sie ergeben sich gleichzeitig aus der Subtraktion der Leistungen in W/m² in FIG. 7 „Absorbed by Surface – Back Radiation“ der rechten Bildhälfte oder 390W/m² – 324 W/m² oder:

Damit entsteht der Gegenstrahlungs- „fluss“ immer aus Null, aus dem „Nichts“. Er ist für die energetische „Bilanzierung“ mathematisch „neutral“. Man kann den Rechenvorgang mit einer „Buchung“ assoziieren. Oder für (1) anders ausgedrückt, die Gegenstrahlung kann mathematisch jeden beliebigen Werten annehmen, beliebig variabel oder „fiat flux“.

Extremwert- oder Grenzwertbetrachtung: Der im Modell KT97 mathematisch zulässige Leistungswert der Gegenstrahlung nimmt einen sehr, sehr hohen, einen extremen Wert an. Seine physikalische Bedeutung bleibt.

Die mathematische Zulässigkeit der Modellierung – die Zahlenwerte der Gegenstrahlungshypothese als Leistung in W/m² dürfen beliebig groß werden – hat folgende physikalische Auswirkung: In letzter Konsequenz darf die Modelloberfläche KT97 durch Gegenstrahlung so heiß werden wie die Sonnenoberfläche mit ca. 6000 °C und gleichzeitig strahlt die Modellatmosphäre dennoch mit -19 °C in frostigem Zustand. Dies ist, wie man sofort erkennt, unmöglich, ein interner Widerspruch und deshalb ein schwerer Modellierungsfehler. Wenn die Modellierung einerseits alle Zahlen zulässt, aber für große Zahlen so eindeutig falsch ist, dann muss der gesamte Modellmechanismus KT97 aus Gründen der Logik auch für kleine Zahlen falsch sein. Der physikalische Grund für die falsch ausgeführte Modellierung liegt darin, dass die Energie, als Gegenstrahlungsleistung in W/m² mal Strahlzeit T, im Modell aus dem Nichts kommt und beliebig groß werden kann. Diese Modellierung verstößt auf das Massivste gegen den 1.Hauptsatz der Thermodynamik und ist deshalb nach Ansicht des Autors falsch. Es ist eine der Beliebigkeit unterworfene Hypothese.

Durch ihre „Bilanzneutralität“ und ihre Beliebigkeit war es möglich, die Gegenstrahlung im Nachhinein 2009 nun auf 333 W/m² abzuändern, FIG.I. Trenberth, Fassulo, Kiehl 4. Eine weitere nachträgliche Abänderung erfolgte 2012 bei Norman Loeb 5. Die Gegenstrahlung erreicht jetzt den Wert von 342 W/m². Dies entspricht dem mathematischen Rechenwert der Sonneneinstrahlung bzw. TSI von 1368 auf die Erde in der ¼ Verteilung der Modellhypothese von KT97. Oder anders formuliert die Gegenstrahlung (oder weniger als 1% des atmosphärischen Gasgemisches) strahlt exakt wie eine zweite Sonne im Modell. „Fiat lux“. Ohne „Gegenstrahlungssonne“ kann die mittlere Globaltemperatur nicht erklärt werden.6

Kann man mit die mittlere Globaltemperatur mit einem anderen Modell erklären? Dies ist nach Meinung des Autors möglich durch: 1) Genauere Betrachtung des Strahlungsverteilungsfaktors, der nach „settled theory“ mit ¼ modelliert wird.

Der Strahlungsverteilungsfaktor

Der Strahlungsverteilungsfaktor ist die maßgebliche, die zentrale Steuerungsgröße bei der Modellierung der Leistungsbilanzierung im Energiehaushalt eines Klimamodells. Er bildet die durchschnittliche Einstrahlung ab. Aus Gründen der Logik gilt allgemein: Besteht ein kontinuierlicher Betrachtungshorizont in einem physikalischen Ablauf, wie z.B. bei einem bewegten Objekt über eine Strecke oder über eine Zeitspanne, aus Σ i Intervallen, muss der Durchschnittswert über den Betrachtungshorizont – da es das mathematische Wesensmerkmal oder hervorstechende Kriterium eines Durchschnittswertes ist – in all seinen i Intervallabschnitten oder über alle i gegen unendlich gültig sein. (Trivial Kriterium).

Für ein Klimamodell folgt: Der modellierte Durchschnitt der Einstrahlung aus der Leistung der Sonne in W/m² muss nicht nur in einem Jahr, einem Monat oder an einem Tag gelten, er muss mathematisch auch für jedes T gegen Null gelten. Wir kehren zurück zur Modellierung von B. Barkstorm, Kiehl und Trenberth. Ihre Leistungsbilanz des Strahlungshaushaltes steht stellvertretend für einen Durchschnittsquadratmeter oder eine homogene Modellkugel mit Radius R. Diese hat nur die Durchschnittswerte mit der Erde gemein. Jeder Ortspunkt (Xi,Yi) auf der Modellkugeloberfläche hat identische Eigenschaften. Damit ist in KT97 die Albedo a an jeder Stelle (Xi,Yi) konstant oder a = 0.3129. Für die Stelle des Radius R wird der Erdradius gesetzt:

Die Erdoberfläche beträgt 510.1 Mio. km². Die durchschnittliche Abstrahlung als Leistungseinheit in W/m² auf ihrer gesamten Oberfläche im Betrachtungshorizont jährlich „annual global mean“, im Intervall eines Monats oder im Intervall von 24 Stunden setzt sich zusammen aus: 107 W/m2 (Reflected Solar Radiation) und 235 W/m² (Outgoing Longwave Radiation) = 342W/m², siehe FIG.7.

Die Energie E aus Durchschnittleistung in W/m² der modellierten Einstrahlung eines Jahres, Monats und eines 24 Stunden Erd-Tags wird bei Gleichsetzung der Abstrahlung mit der Einstrahlung die Energie weiterhin im Modell richtig errechnet, aber mathematisch wird die Einstrahlung über den „niedrigen“ Durchschnitt auf die dunkle Nachtseite mit einbezogen. Hierin liegt die Tücke dieser Modellvorstellung. In den nächsten Intervallstufen, Sekunde und in T gegen Null ist es in auf der Nacht-Hemisphäre der fiktiven, homogenen Modellkugel mathematisch taghell.

Beim Übergang des einzelnen, zeitlichen i- Intervalls von Jahr, Monat, Tag, Sekunde und weiter zu N Intervallen, der Einstrahlung im Augenblick (T gegen Null oder Zeit / N), mit einer Folge von N Intervallen und damit N gegen unendlich für einen 24 Stunden Erdtag als Betrachtungshorizont, kann aber stattdessen formuliert werden:

Für eine stets nur halbseitig beleuchtete Kugel, bezogen auf die doppelt gekrümmte Kugeloberfläche berechnet mit der Integration über Polarkoordinaten, siehe auch Kap. 5.1.2 9. Der Übergang von der nicht rotierenden zur rotierenden Kugel, siehe Anhang 19, führt wieder zu einer Einstrahlung von 684 W/m² (2). Auch diese Modellierungsvariante errechnet die Energie E richtig. Sie entspricht aber jetzt so modelliert der echten Sonneneinstrahlung in T gegen Null, also unserer Beobachtung. Deshalb beträgt die Einstrahlung auf der Hemisphäre einer stets nur halbseitig beleuchteten Kugel im rechnerischen Durchschnitt im Modell 684 W/m². Für den Strahlungsverteilungsfaktor der Einstrahlung bedeutet dies:

Für das infinitesimal kleine Stück ∕der rotierenden Mantelflächenlinie um die Rotationsachse x gilt:

Energie E aus durchschnittlicher, flächenbezogener Leistung, die die Mantelfläche des Rotationskörpers in T(sec) erhält, mit x = 0 als Mittelpunkt. Die Energie in T errechnet sich über Integration entlang der x-Achse über Δx von x = -R bis x = 0, wenn in T stets nur eine halbe Kugel als Rotationskörper um x und Beleuchtung in x-Richtung erhält.

Mit einem Erdradius R von 6.378 Km dreht sich in jeder Sekunde die Erde um 1/86400 eines 24-h-Tages ein Stück weiter. Oder 86.400 Energieportionen einer Sekunde erhält die Erde in 24 Stunden oder:

E = 684 W/m² 2 x (6.378.124 m)² π 86400 sec = 1.51 1022 Wsec = 1.51 1022 J = 1368 W/m² R² π in 24 h

Die Integration über die Formulierung kartesischer Koordinaten zeigt die Parallelität der Einstrahlungsleistung L von 684 W/m² zur globalen x-Richtung und der stets nur halbseitig beleuchteten Mantelfläche der Kugel als Rotationskörper um die globale x-Richtung. Die Formulierung in Polarkoordinaten, die das identische Ergebnis liefern muss, zeigt dagegen das Wirken von 684 W/m² Einstrahlleistung auf eine stets doppelt gekrümmte Oberfläche, S.83 und S.176 -177. 9 Beide Rechenwege liefern das identische Ergebnis von 1.51 1022 J Energie aus Sonne unter stets halbseitiger Beleuchtung der in 24 h einmal rotierenden Erde liefern. Damit ist der Strahlungsverteilungsfaktor ¼ falsch und ½ richtig. Was es bedeuten kann, einen falschen Verteilungsfaktor in einer Netzmodellierung zu benutzen, siehe Kap. 5.17 9.

2) Genauere Betrachtung der Satellitenmesswerte: In der Rezeption von KT97 werden die Werte wattgenau benutzt. KT97 bezieht sich in S.199 auf die ERBE Datensätze „ …, we use the ERBE outgoing longwave flux of 235 W/m²…“ [Hervorhebungen hinzugefügt]. Es wird darauf hingewiesen, dass dieser olf für die einzelnen Satelliten ERBS, NOAA-9, NOAA-10 (ERBE) vorsichtig formuliert nicht 235 W/m² beträgt. Der Unterschied zwischen dem ERBE-Datensatz 1985-1989 z.B. (ERBS min. 242.3 – max. 243.5 W/m² nach CEDA) und der in KT97 modellierten Strahlungsgröße olf macht hier bereits 7 W/m² aus, weitere Abweichungen siehe auch Kap 4.1.1.bis 4.1.6 9. In KT97 wird auf S.206 erklärt: „The purpose of this paper is not so much to present definite values,…“. Die Qualität der Datensätze ist beim Satelliten ERBS am höchsten (Begründung: Kap. 2.3 bis 2.6 9). Mit diesen kann ein neues Modell formuliert werden (Kap 5 9). Bei den Datensätzen des ERBS Satelliten gibt es spezielle Net– Werte (siehe die weiter hinten im Text grün abgebildete Werte mit Verweis auf GLOBAL MEAN OF nach CEDA, Centre for Environmental Data Analysis, Oxford, England). Das folgende Beispiel eines Datensatzes der Quelle CEDA 7, gemeint ist die Zahlenkolonne nach Mean1987, verdeutlicht dies in a) bis c) als ein Beispiel zur Interpretation der Net– Strahlungen:

a) Net-Strahlungen unter Berücksichtigung des negativen Vorzeichens, gemäß der Datenübermittlung von ERBS:

Net Cloud Forcing -20.25 + Net Radiation 20.19 = 0 ≠ Clear-Sky Net Radiation (40.44). Es gibt keine Übereinstimmung. Alternativ ohne Berücksichtigung des Vorzeichens und damit als mathematischer Betrag:

Net Cloud Forcing |-20.25 | + Net Radiation |20.19| = 40.44 = Clear-Sky Net Radiation (40.44). Es gibt eine Übereinstimmung. Wenn man die drei Net-Strahlungen berücksichtigt, erscheint es sinnvoll, sie als mathematische Beträge von Leistungen zu interpretieren.

b) Unabhängig von einer Datenübermittlung mit Vorzeichen oder ohne Vorzeichen als Betrag ist:

Clear-Sky Net Radiation |40.44 | + Clear Sky Shortwave Radiation |52.52 | = 92.96 ≈ Shortwave Radiation 97.21. Dies ist halbwegs eine Übereinstimmung von mathematischer Summe zum Messwert und bei Betrachtung der Datensätze eher selten.

c) TSI/4 – (shortwave rad.) – (longwave rad.) = (net rad.) 20.19 oder 1368/4 – |97.21 | -|245.13 | = – 0.34

– 0.34 ungleich 20.19 (net rad.). Es gibt keine Übereinstimmung der mathematischen Differenz zum Net-Messwert. Wäre die Net-Radiation lediglich eine Strahlungsdifferenz und kein eigener Messwert, müsste der Messwert hier ebenfalls 0 sein. Das ist nicht der Fall. Damit ist diese Net-Radiation ein eigener Messwert. Wenn sie ein eigener Messwert ist, sind aus Gründen der Logik, alle drei Typen der übermittelten Net– Radiations Messwerte (weitere Beispiele und Begründungen, siehe Kap. 5.4.2 bis 5.4.5, 5.12 und S.187 -190 9 ).

Unabhängig von dieser Begründung wurden für die Modellierung trotzdem beide Varianten untersucht. Die Net- Werte wurden zu Null gesetzt und unberücksichtigt gelassen und im anderen Fall als gemessene Strahlung verstanden. In der jeweiligen Modellierung unterscheiden sich dann lediglich die Größen von SH, LH und Satm (Kap. 5.4.2 9). Die Wärme des Tages wirkt in beiden Varianten über Speichereffekte in die Nacht (Kap. 5.4.3 9). Die ERBS Messwerte zeigen für beide Fälle, es bildet sich eine mittlere Globaltemperatur mit rund 15 °C ohne Treibhaushypothese durch unsymmetrische atmosphärische Moleküle aus. Fasst man die Net–Werte als Messwerte auf, lässt sich ein Modell 5 formulieren, welches alle Messreihen widerspruchsfrei abbildet. Die Modellabweichung dieses Modell ist < = 2 W/m² zu der vom Satelliten erst einzeln gemessenen, danach gemittelten Strahlung oder macht weniger als fünf Tausendstel der „top of“ gemessenen Gesamtstrahlung aus (4.8 = 2.0 W/m²/414.5 x 1.000). Exakte Ableitung des Gegenmodels (Modell 5) zu KT97 (siehe Kap. 5.3f 9 ).

Die durchschnittliche, mittlere stets halbseitige Einstrahlungsleitung des Modell 5 (siehe cloudy sky und clear sky), jährlich (annual), monatlich, in 24 h oder in T gegen Null betrug über Integration über Polarkoordinaten, wie die kartesische Berechnung 684 W/m². 684 W/m² sind auf die gekrümmte Oberfläche bezogen (siehe Kap. 5.1.2, S.83 9). 1368 sind auf den ebenen Einstrahlkreis bezogen. Messwerte des ERBS Satelliten 1985 bis 1989 im 5- jährigen Mittel nach CEDA:

Die römischen Zahlen entsprechen den horizontalen Ebenen der Atmosphäre in Bild 2 und bilden eine stehende halbseitig beleuchtete Hemisphäre ab. Für den Übergang zur rotierenden halbseitig beleuchteten Kugel (siehe Kap. 5.4.2, S.92 – 93 9).

Aus der Erdkrümmung folgt eine Strahlungsabschwächung für die Messebene des Satelliten ERBS auf knapp 600 km mittlere Höhe in Ebene I´ (siehe Anhang 7 9). Wird eine Abschwächung von 17.2% berücksichtigt, folgt:

500 W/m² x 0.828 = 414 W/m² oder = Summe der Messwerte in W/m² = Σ 101 +19 +20 +243 +31 = 414 W/m².

Ebene I´ ist die Messebene des Satelliten und Ebene VII die Ebene der Erdoberfläche mit einer durchschnittlichen Globaltemperatur aus Tag- und Nachtmittel von rund 15 °C. In Analogie zu KT 97 mit 62 % durchschnittlicher Wolkenbedeckung für die Erde (nach KT97, S.206) aber mit atmosphärischem Fenster von 87 W/m² (Begründung Kap 4.1.8 9). Es wird so sichtbar, (500 W/m²) werden vom Tag in die Nacht hinein gespeichert.

Die Atmosphärenebene I bis VII aus Tag + Nacht erfüllen in 24 h gemeinsam das horizontale Gleichgewicht der Leistungsbilanzierung. Die Einstrahlung stets in T gegen Null auf der halben Kugel und Abstrahlung auf der Vollkugel, durch | getrennt, erfüllen das vertikale Bilanzgleichgewicht. 368/1368 = 0.269 = Albedo von ERBS oder als Tag und Nachtmessung durch ERBS:

II Σ +183 +0 +185 -185 -0 -1183 + 86 +86 +2 [Tag- und Nachtmessung] x (+101 +19 +20 +243 +31) = 0 q.e.d.

Eine der Beliebigkeit unterworfene Gegenstrahlung, ein „fiat flux“, kaschierte die falsche Strahlungsverteilung. Es existiert kein Treibhauseffekt von 33 K zur Bildung einer globalen mittleren Oberflächentemperatur von rund 15 °C. Die gemessenen Daten des ERBS Satelliten, mit allen Reihen beweisen dies. In der Leistungsbilanz über Ebene I´ bis VII wird sichtbar, wie die Tagestemperatur über Speicherwirkung in die Nacht hineinwirkt. Bei Kiehl- und Trenberth im Modell KT97 gibt es keine Wärmespeicherung. Von der direkten Wirkung der Sonne blieben nur 66 W/m² übrig. Deshalb musste in KT97 die Sonne mit 342 W/m² nachts rechnerisch in jedem T gegen Null die nicht beleuchtete Hemisphäre „nachheizen“.

Eine generelle Strahlungsbehinderung in der Abstrahlung durch eine hohe Gegenstrahlung von 300 W/m² existiert nicht. Die Nacht reicht aus, um die von der Sonne empfangene Wärme des 24 Stunden Tages über SH, LH, Satm, Reflektion und Strahlung ungehindert auf der Vollkugel abzustrahlen. Für den betrachteten Gleichgewichtszustand in der Leistungsbilanz Einstrahlung/Abstrahlung in W/m² stellt sich so Oberflächentemperatur von rund 15 °C ohne Treibhauseffekt ein. Durch Wolken und durch die Wärmeleiteigenschaften der Luft mag es zeitliche Verzögerungen in der Wärmeabgabe geben, ebenso durch langfristige Effekte von Änderungen in den Wärmespeichern der Erde. Man kann zeigen, dass statt der Gegenstrahlung die Änderung der Albedo in der Modulierung der Globaltemperatur eine sehr wichtige Rolle spielt Kap 5.13 9). Ein Experiment mit CO2 unter direktem Sonnenlicht, Anhang 4 9, bestätigt ebenfalls, dass es einen atmosphärischen Treibhauseffekt aus einer Gegenstrahlungshypothese nicht gibt. Für eine verstärkte Einbindung der Wolken in die Modellierung über den Messwert des Longwave Cloud Forcing wird auf Kap. 5.7 9 verwiesen.

Zusammenfassung des Artikels:

Die Gegenstrahlung ist eine reine Modellhypothese aber Basis der aktuellen Klimamodelle. Der Strahlenverteilungsfaktor ¼ ist zur Berechnung der Einstrahlung im Klimamodell falsch und stattdessen ½ richtig. Mit ¼ wird die mittlere Einstrahlung in der Modellierung viel zu gering errechnet. Diesen Fehler musste die Gegenstrahlungshypothese in der Treibhaushypothese bereits bei B. Barkstorm ausgleichen. Mit dem richtigen, über ½ errechneten Einstrahlungsdurchschnitt entfällt sofort ihre Grundlage. Bei Verwendung aller Messreihen der fünfjährigen gemittelten Datensätzen des ERBS Satelliten lässt sich in Anschluss ohne Gegenstrahlung bei stets halbseitiger Beleuchtung der Erde – die unserer Beobachtung entspricht – die Speicherwirkung der Erdoberfläche vom Tag in die Nacht hinein darstellen Die Abweichung zwischen Messwert und Rechenwert oder Modellgüte des neuen Modells beträgt dann weniger als fünf Tausendstel der „top of“ gemessenen Gesamtstrahlung oder ist kleiner gleich 2W/m².

9 A. Agerius, 2021, Kritische Analyse zur globalen Klimatheorie, Erweiterung-Vertiefung-Prognose, 2. Auflage, tredition, Hamburg

1Barkstorm, Ramanathan and Harrison, 1989, CLIMATE AND THE EARTH’S RADIATION BUDGET, in PHYSICS TODAY, American Institute of Physics.

2J. Kiehl, K.E. Trenberth, 1997, Bulletin of the American Meteorological Society, Vol. 78, No. 2, February 1997, S. 197-208. Im Folgenden wird diese Studie als KT97 bezeichnet.

3KT97, Table 1. Summary of the earth energy budget estimates…, S. 199. [Hervorhebung hinzugefügt]

4Trenberth, Fasullo and Kiehl, 2009, EARTH’s GLOBAL ENERGY BUDGET, American Meteorological Society, BAMS S. 1-13, DOI:10.1175/2008BAMS2634.I.

5Loeb, Dutton, Wild et altera, 2012, The global energy balance from a surface perspective, Clim Dyn (2013) 40:3107-3134, Springer-Verlag, Doi 10.1007/s00382-012-1569-8.

6Für die Messung einer solchen Gegenstrahlungssonne mit Messgeräten wird auf 9, Kap. 4.24, 75 f. verwiesen.

7CEDA, Oxford, England, ERBS Datensätze 1985 – 1989, mit Stand vom 19.11.2020, beispielsweise für die Messreihe mean1987: http://data.ceda.ac.uk/badc/CDs/erbe/erbedata/erbs/mean1987/ und hierin die Datei data.txt aufrufen. Der Datenaufruf im ERBS Datensatz muss für die Jahre, Strahlungstypen/Albedo, spezielle Messreihen, Durchschnitte, Darstellungen, etc. entsprechend angepasst werden.

Europa ist die Region, die nachweislich am stärksten unter früheren Grand Solar Minima (Dalton/Maunder) gelitten hat, was angesichts der Nähe zum Pol und der großen Bevölkerungszahl auch Sinn macht.

Der Beginn dieses nächsten GSM zeigt, dass das auch diesmal der Fall ist, selbst in diesem frühen Stadium…

Wie Anfang der Woche berichtet, hat der europäische Kontinent gerade einen historisch kalten April erlebt, der nun bis in den Mai hinein anhält.

[Einschub: Dazu passt die Meldung der auf der alarmistischen Seite stehenden Plattform wetteronline.de, wonach sich heute früh (7. Mai) in den Niederlanden (!) verbreitet kurzzeitig eine dünne Schneedecke gebildet hatte {Link}. Ende Einschub]

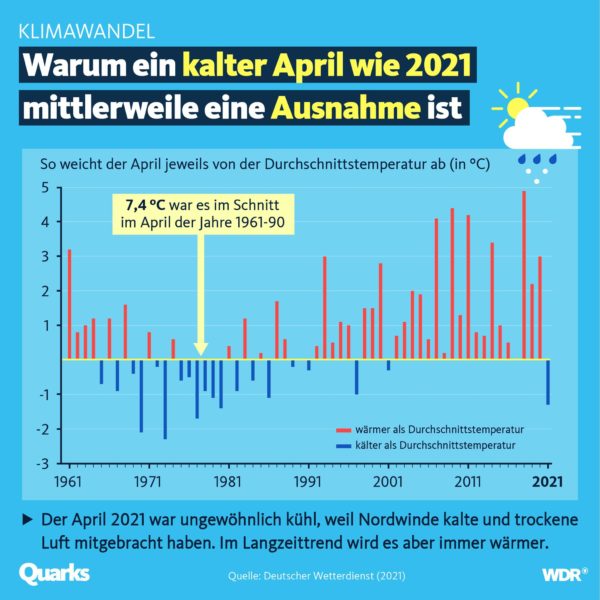

Mit einer Durchschnittstemperatur von nur 6C war der April 2021 in Deutschland der kälteste vierte Monat des Jahres seit 1977 (solares Minimum des Zyklus 20). Dieser Durchschnittswert liegt etwa 3C unter der klimatologischen Norm von 1991-2020 und 2,3C unter dem bisherigen 30-jährigen Mittel von 1981-2010.

Der Monat war auch etwas trockener als im Durchschnitt, berichtet der DWD Klima und Umwelt auf Twitter:

Man beachte den starken Temperaturrückgang in dieser Graphik.

Unter der Lupe sieht man den Absturz vom April 1920 auf den April 2021 noch deutlicher:

Dies ist ein Hinweis darauf, wie schnell sich das Klima abkühlen kann, wenn die Bedingungen es zulassen, Bedingungen wie geringe Sonnenaktivität und La Ninas.

Entscheidend ist hier auch, dass die Zeitspanne zwischen geringer Sonnenaktivität und terrestrischer Abkühlung nun vorbei zu sein scheint.

Der „Abkühlungstrend“, den die NASA in den letzten Jahren in der „oberen“ Atmosphäre registriert hat, ist nun endlich in die unteren Atmosphärenschichten und in die globale „untere“ Atmosphäre und damit in den Lebensraum von uns Menschen durchgedrungen.

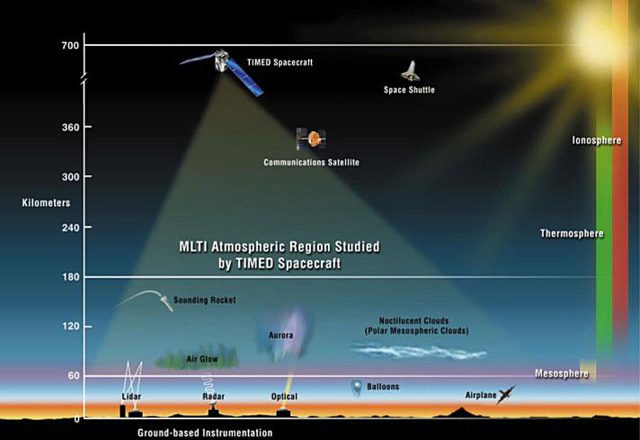

„Hoch über der Erdoberfläche, nahe dem Rand des Weltraums, verliert unsere Atmosphäre Wärmeenergie“, sagte Martin Mlynczak von der NASA, Associate Principal Investigator für das SABER-Instrument an Bord des TIMED-Satelliten der NASA, bereits im Jahre 2018. „Wenn sich die aktuellen Trends fortsetzen, könnte es bald einen Kälterekord für das Weltraumzeitalter geben“ – was Ende 2018 der Fall war.

Der TIMED-Satellit der NASA:

Die Aufgabe von SABER ist es, die Infrarot-Emissionen von Kohlendioxid (CO2) und Stickstoffmonoxid (NO) zu überwachen – durch die Messung des Infrarot-Glühens dieser Moleküle kann SABER den thermischen Zustand des Gases ganz oben in der Atmosphäre beurteilen: eine Schicht, die die Forscher „Thermosphäre“ nennen.

„Die Thermosphäre kühlt immer während des solaren Minimums ab“, so Mlynczak weiter. „Das ist eine der wichtigsten Arten, wie der Sonnenzyklus unseren Planeten beeinflusst.“

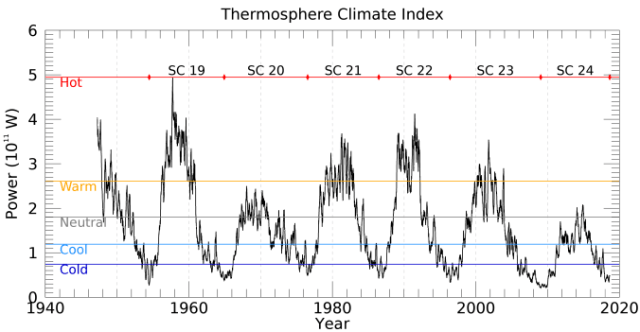

Um zu verfolgen, was in der Thermosphäre passiert, haben Mlynczak und Kollegen kürzlich den „Thermosphären-Klima-Index“ (TCI) eingeführt – eine in Watt ausgedrückte Zahl, die angibt, wie viel Wärme die NO-Moleküle in den Weltraum abstrahlen. Während des Sonnenmaximums ist der TCI hoch („heiß“), während des Sonnenminimums ist er niedrig („kalt“).

Und obwohl SABER seit zwei Jahrzehnten im Orbit ist, konnten Mlynczak und Kollegen den TCI bis in die 1940er Jahre zurück berechnen: „SABER hat uns das gelehrt, indem es uns gezeigt hat, wie TCI von anderen Variablen wie der geomagnetischen Aktivität und der Leistung der Sonne abhängt – Dinge, die seit Jahrzehnten gemessen werden“, erklärt er.

Mlynczak und Kollegen haben kürzlich eine Arbeit über den TCI veröffentlicht, die zeigt, dass der Zustand der Thermosphäre mit einer Reihe von fünf Begriffen in einfacher Sprache beschrieben werden kann: Kalt, Kühl, Neutral, Warm und Heiß.

Betrachtet man Mlynczaks obiges Diagramm – und genauer gesagt seine Darstellung der letzten 6 Sonnenzyklen, die direkt mit dem Thermosphären-Klima-Index von SABER übereinstimmen – so zeigt sich, dass diese jüngste und historische Runde niedriger Sonnenleistung erst mit dem Minimum von Zyklus 23 (wohl 2008) begann.

Und da die Auswirkungen des rekordstarken El Nino von 2016-17 nun vollständig verblasst sind und die Auswirkungen des moderaten Ereignisses von 2019-20 sich ebenfalls verflüchtigt haben (beides deutlich sichtbar in der untenstehenden Grafik), wirkt sich die kumulative Verringerung der Aktivität durch die Zyklen 23 und 24 schließlich auf unsere „globalen“ Temperaturdaten aus, und nicht nur auf die regionalen – wie oben erwähnt, hat sich die Rekordabkühlung der Thermosphäre nun bis in die Troposphäre vorgearbeitet [Hervorhebung im Original]:

Um noch einmal kurz auf die regionalen Daten zurückzukommen, denn ich denke, es ist wichtig, dass wir uns der Auswirkungen vor Ort bewusst sind, damit wir uns richtig vorbereiten können: Deutschland war eine der Nationen, die während des vorangegangenen Großen Sonnenminimums, dem gemäßigteren Dalton-Minimum (1790-1830), eine schnelle und intensive terrestrische Abkühlung verzeichneten.

Die Oberlacher Wetterstation beispielsweise verzeichnete Anfang des 19. Jahrhunderts einen Temperaturrückgang von 2°C innerhalb von nur 20 Jahren – diese rapide Abkühlung zerstörte die Nahrungsmittelproduktion des Landes und trug dazu bei, dass Millionen und Abermillionen von Menschen in ganz Eurasien hungern mussten. Es räumt auch mit der Behauptung auf, dass solch starke Veränderungen des Klimas Jahrhunderte brauchen, um sich zu manifestieren – dies ist nicht wahr, historische Dokumente – ganz zu schweigen von Proxydaten – zeigen uns, dass eiszeitliche Bedingungen innerhalb von nur wenigen Jahren eintreten können.

Der starke Temperaturrückgang in Deutschland von April 2020 auf April 2021 ist ein weiterer Beleg dafür.

Link: https://electroverse.net/germanys-coldest-april-since-1977-as-even-nasa-notes-a-cooling-planet/

Übersetzt von Chris Frey EIKE

Spektrum berichtet, daß eine Forschergruppe der Universität von Kalifornien in Santa Barbara (UCSB) es für sehr wahrscheinlich halte, daß Lockdown-bedingt 30 % weniger Industrie-Feinstaub wie Kohlepartikel ausgestoßen worden seinen, die sich sonst auf den Schneeflächen rund ums Industal in Pakistan ablagern. Da der Schnee somit „weißer“ ist, strahlt er mehr Wellenlängen des Sonnenlichts zurück ins All oder die Atmosphäre, die dann nicht in Wärme umgewandelt werden und den Schnee aufheizen. Der Laie kennt den Effekt der Schnee-Albedo von der berüchtigten Schneeblindheit: Die Augen bekommen die volle Sonnenstrahlung ins Auge, bis die Netzhaut vorübergehend abschaltet.

2020 sei daher deutlich weniger Schnee geschmolzen, als im Jahresmittel vorher. Gemessen habe man das mit Fernerkundungsdaten; Proben wurden noch keine genommen. Erst damit könne man die Hypothese überprüfen (Warum veröffentlichen die dann jetzt schon?).

Wir haben eine Alternativhypothese anzubieten: Es wird zumindest auf der Nordhalbkugel Solarzyklus-bedingt immer kühler, wie man überall seit Dezember beim Anblick von Blizzards selbst erleben konnte. Logisches Ergebnis ist natürlich ein verringertes Abschmelzen von Schneemassen auf Bergen.

Könnte es sein, daß die Schnell-Veröffentlichung, deren Titel übrigens gar nicht so konjunktivlastig ist, interessensmotiviert ist? Könnte es sein, daß die „Pandemie“- und die Klimaerzählung verschmolzen werden, um bestimmte, davon unabhängige Ziele zu erreichen; und Wissenschaftler als Verbreiter und Verteidiger des Narrativs dienen? Entscheiden Sie selbst:

COVID-19-Quarantänen zeigen eine verringerte Verschmutzung von Schnee und Eis im Indus-Einzugsgebiet

„Insbesondere erblicken wir in dem System der fossilen Klimazeugen keinen empirischen Anhalt für die Annahme, daß die von der Sonne ausgehende Strahlung sich im Laufe der Erdgeschichte geändert habe. Desgleichen fehlt es an Tatsachen, welche durch Änderung der Durchstrahlbarkeit der Atmosphäre (Arrhenius) oder des Weltalls (Nölke) zu erklären wären; …“

Daran hat sich bis heute nichts geändert, denn die Klimawissenschaft ist seit nunmehr knapp 100 Jahren mit einem eindeutigen Beweis für diesen vorgeblichen „natürlichen atmosphärischen Treibhauseffekt“ nicht vom Fleck gekommen. Vielmehr basiert das Bild der Klimawissenschaft von unserer Erde noch immer auf einer „Erde ohne Atmosphäre“, wie sie Julius von Hann im Jahre 1897 beschrieben hatte, Sekundärzitat mit Dank an Dr. Gerhard Kramm (Fairbanks, Alaska):

«Denken wir uns die Erdoberfläche ganz vom Fest-land eingenommen und ohne Atmosphäre, also etwa in dem Zustande, in dem sich der Mond befin-det, so würde die Wärmeverteilung auf derselben überall nur von der jedem Orte zukommenden Quantität der Sonnenwärme und dem Betrage der Wärmeausstrahlung daselbst abhängig sein. Da nun diese beiden Faktoren für alle Orte auf demsel-ben Parallel- oder Breitekreise dieselben sein müß-ten, so würden die Erdgürtel gleicher Wärme mit den Breitekreisen zusammenfallen. Selbst die Exis-tenz einer wasserdampffreien Atmosphäre würde an dieser Wärmeverteilung wenig ändern, bloß die absoluten Quantitäten der Wärme-Einstrahlung und -Ausstrahlung an der Erdoberfläche würden dadurch beeinflußt.»

Und um jetzt den Unterschied zwischen einer „Erde ohne Atmosphäre [und Ozeanen]“ einerseits und andererseits den Messwerten von einer realen Erde zu erklären, hatte man schließlich den ominösen „natürlichen atmosphärischen Treibhauseffekt“ erfunden. Dieser Effekt soll auf einer sogenannten „atmosphärischen Gegenstrahlung“ beruhen, die wiederum dem 2. HS der Thermodynamik widerspricht.

Es stehen hier also zwei konkurrierende Modelle für unsere reale Erde zur Diskussion:

Das Faktor4-Tag=Nacht-THE-Flacherdemodell mit einem „natürlichen atmosphärischen Treibhauseffekt“ (THE) der etablierten Klimawissenschaft auf dem Stand des 19. Jh.:

Reale Erde = „Erde ohne Atmosphäre“ + THE

Der Ketzer Weber behauptet im 21. Jh. dagegen, es gäbe gar keinen THE:

Reale Erde = Hemisphärisches S-B-Modell ohne THE

Wir setzen jetzt die beiden Modelle für die „reale Erde“ gleich und erhalten die Alternativen:

„Erde ohne Atmosphäre“ plus THE = Hemisphärisches S-B-Modell ohne THE

Und welches von beiden Modellen ist nun wohl richtig?

Das Dilemma der exakten Atmosphärenwissenschaft sind Tag und Nacht, die von der Jahreszeit bestimmte breitenabhängige Tageslänge sowie die physikalischen Einheiten für Leistung und Arbeit. Die üblichen klimawissenschaftlichen Darstellungen der solaren Einstrahlung auf unserer Erde umfassen seit mehr als einem Jahrhundert lediglich die taggenaue örtliche Gesamtstrahlungsmenge der Sonne über die gesamte Erdoberfläche, sogar inklusive der Elliptizität der Erdbahn; einige dieser Beispiele hatte ich hier diskutiert. Bei einem solchen 24h-Durchschnitt der solaren Arbeit ist dann physikalisch allerdings Endstation. Unbeleuchtete Flächen und zeitliche Ableitungen haben in einer S-B-Inversion nämlich nichts zu suchen, und daher müssen wir uns bei der Betrachtung der Sonneneinstrahlung auf die Tagseite unserer Erde beschränken.

Zur Erinnerung, ich hatte in meinen beiden DGG-Veröffentlichungen (2016 und 2019) diesen sogenannten „natürlichen atmosphärischen Treibhauseffekt“ als Ergebnis einer fehlerhaften Faktor4-Inversion des Stefan-Boltzmann-Gesetzes widerlegt. Unter anderem hatte ich das hier noch einmal näher ausgeführt und einen konkreten Nachweis geliefert, dass unbeleuchtete Flächen in einer Inversion des Stefan-Boltzmann-Gesetzes nichts zu suchen haben, Zitat:

„Es gibt im streng ‚gleichzeitigen‘ Stefan-Boltzmann-Gesetz keine Flächen (B), die nicht zur Strahlungsleistung (P) des Schwarzkörpers beitragen. Daher sind auch keine unbeleuchteten Flächen (B) in einer ‚gleichzeitigen‘ S-B-Inversion erlaubt. Physikalisch ‚gleichzeitig‘ bedeutet übrigens auch nicht, dass unterschiedliche ‚Gleichzeitigkeiten‘ in einer einzigen S-B-Berechnung aufaddiert und gemittelt werden dürften.“

ALSO: Der Faktor4-Tag=Nacht-THE-Flacherdeansatz leitet sich aus der durchschnittlichen solaren ARBEIT über den 24h-Tag her. Ein solcher Tag+Nacht-Durchschnittswert der solaren Strahlungsleistung hat aber überhaupt nichts mit der Temperatur auf unserer Erde zu tun, wie ich hier bereits ausführlich erläutert hatte. Denn von der 24h-durchschnittlichen Arbeit führt nun einmal kein physikalisch korrekter Weg mehr zurück zur Ermittlung der tatsächlichen spezifischen solaren Strahlungsleistung auf der Tagseite unserer Erde.

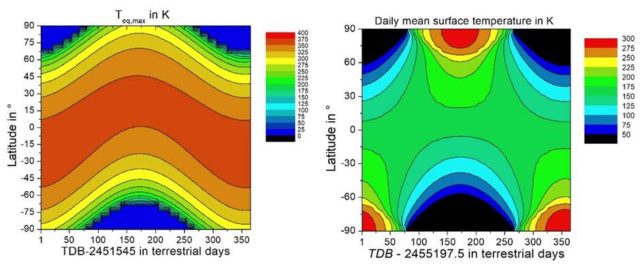

Aus einer solchen rückgerechneten 24h-Tag&Nacht-Durchschnittsleistung der Sonneneinstrahlung hatten erstmals Kramm et al. (2017) eine breitenabhängige Ortstemperatur (Kramm et al. (2017) Abbildung 22a) vorgelegt. Dieser Wert entsteht aus der Division der eingestrahlten solaren 24h-Gesamtenergie geteilt durch die Sekunden@24h pro Quadratmeter, die eigentliche physikalische Einheit ist also 1 J/(m² s). Folgerichtig ergibt die Ableitung einer Temperatur aus einer solchen 24h-durchschnittlichen Rückrechnung der solaren Strahlungsleistung durch die Einbeziehung der unbeleuchteten Nachtseite eine „Schneeball-Erde“ mit gefrorenen tropischen Meeren und einem Temperatur-Hotspot am Pol der jeweiligen Sommerhemisphäre, wie man das ebenfalls in der nachfolgenden Abbildung 1b ablesen kann.

In seiner E-Mail vom 29.01.2021 um 09:58 Uhr* an mich und den üblichen Skeptiker-Email-Verteiler hatte dieser Dr. Gerhard Kramm schließlich ein PDF-Dokument „kramm_bemerkungen_weber_v3.pdf“ (wird in der Folge als „Kramm 2021“ bezeichnet) mit einem direkten Vergleich zwischen meinem hemisphärischen S-B-Modell und seiner „Erde ohne Atmosphäre“ verschickt. Die beiden nachfolgenden Abbildungen entstammen diesem PDF:

Anmerkung: Die Temperaturskalen dieser Abbildungen stimmen nicht überein.

Originalbeschreibung: „Abbildung 15. Wie in Abbildung 12, jedoch für die auf dem lokalen Strahlungsgleichgewicht nach Gleichung (3) beruhende Oberflächentemperatur.“

Dazu der Text zu Abbildung 12: „Berechnete solare Einstrahlung für alle Tage des Jahres und alle geographischen Breiten:

(a [links]) Maxima nach Weber, beginnend mit dem 1. Januar 2000, 12:00 Uhr (JD = 2451545),

(b [rechts]) Tägliche Mittelwerte nach Kramm et al. (2017), beginnend mit 1.Januar 2010, 00:00 Uhr (JD =2455197,5).“

Die „Maxima nach Weber“ in der linken Abbildung, abgeleitet aus dem Maximum der örtlichen solaren LEISTUNG [W/m²] ohne Albedo, schwanken mit dem jahreszeitlichen Sonnenstand um den Äquator („Latitude 0°“) mit bis zu 394 Kelvin. Sie reduzieren sich dann zum Pol der Winterhemisphäre gegen null Kelvin. In der Realität werden diese theoretischen Maximalwerte aber aufgrund von Albedo, Verdunstung und Konvektion nicht erreicht; die Minimalwerte werden dagegen durch Advektion und Kondensation gestützt.

Die „Tägliche[n] Mittelwerte nach Kramm et al. (2017)“ in der rechten Abbildung, abgeleitet aus einer 24h-durchschnittlichen solaren ARBEIT [J/m²s] ohne Albedo, stellen dagegen die äquatoriale Zone bei 150-200 Kelvin mit gefrorenen tropischen Meeren als „Snowball-Earth“ dauerhaft im ewigen Eis dar; dafür verwandelt sich die Polarregion der jeweiligen Sommerhemisphäre in einen Touristen- und Temperatur-Hotspot mit 275-300 Kelvin.

Allein unser Schulwissen sagt uns also schon, welche der beiden Abbildungen am ehesten den Verlauf der Klimazonen unserer Erde spiegelt und dass der Pol der jeweiligen Sommerhemisphäre gar kein globaler Temperatur-Hotspot ist. Meine Ausführungen dazu hatte ich in dem EIKE-Artikel „Verbesserungswürdig: Über fehlerhafte Ansätze für eine breitenabhängige Globaltemperatur“ vom 18. März 2020 ausführlich dargestellt.

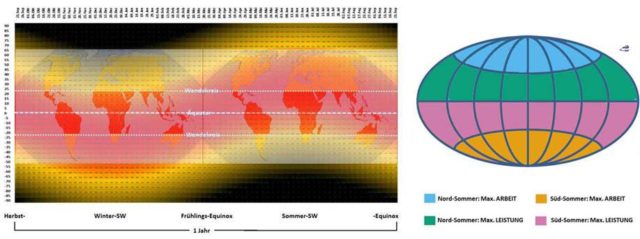

Auf unserer Erde wandert der senkrechte Sonnenstand im Verlauf des Jahres zwischen den beiden Wendekreisen und verursacht so die gegenläufigen Jahreszeiten auf der Nord-und Südhemisphäre. Das maximal mögliche rechnerische S-B-Temperaturäquivalent der solaren Strahlungsleistung (@W/m²) folgt diesem vertikalen Sonnenstand, also von der Sonnenwende am Wendekreis der jeweiligen Sommerhemisphäre über den Äquator mit dem Äquinoktium zum gegenüber liegenden Wendekreis und wieder zurück. Polare Temperatur-Hotspots dagegen existieren nicht, es gibt in der Polarzone der Sommerhemisphäre lediglich eine tageszeitlich länger eingestrahlte solare Energiemenge [J/m²], die dort zu einer erhöhten Biomasse-Produktion im Sommerhalbjahr führt.

Also schauen wir mal, was wir sonst noch über die sogenannte „gemessene globale Durchschnittstemperatur“ herausfinden können

Betrachten wir jetzt einmal, wie sich die Tagseite (A) und die Nachtseite (B) auf die sogenannte „gemessene globale Durchschnittstemperatur“ von vorgeblich 14,8°C auswirken. Denn diese Durchschnittstemperatur NST kann über ihren 24h-Verlauf eigentlich nur ganz minimal schwanken. Schließlich soll dieser Wert aus weltweit zeitgleich ermittelten Temperaturen berechnet werden und bildet deshalb für jeden Zeitpunkt des 24h-Tages einen globalen Tag&Nacht-Durchschnitt ab. Die Tagseite (A) und die Nachtseite (B) der Erde sind an diesen Durchschnittswerten also gleichberechtigt beteiligt. Lediglich die unterschiedliche geographische Verteilung von Land- und Ozeanflächen und deren Position zum aktuellen Stand der Sonne dürften einen merklichen Einfluss auf den globalen tages- und jahreszeitlichen Temperaturdurchschnitt ausüben.

Es ist etwas ärgerlich, aber die „gemessenen“ Globaltemperaturen werden üblicherweise als Differenzen zu einem Referenzzeitraum angegeben, sodass eine echte Zuordnung oder gar die Überprüfung von konkreten Aussagen kaum noch möglich ist. Diesem Vorgehen liegt sicherlich keine böse Absicht zugrunde, Zusammenhänge zu verschleiern oder gar fehlerhafte Aussagen zu stützen. Auf meteo.plus findet man schließlich eine Copyright-geschützte Abbildung mit dem Verlauf der absoluten Globaltemperaturen seit 1979 bis heute, und zwar aufgeteilt in Globaltemperaturen sowie die Temperaturen von Nord- und Südhemisphäre, deren grobe Durchschnittswerte nachstehend aufgeführt sind:

Tabelle 1: Globale Durchschnittswerte der Temperatur (Daten von meteo.plus)

Im Ergebnis schwankt die Globaltemperatur also zwischen 12°C und 17°C, und im langjährigen Durchschnitt liegt sie bei etwa 14,5°C. Sie verläuft in Phase mit der Temperatur der Nordhemisphäre, und zwar mit dem Mittelwert der jeweiligen Temperaturen von Nord- und Südhemisphäre, beispielsweise als MED(MIN-Nord, MAX-Süd) oder MED(MAX-Nord, MIN-Süd).

In einer ersten groben Näherung können wir also die Nord-Temperatur den Landmassen und die Süd-Temperatur den Ozeanen zuordnen, wohl wissend, dass eine reine Land-Temperatur eine noch größere Schwankungsbreite hätte und eine reine Ozean-Temperatur eine noch geringere; Willis Eschenbach gibt übrigens die Schwankungsbreite der reinen Landtemperatur mit 15°C und die der Ozeane mit 5°C an. Was bei den meteo.plus-Daten allerdings in beiden Fällen bleibt, ist eine Mitteltemperatur von etwa 14,5°C, die der sagenhaften „gemessenen globalen Durchschnittstemperatur“ (NST) von 14,8°C recht nahe kommt. Und in seiner E-Mail vom 11.04.2021 um 23:47 Uhr an den Skeptiker-Verteiler verweist Kramm auf einen Artikel von Lockyer, „Studies of temperature and pressure observations„, der 1906 in Nature erschien war. Darin heißt es, Zitat:

« It is interesting to remark that the northern hemisphere appears to be 1.5 °C warmer than the southern. Spitaler in 1886 came to a similar conclusion, his figures being :-

[Der Google-Übersetzer: Es ist interessant festzustellen, dass die nördliche Hemisphäre 1,5 ° C wärmer zu sein scheint als die südliche. Spitaler kam 1886 zu einem ähnlichen Ergebnis, seine Zahlen waren:- ]

Northern hemisphere …..15.4 °C,

Southern hemisphere….. 14.8 °C,

Whole earth………………. 15.1 °C,

Excess of N. over S. ………0.6 °C.»

Die „Whole-earth-Temperatur“ von Spitaler (1886) liegt also bei etwa 15°C. Da bleibt die Frage, wie überhaupt die „aktuelle globale Erwärmung bereits bei etwa 1 Grad Celsius“ über einer „vorindustriellen Durchschnittstemperatur“ liegen kann, wo doch in der Gegenwart immer noch sogenannte Globaltemperaturen um 15°C herum gemessen werden. Schließlich können für die Zeit vor 1886 gar keine neuen Temperaturmessungen mehr dazugekommen sein…

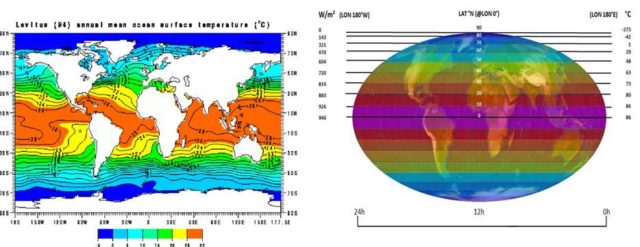

Meinem hemisphärischen S-B-Modell für unsere reale Erde wird von diversen Kritikern eine Nachttemperatur von 0 Kelvin nachgesagt. Nun erhält die Nachtseite unserer realen Erde zwar keinerlei Sonneneinstrahlung, aber trotzdem herrscht dort keine Mond-Temperatur von etwa minus 200°C. Vielmehr befindet sich die Temperatur unserer Erde in einem „eingeschwungenen“ Zustand. Lediglich die Differenz zur minimalen Nachttemperatur muss täglich ersetzt werden (hier letzte Abbildung). Denn die Nachttemperatur eines passiv bestrahlten Himmelskörpers hängt im Wesentlichen von dessen Wärmespeicherfähigkeit ab. Und auf unserer Erde wird der Nachtseite die erforderliche Wärme von ihrer kombinierten Luft-Wasser-Heizung aus den globalen Zirkulationen (Atmosphäre und Ozeane) zur Verfügung gestellt. Allein die Ozeane, die zwei Drittel unserer Erdoberfläche bedecken, enthalten ein Wärmeäquivalent von etwa 50.000 24h-Tagen Sonneneinstrahlung; und diese Wärmespeicher (Atmosphäre und Ozeane) werden wiederum fortwährend durch die solare Einstrahlung auf der Tagseite unserer Erde „aufgeladen“. In der nachfolgenden Abbildung ist links die jahresdurchschnittliche Oberflächentemperatur der Ozeane dargestellt, also der Durchschnitt zwischen Tag und Nacht sowie Frühling, Sommer, Herbst und Winter – mit entgegengesetzten Jahreszeiten auf beiden Hemisphären:

Mit angepasster Mollweide-Projektion (Copyright L. Rohwedder – Lizenz CC BY-SA 3.0)) Darüber: Das örtliche Maximum der breitenabhängigen temperaturwirksamen spezifischen Strahlungsleistung der Sonne für die gesamte Erde über einen 24h-Tag im Äquinoktium

ALSO noch einmal ganz langsam zum Mitdenken: Die Sonne muss unsere Erde gar nicht jeden Morgen von 0 Kelvin auf Tagestemperatur bringen. Die Erde befindet sich nämlich in einem „eingeschwungenen“ Zustand und ihre Wärmespeicher sind mit dem Äquivalent von mehr als 50.000 24h-Tagen Sonneneinstrahlung gefüllt. Diese Wärmespeicher verlieren also nachts „nur etwas“ Energie und müssen deshalb auf der Tagseite lediglich „nachgefüllt“ werden, mehr nicht. Im Mittel sprechen wir hier von 1,05*10^22 Joule, die die Erde über den durchschnittlichen 24h-Tag netto erhält und auch wieder abstrahlt. Denn sonst wäre die sogenannte „gemessene“ globale Durchschnittstemperatur (NST) nicht einigermaßen stabil. Herr Werner Schulz hatte die KKDML-Fraktion mit pädagogischem Langmut immer wieder darauf hingewiesen, dass auf der Tagseite im Mittel* 480W/m² kontinuierlich eingestrahlt und 240W/m² kontinuierlich über die Gesamtfläche der Erde abgestrahlt werden. Abgestrahlt werden also jeweils 240W/m² auf der Tagseite und 240W/m² auf der Nachtseite – das ergibt in Summe dann wieder 480W/m² Abstrahlung, also gilt: IN=OUT.

*) Für die Sophisten unter Ihnen: Korrekt wäre bei der Einstrahlung eine Summierung über (S0(1-Albedo)* COSZenitwinkel). Ich verwende hier nach KT97 weiterhin 940W/m² für (S0(1-ALBEDO)); in meinen DGG-Veröffentlichungen beschreibe ich dagegen einen Zweischichtfall.

Die solare Einstrahlung ersetzt also lediglich die terrestrische Abstrahlung bei einer „gemessenen globalen Durchschnittstemperatur“ (NST) von etwa 15°C, die sich wiederum ohne einen „natürlichen atmosphärischen Treibhauseffekt“ ganz zwanglos aus meinem hemisphärischen S-B-Ansatz herleitet. Es gilt demnach im langjährigen Durchschnitt:

[ Solare Einstrahlung @2PIR² = terrestrische Abstrahlung @4PIR² ] @ NST

Unsere Erde verfügt auf zwei Dritteln ihrer Oberfläche über eine Fußbodenheizung mit der in Abbildung 3 (links) dargestellten mittleren Vorlauftemperatur. Diese Ozean-Temperaturen repräsentieren wiederum zwei Drittel der „gemessenen“ globalen Ortstemperaturen. Die mittlere jährliche Oberflächentemperatur der Ozeane liegt bis etwa 70° nördlicher und südlicher geographischer Breite zwischen 0°C – 30°C und fällt erst jenseits davon auf bis zu -5°C ab; ein globaler Durchschnitt dürfte also in etwa bei der NST von etwa 15°C kumulieren. Wie wir bereits erfahren haben, wird das maximale rechnerische S-B-Temperaturäquivalent meines hemisphärischen S-B-Modells aufgrund von örtlicher Konvektion und Verdunstung in der Realität nirgendwo erreicht. Andererseits sinkt die Temperatur der Winterhemisphäre, insbesondere in der Polarnacht, niemals auf das rechnerische S-B-Temperaturäquivalent der geringen/fehlenden solaren Einstrahlung ab. Die nachfolgende Abbildung zum globalen horizontalen Wärmetransport gibt Aufschluss über die Gründe dafür:

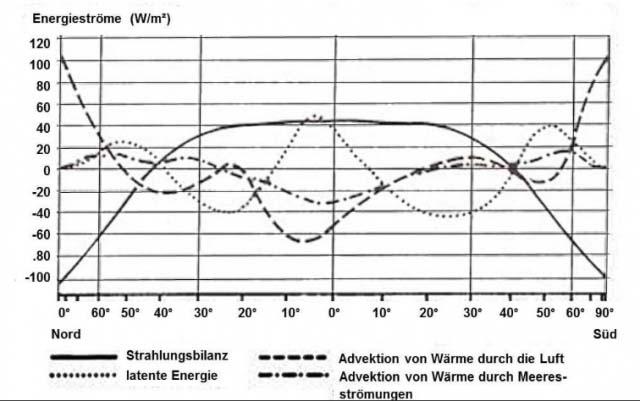

Alle diese Energieströme summieren sich für eine feste geographische Breite im durchschnittlichen Jahresmittel gerade auf null. Wir können hier also erkennen, dass sich die Überschüsse und Defizite gegenüber dem hemisphärisch berechneten S-B-Temperaturäquivalent durch den lateralen Transport von Wärme gerade global ausgleichen und damit mein hemisphärisches S-B-Modell voll bestätigen.

Wenn wir jetzt abschließend in der nachfolgenden Abbildung noch einmal die beiden Modell-Temperaturverläufe mit den Beleuchtungsklimazonen unserer Erde vergleichen, dann finden wir estätigt, dass unser Schulwissen über diese Klimazonen gar nicht mal so schlecht ist:

Ergebnis: Unserem profanen Schulwissen ist an dieser Stelle wohl nichts mehr hinzuzufügen. Wie erwartet, spiegeln die Beleuchtungsklimazonen (Definition) unserer Erde (Abbildung 5 Mitte) den Verlauf der maximalen örtlichen solaren Strahlungsleistung. Und diese solare Strahlungsleistung ist in den Tropen am höchsten und fällt dann zu den Polarregionen kontinuierlich ab. Von den beiden konkurrierenden theoretischen Klimamodellen in Abbildung 5 wird dieser natürliche Verlauf lediglich von meinem hemisphärischen S-B-Modell korrekt abgebildet. Mein hemisphärisches S-B-Modell aus dem 21. Jahrhundert ersetzt als realistisches Modell unserer Erde ohne THE also das Faktor4-Tag=Nacht-THE-Flacherdemodell der real existierenden Klimawissenschaft mit einem fehlerhaft konstruierten „natürlichen atmosphärischen Treibhauseffekt“ von konstant 33°C.

*) Nachtrag: Um jedweden Beschwerden vorzubeugen, bestätige ich hiermit, ein direkter „An“-Adressat der o. g. E-Mail vom 29. Januar 2021 um 09:58 Uhr mit Kramms PDF-Dokument „kramm_bemerkungen_weber_v3.pdf“ und den dort enthaltenen Abbildungen 15 a und b (hier Abb. 1 a und b sowie Abb. 5 links und rechts) zu sein, ebenso, wie u. a. auch die Herren Lüdecke, Limburg und Kirstein. Ich beweise nachfolgend mit der „Confidentiality Warning“ des Dr. Gerhard Kramm die rechtmäßige Nutzung dieser Graphiken in meinem Artikel „Die sogenannte ‚gemessene globale Durchschnittstemperatur‘ wird von den Ozeanen bestimmt“, Zitat:

“CONFIDENTIALITY WARNING: The information transmitted is intended only for the person or entity to which it is addressed and may contain confidential and/or privileged material. Any review, retransmission, dissemination or other use of, or taking any action in reliance upon, this information by persons or entities other than the intended recipient is prohibited. If you receive this in error, please contact the sender and delete the material from any computer.”

Der unbestechliche Google-Übersetzer bestätigt mir ausdrücklich, die Inhalte der besagten E-Mail Kramm vom 29. Januar 2021 um 09:58 Uhr rechtmäßig zitiert zu haben:

„VERTRAULICHKEITSWARNUNG: Die übermittelten Informationen sind nur für die Person oder Organisation bestimmt, an die sie gerichtet sind, und können vertrauliches und / oder privilegiertes Material enthalten. Jegliche Überprüfung, Weiterverbreitung, Verbreitung oder sonstige Verwendung oder Ergreifung dieser Informationen durch andere Personen oder Organisationen als den beabsichtigten Empfänger ist untersagt. Wenn Sie dies irrtümlich erhalten, wenden Sie sich bitte an den Absender und löschen Sie das Material von einem beliebigen Computer.

ERGO: Es verbleiben für eine erlaubte „Überprüfung, Weiterverbreitung, Verbreitung oder sonstige Verwendung oder Ergreifung dieser Informationen“ ausschließlich die von Dr. Kramm „beabsichtigten Empfänger“, und ich bin definitiv der ERSTE „AN“-EMPFÄNGER dieser E-Mail.

Am Montag, den 15. März, wurde ein Artikel [1] in Nature Geoscience veröffentlicht (eine der Zeitschriften des Nature-Verlags), in dem behauptet wird, dass „die Abfolge der jüngsten [mitteleuropäischen] Sommertrockenheit seit 2015 beispiellos in den letzten 2.110 Jahren ist“ und „wahrscheinlich durch die anthropogene Erwärmung und die damit verbundenen Veränderungen in der Position des Sommer-Jetstreams verursacht wurde.“ Der Guardian [2] griff diese Erkenntnisse auf und titelte: „Recent European Droughts: Worst in 2,000 Years“.

Aber am Freitag derselben Woche (19. März) wurde in einem anderen Nature-Journal – Communications Earth & Environment – ein weiterer Artikel[3] veröffentlicht, der zu dem Ergebnis kam, dass „Mitteleuropa viel längere und schwerere Dürren [in den Jahren 1400-1480 n. Chr. und 1770-1840 n. Chr.] als die im 21. Jahrhundert beobachteten erlebt hat“ und dass die Megadürren durch Winterblockaden über den Britischen Inseln, reduzierten solaren Antrieb und explosiven Vulkanismus verursacht wurden. Sie kommen zu dem Schluss, dass die „jüngsten Dürre-Ereignisse (z.B. 2003, 2015 und 2018) im Bereich der natürlichen Variabilität liegen und im letzten Jahrtausend nicht beispiellos sind.“

Wie kann es sein, dass zwei Arbeiten, die innerhalb derselben Kalenderwoche in zwei angesehenen Fachzeitschriften veröffentlicht wurden, zu Schlussfolgerungen kommen, die diametral entgegengesetzt sind? Willkommen in der Welt der Wissenschaft, wo „The Science is Never Settled“. Ungeachtet dessen, was die Alarmisten Sie glauben machen wollen, ist die Klimawissenschaft immer noch eine laufende Debatte, und wir haben sicherlich nicht alle Antworten.

————————

[1] Büntgen, U., Urban, O., Krusic, P.J. et al. Recent European drought extremes beyond Common Era background variability. Nat. Geosci. (2021). https://doi.org/10.1038/s41561-021-00698-0

[2] https://www.theguardian.com/environment/2021/mar/15/climate-crisis-recent-european-droughts-worst-in-2000-years

[3] Ionita, M., Dima, M., Nagavciuc, V. et al. Past megadroughts in central Europe were longer, more severe and less warm than modern droughts. Commun Earth Environ 2, 61 (2021). https://doi.org/10.1038/s43247-021-00130-w

Link: https://cornwallalliance.org/2021/05/is-the-science-settled/

Übersetzt von Chris Frey EIKE

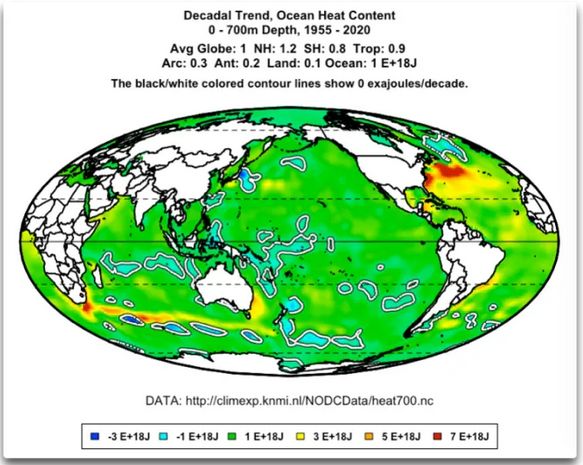

Und was habe ich gefunden? Nun, ich bin ein visueller Typ, das heißt, ich brauche es anschaulich. Hier sind also meine Grafiken. Ich interessiere mich für die Veränderungen im ozeanischen Wärmeinhalt, also sind das zwei Ansichten dieser Trends.

Meine erste Überraschung? Es gibt eine Reihe riesiger ozeanischer, langsam rotierender Wirbel, die ich schon einmal gesehen habe. Sie beginnen an der Südspitze Afrikas und reichen bis unter Australien. Ich wusste von ihnen, weil sie in Grafiken von Satellitendaten über die Meeresoberfläche sichtbar sind. Aber was mir nicht klar war: diese Wirbel mischen warmes Oberflächenwasser in die Tiefe. Dies wird durch die orange/gelbe Linie der erhöhten Unterwasserwärme angezeigt, die sich von Afrika unter Australien erstreckt.

Und wenn man etwas warmes Oberflächenwasser nach unten mischt, muss anderes kühles Tiefenwasser nach oben kommen … wie die entsprechende Linie von Gebieten direkt südlich der Wirbel anzeigt, die von schwarz/weißen Linien umgeben sind und Gebiete zeigen, die seit 1955 tatsächlich Wärme verloren haben.

Was hat mich noch überrascht? Die Turbulenzen des Golfstroms, die mit der Topographie des Ozeanbodens entlang der Ostküste der USA interagieren, mischen auch warmes Oberflächenwasser nach unten … und der entsprechende Auftrieb von kaltem Wasser unter der Oberfläche findet gerade südlich von Grönland statt.

Ich habe mich schon lange gefragt, wie sich weniger dichtes, wärmeres Wasser nach unten in dichteres, kühleres, tieferes Wasser mischen kann … nun, es gibt ein paar Orte, an denen dies geschieht.

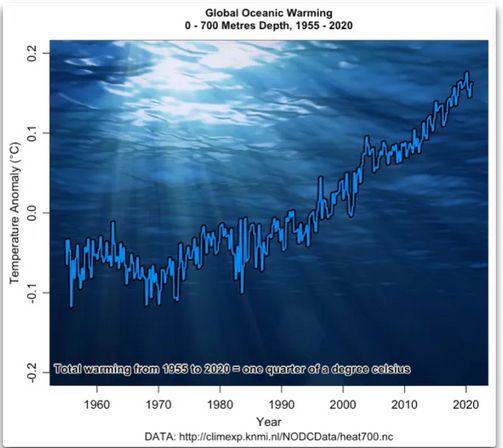

Zum Schluss habe ich mir noch die tatsächliche Temperaturänderung angesehen, die durch diese Exajoule an Energieänderungen dargestellt wird. Ich bin sicher, ich weiß es nicht.

Aber man kann es ausrechnen. Also habe ich die langsame Zunahme des Wärmeinhalts in Exajoule in Grad Celsius langsamer Erwärmung umgerechnet. Hier ist das Ergebnis:

Ein Viertelgrad in einem halben Jahrhundert?

Nun lese ich immer wieder davon, dass Fische als Reaktion auf die Erwärmung der Ozeane ihre Standorte ändern. Aber das erscheint mir äußerst zweifelhaft, weil die Veränderungen so gering sind. In den letzten fünfzig Jahren hat sich der Ozean um etwa 0,005°C pro Jahr erwärmt … und nennen Sie mich verrückt, aber ich glaube einfach nicht, dass die Fische und andere Unterwasserbewohner so temperaturempfindlich sind, dass eine Veränderung von einem Viertelgrad in einem halben Jahrhundert sie dazu bringt, ihr glückliches Zuhause zu verlassen.

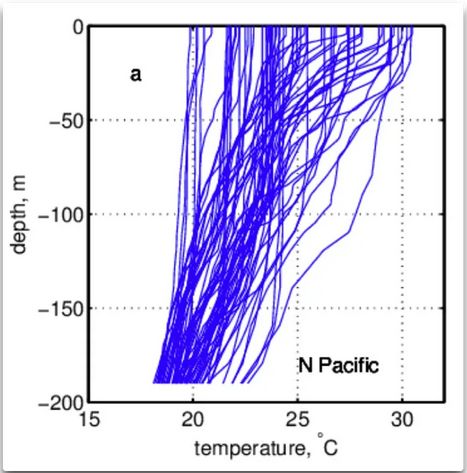

Zum einen liegt die vertikale Temperaturveränderung im offenen Ozean oft in der Größenordnung von 1°C pro 40 Meter Höhe oder so. Hier sind einige ARGO-Schwimmerprofile der oberen 200 Meter:

Und das bedeutet, dass ein Fisch oder ein anderer Unterwasserbewohner, wenn er sich um zehn Meter nach oben oder unten bewegt, bereits die gefürchtete Temperaturänderung von einem Viertelgrad durchgemacht hat …

Hinzu kommt, dass viele Millionen von Meeresfischen, Garnelen und Copepoden jede Nacht von 800-1000 Metern Tiefe auf etwa 100 Meter Tiefe wandern und dann bei Sonnenaufgang wieder abtauchen … was bedeutet, dass sie jede Nacht fröhlich 5° – 10° Temperaturwechsel ertragen. Ich bezweifle daher sehr, dass sie sich von einer Temperaturänderung von einem Viertelgrad in einem halben Jahrhundert stören lassen.

Und gemessen an der Tonnage ist diese tägliche vertikale Wanderung die größte Bewegung von Lebewesen auf dem Planeten … wir reden also nicht über ein paar Fische hier und da.

Das ist die Quintessenz. Wenn die Lebewesen auf der Welt, sowohl an Land als auch im Meer, so temperaturempfindlich wären, wie die Alarmisten uns glauben machen wollen, wären diese Lebewesen (und auch wir Humanoiden) alle schon längst ausgestorben. Und soweit ich das beurteilen kann, ist das nicht geschehen … zumindest noch nicht.

Link: https://wattsupwiththat.com/2021/05/01/oceanic-warming-well-sorta/

Übersetzt von Chris Frey EIKE

Wer von den älteren Semestern kennt sie nicht, die Kabarettnummer von Lisa Fitz im Scheibenwischer der ARD 1986 nach Tschernobyl? Die Physiker und Ingenieure mochten den Auftritt wohl nicht, weil die öffentlich-rechtlichen Medien damals schon gemeinsam mit Spiegel & Co. die Weltuntergangsgeschichten von Atomtod und Waldsterben verbreiteten – der aktuelle Eliten-Lobbyismus von ARD und ZDF ist also „nichts Neues unter der Sonne“, wie das Alte Testament so schön sagt.

Umso mehr wundert man sich, daß ausgerechnet die früher eher grüne Fitz heute ausgerechnet im SWR (ARD!) den Regierenden und schon länger hier Profitierenden eine Ohrfeige nach der anderen verpaßt.

Letzten Samstag bekam Tesla-Boß Elon Musk eine Watsch’n von der Fitz, die man bei EIKE oder der Achse, aber nicht im SWR vermutet hätte. Die Münchener Kabarettistin aus alter Schaustellerfamilie berichtete über Musks Gigafaktorei in Grünheide bei Berlin, die, ganz ökologisch, die größte Produktionsstätte der Welt sein wird. Sie hob besonders darauf ab, daß die Fabrik mitten in einem Wasserschutzgebiet stehe und von diesem Wasser sehr viel verbrauche. Dann zitiert sie den Besitzer, von örtlichen Naturschützern darauf angesprochen, nur meint: Ja, aber da wüchsen ja viele Bäume, die bräuchten Wasser, und das müsse dann ja auch dort sein. Es sei ja nicht die Wüste.

„Wow. Also, daß er Ami is, weiß man..aber daß er so dumm ist…“ meint die Künstlerin lakonisch dazu.

(Musk ist Kanadier-Südafrikaner, hat aber die US-Bürgerschaft.)

So geht das übrigens jeden Monat in der Spätschicht, wenn Lisa Fitz auftritt. Was sie über den Drosten-Lauterbach-Coronismus sagt, können Sie sich denken. Schauen Sie es sich trotzdem an, wenn Sie es noch nicht kennen. Kollegin Simone Solga aus Sachsen ist übrigens auch sehr zu empfehlen!

Man wundert sich schon, wie glatt das bislang durchgeht; besonders, wenn man an die Angriffe auf Naomi Seibt, Dieter Nuhr und aktuell die Schauspieler von #allesdichtmachen denkt. Der unbeirrbare Nuhr läßt es sich nicht nehmen, Greta Thunberg und ihre Entourage auf die Schippe zu nehmen und die Themen wie Klimagenderismus und Corona-Politik mit ganz einfachen Fragen auseinanderzunehmen. Die gefährlichen Gedanken der Allesdichtmacher wurden noch heftiger angegangen, einschließlich Morddrohungen. Über eine mediale Hatz der selbsternannten Meinungs- und Gedankenpolizisten auf Lisa Fitz ist bislang nichts groß bekannt geworden. Ich würde sagen: Es würde auch nichts nutzen. Fitz macht nicht den Eindruck, als würde sie wie Meret Becker oder Heike Makatsch auch nur daran denken, etwas Gefälligeres zu sagen oder gar zu widerrufen. Und der SWR kann es sich analog zu Nuhr sicher nicht leisten, seine altgediente Kabarettwaffe auszumustern. Womit soll man sonst seine Milliardengebühren noch rechtfertigen? Mit Tagesschau und Herzschmerz-Serien? Vielleicht sehen die Staatsfunker von „Miosga today“ und „Kleber today“ (Zitat Dirk Maxeiner) die Fitz auch als eine Art „Ventillösung“, wie damals die Kollegen am Grenzübergang Bornholmer Straße.

Professor Koonin schickte mir im November einen fast endgültigen Entwurf zum Lesen und Kommentieren und ich habe sein Buch ein wenig überarbeitet, aber der Entwurf war schon damals in guter Form. Jetzt ist er noch besser. Ich habe vor ein paar Wochen ein signiertes Vorabexemplar erhalten, aber ich habe trotzdem eine Kindle-Version vorbestellt, um leichter darauf zugreifen zu können, und ich empfehle Ihnen, das auch zu tun. Dies ist ein wichtiges Buch, nicht nur weil Koonin ein brillanter und berühmter Physiker ist, sondern auch wegen des Inhalts. Es ist ein guter Überblick über die Wissenschaft, aber auch philosophisch wichtig.

Koonin hat mehr als 200 wissenschaftliche Arbeiten und Artikel geschrieben. Sie wurden laut Google Scholar über 14.000 Mal zitiert. Diese beziehen sich meist auf seine Hauptgebiete der Kern- und Atomphysik. Er hat auch über Biokraftstoffe, Energie, Klimawissenschaft, Beobachtungen der Albedo der Erde und die Analyse des menschlichen Genoms geschrieben. Er war einst Vorsitzender der kleinen JASON-Gruppe von Wissenschaftlern, die das Pentagon und andere Bundesbehörden beraten. Wie das Wall Street Journal in seiner kürzlichen Rezension des Buches berichtet, sind „Mr. Koonins wissenschaftliche Referenzen tadellos.“ (Mills, 2021).

Wir können erwarten, dass er von der Presse geschmäht wird, weil er nicht auf der Parteilinie liegt, aber er ist in dem Buch eindeutig korrekt und besonnen. Das Buch ist noch nicht für die Öffentlichkeit zugänglich, aber es ist bereits ein #1 Bestseller im Amazon Kindle Store, unter „Wetter“. Ein paar interessante Zitate aus der frühen Kopie, die er mir geschickt hat:

Die Erde hat sich im letzten Jahrhundert erwärmt, teilweise aufgrund natürlicher Phänomene und teilweise als Reaktion auf wachsende menschliche Einflüsse. Diese menschlichen Einflüsse (vor allem die Anhäufung von CO2 aus der Verbrennung fossiler Brennstoffe) üben einen physikalisch kleinen Effekt auf das komplexe Klimasystem aus. Leider reichen unsere begrenzten Beobachtungen und unser Verständnis nicht aus, um sinnvoll zu quantifizieren, wie das Klima auf menschliche Einflüsse reagiert oder wie es sich auf natürliche Weise verändert. Doch selbst wenn sich die menschlichen Einflüsse seit 1950 verfünffacht haben und sich der Globus nur geringfügig erwärmt hat, bleiben die meisten schweren Wetterphänomene innerhalb der Variabilität der Vergangenheit. Projektionen zukünftiger Klima- und Wetterereignisse beruhen auf Modellen, die für diesen Zweck nachweislich ungeeignet sind.“ (Koonin, 2021, S. 24)

Dieses Zitat ist besonders wichtig, weil viele in der Öffentlichkeit nicht erkennen, dass der menschliche Einfluss auf das Klima nie in der Natur beobachtet oder gemessen wurde. Sie halten es für eine Tatsache, aber das IPCC hat uns nur eine sehr grobe Schätzung auf der Basis von Modellen geliefert. Was hat Professor Koonin zu den Klimamodellen zu sagen?

Es ist leicht, sich von der Vorstellung verführen zu lassen, dass wir einfach den gegenwärtigen Zustand der Atmosphäre und der Ozeane in einen Computer einspeisen können, einige Annahmen über zukünftige menschliche und natürliche Einflüsse machen und so das Klima Jahrzehnte in die Zukunft genau vorhersagen können. Leider ist das nur ein Hirngespinst, wie man aus Wettervorhersagen schließen kann, die bis auf zwei Wochen oder so genau sein können. (Koonin, 2021, S. 79)

Zwei Wochen? Koonin ist sehr großzügig; er beruft sich auf diese Quelle [EZMW]. Er fügt ein paar Seiten später hinzu:

Jeder, der sagt, dass Klimamodelle ’nur Physik‘ sind, versteht sie entweder nicht oder er will absichtlich in die Irre führen. (Koonin, 2021, S. 81).

Einige Wissenschaftler des Max-Planck-Instituts haben beschrieben, wie sie ihr Klimamodell getrimmt haben, indem sie eine ECS (die Klima- oder Temperatursensitivität auf eine Verdoppelung der CO2-Konzentration) von etwa 3°C anvisierten, indem sie ihre Wolkenrückkopplungen anpassten. Um zu verstehen, wie ungeheuerlich dies ist, muss man verstehen, dass Wolken nicht modelliert werden; sie sind einstellbare Parameter. ECS ist kein Modell-Input, sondern wird aus dem Modell-Output errechnet. Koonin’s Kommentar: „Die Forscher haben ihr Modell so manipuliert, dass die Sensitivität gegenüber Treibhausgasen ihren Vorstellungen entsprach. Das heißt, sie frisieren die Modelle, bis sie zum Narrativ passen.“ (Koonin, 2021, S. 93).

Die Regierungen der Welt und die U.N. haben Milliarden von Dollar für die Klimaforschung ausgegeben, und Tausende von Wissenschaftlern auf der ganzen Welt haben ihre ganze Karriere mit diesem Thema verbracht, wie steht es also um uns? Koonin sagt es uns:

Ein erhebliches Problem ist, dass die Streuung des [IPCC AR5] CMIP5-Ensembles in den Jahren nach 1960 größer ist als die der Modelle in CMIP3 – mit anderen Worten, die spätere Generation von Modellen ist tatsächlich unsicherer als die frühere. Hier gibt es also eine echte Überraschung: selbst als die Modelle anspruchsvoller wurden – einschließlich feinerer Gitter, ausgefeilterer Untergitter-Parametrisierungen … nahm die Unsicherheit zu (Koonin, 2021, S. 87)

Wir fügen hinzu, dass die Unsicherheit bei der Berechnung des Effekts von CO2 auf die globale Erwärmung (ECS) im AR5 genau der Berechnung entspricht, die im Charney-Report (Charney, et al., 1979, S. 2) angegeben wurde, nämlich 1,5° bis 4,5° (IPCC, 2013, S. 16).

Koonin wurde zuerst in Physik an der Cal Tech ausgebildet, wo er Richard Feynman kannte und mit ihm studierte, den berühmten Physiker, der uns lehrte, „an die Unwissenheit der Experten zu glauben.“ Koonin zitiert diese Passage aus Feynmans Cal-Tech-Eröffnungsrede von 1974:

Gestern Abend habe ich (im Fernsehen) gehört, dass das Wesson-Öl nicht das Essen durchtränkt. Nun, das ist wahr. Es ist nicht unehrlich; aber die Sache, von der ich spreche, ist nicht nur eine Angelegenheit von nicht unehrlich sein, es ist eine Angelegenheit der wissenschaftlichen Integrität, die eine andere Ebene ist. Die Tatsache, die zu dieser Werbeaussage hinzugefügt werden sollte ist, dass Öle keine Lebensmittel durchtränken, wenn sie bei einer bestimmten Temperatur zubereitet werden. Wenn sie bei einer anderen Temperatur betrieben werden, werden sie alle durchweichen – auch Wesson Oil. Es ist also die Implikation, die vermittelt wurde, nicht die Tatsache, die wahr ist, und der Unterschied ist das, womit wir uns beschäftigen müssen. (Koonin, 2021, S. 7)

Wie Koonin erzählt, ist dies der Zustand der Klimawissenschaft heute. Was der IPCC und die US-Regierung uns über die Klimawissenschaft erzählen, ist im Allgemeinen wahr, aber in ihrem Bemühen, „eher zu überzeugen als zu informieren“, lassen sie das weg, was nicht in ihr Narrativ passt. Sie erzählen uns genug, um alarmiert zu sein, aber nicht genug, um uns zu informieren. Es ist der Verlust der wissenschaftlichen Integrität, der alarmierend ist, nicht das Klima.

Ein Großteil des Buches wird damit verbracht, den Mythos zu zerstreuen, dass extreme Wetterereignisse aufgrund des vom Menschen verursachten Klimawandels zunehmen. Er erzählt, dass Hitzewellen heute nicht häufiger vorkommen als im Jahr 1900, Tornados nehmen nicht zu, ebenso wenig wie Dürren. Koonin kritisiert die Medien für die Behauptung, dass extremes Wetter irgendwie mit menschlichen Aktivitäten zusammenhängt, obwohl es dafür keine Beweise gibt.

Holman Jenkins vom Wall Street Journal hat ebenfalls einen Entwurf des Buches gelesen und Folgendes geschrieben, basierend auf einem Interview mit Koonin:

Koonin argumentiert nicht gegen die aktuelle Klimawissenschaft, sondern dass das, was die Medien und Politiker und Aktivisten über die Klimawissenschaft sagen, so weit von der tatsächlichen Wissenschaft entfernt ist, dass es absurd und nachweislich falsch ist. (Jenkins, 2021)

Jenkins und Koonin beklagen sowohl den Verlust der Ehrlichkeit als auch des Glaubens an die Bedeutung von Ehrlichkeit und Wahrheit in den heutigen Nachrichtenmedien und der Politik. Von 2009 bis 2011 war Koonin Präsident Obamas Unterstaatssekretär für Wissenschaft im Energieministerium. Später, im Jahr 2020, erklärte Obama, dass wir uns in einer „epistemologischen Krise“ befinden. Ob wir mit Obama in der Sache übereinstimmen oder nicht, wir sind uns einig, dass sich die USA in einer Krise in Bezug auf Wahrheit und Wissen befinden. In der Wissenschaft geht es darum, die Wahrheit auf objektive und reproduzierbare Weise zu ermitteln. Die eigenen Gefühle spielen keine Rolle, Ausreden spielen keine Rolle, Konsensmeinungen spielen keine Rolle, wie man es nennt („globale Erwärmung“ oder „Klimawandel“) spielt keine Rolle, es zählt nur das, was man präsentiert, das unabhängig reproduziert werden kann. Bei Unsettled geht es darum, die Wissenschaft wieder auf den richtigen Weg zu bringen, Wissenschaftler sollten berichten, was sie wissen, was sie nicht wissen, was sie modelliert haben und was sie beobachtet haben. Nicht mehr und nicht weniger.

Einige von Ihnen erinnern sich vielleicht daran, dass Professor Koonin 2014 einen interessanten, hochkarätig besetzten Workshop der American Physical Society zum Thema Klimawandel leitete. Sie diskutierten und debattierten die wesentlichen Elemente der laufenden Klimawandel-Debatte. Meine Zusammenfassung des Workshops kann hier nachgelesen werden. Das Lesen des Transkripts dieses Workshops war für mich ein großes Aha!-Erlebnis, es ist 573 Seiten lang, aber ein großartiges Beispiel für gut gemachte Wissenschaft. Leider wurden die großen Defizite in der populären, vom Menschen durchgeführtten Klimawissenschaft, die er aufzeigte, ignoriert. Koonin setzte sich aktiv für mehr solcher formalen wissenschaftlichen Debatten über die Wissenschaft ein; wobei ihm zufolge beide Seiten vertreten sein sollten. Leider wurde jeder Vorschlag in diese Richtung abgeschmettert. In Kapitel 11 beschreibt er „Fixing the Broken Science,“ und wie prominente demokratische Senatoren Markey, Schatz, Smith, Blumenthal, Shaheen, Booker, Stabenow, Klobuchar, Hassan, Markey, und Feinstein versuchten, jede Finanzierung einer ehrlichen Debatte über die Klimawissenschaft buchstäblich zu verbieten:

… die Verwendung von Geldern an Bundesbehörden zu verbieten, um ein Gremium, eine Arbeitsgruppe, einen beratenden Ausschuss oder andere Bemühungen einzurichten, die den wissenschaftlichen Konsens zum Klimawandel in Frage stellen, und für andere Zwecke. (Koonin, 2021, S. 202)

Versuchen sie wirklich, ein Forschungsergebnis gesetzlich festzulegen? Wissenschaft ist Debatte. Ohne Debatte gibt es keine echte Wissenschaft. Die verschiedenen wissenschaftlichen Akademien sind nicht besser als der Senat. Koonin und seine Kollegen haben sie gedrängt, ihren Prinzipien treu zu bleiben und zu informieren, anstatt zu überreden, aber ihre Bitten wurden ignoriert. An diesem Punkt sind wir heute. Wir applaudieren Professor Koonin’s Standpunkt zur wissenschaftlichen Integrität und ermutigen andere, seinem Beispiel zu folgen.

[Hervorhebung vom Übersetzer]

Charney, J., Arakawa, A., Baker, D., Bolin, B., Dickinson, R., Goody, R., . . . Wunsch, C. (1979). Carbon Dioxide and Climate: A Scientific Assessment. National Research Council. Washington DC: National Academies Press. doi:https://doi.org/10.17226/12181

IPCC. (2013). In T. Stocker, D. Qin, G.-K. Plattner, M. Tignor, S. Allen, J. Boschung, . . . P. Midgley, Climate Change 2013: The Physical Science Basis. Contribution of Working Group I to the Fifth Assessment Report of the Intergovernmental Panel on Climate Change. Cambridge: Cambridge University Press. Retrieved from https://www.ipcc.ch/pdf/assessment-report/ar5/wg1/WG1AR5_SPM_FINAL.pdf

Jenkins, H. (2021, April 16). How a Physicist Became a Climate Truth Teller. Wall Street Journal. Retrieved from https://www.wsj.com/articles/how-a-physicist-became-a-climate-truth-teller-11618597216?mod=article_inline

Koonin, S. E. (2021). Unsettled: What Climate Science Tells us, What it doesn’t, and why it matters. Dallas, Texas, USA: BenBella. Retrieved from https://www.amazon.com/dp/B08JQKQGD5/ref=dp-kindle-redirect?_encoding=UTF8&btkr=1

Mills, M. P. (2021, April 25). ‘Unsettled’ Review: The ‘Consensus’ On Climate. Wall Street Journal. Retrieved from https://www.wsj.com/articles/unsettled-review-theconsensus-on-climate-11619383653

Link: https://andymaypetrophysicist.com/2021/04/26/unsettled-steven-koonins-new-book/

Übersetzt von Chris Frey EIKE

Der lange in Moskau tätige Journalist Boris Reitschuster meinte in einem seiner Videos, die russischen Generäle nähmen der Bundeswehr die von Ursula vd Leyen auferlegte Multikulti-Gender-Initiative nicht ab. Das sei Desinformation, um mögliche Gegner in Sicherheit zu wiegen. Daß deutsche Eliten mittlerweile völlig inkompetent und deswegen „woke“ sind, liegt außerhalb des Vorstellungsvermögens der russischen Eliten.

Vor kurzem gab der Chef des britischen Geheimdienstes MI6 (Außen, Military Intelligence Section 6, auch SIS), Richard Moore oder „C“, das erste Mal in der Geschichte des Dienstes ein öffentliches Interview und betonte, daß seine Agenten nach Klimasündern im Ausland Ausschau halten würden. Wie darf man sich das vorstellen? Hangeln sich da Doppel-Null-Spione im Stil eines James Bond nachts durch Raffinerieanlagen in Dschidda? Knipst ein Schlapphut mit Minox-Minikamera vertrauliche Emissions-Aufzeichnungen im Berliner Wirtschaftsministerium? Oder klettert ein Geheimer im schmutzgrauen Tarnanzug an Schloten hoch und mißt den CO2-Gehalt im Qualm?

Vielleicht wird der übernächste Bond-Film ja ein Ökothriller, in dem Daniel Craig Klimaschurken nachspürt. Arbeitstitel: „Liebesgrüße aus Leuna“.

Zitat Moore:

„Wo Menschen im Klimaschutzbereich Verpflichtungen eingehen, ist es vielleicht unsere Aufgabe sicherzustellen, dass das, was sie tun, auch wirklich das ist, wozu sie sich verpflichtet haben. Wie jemand so schön zu sagen pflegte: ‚Vertrauen ist gut, Kontrolle ist besser.'“

Ob man das ernst nehmen darf, ist offen. Ähnlich wie bei der Bundeswehr ist in westlichen Staaten grundsätzlich davon auszugehen, daß kleine grünrote Interessensgruppen ihre Agenda selbst in Institutionen durchsetzen, die sie bislang verachteten oder ignorierten. Vielleicht kann man Militär und Geheimdienst mit einer Gender-Bundeswehr oder einen Klima-MI6 ja durch die Hintertür abschaffen. Dumm nur, daß die Russen und Chinesen es nicht tun.

Allerdings muß man beachten, daß der britische Regierungschef nicht Angela Merkel oder Annalena Baerbock heißt, sondern Alexander Boris de Pfeffel Johnson. Er hat zwar genau wie seine kontinentalen Kollegen die Corona-Sars2-„Pandemie“ politisch genutzt; in anderen Fragen aber eine klar bürgerfreundliche Politik gemacht. Daß er einem „C“ dessen ernsthafte Klimaschnüffelei durchgehen lassen würde, ist daher nicht wahrscheinlich. Vermutlich ist das Tamtam wohl nur eine PR-Offensive von Moore, der den britischen Journalisten etwas zu schlucken gab, da die genau wie die Kollegen in den DACH-Staaten meist völlig entrückt sind. Ganz substanzlos wäre ein Klima-007 aber nicht: Würde der MI6 Informationen darüber besitzen, daß die Klimapolitik zum Beispiel eines Joe Biden oder einer Bärbock nach vier Jahren nicht so erfolgreich ist wie verlautbart, könnte man das schon in Verhandlungen unterschiedlicher Art nutzen.

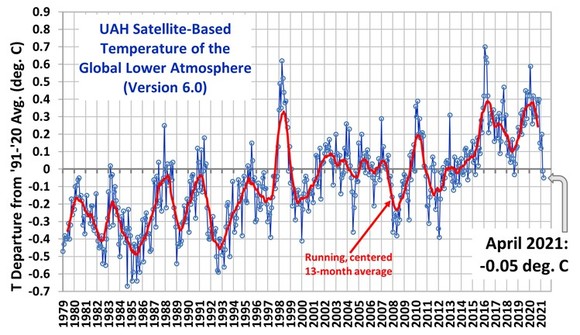

Globale Temperaturkurve im kalten April 2021

Die Abweichung der globalen Mitteltemperatur der satellitengestützten Messungen vom Durchschnitt der Jahre 1991 – 2020 ging im April 2021 weiter auf – 0,05 Grad Celsius zurück. Noch wirkt sich die kühle La Niña-Situation der letzten Monate aus. Laut der US- amerikanischen Wetter- und Ozeanografiebehörde NOAA wird La Niña mit 80%iger Wahrscheinlichkeit von Mai bis Juli beendet sein. Allerdings erwartet die Behörde im Herbst den Wiederbeginn einer neuen La Niña.

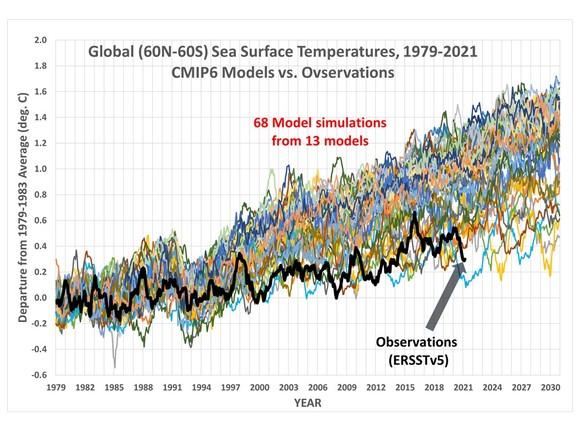

Der Durchschnitt der Temperaturerhöhung beträgt 0,14 Grad Celsius pro Jahrzehnt. Die Modellrechnungen, auf denen die Empfehlungen des IPCC beruhen, kommen auf einen doppelt so hohen Temperaturanstieg für den gleichen Zeitraum. (siehe nächste Grafik, Quelle: R.Spencer 2021). Diese eklatante Abweichung von der realen Temperaturentwicklung ist politisch bedeutsam, weil die Prognosen der Modelle zur Grundlage von weitreichenden Entscheidungen, wie z.B. Verfassungsgerichtsurteilen, gemacht werden.

Ein Verfassungsgerichtsurteil, das sich auf fragwürdige Quellen stützt

Mit Beschluss vom 24.März hat das Bundesverfassungsgericht auf Klage einiger Einzelpersonen wie dem Schauspieler Hannes Jänicke, Luisa Neubauer (Fridays for future), Prof. Volker Quaschning, Josef Göppel (CSU und Energiebeauftragter des Bundesministeriums für wirtschaftliche Zusammenarbeit) entschieden, dass das Klimaschutzgesetz vom 12. Dezember 2019, verfassungswidrig ist, weil „hinreichende Maßgaben für die weitere Emissionsreduktion ab dem Jahre 2031 fehlen“.

Wie kommt das Gericht zu diesem Ergebnis?

In der Beschreibung der „tatsächlichen Grundlagen des Klimawandels“ (Ziff.16-29) und den „tatsächlichen Grundlagen des Klimaschutzes“ (Ziff.31-37) bezieht das Gericht sich im Wesentlichen auf vier Quellen: den IPCC, das Buch Rahmstorf/Schellnhuber „Der Klimawandel“, das Umweltbundesamt und den Sachverständigenrat für Umweltfragen SRU.

Das Gericht stellt zu den Grundlagen des Klimawandels fest:

„zwischen der Gesamtmenge an emittierten klimawirksamen Treibhausgasen und dem Anstieg der mittleren Oberflächentemperatur besteht eine annähernd lineare Beziehung“ (Ziff.19). „Ohne zusätzliche Maßnahmen zur Bekämpfung des Klimawandels gilt derzeit ein globaler Temperaturanstieg um mehr als 3 °C bis zum Jahr 2100 als wahrscheinlich„.

Hier ignoriert das Gericht die erheblichen Unsicherheiten über Rückkopplungseffekte, wie etwa der Wolken, die das IPCC selbst dazu führt, eine Spannbreite von 1,5 bis 4,5 Grad Celsius bei Verdoppelung der CO2-Konzentrationen von 285 ppm (1.860) auf 570 ppm 2.100 anzugeben.

In Ziffer 20 greift das Gericht die unter Klimaforschern umstrittene Annahme Stefan Rahmstorfs auf, wonach es Hinweise gibt,

„daß infolge des Abschmelzens des Grönländischen Eisschildes und anderer Frischwassereinträge in den Nordatlantik die thermohaline Zirkulation des Nordatlantiks (atlantische Umwälzbewegung) an Stärke verliert. Eine starke Abschwächung hätte unter anderem große Auswirkungen auf die Wettersysteme in Europa und Nordamerika. Der Nordatlantikraum würde sich rasch um mehrere Grad abkühlen.“

Hier beruft sich das Gericht auf eine umstrittene Außenseitermeinung. Hätte es auf die Web-Seite des Max-Planck-Instituts für Meteorologie in Hamburg geschaut, hätte es auf die Frage “ kann die globale Erwärmung zum Abriss des Golfstroms führen?“ die Antwort gelesen „Die kurze Antwort ist: Nein.

Auch die Schellnhuberschen Kipppunkte haben es dem Gericht angetan.

„Als eine besondere Gefahr für die ökologische Stabilität werden sogenannte Kipppunktprozesse im Klimasystem angesehen, weil diese weitreichende Umweltauswirkungen haben können. Kippelemente sind Teile des Erdsystems, die eine besondere Bedeutung für das globale Klima haben und die sich bei zunehmender Belastung abrupt und oft irreversibel verändern. Beispiele sind die Permafrostböden in Sibirien und Nordamerika, die Eismassen in den polaren Zonen, der Amazonasregenwald und bedeutende Luft- und Meeresströmungssysteme.„(Ziffer 21)

Wahrscheinlich hatten die Richter das Interview mit Jochem Marotzke, Doyen der deutschen Klimaforscher vom Hamburger Max-Planck-Institut für Meteorologie mit der FAZ nicht gelesen:

FAZ: Welcher Kippunkt macht Ihnen am meisten Sorgen?

Marotzke: Keiner

Auch bei den Extremereignissen entspricht das Gericht kaum den aktuellen Erkenntnissen. Selbst der Deutsche Wetterdienst hatte 2018 erklärt – wie der IPCC noch 2013 – dass es schwierig sei, eine Zunahme von Extremwetterereignissen in Deutschland statistisch nachzuweisen. Und dies gilt auch – nach wie vor – weltweit für Dürren, Starkregenereignisse, Hurrikane, Tornados. Im Kapitel IV-Extremwetter unseres Buches „Unerwünschte Wahrheiten“ haben wir 488 Literaturstellen zitiert, die die weitverbreitete Meinung, Extremwetter hätten zugenommen, widerlegen.

Als Widerlegung der Aussage des Gerichts (Ziffer 27):

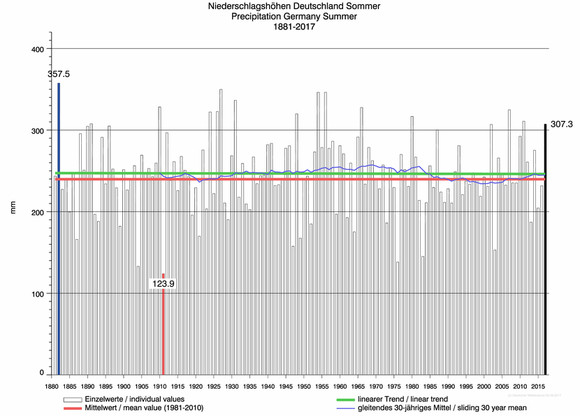

„Als eine besondere Herausforderung gilt die in Deutschland beobachtete Zunahme von Trockenheit und Dürre. Die hiermit einhergehende Austrocknung der Böden hat vor allem für die Landwirtschaft Bedeutung“, sei die Grafik der Sommerniederschläge gezeigt:

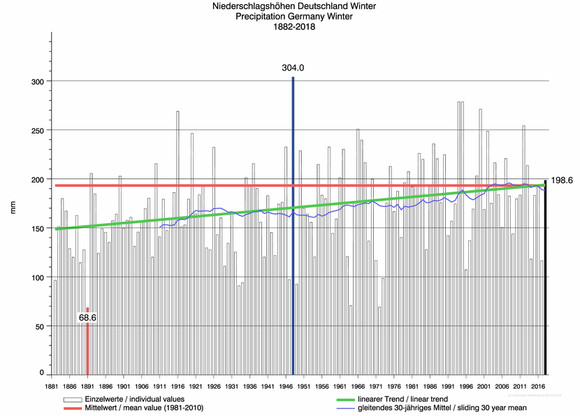

Aber nicht nur die Sommerdaten widerlegen diese Aussage des Gerichts, die Winterdaten ebenso.

Hier gibt es sogar einen Anstieg der Niederschläge. Quelle : hier

Es gibt auch keinen Dürreanstieg europaweit und sogar weltweit („Unerwünschte Wahrheiten“, S. 168). In Ziffer 28 des Beschlusses heißt es :

„Der Klimawandel ist zudem bedeutende Ursache von Flucht und Migration. Menschen verlassen ihre Heimat auch in Folge von Naturkatastrophen und aufgrund langfristiger Umweltveränderungen wie etwa vermehrter Dürren und des Anstiegs des Meeresspiegels.“(Quellenangabe Rahmstorf/Schellnhuber)

Benjamin Schraven vom Deutschen Institut für Entwicklungspolitik schreibt zu diesem Sachverhalt :

„Vieles deutet daraufhin, dass die immer noch weit verbreitete Annahme eines Automatismus zwischen Klimawandel und Migration stark angezweifelt werden muss. Ein solch genereller Ökodeterminismus ist empirisch nicht haltbar.“