Diesel-Verteufelung: Krieg gegen das eigene Volk Diesel: Die Lückenmedien im Glashaus (3)

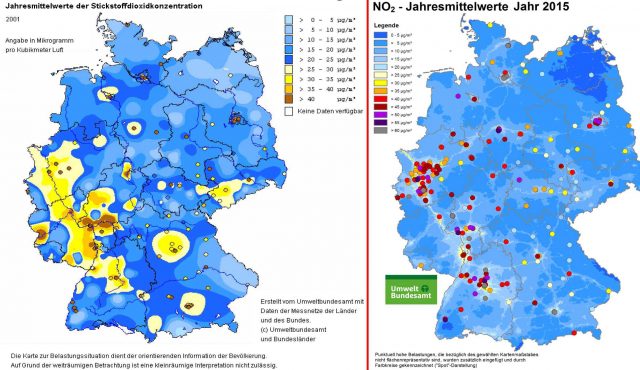

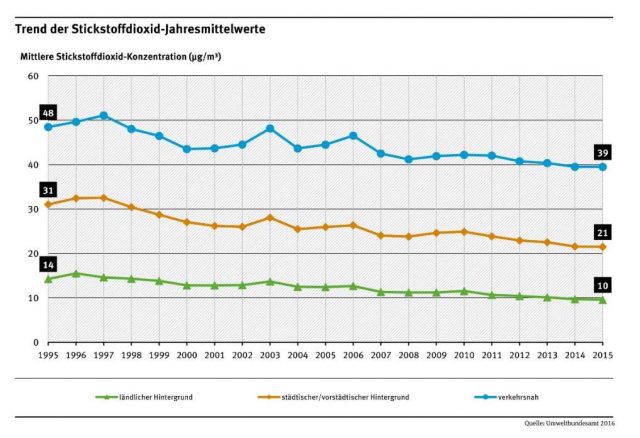

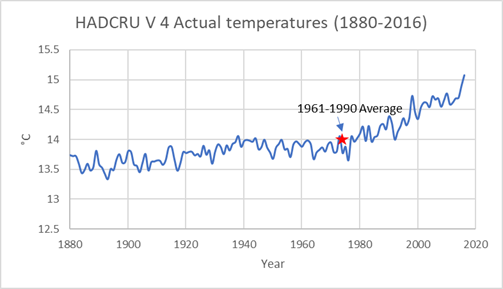

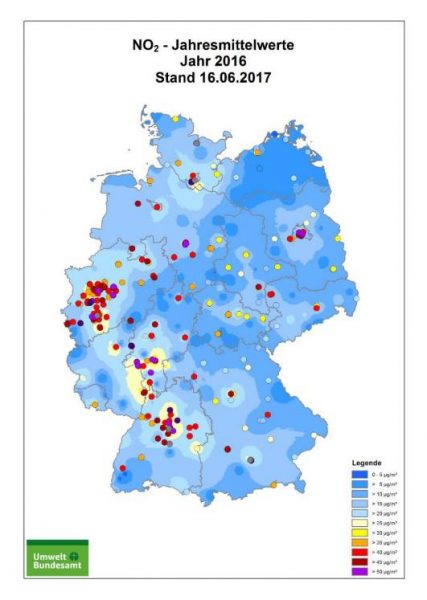

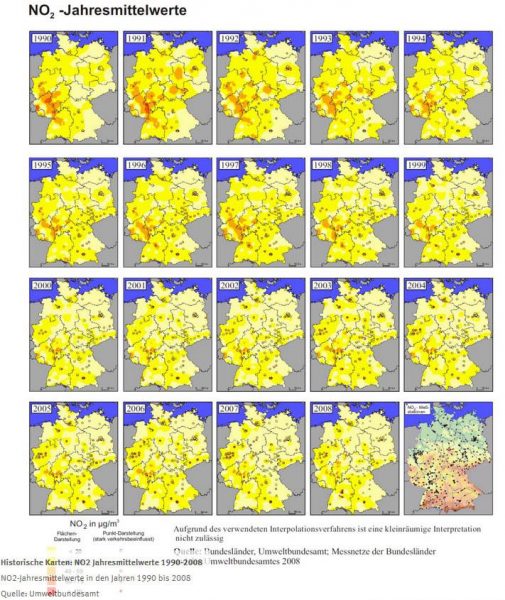

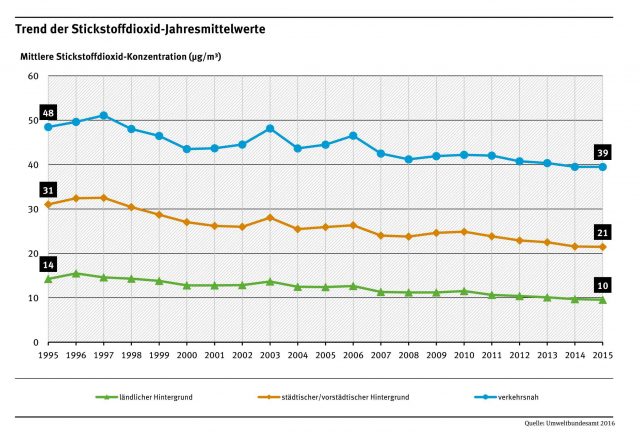

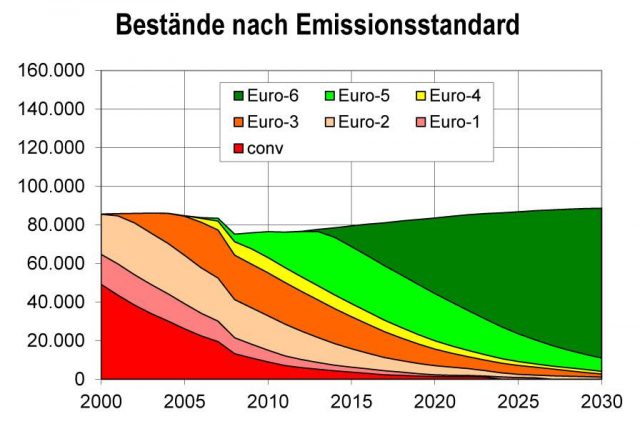

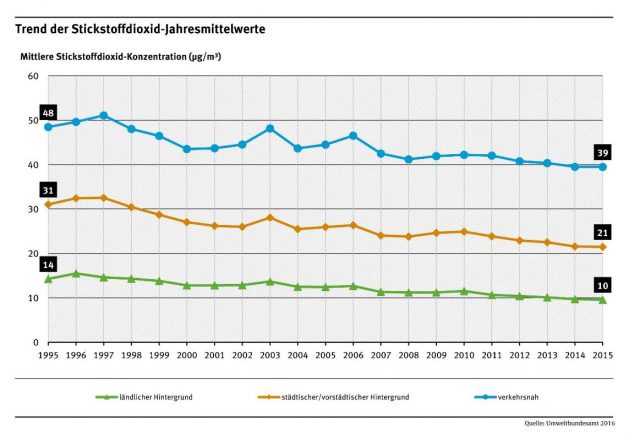

Im ersten Teil dieses Aufsatzes wurde nachgewiesen, dass die NO2-Belastung der Luft in ganz Deutschland und auch an den sogenannten „Hotspots“ in den Städten zurückgegangen ist. Grund ist die stetige Ablösung älterer durch jüngere Fahrzeuge mit besseren Abgasbehandlungssystemen. Dieser Trend wird sich auch in den nächsten Jahren fortsetzen. Der zweite Teil der Analyse beschäftigte sich mit der Fragwürdigkeit der Messmethoden und den dabei eingesetzten Tricks und Manipulationen. Im jetzigen dritten Teil werfen wir einen Blick auf die teils grotesk übertriebenen Behauptungen über die gesundheitlichen Auswirkungen von Stickstoffdioxid sowie auf die Methoden und Tricks, mit denen die öffentlich-rechtlichen Medien als Sprachrohr industriefeindlicher Behörden die Wirklichkeit verzerren und die Öffentlichkeit irreführen.

Die Horrorstory der ARD, Teil 1: Feinstaub…

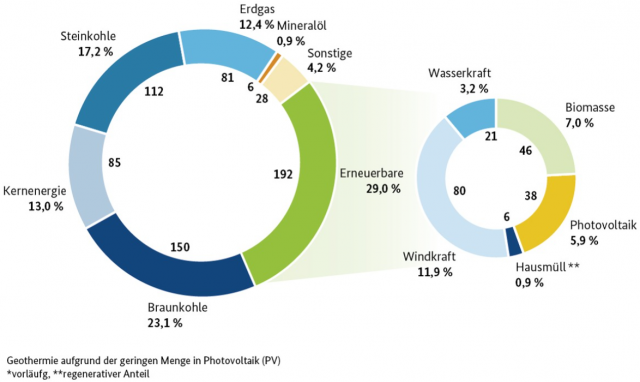

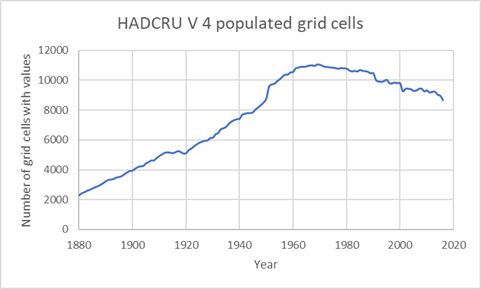

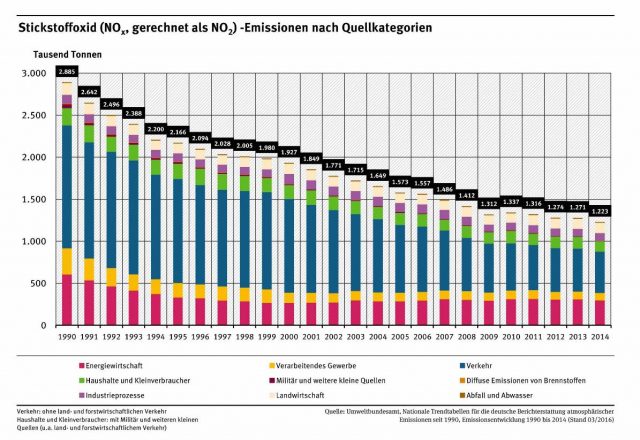

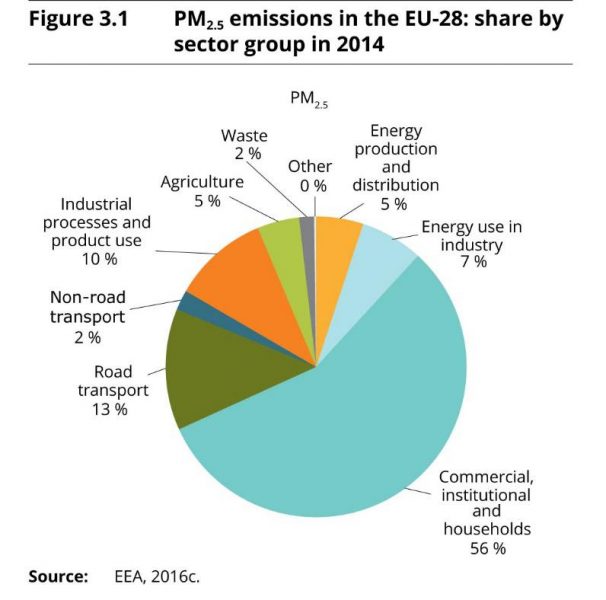

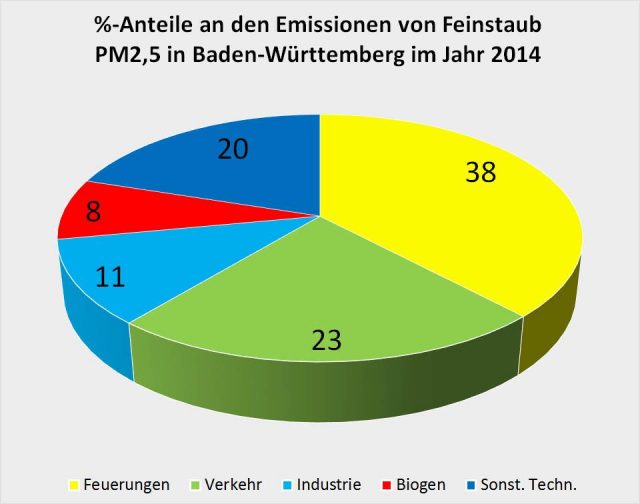

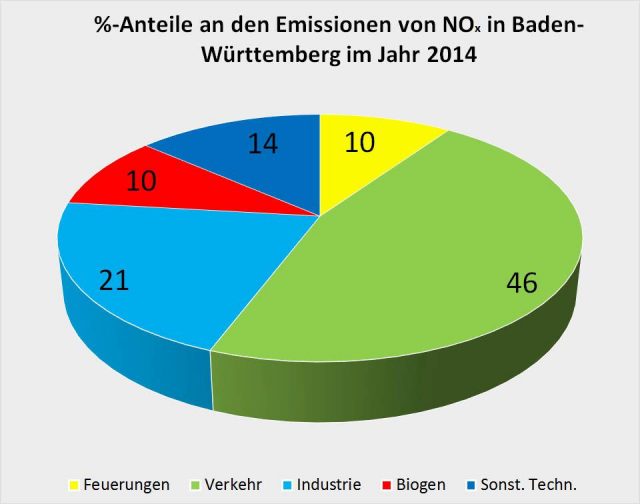

Im Rahmen ihres „Faktenfinder“-Artikels verweisen die Autoren auf einen Kurzfilm der ARD über die angeblichen Gefahren durch verkehrsbedingte Emissionen von Feinstaub und Stickoxiden [TAGS]. Darin erläutert der SWR-Reporter Martin Schmidt, unterbrochen von animierten Abgasfahnen und gespielten Hustenanfällen, dass Feinstaub nach Berechnungen des Umweltbundesamtes allein in Deutschland 47.000 vorzeitige Todesfälle verursachen soll. Zwar gebe es noch andere Feinstaubquellen wie Industrie oder private Heizöfen, doch sei der weitaus größte Teil dem Verkehr anzulasten. Diese Aussage ist nachweislich falsch, Bild 2 und Bild 3.

Die Horrorstory der ARD, Teil 2: Stickoxide

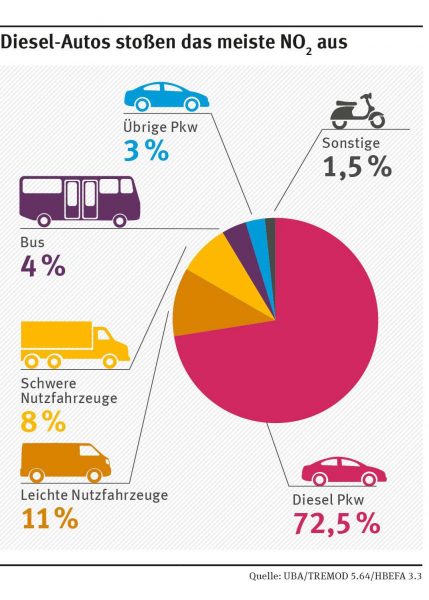

Nach der Verdammung des Feinstaubs kommt der SWR-Reporter dann gegen Ende der Sendung zu seinem eigentlichen Thema. Das Lamento über Feinstaub diente ihm vor allem als Kunstgriff zur Einstimmung der Zuschauer auf sein Hauptanliegen, die Anklage gegen das Stickstoffdioxid. Nach effektvoller Einleitung mit einer weiteren simulierten Hustenattacke kommt er zur Sache: „Auch Stickstoffdioxid ist sehr gefährlich“. Es könne zum Beispiel Atemwegsprobleme oder Herz-Kreislauferkrankungen auslösen. Nach Erkenntnissen des UBA sei in Innenstädten der Verkehr mit 84 % der Hauptversucher, und Schuld daran seien fast ausschließlich Dieselfahrzeuge.

Das sind gleich drei Unwahrheiten, genauer gesagt eine Halbwahrheit und zwei regelrechte Falschaussagen. Man muss sich wirklich fragen, wie man als Fernsehanstalt solche Dinge ungeprüft in einer Nachrichtensendung verbreiten kann. Schauen wir uns diese Vorwürfe im Einzelnen an.

Welche Gefahr geht von Stickstoffdioxid wirklich aus?

Was ist eigentlich Gift? Im Prinzip ist fast alles giftig. Wem ist schon bewusst, dass Salz ein tödliches Gift ist? Im Jahre 2005 starb im Saarland ein Kind, weil es gezwungen wurde, einen versehentlich versalzenen Pudding komplett aufzuessen. Zwar lebte es bei der Einlieferung in die Klinik noch, konnte aber dennoch nicht mehr gerettet werden [SALZ1].

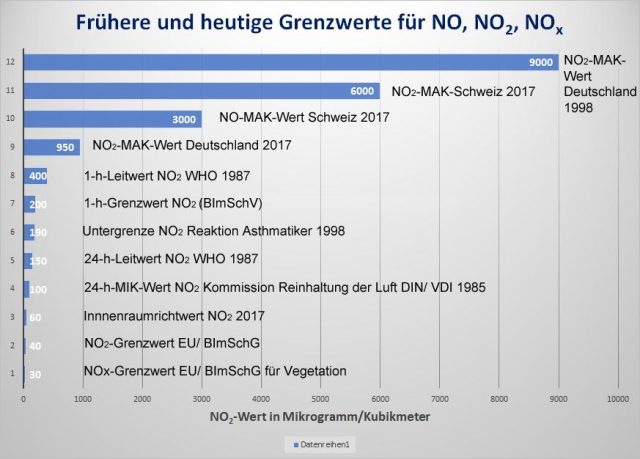

Zwar ist dies ein Extremfall, aber tödlich ist Salz auch in weit geringeren Mengen. Fachleute gehen davon aus, dass weltweit jährlich über 2 Millionen Menschen aufgrund von Herzerkrankungen sterben, die durch zuviel Salz im Essen verursacht werden [SALZ2]. Oder nehmen wir das Beispiel Alkohol: Das edle Genussmittel in Bieren, Weinen und Schnäpsen ist de Facto ein krebserregendes Nervengift, dem jedes Jahr 74.000 Deutsche zum Opfer fallen. Die Liste ließe sich beliebig fortsetzen, denn ab einer gewissen Menge ist fast jeder Stoff giftig. Erst das Zuviel macht aus einem natürlichen oder gar lebensnotwendigen Stoff ein unter Umständen tödliches Gift. Das gilt selbst für Wasser (dessen tödliche Dosis bei ca. 6 Liter liegt). Auch Stickstoffdioxid ist ein natürlich vorkommendes Spurengas in unserer Atmosphäre. Ein Grenzwert von Null, wie er von einigen Epidemiologen gefordert wird, ist pure Utopie. Statt solche sinnfreien Forderungen zu stellen, sollte man über die Zulässigkeit von Dosierungen sprechen, Bild 6.

Grenzwerte am Arbeitsplatz…

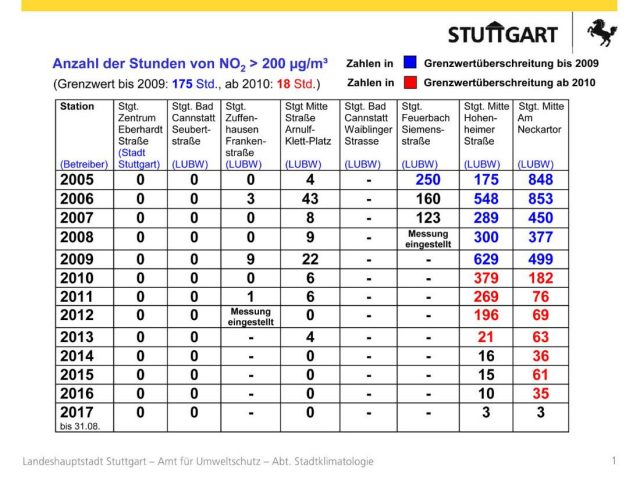

Über mögliche Beeinträchtigungen durch NO2 in Abgasen für die Allgemeinheit sollte man daher nur im Zusammenhang mit den Dosierungen sprechen, die tatsächlich in der Luft unserer Städte vorliegen. Das sind im Mittel nirgendwo mehr als 90 µg/m3 mit seltenen Spitzen bis etwas über 200 µg/m3. Dieser Wert ist gleichzeitig die Geruchsgrenze, d.h. man kann nicht unbemerkt vergiftet werden. In diesem Konzentrationsbereich ist NO2 nicht giftig, sondern lediglich ein Reizstoff für die Lunge. Der Grenzwert für die Dauerbelastung von Mitarbeitern bei körperlicher Arbeit (MAK-Wert) lag früher in Deutschland bei 9.000 µg/m3 und wurde erst Anfang der 2000er Jahre auf 950 µg/m3 reduziert, in der Schweiz liegt er sogar bei 6.000 µg/m3. Bis zu dieser Schwelle ist NO2 also kein Gift, sondern lediglich ein Reizstoff, dem man als gesunder Erwachsener bis zu rund 1.500 Stunden pro Jahr ausgesetzt sein kann, ohne nachteilige gesundheitliche Auswirkungen befürchten zu müssen. MAK-Werte werden von einer Kommission festgelegt, die mit Fachleuten aus verschiedensten Bereichen wie z.B. der Toxikologie und der Arbeitsmedizin oder der Lungenheilkunde besetzt sind. Sie werden so definiert, dass sie nach aktuellem Kenntnisstand der Medizin sicher unterhalb der Gefährdungsgrenze liegen.

…und Grenzwerte in Büro- und Privaträumen

Da die Bevölkerung nicht nur aus Gesunden besteht, wurden auch die Auswirkungen wesentlich darunter liegender Konzentrationen z.B. auf Asthmatiker oder Kinder mit großer Sorgfalt untersucht. Auch hier obliegt dies einem eigenen Fachgremium, in diesem Fall dem Ausschuss für Innenraumrichtwerte des Umweltbundesamtes. Dort wurden verschiedenste Kurzzeit- und Dauerbelastungs-Grenzwerte definiert, die mit großen Sicherheitsmargen nach unten sicherstellen sollen, dass selbst die Schwächsten unserer Gesellschaft bei Dauerbelastung keinen Schaden nehmen. Dieser für Büroräume ebenso wie für Privatwohnungen geltende Grenzwert liegt bei 60 µg/m3. Im Unterschied zum MAK-Wert gilt er auch für Dauereinwirkung rund um die Uhr, da wir zwischen 70 und über 90 % unserer Zeit in solchen Räumen verbringen.

Woher kommt der tiefere Grenzwert in der Außenluft?

Da die 60 µg/m3 deutlich über den für die Außenluft geltenden 40 µg/m3 liegen, stellt sich die Frage, wie es zu diesen krass unterschiedlichen Festlegungen gekommen ist. Die Antwort ist ganz einfach: Es handelt sich um ein Diktat von oben, d.h. es mussten Vorgaben der EU übernommen werden. Deutsche Fachgremien hatten nichts zu melden. Und bei den zuständigen EU-Gremien orientierte man sich an Vorgaben der Weltgesundheitsorganisation WHO. Wir haben also die absurde Situation, dass dort, wo man sich eher selten aufhält, nämlich auf dem Bürgersteig einer sehr stark befahrenen Straße, wesentlich strengere Grenzwerte gelten als in den Innenräumen und Büros, wo ein deutlich höherer Pegel als gesundheitlich unbedenklich eingestuft wird. Hinter diesen unterschiedlichen Ansichten stecken auseinandergehende Auffassungen über die Methoden, die zur Ermittlung gesundheitlicher Risiken eingesetzt werden.

Messen oder Simulieren?

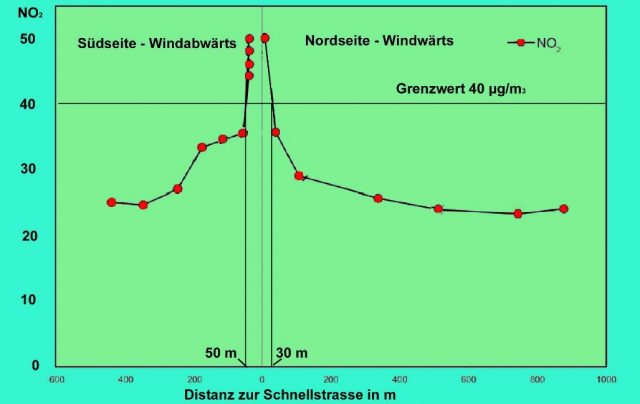

Vereinfacht ausgedrückt geht es um die Frage, ob man sich an den Verfahren der Pharmaforschung oder an statistisch ermittelten Daten orientiert. Toxikologen gehen nach den Methoden vor, die z.B. auch für die Entwicklung von Medikamenten vorschrieben sind. Sie erforschen die Wirkungsweise bestimmter Substanzen im Körper und bestimmen eindeutige Ursache-Wirkungs-Zusammenhänge. Epidemiologen erfassen dagegen große Bevölkerungsgruppen und versuchen, mögliche Gesundheitsrisiken mit statistischen Verfahren zu erkennen. Das kann jedoch zu Fehlschlüssen führen, z.B. weil Abgase ja als Gemisch auftreten. Ein Beispiel: man ermittelt Daten wie Krankheitshäufigkeit oder Todesursache von Menschen, die in der Nähe stark befahrener Straßen wohnen, in Abhängigkeit von der Entfernung ihrer Wohnung zur Straße. Doch kann man bei der Wahl solcher Kriterien auch böse danebenliegen. Ein Beispiel: Wohnungen direkt an Schnellstraßen sind unbeliebt und die Mieten daher sehr günstig. Also ziehen hier Menschen hin, die sich nicht mehr leisten können, Bild 8.

Dann könnte ein Statistiker mit hoher Sicherheit Auswirkungen erhöhter Abgasbelastungen auf das Einkommen „errechnen“. Sogar mit einer erheblich höheren Sicherheit als bei der Ermittlung gesundheitlicher Auswirkungen der einzelnen Stoffe im kunterbunt zusammengesetzten Abgasgemisch.

Wegen dieser Mischung verschiedenster Abgasbestandteile ist daher oft nicht genau zu klären, welche Komponente des Abgases denn wirklich für die festgestellte gesundheitliche Beeinträchtigung verantwortlich ist. Das Pech für das NO2 ist, dass man es recht gut messen kann und daher gerne als generellen Indikator für Abgasbelastungen heranzieht. Dann kann es schnell passieren, dass man ihm Effekte anlastet, die eigentlich von anderen Bestandteilen wie z.B. dem krebserregenden Benzo-a-Pyren hervorgerufen werden. So werden in manchen epidemiologischen Studien Krebsrisiken „festgestellt“, die der Toxikologe bestreitet. Der WHO wird oft vorgehalten, sie setze zu stark auf solche epidemiologischen Studien. Aber sie hat halt bei den EU-Gremien Gehör gefunden.

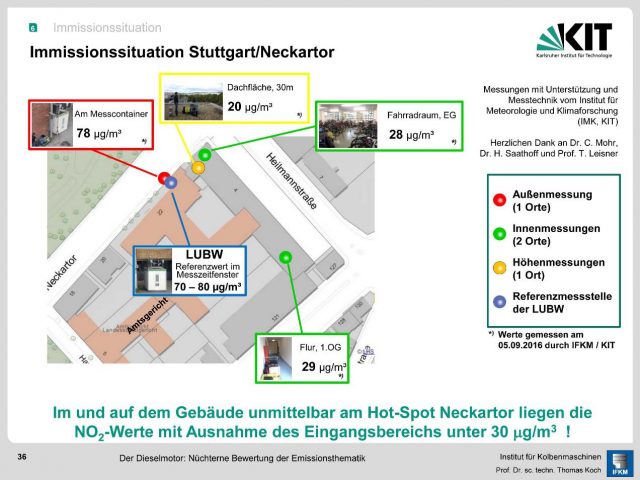

Namhafte Wissenschaftler: Grenzwerte sind übertrieben

Jedenfalls bestreitet der führende Toxikologe und langjährige Vorsitzende der MAK-Kommission Professor Helmut Greim von der TU München die wissenschaftliche Basis des für die Außenluft festgelegten NO2-Grenzwerts von 40 µg/m3 NO2 im Freien: „Epidemiologen errechnen ihre Werte, wir Toxikologen messen sie und setzen danach Grenzwerte fest“. Seiner Ansicht nach sei eine Belastung von 40 µg/m3 NO2 im Freien völlig unbedenklich, solange der Arbeitnehmer bei der Innenluft dem 20fach höheren Grenzwert (950 µg) ohne Gesundheitsbedenken ausgesetzt sein darf [GREI]. Erheblich Zweifel an politischen Grenzwertsetzungen beim NO2 äußert auch Professor Tobias Welte. Aus seiner Sicht sei das der vollkommen falsche Parameter. Er glaube, dass Feinstaub eine wesentlich größere Bedeutung habe als Stickoxid. Deshalb wäre es wichtig, sich darauf zu konzentrieren [WELT]. Auch Welte ist, was die Beurteilung von luftgetragenen Schadstoffen angeht, als Leiter der größten Universitäts-Lungenklinik Deutschlands mit 30 Jahren Berufserfahrung und 700 Veröffentlichungen eine Kapazität von Rang. Und Prof. Koch vom Institut für Kolbenmaschinen am Karlsruhe Institut für Technik zitiert aus der Mail eines Pathologieprofessors und Leiters eines Pathologieinstituts folgende Passage: „Es sind wahrhaft Horrorzahlen und Horrorgeschichten, die über die Toxizität der Dieselabgase und deren angebliche Todesfälle insbesondere bezüglich des Feinstaubes in der Öffentlichkeit aus verschiedensten Interessen verbreitet werden. Man hat heute allgemein den Eindruck, die Luftbelastung habe in den letzten Jahren zugenommen und die Menschen seien dadurch vermehrt krank geworden, was in keinster Weise auf einer wissenschaftlichen Grundlage beruht. Im Gegenteil, die Menschen sind bis in das hohe Alter gesünder, insbesondere was ihre Lungen betrifft, und leben auch dadurch deutlich länger als früher [KOCH].

Festzuhalten bleibt: Der heute in Deutschland geltende Immissionsgrenzwert ist uns ohne Anhörung unserer Fachgremien politisch von außen aufgedrückt worden. Er dient nicht der Gesundheit der Bevölkerung, sondern befriedigt das Machtstreben von Ideologen. Hätte man stattdessen den für Innenräume seit 20 Jahren geltenden Wert übernommen, dann gäbe es heute gar keine NO2-Diskussion mehr. Nicht der Dieselmotor ist das Problem, sondern weltfremde Grenzwerte sowie die damit befeuerte Angstkampagne in den Medien.

Ist der Verkehr Hauptverursacher von NO2-Emissionen?

Als nächstes ist zu klären, ob der Verkehr in Innenstädten tatsächlich – wie in der Sendung unter Berufung auf das UBA behauptet – mit 84 % der Hauptverursacher von NO2-Emissionen ist. Da ist zunächst die Frage zu stellen, wann das UBA welche diesbezügliche Behauptung aufgestellt hat. Offensichtlich hatten dort vergleichbare Meldungen mit unterschiedlichen Zahlen in letzter Zeit Hochkonjunktur. Auf der sehr anwenderunfreundlichen UBA-Webseite ist es oft kaum möglich, den jeweils „richtigen“ zu finden. Die Suchfunktion gleicht einem Lotteriespiel, Bilder erscheinen grotesk geschnitten und es werden auch immer mal wieder Beiträge schon nach kurzer Zeit zurückgezogen. Deshalb nehmen wir hier eine etwas anderslautende UBA-Mitteilung vom 26. April 2017 mit der folgenden Grafik, Bild 9.

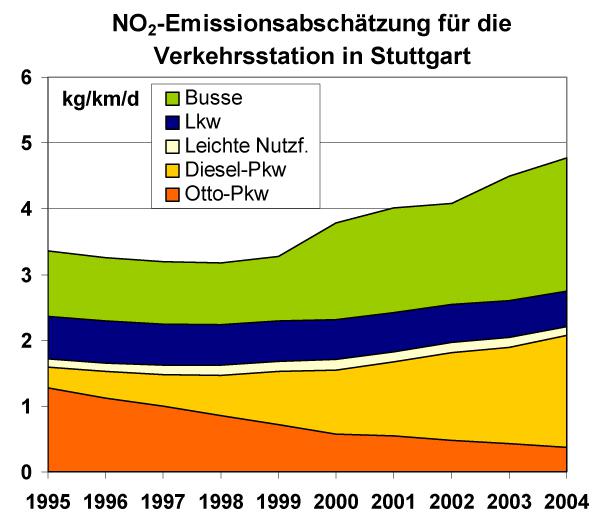

Auffallend ist an dieser Darstellung insbesondere der niedrige Anteil der Busse. Das sah in einer Berechnung, die das Institut für Energie- und Umweltforschung Heidelberg 2006 im Auftrag des Umweltministeriums Baden-Württemberg durchführte, nämlich noch ganz anders aus, Bild 10.

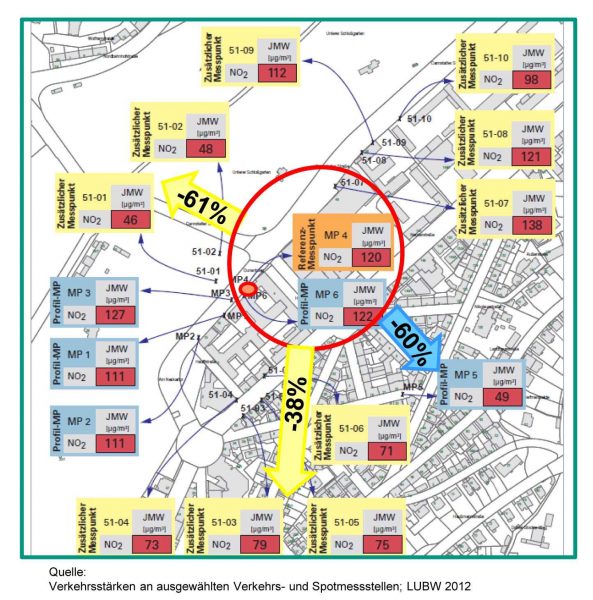

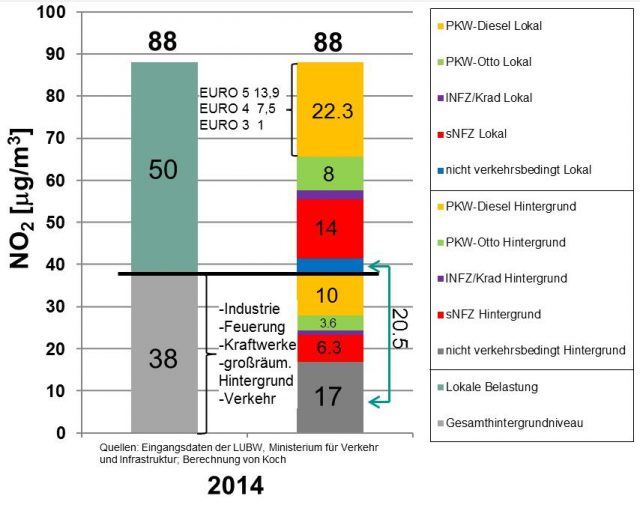

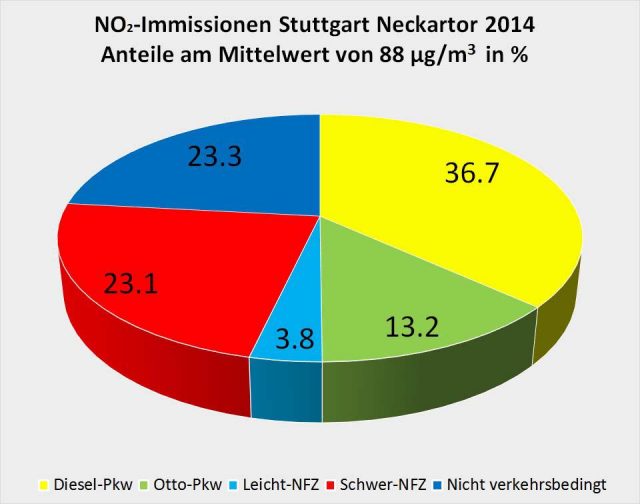

Bei dieser Untersuchung von Professor Koch wurde zwischen Hintergrundgehalten – entfernter liegende Quellen, deren Abgase bereits großräumig verteilt wurden – und lokalen Quellen unterschieden. Da es bei dieser Art der Darstellung schwieriger wird, den Beitrag der einzelnen Quellen optisch leicht fasslich darzustellen, wurde zusätzlich eine zusammenfassende Grafik erstellt, Bild 14.

Worüber regt man sich beim UBA eigentlich auf?

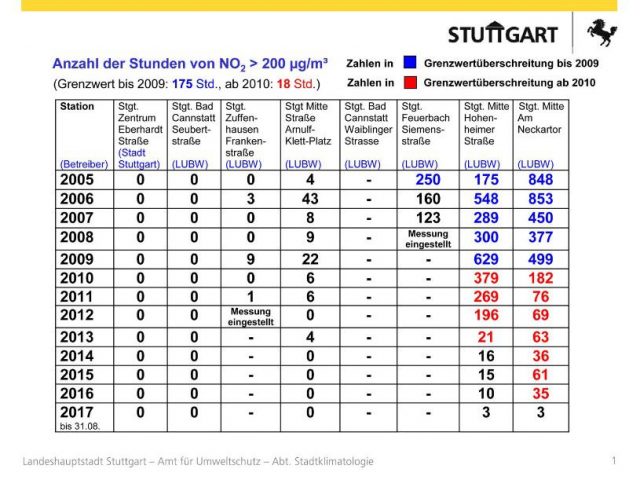

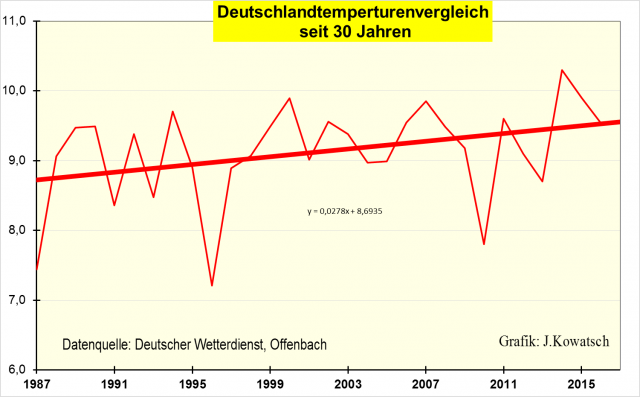

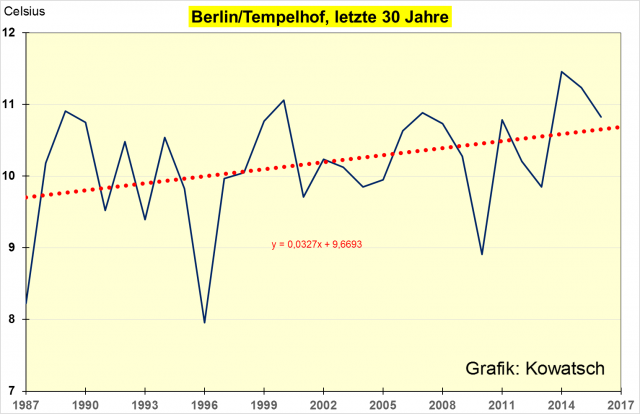

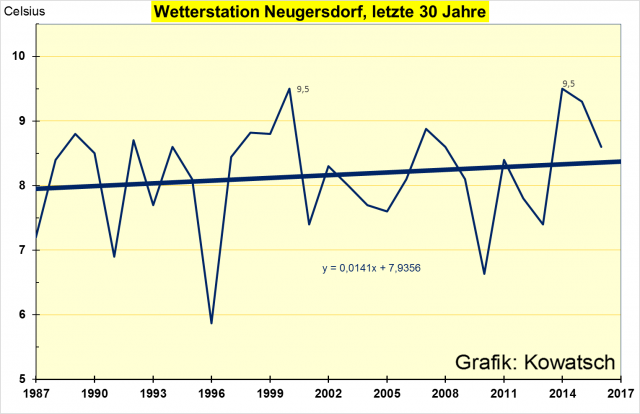

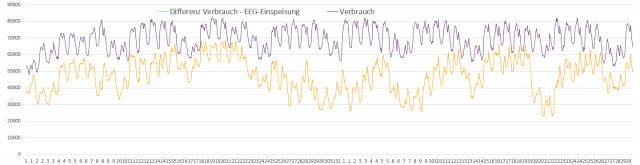

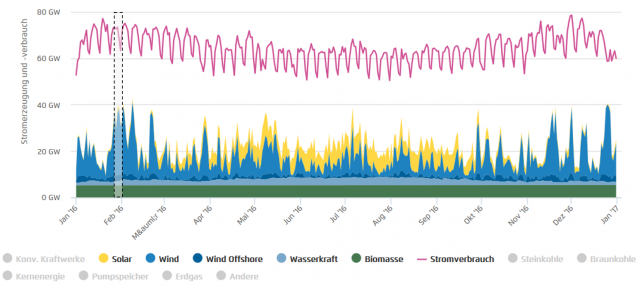

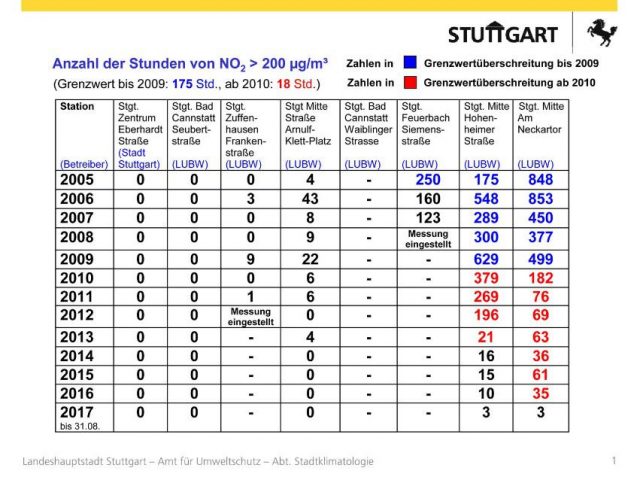

Festzuhalten bleibt zunächst, dass ungeachtet der lautstarken Kampagne in den Medien wegen gewisser Unterschiede zwischen den Vorgaben und den im Realbetrieb festgestellten Emissionswerten von neuen Dieselfahrzeugen die Gesamtbelastung in den Städten auch in den letzten Jahren kontinuierlich weiter gesunken ist. Das ist durch Bild 15 und Bild 16 eindeutig belegt.

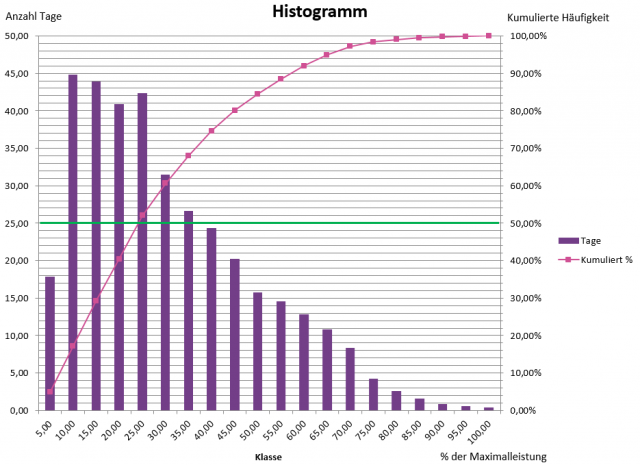

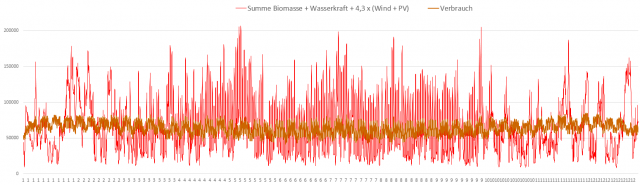

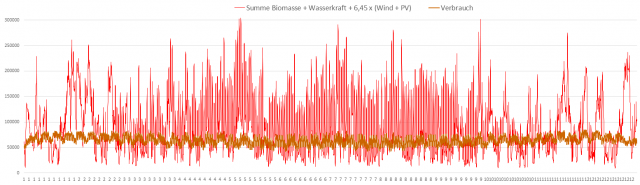

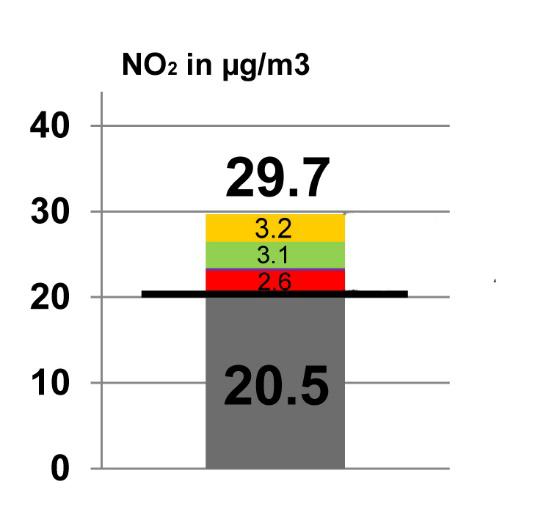

Somit haben die gerade bei neueren Fahrzeugen beobachteten Differenzen beim Emissionsverhalten keine nachteiligen Auswirkungen auf die Immissionswerte. Viel entscheidender ist die weiter fortschreitende Verjüngung des Bestandes durch Ersatz älterer Fahrzeuge mit schlechteren Abgaswerten. Anders ausgedrückt: Selbst ein noch nicht ganz perfekter EURO-6-Diesel ist immer noch viel besser als ein perfektes Modell mit EURO-5 oder gar EURO-3. Zudem kommen demnächst Fahrzeuge mit nochmals verbesserter Abgasbehandlung EURO-6dtemp auf den Markt. Wie sich dies auf die NO2-Belastung der Luft auswirken wird, zeigt Bild 17.

Die zwielichtige Rolle der Umweltbehörden

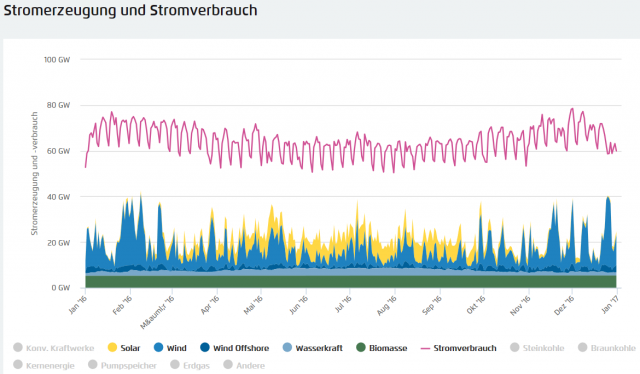

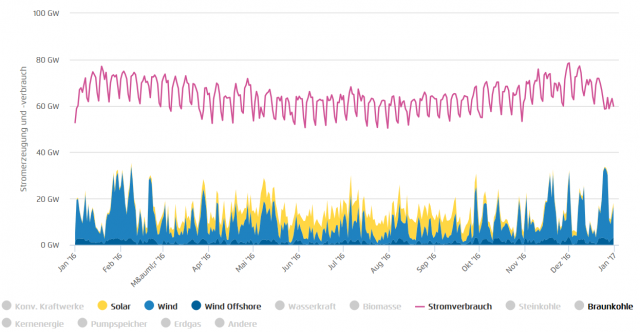

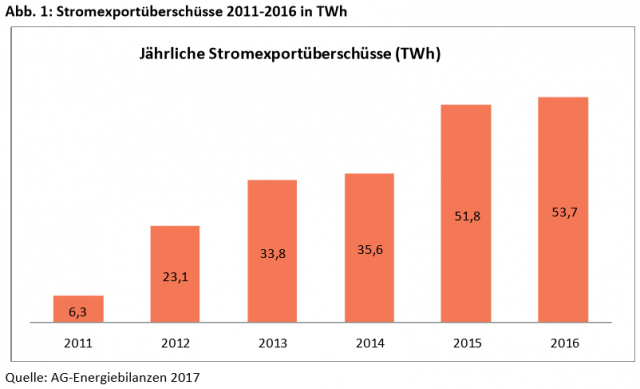

Bei nüchterner Betrachtung der Fakten stellt sich die Frage, was mit den massiven Attacken von Umweltministerin Hendricks und UBA gegen den Diesel-PKW eigentlich bezweckt wird. Gesundheitsschutz der Bevölkerung kann es nicht sein, denn die Industrie hat es trotz unnötig übertriebener Grenzwertvorgaben geschafft, die NO2-Gehalte in den Städten langsam, aber kontinuierlich immer weiter zu senken. Durch neue Entwicklungen wird sich dieser Trend in den nächsten Jahren weiter fortsetzen. Die Gehässigkeit, mit der dennoch behördlicherseits auf die Hersteller losgegangen wird, hat offensichtlich einen tieferen Grund. Hendricks und UBA stehen unter Druck, weil sie mit ihrer Strategie zur Senkung der CO2-Emissionen Schiffbruch erlitten haben. Da kommt es ihnen zupass, die Individualmobilität mit Verbrennermotoren an den Pranger zu stellen. Man verspricht sich davon gleich zwei Vorteile: Ablenkung vom eigenen Scheitern und Schädigung einer Industrie, die in Sachen Elektromobilität nicht so will, wie es die Politik möchte, sondern das herstellt, was die Verbraucher verlangen.

Welches Spiel spielen ARD, ZDF und Co?

Von den dort arbeitenden Journalisten wäre eigentlich zu erwarten, dass sie sich nicht als Staatsfunk betätigen. Das hatten wir in Deutschland schon zweimal, einmal in Braun und einmal in Rot, und es hat dem Volk nicht gutgetan. Die Journalisten der Sender sollten Aussagen von Behörden, die in der Dieselthematik eine offen industriefeindliche Position einnehmen, eigentlich einer kritischen Kontrolle unterziehen. Das ist nicht geschehen, weshalb es jetzt an dieser Stelle nachgeholt wurde. Das Ergebnis dieser Nachkontrolle lässt sowohl das UBA als auch den Sender in einem ziemlich unvorteilhaften Licht erscheinen. Schließlich ist durch Statistiken belegt, dass der Anteil des Gesamtverkehrs an den NO2-Emissionen Deutschlands bis 2015 auf 40 % gesunken ist. Auch ist der Straßenverkehr nicht der einzige Verkehrsträger, es gibt darüber hinaus auch noch die Bahn, das Schiff und das Flugzeug. Oder sollten auf den Stuttgarter Bahngleisen tatsächlich keine Rangierloks mit Dieselantrieb fahren?

Eine Begründung für Autofahrverbote wegen Feinstaubalarm oder aufgrund von NO2-Werten lässt sich jedenfalls derzeit nicht ableiten. Juristen sollten in den hier dargelegten Fakten und Dokumenten genug Stoff finden, um Klagen der DUH vor Gericht scheitern zu lassen.

Fakten und „Faktenfinder“

Die bisherige Analyse der von den „Faktenfindern“ von NDR und Tagesschau präsentierten Aussagen lässt erkennen, dass man sich dort alles andere als kritisch-investigativ mit dem Thema NO2-Immissionen der Stadtluft beschäftigt hat. Stattdessen übernimmt man einfach die Positionen von Hendricks und dem UBA, als seien deren Ansichten der Weisheit letzter Schluss. Eine eigenständige kritische Wertung von Daten und Hintergründen ist nicht einmal in Ansätzen erkennbar. Dies bestätigt die bereits bisher gemachte Erfahrung, dass die Mehrzahl der Medien – allen voran die Fernsehanstalten ARD, ZDF und ihre Landesdependancen – beim sogenannten „Diesel-Skandal“ einseitig, parteiisch und irreführend berichten. Statt um Ausgewogenheit und Sorgfalt bemüht man sich offenkundig eher darum, das Thema so darzustellen, wie die Bundesbehörden sowie die anderen etablierten Parteien es gerne haben möchten. Abweichende Meinungen von Medien, Journalisten oder Blogger werden als unglaubwürdig hingestellt. So leistet man dem ideologischen Ziel der Deindustrialisierung Deutschlands durch „Dekarbonisierung der Volkswirtschaft“ Vorschub. Der Diesel ist dabei nur das erste Opfer. Es wird danach weitergehen, und zwar alternativlos.

Fred F. Mueller

Demnächst folgt Teil 4

Quellen

[FAKT] http://faktenfinder.tagesschau.de/inland/stickstoffdioxid-111.html

[HEUTE] „Heute“-Nachrichtensendung des ZDF vom 9.8.2017, Interview mit Thomas Geisel, SPD-Oberbürgermeister der Stadt Düsseldorf, Stichwort „Verkehrserziehung in Richtung Zukunft“

[IFEU] Ifeu Institut für Energie- und Umweltforschung Heidelberg GmbH Analyse der Ursachen für hohe NO2-Immissionen in Baden-Württembergischen Städten im Auftrag des Umweltministeriums Baden-Württemberg, Juli 2006

[KOCH] https://www.ifkm.kit.edu/downloads/Focus_Antworten_v2.0.pdf Institut für Kolbenmaschinen Prof. Dr. sc. techn. Thomas Koch. Der Dieselmotor: Nüchterne Bewertung der Emissionsthematik

[LUKA] Luftschadstoff-Emissionskataster Baden-Württemberg 2014. Landesanstalt für Umwelt, Messungen und Naturschutz Baden-Württemberg

[PEEL] JENNIFER L. Peel Is NO2 a Marker for Effects of Traffic Pollution or a Pollutant on Its Own. COLORADO STATE UNIVERSITY MAY 4, 2015 HEI ANNUAL MEETING PHILADELPHIA, PA

[TAGS] http://www.tagesschau.de/multimedia/video/video-312819.html

[THAL] European Environment Agency EEA Report No28/2016 Air Quality in Europe – 2016 report https://www.eea.europa.eu/publications/air-quality-in-europe–2016

[TREM] Aktualisierung „Daten- und Rechenmodell: Energieverbrauch und Schadstoff-Emissionen des motorisierten Verkehrs in Deutschland 1960-2030“ (TREMOD, Version 5.3) für die Emissionsberichtserstattung 2013 (Berichtsperiode 1990-2011) ifeu Institut für Energie- und Umweltforschung Heidelberg GmbH

[SALZ1] https://www.nwzonline.de/panorama/versalzener-pudding-kostet-angelinas-leben_a_6,1,2300022554.html

[SALZ2] https://www.medpagetoday.com/cardiology/prevention/38011