Insbesondere durch Opfer wurde das Volk dazu gebracht, die höheren Wesen gnädig zu stimmen. Die häufig erfolgende Bestrafung der Sünder äußerte sich in Katastrophen verschiedenster Art: Seuchen, Missernten, Sintfluten , Erdbeben oder auch das längere Ausbleiben von Regen und andere schmerzliche Ereignisse, die den Menschen ihre Machtlosigkeit gegen die Götter vor Augen führte.

Die christlichen Religionen hatten für diesen Zweck die Hölle eingeführt. Während die Evangelischen kaum Chancen haben, angesichts ihrer Sünden der Hölle zu entkommen, hat die katholische Kirche ein kluges System etabliert, mit dem sich die Sünder freikaufen können: Im Mittelalter buchstäblich mit Geld (der von Martin Luther bekämpfte Ablasshandel), heute mit dem Absolvieren bestimmter Rituale (Wallfahrten, Rosenkränze beten etc.).

Im Grunde hat sich auch in unseren angeblich aufgeklärten Zeiten nicht viel an dieser Methode der Kontrolle und Steuerung einer Bevölkerung geändert, denn die Benutzung von Angst zur Erreichung politischer Ziele war und ist unübertroffen wirksam. Die Priesterschaft vergangener Zeiten ist heute durch eine enge Arbeitsgemeinschaft von Regierenden und Medien ersetzt worden; (Anmerkung der Redaktion: „Die Wissenschaftler“ nicht zu vergessen, deren Autorität von den Regierenden und Medien genutzt werden, um ihre Behauptungen udn Forderungen unangreifbar zu machen, die aber auch oft selber in einer Doppelrolle: Verkünder der letzten Weisheit und politischer Vollstrecker – Beispiel unter vielen H.J. Schellnhuber & Cie- diese Rolle übernehmen) die Götter haben zumindest in unserem Lande nicht mehr viel zu melden, aber die Dämonen sind geblieben. An die Stelle der Götter sind flexibel nutzbare Begriffswolken wie Umwelt, Klima und Natur getreten; seltener die Mutter Erde persönlich in Gestalt von Gaia.

Was aber im Vergleich zum Mittelalter sehr viel stärker in der Angstpolitik genutzt wird, ist der Ablasshandel. Er hat viele Erscheinungsformen:

– Bioprodukte kaufen,

– Ökostrom nutzen,

– vorbildliche Mülltrennung,

– Photovoltaik-Paneele auf dem Dach,

– Elektroauto oder Hybridauto fahren,

– Jute-Tragetaschen,

– Fair-Trade-Artikel kaufen;

das sind nur einige Beispiele für Handlungsweisen, die ein sog. Gutmensch praktizieren muss, damit er als solcher von Seinesgleichen auch anerkannt wird. An die Stelle der Hölle ist die Ächtung durch die Medien, also die angebliche Öffentlichkeit, getreten; was nach dem Tode folgt, spielt keine Rolle mehr. Dieses System hat den Vorteil, dass die Strafe für Ungläubige und Ketzer bereits im Diesseits und nicht mehr im dubiosen Jenseits erfolgt. Auch muss man sich nicht mehr Sonntags in eine Kirche bemühen, um vom Dorfpfarrer zusammengestaucht zu werden. Das erledigen die täglich präsenten Medien mit Schreckensnachrichten aus aller Welt, mit den haaresträubenden Berichten und nicht sofort nachprüfbaren Prophezeiungen angeblicher Wissenschaftler sowie den mahnenden Ansprachen von Politikern, die ihrerseits das von den Medien vorsortierte und von Kritik gesäuberte Faktenmaterial als ihre Meinung vortragen.

Damit auch die Ungläubigen, die den Ablasshandel boykottieren, in das Ablass-System einzahlen müssen, gibt es spezielle Steuern, Abgaben und Umlagen, durch die sie als Sünder gegen die Umwelt bestraft werden, wodurch auch gleichzeitig der Finanzminister profitiert. Wie man die Gutmenschen davon verschont, ist noch nicht geklärt; schließlich braucht der Finanzminister auch deren Geld.

.

Weil sich die Natur des Menschen im Laufe der kurzen Zeitspanne seiner Existenz in keiner Weise verändert hat, gehört auch heute zum politischen System der Angstmacherei immer das Verdienen von Geld in großem Stil. Die Profiteure der Angst stellen sich rasch auf diese mit Subventionen gefüllten Rendite-Goldgruben ein und stellen eine die Politik stützende Lobby dar. Zum Beispiel mit der Produktion von politisch begünstigten Anlagen, die normalerweise niemand kaufen und installieren würde – gigantische Windräder, deren „Zappelstrom“ völlig unbrauchbar ist oder Photovoltaik-Paneele auf dem Dach, die nachts und bei schlechtem Wetter funktionslos vor sich hingammeln – aber bei den Nachbarn Eindruck machen.

Die sogenannte Energiewende und der ebenfalls sogenannte Klimaschutz – verstärkt durch den Kernkraft-Ausstieg – haben speziell in Deutschland einen quasi-religiösen Charakter erhalten. Kritik durch Fachleute gab es von Anfang an, aber im Parlament, wo angeblich nur ihrem Gewissen verpflichtete Abgeordnete sitzen, gab es bis heute keine vernehmliche kritische Stimme – von keiner einzigen Partei.

Die insbesondere durch die Umwelt- und Energiepolitik zwangsläufig und unvermeidbar entstandenen riesenhaften Probleme sind bereits in zahlreichen klugen Artikeln beschrieben worden. Die liest nur leider nicht jeder.

Dass die Gesetze der Physik die Todfeinde der Energiewende sind, ist zum Beispiel in einem Artikel vor nicht allzu langer Zeit dargestellt worden. Diese Tatsache hätte zwar den Politikern und insbesondere den Ministerialbeamten rechtzeitig zu denken geben müssen, aber wenn man von der Physik keine Ahnung hat, dann gibt es auch keine Bedenken,

Die Ahnungslosigkeit in Bezug auf die Physik betrifft auch die Mehrheit der Bevölkerung, was an der vor allem in den westlichen Bundesländern jahrelang und bis heute miserablen Schulausbildung liegt. Ausnahmen sind Bayern und die Ost-Länder; letztere hatten in DDR-Zeiten eine wirklich gute Schulausbildung in den naturwissenschaftlichen Fächern – was auch dafür der Grund sein mag, dass sich die „Ossis“ deutlich weniger von fragwürdigen Weltuntergangstheorien wie die angebliche Klimakatastrophe oder von pseudotechnologischen Heilslehren wie die Segnungen durch „erneuerbare Energien“ beeindrucken lassen. Außerdem haben sie gelernt, in einer manipulierten Presse zwischen den Zeilen zu lesen, was ihnen heute angesichts einer abermals regierungsfrommen, nun aber links-grün ausgerichteten Presse nach wie vor zu Gute kommt.

Ein beeindruckendes Beispiel für die nach DDR-Muster erzeugte typische Jubel-Staatspropaganda bot der im Januar 2017 von der Bundesregierung (BMWi) veröffentlichte Bericht „Die Energiewende: unsere Erfolgsgeschichte“. Er ist wie folgt in Abschnitte gegliedert:

– Nachhaltig und sicher

– Bezahlbar und planbar

– Verlässlich und intelligent

– Effizient

– Wettbewerbsfähig

– Weltweit wegweisend (!).

In Anbetracht der Tatsachen ist dieser Bericht unbeabsichtigt eine grausame Parodie; er zeigt aber auch eine klare Verachtung der Bürger, denen damit eine kaum fassbare Konzentration von geradezu devoter Schönfärberei, Faktenunterdrückung, Verdrehungen und nicht zuletzt peinlichem Größenwahn („weltweit wegweisend“) zugemutet wird.

Dennoch ist dieser Bericht wertvoll. Er beschreibt das Niveau einer Regierung und erinnert an die legendäre Pressekonferenz des irakischen Propagandaministers, Journalistenbezeichnung „Chemical Ali“, der frohgemut Siegesmeldungen in die TV-Kamera verkündete, während man durch sein Bürofenster im Hintergrund bereits US-Panzer sehen konnte.

Es gibt eine Menge Leute, die genau wissen, dass die Energiewende von Frau Merkel unweigerlich auf ein Scheitern hinläuft. Es gibt über 1000 Bürgerinitiativen, die gegen Windparks, gegen die Zerstörung von Waldgebieten und gegen neue Stromtrassen kämpfen. Aber es gibt eine offenbar deutlich größere Anzahl von Bürgern, die mangels Wissen, aus Desinteresse und wohl auch, weil die Kosten noch nicht schmerzhaft genug sind, Merkels staatliche Umwandlungspläne kritiklos hinnehmen.

Aber es gibt ein noch weitaus stärkeres Motiv für die Zurückhaltung: Es ist die Angst.

Die Angst ist seit Menschengedenken ein probates Mittel, um die Untertanen von ketzerischen Gedanken oder gar Widerstand abzuhalten. Und Angst ist auch heute noch aus den gleichen Gründen ein Mittel der Politik. Gelingt es erst einmal, in großem Ausmaß Angst zu erzeugen, dann kann man sogar sehr fragwürdige politische Entscheidungen durchsetzen, die in einer funktionierenden Demokratie sofort blockiert und unterbunden worden wären.

Ohne das Erzeugen von Ängsten wäre die Energiewende mit dem Ziel eines radikalen Umbaus großer Teile der Wirtschaft nicht möglich. Als sie beschlossen wurde, war so ziemlich allen fachkundigen Menschen in der Industrie und in der Wissenschaft klar, was das für ein Unsinn war. Man sollte annehmen, dass sich sofort ein Sturm der Entrüstung erhob, der die Regierung hinwegfegte. Aber so war es nicht. Aus der Industrie kam fast kein Protest; von den Verbänden überhaupt keiner. Auch die Wissenschaft verhielt sich sehr ruhig.

Bei näherem Hinsehen zeigte sich, dass mehrere Varianten von Angst am Werk waren: Bei der Industrie eine Mischung von kritikloser Politikfrömmelei („Es ist schließlich von der Regierung so beschlossen und die werden es schon richtig machen“) , verbunden mit der Erwartung von Subventionen, falls es schief zu gehen drohte, womit man wohl rechnete. Außerdem versprach die vorübergehende Eröffnung eines durch Planwirtschaft gesteuerten „Marktes“ für politisch erwünschte Produkte und Anlagen gute Renditen – wenn auch nur auf Zeit.

Bei den gänzlich unpolitischen Natur- und Ingenieurwissenschaften war die Angst vor der Abkoppelung vom warmen Regen der Fördergelder ausschlaggebend, für deren Bewilligung man jede kritische Anwendung physikalischer Gesetze und damit auch jede Scham fallen lassen musste.

In beiden Fällen war es also die Furcht vor dem Verlust von Geld.

Eine besondere Rolle kam der sogenannten öffentlichen Meinung zu. So werden hier Presse und Fernsehen bezeichnet, aber es liegt eine massive Täuschung darin. Mehrere Recherchen ergaben, dass in den zugehörigen Redaktionen zu ca. 70 Prozent parteipolitisch festgelegte Personen saßen, die sich selbst als Anhänger der Grünen und der SPD bezeichneten. Diese Personen interpretierten ihre Arbeit als legitime Unterstützung ihrer Partei, wozu politisch missliebige, wenn auch wichtige und zutreffende Informationen unterdrückt werden mussten. Im Fernsehen fielen diese Manipulationen deutlicher auf, weil ständig die gleichen „Experten“ zu den Interviews und Talkrunden eingeladen wurden. So gibt es in Deutschland genau eine einzige Energieexpertin und zwei Klimafachleute – Sie kennen die zur Genüge (Anmerkung der Redaktion: Genau genommen gibt es 2 1/2 hier einer davon). Kritiker werden fern gehalten, was kontroverse Debatten vermeiden hilft und vor allem die Verbreitung ihrer Argumente in der Öffentlichkeit verhindert.

Diese Selbstzensur der Redaktionen erzeugte eine rot-grüne Medienmacht, die zwar mit einer öffentlichen Meinung nur noch wenig zu tun hatte, die aber von der Politik zunehmend gefürchtet wird.

In Ostdeutschland, wo man über 40 Jahre von den Medien systematisch belogen wurde, hat man wesentlich empfindlichere Antennen für Manipulationen und Falschmeldungen, was die dortige harte Kritik an den Medien erklärt.

Die Methode der gezielten Informationsunterdrückung verliert allerdings stetig an Kraft, weil das politisch unkontrollierbare Internet – man ist ja (noch) nicht in China – speziell unter den Jüngeren immer mehr zur einzig genutzten Informationsquelle wird.

Die Angstthemen der Regierung

Die Angst vor dem Weltuntergang durch menschengemachte CO2-Emissionen.

In der Naturwissenschaft gilt ein unumstößliches Gesetz: Jede Theorie ist nur dann richtig, wenn sie durch ein überzeugendes Experiment bewiesen wird. Und über dieses Experiment muss vollständig berichtet werden, um anderen Forschern die Möglichkeit zu geben, das Experiment zu wiederholen und dessen Ergebnisse mit der vorgestellten Theorie zu vergleichen. Erst wenn das erfolgreich geschehen ist, gehört die Theorie zur wissenschaftlichen Erkenntnis.

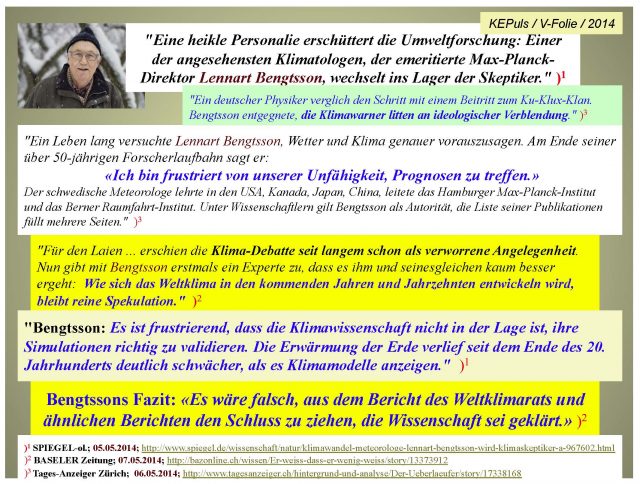

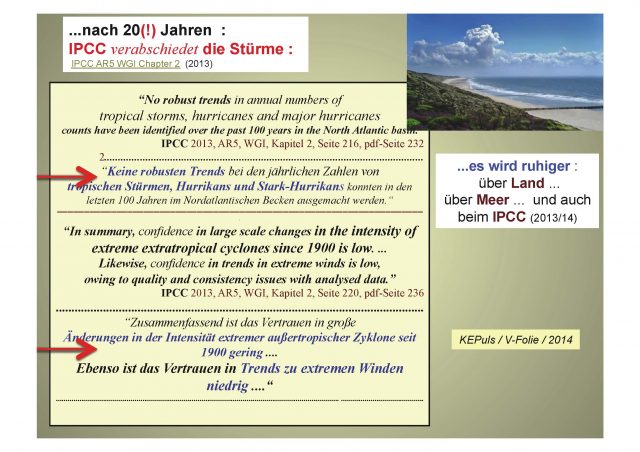

Einen derartigen Beweis für die Theorie vom menschengemachten Klimawandel, dessen Ursache die von den Menschen verursachten Kohlendioxid- (CO2)-Emissionen sein sollen, hat es bis heute nicht gegeben. Es handelt sich deshalb um eine unbewiesene Theorie, die daher auch von sehr vielen Wissenschaftlern angegriffen wird. Einen Konsens der Forscher hat es niemals gegeben; im Gegenteil. Im Übrigen genügt in der Wissenschaft ein einziger fundierter Gegenbeweis, um eine falsche Theorie zu „kippen“. Die wissenschaftliche Literatur ist inzwischen voller derartiger Gegenbeweise, was aber die politische Klimarats-Organisation IPCC nicht daran hindert, ihre allein auf Computer-Simulationen beruhende Theorie weiter zu vertreten.

Dass die internationale Politik jemals bereit war, dieses unbewiesene und umstrittene Stück erfolgloser Wissenschaft zu glauben und daraus eine weltweite Rettungsaktion zur Verhinderung des angeblich bevorstehenden Untergangs dieses Planeten zu machen, ist zwar ein Meisterstück politischer Manipulation, aber sonst nichts.

Die wichtigste Triebkraft dieser Klimapolitik ist wieder die Angst, das bewährte Druckmittel. Es ist nicht weiter verwunderlich, dass Deutschland als die Nation, deren Politik schon lange besonders bedenkenlos die Angstverbreitung zu einem der wichtigsten politischen Instrumente gemacht hat, in der internationalen Klimapanik an vorderster Front steht.

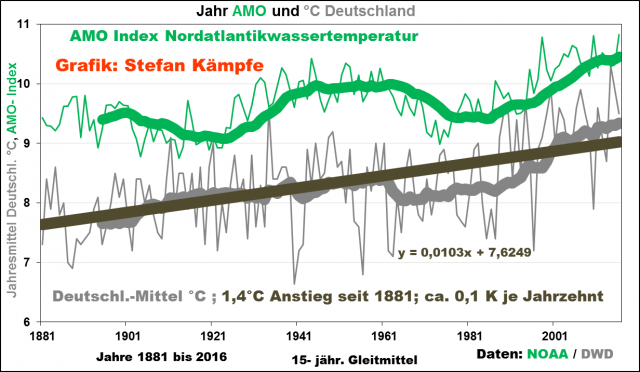

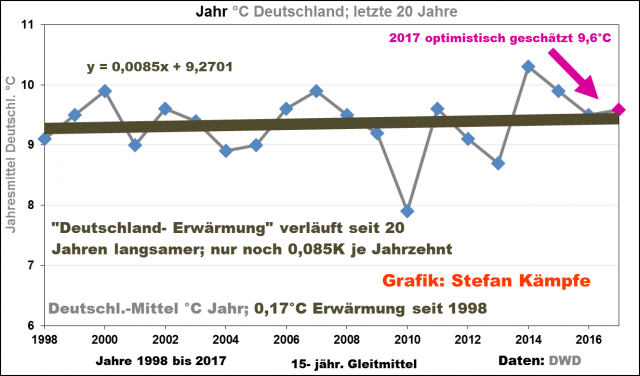

Immer deutlicher stellt sich heraus, dass die von Menschen verursachten Emissionen von CO2 keinen bedeutenden Einfluss auf das Erdklima haben. Seit nunmehr fast 20 Jahren ändert sich die globale Durchschnittstemperatur der Erde nicht mehr, obwohl die CO2-Emissionen – insbesondere durch China – gerade in diesem Zeitraum immer weiter angestiegen sind.

Ein Politiker muss keineswegs ein Wissenschaftler sein, um die ganze Sinnlosigkeit dieser Klimapanik und insbesondere die winzige und vollkommen unmaßgebliche Rolle des kleinen Deutschlands bei den angeblich notwendigen Gegenmaßnahmen – die weltweite Vermeidung von CO2-Emissionen – zu erkennen.

Es genügt das Lesen der regelmäßig erscheinenden Berichte über die Emissionen der Staaten und etwas Schulmathematik aus der 3. oder 4. Klasse.

Dann sieht man, dass China mit 30 Prozent Anteilen an der weltweiten Emission der sog. Treibhausgase aus der energetischen Verwendung fossiler Brennstoffe den Löwenanteil hat, während Deutschland mit gerade einmal 2,2 Prozent eine winzige Rolle spielt. Jeder kann ausrechnen, dass selbst eine Verringerung der deutschen Emissionen um den zehnten Teil nur 0,2 Prozent an weltweiter Reduzierung bringen würde. Aber tatsächlich schafft Deutschland überhaupt keine Reduzierung, sondern erhöht sogar seinen Ausstoß. Und das wird sich mit jedem neu abgeschalteten Kernkraftwerk fortsetzen, denn dessen Strom wird durch Kohlekraftwerke ersetzt werden müssen. Erneuerbare Energien können das nicht, so viele Windräder man auch in die Landschaft und in die Wälder stellt.

Dieses Thema wird für Deutschland und seine Regierung noch peinlicher, wenn man die Wirkung des europäische Zertifikatssystems für Treibhausgas-Emissionen betrachtet. Es setzt die erlaubte Höchstmenge dieser Emissionen fest und der Handel mit diesen sog. Verschmutzungsrechten führt zu einem Preis für diese. Wenn ein Land wie Deutschland eine eigene, in Europa nicht vorgesehene zusätzliche Emissionsminderung mit Subventionen wie die EEG-Zulage installiert, dann werden Zertifikate sowohl frei als auch billiger, die dann ein anderes EU-Land kaufen kann, um seine Emissionen erhöhen zu können. Das bedeutet, dass alle zusätzlichen Minderungsmaßnahmen der Energiewende durch ausländische Mehr-Emissionen vollständig ausgeglichen werden: Der Effekt für die europäische Treibhausgas-Bilanz ist gleich Null. Die Regierung weiß das selbstverständlich, denn sie beherrscht die Viertklässler-Schulmathematik auch. Aber sogar die Kritik an der Nutzlosigkeit dieser deutschen Extra-Aktivitäten im letzten Klimabericht des IPCC hat nichts bewirkt.

Und der dänische Politiloge und Statistiker Björn Lomborg macht sich regelmäßig einen Spaß daraus, den Deutschen auf der Grundlage der IPCC-Formeln vorzurechnen, um wie viele Stunden oder Tage sämtliche über die vielen Jahre ihrer Anwendung ausgegebenen Energiewende-Milliarden die angeblich in einigen Jahrzehnten bevorstehenden Klimaerwärmung zeitlich hinausschieben würden – wenn dieser Unsinn überhaupt stimmt.

Er veröffentlichte am 15. Mai 2015 in der FAZ einen ausführlichen Artikel zu dem Thema „Deutschlands gescheiterte Klimapolitik“ (3).

Er schrieb darin zu der Wirkung der deutschen Klima-Milliarden:

„Sämtliche Anstrengungen, die Deutschland zur Förderung der erneuerbaren Energien unternimmt, werden geschätzt zu einer Senkung der Emissionen um jährlich 148 Megatonnen (Millionen Tonnen) führen. Im Standard Klimamodell führt die gesamte Förderung der nächsten 20 Jahre zu einer Reduktion um gerade einmal 0,001 Grad Celsius bis zum Ende des Jahrhunderts oder einer Hinauszögerung des Temperaturanstiegs bis zum Jahr 2100 um weniger als 18 Tage.

Es sollte kaum verwundern, dass eine derart teure Klimapolitik , die so wenig Auswirkung auf das Klima hat, für die restliche Welt kaum nachvollziehbar ist.“ (Ende des Zitats).

Die Angst vor der atomaren Vernichtung durch die eigene Kernkraft

Als die Regierung 2011 mit dem Ausstiegsbeschluss aus der Kernkraft der Energiewende eine unerwartete Richtungskorrektur gab, die aber – ohne das es die Regierung begriff – gleichzeitig das Scheitern der Energiewende beschleunigte, zeigte sich, dass das Aufeinandersetzen zweier apokalyptischer Ängste das Erreichen des ursprünglichen Ziels zuverlässig verhindert. Unter allen schweren Fehlern der Regierung war der Kernkraftausstieg der folgenreichste. Es war nicht nur ein katastrophaler Schaden für das Industrieland Deutschland, sondern auch gleichzeitig der Sargnagel Nr.2 für Merkels Lieblingsprojekt Energiewende.

Wir erinnern uns: Sargnagel Nr.1, der allein schon für deren Scheitern völlig ausreicht, ist das dauerhafte Fehlen einer erforderlichen, enormen Anzahl großer Pumpspeicherkraftwerke.

Der Fortfall eines großen Teils der Strom-Grundlastversorgung erzwingt deren Ersatz durch eine andere Grundlastquelle – und das ist alleine Kohlestrom, der nur mit Braunkohlekraftwerken kostengünstig produziert werden kann. Allerdings ist es nun eine eher unwichtige Eigenschaft der Kernkraftstrom-Erzeugung, dass sie praktisch keine sog. Treibhausgas-Emissionen verursacht. Und diese mächtige Stromerzeugungs-Kapazität musste nun als Folge der nur in Deutschland propagierten Angst vor den eigenen Kernkraftwerken stillgelegt werden. Damit steigen die CO2-Emissionen an und es geschieht damit das Gegenteil der nun zur Makulatur gewordenen vollmundigen „Klimaschutz“-Ankündigungen. Dass das Spurengas CO2 nahezu nichts mit dem Klimawandel zu tun hat, gehört wiederum zum Angstthema „Weltuntergang durch menschengemachte CO2-Emissionen“.

Weder der Unfall von Tschernobyl noch der von Fukushima gaben Deutschland einen Anlass, die Sicherheit der eigenen Kernkraftwerke in Frage zu stellen. In Tschernobyl explodierte ein veralteter Reaktortyp (Druckröhren-Reaktor), der wegen seiner prinzipiell großen Gefährlichkeit – und noch dazu fehlender Sicherheitsvorkehrungen wie eine stabile Schutzhülle – niemals im Westen gebaut worden ist. Dass die Sowjetunion die wenigen Reaktoren dieses Typs nicht längst stillgelegt hatte, führte letztlich zu dieser leider durchaus möglichen und wahrscheinlichen Katastrophe.

In Fukushima standen 4 alte Reaktoren eines US-Typs, die – im Gegensatz zu allen deutschen Raktoren – niemals während ihres jahrzehntelangen Betriebs sicherheitstechnisch nachgerüstet worden waren. Nicht genug damit: Sie waren völlig unzureichend gegen Tsunamis geschützt, die im Durchschnitt alle 30 Jahre deutlich höhere Flutpegel als die viel zu niedrige Sperrmauer aufwiesen, was zur Überschwemmung des unteren Teils der Anlagen führte, in denen ausgerechnet die für den Ausfall der externen Stromversorgung und damit der Reaktorkühlung vorgesehenen Notstromdiesel wiederum ungeschützt eingebaut waren – und absoffen. Die Stromversorgung von Land aus war durch das Erdbeben unterbrochen. Daraufhin fiel die Nachkühlung der abgeschalteten Reaktoren aus. Dieser Unfall war somit die Folge einer kaum glaublichen Verantwortungslosigkeit der unfähigen Chefs und Aufsichtspersonen der Betreiberfirma TEPCO. Es ist nicht bekannt, ob auch nur einer von ihnen zur Verantwortung gezogen worden ist.

Obwohl durch diesen Unfall keine Person ihr Leben verlor, verstanden es die deutschen Medien, die Unfallfolgen so darzustellen, als ob alle über 18.000 Toten, die Japan als Folge der Flutwelle zu beklagen hatte, durch die beschädigten Reaktoren verursacht worden seien. Es gab jedoch keinen einzigen Todesfall durch Strahlung. Diese Falschmeldungen sind international stark kritisiert worden.

In Deutschland wiederum waren alle Kernreaktoren regelmäßig mit den neuesten Sicherheitstechniken nachgerüstet worden und es bestanden insofern keinerlei Bedenken in Bezug auf ihre Sicherheit, wie die Reaktorsicherheits-Kommission der Regierung bescheinigte. Und eine Tsunami-Gefahr gab es ebenfalls nicht. Frau Merkel ersetzte daher das Votum der Experten durch eine sog. Ethik-Kommission, die auch das erwünschte Ergebnis – die Empfehlung zur Stilllegung aller Kernkraftwerke – lieferte. Und das Parlament stimmte dieser geradezu absurden Manipulation zu – ein Versagen, das es zuvor so noch nicht gegeben hatte.

Seither wird wie geplant stillgelegt. Woher die südlichen Bundesländer nach dem Abschalten ihrer letzten Kernkraftwerke den für eine zuverlässige Versorgung zwingend erforderlichen Grundlaststrom bekommen sollen, weiß im Moment niemand.

Die Regierung hatte zur Lösung dieses offensichtlichen ernsten Problems eine zusätzliche, ebenfalls teure Investition in die Wege geleitet: Den Neubau mehrerer Höchstspannungsleitungen, die von Norddeutschland ausgehend den dort – nur gelegentlich und wetterabhängig – erzeugten Windstrom in den Süden zu leiten. Es entstanden viele Bürgerinitiativen, die diese Pläne bekämpften und die eine erstaunliche Entdeckung machten: Die östliche Trasse, die Bayern mit Windstrom versorgen sollte, endete bereits bei Bad Lauchstädt bei Leipzig. Also mitten im Braunkohlerevier mit seinen Kohlekraftwerken – und mit dem zweiten Braunkohlerevier an der polnischen Grenze und den dort zugehörigen Kohlekraftwerken mit Leitungen verbunden. Niemand wollte ernsthaft Windstrom aus dem Norden nach Bayern transportieren. Die Bürgerinitiativen entdeckten die Täuschung und die bayrische Landesregierung sah sich gezwungen, den Bau dieser Trasse zu stoppen. Später erschien eine neue Landkarte des Netzausbaus und dieses Mal ging die Osttrasse weiter bis Norddeutschland…Auch die westliche Trasse führt recht nahe am rheinischen Braunkohlerevier vorbei.

Aber alle wissen, dass der völlig unzuverlässige, stark schwankende und auch gerne einmal für zwei Wochen ausfallende Windstrom niemals irgendein Bundesland sicher versorgen kann. Und die Bundesnetzagentur weiß es auch. Deshalb sorgte sie mit ihrer Planung für ausreichend Braunkohlestrom für Süddeutschland, tat aber so, als wäre es grüner Windstrom…Wieder eine Täuschung, hier aber sinnvoll – und im Grunde ein Akt der Verzweiflung.

Schließlich entschied noch Minister Gabriel, dass alle neuen Höchstspannungsleitungen als Erdkabel gebaut werden müssen. Das tröstete die Bürgerinitiativen etwas, führt aber zu mindestens zwei weiteren Jahren der Verzögerung; von den Mehrkosten ganz zu schweigen.

Der gesamte Netzausbau ist daher nur ein unnötiges, extrem teures Hilfsprojekt, mit dem den Bürgern eine sinnvolle Verwendung des vom Wetter gesteuerten und daher überwiegend unbrauchbaren oder auch vollkommen ausfallenden Windstroms vorgegaukelt werden soll.

Mit der Entscheidung für den Kernkraftausstieg hat die Regierung ihrer Energiewende selbst die Grundlage entzogen und ihre nach wie vor betonte Rolle als „Vorreiter“ ist zur internationalen Lachnummer geworden.

Wenn eine Angst nicht mehr wirkt – dann eben eine Ersatzangst

Manchmal muss man tatsächlich eine Rede der Bundeskanzlerin nachlesen – und dann muss man sie noch einmal lesen, weil man es einfach nicht glauben will. Vom Glauben spricht die Kanzlerin übrigens in ihrer hier behandelten Rede beim Internationalen WBGU-Symposium am 9. Mai 2012 in Berlin mehrfach. Ein Zitat ist erforderlich, um die eigentümliche Denkweise zu verstehen und die merkwürdigen Schlussfolgerungen bewerten zu können.

Merkel: „Ich nenne immer Klimawandel und Ressourceneffizienz oder Endlichkeit der Ressourcen in einem Zusammenhang, weil ich keine Lust habe, mich immer mit Zweiflern auseinanderzusetzen, ob der Klimawandel nun wirklich so schwerwiegend sein wird…Allein die Tatsache, dass wir in die Richtung neun Milliarden Menschen auf der Welt zugehen, zeigt uns, dass auch diejenigen, die an den Klimawandel nicht glauben, umdenken müssen. Damit hier kein Zweifel aufkommt: Ich gehöre zu denen, die glauben, dass etwas mit dem Klima passiert. Aber damit wir nicht über das Ob so lange Zeit verlieren, sage ich einfach: Wer nicht daran glauben mag, wer immer wieder Zweifel sät, wer die Unsicherheiten in den Vordergrund stellt, sollte sich einfach daran erinnern, dass wir in Richtung auf neun Milliarden Menschen auf der Welt zusteuern, und er sollte sich die Geschwindigkeit des Verbrauchs fossiler Ressourcen anschauen. Dann kommt er zu dem gleichen Ergebnis, dass nämlich derjenige gut dran ist, der sich unabhängig davon macht, Energie auf die herkömmliche Art und Weise zu erzeugen. Deshalb sind eine andere Energieversorgung, also durch erneuerbare Energien, und ein effizienterer Umgang mit der Energie und den Ressourcen die beiden Schlüsselfaktoren.“

(Ende des Zitats)

Wäre dies ein Schulaufsatz gewesen, die rote Tinte wäre reichlich geflossen. Wo soll man anfangen? Die mehrfache Verwendung des Verbums „glauben“ ist bezeichnend. Tatsächlich geht es ja um Naturwissenschaft, und da wird nicht geglaubt, sondern bewiesen und widerlegt- siehe oben. Nur Politiker und Kirchenleute legen Wert auf den Glauben. Natürlich nur den richtigen.

Die Kritik an denen, die an den Klimawandel nicht glauben wollen, ist vollkommen daneben, denn von den zweimal genannten demnächst 9 Milliarden Menschen weiß nahezu jeder, dass Klimawandel etwas Normales ist, was seit etlichen 100 Millionen Jahren geschieht – und zwar durch die Sonne gesteuert. Mit „Zweiflern“ meint sie Wissenschaftler, die die unbewiesenen Theorien des IPCC als falsch betrachten und andere Theorien bevorzugen. Das ist deren Job. Und eine der Kritiker-Gruppen hat sogar ein Experiment zur Wolkenbildung durch die kosmische Höhenstrahlung erfolgreich durchgeführt, was zur Erklärung der atmosphärischen Prozesse beiträgt und in dem das Spurengas CO2 überhaupt nicht vorkommt. Das ist bisher das einzige Experiment in der ganzen theoretischen Debatte. Und das sind eben keine „Zweifler“. Man beachte die Wortwahl. Dass sie „keine Lust hat“, sich mit diesen „Zweiflern“ auseinanderzusetzen, kann man verstehen. Sie würde dabei untergehen.

Und dann kommt der doppelte Rittberger: Eine neue Angst an Stelle einer alten, deren Wirkung nachzulassen scheint. Die Frage der Verfügbarkeit der Vorräte und der Reserven sei ganz einfach die gleiche, wie die nach der Glaubwürdigkeit der Theorien des IPCC, weil es schliesslich immer nur um das CO2 geht. Und nach diesem Salto braucht man nur noch über die Ressourcen sprechen. Aber Merkel liegt auch damit wieder falsch. Ihre Bundesanstalt für Geologie und Rohstoffe BGR hat in seriösen Berichten den Beweis geführt, dass fossile Ressourcen noch sehr lange reichen; insbesondere die Kohle.

In ihrem letzten Satz braucht man übrigens nur die Worte „erneuerbare Energien“ durch „Kernkraft“ zu ersetzen und hat dann eine richtigere Aussage, denn mit den in der Entwicklung befindlichen Reaktortypen der 4. Generation vergrößert man den Vorrat an nutzbarem Uranbrennstoff um das 60-fache – auf Jahrtausende. Und dann ist die Kohle längst überflüssig als Energiequelle.

Bei aller Fehlerkonzentration und logikfreien Analogie von Klima und Rohstoffen ist Merkels Aussage doch vielsagend und wertvoll: So denkt Deutschlands führende Politikerin.

Eine begründete Angst, die im Angst-Arsenal fehlt: Der große Blackout

Die durch die unkontrollierbaren Störungen immer kritischer werdende Situation im Stromnetz – verursacht vor allem durch die Windräder – kann von den Netzbetreibern mit ihren Redispatch-Maßnahmen kaum noch beherrscht werden. Der große Blackout droht im Winter bei „Dunkelflaute“.

Auch im Januar 2017 befand sich das deutsche Stromnetz am Rande des Zusammenbruchs. Der Grund dafür war die klägliche Leistung von Windkraftanlagen (WKA) und Solarstromerzeugern, die zusammen eine sogenannte Dunkelflaute erlitten – ein im Winter nicht seltener Zustand, in dem die schon damals riesenhafte gemeinsame installierte Leistung von 83.900 MW auf praktisch Null – wie 20 oder 30 MW von WKA in ganz Deutschland – zusammenschrumpfte. Dieser Zustand kann ohne weiteres mehrere Tage anhalten. Während dieser Zeit muss die gesamte notwendige Erzeugungsleistung, die im Winter mindestens 80.000 Megawatt beträgt, von den konventionellen Kraftwerken kommen – also von Kohle- und Kernkraftwerken sowie von Gaskraftwerken.

Der 24. Januar 2017 war nun wieder einmal ein Tag, an dem der Ernstfall – der völlige Zusammenbruch der deutschen Stromversorgung – gefährlich nahe kam. Dieser große Blackout wurde gerade noch vermieden, weil die Energieversorger „auch noch das letzte Reservekraftwerk heranzogen“, wie Michael Vassiliadis, der Chef der für die Kraftwerkswirtschaft zuständigen IG Bergbau, Chemie, Energie Reportern mitteilte (1).

Nach dem Bericht von RP-Online führte Vassiliadis auf einer Veranstaltung in Haltern am See vor Journalisten aus, dass „der Zustand am 24. Januar kritisch wurde. Energieunternehmen und Netzbetreiber hätten an diesem Tage die Stromversorgung nur mit größter Mühe aufrechterhalten können.“ Denn die Deutschen forderten – wie an anderen Tagen auch – mehr als 80.000 MW Leistung ab. Vassiliadis: „Die Erneuerbaren konnten nicht einmal fünf Prozent davon bieten“.

Den meisten Bürgern ist nicht klar, was ein großer Blackout bedeutet, stellten die Fachleute des Büros für Technologiefolgen-Abschätzung beim Deutschen Bundestag (TAB) in einem sehr ausführlichen Bericht (4) fest, der zwar bereits 2011 erstellt wurde, dessen Aktualität jedoch heute mit jedem Monat zunimmt.

Aus diesem Bericht werden hier wichtige Ergebnisse zitiert:

„Aufgrund der Erfahrungen mit bisherigen nationalen und internationalen Stromausfällen sind erhebliche Schäden zu erwarten. Für den Fall eines mehrwöchigen Stromausfalls sind Schäden zu erwarten, die um Größenordnungen höher (als mehrere Milliarden €) liegen.

Telekommunikations- und Datendienste fallen teils sofort, spätestens aber nach wenigen Tagen aus. Die für zentrale Kommunikationseinrichtungen vorgehaltenen Reservekapazitäten wie »Unterbrechungsfreie Stromversorgung« und Notstromaggregate sind nach wenigen Stunden oder Tagen erschöpft bzw. aufgrund ausgefallener Endgeräte wirkungslos. Damit entfällt innerhalb sehr kurzer Zeit für die Bevölkerung die Möglichkeit zur aktiven und dialogischen Kommunikation mittels Telefonie und Internet.

Im Sektor »Transport und Verkehr« fallen die elektrisch betriebenen Elemente der Verkehrsträger Straße, Schiene, Luft und Wasser sofort oder nach wenigen Stunden aus. Zu Brennpunkten werden der abrupte Stillstand des Schienenverkehrs und die Blockaden des motorisierten Individual- und öffentlichen Personennahverkehrs in dichtbesiedelten Gebieten….Der Straßenverkehr ist unmittelbar nach dem Stromausfall besonders in großen Städten chaotisch. Es ereignen sich zahlreiche Unfälle, auch mit Verletzten und Todesopfern. Rettungsdienste und Einsatzkräfte haben erhebliche Schwierigkeiten, ihren Aufgaben gerecht zu werden. Durch den Ausfall der meisten Tankstellen bleiben zunehmend Fahrzeuge liegen, der motorisierte Individualverkehr nimmt nach den ersten 24 Stunden stark ab. Der Öffentliche Personennahverkehr kann wegen knappen Treibstoffs allenfalls rudimentär aufrechterhalten werden.

Die Wasserversorgung benötigt elektrische Energie in der Wasserförderung,

-aufbereitung und -verteilung. Fallen diePumpen aus, ist die Grundwasserförderung nicht mehr möglich, die Gewinnung von Wasser aus Oberflächengewässern zumindest stark beeinträchtigt.

Eine Unterbrechung der Wasserversorgung wirkt sich umfassend auf das häusliche Leben aus: Die gewohnte Körperpflege ist nicht durchführbar; für die Mehrzahl der Haushalte gibt es kein warmes Wasser. Das Zubereiten von Speisen und Getränken ist nur reduziert möglich, und die Toilettenspülung funktioniert nicht.

Da als Folge der reduzierten oder ausgefallenen Wasserversorgung die Brandbekämpfung beeinträchtigt ist, besteht insbesondere in Städten wegen der hohen Besiedelungsdichte die Gefahr der Brandausbreitung auf Häuserblöcke und möglicherweise sogar auf ganze Stadtteile.

Als Folge des Stromausfalls ist die Versorgung mit Lebensmitteln erheblich gestört; deren bedarfsgerechte Bereitstellung und Verteilung unter der Bevölkerung werden vorrangige Aufgaben der Behörden. Von ihrer erfolgreichen Bewältigung hängt nicht nur das Überleben zahlreicher Menschen ab, sondern auch die Aufrechterhaltung der öffentlichen Ordnung. Die weiterverarbeitende Lebensmittelindustrie fällt zumeist sofort aus, sodass die Belieferung der Lager des Handels unterbrochen wird. Trotz größter Anstrengungen kann aber mit hoher Wahrscheinlichkeit die flächendeckende und bedarfsgerechte Verteilung der Lebensmittellieferungen nur ungenügend gewährleistet werden.

Das dezentral und hocharbeitsteilig organisierte Gesundheitswesen kann den Folgen eines Stromausfalls nur kurz widerstehen. Innerhalb einer Woche verschärft sich die Situation derart, dass selbst bei einem intensiven Einsatz regionaler Hilfskapazitäten vom weitgehenden Zusammenbrechen der medizinischen und pharmazeutischen Versorgung auszugehen ist. Bereits nach 24 Stunden ist die Funktionsfähigkeit des Gesundheitswesens erheblich beeinträchtigt. Krankenhäuser können mithilfe von Notstromanlagen noch einen eingeschränkten Betrieb aufrechterhalten, Dialysezentren sowie Alten- und Pflegeheime aber müssen zumindest teilweise geräumt werden und Funktionsbereiche schließen. Arzneimittel werden im Verlauf der ersten Woche zunehmend knapper, da die Produktion und der Vertrieb pharmazeutischer Produkte im vom Stromausfall betroffenen Gebiet nicht mehr möglich sind und die Bestände der Krankenhäuser und noch geöffneten Apotheken zunehmend lückenhaft werden. Dramatisch wirken sich Engpässe bei Insulin, Blutkonserven und Dialysierflüssigkeiten aus.

Dieser dezentral strukturierte Sektor ist schon nach wenigen Tagen mit der eigenständigen Bewältigung der Folgen des Stromausfalls überfordert. Der Zusammenbruch der in Krankenhäusern konzentrierten Versorgung droht.

Spätestens am Ende der ersten Woche wäre eine Katastrophe zu erwarten, d.h. die gesundheitliche Schädigung bzw. der Tod sehr vieler Menschen sowie eine mit lokal bzw. regional verfügbaren Mitteln und personellen Kapazitäten nicht mehr zu bewältigende Problemlage. Ohne weitere Zuführung von medizinischen Gütern, Infrastrukturen und Fachpersonal von außen ist die medizinisch-pharmazeutische Versorgung nicht mehr möglich.

FAZIT: Wie die zuvor dargestellten Ergebnisse haben auch die weiteren Folgenanalysen des TAB gezeigt, dass bereits nach wenigen Tagen im betroffenen Gebiet die flächendeckende und bedarfsgerechte Versorgung der Bevölkerung mit (lebens)notwendigen Gütern und Dienstleistungen nicht mehr sicherzustellen ist. Die öffentliche Sicherheit ist gefährdet, der grundgesetzlich verankerten Schutzpflicht für Leib und Leben seiner Bürger kann der Staat nicht mehr gerecht werden. Die Wahrscheinlichkeit eines langandauernden und das Gebiet mehrerer Bundesländer betreffenden Stromausfalls mag gering sein. Träte dieser Fall aber ein, kämen die dadurch ausgelösten Folgen einer nationalen Katastrophe gleich. Diese wäre selbst durch eine Mobilisierung aller internen und externen Kräfte und Ressourcen nicht »beherrschbar«, allenfalls zu mildern“.

(Ende des Zitats)

Die Netzbetreiber wissen das selbstverständlich alles. Niemand wagt es derzeit, die einzig sinnvolle und bezahlbare Lösung vorzuschlagen: Den Verzicht auf die Stilllegung der letzten Kernkraftwerke – verbunden mit einer mindestens 15 Jahre langen Laufzeitgarantie. Eher würden wohl die für die deutsche Energiepolitik Verantwortlichen einen Tabu-Tod erleiden, wie er bei den Menschen einiger Naturvölker eintritt, wenn sie es wagen, eine vom Schamanen gekennzeichnete verbotene Zone zu betreten.

Die Absicht der Netzbetreiber ist viel bescheidener: Sie sehen so deutlich wie sonst niemand den großen Blackout auf sie zukommen. Genauso, wie auch U. Kaussen von Tennet auf die gestellte Frage „Droht uns ein Blackout ?“ mit einem klaren „Ja“ geantwortet hat (2). Und sie kennen auch die übliche Reaktion der Politik, wenn es darum geht, sich für ihr Versagen zu rechtfertigen: Sie haben bereits heute die Sündenböcke identifiziert. Es sind natürlich die Netzbetreiber, die bei ihrem Redispatch versagt haben. Auch die Bundesnetzagentur – dem Wirtschaftsministerium unterstellt – wird ins gleiche Horn stoßen.

Das Waldsterben

Das Märchen vom bevorstehenden Absterben des Waldes ist ein extremes Beispiel von der Entstehung und der staatlich betriebenen Aufblähung einer falschen Theorie, die insbesondere der Presse, aber auch bestimmten staatlichen Stellen sehr gut gefiel. Im Jahre 1979 berichtete ein Forstprofessor aus Göttingen, dass er in Laborversuchen festgestellt hätte, dass eine Beregnung von kleinen Nadelbäumen mit „saurem Regen“ erhebliche Schäden verursachte, die letztlich zu deren Absterben führten. Er verstieg sich dabei zu der Prognose, dass in wenigen Jahren der deutsche Wald vernichtet werde.

Anlass für seine Untersuchungen waren die immer noch vorhandenen Schwefeldioxidemissionen aus Kraftwerken, die zwar längst durch sehr wirksame Maßnahmen der Rauchgasentschwefelung, die von früheren Regierungen angeordnet wurden, drastisch verringert worden waren und weiter sanken. Aber immer noch hatten Niederschläge einen zu kleinen pH-Wert, waren also sauer anstatt neutral.

Schon in den siebziger Jahren gab es eine internationale Debatte über den sauren Regen und seine Folgen. Der Säureregen zerfraß Gebäude, ließ vitale Seen absterben, schädigte Pflanzen und bedrohte auch die Gesundheit der Menschen. Bereits im 1.Umweltprogramm der Regierung Brandt von 1971 wurde dieses Problem detailliert samt entsprechenden Aktionen vorgestellt. Die Stockholmer UN-Umweltkonferenz von 1972 und das Genfer Übereinkommen 1979 führten zu internationalen Verträgen mit weitreichenden Maßnahmen. Bereits im März 1974 konnte Bundesinnenminister Werner Maihofer beachtliche Erfolge vorzeigen: Die Schwefeldioxid-Emissionen waren drastisch zurückgegangen und sanken weiter.

Unterstützung erhielt der Göttinger 1981 von einem Professor aus München; das war aber schon alles an Beistand aus der Forschung. Die gesamte übrige Forstforschung lehnte diese Theorie ab. Aber es half schon nichts mehr: Die Medien hatten dieses wunderbare Panikthema aufgegriffen. Eine Art Himmelsgeschenk erhielten sie durch eine recht flapsige Bezeichnung für Waldschäden, die von den Forstleuten selbst erfunden worden war: Wenn in einem Waldgebiet irgendeine Schädigung im Gange war – sei es durch Insekten, Pilze oder andere Ursachen – pflegte man dafür einen Begriff zu wählen, der die betroffene Baumart und den Anhang „-sterben“ zusammenfügte. Also z.B. Eichensterben. Gab es mehrere derartige Schadfaktoren oder waren gleichzeitig mehrere Baumarten betroffen, nannte man es ungerührt und im Grunde leichtfertig „Waldsterben“. Damit hatte die Presse den besten Angstbegriff für eine Medienkampagne.

Die Sache wäre normalerweise innerhalb der Wissenschaft geklärt worden und man hätte dann nichts mehr von der falschen Theorie gehört. Aber die Presse gab keine Ruhe. Und dann geschah etwas, das aus einer Theorie eine staatliche Großaktion machte, die sogar auf andere Länder übergriff: Das Bundeslandwirtschafts-Ministerium BML, in dem nur eine sehr kleine Abteilung, die keinerlei Kompetenzen aber eine inhaltlose Zuständigkeit für Waldangelegenheiten hatte, vor sich hin dämmerte. Bundes-Staatswald gab es nicht. Wald, Forstämter, Forstforschungseinrichtungen, weitere Kompetenzen und vor allem Geld hatten allein die Länder.

In dieser Situation war die Waldsterbepanik ein Geschenk des Himmels für das BML. Es winkten endlich Geld, neue Pöstchen, großartige Koordinierungsaktionen mit den Ländern und damit endlich eine Erlösung aus der Bedeutungslosigkeit.

Es folgte ein gewaltiger Aktionismus, eine bundesweite Waldschadenserhebung wurde geboren – mit ungeeigneten Kriterien dafür, was eigentlich ein Waldschaden sei. Die Kritik von sämtlichen Forstwissenschaftlern (außer die in Göttingen) wurde beiseite gewischt. Man wollte sich das großartige Waldsterben nicht nehmen lassen.

Die Wissenschaft witterte das Geld und Forschunganträge begannen hereinzuströmen. Viele Forscher schreckten auch nicht vor völlig unsinnigen Theorien zurück: So wollt man z.B. Kernkraftwerke als Schuldige überführen. Auch die Grünen beteiligten sich fleißig an der Angsterzeugung: Sie starteten 1990 eine Kleine Anfrage im Parlament: »Zu den Problemen von Waldsterben … durch Einwirkung von Richtfunk und Radarwellen«. Es erwies sich ebenfalls als Unsinn.

Am 2. Februar 1993 – also immerhin 10 Jahre nach der Einführung der unbrauchbaren Waldschadenserhebung durch das BML – veröffentlichte das Bundesforschungsministerium (BMFT) eine Zwischenbilanz mit einer Stellungnahme seines Expertenkreises. Dieses Gremium, dem auch der o.e. Göttinger Professor angehörte, kam zu der klaren Aussage, »dass ein Absterben ganzer Wälder in Zukunft nicht mehr zu befürchten« sei. Er räumte damit in respektabler Manier ein, dass er damals mit seiner Prognose zu weit gegangen war. Nur 4 von 54 Tageszeitungen brachten diese Nachricht. Man wollte sich die Panik nicht durch die Forstforscher vermiesen lassen.

Die politischen Parteien hielten noch viel länger unverdrossen am Waldsterben fest. Noch im Mai 2000 stellten die Fraktionen der CDU/CSU und der SPD gleichlautend fest, »dass es keinen Grund zur Entwarnung gibt«. Dieser Satz dient seit Jahren der umweltpolitischen Geisterbeschwörung – vor allem für die Umweltverbände, die auf Entwarnungen allergisch reagierten. Im März 2001 erklärte Landwirtschafts-Staatssekretär Berninger im Parlament, »dass wir zusätzliche Strategien gegen das Waldsterben entwickeln«. Und im Januar 2002 forderten die Fraktionen der SPD und der Grünen, die Anstrengungen zur Reduktion und Beseitigung der »neuartigen Waldschäden« zu verstärken.

Dann kam die Überraschung: Im Sommer 2003 – also ganze 10 Jahre nach dem wissenschaftlichen Todesurteil der Waldsterbe-Theorie im Februar 1993 und 20 Jahre nach der Einführung der unbrauchbaren Waldschadenserhebung (heute Waldzustandserhebung) – erklärte Ministerin Renate Künast das Waldsterben für beendet. Die fachliche Kritik und wohl auch der Spott waren offenbar unerträglich geworden. Die Franzosen, die deutsche Ängste seit je nicht ganz ernst nehmen, fügten ihrem Vokabular le waldsterben hinzu, nachdem sie bereits le angst aufgenommen hatten.

Der Autor nahm damals im Bundesforschungs-Ministerium am Kampf gegen die BML-Panikfraktion teil – vergebens, denn die hatten die Zuständigkeit. Seltsamerweise bekam der BML-Minister, immerhin ein CSU-Mitglied, nichts von alledem mit. Die Regierung selbst verhielt sich vollkommen passiv. So dauerte es 10 Jahre, bis die grundlegenden Fehler in der Göttinger Theorie aufgedeckt wurden und die gesamte Waldsterbepanik in sich zusammen brach und weitere 10 Jahre, bis die Politik das Thema aufgab.

Am Ende war das Waldsterben nur noch ein sicherer Lacher in Kabaretts. Für die Steuerzahler gab es dagegen wenig zu lachen, denn die staatliche Förderung der Forschung über die vermeintlichen Ursachen des nicht existierenden Waldsterbens hatte allein im Bereich der Bundesregierung über 600 Millionen DM gekostet – die Ausgaben der Länder nicht gerechnet.

Eine ausführliche Schilderung der deutschen Waldsterbe-Angst und ihrer Folgen hat der Autor 2004 in der ZEIT veröffentlicht (5).

Der belgische Reaktor Tihange

Eine Variante der Nuklearangst ist die Schreckensvision von einer Reaktorkatastrophe im belgischen Tihange. Von Umweltschützern und inzwischen auch von westdeutschen Landesregierungen wird behauptet, dass der Stahl des Reaktordruckgefäßes von Rissen durchzogen und damit unsicher sei. Damit wäre ein großes Unglück wahrscheinlich. Seltsamerweise sehen das die dem Kraftwerk viel näher lebenden Belgier ganz anders. Die zuständigen Behörden des Landes betonen auch, man habe alles geprüft und es bestünde keine Gefahr.

Aber die deutsche Politik muss auf Ängste – echte oder nur behauptete – reagieren und so gab es böse Briefe der NRW-Landesregierung nach Belgien und die Stadt Aachen setzte noch eins drauf und verteilte Jodtabletten, die im Falle einer Explosion des Reaktors sofort zu schlucken wären.

Im Grunde laufen diese Aktionen darauf hinaus, der belgischen Atomaufsicht Leichtfertigkeit und Verantwortungslosigkeit und der belgischen Bevölkerung Leichtsinn und Dummheit zu unterstellen. Auch hierbei spielen die deutschen Medien eine fragwürdige Rolle.

Die Geisterbahn hat noch viele Nischen, in denen Angst lauert

Es gibt noch den Rinderwahnsinn, von dem bislang nicht behauptet werden kann, dass er auf den Menschen übertragbar ist. Gab es hierzu eine endgültige Entwarnung ?

Es gibt die Angst vor der Strahlung von Mobiltelefonen, die eigentlich wie alle Hochfrequenzstrahlung nur Wärme im Gewebe erzeugen kann, bei der sich die Wissenschaft aber auf die übliche Floskel „weitere Untersuchungen sind aber nötig“ zurückzieht. In diesem Falle ist aber der Wunsch der Kunden, unbedingt so ein Gerät zu besitzen, derart übermächtig, dass jegliche Angsterzeugung unbeachtet bleibt.

Die Bürger sollten vielleicht einmal den Katalog ihrer Ängste prüfen. Im Grunde können sie sämtliche von der Regierung verbreiteten Ängste streichen.

Vor dem großen Blackout aber dürfen sie sich mit Recht grausen.

Angst ?

Dass hier so über die Angstmacher und die Angsthasen gschrieben wird, liegt daran, dass der Autor keine dieser Ängste (mit Ausnahme des Großen Blackouts) ernst nimmt. Eigentlich bleibt dann nur die berechtigte Angst vor dem Zahnarzt übrig.

Allerdings gibt es doch vielleicht eine Sache, die mir etwas Sorge bereitet. Wenn in der näheren Umgebung unseres Hauses eine Wasserstoff-Tankstelle eröffnet wird, ziehe ich um. Den gewaltigen Explosionskrater kann ich mir gut vorstellen. Natürlich habe ich keine Angst. Aber dieses mulmige Gefühl…….

Quellen

(1): Michael Vassiliadis, der Chef der für die Kraftwerkswirtschaft zuständigen IG Bergbau, Chemie, Energie; Kommentar zu den Vorgängen am 24.1.2017; Veranstaltung in Haltern am See vor Journalisten

(2): Urban Kaussen: „Droht uns ein Blackout ?“, Technology Review – TR Online, 08.07.2015; https://www.heise.de/tr/droht-uns-ein-blackout-2639922.hmtl

(3): Björn Lomborg: „Deutschlands gescheiterte Klimapolitik“, FAZ, 15.05.2015;

www.faz.net/aktuell/wirtschaft/energiepolitik/bjoern-lomborg-ueber-klimawandel-und-gescheiterte-klimapolitik-13580487-p3.html

(4): Thomas Petermann, Harald Bradtke, Arne Lüllmann, Maik Poetzsch, Ulrich

Riehm: „Gefährdung und Verletzbarkeit moderner Gesellschaften – am Beispiel

eines großräumigen und langandauernden Ausfalls der Stromversorgung“,

17.5.2011; Arbeitsbericht Nr. 141; Publikation: „Was bei einem Blackout geschieht“, Studie des Büros für Technikfolgenabschätzung beim Deutschen Bundestag, Bd. 33, 2011, Verlag edition sigma, Berlin, ISBN 9783836081337, Volltext:

http://www.tab-beim-bundestag.de/de/pdf/publikationen/berichte/TAB-Arbeitsbericht- ab141.pdf

(5): Günter Keil: „Chronik einer Panik“, DIE ZEIT, 9.12.2004;

www.zeit.de/2994/51/N-Waldsterben