Ebenfalls am 28. Oktober entwickelten auf einer Pressekonferenz der Vorstandsvorsitzende der Kassenärztlichen Bundesvereinigung (KBV) Andreas Gassen gemeinsam mit den Professoren Hendrik Streeck (Bonn) und Jonas Schmidt-Chanasit (Hamburg) ein moderates Gegenmodell zum autoritären Containement-Modell der herrschenden Virologenschule. Seine Kernthesen waren (in wörtlicher Wiedergabe ) :

-

„Abkehr von der Eindämmung allein durch Kontaktpersonennachverfolgung.

-

Einführung eines bundesweit einheitlichen Ampelsystems anhand dessen sowohl auf Bundes- als auch auf Kreisebene die aktuelle Lage auf einen Blick erkennbar wird.

-

Fokussierung der Ressourcen auf den spezifischen Schutz der Bevölkerungsgruppen, die ein hohes Risiko für schwere Krankheitsverläufe haben.

-

Gebotskultur an erste Stelle in die Risikokommunkation setzen“

Die letzten beiden Spiegelstriche bedeuten die implizite Absage an das Instrument des Lockdowns.

Während diese Kernthesen vielleicht auch den Beifall von Mitgliedern der „Querdenken“-Bewegung finden könnten, ist dies sicherlich nicht der Fall beim Festhalten der Gruppe an den fünf Corona-Benimmregeln: Maske, Abstand, Hygiene, Lüften und Warn-App.

Hier wäre zu wünschen gewesen, dass die Reformgruppe um KBV-Chef Gassen eine Erklärung dafür gibt, dass die offiziellen Fallzahlen seit Oktober in die Höhe schießen, obwohl das Regime der Corona-Benimmregeln schon Monate zuvor in Kraft getreten ist. Immerhin hatte bereits die Einführung der Maskenpflicht am 22. April d. J. keinen messbaren Effekt gehabt (CIDM. online, 2020, Graphik Aktuelles Corona-Monitoring 2 / 2).

Die Empfehlungen aus Wissenschaft und Ärzteschaft (laut Gassen 200 000 Kassenärzte !) konnten nur für sehr kurze Zeit die mediale Aufmerksamkeit beanspruchen. Als sich immer mehr herausstellte, dass sich die Corona-Fallzahlen nicht dem staatlichen Steuerungsoptimismus fügen wollten und auf relativ hohem Niveau verharrten, ergriff unsere Staatslenker einmal mehr eine Panikattacke. Den Anfang machte wieder einmal MP Markus Söder, der den Vorreiter im Corona-Abwehrkampf gab und am 6. Dezember den Katastrophenfall für Bayern verkündete Im Zuge dessen weitete die Landesregierung die Kontaktbeschränkungen aus und kippte die für Silvester vorgesehenen Lockerungen. Von nun an gab es kein Halten mehr und ein Bundesland nach dem anderen kündigte Verschärfungen an. Dabei war die spektakulärste wohl die Ankündigung eines „harten“ Lockdowns in Sachsen. Dem folgte wenig später MP Günther für SH.

In dem panischen Aktionismus ging der Vorschlag der KBV vollständig unter. Offenbar erfüllte er auch nicht den Begriff von Wissenschaftlichkeit, den Merkel meinte, als sie sich in ihrer Haushaltsrede am 9. Dezember zur Verteidigung ihrer Position härterer Corona-Schutzmaßnahmen ausdrücklich auf die „Wissenschaft“ berief. Damit war offensichtlich nur der harte Lockdown-Vorschlag der Nationalen Wissenschaftsakademie Leopoldina gemeint, den diese für die Weihnachtszeit gemacht hatte.

Wie schon bei der Klimapolitik anerkennt Merkel offenbar nur die Form von Wissenschaft, deren Ergebnisse ihr aus welchem Grund auch immer zupass kommen. Mir ihrer Ignorierung des pluralistischen Charakters moderner Wissenschaft, auch von Naturwissenschaft, lässt sie erkennen,. dass sie von Wissenschaft gar nichts versteht. Darüber hinaus kann man erkennen, dass sie innerhalb der ihr genehmen Wissenschaftsvariante die jeweilige Hardliner-Position favorisiert.

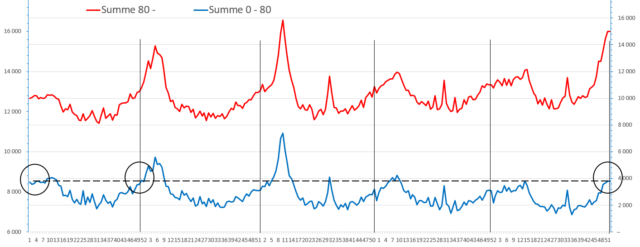

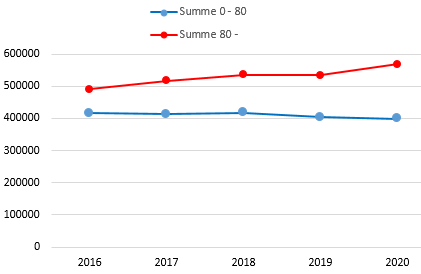

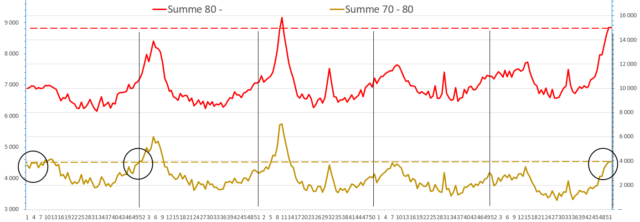

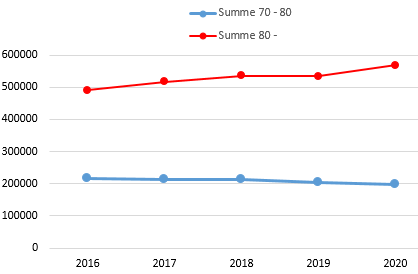

Dabei hat der am Schutz der Risikogruppen orientierte Ansatz der KBV die statistische Wahrheit für sich: 90 % aller „Coronatoten“ sind laut RKI über 70 Jahre alt, der Altersmedian liegt bei 83 Jahren. Diese Menschen haben in aller Regel zumindest eine schwere Vorerkrankung. Was liegt da näher, als die Ressourcen auf diese Gruppe zu konzentrieren? So könnte man an eine regelmäßige satte staatliche Bonuszahlung über eine längere Zeit an die Beschäftigten im Kranken- und Altenpflegebereich denken, um das seit langem bestehende strukturelle Personaldefizit in diesem Bereich dauerhaft zu beheben. Eine derartige Ausgabe erscheint deutlich zielführender als milliardenschwere Kompensationszahlungen an durch Lockdowns geschädigte Restaurantbetreiber und Einzelhändler.

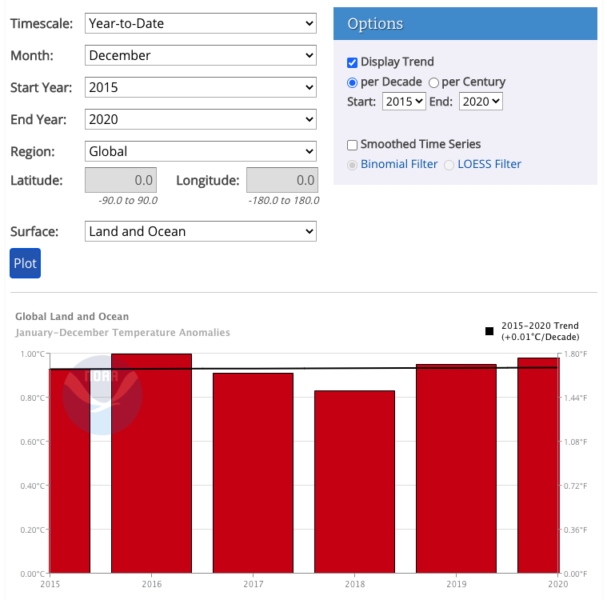

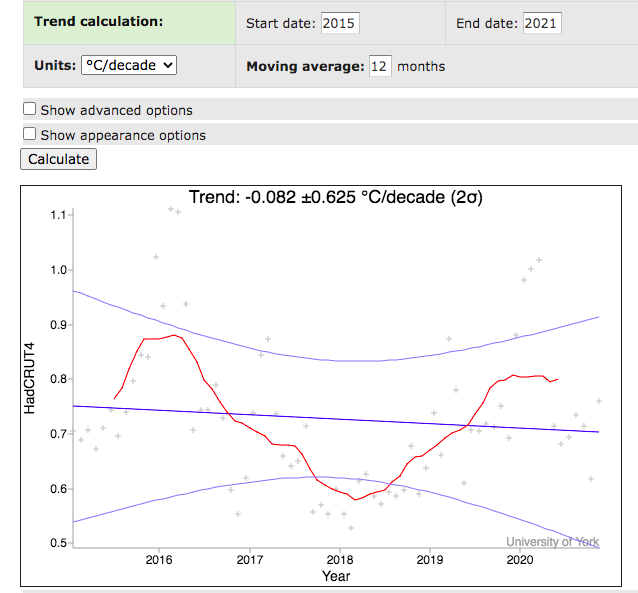

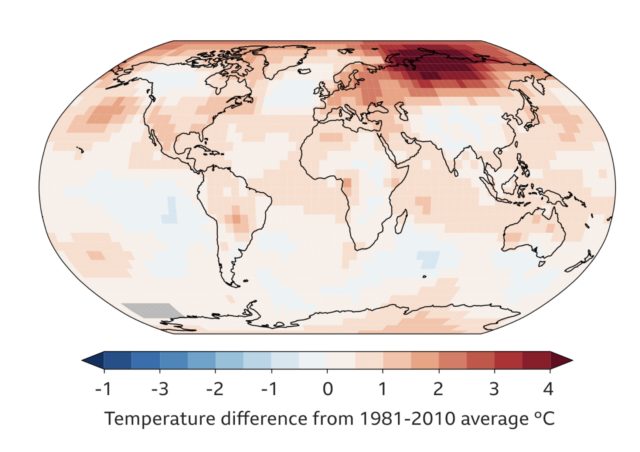

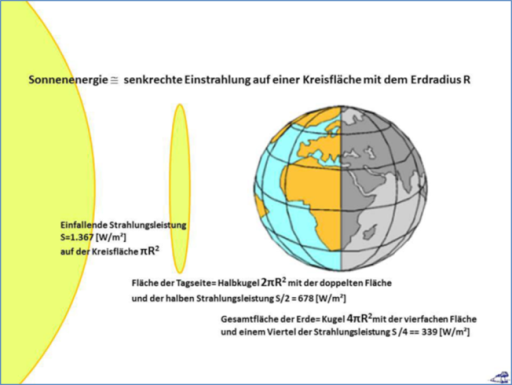

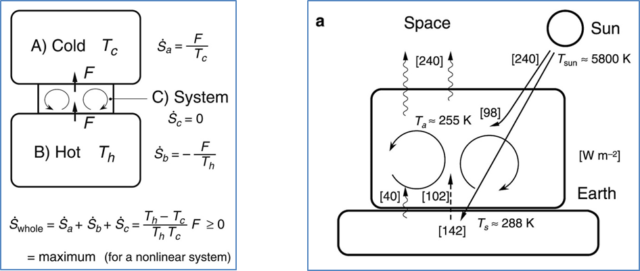

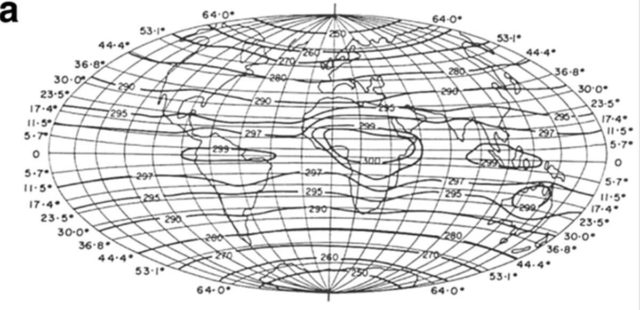

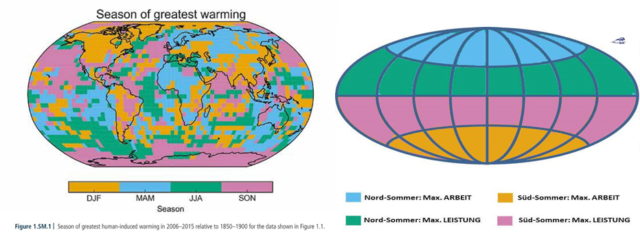

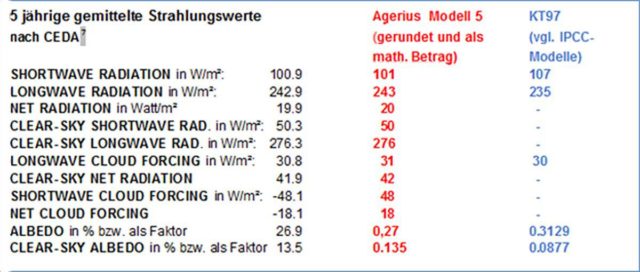

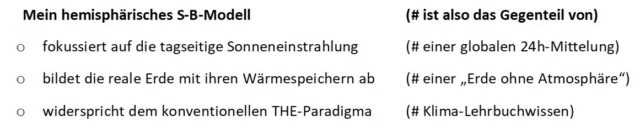

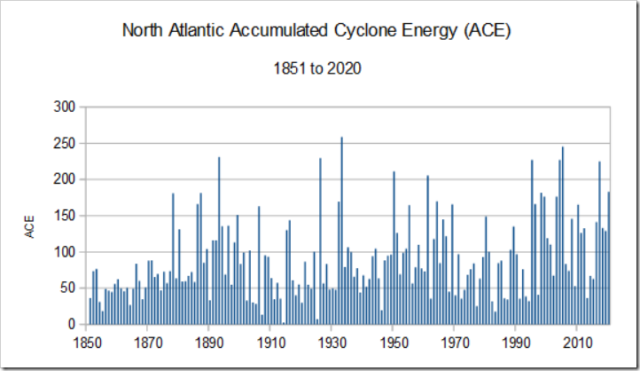

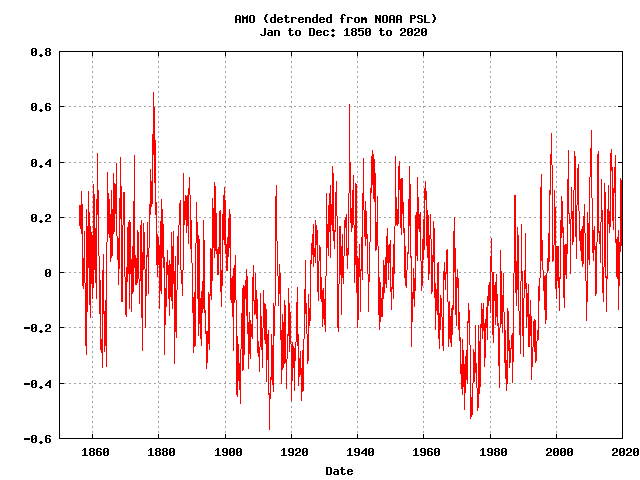

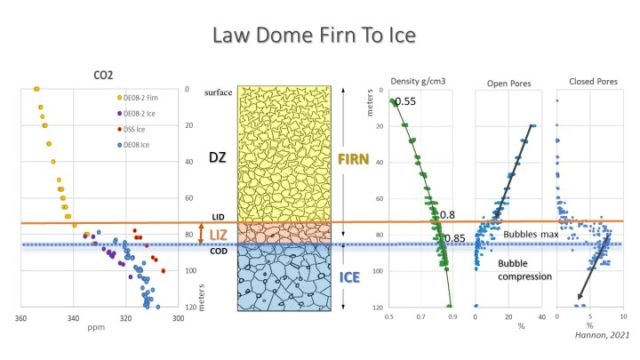

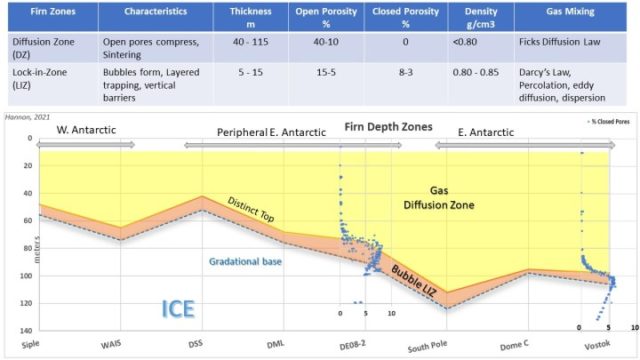

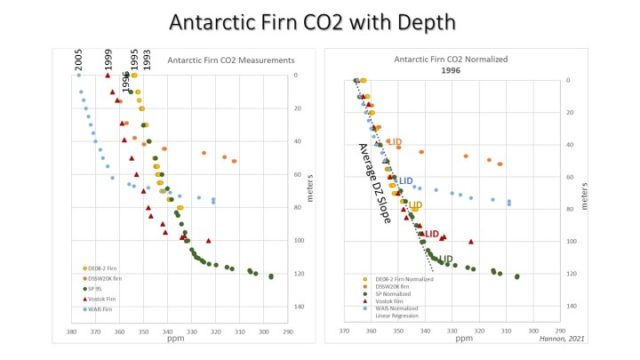

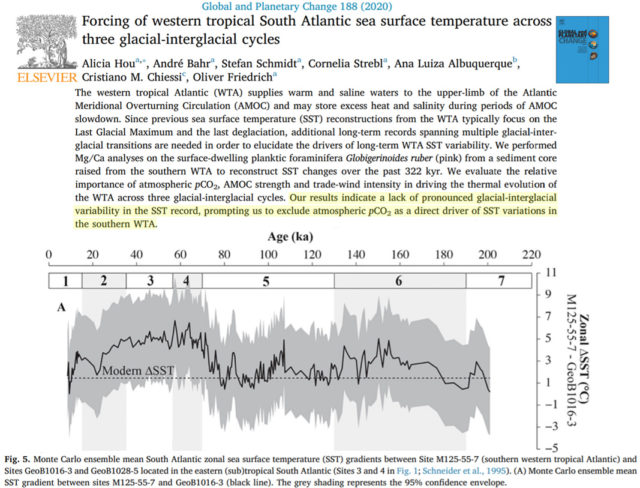

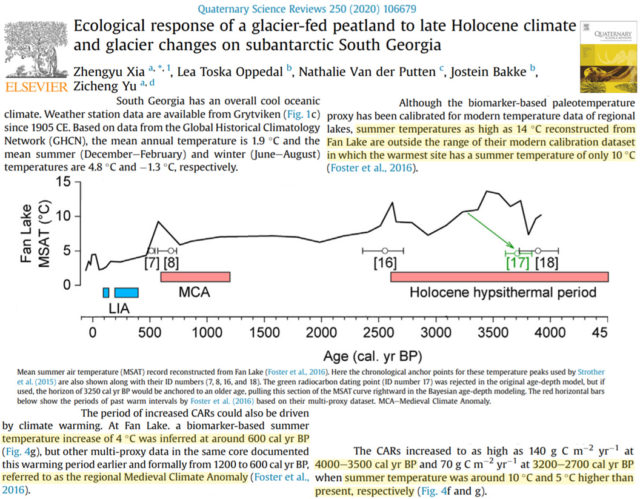

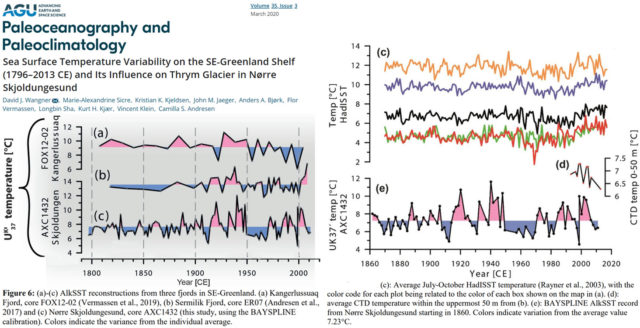

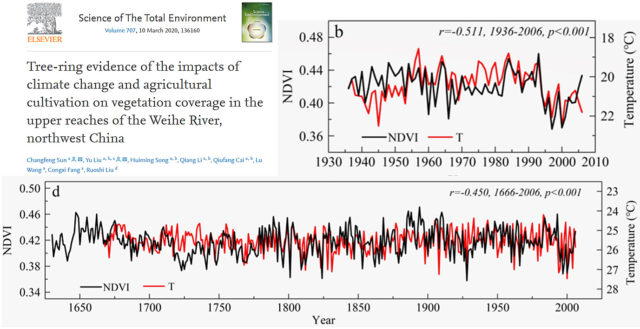

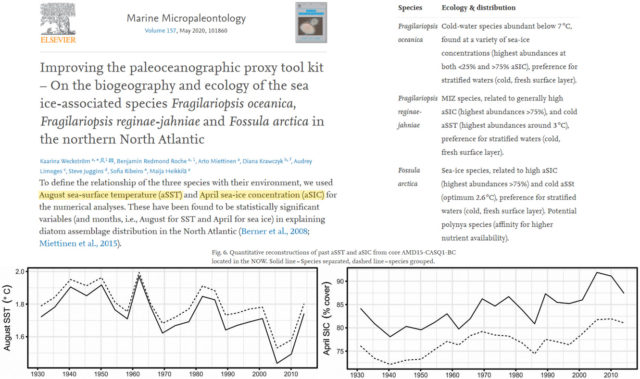

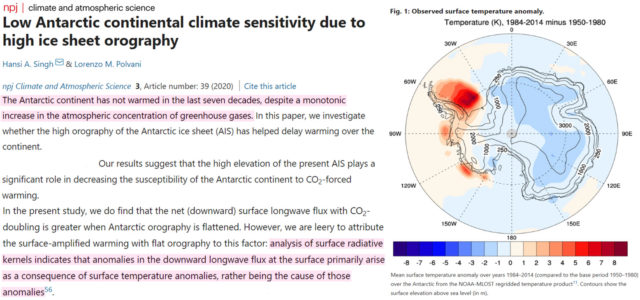

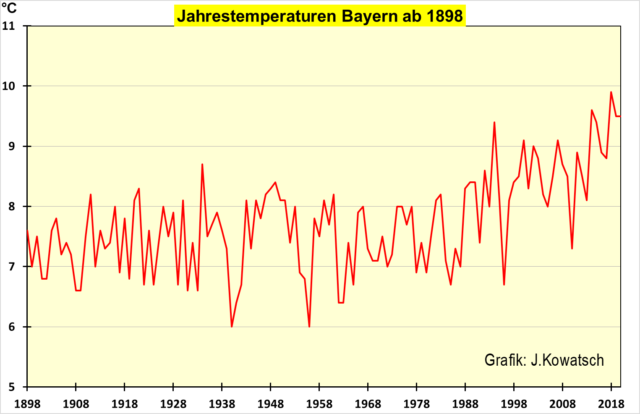

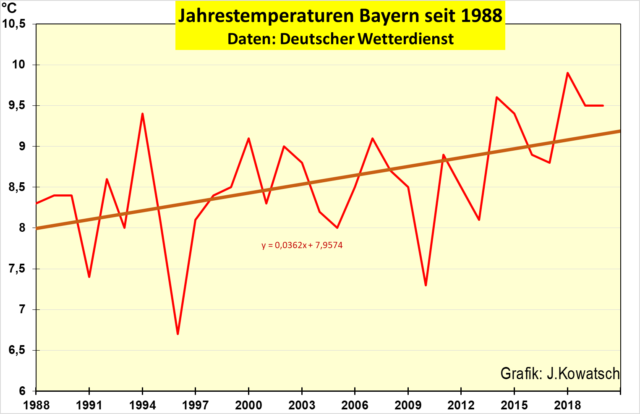

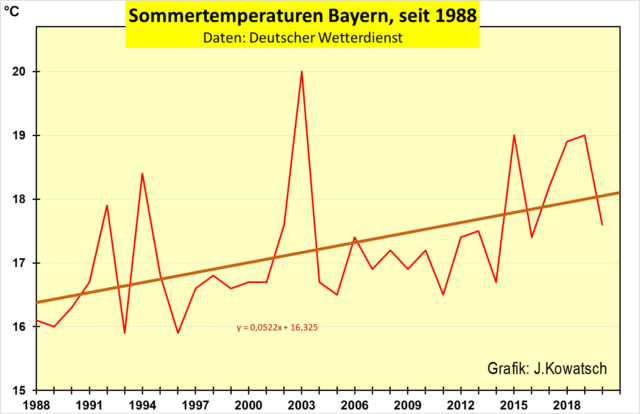

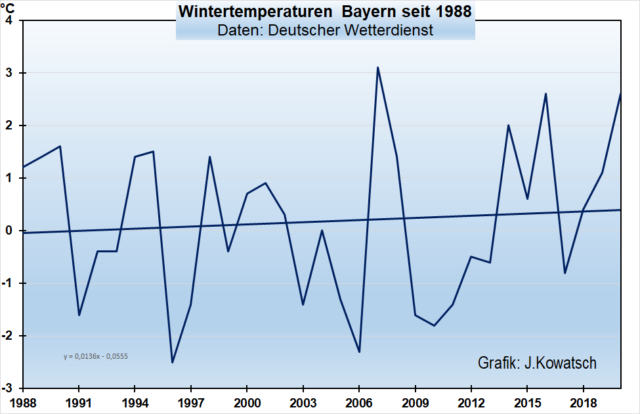

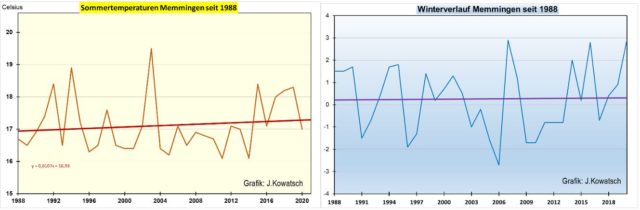

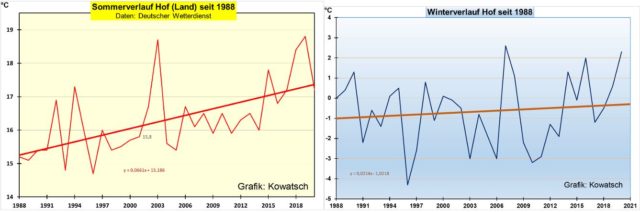

Ähnlich einseitig die Position der Bundesregierung beim Klimaschutz. Hier war jahrelang engster Berater Merkels der frühere Präsident des PIK Hans-Joachim Schellnhuber, der es in einer Veröffentlichung 2018 unter Berufung auf das Eintreten fiktiver „Kippelemente“ tatsächlich fertig brachte, die Gefahr einer Erderwärmung um bis zu 8 Grad in diesem Jahrhundert an die Wand zu malen – etwa das Doppelte des negativsten Szenarios des Weltklimarats IPCC (zur Kritik vgl. Nahamowitz 2020 a). Die ausführlich begründete klimaskeptische Gegenposition entthront das CO2 als Haupttreiber des Klimas und ersetzt es zumindest zu 50 % durch die Sonne und diverse ozeanische Oszillationen. Sie ist kürzlich noch einmal ausführlich von Vahrenholt / Lüning (2020) begründet worden – und bleibt von der Politik und den Mainstream-Medien unbeachtet, obwohl sie mit ihrer (m.E. selbst wieder problematischen) grundsätzlichen Anerkennung des CO2 als etwa hälftigem Klimaverursacher zwischen dem alarmistischen und dem skeptischen Klimaparadigma eine vermittelnde Position einnimmt.

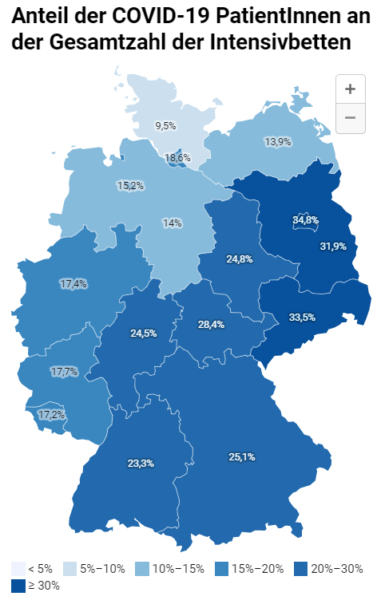

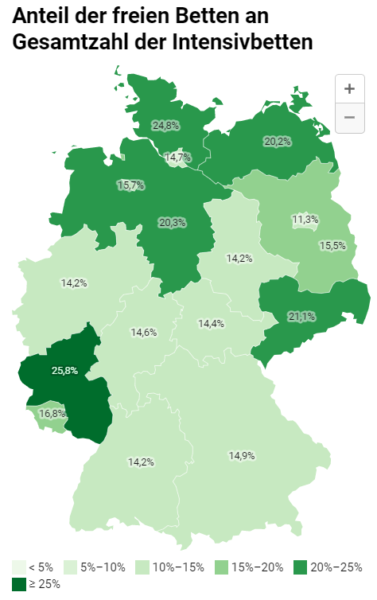

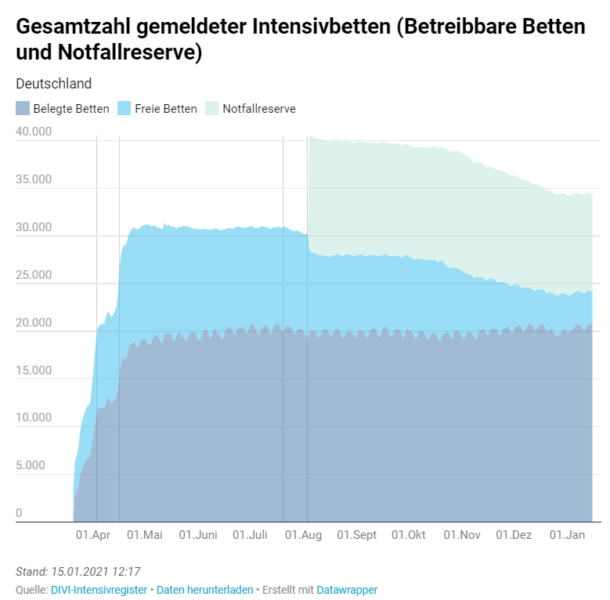

Bei Corona ist Merkels engster Berater der Berliner Virologe Christian Drosten, der zusammen mit dem RKI schon bei der Schweinegrippe ( 2009 / 2010 ) durch völlig übertriebene Warnungen aufgefallen war (Reiss, Bhakdi 2020, 121 f). Seit kurzem ist als ihr Berater der Braunschweiger studierte Physiker Meyer-Hermann hervorgetreten, der aber seinem Kollegen Drosten in seiner Vorliebe für harte Lockdowns in nichts nachsteht und der wahrscheinlich bei der Lockdown-Empfehlung der Leopoldina eine treibende Kraft war. Diese in Deutschland und europaweit dominierende Position hat das Ideal eines unbarmherzigen Schlages in Form eines möglichst harten Lockdowns, der das Virus ein für alle Mal vertreibt oder zumindest – so bescheiden ist man zum Teil mittlerweile geworden – eine Zeitlang still stellt, so dass das Gesundheitssystem vor Überlastung bewahrt wird.

Diese Strategie ist mittlerweile dabei, sich selbst ad absurdum zu führen, wird sie gegenwärtig in Deutschland doch zum zweiten Mal probiert und in Österreich und Italien zum dritten Mal – innerhalb von 9 Monaten. Diese Strategie ist frustran und teuer, ihre Protagonisten sollten anerkennen, dass das Virus gekommen ist, um zu bleiben. Auch mit der Grippe existiert in den modernen Gesellschaften eine ( mitunter spannungsvolle ) Koexistenz. Die mögliche Konsequenz daraus kann nur sein: Die finanzielle und personelle Ausstattung des Gesundheitssystems zu optimieren, auch in Vorsorge gegen künftige Epidemien, die wirklich gefährlich sind, anstatt dort nach gewohntem Muster zu sparen.

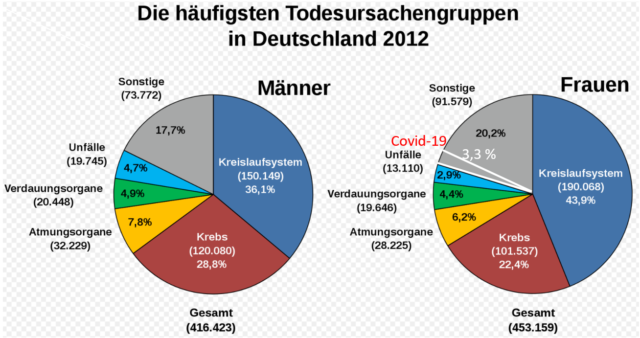

Die epidemiologisch vorzüglich begründete, explizit auf Evidenz basierende Gegenposition wird in Deutschland vor allem vom Professoren-Ehepaar Reiss / Bhakdi (2020), dem früheren Amtsarzt und Bundestagsabgeordneten Wolfgang Wodarg und auf internationaler Ebene vom Stanford-Professor John Joannidis (2020) vertreten. Diese Richtung hebt ab auf die relativ niedrige, einer mittelstarken Grippe vergleichbare Letalitätsrate von SARS-CoV-2, auf den quantitativ und qualitativ erheblichen Unterschied von „an“ und „mit“ Corona Verstorbenen sowie die Unterscheidung von Infizierten und Erkrankten. Sie betont die Unzuverlässigkeit des nicht validierten und nicht für die klinische Diagnose zugelassenen PCR-Tests und macht auf den systematischen Zusammenhang von ansteigenden Fallzahlen und Zunahme der Testungen aufmerksam. Nicht zuletzt gewinnt sie ein realistisches Bild von der quantitativen Bedeutung der Corona-Sterbezahlen, indem sie diese in Beziehung setzt zu anderen Todesarten wie Herz-Kreislauferkrankungen, Krebs, Lungenentzündung u.a.

Als praktische Handlungsempfehlung folgt aus diesem Konzept 1. die sofortige Beendigung der repressiven Containment-Politik für die allgemeine Bevölkerung, 2. die Konzentration der Ressourcen auf die verwundbaren Gruppen der Bevölkerung, vor allem die über 70-jährigen mit Vorerkrankungen sowie 3. die Aufhebung der erwiesenermaßen wirkungslosen Maskenpflicht, soweit sie die Alltagsmasken betrifft. In diesem dritten Punkt sowie in dem Verzicht auf das bundesweite Ampelsystem bestehen die entscheidenden Unterschiede zur Reformgruppe um Gassen und Streeck.

Das Ohr der Politik erreichen beide Reformgruppen nicht, Merkel und die Länder-MP setzen ihre unbeirrt lernresistente Linie fort. Angesichts der nahezu weltweiten Lernresistenz der Politik erkennt Joannidis keine Corona-Krise, sondern eine „Krise der Evidenz“.

Zweifel an der Urteilsfähigkeit Merkels sind nicht nur in Sachen Wissenschaft, sondern auch bei relativ banalen Angelegenheiten angebracht. Man erinnere ihren Versuch, dem Fernsehpublikum die Funktionsweise des Reproduktionswerts R zu erklären, Bekanntlich bedeutet R = 1, dass ein Infizierter einen anderen Menschen ansteckt, Was aber bedeutet R = 1,1 oder R = 1,3 ? Bei dem Versuch. diese Frage zu beantworten, gerät die promovierte Physikerin Merkel so vollständig in die Konfusion, dass die Antwort unverständlich ausfällt. Der Zuschauer ist ratlos, sollte die Kanzlerin tatsächlich intellektuell überfordert sein?

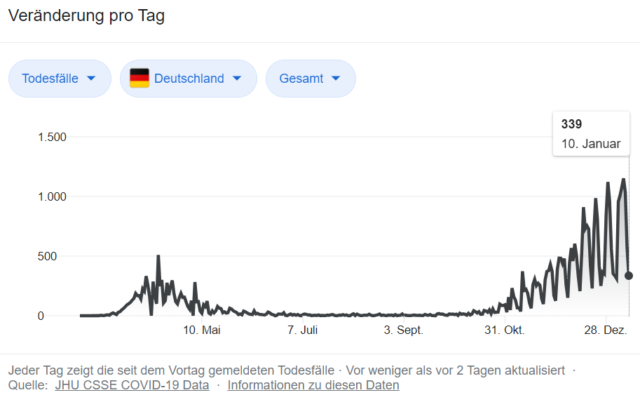

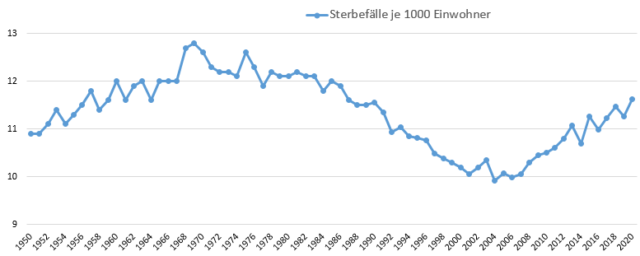

Bei den Hausberatungen in der ersten Dezemberhälfte zeigt Merkel einmal mehr ihr unzureichendes Verständnis der Corona-Realität, wenn sie angesichts der RKI-Zahlen des Tages klagt : „ 590 Tote ! Es tut mir so leid“. Der Ausspruch deutet darauf hin, dass sie erstens nicht weiß, dass in Deutschland die durchschnittliche tägliche Sterbezahl bei 2600 liegt, die doch alle wohl ebenfalls Mitleid verdienen und ihr zweitens unbekannt ist, dass mindestens 80 % keine „echten“ Corona-Tote, sondern nur „mit“ dem Virus Gestorbene sind. Bei so viel Unwissenheit wird man schließlich nicht von ihr verlangen können, dass sie die für Deutschland auch im Corona-Jahr 2020 relevanten Phänomene der Untersterblichkeit bzw. nur leichten Übersterblichkeit (s. unten unter 3.) kennt.

Bei der Haushaltsrede Merkels am 9. Dezember ereignete sich auch noch ein bezeichnender Zwischenfall. Auf den Zwischenruf eines AfD-Abgeordneten : „Das ist doch alles nicht bewiesen“. antwortet sie direkt – und zwar unter Bezug auf ihr Physikstudium in der DDR – mit dem Hinweis auf die unabänderliche Kraft der „Schwerkraft“ und der „Lichtgeschwindigkeit“. Was genau sie damit meint, bleibt unklar. Anscheinend möchte sie wohl der von ihr verfolgten Strategie der Corona-Abwehr den Status unverbrüchlicher Naturgesetzlichkeit verleihen. Die ignorante Schlichtheit des Arguments macht ziemlich fassungslos.

Schon während der Haushaltsberatungen drang zunehmend der Ruf einiger Länder-MP nach einem baldigen harten Lockdown durch. Hinter dem Vorschlag steht ein fehlgeleitetes Coronaverständnis, welches erstens Corona als verhängnisvolles Killervirus und zweitens als ein radikal aus dem Land zu vertreibendes Agens auffasst. Diese unterkomplexe Auffassung wird vor allem von den traditionellen Virologen vertreten. Epidemiologen sehen Corona zumeist differenzierter. Zwischen den traditionalistischen Virologen a` la Drosten, Lauterbach, Wieler und Co. einerseits und den evidenzbasierten Epidemiologen um Reiss /Bhakdi und Joannidis andererseits nimmt die Gruppe um die Virologen Streeck und Schmidt-Chanasit sowie den KBV-Vorstandsvorsitzenden Gassen so etwas wie eine Mittelstellung ein.

Streeck fasst sie gerne in die Formel, dass das Corona-Virus einerseits zwar „ernst zu nehmen“, andererseits aber „nicht zu überdramatisieren“ sei. Mit letzterer Wendung wird der Lockdown als Instrument der Infektionsbekämpfung implizit ausgeschlossen. Auch vertritt er die Auffassung, dass das Corona-Virus hier sei, um zu bleiben und sich den anderen vier schon seit Jahrzehnten hierzulande residierenden Corona-Virenstämmen bei zu gesellen.

Beides dürfte der wesentliche Grund dafür sein, dass die Gruppe, obwohl anders als Bhakdi, Joannidis und Co. fest im deutschen medizinischen Establishment verankert, keine Chance hatte, das Ohr der Kanzlerin und der MP zu erlangen. Die politische Vereinigung der Corona-Dilettanten aus Bund und Ländern sträubt sich mit aller Macht gegen epidemiologische Aufklärung.

Am 13. Dezember nun wurde ein harter Lockdown von eben dieser Dilletantenrunde zunächst einmal bis zum 10. Januar beschlossen. Die einzelnen Bestandteile eines harten Lockdowns sind aus dem Frühjahr bekannt, ich gehe nicht näher auf sie ein.

Nur Weihnachten erhielt eine spezielle Regelung. Das weihnachtliche Feiern machte der Politik größte Sorgen. So bemühten sich etwa Gesundheitsminister Spahn und Bundespräsident Steinmeier, den Bürgern die altruistischen Vorteile ungeselliger Weihnachtsfeiern (z.B. zugunsten des Pflegepersonals) schmackhaft zu machen. Ein Eindämmungskonzept, welches sich derartiger Überredungsstrategien glaubt bedienen zu müssen, zeigt sehr deutlich seine Hilflosigkeit.

Die Auseinandersetzung zwischen den konkurrierenden Corona-Konzepten fand ihren vorläufigen Abschluss durch einen kürzlich erfolgten Aufruf hunderter europäischer Wissenschaftler zu Gunsten einer strengen Politik des Containement für einen längeren Zeitraum und abgestimmt unter den europäischen Staaten. Der Aufruf wurde im renommierten Fachjournal „Lancet“ am 19. Dezember d. J. veröffentlicht. Im Kern verfolgt er die gleiche stramm virologische Konzeption wie auch die Leopoldina., welcher der deutsche harte Lockdown-Beschluss nahezu nahtlos gefolgt war.

Es verwundert daher nicht, dass der Aufruf von den deutschen strammen Virologen-Virologen Drosten, Wieler und z.B. Brinkmann unterzeichnet ist, Ebenso unterzeichnet haben die Präsidenten der Leopoldina und der großen Wissenschaftsorganisationen. Bei letzteren ist freilich keine Sachkompetenz zu unterstellen, genauso wenig wie bei dem mitunterzeichnenden Ökonomen und IfO-Präsidenten Clemens Fuest.

Ziel ist die Senkung der Fallzahlen auf den Stand von Ländern wie China und Australien. Mit „entschlossenem Handeln“ und „tiefgreifenden Interventionen“ soll innerhalb von 2 Wochen der R-Wert auf 0,7 gesenkt und die 7-Tage-Inzidenz von 200 auf 50 gesenkt werden. Diese Holzhammertherapie soll offenbar an die in Deutschland und anderen Ländern seit Wochen exekutierten Lockdowns angeschlossen werden. Das ultimative Zeil ist aber noch weit ehrgeiziger: eine Inzidenz von maximal 7 auf 100 000 Einwohner , zu erreichen „spätestens im Frühjahr“.

Der Aufruf scheint mir das typische Produkt enthemmter Virologenphantasien zu sein, welcher die Folgebereitschaft einer bereits sehr Corona-müden Bevölkerung deutlich überschätzt und die mannigfachen Folgeschäden der Therapie mit dem Holzhammer unterschätzt. In China jedenfalls dauerte die Phase des harten Lockdowns nur 4 Wochen. Dass dieses riesige Land nun gänzlich frei von Corona ist, lässt m.E. nur eine Erklärung zu: Es wird – im Vertrauen auf die relativ geringe Gefährlichkeit des Virus – nicht mehr getestet.. Dann wird das Virus auch nicht mehr gefunden. Aufgrund seiner relativ geringen Letalitätsrate birgt diese Strategie auch kein untragbares Risiko für die Machthaber.

Im übrigen weist der Appell die bekannten epidemiologischen Defizite auf und zeigt noch einmal. dass die Virologen die Epidemiologie nicht können. Ich nenne drei prinzipielle Kritikpunkte :

-

Es wird ignoriert, dass SARS-CoV-2 die Gefährlichkeit nur eines mittleren Grippevirus hat. Ein solches hat noch nie auf der Welt staatliche Zwangsmaßnahmen hervorgerufen. Typisch für die unzureichende wissenschaftliche Qualifikation der Verfasser ist, dass das Bulletin der WHO vom 14. Oktober ignoriert wird, in dem die Organisation das Ergebnis der umfangreichen Metaanalyse von John Joannidis sich zu eigen macht. Nach ihr liegt die Median-Covid-19-Infektionssterblichkeitsrate bei nur 0,23 % und damit auf dem Niveau eines mittelstarken Grippevirus. Das bedeutet 2300 Tote auf 1 Mio. Infizierte (bei gegenwärtig gut 1,7 Mio. positiv Getesteten in Deutschland), was denjenigen nicht zu erschrecken braucht, der weiß, dass gegenwärtig hierzulande, wie bereits erwähnt, 2600 Menschen pro Tag sterben.

-

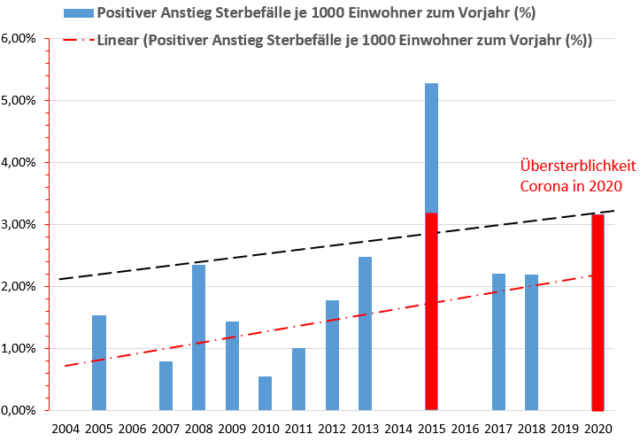

Ausfluss der geringen Sterblichkeitsrate ist, wie im 3. Abschnitt belegt wird, dass Deutschland im Jahr mehrerer Lockdowns keine signifikante Übersterblichkeit und damit auch keine „epidemische Lage von nationaler Tragweite“ aufweist. Damit entfällt überhaupt die Grundlage für Zwangsmaßnahmen nach dem InfektionsschutzG.

-

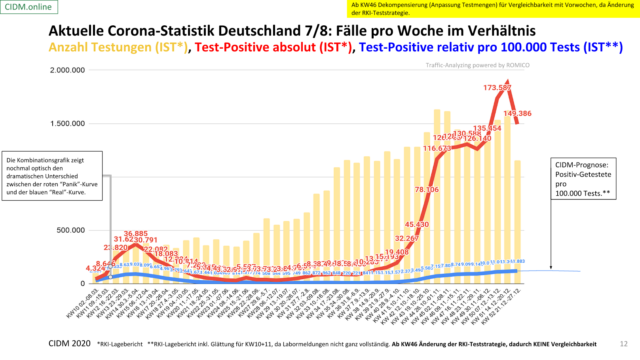

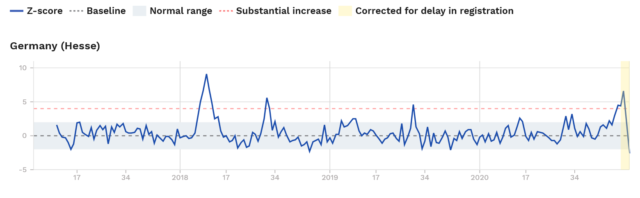

Unbekannt ist den Initiatoren ebenfalls, dass der rasche Anstieg der Fallzahlen seit September / Oktober überwiegend der Verdopplung der Testungen geschuldet ist (CIDM.online, Grafik 7 / 8). Die kritischen Beobachter des Infektionsgeschehens sprechen von „Labor -Pandemie“.

Einen Tag nach Veröffentlichung des Aufrufs erschien die Meldung, dass in England eine Mutation des Corona-Virus mit um 70 % erhöhter Infektiösität aufgetaucht sei. Damit scheint allen überambitionierten Eindämmungsphantasien bezüglich des Virus. wie sie der „Lancet“- Aufruf aufweist, ein Riegel vorgeschoben. Eindämmungszeit und / oder regulatorischer Eindämmungsaufwand müssten sich um den genannten Prozentsatz erhöhen. Und zwar in ganz Europa, denn das mutierte Virus hat inzwischen auf dem Festland Fuß gefasst. Am 5. Januar 2021 hat denn auch der englische Premierminister die Konsequenz gezogen und einen harten Lockdown angeordnet, begründet u.a. mit der Mutation des Virus. Der Chef von Biontech brauchte nur verdächtig wenige Tage um zu versichern, dass der Impfstoff von Biontech / Pfizer auch gegen das mutierte Virus wirke.

Zum Schluss noch einmal zurück zu Angela Merkel, und zwar zu ihrer Neujahrsansprache. Nun verwandelt sich die Irritation endgültig in Verärgerung. Die Kritiker der staatlichen Maßnahmen werden nach dem bereits sattsam Muster politischer Verunglimpfung als „unverbesserliche Leugner des Virus“ bezeichnet und mit „Verschwörungstheorien“ in Zusammenhang gebracht. Die Kritiker leugnen aber in der Regel nicht die Existenz des Virus, sondern kritisieren die überbordende Unverhältnismäßigkeit der Maßnahmen, von der eine auch nach 10 Monaten Krise immer noch schlecht informierte Kanzlerin auch nicht den Hauch einer Ahnung hat. Ich gebe nur zwei Stichworte: Erstens, die exponentiellen Fallzahlen existieren bei korrekter Zählung nicht und zweitens, die Todeszahlen sprengen nicht den Rahmen des Üblichen der letzten Jahre. Damit ist der staatlichen Containement-Politik der epidemiologische und rechtliche Boden entzogen. Darüber weiter unten mehr.

Der zweite Punkt ist der Drosten-Test, den die Kanzlerin als „zuverlässig“ bezeichnet. Hier stellt sich sehr unmittelbar die Frage, weiß sie es nicht besser oder lügt sie. Es ist allseits bekannt, dass der Test nicht validiert und demgemäß offiziell für die klinische Diagnose nicht zugelassen ist. Die kritischen Experten gehen bei den positiv Getesteten von eine Fehlerquote von 1-3 % aus („falsch positiv“). Der deutsche Rechtsanwalt Dr. Rainer Fuellmich, der mit amerikanischen Kollegen eine Sammelklage („class action“) auf Schadensersatz gegen die Herren Drosten, Wieler und Spahn vor einem amerikanischen Zivilgericht anhängig gemacht hat, geht von einer Fehlerquote bis zu 97 % aus. Andere Klagen, auch gegen staatliche Stellen, sind in weiteren Ländern (Österreich, England) in Vorbereitung oder bereits anhängig. Von dieser Seite könnte aus der „Jahrhundertaufgabe“ der Pandemiebekämpfung, von der Merkel spricht, eine Jahrhundertpleite für die Politik werden,

2. Die absurde Jagd auf die „Infektions“-Zahlen

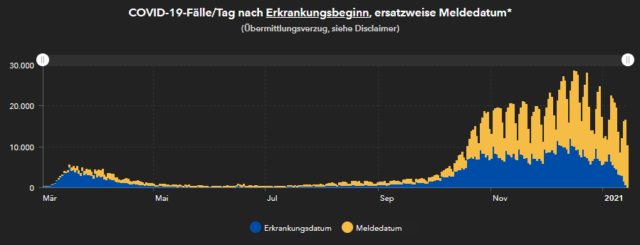

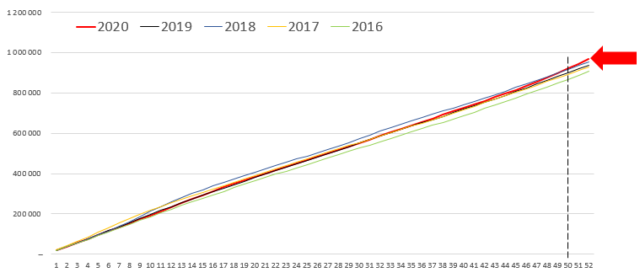

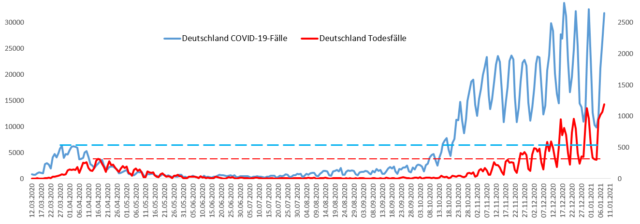

Seit Ende September / Anfang Oktober befinden sich in Deutschland die absoluten Zahlen der positiv Getesteten in einem steilen Anstieg – der Anlass für die seit Anfang November hierzulande eingeschlagene Politik der Lockdowns. Deren politischen Initiatoren ist offensichtlich unbekannt, dass primärer Grund für den Anstieg der absoluten „Infektions“-Zahlen die Verdopplung der Testungen ab Mitte August ist – ein schockierender Fall staatlicher Ignoranz.

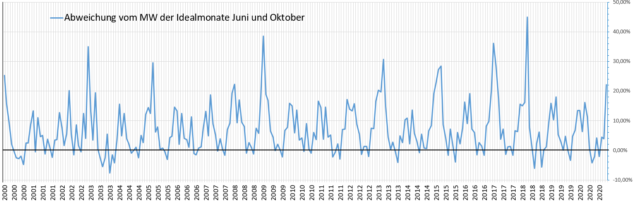

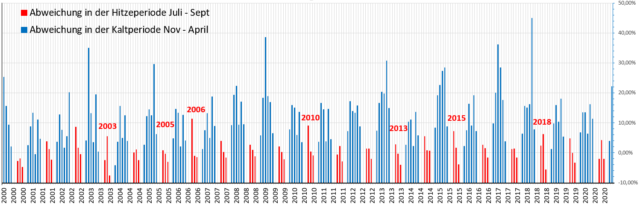

Oder doch nicht? Es ist öffentlich geworden, dass zumindest Gesundheitsminister Spahn und das RKI um den systematischen Zusammenhang von Fallzahlen und Häufigkeit der Testungen wissen. Die absoluten Fallzahlen verlieren ihren Schrecken, wenn sie richtigerweise korrigiert und auf 100 000 Testungen bezogen werden. Dann tritt an die Stelle der roten ( „exponentiellen“) „Panik“-Kurve die blaue „Real“-Kurve mit ihrem nur sanften Anstieg ( vgl. unten die Graphik 7 / 8 von CIDM. online ). Diese Graphik hatte ich schon in meinem letzten Artikel herangezogen (Nahamowitz 2020 c), nun geht ihre Zeitreihe bis zum Jahresende (KW 52).

Die Schlussfolgerungen bleiben die gleichen: Von einer „exponentiellen Infektionsdynamik“ und einer „drohenden Überforderung des Gesundheitswesens“ kann keine Rede sein, weder eine „erste“ noch eine „zweite“ Infektionswelle sind für das Jahr 2020 auffindbar. Der Kampf der Politik gegen die steigenden „Infektions“-Zahlen erinnert stark an den dichterisch beschriebenen Kampf des Don Quixote gegen die Windmühlen, die nur in der Phantasie des verblendeten spanischen Edelmannes eine Gefahr darstellten.

Die frühzeitige Veröffentlichung der „Realkurve“ schon im Frühjahr hätte die Hysterie um Corona im Keim erstickt. Dass sie unterblieben ist, stellt eine Amtspflichtverletzung der im RKI und im Gesundheitsministerium Verantwortlichen i. S. von Art. 34 GG / § 839 BGB dar und berechtigt die durch die Corona-Maßnahmen Geschädigten zu Schadensersatz gegen den Staat.

Sehr dubios ist auch die von Beginn an praktizierte kombinierte Zählweise des RKI der „an und mit“ Corona Gestorbenen. Schon diese Kombination ist eine permanente Verletzung ärztlicher Leitlinien (Reiss / Bhakdi, 18). Da kommt es gegenwärtig zu Zahlen von mehreren hundert bis über 1000 täglichen „Corona-Toten“ – Zahlen, die völlig unglaubhaft sind. Der Anteil der Atemwegserkrankungen an den Todesarten in Deutschland liegt seit langem bei ungefähr 10%, der von Krebs bei einem Viertel und der Anteil der Herz-Kreislauferkrankungen bei einem Drittel, Täglich sterben etwa 2600 Menschen in Deutschland. 1000 „an und mit“ Corona, welche eine Atemwegserkrankung ist, Gestorbene würden einen Anteil von über einem Drittel ausmachen – völlig unglaubhaft. Hier sind im großen Stil Umverteilungen innerhalb der Todesarten hin zu Corona vorgenommen worden. Daher ist von einer weiteren Amtspflichtverletzung des für die Zählung verantwortlichen RKI auszugehen..

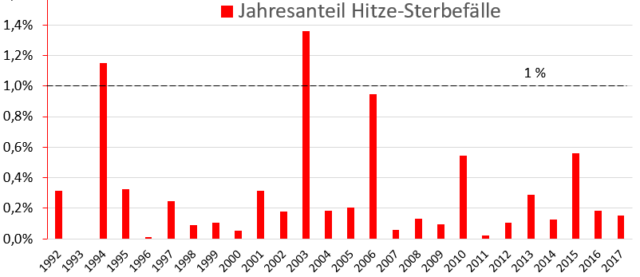

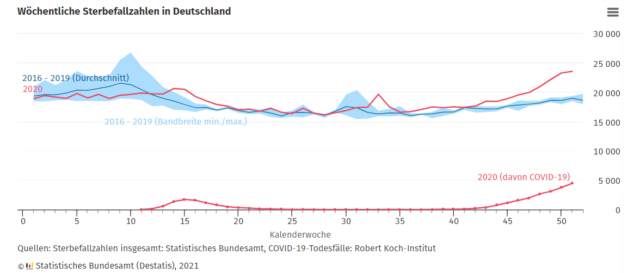

Nach der kompetenten Schätzung der Corona Initiative Deutscher Mittelstand (CIDM) betrug im vergangenen Jahr der Anteil der „echten“ Corona-Toten, d.h. „an“ Corona Verstorbenen, an allen Verstorbenen nicht mehr als 1,1 % (CIDM. online, Graphik Sterbefallzahlen Deutschland). In absoluten Zahlen sind dies weniger als 30 täglich. Es wird Zeit, dass der schon bei der Schweinegrippe zu Tage getretene völlig übersteigerte Alarmismus des RKI beendet wird.

3. Über– und Untersterblichkeit in Deutschland

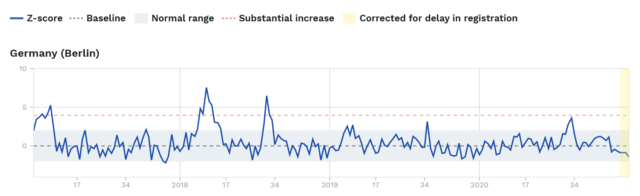

Für die Darstellung der Mortalität in Deutschland verwende ich die Daten von Euromomo (European mortality monitoring) in den alternativen Fassungen von Germany (Berlin) und Germany ( Hessen ). Die Daten des Statistischen Bundesamts (Destatis) finden keine Verwendung, da das Amt seit seinem Versuch, für die Corona-Monate im Frühjahr eine Phase von Übersterblichkeit für unser Land herbei zu rechnen, unter Manipulationsverdacht steht.

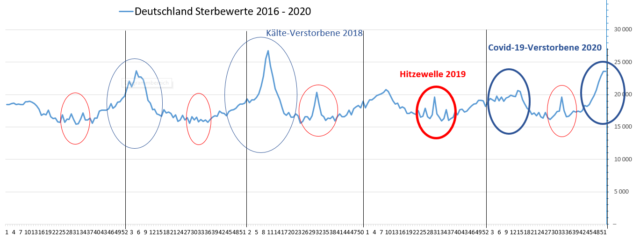

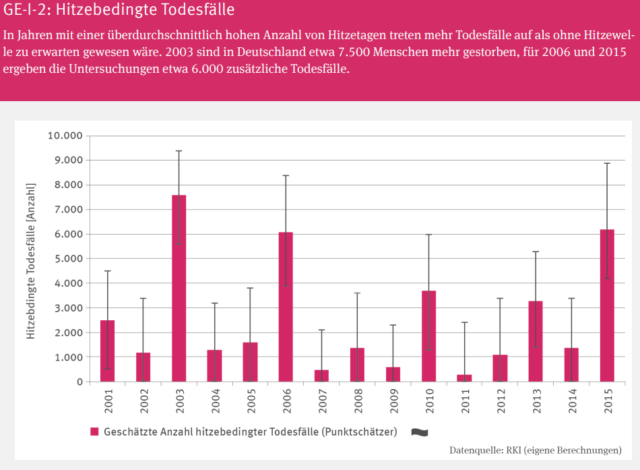

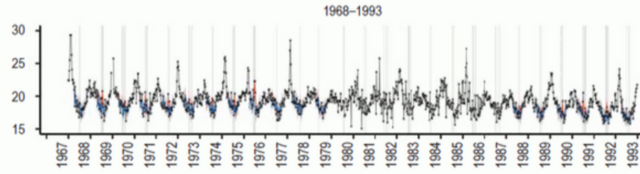

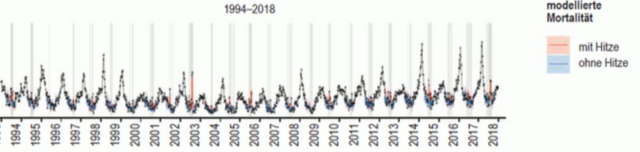

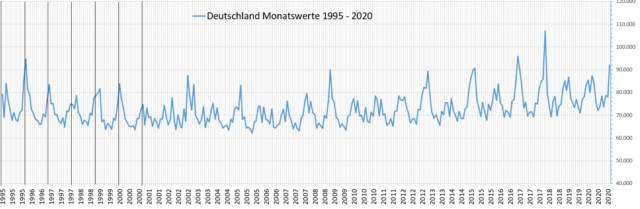

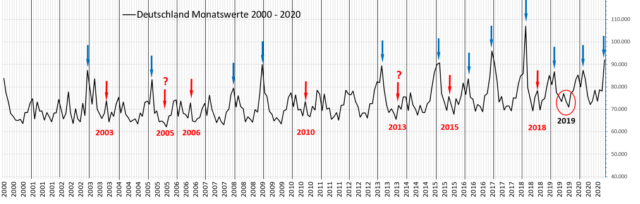

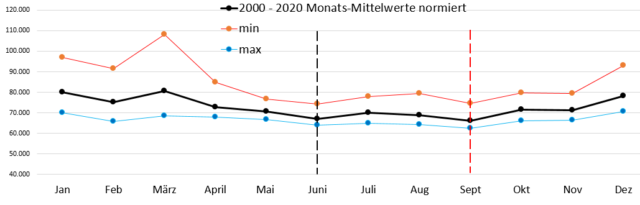

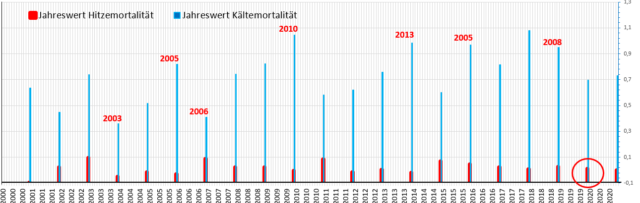

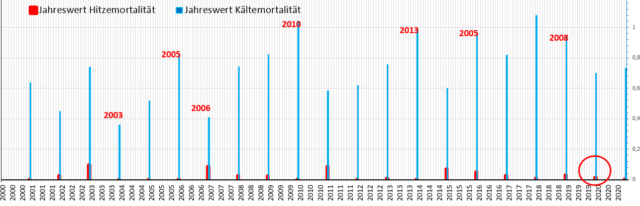

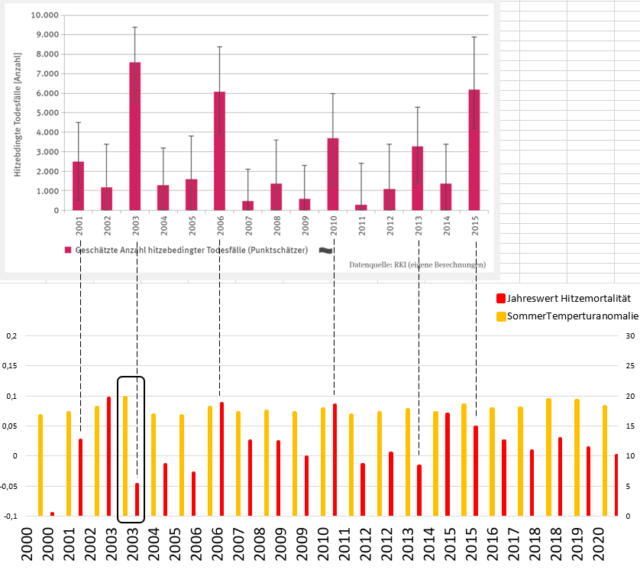

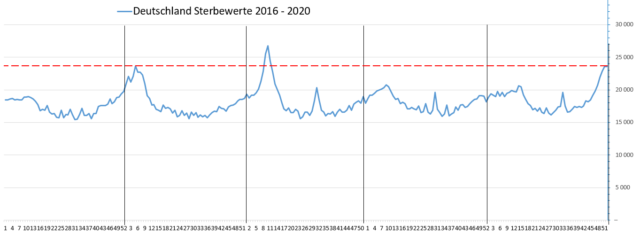

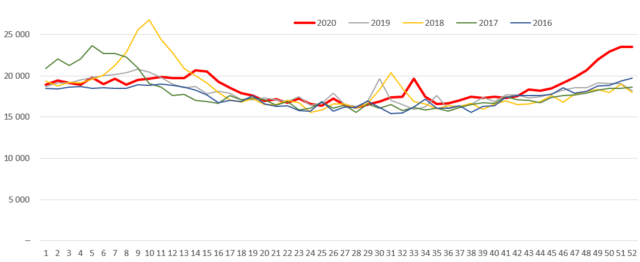

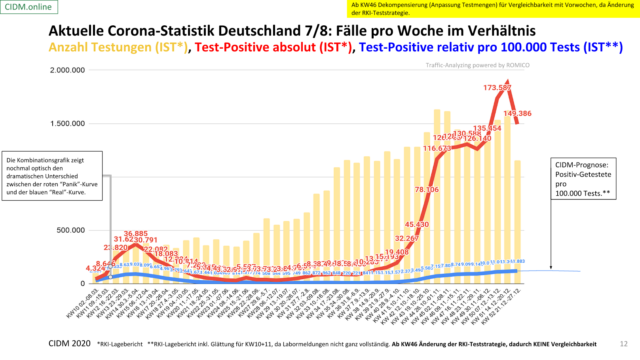

Schon mit bloßem Auge ist erkennbar, dass die Mortalitätsentwicklung gemäß Graphik Germany (Berlin) im Jahr 2020 flacher als in den Vorjahren ab 2017 verläuft, d. h. mit weniger Zacken nach oben (den Indikatoren für Übersterblichkeit). Das Jahr 2018 weist erkennbar die höchste Übersterblichkeit auf. In 2020 gibt es allein in KW 33 (3.8. – 9. 8.) einen Zacken etwas höherer Übersterblichkeit (Standardabweichung plus 3,44, wie uns der Cursor verrät). Dieser dürfte wie in den beiden Vorjahren der Sommerhitze geschuldet sein.

Von KW 47 (16. 11. – 22. 11.) an bis Jahresende , d.h. von der zeitlichen Mitte des Teil-Lockdown im November bis zum Jahresende befand sich das Land, wie uns der Cursor ebenfalls mitteilt, in einem Zustand leichter Untersterblichkeit. Aber der Öffentlichkeit wurde aus allen Rohren der Meinungsmanipulation, einschließlich der Alarmmeldungen des RKI, das Gegenteil erzählt. Und die Politiker, anscheinend von niemandem über die realen Mortalitäts- und damit Epidemieverhältnisse aufgeklärt, wurden zum Opfer ihrer eigenen Katastrophenlegenden (z. B.Söders Katastrophenalarm in Bayern Anfang Dezember).

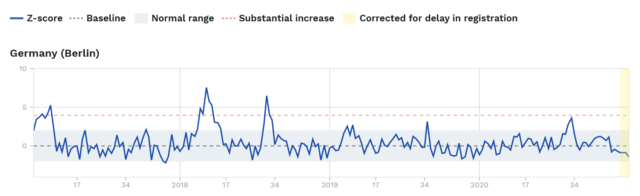

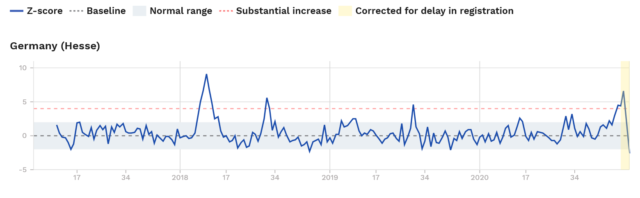

Die Graphikvariante Germany (Hessen) ergibt ein etwas anderes Bild. Hier ist die Übersterblichkeit in 2020 etwas (nicht wesentlich) stärker vertreten. Zunächst einmal im Vergleich zu den Vorjahren 2017 und 2019, ohne deren Sterblichkeit freilich signifikant zu übertreffen. Das Jahr 2018 weist weiterhin die höchste Übersterblichkeit auf. Vor allem aber befinden sich die Wochen während der beiden Lockdowns (ab KW 45) fast durchgängig im Zustand einer leichten Übersterblichkeit – bis auf die KW 50 und 51 mit einer deutlicheren Übersterblichkeit, (Standardabweichung plus 5,44 und 4,30) die aber durch die deutlichere Untersterblichkeit der KW 52 (Standardabweichung minus 2,56) etwas ausgeglichen wird.

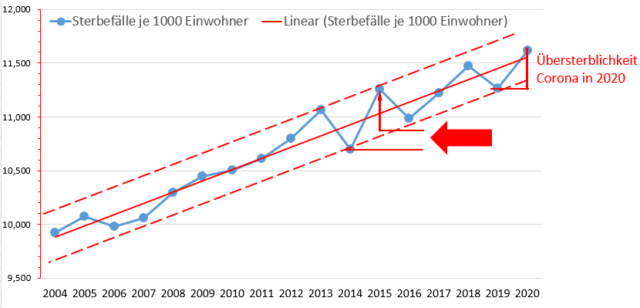

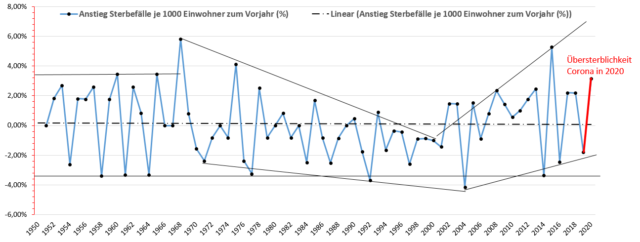

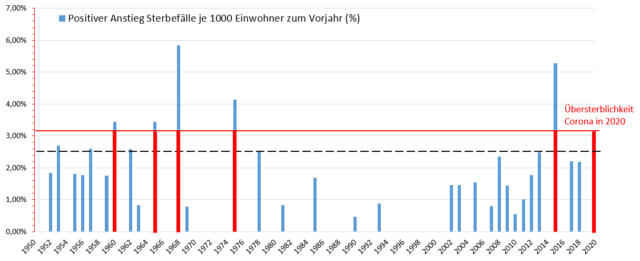

Nimmt man die Aussagen beider Kurven, die leichte Untersterblichkeit von Germany (Berlin) und die leichte Übersterblichkeit von Germany (Hessen), zusammen, ergibt sich für ganz Deutschland im Jahr 2020 grosso modo das Bild einer Mortalität, welche der durchschnittlichen Entwicklung seit vier Jahren entspricht. Daraus folgt, dass in Deutschland eine „epidemische Lage von nationaler Tragweite“, wie sie der Bundestag gem. §5 Abs.1 Infektionsschutzgesetz festgestellt hat, zu keiner Zeit auffindbar war. COVID-19 ist keine „bedrohliche übertragbare Krankheit““ i.S. des § 5 Abs. 1 Nr. 1 und 2 IfSG. Der Beschluss des Bundestags gehört daher schon lange aufgehoben.

Auch im internationalen Vergleich ist die Mortalität Deutschlands nicht besorgniserregend. Euromomo unterscheidet sechs Stufen der „Exzess-Mortalität“, reichend von „No excess“ bis „Extraordinary high excess“.

Die Rangfolge der Länder ( Stand: Ende 2020, KW 52 ) :

No excess: Germany (Berlin), Sweden, Finland, Norway, Estonia, Ireland. UK (Wales), UK (Scotland), Hungary, Spain.

Low excess : Germany (Hessen), France, Denmark, Belgium, Greece, Estonia.

Moderate excess , UK (England), Austria, Netherlands, Italy, Portugal.

High excess : Slovenia.

Very high excess: Switzerland.

Extraordinary high excess : –

Bemerkenswert ist die Position Deutschlands (Hessen), die sich im Dezember innerhalb eines Tages um zwei Stufen auf moderate excess verschlechtert hatte, aber in KW 52 auf low excess zurück gegangen ist. Germany (Berlin) hingegen blieb durchgängig auf No excess. Die gute Performance unseres Landes bei der Mortalität zeigt sich auch international.

Erfreulich auch die sehr gute Stellung Schwedens, welches allen, vor allem deutschen Anfeindungen (einschließlich dreisten fake news) zum Trotz, als einziges Nicht-Lockdown-Land eine Reihe von Lockdown-Ländern hinter sich gelassen hat und mit anderen auf der gleichen Stufe No excess steht.

4. Der fällige Offenbarungseid der Corona-Politik

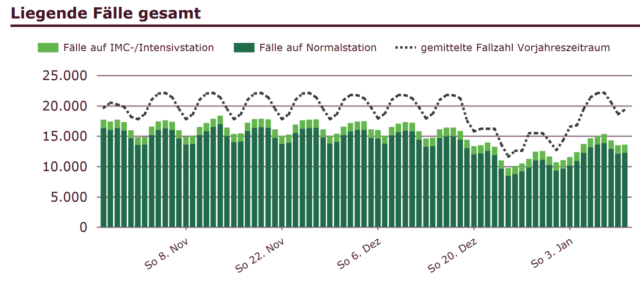

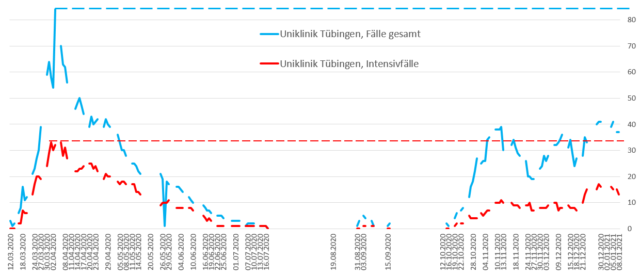

Das von verschiedenen Variationen staatlicher Corona-Eindämmung regulierte Jahr 2020 zeigt nach seiner Beendigung, dass für die `überkommene Corona-Politik die Zeit des Offenbarungseids gekommen ist. Der politische Offenbarungseid hätte offen zu legen, dass die Daten von 2020 nicht mit den Zielen der Corona-Politik überein stimmen, die „Infektions“-Zahlen auf die 7-Tage-Inzidenz von 50/100 000 zu reduzieren und so zu einer deutlichen Entlastung der krisenhaft überlasteten Intensivstationen zu kommen.

Denn die „Infektions“-Zahlen sind bei korrekter Zählung, welche sie auf 100.000 Testungen bezieht, weder exponentiell ansteigend noch sonst besorgniserregend. Die „Realzahlen“ zeigten im Frühjahr und zeigen gegenwärtig nur einen sehr sanften Anstieg. Dies gilt es von der Politik nun anzuerkennen. Und die Mortalität des zu Ende gegangenen Jahres übersteigt nicht die durchschnittliche Mortalität der letzten vier Jahre. Gegenüber 2018 ist sie sogar erkennbar geringer. 2018 sprach niemand von der Gefahr überlasteter Intensivstationen, und sie ist auch gegenwärtig nicht gegeben. Auch dies gilt es von der Politik nun anzuerkennen.

Dies ist die Voraussetzung für die Änderung einer im Kern verfehlten Krisenpolitik. Eine Bundeskanzlerin, die in ihrer Neujahrsansprache für die Krisenüberwindung entscheidend auf das freiwillige Engagement der Bürger setzt, nachdem sie vorher monatelang deren Freiheitsbetätigung stranguliert hat, gibt damit das Scheitern der Repressionspolitik unfreiwillig zu. Um aus der Sackgasse unbotmäßiger Fallzahlen herauszukommen, die nicht ausreichend sinken wollen, gilt es, sich den alternativen Konzepten der Corona-Behandlung, wie sie eingangs dieses Artikels vorgestellt worden sind, zu öffnen.

Der Notwendigkeit eines solchen drastischen Politikschwenks wird die offizielle Corona-Politik nicht durch die Perspektive der Impfung enthoben. Erstens ist das letzte Wort über deren Wirksamkeit, vor allem aber deren Sicherheit, noch nicht gesprochen. Zweitens steht die Impfbereitschaft der deutschen Bevölkerung durchaus in Frage. Und drittens wird, auch wenn das Projekt Impfung alle Versprechungen hält, ein allgemeiner Immunschutz für die Bevölkerung erst in Monaten erreicht sein.

Was bleibt, ist dann nur noch die Hoffnung auf das Frühjahr mit dem Abklingen des saisonalen Infektionsgeschehens in seinem Gefolge. Dies ist für eine rationale Politik, die auch mit dem Widerstand eines mutierten Virus mit erhöhter Infektiösität zu rechnen hat, eine sehr dünne Perspektive, die auch erst ab März / April zum Tragen kommen könnte. Soll so lange der Lockdown bestehen bleiben?

Es ist Zeit für die Politik, ihre oft genug manifestierte Lernresistenz abzulegen und einen grundlegend anderen Ansatz für die Krisenbewältigung zu wählen. Was liegt näher, als das eingangs vorgestellte moderate Reformkonzept der Gruppe um Gassen und Streeck zu wählen? Dieses müsste doch auch für den politischen Mainstream akzeptabel sein.

5. Der Offenbarungseid wird nicht geleistet

Am 5 Januar beschloss die Runde der notorisch Unkundigen aus Coronakabinett mit der Kanzlerin an der Spitze und den MP der Bundesländer die Verlängerung des Lockdowns bis Ende Januar, der sogar verschärft wurde. So wurden etwa die privaten Kontakte weiter eingeschränkt und in den Hotspots ab einer Inzidenz von 200/100.000 die räumliche Bewegungsfreiheit auf 15 km begrenzt.

Ende Januar wird die drastische Einschränkung der sportlichen Betätigung durch die Schließung von Schwimmhallen, Sportstätten und Fitnessstudios im Gefolge dreier Lockdowns seit drei Monate andauern. Dies hat negative Konsequenzen für das vor Infektionen schützende natürliche Immunsystem und die Gesundheit allgemein der sportlich orientierten Teile der Bevölkerung. Der Autor z.B. war es seit Jahrzehnten gewohnt, mehrfach in der Woche Schwimmen zu gehen. Der Mangel an sportlicher Betätigungsmöglichkeit dürfte freilich für einige seiner maßgeblichen Urheber nicht von Wichtigkeit sein: Der seit Jahren übergewichtigen Kanzlerin und ihrem adipösen Kanzleramtsminister Braun sowie den Herren Spahn und Söder mit ihren sichtbar wachsenden Bauchansätzen dürfte sportliche Betätigung wenig bis nichts bedeuten. Dem entspricht die Nonchalance, mit der die Lockdownpolitik durchgezogen wird.

Eine bewusste staatliche Förderung von Gesundheit und Immunsystem durch systematische Aufklärung über richtige Ernährung, Bewegung, gesunden Schlaf und wichtige Nahrungsergänzungsmittel wie Omega 3 und Vitamin D findet denn auch nicht statt. Anscheinend wird die Sorge um die Gesundheit der Schulmedizin und der Pharmaindustrie überlassen.

Durch ihre Verlängerung wurde der an sich fällige Offenbarungseid der bisherigen Corona-Politik vermieden. Im Wirtschaftsleben würde man von Insolvenzverschleppung sprechen. Es ist auch kaum damit zu rechnen, dass die angestrebte Inzidenz von 50/100.000 bis Ende Januar tatsächlich erreicht wird. Nicht zuletzt die aufgrund der Mutation gesteigerte Infektiösität des Virus spricht dagegen. Manche Forderungen sind sogar noch ehrgeiziger und zielen auf eine noch niedrigere Inzidenz, z.B. 25/100.000 oder sogar 7/100.000, ab.

Es ist immer wieder schockierend, mit welcher Chuzpe die politisch Verantwortlichen und ihre Berater die empirische Evidenz ignorieren, z. B. die Erfahrungen Israels. Israel hatte im September bei laut worldometer über 6000 täglichen Neu-“Infektionen“ Ende des Monats einen harten Lockdown angeordnet, der die Fallzahlen bis Mitte November auf etwas über 600, also auf ein Zehntel, drückte. Diese sind aber Anfang Januar 2021 wieder auf über 6000 gestiegen. Der Erfolg hatte also eine Verfallszeit von gerade gut 6 Wochen.

Auch die wissenschaftliche Evidenz wird ignoriert. In einer hochrangigen aktuellen Studie des amerikanischen National Bureau of Economic Research wird gezeigt, dass Lockdowns, Schließungen, Reisebeschränkungen, Quarantänemaßnahmen, Sperrstunden und Masken keinen Einfluss auf die Übertragungsraten des Corona-Virus und die Todesfälle haben ( Atkeson, Kopecky, Zha 2020 ).

Quellen :

Atkeson, Andrew, Kopecky, Karen, Zha, Tao 2020 : Four stylized Facts about COVID-19, Working Paper 27719, National Bureau of Economic Research.

Nahamowitz, Peter 2020 a : Klimawandel und CO2: falsche Alarmzeichen für die Weltgesellschaft, scienceFiles, Blaue Reihe, Bd. 8.

Nahamowitz, Peter 2020 b: Sechs kurze Begründungen für die Verfassungswidrigkeit des Shutdown in Deutschland, EIKE-Publikation vom 17. Mai.

Nahamowitz, Peter 2020 c: Corona-Panik, die dritte: Zentrale Gründe für die Verfassungswidrigkeit des Teil-Lockdown vom 28. Oktober 2020, EIKE-Publikation vom 25. 11.

Reiss, Karina, Bhakdi, Sucharit 2020: Corona Fehlalarm?, Berlin.

Vahrenholt, Fritz, Lüning, Sebastian, 2020: Unerwünschte Wahrheiten. Was Sie über den Klimawandel wissen sollten, München.

Zum Autor :

Peter Nahamowitz war Prof. für öffentliches Wirtschafts- und Finanzrecht sowie Politikwissenschaft am Fachbereich Rechtswissenschaften der Leibniz Universität Hannover. Er ist seit 2007 im Ruhestand.