Die Hitzetoten des Dr. von Hirschhausen

Der Klimafolgen-Fachmann von Hirschhausen

Laut Herrn Hirschhausen haben Hitzewellen eine so hohe Sterberate, dass Covid-19 dagegen eher nebensächlich ist, weil Hitze das wirkliche – neue – Mortalitätsproblem aufgrund des Klimawandels wäre: [2] … um die größte Gesundheitsgefahr, nämlich die Klimakatastrophe anzugehen … Die Welt vorher war nicht normal, wir schliddern in diesem Jahrzehnt auf die entscheidende Phase zu, in der sich entscheidet, ob Menschen überhaupt auf dieser Erde bleiben können.“

.. „Wir haben 20.000 Hitzetote im letzten Jahr gehabt! Das waren sehr viel mehr sozusagen Übersterblichkeit im Sommer als an Covid. Hat keiner drüber geredet. Wir sind das Land mit den dritthäufigsten Hitzetoten nach China und Indien. Warum kommt das in den Medien nicht vor?“ …

Dass solche Aussagen in den Medien nicht (auch) vorkämen, stimmt natürlich nicht. Und unsere – von jeglichem Wissen zum Klima und seinem regelmäßigen Wandel befreite (rein persönliche Meinung des Autors, die durch nichts belegt ist) – Umweltministerin ist ja ebenfalls dieser Ansicht:

[3] Merkur 26.11.2019: (Sv. Schulze) „Alarmierend“ Immer mehr „heiße Tage“: Ministerin mit drastischem Urteil über Klima-Folgen für Deutschland … Der Klimawandel hinterlässt in Deutschland immer heftigere Spuren. Laut einem neuen Bericht der Bundesregierung kam es wegen der Hitze sogar zu mehr Todesfällen.

… Die Folgen des Klimawandels lassen sich immer besser erkennen. Bundesumweltministerin Svenja Schulze spricht über „alarmierende“ Befunde …

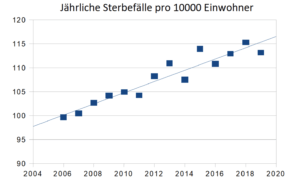

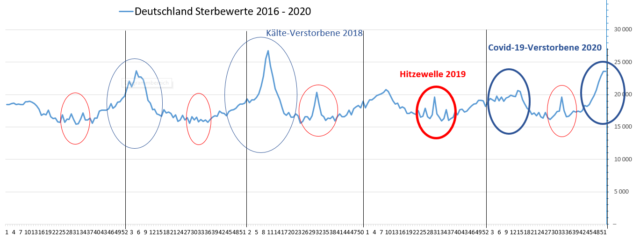

Nur können Hitze-„Todesmeldungen“ eher selten gebracht werden, denn Herrn Hirschhausens Aussage hat einen gravierenden Fehler: Sie stimmt nicht. Zur Veranschaulichung dieser These, vorab der Verlauf der Sterblichkeit in Deutschland über die letzten fünf Jahre mit Kennzeichnung der „Hitzewellen-Überversterbung“ 2019 und den bisher Covid-19 zugeordneten Sterbewerten:

Was ist bei uns mortaler? Hitze oder Kälte?

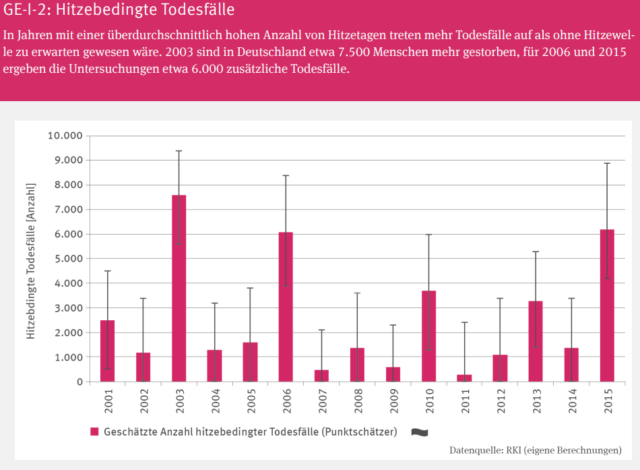

Glaubt man offiziellen „Informationen“, dann muss Sommerhitze ein zunehmendes Sterblichkeits-Problem geworden sein. Zum Beispiel listet der deutsche Klimabericht 2019 dazu Schlimmes, während zur Mortalität im Winterhalbjahr allerdings keine Angaben oder Hinweise enthalten sind:

Auch das Ärzteblatt berichtete darüber:

Ärzteblatt 2019 MEDIZINREPORT: Studien im Fokus: Übersterblichkeit bei Hitzewellen in Deutschland: Zahl der hitzebedingten Todesfälle zwischen einigen Hundert und vielen Tausenden

… In Deutschland traten 11 der extremsten Hitzewellen seit 1950 nach der Jahrtausendwende auf. Dazu gehörten die Sommer der Jahre 2003, 2006, 2013, 2015 und 2018 …

Ein unbedarfter Bürger muss danach annehmen, dass inzwischen wohl die Sommerhitze die im Jahr „anfallenden“ Über-Verstorbenen „erzeugt“ und in den restlichen Jahreszeiten – schließlich werden die Winter immer wärmer – anscheinend keine Übermortalität vorliegt. Wie es schon Bild 1 zeigt, ist allerdings genau das – weiterhin – nicht der Fall.

Eine Studie

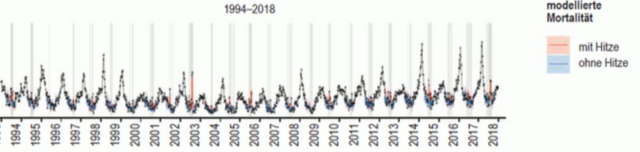

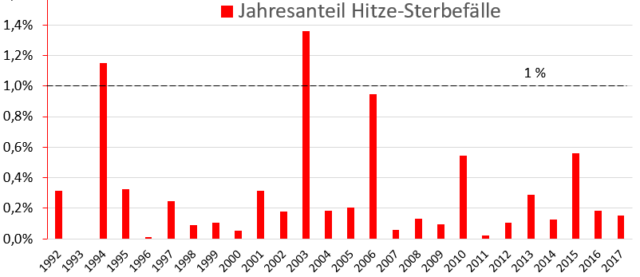

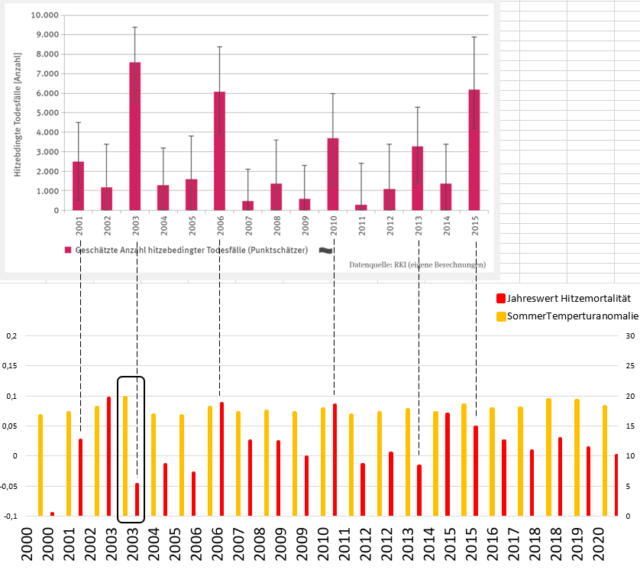

Über das „Ärzteblatt“ findet sich eine Studie zur hitzebedingten „Übersterblichkeit“ vom RKI: [5] ärzteblatt.de 37/2020: MEDIZIN: Originalarbeit Hitzebedingte Mortalität – Eine Analyse der Auswirkungen von Hitzewellen in Deutschland zwischen 1992 und 2017,

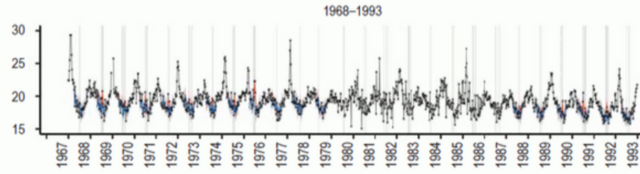

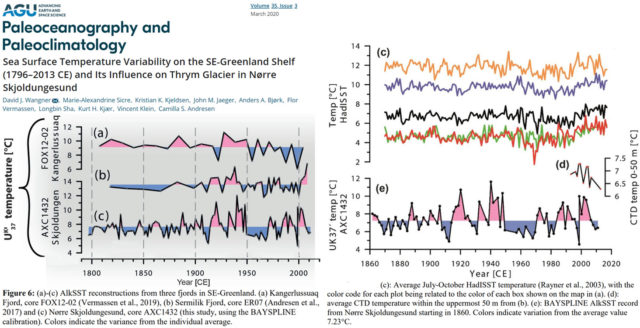

worin Mortalitätsangaben in einer Grafik ab 1967 und tabelliert ab 1993 angegeben sind.

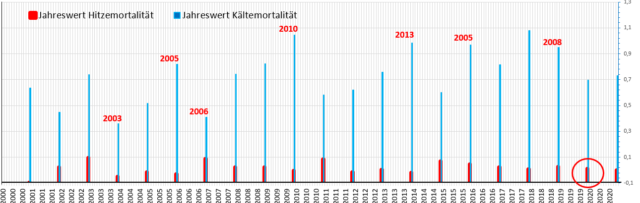

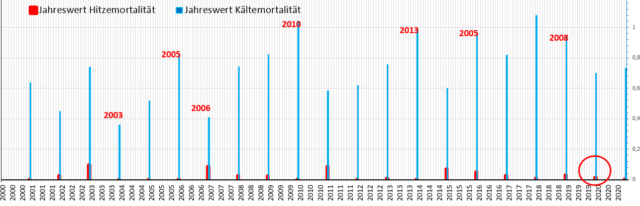

Die Langzeitgrafik in der Studie ist recht undeutlich abgebildet. Trotzdem zeigt sie die teils extremen Kälte-Mortalitätsspitzen und anhand der kaum erkennbaren roten Hitzemortalitäten, wie vergleichbar niedrig diese sich dagegen ausmachen.

Sofort spring ins Auge, dass die hitzebedingte Mortalität seit langem abnimmt und von einer Erhöhung überhaupt keine Spur zu sehen ist. Hätte man das nach den Aussagen von Herrn Hirschhausen (und unserer Umweltministerin [3]) auch nur entfernt vermutet?

Und selbst dieses wirklich kleine Problem lässt sich sehr gut vor Ort einfach und billig lösen. Die Studie des RKI hat dazu eine Schlussfolgerung:

[5] … Insgesamt wird der Effekt von Hitze auf die Mortalitätsrate über die betrachteten Dekaden schwächer. Dies deutet auf Anpassungsprozesse hin, die auf einer physiologischen Anpassung (34) beruhen können, aber vermutlich vor allem durch Hitzewarnungen (35) und anderen Präventivmaßnahmen, besonders in der Betreuung älterer Menschen, verursacht wurden …

Solche „Anpassungsprozesse“ sind: Vor allem zur Verhinderung einer Dehydrierung ausreichend Wasser trinken und vielleicht auch endlich einmal den Komfort von Klimatisierung im Altersheim.

Herr Hirschhausen möchte als „Lösung“ dagegen unbedingt weltweit CO2 verhindern und inzwischen auch Bürgerrechte – für Aktivitäten welche CO2 emittieren – einschränken.

Ein besseres Beispiel für den idiotischen, da (falls überhaupt etwas wirksam) hoffnungslos überteuerten und uneffektiven CO2-Wahnsinn, mit dem alleine Deutschland mit Billiardenaufwand vesucht, die Welttemperatur bis zum Jahr 2100 um sagenhafte (nicht einmal gesicherte) 0,035 Grad zu reduzieren [6], findet man selten.

Eigentlich könnte der Artikel nun enden. Wer sich mit dem Thema näher beschäftigt, stellt allerdings fest: Nahezu immer fehlen bei Angaben zur ach so schlimmen Hitzemortalität Vergleiche mit der Mortalität im Winter. Nicht einmal der dicke Klima-Monitoringbericht 2019 erwähnt etwas dazu.

Dieser Mangel soll mit dem nun folgenden Kapitel behoben werden.

Übersterblichkeit

Wie schon bei der Bewertung von Coronadaten stellt sich auch bei der von Hitzewellen-Übersterblichkeit die Frage, wie eine Übersterblichkeit überhaupt definiert wird. Bei „Corona“ gibt es „offiziell“ eine, welche allerdings recht augenscheinlich falsch und unbrauchbar ist [4], was führende Politiker jedoch nicht hindert sie anzuwenden, weil diese sicher alarmistische Ergebnisse liefert und ihnen damit „in den Kram“ passt.

zur Hitzemortalität hat der Autor keine gefunden. Auch anderen scheint es so zu gehen, denn es gibt erhebliche Zahlendifferenzen zwischen einzelnen Publikationen. Deshalb vor der Auswertung der Versuch einer Definition dazu.

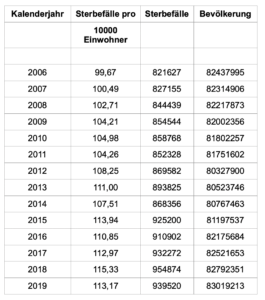

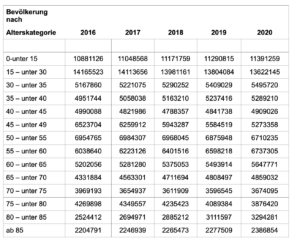

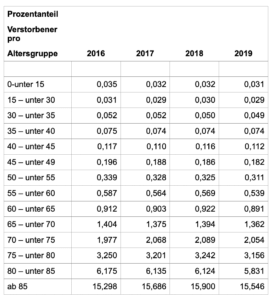

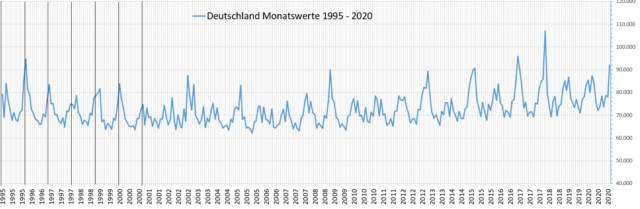

Daten zur Langzeit-Sterberate lassen sich finden. Anbei ein Datensatz, der beim Statistischen Bundesamt über einen Link hinterlegt ist.

Betrachtet man die Daten, stellt man verblüffend fest, dass die Werte bis zum Jahr 2000 bezüglich der Auflösung deutlich anders aussehen, als die danach. Und ausgerechnet die wichtigen „Sommer“-Sterbewerte sind in den Daten vor dem Jahr 2000 darin deshalb nicht zu finden. (Wieder) ein exemplarisches Beispiel für die teils erschütternd schlechte Datenqualität in unserem Hochtechnologie-Land und ein Hinweis, Daten nie „Blind“, also rein schematisch oder über so etwas wie „Künstliche Intelligenz“ auszuwerten. Vielleicht auch ein Grund, warum die „Hitzemortalität“ erst seit dem Jahr 2000 (in den Medien) so präsent ist? Jedenfalls sind die Daten erkennbar erst ab dem Jahr 2000 verwertbar.

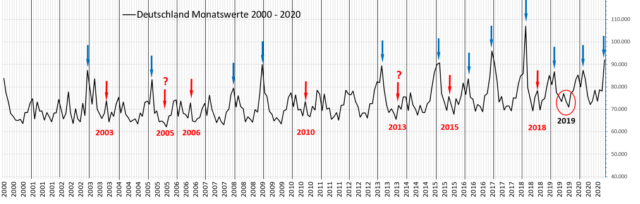

Den Mortalitätsverlauf seit dem Jahr 2020 zeigt das folgende Bild. Ergänzend zum Bild 1 zeigt es auch die nach Herrn von Hirschhausen besonders erwähnenswerte, „hohe“ Übersterblichkeit im Sommer 2019 im zeitlich längerem Kontext:

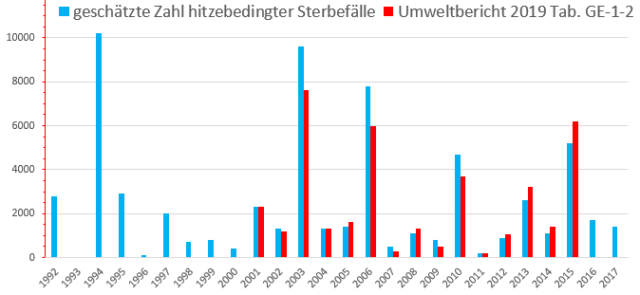

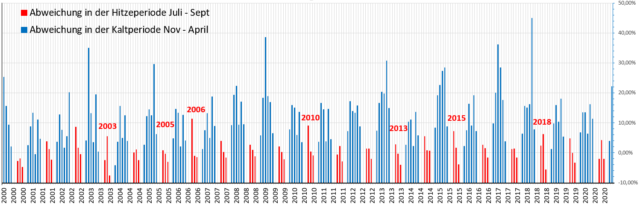

Die zusätzlich eingetragenen, besonderen „Hitze“-Übersterblichkeits-Jahre sind im Monitoringbericht 2019 (Bild 2) deklarierte Jahre und im „Ärzteblatt“ im Jahr 2019 angegebene.

Im Bild 7 muss man die Überverstorbenen der Sommerhitze wirklich suchen, da diese aufgrund der hohen „Wintersterblichkeit“ stark zurücktreten.

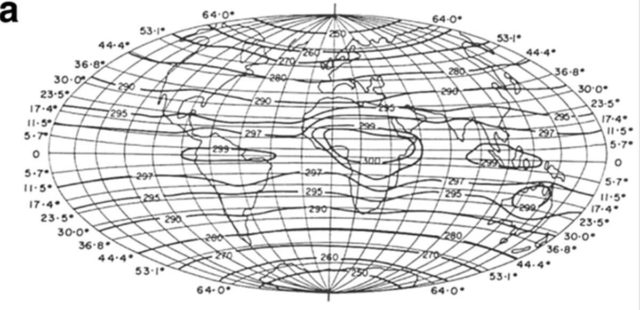

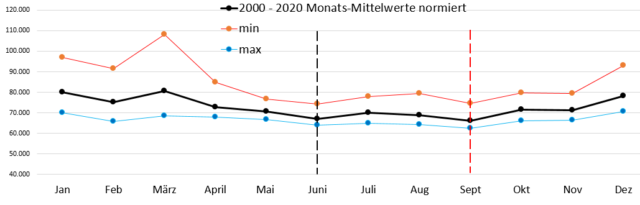

Zur Festlegung einer Definition für „Übersterblichkeit“ nun eine Überlegung. Betrachte man die Sterbezahlen der Einzelmonate im Bild 8,

ist erkennbar, dass die minimalen Sterbewerte recht stabil um den Monaten Juni und September liegen. Daraus wäre zu folgern, dass diese Monate sozusagen minimal-Mortalitäts-„Idealtemperatur“ haben. Es erscheint also angebracht, diese zwei Monate als Referenz anzuziehen und Abweichungen von den Sterbewerten dieser „minimal-idealen“ Monate als „Überverstorben“ zu bezeichnen.

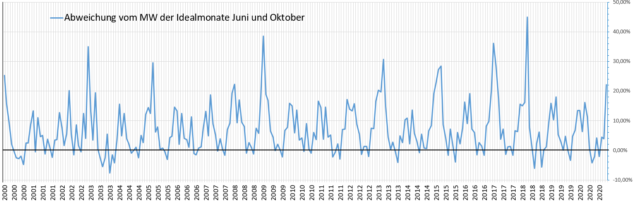

Getan, zeigt sich das Ergebnis von Bild 9. Die Fehler dieser Festlegung sind erkennbar (negative Werte), jedoch sehr gering.

Danach lassen sich die Monate bewerten und die Übermortalität für die Sommerhitze und Winterkälte separieren. Erstmals bekommt man damit ein „Gefühl“ für den Einfluss von Winter- und Sommerzeiten auf die „Übersterblichkeit“.

Nicht nur ein „Gefühl“, sondern die konkreten Jahreswerte, und somit einen effektiven Vergleich liefert die Grafik der separierten Jahressummen.

Über die angeblich extrem vielen Hitze-Verstorbenen im Jahr 2019 (rot eingerahmt) hat sich Herr Hirschhausen ganz besonders entrüstet. Wobei sich dazu wirklich die Frage stellt: Ist dieser Herr noch bei Sinnen?

Nochmals der Hinweis, dass die Grafiken Bild 10/11 auch negative Werte haben. Das ist der im Bild 9 erkennbare Überlappungs – und damit fehlerbehaftete Bereich der Separierung. Nimmt man diesen „weg“, was sicher datengemäß nicht einfach zulässig ist, sondern aufwendig korrigiert werden müsste. zeigt sich das folgende Verhältnis zwischen Winter- und Sommer-Übersterblichkeit:

Bleibt noch zuzufügen, dass die Trennung nach der Definition „Überverstorben“ des Autors natürlich zu anderen Werten als in der Studie und im Klimabericht führt. Komischerweise erscheint die größte Abweichung beim oft publizierten, „ganz schlimmen“ Hitze-Mortalitätsjahr 2003.

Eine mögliche Folgerung wäre: Die Übersterblichkeitsangaben für dieses Jahr sind nicht aus Messzahlen abgeleitet, sondern entstammen fiktiven Hochrechnungen (der Autor hält dies auch für Wahrscheinlich).

Fazit

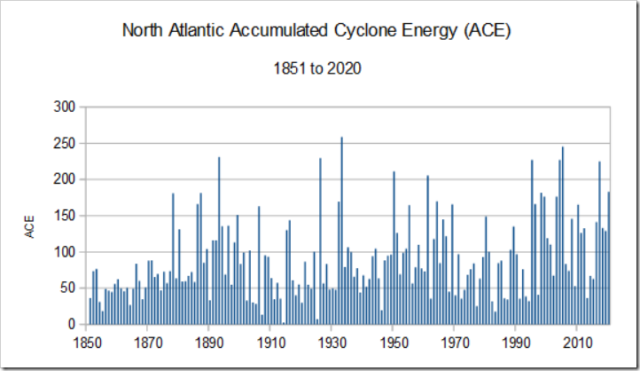

Alleine anhand der Datenlage würde jeder wirklich an im Jahresdurchschnitt minimalisierter Mortalität Interessierte folgern, dass dazu auf keinen Fall die Hitze verringert, sondern die Kälte weiter reduziert, es also wärmer werden müsste.

Diese einfach zu belegende und dazu auch noch eindeutige Erkenntnis ist für unsere Klimaalarmisten jedoch schon alleine aus ideologischen Gründen nicht entfernt akzeptabel. Und so werden in den Publikationen zur Hitzemortalität in der Regel einfach die Angaben zur wesentlich höheren Mortalität der kühlen bis kalten Jahreszeiten weggelassen, um die Bürger – welche die Maßnahmen bezahlen und immer weiter gehende Einschränkungen ertragen müssen – nicht zu verunsichern und gar „ins Grübeln“ zu bringen

Zwar reduziert dies die Aussagen auf ein fachliches Niveau von Kindergarten- bis Schulkindern, aber die „Experten“ müssen sich so weit herablassen, sonst könnten sie nicht mit denen gemeinsam gegen solche Fakten „hüpfen“.

Herr Hirschhausen ist inzwischen ein reiner Klima-Agitator. Welchen fachlich wirklich extremen Unsinn er dazu unwidersprochen im „Öffentlichen“ vorträgt und auch darf, wurde nun gezeigt. Dass in Talkshow-Runden, woran angeblich so etwas wie wenigstens im Ansatz fachlich zum Thema informierte Personen teilnehmen, es niemand bemerkt, ist inzwischen schon zum „Öffentlichen Markenzeichen“ geworden und zeigt die durchschlagenden Erfolge der Klimapropaganda und Verdummung in Deutschland, auch bei unserer angeblichen „Intelligenz“.

Zufügung: Der Autor tut Herrn Hirschhausen etwas unrecht. Dieser plappert ja nur treu nach, was ihm vorgegeben und gefordert wird, um im lukrativen „Öffentlichen“ auftreten zu dürfen. Vielleicht hat sein kompromissloser Schulterschluss mit den Freitagshüpfern auch solche Gründe. Schließlich wäre es nichts Verwerfliches, auf ein Einkommen angewiesen zu sein.

Fachlich dürfte Herr Dr. med. v. Hirschhausen sehr wohl in der Lage sein, die Faktenlage zu überblicken. Schließlich sind fast alle medizinischen Dissertationen mehr oder weniger statistische Fallanalysen. Seine dürfte dazu gehören: Promotionstitel: Wirksamkeit einer intravenösen Immunglobulintherapie in der hyperdynamen Phase der Endotoxinämie beim Schwein

Personen wie unsere Umweltministerin sind für die Faktenbetrachtung allerdings wirklich zuständig. Wenn solche gegen die Faktenlage Gleiches behaupten, sind sie ihren Amtseid Missachtende. Doch dazu lässt sich hinzufügen: Wäre Frau S. Schulze nicht ohne jegliches belastende Wissen über das Klima und seinem stetigen Wandel (Wiederholung: Rein persönliche Meinung des Autors und unter wirklichen Klima-Fachpersonen nicht belegt), hätte sie unter der unfehlbaren Merkel den Minister*innen-Job niemals bekommen. Das war schon bei ihrer fast schon krankhaft klimahysterischen Vorgängerin so und bei einer ganzen Ministerkette davor ebenfalls.

Quellen

[1] EIKE 19. Januar 2021: Klimawarner Eckart v. Hirschhausen: Mehr Hitzetote als Corona-Opfer

[2] Achgut, 17. Januar 2021: Der Klima-Wendler: Dr. Eckart von Hirschhausen

[3] EIKE 27.11.2019: Deutscher Klima-Monitoringbericht 2019, S. Schulze spricht über alarmierende Befunde

[4] EIKE 17. Januar 2021: Unsere Politiker sollten sich endlich darum kümmern, wie man mit Corona leben kann und nicht umgekehrt

[5] ärzteblatt.de 37/2020: MEDIZIN: Originalarbeit Hitzebedingte Mortalität – Eine Analyse der Auswirkungen von Hitzewellen in Deutschland zwischen 1992 und 2017

[6] EIKE 16.12.2020: Wie „DIE LINKE“ die Tigermücke besonders effektiv verhindert