G20 Klimafakten ohne Hysterie betrachtet Teil 1(4)

Und deshalb gab es am 6. Juli 2017 in Hamburg die Pressekonferenz einer hochkarätigen G20-Klimainitiative:

G20-Broschüre Klimawandel – eine Faktenliste zum Stand der Forschung

Klimafakten – oder doch nur wieder Klimaalarm?

Anhand der folgenden, vierteiligen Artikelserie wird gesichtet, ob diese Klimainitiative in ihrer Faktenbroschüre Wert darauf gelegt hat, neutral zu informieren. Wie immer, sind die wichtigen Daten direkt enthalten und nicht nur als Linksammlung hinterlegt. Dadurch ist die Ausarbeitung lang geworden, bietet aber einen guten Querschnitt und macht das teils etwas sperrige Thema für „Anfängern“ sicher lesbarer und interessanter.

Nachdem der Autor die Rezension schon fertig geschrieben hat, kann er das Ergebnis seiner Sichtung bereits verkünden: Dieses „Klimakonsortium“ wollte eines auf gar keinen Fall: Neutrale, zum (Nach)Denken anregende Information über das Klima vermitteln. Der einzige Sinn bestand darin, den Klimaalarmismus zu stärken.

Alles was uns am Wetter nicht gefällt, kann doch Klimawandel sein

Schon beim orientierenden Querlesen fällt auf, dass die Broschüre an allen „Ecken und Enden“ der Klimadaten einen Alarm, mindestens tiefe Besorgnis zu entdecken meint. Dabei ist es nicht so, dass die Daten in der Broschüre nicht richtig wären. Es ist oft unglaublich, wie wechselhaft das Klima und das Wetter sein können. Entsprechend zeigen die Daten dazu oft schlimme – kurzfristige, oder vermeintliche -Trendmuster an.

In der G20-„Faktenliste“ werden jedoch fast alle, auch kurzfristigen Ereignissen, als unnatürlich dargestellt und mindestens vorsichtshalber mit einem Alarm versehen. Geradezu desorientierend ist, dass selten eine Hintergrundinformation beigelegt ist, welche eine Einstufung ermöglichen würde.

Deshalb sah sich der Autor veranlasst, so wie die „Klimaintelligenz“ ihre Klimahysterie mit dieser Broschüre wieder auffrischt, damit diese nicht etwa verblassen möge, zu zeigen, dass die gleichen Daten neutral und mit Hintergrundwissen betrachtet, meistens überhaupt keinen Anlass zu einem Alarm geben.

Hinweis: Nach der Editierung dieser Rezension erschien genau dazu ein Beitrag auf EIKE (die Abstimmung der privaten Autoren gelingt halt nicht, so dass manchmal fleißig parallel am gleichen Thema getippeifert wird):

EIKE 22. Juli 2017: Deutscher Wetterdienst (DWD) im „Klima-Wahn

Der Beitrag ist jedoch erheblich kürzer und lässt viele Themen fast aus. Diese Langfassung ist deshalb eine gute Ergänzung der dortigen, kurzen Einführung.

GLOBAL Temperatur

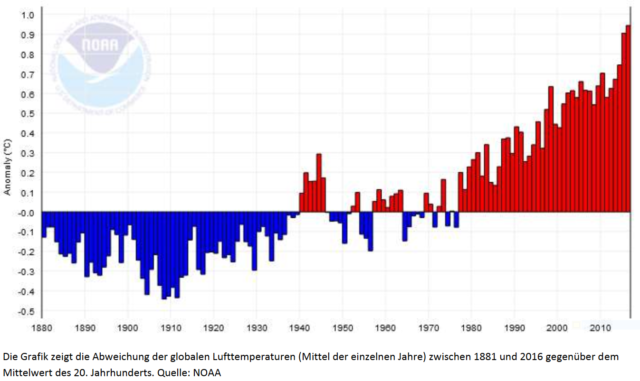

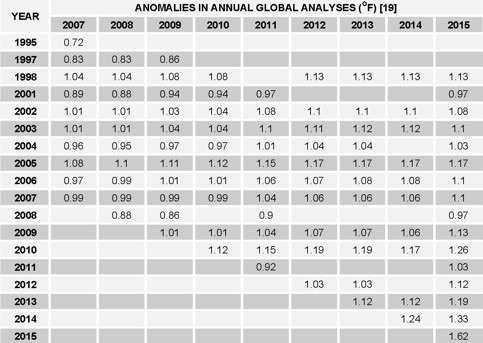

G20-Klimawandel-Faktenliste: [2] … Die Luft an der Erdoberfläche hat sich bereits deutlich erwärmt.

Im Jahr 2016 lag die mittlere globale oberflächennahe Lufttemperatur um rund 0,94°C höher als das Mittel im 20. Jahrhunderts. Dies teilte die NOAA Anfang 2017 auf der Basis dreier unabhängiger Datenreihen mit. Damit war 2016 das wärmste Jahr seit Beginn der Auswertungen und übertraf die vorherigen Rekordjahre 2015 und 2014 … drei Rekordjahre in Folge wurden noch nie seit Beginn der Wetteraufzeichnung registriert.

Global-Temperatur-Betrachtung ohne Hysterie

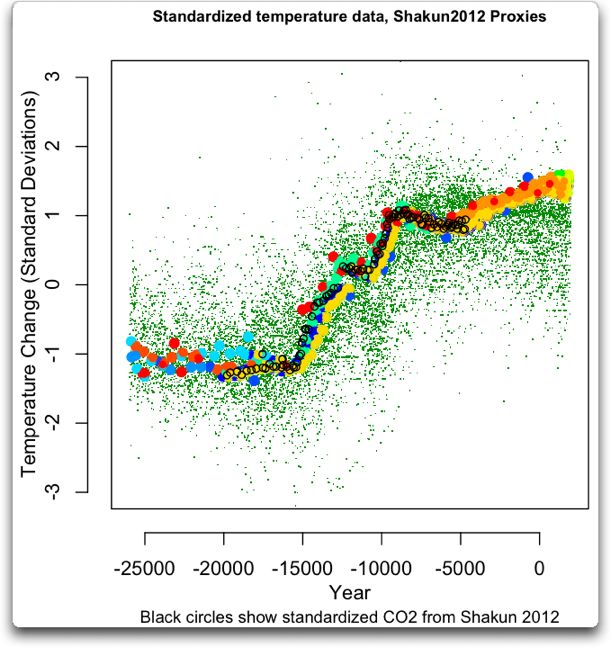

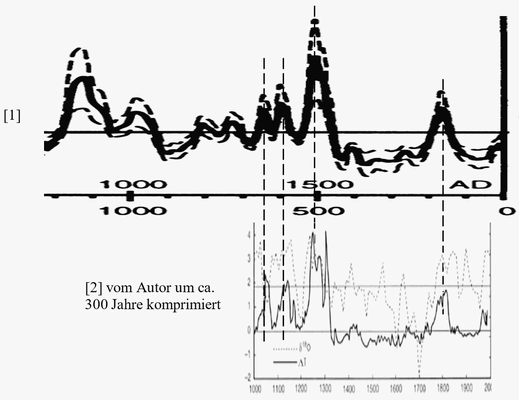

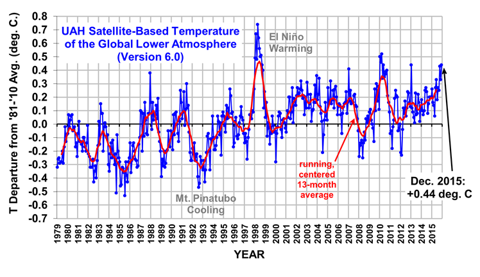

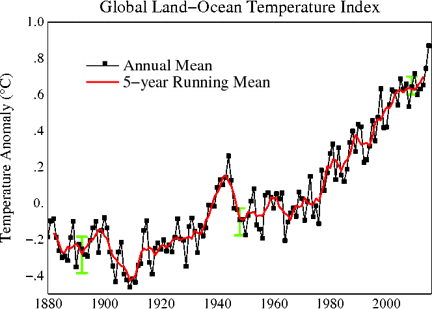

Die Temperatur-Anomaliebilder (Bild 1-2) mit ihren starken Achsendehnungen und der tief-roten Einfärbung aller Temperaturen über dem Mittelwert der Kältephase im letzten Jahrhundert sehen immer ganz schlimm aus – wie geschaffen, um eine Alarmstimmung zu erzeugen.

Doch Klima gibt es schon länger als seit dem Jahr 1880. Und damit bleibt die Frage, ob die aktuell immer gemeldeten „Rekorde“ wirklich unnatürlich sind, und damit eine Warnung sein müssen.

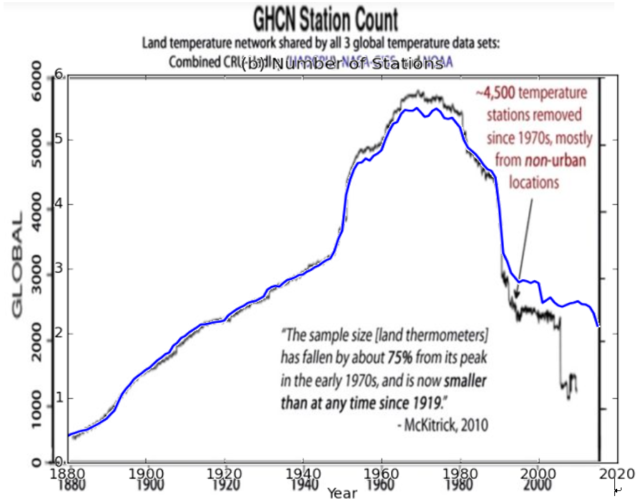

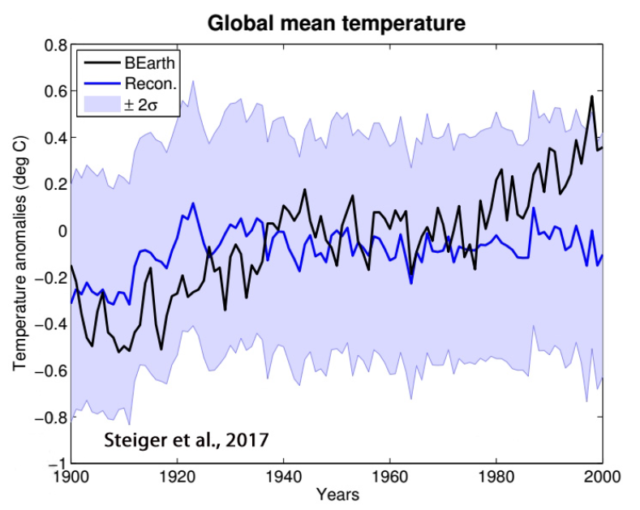

Wie genau und sicher wird die Globaltemperatur ermittelt?

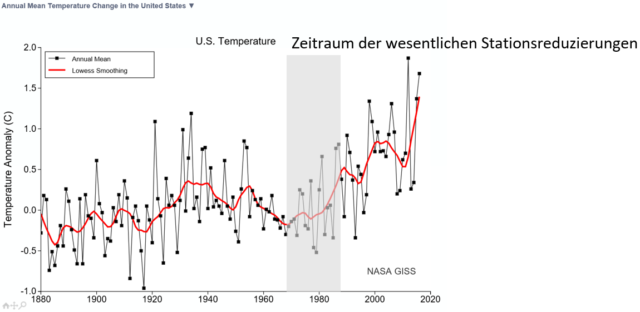

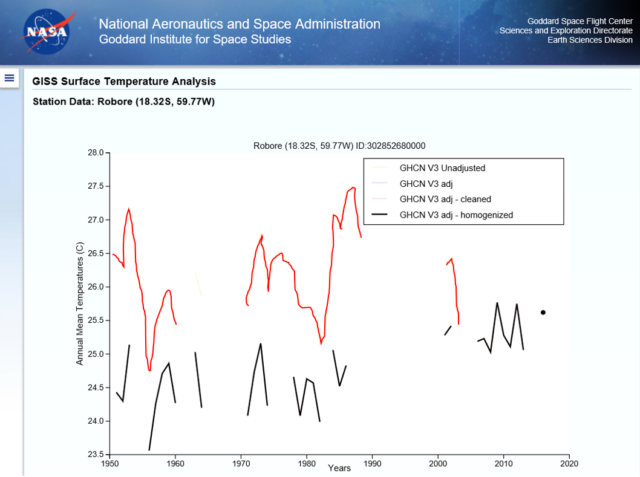

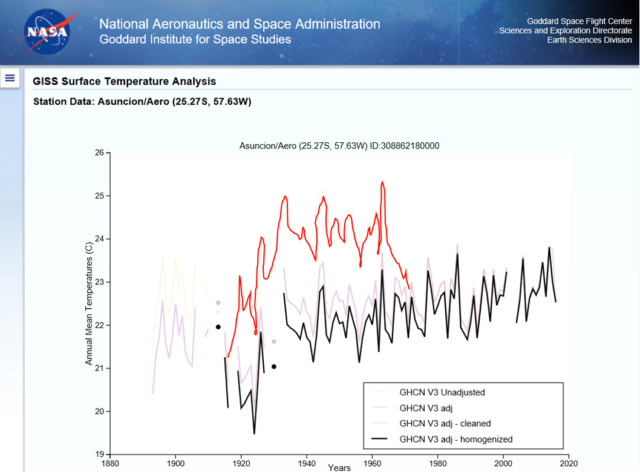

Zuerst muss man immer wieder anmerken, dass die Globaltemperatur-Ermittlung und Ausweisung aus verschiedenen Gründen höchst fragwürdig ist. Nicht allen ist geläufig, dass die Stations-Messdaten nicht direkt verwendet werden, sondern eine teils erhebliche Nachbearbeitung erfolgt. Auch wurde die Anzahl der Messstationen ab den 80er Jahren des letzten Jahrhunderts drastisch reduziert. Und zwar nicht die an Wärmeinseln gelegenen Stadt- und Flugplatz-nahen Stationen, sondern ausgerechnet die kälteren auf dem Land und in höheren Lagen.

-Dr. James P. Wallace at al., June 2017: [7] On the Validity of NOAA, NASA and Hadley CRU Global Average Surface Temperature

-EIKE, 10. Juli 2017: [5] Brandaktuelle Studie: Temperatur-Adjustierungen machen „fast die gesamte Erwärmung“ in den Klimadaten der Regierung aus

-EIKE, 20. Februar 2017: [6] Weitere Daten-Manipulationen seitens NOAA, NASA, HadCRUT … Vergangenheit kälter, Gegenwart wärmer gemacht

Es mag deshalb kein Zufall sein, dass ausgerechnet ab diesem Zeitpunkt der drastischen Stations-Reduzierung die “Globaltemperatur” wieder anstieg, wie es das Bild der USA-Landtemperatur (Bild 1-4) deutlich zeigt.

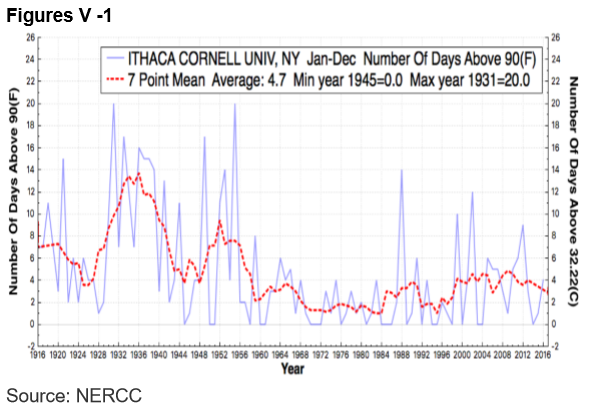

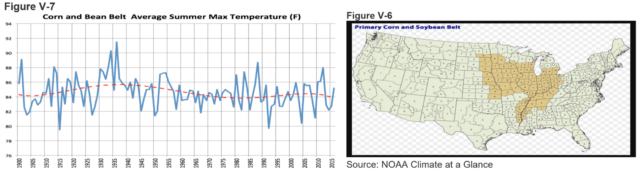

Trotzdem steigt in den USA die Anzahl der heißen Tage nicht

Regelmäßig liest man bei uns, wie die USA fast immer irgendwo an einer „Überhitzung“ leiden müssen (wenn sie wieder wegen einer extremen Kältewelle und Schneemenge fast erfrieren – weil dann auch oft der Strom ausfällt – liest man das kaum).

Dazu die Daten zu Hitzetagen in den USA. Obwohl die USA-Festlandsdaten einen erheblichen Temperaturanstieg „ausweisen“, nimmt die Anzahl der heißen Tage nicht zu.

Bild 1-5 Anzahl der heißen Tage über 32,22 °C in den USA. Quelle: [7]

Bild 1-5 Anzahl der heißen Tage über 32,22 °C in den USA. Quelle: [7]

Messwert-Adjustierungen

Erdstationen

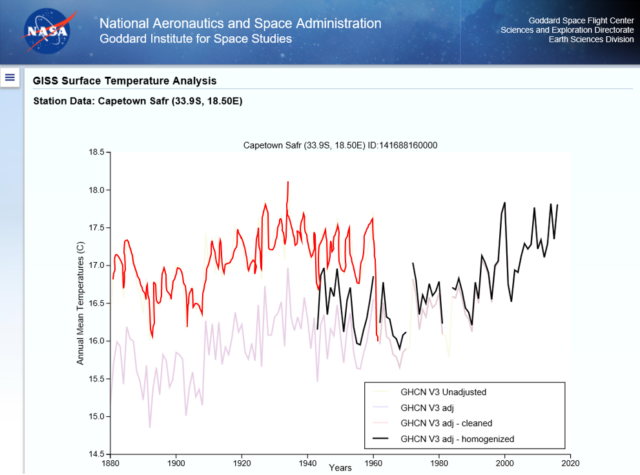

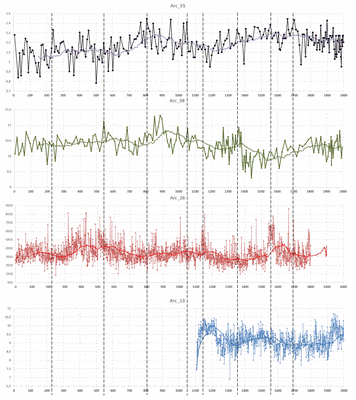

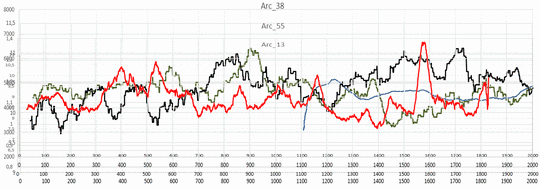

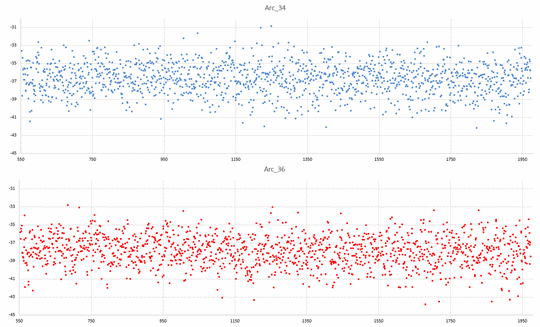

Dass es eine solch große Diskrepanz zwischen dem angeblich stetig steigenden „Globalwert“ und anderen Temperaturparametern hat, liegt sicher an vielen, kleinen „Drehungen“ der Parameter. Ein weiterer ist das „Bereinigen“ der Stationsmesswerte von „Fehlern“. Solche werden zum Beispiel angenommen, wenn eine Station Messwerte liefert, die „dort nicht sein dürfen“.

Welche teils drastischen Ausmaße Temperatur-Adjustierungen haben, sei an ein paar Beispielen gezeigt. Man verliert beim Sichten das Vertrauen in die weltweiten Messstationen und das daraus ermittelte Globalergebnis, nachdem die Stationen (angeblich) solch drastische Fehler liefern.

Auf See gibt es keine festen Messstationen. Da wurde und wird von Schiffen aus gemessen (heute auch mit Messbojen). Selbstverständlich wurden auch deren Ergebnisse Adjustiert. Wie? Früher wurde natürlich zu warm gemessen:

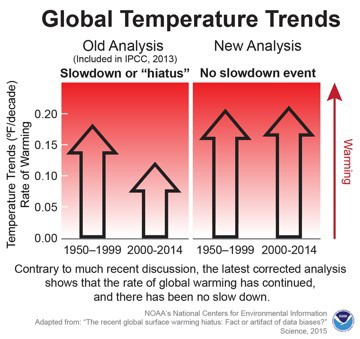

DER TAGESSPIEGEL, 04.06.2015: Klimawandel : Die Pause bei der Erderwärmung ist auf einmal weg

Weiteres dazu lässt sich nachlesen:

kaltesonne, 26. September 2014: Neues aus der wunderbaren Welt der Temperaturdaten-Korrekturen

Achgut, 18.11.2015: Sind die Klimadaten manipuliert?

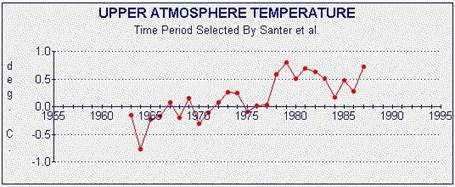

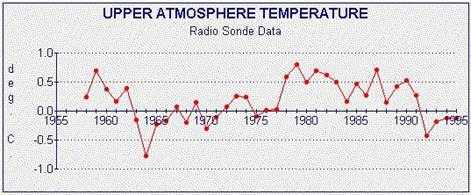

Satellitendaten

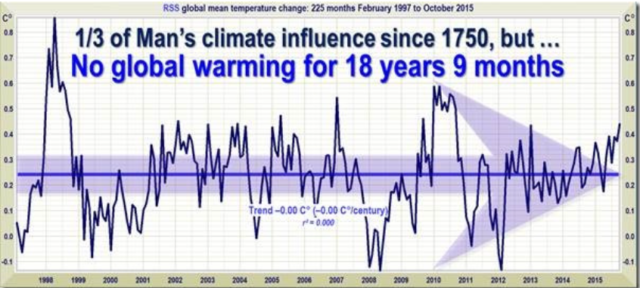

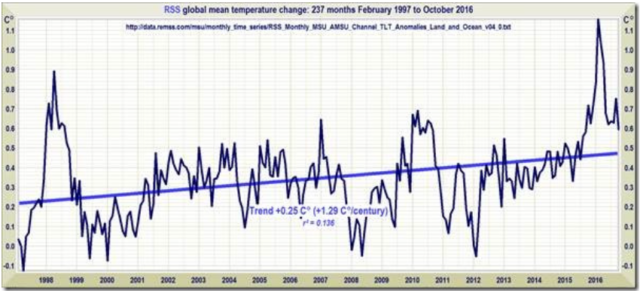

Auch die „unbestechlichen“ Satellitendaten sind nicht vor unterschiedlichsten Interpretationen sicher.

Im Artikel:

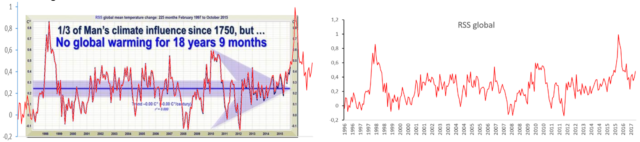

WUWT, Christopher Monckton of Brenchley, July 7, 2017: [8] How They airbrushed out the Inconvenient Pause

ist dargestellt, wie schnell sich Trends drastisch ändern können, ohne dass sich in der Natur wirklich viel verändert.

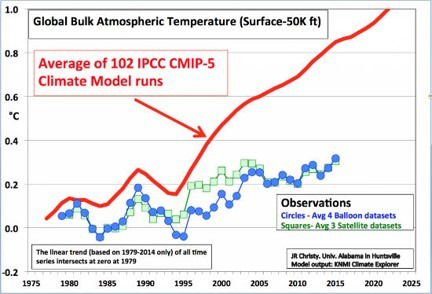

Bis zum Jahr 2015 zeigten die Messreihen keine Erwärmung an.

Womit es dabei bleibt, dass die Ableitung aus den Stationsmessungen und die Messungen der Satelliten im Trend gewaltig differieren und die Mängel und Ungenauigkeit, eigentlich fast Unbrauchbarkeit von Erdstations-ermittelten Globalwerten zeigen.

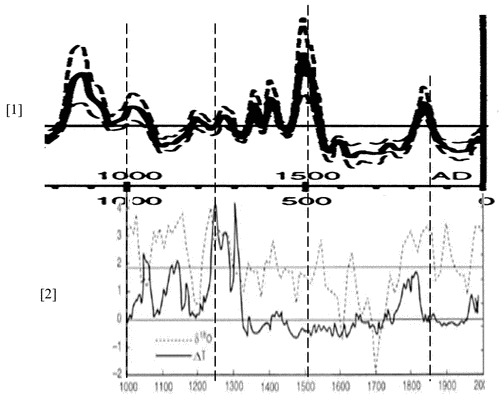

Wie genau und sicher ist die historische Globaltemperatur bekannt?

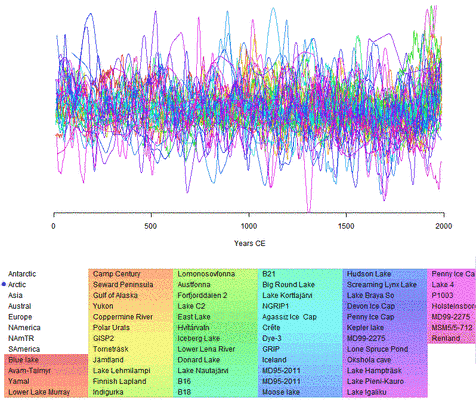

Wer die bisherigen Publizierungen des Autors kennt, weiß es schon: Die wirklichen, historischen Global-Temperaturen weiß niemand. Da mögen die „Klimawissenschaftler“ noch so oft das Gegenteil behaupten. Warum, und wie ungenau die Rekonstruierung derTempreraturhistorie ist, lässt sich zusammengefasst in einer Recherche nachlesen:

EIKE 11.05.2016: [9] Die Problematik der Temperaturrekonstruktion Eine beispielhafte Sichtung dazu anhand des Projektes PAGES 2k

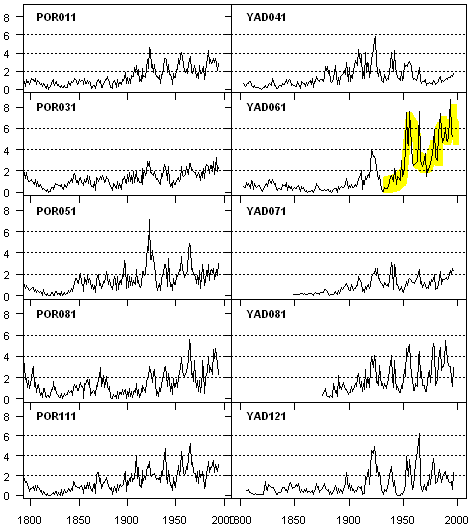

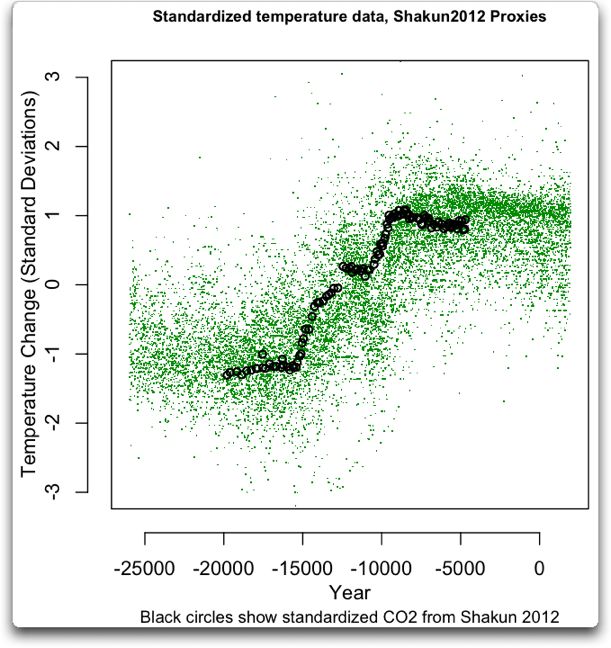

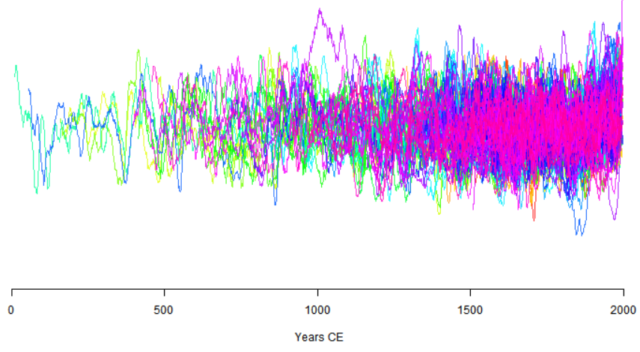

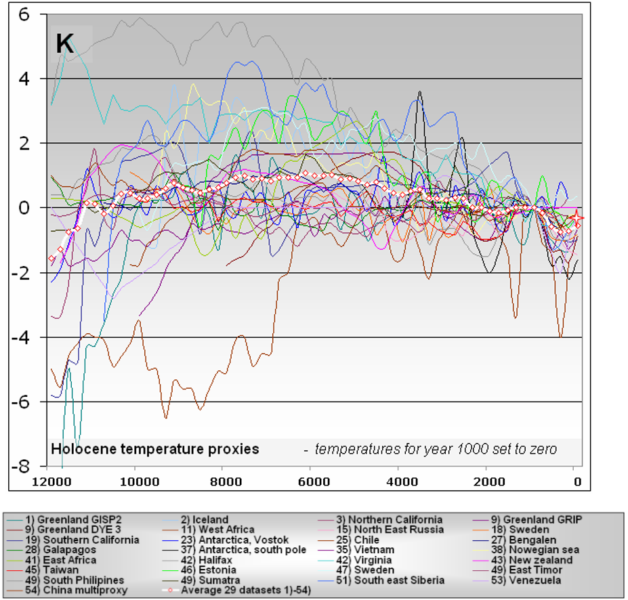

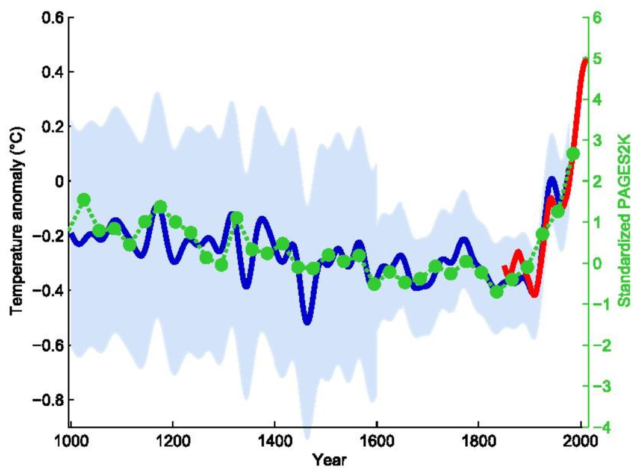

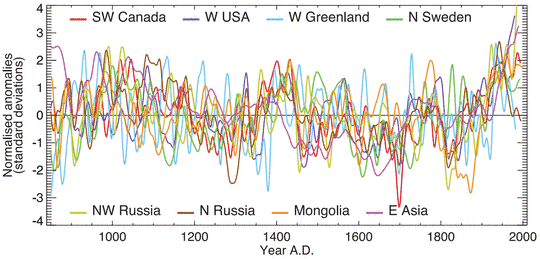

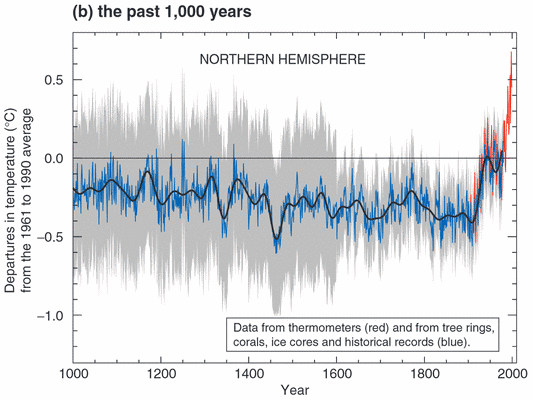

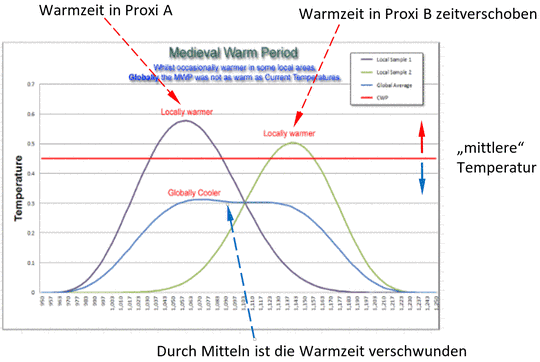

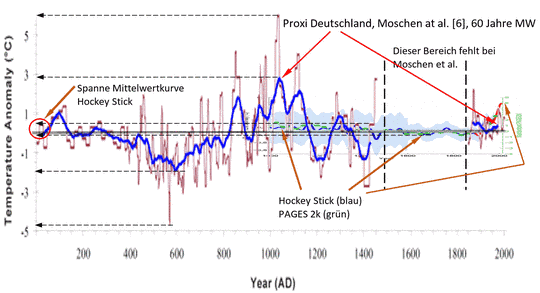

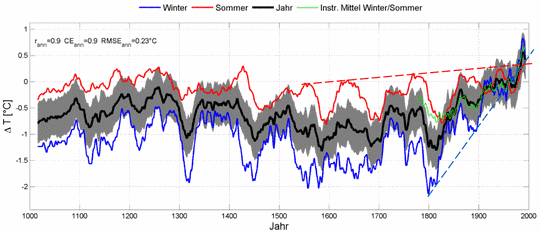

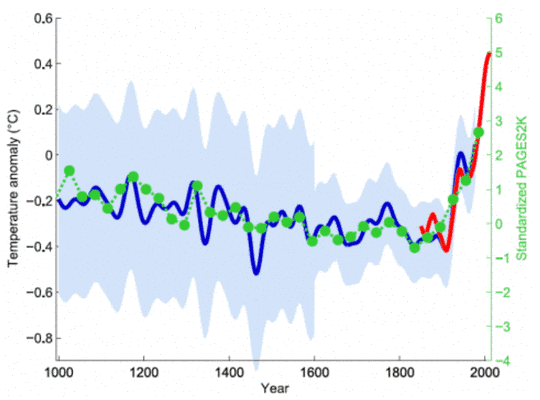

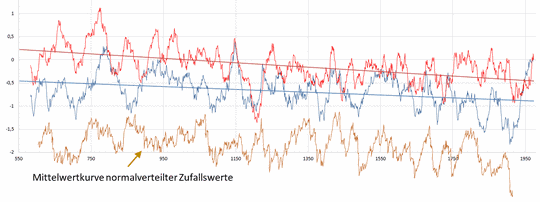

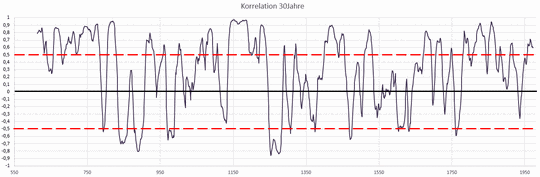

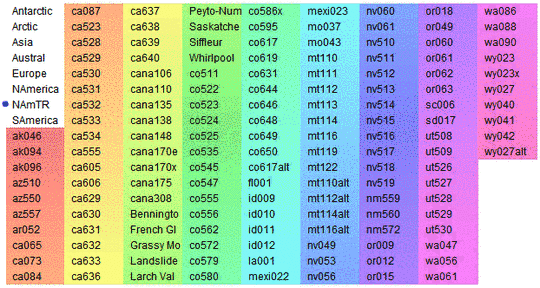

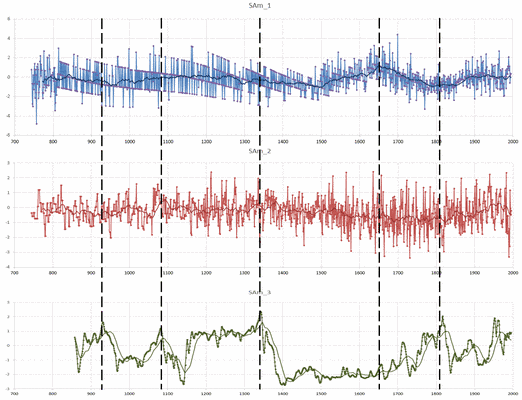

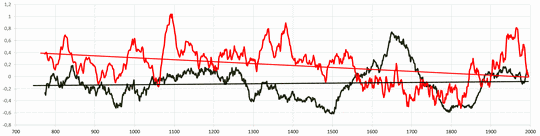

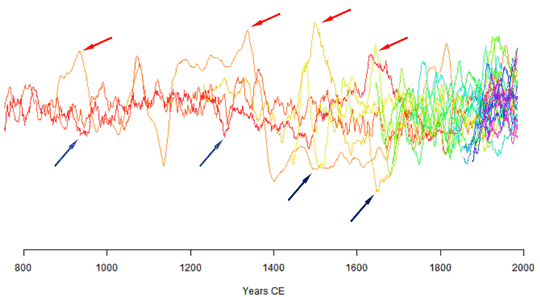

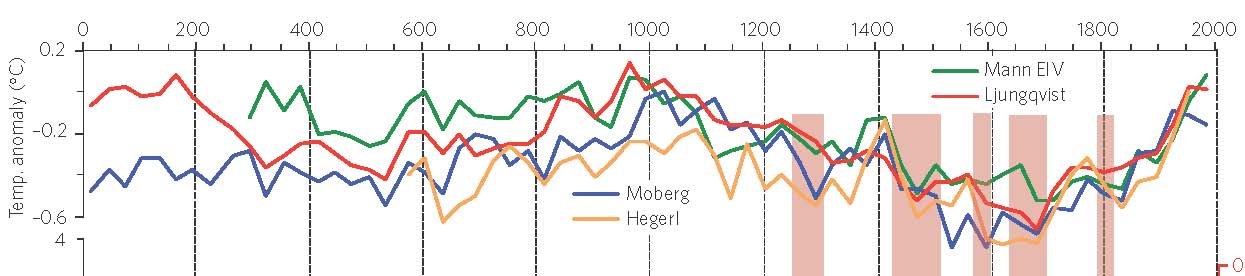

Das folgende Bild mag es verdeutlichen. Auch die „beste“ Statistik kann aus einem Proxi-Datensalat wie zum Beispiel dem der riesigen, asiatische Landfläche keinen „wirklichen“ Temperaturverlauf zaubern.

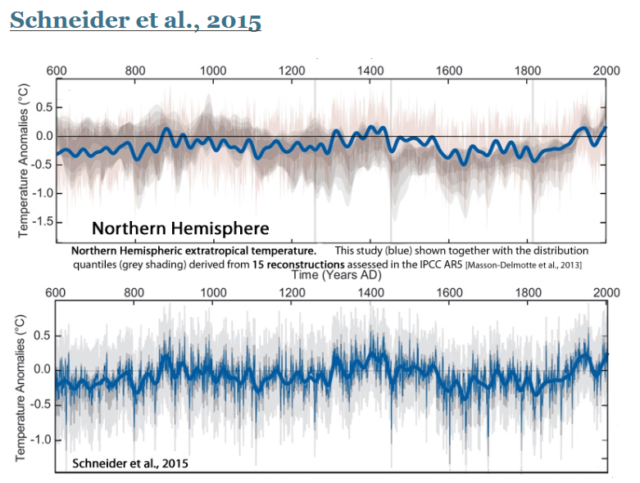

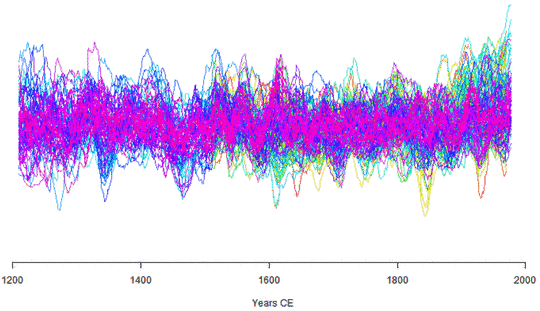

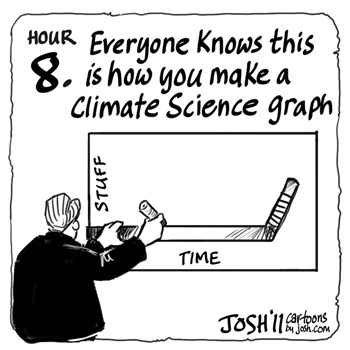

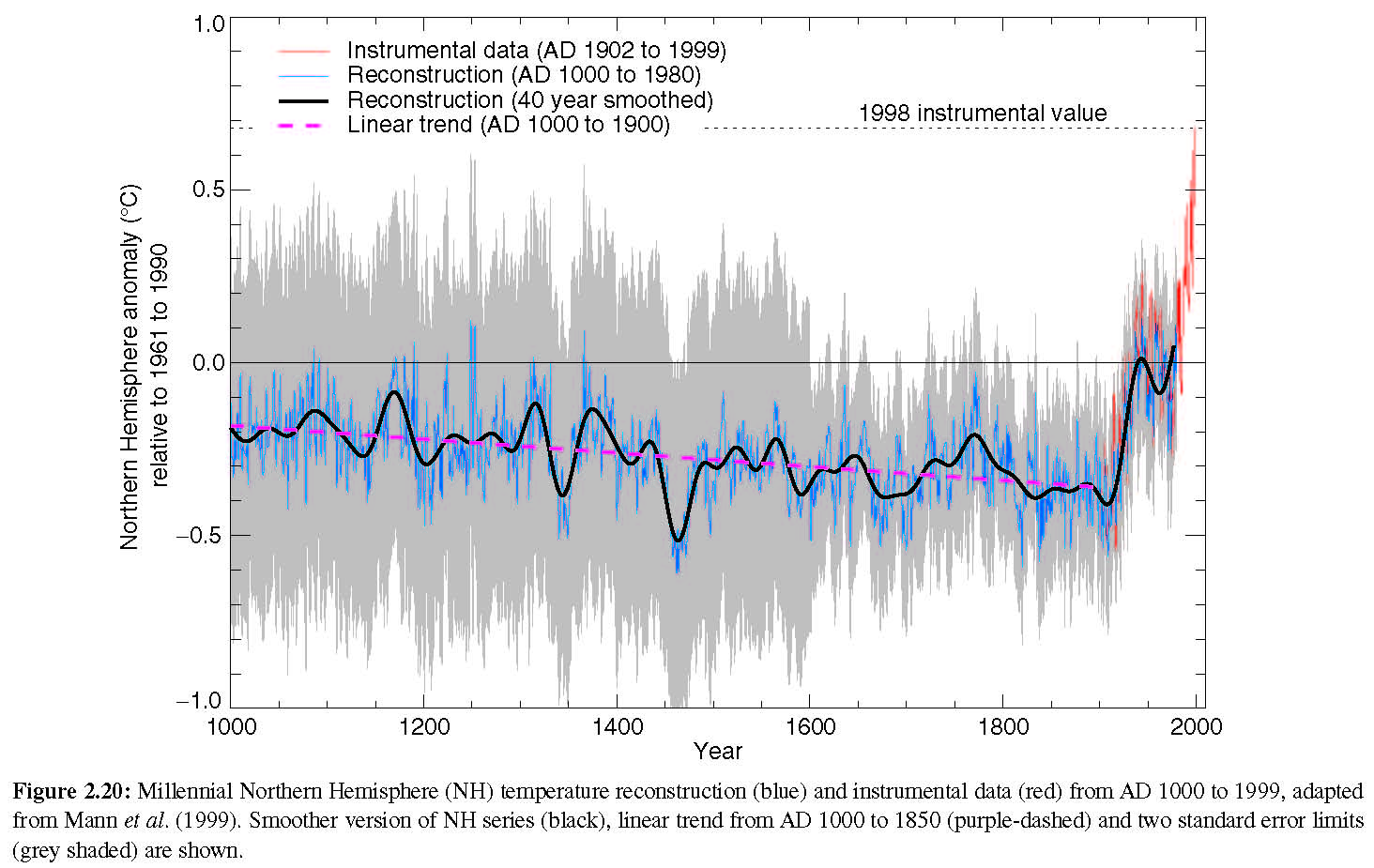

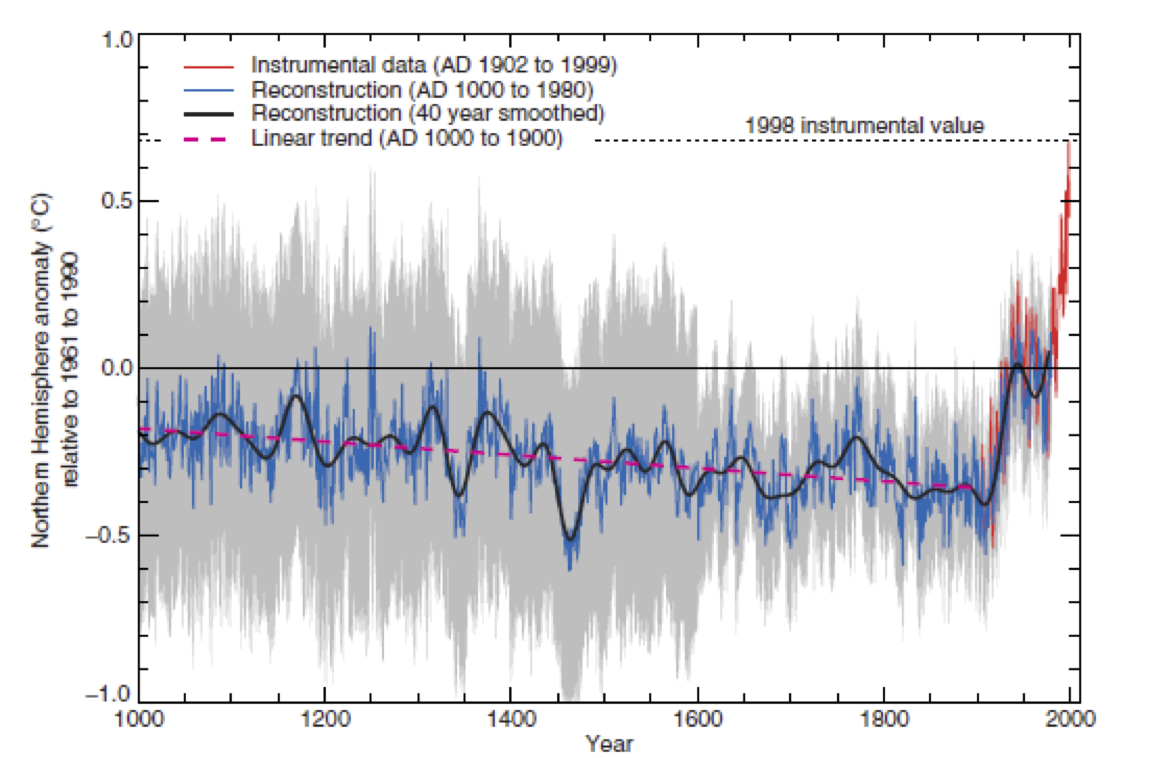

Allerdings führt die „Statistik“ dazu, dass immer die berüchtigte, Angst einflößende Hockeystick-Kurve (Bild 1-17) herauskommt. Das „Rauschen“ der Proxis wird grundsätzlich fast zu einer Geraden gemittelt. So ab 1900, wenn die Proxis die aktuelle, „geforderte“ Erwärmung nicht zeigen, werden die Werte durch Messwerte ersetzt, die natürlich steil nach oben reichen.

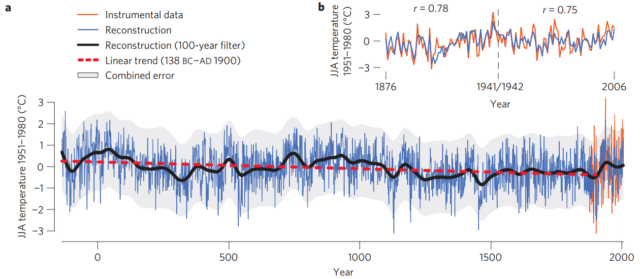

Was wäre, wenn Temperatur-Proxirekonstruktionen stimmen

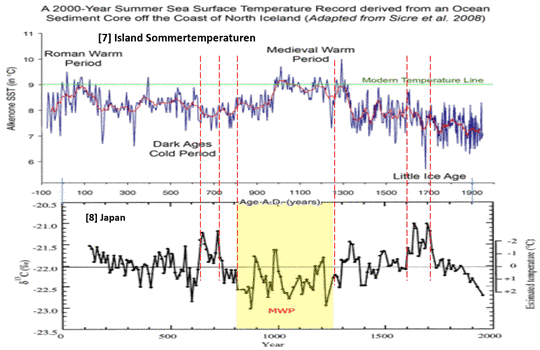

Nehmen wir einmal an, die Uni Giessen liegt mit ihrer Proxianalyse richtig. Dann befindet sich zumindest das Klima in Nordeuropa am Ende einer seit mehreren tausend Jahre langen Temperatur-Verringerung und die Warmzeiten dazwischen hat es wirklich gegeben (was die AGW-Klimawandelvertreter leugnen).

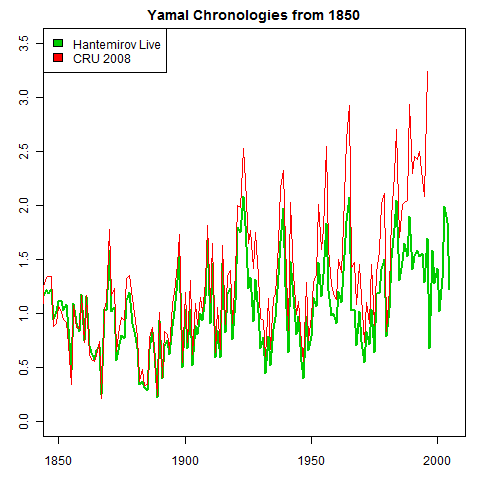

Universität Giessen, 9. Juli 2012: [4] Klima in Nord-Europa während der letzten 2.000 Jahre rekonstruiert: Abkühlungstrend erstmalig präzise berechnet

… Römerzeit und Mittelalter waren wärmer als bisher angenommen: Unter Beteiligung der Justus-Liebig-Universität Gießen hat ein internationales Forschungsteam jetzt eine 2.000-jährige Klimarekonstruktion für Nord-Europa anhand von Baumjahrringen vorgestellt. Unter Federführung der Universität Mainz kombinierte die Gießener Gruppe um Prof. Jürg Luterbacher, PhD, vom Institut für Geographie Jahrring-Dichtemessungen fossiler Kiefernbäume aus dem finnischen Lappland zu einer Zeitreihe, die bis in die Zeit 138 v. Chr. zurückreicht. Dabei hat das internationale Team erstmalig einen langfristigen Abkühlungstrend über die letzten Jahrtausende präzise berechnet [3]. „Wir konnten zeigen, dass die historischen Temperaturen zur Römerzeit und im Mittelalter als zu kühl eingeschätzt wurden“, so Professor Luterbacher. „Diese Befunde sind auch insofern von klimapolitischer Bedeutung, da sie die Beurteilung des aktuellen Klimawandels im Vergleich zu den historischen Warmphasen beeinflussen.“

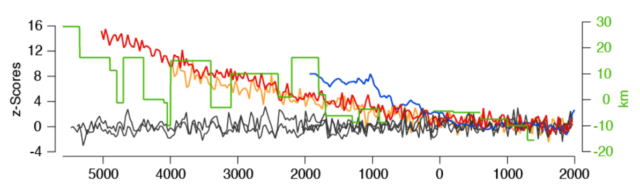

EIKE 07.01.2017:[10] Drei-Königs Sternsinger Aktion 2017 gegen Klimawandel-Auswirkungen in Kenia: Seit 5000 Jahren besteht dort ein ununterbrochener Trend zum heutigen Klima, doch seit Kurzem ist der Westen daran schuld

Danach wurde auch dort das Klima über mehrere tausend Jahre kälter und dadurch trockener. Eine Vielzahl von Rekonstruktionen unterstützt dies jedenfalls.

NoTricksZone, Kenneth Richard on 20. July 2017 : The ‘Real Proxy’ Temperature Record Hints Near-Global Cooling Has Begun Scientists Find At Least 75% Of The Earth Has Not Warmed In Recent Decades

Alternative Globaltemperatur-Bestimmung

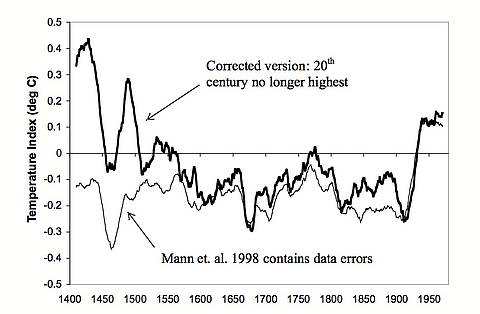

Der „berühmte“ Hokeystick von M. Mann at al., plakativer Auslöser der Klimahysterie, zeigt einen recht langen, fast geraden, historischen Temperaturtrend und dann den berüchtigten, steilen (angeblich nur anthropogen verursachten) Anstieg.

Anmerkung: Inzwischen hat M. Mann seine Darstellung stark überarbeitet und die ursprünglich ignorierte, mittelalterliche Warmzeit nachträglich wieder entstehen lassen.

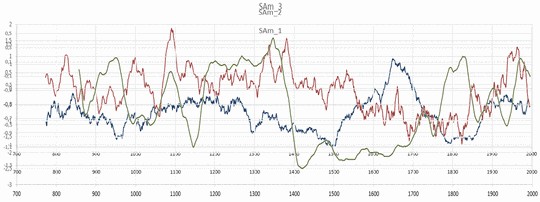

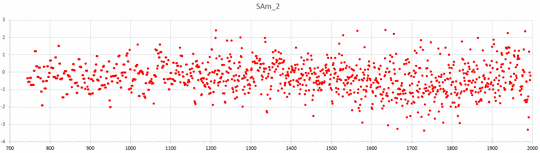

Dieser Kurvenverlauf entsteht immer und unvermeidbar, wenn Proxispaghetti (Bild 1.13) mit gemessenen Temperaturen ergänzt werden. Einmal, weil der Mittelwert der „Proxispaghetti“ durch Mitteln immer eine Gerade erzeugt und auch, weil Proxis die wirklichen, teil extremen Temperaturvariabilitäten nicht abbilden. Die gemessenen Temperaturen bilden diese aber mindestens teilweise ab. Als Konsequenz werden die historischen Variabilitäten unterdrückt und die aktuellen überbewertet.

Dies führte zur Überlegung, dass zur richtigen Weiterführung der historischen Temperaturen auch die aktuellen Werte durch Proxis gebildet werden müssen. Auch unter der Annahme, dass diese die Globaltemperatur „richtiger“ abbilden als die problematischen 2m-Stationsmesswerte mit ihren Flächenmittelungs-Versuchen.

Das Ergebnis daraus ist jedenfalls interessant: Es gibt dann keinen Hockeystick mehr und die Erde kühlt sich inzwischen ab.

NoTricksZone, 2017 / July / 20: [30] Scientists Find At Least 75% Of The Earth Has Not Warmed In Recent Decades

… As a new scientific paper (Turney et al., 2017) indicates, the Southern Ocean encompasses 14% of the Earth’s surface. And according to regional temperature measurements that have apparently not been subjected to warming “corrections” by data adjusters, the Southern Ocean has been cooling in recent decades.

The Northern Hemisphere embodies the top half (50%) of the world’s surface. And according to many scientists’ temperature reconstructions using proxy evidence (ice cores, tree rings, etc.) from numerous locations North of the equator, there has been no net warming in the Northern Hemisphere since the 1940s.

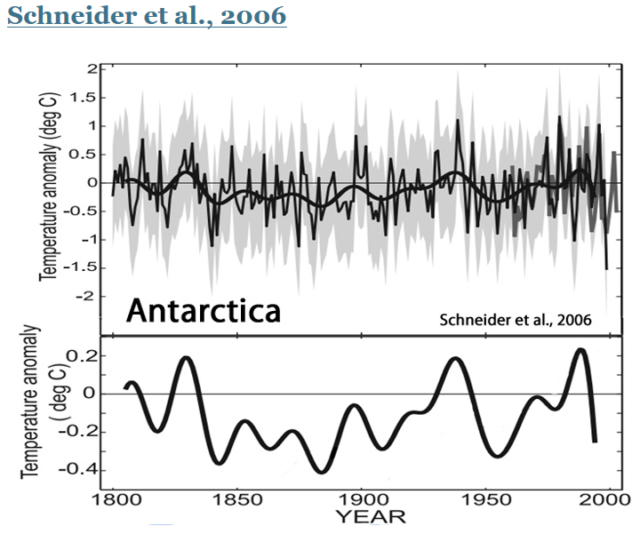

Antarctica (2.7%) and the Indian Ocean (14.4%) together represent about 17% of the Earth’s surface. Neither Antarctica nor the Indian Ocean have been observed to have warmed since the 1970s, with Antarctica exhibiting a cooling trend.

Just these regions of the globe alone represent more than 75% of the Earth’s surface. A net non-warming (cooling) trend in these regions in recent decades is highly inconsistent with commonly accepted instrumental data sets (such as NOAA, NASA, and HadCRUT) which show an abrupt recent warming trend – especially since the 1980s.

Hitzerekorde

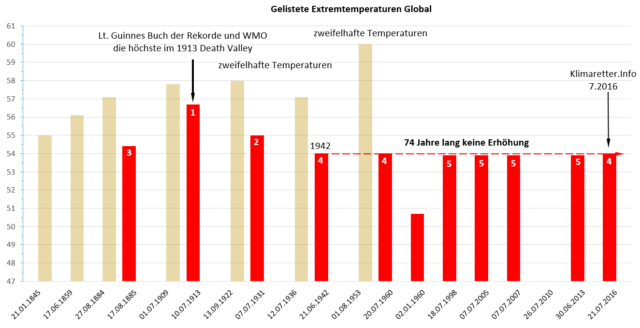

Weil die letzten drei Jahre etwas Besonderes zeigen (sollen):

G20-Klimawandel-Faktenliste: [2] „ … die drei Rekordjahre in Folge wurden noch nie seit Beginn der Wetteraufzeichnung registriert … „

muss auch dazu erwähnt werden, dass es dadurch immer noch nicht heißer geworden ist.

EIKE 30.07.2016: [11] Weltweiter Temperaturrekord gemessen?

Die Daten

-Seit 103 Jahren ist es global nicht mehr heißer geworden

-Seit 74 Jahren hat sich an der globalen Grenztemperatur überhaupt nichts verändert

-In 32 Jahren ist es in Deutschland (vielleicht, da nicht signifikant messbar) um 0,1 °C heißer geworden [12]

– würde man die „verworfenen“ Messungen einbeziehen, wäre es früher weit wärmer gewesen als aktuell

– auch Australien (NSW) hatte seinen Hitzerekord mit 44.06 Grad am 14. Januar 1939.

EIKE 24.09.2016: [13] Die heißeste Temperatur Deutschlands war nur ein Wärmeinseleffekt: Ein Klimaprofessor plaudert aus seinem „Nähkästchen für Temperatur“

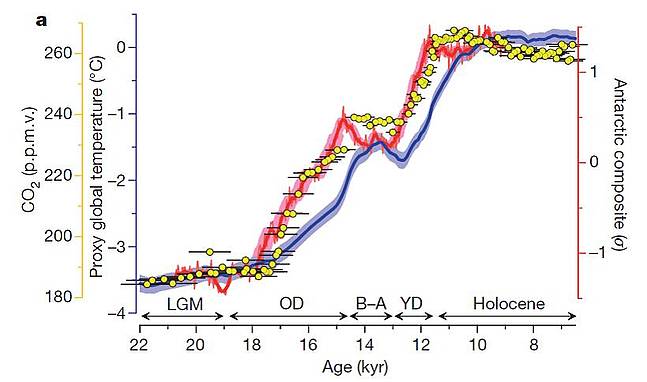

Wie weit „darf“ sich die Temperatur noch naturbelassen erhöhen?

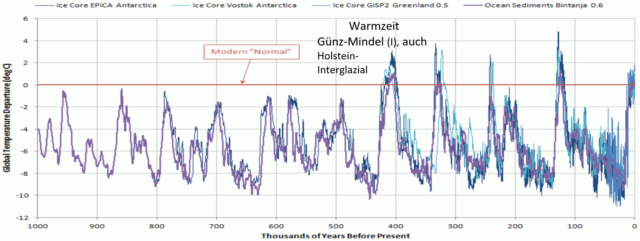

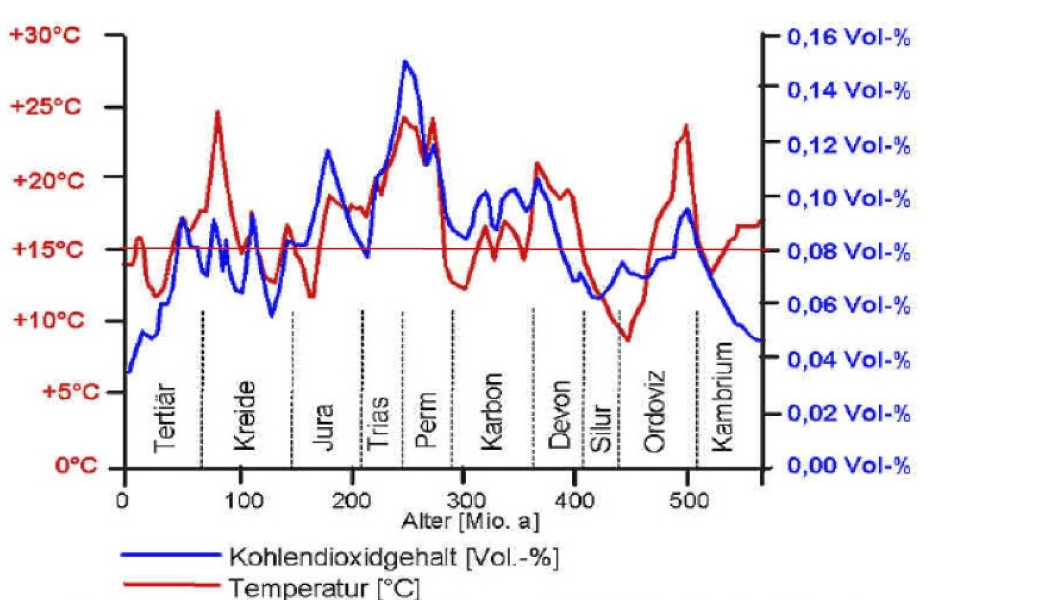

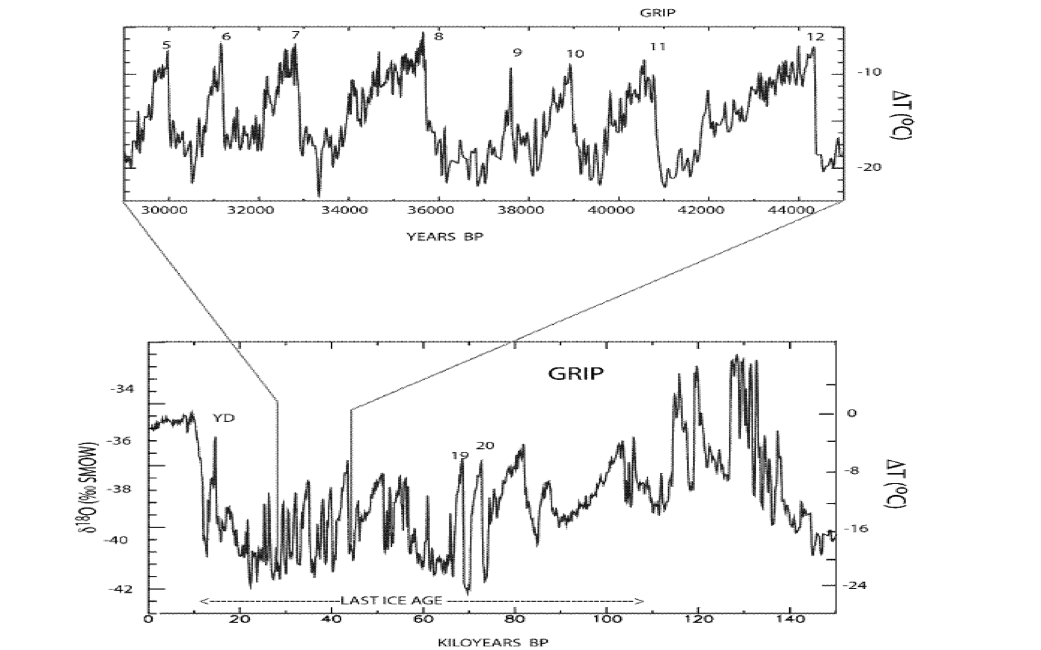

Um das abzuschätzen, braucht man nur die letzten 1 Millionen Jahre Temperaturverlauf anzusehen:

EIKE 25.12.2016: [15] Man sollte schon langsam an die nächste Eiszeit denken, denn wenn die neuesten Hypothesen sich als falsch erweisen, kann sie schnell da sein

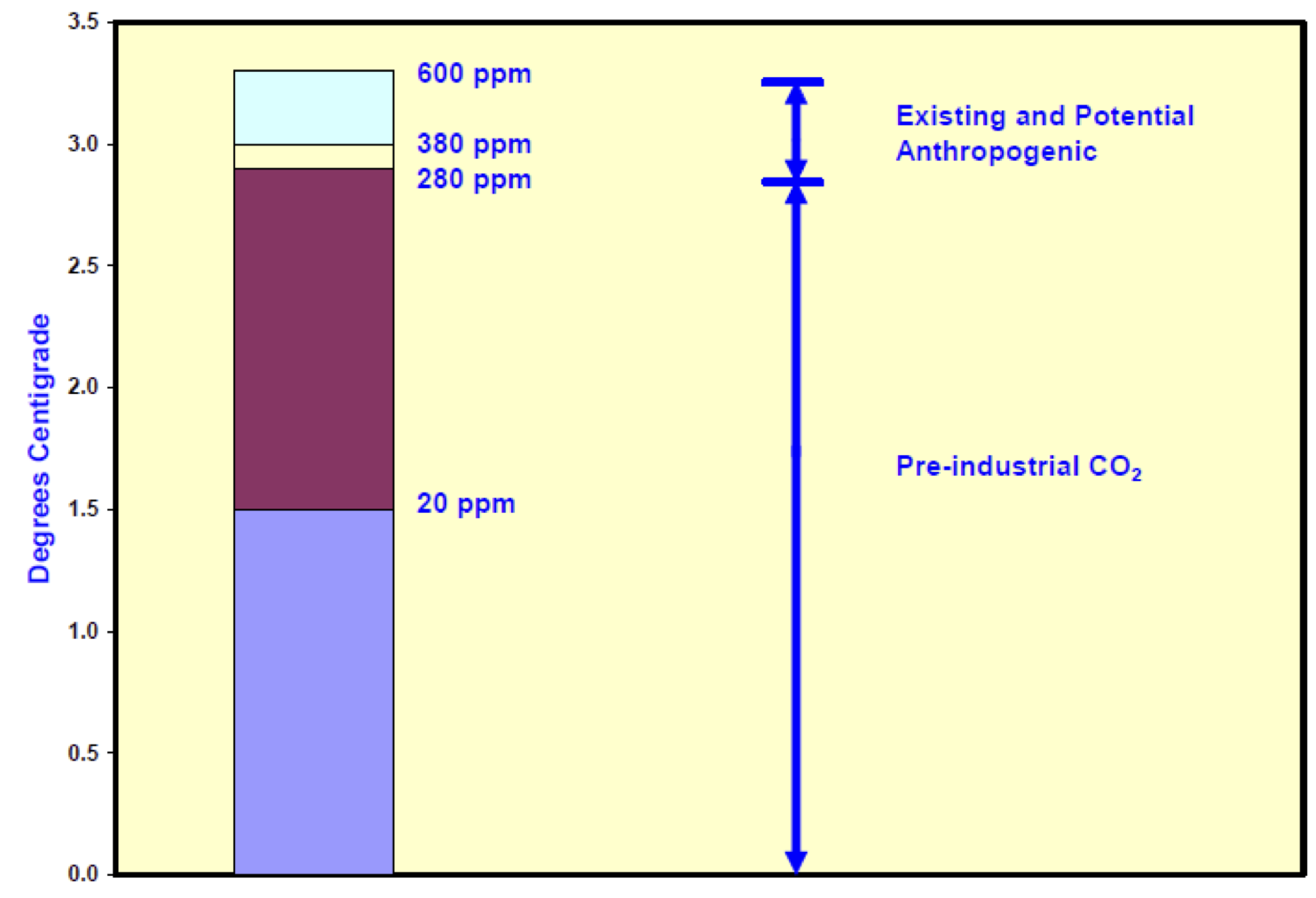

Die Behauptung, dass bei +2 oder gar +1,5 Grad Erhöhung ein Kipppunkt zur nicht mehr stoppbaren Überhitzung erreicht sein muss, widerspricht somit der „Erdklima-Erfahrung“ der letzten 1 Millionen Jahre.

Wieder ist es so, dass es den Kipppunkt ausschließlich in von Menschen programmierten Klimasimulationen gibt. Dass ein Programmierer das Klimaverhalten besser weiß, als die Erde seit einer Millionen Jahre, muss man dazu dann glauben.

Natürlich hat solcher Glaube eine „wissenschaftliche“ Begründung:

PIK: Menschgemachter Klimawandel unterdrückt die nächste Eiszeit

Mit einem ausgeklügelten Computermodell des Erdsystems, in dem die Dynamik von Atmosphäre, Ozean, Eisschilden und der globale Kohlenstoffzyklus simuliert werden, haben die Wissenschaftler den Effekt menschgemachter CO2-Emissionen auf das Eisvolumen der Nordhalbkugel untersucht. „Weil Kohlendioxid in der Atmosphäre extrem langlebig ist, haben vergangene wie künftige Emissionen großen Einfluss darauf, wann ein neuer Eiszeitzyklus beginnt“, sagt Ko-Autorin Ricarda Winkelmann. „Unsere Analyse zeigt, dass schon geringe zusätzliche Kohlenstoff-Emissionen die Entwicklung der Eisbedeckung auf der Nordhalbkugel wohl auf zehntausende Jahre beeinflussen würde, während künftige CO2-Emissionen von 1.000 oder 1.500 Gigatonnen Kohlenstoff die nächste Eiszeit um mindestens 100.000 Jahre verschieben könnten.“

Neben dem, dass bisher kein Computermodell das Erdsystem wirklich erfasst – schon gar nicht die Eiszeitzyklen, deren Entstehung bisher nur als Hypothesen „erklärt“ sind, stimmt bei der PIK-Behauptung auch nicht, dass das anthropogenen CO2 in der Atmosphäre extrem langlebig wäre. Eine grobe Einigkeit besagt eine Verweildauer von ca. 100 Jahren (einige vermuten noch viel weniger). Damit ist das anthropogene Zusatz-CO2-Budget alle 100 Jahre neu auffüllbar. Das resultierende CO2 Forcing-Ergebnis reicht für solche (simulierten) Effekte dann einfach nicht aus. Neben dem, dass das wirkliche CO2-Forcing inzwischen eher bei ca. 1 Grad / Verdopplung und nicht den vom IPCC noch angegebenen 3 Grad pro Verdopplung liegt. Ein Überhitzungs-Kipppunkt durch anthropogenes CO2 ist danach überhaupt nicht mehr möglich.

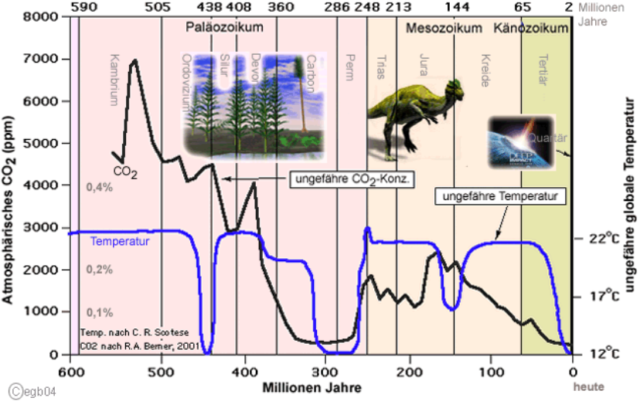

Es lässt sich auch zeigen, dass die Erde sich seit der messbaren Erdgeschichte am untersten Temperaturniveau befindet. Die Menschheit muss demnach mehr Angst vor der vollkommenen Vereisung haben und davor, dass der lebensnotwendige Pflanzendünger CO2 in der Atmosphäre noch weiter abnimmt und damit kein Wachstum von Grünpflanzen mehr möglich wäre.

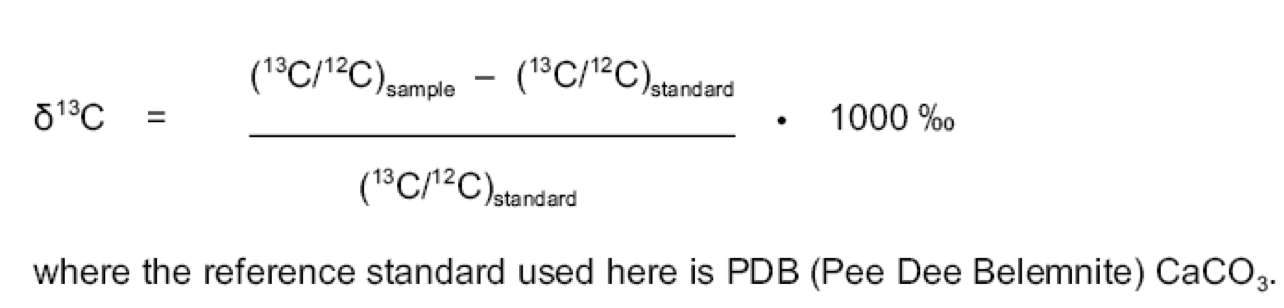

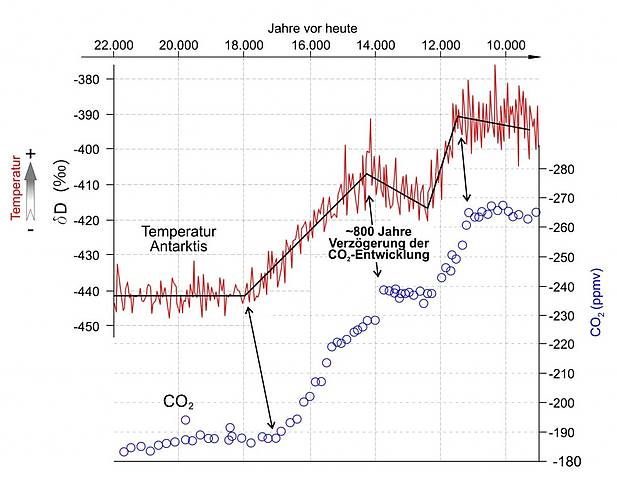

Leser*innen, welchen im Bild 1-19 auffällt, dass zwischen CO2 und Erdtemperatur überhaupt keine Korrelation besteht und deshalb noch wissen wollen, wie wenig CO2 und Temperaturverlauf auch in jüngerer Zeit korrelieren, seien zum Weiterlesen auf den folgenden Artikel verwiesen:

WUWT David Middleton / December 7, 2012: A Brief History of Atmospheric Carbon Dioxide Record-Breaking

Wer dann noch sehen möchte, wie das Umfallen des berühmten Sack Reises in China, hier der übliche Abbruch von Schelfeis in der Antarktis – medial zu einem Katstrophenszenario aufgebauscht wird, lese:

EIKE 13. Juli 2017: Zerbricht der Südpol? Riesiger Antarktis-Schelfeis-Abbruch ein ganz normaler Vorgang – dabei wird die Antarktis seit 30 Jahren kälter

kaltesonne, 22. Januar 2017: Kein Klimawandel: Vom antarktischen Larsen-C-Schelfeis droht ein großer Eisberg abzubrechen

Fazit

Die Schlussfolgerung, ob sich die Erde global oder lokal wirklich in einem unnatürlichen Überhitzungsmodus oder alternativ im Zeitalter eines der größten Wissenschaftsbetrügereien dieses Jahrhunderts befindet, sei jedem Leser*in selbst überlassen.

Quellen

[1] EIKE: Der dürregebeutelte Sahel wird grün – ein schlimmes Anzeichen des Klimawandels

[2] Klimawandel – eine Faktenliste zum Stand der Forschung Pressekonferenz in Hamburg 6. Juli 2017

[3] Johannes Gutenberg University, 55099 Mainz, Jan Esper at al, 8 JULY 2012: Orbital forcing of tree-ring data

[4] Universität Giessen, 9. Juli 2012: Klima in Nord-Europa während der letzten 2.000 Jahre rekonstruiert: Abkühlungstrend erstmalig präzise berechnet

[5] EIKE, 10. Juli 2017: Brandaktuelle Studie: Temperatur-Adjustierungen machen „fast die gesamte Erwärmung“ in den Klimadaten der Regierung aus

[6] EIKE, 20. Februar 2017: [6] Weitere Daten-Manipulationen seitens NOAA, NASA, HadCRUT … Vergangenheit kälter, Gegenwart wärmer gemacht

[7] Dr. James P. Wallace at al., June 2017: On the Validity of NOAA, NASA and Hadley CRU Global Average Surface Temperature Data & The Validity of EPA’s CO2 Endangerment Finding Abridged Research Report

[8] WUWT, Christopher Monckton of Brenchley, July 7, 2017: How They airbrushed out the Inconvenient Pause

[9] EIKE 11.05.2016: Die Problematik der Temperaturrekonstruktion Eine beispielhafte Sichtung dazu anhand des Projektes PAGES 2k

[10] EIKE 07.01.2017: Drei-Königs Sternsinger Aktion 2017 gegen Klimawandel-Auswirkungen in Kenia: Seit 5000 Jahren besteht dort ein ununterbrochener Trend zum heutigen Klima, doch seit Kurzem ist der Westen daran schuld

[11] EIKE 30.07.2016: Weltweiter Temperaturrekord gemessen?

[12] EIKE 28.07.2015: 5. Juli 2015, der bisher heißeste Tag Deutschlands?

[13] EIKE 24.09.2016: Die heißeste Temperatur Deutschlands war nur ein Wärmeinseleffekt: Ein Klimaprofessor plaudert aus seinem „Nähkästchen für Temperatur“

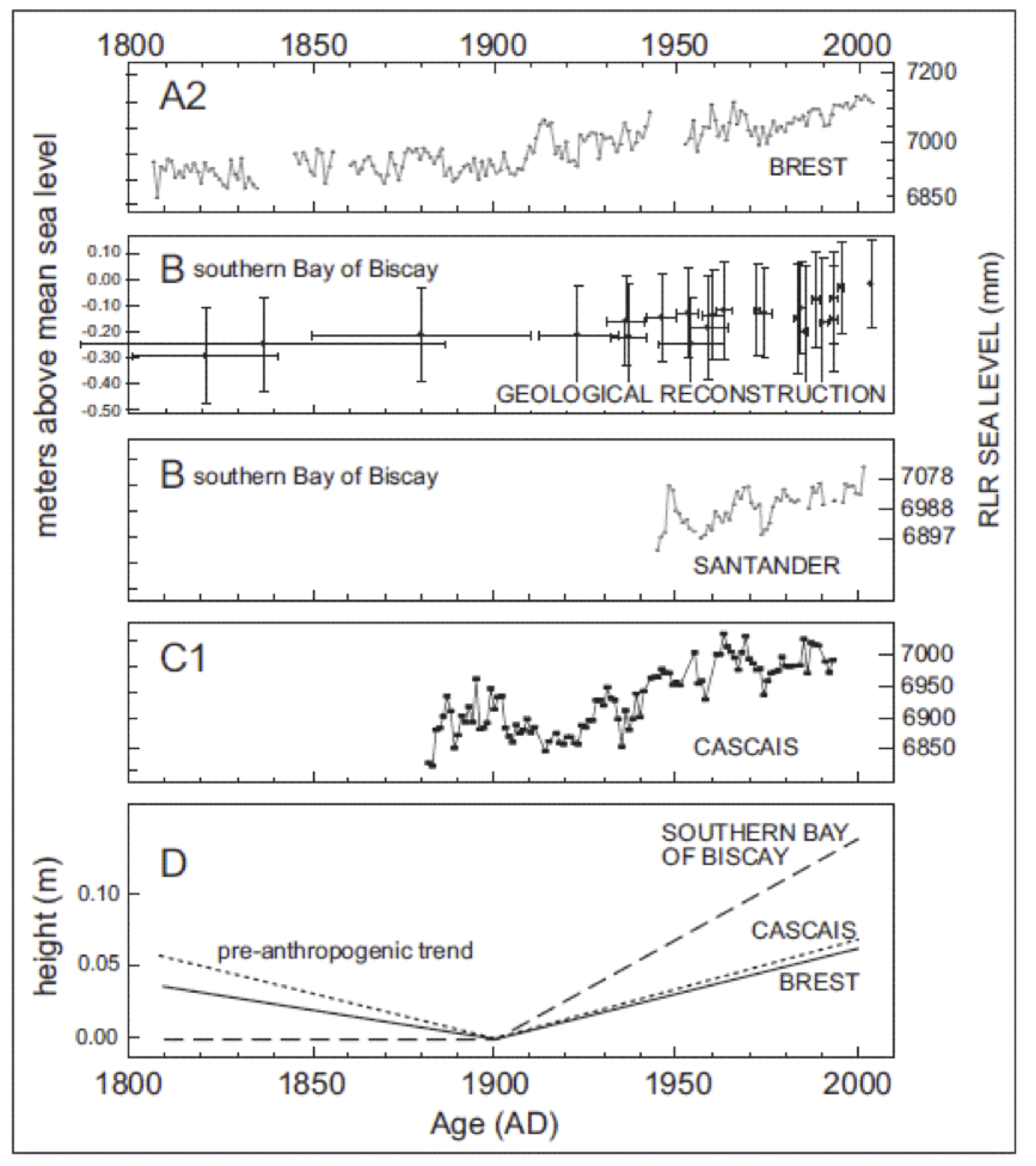

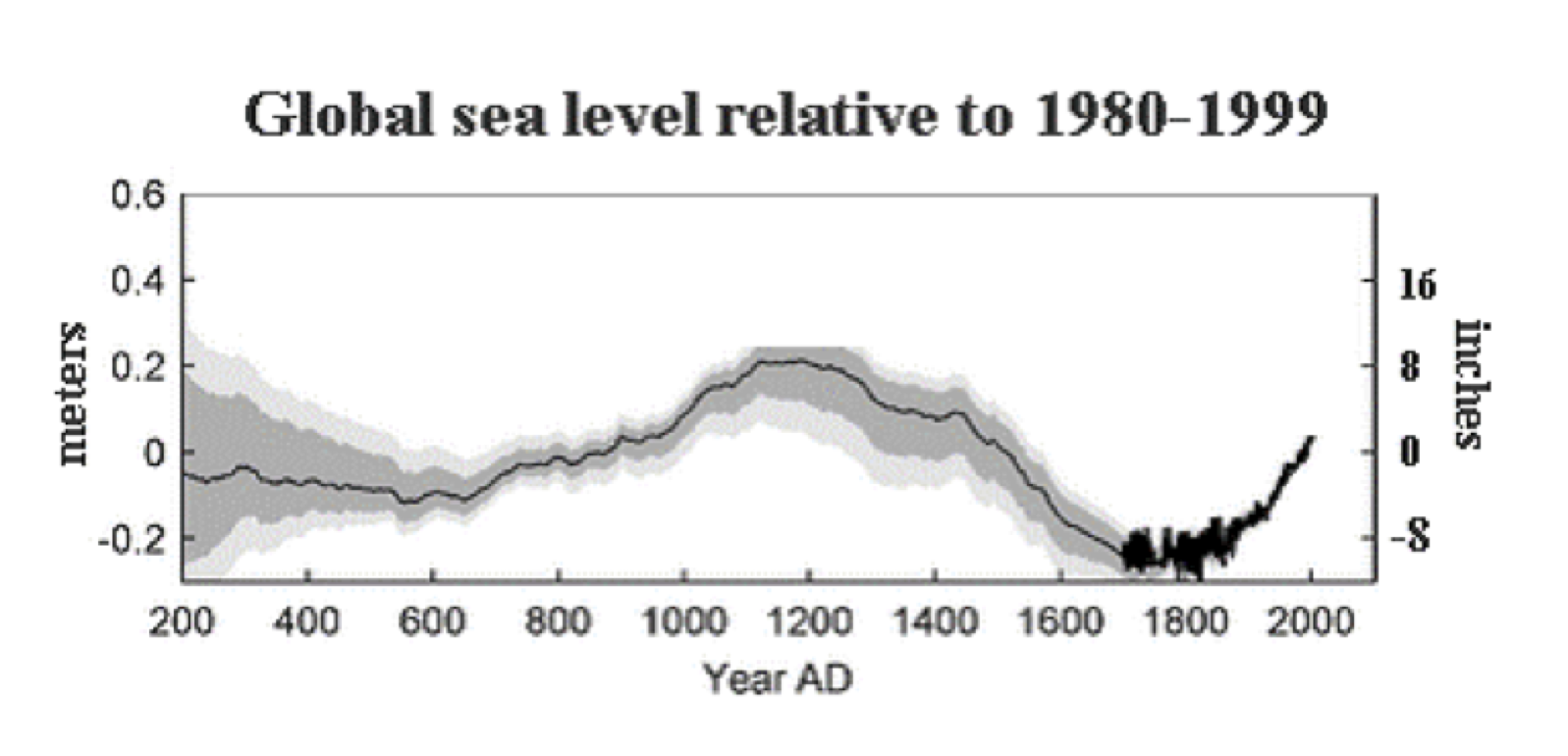

[14] EIKE 17.07.2016: Wie man den Meerespegel-Verlauf in die richtige Richtung dreht Aus dem Lehrbuch für (Klima-) Statistikbetrug

[15] EIKE 25.12.2016: Man sollte schon langsam an die nächste Eiszeit denken, denn wenn die neuesten Hypothesen sich als falsch erweisen, kann sie schnell da sein

[16] EIKE, 8. Juli 2014 Klaus-eckart Puls: Säkularer und Aktueller Meeres-Anstieg: Pegel (1.6 mm/Jahr) oder SAT-Altimeter (3.2 mm/Jahr) – WAS ist richtig ?

[17] EIKE 14.12.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 3 Die Marshall-Inselgruppe – (kein) Beispiel für einen Untergang

[18] EIKE 26.11.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 2

[19] RMIT University, Bundoora, VIC, Australia. A. Parker, 23/Jul/2014: Problems and reliability of the satellite altimeter based Global Mean Sea Level computation

[20] EIKE 07.04.2016: Der Verlauf des Meeresspiegels im Holozän und seit 2.000 Jahren

[21] EIKE, 26. Dezember 2014: Schummeleien überall: Jetzt zur Versauerung der Ozeane

[22] ScienceScepticalBlog, 22. Oktober 2014: “Versauerung” der Meere: Reale Bedrohung, oder nicht mehr als Panikmache?

[23] Vinje, T. 2001. Anomalies and Trends of Sea-Ice Extent and Atmospheric Circulation in the Nordic Seas during the period 1864-1998. Journal of Climate, February 2001, 255-267.

[24] EIKE 01.06.2017: Der Meerespegel steigt drei Mal so stark an – ohne dass sich an dessen Verlauf etwas verändert hat

[25] ScienceScepticalBlog 2012: Was nicht passt wird passend gemacht – ESA korrigiert Daten zum Meeresspiegel

[26] Forst BW Waldzustandsbericht 2016 für Baden-Württemberg

[27] kaltesonne, 18. Juli 2017: Der Bauer und sein Klima: Film ist jetzt im Internet verfügbar

[28] WUWT, David Middleton, July 20, 2017: More Fun With Sea Level

[29] Uba Juli 2015: Klimawandel könnte künftig mehr Hitzetote fordern. Hitzewellen erhöhen das Sterblichkeitsrisiko von Herzkranken um bis zu 15 Prozent. Das ergab eine Studie des Deutschen Wetterdienstes (DWD) für das Umweltbundesamt (UBA). WEB: http://www.dwd.de/klimawandel

[30] NoTricksZone, 2017 / July / 20, Kenneth Richard: Scientists Find At Least 75% Of The Earth Has Not Warmed In Recent Decades

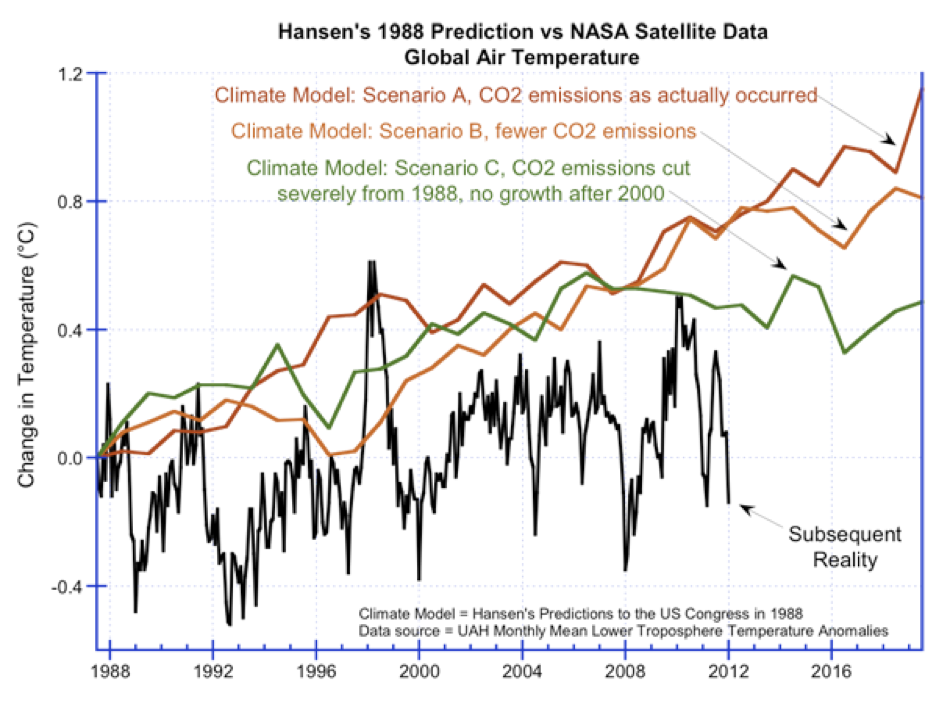

Bild WUWT

Bild WUWT

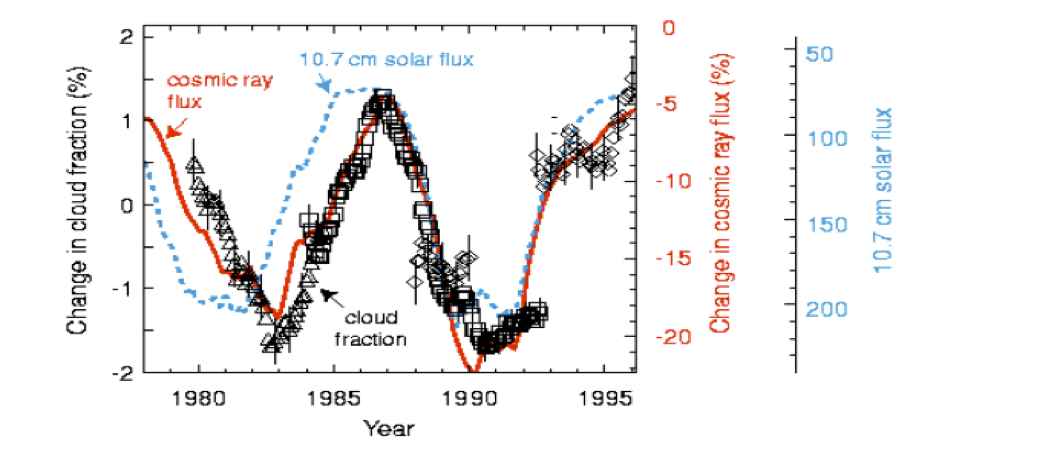

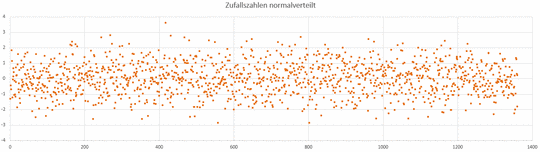

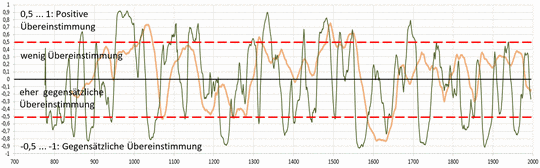

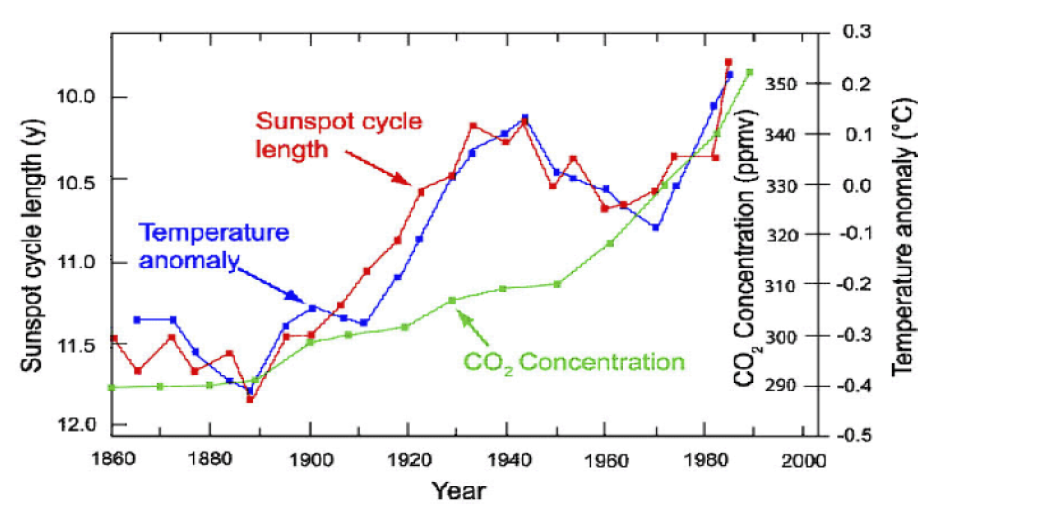

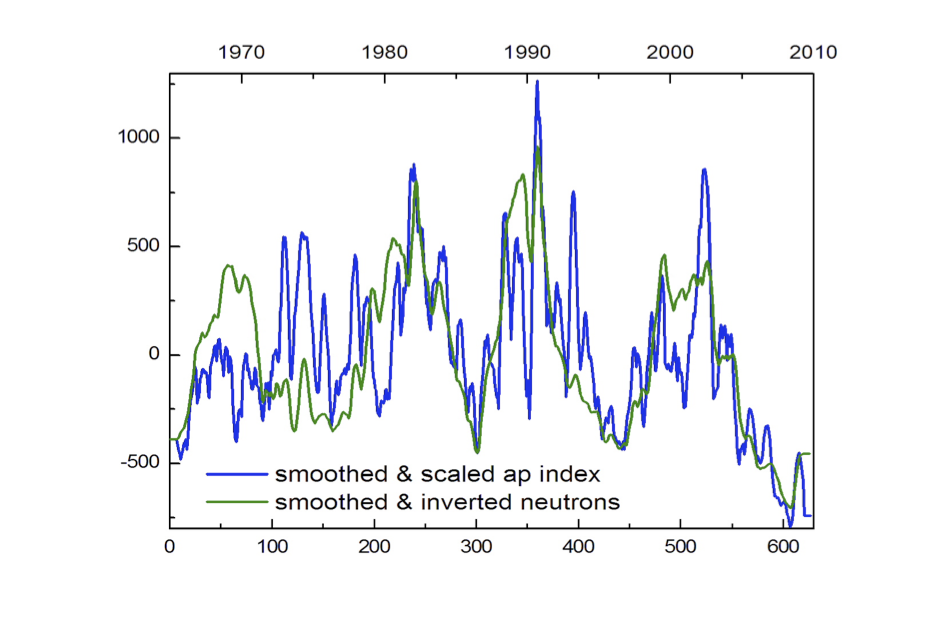

Die folgende Graphik zeigt zweifelsfrei, dass es eine enge Korrelation zwischen der kosmischen Strahlung und der Wolkenbildung gibt. Mehr Wolken bedeuten geringere Einstrahlung und sinkende Temperaturen und vice versa.

Die folgende Graphik zeigt zweifelsfrei, dass es eine enge Korrelation zwischen der kosmischen Strahlung und der Wolkenbildung gibt. Mehr Wolken bedeuten geringere Einstrahlung und sinkende Temperaturen und vice versa.