Der sich abzeichnende Thermostat

Abstract

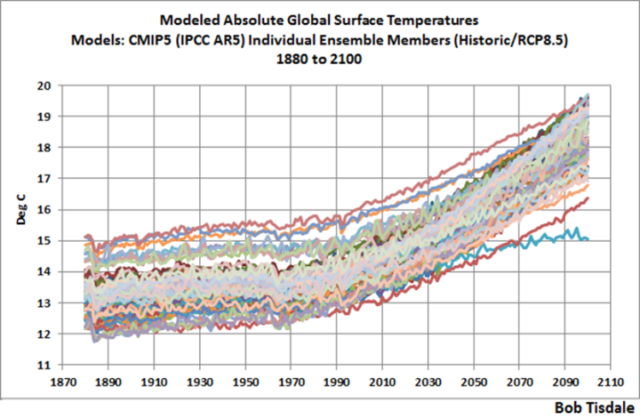

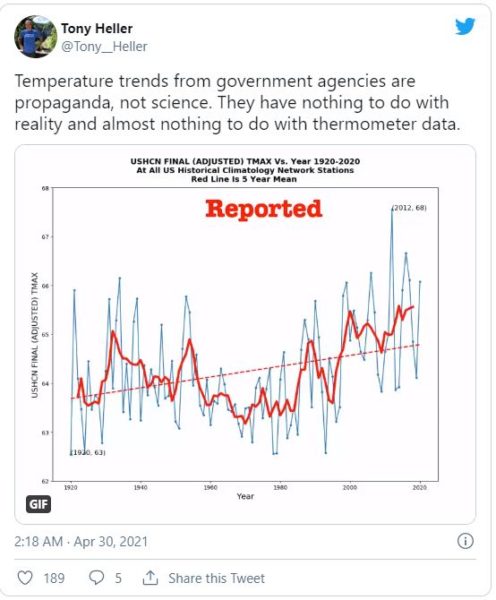

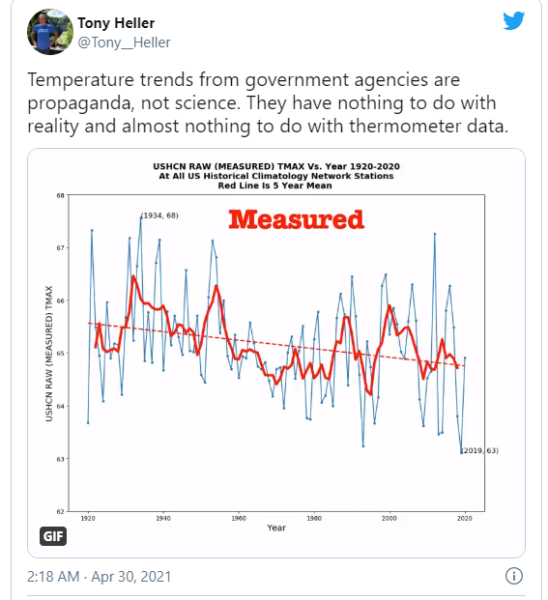

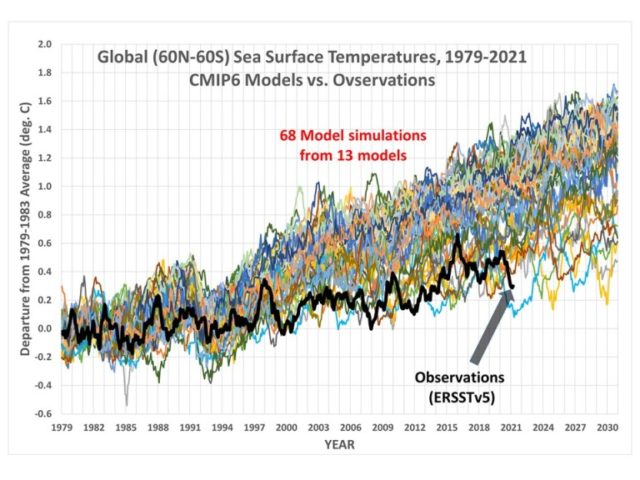

Das aktuelle Paradigma der Klimawissenschaft besagt, dass die langfristige Änderung der globalen Temperatur durch eine Konstante namens „Klimasensitivität“ multipliziert mit der Änderung der abwärts gerichteten Strahlung, genannt „Strahlungsantrieb“, gegeben ist. Trotz über vierzigjähriger Untersuchungen hat sich die Unsicherheit des Wertes der Klimasensitivität jedoch nur vergrößert.1 Dieser Mangel an jeglichem Fortschritt bei der Bestimmung des zentralsten Wertes im aktuellen Paradigma deutet stark darauf hin, dass das Paradigma selbst falsch ist, dass es keine genaue Beschreibung der Realität darstellt. Hier schlage ich ein anderes Klimaparadigma vor, das besagt, dass eine Vielzahl von auftretenden Klimaphänomenen zusammenwirken, um die Oberflächentemperatur in engen Grenzen zu halten. Dies erklärt die ungewöhnliche thermische Stabilität des Klimasystems.

Übersicht

Mehrere Autoren haben das Klimasystem als eine Wärmekraftmaschine analysiert. Hier ist die Beschreibung von Reis und Bejan:

Die Erde mit ihrem solaren Wärmeeintrag, ihrer Wärmeabstrahlung und den Schwingungen der atmosphärischen und ozeanischen Zirkulation ist eine Wärmekraftmaschine ohne Welle: ihre maximierte (aber nicht ideale) mechanische Leistung kann nicht an ein extraterrestrisches System abgegeben werden. Stattdessen ist der Erdmotor dazu bestimmt, die gesamte von ihm erzeugte mechanische Leistung durch Luft- und Wasserreibung und andere Irreversibilitäten (z. B. Wärmelecks über endliches ∆T) zu zerstreuen. Er tut dies, indem er sich so schnell wie möglich „in seiner Bremse dreht“ (daher die Winde und Meeresströmungen, die auf einfachsten Wegen verlaufen).2

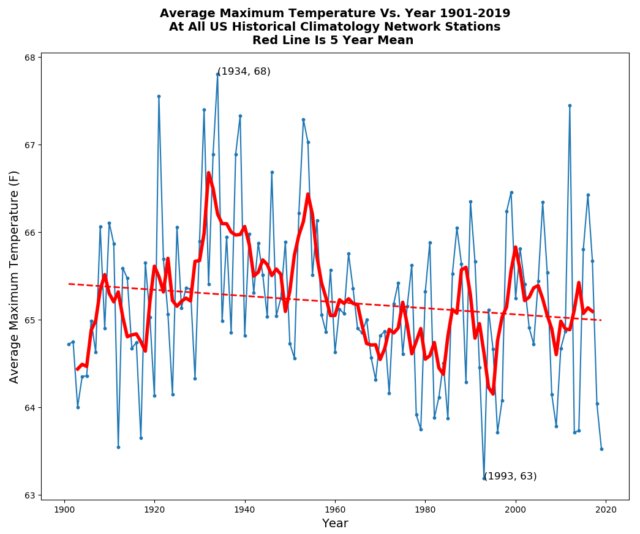

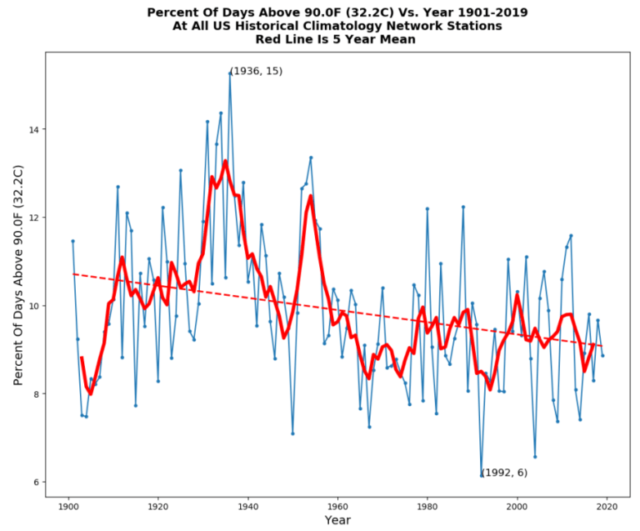

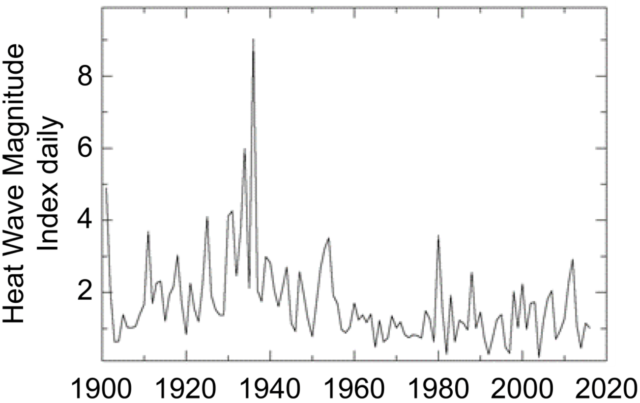

Einer der ungewöhnlichsten und im Allgemeinen nicht beachteten Aspekte bei der Betrachtung der Wärmekraftmaschine ist ihre verblüffende Stabilität. Im Laufe des 20. Jahrhunderts schwankte die globale durchschnittliche Oberflächentemperatur um weniger als ein Kelvin. Das ist eine Schwankung von ± 0,2 %. In Anbetracht der Tatsache, dass das System eine variable Menge an einfallender Energie zurückweist, wobei die Schwankungen größtenteils durch nichts Handfesteres als Wolken gesteuert werden, ist dies ein höchst überraschender Grad an Stabilität.

Dies wiederum spricht stark für einen globalen Thermo-Regulations-Mechanismus. Die Stabilität kann nicht auf einfacher thermischer Trägheit beruhen, da die hemisphärischen Landtemperaturen im Laufe des Jahres um ~ 20 K und die hemisphärischen Meerestemperaturen um ~ 5 K variieren.

Emergenz*

[*Es lässt sich keine befriedigende Übersetzung für diesen Terminus finden. Er wird daher im Folgenden beibehalten. Der Vergleich des Titels im Original und in dieser Übersetzung macht klar, was gemeint ist. – A. d. Übers.]

Es gibt keine allgemein akzeptierte Definition von Emergenz. Im Jahr 1874 schlug Lewes die folgende Definition vor: „Emergenz: Theorie, nach der die Kombination von Entitäten einer bestimmten Ebene eine Entität einer höheren Ebene hervorbringt, deren Eigenschaften völlig neu sind“.3

Für die Zwecke dieses Artikels werde ich emergente Klimaphänomene funktional und anhand eines Beispiels definieren.

Emergente Klimaphänomene entstehen spontan, oft beim Überschreiten einer thermischen oder anderen Schwelle. Man Betrachte die tägliche Entwicklung des tropischen Kumuluswolkenfeldes.

Beim Überschreiten einer Temperaturschwelle können aus einem klaren Himmel in kurzer Zeit Hunderte von einzelnen Kumuluswolken entstehen.

Sie haben eine Entstehungszeit und eine begrenzte Lebensdauer. Staubteufel bilden sich spontan zu einem bestimmten Zeitpunkt, bestehen eine Zeit lang und lösen sich dann auf und verschwinden.

Sie bilden ein separates Ganzes, das sich von der Umgebung unterscheidet. Tropische Gewitter sind von klarer Luft umgeben.

Sie sind oft beweglich und bewegen sich auf unvorhersehbare Weise. Infolgedessen haben tropische Wirbelstürme „Vorhersagekegel“ dafür, wohin sie möglicherweise als nächstes ziehen werden, anstatt genau vorhersehbar zu sein.

Sie sind oft mit Phasenänderungen in den entsprechenden Flüssigkeiten verbunden. Konvektive Wolkenentstehung beinhaltet eine Phasenänderung von Wasser.

Einmal vorhanden, können sie unterhalb der für ihre Entstehung notwendigen Schwelle bestehen bleiben. Die Rayleigh-Benard-Zirkulation erfordert eine bestimmte Temperaturdifferenz, um zu entstehen, aber wenn sie einmal existiert, kann die Zirkulation bei einer kleineren Temperaturdifferenz bestehen bleiben.

Es handelt sich um Strömungssysteme, die weit vom Gleichgewicht entfernt sind. Als solche müssen sie sich gemäß dem Konstruktionsgesetz4 weiterentwickeln und mutieren, um zu überleben.

Sie sind nicht einfach vorhersehbar, da sie ganz andere Eigenschaften haben als das Medium, aus dem sie hervorgehen. Wenn Sie irgendwo leben würden, wo es nie Wolken gibt, würden Sie wahrscheinlich nicht vorhersagen, dass plötzlich ein riesiges weißes Objekt Hunderte von Metern über Ihrem Kopf auftauchen könnte.

Beispiele für natürliche emergente Phänomene, mit denen wir vertraut sind, sind das Verhalten von Vogelschwärmen, Wirbel aller Art, Termitenhügel, Bewusstsein und sogar das Leben selbst. Bekannte emergente Klimaphänomene sind Gewitter, Tornados, die Rayleigh-Bénard-Zirkulation der Atmosphäre und des Ozeans, Wolken, Zyklone, El Ninos und Staubteufelchen.

Ein einfaches Beispiel

Um zu erklären, wie emergente Phänomene die Temperatur der Erdoberfläche thermoregulieren, betrachten wir das kleine „Staubteufelchen“. Wenn die Sonne im Sommer ein Feld aufheizt, ist die Temperaturänderung eine ziemlich lineare Funktion des Antriebs, hier der abwärts gerichteten Sonnenstrahlung. Dies steht im Einklang mit dem aktuellen Paradigma. Aber wenn der heißeste Teil des Feldes eine bestimmte Temperatur in Bezug auf die darüber liegende atmosphärische Temperatur erreicht, taucht aus klarem Himmel ein Staubteufelchen auf. Dieser kühlt die Oberfläche auf mehrere Arten ab. Erstens bewegt er warme Oberflächenluft nach oben in die untere Troposphäre. Zweitens erhöht er die fühlbare Wärmeübertragung, die eine ungefähr lineare Funktion der Windgeschwindigkeit über der Oberfläche ist. Drittens erhöht sie die Verdunstung, was wiederum eine ungefähr lineare Funktion der Windgeschwindigkeit über der Oberfläche ist.

An diesem Punkt bricht das derzeitige Paradigma, dass die Temperaturänderung eine lineare Funktion der Änderung des Antriebs ist, vollständig zusammen. Wenn die Sonne die Oberfläche weiter bestrahlt, erhalten wir statt einer höheren Temperatur mehr Staubteufel. Dies setzt eine Obergrenze für die Oberflächentemperatur. Man beachte, dass diese Obergrenze nicht eine Funktion des Antriebs ist. Der Schwellenwert ist Temperatur-basiert, nicht Antriebs-basiert. Folglich wird sie nicht von Dingen wie einer veränderten Sonneneinstrahlung oder Variationen der Treibhausgase beeinflusst.

Ein vollständiges Beispiel

Die Schwerstarbeit des thermo-regulatorischen Systems wird jedoch nicht von Staubteufeln geleistet. Sie wird durch Variationen des Zeitpunkts und der Stärke des täglichen Auftretens tropischer Kumulusfelder und der darauf folgenden tropischen Gewitter, insbesondere über dem Ozean, erreicht. Dabei handelt es sich um das Zusammenspiel mehrerer verschiedener emergenter Phänomene.

Hier kommt der Ablauf von Tag und Nacht im tropischen Ozean ins Spiel. Der tropische Ozean ist der Ort, an dem der Großteil der Sonnenenergie in die riesige Wärmemaschine, die wir Klima nennen, eintritt. Infolgedessen befinden sich dort auch die wichtigsten thermostatischen Mechanismen.

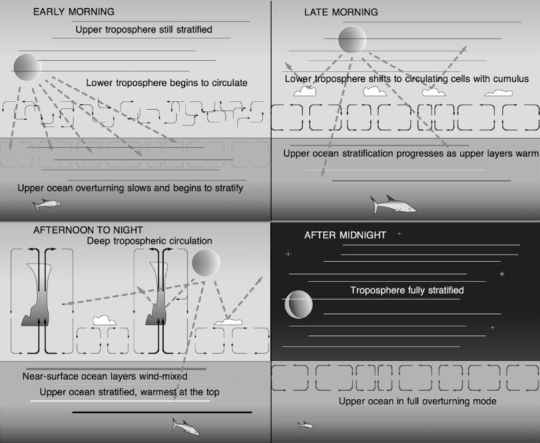

Wie im Paneel „Early Morning“ zu sehen, weist die Atmosphäre in der Morgendämmerung mehrere Schichten auf, wobei die kühlste Luft der Oberfläche am nächsten ist. Die nächtliche, emergente Rayleigh-Bénard-Umwälzung des Ozeans geht zu Ende. Die Sonne ist frei, um den Ozean zu erwärmen. Die Luft nahe der Oberfläche wirbelt willkürlich.

Während die Sonne den Ozean weiter aufheizt, entsteht gegen zehn oder elf Uhr morgens ein neues Zirkulationsmuster, welches die zufällige atmosphärische Verwirbelung ersetzt. Sobald eine kritische Temperaturschwelle überschritten wird, bilden sich überall lokale Zirkulationszellen vom Rayleigh-Bénard-Typ. Dies ist der erste emergente Übergang von der zufälligen Zirkulation zur Rayleigh-Bénard-Zirkulation. Diese Zellen transportieren sowohl Wärme als auch Wasserdampf nach oben.

Am späten Vormittag ist die Rayleigh-Bénard-Zirkulation typischerweise stark genug, um den Wasserdampf bis zum lokalen Lifting Condensation Level (LCL) anzuheben. In dieser Höhe kondensiert der Wasserdampf zu Wolken, wie im Paneel „Late Morning“ gezeigt.

Diese flächendeckende Verschiebung zu einem organisierten Zirkulationsmuster ist weder eine Änderung der Rückkopplung, noch steht sie in Zusammenhang mit einem Antrieb. Es handelt sich um ein selbstorganisiertes, emergentes Phänomen. Es ist schwellenbasiert, was bedeutet, dass es spontan auftritt, wenn eine bestimmte Schwelle überschritten wird. In den feuchten Tropen gibt es viel Wasserdampf, so dass die Hauptvariable für den Schwellenwert die Temperatur ist. Außerdem ist zu beachten, dass es in Tafel 2 zwei verschiedene Phänomene gibt – die Rayleigh-Bénard-Zirkulation, die vor der Cumulusbildung entsteht, und die durch die völlig getrennte Entstehung der Wolken verstärkt wird. Wir haben es nun auch mit zwei Zustandsänderungen zu tun, mit der Verdunstung an der Oberfläche und der Kondensation und Wiederverdunstung in der Höhe.

Unter diesem neuen Regime der Cumulus-Zirkulation am späten Vormittag findet viel weniger Oberflächenerwärmung statt. Ein Teil des Sonnenlichts wird zurück in den Weltraum reflektiert, so dass zunächst weniger Energie in das System gelangt. Dann erhöht der zunehmende Oberflächenwind aufgrund des Cumulus-basierten Zirkulationsmusters die Verdunstung, wodurch die Oberflächenerwärmung noch weiter reduziert wird, indem die latente Wärme nach oben in die aufsteigende Kondensationsebene transportiert wird.

Entscheidend sind hier der Zeitpunkt und die Stärke des Auftretens. Wenn der Ozean etwas wärmer ist, setzt das neue Zirkulationsregime früher am Morgen ein und verringert die gesamte Tageserwärmung. Ist der Ozean hingegen kühler als üblich, hält der klare Morgenhimmel bis spät in den Tag hinein an und ermöglicht eine verstärkte Erwärmung. Die Systemtemperatur wird also sowohl vor Überhitzung als auch vor übermäßiger Abkühlung durch den Zeitpunkt des Einsetzens des Regimewechsels reguliert.

Man betrachte das Phänomen „Klimasensitivität“ in diesem System, die die Empfindlichkeit der Oberflächentemperatur auf den Antrieb ist. Der solare Antrieb nimmt ständig zu, wenn die Sonne höher am Himmel steht. Morgens vor dem Einsetzen der Kumuluszirkulation kommt die Sonne durch die klare Atmosphäre und erwärmt die Oberfläche schnell. Daher ist die thermische Reaktion groß und die Klimasensitivität hoch.

Nach dem Einsetzen der Cumulus-Zirkulation wird jedoch ein Großteil des Sonnenlichts zurück in den Weltraum reflektiert. Es bleibt weniger Sonnenlicht übrig, um den Ozean zu erwärmen. Zusätzlich zur reduzierten Sonneneinstrahlung kommt es zu einer verstärkten Verdunstungs-Abkühlung. Im Vergleich zum Morgen ist die Klimasensitivität deutlich geringer.

Wir haben hier also zwei Situationen mit sehr unterschiedlichen Klimasensitivitäten. Am frühen Morgen ist die Klimasensitivität hoch, und die Temperatur steigt mit der zunehmenden Sonneneinstrahlung schnell an. Am späten Vormittag kommt es zu einem Regimewechsel hin zu einer Situation mit viel geringerer Klimaempfindlichkeit. Das Hinzufügen von zusätzlicher Sonnenenergie erhöht die Temperatur nicht mehr annähernd so schnell wie zuvor.

Irgendwann am Nachmittag besteht eine gute Chance, dass das Cumulus-Zirkulationsmuster nicht ausreicht, um den weiteren Anstieg der Oberflächentemperatur zu stoppen. Wenn die Temperatur einen bestimmten höheren Schwellenwert überschreitet, wie im Paneel „Late Afternoon“ gezeigt, findet ein weiterer vollständiger Regimewechsel statt. Dieser beinhaltet die spontane Entstehung von unabhängig voneinander beweglichen Wärmekraftmaschinen, die Gewitter genannt werden.

Gewitter sind Wärmekraftmaschinen mit zwei Brennstoffen. Sie werden mit Luft niedriger Dichte betrieben. Diese Luft steigt auf und kondensiert die Feuchtigkeit aus. Die Kondensation setzt Wärme frei, die die Luft wieder erwärmt, die bis weit nach oben in die Troposphäre aufsteigt.

Es gibt zwei Möglichkeiten, wie die Gewitter die Luft mit niedriger Dichte erhalten. Einer ist die Erwärmung der Luft. So entsteht ein Gewitter als ein von der Sonne angetriebenes Phänomen, das aus mächtigen Kumuluswolken entsteht. Die Sonne und die Treibhausgasstrahlung erwärmen zusammen die Oberfläche, die dann die Luft erwärmt. Die Luft mit geringer Dichte steigt nach oben. Wenn diese Zirkulation stark genug wird, bilden sich Gewitter. Sobald das Gewitter begonnen hat, wird der zweite Treibstoff hinzugefügt – Wasserdampf. Je mehr Wasserdampf sich in der Luft befindet, desto leichter wird sie. Das Gewitter erzeugt starke Winde um seine Basis. Die Verdunstung ist proportional zur Windgeschwindigkeit, so dass die lokale Verdunstung stark zunimmt. Dadurch wird die Luft leichter und steigt schneller auf, wodurch das Gewitter stärker wird, was wiederum die Windgeschwindigkeit um die Gewitterbasis erhöht. Ein Gewitter ist ein regeneratives System, ähnlich wie ein Feuer, bei dem ein Teil der Energie verwendet wird, um einen Blasebalg anzutreiben, damit das Feuer noch heißer brennt. Ist es einmal entfacht, ist es viel schwieriger zu stoppen. Dies verleiht Gewittern eine einzigartige Fähigkeit, die in keinem der Klimamodelle dargestellt ist. Ein Gewitter ist in der Lage, die Oberflächentemperatur weit unter die Auslösetemperatur zu drücken, die nötig war, um das Gewitter in Gang zu setzen. Das Gewitter kann bis in den Abend hinein laufen, oft sogar bis weit in die Nacht hinein, dank der Kombination aus thermischen und Verdunstungs-Energiequellen.

Gewitter fungieren als Wärmeleitbahnen, die warme Luft schnell von der Oberfläche zum Kondensationsniveau transportieren, wo sich die Feuchtigkeit in Wolken und Regen verwandelt, und von dort in die obere Atmosphäre, ohne mit den dazwischenliegenden Treibhausgasen zu interagieren. Die Luft und die in ihr enthaltene Energie werden im Inneren des aufsteigenden Gewitterturms versteckt in die obere Troposphäre transportiert, ohne auf dem Weg dorthin von Treibhausgasen absorbiert oder behindert zu werden. Gewitter kühlen die Oberfläche auch auf eine Vielzahl anderer Arten, indem sie eine Kombination aus einem Standard-Kältekreislauf mit Wasser als Arbeitsmedium plus von oben zurückfließendem kaltem Wasser, klarer Umgebungsluft, die eine größere aufsteigende Oberflächenstrahlung ermöglicht, windgetriebener Verdunstung, Sprühnebel, der die Verdunstungsfläche vergrößert, Albedo-Änderungen und kalter, nach unten gerichteter, mitgerissener Luft nutzen.

Wie beim Einsetzen der Cumulus-Zirkulation tritt das Einsetzen von Gewittern früher an Tagen auf, an denen es wärmer ist, und es tritt später (und manchmal gar nicht) an Tagen auf, die kühler sind als üblich. Auch hier gibt es keine Möglichkeit, eine durchschnittliche Klimasensitivität zuzuordnen. Je wärmer es wird, desto weniger erwärmt jedes zusätzliche Watt pro Meter die Oberfläche.

Sobald die Sonne untergeht, zerfallen zuerst die Kumuluswolken und dann die Gewitter und lösen sich auf. In Paneel 4 zeigt sich ein letztes und wiederum anderes Regime. Das Hauptmerkmal dieses Regimes ist, dass der Ozean während dieser Zeit die allgemeine Menge an Energie abstrahlt, die während aller anderen Teile des Tages absorbiert wurde.

Während der Nacht empfängt die Oberfläche immer noch Energie von den Treibhausgasen [?]. Dies hat den Effekt, dass das Einsetzen der ozeanischen Umwälzung verzögert und die Abkühlungsrate verringert wird. Man beachte, dass die ozeanische Umwälzung wieder die entstehende Rayleigh-Bénard-Zirkulation ist. Da es weniger Wolken gibt, kann der Ozean freier in den Weltraum abstrahlen. Darüber hinaus bringt die Umwälzung des Ozeans ständig neues Wasser an die Oberfläche, das abstrahlt und abkühlt. Dies erhöht den Wärmeübergang über die Grenzfläche. Wie bei den vorherigen Schwellenwerten ist der Zeitpunkt dieses endgültigen Übergangs temperaturabhängig. Sobald ein kritischer Schwellenwert überschritten ist, setzt die ozeanische Umwälzung ein. Die Schichtung wird durch Zirkulation ersetzt, die neues Wasser zum Abstrahlen, Abkühlen und Absinken bringt. Auf diese Weise wird Wärme abgeführt, nicht nur von der Oberfläche wie tagsüber, sondern vom gesamten Körper der oberen Schicht des Ozeans.

Prognosen

Eine Theorie ist nur so gut wie ihre Prognosen. Aus den obigen theoretischen Überlegungen können wir Folgendes vorhersagen:

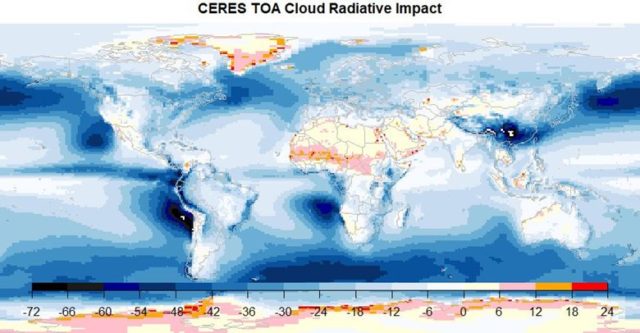

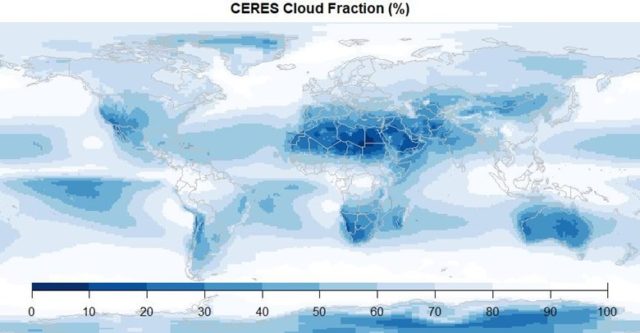

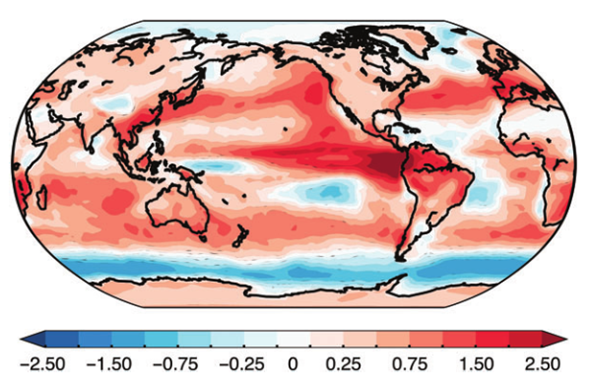

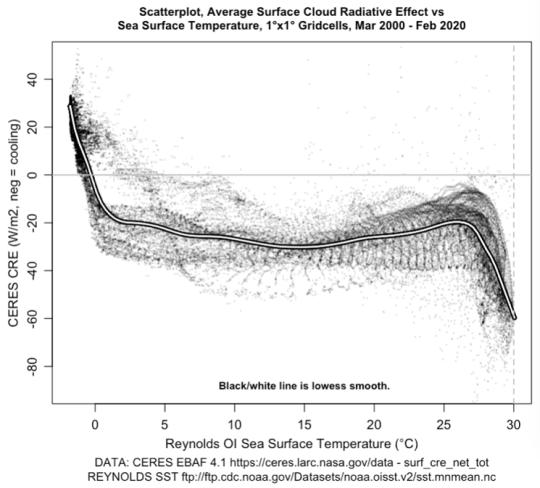

Prognose 1: In warmen Gebieten des Ozeans wirken Wolken kühlend auf die Oberfläche, in kalten Gebieten wirken sie wärmend auf die Oberfläche. Dies wird oberhalb einer Temperaturschwelle bei den wärmsten Temperaturen am stärksten ausgeprägt sein.

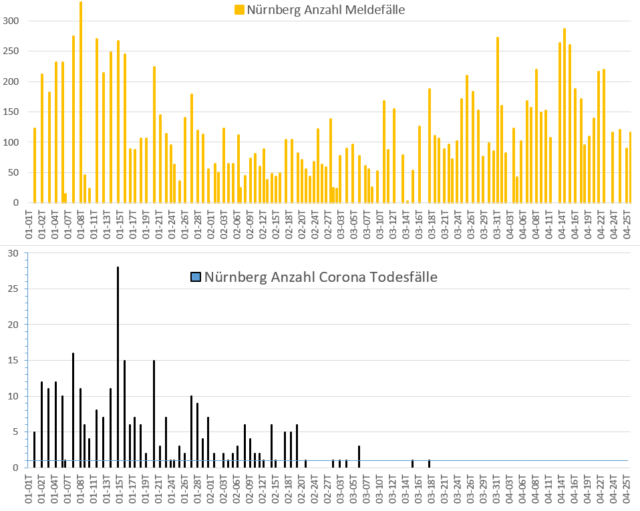

Beweise, die die erste Prognose bestätigen:

Wie prognostiziert, erwärmen die Wolken die Oberfläche, wenn sie kalt ist, und kühlen sie, wenn sie warm ist, wobei der Effekt oberhalb von etwa 26°C – 27°C sehr ausgeprägt ist.

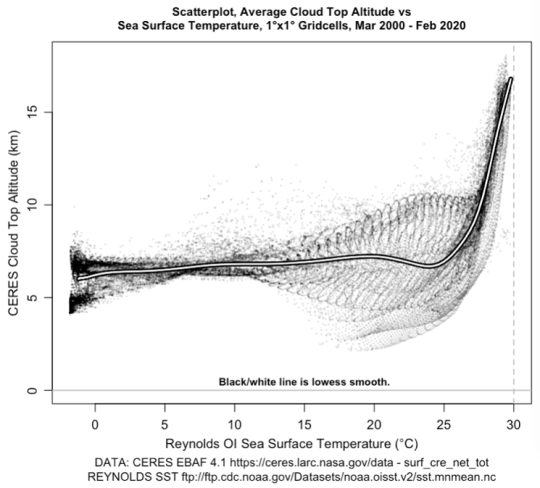

Prognose 2: Im tropischen Ozean, wiederum oberhalb einer bestimmten Temperaturschwelle, werden Gewitter mit steigender Temperatur sehr schnell zunehmen.

Beweise, die die zweite Prognose bestätigen:

Da es immer viel Wasser über dem tropischen Ozean gibt und viel Sonnenschein, um sie anzutreiben, werden thermisch angetriebene tropische Gewitter eine Funktion von wenig mehr als der Temperatur sein.

Wie bei Wolken im Allgemeinen gibt es eine klare Temperaturschwelle bei etwa 26°C – 27°C, mit einem fast vertikalen Anstieg der Gewitter oberhalb dieser Schwelle. Dies setzt dem Temperaturanstieg eine sehr starke Grenze.

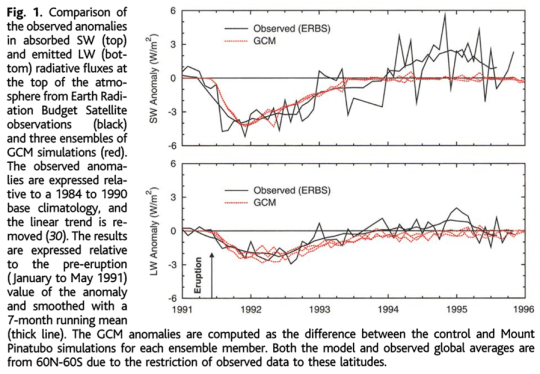

Prognose 3:. Vorübergehende Abnahmen des solaren Antriebs, wie z.B. durch Eruptionen, werden durch eine erhöhte Sonneneinstrahlung infolge einer verspäteten und selteneren Bildung tropischer Gewitter kompensiert. Das bedeutet, dass nach einer anfänglichen Abnahme die eingehende Sonneneinstrahlung über den Ausgangswert vor der Eruption steigt, bis der Status quo ante wiederhergestellt ist.

Belege zur Validierung der dritten Prognose

Was die dritte Prognose betrifft, so löst meine Theorie das folgende Pinatubo-Rätsel von Soden et al.5:

„Ab 1994 werden zusätzliche Anomalien in den Satellitenbeobachtungen der von der Atmosphäre absorbierten Sonnenstrahlung deutlich, die nichts mit dem Ausbruch des Mount Pinatubo zu tun haben und daher in den Modellsimulationen nicht reproduziert werden. Es wird angenommen, dass diese Anomalien von dekadischen Veränderungen in der tropischen Zirkulation Mitte bis Ende der 1990er Jahre herrühren [siehe J. Chenet al., Science 295, 838 (2002); und B.A. Wielicki et al., Science 295, 841 (2002)], aber ihr Wahrheitsgehalt bleibt Gegenstand von Debatten. Wenn sie real sind, impliziert ihr Fehlen in den Modellsimulationen, dass Diskrepanzen zwischen den beobachteten und den modellsimulierten Temperaturanomalien, die durch die thermische Trägheit des Klimasystems um 1 bis 2 Jahre verzögert werden, bis Mitte der 1990er Jahre auftreten könnten.“

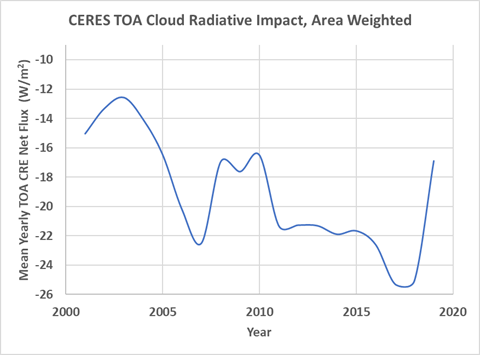

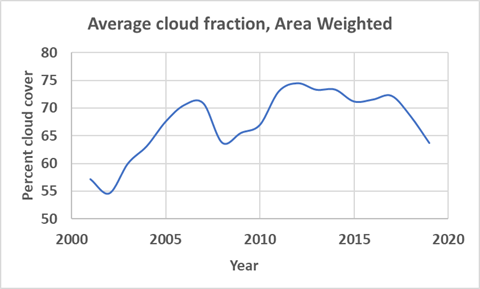

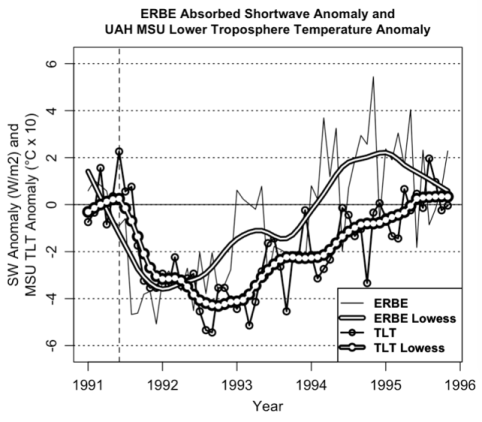

Dies ist jedoch ein vorhersehbares Ergebnis der emergenten Thermostat-Theorie. Hier ist die Änderung der unteren atmosphärischen Temperatur zusammen mit den ERBS-Daten von Soden:

Wie von der Theorie vorhergesagt, steigt die absorbierte Sonnenenergie über die Basislinie, bis die Temperatur der unteren Troposphäre zu ihrem Wert vor dem Ausbruch zurückkehrt. An diesem Punkt hört die erhöhte Aufnahme von Sonnenenergie auf und das System befindet sich wieder in seinem stationären Zustand.

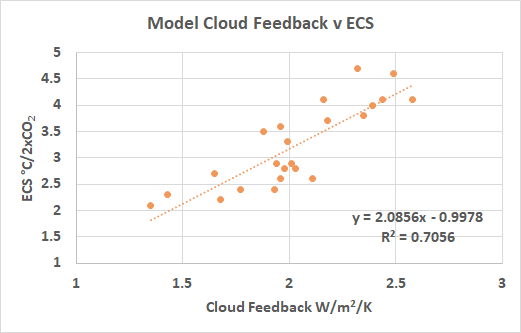

Prognose 4: Die „Klimasensitivität“ ist bei weitem keine Konstante, sondern wird sich als eine Funktion der Temperatur herausstellen.

Beweise, die die vierte Prognose bestätigen.

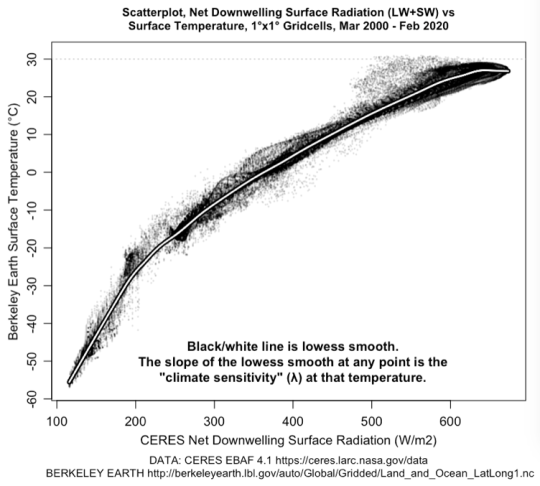

Die folgende Abbildung 6 zeigt die Beziehung zwischen der Nettoabwärtsstrahlung an der Oberfläche und der Oberflächentemperatur in einem Raster von 1° Breitengrad und 1° Längengrad für jede Zelle:

Die enge Korrelation zwischen der Oberflächentemperatur und der abwärts gerichteten Strahlung bestätigt, dass es sich um eine gültige Langzeitbeziehung handelt. Dies gilt insbesondere, wenn man bedenkt, dass die beiden betrachteten Variablen aus völlig unterschiedlichen und nicht miteinander verbundenen Datensätzen stammen.

Man beachte, dass die „Klimasensitivität“ tatsächlich eine Funktion der Temperatur ist, und dass die Klimasensitivität bei den höchsten Temperaturen negativ wird. Es ist auch erwähnenswert, dass fast nirgendwo auf dem Planeten die langfristige Durchschnittstemperatur über 30°C liegt. Dies ist ein weiterer Beweis für die Existenz starker thermo-regulatorischer Mechanismen, die die durchschnittliche Erwärmung der Oberfläche effektiv begrenzen.

Prognose 5: In einigen Gebieten wird die Temperatur nicht durch die abwärts gerichtete Oberflächenstrahlung gesteuert, sondern die Oberflächenstrahlung wird durch die Temperatur gesteuert.

Beweise zur Bestätigung der fünften Prognose

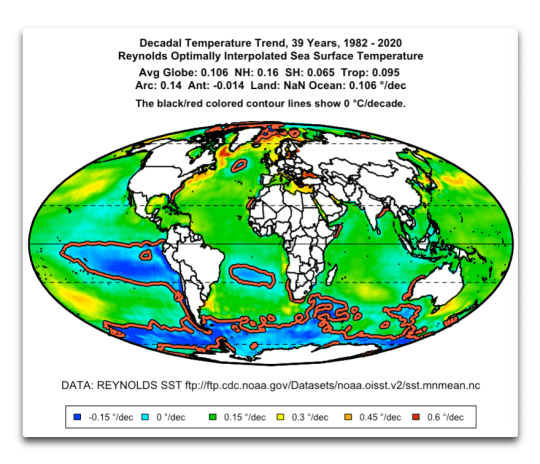

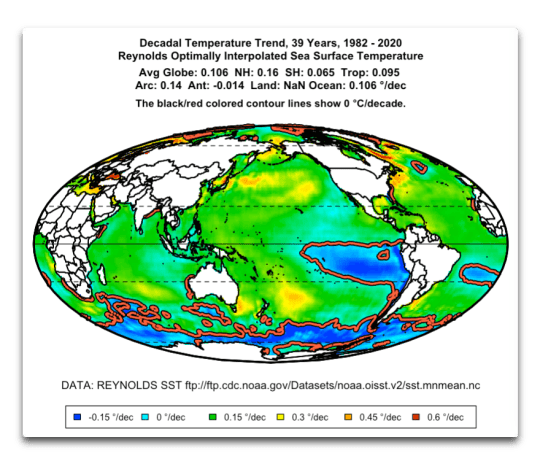

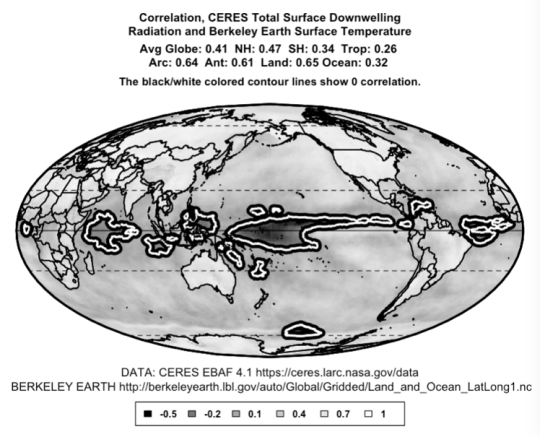

Abbildung 7 unten zeigt die Korrelation zwischen der abwärts gerichteten Oberflächenstrahlung (kurzwellige plus langwellige Strahlung) und der Oberflächentemperatur. Wie erwartet, ist die Korrelation über den meisten Landmassen positiv – wenn die Einstrahlung zunimmt, steigt auch die Oberflächentemperatur.

Über weite Bereiche des tropischen Ozeans sind die Temperatur und die Einstrahlung jedoch negativ korreliert. Da eine abnehmende Einstrahlung die Oberflächentemperatur nicht erhöhen kann, ist die einzig mögliche Schlussfolgerung, dass in diesen Gebieten die steigende Temperatur die Anzahl und Art der darüber liegenden Wolken so verändert, dass die Einstrahlung abnimmt.

CONCLUSIONS

1) Das derzeitige Klimaparadigma, das besagt, dass Änderungen der globalen Oberflächentemperatur langfristig eine einfache lineare Funktion von Änderungen des Antriebs (Einstrahlung) sind, ist falsch. Dies zeigt sich an der Unfähigkeit der Forscher, die Unsicherheit des zentralen Wertes des Paradigmas, also der „Klimasensitivität“, einzugrenzen, trotz vierzigjähriger Untersuchungen, Millionen von Dollar, Milliarden von Computerzyklen und Millionen von Arbeitsstunden, die bzgl. dieses Problems aufgewendet worden waren. Es wird auch durch die obigen Grafiken demonstriert, die zeigen, dass die „Klimasensitivität“ keineswegs eine Konstante ist, sondern eine Funktion der Temperatur.

2) Ein höchst merkwürdiger Aspekt des Klimasystems ist seine erstaunliche Stabilität. Trotz der Unterstützung einer Temperatur, die um Dutzende Grad über der des Mondes liegt, durch nichts stabiler als evaneszenten Wolken, trotz Vulkanausbrüchen, trotz Änderungen in CO2 und anderer GHG-Antriebe, trotz großer Schwankungen in Aerosolen und schwarzen Kohlenstoff variierte die Temperatur über das 20. Jahrhundert um nur ±0,2%.

3) Diese erstaunliche Stabilität impliziert und erfordert in der Tat die Existenz eines sehr starken Thermo-Regulationssystems.

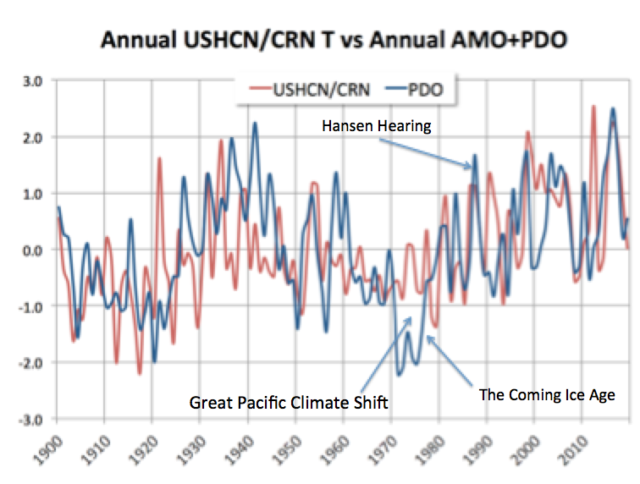

4) Meine Theorie ist, dass die Thermoregulation durch eine Vielzahl von interagierenden emergenten Phänomenen bereitgestellt wird. Dazu gehören die Rayleigh-Benard-Zirkulation des Ozeans und der Atmosphäre, Staubteufelchen, tropische, thermisch angetriebene Kumuluswolkenfelder, Gewitter, Sturmböen, Wirbelstürme, Tornados, die La-Nina-Pumpe, die tropisches warmes Wasser zu den Polen bewegt und kühles darunter liegendes Wasser freilegt, und die großen Veränderungen in der Ozeanzirkulation, die mit der pazifischen dekadischen Oszillation, der nordatlantischen Oszillation und anderen ozeanischen Zyklen einhergehen.

5) Dies impliziert, dass es unwahrscheinlich ist, dass die Temperaturen aufgrund von CO2-Variationen, Vulkanen oder anderen sich ändernden Einflüssen stark von ihrem derzeitigen Zustand abweichen. Die Schwellenwerte für die verschiedenen Phänomene sind temperaturbasiert, nicht antriebsbasiert. Daher werden Variationen des Forcings sie nicht stark beeinflussen. Es stellt sich jedoch auch eine neue Frage: Was verursacht eine langsame thermische Drift in thermoregulierten Systemen?

REFERENCES

1 Knutti, R., Rugenstein, M. & Hegerl, G. Beyond equilibrium climate sensitivity. Nature Geosci 10, 727–736 (2017). https://doi.org/10.1038/ngeo3017

2 Lewes, G. H. (1874) in Emergence, Dictionnaire de la langue philosophique, Foulquié.

3 Reis, A. H., Bejan, A, Constructal theory of global circulation and climate, International Journal of Heat and Mass Transfer, Volume 49, Issues 11–12, 2006, Pages 1857-1875, https://doi.org/10.1016

4 Bejan, A, Reis, A. Heitor, Thermodynamic optimization of global circulation and climate, International Journal of Energy Research, Vol. 29, Is. 4, https://doi.org/10.1002/er.1058

5 Brian J. Soden et al., Global Cooling After the Eruption of Mount Pinatubo: A Test of Climate Feedback by Water Vapor,Science 26 Apr 2002, Vol. 296, Issue 5568, pp. 727-730, DOI: 10.1126/science.296.5568.727

Anyhow, that’s what I have to date. There are few references, because AFAIK nobody else is considering the idea that emergent phenomena act as a global thermostat. Anyone who knows of other references that might be relevant, please mention them.

Finally, any suggestions as to which journal might be willing to publish such a heretical view of climate science would be much appreciated.

Link: https://wattsupwiththat.com/2021/04/28/a-request-for-real-peer-review/

Übersetzt von Chris Frey EIKE