Leider gibt es noch kein Video vom Landtag; und der Life-Stream ist nur für angemeldete Bürger sichtbar.

Daher hier der Text der Stellungnahmen.

Prof. Horst Lüdecke:

Gutachterliche Stellungnahme zum Gesetzentwurf der Landesregierung Klimaanpassungsgesetz

Nordrhein-Westfalen (KIAnG)

Zusammenfassung und Stellungnahme

Der Gesetzentwurf des Klimaanpassungesetzes (im Folgenden KlAnG) bezieht sich auf die stets notwendige und vernünftige Aktivität der zivilisierten Menschheit, sich vor schädlichen Folgen des Klimawandels (es gibt genauso viele positive Folgen) durch möglichst frühzeitig durchgeführte Maßnahmen zu schützen.

Diese Bestrebungen gibt es vermutlich, seit die Menschheit existiert. Heute sind sie infolge

der immer größeren Verwundbarkeit moderner Zivilisationen gegen Wetter- und Klima-Unbilden

dringender denn je geworden. Musterbeispiel dafür sind die Holländer mit ihren Deichsystemen, die

seit jeher gemäß der sich ändernden Überschwemmungsbedrohung verstärkt und angepasst wurden.

Daher wird diesem Gesetzentwurf hier prinzipiell zugestimmt. Aus Platzgründen wird auf das Eingehen

auf Einzelheiten verzichtet, weil fast unzählige Aktionsfelder beteiligt sind, stellvertretend seien nur

die landwirtschaftliche Wasserversorgung und der Hochwasserschutz in von Fluss-Überschwemmungen

gefährdeten Wohngebieten genannt.

Leider enthält der KIAnG aber sachliche Fehler, die seine Absicht und Wirkung zwar nicht maßgebend

berühren, aber dennoch korrigiert werden sollten. Der KlAnG enthält zudem auch einen gefährlichen

Mangel, auf den hier hingewiesen wird und der in einer Korrektur des Entwurfs zu berücksichtigen ist.

Zum Zweck der Platzersparnis wird in den folgenden Anmerkungen neben weiteren Quellen auch die

ausführliche Stellungnahme des Autors zur Neufassung des Klimaschutzgesetz referenziert, am Vormittag des 10.05.2021 in einer Expertenbefragung der NWR-Landesregierung behandelt. Diese Stellungnahme ist nachfolgend als NeuKL abgekürzt.

Sachliche Fehler des KlAnG:

KIAnG, Seite 2, I, 13.2:

Dort heißt es „Klimaschutz und Klimaanpassung vor Ort stärken“. Klimaschutz ist aber ein völlig sinnloser

Begriff (s. NeuKL), denn Klima – ein statistisches Mittel über mindestens 30 Jahre – kann man

nicht schützen. Zudem hat „Klimaschutz“ nicht das Geringste mit „Anpassung an Klimawandel“ zu tun

und gehört daher nicht in den Gesetzentwurf.

KIAnG, Seite 5, §1:

Hier steht „…Damit sollen die negativen Auswirkungen des Klimawandels begrenzt…“. Das ist in dieser

Formulierung falsch, denn Klimawandel hat oft genug auch ebenso viele positive Auswirkungen gehabt,

s. Grönland = Grünland, die mittelalterliche Warmzeit usw. Auch der jüngste Klimawandel hat

natürlich auch positive Auswirkungen, so sind durch die Erwärmung früher nicht geeignete Gebiete im

höheren Norden (Sibirien) jetzt zu landwirtschaftlichen Nutzflächen geworden. Es muss daher an Stelle

von „die negativen Auswirkungen“ korrekt „negative Auswirkungen“ heißen. Die gleiche Korrektur ist

auf Seite 5, §3, (1), Seite 6, §4 (5) und allen weiteren Stellen mit der Formulierung „die negativen Auswirkungen“ vorzunehmen.

KIAnG, Seite 9, Begründung, A Allgemeiner Teil, erster Satz:

Wieder heißt es „Schutz des Klimas“, der folgende Satz ist aber noch größerer sachlicher Unsinn. Es ist

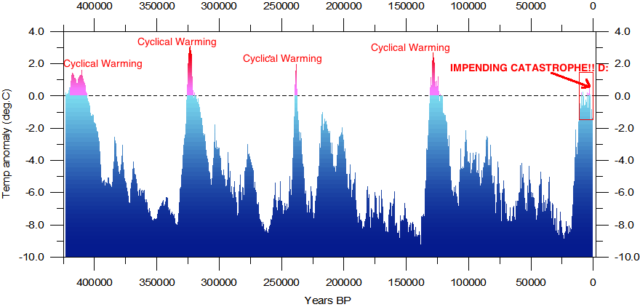

leider nicht ausgemacht, dass auf Jahrhunderte bis Jahrtausende die günstige heutige Erwärmung bestehen bleibt wie im Text behauptet. Mit den Erkenntnissen der Klimawissenschaft sind die entsprechenden Aussagen vom IPCC(?) – dem Autor unbekannt, selbst das IPCC schreibt seines Wissens solch einen Unsinn nicht – jedenfalls nicht vereinbar. Jeder Klimaforscher bestätigt, dass eine neue Eiszeit vor der Tür steht, sie ist angesichts der großen Länge des warmen Holozän (ca. 9000 Jahre) bereits überfällig. Wenn die Menschheit noch ein paar 100 Jahre oder gar 1000 Jahre von der nächsten Eiszeit

verschont bleibt, wäre dies ein ausgesprochener Glücksfall. Alle weiteren Phantastereien im Text, bei

denen man sich insbesondere bei fragwürdigen Aussagen des Potsdamer Institut für Klimafolgenforschung

(PIK) bedient hat, mögen Unterhaltungswert aufweisen, als Begründung für das sehr sinnvolle

Klimaanpassungsgesetz wirken sie aber eher lächerlich und sollten besser gestrichen werden.

KIAnG, Seite. 9, B, Zu Absatz 2:

Zum 2-Grad Ziel (inzwischen sind es sogar 1,5 Grad geworden!) erlaubt sich der Autor ohne weiteren

Kommentar den bekannten Klimaforscher Prof. Dr. Heinz Miller, ehemaligen Direktor des Alfred-Wegener-

Instituts in Bremerhaven zu zitieren

„Wer von Klimaschutz redet, weckt Illusionen. Klima lässt sich nicht schützen und auf einer Wunschtemperatur stabilisieren. Es hat sich auch ohne Einwirkungen des Menschen oft drastisch verändert. Schlagworte wie „Klimakollaps“ oder „Klimakatastrophe“ sind irreführend. Klima kann nicht kollabieren, die Natur kennt keine Katastrophen“

Gefährlicher Mangel des KlAnG:

KIAnG, Seite 2, I:

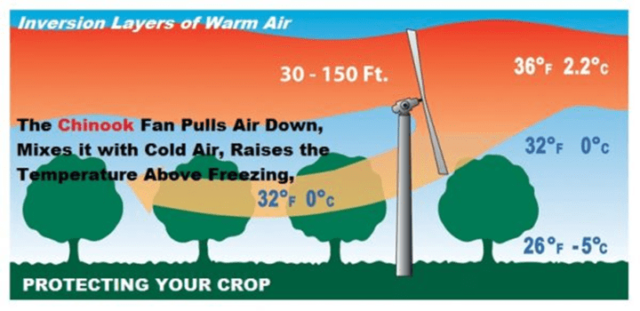

In der hier vorgenommenen Aufzählung im Text fehlt der wohl wichtigste Punkt, der sogar zuerst genannt werden sollte. Dieser Punkt ist auch im folgenden Text des KIAnG nirgendwo explizit erwähnt. Klimawandel kann (muss aber nicht) bedeuten, dass Extremwetter wie Stürme, Starkregen etc. zunehmen. So zeichnete sich insbesondere die „kleine Eiszeit“ als Kälteperiode von ca. 1450 bis 1850 durch solche Extremwetterzunahmen aus. Sämtliche noch erhaltenen Hochwasserpegel an Europas Flüssen belegen dies [3]. Glücklicherweise waren Extremwetterzunahmen in unserer jüngsten Erwärmungsphase bislang nicht zu beobachten [4]. Extremwetter sind insbesondere für eine zuverlässige Stromversorgung gefährlich. Diese Zuverlässigkeit ist aber im heutigen Deutschland auf Grund des zunehmenden Windrad- und Photovoltaikausbaus mit fluktuierender und im Extremfall völlig fehlender Leistungsabgabe der Anlagen nicht mehr gegeben [5] (Photovoltaik nachts oder bei Wolkenbedeckung, Windräder bei Flaute).

Der Autor empfiehlt daher dringend, den Punkt „gegen Extremwetter resiliente Stromversorgung“ in das KIAnG explizit und betont mit aufzunehmen. Dazu gehört beispielsweise als wohl wichtigste Anpassungsmaßnahme, ausreichend viele grundlastfähige Kohlekraftwerke weiter in Betrieb zu belassen. Auf die Gefahren eines längerfristigen Blackouts wurde bereits an vielen Stellen hingewiesen, auch von der Bundesregierung [6]. Es wird zudem empfohlen, auch auf „S. 6, §4 unter 1., Sonstige Maßnahmen“ eine ertüchtigte und sichere Stromversorgung als robuste und gegen jede Wetter- und Klimaunbilden resiliente Stromversorgung explizit als Anpassungsmaßnahme zu nennen.

Zum Autor

Jahrgang 1943, Studium und Promotion in Physik, kernphysikalische Forschung, chemische Industrie (BASF), Professur an der HTW des Saarlandes (Physik, Informatik, OR), seit 2008 em. im Altersruhe-stand.

Verfasser eines Fachbuchs und drei Sachbüchern, Erstautor und Mitautor in 10 begutachteten Klima-fachpublikationen in Fachjournalen wie Climate of the Past der Europäischen Geophysikalischen Union oder Hydrology: regional studies (Elsevier) und weiteren, s. hierzu https://www.horstjoachimlue-decke.de/ unter „Publikationen“. Seit jüngerer Zeit anonymer Peer Reviewer bei zwei begutachteten Klimafachjournalen.

3 Historische Hochwassermarken, http://real-planet.eu/hochwasser.htm

4 IPCC, 2013. Climate Change 2013: The Physical Science Basis. Contribution of Working Group I to the Fifth Assessment Re-port of the Intergovernmental Panel on Climate Change. Cambridge and New York: Cambridge University Press. AR5, WG1, Technical summary, TS.6.3, S. 114.

5 H.-J. Lüdecke: Energie und Klima, Kapitel 3.4, expert Verlag 2020.

6 Deutscher Bundestag, Drucksache 17/5672. https://dip21.bundestag.de/dip21/btd/17/056/1705672.pdf

Dr. habil. Sebastian Lüning:

Stellungnahme zur Sachverständigen-Anhörung des Ausschusses für Wirtschaft, Energie und Landesplanung am 10. Mai 2021, Gesetzesentwurf der Landesregierung, Drucksachen 17/12976 und 17/12977, Landtag Nordrhein-Westfalen, Düsseldorf

Im Pariser Klimaabkommen von 2015 haben sich die Staaten der Erde darauf geeinigt, alles dafür zu tun, die Klimaerwärmung auf 2°C über dem Mittelwert von 1850-1900 zu begrenzen, und sogar eine Schwelle von 1,5°C nicht zu überschreiten. Auch Nordrhein-Westfalen muss hier seinen Beitrag leisten, was ein effektives Klimaschutzgesetz und gemeinsame Anstrengungen erfordert. Umso wichtiger ist ein robustes fachliches Fundament, auf dem die Klimaschutzmaßnahmen fußen. Leider enthält der Gesetzentwurf KlAnG und die damit verbundene Drucksache 17/12977 klimawissenschaftliche Mängel, die vor einer Verabschiedung des Gesetzes auf jeden Fall behoben werden sollten, um die Grundlage der gesellschaftlichen Bemühungen zu stärken.

Abschnitt „A Problem“ (Seite 1, Drucksache 17/12977)

Im Entwurf heißt es: „Stattdessen besteht die Notwendigkeit, den bereits heute spürbaren Symptomen wie u.a. häufigeren Dürephasen und Hitzewellen oder Extremwetterereigissen wie Starkregen stärker vorzubeugen,…“.

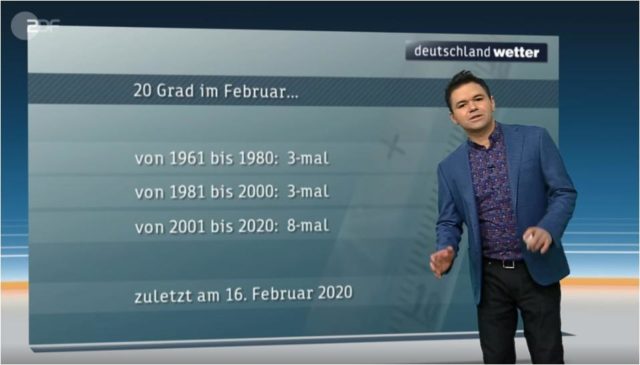

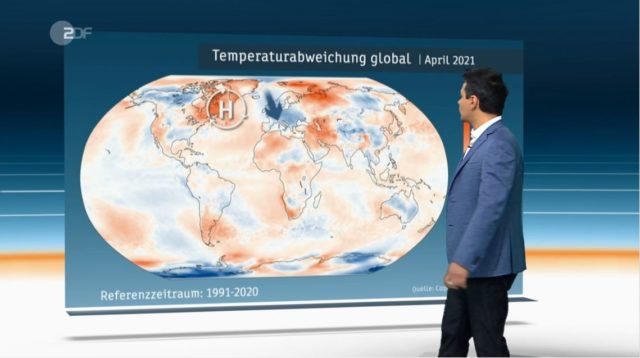

Aus dem Kontext ist zu verstehen, dass es sich hier um das Gebiet Deutschlands handeln muss. Während Hitzwellen in der Tat im Zuge der Klimaerwärmung der letzten 150 Jahre häufiger geworden sind, trift dies nicht auf Dürrephasen, Starkregen oder viele andere Extremwetterereignisse zu. Insofern ist die Aussage im Gesetzesentwurf klimawissenschaftlich nicht korrekt.

Dürrephasen

In Deutschland gibt es keinen statistisch gesicherten Trend in der Häufigkeitsentwicklung von Trockenperioden, stellte das Umweltbundesamt (UBA) in seinem ‚Monitoringbericht 2015 zur Deutschen Anpassungsstrategie an den Klimawandel‘ fest.(Umweltbundesamt, 2015) Allerdings seien ausgeprägte natürliche Schwankungen mit abwechselnden Phasen stärker und geringer ausgeprägter Trockenheit festzustellen (Umweltbundesamt, 2015). In Österreich sind die Sommer in den letzten 55 Jahren etwas feuchter geworden (ZAMG, 2020). Stellt man die Dürregeschichte des Alpenraums der letzten Jahrzehnte in den Kontext der letzten Jahrhunderte, so ist auch hier kein Langzeittrend zu erkennen (Haslinger et al., 2016). Zu den drei trockensten Sommern der letzten 500 Jahre zählen in den Alpen neben 2003 auch die Jahre 1921 und 1540 (Casty et al., 2005).

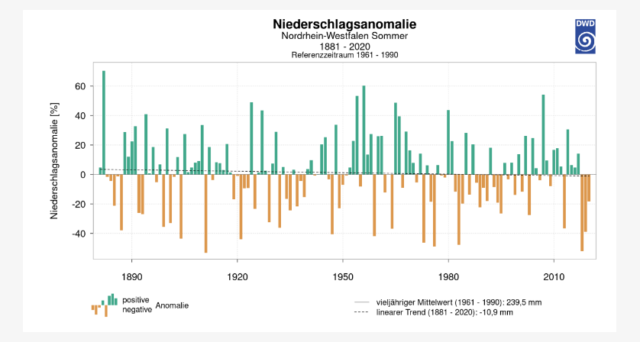

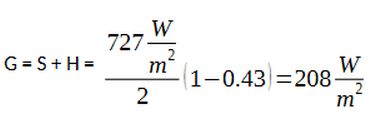

Zwar gab es zwischen 2013 und 2019 in Deutschland eine Häufung von Dürren. Aus der Sommer-Niederschlags-Statistik des Deutschen Wetterdienstes für die letzten 140 Jahre geht aber auch hervor, dass es bereits in der Vergangenheit immer wieder Serien von Dürresommern gegeben hat, zum Beispiel in den 1920er und 1980er Jahren (Abbildung 1). Langfristig hat sich die Regenmenge im Sommer in Deutschland leicht verringert.

Abb. 1: Sommerniederschläge in NRW während der letzten 140 Jahre. Quelle: DWD.

Eine kürzliche Studie auf Basis von Sauerstoff- und Kohlenstoff-Isotopen in Baumringen glaubte, dass die kürzlichen Dürren bereits den Bereich der natürlichen Schwankungsbreite der letzten 2000 Jahre verlassen hätte (Büntgen et al., 2021). Eine kurz darauf erschienene andere Studie eines breiter aufgestellten Datensatzes konnte dies jedoch nicht bestätigen. In der Studie des Alfred-Wegener-Instituts (AWI) kamen neben Dicke-Messungen von Baumringen auch historische Aufzeichnungen zu Wasserständen in Flüssen sowie meteorologische Messdaten zum Einsatz (Ionita et al., 2021). Laut AWI bewegten sich die Dürresommer der letzten Jahre noch vollständig innerhalb der Grenzen der natürlichen Klima-Variabilität. Ähnlich extreme Dürreperioden gab es mehrfach auch in der vorindustriellen Vergangenheit. Die ausgeprägtesten Dürren in Mitteleuropa ereigneten sich von 1400 bis 1480 sowie 1770 bis 1840 zu Zeiten einer reduzierter Sonnenaktivität.

Auch eine kürziche Studie zur Dürre-Historie Westeuropas für die vergangenen 170 Jahre anhand von Wetter-Stations-Daten konnte keinen statistisch signifikanten Langzeit-Trend bei den Dürren ausmachen, dafür aber starke Schwankungen (Vicente-Serrano et al., 2021).

Starkregen und Überschwemmungen

Seit 1951 hat sich die Häufigkeit von Starkniederschlag in Deutschland von mehr als 30 mm nur geringfügig erhöht (DWD, 2014). Die Veränderung ist aus statistischer Sicht jedoch insignifikant, so dass kein belastbarer Langzeittrend ausgemacht werden kann. Die Zeitreihe moderner Radardaten zum Starkregen ist leider noch zu kurz, um aussagekräftige Trends interpretieren zu können (DWD, 2016). Auch das Umweltbundesamt konnte in seinem Monitoringbericht 2015 zum Klimawandel keine belastbaren Trends zu Starkniederschlägen in Deutschland finden (Umweltbundesamt, 2015). Die Zahl der Tage mit einer Niederschlagssumme von 20 mm und mehr im Sommer ist seit 1951 nahezu unverändert geblieben. Im Winter ist der entsprechende Index (Flächenmittel der maximalen 5-Tagessumme der Niederschläge) zwar leicht angestiegen, wobei der Anstieg aufgrund der starken Variabilität von Jahr zu Jahr statistisch nicht signifikant ist.

Klimarekonstruktionen dokumentieren eine hohe natürliche Variabilität der Hochwasserhäufigkeit in Deutschland während der vergangenen Jahrhunderte. Studien zeigen, dass Hochwasser in Mitteleuropa in den vergangenen 500 Jahren nicht häufiger geworden ist (Der Spiegel, 2013; Schmocker-Fackel and Naef, 2010). Dasselbe gilt auch für Gesamteuropa und die letzten 50 Jahre (Blöschl et al., 2017). Auf der 7. Deutschen Klimatagung im Oktober 2006 stellten Manfred Mudelsee und Gerd Tetzlaff Studienergebnisse vor, die auch für Deutschland keine Zunahme der Hochwasserereignisse sahen (Mudelsee and Tetzlaff, 2006). Weil immer mehr Menschen an die Ufer zogen, stiegen aber die Schäden durch Hochwasser. Zieht man diesen Wertzuwachs-Effekt ab, zeigt sich Berechnungen zufolge keine ungewöhnliche Zunahme in den vergangenen Jahrzehnten (Barredo, 2009; Paprotny et al., 2018; TU Delft, 2018).

Abschnitt „§ 9 Monitoring“ (Seite 8, Drucksache 17/12977)

Ein fortlaufendes wissenschaftliches Monitoring is ausdrücklich zu begrüßen. Dies sollte auf jeden Fall auch die klimawissenschaftlichen Trends beinhalten. Neben einer gewissenhaften Auswertung der Messdaten der letzten 150 Jahren ist auch eine verstärkte Auseinandersetzung mit der vorindustriellen Klimaentwicklung Nordrhein-Westfalens für die vergangenen Jahrtausende notwendig. Denn diese vorindustriellen Klimaschwankungen der letzten zwei bis zehn Millennia bilden den eigentlichen vorindustriellen Kontext der natürlichen Klimaentwicklung, stellen also das natürliche Basisniveau („baseline“) dar, gegen das die heutigen Entwicklungen verglichen werden müssen. Der IPCC ist sich sehr wohl darüber bewusst, dass das derzeit verwendete „vorindustrielle“ Vergleichsniveau 1850-1900 am Ende der Kleinen Eiszeit im Vergleich zur Gesamtheit der letzten Jahrtausende deutlich zu kalt ist (Lüning, 2021; Lüning and Vahrenholt, 2017). In den folgenden zwei Absätzen wird die klimahistorische Entwicklung NRWs und Mitteleuropas kutz zusammengefasst, als das 1,5-Grad-Ziel bereits mehrfach auf natürliche Weise zumindest lokal überschritten wurde.

Temperaturentwicklung der letzten 1000 Jahre

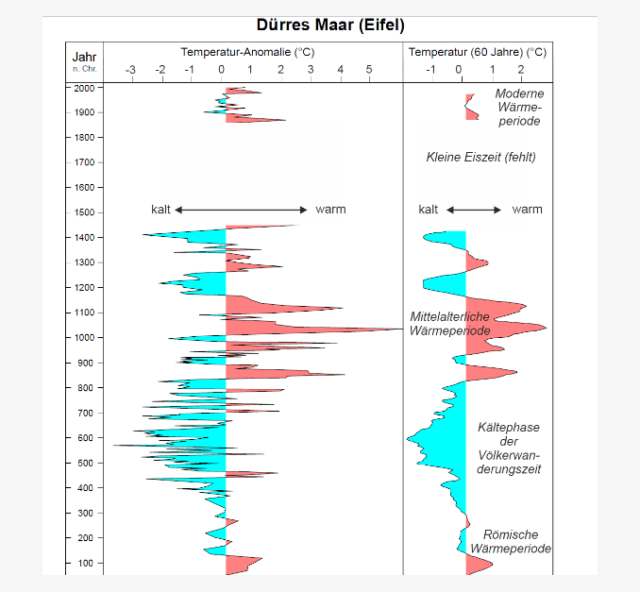

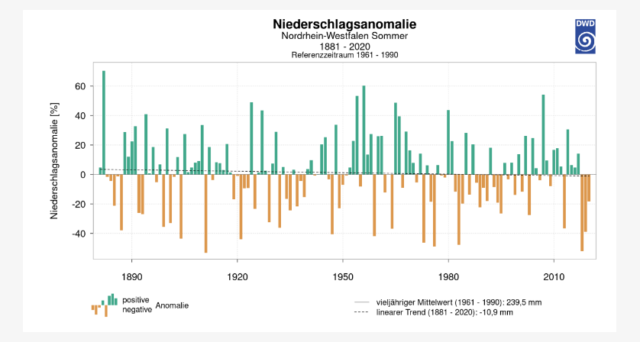

Die Moderne Wärmephase ist nicht die einzige Erwärmungsperiode in der nacheiszeitlichen Klimageschichte. Bereits im Mittelalter vor 1000 Jahren ereignete sich eine Warmphase, die besonders gut aus dem nordatlantischen Raum bekannt ist, aber auch in vielen Regionen der restlichen Welt ausgeprägt war, z.B. in Afrika (Lüning et al., 2017), Antarktis (Lüning et al., 2019b), Südamerika (Lüning et al., 2019a) und Ozeanien (Lüning et al., 2020). So wurde die Mittelalterliche Wärmeperiode (MWP) bzw. Mittelalterliche Klimaanomalie (MCA) auch aus dem NRW-Nachbarland Rheinland-Pfalz (RP) beschrieben. Moschen et al. (2011) rekonstruierten die Temperaturgeschichte anhand von Kohlenstoffisotopen in einem Torfkern aus dem Dürren Maar. Dabei fanden sie eine Erwärmung von mehr als 5°C im Übergang der Kälteperiode der Völkerwanderungszeit (500-700 n. Chr.) zur MWP (Abbildung 2). In diesem Zusammenhang traten offenbar starke Erwärmungsschübe auf, bei denen die Temperaturen auf natürliche Weise innerhalb weniger Jahrzehnte um mehrere Grad nach oben schnellten. Insofern scheint weder das heutige Temperaturniveau, noch die heutige Erwärmungsrate im Raum NRW-RP im historischen Kontext beispiellos zu sein.

Abb. 2: Temperaturentwicklung des Dürren Maar (Eifel) während der letzten 2000 Jahre basierend auf einer Temperaturrekonstruktion anhand von Zellulose-Kohlenstoffisotopen eines Torfkerns. Nullpunkt der Temperatur-Anomalieskala liegt etwas über dem Temperaturdurschnitt der letzten 2000 Jahre (Kleine Eiszeit fehlt). Linke Kurve: Ungeglättete Daten. Rechte Kurve: Gleitender Mittelwert über 60 Jahre. Daten digitalisiert von Moschen et al. (2011).

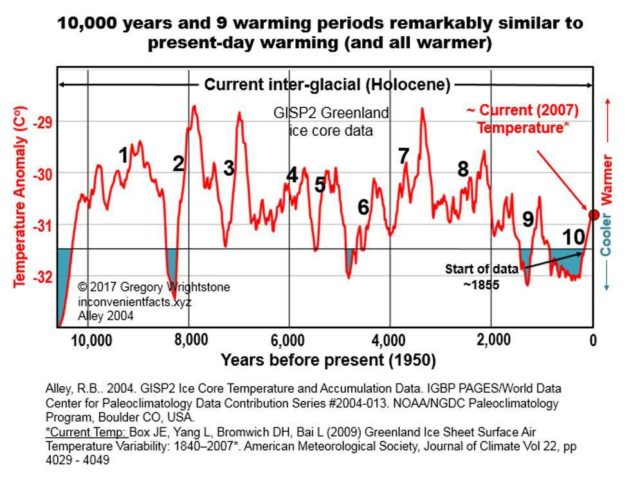

Temperaturentwicklung der letzten 10.000 Jahre

Erweitert man den Referenzzeitraum auf die letzten 10.000 Jahre, so wird klar, dass es eine ganze Reihe von Warm- und Kältephasen in vorindustrieller Zeit gegeben hat. In der Wissenschaft wird hier von klimatischen Millenniumszyklen gesprochen, da sich die Änderungen im Takt von 1000-2000 Jahren ereigneten. Die Zyklen sind aus allen Erdteilen beschrieben worden (Lüning and Vahrenholt, 2016) und könnten zumindest einen Teil ihres Antrieb aus der schwankenden Sonnenaktivität beziehen (Bond et al., 2001). Andere Forscher nehmen einen klimasysteminternen Puls an.

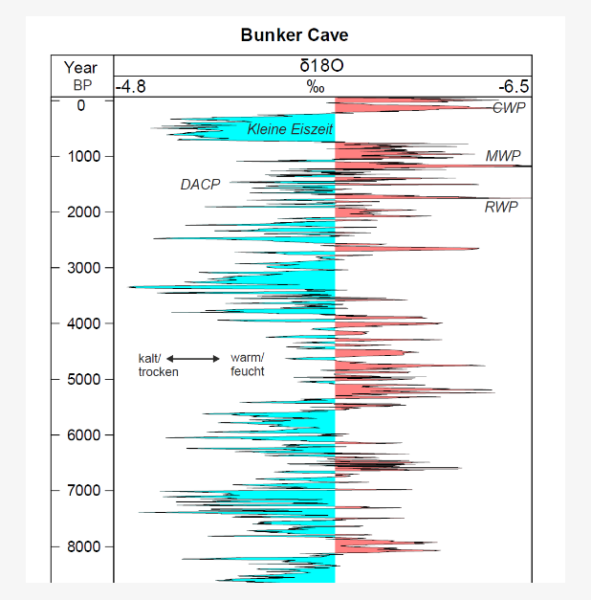

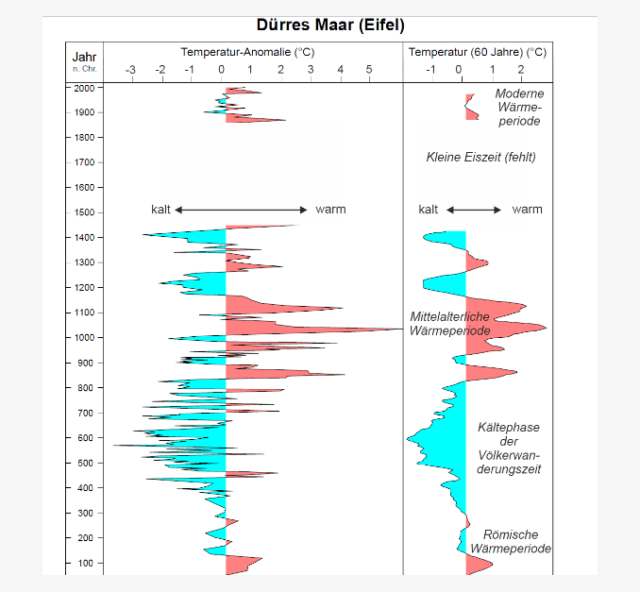

Eine derartige Millenniumszyklik wurde auch in der sauerländischen Bunkerhöhle von Fohlmeister et al. (2012) nachgewiesen. Rhythmische Änderungen in den Sauerstoffisotopen- in Tropfsteinen zeigen über die vergangenen 11.000 Jahre einen fortlaufenden natürlichen Klimawandel, bei dem das System zwischen warm/feucht und kalt/trocken schwankte (Abb. 3). Der Wechsel zwischen der Kältephase der Völkerwanderungszeit, MWP und Moderner Wärmeperiode ist in der Höhlenrekonstruktion gut erkennbar.

Abb. 3: Natürliche Klimaschwankungen im Sauerland während der vergangenen 11.000 Jahre, rekonstruiert auf Basis von Sauerstoffisotopenschwankungen (δ18O) von Tropfsteinen der Bunkerhöhle. Einheit in Promille der Sauerstoffisotope. CWP=Moderne Wärmeperiode (Current Warm Period), MWP=Mittelalterliche Wärmeperiode, DACP=Kälteperiode der Völkerwanderungszeit (Dark Ages Cold Period), RWP=Römische Wärmeperiode. Alterskala zeigt Jahre vor 1950 (Years BP, before ‚present‘=1950). Daten von Fohlmeister et al. (2012), heruntergeladen von https://www.ncdc.noaa.gov/paleo/study/20589

Eine besonders warme Phase stellte das sogenannte Holozäne Thermische Maximum (HTM) dar, das sich in der Zeit 8000-5500 Jahre vor heute ereignete. Kühl and Moschen (2012) rekonstruierten die Temperaturen dieser Klimaepisode für das Dürre Maar anhand von Pollen. Es zeigte sich, dass die Temperaturen in der Eifel damals um mehr als ein Grad über dem heutigen Wärmeniveau lagen (1990-2017), bzw. fast zwei Grad, wenn man das kühlere Referenzintervall 1961-1990 zum Maßstab nimmt. Die Juli-Temperaturen der Eifel lagen während des HTM bei 18,0-18,5°C, wohingegen an der nächstgelegenen Wetterstation Manderscheid im DWD-Referenzintervall 1961-1990 ein Juli-Durchschnittswert von 16,3°C gemessen wurde (Kühl and Moschen, 2012).

Das Fachgebiet der Paläoklimatologie hat in den letzten 15 Jahren große Fortschritte gemacht, und es wurde in der ganzen Welt eine Vielzahl von neuen lokalen Temperaturrekonstruktionen erstellt. Die regionale und überregionale Synthese dieser Daten hinkt dabei allerdings noch etwas hinterher. So gibt es bis heute noch immer keine robuste globale Temperaturrekonstruktion für die vergangenen 10.000 Jahre, bei der sowohl Land- als auch Meerstemperasturen integriert sind. Die vielzitierte Kurve von Marcott et al. (2013) stützt sich fast ausschließlich auf Meerestemperaturen, deren Temperaturänderung jedoch aufgrund der thermischen Trägheit der Ozeane sehr viel weniger stark ausfällt als an Land. Eine globale Temperaturrekonstruktion für die letzten 2000 Jahre durch das PAGES 2k Consortium (2013) fand, dass es in der Zeit 1-600 n. Chr. offenbar bereits mehrfach mindestens genauso warm gewesen ist wie heute. Allerdings ist auch hier noch mit Änderungen zu rechnen, da die Rekonstruktion stark auf Baumringdaten setzt, die in vielen Fällen aus unveröffentlichten und nichtbegutachteten Quellen stammen. Zudem scheinen in die Mittelwerte auch andere ungeeignete Daten eingearbeitet worden zu sein (Beispiel Afrika: Lüning et al., 2017). Insofern sollte hier zunächst verstärkt auf verlässlichere lokale Temperaturserien wie die Bunkerhöhle und das Dürre Maar gesetzt werden, bis in Zukunft hoffentlich bald verbesserte globale Temperaturkurven verfügbar werden.

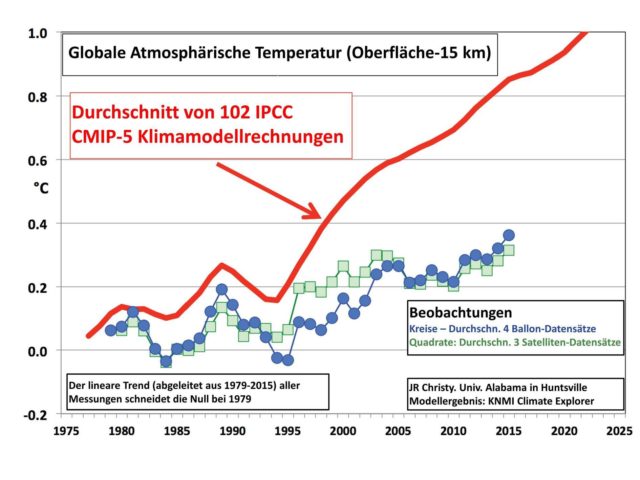

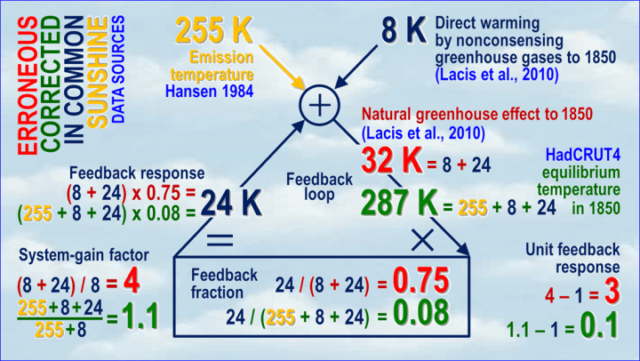

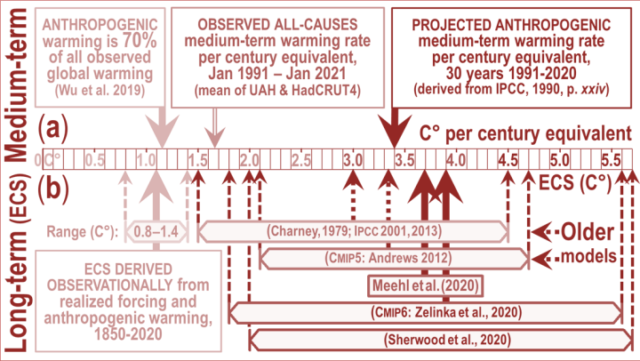

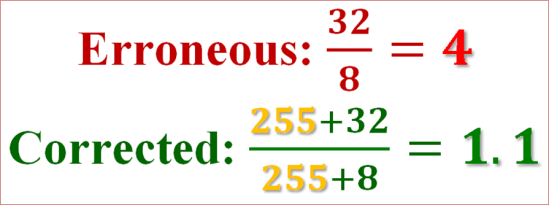

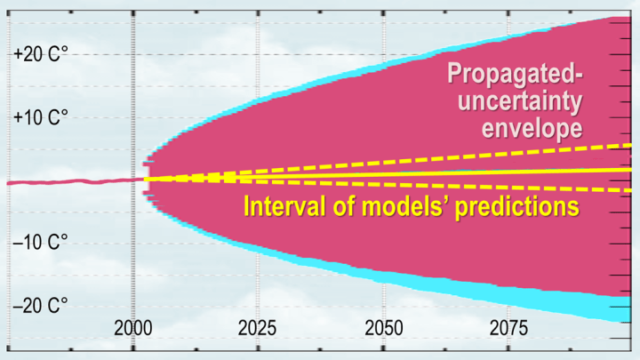

Problematische Klimamodelle

Die Klimaprognosen bis zum Jahr 2100 basieren auf theoretischen Klimasimulationen. Für den in Kürze erscheinenden 6. Klimazustandsbereicht (AR6) des IPCC wurden von den führenden Instituten der Welt neue Klimamodelle (CMIP 6) erstellt, die dem CO2 eine noch stärkere Erwärmungsfähigkeit zugemessen haben als zuvor. Allerdings stellte sich schnell heraus, dass der Großteil der CMIP 6-Modelle grundlegende Fehler enthielt, so dass die mit ihnen errechneten Prognosen wohl kaum belastbar sind.

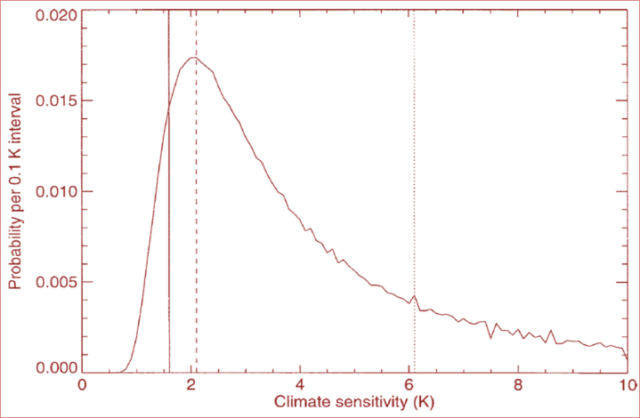

Im Dezember 2019 warnte eine Gruppe um den IPCC-Autor Piers Forster von der University of Leeds explizit, dass die überhöhten Klimasensitivitäts-Werte der neuen Klimamodelle nicht in Einklang mit den Messwerten stehen und sich daher wohl letztendlich als falsch erweisen werden (Forster et al., 2020). Im Laufe des Jahres 2020 erschienen weitere Publikationen, die eine geringere Erwärmungswirkung des CO2 unterstützten (Glassmeier et al., 2021). Im Februar 2021 veröffentlichte eine Forscherguppe der Princeton University und der University of eine weitere Studie, die den überhöhten CO2-Klimasensitivitäten der CMIP6-Modelle eine Absage erteilt (Wang et al., 2021). Der für die zukünftig zu erwartende Erwärmung wichtige Wert der „CO2-Klimasensitivität“ ist noch immer nur sehr ungenau bekannt. Die vom IPCC (AR5) angegebene Spanne reicht von 1,5°C bis 4,5°C Erwärmungswirkung pro CO2-Verdopplung, also eine mit Faktor 3 behaftete Unsicherheit.

Das im Gesetzesentwurf festgeschriebene Klimamonitoring sollte auch die Entwicklungen in diesem Aspekt detailliert verfolgen, da das notwendige Tempo der Dekarbonisierung von einer hoffentlich bald genaueren Einschätzung der CO2-Klimasensitivität beeinflusst wird. Aufgrund der zu erwartenden enormen Kostensteigerungen für Energie, Zement und andere direkt oder indirekt mit der CO2-Besteuerung verbundenen Lebensbereichen, muss die Politik einen gesunden Mittelweg zwischen Klimaschutz, Innovation sowie wirtschaftlicher und sozialer Nachhaltigkeit finden. Subventionen und planwirtschaftliche Elemente sind nur für eine relativ kurze Übergangszeit finanzierbar. Politische Planer sollten den Bürgern die Gesamtkosten des Projekts „Energiewende“ transparent mitteilen und darauf hinweisen, dass Klimaschutz nicht umsonst zu haben ist. Mittlerweile hat Deutschland den höchsten Strompreis der Erde, wobei mit weiteren Preisteigerungen gerechnet wird. Eine Teilfinanzierung der EEG-Umlage aus Steuermitteln belastet letztendlich auch wieder den Stromkunden, diesmal als Steuerzahler. Unter diesem Hintergrund sollte die Geschwindikeit der Dekarbonisierung in der Tat regelmäßig auf die klimatische, wirtschaftliche und soziale Verträglichkeit hin überprüft werden, da ansonsten die Unterstützung des Projekts durch die Öffentlichkeit schnell verloren werden könnte.

Empfehlungen

• Das Thema der vorindustriellen natürlichen Klimavariabilität darf kein Tabu-Thema bleiben. Auch die Klimadiskussion kann aus der Geschichte lernen, muß klimahistorische Fakten anerkennen und einbeziehen.

• Behörden, Politiker und Forscher müssen die enorme natürliche Klimavariabilität der vorindustriellen Zeit aktiv kommunizieren. Die Klimageschichte beginnt nicht erst am Ende der Kleinen Eiszeit um 1880.

• Geignete Maßnahmen sollten ergriffen werden, um die CO2-Klimasensitivität und die damit verbundenen natürlichen und anthropogenen Anteile der Erwärmung der letzten 150 Jahre endlich enger einzugrenzen. Die aktuelle große Spannbreite stellt keine robuste Planungsgrundlage für weitreichende Änderungen der Industriestruktur dar.

Zur Person

Dr. habil. Sebastian Lüning (www.luening.info) studierte Geologie/Paläontologie an der Universität Göttingen. Seine Promotion und Habilitation in diesem Fach erhielt er an der Universität Bremen. Für Vordiplom, Doktorarbeit und Habilitation erhielt Lüning jeweils Studienpreise. Während seiner Postdoc-Zeit arbeitete er zu ökologischen Sauerstoffmangelsituationen in der Erdgeschichte. Seit 2007 ist Lüning hauptberuflich in der Energiebranche tätig, aktuell mit Schwerpunkt im Bereich der Energiewende. Die Teilnahme an dieser Anhörung und die Beschäftigung mit dem Thema Klimawandel erfolgt ausschließlich in privater Funktion, in Fortsetzung seiner langjährigen Vollzeit-Forschertätigkeit. Diese Forschung ist vollständig unabhängig und wurde weder von der Industrie beauftragt noch von ihr gefördert.

Im Jahr 2020 veröffentlichte Lüning zusammen mit Fritz Vahrenholt das Buch „Unerwünschte Wahrheiten – Was Sie über den Klimawandel wissen sollten“. Sebastian Lüning ist mit dem Institut für Hydrographie, Geoökologie und Klimawissenschaften (IFHGK) in der Schweiz assoziiert und wirkte als offizieller Gutachter an den IPCC-Sonderichten zum 1,5 Grad-Ziel und zu Ozeanen/Kryosphäre mit. Zudem war Lüning auch als Gutachter am 6. Klimazustandsbericht des IPCC beteiligt.

Literatur

Barredo, J. I., 2009, Normalised flood losses in Europe: 1970–2006: Nat. Hazards Earth Syst. Sci., v. 9, no. 1, p. 97-104.

Blöschl, G., Hall, J., Parajka, J., Perdigão, R. A. P., Merz, B., Arheimer, B., Aronica, G. T., Bilibashi, A., Bonacci, O., Borga, M., Čanjevac, I., Castellarin, A., Chirico, G. B., Claps, P., Fiala, K., Frolova, N., Gorbachova, L., Gül, A., Hannaford, J., Harrigan, S., Kireeva, M., Kiss, A., Kjeldsen, T. R., Kohnová, S., Koskela, J. J., Ledvinka, O., Macdonald, N., Mavrova-Guirguinova, M., Mediero, L., Merz, R., Molnar, P., Montanari, A., Murphy, C., Osuch, M., Ovcharuk, V., Radevski, I., Rogger, M., Salinas, J. L., Sauquet, E., Šraj, M., Szolgay, J., Viglione, A., Volpi, E., Wilson, D., Zaimi, K., and Živković, N., 2017, Changing climate shifts timing of European floods: Science, v. 357, no. 6351, p. 588-590.

Bond, G., Kromer, B., Beer, J., Muscheler, R., Evans, M. N., Showers, W., Hoffmann, S., Lotti-Bond, R., Hajdas, I., and Bonani, G., 2001, Persistent Solar Influence on North Atlantic Climate During the Holocene: Science, v. 294, p. 2130-2136.

Büntgen, U., Urban, O., Krusic, P. J., Rybníček, M., Kolář, T., Kyncl, T., Ač, A., Koňasová, E., Čáslavský, J., Esper, J., Wagner, S., Saurer, M., Tegel, W., Dobrovolný, P., Cherubini, P., Reinig, F., and Trnka, M., 2021, Recent European drought extremes beyond Common Era background variability: Nature Geoscience, v. 14, no. 4, p. 190-196.

Casty, C., Wanner, H., Luterbacher, J., Esper, J., and Böhm, R., 2005, Temperature and precipitation variability in the European Alps since 1500: International Journal of Climatology, v. 25, no. 14, p. 1855-1880.

Der Spiegel, 2013, Zehn Fakten zur Flut: 6.6.2013, https://www.spiegel.de/wissenschaft/natur/hochwasser-fakten-zur-flut-an-fluessen-elbe-rhein-donau-a-904232.html.

DWD, 2014, Deutscher Wetterdienst zum neuen Bericht des Weltklimarats (IPCC): Auch Deutschland benötigt Empfehlungen zur Anpassung an den Klimawandel: https://www.dwd.de/DE/klimaumwelt/klimawandel/_functions/aktuellemeldungen/140331_ipcc_bericht.html.

-, 2016, Starkregenrisiko in Städten kann jetzt besser eingeschätzt werden: https://www.dwd.de/DE/klimaumwelt/klimawandel/_functions/aktuellemeldungen/160308_dwd_klima_pk.html.

Fohlmeister, J., Schröder-Ritzrau, A., Scholz, D., Spötl, C., Riechelmann, D. F. C., Mudelsee, M., Wackerbarth, A., Gerdes, A., Riechelmann, S., Immenhauser, A., Richter, D. K., and Mangini, A., 2012, Bunker Cave stalagmites: an archive for central European Holocene climate variability: Climate of the Past, v. 8, p. 1751-1764.

Forster, P. M., Maycock, A. C., McKenna, C. M., and Smith, C. J., 2020, Latest climate models confirm need for urgent mitigation: Nature Climate Change, v. 10, p. 7-10.

Glassmeier, F., Hoffmann, F., Johnson, J. S., Yamaguchi, T., Carslaw, K. S., and Feingold, G., 2021, Aerosol-cloud-climate cooling overestimated by ship-track data: Science, v. 371, no. 6528, p. 485-489.

Haslinger, K., Schöner, W., and Anders, I., 2016, Future drought probabilities in the Greater Alpine Region based on COSMO-CLM experiments – spatial patterns and driving forces: Meteorologische Zeitschrift, v. 25, no. 2, p. 137-148.

Ionita, M., Dima, M., Nagavciuc, V., Scholz, P., and Lohmann, G., 2021, Past megadroughts in central Europe were longer, more severe and less warm than modern droughts: Communications Earth & Environment, v. 2, no. 1, p. 61.

Kühl, N., and Moschen, R., 2012, A combined pollen and δ18OSphagnum record of mid-Holocene climate variability from Dürres Maar (Eifel, Germany): The Holocene, v. 22, no. 10, p. 1075-1085.

Lüning, S., 2021, IPCC SROCC Bericht: Was ist aus meinen Gutachterkommentaren geworden?, https://www.youtube.com/watch?v=NhgeeqJ8KrE&t=304s: Klimaschau 23.

Lüning, S., Gałka, M., Bamonte, F. P., Rodríguez, F. G., and Vahrenholt, F., 2019a, The Medieval Climate Anomaly in South America: Quaternary International, v. 508, p. 70-87.

Lüning, S., Gałka, M., García-Rodríguez, F., and Vahrenholt, F., 2020, The Medieval Climate Anomaly in Oceania: Environmental Reviews, v. 28, no. 1, p. 45-54.

Lüning, S., Gałka, M., and Vahrenholt, F., 2017, Warming and Cooling: The Medieval Climate Anomaly in Africa and Arabia: Paleoceanography, v. 32, no. 11, p. 1219-1235.

-, 2019b, The Medieval Climate Anomaly in Antarctica: Palaeogeography, Palaeoclimatology, Palaeoecology, v. 532, p. 109251.

Lüning, S., and Vahrenholt, F., 2016, The Sun’s Role in Climate, Chapter 16 in „Evidence-Based Climate Science“ (Second Edition), Elsevier, p. 283-305.

Lüning, S., and Vahrenholt, F., 2017, Paleoclimatological Context and Reference Level of the 2°C and 1.5°C Paris Agreement Long-Term Temperature Limits: Frontiers in Earth Science, v. 5, no. 104.

Marcott, S. A., Shakun, J. D., Clark, P. U., and Mix, A. C., 2013, A Reconstruction of Regional and Global Temperature for the Past 11,300 Years: Science, v. 339, no. 6124, p. 1198-1201.

Moschen, R., Kühl, N., Peters, S., Vos, H., and Lücke, A., 2011, Temperature variability at Dürres Maar, Germany during the Migration Period and at High Medieval Times, inferred from stable carbon isotopes of Sphagnum cellulose: Clim. Past, v. 7, p. 1011-1026.

Mudelsee, M., and Tetzlaff, G., 2006, Hochwasser und Niederschlag in Deutschland: Die Notwendigkeit von Langfristbeobachtungen unter räumlicher Hochauflösung: 6. Deutsche Klimatagung, München, https://www.manfredmudelsee.com/publ/abstr-pdf/Hochwasser-Niederschlag-Deutschland-Mudelsee-Tetzlaff-2006-7DKT.pdf.

PAGES 2k Consortium, 2013, Continental-scale temperature variability during the past two millennia: Nature Geosci, v. 6, no. 5, p. 339-346.

Paprotny, D., Sebastian, A., Morales-Nápoles, O., and Jonkman, S. N., 2018, Trends in flood losses in Europe over the past 150 years: Nature Communications, v. 9, no. 1, p. 1985.

Schmocker-Fackel, P., and Naef, F., 2010, Changes in flood frequencies in Switzerland since 1500: Hydrol. Earth Syst. Sci., v. 14, no. 8, p. 1581-1594.

TU Delft, 2018, No increase in losses in Europe from floods in the past 150 years: 31.5.2018, https://www.tudelft.nl/en/2018/tu-delft/no-increase-in-losses-in-europe-from-floods-in-the-past-150-years/.

Umweltbundesamt, 2015, Monitoringbericht 2015 zur Deutschen Anpassungsstrategie an den Klimawandel, Dessau-Roßlau.

Vicente-Serrano, S. M., Domínguez-Castro, F., Murphy, C., Hannaford, J., Reig, F., Peña-Angulo, D., Tramblay, Y., Trigo, R. M., Mac Donald, N., Luna, M. Y., Mc Carthy, M., Van der Schrier, G., Turco, M., Camuffo, D., Noguera, I., García-Herrera, R.,

Becherini, F., Della Valle, A., Tomas-Burguera, M., and El Kenawy, A., 2021, Long-term variability and trends in meteorological droughts in Western Europe (1851–2018): International Journal of Climatology, v. 41, no. S1, p. E690-E717.

Wang, C., Soden, B. J., Yang, W., and Vecchi, G. A., 2021, Compensation Between Cloud Feedback and Aerosol-Cloud Interaction in CMIP6 Models: Geophysical Research Letters, v. 48, no. 4, p. e2020GL091024.

ZAMG, 2020, Klimamonitoring: https://www.zamg.ac.at/cms/de/klima/klima-aktuell/klimamonitoring/.