Elektromobilität? Politiker-Beschwichtigungs-Karossen!

Die nordrhein-westfälische Umweltministerin Christina Schulze Föcking machte unlängst Schlagzeilen, als sie einen erst kurz vorher von ihrem Vorgänger angeschafften Tesla-S-90D-Elektro-Dienstwagen wieder ausmustern ließ. Wer hier vermutet, dass man das nicht gerade ökologisch korrekte Image einer 110.000 Euro teuren und 422 PS leistenden Luxuskarosse scheute, beweist damit nur sein Alter. Moderne Öko-Hipster denken im Traum nicht mehr daran, ihre Doppelmoral schamvoll zu verbergen und zumindest nach außen hin eine Fassade von Frugalität zu bewahren; sie haben keine Hemmungen, ihren ressourcenfressenden Lebensstil ungeniert zur Schau zu stellen, solange sich irgendein Gimmick finden lässt, mit dem sie ihre öko-moralische Überlegenheit demonstrieren können. Nein, man war schlicht und ergreifend mit der Leistung der Rennsemmel unzufrieden, die Reichweite habe sich im Praxisbetrieb mit weniger als 300 Kilometern als zu gering herausgestellt. Als Ersatz gönnt sich die Ministerin jetzt einen noch dickeren Mercedes-S500-Verbrenner mit 442 PS (aber immerhin in der besonders teuren Hybridversion mit zusätzlichem Alibi-Elektromotörchen).

Also ein weiteres typisches Beispiel des Wasser-predigen-aber-Wein-saufen-Verhaltens der bundesrepublikanischen politischen Klasse, der die von ihr gepuschte Elektromobilität für den Eigengebrauch nicht gut genug ist, nicht einmal in einer High-End-Luxusausführung.

Wir wollen erst gar nicht die Frage aufwerfen, warum unsere Öko-Politokraten überhaupt dem bösen Individualverkehr frönen und nicht die vielgelobten (und subventionierten) öffentlichen Verkehrsmittel benutzen, die sie uns Normaluntertanen aufzwingen wollen.

Die Episode zeigt aber insbesondere auch in aller Deutlichkeit, dass trotz allen Hypes Elektroautos Lichtjahre von einer Wettbewerbsfähigkeit mit den uncoolen Verbrennern entfernt sind. Was das Reichweitenproblem angeht, so ergibt sich dies schon unmittelbar aus harten physikalischen Tatsachen: Die spezifische Energie eines Bleiakkus beträgt etwa 35 Wattstunden pro Kilogramm, moderne Lithium-Ionen-Akkus liegen hier deutlich besser bei etwa 150 Wattstunden pro Kilogramm. Aber: Benzin hat einen Energiegehalt von 12.800 Wattstunden pro Kilogramm, also 85 Mal soviel!

Eine Speicherkapazität von einer Kilowattstunde benötigt also einen Lithium-Ionen-Akku mit einer Masse von 6,67 Kilogramm; dies entspricht gerade einmal 0,08 Kilogramm oder 0,1 Liter Benzin. Hier muss man noch die unterschiedlichen Wirkungsgrade berücksichtigen: Im optimalen Drehzahlbereich erreicht beim heutigen Serienstand der Technik ein Saugbenziner 30 bis 35 Prozent, ein Turbobenziner 35 bis 40 Prozent und ein Diesel 40 bis 45 Prozent, während ein Elektromotor 90 Prozent und mehr erreichen kann (wobei aber etwa zehn Prozent Verlust in der Leistungselektronik zwischen Akku und Motor abgezogen werden müssen). Aber selbst wenn wir sehr großzügig aufrunden und von einer durchschnittlichen dreifachen Effizienz des Elektroantriebs gegenüber einem Benziner oder einer 2,5-fachen gegenüber einem Diesel ausgehen, so würden 6,67 Kilogramm Akkumasse doch immer noch lediglich etwa 0,24 Kilogramm oder 0,3 Litern Benzin entsprechen.

Der 90-Kilowattstunden-Akku des verschmähten Tesla entspricht also gerade einmal 27 Litern Benzin; dass die Reichweite des Wagens unter diesen Umständen zu wünschen übrig lässt, verwundert nicht wirklich, denn das ist recht mager für ein Zwei-Tonnen-Fahrzeug, woran der Akku mit mehr als einer halben Tonne wesentlich beteiligt ist. Das hohe Gewicht der Batterie wirkt sich natürlich auch negativ auf den Verbrauch aus: Bei Benzinern rechnet man für alle 100 Kilogramm mehr Gewicht mit einem Mehrverbrauch von etwa 0,3 bis 0,4 Litern je 100 Kilometer, was als Vorwand für staatliche Vorschriften genommen wird, die den Automobilherstellern strikte Gewichtsbeschränkungen bei neuen Verbrenner-Automodellen auferlegen; die Automobilhersteller sehen sich bei diesen deshalb gezwungen, um jedes Gramm zu kämpfen und vom technischen Standpunkt aus gesehen unnötige Kompromisse einzugehen. Bei den heiligen Elektro-Kühen, wo, wie wir hier sehen, das zusätzliche Gewicht allein durch die Batterie eine halbe Tonne mehr als bei einem äquivalenten Verbrenner betragen kann, kräht kein Hahn danach. Und die 90 Kilowattstunden gelten wohlgemerkt für ein extrem teures High-End-Modell, Elektromobile in für Normalverdiener halbwegs erschwinglichen Preisbereichen müssen mit Akkus von deutlich geringerer Kapazität auskommen. Üblich sind derzeit Kapazitäten im Bereich von etwa 30 Kilowattstunden, was nach unserer obigen Rechnung eine Tankgröße von gerade neun Litern ergibt.

Das Problem der geringen Reichweite wird noch wesentlich verschärft durch das zweite technische Hauptmanko der Elektrofahrzeuge, nämlich die langen Ladezeiten. Diese sind bedingt durch die sehr begrenzte Rate, mit der Batterien geladen werden können, ohne sie zu beschädigen. Heutige Ladestationen haben in der Regel eine Laderate von elf oder 22 Kilowatt; die „Supercharger“ von Tesla schaffen immerhin bis zu 120 Kilowatt. Für die fernere Zukunft wird von 350 Kilowatt gemunkelt, obwohl noch nicht klar ist, welche Fahrzeuge diese überhaupt werden nutzen können. Der Verbrennerfahrer kann über solche Zahlen nur müde lächeln; eine normale Pkw-Benzinzapfsäule mit einer Durchflussmenge von 35 Litern pro Minute hat, in Elektronomenklatur ausgedrückt, eine „Laderate“ von gigantischen 21 Megawatt oder immer noch von sieben Megawatt, wenn wir unseren großzügigen Umrechnungsfaktor benutzen.

Während man so einen Kraftstofftank in höchstens zwei bis drei Minuten auffüllen kann, dauert dies bei einem Elektromobil typischerweise mindestens fünf bis sechs Stunden, weshalb es in der Praxis zumeist erforderlich ist, in eine eigene häusliche Ladestation zu investieren, um über Nacht „nachtanken“ zu können. Inzwischen gibt es bei einigen Modellen auch „Schnelladung“; auch hier wird die Wartezeit an der Stromtankstelle aber ganz schön lang, da es die Ladezeit bestenfalls auf etwa 20 bis 30 Minuten verkürzt. Zudem setzen so hohe Ladeströme die Lebensdauer des Akkus herab, weshalb etwa bei Tesla die Anzahl der Schnelladezyklen über die Fahrzeugsoftware begrenzt wird. Ohnehin kommt man mit Schnelladung nur bis zu etwa 80 Prozent der Nennkapazität, wer volltanken will, muss die restlichen 20 Prozent im normalen Ultra-Schneckentempo absolvieren.

Aber auch unabhängig vom „Schnelladen“ wird empfohlen, nicht mehr als bis auf 80 Prozent der Nennkapazität aufzuladen und auf nicht weniger als 20 Prozent zu entladen, um die Lebensdauer des Akkus nicht herabzusetzen. Dies bedeutet natürlich effektiv, nur 60 Prozent der ohnehin unzureichenden Akkukapazität zu nutzen. Generell sind bislang kaum belastbare Erfahrungsdaten darüber publik geworden, wie gut es um die Langzeit-Haltbarkeit der Fahrzeugakkus steht; man geht von im Normalfall etwa sieben bis zehn Jahren aus, bis der Kapazitätsverlust einen Austausch nötig macht.

Ein weiteres ernstes Problem ist die starke Temperaturabhängigkeit der Akkus, die angegebenen Nennwerte erreichen sie nämlich nur in einem recht engen Temperaturbereich von etwa 20 bis 30 Grad Celsius. Außerhalb dessen sind negative Auswirkungen sowohl auf Kapazität als auch auf Ladezeit und Effizienz sowie Lebensdauer zu erwarten. So ist etwa bereits bei minus fünf Grad mit Kapazitätsverlusten im Bereich von 50 Prozent zu rechnen. Oftmals besitzen Elektroautos deshalb eine Heizung und eine Klimaanlage für die Batterie, was aber nicht nur ein Kostenfaktor ist, sondern auch für einen hohen zusätzlichen Energieverbrauch sorgt.

Aber mindestens ebenso bedeutsam wie die massiven technischen Nachteile des Elektroautos sind seine Kosten. Staatliche Subventionen und die für die Hersteller nicht kostendeckenden Preise (die letztendlich zumeist von den Käufern der normalen Modelle getragen werden müssen) verschleiern oftmals, wie exorbitant der Kostenaufschlag für die Elektromobilität eigentlich ausfällt.

Eine sehr gute Basis für einen realistischen Vergleich der Produktionskosten von Elektrikern und Verbrennern bietet der Chevrolet Bolt von General Motors, da er in relativ hohen Stückzahlen produziert wird und bis auf seinen elektrischen Antriebsstrang weitgehend identisch mit dem Benziner Sonic ist: Der Bolt hat einen Listenpreis von 37.000 US-Dollar (durch Subventionen kann dies für den Käufer natürlich deutlich weniger werden), einen Sonic mit vergleichbarer Ausstattung bekommt man schon für 19.000 US-Dollar. Allerdings macht GM etwa 8.000 bis 9.000 US-Dollar Verlust für jeden produzierten Bolt, womit sich die tatsächlichen Kosten auf mindestens 45.000 US-Dollar belaufen, was satte 26.000 US-Dollar oder 137 Prozent Mehrkosten im Vergleich zur Benziner-Version bedeutet. Dazu müsste man natürlich eigentlich noch die Gewinnspanne für die Benziner-Version aufschlagen, auf die GM bei seinen „normalen“ Fahrzeugen wohl kaum verzichten wird (auch wenn sie, da es sich um einen Kompaktwagen handelt, vermutlich nicht allzu üppig ausfallen wird).

Bei anderen Anbietern kommt man auf ganz ähnliche Zahlenwerte. So bietet etwa auch Fiat aufgrund der „Zero Emission“-Gesetze im US-Bundesstaat Kalifornien, die Elektro-unwilligen Automobilherstellern heftige Strafzahlungen androhen, eine Stromer-Version des Fiat 500 an. Sie kostet happige 33.000 US-Dollar im Vergleich zu etwa der Hälfte für eine entsprechende Benziner-Version. Einen Gewinn macht Fiat damit aber genauso wenig wie GM, wie Fiat-Chrysler-Chef Sergio Marchionne auf einer Konferenz mit folgender, wenig enthusiastischer „Werbebotschaft“ für das ungeliebte Produkt klarmachte: „Ich hoffe, Sie kaufen es nicht, denn jedes Mal, wenn ich eines verkaufe, kostet es mich 14.000 Dollar.“

Die Kosten für ein Elektroauto betragen also deutlich mehr als das Doppelte eines ansonsten vergleichbaren Verbrenners (vergleichbar heißt aber nicht gleichwertig, da natürlich die Gebrauchsnachteile des Elektrikers berücksichtigt werden müssen). Wie kommt diese gewaltige Kostenkluft zustande? Zum einen ist da natürlich der Preis für den notwendigen massiven Akku. Das kann aber nicht alles sein, wie ein weiterer Blick auf das Beispiel Chevrolet Bolt klarmacht. Der Einkaufspreis der Zellen für den dort verbauten 60-Kilowattstunden-Akku beträgt laut GM 8.700 US-Dollar, die Kosten für den gesamten Akku werden auf etwa 12.0000 bis 13.000 US-Dollar geschätzt. Der Akku ist also nur für etwa die Hälfte der Mehrkosten verantwortlich, offensichtlich sind auch andere Bestandteile des Antriebsstrangs an der Elektro-Kostenexplosion beteiligt.

Diese Feststellung ist insofern bemerkenswert, als sie in direktem Widerspruch zu den oft gehörten Behauptungen über vermeintliche Kostenvorteile für Elektrofahrzeuge wegen ihrer geringeren mechanischen Komplexität steht. Wirklich überraschend ist sie jedoch nicht, denn es ist ohne weiteres einsichtig, dass die vielbeschworenen Einsparungen für mechanische Komponenten in der Realität nicht sonderlich stark ins Gewicht fallen; ein Motor ist natürlich weiterhin vorhanden, und Elektrofahrzeuge benötigen entgegen einem weit verbreiteten Irrglauben durchaus ein Getriebe, auch wenn nur ein oder zwei Fahrstufen nötig sind und es daher etwas einfacher als bei einem Verbrenner ausfallen kann. An anderen Stellen muss dafür aber erheblich mehr Aufwand getrieben werden: So ist etwa eine umfangreiche Leistungselektronik für die Handhabung der hohen Ströme erforderlich, die für den Elektromotor notwendige Regelungselektronik fällt weitaus komplexer als für einen Verbrennungsmotor aus, und die geringe Verlustwärme des Motors hat auch Nachteile, da eine zusätzliche elektrische Heizung notwendig ist; die dringend zu empfehlende Batterieheizung/Klimatisierung haben wir schon erwähnt.

Angesichts der gravierenden Nachteile von Elektrofahrzeugen ist es kein Wunder, dass sie völlig von staatlichen Subventionen abhängig sind. Höhere Marktanteile – wofür schon der obere einstellige Prozentbereich gelten kann – erreichen sie nur dort, wo die Bevorzugung gegenüber Verbrennerfahrzeugen extreme Ausmaße von 100 Prozent des Fahrzeugwertes und mehr erreicht. In der Praxis geschieht dies dort, wo normale Autos besonders hoher steuerlicher Belastung ausgesetzt sind und Elektrofahrzeuge davon befreit werden. Sehr aufschlussreich ist es, zu beobachten, was geschieht, wenn diese Vergünstigungen wieder reduziert werden. In Hongkong erreichten Elektroautos, da sie von der dortigen hohen Anmeldesteuer befreit waren, durchaus ansehnliche monatliche Verkaufszahlen im dreistelligen Bereich. Vorwiegend handelte es sich um hochpreisige Teslas – die Firma machte 2015 etwa zehn Prozent ihres Auslandsumsatzes in Hongkong. Als die Steuerbefreiung schließlich auf einen Fahrzeugpreis von umgerechnet etwa 12.000 Euro gedeckelt wurde, waren die Auswirkungen dramatisch: Von einem Rekordwert von 2.964 Fahrzeugen im März 2017 sank die Zahl der Anmeldungen im Folgemonat auf buchstäblich Null – was sich in den Folgemonaten nur minimal auf knapp zweistellige Werte „erholte“. In Dänemark hatten Elektrofahrzeuge dank der Nichterhebung der für Autos sonst fälligen bis zu 180-prozentigen Importsteuer einen Marktanteil von immerhin 2,2 Prozent erreicht. Als aber 2016 Elektrofahrzeuge wieder steuerpflichtig wurden, sackten ihre Verkaufszahlen um gut 60 Prozent ab – und das, obwohl für Fahrzeuge unter umgerechnet etwa 100.000 Euro die Steuer nur auf moderate 20 Prozent der regulären Rate festgelegt wurde. Wie man sieht, ist es notwendig, die massiven Vergünstigungen auf Dauer aufrechtzuerhalten; das schließt diesen Weg zur Durchsetzung der schönen neuen Elektrowelt praktisch aus, da wohl kaum ein Finanzminister bereit sein wird, auf die ergiebige Melkkuh Autofahrer zu verzichten.

Aber wie sieht es mit der Zukunft aus? Wenn wir ihren Evangelisten Glauben schenken wollen, schreitet die elektromobile Revolution mit exponentieller Geschwindigkeit fort, und wenn die Fahrzeuge auch heute noch weit entfernt von jeglicher Wettbewerbsfähigkeit sein sollten, so werden sie sie in jedem Fall in wenigen Jahren erreicht haben. Aber auch hier sehen die harten Fakten anders aus: Signifikante Verbesserungen, sowohl was Leistung als auch was Kosten angeht, sind in absehbarer Zukunft nicht zu erwarten.

Zum Teil liegt dies daran, dass erst für die Zukunft prognostizierte positive Effekte schon eingetreten sind. Das gilt insbesondere für die „Skaleneffekt“-Entschuldigung der hohen Kosten elektrischer Fahrzeuge: Demnach würden diese bislang nur in vergleichsweise niedrigen Stückzahlen hergestellt, wenn erst ähnlich hohe Produktionsziffern wie bei der Verbrennerkonkurrenz erreicht seien, so würden sich auch die Kosten angleichen. Angesichts der Tatsache, dass schon heute mehrere Elektromodelle mit jährlichen Produktionszahlen im Zehntausenderbereich existieren, erscheint diese Argumentation jedoch wenig überzeugend. Um einmal mehr den Chevrolet Bolt und sein Benziner-Geschwister Sonic als Beispiel heranzuziehen: Vom Sonic wurden 2016 etwa 60.000 Stück gebaut, für den Bolt, der seit November 2016 auf derselben Produktionslinie gebaut wird, ist eine Jahresproduktion von 25.000 bis 30.000 Stück vorgesehen. Das ist wohl kaum ein größenordnungsmäßig entscheidender Unterschied. Mehr noch: Die Verfügbarkeit des Opel Ampera-e, der Version des Bolts für den europäischen Markt, wird künstlich auf wenige Tausend Stück im Jahr beschränkt, obwohl man, insbesondere aufgrund so extrem hoch subventionierter Märkte wie Norwegen, wesentlich mehr absetzen könnte. Es wäre sicherlich kein Problem, mit den Absatzzahlen für den nordamerikanischen Markt zumindest gleichzuziehen. Man sieht jedoch offensichtlich bei GM keine Möglichkeit, selbst bei einer wesentlichen Erhöhung der Stückzahlen das Fahrzeug kostendeckend produzieren zu können.

Auch beim Elektro-Wunderkind Tesla ist nichts von der Wirkung der wundersamen „Skaleneffekte“ zu spüren, denn dort verzeichnet man trotz einer inzwischen erreichten Jahresproduktion von annähernd 100.000 Fahrzeugen weiterhin horrende Verluste. Dies wiegt umso schwerer, als Tesla die durchaus clevere Strategie verfolgte, zunächst einmal gerade eben nicht ökologisch korrekt auf das Kleinwagensegment abzuzielen, wie das die etablierte Konkurrenz mit ihren E-Mobilen vorwiegend tat, sondern stattdessen extrem teure Luxus-Spaßmobile anzubieten, deren hohe Margen bessere Chancen boten, den Elektromobilitäts-Kostennachteil auszugleichen. Dass man aber auch so die Fahrzeuge, trotz hoher staatlicher Subventionierung, nur mit massiven Verlusten absetzen konnte, zeigt drastisch, wie extrem weit entfernt Elektroautos von einer Konkurrenzfähigkeit mit Verbrennern sind. Und nicht einmal eine Tendenz zum Besseren ist zu erkennen, denn aus einem Blick in die Tesla-Bilanzen lässt sich schließen, dass, obwohl sich die Produktionszahlen zwischen 2014 und 2016 fast verdreifachten, dies zu keiner Senkung der Produktionsstückkosten geführt hat, eher im Gegenteil.

Auch was speziell die Schlüsselkomponente des Elektromobils, den Akku, angeht, ist das Rationalisierungspotential bereits weitgehend ausgeschöpft. Eine Studie der University of Michigan etwa sieht das Optimum, ab dem eine weitere Erhöhung des Ausstoßes kaum noch zusätzliche Kostenvorteile mit sich bringt, bei einer jährlichen Produktionsrate von 200 bis 300 Megawattstunden. Diese Zahlen werden etwa beim Nissan Leaf, beim Chevrolet Bolt und von Tesla bereits überschritten. Weiterhin ist zu beachten, dass ein beträchtlicher Teil der von Elektro-Enthusiasten viel bejubelten starken Preissenkungen für Lithium-Ionen-Akkuzellen der letzten zehn Jahre nicht auf niedrigere Produktionskosten zurückzuführen ist, sondern auf das Schrumpfen der Gewinnspannen der Zellenhersteller, die in Erwartung des vermeintlichen riesigen Elektromobilitätsmarktes gewaltige Überkapazitäten aufgebaut haben und jetzt nur mehr mit hauchdünnen Margen oder mit Verlust arbeiten. Es ist kein Wunder, dass unter diesen Umständen inzwischen auch der letzte deutsche Zellenhersteller das Handtuch schmeißen musste. Bei den verbliebenen Herstellern handelt es sich vorwiegend um große asiatische Konglomerate, die die Zellenherstellung über andere, profitable Geschäftsbereiche quersubventionieren können. Es ist aber nicht anzunehmen, dass sie diesen Aderlass unbegrenzt tolerieren werden, wenn sich nicht in absehbarer Zeit der versprochene Bedarf auftut.

In der Propaganda der Elektro-Enthusiasten wird versucht, für die Entwicklung der Akkutechnologie einen ähnlich rasanten Fortschritt wie den durch das berühmte Mooresche Gesetz beschriebenen in der Mikroelektronik zu suggerieren. Aber alle Erfahrungen der Vergangenheit zeigen, dass die Entwicklung in der Batterietechnik nur relativ langsam fortschreitet, sowohl was die Verbesserung bestehender als auch was die Einführung neuer Technologien angeht. Der Bleiakkumulator etwa erfuhr in den mehr als 150 Jahren seiner Geschichte in seinen grundlegenden Eigenschaften nur recht moderate Verbesserungen.

Auch beim Lithium-Ionen-Akku ist der behauptete rasante Fortschritt eher nicht zu erkennen und verlangsamt sich in den letzten Jahren sogar noch. Das ist nicht weiter verwunderlich, denn die Technologie gilt als weitgehend ausgereizt, sowohl was Kosten als auch was Leistung betrifft. So geht Panasonic, der Lieferant für die Batteriezellen des Elektro-Vorzeigeherstellers Tesla, von lediglich 20 Prozent bis 30 Prozent mehr an spezifischer Energie aus, die sich noch aus der Lithium-Ionen-Zellentechnologie herausholen lassen würden. Das zeigt sich auch an den neuen Batteriezellen, die in der neuen Tesla-„Gigafabrik“ hergestellt werden und zwar eine höhere Kapazität aufweisen, gleichzeitig jedoch auch entsprechend größer sind, womit sich die Energiedichte also nicht verbessert hat. Diese Stagnation macht sich dann entsprechend auch in den Gesamt-Akkupaketen bemerkbar: Die Batterie des 2007 erschienenen ersten Fahrzeugs, des Roadster, wies eine spezifische Energie von 127 Wattstunden pro Kilogramm auf, was sich schrittweise bis auf 170 Wattstunden pro Kilogramm für das Model S von 2016 erhöhte. Bei den Batterien für das aktuelle Model X und das Model 3 von 2017 ist jedoch nicht nur keine weitere Erhöhung, sondern sogar eine Regression auf 150 Kilowattstunden pro Kilogramm festzustellen.

Mit dem Lithium-Ionen-Akku wird die elektromobile Revolution also nicht zu machen sein. Doch was ist mit den ganzen revolutionären neuen Batterietechnologien, die alle naselang verkündet werden? Zunächst einmal ist festzustellen, dass, wie üblich, die große Mehrheit dieser neuen Wundertechnologien scheitern und sang- und klanglos in der Versenkung verschwinden wird. Aber selbst bei denjenigen von ihnen, die sich als grundsätzlich realisierbar herausstellen sollten, wird es noch eher Jahrzehnte als Jahre dauern, bis sie für den Einsatz in Fahrzeugen relevant werden. Erste Versuchsmuster von Lithium-Ionen-Akkus wurden bereits in den 70er Jahren entwickelt, aber erst Anfang der 90er Jahre kamen die ersten kommerziellen Anwendungen auf den Markt. Es dauerte ein weiteres Jahrzehnt, bis sie einen solchen Reifegrad erreicht hatten, dass an einen Einsatz in automobilen Anwendungen gedacht werden konnte. Und erst heute, also noch ein weiteres Jahrzehnt später, kann man von einem leistungs- und kostenoptimierten Stand der Technik sprechen. Es gibt keinen Grund dafür, anzunehmen, dass zukünftige neue Batterietechnologien wesentlich kürzere Entwicklungszeiträume aufweisen werden.

Weiterhin muss kritisch geprüft werden, wie relevant die potentiellen Verbesserungen neuer Batterietechnologien tatsächlich für die Frage nach der Wettbewerbsfähigkeit von elektrischen Fahrzeugen sind. Nehmen wir etwa die Lithium-Schwefeltechnologie, die wohl die am weitesten fortgeschrittene unter den neuen Batterietechnologien ist: Hier wird euphorisch mit einer spezifischen Energie von 500 Wattstunden pro Kilogramm geworben, die sich bei den neuesten Labormustern schon erzielen lassen würden, für die fernere Zukunft wird sogar von zumindest theoretisch erzielbaren mehr als 2.000 Wattstunden pro Kilogramm gemunkelt. Das klingt zunächst sehr gut, bis man sich auch einmal die Energiedichte ansieht – diese ist nämlich nicht besser, tendenziell sogar eher etwas schlechter, als bei den etablierten Lithium-Ionen-Akkus. Im Klartext: Ich benötige weiterhin eine Batterie vergleichbarer Größe und Komplexität, mit einer vergleichbaren Anzahl von Einzelzellen, um eine bestimmte Energiemenge zu speichern; der einzige Vorteil ist, dass diese leichter sein wird. Nun wäre es sicherlich sehr willkommen, wenn die Batterie in meinem Elektrofahrzeug nur noch 100 oder 200 Kilogramm statt einer halben Tonne wiegt; aber das hohe Batteriegewicht ist unter den zahlreichen Problemen, die die Elektromobilität plagen, noch ein vergleichsweise harmloses. Es ist klar, dass sich bei den Hauptproblemen, den hohen Kosten und der geringen Reichweite, nur durch Verbesserung auch der Energiedichte echte Fortschritte erzielen lassen – eine Einzelzelle vergleichbarer Größe muss eine höhere Energiespeicherkapazität aufweisen.

Bis eine neue, wesentlich leistungsfähigere, Batterietechnologie einigermaßen ausgereift und zu vertretbaren Kosten verfügbar ist, wird es also selbst optimistisch gesehen eher noch 20 als zehn Jahre dauern. Die Kosten für Elektrofahrzeuge werden aber auch dann weiterhin höher sein, die Batterie wird immer einen signifikanten Zusatzaufwand bedeuten, der bei einem Verbrenner schlichtweg nicht existiert. Immerhin könnten sie dann einigermaßen deren Leistungsniveau erreichen.

Aber zumindest bis dahin ist jegliche Investition in elektrische Massenmarktmodelle und entsprechende Infrastruktur nichts weiter als sinnlos verschleudertes Geld. Unter diesem Gesichtspunkt kann man die von den rückgratlosen Managern der deutschen Automobilindustrie diensteifrig gegenüber der Politik versprochenen Milliardeninvestitionen in Elektrofahrzeuge nur mit Entsetzen betrachten, denn dieses Geld fehlt dann natürlich für Investitionen in die Weiterentwicklung von Verbrennungsmotoren. Als Beispiel sei hier die sogenannte homogene Kompressionszündung erwähnt, auch „Diesotto“ genannt, weil einem Ottomotor die Fähigkeit verliehen wird, in bestimmten Betriebszuständen alternativ auch die Selbstzündung eines Diesels zu nutzen, mit massiven Effizienzvorteilen. Die deutschen Hersteller haben die weitere Entwicklung dieser Technologie zugunsten der allgemeinen „Elektrifizierung“ aufgegeben und damit der Konkurrenz das Feld überlassen. Und die schläft nicht: Der japanische Hersteller Mazda hat für 2019 das erste Serienfahrzeug mit Diesotto-Motor angekündigt. Und so wird es wohl in einigen Jahren so aussehen, dass deutsche Hersteller mit ihren weitgehend unverkäuflichen (insbesondere zu kostendeckenden Preisen) Politiker-Beschwichtigungs-E-Karossen dastehen, während sie im tatsächlichen Massenmarkt gezwungen sind, mit veralteter Motorentechnologie gegen andere, weniger kurzsichtige, Konkurrenten anzutreten.

Diese Tatsache, nämlich dass sich die Verbrennertechnologie auch weiterentwickelt, ist im übrigen ein bei Betrachtungen über die Fortschritte in der Batterietechnologie gern vergessener Aspekt. Deshalb auch der Konjunktiv in der obigen Einschätzung, es ist nämlich durchaus nicht ausgeschlossen, dass wie in der Fabel vom Hasen und vom Igel bei der Einführung der schönen neuen Batterietechnik „Ück bün schon da“ ertönt, weil nämlich der Verbrennungsmotor inzwischen so große Fortschritte gemacht hat, dass sich der Abstand zwischen beiden Technologien nicht entscheidend vermindert hat.

Durchaus möglich ist auch, dass es letztendlich nicht die galvanische Zelle sein wird, die das ersehnte Energiespeichermedium für die Ablösung des Verbrennungsmotors liefern wird. Als Alternative kommt hier insbesondere die Kondensatortechnik in Frage – Physik statt Chemie. Aber die Erzielung brauchbarer Energiedichten für Hochleistungskondensatoren liegt in noch fernerer Zukunft als die Entwicklung einer neuen Generation von Batterien.

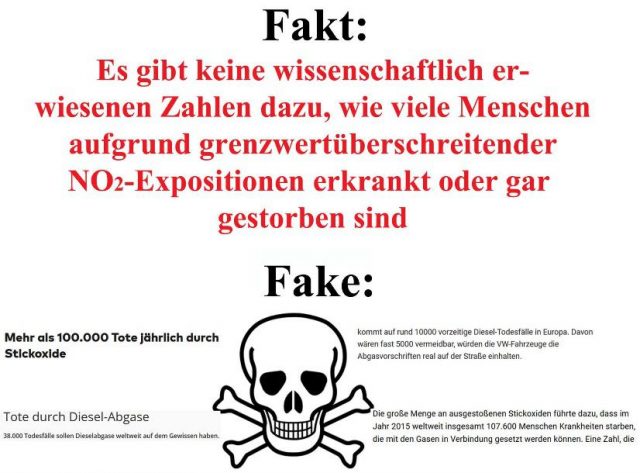

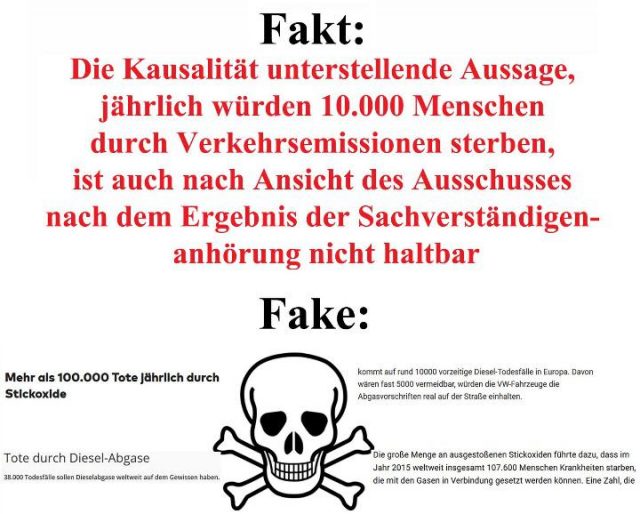

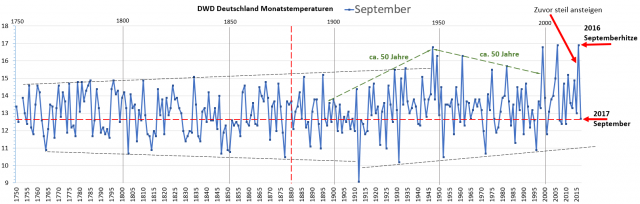

Aber stellen wir einmal die ketzerische Frage, aus welchem Grund wir eigentlich so ungeduldig das Kommen der elektromobilen Offenbarung auf Biegen und Brechen herbeiführen sollen. Wegen ihrer „Umwelt“-Freundlichkeit? Aber in welcher Beziehung haben die E-Mobile überhaupt einen „Umwelt“-Vorteil gegenüber Verbrennern? Diese Frage zu beantworten ist gar nicht so einfach, da, was als „Umwelt“-freundlich oder -feindlich zu gelten hat, sehr vage definiert ist und je nach politischem Einsatzzweck sehr unterschiedlich oder gar gegensätzlich interpretiert wird. Fangen wir einmal mit den „klassischen“ Kritikpunkten am motorisierten Straßenverkehr an, die Belästigung und Gesundheitsgefährdung durch Abgase. Hier wird bekanntlich bereits seit Jahren eine massive Kampagne insbesondere gegen den Diesel gefahren. Mit der Realität hat das nicht das Geringste zu tun, sowohl Diesel als auch Benziner haben in den letzten Jahrzehnten, was Abgasqualität betrifft, dramatische Fortschritte erzielt; keine durch Autoabgase verursachten Schadstoffe erreichen auch nur annähernd als gesundheitsschädlich einzustufende Konzentrationen.

Heutige Fahrzeuge erreichen, was Abgasreinigung betrifft, einen derart hohen Stand, dass es in einigen Kategorien sogar vorkommen kann, das aus dem Auspuff weniger Schadstoffe kommen, als in der Luft waren, die vorher eingesaugt wurde. Dies gilt etwa für den berühmt-berüchtigten Feinstaub, was der entsprechenden Kampagne einen ganz besonders absurden Zug verleiht. Abgesehen davon, dass es keinerlei Beleg dafür gibt, dass der Feinstaub, wie er in üblichen Konzentrationen vorkommt, gesundheitsschädliche Auswirkungen hat (die Konzentrationen in Innenräumen sind in der Regel weit höher), wird nur ein unbedeutender Anteil – etwa zehn Prozent – durch den Straßenverkehr verursacht. Wer Feinstaub als Problem ansieht, sollte als Abhilfemaßnahme vielleicht eher dafür plädieren, künftig den Staub auf den Straßen mit Wasserschläuchen abzuspritzen, wie man es früher gemacht hat. Und selbst wenn man speziell den Straßenverkehr betrachtet, so sind Reifen- und Bremsenabrieb weitaus bedeutendere Quellen für Feinstaub als der Motor: Ein moderner Dieselmotor produziert pro gefahrenem Kilometer etwa 0,2 bis 0,5 Milligramm Feinstaub, ein Fahrrad aber allein durch Bremsenabrieb etwa fünf bis zehn Mal soviel – Wo bleiben die Fahrradfahrverbote?

Das generelle Problem bei Schadstoff-Grenzwerten ist, dass sie, völlig unbeschwert von irgendwelchen wissenschaftlichen Fakten, nach Gutdünken von Bürokraten und Politikern gemäß deren politisch-ideologischer Agenda festgelegt werden können, sei es eine „öko“-sozialistische, oder wie bei den US-Grenzwerten, die VW zum Verhängnis wurden, eine ökonomische Kriegsführung gegen die bei der Dieseltechnologie führenden deutschen Unternehmen. So lassen sich etwa bei den neben dem Feinstaub besonders im Fadenkreuz der Anti-Diesel-Kampagne stehenden Stickoxiden in toxikologischen Experimenten keinerlei schädliche Auswirkungen bei Konzentrationen unterhalb von zwei bis drei Milligramm pro Kubikmeter Luft feststellen. Entsprechend wurde der Grenzwert für erlaubte Konzentrationen am Arbeitsplatz mit einem großzügigen Sicherheitsabstand auf 0,95 Milligramm pro Kubikmeter festgelegt, für besonders empfindliche Personen wie Kranke und Kinder ging man noch einmal auf 0,2 Milligramm pro Kubikmeter herab. Die höchsten in Deutschland im Straßenverkehr gemessenen Konzentrationen liegen bei etwa 0,07 bis 0,08 Milligramm pro Kubikmeter, also weniger als die Hälfte dessen, was man in Innenräumen selbst für besonders empfindliche Personen als unbedenklich ansieht. Kein Problem, sollte man meinen – bis auf die Tatsache, dass der Grenzwert für den Straßenverkehr von EUkraten völlig willkürlich auf den buchstäblich aus der Luft gegriffenen Wert von 0,04 Milligramm pro Kubikmeter festgelegt wurde.

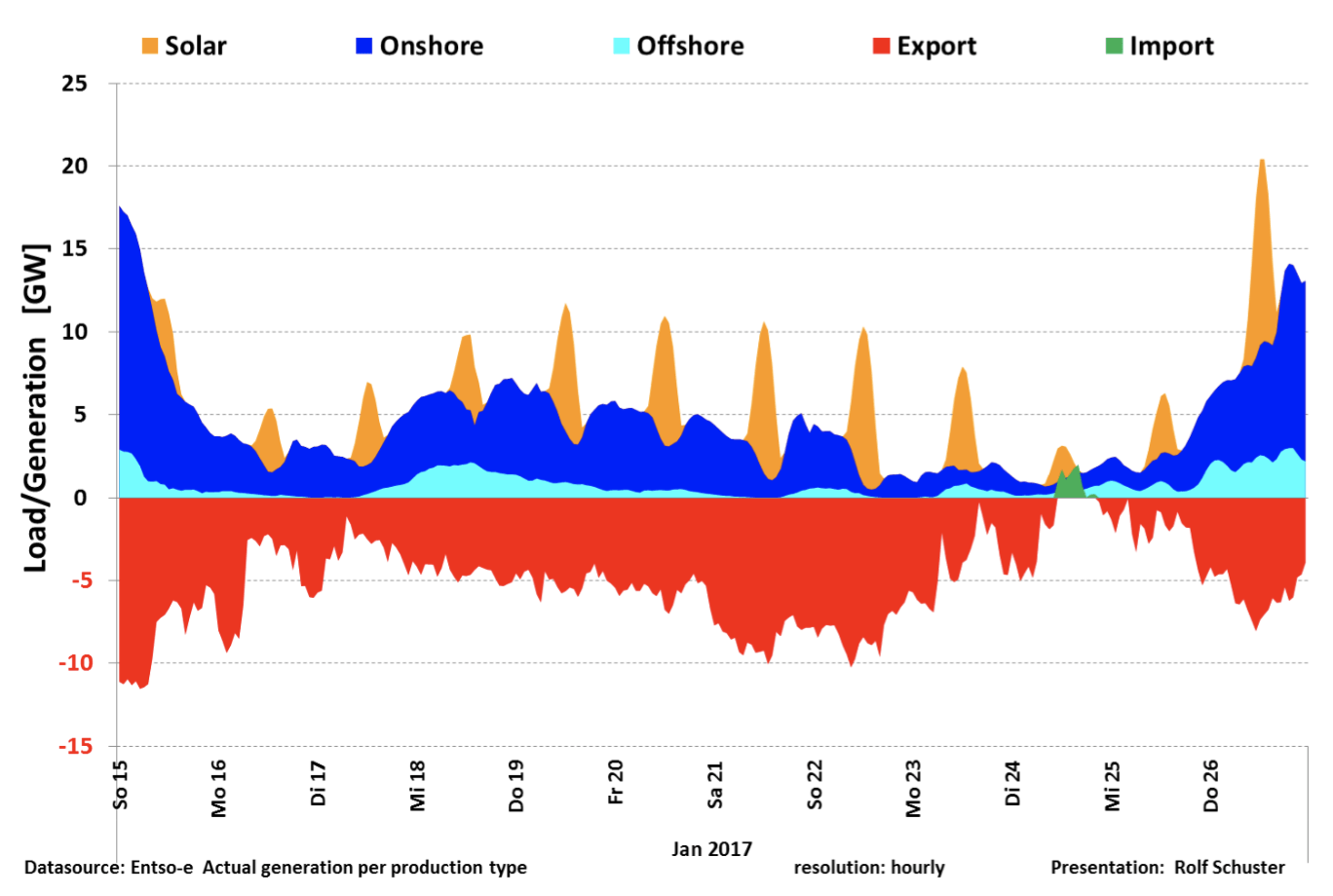

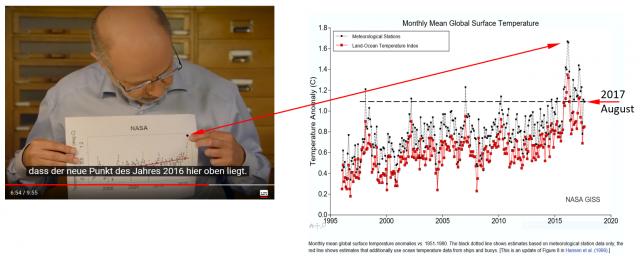

Wenn möglich aber noch absurder wird es, wenn wir die angeblich entscheidende Umwelt-Trumpfkarte der Elektrofahrzeuge angehen, nämlich ihre „Klimafreundlichkeit“. Denn egal, ob man die CO2-Klima-Mythologie ernst nimmt oder nicht (oder zumindest vorgibt, sie ernst zu nehmen), Tatsache bleibt, dass der elektrische Strom, mit dem man ein Elektroauto auflädt, erst einmal produziert werden muss. Und das heißt, abgesehen von geringen und regional beschränkten Mengen an Wasserkraft und Geothermie sowie der Kernenergie, die man ja auf gar keinen Fall haben will, fossile Energie. Dies gilt natürlich ebenso für die Lieblinge der Energiewende, Windkraft und Solar, da es deren sattsam bekannte Unfähigkeit, kontinuierlich Strom zu liefern, erforderlich macht, ihre „Zappelstrom“-Produktion zu 100 Prozent mit konventionellen Kraftwerken abzusichern. Und da ein Kohlekraftwerk etliche Stunden zum Anfahren braucht, müssen diese nicht nur bereitgehalten, sondern auch ständig beheizt werden, damit sie bei einer Flaute rechtzeitig einspringen können.

Das heißt, dass ein Elektroauto in Deutschland, selbst bei der Verwendung von sogenanntem „Ökostrom“, de facto mit Kohle betrieben wird. Das könnte man freilich weitaus billiger und effektiver haben, wenn man wie im Zweiten Weltkrieg die Kohle verflüssigen und damit die Autos ganz normal betreiben würde (mit heutiger Technik wäre der Kostennachteil gegenüber Erdöl sogar nur noch moderat).

Weiter oben haben wir eine höhere Effizienz des Elektromotors im Vergleich zum Verbrenner festgestellt. Das gilt aber nur für eine isolierte Betrachtung, bei einem Blick auf das Gesamtsystem sieht die Bilanz weitaus weniger rosig aus. Zunächst einmal muss der Brennstoff natürlich in einem Kraftwerk in Elektrizität umgewandelt werden: Bei Kohle haben wir üblicherweise einen Wirkungsgrad von 30 Prozent bis 40 Prozent, bei den modernsten Kraftwerken bis zu 45 Prozent, also ähnlich wie bei einem Automotor. Normalerweise könnte man hier dennoch von einem gewissen Vorteil des Kraftwerks ausgehen, da es die meiste Zeit mit einem optimalen Auslastungsgrad gefahren werden kann, während man bei einem Automotor damit rechnen muss, dass er längere Zeit in eher ungünstigen Drehzahlbereichen betrieben wird. Das ist natürlich kein Argument für das Elektroauto, denn der Effizienzverlust bei ungünstigen Drehzahlen gilt selbstverständlich auch für Elektromotoren. Es kommt aber noch hinzu, dass die aktuelle Situation alles andere als normal ist, da die Kohlekraftwerke als Zappelstrom-Lückenbüßer herhalten müssen, womit von einer optimalen Auslastung zumeist keine Rede mehr sein kann. Und wenn der Strom erst einmal erzeugt ist, muss man noch etwa zehn Prozent Verlust für die Übertragung und etwa 20 Prozent für den Batterie-Ladevorgang, bei Schnelladung eher 30 Prozent, dazurechnen. Kaltes Wetter ist auch in dieser Beziehung ein schwerwiegendes Problem, bei Minusgraden kann der Ladeverlust durchaus auf 50 Prozent ansteigen.

Ein weiterer höchst problematischer (und deshalb zumeist unter den Teppich gekehrter) Aspekt von vorgeblichen CO2-Reduzierungstechnologien ist der bei ihrer Produktion anfallende CO2-Ausstoß. Wenn man etwa das bei der Herstellung von Solar- und Windkraftanlagen erzeugte CO2 mitberücksichtigt, so ergibt sich für die „Energiewende“ nicht nur keine Verminderung, sondern vielmehr eine Erhöhung des CO2-Ausstoßes. Bei der Elektro-Mobilität sieht es ähnlich aus: So wurde in einer Studie des schwedischen Umweltministeriums festgestellt, dass die Produktion allein des Akkus für einen Tesla Model S so viel CO2 freisetzt, dass selbst wenn man den zum Laden verwendeten Strom vernachlässigt, es mehr als acht Jahre dauern würde, bis man diese Menge CO2 wieder eingespart hätte; nach dieser Zeitspanne kann man davon ausgehen, dass die Batterie reif für die Verschrottung ist.

Die Elektromobilität reiht sich also nahtlos in den illustren Reigen von „Klimarettungs“-Gimmicks ein, die zwar horrende Kosten und immensen Schaden verursachen, deren Auswirkung auf den CO2-Ausstoß aber praktisch gleich null ist (und das oftmals auch noch in der falschen Richtung). Es führt kein Weg daran vorbei: Die einzige in absehbarer Zukunft verfügbare Technologie, die in der Lage ist, fossile Energie in nennenswertem Umfang zu ersetzen, ist die Kernenergie. Die Alternative ist eine Politik der extremen Energie-„Nachfragevernichtung“, die einen großen Teil der Bevölkerung in nach heutigen Maßstäben dermaßen bittere Armut treiben würde, dass wohl selbst der schlafmützige, obrigkeitshörige deutsche Untertan aufbegehren würde.

Wer keine dieser beiden Optionen haben will, wählt damit automatisch die einzige mögliche Alternative, nämlich den weiteren (und, aufgrund der Abschaltung der Kernkraftwerke, sogar verstärkten) Einsatz fossiler Brennstoffe, egal ob sie in Kraftwerken oder in Automobilen verbraucht werden.

Im Wettstreit zwischen wissenschaftlich-technischer Realität und politisch-ideologischem Dogma hat erstere eine Erfolgsquote von 100 Prozent, und es ist kaum davon auszugehen, dass die E-Mobilität hier eine Ausnahme darstellen wird. Wie lange wird es dauern, bis die Blase platzt? Diese Frage ist für mich auch persönlich direkt relevant: Mein Arbeitgeber, ein Entwickler von elektronischen Steuergeräten für die Automobilindustrie, wurde von einem großen Zulieferer übernommen, vorwiegend um einem neu gegründeten Geschäftsbereich zuzuarbeiten, der die vermeintliche Goldgrube E-Mobilität beackert. Als erstes Projekt wird jetzt an einer Elektroauto-Ladestation gebastelt.

Es stellt sich ein gewisser Déjà-vu-Effekt ein – vor einigen Jahren war ich bei einer Firma beschäftigt, die ein Entwicklungsprojekt für die Solartechnik-Sparte eines großen deutschen Elektrokonzerns unterstützte. Als die Investition in die vermeintliche Zukunftstechnologie sich als Milliardengrab herausstellte und das Projekt (und dann die gesamte Sparte) eingestampft wurde, erwies es sich leider als erforderlich, nach einer neuen Arbeitsstelle Ausschau zu halten. Man sagt zwar, dass sich die Geschichte nie exakt gleich wiederholt, es ist aber wohl vielleicht doch eine gute Idee, die Bewerbungsunterlagen aktuell zu halten.

Dieser Beitrag wurde vom Blog eigentümlich frei übernommen