China: Neuer Schwung beim Ausbau der Kernenergie?

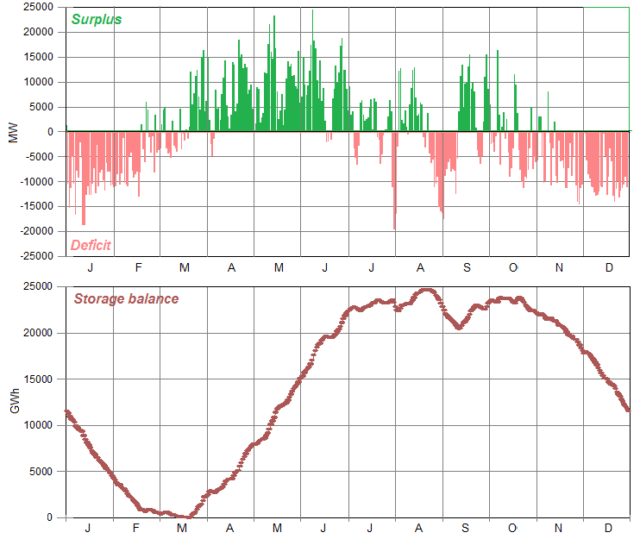

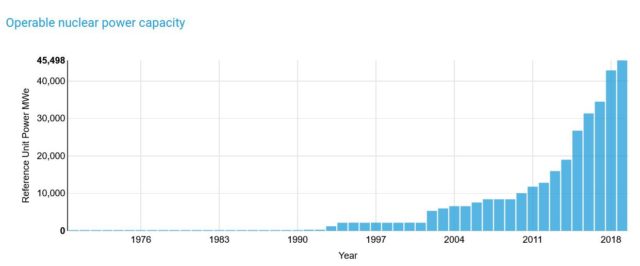

Einer Meldung in der Online-Ausgabe der Hongkonger South China Morning Post zufolge hat Chinas Staatsrat am 12. Mai beschlossen, insgesamt fünf neue Kernkraftwerke errichten zu lassen. Diese Massnahme ist als Auftakt eines langfristigen Bauprogramms zur Errichtung zahlreicher weiterer Kernkraftwerke gedacht. Mit dieser Initiative will das Land schrittweise seiner Selbstverpflichtung zur Deckelung der „Treibhausgas“-Emissionen bis 2030 und der Erreichung von CO2-Neutralität bis 2060 näherkommen. Bei den jetzt vorgesehenen Neubauten handelt es sich um vier klassische KKW’s mit einer Leistung von je 1,2 Gigawatt (GW) sowie einen neuartigen SMR (Small Modular Reactor). Die vier konventionellen Reaktoren sind russische VVER-1200 Kraftwerke, der SMR-Reaktor mit einer Leistung von 125 MW ist der Demonstrator einer chinesischen Eigenentwicklung. Der Bau von zwei der VVER-Reaktoren soll noch in diesem Jahr beginnen, ihre Inbetriebnahme ist für 2026 geplant. Mit diesen Projekten wird die Gesamtkapazität der chinesischen KKW-Flotte, die bisher bei rund 48 GW lag, um rund 10 % zunehmen.

Neue Ausrichtung der Langfrist-Strategie im Kernkraftbereich

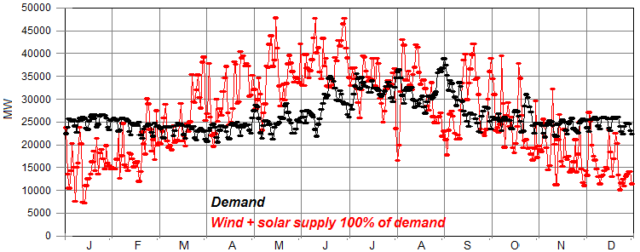

In einem weiteren Artikel der gleichen Online-Ausgabe finden sich interessante Zusatzinformationen, aus denen sich einiges über die Hintergründe und Stoßrichtung der neuen KKW-Strategie herauslesen lässt. Es wird darauf hingewiesen, dass China Solar- und Windenergie als zu unzuverlässig für eine stabile Energieversorgung des Landes einstuft. Andererseits scheint das Land aber auch nicht vollständig oder zumindest überwiegend auf Kernkraft setzen zu wollen. Für diese Änderung der früheren Zielsetzung eines massiven KKW-Zubaus werden drei wesentliche Gründe angeführt: Die Fukushima-Ereignisse, die zunehmende Feindseligkeit des Westens und die geringen Uranreserven des Landes. Darüber hinaus lassen sich nicht nur aus den vorhandenen, sondern auch aus manchen nicht vorhandenen Angaben zusätzliche interessante Schlussfolgerungen ziehen.

Moratorium nach Fukushima

China ist unbestritten ein autoritär regierter Staat. Vielfach wird deshalb unterstellt, die Parteiführung würde einfach durchregieren, ohne sich um die Meinung der Bevölkerung zu scheren. In der Praxis achtet die politische Führung des Landes jedoch sehr darauf, Unmut im Volk zu vermeiden, indem sie dessen Lebensstandard stetig anhebt. Dies gilt auch für die ärmeren Schichten aus den wirtschaftlich unterentwickelten ländlichen Regionen, aus dem auch das Millionenheer der bitterarmen Wanderarbeiter kommt. Diese Haltung der Verantwortlichen erklärt sich aus den Lehren der chinesischen Geschichte. In Deutschland waren die Bauernrevolten des Mittelalters blutig gescheitert. Über Jahrhunderte regierten danach absolutistische Herrscher „von Gottes Gnaden“ nach Gutdünken und Gutsherrenart.

In China wurden dagegen wiederholt missliebige Dynastien von Volksaufständen hinweggefegt. Selbst die Herrschaft der nicht gerade als zimperlich bekannten mongolischen Eroberer fand durch den Aufstand unzufriedener Volksmassenassen ein abruptes Ende. Die heutige Führung, die selbst aus Erben eines erfolgreichen Aufstands verarmter bäuerlicher Massen besteht, hat diese Lektionen nicht vergessen. Deshalb wurden nach den Fukushima-Ereignissen die bisherigen Planungen gestoppt und der weitere Ausbau der Kernkraftflotte weitgehend auf Eis gelegt. Zunächst wollte man die Lehren aus dem ziehen, was in Japan passiert war. Dafür nahm das Land sogar ein mehrjähriges faktisches Moratorium bei dem dringend benötigten Ausbau der Versorgung mit Strom aus Kernkraft in Kauf. Diese Pause wurde für eine umfassende Analyse und Bewertung der Risiken sowie möglicher Verbesserungen der diversen existierenden und in der Entwicklung befindlichen Reaktortypen genutzt. Dies erfolgte unter umfassender Einbeziehung von Fachleuten aus den Bereichen Energieerzeugung und Kernkrafttechnologie.

Besonderer Wert wurde auch auf die Einbeziehung der Öffentlichkeit gelegt. Das im Jahre 2017 veröffentlichte Gesetz über Kernkraftsicherheit enthält deshalb ein eigenes Kapitel über „Offenheit der Informationen und Teilnahme der Öffentlichkeit“. Die Betreiber chinesischer Kernkraftwerke legen daher viel Wert auf Kommunikation mit der Öffentlichkeit, um deren Akzeptanz zu erhöhen.

Man vergleiche dies mit der nonchalanten Art, wie Merkel die Kernenergie per „Ordre de Mutti“ abräumte. Als Feigenblatt diente ihr das Votum einer Ethikkommission aus handverlesenen „Fachleuten“, die über Qualifikationen von Soziologie über Philosophie bis zu höchsten Kirchenämtern verfügten. Energiefachleute hatte man allerdings nicht hinzugezogen.

Zunehmender Druck aus westlichen Ländern

Als zusätzliche Komplikation kam zu diesen innenpolitischen Überlegungen noch ein neuer Trend im politischen Raum hinzu. Spätestens ab 2000 wurde mit dem Amtsantritt von Präsident Bush erkennbar, dass die USA die Konkurrenz durch das industriell aufstrebende China nicht nur als lästig, sondern zunehmend als Bedrohung des eigenen Machtmonopols empfand. Man begann selbst solche Verbündete zu sammeln, deren Ruf eher zweifelhaft war. Schon Bush räumte Indien im Nuklearbereich weitreichende Privilegien ein, obwohl das Land bis heute dem Atomwaffensperrvertrag nicht beigetreten ist. Zu einer zeitlichen Verzögerung kam es dann allerdings aufgrund des Terroranschlags vom 11 September. Infolgedessen konzentrierten sich die USA zunächst auf den Krieg gegen den islamistischen Terror. Dabei verrannte man sich wie auch schon früher in opferreiche und nicht zu gewinnende Konflikte, diesmal in Afghanistan, dem Irak und anderen Ländern. Nach Bush griff Obama die Langfriststrategie gegen China dann mit der „Hinwendung zum Pazifik“ wieder auf und führte die langfristige politische und militärische Neuausrichtung gegen China weiter. Auf diesem Fundament konnte dann der wesentlich aggressiver auftretende Trump die endgültige Ablösung der bisherigen Politik der friedlichen Koexistenz durch eine weitgehende Konfrontation vollenden. Seither und auch unter Biden betreiben die westlichen Industriestaaten unter der Führung der USA eine Politik, die sich immer mehr in Richtung eines kalten Krieges 2.0 entwickelt. Der Westen nimmt hierbei für sich das Recht in Anspruch, von China weitreichende Veränderungen des politischen und sozialen Systems zu fordern, während Versuche Chinas, seinerseits Einfluss in anderen Ländern auszuüben, als „Aggression“ gebrandmarkt werden. Inzwischen hat sich daraus neben einem ständig verschärften Handelskrieg auch eine immer massivere Serie diplomatischer und militärischer Geplänkel entwickelt, durch die sich China in seinen Lebensinteressen bedroht sieht.

Drohende Einkreisung

Mit Blick auf den freien Zugang zum Meer und damit zum weltweiten Handel befindet sich China in einer geographisch ungünstigen Lage. Auf drei Seiten von Landgrenzen umgeben, ist der Zugang zum Pazifik und zum indischen Ozean nur durch einen flachen (und damit leicht zu verminenden) Ozean möglich, der durch einen doppelten Ring von Inselfestungen der USA und ihrer Verbündeten abgeriegelt ist. Eine US-geführte Koalition könnte das ölarme Land daher bequem durch Abriegelung der Handels- und Tankerrouten in die Knie zwingen. Zusätzliche Bedrohungspotenziale ergeben durch einen immer stärkeren Boykott bei wesentlichen Technologien wie der Zusammenarbeit im Weltall oder – gerade ganz aktuell – im Bereich moderner IT-Technologien wie 5G-Netzwerke oder der Chipherstellung. Im Bereich Kernenergie hat China deshalb den Kauf westlich lizensierter Kraftwerkstechnologie heruntergefahren. Stattdessen konzentrierte sich das Land darauf, eigene Reaktortechnologien zu entwickeln – und den Schulterschluss mit Russland zu suchen.

Uran aus dem Meer

Als weiterer Bremsklotz erweist sich für das Land die Abhängigkeit von ausländischen Uranimporten. Die heimischen Reserven von gerade einmal 170.000 Tonnen liegen noch unter denen von Frankreich. Bei einem Baufortschritt von jährlich sechs bis acht Kernkraftwerken würde China schon 2035 jährlich 35.000 Tonnen Uran benötigen. Die eigenen Reserven würden nicht einmal bis dahin reichen. Um sich vom Uranimport unabhängig zu machen, plant China deshalb die Entwicklung einer Anlage zur Gewinnung von Uran aus Meerwasser. Die Ozeane enthalten rund 1.000 Mal mehr Uran, als an Land gewonnen werden kann. Zwar werden die Kosten für die Gewinnung aus dem Meer um mindestens das zehnfache über denen aus bergbaulicher Gewinnung geschätzt, doch könnte sich das Land auf diese Weise eine unabhängige Versorgung sichern. Die Entwicklung dieser Technologie ist allerdings sehr aufwendig, so dass mit einem Durchbruch erst in den 2030er Jahren zu rechnen ist.

Russische Kraftwerke sind ein Signal an den Westen

Von besonderem Interesse dürfte an den obigen Meldungen sein, dass sich China für diesen bedeutsamen Neustart für russische und damit gegen westliche Technologie entschieden hat. Die vier konventionellen Reaktoren werden von russischen Unternehmen gebaut und von chinesischen Gesellschaften finanziert. Das an den Westen damit gegebene Signal ist überdeutlich, denn China dürfte sich in den nächsten Jahrzehnten zum mit großem Abstand weltgrößten Markt für Kerntechnologie entwickeln. Die jetzt angekündigten Reaktoren werden die derzeitige KKW-Kapazität des Landes um rund 10 % erhöhen. Bis 2035 rechnet die China Nuclear Energy Association mit einer Steigerung auf 200 GW. Chinas Gesamt-Stromerzeugung aus allen Technologien liegt derzeit mit ca. 7500 Terawattstunden/ Jahr (TWh/a) rund 11-12 Mal so hoch wie die Deutschlands. Mit der weiter fortschreitenden Industrialisierung des Landes wird sich der Bedarf bis zur Mitte des Jahrhunderts vermutlich um mindestens 50 % erhöhen. Um diesen ohne fossile Kraftwerke zu decken, wird man in China wohl mindestens 1200 GW an nicht-fossiler Stromerzeugung installieren müssen, das entspricht der Kapazität von rund 1.000 KKW.

Natürlich will China an diesem gigantischen Markt künftig auch selbst partizipieren. Aktuell hält man sich jedoch noch zurück, obwohl das Land inzwischen mit dem Hualong 1 über eine ausgereifte eigene Technologie verfügt. Dennoch wird dieser Reaktortyp in den oben erwähnten Meldungen nur im Zusammenhang mit dem geplanten neuen Modell Hualong 2 erwähnt, dessen Ersterrichtung ab 2024 beginnen soll. Der Bau des Hualong 2 soll lediglich 2.000 US-$/kWe kosten und in vier statt der bisher erforderlichen fünf Jahre erfolgen. (Zum Vergleich: Europäische Reaktoren des EPR-Typs wie Flamanville und Olkiluoto kosten ca. 10.000 US-$/kWe bei Bauzeiten von teils > 10 Jahren). Anhand solcher Vergleiche wird deutlich, welche Bedeutung der Kernenergie in Asien zukommen wird. Allein der chinesische Markt für Kernkraftwerke dürfte bis 2050 ein Volumen von mehreren 1.000 Mrd. US-$ haben, vom Weltmarkt ganz zu schweigen. Auf diesem Zukunftsmarkt werden Russland und später auch China den Ton angeben, während Deutschland und Europa die selbstgewählte Rolle des Windbeutels spielen dürften.

Quellen:

https://deutsche-schutzgebiete.de/wordpress/projekte/kolonien/kiautschou/

http://german.china.org.cn/txt/2019-08/02/content_75060373.htm

https://www.sueddeutsche.de/politik/atomwaffensperrvertrag-das-indische-problem-1.889347