Zwei Kurzmeldungen des Heartland Institute

Stärke von Hurrikanen nimmt seit 80 Jahren ab

Auf seinem Wissenschafts-Blog schreibt der mit Preisen bedachte Meteorologe Roy Spencer, PhD, ein Grundlagenforscher an der University of Alabama in Huntsville UAH, dass trotz der massiven Schäden durch den Hurrikan Florence „es in der Vergangenheit häufiger starke Hurrikane gab (Kategorie 3 oder höher), die auf das Festland übergetreten waren. Derartige Ereignisse haben im Mittel in den USA seit den dreißiger Jahren um über 50% abgenommen“.

Im Gegensatz zur Stärke von Hurrikanen, sind alle der kostspieligsten Hurrikane in der US-Historie (ohne Todesfälle) seit den dreißiger Jahren aufgetreten. Grund hierfür ist aber nicht die zugenommen habende Stärke der Hurrikane, sondern ausschließlich die gewaltige Zunahme der Anzahl von Menschen, welche nahe der Küste leben und die samt ihrer Infrastruktur anfällig für Hurrikane sind. Da immer mehr Menschen in Küstengebieten leben und dort Luxushotels, Eigentumswohnungen und Appartment-Häuser aus dem Boden schießen, haben sich die Kosten für Schäden durch einen auf das Festland übergreifenden Hurrikan drastisch verteuert.

Quelle: Dr. Roy Spencer Blog

————————————

Klimawandel ist unabhängig von atmosphärischem Kohlendioxid

Die Forscher bei CO2Science haben jüngst eine 2017 im Journal Climate erschienene Studie zusammengefasst, der zufolge das Niveau des atmosphärischen Kohlendioxidgehalts über die gesamte geologische Historie keine Relation zu Temperaturen oder Klimabedingungen zeigt.

Der Autor der Studie, W. Jackson Davis, PhD, Direktor des Environmental Studies Institute, analysierte eine umfassende Gruppe empirischer Datensätze, welche 6680 Proxy-Temperaturwerte und 831 Proxy-Kohlendioxid-Messungen enthalten, um die Relation zu untersuchen zwischen historischen Temperaturen und atmosphärischem Kohlendioxid über 522 Millionen Jahre vor heute bis jetzt. Davis sagt, dass seine Datengruppe „bis heute die genaueste quantitative, empirische Evaluierung der Relation zwischen atmosphärischen CO2-Konzentrationen und Temperatur ist“.

Davis fand über Millionen von Jahren weder eine kausale Verbindung noch eine Korrelation zwischen Kohlendioxid-Niveau und Temperatur.

Beispielsweise berichtet Davis, dass „ein Spitzenwert der Kohlendioxid-Konzentration vor 415 Millionen Jahren nahe einem Temperaturminimum vor 445 Millionen Jahren lag, und dass CO2-Spitzenwerte vor rund 285 Millionen Jahren zeitlich mit einem Temperaturminimum vor etwa 280 Millionen Jahren zusammenfielen“. Ultimativ kommt Davis zu dem Ergebnis: „Über 95% der Temperatur-Varianz über Millionen von Jahren erklärt sich durch nicht identifizierte Variablen, aber nicht mit der atmosphärischen Konzentration von Kohlendioxid“. Davis weiter: „Diese Ergebnisse bestätigen frühere Ergebnisse auf der Grundlage von Untersuchungen des Klimas im Paläozän, dass ,das globale Klima vermutlich unabhängig ist von Variationen der atmosphärischen Kohlendioxid-Konzentration’“.

Davis schließt: „Korrelation bedeutet nicht Kausalität, aber fehlende Korrelation beweist endgültig das Fehlen jedweder Kausalität“.

Quellen: CO2 Science; Climate

Link zu beiden Kurzbeiträgen: https://www.heartland.org/news-opinion/news/new-nipcc-report-highlights-benefits-of-fossil-fuels

Übersetzt von Chris Frey EIKE

Bemerkung: Der Hauptbeitrag in diesem Rundbrief kommt als separater Beitrag demnächst.

Die Vorschrift bzgl. Erneuerbare würde die Armen in Arizona hart bestrafen

Unglücklicherweise hat Steyer seinen politischen und umweltlichen Aktivismus nicht nur auf den Südwesten [der USA] beschränkt. Er gab über 1 Million seines Privatvermögens zur Förderung von NextGen America aus, also für seinen politischen Arm zur Verschärfung der Vorschriften bzgl. der Erzeugung aus Erneuerbaren. Ähnliches tat er in Nevada und Michigan, wo er bereits einen Teilerfolg einstreichen konnte. In diesem Staat konspirierte er mit den beiden größten Versorgern, um die Verpflichtung zur Erzeugung aus Erneuerbaren bis zum Jahr 2030 auf 25% zu schrauben. Dabei hat Steyer den Staat hintergangen, hat er doch seine Agenda impliziert, ohne die Einwohner von Michigan oder deren gewählte Vertreter zu konsultieren.

„Der Prozess einer Wähler-Initiative ist nicht offen für eine Konversation“, sagt der Sprecher von Tucson Electric Power Joe Salkowski. „Es ist eine Vorschrift, in Kraft gesetzt ohne Rücksicht auf das, was individuelle Versorger machen und welche individuellen Gemeinden in der Lage sind, das zu bezahlen“.

Salkowski hat recht. Vorschriften bzgl. erneuerbarer Energie, auch bekannt unter der Bezeichnung Renewable Portfolio Standards RPS, zwingen den Strom- und Steuerzahlern den schwer subventionierten Wind- und Solarstrom auf. Mit den steigenden Energiepreisen und den behaupteten, praktisch aber nicht vorhandenen Vorteilen für die Umwelt sind derartige Vorschriften ein lose-lose für Steuerzahler und Verbraucher.

Wie stark werden RPS-Vorschriften subventioniert? Pro erzeugter Einheit Energie erhält die Windindustrie 35,33 Dollar pro Megawattstunde an Subventionen seitens der Regierung. Die Solarindustrie erhält sogar atemberaubende 231,21 Dollar pro MWh. Im Gegensatz dazu erhalten die Kohle- und Petroleum-Industrie gerade mal jeweils 0,57 Dollar bzw. 0,67 Dollar pro MWh.

Im Jahre 2014 fand die Brookings Institution, dass Windenergie doppelt so teuer ist wie die von ihr ersetzte konventionelle Energie. Inzwischen ist Solarenergie sogar dreimal so teuer. Folglich kommt der Autor zu dem Ergebnis, dass „Anreize für Erneuerbare zugunsten von Wind und Solar verzerrt sind … sie sind ein sehr teurer und ineffizienter Weg, Kohlendioxid-Emissionen zu reduzieren“.

So ist es keine Überraschung, dass die Energiepreise in Staaten mit Vorschriften bzgl. Erneuerbarer doppelt so schnell steigen wie im nationalen Mittel [der USA]. Einer Studie aus dem Jahr 2016 zufolge betrugen die Gesamtkosten der Vorschriften bzgl. Erneuerbarer in nur 12 Staaten 5,76 Milliarden Dollar im Jahre 2016 und werden bis zum Jahr 2030 auf 8,8 Milliarden steigen. Tucson Electric Power schätzt, dass diese Vorschriften die Stromrechnungen der lokalen Verbraucher um über 500 Dollar pro Jahr steigen lassen werden.

Ganz offensichtlich sind höhere Energiepreise eine drückende Last für die Bürger von Arizona, und jedwede Politik, die Preise für Unabdingbares wie Strom steigen lässt, wird Familien mit niedrigem Einkommen unverhältnismäßig stark belasten. Mehr Geld für Strom bedeutet weniger Geld für Nahrungsmittel, Miete, Kleidung, medizinische Ausgaben usw. Und zum Sparen bleibt gar nichts übrig.

Falls man wohlhabend ist, wird einen die Zunahme der Stromkosten irritieren, aber kein ernstes Problem darstellen. Allerdings leben bereits über 1,2 Millionen Bürger Arizonas, das sind fast 18% der Gesamtbevölkerung dieses Staates, in etwas, dass man „Energiearmut“ nennt. Das bedeutet, dass sie mindestens 10% ihres Jahreseinkommens für Energie aufbringen müssen. In Maricopa County beispielsweise mussten Haushalte mit Einkommen unter 50% des staatlichen Armutsniveaus 18% ihres Einkommens für Energie ausgeben.

Für diese Menschen zählt jeder Penny. Sie sollten nicht vor die Wahl gestellt werden zwischen Wohngeld einerseits und Strom für Licht und Heizung andererseits – nur wegen eines linken Lieblingsprojektes irgendeines Milliardärs.

Obwohl Kalifornien mit einer Vielfalt von billigen Energie-Ressourcen gesegnet ist, muss man in dem Staat mit Abstand die höchsten Preise für Strom im Westen der USA zahlen. Über sechs Millionen Bürger des Staates leben in Energiearmut. Der Strompreis in dem Staat ist um 47% höher als in Arizona und um 70% höher als in den Nachbarstaaten Nevada und Oregon.

Falls Steyer Erfolgt hat, wird die Energiezukunft von Arizona genauso düster aussehen wie sie in Kalifornien bereits ist.

[Originally Published at American Spectator]

Link: https://www.heartland.org/news-opinion/news/steyers-renewable-mandate-would-punish-arizonas-poor

Übersetzt von Chris Frey EIKE

Amerika spielt die Nukleare Energiekarte: Gesetz für fortschrittliche Technik ist unterzeichnet

Vor der Wahl von Donald J Trump waren die USA wirtschaftlich im Abriss begriffen, bestimmt von den Renditegierigen mit erneuerbaren Energien und den Öko-Ideologen, die sich für ihre Sache einsetzen. Zahlreiche amerikanische Staaten, nicht zuletzt Texas und Kalifornien, sowie die Prärien im Mittleren Westen wurde von teuren und chaotischen subventionierten Wind- und Sonnenenergieanlagen überrollt.

Die Strompreise in diesen Staaten sind unweigerlich hochgeschnellt – von Wind und Sonne „versorgte“ Kalifornier zahlen 40% mehr für den Strom als der US-Durchschnitt – und bedrohen damit die heimische amerikanische Industrie und mehr als 1 Million Arbeitsplätze, nach einer US-Studie.

Dann kam Donald Trump und alles änderte sich.

Audrey Zibelman, eine der lautesten Verfechterinnen von Wind- und Sonnenenergie in den USA, wurde aus der Stadt [New York] vertrieben und landete in Australien – wo sie eindeutig entschlossen ist, die ehemals erschwinglichen und zuverlässigen Stromversorgungen auf dieselbe Weise zu zerstören, wie sie es in New York und darüber hinaus gerne getan hätte, hätte Hillary Clinton im Jahr 2016 das Oval Office übernommen.

Die durchschnittlichen Verbraucherstrompreise in den USA liegen bei rund 1/3 der Strompreise, die in Australien bezahlt werden müssen und Trump will das natürlich auch so halten.

Das amerikanische Engagement für den Pariser Klimavertrag aufzugeben, war nur eine von vielen Maßnahmen, die der Präsident ergriffen hat, um sicherzustellen, dass die USA, nicht zuletzt als Energiesupermacht, außergewöhnlich bleiben.

Ein weiterer Schritt in diese Richtung, ist die Verbesserung der beneidenswerten Kernkraftwerke der USA, um auf die nächste Generation von noch sichereren und effizienteren Anlagen umzurüsten.

Präsident Donald Trump hat ein neues Gesetz unterzeichnet, das die Entwicklung fortschrittlicher Reaktoren in den Vereinigten Staaten beschleunigen wird. Dieses Gesetz passierte sowohl den US Congress als auch den Senat [der Nuclear Energy Innovation Capabilities Act (NEICA) (S.97). Das Gesetz weist das Energieministerium an, die Grundlagen zu schaffen, für eine vielseitige Neutronenquelle für Forschungszwecke mit niedrig angereichertem Uran.[ „.. high-assay, low-enriched uranium“- ich hoffe, es ist korrekt übersetzt, der Übersetzer]

Mit dem Gesetz über die Innovation der Kernenergie,

werden einige der finanziellen und technologischen Barrieren beseitigt, die einer nuklearen Weiterentwicklung im Weg stehen. Es stellt auch ein starkes Engagement der Regierung dar, den kommerziellen Nuklearsektor zu unterstützen und sicherzustellen, dass die USA ihre Führung in der Welt behält.

Die Bestimmungen im NEICA (… Gesetz) bauen auf den erfolgreichen öffentlich-privaten Partnerschaften auf, die durch das Gateway for Accelerated Innovation in Nuclear (GAIN) ermöglicht werden [~ Cluster…], das die Entwicklung und den Einsatz fortgeschrittener Reaktortechnologien beschleunigt.

„In Amerika gibt es derzeit einige wirklich umwälzende und fortschrittliche Nukleartechnologien, und diese Gesetzesvorlage stärkt nur die fortgesetzten Bemühungen dieser Regierung, die Atomindustrie wiederzubeleben“, sagte Ed McGinnis, stellvertretender Hauptsekretär des Amtes für Atomenergie.

Durch Senkung der Zulassungskosten fördert NEICA die Zusammenarbeit zwischen dem öffentlichen und dem privaten Sektor und wird dazu beitragen, einen Teil der Anfangskosten für die Lizenzierung neuer Reaktoren auszugleichen.

Der Gesetzentwurf sieht ein Kostenbeteiligungsprogramm vor, um einen Teil der Lizenzgebühren abzudecken, die von der US Nuclear Regulatory Commission während ihres Überprüfungsprozesses für neue Reaktortechnologien erhoben werden.

Die Gesetzgebung weist das Energieministerium auch an, mit Plänen zur Entwicklung einer schnellen Neutronenquelle (dh. eines schnellen Testreaktors) fortzufahren, um die Entwicklung von fortschrittlichen Reaktorbrennstoffen und -materialien zu beschleunigen.

Eine solche Testeinrichtung existiert in den Vereinigten Staaten nicht und wird benötigt, um neue Reaktormaterialien und Brennstoffe für den Einsatz in fortschrittlichen Reaktoren zu testen.

Weiterhin steht im Gesetz, die Einrichtung von Demonstrationsanlagen für fortgeschrittene Reaktorforschung durch Partnerschaften zwischen Energieministerium und der privaten Industrie zu erleichtern.

Schließlich verlangt die Gesetzesvorlage vom Energieministerium, das Know-how im Bereich Hochleistungsrechner zu erweitern, indem es sich auf die Modellierung und Simulation fortschrittlicher Kernreaktoren konzentriert, um deren Entwicklung weiter zu beschleunigen.

Die nationalen Labors, Universitäten und der private Sektor werden dazu beitragen, neue Software und Werkzeuge für Entwickler zu entwickeln, mit denen sie ihre Forschung an Spalt- und

Was kommt als nächstes?

Energieminister Rick Perry wird 180 Tage Zeit haben, um dem Kongress einen Bericht vorzulegen, der die Fähigkeiten des Energieministeriums zur Aufnahme und zum Betrieb experimenteller und fortgeschrittener Kernreaktoren in den nationalen Labors oder anderen Standorten bewertet. Weiterhin sind auch zwei 10-Jahres-Budgetpläne für die nukleare Forschung & Entwicklung einzureichen.

Gefunden auf Stopthesethings vom 06.10.2018

Übersetzt durch Andreas Demmig

***

Als Abspann eine Karikatur zur Situation in Deutschland

Petition: GEGEN DAS DIKTAT DER ÖKOLOGIE – FÜR FAIRE MEDIEN UND DIE RODUNG DES HAMBACHER FORSTES!

PRO LAUSITZER BRAUNKOHLE E.V. & INITIATIVEN VON PRO LAUSITZER BRAUNKOHLE E.V.

Immer teurere und ineffektivere Klimaziele

Nur eine massive und weltweite Transformation von Stromverbrauch, Transportwesen und Landwirtschaft kann den Temperaturanstieg um 2°C verhindern. Genau dazu haben sich Nationen im Pariser Klima-Abkommen verpflichtet.

In einem Kommentar zu dem Report sagte der norwegische Umweltminister Ola Elvestuen: „Wir bewegen uns viel zu langsam. Wir müssen mehr schneller tun. Um die Ziele des Paris-Abkommens zu erreichen brauchen wir große strukturelle Änderungen“.

Das Problem: Regierungen tun sich immer schwerer, die Bevölkerung von den radikalen Restriktionen bzgl. fossiler Treibstoffe sowie von fundamentalen Änderungen ihrer Lebensweise zu überzeugen, um den Pariser Klima-Verpflichtungen gerecht zu werden. Dabei zeigen schon die IPCC-eigenen Berechnungen, dass diese Verpflichtungen unzureichend sind, um den befürchteten Temperaturanstieg zu verhindern. Die Menschen verstehen nicht, dass die minimalen Vorteile des Klimawandels nur dann zu erreichen sind, wenn sie Opfer bringen, welche ihnen einen niedrigeren Lebensstandard beschert.

Selbst für die minimalen, von Regierungen durchgeführten oder geplanten Maßnahmen muss man schon einen hohen Preis zahlen.

Im Jahre 2016 und dann wieder 2018 beispielsweise hat das Repräsentantenhaus Resolutionen zugestimmt, in denen eine Steuer auf Kohlendioxid-Emissionen zurückgewiesen wird, haben doch Forschungen gezeigt, dass schon eine so geringe Steuer wie 28 Dollar pro Tonne zu verminderter ökonomischer Aktivität führen, während der nächsten vier Jahrzehnte bis zu 21 Millionen Arbeitsplätze kosten und die Löhne der Arbeiter um 8,5% sinken lassen wird. Eine andere, separat durchgeführte Studie ergab, dass eine Kohlenstoff-Steuer von 37 Dollar pro Tonne zu einem Verlust des gesamtwirtschaftlichen US-Bruttoinlandproduktes von über 2,5 Billionen Dollar führen würde. Das bedeutet über 21.000 Dollar Einkommensverlust pro Familie – und bis zum Jahre 2030 den Verlust von über 500.000 Arbeitsplätzen im produzierenden Gewerbe und über 1 Million Arbeitsplätze allgemein.

Die kanadische Zeitung Financial Post berichtet, dass die von Premierminister Justin Trudeau ins Spiel gebrachte Kohlenstoff-Steuer von 50 Dollar pro Tonne die Haushalte in Nova Scotia mit 1120 Dollar pro Jahr zu stehen kommt, in Alberta sind es 1111 Dollar pro Jahr. In beiden Provinzen bewirkt diese Steuer die höchsten Preissteigerungen für Energie. Selbst in Quebec und Manitoba, wo die Energiepreise aufgrund der Steuer am wenigsten steigen werden, müssen Haushalte immer noch jeweils 662 bzw. 683 Dollar mehr pro Jahr für Strom bezahlen.

Es kommt für die Kanadier aber noch schlimmer. Die Financial Post berichtet von vielen Experten, die sagen, dass eine zur Verhinderung einer Katastrophe ausreichenden Reduktionen von Kohlendioxid-Emissionen mit bis zu 100 Dollar pro Tonne besteuert werden müssen.Bei einem solchen Szenario „werden die Haushalte in Alberta bis zu 2223 Dollar, in Saskatchewan 2065 Dollar und in Nova Scotia 2240 Dollar berappen müsse. Tatsächlich wird der mittlere Preis für Haushalte bei einer Steuer von 1000 Dollar pro Tonne deutlich über 1000 Dollar pro Jahr liegen“. So weit die Financial Post.

Als Reaktion auf steigende Energiepreise haben die Premierminister von vier kanadischen Provinzen beschlossen, die Steuern, Programme und Abgaben in ihren Provinzen zu kassieren, welche den Bürgern auferlegt worden waren, um Trudeaus Kohlenstoff-Steuer umzusetzen.

All dies kommt vor dem Hintergrund, dass neuen Forschungen zufolge der Preis von Kohlendioxid viel höher als derzeit sein müsste, um die vermeintliche Klimakatastrophe zu verhindern. …

Politiker, welche damit konfrontiert sind, von den Wählern aus dem Amt gewählt zu werden aufgrund deren Unwillen, höhere Strompreise zu zahlen für immer unzuverlässig fließenden Strom und dafür den hohen Preis für Kohlenstoff zahlen sollen, sagen aber, dass eben dies notwendig ist zur Vermeidung einer Katastrophe. Führende Politiker in Australien, Brasilien und Kanada distanzieren sich öffentlich von ihren Verpflichtungen zur Reduktion von Kohlenstoff-Emissionen, obwohl sie unwillig sind, sich explizit aus dem Paris-Abkommen zurückzuziehen, wie Präsident Trump es vorgemacht hatte. In China, Europa und Japan verleihen politische Führer ihrer Treue zu dem Abkommen Ausdruck, während sie ihre Emissions-Reduktionsziele verfehlen, still und leise neue Kohle- und Gaskraftwerke genehmigen und mehr durch fossile Treibstoffe angetriebene Fahrzeuge verkaufen.

Aber ich habe gute Nachrichten. Allen vorliegenden Beweisen zufolge verursachen die Menschen nicht eine Klima-Apokalypse. Das bedeutet, dass ein Scheitern von Paris völlig in Ordnung und sogar wünschenswert ist, weil die Annullierung desselben mehr und preiswertere Energie für alle bedeutet.

H. Sterling Burnett

Quellen: The Hill; IHS Markit; Anti-Carbon Tax Coalition 2018; Anti-Carbon Tax Coalition 2016; Financial Post; Vox

Link: https://www.heartland.org/news-opinion/news/increasingly-costly-ineffective-climate-targets

Übersetzt von Chris Frey EIKE

Die Zukunft sagt: Atomkraft, ja bitte! Aufruf zum Nuclear Pride Fest

Ist Afrika klüger als Deutschland?

Die entsprechende Nachricht ist in den Energy News vom 10.4.2018 zu finden. Kenia baut ein 1 GW Kohlekraftwerk neuesten Typs in Lamu. Die Hintergründe für diese Entwicklung sind von hier aus schlecht zu beurteilen. Auf jeden Fall sind – wie schon seit längerem in Afrika – anscheinend auch die Chinesen irgendwie mit dabei. Und insbesondere sind auch die USA engagiert, welche als größte Geldgeber der Weltbank und des IMF diesen beiden Institutionen kritisch gegenüberstehen und gleichzeitig im Board der Afrikanischen Entwicklungsbank sitzen.

Der entscheidende Punkt scheint jedoch zu sein, dass der IMF seine Finanzierung an „Erneuerbare“ geknüpft hat und dies die inzwischen rechnenden afrikanischen Nationen für verhängnisvoll halten. Vielleicht waren ja einige Regierungsvertreter inkognito in Deutschland und haben sich über die deutsche Energiewende schlau gemacht. Das hätte bereits genügt.

Südafrika, Botwana und Zimbabwe gewinnen bereits den größten Anteil ihrer elektrischen Energie aus Kohleverbrennung. Australien, Bangladesh, Indien und natürlich an erster Stelle China bauen sie weiter aus. Generell ist eine Steigerung der Kohleverbrennung und der Trend zu neuen, modernen Kohlekraftwerken mit Filtern gegen Ruß, Aerosole und Staub (nicht gegen CO2, das kann man nicht wegfiltern) insbesondere in den ehemaligen Entwicklungsländern zu beobachten.

Wenn Deutschland mit der Energiewende so fortfährt und nicht komplett dem Energiewendewahnsinn den Garaus macht, hat dies zumindest doch einen Vorteil. Unsere Volkswirtschaft wird sich steigender Einnahmen aus dem Tourismus erfreuen. Einem Tourismus aus den oben genannten Entwicklungsländern, der staunend Zeuge sein will, wie sich ein ehemaliges modernes Industrieland selbst entleibt. Das ist touristisch sicher spannender als immer wieder nur Landschaften, alte Bauwerke und Museen zu besuchen.

Wenn etwas schlechter wird, hat die Schuld immer der Klimawandel …

Deutsche Stromversorgung bleibt verlässlich, aber …

Die Pressemitteilung der Bundesnetzagentur [2] dient dem Zweck, den deutschen Untertanen zu vermitteln, dass das EEG ein Segen für unser Energiesystem ist und alle bösen Stimmen, welche Probleme vermitteln wollen, Unrecht haben. Wenn es überhaupt Probleme gibt, dann ist es der Klimawandel mit seinen unerbittlichen Folgen:

BNetzA: [2] Vizepräsident Franke: „Deutsche Stromversorgung bleibt verlässlich“ … Die Energiewende und der steigende Anteil dezentraler Erzeugungsleistung haben weiterhin keine negativen Auswirkungen auf die Versorgungsqualität“, so Franke weiter …

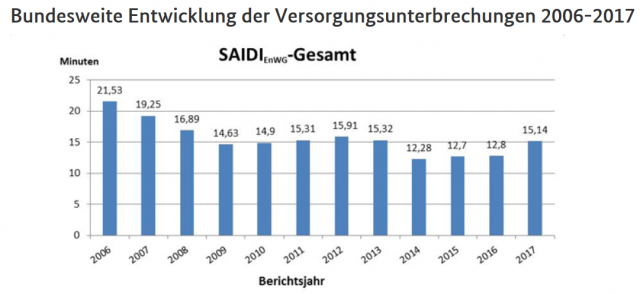

Allerdings wurde auch festgestellt, dass zwischen dem Jahr 2017 und dem Jahr 2016 die Länge der Ausfallzeiten angestiegen ist:

BNetzA: [2] … Im Jahr 2017 lag die durchschnittliche Unterbrechungsdauer je angeschlossenem Letztverbraucher in der Nieder- und Mittelspannung bei 15,14 Minuten. Im Jahr 2016 lag sie bei 12,80 Minuten ...

Doch liegt das selbstverständlich nicht am EEG, sondern dem bekannten Erdzerstörer (AGW-)Klimawandel, der wie allgemein bekannt, auch Deutschland mit zunehmendem Extremwetter „geißelt“ [3]:

BNetzA: [2] … Anstieg wegen extremer Wetterereignisse

… Ausfallzeiten im Verteilnetz, deren Ursache in Wetterereignissen liegen, haben sich gegenüber dem Vorjahr mehr als verdoppelt. Hierunter fallen beispielsweise Stürme, Hochwasser oder Schnee … „Ursache für den Anstieg der Versorgungsunterbrechung in Mittel- und Niederspannungsebene sind vor allem die Zunahme extremer Wettereignisse.

Was die Bahn vormacht – bei schlechtem Wetter den Zugverkehr einzustellen – weil man ihr solches nicht zumuten kann, scheint man bei der Stromversorgung wohl auch anzudenken.

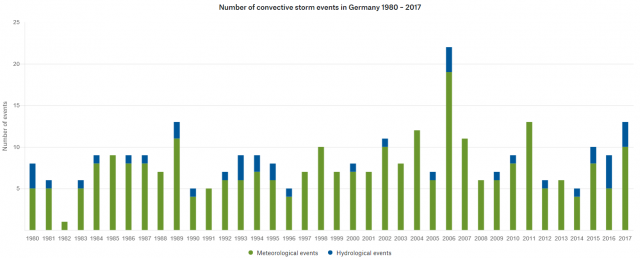

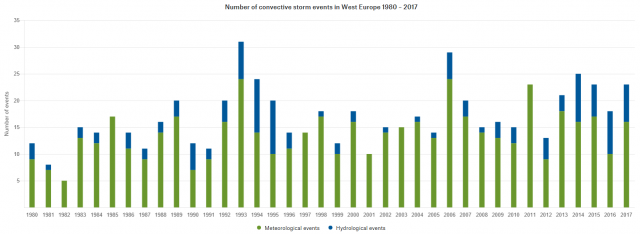

Nun gibt es in Deutschland aber keine Zunahme von Extremwetter …

Und so stellt sich die Frage: wie kommt die Bundesnetzagentur auf ihre Aussage, dass der Anstieg der Länge der Ausfallzeiten vom Jahr 2016 auf das Jahr 2017 zunehmenden, extremen Wetterereignissen geschuldet ist?

Vergleichen wir dazu die Extremereignisse dieser beiden Jahre.

Wetterrückblick Deutschland zum Jahr 2016

DWD 29.12.2016: Deutschlandwetter im Jahr 2016

… Weit überdurchschnittliche Niederschlagssummen im Januar und Februar 2016 beendeten die große Trockenheit, die 2015 vor allem im Süden und in der Mitte Deutschlands geherrscht hatte. Während Deutschland in den vorangegangenen Aprilmonaten oft mit frühsommerlichen Temperaturen verwöhnt worden war, brachte diesmal ein Kaltlufteinbruch im letzten Drittel Schnee bis ins Flachland. Ende Mai und im Juni entluden sich schwere Gewitter mit extremen Regenfällen, die örtlich zu katastrophalen Überflutungen führten. Damit war in der ersten Jahreshälfte 2016 an zahlreichen DWD-Stationen schon mehr Niederschlag gefallen als im ganzen Jahr 2015. Dann stellte sich die Großwetterlage um: Die folgenden Monate blieben teils erheblich zu trocken, ab Juli rollten mehrere Hitzewellen heran. Der September gehört zu den drei wärmsten seit Aufzeichnungsbeginn 1881, der Oktober und November blieben zu kühl. Der Dezember verlief zwar deutlich kälter als im Jahr 2015, aber fast genauso schneearm.

Wetterrückblick Deutschland zum Jahr 2017

2017 war ein Jahr der Wetterextreme

02.01.2018 – 2017 war erneut ein sehr warmes Jahr, unbeständig und oft extrem. Vizepräsident Dr. Becker berichtet darüber unter anderem in Tagesschau und Tagesthemen.

Das Wettergeschehen zeigte im Jahresverlauf oft wenig Beständigkeit, dafür aber immer wieder extreme Ausprägung. Der Januar begann mit teilweise strengen Nachtfrösten, die zahlreiche Gewässer zufrieren ließen. Im Februar schien der Winter bereits auf dem Rückmarsch zu sein: Im Flachland fiel verbreitet keine einzige Schneeflocke. Der März war sogar der wärmste seit Messbeginn 1881. Im April folgte dann jedoch ein jäher Kälterückfall mit Minusgraden, der sich katastrophal auf die schon sehr weit fortgeschrittene Vegetation auswirkte. Nach nass-kühlem Beginn rollte bereits Ende Mai die erste Hitzewelle heran. Der Sommer präsentierte sich im Süden sehr heiß, im Norden eher kühl. Dabei herrschte zunächst Trockenheit, im Juli und August fiel dann oft reichlich Niederschlag. Auch der September verlief nass und dabei etwas zu kühl. Der Oktober gehörte dann wieder zu den wärmsten seit 1881. Die Orkane „Xavier“ und „Herwart“ forderten Menschenleben und verursachten große Schäden. Anfang November begann eine längere Niederschlagsperiode mit nur wenigen trockenen Tagen, die bis zum Jahresende anhielt. In der Adventszeit fiel gelegentlich auch im Flachland etwas Schnee, der jedoch bei Tauwetter immer wieder rasch verschwand.

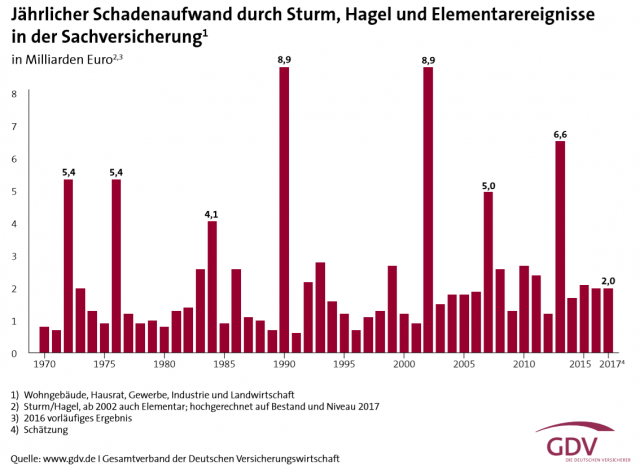

Was sagte ein Versicherer dazu:

GDV 27.12.2017: Naturgefahrenbilanz 2017

… Wie bereits im Jahr 2016 fällt die Naturgefahrenbilanz 2017 mit erneut 2 Milliarden Euro Versicherungsleistung unterdurchschnittlich aus: Es wüteten nur wenige, regional begrenzte Unwetter. Schon diese Wetterlagen können hohe Schäden verursachen; große Naturkatastrophen blieben 2017 allerdings aus.

Was war dazwischen der Extremwetter-Unterschied?

Die Bundesnetzagentur berichtet als Ursache der „Probleme“:

BNetzA: [2] … Hierunter fallen beispielsweise Stürme, Hochwasser oder Schnee …

Nun gab es Hochwasser und Schnee nicht im Jahr 2017, sondern im Jahr 2016. Nur bei den Stürmen war das Jahr 2017 extremer. Das vom DWD für 2017 gemeldete „Jahr der Wetterextreme“ bezog sich vor allem auf Temperatursprünge und „reichlich Niederschlag“, der allerdings keinesfalls extrem war.

Die Obstbäume haben darunter – vor allem von der Frühjahrskälte – sehr, teils extrem gelitten. Dass ein elektrisches Versorgungssystem auch davon beeinflusst würde, ist aber kaum anzunehmen.

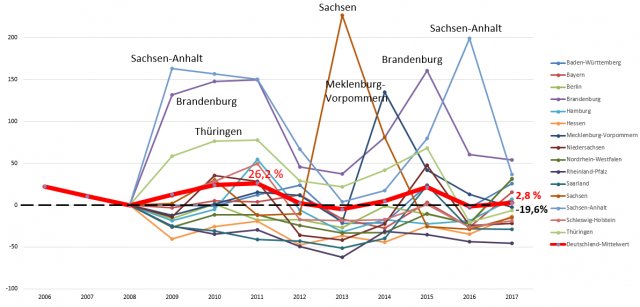

Und somit bleibt, dass von den drei gemeldeten „Extremeinflüssen“ zwei im Jahr 2016 heftiger waren. Das dritte – Stürme – im Jahr zwar stärker, im längerfristigen Verlauf aber nicht herausragend (Bild 1.2).

Dabei ist diese Betrachtung, kurze Zeiträume, hier sogar nur eine Jahresdifferenz, als „Anstieg wegen extremer Wetterereignisse“ deuten zu können, vollkommen unsachlich, aber inzwischen leider in der Berichterstattung von (politisch gelenkten) Organisationen Standard. Solche Betrachtungen sind jedoch zur Generierung von „Extremen“ erforderlich, da auch in Deutschland mittel- und langfristig keinerlei Zunahme von AGW-Klimawandel-bedingten Extremereignissen messbar ist:

EIKE 6. Oktober 2018: Das FAZ-Klima-Interview vom 2.10.2018: Nachdem sie das Ziel endgültig aus den Augen verloren hatten, verdoppelten sie ihre Anstrengungen

EIKE 09. September 2018: [3] Deutschland in den Klauen des Klimawandels

kaltesonne

Unwetter in Europa: Nicht mehr Überflutungen als früher (3.6.2018)

Hessischer Starkregen aus dem Juli 2014 eine Folge des Klimawandels? Eher unwahrscheinlich. Statistiken zeigen eine Abnahme schwerer sommerlicher Regengüsse während der letzten 100 Jahre (21.8.2014)

Deutscher Wetterdienst: Es gibt in Deutschland keinen Trend zu heftigeren Regenfällen (8.6.2016)

Eine unbequeme Wahrheit: Während der Kleinen Eiszeit waren die Stürme in Europa stärker als heute (5.8.2012)

PIK endlich einmal mit guten Nachrichten: Sturmaktivität der nördlichen mittleren Breiten hat signifikant abgenommen (3.10.2016)

Neue begutachtete Studie in Nature Climate Change: Klimawandel lässt Hochwasser in Europa wohl in Zukunft seltener werden (11.6.2013)

Wie sehen die Versorgungsdaten eigentlich aus?

Interessant wird es (wieder), wenn man sich die Versorgungsdaten bei der Bundesnetzagentur selbst ansieht, grafisch aufbereitet und betrachtet, welche Aussagen daraus abgeleitet werden können.

Für die Grafiken vorab die Erklärung der verwendeten Kenndaten:

Die Bundesnetzagentur ermittelt aus den von den Netzbetreibern übermittelten Daten zu Versorgungsunterbrechungen mit einer Dauer über drei Minuten bestimmte Kennzahlen.

Kennzahlen bzw. Indizes

SAIDIEnWG (System Average Interruption Duration Index)

Spiegelt die durchschnittliche Versorgungsunterbrechung je angeschlossenen Letztverbraucher innerhalb eines Kalenderjahres wieder.

ASIDIEnWG (Average System Interruption Duration Index)

Spiegelt die durchschnittliche Versorgungsunterbrechung je angeschlossenen Bemessungsscheinleistungen innerhalb eines Kalenderjahres wider.

SAIDIEnWG-Gesamt

Summe aus dem SAIDIEnWG und dem ASIDIEnWG

Zuerst das Gesamtbild, wie es die BNetzA zeigt. Die Darstellung der Gesamtzeit der Versorgungsunterbrechungen seit dem Jahr 2006 zeigt keinen verschlimmernden Einfluss durch einen „Anstieg wegen extremer Wetterereignisse“. Nur ist richtig zu erkennen, dass das Jahr 2017 gegenüber dem Vorgängerjahr leicht schlechter ist, der Gesamttrend aber seit dem Jahr 2006 deutlich zu niedrigeren Versorgungsunterbrechungen zeigt. Ein negativer Trend, oder eine signifikante Trendumkehr ist daraus nicht ableitbar.

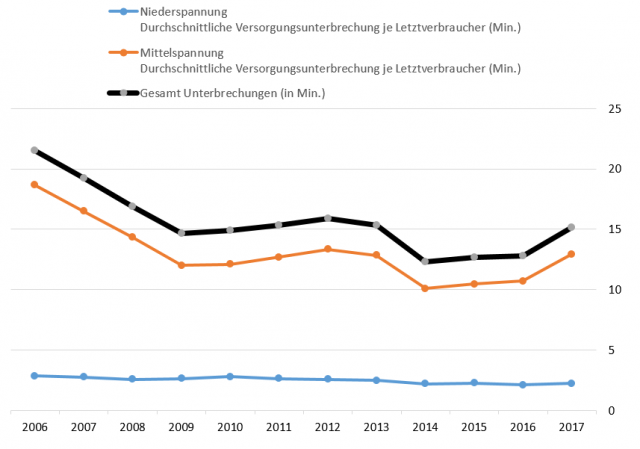

Im folgenden Bild 3 sind anhand der verfügbaren Einzeldaten die Unterbrechungen nach Netzart dargestellt. Man sieht, dass Die Ausfallzeiten im Niederspannungsnetz fast durchgehend gleich bleiben, eher abnehmen, nur im Mittelspannungsnetz nahmen sie das eine Jahr von 2016 auf 2017 etwas deutlicher zu.

Trotzdem textet die BNetzA;

BNetzA: [2] … „Ursache für den Anstieg der Versorgungsunterbrechung in Mittel- und Niederspannungsebene sind vor allem die Zunahme extremer Wettereignisse.

Von der BNetzA lassen sich auch die Daten der einzelnen Bundesländer laden. Dann sehen die Verläufe wie im folgenden Bild 4 aus. Dabei ist zu beachten, dass die BNetzA-Daten anstelle mit dem Jahr 2006 wie in der vorhergehenden Übersichtsgrafik, erst mit dem Jahr 2008 beginnen. Dann hat das Jahr 2017 einen „Zuwachs“ seit 2008 von 2,8 % (was nicht mehr als statistisches Rauschen ist). Seit dem Jahr 2011 aber eine Verringerung von -24 %!

Ergänzt man jedoch die fehlenden, zwei Anfangsjahre, dann weist das Jahr 2017 plötzlich eine Verringerung um -19,6 % aus!

Schlägt der Klimawandel nur im (falsch wählenden) Osten zu?

Auffallend am Bild 4 ist, dass sich herausragend schlechte Netzdaten auf wenige, ausschließlich im Osten gelegene Länder konzentrieren, von denen aber trotzdem die meisten von 2016 auf 2017 eine Verbesserung zeigen. Und es fällt natürlich auch auf, dass trotzdem in Summe eine Verbesserung und vor allem weder langfristig, noch kurzfristig, keinerlei Verschlechterungstendenz vorliegt.

Es kann aber unmöglich sein, dass sich der „schlimme Einfluss“ der „Zunahme extremer Wettereignisse“ ausgerechnet auf wenige, im Osten konzentrierte Bundesländer beschränken sollte.

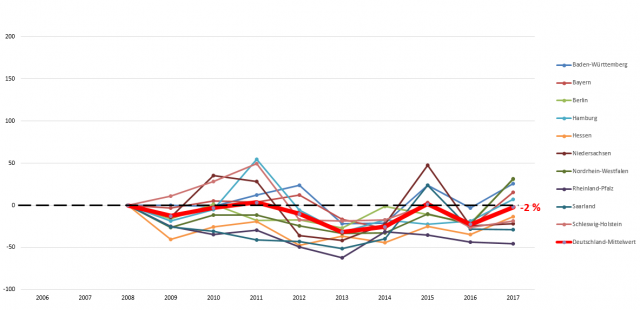

Nimmt man die Ost-Versorgungsgebiete (welche ausschließlich im Bereich des Betreibers 50herz liegen) weg (Bild 5), verhalten sich die Schwankungen der Versorgungsstabilität auf einmal vollkommen normal und in einer „sinnvollen“ Schwankungsspanne. Wirklich nichts – auch nicht die geringste Spur – lässt auf den signifikanten Einfluss oder eine signifikante Einfluss-Zunahme von Extremereignissen schließen.

Die Frage stellt sich, wie der unerbittliche Klimawandel mit seinem angeblich schon zunehmendem Extremwetter sich so konsequent auf die Ost-Versorgungsgebiete eines Betreibers „beschränkt“.

Dafür muss – und wird – es ganz andere Erklärungen geben. Zum Beispiel könnte die Folgende ein kleiner Hinweis sein:

energatemessenger 02.01.2018 [4] … Dass der Netzausbau zur Stabilisierung der Kosten für Redispatch- und Einspeisemanagement-Maßnahmen beiträgt, zeigt das Beispiel „Thüringer Strombrücke“. Die Kuppelleitung wurde im November 2017 vollständig in Betrieb genommen und ist ein wesentlicher Faktor, warum sich die Engpasskosten im Netzgebiet des ostdeutschen Übertragungsnetzbetreibers 50 Hertz stabilisiert haben.

Und somit kann man schon einmal über die BNetzA-Pressemitteilung eine Aussage treffen:

Die BNetzA in Vertretung durch ihren Vizepräsidenten Franke, hat in ihrer Pressemitteilung wie üblich, in vorauseilendem Gehorsam bewusst eine politisch gewünschte Klimawandel-Tendenzaussage „dazugedichtet“.

Der Autor hat dazu bei deren Pressestelle nachgefragt und ist auf die Antwort gespannt.

Wenn es nicht am Klimawandel liegt, wer könnte trotzdem einen Trend hervorrufen?

Die bisherige Darstellung zeigt, dass die Netzstabilität – bezogen auf die Länge der Ausfallzeiten – stetig besser geworden ist.

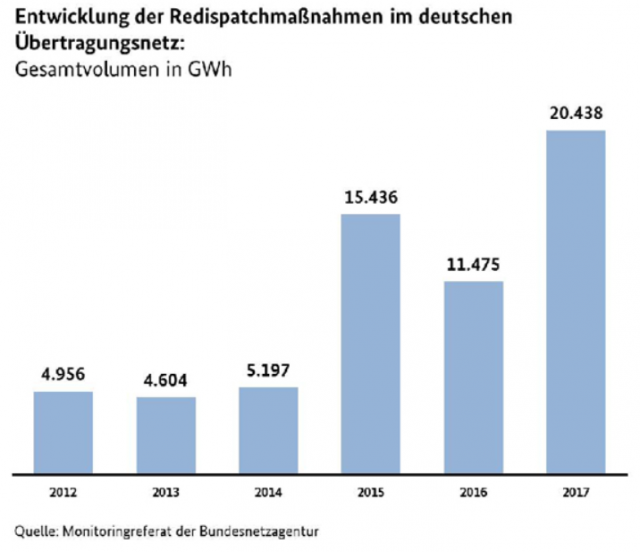

Allerdings kaschieren diese Darstellungen vollständig bereits im System erkennbare und wirklich stetig zunehmenden Probleme, welche die BNetzA in ihrer Pressemitteilung allerdings verschwiegen hat. Es gibt sie bereits massiv und bald werden Blackouts folgen.

Die Kosten haben wir schon, die Verschlechterung kommt noch

Allerdings nicht wegen eines sich ständig verändernden Klimas, sondern genau wegen dem, was offiziell nicht sein darf:

BNetzA: [2] … Die Energiewende und der steigende Anteil dezentraler Erzeugungsleistung haben weiterhin keine negativen Auswirkungen auf die Versorgungsqualität“, so Franke weiter …

Dass es bisher keine negativen Auswirkungen hat, ist ausschließlich der gerade noch technisch möglichen Netzstabilisierung zu verdanken und diese kostet schon aktuell (den privaten Strombeziehern, die es fast ausschließlich bezahlen müssen) eine Menge Geld:

energatemessenger: [4] Bayreuth/Berlin (energate) – Die Kosten zur Stabilisierung des Stromnetzes sind auf ein Rekordniveau gestiegen. Beim Übertragungsnetzbetreiber Tennet belaufen sich die Kosten für netzstabilisierende Maßnahmen für das Jahr 2017 auf voraussichtlich mehr als eine Mrd. Euro, gab das Unternehmen bekannt. Dieser Höchstwert entspreche einem Zuwachs von etwa 50 Prozent gegenüber 2016 (660 Mio. Euro). Im bisherigen Rekordjahr 2015 betrug der Wert 710 Mio. Euro … „Wir haben mehr denn je damit zu tun, das Netz zu stabilisieren“, sagte Tennet-Geschäftsführer Lex Hartman. Grund für den hohen Einsatz von Netz- und Systemsicherheitsmaßnahmen sei der unzureichende Netzausbau, der mit dem Erneuerbarenumbau nicht Schritt halte. „Bis das Energiewende-Netz gebaut ist, werden wir das Stromnetz weiter mit teuren Notmaßnahmen stabilisieren müssen“, so Hartman. Besserung sei nicht in Sicht: „Ich sehe für die nächsten Jahre keine Entspannung. Bevor es besser wird, wird es erst einmal schlechter.“

Die Versorger und die Politik wissen um die kommende Problematik und bauen schon für den ersten Blackout (und die folgenden) vor:

EIKE 02.11.2016: Verwundert, weil ihr Stadtteil dank EEG zeitweise keinen Strom bekommt? Auf unserer Homepage wurde doch darüber informiert!

Die Süddeutsche Zeitung meldete es am 6./7.Oktober 2018 als eine grandiose, dem Fortschritt dienende Maßnahme:

SZ: Intelligenter Strom – Bayernwerk weiht Europas modernste Energieanlage ein

… hat die Bayernwerk AG am Freitag in Dachau ihre neue Leitstellen-Technologie in Betrieb genommen. Sinn und Zweck der 22 Millionen teuren Hard- und Software ist es, künftig flexibel und effizient auf ein Zuviel oder Zuwenig an eingespeistem Strom und Bedarf reagieren zu können … somit haben die Betreiber die Kontrolle über Einspeisung und Verbrauch, Zustand der Leitungen, Störungen und sogar über Wind und Wetter … Personal spart sich das Bayernwerk dadurch nicht. „Geht die Entwicklung so weiter, müssen wir sogar noch mehr Techniker einstellen“ ...

“Intelligenz“ beginnt in Deutschland, wenn ein Schalter betätigt werden kann

Die im SZ-Artikel von der Redakteurin, dem Staatssekretär Pschierer und dem Bayernwerk als Betreiber hochgelobte, „modernste Energieanlage Europas“ liefert also „Intelligenten Strom“.

Dazu muss man seine eigene schon sehr stark reduzieren (so man sie vorher hatte), um dem Strom eine Intelligenz zu geben. Denn diese „Energieanlage“ liefert keine Energie, sondern macht nichts weiter, als Strom zu- und abzuschalten, wenn zu wenig, oder zu viel vorhanden ist. Und natürlich ermittelt und verrechnet sie die Kosten, mit denen die Verbraucher zu belasten und die Profiteure zu belohnen sind.

Der Autor kann dem Zu- und Abschalten von Strom trotzdem nach wie vor keine besondere „Intelligenz“ einräumen und schon gar nicht feststellen, dass der Strom dank dieser „Schulung“ irgendwie eine Intelligenz bekommen hätte.

Spinnt man diese „Intelligenz“ nämlich weiter, dann haben die Mangel-Stromversorgungen in Afrika weltweit die größte Intelligenz. Da die (Strommangel-)Schaltungen dort nicht von teuren Computersystemen, sondern direkt von Menschen „gelenkt“ und ausgeführt werden, sind diese wohl auch die intelligentesten auf der Welt ….

Aber Intelligenz durch Schaffen eines in sich stabilen Versorgungssystems – wie es über viele Jahrzehnte in Deutschland weltweit beispielhaft war – ist „langweilig“ und entspricht nicht mehr modernen Zeiten. Vor allem konnte am früheren, inhärent stabilen Energiesystem kein Wählerklientel verdienen:

EIKE 18.05.2017: Rechnerisch lohnt sich die solare Eigenversorgung nicht – so lange unser Versorgungsnetz stabil ist. Doch das wird sich ja ändern

EIKE 14.04.2018: Die wundersame Speicherung des EEG-Zappelstroms, oder: Die nächste Abzocke privater Stromkunden durch die EEG-Energieernter

Von einem modernen System erwartet „man“ keine Stabilität, sondern fordert, dass es hip ist:

EIKE 27.07.2017: Der letzte Enabler hat ja einen super Elevator-Pitch hingelegt, aber ohne Blockchain sehe ich da keine scalability

Damit Deutschland Intelligenz ausreichend bekommt, wird entsprechend ausgebildet

Die Wahl-Werbeslogans der Parteien sind inzwischen so schlecht und nichtssagend, dass man fast Beliebiges in sie hineininterpretieren kann. Bei einer Partei könnte man interpretieren, dass sie einen Slogan, der aus der Maobibel – oder modifiziert, aus der ehemaligen DDR – stammen könnte verkündet: „Übersetzt“: Zuerst indoktrinieren wir die Kinder, dann indoktrinieren diese die Welt, nun auch in Bayern umsetzen will.

Dazu passt, was man im Bund angeblich vorhat: Den Untertanen soll die Nutzung alternativer Information endlich eingeschränkt werden. Zu Viele Untertanen zeigen inzwischen „eingeschränkte Kompetenz“, was die Politik zunehmend beunruhigt:

Die Lokalzeitung des Autors hat das auch schon festgestellt. Die unter 18 dürfen inzwischen ja wählen üben. Das erste Ergebnis zeigte, dass die 12- bis 17jährigen in Bayern doppelt so oft GRÜN wählen (würden), als die Erwachsenen und nur verschwindend die AFD. Die Lokalredaktion konnte sich im Bericht vor Begeisterung über die politische Sachkunde der heutigen Jugendlichen und deren vorbildliches Wahlverhalten kaum bremsen.

Quellen

[1] ZDF 05.10.2018 : Bundesnetzagentur – Weniger Stromausfälle gemeldet

[2] BNetzA 05.10.2018: Versorgungsunterbrechungen Strom 2017

[3] EIKE 09. September 2018: Deutschland in den Klauen des Klimawandels

[4] energatemessenger 02.01.2018:Netzstabilität Kosten für Netzeingriffe auf Rekordniveau

Wer nichts weiß, muss alles glauben

Der Klimawandel-Alarmismus nimmt schon wieder schrille Töne an. Der Ausschuss für Klimaänderungen*) trompetet wieder Warnungen in die Welt. Einen Sonderbericht hat er veröffentlicht. Die Lückenmedien können sich gar nicht lassen vor Begeisterung mitzutrompeten.**)Beispiele dafür sind diese: „Klimarat: Jetzt helfen nur noch radikale Maßnahmen“ – „Klimabericht befeuert Debatte um den Kohleausstieg. Umweltschützer sehen sich durch Weltklimarast bestätigt“ – „Klimawandel: Die Zeit drängt. UN-Experten fordern rasches Handeln“ – „Jetzt mal schnell die Welt retten“ – „Erderwärmung: Lübecks Kampf gegen das Wasser“ – „Die Welt geht unter, macht was draus“. So tönen sie ihrem Publikum entgegen, das – weil dauerhaft indoktriniert – tief ergriffen und entsetzt ist, weil es nicht sämtliche Fakten kennt, auch nicht kennen kann, denn sie werden ihm vorenthalten. Da wir mit diesen Alarmtönen schon so lange und immer wieder traktiert werden, muss man auch immer wieder dagegenhalten.

Gegen den Klimawandel und CO2 der Natur kann der Mensch nichts ausrichten

Klimawandel in der Erdgeschichte hat es immer gegeben – im Wechsel Eiszeiten, Kaltzeiten, Warmzeiten. Niemand kann es bestreiten, es tut auch niemand. Das ist Natur, dagegen lässt sich nichts ausrichten. Eines Tages ist die Erzählung aufgetischt worden, das CO2 in der Lufthülle der Erde sei ein Gas, das wie in einem Treibhaus von Gärtnern die Erde erwärme. Auch dagegen kann der Mensch, wenn es denn so wäre, nichts machen. Aber zu dem natürlichen CO2 kommt von Menschen erzeugtes CO2 hinzu, nämlich durch das Verbrennen fossiler Rohstoffe (Kohle, Erdgas, Erdöl), um deren Energie in elektrische oder andere Energie umzuwandeln.

Gegner der Klimaschutzpolitik sind Geschäftsverderber und werden bekämpft

Ja, das ist Tatsache. Doch ebendieses menschengemachte (= anthropogene) Kohlendioxid – so wird uns gesagt – heize das Erdklima auf. Doch gibt es genug Wissenschaftler, die gegenteilige Informationen bieten. In meinen eigenen Beiträgen auf dieser Seite reiche ich sie weiter. Es sind weit über hundert. Sie finden sie alle hier und hier und hier. Mehr noch finden Sie bei dem Verein EIKE, der sich Europäisches Institut für Klima und Energie nennt (hier) und von Wikipedia (hier) und den Profiteuren der Klimaschutzpolitik als unglaubwürdig hingestellt wird. Klar, es verdirbt ihnen den erfundenen, hoch lukrativen Geschäftszweig. Diese Geschäftsverderber werden folglich bekämpft. Alle EIKE-Beiträge zur Klimaschutzpolitik hier.

Willfährig gemacht durch Alarmismus und Lücken-Information

Auch der neue Sonderbericht des IPCC dient dem Ziel, für die Menschen akzeptabel und hinnehmbar zu machen, dass anthropogenes Kohlendioxid ein „Klima-Killer“ ist, dass daher abgeschafft gehört und es folglich gerechtfertigt ist, Milliarden und Aber-Milliarden für das hehre Ziel auszugeben. Der neue Bericht soll die Menschen zusätzlich willfährig machen – willfährig durch Alarmismus und Lücken-Information. Das Leiden, dem sie durch die Klimaschutzpolitik ausgesetzt sind, ist ein politisch und geschäftlich erzwungenes Leiden. Daher darf es nicht sein, dass der Klimawandel n i c h t menschengemacht, n i c h t anthropogener Art ist. Da viele Wissenschaftler und nahezu sämtliche Politiker dies seit vielen Jahren herunterbeten, glauben es die Leut’. Solange sie nicht kundiger gemacht werden, solange sie sich nicht aus Eigenantrieb kundiger machen, was im Internet unschwer möglich ist, werden Sie glauben müssen, was ihnen vorgebetet wird. Wer nichts weiß, der muss alles glauben.

___________________________________________________________________

*) Vollständiger Name: Zwischenstaatlicher Ausschuss für Klimaänderungen (Intergovernmental Panel on Climate Change, abgekürzt IPCC). Näheres über ihn, aber mit Vorsicht zu lesen, bei Wikipedia hier.

**) Die Zitate stammen aus der Frankfurter Allgemeinen Zeitung (FAZ)vom 8. und 9. Oktober und aus den Lübecker Nachrichten vom 9. Oktober.

Dei Beitrag erschien zuerst auf dem Blog des Autors hier

Brandaktuell: Untersuchung des Globale-Erwärmung-Datensatzes zeigt, dass er von Fehlern wimmelt

Vom IPCC:

Globale Erwärmung um 1,5°C – ein Sonderbericht des IPCC zu den Auswirkungen einer globalen Erwärmung um 1,5°C über das vorindustrielle Niveau und damit zusammenhängende Treibhausgas-Emissionen im Zusammenhang mit der Intensivierung der globalen Bemühungen gegen die Bedrohung des Klimawandels, nachhaltige Entwicklung und Bemühungen zur Bekämpfung der Armut.

Das hat man nun von Konsens-Wissenschaft – groupthink ohne Qualitätskontrolle.

HadCRUT4 ist der primäre, vom IPCC herangezogene globale Temperatur-Datensatz für dessen dramatische Behauptungen über eine „vom Menschen verursachte globale Erwärmung“. Es ist auch der Datensatz im Mittelpunkt von „Klimagate 2009“, gemanagt von der Climate Research Unit (CRU) an der East Anglia University.

Die Überprüfung ergab über 70 bedenkliche Bereiche – bedenklich hinsichtlich der Qualität und der Präzision der Daten.

Einer Analyse des australischen Forschers John McLean zufolge ist der Datensatz viel zu schlampig, um selbst von Klimawissenschaftlern ernst genommen werden kann, geschweige denn von einer so einflussreichen Institution wie dem IPCC oder von den Regierungen der Welt.

…

Wesentliche Punkte:

● Die Hadley-Daten sind unter den von den wichtigsten Datensätzen am meisten angeführten Daten zur Klima-Modellierung und damit für politische Maßnahmen, bei denen Milliarden von Dollars involviert sind.

● Mclean fand sonderbar unglaubwürdige Daten sowie systematische Adjustierungs-Fehler, große Lücken ohne irgendwelche Daten, Fehler bei der Zuordnung von Standorten, Grad Fahrenheit, die als Grad Celsius angegeben worden sind, und Rechtschreibfehler.

● Es wurden keinerlei Qualitätskontrollen durchgeführt: Ausreißer, welche offensichtliche Fehler sind, wurden nicht korrigiert – eine Stadt in Kolumbien soll im Jahre 1978 drei Monate lang eine mittlere tägliche Temperatur von über 80°C aufgewiesen haben. Eine Stadt in Rumänien sprang direkt aus dem Sommer des Jahres 1953 in einem Frühlingsmonat mit minus 46°C. Dies sind vermeintlich „mittlere“ Temperaturen für einen ganzen Monat insgesamt. Aus St. Kitts, einer Insel in der Karibik, wurde einen ganzen Monat lang eine Temperatur von 0°C aufgezeichnet – und das zwei mal!

● Die Temperaturen der gesamten Südhemisphäre im Jahre 1850 und der folgenden drei Jahre beruhen auf einer einigen Station in Indonesien und einigen zufälligen Schiffsbeobachtungen.

● Wassertemperaturen der Ozeane repräsentieren 70% der Erdoberfläche, aber einige Messungen stammen von Schiffen, welche von Standorten 100 km landeinwärts geortet wurden. Andere Meldungen stammen von Schiffen in Häfen, wo die Wassertemperatur kaum repräsentativ für den offenen Ozean sein dürfte.

● Wenn ein Thermometer an einer anderen Stelle aufgestellt wird, lässt die Adjustierung vermuten, dass die alte Messstelle immer zugebaut war und „aufgeheizt“ wurde durch Beton und Gebäude. In Wirklichkeit kam die künstliche Erwärmung schleichend daher. Mittels einer Korrektur aufgrund von Gebäuden, die im Jahre 1880 noch gar nicht existierten, wurden alte Aufzeichnungen künstlich kälter gemacht. Adjustierungen von nur wenigen Änderungen der Messorte können ein ganzes Jahrhundert lang künstliche Erwärmungstrends erzeugen.

Details der schlimmsten Ausreißer

● Im April, Juni und Juli 1978 meldete die Station Apto Uto (Kolumbien, ID:800890) eine mittlere monatliche Temperatur von jeweils 81,5°C; 83,4°C und 83,4°C.

● Die Monats-Mitteltemperatur vom September 1953 in der rumänischen Stadt Paltinis wird mit -46,4°C angegeben (in anderen Jahren betrug das September-Mittel etwa 11,5°C).

● Am Golden Rock Airport auf der Karibikinsel St. Kitts werden für Dezember 1981 und 1984 mittlere monatliche Temperaturen von 0,0°C gemeldet. Aber von 1971 bis 1990 betrug das Mittel in allen anderen Jahren 26,0°C.

Mehr dazu bei Jo Nova.

Der Report

Unglücklicherweise liegt der Report hinter einer Zahlschranke. Aber die beträgt nur 8 Dollar.

Der Forscher John McLean führte seine Forschungen ausschließlich auf eigene Kosten durch, so dass ihm die Zahlschranke ein wenig Ausgleich bietet für die Zeit und Mühe, die er aufgebracht hat. Er schreibt:

Dieser Report basiert auf einer Aufgabenstellung für meine PhD-Arbeit. Ich erhielt meinen PhD im Dezember 2017 von der James Cook University in Townsville, Australien. Die Aufgabenstellung beruhte auf dem HadCRUT4-Datensatz und damit zusammenhängenden Datensätzen mit Stand von Ende Januar 2016. Dabei wurden 27 bedenkliche Umstände hinsichtlich des Datensatzes erkannt.

Die Versionen vom Januar 2018 der Datensätze enthielten nicht nur Aktualisierungen für die inzwischen vergangenen 24 Monate, sondern auch zusätzliche Messpunkte und daraus resultierende Änderungen der monatlichen globalen mittleren Temperatur-Anomalie bis zurück zum Beginn des Datensatzes im Jahre 1850. Der Report zieht die Daten vom Januar 2018 heran und überarbeitet die Analyse der ursprünglichen These bzw. erweitert diese, manchmal mit dem Weglassen unbedeutender Dinge, manchmal mit der Aufteilung wichtiger Themen und manchmal mit der Analyse neuer Bereiche. Die Ergebnisse werden in diesem Report beschrieben.

Die These wurde von Experten außerhalb der Universität unter die Lupe genommen, mit Bezug auf die Kommentare der Inspektoren überarbeitet und dann von der Universität akzeptiert. Der Prozess war zumindest äquivalent zu einem „peer review“, wie es von wissenschaftlichen Journalen durchgeführt wird.

Ich habe eine Ausgabe gekauft und daraus die folgende executive summary erstellt. Ich empfehle jedem dringend, ebenfalls eine Ausgabe zu kaufen und seine Arbeit zu unterstützen.

EXECUTIVE SUMMARY

Soweit ich weiß, ist dies das erste Audit des HadCRUT4-Datensatzes, also des Haupt-Datensatzes, der die Grundlage bildet für Klimazustands-Berichte des IPCC. Regierungen und das UNFCCC stützen sich schwer auf die IPCC-Berichte, so dass unabdingbar ist, dass die Temperaturdaten präzise und zuverlässig sind.

Diese Überprüfung zeigt, dass nichts dergleichen der Fall ist.

Über 70 Bereiche wurden untersucht, welche den gesamten Prozess abdecken von der Messung der Temperaturen bis zur Erstellung des Datensatzes, den daraus abgeleiteten Daten (wie etwa Mittelwerte) und deren eventueller Veröffentlichung. Die Ergebnisse (in kompakter Form in Anhang 6 gezeigt) enthalten sogar einfache Dinge wie offensichtlich falsche Daten, beschönigte Mängel von Daten, bedeutende, aber fragwürdige Hypothesen und Temperaturdaten, die unrichtig auf eine Art und Weise adjustiert worden sind, dass sie Erwärmung übertreiben.

So wurden beispielsweise Stationen gefunden, aus denen mittlere monatliche Temperaturen über 80°C vorlagen, zwei Beispiele einer Station in der Karibik mit gemeldeten mittleren Dezember-Temperaturwerten um 0°C und eine Station in Rumänien mit einer Meldung über ein September-Temperaturmittel um -45°C, wo doch das typische Septembermittel etwa 10°C beträgt. Als Clou des Ganzen gibt es auch Meldungen von Schiffen, die Standorte angaben, welche über 80 km landeinwärts liegen.

Es scheint, dass die Lieferanten der Temperaturdaten von Land und See keinerlei Checks auf grundlegende Fehler durchgeführt haben, und die Personen, welche den HadCRUT4-Datensatz erzeugten, haben diese Fehler nicht gefunden und auch keinerlei Fragen gestellt.

Das Verfahren zur Erstellung des Datensatzes hat einige Fehler entfernt, aber es wurde ein Satz von zwei Werten verwendet, berechnet aus einem Teil der Daten, aus denen jedoch vor der Berechnung die Fehler nicht korrigiert worden waren.

Datenmangel ist ein reales Problem. Der Datensatz beginnt im Jahre 1850, aber über zwei Jahre lang zu Beginn der Aufzeichnungen stammten die Festlands-Daten der Südhemisphäre von einer einzigen Station in Indonesien. Nach fünf Jahren gab es in jener Hemisphäre ganze drei Stationen. Globale Mittelwerte werden aus den Mittelwerten von jeder der beiden Hemisphären berechnet, so dass diese wenigen Stationen einen enormen Einfluss auf das haben, was vermeintlich „global“ genannt wird. Bezogen auf die Anzahl der Daten ist der Prozentsatz der Welt (oder der Hemisphäre) welche die Daten abdecken. Dem Verfahren der Berechnung der Abdeckung mit Daten in dem Datensatz zufolge wurden 50% der globalen Abdeckung erst im Jahre 1906 erreicht und 50% der Südhemisphäre erst im Jahre 1950.

Im Mai 1861 betrug die globale Abdeckung gerade mal 12% – weniger als ein Achtel. In vielen der Jahre von 1860 bis 1880 bestand die vermeintlich globale Abdeckung nur aus Europa sowie den Haupt-Schiffsrouten und Häfen, also nur etwa 13% der Erdoberfläche. Um aus diesen Daten Mittelwerte zu berechnen und sich auf diese als „globale Mittelwerte“ zu berufen muss man schon sehr leichtgläubig sein.

Ein weiteres bedeutendes Ergebnis dieses Audits ist, dass viele Temperaturwerte unsachgemäß adjustiert worden sind. Die Adjustierung von Daten zielt darauf ab, eine Temperaturaufzeichnung zu erzeugen, welche sich ergeben hätte, falls man an den gegenwärtigen Messpunkten und mit der Ausrüstung derselben die Temperatur vor Ort gemessen hätte. Adjustierungen werden typischerweise vorgenommen, wenn eine Station oder deren Instrumentierung verändert wurde.

Ein typisches Verfahren der Daten-Adjustierung ist es, alle zuvor gewonnen Messdaten um den gleichen Betrag zu verändern. Die Anwendung dieses Verfahrens Fälle mit graduellen Änderungen (wie etwa eine wachsende Großstadt die wahre Temperatur zunehmend beeinflusst), ist sehr falsch und führt dazu, dass die früheren Daten stärker adjustiert werden als man es hätte tun sollen. Messpunkte können häufig versetzt worden sein, und wenn man alle Daten zuvor jedes Mal adjustiert, können die frühesten Daten weit unter ihrem korrekten Wert liegen, womit der ganze Datensatz einen übertriebenen Erwärmungstrend zeigt.

Unter dem Strich lautet die Schlussfolgerung, dass die Daten in keiner Weise für globale Studien geeignet sind. Daten vor 1950 leiden unter geringer Abdeckung und sehr wahrscheinlichen falschen Adjustierungen der Stationsdaten. Daten nach jenem Jahr wiesen zwar eine bessere Abdeckung auf, haben aber immer noch das Problem der Daten-Adjustierung sowie die ganze Vielfalt der anderen, in dem Audit untersuchten Dinge.

Eine Berechnung der korrekten Temperaturen würde eine riesige Menge detaillierter Daten, Zeit und Mühe erfordern, was über diese Untersuchung hinausgehen würde und vermutlich unmöglich ist. Die primäre Schlussfolgerung des Audits lautet jedoch, dass der Datensatz eine übertriebene Erwärmung zeigt und dass globale Mittelwerte viel weniger sicher sind als behauptet.

Eine Implikation der Untersuchung ist, dass Klimamodelle frisiert wurden, damit deren Ergebnisse zu falschen Daten passen. Das verfälscht ihre Prophezeiungen zukünftiger Temperaturen und Schätzungen des menschlichen Einflusses auf die Temperatur.

Eine weitere Implikation ist, dass die Prämisse des Pariser Klima-Abkommens, nämlich die Mittelwerte der Jahre 1850 bis 1899 als „indikativ“ für die Temperaturen in vorindustrieller Zeit anzusehen, grundfalsch ist. Während jenes Zeitraumes war die globale Abdeckung mit Daten gering – nicht mehr als 30% über jenen Zeitraum – und viele Temperaturwerte vom Festland sind sehr wahrscheinlich exzessiv adjustiert worden und daher falsch.

Eine dritte Implikation ist, dass selbst falls die Behauptung des IPCC korrekt wäre, dass also die Menschheit für den größten Teil der Erwärmung seit 1950 verantwortlich ist, dann wäre die Größe einer solchen Erwärmung über die vergangenen 70 Jahre immer noch vernachlässigbar. Dann erhebt sich die Frage, ob die Mühen und Kosten, dieser zu begegnen, überhaupt in irgendeiner Weise Sinn machen.

Die Meinung des Autors ist ultimativ, dass der HadCRUT4-Datensatz und jedwede darauf beruhende Berichte oder Behauptungen in keiner Weise eine glaubwürdige Grundlage sind für Klimapolitik oder internationale Abkommen hinsichtlich der Gründe des Klimawandels.

Der ganze Report steht hier

————————————

Auch der Karikaturist Josh, dessen Karikaturen verwendet werden dürfen, hat sich schon gedanken zum jüngsten IPCC-Bericht gemacht:

Josh: Der neue IPCC-Bericht ist ein Kunstwerk

Der Karikaturist Josh konnte schon vor der Veröffentlichung des IPCC SR 15-Berichtes darin Einblick nehmen und meint, dass ein technisches Wert hoch moderner Kunst ist:

Ich frage mich, was ist dieser Report wert?

Link: https://wattsupwiththat.com/2018/10/07/josh-the-new-ipcc-report-is-a-work-of-art/

Übersetzt von Chris Frey EIKE

Colorado sollte seinen riskanten Energie-Plan noch einmal überdenken

Wir würden es sehr begrüßen, wenn uns Andere folgen. Die Kommentarfunktion des PUC findet sich hier.

Dem Energieplan zufolge sollen zwei Kohleenergie-Erzeugungseinheiten mit einer kombinierten Kapazität von 660 MW vorsorglich abgeschaltet und durch verschiedene Windparks ersetzt werden. Während viele [US-]Staaten die Hinwendung zu erneuerbarer Energie vorgeschrieben haben, ist Colorado der erste Staat mit der Forderung, Kohle vollständig durch Windkraft zu ersetzen. Das kann so nicht funktionieren und gibt daher ein denkbar schlechtes Vorbild.

Es gibt drei große Bereiche, die zu erheblichen Bedenken Anlass geben, nämlich (1) riskante Angebote, (2) das offensichtliche Fehlen eins fairen Wettbewerbs und (3) das Risiko eines längeren Stromausfalls bei schwachem Wind zu Zeiten der stärksten Nachfrage.

Hier folgen nun die drei spezifischen Forderungen von CFACT. Sie werden danach kurz erklärt:

1.Wir fordern mit allem Respekt, dass das PUC eine sorgfältige Überprüfung der Angebote eines jeden Anbieters vornimmt bzgl. der Projekte, die sie anbieten. Außerdem sollte das PUC angemessene Notfallpläne entwickeln für den Fall des Scheiterns.

2.Wir fordern mit allem Respekt, dass das PUC genau unter die Lupe nimmt, ob das Pueblo County fälschlich bevorzugt worden ist im Verlauf der Angebots-Prozedur.

3.Wir fordern mit allem Respekt, dass das PUC einen detaillierte Notfall-Analyse durchführt für den Fall, dass Zeiten mit einer Spitzen-Nachfrage nach Strom mit Zeiten schwachen Windes zusammenfallen. Der Plan muss zuverlässige Reserve-Kapazitäten enthalten, um angemessen auf solche Fälle reagieren zu können.

[Es folgt eine kurze Diskussion der einzelnen Punkte mit Verweis auf die Petition, in der ausführlicher darauf eingegangen wird. Die Anfragen 1 und 2 von CFACT sind mehr ein inneramerikanisches Problem, weshalb hier nur die Begründung zu Punkt 3 übersetzt wird. Anm. d. Übers.]

Das Risiko eines längeren Blackouts bei schwachem Wind in Zeiten der stärksten Nachfrage

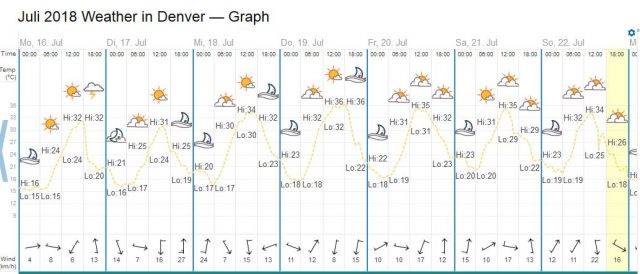

Wenn es um die Deckung der Spitzennachfrage geht, kann man nicht einfach Kohle durch Wind ersetzen, wie es der Colorado Energy Plan fordert. Die wärmsten und kältesten Perioden erzeugen Spitzenbedarf, doch gehen diese Perioden oftmals mit schwachem Wind einher. Sie kommen nämlich oft durch lang dauernde Hochdrucklagen zustande, bei denen der fehlende Druckgradient keine Windbewegungen zulässt.

In der Regel ist eine stabile Windgeschwindigkeit von 10 bis 15 km/h* erforderlich, um die Turbinen überhaupt in Drehung zu versetzen, aber selbst dann wird fast noch kein Strom erzeugt. Für eine signifikante Stromerzeugung ist eine Windgeschwindigkeit von 50 bis 80 km/h erforderlich. Sowohl bei Hitze- als auch bei Kältewellen fehlt es aber an diesem Wind.

Als Beispiel sei hier der aktuelle Fall von Denver genannt. Die folgende Graphik zeigt den Wetterverlauf vom 16. bis zum 22. Juli 2018. Es herrschte eine Hitzewelle, in welcher die Windgeschwindigkeit kaum einmal über 18 km/h hinausging. Bei dieser geringen Geschwindigkeit kann kaum oder gar kein Strom erzeugt werden, während die Nachfrage nach Strom auf dem höchsten Niveau liegt.

Daher erfordert ein Ersatz der Kohle durch Wind Speichermöglichkeiten, um die Nachfrage bei einem solchen Spitzenniveau decken zu können. Die einzige Speichermöglichkeit betrifft Solar, nicht Wind, und ist relativ gering im Vergleich zur Windkapazität. Außerdem muss die Speicherung von Windstrom sehr groß sein, um den Bedarf über 7 Tage oder noch länger decken zu können. Der Punkt ist, dass ein derartig großes Speichervolumen außerordentlich teuer ist bis hin zur Unbezahlbarkeit – vor allem, wenn man es mit dem Gebrauch der bestehenden Kohlekraftwerke vergleicht.

[*Die Angaben im Original sind mph und werden hier gleich in km/h umgerechnet genannt. Anm. d. Übers.]

Kurz gesagt, der Colorado Energy Plan ist vernichtend gescheitert, falls Kohle durch Wind ersetzt wird. Er ist ein Rezept für großmaßstäbliche Stromausfälle bei Hitze- oder Kältewellen. In Zeiten der Spitzennachfrage kann Kohle nicht durch Wind ersetzt werden. Das war gerade der Fall in Australien, vor Ort bekannt als „die Woche ohne Wind“. Längere Stromausfälle müssen auf jeden Fall vermieden werden, koste es, was es wolle, weil der Schaden für die Stromzahler potentiell katastrophal ist. Stromausfälle sind viel schlimmer als höhere Preise oder fortgesetzte Emissionen.

Zusammengefasst: Durch die Genehmigung des Colorado Energy Plans seitens des PUC erheben sich eine Anzahl sehr ernster Fragen. So ernst, dass sie dem Fortbestehen der Genehmigung widersprechen. Dessen Aufhebung muss von den Ergebnissen dieser Untersuchungen und nachfolgender Analysen abhängig gemacht werden.

David Wojick is a journalist and policy analyst. He holds a doctorate in epistemology, specializing in the field of Mathematical Logic and Conceptual Analysis.

Link: http://www.cfact.org/2018/10/05/colorado-should-rethink-its-risky-energy-plan/

Übersetzt von Chris Frey EIKE

IPCC im roten Drehzahlbereich von Ideologie und Realitätsverlust

Ein kleiner Überblick zum anthropogenen CO2

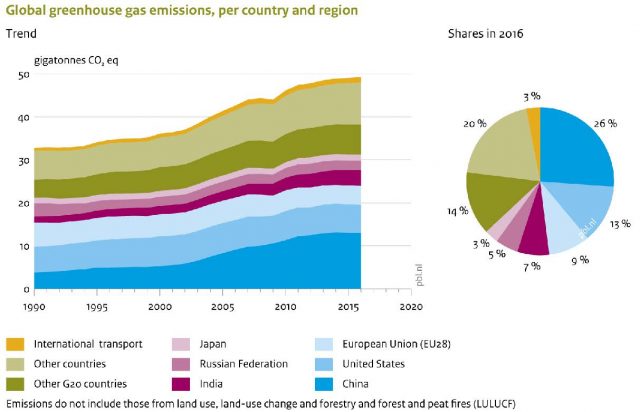

Schauen wir dazu einfach im Report der PBL Netherlands Environmental Assessment Agency nach, einer Organisation der holländischen Regierung (hier), die Trends in den globalweiten Emissionen von Klimagasen veröffentlicht. In diesem Report sagt Fig. 2.3 bereits alles nötige aus

Bild (Fig. 2.3): Emissionen von Klimagasen weltweit (hier)

In guter Näherung können wir die im Bild angegebenen Klimagase mit CO2 gleichsetzen, denn die entsprechenden Differenzen spielen für unsere Betrachtung keine Rolle. Die Tortengrafik in Fig. 2.3 weist mit zusammen knapp 40% die USA plus China als größte CO2 Emittenten aus. Russland und Japan zusammen mit 8% entsprechen etwa der EU mit ihren 9%. Deutschlands Beitrag ist im Bild nicht mehr aufgeführt, er liegt bei grob 2,5%. Bereits hier ist erkennbar, dass unser Beitrag global vernachlässigbar ist, weiter unten dazu mehr.

Über den industriellen Entwicklungshunger Chinas braucht man kaum Worte zu verlieren. Es baut neue Kohlekraftwerke fast im Wochentakt. China von seinem Weg des CO2 Ausstoßes abzuhalten wäre allenfalls theoretisch mit Waffengewalt möglich. Dabei denkt sicher jeder sofort an Josef Stalin, der sich über den Papst mit der rhetorischen Frage lustig machte „wieviel Division hat der Papst“ (also hier das IPCC)? Mit China und den USA als stärksten CO2 Emittenten ist es aber nur aktuell getan, Indien und Brasilien liegen schon in den Startlöchern, sie fangen an mit massiver Kohleverbrennung und später mit Kernkraftwerken nachzuziehen.

Müssen wir nun verzweifeln?

Nein, einer fiktiven Klimaschädigung wegen, verursacht durch menschgemachtes CO2, jedenfalls nicht. Was den Sachverstand des IPCC oder der GroKo angeht ist, ist das allerdings anders, hier sind starke Nerven gefragt, um tiefster Verzeiflung zu entkommen. Ein schöner Beitrag von Dirk Maxeiner (ACHGUT) zu diesem Thema hier. Trotz Propagandageballer aus allen Grün-Kanonenrohren dieser Welt ist ein Faktum nun einmal nicht aus der Welt zu schaffen, die Fachwissenschaft bürgt dafür – für jedermann erreichbar an Hand der öffentlich zugänglichen begutachteten Klima-Fachpublikationen: Es gibt bis heute keinen stringenten Nachweis, dass das anthropogene, also menschgemachtes(!) CO2 irgend einen Klimaeinfluss ausgeübt hat, der eindeutig auf diese Quelle zurückführbar ist.

Die so laut beklagte Temperatursteigerung gegen Ende des 20. Jahrhunderts (seit etwa 20 Jahren stagnierte die mittlere Globaltemperatur wieder bis heute) liegt weit im natürlichen Normalbereich, s. dazu Bild 1 in der EIKE-News hier. Die Steigerung des CO2 Gehalts in unserer Atmosphäre seit Beginn der Industrialisierung ist dagegen sehr wohl menschgemacht. Zum Glück für die Menschheit stieg der CO2-Gehalt der Luft wieder an, denn dadurch hat die Pflanzenmasse unseres Planeten zugenommen (hier) – einschließlich der globalen Nahrungsernten. Natürliche Klimaänderungen wie unsere bislang nur sehr kurze jüngste Warmperiode, haben stets Gewinner und Verlierer. Nur in Extremfällen, wie der kleinen Eiszeit vom Ende des 15. bis Mitte des 19. Jahrhunderts oder gar dem letzten Glazial vor 115.000 bis vor 12.000 Jahren, gab es so gut wie keine Gewinner.

Was passiert, wenn Deutschland weiter CO2 vermeidet?

Für die mittlere Globaltemperatur gar nichts! Die folgende Grobabschätzung für die globale Wirkung der CO2-Emissionen zeigt es, wobei hilfsweise die abstrusen Annahmen des IPCC vorausgesetzt werden:

Deutschlands Anteil an den weltweiten CO2 Emissionen beträgt etwa 2,5%. Um zu ermitteln, wie sich eine Verringerung dieses Beitrags um 50% auf die globale Mitteltemperatur bis zum Jahre 2050 auswirkt, gehen wir von vereinfachten Annahmen aus: Die derzeitige CO2 Konzentrationserhöhung der Luft beträgt 2 ppm/Jahr36, das sind in den 32 Jahren bis 2050 32 x 2 = 64 ppm mehr. Die deutsche 50% Einsparung ergibt 0,5 x 0,025 x 64 = 0,8 ppm weniger. Als ungünstigsten Wert der Klimasensitivität, also infolge CO2 Anstieg von heute 400 ppm auf 2 x 400 = 800 ppm, nennt das IPCC im Sachstandsbericht AR5 (2015) 4,5 °C. Die Temperaturverringerung durch 50% deutscher CO2 Einsparung beträgt somit höchstens 4,5 x 0,8/400 = 0,009 °C, also so gut wie nichts. Dieses „Nichts“ kostet Deutschland viele Milliarden Euro jedes Jahr. Diese Abschätzung wurde dem NRW-Landtag vom Autor anlässlich seiner Einladung als Gutachter zur Kenntnis gebracht und ist auf dem Landtagsserver abgreifbar. Es ist nicht bekannt, dass sie bei den politisch Veranwortlichen zum nachdenken geführt hat.

Leider passiert aber doch etwas, betreffend unseren Industriestandort. Eine Minderheit von sachunkundigen Grünverrückten (Strom kommt aus der Steckdose und wenn nicht, dann eben aus Wind und Sonne), fast die gesamte deutsche Medienlandschaft und leider auch die Justiz (hier) sind fleißig dabei Deutschland zum Zweck der CO2 Einsparung in die Tonne zu treten. Ein naiver Zeitgenosse fragt sich nicht zuletzt bei dem Urteil des OVG Münster zum Hambacher Forst, ob es inzwischen zwei Rechtsauffasungen gibt, eine für die Fällung von Bäumen für Windräder und eine für die Kohleversorgung. Wo protestieren eigentlich die grünen Aktivisten, wenn es den Waldtieren bei Windradinstallationen an den Kragen geht?

Nehmen wir jetzt einmal an, CO2 Vermeidung sei nötig. Wo soll die in Deutschland denn noch erfolgen? Windenergie trägt heute mickrige 3% zur deutschen Primärenergie bei, Photovoltaik 1%. Beide werden subventioniert und können nur den für ein stabiles Stromnetz unbrauchbaren Flatterstrom liefern. Die Versorgungssicherheit geht mit jedem neuen Windrad und jeder neuen Photozelle weiter in die Knie (hier, hier, hier, hier). Bleibt noch Energiemais mit 1%. Zu steigern ist dieses „Erneuerbare“ daher nicht mehr, denn insbesondere die Schäden durch Windturbinen übersteigen in Deutschland bereits jedes Maß (hier). Eine Studie des Bundesumweltamts zeigt auf S. 38 die Abbildung 12, aus der hervorgeht, dass ein weiterer Ausbau der Windenergienutzung zumindest an Land kaum noch möglich ist.

CO2 – Emissionen sind proportional zum Energieverbrauch. Hier sind auf allen Sektoren in Deutschland die Margen bereits ausgereizt. Selbst „Nullenergie-Häuser“ stellen sich inzwischen als Energieverschwender anstatt Energieeinsparer heraus (hier) – vorausgesetzt man erstellt eine realistische Gesamtbilanz.

Wovon wir als rohstoffarmes Land noch leben sollen, wenn die Kernkraftwerksindustrie, die Kohle, die Elektrizitätswirtschaft, die Autoindustrie, die chemische Industrie (Pflanzenschutz) und alle energieintensiven Industrien abgewickelt sind, kommt den für diesen Vernichtungsfeldzug Verantwortlichen anscheinend nicht in den Sinn. Haben die vielen Profiteure dieses Feldzugs schon vorgesorgt? Sie sollten es allmählich tun, denn den Ast auf dem sie sitzen, sägen sie gerade selber ab.

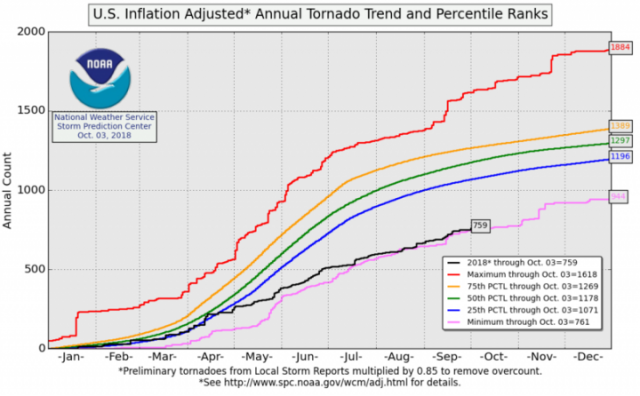

Jahr 2018: Geringste Anzahl von Tornados seit Beginn von Aufzeichnungen vor 65 Jahren

Und jetzt das: Bislang in diesem Jahr wurden 759 Tornados in den USA registriert, das ist eine rekord-niedrige Anzahl. Den SPC-Daten zufolge waren das zwei weniger als das bisherige Rekord-Minimum von 761.

Überhaupt war die Tornado-Aktivität während der letzten Jahre ungewöhnlich gering, wenn man die Aufzeichnungen betrachtet, die bis zurück zu Anfang der fünfziger Jahre reichen.

Dr. Roy Spencer von der UAH schreibt auf seiner Website:

Dieses Fehlen von Tornado-Ereignissen während der letzten Jahre sollte allgemein auch mit geringerer Gewitter-Aktivität in den USA korrelieren, sind doch die atmosphärischen Bedingungen zur Bildung von Tornados, Hagel und schweren Sturmböen genau die Gleichen …

Die Graphik mit den jährlichen Tornado-Trends ist das Ergebnis eines Verfahrens, welches von Harold Brooks, NSSL, und Greg Carbin, SPC, auf die beobachteten Daten bzgl. Tornados angewendet worden ist. Da eingehende Tornado-Berichte immer begutachtet werden, wird die tatsächliche oder „geglättete“ Anzahl von Tornados der Graphik hinzugefügt.

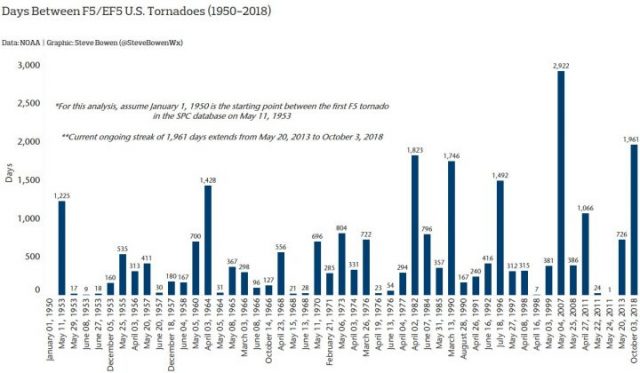

Im Zusammenhang damit schreibt der Meteorologe Steve Bowen auf Twitter:

Heute ist der 1961-te aufeinanderfolgende Tag ohne einen F5-Tornado in den USA. Das ist bis dato der zweitlängste Zeitraum ohne ein solches Ereignis seit 1950.

Er fügte folgende Graphik hinzu:

Das lässt die Behauptungen der Alarmisten zerplatzen, dass Klimawandel Extremwetter immer schlimmer macht.

Und der Trend, wenn man ihn adjustiert nach der Zunahme der Bevölkerung, besseren Beobachtungen und verbesserter Technologie, verläuft einfach flach, wie diese vom SPC erstellte Graphik zeigt:

Diese Graphik reicht leider nur bis zum Jahr 2007. Hoffentlich kommt bald eine Aktualisierung.

Link: https://wattsupwiththat.com/2018/10/04/2018-us-tornadoes-lowest-in-65-years-of-record-keeping/

Übersetzt von Chris Frey EIKE

Die Sicherheitsbereitschaft

Dieser Begriff bezeichnet eine staatliche Zwangsmaßnahme, die Teil des „Gesetzes zur Weiterentwicklung des Strommarktes“ (Strommarktgesetz) vom Juli 2016 ist. Geregelt sind in diesem auch die Kapazitätsreserve und die Netzreserve.

Im Grunde dient eine Bereitschaft immer irgendwie der Sicherheit, deshalb ist dieses kombinierte Substantiv schon im Wortsinn gedoppelt. Betroffen von dieser Bereitschaft sind ausschließlich Braunkohlekraftwerke, weil man sie auf Grund der CO2-Emissionen vom Markt ausschließen will. Trotz ständiger Behauptungen von Grünen und ihren Thinktanks, ihre Wirtschaftlichkeit wäre ohnehin nicht mehr gegeben, bedarf es administrativer Gewalt, sie außer Betrieb zu setzen. Richtig ist, dass die Preise der Emissionszertifkate steigen, aber ebenso steigen die Strompreise im Großhandel. Gaskraftwerke kommen auf wirtschaftlichem Weg nach wie vor nicht in der Stromproduktion zum Zug.

Einige Braunkohlekraftwerke wurden und werden per Gesetz in diese Zwangsbereitschaft geschickt. Die „Sicherheitsbereitschaft“ gilt für das Kraftwerk Buschhaus in Niedersachsen bereits seit 1. Oktober 2016, zwei Blöcke in Frimmersdorf (NRW) wurden am 1. Oktober 2017 zwangsabgeschaltet. In Niederaußem (NRW) gehen zum 1. Oktober 2018 für zwei Blöcke die Lichter aus, ebenso für einen Block in Jänschwalde (Brandenburg), dort folgt ein zweiter zum Oktober 2019 sowie einer in Neurath (NRW). Die Blöcke bleiben für vier Jahre in dieser Kaltreserve und werden dann per Gesetz stillgelegt. Damit sind dann 13 Prozent der Braunkohleleistung aus dem Rennen, verursachen aber in ihrer Bereitschaftszeit weiter Kosten, die der Stromkunde trägt.

Grund dieser schrägen und teuren Regelung ist ein Kompromiss zwischen Wirtschaftsministerium, Unternehmen und den Gewerkschaften IG BCE und Ver.di als Ergebnis politischer Auseinandersetzungen. Ursprünglich war ein „Nationaler Klimaschutzbeitrag“ geplant, der die Produktion aus Braunkohlekraftwerken so verteuern sollte, dass sie aus dem Markt gedrängt würden. Die Blöcke werden nun in einer Kaltreserve gehalten, so dass sie bei länger anhaltenden angespannten Versorgungslagen wieder angefahren werden könnten. Ex-Wirtschaftsminister Gabriel sprach vom zusätzlichen Gürtel zum Hosenträger. Abzusehen ist, dass politisch alle Hebel in Bewegung gesetzt werden, um diesen Fall zu vermeiden. Er würde Zweifel an den Erfolgsaussichten des weltweit einzigartigen deutschen Dekarbonisierungsweges wecken.

Betreiber LEAG wird wohl für die beiden in Zwangsbereitschaft stehenden Blöcke in Jänschwalde mehrere hundert Millionen Euro bekommen, die der Stromkunde zahlen muss. Das ist aber kein Geldgeschenk, sondern Entschädigung für Enteignung und Kostenerstattung für die Reservestellung.

Etliche technische Maßnahmen sind erforderlich und nicht zum Nulltarif zu haben. Vor Abschaltung müssen Chemikalien dosiert werden, die in den Rohrleitungen eine Schutzschicht gegen Korrosion ausbilden, einige Rohrleitungen müssen nach Konservierung permanent belüftet werden. Kesselhäuser und Maschinenhaus müssen im Winter frostfrei bleiben (ein gutes Drittel des Eigenbedarfs eines laufenden Blockes ist nötig, um den Heizstrom dafür zu liefern und zusätzliche Heizwasserregister müssen installiert werden). Eine kleine Bedienermannschaft bewegt permanent nach Checklisten Pumpen, Antriebe und Armaturen, um die Beweglichkeit zu erhalten. TÜV-Prüfungen müssen trotz Stillstands zeitzyklisch durchgeführt werden.

Verhinderter Fortschritt

Hinzu kommt, dass innovative Entwicklungen zwangsweise beendet werden. SIEMENS testet an einem Block erfolgreich eine Speisepumpen-Antriebsturbine mit Magnetlagerung. Ein Dampfkessel wurde so umgebaut, dass zur Inbetriebnahme die kalte Brennkammer nicht mehr mit Heizöl vorgewärmt werden muss, sondern mittels einer Plasmazündung direkt mit Trockenkohlestaub gezündet werden kann. Diese neuen Techniken, die einen Entwicklungsweg künftiger konventioneller Kraftwerkstechnik aufzeigen, werden sich international durchsetzen. In Deutschland wird darauf großmütig verzichtet.

Kein Geld gibt es für die Lausitz für den Entfall von 600 direkten (Kraftwerk und Tagebau) Arbeitsplätzen und etwa 900 indirekten. Wie teuer sind 1.500 politisch vernichtete tarifliche Arbeitsplätze für die Region? Lässt sich das abfedern?

Eine Idee ist die Ansiedlung von Bundesbehörden in der Lausitz. Inwiefern diese Behörden ohne jede Wertschöpfung, die von unlustig angereisten Pendlern aus Berlin bevölkert würden, der Region helfen sollen, ist unklar. Ein paar Stellen für Hausmeister – pardon, Facility-Manager -, Chauffeure und Gebäudereiniger fallen sicherlich ab. Man erinnert sich an Zeiten, als Brandenburg bei Investoren mit niedrigen Löhnen warb.

Investitionen in die Infrastruktur, die ohnehin überfällig sind, wären willkommen. So der Breitbandausbau, vor allem aber der von Straßen und Schienen. 1948, als im Westen mit dem Marshallplan die Grundlage für das Wirtschaftswunder anlief, ließen die Sowjets das zweite Gleis zwischen Berlin und Görlitz abbauen. Eine von vielen Reparationsleistungen, im Übrigen für ganz Deutschland. Nach 40 Jahren DDR und 28 Jahren geeinter Bundesrepublik sind noch immer 123 Kilometern zwischen Görlitz und Lübbenau eingleisig. Das Staatsunternehmen Deutsche Bahn verlegt zwar ganze Bahnhöfe unter die Erde und verfügt über unterbeschäftigte Vorstände (oder warum sitzt Pofalla sonst in der „Kohlekommission“ und gibt dort den großen Zampano?), ansonsten steht das Staatsunternehmen exemplarisch für eine gescheiterte Verkehrswende. Die Dimensionen stillgelegter Streckenkilometer und Bahnhöfe sind erheblich, der Erfolg des Prinzips „Von der Schiene auf die Straße“ ist beachtlich, was an DB Schenker, DB Bus und IC Bus zu erkennen ist.

Selbst wenn das zweite Lausitzer Gleis kurzfristig, also nach Zeitrechnung der Deutschen Bahn in frühestens zehn Jahren, kommen sollte und Straßen wie die Lausitzmagistrale sowie die A16 von Cottbus nach Leipzig und andere gebaut und ausgebaut werden sollten, so sind gut ausgebaute Verkehrswege keine Garantie für die Ansiedlung von Investitionen. Man kann auf diesen Wegen auch schneller an der Lausitz vorbei fahren, zum Beispiel nach Polen, wo die Wojewodschaften Lubuski (Lebus) und Dolny Slask (Niederschlesien) mit Sonderwirtschaftszonen locken.

„Ich werde Arbeitsplätze zu den Menschen bringen“, so Wirtschaftsminister Altmaier im Vorfeld der Beratungen der Strukturkommission. Wie er das genau machen will, bleibt nebulös. Eine Batteriefabrik ist eine heiße Idee, Elon Musk habe ihm persönlich gesagt, dass künftig auch Flugzeuge elektrisch fliegen werden. Mancher Jurist glaubt sowas. Dass diese Fabrik gegen den größten chinesischen Batteriezellenhersteller CATL konkurrieren müsste, der am Rand von Erfurt bereits Tatsachen schafft, macht das Vorhaben nicht einfacher. Die weltweiten Lithium- und Kobaltkapazitäten sind im Wesentlichen vergeben – unter anderem an China. Die Chinesen haben direkten Zugang zu den Batterierohstoffen, Deutschland muss importieren, was noch zu haben ist. Wenn viel Staatsknete in eine solche Fabrik fließen würde, wäre es der Umstieg von der Markt- in die Subventionswirtschaft. Die weckt nicht nur schlechte Erinnerungen an DDR-Planwirtschaft, sondern auch an die ehemalige „Solar-City“ Frankfurt/Oder.

Abgesehen von der Automobilindustrie gibt es in Deutschland kaum noch Fließbandfertigung, die Kosten für lebendige Arbeit sind im internationalen Vergleich sehr hoch. Um Elektrodenpaare in Batteriegehäuse zu setzen, bedarf es keiner großen Zahl gut gebildeter Facharbeiter.

Emissionssenkung mit Gewalt statt smart

Die Stilllegung beider Jänschwalder Blöcke mindert die CO2-Emissionen um etwa 7 Millionen Tonnen pro Jahr bei einem globalen anthropogenen Ausstoß von über 40.000 Millionen Tonnen, Tendenz steigend. Die gleiche Emissionsminderung träte ein, würde man die jetzigen Jänschwalder Blöcke durch Neubauten ersetzen. Dann bliebe die Versorgungssicherheit erhalten. Weitere Minderung hätte die geplante Demonstrationsanlage mit CCS-Technologie („Carbon Capture and Storage“) gebracht. Seinerzeit von Vattenfall initiiert, heute vom IPCC empfohlen, wurde sie politisch erwürgt. Die Pläne dazu waren fertig und verstauben jetzt als Irrtum deutscher Wirtschaftsgeschichte in den Aktenschränken. Gut, ein Teil der im entsprechenden Pilotversuch in Schwarze Pumpe gewonnenen Erkenntnisse ließ sich verkaufen, zum Beispiel nach Kanada, wo die Entwicklung weitergeht.