EEG-Neusprech erklärt: Solarcloud und Sonnenscheingarantie

Das Speicherproblem

EIKE Leser wissen es: Eines der ganz großen Probleme des EEG ist fehlender Speicher für den elektrischen Strom [5]. Dieses Problem resultiert nicht aus einem dummen Zufall, sondern ist den Elektrotechnikern seit weit über hundert Jahren bekannt, da es auf physikalischen Gesetzmäßigkeiten beruht.

Gegen diese Physik der Elektrotechnik kämpfen (oft von Parteien ernannte) Fachperson*innen zwar vehement an [2] und auch wirkliche Fachpersonen „erfinden“ für ausreichend Fördergeld (nicht durchführbare) Lösungen [4] [6] denen zumindest eines immer eigen ist: Sie sind, beziehungsweise wären, bei einer Umsetzung – sofern überhaupt möglich – mindestens unglaublich teuer.

SolarCloud: Der einzigartige, virtuelle Speicher …

Wie wohltuend ist es da, wenn eine Fachfirma wie E.ON publiziert, dass ihre fleissigen Erfinder eine Lösung gefunden haben:

E.ON: [1] Die E.ON SolarCloud: der einzigartige virtuelle Speicher, mit dem Sie Ihren Solarstrom unbegrenzt ansparen und bei Bedarf wieder abrufen können.

Und nicht nur speichern kann diese Lösung, nein, sie gibt auch eine Sonnenenergie-Garantie:

E.ON: [1] 22 % Wolken 78 % Sternenhimmel 100 % Sonnenenergie.

Im Werbevideo sieht man es im Detail und verfolgt eine Wolke mit eingezeichnetem Batteriesymbol, welche sich lädt und entlädt. Womit die „Speicherwolke“auch für jeden Laien sofort als Speichermedium erkennbar ist.

Komischerweise heißt es dann jedoch:

E.ON: [1] … Entdecken Sie jetzt unseren virtuellen Speicher, der komplett ohne Batterie auskommt.

Auch dies liest man gerne und freut sich über den Erfindungsreichtum der E.ON Entwickler. Denn man weiß: Batteriespeicher gehören zu den teuersten Produkten, um elektrischen Strom zu speichern [5]:

EIKE 18.05.2017: Rechnerisch lohnt sich die solare Eigenversorgung nicht – so lange unser Versorgungsnetz stabil ist. Doch das wird sich ja ändern

… ist reiner „Zertifikatestrom“

Liest man sich tiefer in die E.ON Werbung ein, verflüchtigt sich der „Cloud-Speicher“ zu einem reinen, kommerziellen Angebotsmodell. Von einem realen Speicher bleibt keine Spur übrig. Kurz gesagt:

E.ON nimmt überschüssigen Solarstrom ab und liefert bei Bedarf „reinen Ökostrom“ als „Zertifikatestrom“ zurück. Dieser „Zertifikatestrom“ wird wie üblich, irgendwo auf der Welt erzeugt. Wo er gebraucht wird, wird er real dem dort aktuell erzeugten Strommix entnommen.

[1] … An sonnigen Tagen bauen Sie ein Guthaben auf, das Sie in der Nacht, bei Regentagen, in den Wintermonaten oder für Ihr Elektroauto nutzen können …

Sonnenscheingarantie

Wer das Premiumpaket ordert, bekommt zusätzlich eine Sonnenscheingarantie:

Was ist die Sonnenscheingarantie?

… Mit der Sonnenscheingarantie sichern wir Ihnen über 10 Jahre 95% des prognostizierten Ertrags Ihrer Solaranlage zu. Sollten Ihre Stromerträge im Jahr niedriger sein als angenommen, gleicht E.ON den Verlust auf Basis der entgangenen EEG-Einspeisevergütung finanziell aus ...

Wie zu erwarten war, ist es ebenfalls eine reine, kommerzielle Versicherungsleistung.

Sozial, unsozial, EEG

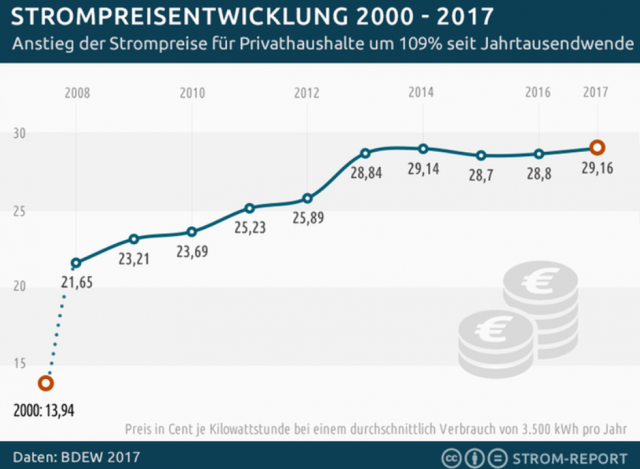

Keine Partei (mit einer Ausnahme) stört es, dass mit diesem Angebot auch E.ON aufzeigt, wie unsozial das EEG wirkt. Inzwischen ist es gelungen, den Haushalts-Strompreis so in die Höhe zu treiben, dass sich eine Solaranlage zum Eigenverbrauch langsam lohnt (eine Installation wegen der Einspeisevergütung lohnt sich längst nicht mehr). Es lohnt sich aber nur, wenn keine Speicherkosten anfallen:

EIKE 18.05.2017: Rechnerisch lohnt sich die solare Eigenversorgung nicht – so lange unser Versorgungsnetz stabil ist. Doch das wird sich ja ändern

Der „nachhaltige“, betuchte Bürger erzeugt deshalb möglichst viel eigenen Strom. Nur wenn dessen Einspeisung fehlt, weil die Sonne nicht scheint, holt er ihn sich von den anderen. Diese dürfen aber die horrenden Nebenkosten der Backup-Kraftwerke, Leitungsgebühren, Netzausbau und und und über die gesamte Zeit voll bezahlen.

Einzige Entschuldigung: Die viel gepriesenen, „Autarken Gemeinden“ machen es auch so.

Die Politik interessiert es wenig, denn sie hat – wie immer – dafür durchschlagende Lösungen parat: [8]

LINKE: … Ein weiterer Vorschlag für ein soziales Stromtarifmodell schlägt die kostenlose Bereitstellung eines Grundkontingentes an Strom für jeden Haushalt vor, verbunden mit teureren Preisen für allen zusätzlich verbrauchten Strom.

CSU: Der CSU-Parteivorsitzende, Horst Seehofer, fordert einen staatlichen Fond, der die steigenden Stromkosten begrenzen soll. So sollen ab einem gewissen Betrag ansteigende Preise durch staatliche Gelder verhindert werden.

GRÜNE: Die Partei … sieht als einfachsten Weg, um die Stromkosten zu senken, den Stromverbrauch selbst zu senken.

CDU: Die CDU fordert in ihrem aktuellen Wahlprogramm sichere, bezahlbare und saubere Energie. Dabei setzt die CDU weiterhin auf den Ausbau erneuerbarer Energien …

Ein geschicktes Ineinandergreifen unterschiedlicher Elemente und Energieträger stabilisiert die Versorgung und entlastet die Verbraucher von Kosten.“

AfD: hält das EEG für nicht reformierbar … möchte das EEG abschaffen … kritisiert, dass Verbraucher die Kosten für die Energiewende tragen müssen

Beim EEG bekommen Fremdwörter neue Bedeutungen

Nicht nur neue Wortschöpfungen werden durch das EEG generiert, auch längst gängige werden umgedeutet.

Nach WIKIPEDIA bedeutet „vir·tu·ẹll“:

Philosophie: der Möglichkeit nach vorhanden.

Physik: nicht beobachtbar, aber erschließbar.

Dieser E.ON Cloud-Speicher ist nach Ansicht des Autors aber weder „der Möglichkeit nach vorhanden“, noch wäre er real „erschließbar“. Einen Speicher für elektrischen Strom gibt es bei E.ON ganz einfach nicht und er war auch nie als physikalische Realisierung angedacht.

Nun erschließt sich, warum der E.ON Vorsitzende des Vorstandes, Herr Teyssen (Volkswirt und Jurist) die Energiewende, durch die sein Konzern fast in die Pleite getrieben wurde, sogar „sexy“ findet:

Teyssen: [7] … Aber wir entwickeln für unsere Netze immer neue Lösungen, etwa um noch mehr Ökostrom transportieren zu können. Ich empfinde die Lösung des Speicherproblems als sexy …

Nur in dieser „physiklosen Scheinwelt“ des EEG lassen sich Marketingbegriffe und Bezahlmodelle wie physikalische Lösungen verkaufen. In anderen Geschäftsfeldern würden wohl lägst Abmahnvereine wegen Irreführung der Verbraucher klagen.

Fazit:

Kein Wunder, dass die Fachperson*innen einiger Parteien da ganz kirre werden und Strom und Stromspeicher überall vermuten, nur nicht dort, wo und wie sie die Elektrophysik zulässt.

EIKE: Eine grüne Stromversorgung Deutschlands

Zum Thema „Netze und Speicher“ präsentiert die Frau Annalena Baerbock, Vorsitzende der Grünen und eine ihrer Abgeordneten im Bundestag ihre Visionen zur künftigen Stromversorgung Deutschlands, zu einer gewaltigen Energiewende. weil angeblich ein dramatischer Klimawandel drohe.

EIKE 24.01.2018: GRÜNE Energieexpertin: Das Netz fungiert als Speicher

EIKE 15.08.2017: Cem Özdemir versucht sich in Energie

Es wird nur noch eine Frage der Zeit sein, bis solche „Fachexpert*innen erklären, dass ein großer Versorgerkonzern die Lösung des Speicherproblems gefunden hat. Einen Start-up Erfinderpreis für diese „Rettung des EEG“ bekommt E.ON sicher nur deshalb nicht, weil es schon ein etabliertes Unternehmen ist.

Quellen

[1] E.ON Solarcloud

[2] EIKE 24.01.2018: GRÜNE Energieexpertin: Das Netz fungiert als Speicher

[3] EIKE 2. Januar 2018: Das Elektroauto erzeugt nur Gewinner – und man verdient sogar Geld damit

[4] EIKE 30. Juli 2017: Der Visionär E. Musk (Tesla) rettet Südostaustralien für 32 Sekunden vor dem Blackout

[5] EIKE 18.06.2015: Elektro-Energiespeicherung, Notwendigkeit, Status und Kosten. Teil 3 (Abschluss)

[6] EIKE 02.09.2016: Weltweit einzigartiger Stromspeicher im Pilotversuch: Der Naturstromspeicher – die von Berlin geförderte EEG-Naturvernichtung

EIKE 12.04.2017: Helden der Energiewende

[7] DERWESTEN 09.07.2016: Eon-Chef Teyssen: Ökostrombranche muss „raus aus dem Streichelzoo“

[8] RICHTUNGSFREI: Strompreis