Umweltaktivisten plädieren auf Meinungsfreiheit, damit sie nicht für Öko-Terrorismus angeklagt werden

„Earth First! kann nicht verklagt werden, weil es sich formaljuristisch nicht um eine Gruppe handelt„, so Rachel Meeropol, die Beraterin von Earth First! Journal, das Nachrichten über die sogenannten Öko-Kriege veröffentlicht. Sie behauptet, dass Klagen gegen ihre Organisation eingereicht wurden, nicht aus Sorge um geschäftliches Interesse, sondern lediglich um das Recht der Aktivisten auf freie Meinungsäußerung zu verletzen.

Screenshot der Webseite von http://earthfirstjournal.org/newswire/2018/01/08/call-for-submissions-for-the-earth-first-journal-spring-issue/

„Earth First! ist eigentlich keine Gruppe … Es ist eine Philosophie, eine Bewegung, also kann man keine Idee verklagen“, sagte Frau Meeropol während eines Greenpeace-Treffens am 30. Januar in einem High-End-Restaurant in Washington, DC. Ihre Gruppe wurde in den späten 1970er Jahren im Südwesten der USA bekannt, als sie direkte Aktionen gegen Firmen wie ExxonMobil und Shell initiierten.

Rachel Meerpol, Leitende Angestellte und Associate Director der juristischen Aus- und Weiterbildung. Quelle: Vorstellung der Mitarbeiter auf der offiziellen Webseite des Center for Constitutional Rights

[Die Vorgehensweise von Frau Meerpol, „alle Aktivitäten von Umweltgruppen fallen grundsätzlich unter Meinungsfreiheit“, findet man auch bei anderen Vorkommnissen / Anklagen, bei denen ihr Name auftaucht., Recherche des Übersetzers]

Die Gruppe antwortete nicht auf die Anfrage des Daily Caller nach einem Kommentar zur Gültigkeit der Forderung von Meeropol. Aber eine Analyse der Steuererklärungen ihrer Gruppe scheint ihre Argumentation zu widerlegen. Earth First! hat sieben Jahre lang Steuererklärungen eingereicht und verfügt über eine registrierte Arbeitgeber-Identifikationsnummer gemäß der Florida State Department Website. Damit ist es anfällig für Klagen.

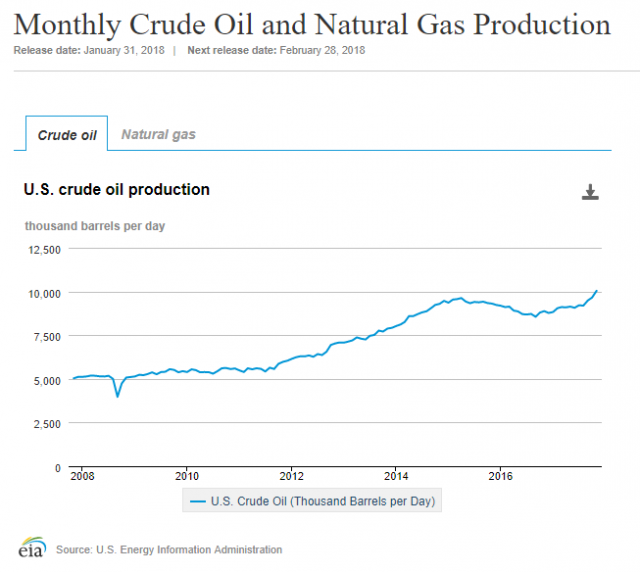

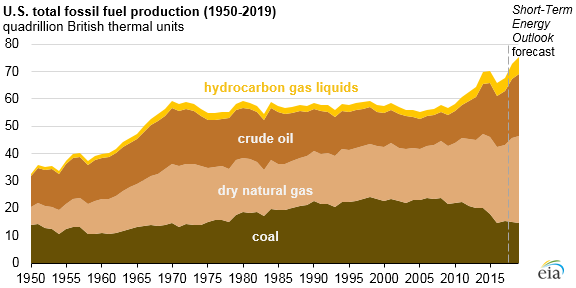

Der Daily Caller nahm an dem Get-together teil, das formuliert wurde, um zu zeigen, wie Aktivisten Klagen von Energieunternehmen und Holzfäller [- Unternehmen] entgegenwirken können – Angriffe gegen Ölprojekte und Sägewerke haben einen fiebrigen Höhepunkt erreicht, während die Ölindustrie weiter boomt. Zwei Unternehmen haben die Gerichte genutzt, um gegen Meeropol, ihre Kollegen und andere Umweltschutzgruppen vorzugehen.

Die Energie- Transfer-Partner (ETP) haben gemeinsam mit der Holzfällerfirma Resolute Forest Products gegen Greenpeace und Earth First! geklagt. Gegen die Lügen der Aktivisten über verschiedene Projekte, um Verluste / Kosten für den Betreiber zu erzeugen. Greenpeace und Earth First! ermutigen auch Aktivisten, direkte Aktionen gegen Projekte zu starten, [unbeachtet dessen], ob sie den Gemeinden schaden und amerikanische Jobs kosten können, so ETP und andere.

Greenpeace gab in legalen Befragungen zu, dass ihre Kampagne zur Verunglimpfung eines in Kanada ansässigen Holzunternehmens auf „Übertreibungen“ und „nicht überprüfbaren Aussagen subjektiver Meinungen“ beruhte, die nicht wörtlich genommen werden sollten. Die Gruppe, die Resolute Forest Products 2012 ins Visier genommen hatte, gab zu, dass sie eine hitzige Rhetorik nutzte, die nicht sachlich war, um in ihren juristischen Auseinandersetzungen nicht für Schäden haftbar gemacht zu werden.

Greenpeace bezeichnete die Mitarbeiter von Resolute Forest Products als „Waldzerstörer“, die mit ihrer geschäftlichen Tätigkeit eine „Todesspirale für Karibus [Rentiere] und deren Aussterben“ verursachten, um damit das Unternehmen dazu zu bringen, sich den Forderungen der Umweltschützer zu beugen. Greenpeace hat sogar eine Webseite, in dem sie ihren Fall gegen Resolute auflistete und was das Unternehmen tun soll, einschließlich der Unterbrechung der Holzeinschlagsarbeiten.

ETP hat auch rechtliche Schritte gegen Greenpeace und Earth First! eingeleitet. Greenpeace und Earth First! stellten falsche Informationen über die Dakota Access Pipeline (DAPL) her, damit sie Spenden generieren und die Pipeline torpedieren konnten, sagte ETP letztes Jahr. Die Handlungen von Greenpeace und Earth First! verletzen auch die Gesetze gegen „organisierte Kriminalität“ des Bundes und der –Staaten.

„Die Angriffe waren kalkuliert und völlig unverantwortlich und verursachten enormen Schaden für Menschen und Eigentum entlang der Pipelineroute“, heißt es in der Erklärung der DAPL, die eine Reihe von Greenpeace’s schlimmsten Vergehen auflistet, darunter Vertragsverletzungen gegen Indianische Stammesländer und das Entweihen von heiligen indianischen Stätten.

Greenpeace und Earth First! gestanden ein, dass ihre Kampagne der ETP und den Finanzinstituten, die das Unternehmen unterstützen, Schaden in Höhe von mehreren hundert Millionen Dollar zugefügt habe, nach DAPL Aufzeichnungen.

DAPL argumentiert, dass die Behauptungen Anti-DAPL-Aktivisten zu der Annahme verleiten, dass das 3,8 Milliarden Dollar schwere Projekt, welches den Missouri in North Dakota untertunnelt, die Stammesgebiete verletzt und möglicherweise die primäre Wasserversorgung des Standing Rock Sioux vergiften könnte, wenn die Leitung undicht wird.

Earth First! und Greenpeace argumentieren, dass ETP und Resolute Forest Products eine hinterhältige juristische Technik namens „Strategic Litigation Against Public Participation“ (SLAPP) [Strategischer Prozess gegen Beteiligung der Öffentlichkeit] verwenden, um die Rechte ihres Aktivisten-Netzwerks zu unterdrücken.

Unternehmen würden SLAPP nutzen, um kritische Reden und Interessenvertretung in Angelegenheiten des öffentlichen Interesses zu schwächen, argumentierten Diskussionsteilnehmer am Dienstag. Sie schlagen außerdem vor, dass Firmen den ROC-Ansatz (Racketeer Influenced and Corrupt Organization Act) als eine Art aktualisierte Version von SLAPP verwenden. [Gesetzt gegen kriminelle Vereinigungen, ursprünglich geschaffen gegen die Mafia]

„Das RICO-Statut erlaubt den Prozessbeteiligten, alle an einer Verschwörung beteiligten Personen in eine Klage einzubeziehen. Wenn die Zivilgesellschaft durch Koalitionen, die Ziele einer „kriminellen Verschwörung“ sein könnten, ihre Fähigkeit verliert, Macht aufzubauen, dann gewinnen die Unternehmen und unsere Demokratie, unsere Gemeinschaften und unser Planet verlieren“ so Greenpeace. [Trumps Rechtsanwälte versuchen, eine Umweltphilosophie nach dem Anti-Racketeering-Gesetze zu verklagen, Earth First! Webseite und

Zu o.g. Vorgang Resolute Forest Products vs. Greenpeace, berichtete der Daily Caller am 31.05.2016

… Resolute Forest Products (RFP) gibt an, Greenpeace hätte gefälschte und digital modifizierte Fotos fabriziert, um das Unternehmen zu schädigen und die Finanzierungs-Bemühungen zu erhöhen. RFP beschuldigt die Umweltgruppe, „konsequent auf sensationellen Fehlinformationen basiert zu sein, die nicht auf Tatsachen oder Wissenschaft ausgerichtet sind, sondern stattdessen starke Emotionen und damit Spenden erzeugen“.

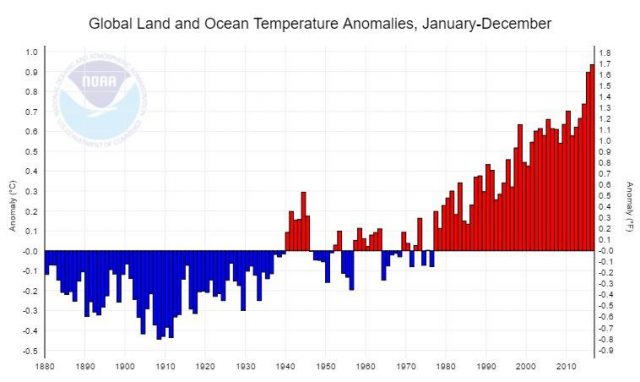

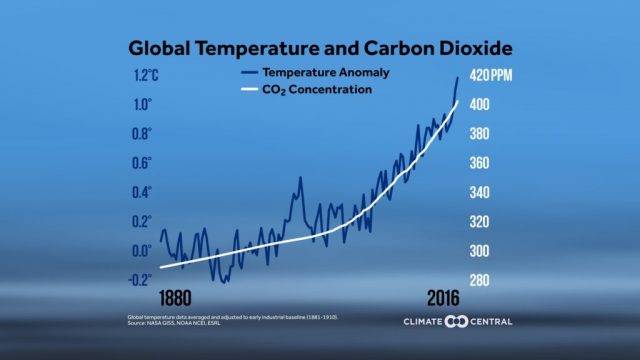

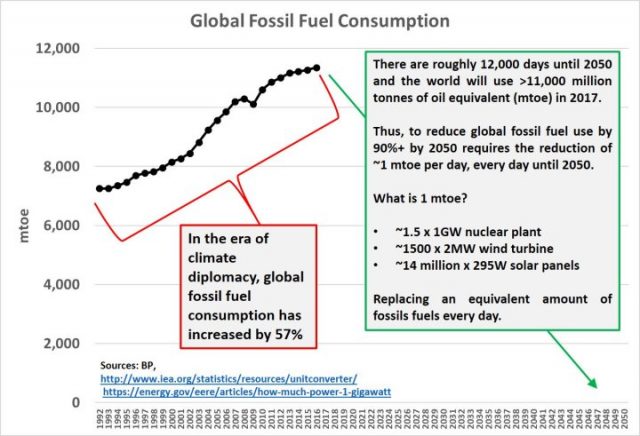

Ironischerweise hat Greenpeace wiederholt die Bundesregierung aufgefordert, Ölfirmen und Organisationen, die die Risiken der Erderwärmung bestreiten, nach der gleichen RICO-Gesetzgebung anzuklagen. Insbesondere forderte der Medienbeauftragte von Greenpeace das Justizministerium auf, eine „breit angelegte“ Untersuchung durchzuführen, um „die Rolle von Unternehmen im Bereich der fossilen Brennstoffe, von Handelsverbänden und ThinkTanks zu untersuchen, die Zweifel an den Risiken des Klimawandels säen“.

Greenpeace und andere Umweltaktivisten trafen sich im Januar hinter verschlossenen Türen, um zu koordinieren, wie man Staatsanwälte am besten dazu bringt, ExxonMobil anzuklagen, weil sie angeblich die Öffentlichkeit über die globale Erwärmung Irre führen, heißt es im Bericht des Wall Street Journal vom April 2016.

Erschienen auf The Daily Caller am 03-02.2018

Übersetzt durch Andreas Demmig

http://dailycaller.com/2018/02/03/environmentalist-earth-first-lawsuits-ecoterrorism/