Das Gegenteil von gut ist gut gemeint

Am 19.01.2018 erschien der Artikel „Vom Klimaschutz zur Klimasteuerung“ auf Novo Argumente. Dieser Artikel greift zunächst – sehr sachlich – alarmistische Konstrukte des anthropogenen Klimawandels auf, stellt dann ganz entspannt deren vorgeblich katastrophale Auswirkungen und Ziele in Frage, um daraus schließlich Argumente für ein globales Geoengineering zur Klimasteuerung abzuleiten. Nachfolgend sollen zunächst einige der klimaalarmistischen Darstellungen aus diesem Artikel näher beleuchtet werden:

Von den vergangenen 500 Millionen Jahre Erdgeschichte hat man zwar ziemlich klare Vorstellungen, aber keine eindeutigen und lückenlos nachgewiesenen Erkenntnisse, Zitat aus dem Novo-Artikel mit Hervorhebungen:

„Tatsächlich ist das Klima der Erde höchst variabel. Es gab Eiszeiten und Wärmeperioden, in denen Palmen an den Polarkreisen wuchsen, möglicherweise auch „Schneeball Erde“ genannte Phasen, in denen nahezu die gesamte Erdoberfläche mit Gletschern bedeckt war. Am besten untersucht sind die letzten 500 Millionen Jahre. Für diesen Zeitraum, der ungefähr dem Phanerozoikum entspricht (also dem erdgeschichtlichen Zeitalter, in dem komplexe Lebensformen entstanden sind), können Wissenschaftler recht genaue Rekonstruktionen des Klimas erstellen. Sie nutzen dazu sogenannte „Proxys“ wie Baumringe, Ozeansedimente oder Eisbohrkerne…“

Zunächst einmal wird dem Leser die Klimaentwicklung der vergangenen 500 Millionen Jahre Erdgeschichte als recht genau bekannt vermittelt. Aber bereits Klimarekonstruktionen von weniger als 1 Million Jahren sind in der Realität nicht unproblematisch, auch wenn dafür tatsächlich Temperaturproxys in Form von Baumringen, Ozeansedimenten oder Eisbohrkernen vorliegen. Die Bedeutung von „recht genau“ wird nämlich immer unschärfer, je weiter wir uns in den geologischen Zeitaltern zurückbewegen. Und am Ende müssen Aussagen zum Klima auch noch zwischen echten Klimaveränderungen und geographischen Lageänderungen der betreffenden Kontinente aufgrund der Plattentektonik unterscheiden.

Ein Artikel aus National Geographic über eine Reduzierung des vorgeblichen CO2-Klimaantriebs wird dann als „gängige Theorie“ für die Entstehung der Eiszeiten benannt, Zitat aus dem Novo-Artikel:

„Der Abwärtstrend, der in das aktuelle Eiszeitalter führte, begann vor circa 50 Millionen Jahren. Die Gründe dafür sind umstritten, eine gängige Theorie geht davon aus, dass die Ausbreitung und spätere Sedimentierung des Süßwasserfarns Azolla der Atmosphäre beträchtliche Mengen des Treibhausgases CO2 entzog. In den letzten zwölf Millionen Jahren ist der Temperaturabfall stärker geworden, gipfelnd in einer schnellen Folge immer intensiverer Glaziale, die die letzten drei Millionen Jahre prägten…“

Genau diese Theorie ist nicht „gängig“, sondern voll alarmistisch. Die eigentlich gängige Theorie erklärt über die genau gleiche Argumentation nämlich die Sauerstoffgenese auf unserer Erde, und zwar mit der Entstehung der globalen Vorkommen an Kohle, Erdöl und Gas aus unterschiedlichen organischen Bestandteilen. Und diese Entwicklung begann bereits mit dem Karbon, also vor etwa 350 Millionen Jahren.

Eine einzelne alarmistische Veröffentlichung über die Abschwächung eines vorgeblichen CO2-Klimaantriebs durch die Auswirkungen der Plattentektonik und wird dann als „aktueller Forschungsstand“ bezeichnet, Zitat aus dem Novo-Artikel:

„Dass das Klima so kalt und volatil geworden ist, liegt laut aktuellem Forschungsstand an der Plattentektonik. Vor etwa 40 bis 50 Millionen Jahren rammte die indische Platte in die eurasische Platte. Es entstanden das Hochland von Tibet und die Gebirge Himalaja, Pamir und Karakorum, zusammen auch „Dach der Welt“ oder „dritter Pol“ genannt. Erdgeschichtlich betrachtet sind Berge, die bis an den Rand der Stratosphäre reichen, eine Anomalie. Die Auffaltung der Felsmassen hat eine außergewöhnliche klimatische Epoche eingeleitet, denn sie hat die Verwitterung silikatreicher Gesteine wie Granit erheblich verstärkt. Bei diesem Prozess wird Calcium freigesetzt. Das Calcium reagiert zu Calciumcarbonat (dem Hauptbestandteil von Kalkstein) und entzieht dabei der Atmosphäre CO2…“

Die Verknüpfung plattentektonischer Ereignisse mit einem vermeintlichen CO2-Klimaantrieb stellt einen konstruierten Mechanismus dar und ist ein Ausdruck des herrschenden Zeitgeistes. Die wissenschaftlich nachgewiesene konventionelle Position von Köppen und Wegener, dem „Vater“ der modernen Plattentektonik, für den natürlichen Paläo-Klimaantrieb durch die Schwankungen der Erdbahn um die Sonne blieb dagegen unerwähnt. In dem bahnbrechenden Werk von Wladimir Köppen und Alfred Wegener, „Die Klimate der geologischen Vorzeit“ (1924) mit den Berechnungen von Milutin Milanković, wird die sommerliche Sonneneinstrahlung in mittleren und höheren Breiten als der natürliche Paläo-Klimamotor unserer Erde identifiziert. Erst im Jahre 1976, also ein halbes Jahrhundert später, konnte dieser Zusammenhang schließlich von Hays, Imbrie und Shackleton nachgewiesen werden. Diese gesicherte geowissenschaftliche Erkenntnis findet allerdings keinen Eingang in den besagten Novo-Artikel, der sich argumentativ an klimaalarmistischen Einzelveröffentlichungen entlanghangelt.

Die Milanković-Zyklen der Erdumlaufbahn werden schließlich argumentativ bemüht, um den Beginn eines menschengemachten CO2-Klimawandels noch weiter bis zum Ende der letzten Eiszeit zurückzudatieren, Zitat aus dem Novo-Artikel mit Hervorhebungen:

„Unser Wissen über die Milanković-Zyklen ermöglicht uns, Vorhersagen über die zukünftige Entwicklung des Klimas zu treffen. Nach dem aktuellen Zyklus hätte vor etwa 5000 Jahren das nächste Glazial beginnen müssen. Dass das nicht eingetreten ist, liegt an dem anderen Faktor, der neben der auftreffenden Sonnenenergie unser Klima maßgeblich beeinflusst: den Treibhausgasen. Genauer: am menschlichen Treibhausgasausstoß. Vor etwa 12.000 Jahren, im Neolithikum, begann ein globaler Übergang von Jäger- und Sammlerkulturen zu sesshaften Bauern. Um Flächen für die Landwirtschaft zu gewinnen, wurden im großen Stil Brandrodungen durchgeführt, was erhebliche Mengen an CO2 freisetzte. Hinzu kam Methan durch Viehhaltung und Reisanbau (Reisfelder sind im Wesentlichen künstliche Sümpfe). Mit der Industrialisierung im 19. Jahrhundert nahm die CO2-Konzentration durch die Verbrennung von Kohle und später Erdöl und Erdgas weiter zu…

Korrekt dauert eine Zwischeneiszeit aber etwa 10.000-15.000 Jahre, sodass unsere gegenwärtige Warmzeit mit bisher etwa 12.000 Jahren Dauer noch voll im Zeitrahmen ihrer Vorgänger liegt. Selbst das IPCC geht übrigens davon aus, dass erst seit den 1950-er Jahren eine Klimawirksamkeit von anthropogen erzeugtem CO2 nachweisbar sei. Die Rückdatierung des menschlichen Einflusses auf das Ende der letzten Eiszeit ist also ein völlig unwissenschaftlicher Akt.

Dem Novo-Autor gebührt jedenfalls ein Lob für seine sachliche Auseinandersetzung mit den vorgeblichen Klimawandelfolgen. Man kann daher sicherlich davon ausgehen, dass er sich intensiv über die wissenschaftlichen Grundlagen seines Beitrags informiert hatte. Im Umkehrschluss muss man dann anhand der oben aufgezeigten Mängel den Schluss ziehen, dass die hier genannten geowissenschaftlichen Grundlagen der natürlichen Paläo-Klimagenese durch den fortwährenden CO2-Klimaalarmismus inzwischen völlig aus der aktuellen gesamtwissenschaftlichen Darstellung verdrängt worden sind.

Die gesamte klimawissenschaftliche Argumentation dieses Artikels baut also einseitig auf einem alarmistischen und grob überzeichneten CO2-Antrieb für die Genese unseres Paläoklimas auf, der so niemals existiert hat. Es ist offenbar dem klimawissenschaftlichen Zeitgeist geschuldet, alle bekannten geologischen und paläoklimatischen Mechanismen mit einem vermeintlichen CO2-Klimaantrieb zu verknüpfen. Das Aktualitätsprinzip der Geologie verlangt aber, dass sich alle vom Menschen postulierten Effekte über die gesamte Erdgeschichte hinweg nachweisen lassen, um als gültig anerkannt zu werden.

Und genau das ist beim vorgeblichen CO2-Klimaantrieb eben nicht der Fall.

Aber gerade wegen der hier aufgezeigten Mängel ist die Analyse des Novo-Autors herausragend, Zitat: „Es drängt sich die Frage auf, ob es bei dem ganzen Klimaschutz-Hype wirklich um Klimaschutz geht.“

Es wurde hier also völlig richtig erkannt, dass unterschiedlichste säkulare Zielsetzungen diverser gesellschaftlicher Gruppierungen in einem gemeinsamen vorgeschobenen Klimaschutz kumulieren. Es ist daher sehr schade, dass sich dieser sachliche und unaufgeregte Artikel dem Teufelskreis menschlicher Überheblichkeit am Ende doch nicht verschließen kann, sondern einem Geoengineering zur aktiven Klimagestaltung durch den Menschen das Wort redet. Denn beides, die Angst von einer menschengemachten Klimakatastrophe, wie auch menschliches Geoengineering zur Steuerung des Klimas, überhöhen den Einfluss des Menschen auf die Stufe der herrschenden Naturgewalten.

Und so werden gerade in der abschließenden Argumentation zum Geoengineering neue Widersprüche aufgerissen, Zitat aus dem Artikel: „…Durch Geoengineering können wir uns von den massiven Vergletscherungen und Schwankungen des Meeresspiegels befreien, die unseren Planeten seit jeher heimsuchen…“

Entscheidungsvorschläge, die allein auf zeitgeistbeeinflusstem Wissen aufgebaut sind, können nicht nur, sondern sie müssen am Ende sogar zwingend katastrophale Folgen haben. Vergletscherung und Meeresspiegel auf unserer Erde hängen nämlich ursächlich miteinander zusammen. Eine durch Geoengineering von ihrer gesamten Vergletscherung befreite Erde würde am Ende einen um etwa 66 Meter höheren Meeresspiegel aufweisen. Damit wäre dann zwar tatsächlich das Problem der langsam steigenden Küstenpegel gelöst, aber nach einer solchen „Rettungsaktion“ gäbe es dann diejenigen Küsten und Inseln gar nicht mehr, die wir damit ursprünglich einmal bewahren wollten.

Anmerkung: Ingenieurwissenschaftliche Eingriffe in komplexe Systeme sind generell nicht ganz unproblematisch, insbesondere dann nicht, wenn man ein solches System genau verstanden zu haben glaubt und dieser Glaube sich dann in der Realität nicht durchsetzen lässt:

Zitat aus Wikipedia mit Hervorhebungen und Ergänzungen: „Die Kritiker (einer Einführung der Aga-Kröte nach Australien) beruhigte der für die Einführung (der Aga-Kröte) verantwortliche Reginald Mungomery 1936, indem er darauf verwies: ‚Die Ansiedlung in Queensland erfolgte nach einer sorgfältigen Abwägung der Pros und Contras und nachdem das Verhalten der Kröte bis heute keinen Anlass für die Befürchtung gibt, dass wir uns in unserem Urteil über sie getäuscht haben‘.“

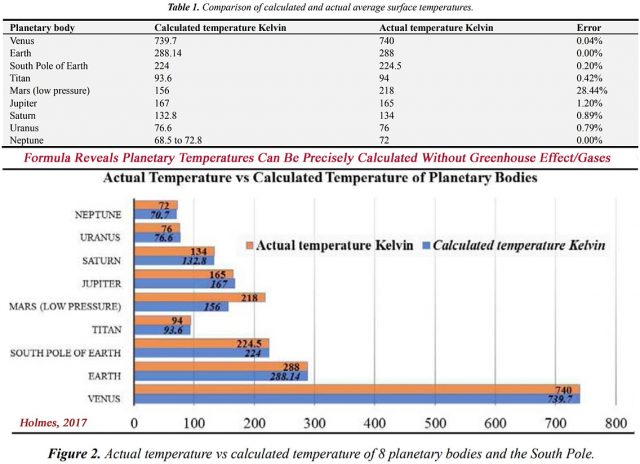

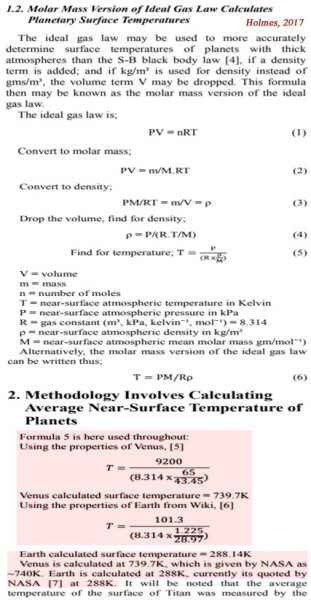

Unsere Erde hat in ihrer geologischen Vergangenheit schon mehrfach Eiszeitalter durchlaufen. Über die Ursache für diese Eiszeiten gibt es bisher nur qualitative wissenschaftliche Aussagen. Das Geoengineering stellt uns jetzt aber Mechanismen zur Verfügung, mit denen wir möglicherweise am Klimathermostaten unserer Erde herumspielen können. Aber während man die Sonneneinstrahlung rechnerisch in Raum und Zeit genau quantifizieren kann, entzieht sich der vorgeblich „natürliche“ atmosphärische Treibhauseffekt jeder genauen räumlichen und zeitlichen Definition. Und selbst die hemisphärische Herleitung der globalen Temperaturgenese ohne diesen Treibhauseffekt kann keine quantifizierbare Formel liefern. Damit ist die natürliche Temperaturgenese auf unserer Erde also völlig ungeklärt und wir wissen nicht, wie die solare Heizung unserer Erde tatsächlich funktioniert. Vor diesem Hintergrund wird jedes globale Geoengineering zu einem verantwortungslosen Vabanque-Spiel…

Wesentliche geowissenschaftliche Zusammenhänge unseres Paläoklimas sind hier zusammengefasst.