[*Ein Kerbfilter {Englisch Notch Filter} ist in der Elektrotechnik eine scharfe (Frequenz-) Bandsperre. Weiteres <a href="http://de.wikipedia.org/wiki/Kerbfilter" target="_blank">hier</a> bei Wikipedia

In diesem Beitrag geht es außerdem um einen groben Umriss des neuen Solarmodells. Es ist ein Null-dimensionales Modell. Seine Stärke liegt in seiner Einfachheit – es ist ein Verfahren von oben nach unten. Dies löst eine Menge der Probleme, die die ambitionierteren GCMs aufweisen – sie sind ein Verfahren von unten nach oben und ertrinken im Endeffekt in Rauschen und Ungewissheit. Dieses Modell hier versucht gar nicht erst, regionale oder jahreszeitliche Auswirkungen in diesem Stadium vorherzusagen. Das Wichtigste zuerst – wir müssen die Haupttreiber des globalen Klimas herausfinden.

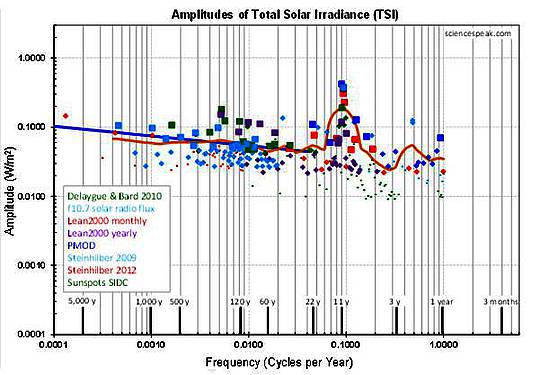

Im Folgenden erklärt David Evans, warum Sinuskurven so mächtige Instrumente sind. Einige der wichtigsten Graphiken hier sind Frequenzen – worauf wir Nicht-Elektroingenieure uns konzentrieren müssen. Man achte auf die logarithmische Skala unten. 1000-Jahres-Zyklen sind links und 1-Jahres-Zyklen rechts.

Es gibt eine Menge zu sagen. Gute Skeptiker werden an Kritiken denken und daran, Hypothesen in Frage zu stellen. Das ist alles wunderbar; man erinnere sich, dass wir diese Fragen ausführlich schon längst gestellt haben (z. B., ist es in Ordnung, Linearität zu vermuten?), und dies ist ein kurzer Artikel zur Einführung. Wir vermuten, jedoch nur zeitweise, dass die Sonnenstrahlung mit all der Erwärmung verbunden sein könnte (man beachte, ich habe nicht gesagt „verursacht“). Diese Hypothese ist für die Untersuchung verwendet und dann fallen gelassen und getestet worden. Das ist parallel zu dem was die CO2-getriebenen Modelle machen – sie vermuten, dass CO2 all diese Erwärmung verursacht hat. Sie sind einfach im Schritt „Testen“ hängen geblieben. Auch hat Evans eine Fourier-Analyse verwendet, um die Datensätze zu untersuchen und die Filter zu finden. Dann nutzte er diese Filter, um ein Modell zu konstruieren. Dieses Zwei-Schritte-Verfahren bedeutet, dass Skeptiker rote Flaggen zeigen können, die für einen Schritt relevant sind, aber durch den zweiten Schritt irrelevant werden. Ich sage dies zu Beginn in der Hoffnung, dass wir zu konstruktiverer Kritik kommen.

Wenn man es eilig hat, gehe man gleich zu den Abbildungen 5 und 6 im wichtigsten Abschnitt! Man betrachte die Spitze bei 11 Jahren und sehe, dass diese in allen Datensätzen auftaucht!

——————————————————————————————————

Den Filter entdecken

Dr. David Evans

Referenz: Cite as Evans, David M.W. “The Notch-Delay Solar Theory”, sciencespeak.com/climate-nd-solar.html, 2014.

Die Kohlendioxid-Theorie ist eindeutig ungeeignet, wie die Leser hier nur zu gut wissen. Also fragten wir uns, ob nicht die Sonne Ursache eines Teils der jüngsten globalen Erwärmung sein könnte. Das heißt die Erwärmung der letzten paar Jahrzehnte, vielleicht zurück bis zum Jahr 1800 oder so.

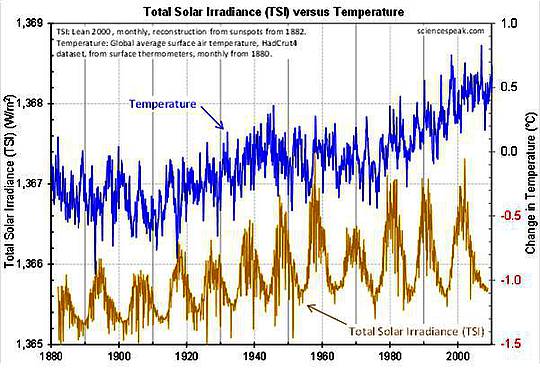

Solarstrahlung und Temperatur

Die besten und eindeutigsten solaren Datensätze sind jene der Gesamt-Solarstrahlung TSI, oder die Gesamtenergie von der Sonne in allen elektromagnetischen Frequenzen – hauptsächlich sichtbar als Licht, aber auch als UV und einige Infrarot-Frequenzen. Diese Datensätze schätzen die Gesamtenergie von der Sonne, die auf eine Fläche fällt, die sich an der Stelle der mittleren Entfernung der Erde von der Sonne befindet (1 Astronomische Einheit AE). Die TSI-Daten sind daher Jahreszeiten-bereinigt, so dass sie uns nichts darüber sagen können, was in Zeiträumen passiert, die kürzer sind als ein Jahr oder bei Häufigkeiten, die größer sind als ein Zyklus pro Jahr (das wird später noch wichtig). Die TSI wird in Watt pro Quadratmeter (W/m²) gemessen.

Die Temperatur, an der wir am meisten interessiert sind, ist die in unserer unmittelbaren Umgebung, die „globale mittlere Lufttemperatur an der Erdoberfläche“, also Lufttemperaturen auf oder nahe der Oberfläche, die über den gesamten Planeten gemittelt sind. Wenn wir den Begriff „Temperatur“ ohne weiteren Zusatz in diesem Beitrag verwenden, dann ist genau diese Temperatur gemeint. Die „globale Erwärmung“ ist der Anstieg dieser Temperatur.

Das Anfangsziel dieses Projektes ist es, eine Antwort auf die folgende Frage zu finden: Falls die jüngste globale Erwärmung fast durchweg der Solarstrahlung geschuldet ist und keinen Zusammenhang mit CO2 aufweist, welches solare Modell kann dies abdecken?

Konstruieren wir also dieses Solarmodell

Wir peilen eine Art Blackbox an, dessen Input die TSI und dessen Output die Temperatur ist.

Das Klimasystem ist angenähert linear hinsichtlich kleiner Störungen, wie sie seit dem Ende der letzten Eiszeit aufgetreten sind. In der Klima-Modellierung ist es üblich anzunehmen, dass das Klimasystem linear ist. Das Klimasystem ist auch „unveränderlich“, was einfach bedeutet, dass sich deren Eigenschaften nicht signifikant mit der Zeit ändern. Also nehmen wir an, dass das Klimasystem linear und invariant ist, zumindest während der letzten paar hundert Jahre (und vermutlich bis zurück zum Ende der letzten Eiszeit).

Der Weg, ein lineares und invariantes System zu analysieren erfolgt mittels Sinuswellen. Eine Sinuswelle hat eine Frequenz, eine Amplitude und eine Phase. Sinuswellen sind das Richtige für lineare invariante Systeme, weil:

• Falls der Input eine Sinuskurve ist, dann ist der Output eine Sinuskurve gleicher Frequenz.

• Bei jeder Frequenz ist das Verhältnis der Output- zur Input-Amplitude sowie die Differenz zwischen den Output- und den Input-Phasen immer die Gleiche.

• Das Verhalten bei einer Frequenz wird nicht beeinflusst von dem, was bei anderen Frequenzen passiert.

Viele Systeme sind linear und invariant, so wie freier Raum für elektromagnetische Fluktuationen. Darum sind Sinuswellen und die Fourier-Analyse so universell in unserer Analyse des Universums. Während man die Fourier-Analyse auch für bloße Kurvenanpassungen verwenden kann, liegt die wirkliche Bedeutung und Macht der Sinuskurven darin, dass sie Eigenfunktionen allerlinearen invarianten Systeme sind.

Analysieren wir also die TSIO- und Temperatur-Datensätze im Frequenzbereich. Das heißt, wir werden sie als Summe von Sinuskurven umformen.

1 Das Input-Spektrum (TSI)

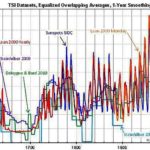

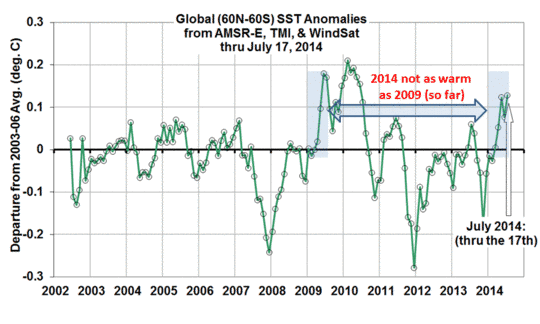

Die TSI wurde von Satelliten erst seit Ende 1978 gemessen. Die Anzahl der Sonnenflecken wurde jedoch seit 1610 aufgezeichnet, und die TSI war rekonstruiert worden nach der Anzahl der Sonnenflecken (Lean 2000). Die wesentlichen TSI-Datensätze sind die PMOD-Satellitenbeobachtungen seit Ende 1978. Leans Rekonstruktion von 1610 bis 2008 und die Steinhilber-Rekonstruktionen aus Beryllium-Isotopen in Eisbohrkernen, die 9300 Jahre zurückreichen.

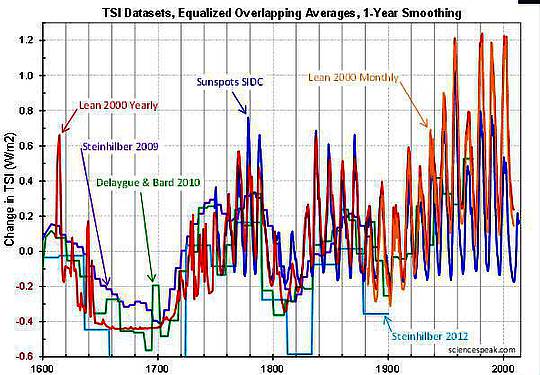

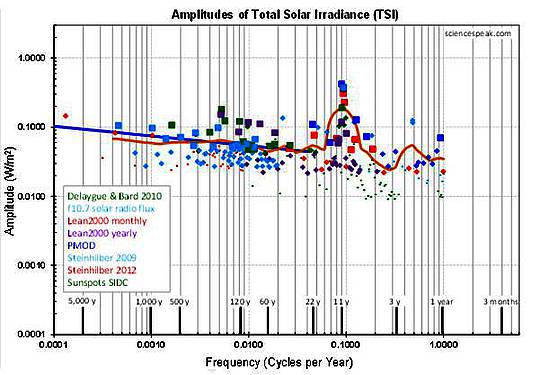

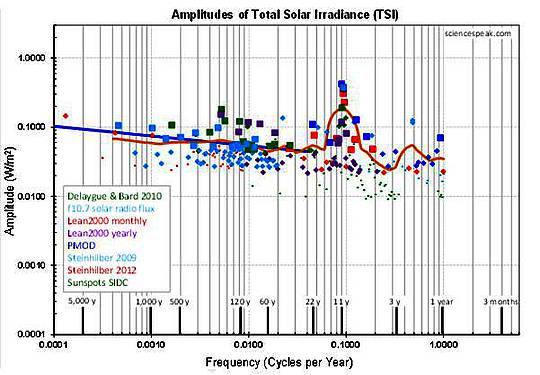

Die wesentlichen TSI-Datensätze sind verrauscht und widersprechen manchmal auch einander. Wir versuchen nicht, eine „beste“ empirische Aufzeichnung herauszupicken, sondern versuchen stattdessen, dasjenige Spektrum der TSI zu finden, das am besten zu fast allen wesentlichen TSI-Datensätzen passt. Wir kümmern uns hier nur um die Amplituden, weil die Phasen der Sinuskurven aus den Klimadatensätzen nicht zuverlässig bestimmt werden können.

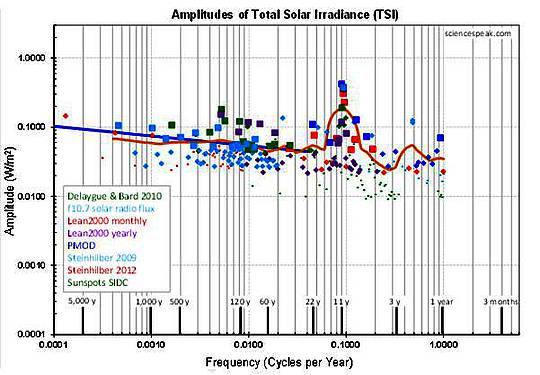

Abbildung 1: Die zur Abschätzung des TSI-Spektrums verwendeten Datensätze seit 1600.

Die vielen Nicht-Übereinstimmungen der TSI-Datensätze stehen für ein verrauschtes kombiniertes Amplituden-Spektrum [Original: The many disagreements of the TSI datasets make for a noisy combined amplitude spectrum.]

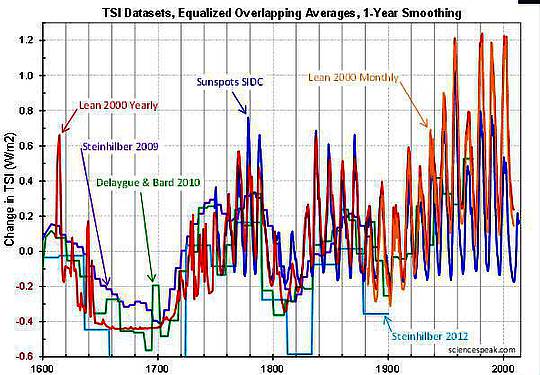

Abbildung 2: Die Amplituden-Spektren der verschiedenen TSI-Datensätze (die Reihe farbiger Punkte) und die geglättete Kurve des Best Fit (orange Linie). Größere Punkte haben mehr Gewicht bei der Glättung. Man beachte die Spitze um 11 Jahre.

Das TSI-Amplitudenspektrum ist die orangene geglättete Kurve in Abbildung 2. Sie verläuft im Wesentlichen gerade über mehr als drei Größenordnungen der Frequenz-Magnitude, mit Ausnahme einer ausgeprägten Spitze um 11 Jahre, dessen Schärfe durch die geglättete Kurve unterschätzt wird.

Die Länge eines Sonnenfleckenzyklus’ beträgt im Mittel 11 Jahre, obwohl individuelle „Zyklen“ zwischen 8 und 14 Jahren variieren. Also würden wir stärkere Sinuskurven etwa alle 11 Jahre erwarten. Dieses Spektrum entspricht unseren Erwartungen.

2 Das Output-Spektrum (Temperatur)

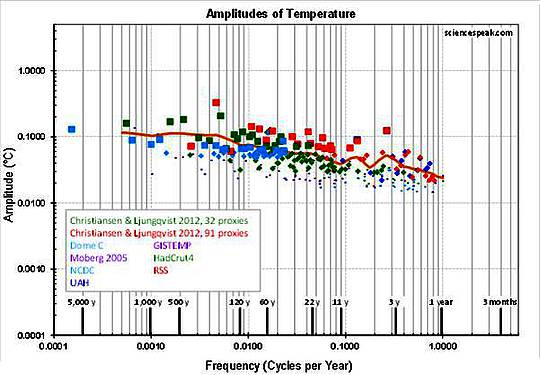

Die wesentlichen Temperaturaufzeichnungen sind die Satellitenaufzeichnungen seit Ende 1978 (UAH und RSS), die Bodenbeobachtungen mit Thermometern seit 1850 oder 1880 (HadCrut4, GISTEMP und NCDC), die beiden umfassenden Proxy-Zeitreihen von Christiansen und Ljungqvist 2012, die bis zum Jahr 1500 zurückreichen mit 91 Proxys und bis zum Jahr Null mit 32 Proxys, sowie die Eisbohrkerne aus Dome C, die 9300 Jahre zurückreichen (um zu den TSI-Daten zu passen).

Die Haupt-Temperatur-Datensätze sind verrauscht und widersprechen einander manchmal. Auch hier haben wir nicht die „beste“ empirische Aufzeichnung herausgesucht, sondern einfach versucht, das Spektrum zu finden, das am besten zu allen Haupt-Datensätzen passt.

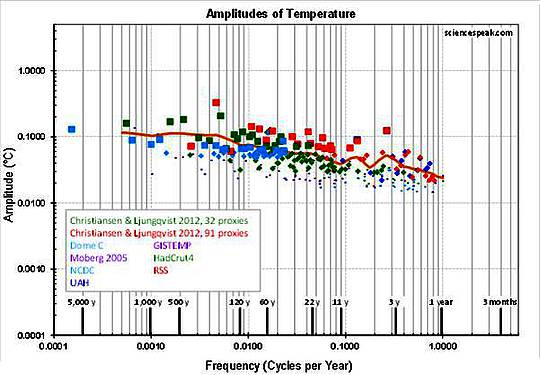

Abbildung 3: Die zur Abschätzung des Temperaturspektrums verwendeten Datensätze sind umso verrauschter und widersprüchlicher, je weiter sie zeitlich zurückreichen.

Das Temperatur-Amplitudenspektrum, die geglättete Kurve in Abbildung 4, verläuft im Wesentlichen gerade über mehr als drei Größenordnungen der Frequenz-Magnitude ohne weitere definitive Besonderheiten.

Abbildung 4: Die Amplituden-Spektren der verschiedenen Temperatur-Datensätze (die Reihe farbiger Punkte) und die geglättete Kurve des Best Fit (orange Linie). Größere Punkte haben mehr Gewicht bei der Glättung.

Man beachte den Großen Anhaltspunkt: Es gibt keine Spitze bei 11 Jahren!

Das kommt unerwartet, denn die TSI liefert die Energie, die die Erde erwärmt. Die TSI erreicht um 11 Jahre einen Spitzenwert, und doch gibt es keine korrespondierende Spitze bei der Temperatur, selbst wenn man unsere hinsichtlich Rauschens optimale Fourier-Analyse anwendet!

(Nennen wir hier einige Zahlen: Die TSI variiert normalerweise vom Minimum zum Maximum eines Sonnenfleckenzyklus’ um 0,8 W/m² von 1361 W/m². An der Erdoberfläche liegt der Wert bei 0,14 W/m² unreflektierter TSI. Falls dies eine langzeitliche Änderung war, würde die Stefan-Boltzmann-Gleichung eine Änderung der Strahlungs-Temperatur von etwa 0,05°C implizieren, was auf der Erdoberfläche zu einer Temperaturänderung von 0,1°C führen würde. Die Spitzen dauern lediglich ein oder zwei Jahre, so dass der Low-Pass-Filter im Klimasystem die Temperaturspitze zu irgendeinem Wert unter 0,1°C reduzieren würde. Die Fehler-Bandbreite der Temperaturaufzeichnungen liegt allgemein um 0,1°C, aber die Fourier-Analyse findet normalerweise sich wiederholende Beulen bis einem kleinen Bruchteil der Fehler-Bandbreite, vielleicht ein Zehntel. Allerdings sind diese Beulen nicht regelmäßig angeordnet, so dass die Nachweisbarkeit ein wenig höher wäre. In jedem Falle würden wir erwarten, dass die Temperatur nachweisbare Spitzen erreicht, wenn wir die Daten und Verfahren verwenden, wie wir es hier tun, wenn auch nicht mit einer gewaltigen Größenordnung. In einem späteren Beitrag zeigen wir eine physikalische Interpretation des Kerbfilters, der der TSI-Erwärmung entgegenwirkt, aber natürlich wäre es sehr unwahrscheinlich, dass ein solches Entgegenwirken die Temperatureffekte eines TSI-Spitzenwertes kompensieren würde. Aber angesichts dessen, dass die Bandbreite zum Auffinden eines TSI-Spitzenwertes nicht groß ist, ist es glaubhaft, dass die haupt-kompensierten TSI-Spitzen tatsächlich nicht auffindbar sind). Dieser Absatz wurde korrigiert.

Das ist ein wichtiger Hinweis. Es ist das Fehlen von etwas, das wir erwartet hatten. In der Elektronik nennt man einen Filter, der das Brummen in den Lautsprechern entfernt, einen Kerbfilter. Er eliminiert eine enge Bandbreite von Frequenzen, die wie ein Einschnitt in einer Frequenzgraphik aussehen. Ohne einen solchen Kerbfilter wäre das Brummen bei 50 oder 60 Hz oft hörbar. Es scheint, dass irgendetwas das 11-jährige „solare Brummen“ aus der Temperatur eliminiert, und darum nennen wir dieses Phänomen „den Filter“.

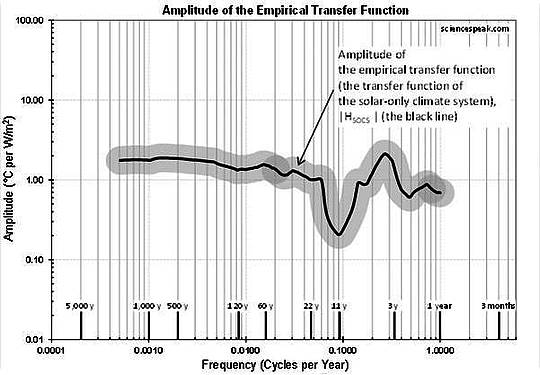

3 Die Transfer-Funktion

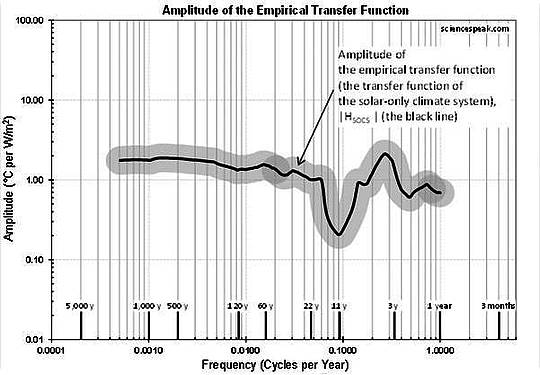

Eine Transfer-Funktion gibt an, wie eine Sinuskurve im Input durch das System transferiert wird, bis sie als Output wieder herauskommt. Hier geht es nur um Amplituden (das heißt nicht um Phasen), so dass deren Wert bei einer gegebenen Frequenz einfach die Output-Amplitude bei dieser Frequenz ist, dividiert durch die Input-Amplitude bei dieser Frequenz. Teilt man die orangene Linie in Abbildung 4 durch die orangene Linie in Abbildung 2, kommen wir zur empirischen Transferfunktion, die Abbildung 5 zeigt:

Abbildung 5: Die Amplitude der empirischen Transfer-Funktion. Die graue Zone ist ein graphisches Hilfsmittel, um es einfacher zu machen, Orte auf und zwischen den Graphiken zu beurteilen und zu vergleichen – weil sie genau am gleichen Ort in allen Diagrammen in diesem Projekt liegen.

Die Transfer-Funktion ist ziemlich flach, außer für die Kerbe beim Zeitpunkt 11 Jahre und Hinweisen auf einen Abfall bei den höheren Frequenzen.

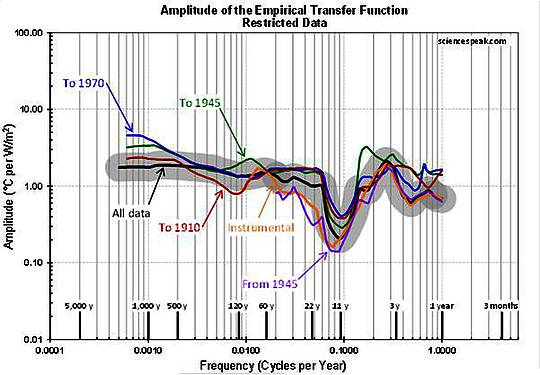

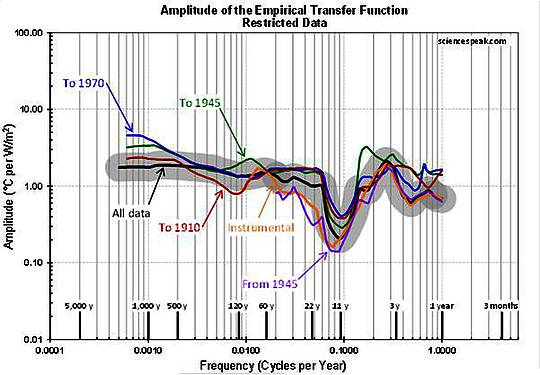

Die Kerbe ist robust. Wir berechneten die empirische Transfer-Funktion aus Sequenzen der Datensätze, wie die Daten vor 1945 oder nach 1945, und in jedem Fall ist die Kerbe klar erkennbar.

Abbildung 6: Die Amplituden der empirischen Transfer-Funktion, wenn die Daten in der markierten Weise begrenzt werden (das heißt, unter Verwendung einer Sequenz des Datensatzes, der zur Erstellung von Abbildung 5 verwendet wurde). Die schwarze Linie und die graue Zone sind entsprechend Abbildung 5.

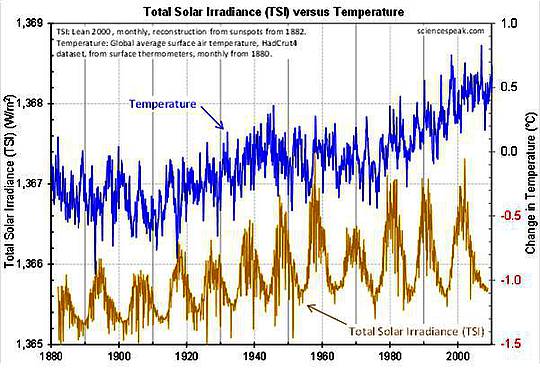

Die Kerbe ist eine so prominente Erscheinung, dass wir sie verifizieren können einfach durch den Vergleich der TSI mit der Temperatur:

Abbildung 7: Die Solarstrahlung zeigt einen starken Ausschlag etwa alle 11 Jahre, die Temperatur aber nicht.

Im nächsten Beitrag wollen wir das Solarmodell konstruieren, beginnend mit einem Kerbfilter.

Link: http://joannenova.com.au/2014/06/big-news-part-ii-for-the-first-time-a-mysterious-notch-filter-found-in-the-climate/

Anm. d. Übers.: Es folgen jetzt noch einige technische Einzelheiten, die man sich gerne im Original anschauen möge. Dieser Beitrag ist offenbar einer in einer neunteiligen Reihe. Die alle zu übersetzen schaffe ich nicht, das würde auch zu weit führen. Hier gibt es jedoch eine Zusammenfassung aller neun Artikel, die hier in deutscher Übersetzung folgt:

The Notch-Delay Solar Theory

Eine neue Theorie zeigt, dass natürliche Einflüsse die jüngste globale Erwärmung erklären können. Die Theorie wird derzeit der Welt vorgestellt in einer Reihe von Blogbeiträgen auf dem Blog von Joanne Nova.

Teil I: historische Entwicklung – Einführung eines neuen solaren Klimamodells (hier)

Teil II: Zum ersten Mal – ein mysteriöser Kerbfilter beim Klima wurde gefunden. Falls die jüngste globale Erwärmung fast durchweg mit der Sonneneinstrahlung verknüpft war und keine Abhängigkeit von CO2 besteht – welches solare Modell würde dies abbilden können? Wir wollen dieses Modell konstruieren. Wir nehmen an, dass das System von der Gesamt-Sonneneinstrahlung (TSI) zur Temperatur linear und invariant ist. Also verwendeten wir Sinuskurven und Frequenzen für die Analyse. Die TSI erreicht alle 11 Jahre einen Spitzenwert, doch gibt es keinen korrespondierenden Spitzenwert bei der Temperatur, was unerwartet kommt. Dies impliziert, dass es einen natürlichen Kerbfilter gibt, der das 11-jährige ‚Brummen‘ von der Sonne herausfiltert [siehe Übersetzung oben inkl. Link).

Teil III: Die Kerbe bedeutet eine Verzögerung. In der Literatur gibt es viele unabhängige Ergebnisse hinsichtlich einer Verzögerung um 11 Jahre zwischen Änderungen der Solarstrahlung und einer korrespondierenden Auswirkung auf die Temperaturen der Erde, und ohne eine Verzögerung ist kaum zu verstehen, wie solare Änderungen viel Einfluss auf die Temperatur an der Erdoberfläche haben können (z. B. Lockwood und Fröhlich 2007). Die Möglichkeit einer Verzögerung ist hoch, so dass wir sie in unser Solarmodell eingehen lassen (Ursprünglich hatten wir gedacht, dass eine Kerbe in einem linearen invarianten System notwendigerweise die Existenz einer damit verbundenen Verzögerung impliziert. Später stellte sich jedoch heraus, dass dies nicht der Fall war). Das Klimasystem gleicht einem Eimer voll Wärme, wobei unreflektierte Solarstrahlung oben hineinfließt und Abstrahlung in den Weltraum aus einem Loch im Boden erfolgt. Dieser Mechanismus hat dieselbe Gleichung wie ein Low-Pass-Filter in unserem Solarmodell, um das thermische Beharrungsvermögen des Klimasystems nachzuahmen (hier).

Teil IV: Ein großer Schritt zum Verständnis der 11-jährigen solaren Verzögerung. Physikalische Interpretation der Kerbe und der Verzögerung. Die Verzögerung ist eine echte Verzögerung, nicht bloß eine Zeitkonstante eines dissipativen Elementes wie die Speicherung ozeanischer Wärme. Soweit wir wissen, hat nichts auf der Erde ein vieljähriges Gedächtnis, aber ein Sonnenflecken-Zyklus hat eine mittlere Länge von 11 Jahren. Die Kerbe zeigt, dass es eine ausgleichende Kraft geben muss, der die TSI-Spitzen in der Temperatur wegbügelt. Diese Kraft muss synchron mit der Sonne laufen. Es ist wichtig, sich nicht im Vorhinein festzulegen, welcher Art dieser Einfluss ist, so dass wir sie hier vorläufig „Kraft X“ nennen wollen. … Obwohl wir die Existenz dieser Kraft in den Datensätzen wiederfinden und wir deren relevante Eigenschaften kennen, wissen wir im jetzigen Stadium nicht, was Kraft X ist (hier)

Teil V: Entweichende Wärme. Die drei-Kanäle-Theorie und der RATS-Vervielfältiger. Der Low-Pass-Filter ergibt die Änderungen der effektiven Temperatur, mit der die Erde in den Weltraum abstrahlt. Die korrespondierenden Änderungen der Temperatur auf der Erde im Zeitmaßstab von einem Jahr oder mehr kann mit einem sehr einfachen Modell berechnet werden, dem RATS-Vervielfältiger (hier)

Teil VI: Konstruktion eines neuen Solar-Klimamodells mit dem Kerbfilter. Der Kerbfilter, ein Verzögerungs-Filter, der Low-Pass-Filter und der RATS-Vervielfältiger werden in der korrekten Reihenfolge arrangiert. Es zeigt sich, dass die Kerb- und Verzögerungs-Filter die Albedo der Erde modulieren – wie viel Solarstrahlung wird in das Klimasystem eingelassen nach Reflektionen durch Wolken, Eis, Schnee und so weiter. Der unmittelbare Weg für TSI-Änderungen, die die Erde direkt erwärmen, wird hinzugefügt, und damit ist das Modell komplett. Die Einschwingphase des Modells wird untersucht (hier)

Teil VII: Nachhersage mit dem Solarmodell. Das Kerbfilter-verzögerte Solarmodell spiegelt die Temperaturen von 1770 bis 2013 ziemlich gut, platziert es doch die wesentlichen Wendepunkte etwa an den richtigen Stellen, einschließlich des „Stillstands“. Es reproduziert auch einige der kurzfristigen Schwankungen, bekannt als „natürliche Klimavariation“, was das CO2-Modell überhaupt nicht kann, weil der CO2-Gehalt gleichmäßig steigt. Das Kerbfilter-verzögerte Solarmodell ist ein quantifiziertes, physikalisches Modell – nicht bloß über den Daumen gepeilt, ohne eine grobe Berechnung, Kurvenanpassung oder unerklärte Korrelationen. Seine Existenz zeigt, dass die globale Erwärmung der letzten beiden Jahrhunderte hauptsächlich mit der TSI und nicht CO2 in Verbindung stehen könnte. Dies überführt einen der felsenfesten Glaubensgrundsätze zur anthropogenen globalen Erwärmung, nämlich dass die jüngste globale Erwärmung ausschließlich über das CO2 erklärlich ist. Die Kerbfilter-Verzögerungs-Theorie bietet eine zweite, alternative Lösung für das Klimaproblem [so es ein solches gibt, Anm. d. Übers.]. Klima ist nicht länger ein „einseitiges Rennen“, das einen darauf begrenzt, entweder die CO2-Theorie zu unterstützen oder sich auf deren Schwächen zu konzentrieren (hier).

Teil VIII: Die neue Solartheorie sagt eine unmittelbar bevorstehende globale Abkühlung voraus. Es gab drei große Rückgänge der Solarstrahlung während der 400 Jahre, aus denen Aufzeichnungen vorliegen. Der erste im 17. Jahrhundert führte zum Maunder-Minimum, der kältesten Periode der letzten 400 Jahre. Der zweite ereignete sich zu Napoleons Zeiten und führte zum Dalton-Minimum, der zweitkältesten Periode der letzten 400 Jahre. Der dritte begann im Jahre 2004, führte aber nicht zu einer Abkühlung… bisher jedenfalls. Die Kerbfilter-Verzögerungs-Theorie (ND) sagt, dass der Abfall der TSI-Signale ein Abfall der Kraft X ist, die nach einer Verzögerung wirksam wird, die 11 Jahre zu dauern scheint. Der Temperatur-Abfall wird also vermutlich 2004 + 11 Jahre = 2015 beginnen. Aber die Verzögerung ist an die Länge des Sonnenzyklus‘ gekoppelt, so dass die Abkühlung eher 2004 + 13 Jahre = 2017 beginnen wird. Die Abkühlung wird mindestens 0,2°C, vielleicht 0,5°C betragen, das wäre ausreichend, um die globale Erwärmung bis auf das Niveau des Jahres 1950 zurückzuschrauben. Kohlendioxid und ND-Solartheorie stimmten während des letzten Jahrhunderts überein, weil der CO2-Gehalt und die Sonneneinstrahlung parallel gestiegen waren, aber inzwischen divergieren sie scharf. Nur eine kann richtig sein, und bald werden wir wissen welche. Hier ist das Kriterium: Ein Rückgang von mindestens 0,1°C (auf 1-jähriger geglätteter Basis) der globalen mittleren Temperatur während des nächsten Jahrzehnts. Wird das Kriterium nicht erfüllt, ist die ND-Solartheorie Unsinn und sollte verworfen werden. Falls es doch dazu kommt, ist die CO2-Theorie Unsinn und sollte verworfen werden [da habe ich Zweifel, wenn das so sein sollte: Glaubenssätze werden von denjenigen, die damit Macht ausüben, sicher nicht weggeworfen, egal wie sehr sie Müll sind! Anm. d. Übers.] (hier)

Hinweis des Übersetzers: Diesen Teil 8 fand der Autor so bedeutsam, dass er ihn im Original rot gesetzt hat. Die Website-Textverarbeitung gibt das aber nicht her, weshalb der Abschnitt kursiv gesetzt ist.

Teil IX: Das Solarmodell! Die Tabelle mit allen Daten, dem Modell und den Berechnungen, alle in einer Excel-Datei, sind zum Download verfügbar, und zwar hier.

Link zu dieser Zusammenfassung: http://sciencespeak.com/climate-nd-solar.html

Alles übersetzt von Chris Frey EIKE