Rezepte zur Irreführung, mit Beispielen aus der Energiepolitik

Danach sollen auch die Kohlekraftwerke weg, weil man das Klima schützen will. Nun ist allbekannt: die Sonne geht abends unter und der Wind hat zumeist Flaute – und dennoch macht Deutschland mit seiner Energiewende unbeirrt weiter, und zwar ganz freiwillig.

Wie kann das sein?

Ein riesiges Land von 83 Millionen Menschen mit klugen und fleißigen Menschen – die zum Beispiel als Meisterleistung den Ressourcen sparenden Dieselmotor für Pkw’s entwickelt haben – will mehrheitlich ganz freiwillig zurück in die vorindustrielle Zeit ohne Stromversorgung!?!?

Mit Vernunft ist das nicht erklärbar, es ist ein Meisterstück der Demagogie.

Die Versuche von Solomon Asch und Stanley Milgram

Der Mensch verhält sich wie ein Herdentier: er folgt der Herde und er gehorcht dem Leittier. Das Herdenverhalten des Menschen wurde von Solomon Asch untersucht und in einem beeindruckenden Versuch bewiesen. Der Mensch glaubt, was ihm in ständiger Wiederholung immer und immer wieder vorgebetet wird. Wer zu Beginn noch zweifelt, folgt schließlich doch der Herde. Frau Prof. Elisabeth Noelle-Neumann begründete auf diesen Versuch ihre Untersuchungen zur „Schweigespirale“ [1]. Sie hat ein Buch dazu geschrieben, dessen Lektüre ist sehr zu empfehlen.

Die Gehorsamkeit des Menschen gegenüber der Obrigkeit wurde von Stanley Milgram in seinem Experiment untersucht und nachgewiesen. Das Erschreckende daran ist, daß auch gehorcht wird, wenn damit anderen Menschen geschadet oder sogar wehgetan wird.

Auf die Einzelheiten beider Versuche kann hier nicht eingegangen werden, sie wurden oft beschrieben, zum Beispiel (hier), (hier), (hier).

Jeder einzelne Mensch ist ein Individuum in der großen Herde eines Volkes oder der Menschheit. Die Medien vermitteln den Kontakt zwischen den einzelnen Individuen der riesengroßen Herde, sie sind das Bindeglied. Ohne die Medien gäbe es keinen Kontakt zwischen den einzelnen Menschen, anders als bei einer Herde von Tieren. Die Medien sind daher ungeheuer wichtig, damit sich ein Herdenverhalten unter Menschen ausbildet.

Das Trommelfeuer der Medien, immer wieder in allen Kanälen die gleiche Botschaft, steuert das Herdenverhalten der Menschen. So gehorcht der Einzelne der Herde. Und die Medien werden von der Obrigkeit gesteuert, sie bestimmt deren Überleben durch Zuckerbrot und Peitsche.

Die Lehren aus beiden Experimenten werden in der Politik angewandt um Wahlen zu gewinnen. Die Lehren aus beiden Experimenten wurden benutzt, um die Deutschen zum freiwilligen Ausstieg der lebensnotwendigen Stromversorgung zu bringen: zurück zum Mittelalter, und das inzwischen freiwillig mit Freude.

Beispiel 1

Die Energiewende begann, als in 1998 die Regierung Schröder – Fischer an die Macht kam und Minister Trittin die Energiewende startete. In einer Vereinbarung vom 14. Juni 2000 [2] hatte die Regierung mit den Stromversorgern den Ausstieg besiegelt. Man wollte für die Zukunft „eine umweltverträgliche und im europäischen Markt wettbewerbsfähige Energieversorgung weiter entwickeln“. Das bedeutete den Ersatz der Kernkraft durch die sogenannten „Erneuerbaren“, im wesentlichen Sonne und Wind. Natürlich wusste man, daß eine sichere Stromversorgung so nicht möglich ist, weil ja die Sonne abends unter geht und der Wind meist Flaute hat. Dennoch hatten die CEO’s der Stromversorger die Vereinbarung unterschrieben. Angesichts der vorherigen jahrelangen Kampagnen gegen die Kernkraft haben sie der Obrigkeit gehorcht, womit das Schicksal mit Deutschlands Ausstieg aus der Kernenergie seinen Lauf nahm. Zur Ehrenrettung der CEO’s muß allerdings gesagt werden:

- Sie sahen in der Zustimmung zu der „Erpressung“ durch Trittin die Möglichkeit, zukünftig ohne ständige Behinderungen den Betrieb der KKW’s weiter führen zu können.

- Es ist wohl so, daß die Herren durch das jahrelange Arbeiten unter der strengen Strahlenschutzverordnung an die Strahlengefahr geglaubt haben, die virtuelle Strahlengefahr wurde für sie zur Realität.

Den Gesetzen muß nun einmal gehorcht werden, wir wissen das. Aber wir wissen auch aus der Geschichte von Galileo bis zur Neuzeit, das es immer wieder falsche Gesetze gab und die Menschen unter Zwang zum Gehorchen gebracht wurden.

Beispiel 2

Beim Fukushima-Unfall (eine gute Zusammenfassung der Ereignisse finden Sie hier) am 15.3.2011 bestimmte die Kanzlerin Angela Merkel eine 180-Grad-Wende in der Kernenergiepolitik unseres Landes. Nachdem gerade ein halbes Jahr zuvor eine 10-jährige Laufzeitverlängerung der Kernkraftwerke beschlossen worden war, kehrte sie zurück zum Programm der Regierung Schröder – Fischer. Die gesamte CDU/CSU gehorchte und folgte dieser 180-Grad-Wende der Kanzlerin, Widerworte gegen diese Entscheidung von Frau Merkel wurden nicht oder kaum bekannt. Ich bin wenige Monate nach dieser 180-Grad-Wende aus der CSU ausgetreten, meine Mitgliedschaft in dieser Partei hatte etwa 5 Jahre betragen.

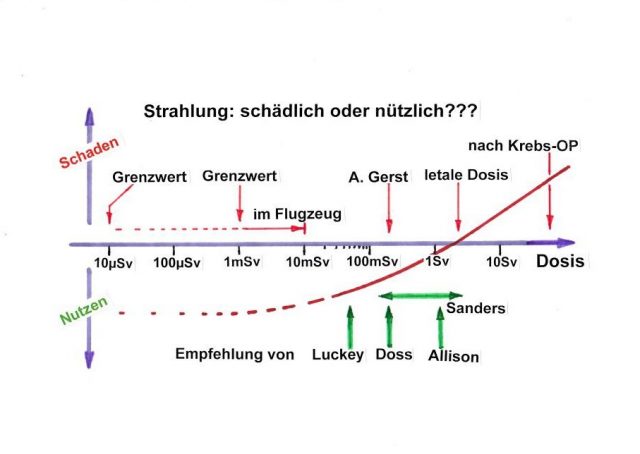

Die Ursache für dieses Gehorchen in diesem Beispiel ist eine tief verwurzelte Angst bei den Deutschen vor Strahlung von radioaktiven Stoffen. Eine gute Zusammenfassung zu den radiologischen Folgen des Unfalls in Japan finden Sie hier. Die Angst vor Strahlung hat eine Tradition seit dem Beginn der friedlichen Anwendung der Kernkraft und wurde mit den Medien im Volk verbreitet. Bei den Parlamentariern ist es hingegen die Angst vor dem Verlust eines gut bezahlten Postens, die sie zum Gehorchen ihrer Parteioberen getrieben hat.

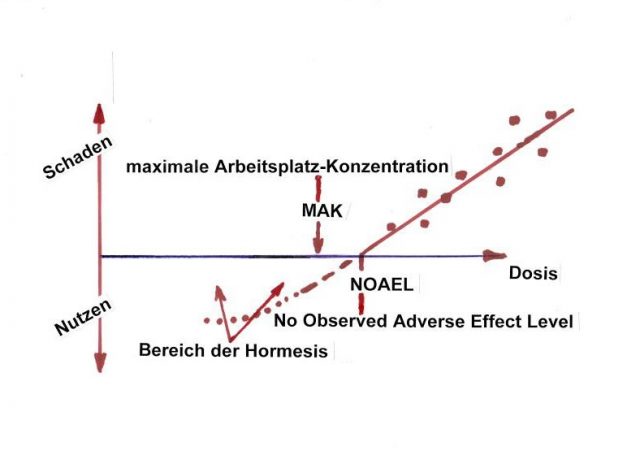

Die Mitarbeiter in den Kernkraftwerken wurden ausgebildet und dabei haben sie die gesetzlichen Bestimmungen gelernt. Mit einer einfachen Modellvorstellung zum Zusammenhang von Strahlung und Krebsentstehung „Jedes Becquerel kann Krebs erzeugen“ wird die Lehrmeinung plausibel gemacht. Diese Modellvorstellung sollte im Experiment geprüft werden. Das machen die Strahlenbiologen, die sich mit der Wirkung von Strahlung auf einen lebenden Organismus befassen. In Fachzeitschriften wie der StrahlenschutzPRAXIS wird darüber berichtet. Der Gesetzgeber – das sind die Parlamentarier im Bundestag – gehorcht der Führung seiner Partei und kennt sich in der Sache nicht aus und die genannte Fachzeitschrift wird ignoriert.

Beispiel 3

In Fukushima hatte die Tsunami-Welle das Kraftwerksgelände überflutet. Die Kraftwerke waren etwa 45 Minuten zuvor beim Erdbeben schon automatisch abgeschaltet worden. Das Wasser der Flutwelle brachte die Stromversorgung zum Erliegen, die Reaktoren konnten nicht mehr gekühlt werden. Es kam zu Kernschmelzen und der entstehende Wasserstoff mußte irgendwann abgelassen werden. Der Wasserstoff explodierte und zerstörte die Gebäude. Dabei wurde auch Radioaktivität frei gesetzt, das war verboten. Durch die automatischen Strahlungsmessungen auf dem Kraftwerksgelände und der weltweiten Verbreitung der Meßwerte war zu sehen, daß niemand durch die Zusatzradioaktivität geschädigt werden konnte.

Dennoch, eine zusätzliche Strahlendosis ist laut Gesetz verboten. Die Menschen glauben, daß mit dem Grenzwert für Strahlung eine Gefahr verbunden ist und es entsteht Angst vor der Strahlung. Es wurden ca. 100 000 Personen im Umkreis aus ihren Häusern evakuiert, desgleichen die Menschen aus Krankenhäusern und Altenheimen abtransportiert. Und nach anfänglichem Zögern wurden sogar die Patienten aus den Intensivbereichen abtransportiert. Jedermann weiß, für Intensiv-Patienten ist die Versorgung durch die vielfältigen Gerätschaften lebensnotwendig. Dennoch wurde dem Befehl zur Evakuierung gehorcht, ca. 50 Intensivpatienten starben unmittelbar danach. Diese traurige Folge der Evakuierung wird oft verschwiegen, wie zum Beispiel in folgendem Bericht. Es war per Gesetz angeordneter Tod von Unschuldigen, durchgeführt von gehorsamen Untertanen und ist ein tragisches Paradebeispiel für die Lehre vom Stanley Milgram-Versuch. Und es gab weitere Todesopfer infolge der Evakuierungen der Altenheime: Der SPIEGEL sprach von 150 bis 600 Opfern, die Fachzeitschrift StrahlenschutzPRAXIS nannte >1000 Opfer und in japanischen Quellen stand 1600 Opfer geschrieben. Das Gehorchen hatte tödliche Folgen.

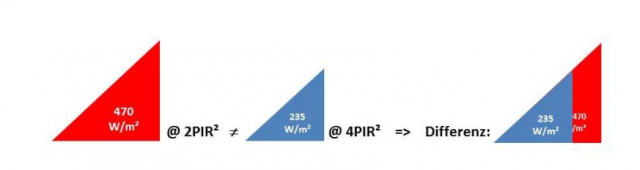

Beispiel 4

In der Folge der Ereignisse von Fukushima wurde in Deutschland die Strahlenschutzgesetzgebung verschärft. Es wurde ein Strahlenschutzgesetz geschaffen, wo zuvor eine Strahlenschutzverordnung galt. Das ist eine juristische Höherstufung. Und es wurden die Sicherheitszonen rund um die Standorte der Kernkraftwerke von 2/10/25km auf 5/20/100km erweitert. Der Anstoß für diese Erweiterung kam von der Politik, die Strahlenschutzkommission gehorchte der Politik und schrieb dazu eine Begründung, nachzulesen in Diskussionsbeiträgen in der StrahlenschutzPRAXIS 3/2014 (nur in ausgedruckter Form beim Autor erhältlich). Der Präsident der Strahlenschutzkommission war damals Prof. Dr. Wolfgang-Ulrich Müller, er kennt sich exzellent aus in der Problematik von biologischer Strahlenwirkung, das belegen seine Arbeiten zu dem Thema. Dennoch gehorchten die Fachleute der Kommission den unwissenden Politikern.

Beispiel 5

Aus dem Auspuff eines Autos kommen die Verbrennungsgase: hauptsächlich H2O und CO2. Elektromotoren haben keine Abgase, daher will die Politik Autos zukünftig mit Elektromotoren antreiben. Und die großen Autokonzerne gehorchen diesem Ansinnen, obwohl (fast) jedermann um die Unsinnigkeit dieser Idee weiß. Verkehr auf der Straße geht am besten mit Benzin oder Diesel. Woher sollte der Strom für e-Mobilität kommen, wenn aus der Stromerzeugung ausgestiegen wird???

Die Autohersteller hätten die Macht, durch Anzeigen in den großen Zeitungen auf den Unsinn der e-Mobilität hinzuweisen. Leider machen sie das nicht, sie gehorchen der Politik und werben stattdessen für e-Mobilität.

Beispiel 6: Ein Paradebeispiel für die Demagogie in den Medien durch ZDF Nachrichten am 26.4.2016 um 19:00 Uhr mit Frau Petra Gerster

Es werden zunächst Emotionen erzeugt durch Angst erzeugende Worte. Dann wird schließlich der entscheidende Satz gesagt: „Innerhalb von 25 Jahren sind ungefähr eine Million Menschen gestorben“. Dieser Satz ist derart in den ZDF-Bericht eingeschoben, daß der Zuhörer die Todesopfer dem Unfall zuordnet, was aber nicht gesagt wurde und was auch nicht geschehen ist. Daher ist der Satz richtig und nicht angreifbar. Was Petra Gerster vorgelesen hat, stammt von ausgebildeten Fachleuten in Agitation und Propaganda.

Hier der Wortlaut aus den ZDF-Nachrichten:

Petra Gerster: Tschernobyl, der Name steht für die bislang schwerste Atomkatastrophe weltweit. Heute vor 30 Jahren explodierte in dem ukrainischen Kernkraftwerk ein Reaktor. Eine radioaktive Wolke breitete sich bis nach Westeuropa aus, insgesamt 200 000 km² wurden verstrahlt, vor allem nahe des Unglücksortes mit schweren Folgen für Mensch und Natur bis heute. Der Reaktorblock 4 wurde damals zwar mit Beton versiegelt, mittlerweile aber ist die Hülle brüchig geworden. Strahlung entweicht. Nun wird vor dem Reaktorkomplex ein neuer Schutzmantel gebaut, eine bogenförmige Stahlkonstruktion, 160 m lang und knapp 110 m hoch. Dieser tonnenschwere Sarkophag soll 2017 über die Kraftwerksruine geschoben werden.

Wienand Wernicke berichtet.

Wienand Wernicke: Besuch in der alten Heimat. Alexander lebte in Pritjat, einer Stadt mit etwa 50 000 Einwohnern ganz nahe am Kernkraftwerk. Heute eine Geisterstadt, verlassen und verstrahlt. 1986 war Alexander 10 Jahre alt, gemeinsam mit seiner Mutter bewohnte er eine 1-Zimmer-Wohnung. Hier schliefen sie, als in der Nacht das Unglück passierte. Heute erzählen viele, man hätte eine Explosion gehört. Wir nicht, wir haben geschlafen. Am Morgen bin ich wie viele meiner Klassenkameraden dann ganz normal zur Schule gegangen. Es gab keine Warnung, erst später wurde evakuiert. Das Ausmaß der Katastrophe, lange verschwiegen von der Sowjetunion. 26. April 1986 ein Reaktortest gerät außer Kontrolle. Es gibt eine Explosion und einen anschließenden einen Brand. Radioaktives Material wird frei gesetzt. Die Ersthelfer, kaum geschützt und mit bloßen Händen im strahlenden Schutt ohne daß ihnen gesagt wurde wie gefährlich, wie tödlich die Arbeit war, ganze Landstriche werden verstrahlt.

Alexej Jablokow untersucht seit Jahren die Folgen des Reaktorunfalles. Sein Fazit: Die Langzeitwirkung der Strahlung ist verheerend.Innerhalb von 25 Jahren sind ungefähr eine Million Menschen gestorben und es gab durch die Strahlung etwa 2 Millionen Fehlgeburten.

Der ukrainische Präsident erinnert am Jahrestag der Katastrophe an die Opfer und zeichnet Helfer aus und erklärt, daß die Ukraine an der zivilen Nutzung der Atomkraft festhalten wolle. Ein Abschalten der noch vorhandenen Kraftwerke im Land sei vorerst nicht möglich. Zur Zeit wird ein sogenannter Sarkophag gebaut. Er soll 2017 über die Trümmer geschoben werden. Unter ihm geschützt soll dann die Reaktorruine abgerissen werden. Was danach mit dem hoch verstrahlten Areal geschieht ist noch unklar.

Petra Gerster: Frage an Wienand Wernicke vor der Kraftwerksruine in Tschernobyl: Wie gefährlich ist denn nun heute die Strahlung noch?

Wienand Wernecke: Die Strahlung hier in dem Gebiet ist relativ hoch und insofern ist es nur immer stundenweise möglich in diesem Gebiet zu sein. Das gilt auch für die Arbeiter, die an dieser Schutzhülle, diesem sogenannten Sarkophag arbeiten. Und wie stark die Strahlung ist erkennt man auch an der Tatsache, daß dieser Schutz, diese Hülle, nicht direkt über dem alten Reaktorblock gebaut wird, sondern das sind 100 oder 120 Meter Entfernung, wo das gebaut wird und dann nach Fertigstellung wird es erst darüber geschoben. Direkt an dem alten Reaktorblock wäre die Strahlung zu hoch, also insofern kann man schon ablesen, hier ist schon noch eine ganz schöne Gefahr.

Petra Gerster: Besorgnis erregende Informationen. Vielen Dank Wienand Wernecke nach Tschernobyl.

Dem geneigten Leser wird empfohlen, die aktuellen Ereignisse zu Corona unter dem Gesichtspunkt von Gehorchen und Herdenverhalten zu betrachten.

[1] „Die Schweigespirale, Öffentliche Meinung – unsere soziale Haut“ von Elisabeth Noelle-Neumann

[2] „Vereinbarung zwischen der Bundesregierung und den Energieversorgungsunternehmen vom 14. Juni 2000“. Es wurden die Restlaufzeiten der KKW’s in Deutschland festgelegt, die Erforschung von Gorleben beendet und das Recycling von abgebrannten Brennelementen verboten.