Auswertung der globalen Temperaturdaten mit statistischen Methoden

Er sagte vor den US – Kongress-Persönlichkeiten [Congresspersonages], oder wie man diese Klasse von Politicritters sonst nennen mag, Folgendes:

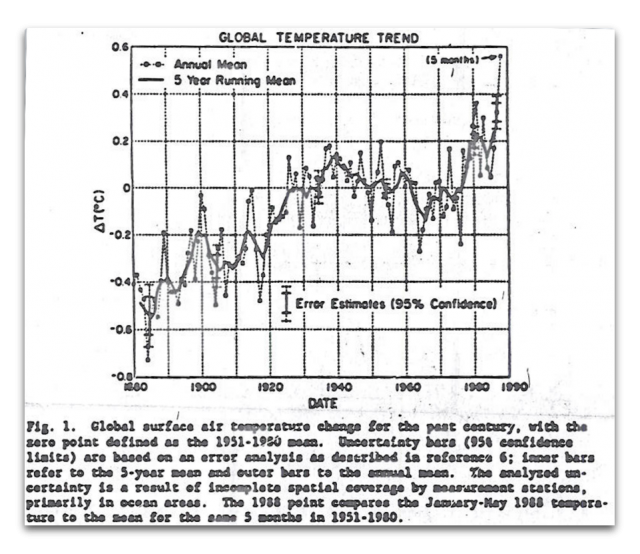

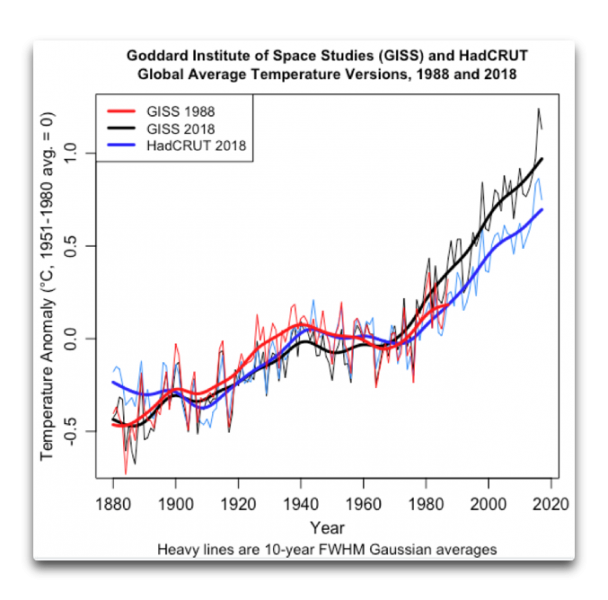

Die beobachtete Erwärmung während der letzten 30 Jahre, das heißt seit wir genaue Messungen der atmosphärischen Zusammensetzung haben, wird durch die dicke schwarze Linie in dieser Graphik dargestellt. Die Erwärmung beträgt fast 0,4°C bis 1987 relativ zur Klimatologie. Das ist der definierte Zeitraum von 30 Jahren, 1950 bis 1980, und die Erwärmung beträgt tatsächlich im Jahre 1988 über 0,4°C. Die Wahrscheinlichkeit einer zufälligen Erwärmung dieser Größenordnung liegt bei etwa 1%. Mit 99% Vertrauen können wir also feststellen, dass die Erwärmung während dieses Zeitraumes ein realer Erwärmungstrend ist.

Hier ist nun diese erwähnte Graphik:

Nun ist es entweder mein Fluch oder mein Segen, mit etwas gesegnet zu sein, was ich „einen Riecher für faule Zahlen“ nenne. Dieses ulkige Talent hat vermutlich seine Ursache im Gebrauch eines Rechenschiebers während meiner Schulzeit. Ein Rechenschieber hat keine Dezimalstellen. Falls sich also darauf das Ergebnis 3141 zeig, muss man sich überlegen, ob es 314,1 oder 3,141 oder 0,003141 oder 31410 ist. Nachdem ich dies Jahre lang gemacht hatte, entwickelte sich bei mir ein immanenter Sinn zu erkennen, ob ein Ergebnis vernünftig ist oder nicht.

Nun ist es entweder mein Fluch oder mein Segen, mit etwas gesegnet zu sein, was ich „einen Riecher für faule Zahlen“ nenne. Dieses ulkige Talent hat vermutlich seine Ursache im Gebrauch eines Rechenschiebers während meiner Schulzeit. Ein Rechenschieber hat keine Dezimalstellen. Falls sich also darauf das Ergebnis 3141 zeig, muss man sich überlegen, ob es 314,1 oder 3,141 oder 0,003141 oder 31410 ist. Nachdem ich dies Jahre lang gemacht hatte, entwickelte sich bei mir ein immanenter Sinn zu erkennen, ob ein Ergebnis vernünftig ist oder nicht.

Als mir also Hansens obiges Zitat vor Augen kam, dachte ich gleich „Unsinn! Faule Zahlen!“ Ich schaute genauer hin und fand … die Zahlen waren noch fauler.

Als erstes versuchte ich, Hansens Zahlen zu reproduzieren. Unglücklicherweise hatte er die alte GISS-Temperaturaufzeichnung herangezogen, erstellt bevor sie so adjustiert worden sind, wie sie sich heute darstellen. Sein Statement lautete auf „fast 0,4°C Erwärmung bis 1987“. Aber in den aktuellen GISS-Daten fand ich noch etwas mehr Erwärmung, nämlich 0,5°C

Nun gut. Dann machte ich daran, obigen Datensatz zu digitalisieren, um mit den Daten von Dr. Hansen arbeiten zu können. Dabei stellte sich heraus dass diese fast 0,4°C Erwärmung bis 1987 tatsächlich 0,32°C betrug. Man kann dies obiger Graphik entnehmen. Hmm … Dr. Hansens Alarmismus ist unstillbar. Man beachte auch, dass Dr. Hansen die Graphik zusammengestückelt hat und das „Jahres“-Mittel des Jahres 1988 diskutierte, obwohl er zu jenem Zeitpunkt erst wenige Monate mit Daten von 1988 hatte … schlechter Wissenschaftler, keine Cookies. Vergleiche sollten zwischen Äpfeln und Äpfeln erfolgen.

Als Nächstes ist da seine Behauptung, dass die Wahrscheinlichkeit dafür, dass die Erwärmung ein Zufallsereignis ist, 1 zu 100 beträgt. Das bedeutet, dass seine Temperatur 1987 um 2,6 Standardabweichungen wärmer sein sollte als das Mittel 1951 bis 1980. Aber noch einmal, Dr. Hansen übertreibt – es sind lediglich 2,5 Standardabweichungen vom Mittel, nicht 2,6.

Allerdings ist das nicht das eigentliche Problem. Gemeinsam mit den meisten Temperatur-Datensätzen bzgl. Klima hat Hansen den GISS-Datensatz als einen hohen „Hurst-Exponenten“ verwendet. Dies bedeutet, dass der GISS-Datensatz etwas aufweist, was „natürlich trendig“ [naturally trendy] genannt wird. In derartigen Datensätzen treten große Schwingungen viel häufiger auf als in rein zufälligen Datensätzen.

Wie viel häufiger? Nun, das können wir tatsächlich überprüfen. Er verglich den 30-jährigen „Klimatologie“-Zeitraum 1951 bis 1980 mit dem Jahr 1987. Ich machte also genau das Gleiche, aber mit anderen Jahren, d. h. ich verglich den 30-jährigen Zeitraum 1901 bis 1930 mit dem Jahr 1937, um zu sehen, wie ungewöhnlich jenes Ergebnis ist, und so weiter.

Macht man das für alle möglichen Jahre im GISS-Datensatz 1988, ergibt sich, dass der Abstand von 2,5 Standardabweichungen vom klimatologischen Mittel keineswegs ungewöhnlich ist. Es kommt in einem von 14 Jahren vor.

Und führt man die gleiche Analyse des gesamten GISS-Datensatzes bis heute durch, ist dies sogar noch normaler. In der historischen Aufzeichnung war es in einem von 7 Jahren aufgetreten. Fazit: Hansens „1 Prozent Wahrscheinlichkeit“, dass die Temperatur 1988 ungewöhnlich war, betrug in Wirklichkeit 14 Prozent Wahrscheinlichkeit … eine weitere alarmistische Fehlinterpretation – keine Überraschung angesichts der Quelle.

Schlussfolgerungen des ersten Teiles:

Betrachtet man die Wärme des Jahres 1987, welche um 2,5 Standardabweichungen wärmer ausgefallen war als das 30-jährige klimatologische Mittel, behauptete Hansen, dass die Wahrscheinlichkeit einer zufälligen Erwärmung in dieser Größenordnung etwa 1 Prozent beträgt.

In Wirklichkeit tritt eine derartige Erwärmung in der von im herangezogenen Aufzeichnung etwa alle 14 Jahre auf … und in der GISS-Aufzeichnung bis heute sogar alle 7 Jahre. Die Wahrscheinlichkeit einer zufälligen Erwärmung dieser Größenordnung in der GISS-Temperaturaufzeichnung beträgt also nicht 1 Prozent, sondern liegt zwischen 7 und 14 Prozent … was bedeutet, dass dies in keiner Weise ungewöhnlich ist.

Zweiter Teil

Im Verlauf der Recherchen zum ersten Teil dieses Beitrags erkannte ich, warum so viel darüber diskutiert wird, ob Hansens Prophezeiungen richtig oder falsch waren.Das Problem ist, dass wir in einem Zeitalter leben, dass der erfinderischste und talentierteste Cartoonist Josh das „Adjustocene“ nennt…

Das weitere Problem ist, dass Dr. James Hansens nicht nur der Knabe ist, der 1988 die alarmistischen Prophezeiungen abgab. Er ist auch derjenige, der verantwortlich war für die GISS-Temperaturaufzeichnung, von der er lange gehofft hatte, dass sie seine Prophezeiungen wahr werden lässt.

Das weitere Problem ist, dass Dr. James Hansens nicht nur der Knabe ist, der 1988 die alarmistischen Prophezeiungen abgab. Er ist auch derjenige, der verantwortlich war für die GISS-Temperaturaufzeichnung, von der er lange gehofft hatte, dass sie seine Prophezeiungen wahr werden lässt.

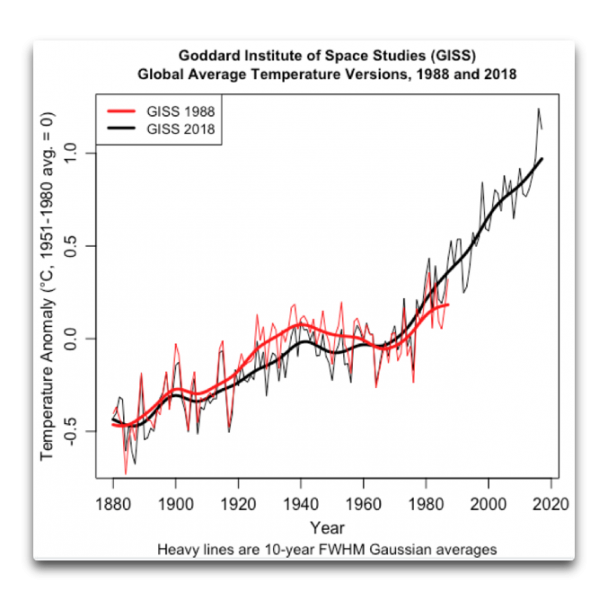

Hier sind also die Änderungen zwischen der Version der GISS-Temperaturaufzeichnungen, die Hansen 1988 herangezogen hatte, und die Version derselben aus dem Jahr 2018:

Meine Güte, das sind ein paar signifikante Änderungen. In der alten GISS-Aufzeichnung (rot) waren die Jahre 1920 bis 1950 viel wärmer als in der neuen Aufzeichnung. Folge: der alten Aufzeichnung zufolge kühlte es sich ziemlich radikal ab von etwa 1940 bis 1970 … aber in der neuen Aufzeichnung ist davon nichts mehr zu sehen.

Und es wird nicht besser, wenn wir eine andere aktuelle Aufzeichnung dem Mix hinzufügen. Hier ist der HadCRUT-Datensatz der globalen mittleren Temperatur des Hadley Centers:

Man beachte, dass HadCRUT (blau) den gleichen Temperaturrückgang von 1940 bis 1970 zeigt, der auch in der Version 1988 der GISS-Temperaturaufzeichnung auftaucht (rot). Auf den Punkt gebracht: Die Divergenz nach 1988 zwischen den Aufzeichnungen des HadCRUT und vom GISS sind groß genug, um es unmöglich zu machen zu bestimmen, ob Hansen recht oder unrecht hatte. Der Gesamttrend in den Daten GISS 2018 ist um etwa 40% größer als in den HadCRUT-Daten. Jeder bekommt also die Antwort die er haben will – er muss nur den richtigen Datensatz wählen.

Man beachte, dass HadCRUT (blau) den gleichen Temperaturrückgang von 1940 bis 1970 zeigt, der auch in der Version 1988 der GISS-Temperaturaufzeichnung auftaucht (rot). Auf den Punkt gebracht: Die Divergenz nach 1988 zwischen den Aufzeichnungen des HadCRUT und vom GISS sind groß genug, um es unmöglich zu machen zu bestimmen, ob Hansen recht oder unrecht hatte. Der Gesamttrend in den Daten GISS 2018 ist um etwa 40% größer als in den HadCRUT-Daten. Jeder bekommt also die Antwort die er haben will – er muss nur den richtigen Datensatz wählen.

Schlussfolgerungen des zweiten Teiles:

Abhängig vom gewählten Datensatz kann jeder zweigen, dass Dr. Hansens Prophezeiungen richtig oder falsch waren … die perfekten Prophezeiungen nach Art von Schrödingers Katze*.

[*Wer wissen will, was sich dahinter verbirgt, schaue hier. Anm. d. Übers.]

Und zum Schluss, ein Nebenaspekt: Was macht ein „Institute of Space Studies“, wenn es das Klima untersucht? Ich habe vorher schon von „mission creep“ (?) gehört, aber das hier ist mehr als mission creep, das ist eine außerirdische Bewegung. Ich weiß nicht, ob die Goddard-Leute es gemerkt haben, aber im Weltraum gibt es kein Klima … wie wäre es, wenn sie zurückkehren zu der Erforschung der Myriaden interessanter Dinge, welche sich im Weltraum ereignen, und die Klimaforschung weniger alarmistischen Personen überlassen?

Link: https://wattsupwiththat.com/2018/06/30/dr-hansens-statistics/

Übersetzt von Chris Frey EIKE

Man muss diese Studie buchstäblich als eine Begutachtung der Daten auf statistischer Grundlage verstehen. Ich habe eine Statistik entwickelt, um die Daten zu quantifizieren, einzuordnen und zu kategorisieren. Meine Statistik enthält keine Ecken und Kanten, sondern ist einfach die Gesamtänderung der Temperatur zwischen den ersten und den letzten 10 Jahren des Zeitraumes 1900 bis 2011 für jede Station.

Hier folgt zunächst eine Auflistung der Länder, welche die geringste bzw. die stärkste Gesamtänderung zeigen sowie die Anzahl der Stationen pro Land:

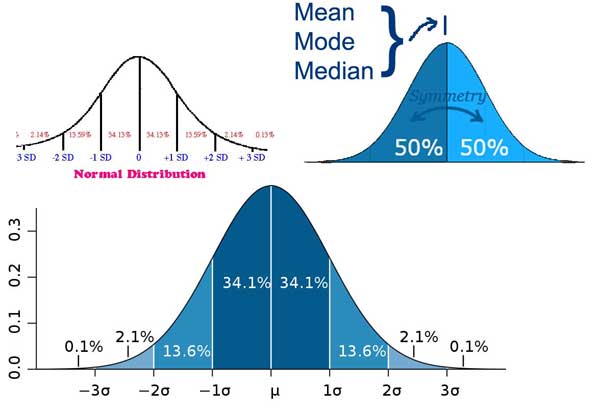

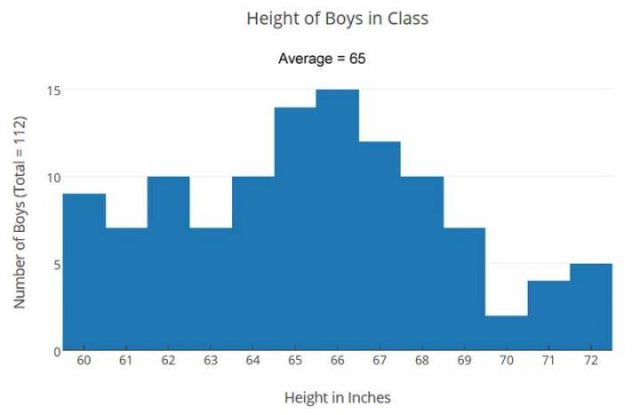

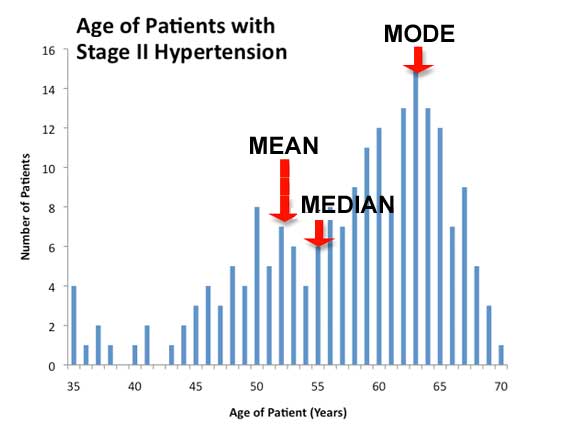

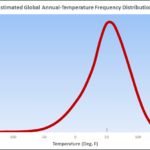

Dies ist ein altmodisches Histogramm, welches die Stationen in der Reihenfolge hinsichtlich der Gesamt-Temperatur listet. Diese zeigt die Daten in einer Glockenkurve. Die zugrunde liegende Verteilung ist sehr ähnlich einer Normalverteilung. Das bedeutet, dass die Anwendung normaler Verfahren sehr vernünftige Abschätzungen ergeben wird. Für einen Statistiker ist dies bedeutsam. Allerdings braucht man kein Hintergrundwissen in Statistik, um das Folgende zu verstehen.

Der Wert der Mittellinie liegt zwischen -0,5° und +0,5°. Die Anzahl der insgesamt eine Abkühlung zeigenden Stationen macht 40% aus. Etwas weniger als 60% zeigen eine Erwärmung. Die absolute Änderung ist an 74,6% aller Stationen statistisch nicht signifikant.

Die folgende Graphik zeigt eine normalisierte Darstellung jeder Kategorie: Keine signifikante Änderung, signifikante Erwärmung und signifikante Abkühlung. Der Graph zeigt gleitende Mittel über 10 Jahre. Jeder Plot ist so normalisiert worden, dass das Mittel des Zeitraumes 1900 bis 1910 Null beträgt.

Obwohl die Steigung jedes Plots signifikant unterschiedlich ist, ist der Verlauf der Kurven nahezu identisch. Eine Zufallssammlung individueller Stationsdaten zeigt, dass die Bedingungen für jede Station innerhalb der Bandbreite wahr bleiben. Zum Beispiel zeigt die dänische Grönland-Station, dass das Mittel der Jahre 1990 bis 2000 gleich ist dem Mittel von 1930 bis 1940.

Kurzfristige Änderungen wie etwa die Erwärmung bis in die dreißiger Jahre, sind bei einer Mehrheit der Stationen eindeutig erkennbar. Andere Beispiele hiervon sind der Temperatursprung der vierziger Jahre, die Abkühlung nach 1950 und der Temperatursprung zum Ende der neunziger Jahre.

Langfristige Änderungen variieren signifikant.

Aus dieser Analyse lässt sich eine ganze Reihe von Schlussfolgerungen ablesen:

● Es gibt keinen statistisch signifikanten Unterschied zwischen Nordamerika und Europa. Die eine signifikante Abkühlung zeigenden Stationen machen nur 8% der Gesamtzahl aus. Bei dieser Statistik wäre die erwartete Anzahl von 17 eine Abkühlung zeigenden Stationen nur eine. Die Anzahl der eine signifikante Erwärmung zeigenden Stationen wäre 3. Vom Standpunkt der Stichprobenmenge aus sind 17 keine ausreichend große Stichprobe, um genaue Schätzungen zu erhalten.

● Kurzfristige Änderungen, welche Stationen von Kanada über die USA bis Europa erkennbar sind, sind möglicherweise hemisphärische Änderungen. Allerdings gibt es keinen Hinweis darauf, dass diese Änderungen global sind, gibt es doch keine Anzeichen ähnlicher Änderungen in Australien. Tatsächlich unterscheidet sich die Gesamtverteilung in Australien offensichtlich von dem, was wir hier sehen.

● Die Beweise zeigen eindeutig, dass die große Variation an den Gesamt-Temperaturtrends entweder regionalen oder lokalen Faktoren geschuldet ist. Wie in der Datentabelle oben gezeigt stammen alle Extreme dieser Variation aus den USA. Wie schon erwähnt reicht die Stichprobenmenge aus Europa einfach nicht aus, um genaue Schätzungen von Bedingungen mit kleiner Prozentzahl zu erhalten.

● Weiter zeigt sich eindeutig, dass die meisten Differenzen der Gesamt-Temperaturänderung lokalen Faktoren geschuldet sind. In den USA erkennt man, dass extreme Erwärmung allgemein auf Gebiete mit starker Zunahme der Bevölkerung, Wachstum oder hohem Entwicklungsniveau beschränkt sind. Große Städte wie San Diego, Washington DC und Phoenix folgen dem verlauf signifikanter Änderung. Das gilt auch für Flughäfen. Allerdings folgen Städte wie New Orleans, St. Louis, El Paso und Charleston der Verteilung ohne signifikante Änderung.

Schlussfolgerung: Der Fall globale Erwärmung auf der Grundlage der verfügbaren langzeitlichen Daten ist sehr schwach. Es gibt Hinweise, dass eine hemisphärische Verteilung existiert. Weitere Beweise zeigen, dass es sich um eine zyklische Verteilung handelt, die in lokalisierten Temperaturspitzen während der dreißiger und der neunziger Jahre zum Ausdruck kommt. Allerdings scheinen Veränderungen der lokalen Umstände an den Stationen infolge menschlicher Entwicklungen der wichtigste Faktor zu sein, welcher die Gesamt-Temperaturänderungen beeinflusst. Extreme Erwärmungstrends sind fast mit Sicherheit auf vom Menschen vorgenommene lokale Änderungen zurückzuführen.

Unklar bis zu diesem Punkt ist die Bedeutung geringerer, vom Menschen induzierter Änderungen. Um dies abzuschätzen, bedarf es der Untersuchung individueller Stationsorte, um eine signifikante Stichprobe von Stationen zu erhalten, die keine Änderung zeigen. Unglücklicherweise hat man sich in den USA, in Kanada und Europa nicht einmal ansatzweise dieser Art von Informationen verschrieben wie in Australien. Ich muss zugeben, dass die Australier exzellente Arbeit geleistet haben, um Stationsinformationen verfügbar zu machen. Mit den aktuellen Koordinaten der tatsächlichen Teststationen war dies einfach. Ich schaute einfach bei Google Maps und war in der Lage, den Aufstellort und die Umgebung zu begutachten.

Mark Fife holds a BS in mathematics and has worked as a Quality Engineer in manufacturing for the past 30 years.

Übersetzt von Chris Frey EIKE

In den Kommentaren zu meinen letzten Beiträgen über Tidenmessgeräte erhob sich die Frage der Beständigkeit der Unsicherheit in den Original-Messungen. Hier folgen die Fragen, die zu beantworten ich mit diesem Beitrag versuchen möchte:

Falls Originalmessungen bis auf eine Unsicherheit von +/- X (irgendein Wert in irgendeiner Einheit) durchgeführt werden, überträgt sich dann die Unsicherheit der Originalmessung auf einen oder alle Mittelwerte dieser Messungen?

Sorgt die Durchführung weiterer Messungen bis auf den gleichen Grad Unsicherheit genau die Berechnung noch genauerer Mittelwerte?

Meine Haltung in diesem Beitrag ist Folgende:

Falls jede Messung nur auf ± 2 cm genau ist, dann kann das monatliche Mittel nicht NOCH genauer sein – es muss die gleiche Bandbreite von Fehlern/Unsicherheiten enthalten wie die Originalmessungen, aus denen das Mittel gebildet worden ist. Die Mittelung bringt keine Erhöhung der Genauigkeit.

Es wäre untertrieben zu sagen, dass es sehr viel Uneinigkeit von einigen Statistikern und jenen mit einer klassischen statistischen Ausbildung gab.

Ich werde mich nicht über das Thema Präzision oder Präzision von Mittelwerten auslassen. Es gibt dazu eine gute Diskussion bei Wikipedia: Accuracy and precision.

Gegenstand meiner Bedenken hier ist diese reine Trivial-Genauigkeit [vanilla accuracy]: „Genauigkeit einer Messung ist der Grad, wie nahe Messungen von bestimmter Anzahl an dem wahren Wert jener Quantität liegt“. (,Wahrer Wert‘ bedeutet hier den tatsächlichen Wert in der realen Welt – nicht irgendein kognitives Konstrukt desselben).

Der allgemeine Standpunkt der Statistiker wird in diesem Kommentar zusammengefasst:

„Die Aussage, dass die Genauigkeit des mittleren Meeresspiegels an einer Stelle nicht verbessert wird durch die Durchführung vieler Messungen über einen verlängerten Zeitraum ist lachhaft und legt ein fundamentales Fehlen von Verständnis der physikalischen Wissenschaft an den Tag“.

Ich gebe zu, dass ich frisch von der Universität einmal diesem Standpunkt zugestimmt habe. Und zwar bis ich einem berühmten Statistiker die gleiche Frage vorlegte. Sofort und gründlich wurde ich mit einer Reihe von Hausaufgaben konfrontiert, womit ich mir selbst beweisen sollte, dass der Gedanke in vielfacher Hinsicht unrichtig ist.

Erstes Beispiel:

Beginnen wir mit einem einfachen Beispiel über Temperaturen. Temperaturen in den USA werden in ganzen Grad Fahrenheit gemessen und aufgezeichnet. (Fragen Sie mich nicht, warum wir nicht den wissenschaftlichen Standard benutzen. Ich weiß es nämlich nicht). Diese Aufzeichnungen in ganzen Grad Fahrenheit werden dann mittels eines Rechners in Grad Celsius konvertiert, und zwar bis zur ersten Dezimalstelle, also beispielsweise 15,6°C.

Dies bedeutet, dass jede und alle Temperaturen zwischen beispielsweise 72,5°F und 71,5°F als 72°F aufgezeichnet werden. (In der Praxis wird die eine oder andere Messung mit X,5 ausgesondert und die anderen ab- oder aufgerundet). Folglich bedeutet eine amtliche Temperaturaufzeichnung vom Battery Park um 12 Uhr mittags von „72°F“ in der realen Welt, dass die Temperatur mittels Messung in der Bandbreite zwischen 71,5°F und 72,5°F liegt – mit anderen Worten, die präsentierte Zahl repräsentiert eine Bandbreite von 1°F.

In der wissenschaftlichen Literatur könnten wir diesen Umstand in der Schreibweise 72 +/- 0.5 °F wiederfinden. Oftmals wird dies dann als eine Art „Vertrauensintervall“, „Fehlerbalken“ oder Standardabweichung missverstanden.

In diesem spezifischen Beispiel einer Temperaturmessung ist es nichts von diesen Dingen. Es ist einfach eine Form von Stenogramm für das tatsächliche Messverfahren, welches jedes Grad Bandbreite von Temperatur als eine einzelne ganze Zahl repräsentiert – wenn die Bedeutung in der realen Welt lautet „eine Temperatur mit einer Bandbreite von 0,5 Grad über oder unter der präsentierten ganzen Zahl“.

Jede Differenz zur tatsächlichen Temperatur über oder unter der präsentierten ganzen Zahl ist kein Fehler. Diese Abweichungen sind keine „Zufallsfehler“ und sind nicht „normalverteilt“.

Noch einmal zur Betonung: Die ganze Zahl einer präsentierten Temperatur an irgendeiner Stelle zu irgendeiner Zeit ist ein Kürzel für eine ein Grad große Bandbreite tatsächlicher Temperaturen, die obwohl laut Messung unterschiedlich in Gestalt der gleichen ganzen Zahl gemeldet werden. Visuell:

Obwohl in der Praxis die Temperaturen nur in ganzen Zahlen gemeldet werden, ändern sich die Temperaturen in der realen Welt nicht in Schritten von einem ganzen Grad – 72, 73, 74, 72, 71 usw. Temperatur ist eine kontinuierliche Variable. Und nicht nur das, sie ist eine sich ständig ändernde Variable. Wenn man Temperatur einmal um 11:00 und dann um 11:01 misst, misst man zwei unterschiedliche Quantitäten; die Messungen erfolgen unabhängig voneinander. Außerdem ist einer und sind alle Werte innerhalb der Bandbreite gleich wahrscheinlich – die Natur „bevorzugt“ keine Temperaturen, welche näher an der ganzen Zahl liegen.

(Anmerkung: In den USA werden ganze Grad Fahrenheit in Grad Celsius bis zur ersten Stelle nach dem Komma gerundet. 72°F werden konvertiert und ebenfalls aufgezeichnet als 22,2°C. Die Natur bevorzugt auch nicht Temperaturen, die näher an einem Zehntelgrad Celsius liegen).

Während es gegenwärtig Praxis ist, eine ganze Zahl zu melden, um die Bandbreite von ,ganzer Zahl plus ein halbes Grad und ganzer Zahl minus ein halbes Grad‘ zu repräsentieren, könnte diese Praxis auch irgendeine andere Notation sein. Es könnte auch einfach sein, dass die gemeldete ganze Zahl alle Temperaturen von der ganzen Zahl bis zur nächsten ganzen Zahl repräsentieren soll, dass also 71 bedeutet „irgendeine Temperatur von 71 bis 72“. Das gegenwärtige System der Verwendung der ganzen Zahl in der Mitte ist besser, weil die gemeldete ganze Zahl in der Mitte der sie repräsentierenden Bandbreite liegt. Allerdings ist dies einfach misszuverstehen, wenn es als 72 +/- 0.5 daherkommt.

Weil Temperatur eine kontinuierliche Variable ist, sind Abweichungen von der ganzen Zahl nicht einmal „Abweichungen“ – sie sind einfach die in Grad Fahrenheit gemessenen Temperatur, welche normalerweise durch den Dezimalanteil repräsentiert wird, welcher der Notation der ganzen Gradzahl folgen würde – der „x.4999“te Teil von 72,4999°F. Diese Dezimalanteile sind keine Fehler, sie sind nicht gemeldete und nicht aufgezeichnete Anteile der Messung, und weil Temperatur eine kontinuierliche Variable ist, muss sie als gleichmäßig verteilt über die gesamte Skala betrachtet werden – mit anderen Worten, es sind keine, keine, keine „normalverteilten Zufallsfehler“. Der einzige Grund, warum sie unsicher sind ist, dass sie selbst bei einer Messung nicht aufgezeichnet werden.

Was passiert also jetzt, nachdem wir herausgefunden haben, dass die Mittelwerte dieser Aufzeichnungen, welche – man erinnere sich – Kürzel von Temperatur-Bandbreiten sind?

Um diese Frage zu beantworten, wollen wir ein Schulexperiment durchführen…

Wir werden das Mittel von drei ganzen Grad Temperatur finden, und zwar erhalten wir diese Temperaturen in meinem Wohnzimmer:

Wie oben diskutiert, repräsentieren diese Temperaturwerte irgendwelche der unbegrenzt variablen Temperaturen, dennoch möchte ich diese kleine Graphik erstellen:

Hier erkennen wir, dass die Temperatur von jeder Stunde den höchsten Wert in der Bandbreite repräsentiert, den mittleren Wert in der Bandbreite (die gemeldete ganze Zahl) und als tiefsten Wert der Bandbreite. (Anmerkung: Wir dürfen nicht vergessen, dass es zwischen den Werten in jeder Spalte eine unendliche Anzahl von Bruchwerten gibt, die wir jetzt nur nicht zeigen). Diese Werte werden dann gemittelt – das Mittel berechnet – von links nach rechts: die höchsten Werte der drei Stunden ergeben ein Mittel von 72,5, der mittlere Wert ein Mittel von 72 und der niedrigste Wert ein Mittel von 71,5.

Das resultierende Mittel kann geschrieben werden in der Form 72 +/- 0.5, was ein Kürzel ist dafür, dass die Bandbreite von 71,5 bis 72,5 repräsentiert wird.

Die Genauigkeit des Mittels, repräsentiert in der Schreibweise +/- 0,5 ist identisch mit der Genauigkeit der Original-Messungen – sie repräsentieren beide eine Bandbreite möglicher Werte.

Anmerkung: Diese Unsicherheit stammt nicht aus der tatsächlichen instrumentellen Genauigkeit der Original-Messungen. Das ist etwas ganz anderes und muss zusätzlich zu der hier beschriebenen Genauigkeit betrachtet werden. Diese resultiert allein aus der Tatsache, dass gemessene Temperaturen als Ein-Grad-Bandbreiten dargestellt werden, wobei die Bruchteil-Informationen außen vor bleiben und für immer verloren sind, was uns mit der Unsicherheit zurücklässt – fehlendem Wissen – was die tatsächliche Messung selbst eigentlich war.

Natürlich kann die um 11:00 gemessene Temperatur 71,5; die um 12:00 gemessene 72 und die um 13:00 gemessene 72,5 betragen haben. Oder es könnte auch 70,5; 72; 73,5 gewesen sein.

Die Berechnung des Mittels zwischen den diagonal gegenüber liegenden Ecken ergibt 72 von Ecke zu Ecke. Über die Mittelpunkte ergibt sich immer noch 72.

Jedwede Kombination von höchsten, mittigen und niedrigsten Werten von jeder Stunde ergibt ein Mittel, welches zwischen 72,5 und 71,5 liegt – innerhalb der Unsicherheits-Bandbreite des Mittels.

Selbst für diese vereinfachten Netze gibt es viele mögliche Kombinationen von einem Wert aus jeder Spalte. Das Mittel jedweder Kombination liegt zwischen den Werten 72,5 und 71,5.

Es gibt buchstäblich eine unendliche Anzahl potentieller Werte zwischen 72,5 und 71,5, da Temperatur eine kontinuierliche Variable für jede Stunde ist. Das Auftreten aller möglichen Werte für jede stündliche Temperatur ist gleich wahrscheinlich – folglich sind alle möglichen Werte und alle möglichen Kombinationen eines Wertes für jede Stunde in Betracht zu ziehen. Nimmt man irgendeinen möglichen Wert aus jeder Spalte mit stündlichen Messungen und mittelt diese drei, ergibt sich immer das gleiche Ergebnis – alle Mittel haben einen Wert zwischen 72,5 und 71,5, was eine Bandbreite der gleichen Größenordnung repräsentiert wie die der Original-Messungen, eine Bandbreite von einem Grad Fahrenheit.

Die Genauigkeit des Mittels entspricht genau der Genauigkeit aus den Original-Messungen – es ist in beiden Fällen eine Ein-Grad-Bandbreite. Sie wurde um keinen Deut reduziert durch das Mittelungs-Verfahren. Das kann es auch nicht.

Anmerkung: Eine mehr technische Diskussion zu diesem Thema gibt es hier und hier.

Und die Daten der Tiden-Messgeräte?

Es ist klar, dass sich die Unsicherheit bzgl. der Genauigkeit der Original-Messungen der Temperatur aus dem Umstand ergibt, dass nur ganze Grad Fahrenheit bzw. Grad Celsius bis zur ersten Dezimalstelle angegeben werden. Das ergibt folglich keine Messungen mit einem Einzelwert, sondern stattdessen Bandbreiten.

Aber was ist mit den Daten der Tide-Messgeräte? Unterscheidet sich ein einzelner gemessener Wert bis zur Präzision von Millimetern also von obigem Beispiel? Die kurze Antwort lautet NEIN, aber ich nehme nicht an, dass das allgemein akzeptiert wird.

Welche Daten werden denn nun von Tiden-Messgeräten in den USA (und in den meisten anderen entwickelten Ländern) gemessen?

Die Geschätzte Genauigkeit wird als +/- 2 cm für individuelle Messungen angegeben, und es wird behauptet, dass diese für monatliche Mittelwerte 5 mm beträgt. Betrachten wir die Daten vom Battery-Park in New York, sehen wir etwas wie das hier:

Man beachte, dass wir laut diesem Datenblatt alle sechs Minuten (1 Zehntel-Stunde) eine Messung haben, und zwar den Wasserstand in Meter bis zum Niveau von Millimetern (4,639 m), und das „Sigma“ wird angegeben. Die Sechs-Minuten-Zahl wird folgendermaßen berechnet:

181 Eine-Sekunde-Wasserstandsmessungen zentriert um jedes Zehntel einer Stunde werden gemittelt, ein three standard deviation outlier rejection test [?] angewendet, dann werden Mittel und Standardabweichung erneut berechnet und gemeldet zusammen mit der Anzahl der Ausreißer. (3 Minuten-Wasserstandsmittel).

Um sicherzustellen, dass wir dieses Verfahren verstehen, stellte ich in einer E-Mail an @ co-ops.userservices@noaa.gov die folgende Frage:

Wenn sagen, bis zu einer Genauigkeit von +/- 2 cm meinen wir spezifisch, dass jede Messung zum tatsächlichen augenblicklichen Wasserstand außerhalb des Mess-Schachtes passt und innerhalb dieser +/- 2-cm-Bandbreite liegt.

Antwort:

Das ist korrekt! Die Genauigkeit jedes 6-minütigen Datenwertes beträgt +/- 2 cm des Wasserstandes zu jener Zeit.

(Anmerkung: In einer separaten E-Mail wurde klargestellt, dass „Sigma die Standardabweichung ist, essentiell die statistische Varianz zwischen diesen 181 1-Sekunde-Messungen“).

Frage und Antwort verifizieren, dass sowohl die 1-Sekunde-Messungen als auch der 6-Minuten-Datenwert eine Bandbreite des Wasserstandes von 4 cm, 2 cm plus oder minus vom gemeldeten Wasserstand repräsentiert.

Diese scheinbar vage Genauigkeit – jede Messung mit einer tatsächlichen Bandbreite von 4 cm – ist das Ergebnis des mechanischen Verfahrens der Mess-Apparatur, trotz der Auflösung von 1 Millimeter. Wie kommt das?

Die Illustration der NOAA des modernen Tiden-Messapparates am Battery Park zeigt den Grund. Die Blase oben links zeigt eindeutig, was während des 1-Sekunde-Intervalls der Messung passiert: Der augenblickliche Wasserstand innerhalb des Mess-Schachtes unterscheidet sich von dem außerhalb dieses Schachtes.

Diese 1-Sekunde-Ablesung wird in der „Primary data collection Platform“ gespeichert und später als Teil der 181 Messungen herangezogen, die für den gemeldeten 6-Minuten Wert gemittelt werden. Er unterscheidet sich wie illustriert von dem tatsächlichen Wasserstand außerhalb des Mess-Schachtes. Manchmal wird er niedriger, manchmal höher liegen. Der Apparat als Ganzes ist darauf ausgelegt, diese Differenz in den meisten Fällen während des 1-Sekunde-Zeitmaßstabes auf eine Bandbreite von 2 cm über oder unter dem Wasserstand im Mess-Schacht zu begrenzen – obwohl einige Ablesungen weit außerhalb dieser Bandbreite liegen und als „Ausreißer“ gelistet werden (die Regel lautet, alle 3-Sigma-Ausreißer auszusondern – aus dem Satz der 181 Ablesungen – bevor man das Mittel berechnet, welches als der 6-Minuten-Wert gemeldet wird).

Wir können nicht jede individuelle Messung als eine Messung des Wasserstandes außerhalb des Mess-Schachtes betrachten – es wird der Wasserstand innerhalb des Mess-Schachtes gemessen. Diese Im-Schacht-Messungen sind sehr genau und präzise – bis auf 1 Millimeter. Allerdings ist jede 2-Sekunde-Aufzeichnung eine mechanische Approximation des Wasserstandes außerhalb des Schachtes – also dem tatsächlichen Wasserstand im Hafen, welcher eine fortwährend sich ändernde Variable ist – spezifiziert zu der Genauigkeits-Bandbreite von +/- 2 Zentimeter. Die aufgezeichneten Messungen repräsentieren Bandbreiten von Werten. Diese Messungen enthalten keine „Fehler“ (zufällige oder andere), wenn sie sich vom tatsächlichen Wasserstand im Hafen unterscheiden. Der Wasserstand im Hafen oder im Fluss oder in der Bucht selbst ist niemals wirklich gemessen worden.

Die als „Wasserstand“ aufgezeichneten Daten sind abgeleitete Werte – und keineswegs direkte Messungen. Das Tiden-Messgerät als Messinstrument wurde so ausgerichtet, dass es Messungen innerhalb des Schachtes mit einer Genauigkeit von 2 cm, plus oder minus durchführt, welche den tatsächlichen augenblicklichen Wasserstandes außerhalb des Schachtes repräsentieren – was ja das ist, das wir messen wollen. Nach 181 Messungen innerhalb des Schachtes und dem Aussortieren jedweder Daten, die zu abwegig sind, wird der Rest der 181 Messungen gemittelt und der 6-Minuten-Wert gemeldet mit der korrekten Genauigkeits-Angabe von +/- 2 cm – der gleichen Genauigkeit also wie bei den individuellen 1-Sekunde-Messungen.

Der gemeldete Wert bezeichnet eine Werte-Bandbreite – welche immer angemessen mit jedem Wert angegeben werden muss – im Falle von Wasserständen der NOAA-Tiden-Messgeräte +/- 2 cm.

Die NOAA behauptet zu recht nicht, dass die sechs-Minuten-Aufzeichnungen, welche das Mittel von 181 1-Sekunde-Messungen sind, eine größere Genauigkeit aufweisen als die individuellen Original-Messungen.

Warum behauptet die NOAA aber dann, dass monatliche Mittelwerte bis auf +/- 5 mm genau sind? In diesen Berechnungen wird die Genauigkeit der Original-Messungen einfach komplett ignoriert, und nur die gemeldeten/aufgezeichneten Sechs-Minuten-Mittelwerte werden betrachtet (vom Autor bestätigt) – das ist der gleiche Fehler, wie er auch bei Berechnungen fast aller anderen großen Datensätze gemacht wird, indem das nicht anwendbare Gesetz Großer Zahlen [Law of Large Numbers] angewendet wird.

Genauigkeit jedoch wird, wie hier gezeigt, bestimmt durch die Genauigkeit der Original-Messungen, wenn man eine nicht statische, sich immer ändernde und kontinuierlich variable Quantität misst und dann als eine Bandbreite möglicher Werte aufzeichnet – die Bandbreite der Genauigkeit spezifiziert für das Messsystem – und die nicht durch Berechnungen von Mittelwerten verbessert werden kann.

1. Wenn numerische Werte Bandbreiten sind anstatt wahrer diskreter Werte, dann bestimmt die Größe der Bandbreite des Originalwertes (in unserem Falle die Messung) die Größe der Bandbreite jedweden nachfolgenden Mittelwertes dieser numerischen Werte.

2. Von ASOS-Stationen berechnete Temperaturen jedoch werden aufgezeichnet und als Temperaturen gemeldet mit einer Bandbreite von 1°F (0,55°C), und diese Temperaturen werden korrekt als „ganze Zahlen +/- 0,5°F“ aufgezeichnet. Die Mittelwerte dieser aufgezeichneten Temperaturen können nicht genauer sein als die Originalmessungen – weil die Aufzeichnungen der Originalmessungen selbst Bandbreiten sind. Die Mittelwerte müssen mit den gleichen +/- 0,5°F angegeben werden.

3. Gleiches gilt für die Daten von Tiden-Messapparaten, wie sie gegenwärtig gesammelt und aufgezeichnet werden. Die primäre Aufzeichnung von 6-Minuten-Werten sind trotz auf Millimeter-Genauigkeit aufgezeichneter Präzision ebenfalls Bandbreiten mit einer Original-Genauigkeit von +/- 2 Zentimetern. Dies ist die Folge des Designs und der Spezifikation des Messinstrumentes, welches das einer Art mechanisch mittelnden Systems ist. Die Mittel von Werten von Tiden-Messgeräten können nicht genauer gemacht werden als die +/- 2 cm – was weit genauer ist als notwendig zur Messung von Gezeiten und der Bestimmung eines sicheren Wasserstandes für Schiffe.

4. Wenn Original-Messungen Bandbreiten sind, sind deren Mittelwerte ebenfalls Bandbreiten von gleicher Größenordnung. Diese Tatsache darf nicht ignoriert oder missachtet werden.Tut man dies doch, erzeugt man einen falschen Eindruck von der Genauigkeit unseres numerischen Wissens. Oftmals überschattet die mathematische Präzision eines berechneten Mittels dessen reale Welt, eine weit verschwommenere Genauigkeit, was zu einer unrichtigen Signifikanz führt, welche Änderungen sehr geringer Größenordnung dieser Mittelwerte beigemessen wird.

Link: https://wattsupwiththat.com/2017/10/14/durable-original-measurement-uncertainty/

Übersetzt von Chris Frey EIKE

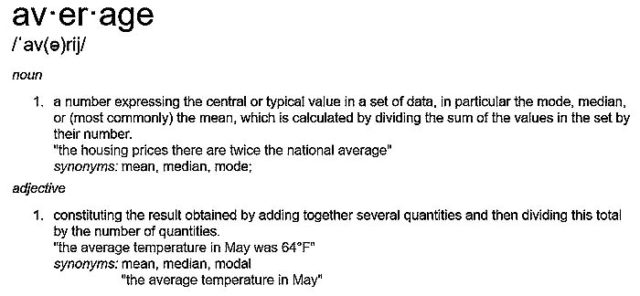

Sowohl das Wort als auch das Konzept „Durchschnitt“ sind in der breiten Öffentlichkeit sehr viel Verwirrung und Missverständnis unterworfen und sowohl als Wort als auch im Kontext ist eine überwältigende Menge an „lockerem Gebrauch“ auch in wissenschaftlichen Kreisen zu finden, ohne die Peer-Reviewed-Artikel in Zeitschriften und wissenschaftlichen Pressemitteilungen auszuschließen.

In Teil 1 dieser Serie lasen Sie meine Auffrischung über die Begriffsinhalte von Durchschnitten, Mittelwerten und Beispiele dazu. Entspricht Ihr Hintergrundwissen bezüglich Mathematik oder Wissenschaft dem großen Durchschnitt der Normalbürger, schlage ich vor, dass Sie einen schnellen Blick auf die Grundlagen in Teil 1 [Teil 1 hier übersetzt] und dann Teil 2 [Teil 2 hier übersetzt] werfen, bevor Sie fortfahren.

„Der Umgang mit Daten kann manchmal Verwirrung verursachen. Ein oft gemachter Fehler ist es, Durchschnittswerte zu mitteln. Dies ist oft zu sehen, wenn versucht wird, regionale Werte aus Landes- oder Kreisdaten abzuleiten“. – Was man mit Daten nicht machen darf: Durchschnittswerte zu mitteln.

„Ein Kunde hat mich heute gebeten, einen“ Durchschnitt der Durchschnittswerte „zu einigen seiner Leistungsberichten hinzuzufügen. Ich gebe offen zu, dass ein nervöses und hörbares Stöhnen meinen Lippen entrang, als ich mich in Gefahr fühlte, hilflos in die fünfte Dimension von „Simpsons Paradox“ zu stürzen – Anders ausgedrückt: Kann die Mittelung der Mittelwerte der verschiedenen Populationen den Durchschnitt der zusammengefassten Bevölkerung darstellen?“- Ist der Durchschnitt der Durchschnittswerte korrekt? (Hinweis: NEIN!)

„Simpsons Paradoxon … ist ein Phänomen der Wahrscheinlichkeiten und Statistik, in dem ein Trend in verschiedenen Datengruppen zu erkennen ist, aber verschwindet oder sich umkehrt, wenn diese Gruppen kombiniert werden. Es wird manchmal auch als Umkehrparadox oder Verschmelzungsparadox angegeben. „- siehe Wiki.de “Simpsons Paradox“

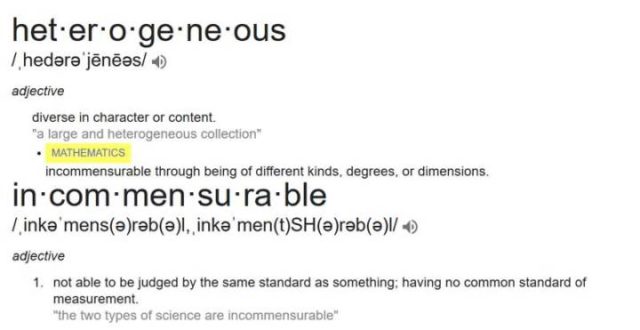

Durchschnittliche Mittelwerte sind nur gültig, wenn die Sätze von Datengruppen, Kohorten, Anzahl der Messungen – alle gleich groß sind (oder fast gleich groß) und die gleiche Anzahl von Elementen enthalten, denselben Bereich repräsentieren, die gleiche Lautstärke, die gleiche Anzahl von Patienten, die gleiche Anzahl von Meinungen und, wie bei allen Durchschnittswerten, sind die Daten selbst physisch und logisch homogen (nicht heterogen) und physisch und logisch kommensurabel (nicht inkommensurabel). [wem dies unklar ist, bitte schauen Sie noch mal Teil 1]

Zum Beispiel, hat man vier Klassen der 6. Klasse, zu denen jeweils genau 30 Schüler gehören und wollte nun die durchschnittliche Größe der Schüler finden, könnte man über es zwei Wege berechnen: 1) Durchschnitt jeder Klasse durch die Summierung der Größen der Schüler Dann finden Sie den Durchschnitt durch Division mit 30, dann summieren Sie die Mittelwerte und teilen sie durch vier, um den Gesamtdurchschnitt zu bekommen – ein Durchschnitt der Mittelwerte oder 2), Sie kombinieren alle vier Klassen zusammen für einem Satz von 120 Studenten, Summieren die Größen und teilen durch 120. Die Ergebnisse sind gleich.

Das gegenteilige Beispiel sind vier Klassen von 6. Klasse Schülern, die alle unterschiedlich groß sind und jeweils unterschiedliche Klassenstärken haben: 30, 40, 20, 60 Schüler. Die Suche nach den Mittelwerten der vier Klassen- und dann Mittelung der Mittelwerte ergibt eine Antwort – ganz anders als die Antwort, als wenn man die Größe von allen 150 Schülern summiert und dann durch 150 teilt.

Warum? Das liegt daran, dass die einzelnen Schüler der Klasse mit nur 20 Schülern und die einzelnen Schüler der Klasse von 60 Schülern unterschiedliche, ungleiche Auswirkungen auf den Gesamtdurchschnitt haben. Um für den Durchschnitt gültig zu sein, sollte jeder Schüler den 0,66ten Anteil des Gesamtdurchschnitts repräsentieren [0,66 = 1/150].

Wenn nach Klasse gemittelt wird, steht jede Klasse für 25% des Gesamtdurchschnitts. So würde jeder Schüler in der Klasse von 20 Schülern für 25% / 20 = 1,25% des Gesamtdurchschnitts zählen, während jeder Schüler in der Klasse von 60 jeweils nur für 25% / 60 = 0,416% des Gesamtdurchschnitts steht. Ebenso zählen die Schüler in den Klassen von 30 und 40 jeweils für 0,83% und 0,625%. Jeder Schüler in der kleinsten Klasse würde den Gesamtdurchschnitt doppelt so stark beeinflussen wie jeder Schüler in der größten Klasse – im Gegensatz zu dem Ideal eines jeden Schülers, der im Durchschnitt gleichberechtigt ist.

Es gibt Beispiele dafür in den ersten beiden Links für die Quoten, die in diesen Abschnitt vorgestellt wurden. (Hier und hier)

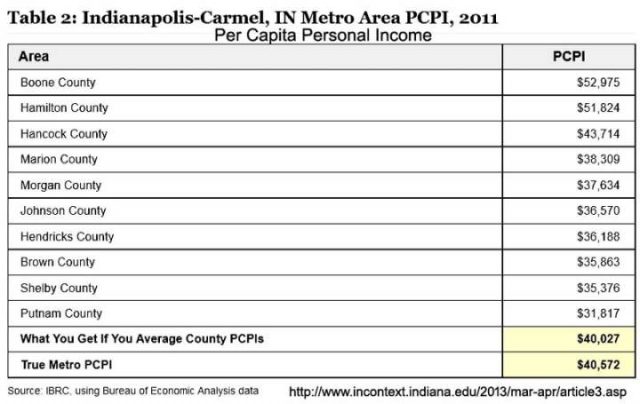

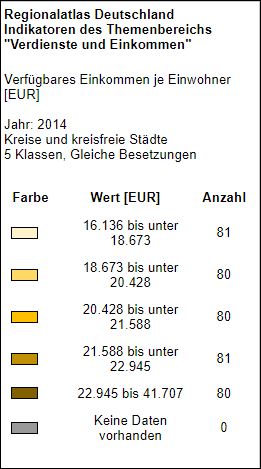

Für unsere Leser in Indiana (das ist einer der Staaten in den USA), konnten wir das beim Pro-Kopf Einkommen im Indianapolis Metropol Bereich erkennen:

Informationen zum Pro-Kopf-Einkommen vom Indiana Business Research Center und hier deren Artikel mit dem Titel: „Was man mit Daten nicht machen darf: Durchschnittswerte zu mitteln.

Wie Sie sehen können, mittelt man die Durchschnittswerte der Landkreise, bekommt man ein Pro-Kopf Einkommen von $ 40,027, aber zuerst kumulieren und dann mitteln gibt die wahre (wahrere) Zahl von $ 40.527. Dieses Ergebnis hat einen Unterschied – einen Fehler – von 1,36%. Von Interesse für diejenigen in Indiana, nur die Top drei der Verdiener in den Landkreisen haben ein Pro-Kopf-Einkommen, dass höher ist als der Landesdurchschnitt nach jedem Rechenweg und acht Landkreise liegen unter dem Durchschnitt.

Das mag trivial für Sie sein, aber bedenken Sie, dass verschiedene Behauptungen von „auffallenden neuen medizinischen Entdeckungen“ und „dem heißesten Jahr überhaupt“ nur diese Art von Unterschieden in den Rechenwegen basieren, die im Bereich der einstelligen oder sogar Bruchteilen von Prozentpunkten liegen, oder ein Zehntel oder ein Hundertstel Grad.

Um das der Klimatologie zu vergleichen, so reichen die veröffentlichten Anomalien aus dem 30-jährigen Klima- Referenzzeitraum (1981-2011) für den Monat Juni 2017 von 0,38 ° C (ECMWF) bis 0,21 ° C (UAH), mit dem Tokyo Climate Center mit einem mittlerem Wert von 0,36 ° C. Der Bereich (0,17 ° C) beträgt fast 25% des gesamten Temperaturanstiegs für das letzte Jahrhundert. (0,71ºC). Selbst bei Betrachtung nur den beiden höchsten Werten: 0,38 ° C und 0,36 ° C, ergibt die Differenz von 0,02 ° C bereits 5% der Gesamtanomalie. [Kann man diesen Unterschied merken? – der Übersetzer]

Wie genau diese Mittelwerte im Ergebnis dargestellt werden, ist völlig unerheblich. Es kommt überhaupt nicht darauf an, ob man absolut Werte oder Anomalien schätzt – die Größe des induzierten Fehlers kann riesig sein

Ähnlich, aber nicht identisch, das ist Simpsons Paradox.

Simpsons Paradox, oder korrekter der Simpson-Yule-Effekt, ist ein Phänomen, das in Statistiken und Wahrscheinlichkeiten (und damit mit Mittelwerten) auftritt, oft in medizinischen Studien und verschiedenen Zweigen der Sozialwissenschaften zu sehen, in denen ein Ergebnis (z. Bsp. ein Trend- oder Auswirkungs-Unterschied) dargestellt wird, der beim Vergleich von Datengruppen verschwindet oder sich umkehrt, wenn die Gruppen (von Daten) kombiniert werden.

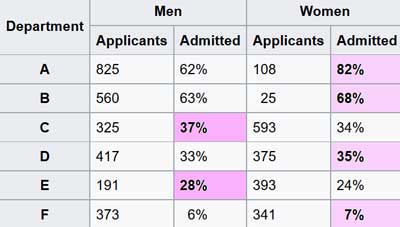

Einige Beispiele mit Simpsons Paradox sind berühmt. Eine mit Auswirkungen auf die heutigen heißen Themen behauptete Grundlage über die Anteile von Männer und Frauen bei den zum Studium an der UC Berkeley zugelassenen Bewerbern.

[Die 1868 gegründete University of California, Berkeley, gehört zu den renommiertesten Universitäten der Welt.]

Hier erklärt es einer der Autoren:

„Im Jahr 1973 wurde UC Berkeley für geschlechtsspezifische Regeln verklagt, weil ihre Zulassungszahlen zum Studium offensichtliche Nachteile gegen Frauen zeigen.

| UCB | Bewerber Applicants |

Zugelassen Admitted |

| Männer | 8442 | 44% |

| Frauen | 4321 | 35% |

Statistischer Beweis für die Anklage (Tabelle abgetippt)

Männer waren viel erfolgreicher bei der Zulassung zum Studium als Frauen und damit führte es Berkeley zu einer der ersten Universitäten, die für sexuelle Diskriminierung verklagt werden sollten. Die Klage scheiterte jedoch, als Statistiker jede Abteilung getrennt untersuchten. Die Fachbereiche haben voneinander unabhängige Zulassungssysteme, daher macht es Sinn, sie separat zu überprüfen – und wenn Sie das tun, dann sie scheinen eine Vorliebe für Frauen zu haben.“

In diesem Fall gaben die kombinierten (amalgamierten) Daten über alle Fachbereiche hinweg keine informative Sicht auf die Situation.

Natürlich, wie viele berühmte Beispiele, ist die UC Berkeley Geschichte eine wissenschaftliche Legende – die Zahlen und die mathematischen Phänomen sind wahr, aber es gab nie eine Klage wegen Benachteiligung von Geschlechtern. Die wahre Geschichte finden sie hier.

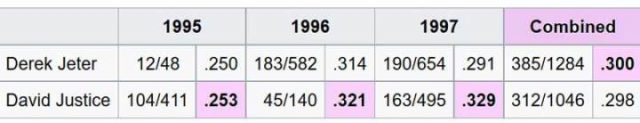

Ein weiteres berühmtes Beispiel für Simpsons Paradox wurde (mehr oder weniger korrekt) auf der langlaufenden TV-Serie Numb3rs vorgestellt. (Ich habe alle Episoden dieser Serie über die Jahre hinweg gesehen, einige öfter). Ich habe gehört, dass einige Leute Sportstatistiken mögen, also ist dieses etwas für Sie. Es „beinhaltet die durchschnittlichen Leistungswerte des Schlägers von Spielern im Profi-Baseball. Es ist möglich, dass ein Spieler in einer Reihe von Jahren einen höheren Durchschnitt der Abschlagwerte hat als ein anderer Spieler, obwohl er in all diesen Jahren nur einen niedrigeren Durchschnitt erreichte.“

Diese Tabelle zeigt das Paradox:

In jedem einzelnem Jahr erreichte David Justice einen etwas besseren Abschlag – Durchschnitt, aber wenn die drei Jahre kombiniert werden, hat Derek Jeter [auch tatsächlich ein Baseballspieler, Jg. 1974] die etwas bessere Statistik. Dies ist das Paradox von Simpson, die Ergebnisse werden umgekehrt, je nachdem ob mehrere Gruppen von Daten separat oder kumuliert betrachtet werden.

In der Klimatologie tendieren die verschiedenen Gruppen die Daten über längere Zeiträume zu betrachten, um die Nachteile der Mittelungsdurchschnitte zu vermeiden. Wie wir in den Kommentaren sehen, werden verschiedene Vertreter die verschiedenen Methoden gewichten und ihre Methoden verteidigen.

Eine Gruppe behauptet, dass sie überhaupt nicht mitteln – sie engagieren sich in „räumlicher Vorhersage“, die irgendwie magisch eine Vorhersage hervorbringt, die sie dann einfach als die globale durchschnittliche Oberflächentemperatur markieren (während sie gleichzeitig bestreiten, eine Mittelung durchgeführt zu haben). Sie fangen natürlich mit täglichen, monatlichen und jährlichen Durchschnitten an – aber das sind keine echten Mittelwerte…. mehr dazu später.

Ein anderer Experte mag behaupten, dass sie definitiv keine Durchschnittswerte der Temperaturen bilden – nur den Durchschnitt von Anomalien. Das heißt, sie berechnen erst die Anomalien und dann mitteln sie diese. Wenn sie energisch genug befragt werden, dann wird diese Fraktion zugeben, dass die Mittelung längst durchgeführt wurde, die lokalen Stationsdaten – die tägliche durchschnittliche „trockene“ [dry-bulb] -Temperatur – wird wiederholt gemittelt, um monatliche Mittelwerte zu erreichen, dann Jahresdurchschnitte. Manchmal werden mehrere Stationen gemittelt, um einen „Messzellen-Durchschnitt“ zu erreichen und dann werden diese jährlichen oder klimatischen Mittel von dem gegenwärtigen absoluten Temperaturdurchschnitt subtrahiert (monatlich oder jährlich, je nach Prozess), um einen Rest zu erhalten, der dann als sogenannte „Anomalie“ bezeichnet wird – oh, dann sind die Durchschnittswerte der Anomalien „gedurchschnittet“ (gemittelt).

Die Anomalien können oder können nicht, je nach Berechnungssystem, tatsächlich gleiche Flächen der Erdoberfläche darstellen. [Siehe den ersten Abschnitt für den Fehler bei der Mittelung von Durchschnittswerten, die nicht den gleichen Bruchteil des kumulierten Ganzen darstellen (~präsentieren)]. Diese Gruppe von Experten und fast alle anderen, verlassen sich auf „nicht echte Durchschnittswerte“ an der Wurzel ihrer Berechnungen.

Die Klimatologie hat ein Mittelungsproblem, aber das echte Problem ist nicht so sehr das, was oben diskutiert wurde. In der Klimatologie ist die tägliche Durchschnittstemperatur, die bei Berechnungen verwendet wird, kein Durchschnitt der Lufttemperaturen, die während der letzten 24-Stunden-Periode bei der Wetterstation erlebt oder aufgezeichnet wurden. Es ist das arithmetische Mittel der niedrigsten und höchsten aufgezeichneten Temperaturen (Lo und Hi, das Min Max) für den 24-Stunden-Zeitraum. Es ist zum Beispiel nicht der Durchschnitt aller stündlichen Temperaturaufzeichnungen, auch wenn sie aufgezeichnet und berichtet werden. Egal wie viele Messungen aufgezeichnet werden, der Tagesdurchschnitt wird berechnet, indem man den Lo und den Hi summiert und durch zwei teilt.

Die Temperaturen wurden als hoch und niedrig (Min-Max) für 150 Jahre oder mehr aufgezeichnet. Das ist genau so, wie es gemacht wurde und um konsequent zu bleiben, so macht man es auch heute noch.

Ein Daten-Download von Temperaturaufzeichnungen für die Wetterstation WBAN: 64756, Millbrook, NY, für Dezember 2015 bis Februar 2016 enthält alle fünf Minuten eine Temperaturablesung. Der Datensatz enthält Werte für „DAILYMaximumDryBulbTemp“ und „DAILYMinimumDryBulbTemp“, gefolgt von „DAILYAverageDryBulbTemp“, alles in Grad Fahrenheit. Die „DAILYAverageDryBulbTemp“ durchschnittliche trockene Temperatur ist das arithmetische Mittel der beiden vorhergehenden Werte (Max und Min). Dieser letzte Wert wird in der Klimatologie als die tägliche durchschnittliche Temperatur verwendet. Für einen typischen Dezembertag sehen die aufgezeichneten Werte so aus:

Täglich Max 43 F – Täglich Min 34 F – Täglicher Durchschnitt 38F (das arithmetische Mittel ist eigentlich 38,5, aber der Algorithmus rundet x,5 ab auf x)

Allerdings ist der Tagesdurchschnitt aller aufgezeichneten Temperaturen: 37.3 F… Die Differenzen für diesen einen Tag:

Unterschied zwischen dem berichteten Tagesdurchschnitt von Hi-Lo und dem tatsächlichen Durchschnitt der aufgezeichneten Hi-Lo-Zahlen ist = 0,5 ° F aufgrund des Rundungsalgorithmus.

Unterschied zwischen dem angegebenen Tagesdurchschnitt und dem korrekteren Tagesdurchschnitt unter Verwendung aller aufgezeichneten Temperaturen = 0,667 ° F

Andere Tage im Januar und Februar zeigen einen Differenzbereich zwischen dem gemeldeten täglichen Durchschnitt und dem Durchschnitt aller aufgezeichneten Temperaturen von 0,1 ° F bis 1,25 ° F bis zu einem hohen Wert von 3,17 ° F am 5. Januar 2016.

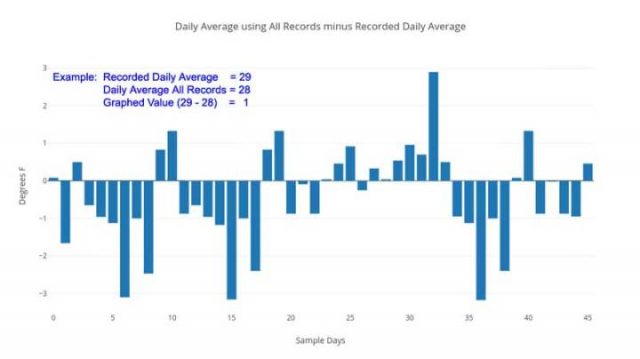

Täglicher Durchschnittswert aller Aufzeichnungen, korrekte Rechnung minus des aufgezeichneten Durchschnitts.

Dies ist kein wissenschaftliches Sampling – aber es ist eine schnelle Fallstudie, die zeigt, dass die Zahlen von Anfang an gemittelt werden – als tägliche Durchschnittstemperaturen, die offiziell an den Oberflächenstationen aufgezeichnet wurden. Die unmodifizierten Grunddaten selbst, werden in keinem Fall für die Genauigkeit oder Präzision überhaupt berechnet [zur Berechnung herangezogen] – aber eher werden berechnet „wie wir das schon immer getan haben“ – der Mittelwert zwischen den höchsten und niedrigsten Temperaturen in einer 24-Stunden-Periode – das gibt uns nicht einmal, was wir normalerweise als „Durchschnitt“ erwarten würden für die Temperatur an diesem Tag „- aber irgendeinen anderen Wert – ein einfaches Mittel zwischen dem Daily Lo und dem Daily Hi, das, wie die obige Grafik offenbart, ganz anders zu sein scheint. Der durchschnittliche Abstand von Null [Abweichung, d.h. wie es korrekt wäre] für die zweimonatige Probe beträgt 1,3 ° F. Der Durchschnitt aller Unterschiede, unter Beachtung des Vorzeichens beträgt 0,39 ° F [also in Richtung wärmer].

Die Größe dieser täglichen Unterschiede? Bis zu oder [sogar] größer als die gemeinhin gemeldeten klimatischen jährlichen globalen Temperaturanomalien. Es spielt keine Rolle, ob die Unterschiede nach oben oder unten zählen – es kommt darauf an, dass sie implizieren, dass die Zahlen, die verwendet werden, um politische Entscheidungen zu beeinflussen, nicht genau berechnete, grundlegende täglichen Temperaturen von einzelnen Wetterstationen sind. Ungenaue Daten erzeugen niemals genaue Ergebnisse. Persönlich glaube ich nicht, dass dieses Problem bei der Verwendung von „nur Anomalien“ verschwindet (was einige Kommentatoren behaupten) – die grundlegenden Daten der ersten Werteebene sind falsch, unpräzise, ungenau berechnet.

Aber, aber, aber … Ich weiß, ich kann die Maulerei bereits jetzt hören. Der übliche Chor von:

Die beiden ersten Argumente sind fadenscheinig.

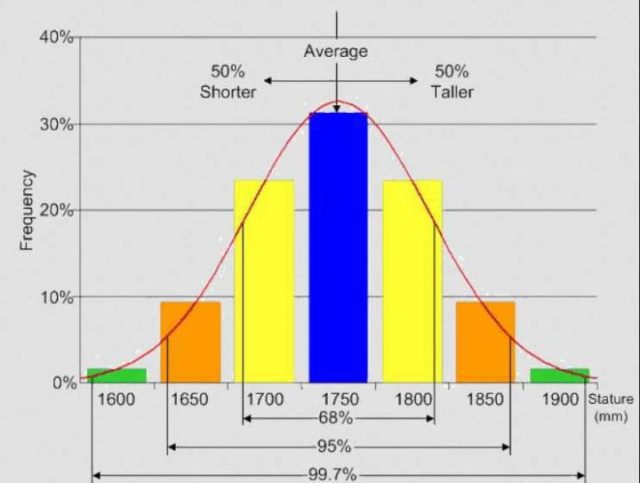

Das letzte will ich ansprechen. Die Antwort liegt in dem „Warum“ der oben beschriebenen Unterschiede. Der Grund für den Unterschied (außer der einfachen Auf- und Abwärtsbewegung von Bruchteilen in ganzem Grad) ist, dass die Lufttemperatur an einer beliebigen Wetterstation nicht normal verteilt wird … das heißt, von Minute zu Minute oder Stunde zu Stunde, keiner würde eine „normal Verteilung“ sehen, die sich so darstellt:

Normal-oder-Standard-Verteilung

Wenn die Lufttemperatur normalerweise so über den Tag verteilt wäre, dann wäre die aktuell verwendete tägliche durchschnittliche trockene Temperatur – das arithmetische Mittel zwischen dem Hi und Lo – korrekt und würde sich nicht vom täglichen Durchschnitt aller aufgezeichneten Temperaturen für den Tag unterscheiden.

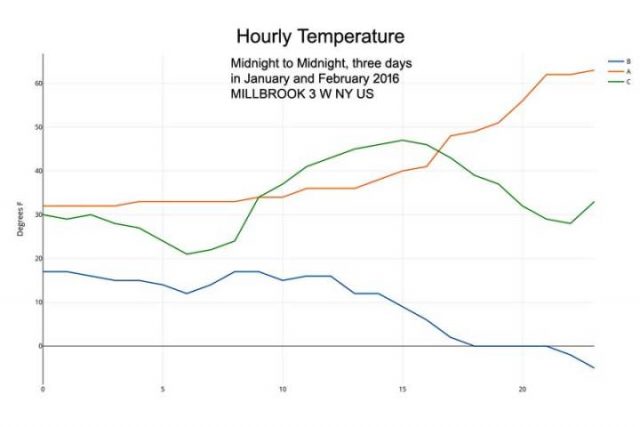

Aber echte Oberflächentemperaturen der Luft sehen viel mehr aus, wie diese drei Tage von Januar und Februar 2016 in Millbrook, NY:

Reale stündliche Temperaturen

Die Lufttemperatur an einer Wetterstation startet nicht am Lo Wert – um gleichmäßig und stetig zum Hi aufzusteigen und sich dann gleichmäßig zum nächsten Lo zurück zu schleichen. Das ist ein Mythos – jeder der sich draußen aufhält (Jäger, Seemann, Camper, Forscher, sogar Jogger) kennt diese Tatsache. Doch in der Klimatologie werden die tägliche Durchschnittstemperatur – und konsequent alle nachfolgenden wöchentlichen, monatlichen, jährlichen Durchschnitte – auf der Grundlage dieser falschen Idee berechnet.

Zuerst nutzten die Wetterstationen Min-Max-Aufnahmethermometer und wurden oft nur einmal pro Tag überprüft und die Aufnahme-Tabs zu diesem Zeitpunkt zurückgesetzt – und nun so weitergeführt aus Respekt für Konvention und Konsistenz.

Wir können nicht zurückkehren und die Fakten rückgängig machen – aber wir müssen erkennen, dass die täglichen Mittelwerte aus diesen Min-Max / Hi-Lo-Messwerten nicht die tatsächliche tägliche Durchschnittstemperatur darstellen – weder in Genauigkeit noch in Präzision. Dieses beharren auf Konsistenz bedeutet, dass die Fehlerbereiche, die in dem obigen Beispiel dargestellt sind, alle globalen durchschnittlichen Oberflächentemperaturberechnungen beeinflussen, die Stationsdaten als Quelle verwenden.

Anmerkung: Das hier verwendete Beispiel ist von Wintertagen in einem gemäßigten Klima. Die Situation ist repräsentativ, aber nicht unbedingt quantitativ – sowohl die Werte als auch die Größen der Effekte werden für verschiedene Klimazonen [… Gegenden], verschiedene Stationen, verschiedene Jahreszeiten unterschiedlich sein. Der Effekt kann durch statistische Manipulation oder durch Reduzierung der Stationsdaten zu Anomalien nicht vermieden werden.

Alle Anomalien, die durch Subtrahieren von klimatischen Durchschnittswerten von aktuellen Temperaturen abgeleitet werden, werden uns nicht mitteilen, ob die durchschnittliche absolute Temperatur an einer Station steigt oder fällt (oder um wie viel). Es wird uns nur sagen, dass der Mittelwert zwischen den täglichen Hochtemperaturen steigt oder fällt – was etwas ganz anders ist. Tage mit sehr niedrigen Tiefs für eine Stunde oder zwei am frühen Morgen gefolgt von hohen Temperaturen für die meiste Zeit des restlichen Tages haben die gleichen Max-Min Mittelwerte wie Tage mit sehr niedrigen Tiefs für 12 Stunden und eine kurze heiße Spitze am Nachmittag. Diese beiden Arten von Tagen, haben nicht die gleiche tatsächliche durchschnittliche Temperatur. Anomalien können den Unterschied nicht erhellen. Ein Klimawandel von einem zum anderen wird in Anomalien nicht auftauchen. Weder noch würde die Umwelt von einer solchen Verschiebung stark betroffen sein.

Es gibt einige die in Frage stellen, dass es tatsächliche eine globale durchschnittliche Oberflächentemperatur gibt. (Siehe „Gibt es eine globale Temperatur?“)

Auf der anderen Seite, formulierte Steven Mosher in seinem Kommentar kürzlich so treffend:

Sind abgeleitete Temperaturen bedeutungslos?

Ich denke, dass es schlecht ist, wenn Alarmisten versuchen, die kleine Eiszeit und die Mittelalterliche Warmzeit zu löschen … WUWT wird die ganze Geschichte leugnen wollen. Die globale Temperatur ist vorhanden. Es hat eine genaue physikalische Bedeutung. Es ist diese Bedeutung, die uns erlaubt zu sagen … Die kleine Eiszeit war kühler als heute … es ist die Bedeutung, die es uns erlaubt, zu sagen, dass die die Tagseite des Planeten wärmer ist als die Nachtseite … die gleiche Bedeutung, die uns erlaubt zu sagen, dass Pluto kühler ist als die Erde und dass Merkur wärmer ist.

Was ein solcher globaler Mittelwert, basierend auf einen fragwürdigen abgeleiteten „Tagesdurchschnitt“, uns nicht sagen kann, ist oder war es in diesem Jahr ein Bruchteil eines Grades wärmer oder kühler?

Der Berechnungsfehler – der Messfehler – der am häufigsten verwendeten Station der täglichen durchschnittlichen Durchschnittstemperatur ist in der Größe gleich (oder nahezu gleich groß) wie die langfristige globale Temperaturänderung. Die historische Temperaturaufzeichnung kann nicht für diesen Fehler korrigiert werden. Moderne digitale Aufzeichnungen würde eine Neuberechnung der Tagesmittelwerte von Grund auf neu erfordern. Selbst dann würden die beiden Datensätze quantitativ nicht vergleichbar sein – möglicherweise nicht einmal qualitativ.

Es ist sehr wichtig, wie und was man mittelt. Es macht was aus, den ganzen Weg nach oben und unten durch das prächtige mathematische Wunderland, was die Computerprogramme darstellen, die diese grundlegenden digitalen Aufzeichnungen von Tausenden von Wetterstationen auf der ganzen Welt lesen und sie zu einer einzigen Zahl verwandeln.

Es macht vor allem dann etwas aus, wenn diese einzelne Zahl dann später als Argument verwendet wird, um die breite Öffentlichkeit zu treffen und unsere politischen Führer zu bestimmten gewünschten politischen Lösungen zu bringen (~ zu zwingen), die große – und viele glauben negative – Auswirkungen auf die Gesellschaft haben werden.

Es reicht nicht aus, den Durchschnitt eines Datensatzes korrekt mathematisch zu berechnen.

Es reicht nicht aus, die Methoden zu verteidigen, die Ihr Team verwendet, um die [oft-mehr-missbrauchten-als-nicht] globalen Mittelwerte von Datensätzen zu berechnen.

Auch wenn diese Mittelwerte von homogenen Daten und Objekten sind und physisch und logisch korrekt sind, ein Mittelwert ergibt eine einzelne Zahl und kann nur fälschlicherweise als summarische oder gerechte Darstellung des ganzen Satzes, der ganzen Information angenommen werden.

Durchschnittswerte, in jedem und allen Fällen, geben natürlicherweise nur einen sehr eingeschränkten Blick auf die Informationen in einem Datensatz – und wenn sie als Repräsentation des Ganzen akzeptiert werden, wird sie als Mittel der Verschleierung fungieren, die den Großteil verdecken und die Information verbergen. Daher, anstatt uns zu einem besseren Verständnis zu führen, können sie unser Verständnis des zu untersuchenden Themas reduzieren.

In der Klimatologie wurden und werden tägliche Durchschnittstemperaturen ungenau und unpräzise aus den täglichen minimalen und maximalen Temperaturen berechnet, die damit Zweifel an den veröffentlichten globalen durchschnittlichen Oberflächentemperaturen hervorrufen.

Durchschnitte sind gute Werkzeuge, aber wie Hämmer oder Sägen müssen sie korrekt verwendet werden, um wertvolle und nützliche Ergebnisse zu produzieren. Durch den Missbrauch von Durchschnittswerten verringert sich das Verständnis des Themas eher, als das es die Realität abbildet.

UPDATE:

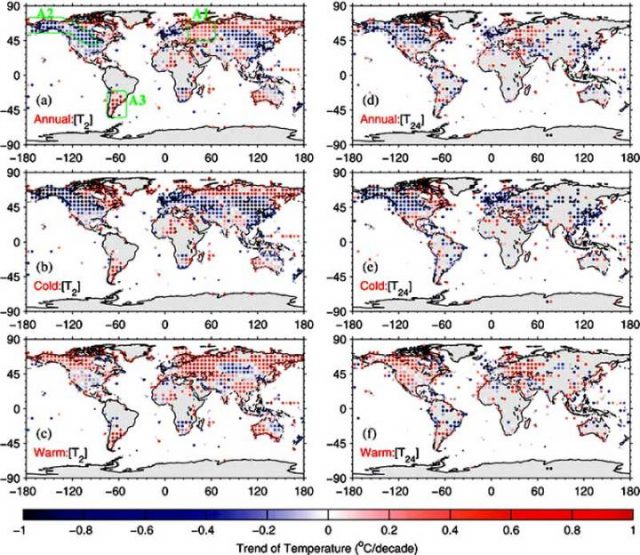

Diejenigen, die mehr Informationen bekommen wollen, über die Unterschiede zwischen Tmean (das Mittel zwischen Täglichem Min und Max) und Taverage (das arithmetische Mittel aller aufgezeichneten 24 stündlichen Temperaturen – einige verwenden T24 dafür) – sowohl quantitativ als auch in jährlichen Trends beziehen sich beide auf die Spatiotemporal Divergence of the Warming Hiatus over Land Based on Different Definitions of Mean Temperature von Chunlüe Zhou & Kaicun Wang [Nature Scientific Reports | 6:31789 | DOI: 10.1038/srep31789].[~Räumliche und zeitliche Abweichungen der Erwärmungspause über Land auf der Grundlage verschiedener Definitionen der mittleren Temperatur] von Chunlüe Zhou & Kaicun Wang [Nature Scientific Reports | 6: 31789 | DOI: 10.1038 / srep31789]. Im Gegensatz zu Behauptungen in den Kommentaren, dass Trends dieser unterschiedlich definierten „durchschnittlichen“ Temperaturen gleich sind, zeigen Zhou und Wang diese Figur und Kation: (h / t David Fair)

Abbildung 4. Die (a, d) jährliche, (b, e) Kälte und (c, f) warme saisonale Temperaturtrends (Einheit: ° C / Jahrzehnt) aus dem Global Historical Climatology Network-Daily Version 3.2 (GHCN-D , [T2]) und die „Integrated Surface Database-Hourly“ (ISD-H, [T24]) sind für 1998-2013 gezeigt. Die GHCN-D ist eine integrierte Datenbank der täglichen Klimazusammenfassungen von Land-Oberflächenstationen auf der ganzen Welt, die Tmax und Tmin Werte von rund 10.400 Stationen von 1998 bis 2013 zur Verfügung stellt. Die ISD-H besteht aus globalen stündlichen und synoptischen Beobachtungen bei etwa 3400 Stationen aus über 100 Originaldatenquellen. Die Regionen A1, A2 und A3 (innerhalb der grünen Regionen, die in der oberen linken Teilfigur gezeigt sind) werden in dieser Studie ausgewählt.

[Klicken Sie hier für ein Bild in voller Größe] in Nature

Erschienen auf WUWT am 24.07.2017

Übersetzt durch Andreas Demmig

https://wattsupwiththat.com/2017/07/24/the-laws-of-averages-part-3-the-average-average/

Zugegeben, den größten Teil dieser schönen Schlagzeile habe ich von Henryk M. Broder auf ACHGUT geklaut. Und der entnahm sie vermutlich einem uralten, etwas delikatem Witz[1]. Doch uns beiden fiel wohl gleichzeitig einige Berichte über Umfragen auf, die zum Nachdenken Anlass geben.

Bei Broder liest sich das so:

Von Henryk.M. Broder.

Eine Emnid-Umfrage im Auftrag der BamS ergab, dass nur 29% der Bundesbürger das Thema „Zuwanderung“ als „äußerst oder sehr wichtig“ für ihre Wahlentscheidung halten. Eine Woche später ergab eine Umfrage der Gesellschaft für Konsumforschung, dass kein anderes Thema die Deutschen so sehr umtreibt „wie die Zuwanderung und Integration von Ausländern“. Seltsam, nicht wahr? Der Unterschied könnte mit der Methodik der Umfragen zu tun haben. Während Emnid einer wie immer „repräsentativen Auswahl“ von Bügern die Frage stellte „Wie wichtig sind Ihnen für Ihre Stimmabgabe bei der Bundestagswahl die folgenden Aufgabenbereiche?“ und die Bereiche auflistete, waren bei der GfK-Umfrage keine Antworten vorgegeben. Die Teilnehmer der Umfrage konnten „frei antworten, in Worte fassen, was sie am meisten besorgt“. – So einfach kann eine Erklärung für das Unerklärliche sein. Und wie einfach es ist, das Ergebnis einer Umfrage durch die Art der Fragestellung zu manipulieren. / Link zum Fundstück

Bei mir war die Ausgangslage etwas anders. Es ging – natürlich- um die vermeintliche Klimaangst der Deutschen. Da behauptete z.B. die Berliner Morgenpost – eine Zeitung der Funke-Mediengruppe- dass, …die Mehrheit der Deutschen denkt laut einer jüngsten Umfrage des Kantar Emnid Instituts, dass Klimawandel das dringendste Problem der Gegenwart ist.“

Diese Erkenntnis des jetzt Kantar Emnid Institutes wurde recht breit auch in anderen Medien und nicht nur von Funke verbreitet.

Im Einzelnen findet man im Beitrag der Morgenpost:

Danach sagen 71 Prozent der Befragten, die Veränderung des Weltklimas bereite ihnen persönlich besonders große Sorgen. 65 Prozent führen neue Kriege als beherrschende Furcht an. Bei 63 Prozent sind es Terroranschläge, 62 Prozent nennen Kriminalität, und 59 Prozent ängstigen sich vor Altersarmut. Mit einigem Abstand folgt die Zuwanderung von Flüchtlingen (45 Prozent). Arbeitslosigkeit ist mit 33 Prozent die geringste der genannten Sorgen.

Weil mir diese Reihenfolge angesichts der täglichen Berichte in allen Medien komisch vorkam, nicht nur in Bezug auf das Klima, rief ich bei Kantar Emnid an, und bat um die Nennung der Fragestellung, die dieser Umfrage zugrunde lägen.

Man beschied mich abschlägig, da diese Eigentum der Funke Mediengruppe seien, und sie nicht darüber verfügen dürften. Und auch aus mehreren Artikeln anderer Medien konnte man nirgends entnehmen, wie und was gefragt wurde. Da gab ich auf.

Aber fast zeitgleich wurde eine Studie des PEW Centers mit 1000 Befragten in Deutschland (z.B. hier) veröffentlicht, die transparenter ist, und bei welcher der Klimawandel nur auf Pos. 3 der Besorgnisse landete. Aber immerhin noch von 63 % der Befragten angegeben wurde.

Und nun die Umfrage der Gesellschaft für Konsumforschung (GFK)!

Stattdessen steht die Furcht vor Zuwanderung/Migration deren Belastung und Kosten ja gerade erst beginnen sich in unserem Alltag zu verfestigen, an prominent erster Stelle.

Warum?

Weil die Befragten – oder soll man besser sagen- die beeinflussten Probanden diesmal- „frei antworten konnte, in Worte fassen, was sie am meisten besorgt“.

Die zu beantwortende Frage lautet: „Was sind Ihrer Meinung nach die dringendsten Aufgaben, die heute in Deutschland zu lösen sind?“

Und da liegt das Thema Zuwanderung/Migration mit ca. 63 %, also Riesenabstand, weit, weit vorn.

Die einen sagen eben so, die anderen so.

Wobei man zu Annahme kommen könnte, dass die einen die Meinungsmacher – genannt Umfrage-Institute- sind, während die anderen, die Leute von der Straße sind, also wir!

Und es drängt sich die Frage auf: Ist die Beeinflussung der Befragten nicht auch bei anderen Umfragen gängige Praxis?

Seufz! Fragen über Fragen.

Die weise Aussage eines Staatmannes „glaube keiner Statistik die Du nicht selber gefälscht hast“ bestätigt sich eben immer wieder.

[1] Der Witz geht so: Fragt ein Freund den anderen: „Na, wie ist denn Deine Frau so im Bett?“ Darauf der Andere: „Die einen sagen so, die andern so!“

Durchschnittliches

Sowohl das Wort als auch das Konzept „Durchschnitt“ sind in der breiten Öffentlichkeit sehr viel Verwirrung und Missverständnis unterworfen und sowohl als Wort als auch im Kontext ist eine überwältigende Menge an „lockerem Gebrauch“ auch in wissenschaftlichen Kreisen zu finden, ohne die Peer-Reviewed-Artikel in Zeitschriften und wissenschaftlichen Pressemitteilungen auszuschließen.

In Teil 1 dieser Serie [Eike, übersetzt] lasen Sie meine Auffrischung über die Begriffsinhalte von Durchschnitten, Mittelwerten und Beispiele dazu. Wenn Ihnen diese Grundlagen nun geläufig sind, dann können wir mit den weiteren Gedankengängen weitermachen.

Wer es vorher oder nochmal lesen möchte, hier ist der Link zum Original [Part 1 of this series]

Ein Strahl der Finsternis in das Licht [Übersetzung des Originaltitels]

oder: Informieren um zu Verschleiern

Der Zweck, zu einem Datensatz verschiedene Ansichten darzustellen – oder über jede Sammlung von Informationen oder Messungen, über eine Klasse von Dingen oder ein physikalisches Phänomen – ist es, dass wir diese Informationen aus verschiedenen intellektuellen und wissenschaftlichen Winkeln sehen können – um uns einen besseren Einblick in das Thema unserer Studien zu geben, was hoffentlich zu einem besseren Verständnis führt.

Moderne statistische Programme erlauben es sogar Gymnasiasten, anspruchsvolle statistische Tests von Datensätzen durchzuführen und die Daten auf unzählige Weise zu manipulieren [bzw. zu sortieren] und zu betrachten. In einem breiten allgemeinen Sinne, ermöglicht die Verfügbarkeit dieser Softwarepakete nun Studenten und Forschern, (oft unbegründete) Behauptungen für ihre Daten zu machen, indem sie statistische Methoden verwenden, um zu numerischen Ergebnissen zu gelangen – alles ohne Verständnis weder der Methoden noch der wahren Bedeutung oder Aussagekraft der Ergebnisse. Ich habe das erfahren, indem ich High School Science Fairs beurteile [zu vergleichen mit „Jugend forscht“] und später die in vielen Peer-Review-Journalen gemachten Behauptungen gelesen habe. Eine der derzeit heiß diskutierten Kontroversen ist die Prävalenz [allgemeine Geltung] der Verwendung von „P-Werten“ [probability value ~ Wahrscheinlichkeitswert], um zu beweisen, dass [auch] triviale Ergebnisse irgendwie signifikant sind, weil „das die Aussage ist, wenn die P-Werte geringer als 0,05 sind“. Die High School Science Fair Studenten bezogen auch ANOVA Testergebnisse über ihre Daten mit ein –jedoch konnte keiner von ihnen erklären, was ANOVA ist oder wie es auf ihre Experimente angewendet wurde.

[Als Varianzanalyse (ANOVA von englisch analysis of variance) bezeichnet man eine große Gruppe datenanalytischer und strukturprüfender statistischer Verfahren, die zahlreiche unterschiedliche Anwendungen zulassen; Quelle Wikipedia]

Moderne Grafik-Tools ermöglichen alle Arten von grafischen Methoden um Zahlen und ihre Beziehungen anzuzeigen. Das US Census Bureau [statistisches Amt] verfügt über einen große Anzahl von Visualisierungen und Graphikwerkzeugen. Ein Online-kommerzieller Service, Plotly, kann in wenigen Sekunden eine sehr beeindruckende Reihe von Visualisierungen Ihrer Daten erstellen. Sie bieten einen kostenlosen Service an, dessen Niveau mehr als ausreichend für fast alle meine Verwendungen war (und eine wirklich unglaubliche Sammlung von Möglichkeiten für Unternehmen und Profis mit einer Gebühr von etwa einem Dollar pro Tag). RAWGraphs hat einen ähnlichen kostenlosen Service.

Es werden komplexe Computerprogramme verwendet, um Metriken wie die globalen Durchschnittlichen Land– und Meerestemperaturen oder die globale mittlere Höhe des Meeresspiegels zu erstellen. Ihre Schöpfern und Promotoren glauben daran, das damit tatsächlich ein einziger aussagekräftiger Wert produziert werden kann, der eine durchschnittliche Genauigkeit bis zu einem Hundertstel oder Tausendstel oder eines Millimeters erreicht. Oder, wenn schon nicht aktuelle quantitativ genaue Werte, so werden zumindest genaue Anomalien oder gültige Trends berechnet. Die Meinungen zu diesen Werten variieren sehr stark, betreffend der Gültigkeit, der Fehlerfreiheit und der Genauigkeit dieser globalen Durchschnittswerte.

Die Mittelwerte sind nur eine von unterschiedlichsten Möglichkeiten, die Werte in einem Datensatz zu betrachten. Wie ich in den Grundlagen für den „Durchschnitt“ erklärt habe, gibt es drei primäre Arten von Mittelwerten – Mittel, Median und Mode – sowie weitere exotische Typen.

In Teil 1 dieser Reihe erklärte ich die Fallstricke von Mittelwerten von heterogenen, nicht miteinander zu vergleichenden Objekten oder Daten über Gegenstände. Solche Versuche enden mit „Obstsalat“, ein Durchschnitt aus Äpfeln und Orangen ergibt unlogische oder unwissenschaftliche Ergebnisse, mit Bedeutungen, die illusorisch, imaginär oder von so geringer Aussage und damit nicht sehr nützlich sind. Solche Mittelungen werden oft von ihren Schöpfern mit Bedeutung – Sinn – erfüllt, die sie nicht haben.

Da der Zweck, Daten auf unterschiedliche Weise zu betrachten – wie das Betrachten eines Durchschnitts, ein Mittelwert oder ein Modus des numerischen Datensatzes – zu einem besseren Verständnis führen soll, ist es wichtig zu verstehen, was tatsächlich passiert, wenn numerische Ergebnisse gemittelt werden und in welcher Weise sie zu einem besseren Verständnis führen und in welcher Weise sie aber auch zu einem reduzierten Verständnis führen können.

Ein einfaches Beispiel:

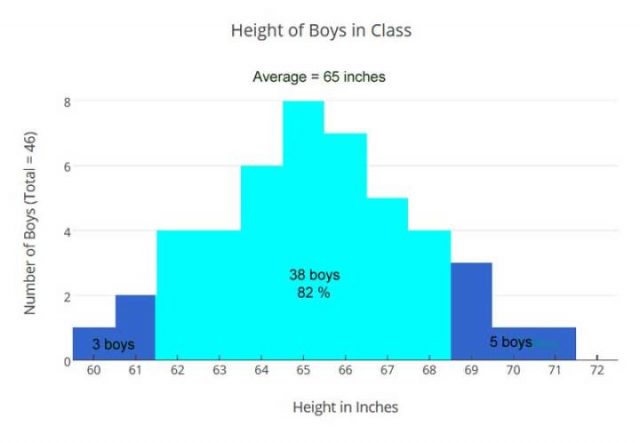

Betrachten wir die Größe der Jungs in Frau Larsens hypothetischer 6. Klasse an einer Jungenschule. Wir wollen ihre Größe kennenlernen, um eine horizontale Klimmzugstange zwischen zwei starken, aufrechten Balken platzieren, damit sie trainieren können (oder als leichte konstruktive Strafe – „Jonny – Zehn Klimmzüge bitte!“). Die Jungs sollten in der Lage sein, sie leicht zu erreichen, indem man ein bisschen hochspringt, so dass beim Hängen an den Händen ihre Füße nicht den Boden berühren.

Die ärztliche Station liefert uns die Größen der Jungs, die gemittelt werden, und wir erhalten das arithmetische Mittel von 65 Zoll [ = 165 cm; für den weiteren Vergleich lasse ich Zoll (= Inch) stehen].

Mit diesen Durchschnittsgrößen rechnen wir weiter, um die benötigte Stangenhöhe in Zoll zu ermitteln:

Größe / 2.3 = Armlänge (Schulter zu den Fingerspitzen)

= 65 / 2.3 = 28 (ungefähre Armlänge)

= 65 + 28 = 93 Zoll = 7,75 Fuß oder 236 cm

Unsere berechnete Höhe der Stange passt gut in ein Klassenzimmer mit 8,5 Fuß Decken, also sind wir gut. Oder sind wir gut? Haben wir genügend Informationen aus unserer Berechnung der Mittleren Höhe?

Lassen Sie es uns überprüfen, indem wir ein Balkendiagramm aller Größen aller Jungs betrachten:

Diese Visualisierung, gibt uns eine andere Sicht als unser berechneter Durchschnitt – um die vorhandenen Informationen zu betrachten – um die Daten der Größen der Jungen in der Klasse auszuwerten. Mit der Erkenntnis, dass die Jungen von nur fünf Fuß groß (60 Zoll) bis hin zu fast 6 Fuß (71 Zoll) groß sind, werden wir nicht in der Lage sein, eine Stangenhöhe festzulegen, die ideal für alle ist. Allerdings sehen wir jetzt, dass 82% der Jungs innerhalb der Mittelhöhe von 3 Inch liegen und unsere berechnete Stangenhöhe wird gut für sie sein. Die 3 kürzesten Jungs könnten einen kleinen Tritt brauchen, um die Stange zu erreichen, und die 5 längsten Jungs können ihre Knie ein bisschen beugen, um Klimmzüge zu machen. Also können wir es so machen.

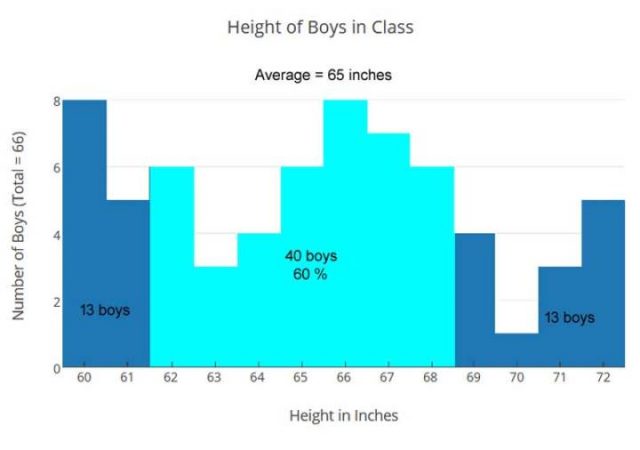

Aber als wir den gleichen Ansatz in Mr. Jones ‚Klasse versuchten, hatten wir ein Problem.

Es gibt 66 Jungen in dieser Klasse und ihre durchschnittliche Größe (Mittelwert) ist auch 65 Zoll, aber die Größen sind anders verteilt:

Jungens, die zweite Klasse

Herr Jones Klasse hat eine andere Mischung, die zu einer ungleichen Verteilung führt, viel weniger um den Mittelwert zentriert. Mit dem gleichen Durchschnitt: +/- 3 Zoll (hellblau), der in unserem vorherigen Beispiel verwendet wurden, erfassen wir nur 60% der Jungs anstatt 82%. In Mr. Jones Klasse, würden 26 von 66 Jungs die horizontale Reckstange bei 93 Zoll nicht bequem finden. Für diese Klasse war die Lösung eine variable Höhenleiste mit zwei Einstellungen: eine für die Jungen 60-65 Zoll groß (32 Jungen), eine für die Jungen 66-72 Zoll groß (34 Jungen).

Für die Klasse von Herrn Jones war die durchschnittliche Größe, die mittlere Größe, nicht dazu geeignet, um uns ein besseres Verständnis die Informationen über die Höhe der Jungen zu beleuchten, zu ermöglichen. Wir brauchten einen genaueren Blick auf die Informationen, um unseren Weg durch die bessere Lösung zu sehen. Die variable Höhenleiste funktioniert auch für Mrs. Larsens Klasse gut, mit der unteren Einstellung für 25 Jungen und die höhere Einstellung gut für 21 Jungen.

Die Kombination der Daten aus beiden Klassen gibt uns diese Tabelle:

Dieses kleine Beispiel soll veranschaulichen, dass Mittelwerte, wie unsere mittlere Höhe, unter Umständen von Nutzen sind, aber nicht in allen Fällen.

In der Klasse von Herrn Jones war die größere Anzahl kleinerer Jungen verdeckt, versteckt, gemittelt, man kann sich auf die mittlere Höhe verlassen, um die besten Lösungen für die horizontale Klimmstange zu bekommen.

Es ist erwähnenswert, dass in Frau Larsens Klasse, die Jungens eine Verteilung der Größen haben – siehe erstes Diagramm oben, die der sogenannten Normalverteilung ähnlich ist, ein Balkendiagramm wie folgend gezeigt:

Normalverteilung

Die meisten Werte ergeben einen Gipfel in der Mitte und fallen mehr oder weniger gleichmäßig davor und dahinter ab. Durchschnitte sind gute Schätzungen für Datensätze, die so aussehen. Dabei muss man dann darauf achten, auch die Bereiche auf beiden Seiten des Mittels zu verwenden.

Mittel sind nicht so gut für Datensätze wie es Herr Jones‘ Klasse zeigt oder für die Kombination der beiden Klassen. Beachten Sie, dass das Arithmetische Mittel genau das gleiche für alle drei Datensätze der Größe der Jungen ist – die beiden Klassen und die kombinierten – aber die Verteilungen sind ganz anders und führen zu unterschiedlichen Schlussfolgerungen.

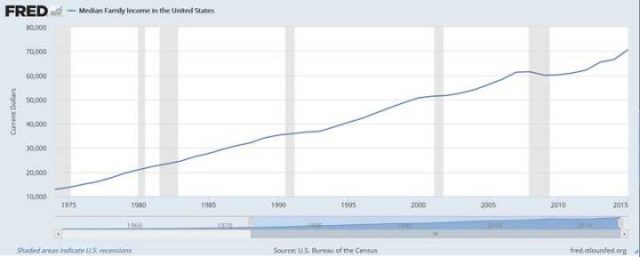

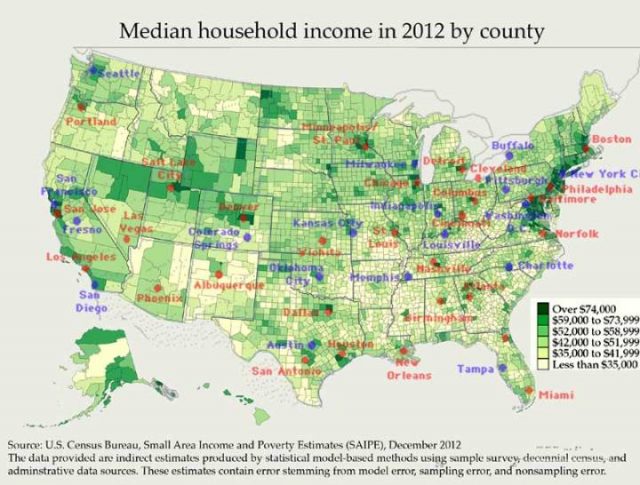

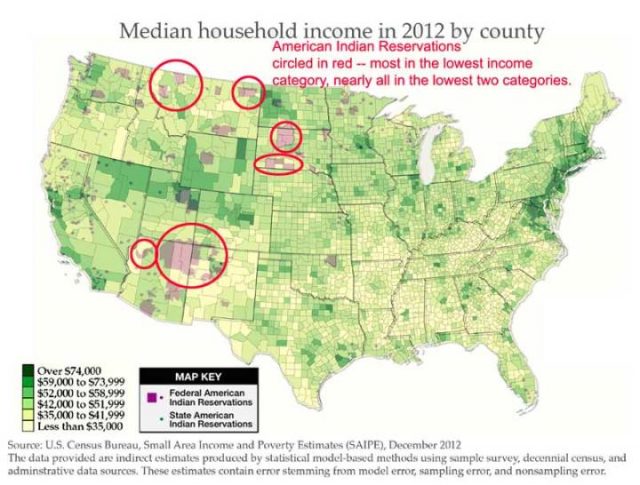

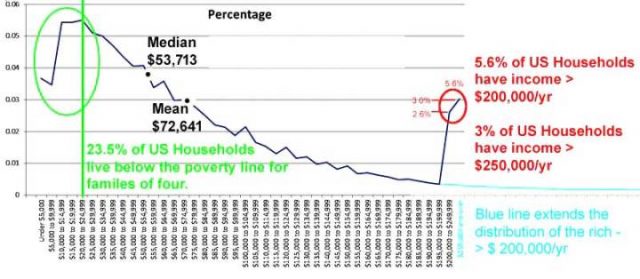

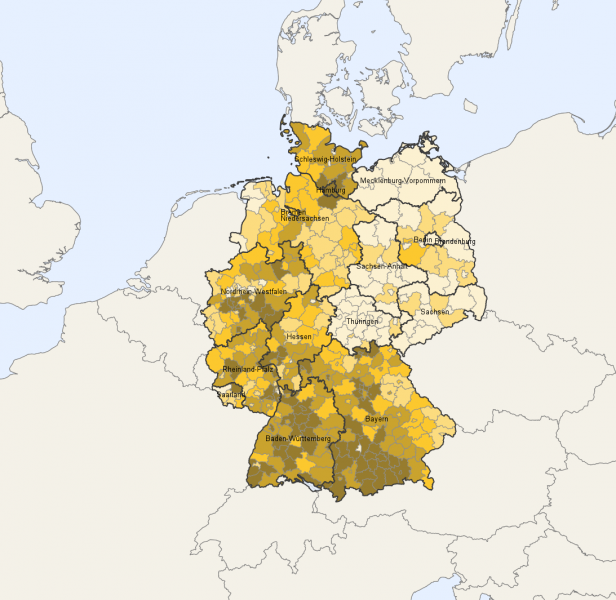

Das durchschnittliche Haushaltseinkommen in USA

Eine häufige angewandte Messgröße für das wirtschaftliche Wohlbefinden in den Vereinigten Staaten ist die jährliche Ermittlung des durchschnittlichen Haushaltseinkommens durch das statistische Amt [US Census Bureau].

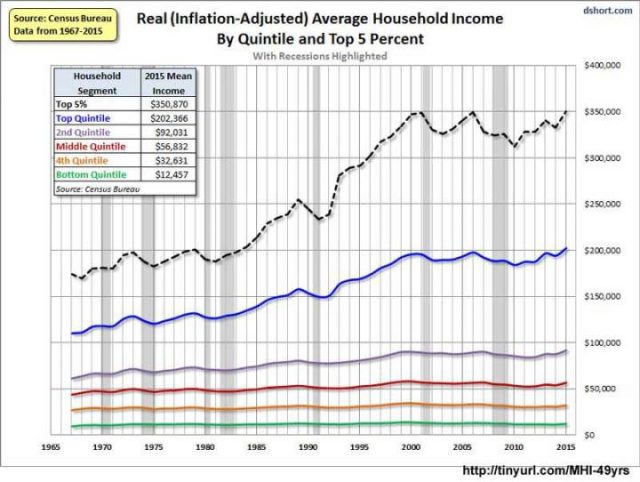

Erstens, dass es als MEDIAN gegeben wird – was bedeutet, dass es eine gleich große Anzahl von Familien mit einem größeren Einkommen sowie auch Familien unter diesem Einkommensniveau geben sollte. Diese Grafik hier, von der jeweils regierenden Partei veröffentlicht – unabhängig davon, ob es die Demokraten oder die Republikaner sind – wird vom Oval Office (US-Präsident) und den beiden Häusern des Kongresses gerne als Argument [für ihre gute Arbeit] genutzt:

Das ist die gute Nachricht!

Grafik: Das mediane Familien Einkommen zeigt über die Jahre einem schönen stetigen Aufstieg und wir singen alle zusammen mit dem Beatles: “I’ve got to admit it’s getting better, A little better all the time…” [Sgt. Pepper’s Lonely Hearts Club Band]

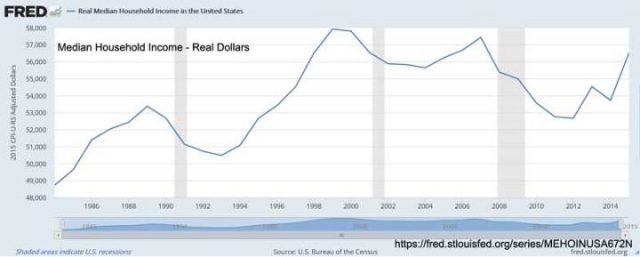

Die nächste Grafik zeigt die nicht so gute Nachricht:

Die Zeitachse ist auf 1985 bis 2015 verkürzt, aber wir sehen, dass die Familien seit etwa 1998 nicht viel, wenn überhaupt, an realer Kaufkraft gewonnen haben, bereinigt um die Inflation.

Und dann gibt es die Grafik der Wirklichkeit:

Trotz der guten Nachrichten! und der Anerkennung der ersten Grafik und der so genannten Neuigkeiten der zweiten, sehen wir, wenn wir tiefer schürfen, eine andere Geschichte – die bislang verdeckt ist. Diese Grafik ist das Durchschnitts Haushalt Einkommen der fünf Quintile des Einkommens, plus die Top 5%, so dass die Zahlen ein bisschen anders sind und eine andere Geschichte erzählen.

Man unterteilt die Bevölkerung in fünf Teile (Quintil), dafür stehen die fünf bunten Linien. Die unteren 60% der Familien mit geringen Haushaltseinkommen, die grünen, braunen und roten Linien, haben in realer Kaufkraft seit 1967 praktisch keine Verbesserung erreicht, die Mitte / das Großbürgertum in lila Linie, hat einen moderaten Anstieg gesehen. Nur die besten 20% der Familien (blaue Linie) haben eine solide, stetige Verbesserung erreicht – und wenn wir die Top 5% herausnehmen, die gestrichelte schwarze Linie, sehen wir, dass sie nicht nur den Löwenanteil der US-Dollar verdienen, Sie haben auch prozentual am meisten davon profitiert .

Wo sind die gefühlten Vorteile?

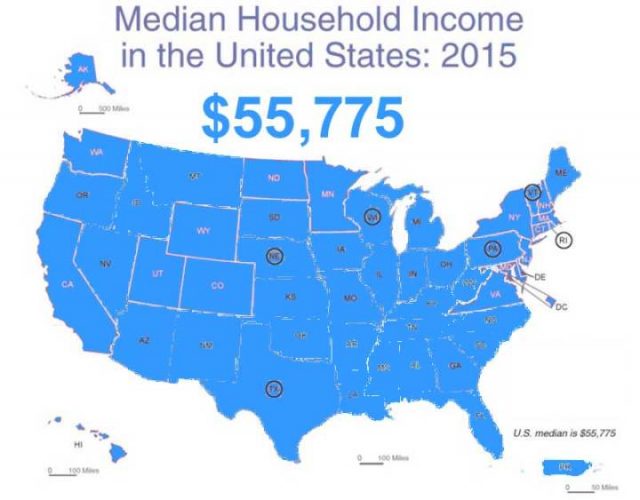

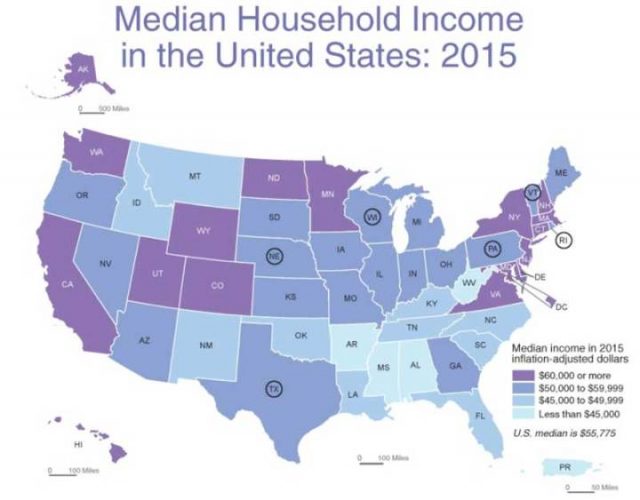

Oben ist, was uns der nationale Durchschnitt mitteilt, die US Median Haushalts Einkommens Metrik. Wenn wir das ein bisschen näher untersuchen, erkennen wir:

Median Haushaltseinkommen nach Bundesstaaten

Neben einigen Überraschungen, wie Minnesota und North Dakota, zeigt es das, was wir vermuten können. Die Bundesstaaten New York, Massachusetts, Connecticut, New Jersey, Maryland, Virginia, Delaware – kommen alle auf das höchste Niveau des durchschnittlichen Haushaltseinkommen, zusammen mit Kalifornien, Washington. Utah war schon immer die Heimstätte der wohlhabenderen Latter-Day Saints [Kirche Jesu Christi der Heiligen der Letzten Tage] und ist zusammen mit Wyoming und Colorado ein Ruhestand Ziel für die Reichen geworden. Die Bundesstaaten, deren Abkürzungen eingekreist sind, haben Haushalte mit Einkommen in der Nähe des nationalen Medians.

Lassen Sie uns das vertiefen:

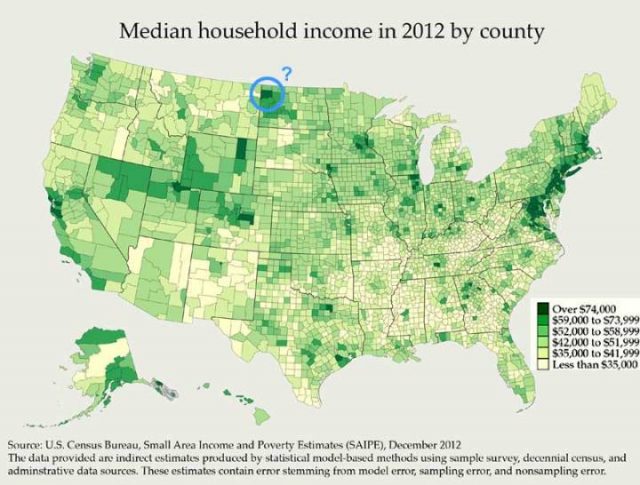

Median Haushaltseinkommen nach Landkreisen

Die dunkleren grünen Kreise haben die höchsten Median Haushaltseinkommen. San Francisco / Silicon Valley im Westen und die Washington DC-bis-New York City-zu-Boston Megapolis im Osten, sind leicht zu erkennen.

Diese Karte beantwortete meine große Frage: Wieso hat North Dakota so ein hohes Median Einkommen? Antwort: Es ist ein Bereich, umkreist und markiert „?“, Zentriert durch Williams County, mit Williston als Hauptstadt. Hier wohnen weniger als 10.000 Familien. Und „Williston sitzt auf der Bakken-Formation, der bis Ende 2012 vorausgesagt wurde, mehr Öl zu produzieren als jeder andere Standort in den Vereinigten Staaten“, es ist das Gebiet von Amerikas neustem Öl-Boom.

Und wo ist das große Geld? Meistens in den großen Städten:

Median Haushaltseinkommen nach Städten

Und wo ist das Geld knapp? Alle jene hellgelben Landkreise sind Gebiete, in denen viele bis die meisten Familien an oder unterhalb der föderalen Armutsgrenze für vierköpfige Familien leben.

Median niedrigste Haushaltseinkommen nach Landkreisen

Einkommen der restlichen Haushalte