RTL-Reportage „Der Klimaschwindel“ von 2007 – warum verpuffte die Aufklärung?

Daß 3Sat und sogar das Erste vor 2010 in Report klimakritische Beiträge von Günther Ederer oder Talkrunden mit Michael Limburg brachten, ist durch das Youtube-Gedächtnis der Österreicher, Schweizer und Deutschen gewährleistet. Vor kurzem wurde auf Facebook in einer Skeptikergruppe (Fakten gegen Klimahysterie) an eine erstaunlich lange und detailreiche Reportage mit Moderatorin Birgit Schrowange erinnert, die heute nicht mehr möglich wäre.

Es ist das Jahr 2007: Al Gores Film Eine unbequeme Wahrheit bekam gerade den Oscar; der Weltklimarat IPCC erhielt den Nobelpreis; und die Bild titelte, „Wir haben nur noch 13 Jahre“.

Und da platzt eine britische Reportage (Channel 4) in den klima-politmedialen Komplex, die es in sich hat. RTL übernahm sie in überarbeiteter eingedeutschter Form, wofür deutsche Medien zitiert und hiesige Journalisten wie Dirk Maxeiner interviewt wurden, so auch Wissenschaftler wie Wolfgang Thüne, Nir Schaviv, Fred Singer und Richard Lindzen, alles Referenten des gerade gegründeten Europäischen Institutes für Klima und Energie, EIKE e.V.

Schauen Sie sich den Film (noch) einmal an; sie werden staunen, was damals in 40 min. in erstaunlich hoher Dichte gebracht wurde. Zusätzlich ist man geplättet, wie klipp und klar sogar ein IPCC-Mitglied, John Christy, die tatsächliche Intention der Klima-Alarmisten benennt:

Man muß eine gewisse Panik schüren, dann fließt das Geld!

Nach der Reportage sendete RTl eine Diskussionsrunde mit Peter Koeppel, Ex-Umweltminister Jürgen Trittin, Zukunftsforscher Matthias Horx, Claudia Kempfert vom Deutschen Institut für Wirtschaftsforschung, dem Meteorologen Dr. Wilfried Thommes und Moderator Tobias Schlegl.

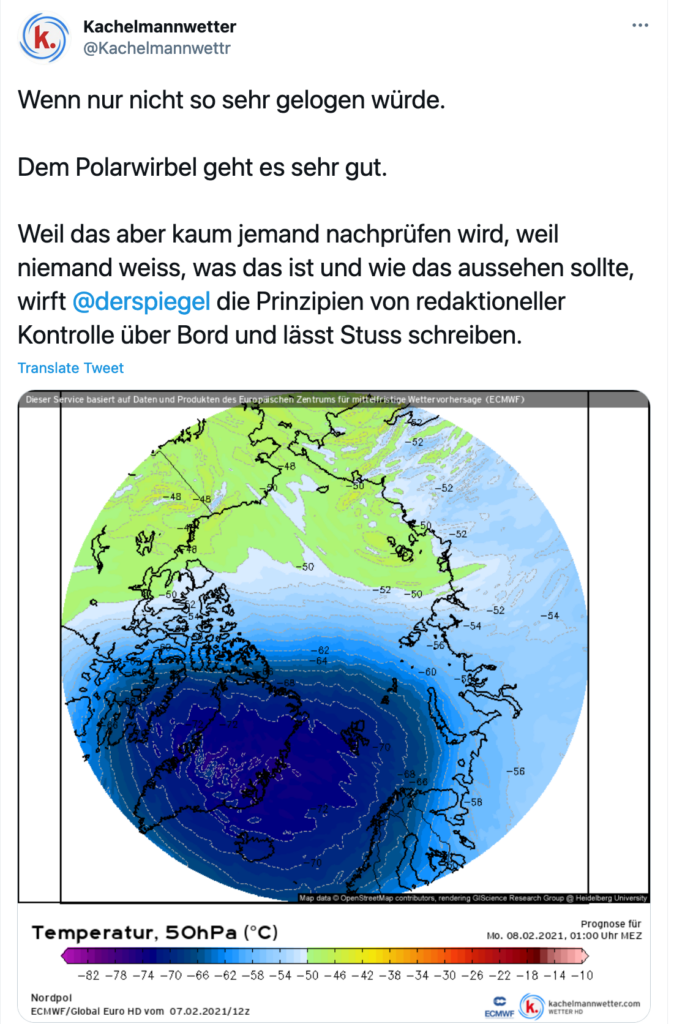

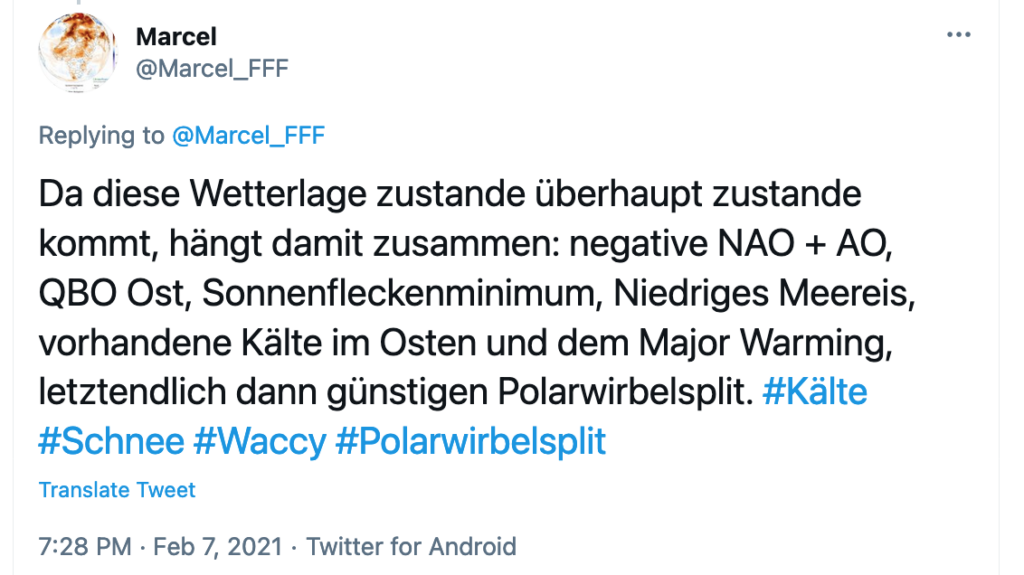

Auch der PIK-Trick, jedes leicht vom gewohnten Wettergeschehen abweichende Phänomen wie der Schneesturm im Februar sogleich als unwiderlegbaren Beweis für den menschgemachten Klimawandel zu präsentieren, wurde damals schon klar benannt. Man hat fast den Eindruck, als hätten sich Rahmstorf & Co. im Film Anregungen geholt.

Aber nein, die „Klimaforschungsfolgen“-Forscher aus dem Hause Schelmhuber, die sich mit Naturwissenschaften nicht so auskennen („Winkel-CO2“), sind gewiefte PR-Leute und Netzwerker, die die ihnen nützlichen Narrative seit Anfang der 90er geschickt unter die Journalisten und Politiker bringen. Dabei sind sie noch nicht einmal die Erfinder der Panikmache: Wie unser Artikel zum Hamburger Klimakongreß 1988 zeigt, sind die heutigen Protagonisten wie Latif, Rahmstorf und Lesch reine Epigonen, die lediglich ein von anderen bereits erprobtes Konzept zur Erlangung von Ruhm & Rubel nutzen.

Was neben dem Inhalt der 07er Reportage auch noch wundert, ist, man muß es so nennen, der Mut des RTL-Extra-Teams und der Moderatorin Birgit Schrowange. Stellen Sie sich, geneigter Leser, einmal vor, eine solche Sendung würde im Jahre 2021 bei RTL oder einem anderen Privatsender wiewie laufen. Der Schittsturm des PIK und anderer Aktivisten, aber vor allem der Journalisten in ARD, ZDF, Spiegel, Süddeutscher Zeitung, Frankfurter Rundschau, Berliner Tagesspiegel, Zeit, FAZ, taz, und so weiter und so fort wäre heftig. Wahrscheinlich gäbe es sogar Talkrunden zur „Wissenschaftsleugnung“ bei Maischberger, sternTV, Anne Will, Maybrit Illner, hart aber fair, und so weiter und so fort. In der Redaktion vermuten wir, daß Schrowange nach einer Woche „freigestellt“ wäre, wie es gerade Julian Reichelt von der Bild passiert ist.

Soweit war damals die Postdemokratie, in der die Fassaden noch stehen, ansonsten aber fast nur noch die Interessen der Privilegierten bedient werden, noch nicht. Stefan Rahmstorf vom Potsdamer Klimainstitut PIK, der in der Abwehr von Kritik besonders aktive und geschickte Klimaprofessor in Deutschland, hat zur Reportage einiges geschrieben. Zitat:

Wie wir von EIKE mit unseren „Millionen von der Ölindustrie“, Sie kennen das ja. An anderer Stelle beklagt Rahmstorf sachliche Fehler im 2007er Film, die absichtliche Fälschungen seien.

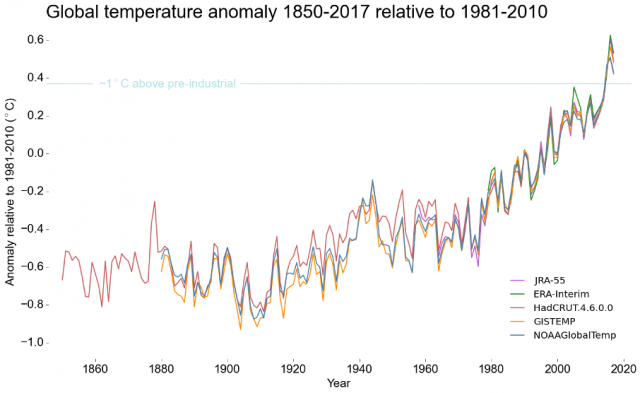

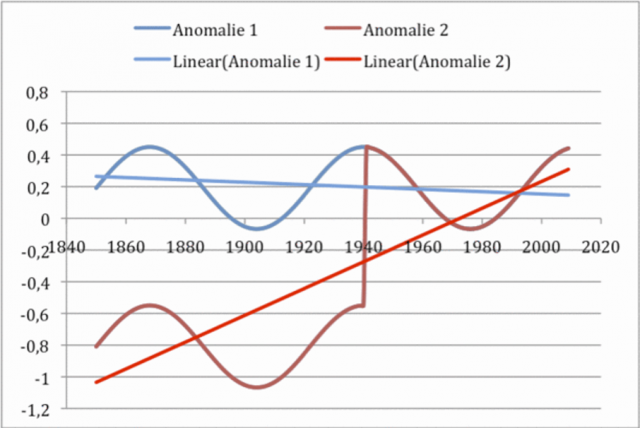

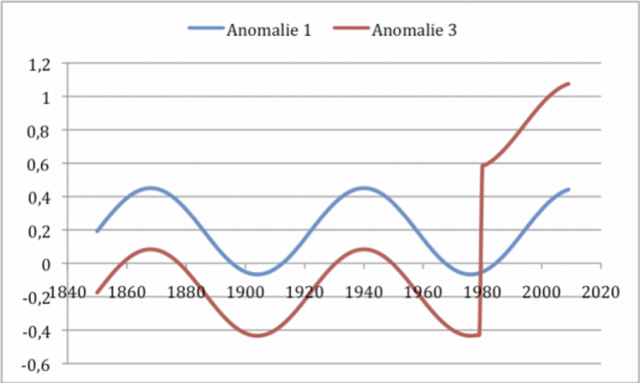

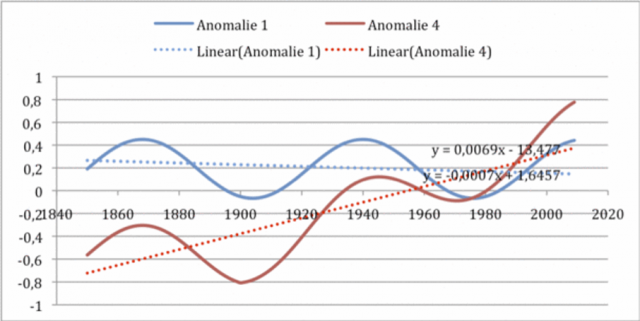

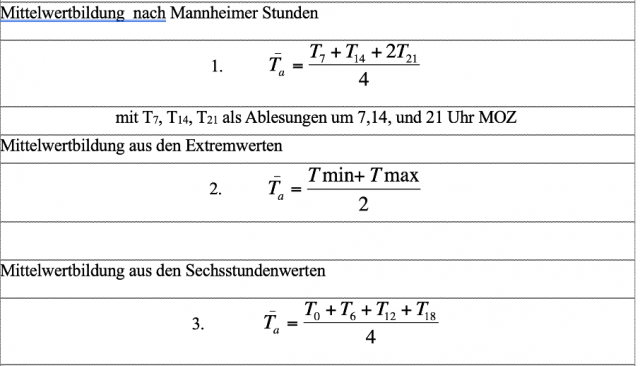

An diesem Beispiel zeigt sich der Unterschied zwischen einer seriösen wissenschaftlichen Diskussion (wo z.B. eine einmal als falsch erkannte Kurve nicht mehr verwendet werden kann, und wo nicht willkürlich Daten erfunden oder weggelassen werden dürfen) und der Mediendiskussion, wo derartige falsche Kurven durch die „Klimaskeptiker“ seit Jahren immer aufs neue einem Laienpublikum präsentiert werden.

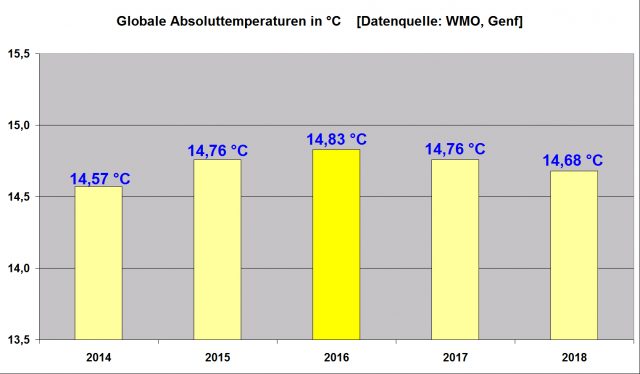

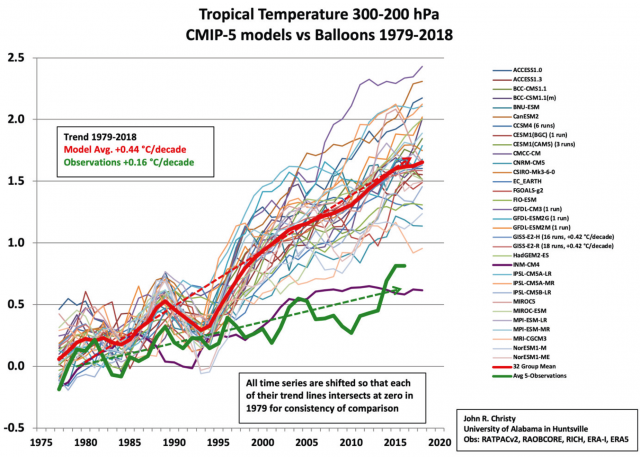

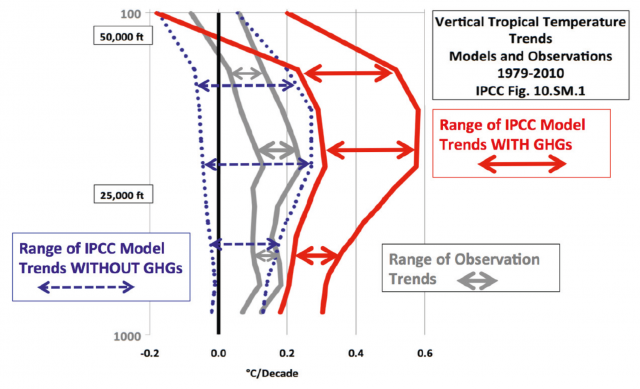

Das ist wirklich pikant – gerade die Forscher der Church of Global Warming gelten, wie Kabarettist Vince Ebert so schön formulierte, als die „Homöopathen der Wissenschaft – Beweisführung, Methodik, alles so’n bißchen huschi-pfuschi“. Man denke zum Beispiel an die beiden Klima-Gates, die zeigten, daß Rahmstorf und Kollegen ihre theoretischen Computermodelle laufend zurechtpfriemeln müssen, damit sie rückwärts und vorwärts in der Zeit zu den Meßdaten passen.

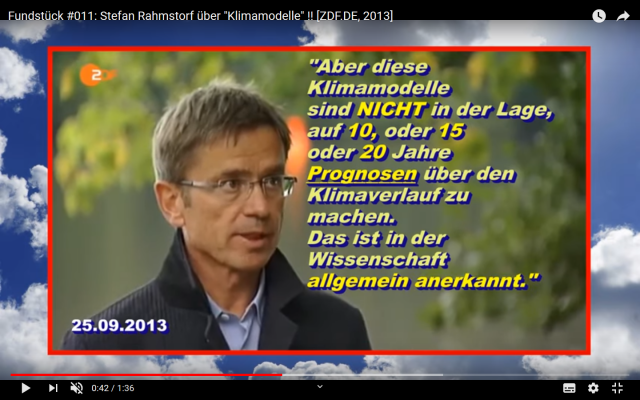

Man denke auch an die Hockeyschlägerkurve von Michael E. Mann, die „seriös wissenschaftlich“ aus völlig unterschiedlichen Datenquellen zusammengeschustert wurde und in der ersten Version die allseits bekannte hochmittelalterliche Heißzeit verschwieg. Man denke auch an Rahmstorfs Beichte, daß seine „seriös wissenschaftlichen“ Rechenmodelle nur chaotische Simulationen aufgrund von Annahmen sind, die nicht als Prognose dienen können.

Der kundige EIKE-Leser erinnert sich vielleicht noch, daß 2007 nicht nur das Jahr des „Klimaschwindels“ war, sondern auch das Jahr des Schlagabtausches von Augusto Mangini, Universität Heidelberg, und Stefan Rahmstorf in der Frankfurter Allgemeinen Zeitung FAZ. Dabei argumentiert Rahmstorf wie so häufig ad hominem:

Höchst selten kommen solche Zweifel noch von seriösen Wissenschaftlern, denn inzwischen haben sich fast alle von den erdrückenden Belegen überzeugen lassen.

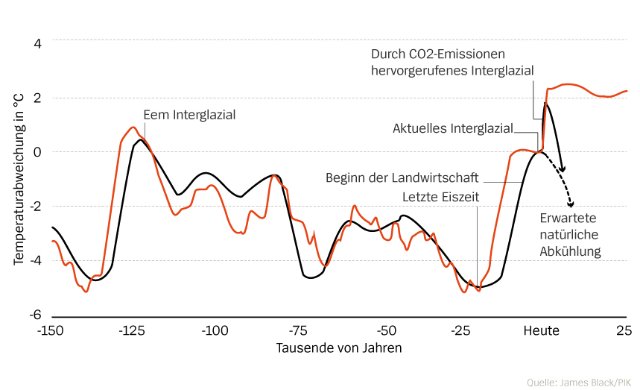

Mangini selber meine er aber nicht, schrieb Rahmstorf, da er mit ihm sogar gemeinsam publiziert habe. Dennoch nutze Mangini ein „Bauernfängerargument“, wenn er sage, daß der natürliche Klimawandel der Vergangenheit ein Hinweis auf die Nichtexistenz des menschgemachten Kollapses sei. Außerdem macht Rahmstorf sich über Manginis Fachgebiet beziehungsweise dessen Proxydaten – Stalagmiten lustig:

Zudem vertritt Mangini bereits seit einigen Jahren die These, die Erwärmung im zwanzigsten Jahrhundert sei überwiegend auf natürliche Sonnenzyklen zurückzuführen. Dies alles schließt er aus Stalagmitendaten.

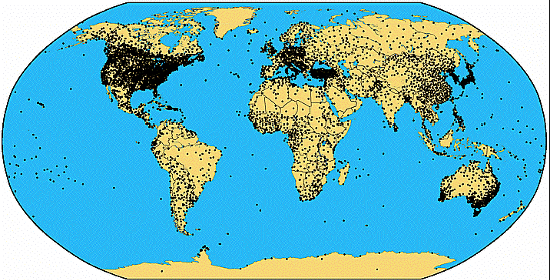

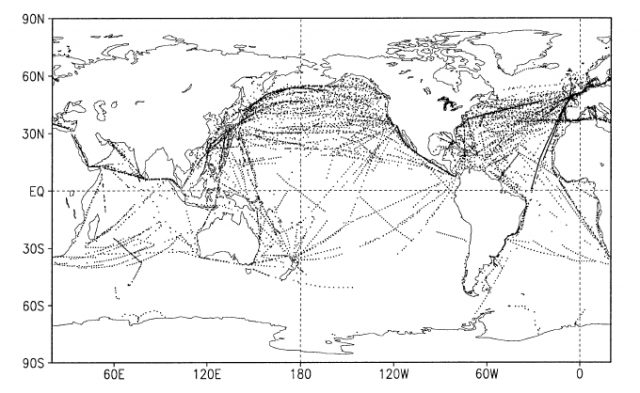

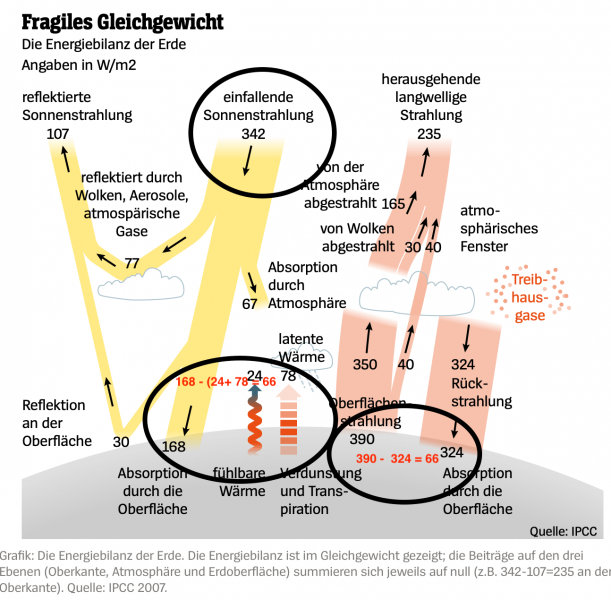

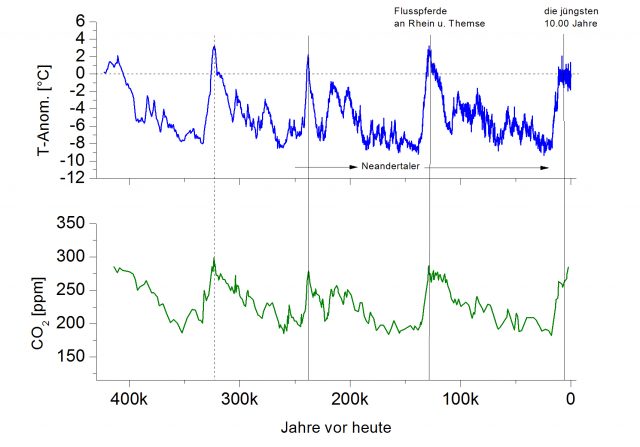

Nein – daß die Sonne mit ihren Zyklen, und andere astronomische Phänomene Hauptreiber des irdischen Klimas sind, war etabliertes Fachwissen in der Meteorologie, bis Treibhausgasforscher wie James Hansen sich politisch-medial in den Vordergrund spielten. Die Wirkung der solaren Zyklen ist durch unterschiedliche Daten bestens belegt – zum Beispiel von den Stalagmiten, die Augusto Mangini als Spezialist selber ausgewertet hat. Wenn die Tropfsteinhöhlen als Proxies unbedeutend seien oder sogar untaugliche Daten lieferten, wie Rahmstorf anklingen läßt – was ist dann mit den Ergebnissen der PIK-Computermodelle, die uns in den Medien als „wissenschaftlicher Beweis“ verkauft werden? Wie Fred Singer auf einer EIKE-Konferenz so schön formulierte: Wissenschaft, das sind die Daten.

Im Artikel teilt Rahmstorf auch noch gegen einen anderen Kollegen aus, dessen Namen er nicht einmal für erwähnenswert hält:

Im bereits erwähnten „heute-journal“ verstieg sich ein Mitarbeiter der Bundesanstalt für Geowissenschaften und Rohstoffe zu der Behauptung, Klimatologen würden vergangene Klimavariabilität gezielt herunterspielen, um den Einfluß des Menschen zu übertreiben. Abgesehen davon, dass dies einem ganzen Berufsstand weltweit Unredlichkeit unterstellt, ist es aus den genannten Gründen logisch unsinnig (…)

Man sieht – 2007 war für die deutschen Priester der Church of Global Warming ein äußerst gefährliches Jahr, in dem ihr guter Ruf (und damit ihre Fördermillionen) beinah gewaltig abgenommen hätte. Leute wie Rahmstorf haben als gewiefte PR-Manager das Ruder noch herumreißen und den klima-politmedialen Komplex in Deutschland derart stabilisieren können, daß ihn auch die beiden hochnotpeinlichen Klimagates nicht mehr erschüttern konnten. Vereinzelte kritische Artikel wie Die selbstgemachte Klimakatastrophe der UN in der Welt fielen schon nicht mehr ins Gewicht. Dabei fällt auf, daß, wie oben gezeigt, der persönliche Angriff und die erstaunlich eifrige Beschäftigung mit den Kritikern im Vordergrund stehen.

Selbstbewußte Wissenschaftler, die politikfern korrekt arbeiten und auf effiziente Wissensakkumulation setzen statt auf eitle Medienpräsenz und politischen Einfluß, haben solche Angriffe gar nicht nötig. Auf sachliche fundierte Kritik wird ebenso sachlich fundiert geantwortet, und im Irrtumsfall der Irrtum zugegeben. Warum auch nicht? – Wissenschaft ist laut (?) Sokrates in erster Linie das Eingeständnis, „zu wissen, daß ich nichts weiß“ – beziehungsweise noch wenig. Die Klimaforscher hingegen betonen auffällig, im Gegensatz zu den „Unseriösen“ und „Verschwörungstheoretikern“ im alleinigen Besitz der Wahrheit zu sein.

Es sollte einmal jemand in den Naturwissenschaften, der Medizin oder im Ingenieurswesen versuchen, Kontrahenten in einer Fachdebatte derart persönlich herabzuwürdigen; der- oder diejenige würde sich unmöglich machen. In den politiknahen Fächern geht es aber nicht die Erforschung der Wirklichkeit oder die darauf basierende effiziente Nutzung der Natur, sondern, wie in der Politik, um Macht und Geld. Dementsprechend fallen die Methoden aus.