Wie viel globale Erwärmung sollte der nächste IPCC-Report prophezeien?

Wie Monckton von Brenchley et al. (2015) in einer Studie für die Chinesische Akademie der Wissenschaften im Jahr 2015 betonten, braucht man kein komplexes, milliardenschweres Computermodell, das bei jedem Einschalten den Stromverbrauch einer Kleinstadt verschlingt und ein Dutzend Eisbären umfallen lässt, falls man nur die ECS berechnen will. ECS ist ein nützlicher Standardmaßstab, weil der verdoppelte CO2-Antrieb ungefähr dem gesamten anthropogenen Antrieb entspricht, den wir in diesem Jahrhundert bei einem Business-as-usual-Szenario erwarten könnten. Diese Studie wurde übrigens von der Website der Zeitschrift der Chinesischen Akademie häufiger heruntergeladen als jedes andere in ihrer 60-jährigen Geschichte, und zwar um eine ganze Größenordnung.

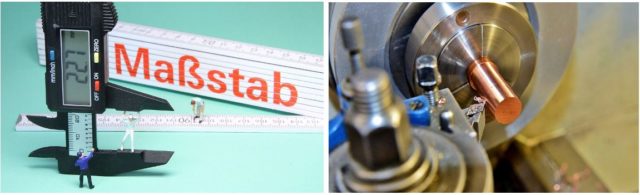

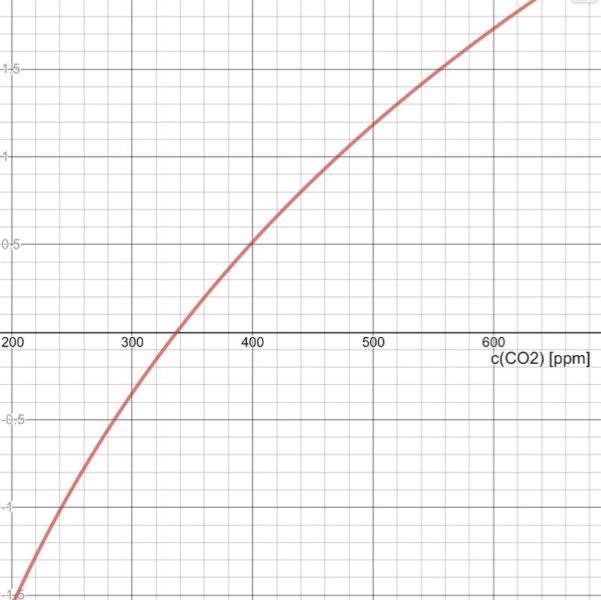

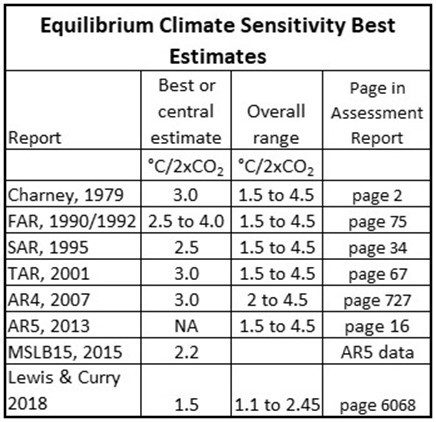

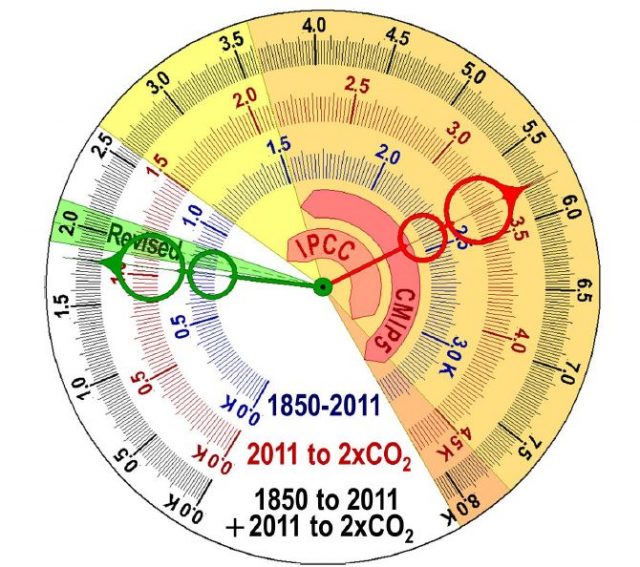

Hier ist ein praktischer ECS-Rechner zum Selbermachen, der auf den neuesten Daten basiert:

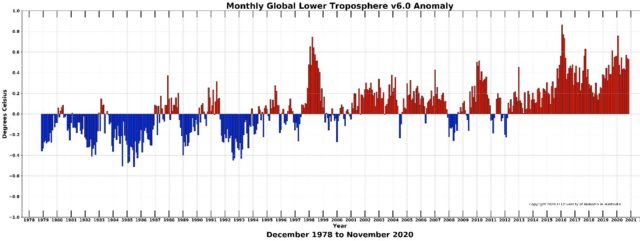

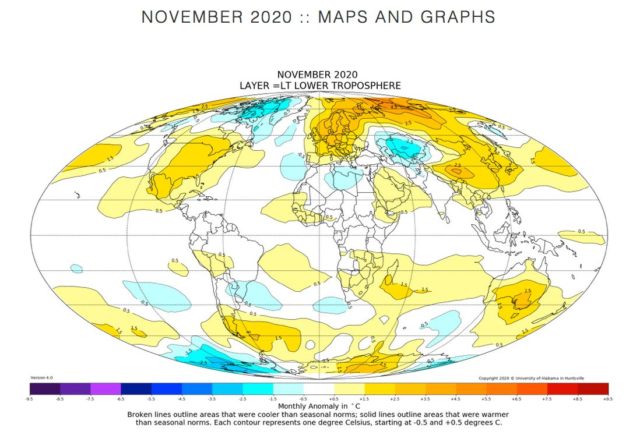

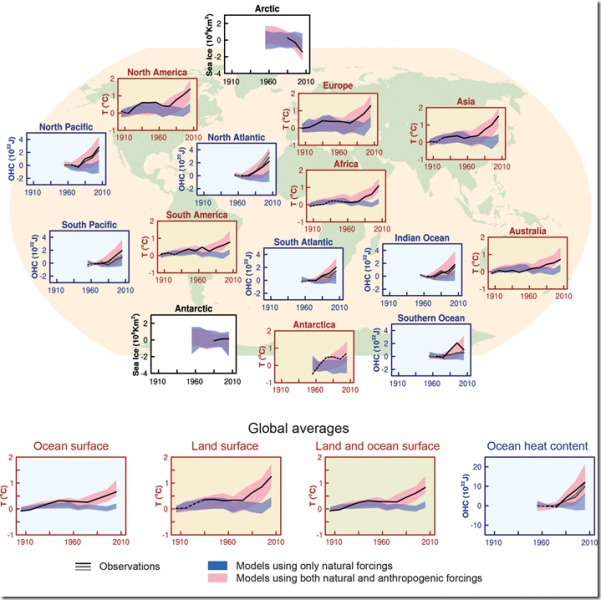

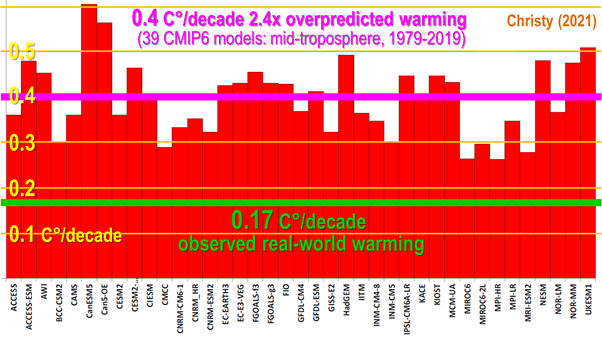

Das IPCC (1990) hatte eine mittelfristige anthropogene Erwärmung von 0,34 K pro Dekade simuliert. In der Realität jedoch beträgt der Least-Squares-Trend über die 30 Jahre 1991-2020 der mittleren Anomalien in zwei monatlichen Temperaturdatensätzen für die Oberfläche (GISS und HadCRUT) und zwei für die untere Troposphäre (RSS und UAH) 0,2 K pro Dekade, wovon 70 % (Wu et al. 2019), also 0,14 K, auf uns zurückzuführen sind.

Daher hat sich die ursprüngliche mittelfristige Erwärmung der unteren Atmosphäre des IPCC als 2,4-fach überbewertet erwiesen. John Christy (2021) hat kürzlich in einem faszinierenden Online-Vortrag gezeigt (Abb. 1), dass die CMIP6-Modelle die mittelfristige Erwärmung der mittleren Troposphäre ebenfalls um das 2,4-fache überbewertet haben:

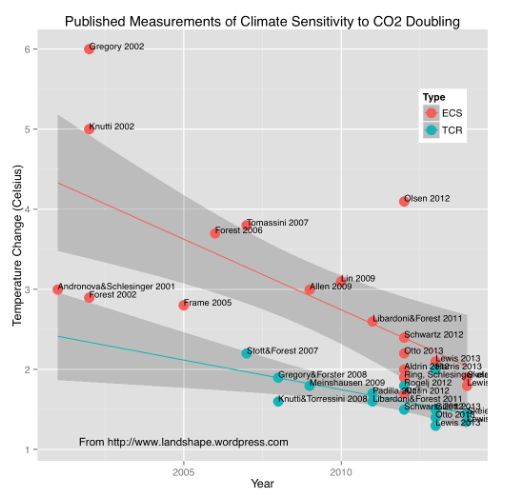

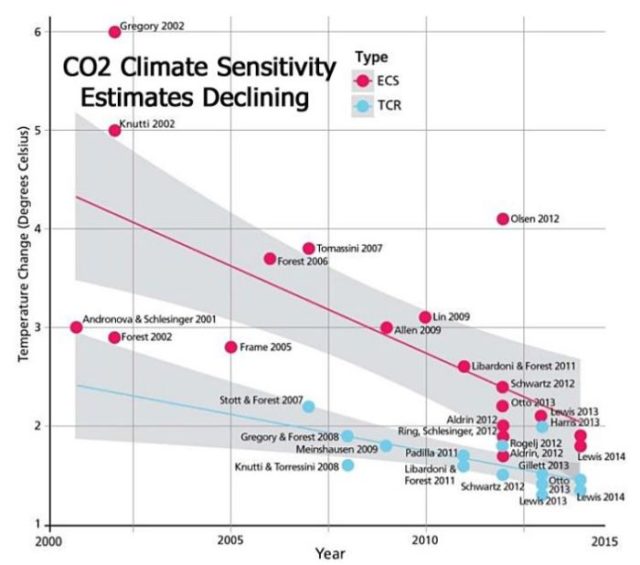

Man kann eine erste grobe Schätzung der mittleren ECS erhalten, indem man die mittlere CMIP6 ECS-Vorhersage von 3,7 K (Meehl et al. 2020) nimmt und durch 2,4 dividiert. Antwort: 1,5 K: nicht genug, um sich Sorgen zu machen.

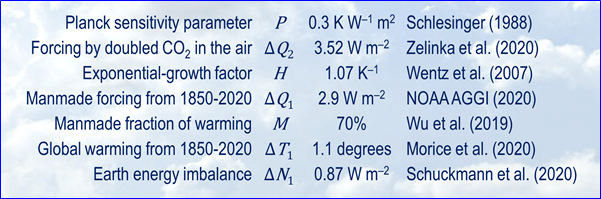

Um ECS ΔE2 genauer abzuleiten, indem man die Ideen der Studie von der Chinese Academy weiter entwickelt, braucht man nur sieben leicht zugängliche und vernünftig eingeschränkte mittlere Parameter aus dem Mainstream:

1: Der Planck-Sensitivitätsparameter P ist die erste Ableitung der Stefan-Boltzmann-Gleichung: d.h. das Verhältnis der Oberflächentemperatur zum 4-fachen der Albedo-angepassten einfallenden Strahlungsflussdichte über der Atmosphäre (Schlesinger 1988). Somit ist P= 288 / (4 x 241), oder 0,3 K/Wm². Dieser unumstrittene Wert variiert mit der Oberflächentemperatur: aber von 1850 bis zur Verdoppelung des CO2 im Vergleich zur heutigen Temperatur ist er nahe genug an 0,3 und macht damit keinen wesentlichen Unterschied.

2: Der Verdopplungs-CO2-Strahlungsantrieb ΔQ2 wurde in Andrews (2012) mit 3,45 W/m² angegeben, dem Mittelwert von 15 CMIP5-Modellen. Für CMIP6 geben Zelinka et al. (2020) 3,52 W/m² an. Da wir die neuesten Mainstream-Daten verwenden, ziehen wir Letzteren heran.

3: Der exponentielle Wachstumsfaktor H pro Rückkopplungs-Einheit mit der Referenzsensitivität wird hier vorsichtshalber mit dem Wert von 1,07 pro K gleichgesetzt, der in Wentz (2007) als Clausius-Clapeyron-Zunahme der spezifischen Feuchtigkeit bei Erwärmung angegeben wird. Auch diese Größe variiert mit der Temperatur, kann aber über das hier relevante enge Temperaturintervall sicher als konstant angenommen werden. In der Realität wird das exponentielle Wachstum der spezifischen Luftfeuchtigkeit durch die logarithmische Temperaturreaktion auf dieses Wachstum ausgeglichen, und das IPCC (2013) schätzt, dass im mittleren Bereich alle anderen Rückkopplungen sich selbst aufheben. In der Realität gibt es wahrscheinlich nur ein geringes oder gar kein Wachstum der Einheitsrückkopplung unter den heutigen Bedingungen. Doch selbst falls man H = 1,2 annehmen würde, was deutlich über der Realität liegt, würde sich ECS kaum ändern.

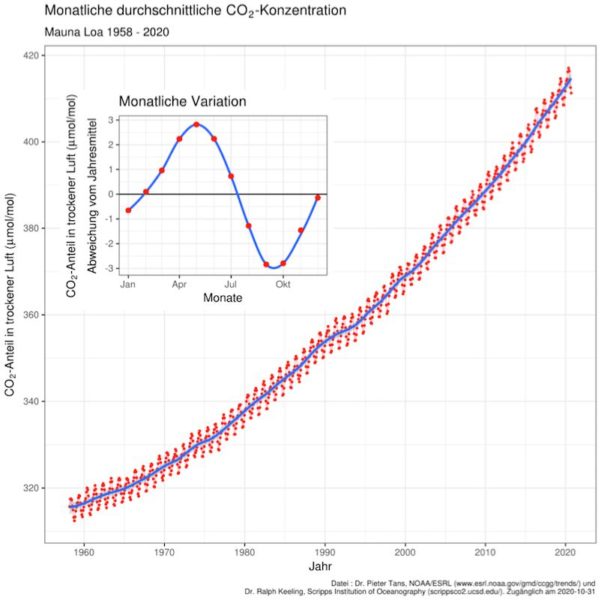

4: Der anthropogene Antrieb ΔQ1 von 1850-2020 betrug 2,9 W/m², die Summe des 3,2 W/m² akkumulierten Treibhausgasantriebs und der 0,4 W/m² Ozon-, -0,8 W/m² Aerosol- und 0,1 W/m² Black-Carbon-Antriebe (NOAA AGGI; Gaudel+ 2020; Dittus+ 2020; IPCC 2001, S. 351).

5: Der anthropogene Anteil M der Erwärmung und des Strahlungsungleichgewichts von 1850-2020 betrug 0,7 (Wu et al., 2019; Scafetta 2021). Die Arbeit von Wu hat Gerald Meehl als Co-Autor.

6: Die vorübergehende Erwärmung T1 von 1850-2020 betrug 1,07 K (HadCRUT5: Morice et al. 2020). Basierend auf Wu et al. waren nur 70% davon, also 0,75 K, anthropogen bedingt.

7: Das Energieungleichgewicht ΔN1 der Erde von 1850-2020 berücksichtigt die Verzögerung des Einsetzens der Erwärmung nach einem Forcing. Schuckmann et al. (2020) geben die aktuelle Mainstream-Mittelwertschätzung 0,87 W/m².

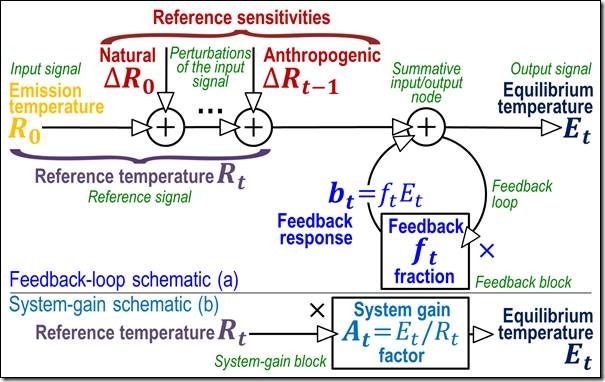

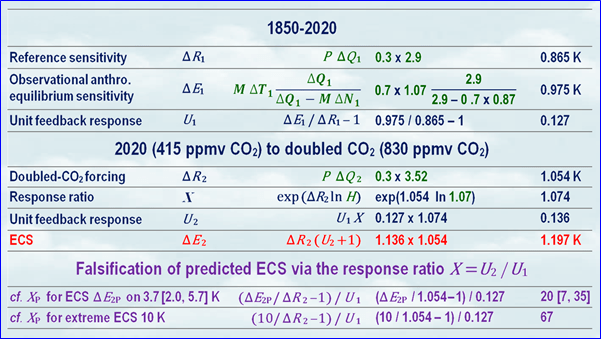

Mit diesen sieben Größen (Abb. 2), alle im mittleren Bereich, alle aktuell, alle aus klimatologischen Mainstream-Quellen, kann man nicht nur eine verlässliche mittlere Schätzung des beobachteten ECS direkt ableiten, ohne auf überkomplexe, unzureichend falsifizierbare und fehleranfällige Computermodelle zurückgreifen zu müssen, sondern auch die Vertretbarkeit des derzeit projizierten ECS-Intervalls 3,7 [2,0, 5,7] K (mittlerer Bereich Meehl et al., 2020; Grenzen Sherwood et al., 2020) falsifizieren. Die Berechnungen sind in Abb. 3 dargestellt. Diese einfache Tabelle bedeutet den Untergang für die Profiteure des Untergangs.

Wie es funktioniert: Seit 1850 haben wir nun angeblich 170 Jahre lang das Klima beeinflusst. Davor war unser Einfluss vernachlässigbar. Aus den sieben Größen in Abb. 2 lässt sich eine entscheidende Größe ableiten – die Einheitsrückkopplungs-Reaktion, die zusätzliche Erwärmung durch Rückkopplung pro Grad Referenzsensitivität. Damit lässt sich diese Reaktion für den Zeitraum von jetzt bis zur CO2-Verdoppelung mit Hilfe des Exponentialwachstumsfaktors H finden, woraus sich ECS ΔR1 ableiten lässt.

1850-2020: Die Periodeneinheit der Rückkopplungsreaktion U1 ist 1 kleiner als das Verhältnis der Gleichgewichtssensitivität ΔE1 zur Referenzsensitivität ΔR1: d. h. 1 kleiner als das Verhältnis der Periodenerwärmung einschließlich Rückkopplungsreaktion zur Periodenerwärmung ohne Rückkopplungsreaktion).

Die Perioden-Referenzsensitivität ΔR1, die direkte Erwärmung vor Hinzurechnung der Rückkopplung, beträgt 0,865 K, das Produkt aus dem Planck-Parameter 0,3 K W-1 m2 und dem anthropogenen Perioden-Antrieb ΔQ1 von 2,9 W/m².

Die Perioden-Gleichgewichts-Sensitivität ΔE1, die eventuelle Erwärmung, nachdem alle kurzzeitigen Rückkopplungen gewirkt haben und sich das Klima wieder im Gleichgewicht befindet, ist etwas komplizierter. Sie ist das Produkt aus zwei Ausdrücken: dem anthropogenen Anteil M ΔT1 der beobachteten vorübergehenden Erwärmung ΔT1 und dem Energie-Gleichgewichts-Verhältnis.

Das Energie-Ungleichgewichts-Verhältnis ist der periodische anthropogene Antrieb ΔQ1 geteilt durch die Differenz zwischen ΔQ1 und dem anthropogenen Anteil M ΔN1 des periodischen Energie-Ungleichgewichts der Erde ΔN1. Im Gleichgewicht gäbe es kein Energieungleichgewicht: der Divisor und der Dividend wären beide gleich ΔQ1. In diesem Fall wäre ΔE1 gleich M ΔT1. Besteht jedoch (wie derzeit) ein Energieungleichgewicht, wird es auch ohne weiteren Strahlungsantrieb nach 2020 zu einer weiteren Erwärmung kommen, so dass ΔE1 das Produkt aus M ΔT1 und dem Energieungleichgewichtsverhältnis ist: also 0,975 K.

Die Einheits-Rückkopplungs-Reaktion U1, die Rückkopplungs-Reaktion pro Grad der Perioden-Referenzempfindlichkeit, ist 1 kleiner als der Systemverstärkungsfaktor ΔE1 / ΔR1. Er beträgt nur 0,127. Vergleichen Sie diesen einfachen, aus Beobachtungen abgeleiteten Mittelwert mit dem Wert von 3,0, der in der folgenden Passage aus Lacis et al. (2010) impliziert ist, die die fehlerhafte offizielle Position zusammenfasst:

„Nicht-kondensierende Treibhausgase, die 25 % des gesamten terrestrischen Treibhauseffekts ausmachen, … sorgen für die stabile Temperaturstruktur, die die gegenwärtigen Niveaus des atmosphärischen Wasserdampfs und der Wolken über Rückkopplungsprozesse aufrechterhält, die die restlichen 75 % des Treibhauseffekts ausmachen“ (Lacis et al., 2010).

2020 auf verdoppeltes CO2: Wie bei 1850-2020, so bei verdoppelter CO2-Konzentration im Vergleich zu den 415 ppmv im Jahr 2020, beginnen Sie mit der Periode die Referenzsensitivität ΔR2, die direkte Erwärmung vor der Addition jeglicher Rückkopplung. ΔR2 ist 1,054 K. Es ist das Produkt aus dem 0,3 K/Wm² (Planck-Parameter) und den 3,52 W/m² anthropogenen Periodenantrieb ΔQ2.

Als nächstes wird die Rückkopplung berücksichtigt, um ECS ΔE2 zu erhalten. Die Methode besteht darin, die Rückkopplungsreaktion U1 der Einheit 1850-2020 entsprechend dem Exponential-Wachstumsfaktor H zu erhöhen.

Das Einheits-Rückkopplungsverhältnis X ist gleich exp(P ΔQ2 ln H), d. h. exp(ΔR2 ln H), oder, einfacher, aber für Mathematik-Puristen anstößig, HΔR2, was 1,074 ist.

Die Einheitsrückkopplung U2 ist das Produkt aus U1 und X, d. h. 1,136.

ECS ΔE2 ist das Produkt aus der Referenzsensitivität ΔE2 auf verdoppeltes CO2 und dem Systemverstärkungsfaktor U2 + 1, d. h. 1,2 K. Nicht 3,7 K (CMIP6: Meehl et al. 2020). Nicht 3,9 K (CMIP6: Zelinka et al. 2020). Nur 1,2 K mittlere anthropogene globale Erwärmung als Reaktion auf verdoppeltes CO2, oder auf alle anthropogenen Antriebe über das gesamte 21. Jahrhundert. Kein großer „Klimanotstand“ also, oder?

Falsifizierung von ECS-Vorhersagen über das Rückkopplungsverhältnis X: Mit dem Wissen, dass die aus Beobachtungen abgeleitete Einheits-Rückkopplungs-Reaktion U1 für 1850-2020 0,127 betrug, ist es möglich, den Wert von XP abzuleiten, der in jeder ECS-Vorhersage ΔE2P impliziert ist: XP = (XP / ΔR2 – 1). Zum Beispiel impliziert der von Meehl et al. (2020) und Sherwood et al. (2020) vorhergesagte ECS von 3,7 [2,0, 5,7] K impliziert XP auf 20 [7, 35]. Selbst die untere Grenze X = 7 würde unhaltbar suggerieren, dass die Rückkopplungsreaktion pro Grad direkter Erwärmung nach 2020 das absurde Siebenfache der Rückkopplungsreaktion pro Grad vor 2020 beträgt. Der in mehreren extremen Arbeiten vorhergesagte High-End-ECS von 10 K ist noch unmöglicher und impliziert X = 67.

Die Unsicherheiten sind gering, da sich die Klimatologie inzwischen auf die Werte der sieben Schlüsselparameter geeinigt hat, die für die Ermittlung des ECS ausreichen. Würde man die 40 Jahre der etwas schnelleren Erwärmung von 1980-2020 als Berechnungsgrundlage nehmen, statt 1850-2020, würde der mittlere ECS auf nur 1,4 K steigen. Selbst falls die gesamte Erwärmung der Industriezeit anthropogen wäre, würde der ECS nur 2 K betragen, aber es wäre nicht mehr der mittlere ECS auf der Basis der aktuellen Mainstream-Daten.

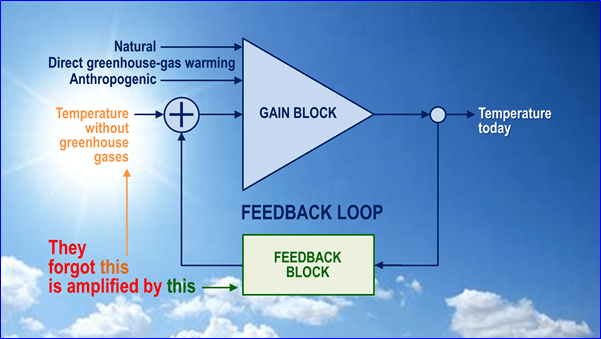

Was sie falsch verstanden haben: Wie haben sich die Klimawissenschaftler dann jemals vorstellen können, dass die globale Erwärmung etwa dreimal so hoch sein würde, wie es die realen Beobachtungen, die sich in ihren neuesten Midrange-Daten widerspiegeln, einen unvoreingenommenen Untersucher erwarten lassen würden?

Klimamodelle verkörpern den Feedback-Formalismus nicht direkt. Ihre ECS-Vorhersagen spiegeln jedoch den Fehler wider, indem sie eine 2,4-mal höhere mittelfristige, anthropogene Erwärmung zeigen als während der letzten 30 Jahre beobachtet, und sie prophezeien das Dreifache der realistischen mittelfristigen ECS.

Im Jahr 2006, in Vorbereitung auf meinen ersten Artikel über die globale Erwärmung, schrieb ich an den verstorbenen Sir John Houghton, damals Vorsitzender der wissenschaftlichen Arbeitsgruppe des IPCC, um zu fragen, warum man dachte, dass die eventuelle globale Erwärmung etwa das Dreifache der direkten Erwärmung betragen würde. Er antwortete, dass der natürliche Treibhauseffekt – die Differenz zwischen der 255 K Emissions-Temperatur ohne Treibhausgase und der 287 K gemessenen Temperatur im Jahr 1850 – 8 K Referenzsensitivität auf Treibhausgase und 24 K Rückkopplungsreaktion darauf umfasste.

Es war diese Erwartung von 3 K Rückkopplung auf jeweils 1 K direkte Erwärmung, also insgesamt 4 K Erwärmung, die die Modellierer dazu brachte, 3 oder 4 K ECS im mittleren Bereich zu erwarten.

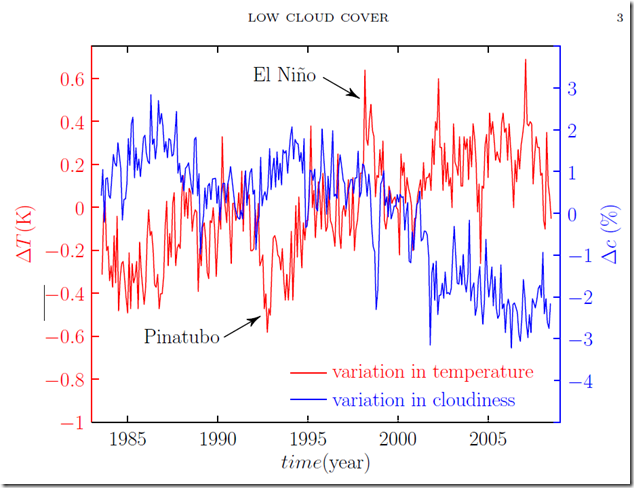

Die Klimatologen hatten vergessen, dass die Sonne scheint (Abb. 4). Was sie übersehen hatten, als sie Mitte der 1980er Jahre die Rückkopplungsformel aus der Regelungstheorie entlehnten war, dass die 24 K vorindustrielle Rückkopplungs-Reaktion nicht nur eine Antwort auf die 8 K direkte Erwärmung durch Treibhausgase war. Ein großer Teil dieser 24 K war eine Reaktion auf die 255 K Emissionstemperatur, die sich auf der Erde auch ohne Treibhausgase eingestellt hätte.

In Wirklichkeit war die vorindustrielle Referenztemperatur die Summe der 255-K-Emissionstemperatur und der 8-K-Referenzsensitivität für vorindustrielle Treibhausgase: also irgendwo in der Gegend von 263 K. Da die 255-K-Emissionstemperatur das 32-fache der 8-K-Referenzsensitivität für Treibhausgase ist, war ein erheblicher Teil der gesamten vorindustriellen Rückkopplungsreaktion von 24 K auf die erstere zurückzuführen, was den Anteil der letzteren entsprechend reduzierte.

Rückkopplung ist eine allgemein gültige Eigenschaft dynamischer Systeme (Systeme, die ihren Zustand mit der Zeit ändern), von elektronischen Schaltkreisen bis zum Klima. Falls und nur falls die gesamte vorindustrielle Referenztemperatur 8 K betrug und es überhaupt keine Rückkopplungsreaktion auf die Emissionstemperatur gab, wäre es zulässig, sich vorzustellen, dass die Rückkopplungsreaktion der Einheit so groß wie 3 war. Selbst dann würde nicht automatisch folgen, dass die Rückkopplungsreaktion der Einheit heute auch nur annähernd so groß wie 3 sein könnte.

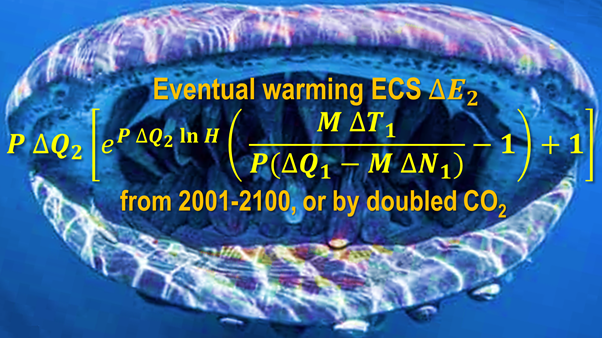

Das IPCC wiederholte den Fehler in seinem Fünften Sachstandsbericht von 2013 (AR 5) und wird ihn in seinem bevorstehenden Sechsten Sachstandsbericht (AR 6) erneut begehen. Man definiert „Klima-Rückkopplung“ als Reaktion nur auf Störungen (fünfmal in der Definition erwähnt), schweigt aber über die weitaus größere Rückkopplungsreaktion auf die Emissionstemperatur selbst. Sie sollte ihre mehrtausendseitigen Berichte durch die einzige Monstergleichung (Abb. 5) ersetzen, die die schrittweisen Berechnungen in Abb. 3 zusammenfasst:

Wären Sie bereit, Ihren Namen unter einen Bericht an das IPCC zu setzen, unter dessen Fehlerprotokoll, und es darüber zu informieren, dass ECS grob überbewertet wurde und um Korrektur bitten? Falls ja, kontaktieren Sie mich über das erste Wort meines Nachnamens [at] mail [dot] com und lassen Sie es mich wissen. Denn die neuesten Mainstream-Mitteldaten, auf die sich das IPCC zwangsläufig stützen muss, schließen die schnelle, gefährliche Erwärmung aus, die es so lange, so zuversichtlich, so gewinnbringend, aber so fehlgeleitet vorhergesagt hat.

Link: https://wattsupwiththat.com/2021/02/01/how-much-global-warming-should-ipccs-next-report-predict/

Übersetzt von Chris Frey EIKE

Anmerkungen des Übersetzers hierzu: Auch mit diesem Beitrag zeigt sich, dass Lord Monckton von einer Erwärmungswirkung durch CO2 aujsgeht – wenn gleich auch viel geringer als vom IPCC prophezeit. Nun mehren sich die Zweifel an einer solchen Wirkung immer mehr, was heißt, dass auch Lord Monckton irgendwo einem Trugschluss unterliegen muss. Vielleicht kann ein versierter Kommentator dazu etwas sagen?