Die Ursprünge des Schwindels vom menschengemachten Klimawandel

Als ich meine Promotion in physikalischer Geographie im Jahre 1981 an der Universität von Calgary abschloss, konnte ich die schwachen Umrisse des „globalen Erderwärmungszuges“ noch kaum erkennen, der die Schienen vom entfernten Horizont herandampfte. Zu dieser Zeit wertete ich den zunehmenden Fokus auf Klimaforschung als gute Sache, weil er würdigen wissenschaftlichen Forschungen dringend benötigte Geldmittel zukommen ließ. Als ich meine universitäre Lehrkarriere (ebenfalls 1981) an der Northern Arizona University in meiner Heimatstadt Flagstaff begann, schien es, als stünde dem jungen Feld der Paläoklimatologie (Studium des Klimas der Vergangenheit) ein Goldenes Zeitalter bevor. Es war eine aufregende Zeit. Zusätzlich zu einem sehr arbeitsaufwendigen Lehrauftrag an der Universität trat ich der American Quaternary Association (AMQUA) bei, einer lose geknüpften, interdisziplinären Gruppe von Gelehrten aus Amerika und Kanada, und wurde ihr Schatzmeister. Bei AMQUA-Treffen genoss ich das Privileg, einige der anerkanntesten Gelehrten aus vielen Gebieten akademischer Forschung treffen zu können, die der Klimaforschung verwandt sind.

Eine der kleinen „wissenschaftlichen Revolutionen“, die sich zu dieser Zeit zutrugen, bestand darin, dass nach Jahrzehnten der Ignoranz durch den „wissenschaftlichen Konsens“ die Milankowitsch- oder Astronomische-Zyklen-Theorie des Klimawandels durch Korrelation von datierten irdischen und ozeanischen Sediment-Sequenzen, die ein eindeutiges „Klimasignal“ trugen, „bewiesen“ wurde. Die Idee astronomisch bedingter Klimazyklen, die die großen glazialen-interglazialen Fluktuationen der letzten zwei bis drei Millionen Jahre antreiben (auch bekannt als „Eiszeit“), schien nun von der Wissenschaftsgemeinde weithin akzeptiert.

Was mir zu dieser Zeit nicht bewusst war: Die junge Wissenschaft der Klimatologie war auf den Fluren der Macht in Washington, D.C. und andernorts bereits zu Zwecken der Ausbeutung und Kooption ins Visier genommen worden, weil sie nützliche Mittel zur Förderung politisch-ökonomischer Ziele lieferte. Denkfabriken wie der „Report from Iron Mountain“ und der Club of Rome, politische Entitäten wie die Vereinten Nationen, verschiedene Zweige des Militärs und der Geheimdienstgemeinde sowie Wall-Street-Konzerne hatten damals entschieden, dass Klima-„Forschung“ genutzt werden könne, um „globalistische“ politisch-ökonomische Ziele voranzutreiben. Tatsächlich kam der „Report from Iron Mountain“ zu dem Schluss, dass die „Wahrnehmung“ einer drohenden Umweltkatastrophe als Ersatz für Krieg dienen könnte und in der Zukunft als organisierendes Prinzip für die Gesellschaft: „Ökonomische Surrogate für Krieg müssen zwei wesentliche Kriterien erfüllen. Sie müssen ‚verschwenderisch‘ sein im landläufigen Sinne des Wortes, und sie müssen außerhalb des normalen Systems von Angebot und Nachfrage operieren.“ – „Es kann sein, dass die schwerwiegende Verschmutzung der Umwelt die Möglichkeit der Massenvernichtung durch Nuklearwaffen als oberste offensichtliche Bedrohung für das Überleben der Spezies ersetzen kann…“ So der „Report from Iron Mountain on the Possibility and Desirability of Peace“ (1967) („Der Bericht von Iron Mountain zur Möglichkeit und Erwünschtheit von Frieden“, deutscher Titel: „Verdammter Friede“) der „Special Study Group“, angeblich Mitglieder eines geheimen Pentagon-Thinktanks (von dem angenommen wurde, dass es sich um die Rand Corporation handelt), dem auch Harvard-Ökonom John Kenneth Galbraith angehörte.

„Auf der Suche nach einem neuen Feind, um uns zu vereinen, kamen wir auf die Idee, dass Umweltverschmutzung, die Bedrohung durch Erderwärmung, Wasserknappheit, Hunger und Ähnliches ihren Zweck erfüllen würden. Die Erde hat Krebs, und der Krebs ist der Mensch.“ – „Der wahre Feind ist dann der Mensch selbst.“ Die „daraus resultierende ideale, tragfähige Erdbevölkerung liegt demnach bei über 500 Millionen, aber weniger als einer Milliarde.“ (Club of Rome)

Zu Beginn meiner akademischen Karriere wusste ich das noch nicht, aber die Suche nach wissenschaftlicher Wahrheit auf Feldern wie der Klimatologie und Paläoklimatologie war bereits politischen und finanziellen Zwecken internationaler Finanziers und ihrer zahlreichen Lakaien-Organisationen untergeordnet.

Auf diese Weise wurde das Feld der Klimawissenschaft in „Pseudowissenschaft“ verwandelt. Die hauptsächlichen Mechanismen dieser Kooption umschlossen UN-gesponserte Staatsfinanzierung, Zensur und Kontrolle von Klimawissenschaftlern und Klimaforschung durch ein System aus Belohnungen und Bestrafungen, ein Netzwerk befangener Zeitschriftenherausgeber sowie, vermutlich am wichtigsten, Computermodelle. In Computermodellen hängen Schlussfolgerungen ausschließlich von den Annahmen ab, die in die Modelle programmiert wurden. Oder wie Computeranalysten sagen: „Garbage in, garbage out.“ („Müll geht rein, Müll kommt raus.“)

Zu den Hauptannahmen, die in diese elaborierten und teuren Klimamodelle programmiert wurden, gehörten: Erstens, es gab keinen signifikanten Klimawandel während der ungefähr 4,6 Milliarden Jahre, die der Ankunft der Ära der fossilen Brennstoffe (circa 1850) vorausgingen, und zweitens, Kohlendioxid ist der größte Klimatreiber.

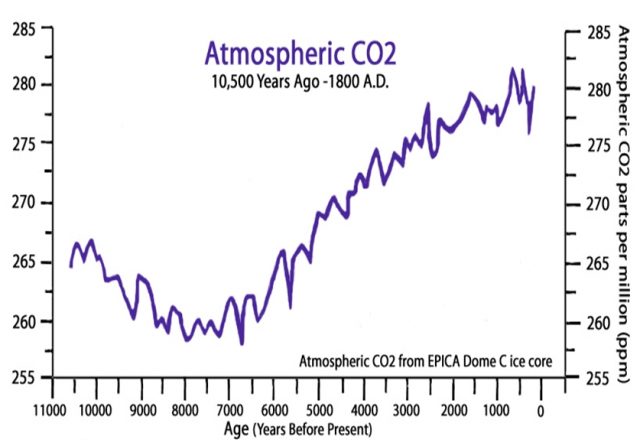

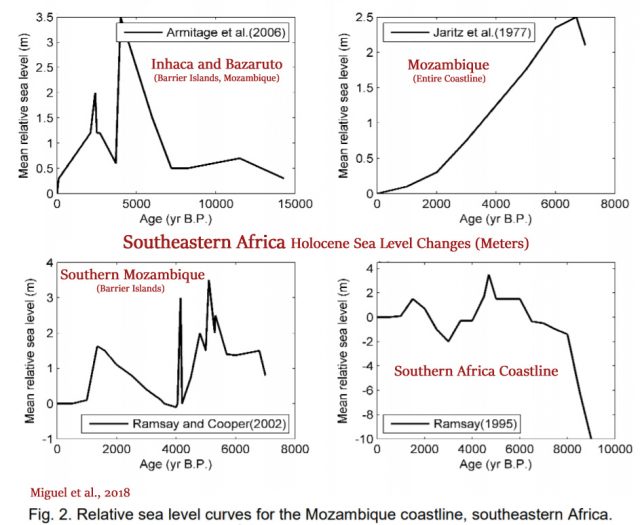

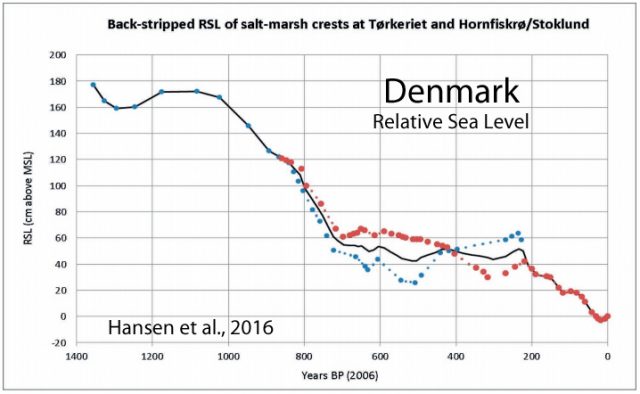

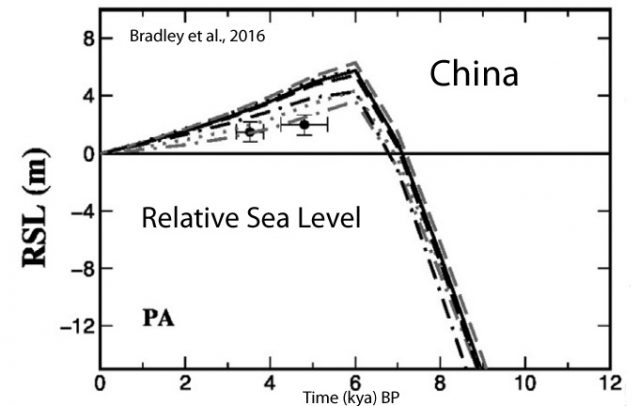

Beide dieser Annahmen sind haarsträubend und falsch und wurden schon vor langer Zeit vom Großteil der wissenschaftlichen Forschung widerlegt. Tatsächlich weist die vorherrschende Forschung darauf hin, dass sich das Klima der Vergangenheit radikal und oft zyklisch wandelte und dass das Spurengas Kohlendioxid eine vernachlässigbare Rolle beim tatsächlichen „Treiben“ der Temperaturen spielt.

Wie es Dr. Reid Bryson, der Vater der modernen wissenschaftlichen Klimatologie, formulierte: „Sie können rausgehen und auf den Boden spucken und dabei denselben Effekt erzielen wie durch eine Verdopplung von Kohlendioxid.“ – „Die gesamte Debatte, ob die Temperatur steigt oder nicht, ist absurd. Natürlich steigt sie. Sie stieg seit der Frühzeit des 19. Jahrhunderts, vor der industriellen Revolution, weil wir aus einer Kleinen Eiszeit austreten, aber nicht, weil wir mehr Kohlendioxid in die Luft blasen.“

„Müll rein, Müll raus“ erklärt teilweise, warum die vielen von Regierungen gesponserten Klimamodelle alle fehlerhafte Voraussagen lieferten (auch bekannt als „Projektionen“ und „Szenarien“).

Somit schloss die Kooption und Korruption der Klimawissenschaft eine Kollision von Interessen mit ein, deren Ergebnis war, dass Standardverfahren wissenschaftlicher Untersuchungsmethoden durch mächtigere politische/ökonomische Kräfte verzerrt wurden, das heißt durch die „Macht der Brieftasche“. Diese Dynamik sollte einen profunden und negativen Einfluss auf meine eigene Karriere haben, ebenso – da bin ich mir sicher – auf die Karrieren vieler meiner Kollegen, inklusive meines Vaters, Dr. Thor N.V. Karlstrom.

Die Wurzeln des Schwindels der anthropogenen Erderwärmung verlaufen tief und vielfältig. Sie lassen sich finden: Erstens in der von der Elite geförderten eugenischen Bewegung des späten 19. und 20. Jahrhunderts, einer weiteren Pseudowissenschaft. Zweitens in Positionspapieren von Denkfabriken wie dem „Report from Iron Mountain“ und dem Club of Rome, die sich dafür aussprechen, die Umweltbewegung zu kontrollieren und als Kriegsersatz einzuspannen. Drittens in der Geschichte der Eliten-Kooption, Korruption und sogar der Verwandlung ganzer akademischer Disziplinen in „Waffen“. Beispiele enthalten die Schaffung der Pseudowissenschaft der Eugenik und die Kooption der Disziplinen der Psychologie und Psychoanalyse durch Figuren wie Sigmund Freud, Sir John Rawlings Rees und Donald Ewen Cameron, des Feldes der Anthropologie, wie es von Franz Boas initiiert wurde, des Feldes der Soziologie durch die deutsche Frankfurter Schule und sogar des Feldes der modernen Musik durch die Frankfurter Schule und die „Sozialwissenschaftler“ des Tavistock Institute wie zum Beispiel Theodor Adorno. Auf diese Weise scheint die Angstkulisse der Erderwärmung zusammengebraut hochgezogen worden zu sein als ein weiteres aus einer langen Reihe von Propagandawerkzeugen, die von Sozialingenieuren am Tavistock Institute und verbundenen Stellen genutzt werden, um einer leichtgläubigen und uninformierten Öffentlichkeit „traumabasierte Bewusstseinskontrolle“ einzuflößen. Viertens in der Notwendigkeit eines Tarnmantels und Finanzierungsmechanismusses für Staaten (vor allem die USA und Großbritannien), die UN, die Nato und andere, um streng geheime Geoengineering-Experimente und -projekte voranzutreiben, deren wahre Ziele auf Wetterkriegsführung, Depopulation und Massenbewusstseinskontrolle hinauslaufen. Fünftens in der Kooption der Umweltbewegung durch die Elite (UN und verwandte Organisationen) mit der globalen Erwärmung als Herzstück, die als Abschreckungstaktik verwendet werden soll, um Nationen dazu zu zwingen, internationale (UN‑) Kontrolle aller ökonomischen und tatsächlich menschlichen Aktivität zu akzeptieren… ebenso wie eine Weltregierung, wie sie in der „Agenda 21“ der Vereinten Nationen kodifiziert wird („Agenda for the 21st Century“, auch bekannt als „nachhaltige Entwicklung“). Die „Agenda 21“ (heute „Agenda 2030“) ist die Blaupause des „faktischen Rechts“, verdeckt übernommen von fast allen Nationen, für die Machtübernahme der UN über alle menschliche Aktivität und Ressourcen und zur Errichtung einer prototypischen Weltregierung. Sechstens: Schließlich liefern die verschiedenen Pläne für Kohlendioxidzertifikatshandel einen weiteren Mechanismus, durch den die Elite (Al Gore, Maurice Strong, Dr. Rajendra Pachauri, Vorsitzender des International Panel on Climate Change (IPCC), ebenso wie Goldman Sachs, zahllose andere Konzernkonglomerate und Kartelle) Billionen an Profiten aus der Kontrolle und dem Verkauf von „Emissionsrechten“ zu schlagen beabsichtigen, die von den UN reguliert und besteuert werden, ferner verschiedenen kooperierenden Regierungen, und so weiter.

„Es wird immer klarer, dass diejenigen, die die sogenannte ‚Neue Weltordnung‘ unterstützen, oder eine Weltregierung unter den Vereinten Nationen, den globalen Umweltschutz als Basis zur Auflösung unabhängiger Nationen und internationalen Neuausrichtung von Macht übernommen haben.“ (Dixy Lee Ray, ehemalige Vorsitzende der Atomic Energy Commission, 1993 in „Environmental Overkill: Whatever Happened to Common Sense?“.)

„Die heraufziehende ‚Ökologisierung‘ unserer Zivilisation und die Notwendigkeit energischen Handelns im Interesse der gesamten globalen Gemeinschaft werden unausweichlich mehrere politische Konsequenzen haben. Die wichtigste davon wird vermutlich eine graduelle Änderung des Status der Vereinten Nationen sein. Diese werden unvermeidlich einige Aspekte einer Weltregierung annehmen müssen.“ (Michail Gorbatschow, ehemaliger Premier der Sowjetunion, State of the World Forum und mit Maurice Strong und Steven Rockefeller Koautor der „Erd-Charta“.)

„Regionalismus muss Globalismus vorausgehen. Wir sehen ein nahtloses Regierungssystem voraus, von lokalen Gemeinden, einzelnen Staaten, regionalen Unionen bis hinauf zu den Vereinten Nationen selbst.“ („UN Commission on Global Governance“)

Dieser Artikel erschien zuerst als einleitender Text der Seite „Natural Climate Change“ und wurde von Axel B.C. Krauss exklusiv für eigentümlich frei ins Deutsche übersetzt.

Die Übernahme des Berichts für Eike erfolgt mit freundlicher Genehmigung von eigentümlich frei

https://ef-magazin.de/2019/09/22/15760-hintergruende-der-globalen-erwaermung-die-urspruenge-des-schwindels-vom-menschengemachten-klimawandel