Ein Kraftwerk-Insider berichtet: “Die Einschläge häufen sich”

Damit die wichtigen Infos nicht verlorengehen, stellen wir sie im Rahmen eines „Woher kommt der Strom?“-Special der Achse-Leserschaft zur Verfügung:

Hallo Herr Stobbe,

ich arbeite in einem Kraftwerk und habe daher ein wenig Einblick in die Kraftwerkseinsatzplanung. Dies gilt natürlich nur für „mein“ Kraftwerk und kann sicherlich nicht verallgemeinert werden.

Bei uns zumindest ist es so, dass die KW-Blöcke – über Tage und Wochen im Voraus – von uns mit ihrer minimal und maximal erreichbaren Wirkleistung, sowie maximal abrufbarer Primär- und Sekundärregelreserve, wie auch Minutenreserve angeboten werden. Dieses Angebot geht an unseren Stromhändler (Dispatcher), und zwar über ein Tool, welches auch direkt an die EEX meldet. Reale (technische oder durch andere Einflüsse bedingte) Abweichungen von unserem Angebot im Bereich >10 MW müssen umgehend gemeldet werden, sonst droht ein REMIT-Verstoß.

Das Dispatch-Management unseres Händlers kennt unsere (ständig aktualisierten) Einsatz-, als auch unsere Anfahrkosten. Im Normalfall werden wir jeweils für den morgigen Tag (Day Ahead) vermarktet und sind somit in Betrieb, sofern der Strompreis dies zulässt. Taucht der Strompreis deutlich und zu lange unter unsere Einsatzkosten ab, werden die Blöcke abgestellt. Ein bisschen Spielraum gibt es, weil wir mit der Primärregelleistung (also der direkten Netzfrequenzstütze) auch noch Geld verdienen, aber wenn es sich gar nicht mehr rechnet, ist der Ofen halt aus.

Berücksichtigt werden dabei aber auch noch die Anfahrkosten, denn ein Blockstart kostet im fünf bis sechsstelligen Bereich. Ebenfalls zu beachten: Wenn wir unseren Strom für den Kraftwerkseigenbedarf nicht selbst erzeugen, müssen wir diesen auch übers Netz beziehen und zahlen da sämtliche EEG- Umlagen und sonstigen Gebühren mit. Ein kompletter Stillstand der Erzeugung kostet eben auch.

Aus dieser komplexen Gemengelage wird also die Kraftwerkseinsatzplanung destilliert.

Intraday wird die Lastkurve der in Betrieb befindlichen Blöcke immer viertelstundenscharf dem entsprechenden Marktumfeld angepasst. Ist ein Wettbewerber billiger, kauft unser Dispatcher dort die entsprechenden Strommengen und wir senken unsere Leistung ab. Sind wir noch lieferfähig (fahren also gerade im Teillastbetrieb) gilt natürlich unser bestehendes Maximalangebot und wir erhöhen die Leistung, sobald ein annehmbarer Preis geboten wird. Zurückhalten tun wir da gar nichts. Wenn wir aber tatsächlich etwas an unserer gemeldeten Verfügbarkeit ändern, also eine Lasteinschränkung melden, dann müssen wir dies schon in diesem Tool tun und auch begründen. Solche Ereignisse werden dann umgehend bei der EEX angezeigt.

Technischer Einschub: Unser Laständerungsgradient liegt übrigens bei 3% der installierten Nennleistung pro Minute. Bei einem angenommenen 1000-MW-Kraftwerksblock wären das also 30 MW/min – innerhalb der technischen Min- und Max.-Grenzen natürlich. Primärregelleistung im gleichen Bereich liegt übrigens innerhalb weniger Sekunden an. Wer in Deutschland am Regelleistungsmarkt teilnehmen möchte, muss mindestens 2% seiner installierten Nennleistung innerhalb 30 Sekunden vollständig als Regelleistung erbringen und für mindestens 5 Minuten halten können. Das zum Thema angeblich mangelnder Flexibilität konventioneller Kraftwerke.

Preis zu volatil? Dann bleiben Kraftwerke einfach außer Betrieb

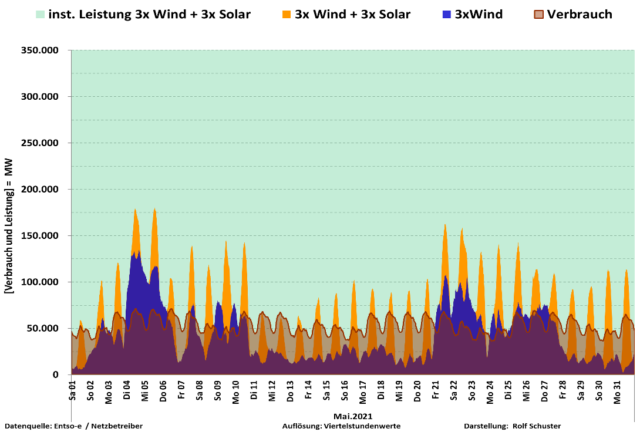

Wenn ich mir jetzt den Juni anschaue, dann exportieren wir die Solarspitzen und importieren während der Solartäler. Der Strompreis schwankt die meiste Zeit zwischen 25 und 50 Euro/MWh. Der Chart der Stromerzeugung zeigt nun, dass Laufwasser-, Biomasse- und Kernkraftwerke in einem relativ gleichbleibenden Band geradeaus fahren, die Braunkohle ebenfalls ein durchgehendes Band fährt (wobei sie auch schon in Teillastbereiche runtergeht), während vor allem Steinkohle und Gas den Ausgleich zwischen fluktuierender Stromerzeugung durch Wind- und Sonnenkraft sowie schwankendem Verbrauch (Last) abfedern.

Bei Gas und Steinkohle dürfte ein (Börsen-)Strompreis von 25 €/MWh für die allermeisten Kraftwerke nicht mehr ausreichen. Ab 40-45 € könnten viele wieder im Preis sein (das hängt stark vom Anlagenwirkungsgrad, von den momentanen Brennstoffkosten und dem Preis für CO2-Zertifikate ab). Wenn der Preis nun aber sehr volatil ist und zu oft unter den Erzeugungskosten liegt, bleiben die Kraftwerke halt einfach außer Betrieb. Je länger aber ein solcher Kraftwerksblock steht, desto kälter ist die Anlage, desto länger dauert eine Anfahrt und desto teurer wird ein Start – dies noch on top.

Meine Vermutung bezüglich der Erzeugungsunterdeckung ist daher die, dass bei stark schwankenden Preisen im Grenzbereich zwischen „lohnt“ und „lohnt nicht“ einfach viele Anlagen gleich außer Betrieb bleiben. Man sieht ja im Preischart schön, dass die solare Mittagsspitze regelmäßig die Preise einbrechen lässt. Es gibt von 06:00 bis 10:00 und am Nachmittag/Abend von 18:00 bis 22:00 Uhr noch etwas zu verdienen, der Rest des Tages sieht mau aus. Da können viele Blöcke einfach nicht durchgängig betrieben werden, und nur für wenige Stunden (oder gar mehrfach) starten sollte man solche Anlagen auch nicht. Das heißt also (für mich), dass in Deutschland seit Mai – mit dem steigendem Photovoltaik-Anteil – einfach nicht mehr genug Anlagen durchgängig und kostendeckend in Betrieb gehalten werden können, um bei Lastschwankungen ohne Importe auszukommen.

Wenn es jetzt an irgendeiner Stelle klappert, wird es eng mit den Reserven im Netz. Ich habe mich gerade durch regelleistung.net gehangelt, um herauszufinden, wieviel Regelleistung denn derzeit so vorgehalten wird. Primärregelleistung (abgekürzt PRL, das ist die direkte Frequenzstütze, ohne die das Netz sofort zusammenbrechen würde) demnach 605 MW in Deutschland. Im europäischen Verbundnetz gesamt sind es dann rd. 3000 MW, auch zur Kompensation des möglichen Ausfalls der größten Erzeugungseinheit innerhalb von 30 sec). Sekundärregelleistung (um die PRL bei Fortdauer der Störung > 5 min abzulösen) 1.876 MW für die vier deutschen Übertragungsnetzbetreiber. Die Minutenreserve liegt offenbar derzeit bei 1.952 MW (um die SRL nach 15 min abzulösen). Zahlenangaben ohne Gewähr.

„Sofort abschaltbare Lasten“

Das erscheint mir angesichts zunehmend fluktuierender Stromerzeugung in Deutschland ein bisschen wenig zu sein. Vom 25.06.19 berichteten mir die zu diesem Zeitpunkt anwesenden Kollegen jedenfalls vom telefonisch bettelnden Lastverteiler, der versuchte, jedes verfügbare MW zusammenzukratzen, und irgendwann vorher im Juni war ich selbst zugegen, als ohne erkennbaren Grund plötzlich über 3.000 MW im deutschen Netz zu fehlen schienen. Ein dies erklärender Kraftwerksausfall oder eine starke Prognoseabweichung bei Wind und Solar war zu diesem Zeitpunkt für mich nicht erkennbar.

Offenbar hält man sich seitens der Übertragungsnetzbetreiber neben der Regelreserve noch mit den „schnell…“ oder „sofort abschaltbaren Lasten“ in der Schwerindustrie über Wasser, aber die Einschläge häufen sich. Wenn man jetzt noch bedenkt, dass die Stromflüsse wegen der Netzungleichgewichte zwischen Nord und Süd zusätzlich die Leitungen und Kuppelstellen belasten (die nicht für solche Energiewende-Experimente gebaut wurden) und die bestehenden Kraftwerksanlagen auch nicht für ständiges „hoch und runter, rein und raus“ konzipiert wurden, kann es einem schon angst und bange werden. Die Instandhaltungskosten und das Ausfallrisiko steigen, während die Marge zunehmend unkalkulierbar wird.

…und das politisch und medial völlig enthemmte Überallausstiegsgetrommel ist da noch nicht einmal berücksichtigt.

Weil ich gerade folgendes Zitat auf achgut.com gelesen habe,

„Marktteilnehmer, darunter die Firma Next Kraftwerke, vermuten hinter den Engpässen im Juni das Werk von Spekulanten. Es besteht demnach der Verdacht, dass Händler Versorgungslücken im Regelenergiemarkt zunächst bewusst nicht ausgeglichen hätten, um später höhere Gewinne einzustreichen.“

… vielleicht noch ein paar Bemerkungen zu Regelenergie und Bilanzkreisabweichungen:

Die benötigten Regelleistungsmengen wurden früher wöchentlich, mittlerweile täglich öffentlich ausgeschrieben. Die Stromerzeuger können dann Angebote abgeben und erhalten ggf. den Zuschlag. Damit sollte die Versorgung immer gewährleistet sein (sofern die errechneten Mengen noch immer ausreichend sein sollten). Für Spekulation und Versorgungslücken sehe ich da eigentlich keinen Raum.

Primärregelung (PRL) und Sekundärregelung (SRL) erfolgen vollautomatisch. Das Regelungssignal kommt direkt aus dem Netz, und die Anlage fährt danach die Leistung hoch oder runter. Auch da sehe ich keinen Raum für Versorgungslücken oder Zeitverzug.

Bei der Minutenreserve (MR) ist das etwas anders, weil da ja noch Zeit zum Handeln bleibt. Bei uns kommt die MR-Anforderung über den ganz normalen Fahrplan (das Tool, in welchem der Dispatcher die zu fahrende Wirkleistung viertelstundenscharf festschreibt) und zusätzlich noch als telefonische Anforderung, damit diese außerplanmäßige Fahrplanänderung auch ja nicht untergeht.

„Das ist Glücksspiel“

Ich könnte mir also durchaus vorstellen, dass eine Minutenreserveanforderung zum gewünschten Zeitpunkt noch nicht vollständig bedient sein könnte, weil diese Anforderungen teilweise auch sehr kurzfristig reinkommen, die Anlagen aber einen technisch bedingten Laständerungsgradienten von x MW/min haben. Da die MR die SRL aber nur ablösen soll und zusätzliche Kraftwerke, die nicht an der Regelung teilnehmen, auch ihren Output erhöhen können (sofern es im Netz noch Reserven gibt), sollte das im Normalfall auch verkraftbar sein. Ein Zurückhalten von Regelleistung sehe ich da nicht, weil man ja seinen vertraglichen Verpflichtungen nachkommt. Im Rahmen der technischen Gegebenheiten natürlich.

Wenn jetzt also alle an der Netzregelung teilnehmenden Erzeuger ihren Pflichten nachkommen, sehe ich keinen Raum für Spekulationen. Würde ein Teilnehmer seine Pflichten nicht erfüllen, würde das für ihn im Nachgang mit Sicherheit teuer. Es wird ja alles überwacht, alle Stromflüsse sind online nachvollziehbar. Ich weiß es nicht genau, könnte mir aber durchaus Vertragsstrafen vorstellen, zusätzlich zu den Kosten der als Lückenfüller schnell zu beschaffenden Leistung. Ein Plus-Geschäft sollte da unmöglich sein, worauf also spekulieren?

Wie genau die realen Stromflüsse gemessen und abgerechnet werden, entzieht sich meiner Kenntnis. Aber sie werden es. Ein paar Wochen nach der tatsächlich erfolgten Erzeugung. Da werden dann auch die Kosten sichtbar, die anfallen, wenn man als Erzeuger von seinem Fahrplan abgewichen ist. Wie schon gesagt, legt der Fahrplan viertelstundenscharf fest, welche (Wirk-) Leistung eine Erzeugungseinheit zu bringen hat. Das ist der sogenannte Arbeitspunkt (AP). Bei eingeschalteter Netzregelung (PRL und/oder SRL) pendelt die Blockleistung dann natürlich um diesen Arbeitspunkt herum, je nachdem, welches Regelsignal aus dem Netz kommt. Alle anderen Abweichungen vom Arbeitspunkt sind aber Bilanzkreisabweichungen, deren Kosten im Nachgang errechnet werden.

Teilweise sind solche Bilanzkreisabweichungen technisch gar nicht zu vermeiden. Die schon angesprochenen Laständerungsgradienten verhindern, dass man innerhalb einer Sekunde (von einem Viertelstunden-Arbeitspunkt zum nächsten) die Leistung ändern kann.

[Technischer Einschub: Man fährt also von einem AP zum nächsten eine Lastrampe, wobei versucht wird, den AP-Wechselzeitpunkt auf der Mitte dieser Rampe zu erwischen. Bei einer gewünschten Laststeigerung von z.B. 100 MW (braucht 4 min bei 25 MW/min) zu 06:00 Uhr, beginne ich also schon 2 min vor 06:00 Uhr die Last anzuheben, habe also eine positive Bilanzkreisabweichung (entgegen meinem noch gültigen AP fahre ich ja zu viel Leistung ins Netz). Um 06:00 Uhr habe ich mit erst 50 aufgebauten MW den neuen AP noch nicht erreicht, habe also für die nächsten 2 min erstmal eine negative Bilanzkreisabweichung.]

Man versucht also Bilanzkreisabweichungen möglichst gering, sowie ausgeglichen positiv und negativ zu halten. Man weiß im Vorfeld nie, was einen wieviel kostet! Diese Rechnung wird erst Wochen später präsentiert. Je nach Netzsituation kann sowas richtig teuer werden, es kann aber sogar Geld dafür gezahlt werden. Man weiß es aber nicht und eine Spekulation wäre hier komplett hoffnungslos. Das ist Glücksspiel.

Es gibt jedoch eine Möglichkeit, wo ich mit künstlicher Verknappung auf steigende Preise spekulieren kann. Mir schreibt ja niemand vor, welche maximale Wirkleistung ich Day Ahead anbieten muss. Wenn ich meine den Wettergott persönlich zu kennen und darauf spekuliere, dass die Wind- und Solarprognosen für den nächsten Tag zu positiv ausfallen, kann ich mich ja mit einem Minimalangebot auf die Lauer legen und hoffen, dass die Intradaypreise höher sein werden. Nur, das können alle anderen auch. Ob ich dadurch also wirklich gewinne, ist halt Spekulation.

Ich könnte mir aber durchaus vorstellen, dass man seitens der Bundesnetzagentur bei größeren Erzeugungseinheiten auch genauer drauf schaut. Erzeugungskapazitäten im Gigawattbereich können ja durchaus Preise bewegen, wenn der Markt gerade eng ist. Ich weiß also nicht, ob einem die Spekulation da nicht hinterher vor die Füße fällt.

Freundliche Grüße / Name des Verfassers ist bekannt

Unglaubliche Augenwischerei!

Im Zusammenhang mit der Vermutung, dass der vermehrte Stromimport zu einer Senkung des CO2-Ausstoßes führen könnte, schrieb kürzlich ein Leser an Achgut.com:

[…] Ihre letztens geäußerte Vermutung, dass in D auf jeden Fall CO2-generierende Stromerzeugung bewusst heruntergefahren bzw. eingeschränkt werden soll, hätte ich bisher fast nicht glauben können.

Doch nun heute gibt es auf Welt.de eine entsprechende Aussage, wie bei uns bei der Stromerzeugung CO2 gespart wurde in den ersten Monaten d. J.

Unglaubliche Augenwischerei!

Beste Grüße und herzlichen Dank für Ihre umfangreichen Informationen.

Rüdiger Stobbe ist nach eigener Auskunft ein schlimmer Ober-Klimaleugner und veröffentlicht regelmäßig auf der Achse des Guten.

Mit freundlicher Genehmigung.