Globale Temperatur um mindestens 40% übertrieben: Klimamodelle des IPCC sind statistischer Schrott [neue Studie]

“The result has obvious consequences also for the models’ warming expectations for the 21st century because, to make these models consistent with our proposed adjusted temperature record, their projected warming should be reduced by about 40% for all emission scenarios.”

Professor Scafetta ist niemand der sagt, es gäbe keinen anthropogenen Klimawandel. Er gehört zu den Wissenschaftlern, die tatsächlich am Thema interessiert sind und nicht bemüht sind, Forschungsarbeiten zu produzieren, die beim IPCC Wohlgefallen finden. Ein Wohlgefallen, das gemeinhin mit Forschungsgeldern belohnt wird. Als ernsthafter Wissenschaftler steht Scafetta vor einem Problem. Diesem:

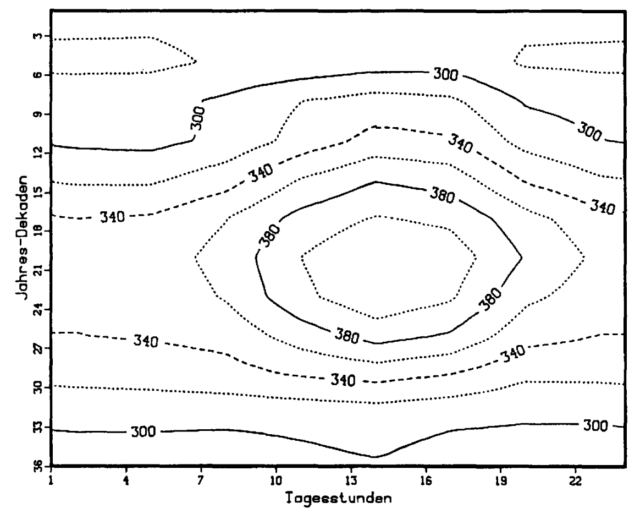

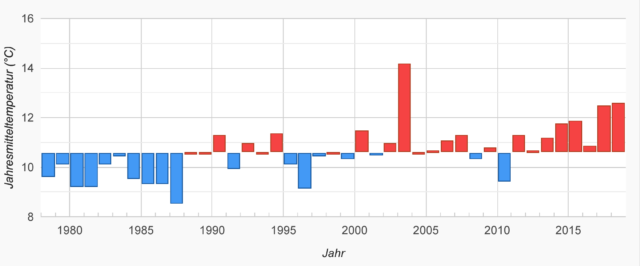

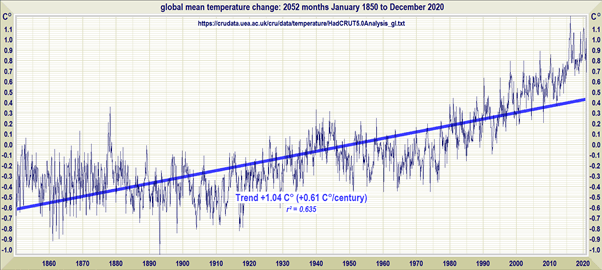

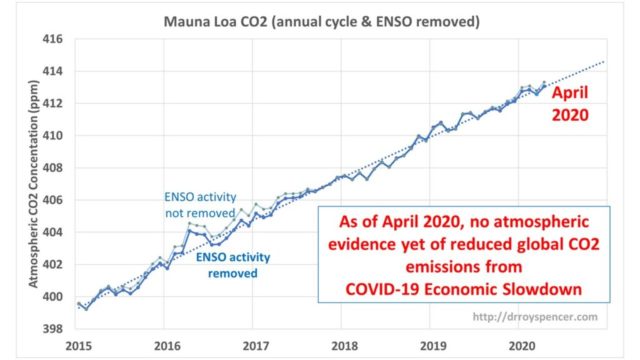

Roy Spencer

Die Abbildung, die Roy Spencer monatlich fortschreibt, zeigt die Temperatur, die in der Troposphäre gemessen wird. Die Daten werden bei der Universty of Huntsville, Alabama gesammelt und als Datensatz bereitgestellt. Scafetta hat sich diesen Datensatz besorgt und zudem hat er sich den Datensatz der Climate Research Unit der University of East Anglia (CRU-TS4.04) besorgt, der Temperatur-Messdaten für Messstationen weltweit kompiliert, die wiederum als Grundlage dienen, auf der die CMIP-Modelle des IPCC berechnet werden. Auch diese Daten, das komplette Datenset für CMIP-5 (Coupled Model Intercomparison Project Phase 5), mit dem die düsteren Prognosen des IPCC erstellt werden, hat sich Scafetta besorgt und dann angefangen, zu vergleichen.

Von den Klimamodellen, so schreibt Scafetta, werde erwartet, dass sie in der Lage seien, globale und lokale Klimavariationen, wie sie durch unterschiedliche Bewölkung, Flächennutzung, und -versiegelung, Aeorosole in der Luft und vieles mehr verursacht werden, adäquat abbilden. Das Problem: Sie tun es nicht. Sie tun es nicht einmal ansatzweise. ALLE, ausnahmslos alle Klimamodelle, die das IPCC vertreibt, überschätzen die Erwärmung, die sich seit 1940 ergeben hat (siehe Abbildung oben), und zwar um ein Vielfaches, was insofern rätselhaft ist, als die Klimamodelle angeblich so kalibriert sind, dass sie die vergangenen Temperaturen akkurat abbilden. Das tun sie offensichtlich nicht, und es kommt noch dicker: Scafetta findet, dass unterschiedliche Modelle des IPCC lokale Unterschiede quasi nach Lust und Laune produzieren, ohne Systematik, widersprüchlich, zufällig.

Normalerweise werden Modelle, die beliebige Ergebnisse auf lokaler Ebene produzieren, in den Mülleimer geworfen. Normalerweise. Aber die Modelle, die das IPCC verbreitet, um es dadurch Milliardären zu ermöglichen, dass sie ihren Reichtum steigern, sie dienen nicht dazu, die Realität akkurat abzubilden, sie dienen dazu, politische Munition zu liefern, mit der man dann nicht nur die Klimawandel-Hysterie anheizen kann, sondern mit der es auch möglich ist, diejenigen, die darauf hinweisen, dass der menschliche Einfluss auf das Klima, sofern er überhaupt in relevantem Ausmaß vorhanden ist, z.B. im Vergleich zum Einfluss der Sonne eher irrelevant ist, zu diskreditieren.

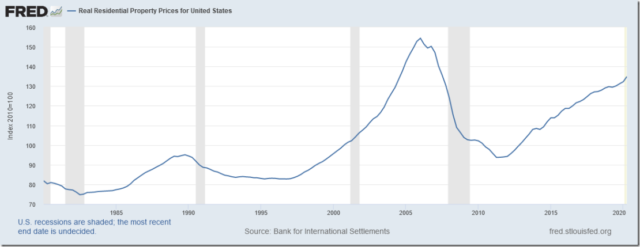

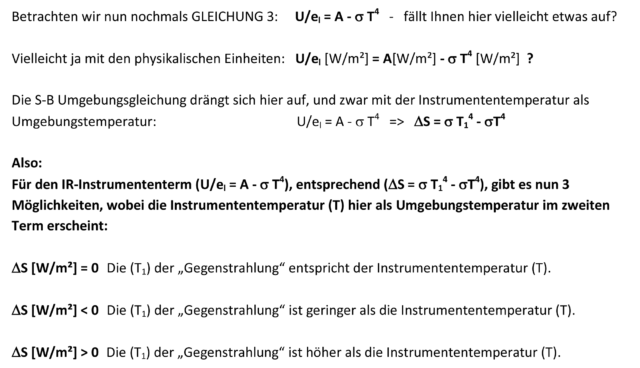

Wie schlecht die Modelle des IPCC sind, das zeigt die folgende Abbildung:

In beiden Abbildungen sind Klimamuster dargestellt. Beide Abbildungen unterscheiden sich darin, dass unterschiedliche Klimamodelle des IPCC zum Einsatz gekommen sind. Wären diese Modelle auch nur ansatzweise reliabel, dann müssten die Farbmuster in beiden Abbildungen identisch sein. Sie sind es offenkundig nicht. Sie sind willkürlich und widersprüchlich. Die Modelle sind absoluter Junk – oder, in der zurückhaltenderen Formulierung von Scafetta:

“…is shown in Fig. 6, which indicates that the various models show very different local patterns that contradict each other while they are supposed to reproduce climatic patterns on a 60-year period also locally.”

Nun stellt man solche Berechnungen nicht an, um zu zeigen, dass die Klimamodelle des IPCC Junk sind. Das ist allgemein bekannt, wird nur von Aktivisten und Politdarstellern aus den unterschiedlichsten Motiven heraus ignoriert. Nein, solche Berechnungen werden auf Basis einer Hypothese darüber angestellt, warum die Modelle des IPCC so daneben sind, wobei die Hypothese sich nicht auf die politische Motivation bezieht, die ist nicht fraglich, denn wenn jemand Hysterie verbreitet und gleichzeitig das Heilmittel gegen die Hysterie feilbietet, dann können nur Motive der eigenen Bereicherung oder Boshaftigkeit, der Wunsch, andere zu schädigen, dahinter stehen, nein, die Hypothese hat die Fehler, die systematischen Fehler zum Gegenstand, die – absichtlich oder unabsichtlich – in Klimamodelle integriert sind und dazu führen, dass die Erwärmung so hoffnunglso überschätzt wird.

Nun stellt man solche Berechnungen nicht an, um zu zeigen, dass die Klimamodelle des IPCC Junk sind. Das ist allgemein bekannt, wird nur von Aktivisten und Politdarstellern aus den unterschiedlichsten Motiven heraus ignoriert. Nein, solche Berechnungen werden auf Basis einer Hypothese darüber angestellt, warum die Modelle des IPCC so daneben sind, wobei die Hypothese sich nicht auf die politische Motivation bezieht, die ist nicht fraglich, denn wenn jemand Hysterie verbreitet und gleichzeitig das Heilmittel gegen die Hysterie feilbietet, dann können nur Motive der eigenen Bereicherung oder Boshaftigkeit, der Wunsch, andere zu schädigen, dahinter stehen, nein, die Hypothese hat die Fehler, die systematischen Fehler zum Gegenstand, die – absichtlich oder unabsichtlich – in Klimamodelle integriert sind und dazu führen, dass die Erwärmung so hoffnunglso überschätzt wird.

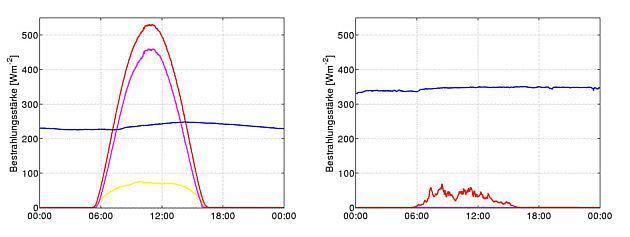

Die Hypothese, die Scafetta gebildet hat, sieht Urban Heat Islands im Mittelpunkt. Es ist schön eine solche Hypothese zu lesen, denn rund 60 Jahre nachdem Garrett Hardin mit seinem Artikel, “The Tragedy of the Commons” darauf hingewiesen hat, dass die meisten Probleme, vor denen die Menschheit steht, eine Folge von ÜBERBEVÖLKERUNG sind, 60 Jahre später setzt sich wieder das Bewusstsein durch, dass die Menge, in der Menschen den Planeten bevölkern, vielleicht das eigentliche Problem sein könnte. Urban Heat Islands (UHIs) entstehen durch Urbanisierung und mit UHIs wird im Wesentlichen umschrieben, dass nächtliche Winde die Luft der Städte, die sich tagsüber aufheizen, ins Umland bringt und dafür sorgt, dass auch das Umland aufgeheizt wird. Die globale Temperaturzunahme, so die Hypothese, ist zumindest in Teilen auf solche UHIs zurückzuführen.

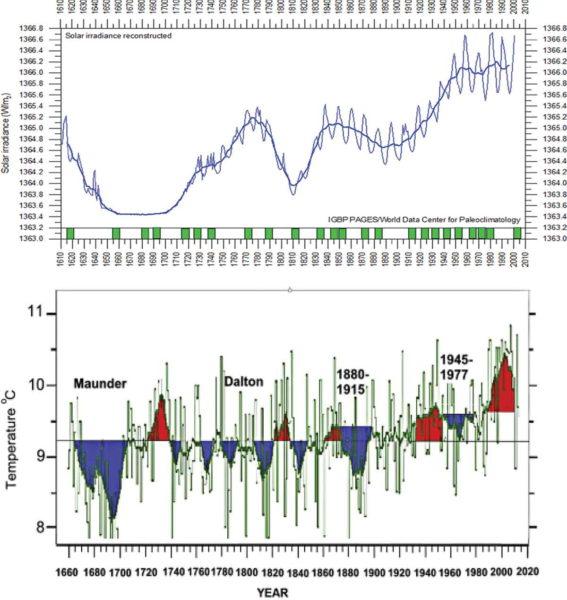

Messbar wird dieses Phänomen über die Minimaltemperaturen, denn im Gegensatz zu dem, was MS-Medien so gerne verbreiten, sind es nicht die Maximaltemperaturen, die in den letzten Jahren gestiegen sind, sondern die Minimaltemperaturen. Aus beiden, den Maximal- und den Minimaltemperaturen für die 2,5 Kilometer mal 2,5 Kilometer großen Flächen, die die Grundeinheit vieler Klimamodelle bilden, berechnet Scafetta den Diurnal Temperature Range (DTR), also die tägliche Temperaturspannweite für die jeweiligen Messeinheiten, die gleichmäßig über die Erde verteilt sind und stellt auf dieser Grundlage zunächst fest, dass die Klimamodelle des IPCC nicht in der Lage sind die Veränderung in den DTR, die sich in den 60 Jahren bis 2014 ergeben haben, abzubilden.

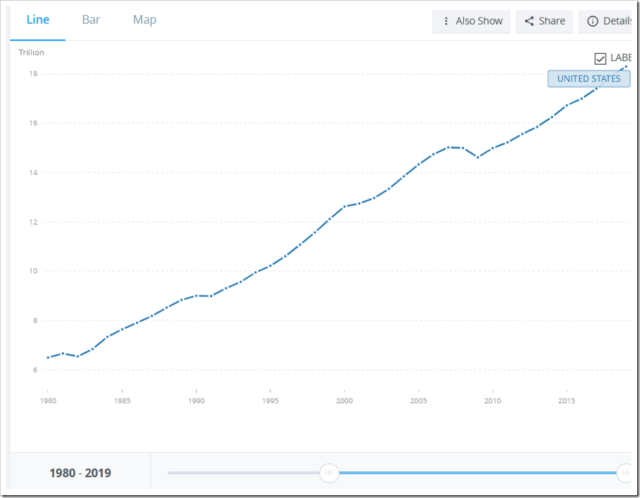

DTR sind ein direktes Ergebnis der Urbanisierung, der sich daraus ergebenden Urban Heat Islands, und die Erwärmung der letzten Jahrzehnte schlägt sich darin nieder, dass die tägilche Temperaturspannweite um Städte herum geringer geworden ist. Das ist zunächst einmal eine Hypothese, aber eine, die Scafetta schnell bestätigen kann. Die daraus folgende Beobachtung, dass Klimamodelle des IPCC diese Veränderung nicht erfassen, dass sie willkürliche und in jedem Fall in Richtung einer erheblichen Überschätzung der Erwärmung gehende Ergebnisse produzieren, führt zum Masterstroke: Wenn es in Klimamodellen einen “Erwärmungs-Bias” gibt, dann sollten diese Modelle die globale Erwärmung in Gegenden, in denen es keine Urban Heat Islands gibt, die die Überschätzung reduzieren, erheblich überschätzen, dann sollten die Modelle deutlich von den Messdaten abweichen. Scafetta prüft diese Hypothese für Grönland und siehe da, das Ergebnis ist dramatisch:

Die rote Linie bildet die Beobachtungsdaten ab, die blaue Linie gibt die Modell-Simulation wieder, die auf Basis dieser Beobachtungsdaten errechnet wurde. Die Abweichung ist erheblich.

“Thus, the models (which are calibrated to reproduce, on average, the observed global warming trend since 1900) hindcast almost twice the warming than what has been recorded in Greenland since 1930-1950.

In den Modellen des IPCC wird die tatsächliche Erwärmung eben einmal verdoppelt. Wer daran wohl ein Interesse haben könnte?

Aber damit ist Scafetta noch nicht am Ende. Nachdem er gezeigt hat, dass die Erwärmung, die in den Klimamodellen des IPCC berechnet wird, die tatsächliche Erwärmung um ein Vielfaches übertreibt, selbst dann, wenn tatsächliche Beobachtungsdaten den Ausgangspunkt der Modellierung bilden, nachdem er gezeigt hat, dass in der Erwärmung, die die Klimamodelle abbilden, nicht klimatische Erwärmung enthalten ist, die sich als Ergebnis von Urbanisierung einstellt, geht Scafetta daran, den entsprechenden Fehler, der in den Klimamodellen des IPCC enthalten ist, zu quantifizieren.

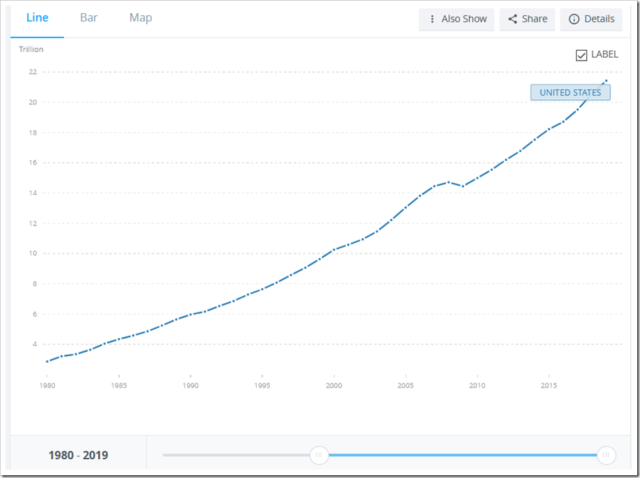

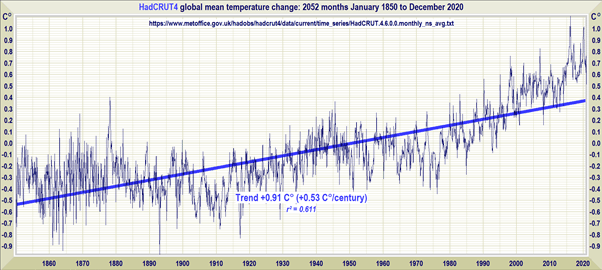

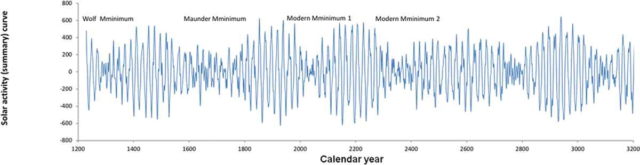

Das Ergebnis sieht so aus:

Die grünen Linien, es sind 106 an der Zahl, geben die Entwicklung der globalen Temperatur an, wenn die unterschiedlichen Modelle des IPCC genutzt werden, um die entsprechende Modellierung vorzunehmen. Die orange Linie stellt den Mittelwert der 106 Modelle dar. Die rote Linie zeigt die tatsächlich in der Troposphäre gemessene Temperatur, und die schwarze Linie zeigt die Rekonstruktion der Temperatur, die Scafatta auf Grundlage der Daten aus East Anglia vorgenommen hat. Wie von Geisterhand geführt, kommen alle Modelle des IPCC im Verlauf der Zeit zu Temperaturen, die weit über den tatsächlichen Temperaturen liegen, während die Berechnung von Scafetta die tatsächliche Temperatur, die über den Datensatz der University of Huntsville zugänglich ist, sehr gut abbildet.

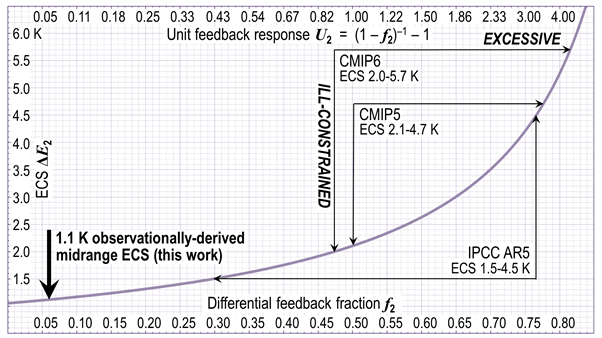

Daraus ergibt sich nur ein Schluss: Die von Scafetta formulierte Hypothese, dass in den Modellen des IPCC nicht nur die globale Temperatur als viel zu hoch berechnet wird, sondern die Ergebnisse auch deshalb falsch sind, weil der Einfluss, den Urbanisierung und daraus entstehende Urban Heat Islands auf die globale Temperatur haben, nicht berücksichtigt wird, ist bestätigt. Fehlt noch die Angabe, um wie viel sich die Panik-Zahl der Erwärmung die das IPCC so gerne verbreitet, reduziert, wenn diese Fehler aus dem Modell beseitigt werden:

“In the light of the above findings, and under the assumption that the SST [Sea Surface Temperature] warming since 1940–1960 is accurate, the models can be scaled on the SST record and used to estimate an expected land warming. Corrected in such a way, we determined that 25–45% of the recorded 0.97±0.05 °C land warming from 1940 to 1960 to 2000–2020 is likely due to urbanization and other unidentifed non-climatic factors biasing the available climatic records.”

Mit anderen Worten: Unter der Annahme, dass die Temperaturangaben, die in den Modellen des IPCC für die Meeresoberfläche enthalten sind, korrekt sind, eine Annahme, die dem IPCC sehr entgegen kommt, beläuft sich der Fehler in den Modellen des IPCC auf mindestens 25%-45% im Verlauf der letzten 60 Jahre. Im Durchschnitt, so schreibt Scafetta einige Zeilen weiter, überschätzen die Modelle des IPCC die tatsächliche Erwärmung des Planeten um 40%. Und diese Schätzung von Scafetta basiert auf der Annahme, dass die Modellierung der Temperatur der Meeresoberfläche richtig ist, eine Annahme, die man nicht machen muss. Scafettas Schätzung von 40% ist somit eine sehr konservative Schätzung. Die tatsächliche Übertreibung liegt vermutlich deutlich darüber.

In jedem Fall wird uns nicht nur im Hinblick auf SARS-CoV-2 absoluter Unfug erzählt, wird nicht nur im Hinblick auf SARS-CoV-2 mit falschen Zahlen hantiert, auch im Hinblick auf die angebliche Klimakrise basiert die gesamte Geschichte auf mehr oder weniger frei erfundenen Zahlen. Dass man die Erfindung dann als Resultat einer Modellierung verkauft, ist nur sympbolische Kosmetik.

Scafetta, Nicola (2021). Detection of non-Climatic Biases in Land Surface Temperature Records by Comparing Climatic Data and their Model Simulations. Climate Dynamics.

Der Beitrag erschien zuerst bei ScienceFiles hier