Kleine Energierückschau 2016, oder: Was ist Zappelstrom

Erneuerbare Energien sind die wichtigste Stromquelle in Deutschland …

… und ihr Ausbau eine zentrale Säule der Energiewende. So meldet es unser zuständiges Ministerium.

Bundesministerium für Wirtschaft und Energie: Erneuerbare Energien

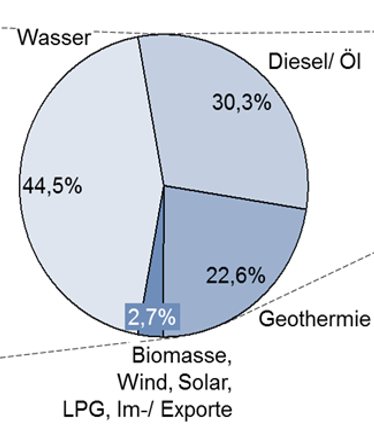

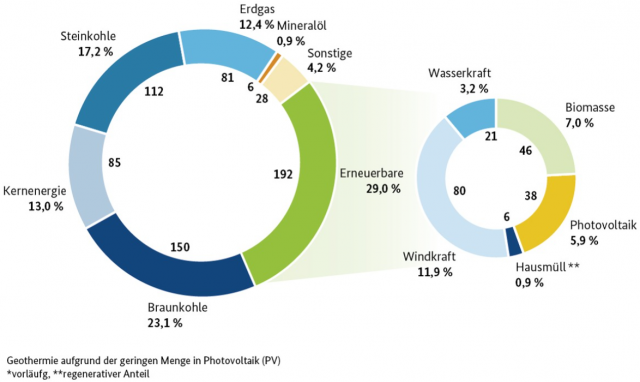

Wie das Ministerium darauf kommt, nachdem die „Erneuerbaren Energien“ gerade einmal 29 % Anteil am Strom liefern, davon die alleine weiter ausbaufähigen, Wind und Solar gerade einmal 15, 8 % (Wind 11,9 %, Solar 5,9 %) bleibt dessen Geheimnis. Aber damit ist auch nicht die Wirklichkeit, sondern der Wunsch gemeint.

Wie es die ersten zwei Bilder zeigen, reicht jedoch schon dieser Ausbau, um unsere Natur großflächig und rücksichtslos nicht nur verschandeln, sondern regelrecht kaputt machen. Für „Klimaretter“ ist es allerdings der ersehnte Umbau Deutschlands zur Energie-Erntelandschaft.

Und leider liefern das EEG nur „Zappelstrom“

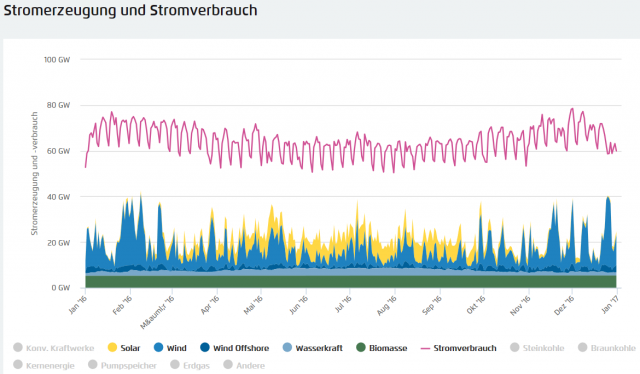

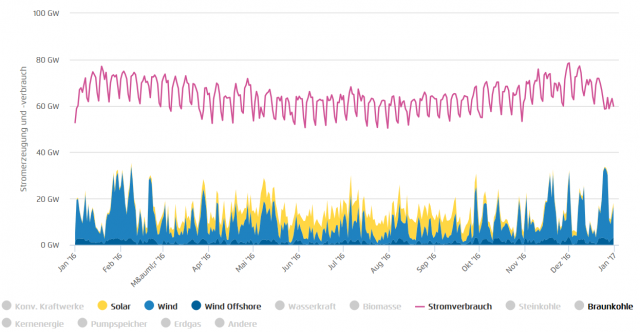

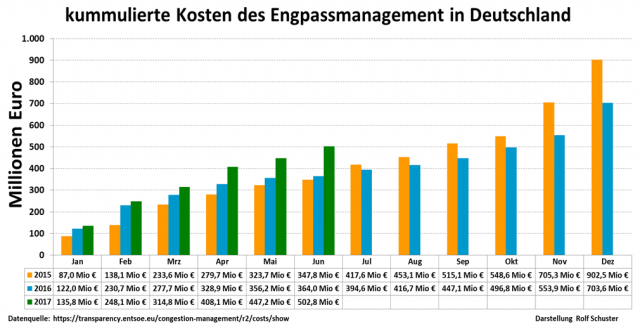

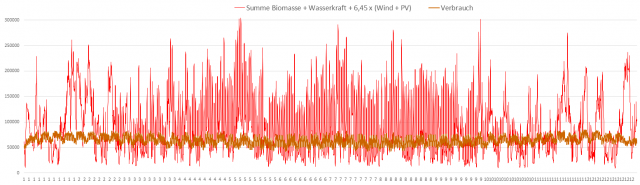

Der Agora-Viewer bietet bezüglich der Elektroenergie sicher die schönsten Übersichtsgrafiken. Daraus der Verlauf des letzten Jahres. Herrlich sieht man den Zappelstrom der Erneuerbaren und die gewaltige Versorgungslücke, welche die konventionellen Kraftwerke stemmen müssen. Bild 3 zeigt die „Erneuerbaren“ mit dem Sockel, welchen Wasserkraft und Biomasse bilden. Wichtig ist jedoch Bild 4, denn es stellt den 15,8 %-Anteil von Wind gesamt und Solar ohne Biogas und Wasserkraft dar. Nachdem Biogas und Wasserkraft in Deutschland nicht weiter ausbaufähig sind, müssen diese beiden Quellen jeden weiteren EEG-Ausbau alleine „stemmen“.

Die große, stark schwankende Differenz zwischen benötigtem Strom und wirklich bereitgestelltem, und was das für Konsequenzen hat, ist in [1] [3] erklärt, vor allem auch in der Artikelreihe: EIKE 24.01.2016: [4] Die neuen Energien erklärt für Dummies Teil 3: Zeitreise ins Jahr 2050 des EEG Eine Energiewende ist nicht planbar

und in diesem Artikel deshalb nicht das (Haupt-)Thema.

„Zappelstrom“, erklärt für Dummies

Die wirklich angebotene Leistung im Verhältnis zur maximalen Leistung

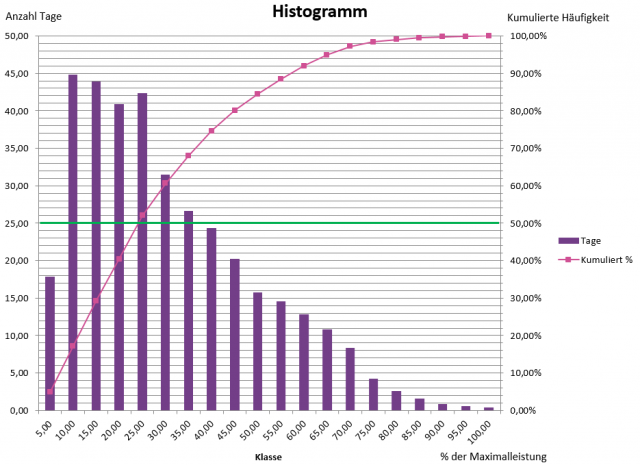

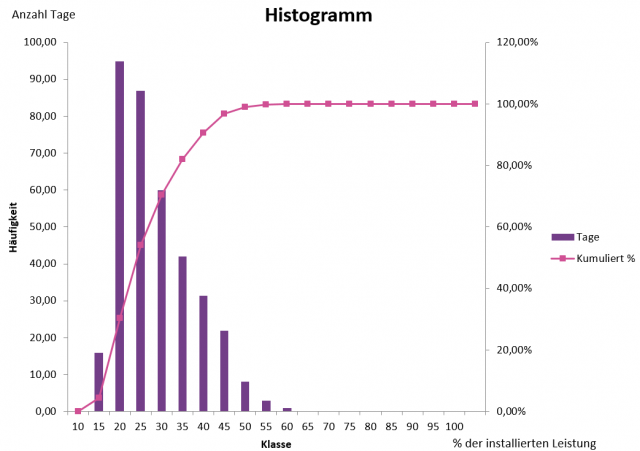

Das folgende Bild 5 zeigt das Histogramm der Leistung von Solar und Windkraft gesamt im Jahr 2016. Bezug ist die maximale, im Jahresverlauf wirklich angebotene Leistung, also nicht die weit höhere, installierte.

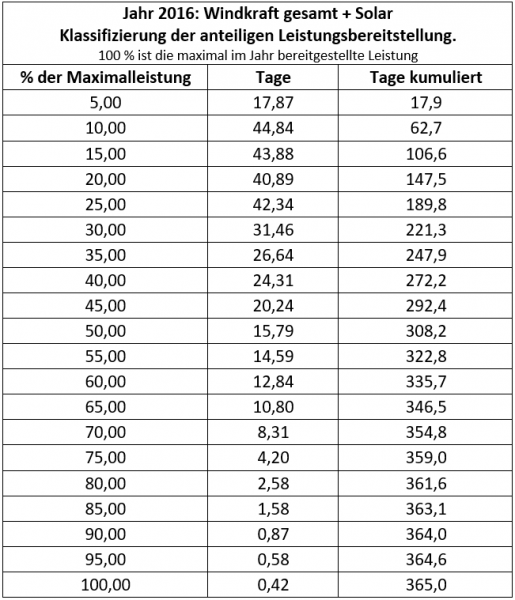

Wem Histogramme nicht so geläufig sind, anbei die Tabellierung dazu:

Was sagen diese Daten von Wind und Solar – immer bezogen auf das Gesamtjahr 2016 mit 365 Normtagen:

-Über 18 Tage betrug die verfügbare Leistung im Maximum 5 %

-Über 63 Tage (also 2 Monate) betrug die verfügbare Leistung im Maximum 10 %

-Über 221 Tage (also 7,4 Monate) betrug die verfügbare Leistung im Maximum 30 %

-Über 308 Tage (also 9 Monate) betrug die verfügbare Leistung im Maximum 50 %

Die wirklich angebotene Leistung im Verhältnis zur installierten Leistung

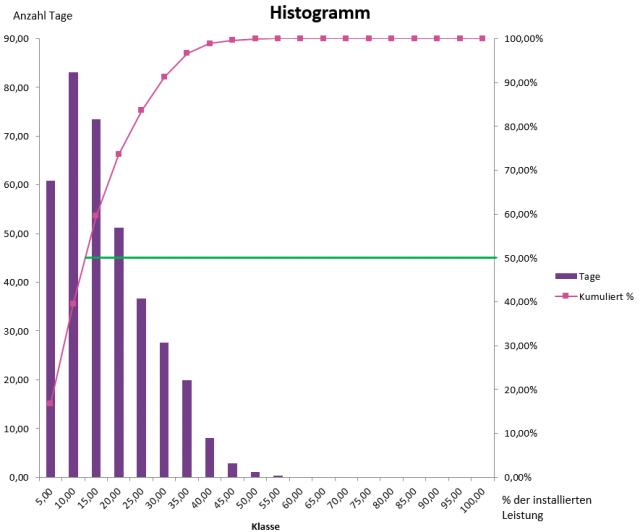

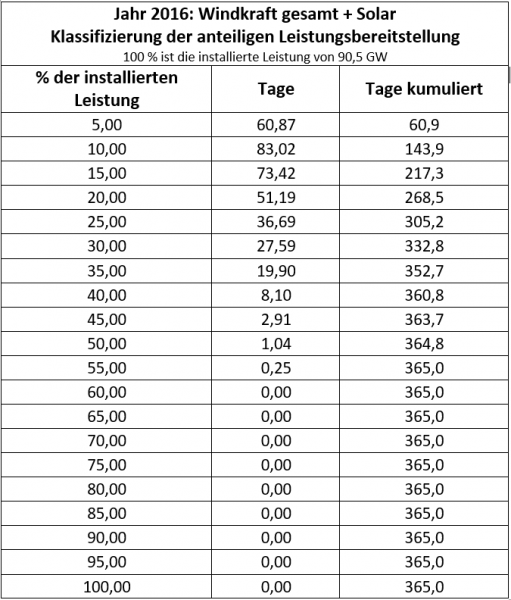

Wer sich etwas mit Netzausbau auskennt weiss, dass die Übertragungssysteme nicht nach der zufällig in einem Jahr erreichten, maximalen Leistung, sondern nach der laut den technischen Angaben spezifizierten, installierten Leistung auszulegen sind. Würde man dies nicht beachten, wäre das Ergebnis das Gleiche wie bei einem Moped, dem der Bastelfilius einen Motorradmotor einbaut, um damit auf der Autobahn solche zu erschrecken, um sich alsbald (sofern er noch Glück hat) im Krankenhaus wiederzufinden, da das Fahrgestell und Reifen für diese Geschwindigkeit nicht gebaut waren.

Unter diesem Gesichtspunkt wird die schon vorher sehr ungünstige Verteilung der wirklich verfügbaren Energie (Bild 6) zum wahren Desaster, wie es Bild 7 und die zugehörige Tabelle zeigen.

Was sagen diese Daten von Wind und Solar – immer bezogen auf das Gesamtjahr 2016 mit 365 Normtagen:

-Über das gesamte Jahr wurden als Maximum ca. 6 Stunden lang 55 % der installierten Leistung erreicht,

-während 9 Monaten betrug die angebotene Leistung nicht über 20 % der installierten.

Schlimmer kann man sich eine Energielieferung nicht vorstellen.

Damit nicht jemand meint, das wäre zu schlecht dargestellt, weil die wichtigen EEG-Träger Biomasse und Wasserkraft fehlen, die Grafik für das EEG gesamt noch anbei. Da die Letztgenannten so etwas wie eine Grundlast bieten, verschiebt sich die Verteilung nur leicht nach rechts.

Die Bewertung durch politische Führungskräfte, welche sich zutrauen, über Deutschlands Energiesystem zu entschieden

Wenn man die Agora-Bilder und die Verteilungen dazu ansieht, wird erst richtig klar, welches (Un-)Wissen hinter Aussagen politischer Führungskräfte steckt, die sich damit aber zutrauen, über Deutschlands Energiesystem zu diskutieren und zu bestimmen:

EIKE 15.08.2017: Cem Özdemir versucht sich in Energie

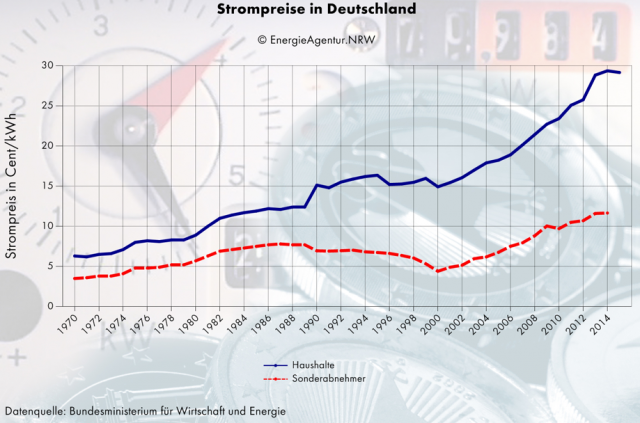

Sprecher: Kritiker sagen: Dann geht in Deutschland entweder das Licht aus, oder der Strom wird viel teurer. Sehen Sie das auch so?

C. Özdemir: Ach wissen Sie, wir kennen die Argumente. Die Argumente sind ja nicht ganz neu. Im Spitzenlastbereich, also nicht im Normallastbereich. Dann wenn der Energieverbrauch am Höchsten in Deutschland ist, ungefähr mittags zwischen 11 und 12, verbrauchen wir ungefähr 80 Gigabyte. Wir produzieren aber ungefähr 140 Gigabyte. Das heißt, das anderthalb-Fache dessen haben wir immer noch übrig, was wir brauchen. Selbst wenn wir die sieben ältesten Meiler abschalten würden, hätten wir immer noch mehr Strom als wir selbst im Spitzenlastbereich gebrauchen.

Für Personen, welche ebenfalls mit der Energie etwas auf Kriegsfuß stehen, es aber zugeben, anbei nochmals die Daten zur Aussage von Herrn Özdemir:

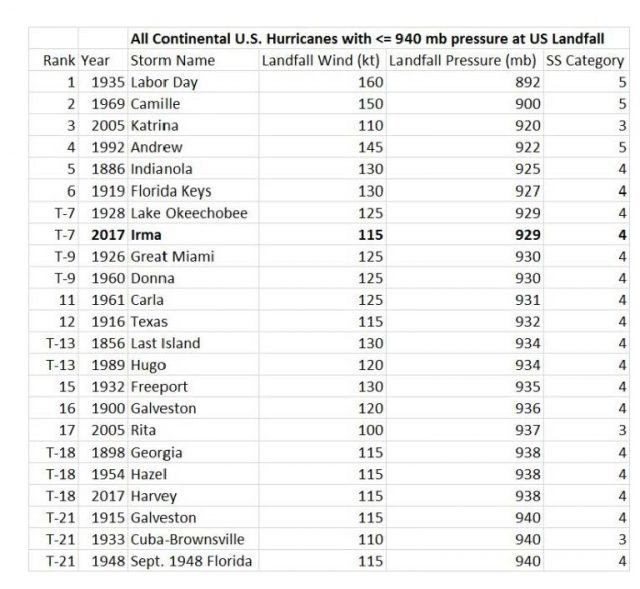

Anstelle der genannten, „mittags regelmäßigen“ 140 Gigabyte (gemeint waren von Herrn Özdemir natürlich Gigawatt), lieferten alle EEG-Lieferanten zusammen als absolutes Maximum am 08.02.2016:

-Einmal 54,2 GW (anstelle der angeblich regelmäßigen 140 GW)

-Der Anteil Wind und Solar betrug daran: 46,24 GW, also von den seitens Herrn Özdemir angegebenen nur 1/3tel (immer daran denken, alleine diese sind weiter ausbaufähig).

-Während des ganzen Jahres gab es nur für ca. 6 Stunden 67 % vom benötigten Bedarf, anstelle Herrn Özdemirs gemeldeter „sicherer“ Überlieferung von + 50 % (gesamt 150 %) zu jeder Mittagszeit,

-den Rest des Jahres, wie die Tabellen zeigen, dann über viele Monate nur zwischen 15 … 30 % davon.

Nicht nur Laien in der Politik fühlen sich bemüßigt, Energiekonzepte zu erdichten. Parteien ernennen auch gerne Mitglieder zu Fachpersonen, ohne deren Kompetenz abzufragen, geschweige zu prüfen. Als Beispiel die Sprecherin der Bundestagsfraktion Bündnis 90/Grüne für Klimapolitik und Mitglied im Ausschusses für Wirtschaft und Energie, welcher zuständig ist für: … alle Aspekte der Energiewende und die damit verbundenen Fragen des Klimaschutzes sowie für das Thema Energieeinsparung … Schwerpunkte der Energieberatungen werden die Neuregelung des Erneuerbare-Energien-Gesetzes (EEG), der Netzausbau und die Energieeffizienz sein.

GRÜNE Annalena Baerbock (Studium: Politikwissenschaft und Öffentliches Recht):

[1] … „Am Kohleausstieg führt kein Weg vorbei. Nicht nur aufgrund unserer klimapolitischen Verpflichtungen, sondern auch wegen des bevorstehenden Desasters am Strommarkt, wenn wir so weitermachen wie bisher. Es mangelt weder an erneuerbaren Energien noch an der Entwicklung von Speichern und Netzen. Es mangelt an der Bereitschaft, aus der Kohle auszusteigen. Deshalb kommen wir bei der Energiewende nicht richtig voran.“

Der Vorteil ist, dass man die vollkommene Unkenntnis dieser „Fachdame“ alleine anhand der Aussagen sofort bemerkt.

Die (versprochenen) Lösungen

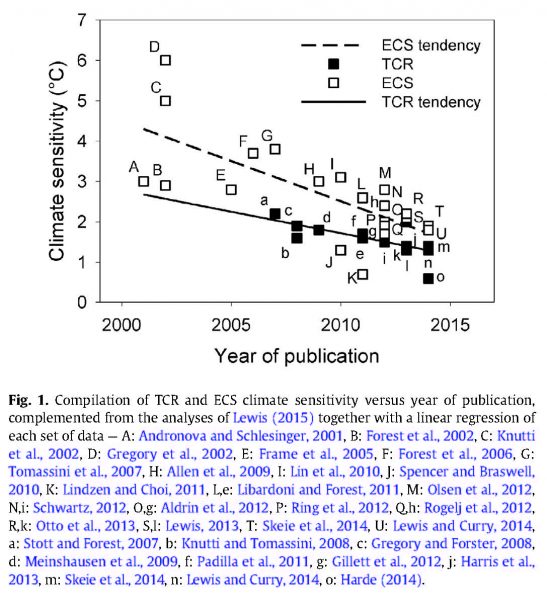

Es gibt jedoch auch die „Wissenschaftlichen“, welche aus verschiedensten Gründen das gleiche tun, es aber so „belegen“, dass es nicht jeder bemerkt.

DIE BUNDESREGIERUNG, 13. Januar 2015: Erneuerbare Energien und stabile Netze

2050 werden Windparks, Solar- und Biogasanlagen mindestens 80 Prozent unseres Stroms erzeugen. Das führt zu Problemen beim Stromnetz. Es muss stabil sein, auch wenn der Strom weite Strecken zurücklegen muss. Im Rahmen der neuen Hightech-Strategie, arbeitet die Forschung an Lösungen – Zukunftsaufgabe „Nachhaltiges Wirtschaften und Energie“.

… Dass erneuerbare Energien den deutschen Strombedarf komplett decken können, wurde bereits 2007 mit dem Vorgängerprojekt Kombikraftwerk 1 nachgewiesen …In dem anschließenden Forschungsprojekt Kombikraftwerk 2 ging es vor allem um die Netzstabilität und die Sicherheit unserer Energieversorgung bei einer rein regenerativen Stromerzeugung

Mit unseren Empfehlungen ist alles erreichbar, wenn die Kosten, die Nachteile und dass es die Lösungen noch gar nicht gibt, nicht berücksichtigt werden muss.

DIE BUNDESREGIERUNG, 13. Januar 2015: Erneuerbare Energien und stabile Netze

… Die Forscher stellten fest: Die heutige Versorgungsqualität ist auch mit einer intelligenten Kombination aus erneuerbaren Energien, Speichern und Backupkraftwerken mit erneuerbarem Gas erreichbar.

… Die Regulierung des Stromverbrauchs, also ein realistisches Lastmanagementpotenzial, wurde im Modell berücksichtigt. Dies reiche aber allein nicht aus, um Erzeugung und Verbrauch in Einklang zu bringen, so das Ergebnis im Projekt. Der Bau von Energiespeichern ist für die 100 Prozent erneuerbare Stromversorgung notwendig. Die Forscher empfehlen deshalb, neuartige Speichertechnologien wie Power-to-Gas weiter zu erforschen und zu entwickeln.

Zu dieser Information fragt man sich, ob die „Fachpersonen“ in unserer Bundesregierung die Untertanen bewusst desinformieren. Denn dass sie so dumm sind, die Problematik der zitierten Analysen und ihrer „Information“ dazu nicht zu durchschauen, kann man sich (bei den Gehältern) nicht vorstellen.

Das „moderne Lastmanagement“ bedeutet nichts anderes, als Verbraucher in Zukunft konsequent wegzuschalten wenn der Strom fehlt:

EIKE 02.11.2016: Verwundert, weil ihr Stadtteil dank EEG zeitweise keinen Strom bekommt? Auf unserer Homepage wurde doch darüber informiert!

Man kennt dieses Verfahren von Ländern, welche früher noch als unterentwickelt bezeichnet werden durften. Nur wurde es früher nicht als „intelligent“, sondern als notgedrungen und nachteilig bezeichnet. Seit dem neuen GRÜNSPRECH hat sich das gedreht und diese Länder sind uns in der Energieversorgungs-Entwicklung voraus. So weit, dass diese bestimmt noch vor uns den großen EEG-Sprung nach Vorne schaffen.

Kofi Annan, Vorwort im APP Bericht 2015: [2] … Africa has enormous potential for cleaner energy – natural gas and hydro, solar, wind and geothermal power – and should seek ways to move past the damaging energy systems that have brought the world to the brink of catastrophe.

Von google grob übersetzt: … Afrika hat ein enormes Potenzial für sauberere Energie – Erdgas und Wasserkraft, Solar-, Wind- und Geothermie – und sollte nach Wegen suchen, an den schädlichen Energiesystemen vorbei zu kommen, die die Welt an den Rand der Katastrophe gebracht haben …

Die Speicher – wie es in den Studien richtig erkannt wurde – gibt es nicht. Es bedeutet natürlich nicht, dass es sie nicht irgendwann geben kann. Dann muss man sich aber auch klar sein, was zum Beispiel Powert to Gas mit Rückverstromung bei 70 … 60 % Umwandlungsverlusten kostet:

EIKE 18.06.2015: Elektro-Energiespeicherung, Notwendigkeit, Status und Kosten. Teil 3 (Abschluss)

an dem im Großmaßstab dann kein Weg vorbei führt, da es sich trotzdem immer noch um das billigste, realisierbare, Groß-Speicherverfahren handelt.

Aber solche „Speichellecker“ liebt unsere Politikkaste. Und die „…Lecker“ leben gut davon. Denn die Fördermittel sprudeln zuhauf, seitdem es im EEG immer mehr (selbst erzeugte) Probleme im Großmaßstab zu lösen gibt.

100 % EEG-Stromversorgung

Im Artikel:

EIKE 11. September 2017: [1] Die GRÜNEN: Es mangelt weder an erneuerbaren Energien noch an der Entwicklung von Speichern und Netzen

wurden Details dazu ausgeführt. Daraus (Bild 10) die hochgerechneten Ganglinien bei 100 % EEG-Versorgung. Die Grafik zeigt, was es bedeutet, wenn in einer Studie steht, dass alles (von der Politik Gewünschte) machbar sei, jedoch empfohlen wird, ein paar kleine Probleme noch zu lösen, wofür bitte Forschungsgelder bereitzustellen sind:

DIE BUNDESREGIERUNG, 13. Januar 2015: Erneuerbare Energien und stabile Netze… … Die Forscher stellten fest: Die heutige Versorgungsqualität ist auch mit einer intelligenten Kombination aus erneuerbaren Energien, Speichern und Backupkraftwerken mit erneuerbarem Gas erreichbar … Dies reiche aber allein nicht aus, um Erzeugung und Verbrauch in Einklang zu bringen …Die Forscher empfehlen deshalb … weiter zu erforschen und zu entwickeln

Es bedeutet nichts anderes, als: Dann fliegt uns das gesamte Energiesystem um die Ohren. Schuld sind wir aber nicht, denn bereits in unseren Simulationen konnten wir das erkennen und haben deshalb ja Empfehlungen ausgesprochen.

Wenn der Bund so dilettantisch agiert, könnte eine Partei in Bayern vielleicht besser sein?

Leser könnten den Eindruck gewinnen, der Autor würde vielleicht (beim Klima und EEG) „nur“ die GRÜNEN nicht leiden. Das stimmt so nicht. Die GRÜNEN bieten lediglich die konstantesten, extremsten und oft auch ulkigsten Beispiele (welche nur noch Frau Hendricks manchmal zu toppen schafft).

Auch die anderen Parteien sind davor jedoch nicht gefeit. Nehmen wir beispielhaft die CSU. Was vor über zwei Jahren darüber geschrieben wurde,:

[5] EIKE 02.07.2015: Der Wind bläst stetig– die Sonne steht still – wenn mein starker Arm es will oder warum gehen in Bayern die Lichter (noch) nicht aus

… Unser Weg führt geradewegs in den Abgrund – etwas mulmig ist uns dabei schon – aber über den Weg wird nicht diskutiert …

gilt heute immer noch.

[7] “Wir denken Klimapolitik global, regional und lokal”

… Nach der Ankündigung des amerikanischen Präsidenten aus dem Pariser Klimaschutzabkommen auszutreten, ist für die Bayerische Umweltministerin Ulrike Scharf klar, dass Bayern zu seinem Wort stehe und Klimapolitik global, regional und vor allen Dingen auch lokal gedacht werden muss. “Wir bekommen mit den Energieagenturen ein wirklich gewichtiges Mitglied zu unserer Klima-Allianz-Familie hinzu und unsere Stimme erhält damit eine neue Tatkraft”, begrüßte die Ministerin den Landesverband der regionalen Energieagenturen im Bund der Klimaallianz Bayern…

Als Fachreferenten waren keine geringeren als Martin Bentele (Verband proHolz Bayern) und Prof. Dr. Harald Lesch (LMU München) eingeladen. Beide zeigten eindrucksvoll die Umwelt- und Klimaentwicklungen der letzten Jahrzehnte auf und verwiesen auf die Notwendigkeit einer raschen Umsetzung der Energiewende mit einer enormen Reduzierung der Treibhausgasemissionen.

Quellen

[1] EIKE 11. September 2017: Die GRÜNEN: Es mangelt weder an erneuerbaren Energien noch an der Entwicklung von Speichern und Netzen

[2] KLIMARETTER.INFO, 05. Juni 2015: Bericht fordert mehr Strom für Afrika

[3] EIKE 03.09.2017: Fake News von dpa: Offshore Windkraft produziert so viel Leistung wie vier sehr große, konventionelle Kernkraftwerke

[4] EIKE 24.01.2016: Die neuen Energien erklärt für Dummies Teil 3: Zeitreise ins Jahr 2050 des EEG Eine Energiewende ist nicht planbar

[5] EIKE 02.07.2015: Der Wind bläst stetig– die Sonne steht still – wenn mein starker Arm es will oder warum gehen in Bayern die Lichter (noch) nicht aus

[6] Prof. Dr.-Ing. Michael Sterner et al. 2013: Ringvorlesung Kraftakt Energiewende II

[7] Regensburger Energieagentur, 26 / 06 / 2017: Bayerische Energieagenturen treten der Bayerischen Klima-Allianz bei