Zur Fragwürdigkeit der Gründe für den angeblichen anthropogenen CO2-Anstieg in der Atmosphäre und seinen möglichen Einfluss auf das Klima

Die Temperaturerhöhungen nach 1900 der Atmosphäre wie der Meere – verursacht durch eine erhöhte Intensität der Sonneneinstrahlung – und die damit verknüpften CO2-Anstiege in der Atmosphäre überlagern den anthropogenen Einfluss deutlich.

Schon alleine aus diesem Grunde – von den fundamentalen Fehlern der Klimamodelle abgesehen – ist der Einfluss der Verbrennung der fossilen Energieträger auf das Klima vernachlässigbar und damit alle Maßnahmen zur Absenkung des anthropogenen CO2-Ausstoßes obsolet.

Fazit

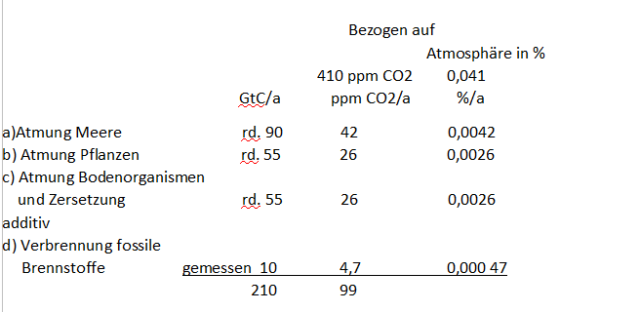

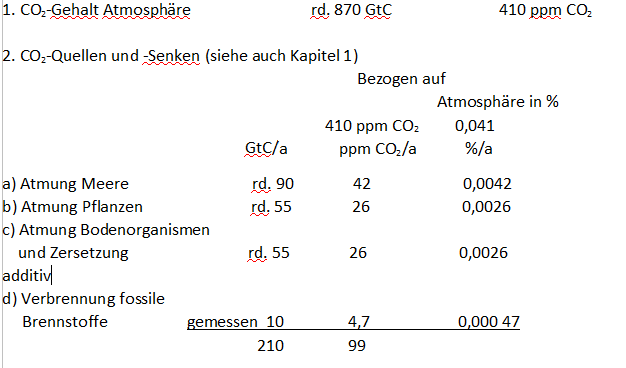

Die Atmosphäre enthält z. Z. etwa 0,041% CO2 oder 410 ppm. Das entspricht einer Kohlenstoffmenge in der Atmosphäre von 870 Giga Tonnen Kohlenstoff (GtC).

Es gibt CO2-Naturkreisläufe, die permanent in den Verlauf der CO2-Konzentrationen eingreifen:

Atmung Meere (90 GtC/a), Atmung Pflanzen (55 GtC/a), Atmung Pflanzen und Bodenorganismen (55 GtC/a) von insgesamt 200 GtC/a.

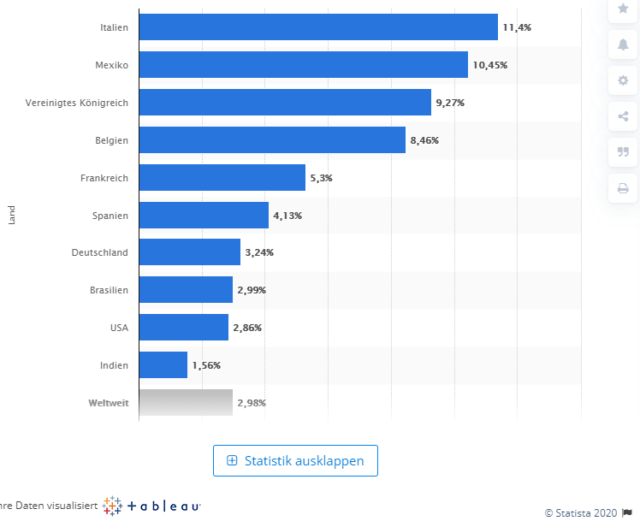

Additiv dazu liegt der weltweite wachsende Anteil aus der Verbrennung fossiler Brennstoffe bei z. Z. etwa 10 GtC/a bzw. 0,000 47%/a in der Atmosphäre oder 4,7 ppm/a.

Der anthropogene Anteil Deutschlands beträgt z. Z. 2% von 4,7 ppm/a oder 0,09 ppm/a oder 0,000 009%/a in der Atmosphäre, eine in Deutschland mit mehreren Billionen belastete CO2-Spur, mit deren Abbau Deutschland zur Vermeidung des Verglühens der Erde beitragen will.

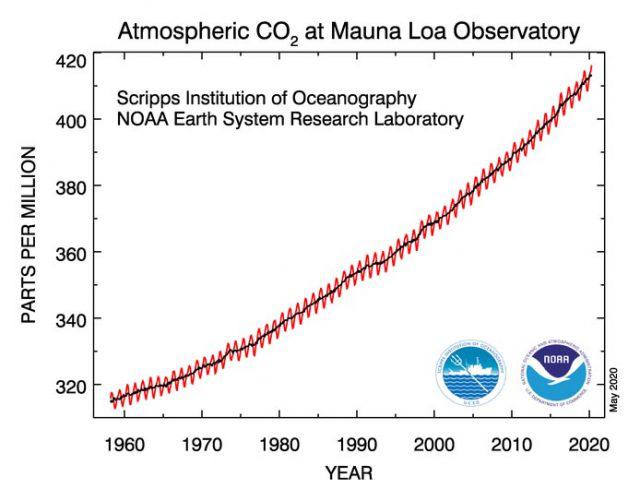

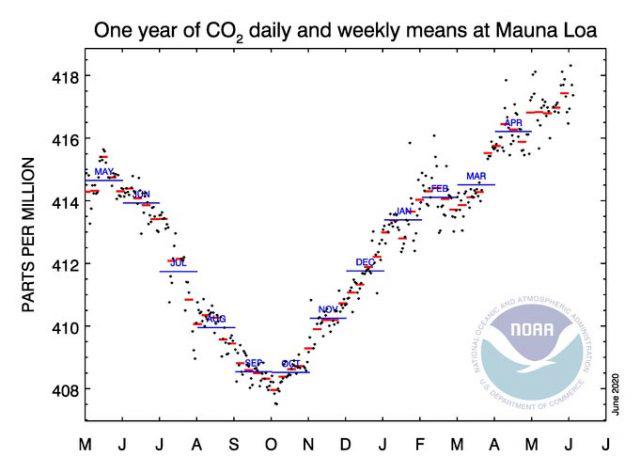

Die CO2-Gehalte in der Atmosphäre werden an mehreren Orten auf der Erde gemessen, am bekanntesten ist auf Mauna Loa auf Hawaii die Keeling-Kurve. Der wiederkehrende jährliche Verlauf lässt auf eine intensive Durchmischung des CO2 mit der Atmosphäre schließen.

Der jährliche mittlere Anstieg der CO2-Konzentrationen liegt bei allen Messstellen bei etwa 2 ppm/a bzw. 4,3 GtC/a , was etwa die Hälfte des anthropogenen Anteiles von 10 GtC/a ausmacht. Daraus wird abgeleitet, dass die 2.Hälfte des jährlich eingetragenen C-Anteiles von der Biosphäre absorbiert wird. Dabei wird die Betrachtung des Temperaturanstieges in der Atmosphäre und in den Meeren mit seiner Wirkung auf die CO2-Gehalte der Atmosphäre außer Acht gelassen.

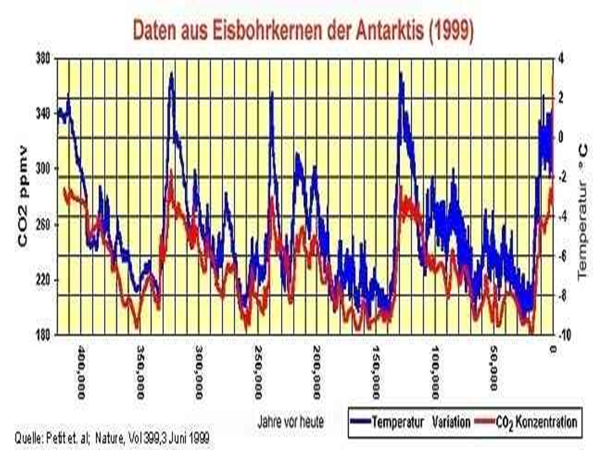

Von den Eiszeiten ist aufgrund der starken Temperatur-abhängigen CO2-Löslichkeit in Wasser eine enge Beziehung zwischen der Temperatur und den CO2-Gehalten in der Atmosphäre bekannt, mit einer Zeitverzögerung für den CO2-Anstieg nach der Temperaturerhöhung von etwa 800 Jahren.

Neuere Untersuchungen haben jedoch gezeigt, dass bei Temperaturerhöhungen nach einem Jahr bereits der CO2-Gehalt in der Atmosphäre ansteigt, stärker jedoch nach etwa 50 Jahren. So konnten nach dem 19. Jahrhundert Temperaturerhöhungen in den Meeren zwischen etwa 0,5/1,0°C gemessen werden, was zu einem freiwerdenden CO2-Potential in dem oberen Meter der Meere von 1385/ 2770 ppm führt bei CO2-Gehalten in der Atmosphäre von 410 ppm.

Ursache für die Temperaturanstiege von den Eiszeiten bis heute sind nachweislich starke Änderungen der Intensität der Sonneneinstrahlung.

Die durch die Sonneneinstrahlung ansteigenden Temperaturen insbesondere der Meere führen zu derartigen CO2-Zunahmen in der Atmosphäre, dass die aus dem anthropogenen C-Eintrag von 10 GtC/a in die Atmosphäre gelangenden CO2-Mengen von 4,7 ppm/a völlig überlagert werden.

So konnten erwartungsgemäß auch die in der Corona-Zeit abnehmenden C-Einträge in die Atmosphäre von bis zu minus 17% bei den CO2-Messungen auf Mauna Loa auf Hawaii nicht nachgewiesen werden.

Die wichtigsten Akteure für den sog. „Treibhauseffekt“ sind Wasser und Wolken und nicht die vom IPCC propagierten „CO2-Klimasensitivitäten“ mit ihrer willkürlichen Einbeziehung des Gesamt-CO2-Gehaltes der Atmosphäre in die Modelle, die weder die Vergangenheit nachvollziehen, geschweige denn die Zukunft voraussagen können.

Um dem anthropogenen CO2-Gehalt der Atmosphäre von

z. Z. etwa 4,7 ppm CO2/a (0,000 47 %/a)

gerecht zu werden, müssten diese niedrigen CO2-Gehalt mit den Modellen diskutiert werden, die zudem von den durch die Temperaturanstiege frei werdenden CO2-Gehalte der Atmosphäre völlig überlagert werden.

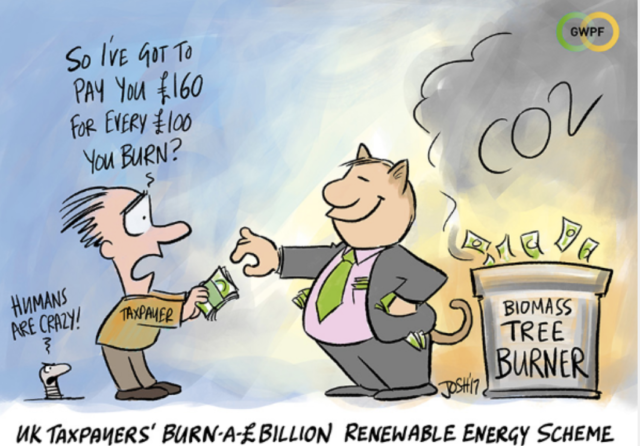

Ungeachtet all dieser fundamentalen Fehler in den Modellen des IPCC folgt vor allem Deutschland wie die Lemminge dem Ruf des teuersten Klimamissverständnisses aller Zeiten.

Wie schrieb noch das „Wall Street Journal“: „Die dümmste Energiewende der Welt“.

————————–

- Aktuelle CO2-Messungen in der Atmosphäre

Das Maß aller Dinge für die Diskussion der CO2-Gehalte in der Atmosphäre sind die seit 1958 durchgeführten CO2-Messungen auf dem Vulkan Maunda Loa auf Hawaii, die sog. Keeling-Kurve.

Bild 1 zeigt die gemessenen CO2-Gehalte von 1958 bis 2020. (NOAA) (1):

Die Hypothese lautet, dass der CO2-Anstieg in der Atmosphäre seit der Industrialisierung zu 100% auf den Menschen zurückzuführen sei. (2)

Ferner wird angenommen, dass der Austausch von CO2 zwischen Atmosphäre, Ozean und Biosphäre vor der Industrialisierung zu einem quasi stabilen Klimazustand geführt hätte, der erst durch die anthropogenen Quellen aus der Kontrolle geraten sei. (3)

Die schwarze Linie in Bild 1 zeigt den Trend, die rote Linie die Messwerte. Die Sägezähne verdeutlichen den Einfluss der Biosphäre (Photosynthese etc.) auf die jährlichen Schwankungen der CO2-Gehalte der Atmosphäre mit einem Maximum jeweils im Mai und einem Minimum im September (vgl. auch später).

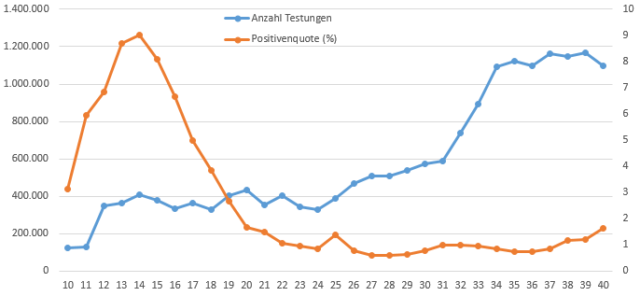

Der durchschnittliche CO2-Anstieg lässt sich zwischen 1970 und 2000 zu etwa 1,5 ppm/a und zwischen 2000 und 2020 zu etwa 2,1 ppm/a abgreifen.

Die kurzzeitigen Schwankungen weisen auf eine unmittelbare schnelle Durchmischung des CO2-Gases mit der Atmosphäre hin.

Die Erdatmosphäre enthält z.Z. etwa 410 ppm CO2 (0,041%). Über das Gewicht der Atmosphäre errechnet sich über die „CO2-Bilanz der Atmosphäre“ eine C-Menge von 870 Giga Tonnen Kohlenstoff (GtC) in der Atmosphäre. 1 ppm entspricht also bei vollkommener Durchmischung von CO2 in der Atmosphäre (vgl. später) bilanzmäßig 2,12 GtC.

Die jährlichen CO2-Kreisläufe von insgesamt etwa 210 GtC setzen sich etwa wie folgt zusammen:

Zu diesen Quellen und Senken kommt additiv die CO2-Menge aus der Verbrennung fossiler Brennstoffe hinzu, die z.Z. um 10 GtC/a liegt. Von diesen CO2-Kreisläufen kann nur der anthropogene Anteil gemessen werden.

Der anthropogene CO2-Anteil d) errechnet sich über die „CO2-Bilanz der Atmosphäre“ zu 4,7 ppm CO2/a oder 0,000 47%/a in der Atmosphäre.

Im Übrigen liegt der Anteil Deutschlands an der weltweiten Verbrennung fossiler Brennstoffe bei 2% von 4,7 ppm CO2/a. Das entspricht 0,09 ppm CO2/a oder 0,000 009%/a in der Atmosphäre – eine mit mehreren Billionen € belastete CO2-Spur, mit deren Abbau Deutschland helfen will, die Erde vor dem Verglühen zu retten.

Eine historische Betrachtung des Verlaufes des CO2-Gehaltes in der Atmosphäre und der Temperatur in den letzten 600 Mio. Jahren gibt eigentlich keine Veranlassung, sich mit derartigen Spuren von CO2 zu beschäftigen (Bild 2), zumal die CO2-Gehalte in der Atmosphäre Spitzenwerte bis 7 000 ppm erreichten bei lebenswerten Temperaturen. Die CO2-Gehalte lagen noch nie so niedrig wie heute und dennoch soll bei ihrem Anstieg die Erde verglühen. (vgl. auch später)

Ein Zusammenhang zwischen dem CO2-Gehalt in der Atmosphäre und der Temperatur gibt es nicht.

Im Übrigen kann in Anbetracht von Bild 2 ein Gleichgewicht bzw. ein stabiler Klimazustand eher als fiktive Annahme bezeichnet werden. Die Diskussion eines CO2-Gleichgewichtspartialdruckes zwischen Atmosphäre und Meere ist also wenig hilfreich und kann es nur begrenzt geben (vgl. später).

(Wird der weltweite C-Anfall aus der Verbrennung fossiler Brennstoffe auf die Summe der CO2-Kreisläufe von 210 GtC/a bezogen, errechnet sich ein Anteil von 4,7%. Der Anteil der natürlichen Prozesse a) bis c) beträgt dann etwa 95%.)

Abgesehen von dem messbaren menschlichen Einfluss über die fossile Verbrennung sind die physikalischen, chemischen und biologischen Prozesse, die den gigantischen CO2-Kreislauf steuern, äußerst komplex.

Daher ist es schwer zu bestimmen, was mit den anthropologischen Emissionen geschieht. Hinzu kommt ein Anstieg der Temperatur auf der Nordhalbkugel vom Ende des 19. Jahrhunderts bis heute von rd. 1,5 °C, ebenso ist die Wassertemperatur gestiegen (vgl. später).

Daher muss die stark Temperatur-abhängige CO2-Löslichkeit in Wasser in die Betrachtungen des CO2-Anstieges in der Atmosphäre einbezogen werden.

Andere Einflussgrößen auf die CO2-Gehalte in der Atmosphäre wie vulkanische Ausgasungen, Temperatur-Phänomene wie El Nino, La Nina, etc. werden hier nicht in die Betrachtung einbezogen.

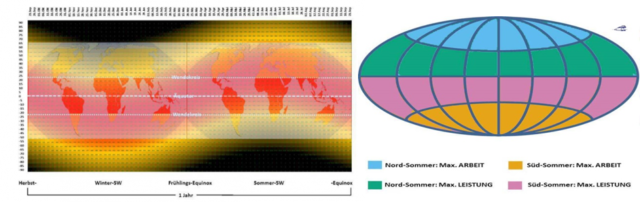

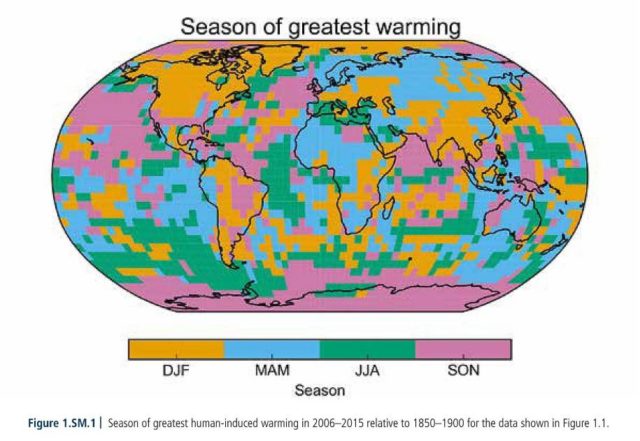

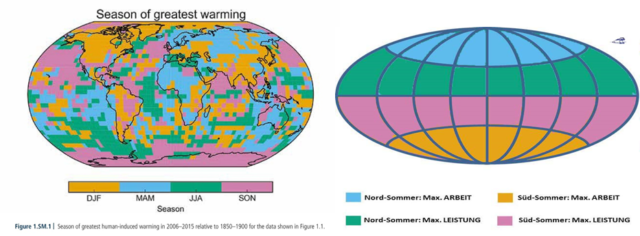

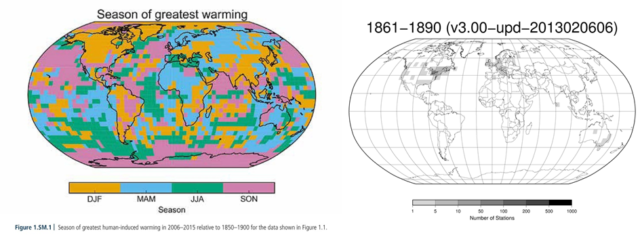

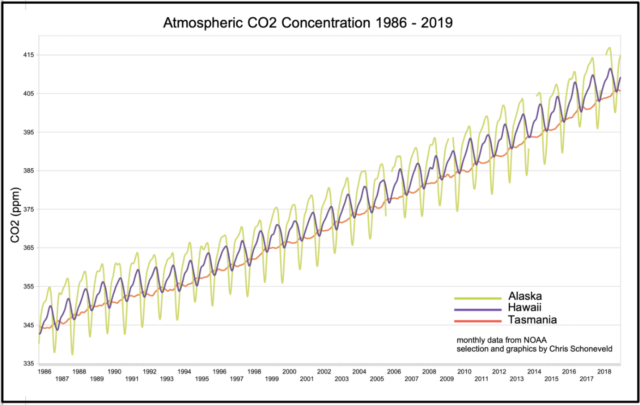

Nun hat sich herausgestellt, dass die Keeling-Kurve nicht repräsentativ ist für die jährlichen globalen CO2-Schwankungen (Bild 3). (4)

So zeigen Messstationen in hohen Breitengraden der nördlichen Hemisphäre eine viel größere Amplitude (Alaska) als Mauna Loa auf Hawaii.

Im Gegensatz dazu zeigen Messstationen in hohen Breiten der südlichen Hemisphäre (Tasmanien) kaum Sägezahnmuster. So ist im Norden der Nordhalbkugel durch die ausgedehnten Wälder ein stärkerer jahreszeitlicher Einfluss als in vergleichbaren Breitengraden der südlichen Hemisphäre erkennbar, wo es kaum Vegetation gibt.

Die Zyklusbreite in Alaska beträgt fast 20 ppm, die auf Hawaii 7 ppm und die in Tasmanien 1 ppm, letzteres allerdings mit einer Phasenverschiebung durch die Verschiebung der Jahreszeiten um 6 Monate. (4)

Das bedeutet, dass die jährlichen CO2-Schwankungen auf den beiden Hemisphären Nord- und Südhalbkugel unterschiedlich verlaufen, wenn auch die jährlichen CO2-Anstiege gleich sind.

Fakt ist der jährliche Anstieg des CO2-Gehaltes der Atmosphäre von etwa 2 ppm/a bzw. 4,3 GtC/a auf der Nord- wie auf der Südhalbkugel, also etwa halb so hoch wie der CO2-Anteil aus der Verbrennung der fossilen Brennstoffe von 10 GtC/a.

Daher wird davon ausgegangen, dass von den 10 GtC/a etwa die Hälfte in der Atmosphäre verbleibt bei einer Verweilzeit von etwa 4 Jahren, die restliche Hälfte wiederum hälftig vom Meer aufgenommen wird und hälftig über die Biosphäre (Photosynthese, Atmung und Zersetzung Bodenorganismen) absorbiert wird, was zu einer Begrünung der Erde führt. (5)

Diese bilanzmäßige Betrachtung der CO2-Verteilung zieht nicht in Erwägung, dass durch die Erwärmung einschließlich der Meere eine gewaltige CO2-Menge freigesetzt werden kann.

Daher wird im Folgenden die Frage der Wirkung des Temperatur-Anstieges einschließlich der Meere auf den CO2-Anstieg in der Atmosphäre abgeschätzt.

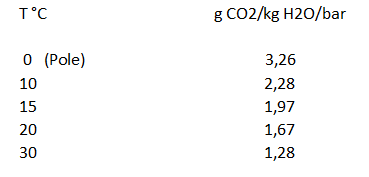

- Abhängigkeit der CO2-Löslichkeit in Wasser von der Temperatur

Die Löslichkeit von CO2 in Wasser hängt nicht nur von den Temperaturen sondern auch vom CO2-Partialdruck in der Atmosphäre ab. Ist z.B. der Partialdruck des CO2 in der Atmosphäre höher als der des Wassers, löst sich CO2 in Wasser und umgekehrt, wenn auch eine ständige Gleichgewichtseinstellung der CO2-Partialdruckes nicht zu erwarten ist (vgl. später).

CO2-Löslichkeit in Wasser:

Daraus errechnet sich im Temperaturbereich von 15-20 °C eine Löslichkeitsveränderung von 0,06 g CO2/kg H20/bar je Grad C.

Wird die Wasseroberfläche der Erde mit 360 570 000 km2 angenommen und eine Temperaturerhöhung für den oberen Meter der gesamten Wasseroberfläche von 15 auf 15,5/16 °C (durchschnittliche Wassertemperatur in der oberen Schicht: 16,3°C – vgl. später), so würde im Gleichgewichtszustand eine CO2-Menge von

frei. Die Erdatmosphäre enthält bei 410 ppm bzw. 870 GtC.

Das ist ein gewaltiges, möglicherweise freiwerdendes CO2-Potential. Auf die Wirkung von Hydrogencarbonationen im Meer und deren Wirkung auf die Löslichkeit von CO2 im Meer soll hier nicht näher eingegangen werden.

Natürlich wird sich die Wassertemperatur an den Polen um 0 °C bewegen, am Äquator deutlich höher liegen (vgl. später).

- Messungen der CO2-Gehalte in der Atmosphäre vom Eiszeitalter bis in die Gegenwart

Vor etwa 2 Mio. Jahren begann die Eiszeit.

Von Untersuchungen an Eisbohrkernen ist bekannt, dass die CO2-Gehalte in der Atmosphäre aufgrund des Temperatur-abhängigen CO2-Lösungsverhaltens in Wasser dem Temperaturverlauf folgen, jedoch mit einer Verzögerung von etwa 800 Jahre (Bild 4).

Der Übergang von CO2 vom Meer in die Atmosphäre beruht einerseits auf der Langsamkeit der Temperaturveränderung des Meeres über einen langen Zeitraum (etwa 800 Jahre), andererseits ist davon auszugehen, dass die Meere in diesem langen Zeitraum bis in große Tiefen erwärmt wurden, was zu hohen Veränderungen der CO2-Gehalte in der Atmosphäre in den Kaltzeiten von etwa 180 ppm auf etwa 280 ppm in den Warmzeiten führte. Dabei wird davon ausgegangen, dass die in den Warmzeiten gemessenen CO2-Gehalte durch Gasverluste bei der Beprobung und der Analyse in Wirklichkeit höher lagen.

Eisbohrkerne können schnelle An- und Abstiege der CO2-Konzentration in der Atmosphäre innerhalb von 100-500 Jahren nicht auflösen. (6)

Es stellt sich die Frage, wie der z.B. auf Mauna Loa gemessene Anstieg der CO2-Gehalte zu erklären ist – ob anteilmäßig über einen anthropogenen Anteil oder über einen Temperaturanstieg – , schließlich können die gemessenen CO2-Anstiege in den Eisbohrkernen nicht als Maß für eine kurzzeitige Veränderung der Temperatur mit ihrem Einfluss auf die CO2-Gehalte in der Atmosphäre herangezogen werden.

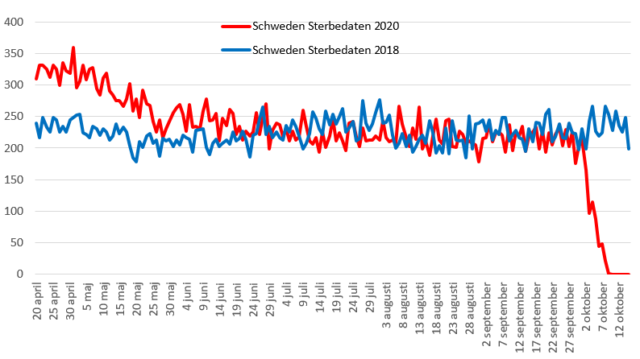

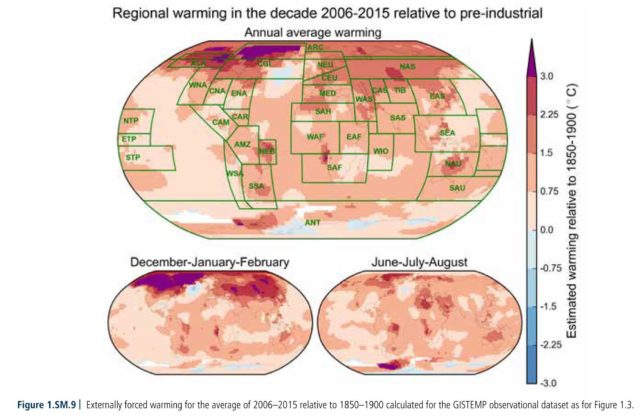

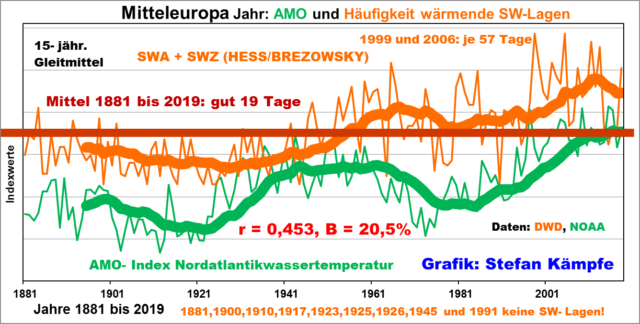

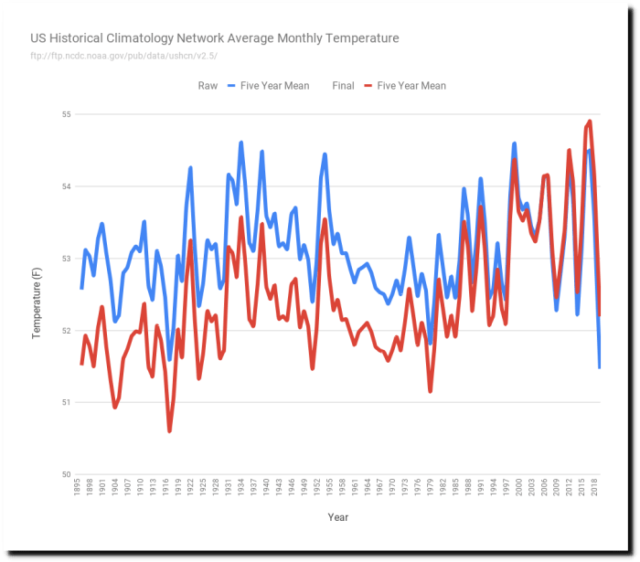

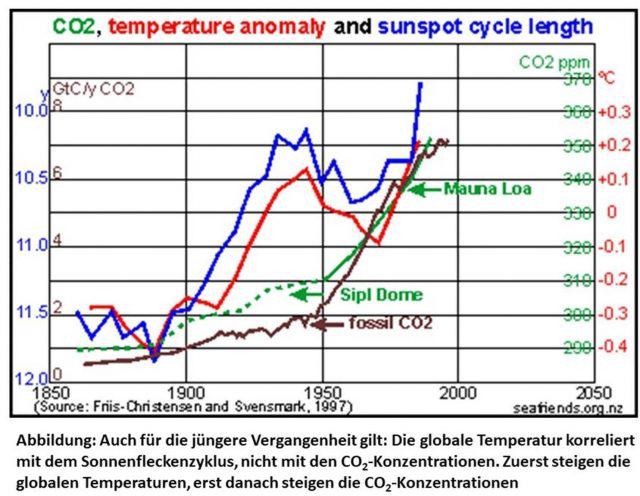

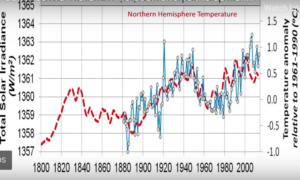

Dazu wurden jüngere Untersuchungen zur Beantwortung dieser Frage ausgewertet. So zeigen Messungen einen deutlichen Zusammenhang zwischen einem Temperaturanstieg vom Ende des 19. Jahrhunderts bis 1990 und der zugehörigen CO2-Entwicklung (Bild 5). (7)

Ursache für den Temperaturanstieg ist die Zunahme der Intensität der Solaren Einstrahlung, worauf in einem der folgenden Kapitel näher eingegangen wird.

In Bild 5 sind die Längen der Sonnenzyklen, die atmosphärischen CO2-Konzentrationen sowie die globalen Temperatur- Anomalien von 1860 – dem Ende der Kleinen Eiszeit – bis 1990 dargestellt.

Von 1890 bis 1945 nahm die Intensität der Sonnenzyklen zu, begleitet von einer Zunahme der globalen Temperaturen um etwa 0,4°C.

Von 1945 bis etwa 1970 wurde es plötzlich kälter, begleitet von einer geringeren Sonnenaktivität. Wissenschaftler beschworen damals sofort den Beginn der neuen Eiszeit, was von allen Medien übernommen wurde mit einem prognostizierten Temperaturabfall bis 2021 von 6°C und Eisbergen bis Portugal.

Aber die Sonne verstärkte von 1975 bis 1995 wieder ihre Zyklen, verbunden mit einem Anstieg der Temperaturen um etwa 0,3°C und einer parallelen Zunahme der CO2-Gehalte in der Atmosphäre.

Diese Darstellung beweist, dass nach Änderung der Temperatur bereits unmittelbar ein leichter CO2-Anstieg feststellbar ist (Oberflächenwasser), intensiv aber nach knapp 50 Jahren.

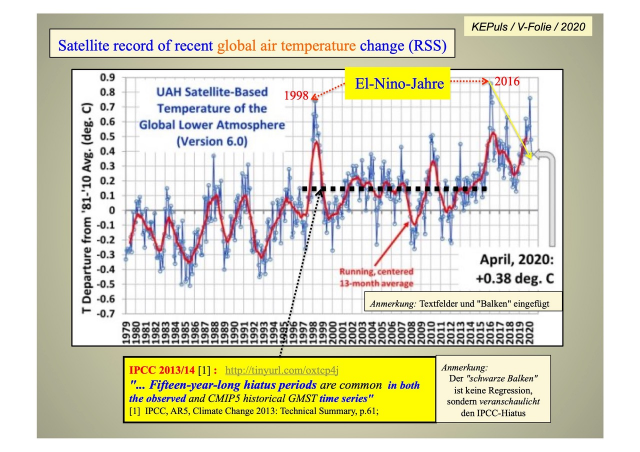

Es lohnt sich auch einen Blick auf die ab 1979 mit Satelliten gemessenen Temperaturen der globalen unteren Atmosphäre (Bild 6).

Zunächst ist durch die zahlreichen El Nino-Temperaturspitzen ein Temperaturanstieg von 1979 bis 2020 nur schwer abzugreifen. Vertretbar wäre aber ein Anstieg um 0,75 °C, der im Übrigen der Aussage von HADCRUT4 mit 0,85°C für die Zeit von 1969 bis 2020 gut entspräche.

Aus diesen beiden diskutierten Zeiträumen (Bild 5 und 6) ergäbe sich dann ein Gesamttemperaturanstieg von Ende des 19. Jahrhunderts bis heute von etwa

0,5 + 0,85 = 1,35 °C.

Dieser Temperaturanstieg kann nicht gleichgesetzt werden mit den Temperaturen der Meere.

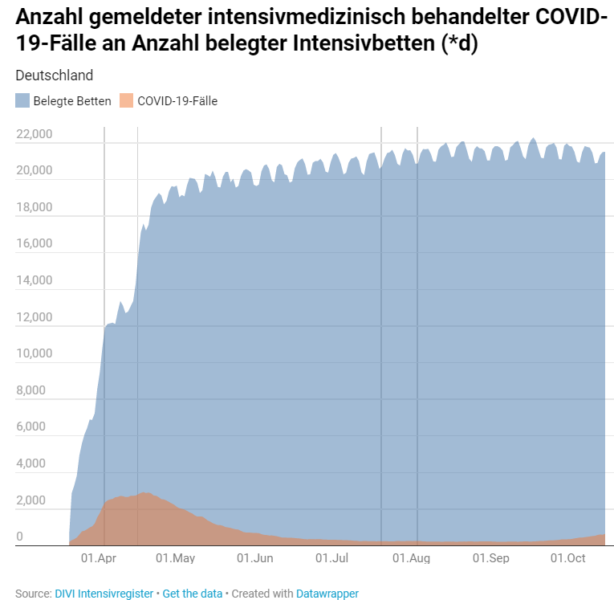

In den Ozeanen existiert eine durch Wind und Wellen gut durchmischte und warme Deckschicht von rd. 75 m. (8) Diese Deckschicht hatte im 20.Jahrhundert eine Durchschnittstemperatur von 16,3 °C (im Gegensatz zur Landtemperatur von 11,1 °C). Nach Angaben der NOAA hat sich die Temperatur der Ozeane oberflächlich in den letzten 150 Jahren um 0,7 °C erwärmt.

Die Durchwärmung der Oberflächenschicht des Meeres kommt vermutlich durch die Durchdringung des Sonnenlichtes bis zu einer Tiefe von 200 m zustande.(9) Der Austausch mit dem tiefen Ozean, der rd. 50 mal mehr Kohlenstoff gespeichert hat, erfordert Zeiträume von etwa 800 Jahren.

Interessant ist, dass in der Luft über den Warmwasserzonen über 50 ppmv höhere CO2– Konzentrationen und über den kalten Zonen über 50 ppmv niedrigere Werte gemessen wurden, was einen ständigen Austausch dieser Konzentrationen zur Folge hat. (10)

Das Klimasystem kann sich daher niemals im Gleichgewicht befinden. Für die ständige Unberechenbarkeit des Klimas sorgt schon die Variabilität des Wasserdampfes während des Tages und die Bildung von Wolken etc.

Gezielte Messungen der Meerestemperaturen gibt es erst seit 2005 (ARGO Flotte).

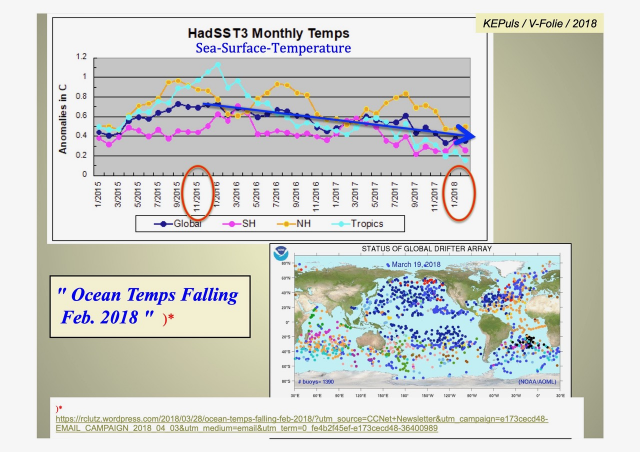

Auch die Messungen auf See zeigen eine Erwärmung der Ozeane um im Mittel etwa 0,5°C mit fallender Tendenz am Ende des Hiatus (Bild 7).

Dabei weist die Nordhalbkugel mit Erwärmungsspitzen bis über 1 °C höhere Temperaturen aus als die Südhalbkugel.

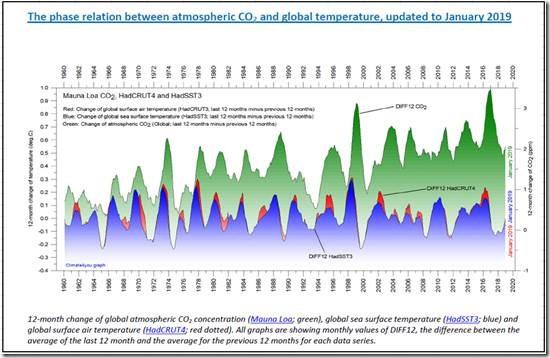

Andere Untersuchungen zeigen eine noch kürzere Ansprechzeit zwischen Temperaturerhöhung und CO2-Anstieg in der Atmosphäre. Die Auftragung des CO2-Anstieges auf der Basis der Messungen auf Mauna Loa (grün), der Temperaturmessungen an der Meeresoberfläche (HaDSST3) (blau) und der Lufttemperatur (HadCRUT4) (rot) zeigen bereits Ansprechzeiten für CO2-Anstiege in der Atmosphäre von nur etwa 12 Monaten nach Temperaturveränderungen (Bild 8). (11)

Alle Werte beruhen jeweils auf Monatsmittelwerten und zeigen die Differenz zwischen den Mittelwerten der letzten 12 Monaten und den Mittelwerten der vorherigen 12 Monate.

Auch von anderen Untersuchungen sind Ansprechverhalten von wenigen Monaten bekannt. (12)

Es stellt sich also die Frage, ob der Austausch von CO2 zwischen Atmosphäre, Ozean und Biosphäre vor der Industrialisierung zu einem quasi stabilen Klimazustand führen konnte, der erst durch die anthropogenen Quellen aus der Kontrolle geraten ist und ob die Hälfte des anthropogenen C-Eintrages von 10 GtC/a zu einem Anstieg des CO2-Gehaltes in der Atmosphäre führen kann.

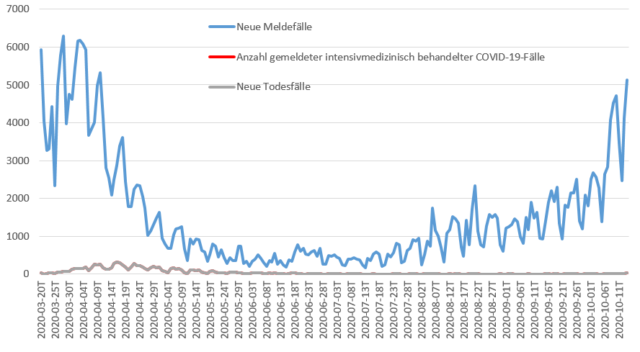

- Minderung der CO2-Emissionen durch die Corona-Krise und mögliche Auswirkung auf die CO2-Gehalte in der Atmosphäre

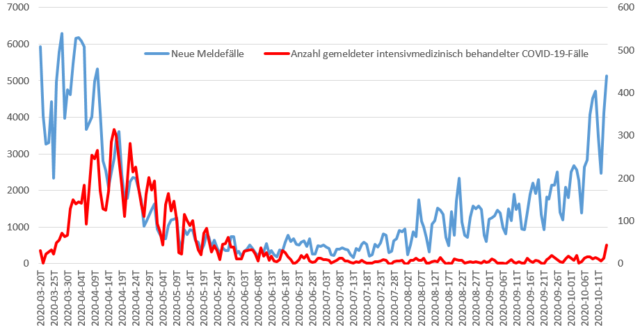

Forscher schätzen den Rückgang der CO2-Emissionen in der Corona-Krise bis auf – 17% gegenüber 2019 auf der Basis von Auswertungen von 70 Ländern. (1)

Wie erwähnt lautet die Hypothese, dass von den 10 GtC/a etwa die Hälfte in der Atmosphäre verbleibt (rd. 5 GtC oder 2 ppm), die andere Hälfte hälftig von der Biosphäre und den Ozeanen aufgenommen wird.

Im Folgenden wird der Frage nachgegangen, ob die verminderten CO2-Emissionen durch Corona bei den Messungen in Mauna Loa sichtbar werden können.

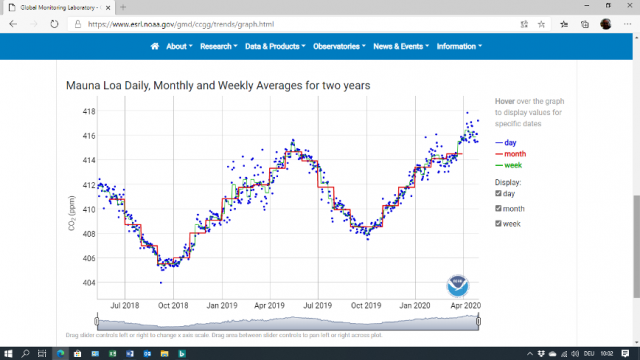

In Bild 9 sind die in der Corona-Zeit angefallenen täglichen, wöchentlichen und monatlichen CO2-Messdaten von 2019 -Juni 2020 aufgetragen. (1)

Auch hier werden die jährlichen, durch die Biosphäre ausgelösten CO2-Schwankungen sichtbar.

CO2 ist ein gut durchmischtes Gas und ist gleichmäßig in der Atmosphäre verteilt, wenn auch in ihren Konzentrationen unterschiedlich in verschiedenen Breiten (Bild 3).

Die NOAA, die für die CO2-Messungen verantwortlich zeichnet, schätzt die Zeitverzögerung zwischen CO2-Emissionen und der Messung auf Mauna Loa auf wenige Wochen.

Die Messungen auf Mauna Loa zeigen nun, dass eine Verminderung der CO2-Gehalte durch Corona in den Messergebnissen bis Juni 2020 nicht sichtbar wird.

Der leichte Rückgang in Februar /März 2020 ist jedes Jahr sichtbar (Bild 10). (13)

Wäre denn eine Abnahme der gemessenen CO2-Gehalte auf Mauna Loa überhaupt zu erwarten gewesen?

Wie bereits ausgeführt, liegt der jährliche anthropogene C-Eintrag über fossile Brennstoffe in die Atmosphäre bei 10 GtC, bei einer Gesamt-Kohlenstoff-Menge von 870 GtC oder 410 ppm CO2.

Wenn nun 10 GtC der Atmosphäre entnommen würden, entspräche dies bilanzmäßig einer Minderung von 4,7 ppm (vgl. Kapitel 1).

Eine Verminderung des C-Eintrages bis 17% durch Corona entspräche dann einem Abbau von

0,17 x 4,7 ppm = 0,8 ppm,

der wohl gerade hätte sichtbar sein müssen (Bild 9).

Dies ist aber nicht der Fall, die CO2-Gehalte steigen in den in Betracht kommenden Monaten sogar stärker an als in 2019.

Im Mai 2019 liegen nach Bild 9 die CO2-Gehalte noch um 415 ppm, bereits im Juni 2019 abfallend, während im Mai 2020 die CO2-Gehalte im Mittel auf etwa 417 ppm ansteigen mit sogar Ausreißern von über 418 ppm, wobei eine Abnahme der CO2-Gehalte im Juni 2020 im Gegensatz zu 2019 nicht zu erkennen ist.

Dies ist ein Hinweis darauf, dass der Anstieg der CO2-Gehalte in der Atmosphäre nicht auf den anthropogenen CO2-Eintrag zurückzuführen ist sondern andere Einflussgrößen wie ein Temperaturanstieg der Meere für den CO2-Anstieg verantwortlich zeichnen.

Ein kurzer Abriss zum Einfluss der solaren Einstrahlung auf die Temperaturentwicklung auf der Erde

Da die Temperaturentwicklung auf der Erde mit der Betrachtung der CO2-Gehalte in der Atmosphäre eng verknüpft ist, wird im Folgenden der überragende Einfluss der Sonneneinstrahlung auf die Erdtemperatur näher betrachtet werden.

Die Veränderung in der Erdbahngeometrie wird durch wechselseitige Gravitationskräfte im System Sonne-Erde-Mond hervorgerufen. Sie ändern die Form der elliptischen Erdbahn (Exzentrizität) um die Sonne mit einer Periode von 100 000 Jahren (Abbildung der Eiszeiten: Bild 4), die Neigung der Erdachse zur Umlaufbahn (21,8 bis 24,5°) mit einer Periode von etwa 41 000 Jahren (Schiefe der Ekliptik), während die Tag- und- Nacht- Gleiche auf der elliptischen Umlaufbahn etwa nach 19 000-23 000 Jahren wieder dieselbe Position auf der Ellipse einnimmt (Präzession).

Durch diese geometrischen Veränderungen wird die Stärke der Sonneneinstrahlung auf die Erde massiv verändert.

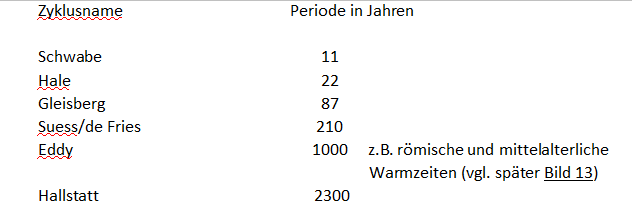

Neben der Veränderung der Erdbahngeometrie ändert auch die Sonne die Intensität ihrer ausgehenden Strahlung durch Strömungsvorgänge im Inneren der Sonne (Magnetfeld).

Die Änderungen der ausgehenden Sonnenstrahlung unterliegen mehreren kürzeren und längeren Zyklen:

Wie bereits dargelegt wurde (Bild 5), ist die Sonnenaktivität auch für kurzzeitige Veränderungen des Erdklimas verantwortlich.

Wie bereits dargelegt wurde (Bild 5), ist die Sonnenaktivität auch für kurzzeitige Veränderungen des Erdklimas verantwortlich.

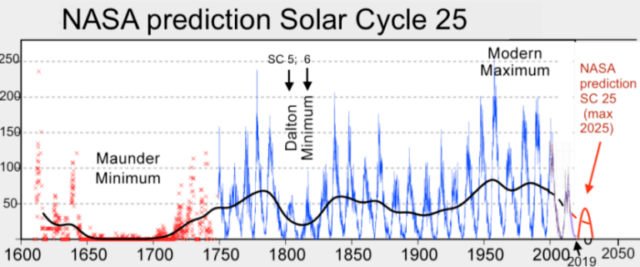

So zeigt Bild 11 (14) die Entwicklung der Schwabe-Zyklen seit etwa 1600 (dem Beginn der Aufzeichnungen) mit deutliche Schwankungen in der Sonnenaktivität.

Es gab im Laufe der Jahrhunderte deutliche Einbrüche im 17. Jahrhundert – das Maunder-Minimum –, um 1800 – das Dalton-Minimum – wie auch am Ende des 19.Jahrhunderts – die sog. „Kleine Eiszeit“ (vgl. auch später Bild 13).

Diese Einbrüche der Sonnenaktivität führten zu starken Abfällen der Erdtemperaturen, Der von der NASA prognostizierte niedrige 25. Solare Zyklus deutet in die gleiche Richtung. Der zu erwartende 25. Zyklus wird als der schwächste der letzten 200 Jahren angesehen.

Auch die in Bild 5 ausgewiesenen Längen der Sonnenzyklen zwischen 1850 und 1900 ebenso wie der Anstieg bis 1945, der kurze Abfall zwischen 1945 und 1970 und der erneute Anstieg nach 1970 sind in Bild 11 zu erkennen.

Schließlich zeigt Bild 12 (15) den Gleichlauf von Sonneneinstrahlung in W/m2 und dem Temperaturverlauf auch über das Jahr 2000 hinaus.

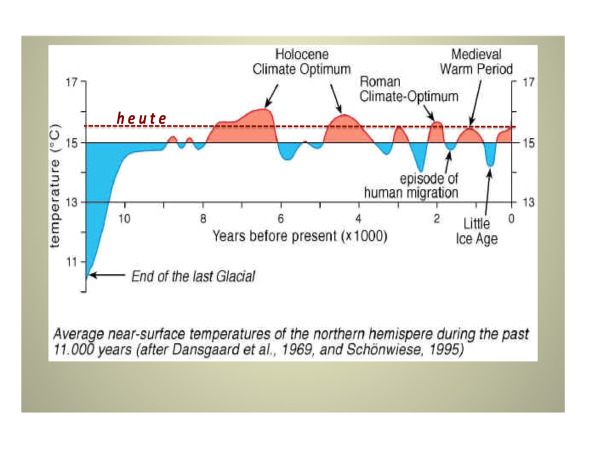

Bild 13 schließlich zeigt den Temperaturverlauf nach der letzten Eiszeit.

Die „Little Ice Age“ spiegelt nach dem Mittelalter den Einbruch der Solaren Zyklen nach Bild 11 wider. Außerdem zeigt Bild 13 nach der letzten Eiszeit einen ständigen Wechsel von wärmeren und kälteren Phasen. Die jetzige Warmphase ist die kälteste der sechs Warmphasen nach der letzten Eiszeit.

Ausgerechnet in dieser jetzigen Warmphase bezeichnet das IPCC den Temperaturanstieg als ein apokalyptisches Ereignis durch einen vom Menschen verursachten CO2-Anstieg, obwohl alle Warmphasen davor ohne menschliches Zutun wärmer waren als die jetzige – was an Absurdität nicht zu überbieten ist.

- Einordnung der Wirkung des menschlich verursachten CO2-Ausstosses in die bekannten, den CO2-Gehalt bestimmenden Größen

Die CO2-Gehalte in der Atmosphäre und ihre CO2-Kreisläufe setzen sich etwa wie folgt zusammen (vgl. Kapitel 1):

In 1970 lag der anthropogene Anteil über die C-Verbrennung noch bei etwa 5 GtC/a (Bild 5), in 2020 bei 10 GtC/a. Das entspricht nach der „CO2-Bilanz der Atmosphäre“ (vgl. Kapitel 1: 1 ppm entspricht 2,12 GtC) einer Zunahme von 2,3 ppm CO2/a in 1970 auf 4,7 ppm CO2/a (0,000 47%/a) in 2020, in 50 Jahren also ein Zuwachs von 0,05 ppm CO2/a (0, 000 005%/a in der Atmosphäre).

Nun soll ausgerechnet der kleinste Teilnehmer dieses CO2-Kreislaufes, der anthropogene Anteil von z.Z. 4,7 ppm/a mit einer jährlichen Zunahme von 0,05 ppm CO2/a in einem Umfeld von nicht messbaren Teilnehmern a) bis c) das Maß aller Dinge für die Veränderung des CO2-Gehaltes in der Atmosphäre darstellen, obwohl die Temperaturen einschließlich der Meere massiv angestiegen sind mit einem möglichen freiwerdenden CO2-Potential aufgrund der mit steigender Temperatur abnehmenden CO2-Löslichkeit von 1385/2770 ppm CO2 bei einer Temperaturerhöhung von 0,5/1°C im Bereich 15-16°C (vgl. Kapitel 2).

Hervorzuheben ist auch, dass nach den CO2-Messungen in der Atmosphäre auf Mauna Loa der CO2-Gehalt von 1970 bis 2020 um 87 ppm entsprechend 1,74/a angestiegen ist (2000 bis 2020 um 2,1 ppm/a) (vgl. Kapitel 1). Damit steigt der gemessene CO2-Gehalt der Atmosphäre deutlich stärker an als der aus der „CO2-Bilanz der Atmosphäre“ errechnete Wert von 0,05 ppm/a. Dies ist ein weiterer deutlicher Hinweis auf den die CO2-Gehalte der Atmosphäre bestimmenden Einfluss der Temperatur.

Von allen möglichen Einflussgrößen auf den CO2-Anstieg in der Atmosphäre unterliegen nur folgende Größen tatsächlichen Messungen:

a) CO2-Konzentrationen in der Atmosphäre

b) CO2-Mengen aus Verbrennung

c) Messungen der Temperaturveränderungen von Atmosphäre und Meere mit der Folge von beträchtlichen CO2-Freisetzungen

d) Messung der solaren Einstrahlung und ihre Wirkung auf die Temperatur der Atmosphäre und der Meere

Wenn davon ausgegangen wird, dass der Austausch von CO2 zwischen Atmosphäre, Ozean und Biosphäre vor der Industrialisierung zu einem stabilen Klimazustand geführt hat, der erst durch die zusätzlichen menschlichen Quellen aus der Kontrolle geraten sei, so ist das durch nichts zu begründen.

Aufgrund der gegebenen Messmöglichkeiten können nun folgende Aussagen getroffen werden:

1. ein durch die Corona- Krise zu erwartender leichter Einbruch der auf Mauna Loa gemessenen CO2-Gehalte kann nicht gefunden werden, was auf einen ausschließlichen CO2-Anstieg durch die Temperaturerhöhung der Atmosphäre wie der Meere hindeutet

2. es werden nach dem Ende des 19.Jahrhunderts bis heute deutliche Temperaturanstiege sowohl der Atmosphäre als auch der Meere durch die Veränderung der Sonneneinstrahlung gemessen mit einem erheblichen Anstieg der in der Atmosphäre gemessenen CO2-Gehalte.

3. eine Aussage zum Anstieg der CO2-Gehalte in der Atmosphäre durch anthropogene Maßnahmen können ohne Berücksichtigung der Temperatur- und CO2-Anstiege nicht gemacht werden

- Zur angeblichen Wirkung von CO2 auf das Klima und die Haltung Deutschlands

Die wichtigsten Akteure für den sog. „Treibhauseffekt“ sind Wasser und Wolken, nicht das vom IPCC anhand von zwischen etwa 0 und 5,8 °C gemessenen „CO2-Klimasensitivitäten“ (Ausmaß der Erwärmung bei CO2-Verdoppelung) – dem „Heiligen Gral“ der Klimawissenschaft – mit einer willkürlichen Einbeziehung von z.Z. 3°C als „best guess“ in die Modelle, die die Vergangenheit nicht nachvollziehen können, wohl aber unter Beschwörung des Weltunterganges bei steigenden CO2-Gehalten die Zukunft voraussagen wollen. (vgl. auch (16,17))

Schließlich wird auch noch der Gesamt-CO2-Gehalt der Atmosphäre in die Modelle eingebaut und nicht der anthropogene Anteil von weltweit

z.Z. etwa 4,7 ppm CO2/a (0,000 47%/a),

um dessen Anstieg und Einfluss auf das Klima es doch letztlich geht, der aber von den genannten Einflussgrößen auf die Temperaturentwicklung der Atmosphäre wie der Meere und damit von der stark temperaturabhängigen CO2-Löslichkeit in Wasser völlig überlagert wird.

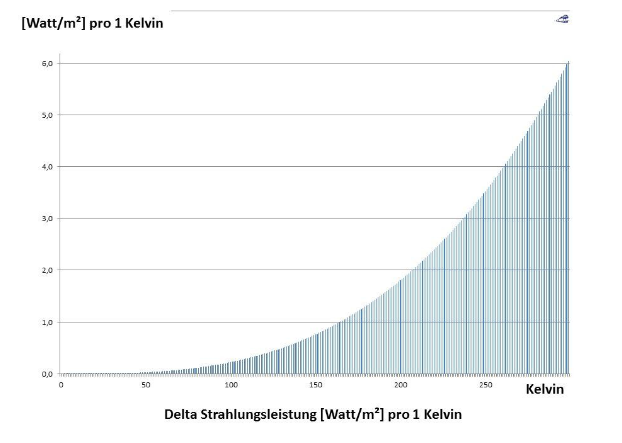

Schließlich darf auch nicht unerwähnt bleiben, dass die Wirkung von CO2 in der Atmosphäre auf den sog. Treibhauseffekt nie gemessen werden konnte, geschweige denn den Einfluss des weltweiten anthropogenen Anteiles von 4,7 ppm/a, da es auch einen Treibhauseffekt aus thermodynamischen Gründen (2. Hauptsatz der Thermodynamik: Wärme fließt nur von warm nach kalt) nicht geben kann. Außerdem würden 410 ppm (0,041%) CO2 in der Atmosphäre mengenmäßig nicht ausreichen, um eine Wärmemenge von 342 W/m2 zur Erde zurückzustrahlen (IPCC), geschweige denn von 4,7 ppm (0,000 47%) CO2/a.

Ungeachtet dieser fundamentalen Fehler folgt Deutschland unterstützt von all den Nutznießern dieser mit den CO2-Gehalten verknüpften Energiewende einschließlich einer Reihe von profitierenden Klimaforschern wie die Lemminge dem Ruf des teuersten Klimamissverständnisses aller Zeiten. Schließlich basiert die Angst vor dem Weltuntergang ausschließlich auf diesen untauglichen Modellergebnissen und hat inzwischen ungeahnte emotionale Höhen erreicht, selbst die Kirchen sprechen vom Höllenfeuer.

Zudem werden in Deutschland wie in der EU ständig neue Restriktionen zur Verminderung des CO2-Ausstosses erfunden bei einer Verantwortlichkeit Deutschlands für

0,09 ppm CO2/a (0,000 009%/a),

obwohl bei den gemessenen Temperaturerhöhungen der Meere von z.B. je 0,5/1 °C 1385/2770 ppm CO2 (15-16°C) frei werden.

Für diese lächerliche Verantwortlichkeit gibt Deutschland freiwillig 6-8 Billionen € aus (18),

die Welt lacht.

Dennoch strebt Bundeswirtschaftsminister Altmaier zu ständig schärferen Klimamaßnahmen in seiner jüngsten „Charta Klimaneutralität und Wirtschaft“: mindestens 65% alternativen Energien in 2030, Klimaneutralität in 2050, d.h. auch für alle Sektoren.

Dabei entgeht ihm, dass durch die E-Mobilität oder die kürzlich propagierte „Wasserstofftechnologie“ der Strombedarf von heute im Mittel etwa 69 GW um 39 GW auf 108 GW (19) bzw. von 69 GW um 75 GW auf 144 GW (20) angehoben werden müsste.

Aber das würde immer noch nicht reichen, schließlich müssen auch noch die anderen Sektoren wie Verkehr, Industrie, etc. auf alternative Energien umgestellt werden, denn die Stromerzeugung bestimmt nur zu knapp 40% den CO2-Austoß Deutschlands.

Auch die EU ist dabei, in ihrer Zielsetzung kräftig nachzusteuern: bis 2030 soll der CO2-Ausstoss nun nicht mehr nur um 40% verglichen mit 1990 vermindert werden sondern um mindestens 55%, mit Klimaneutralität in 2050. Dafür sollen von dem 750 Milliarden € umfassenden Wiederaufbaufond 37% oder 278 Milliarden € in den „Green Deal“ fließen.

Auch die Autohersteller sollen die Emission ihrer Neuwagen nicht mehr nur um 37,5% verglichen mit 2021 verringern, die Kommission erwägt eine Anhebung sogar auf 50%.

Deutschland – wie die EU – sind dabei, sich von jeglicher Diskussion auf der Basis von Fakten zu verabschieden und erstarren in einer Emotionalität im Stile einer Friday-for-Future-Bewegung.

Für das tragische Ende Deutschlands wird am Ende die nicht funktionierende Energiewende stehen, denn wo soll nach Stillsetzung der Kern- und Kohlekraftwerke nachts bei Windstille der Strom herkommen (von 14-tägigen Dunkelflauten abgesehen) – ausreichende Stromspeicher kann es nicht geben.

Stromstillstände wie in Australien und wie jetzt in Kalifornien (21) sind vorhersehbar, die deutsche Industrie hat dann keine Chancen mehr, leider auch nicht die deutsche Gesellschaft.

Hier fällt einem nur noch die Aussage des „Wall Street Journal“ ein: „Die dümmste Energiewende der Welt“.

Es gibt dennoch auch Erfreuliches zu berichten: die Niederlande ist zu der Erkenntnis gelangt, dass für die Garantie der Stromversorgungssicherheit ab 2030 Kernreaktoren erforderlich sind („Die Welt“, 26.10.2020).

Quellen

1. De Vos, Rob: „CO2 und Corona“; EIKE, 29.07.2020

2. IPCC Synthesis Report 2014

3. Schönwiese “Klimatologie”, 3.Auflage Ulmer Verlag 2008

4. Schönfeld, Ch.: „Der globale Kohlenstoff- Haushalt: schöne Zahlen, vorgetäuschtes Vertrauen, aber höchst fragwürdig“, Teil 3; EIKE 13.06 2020

5. Lüdecke, H-J: „Was Sie schon immer über CO2 wissen wollten; Teil 3 – der globale CO2-Kreislauf“; EIKE, 12.08 2019

6. Van Hoof et al.: Tellus 57 B, 2005, S. 351-355

7. Döhler, K.D.: „Sonnenzyklen, globale Temperatur und atmosphärische CO2-Konzentrationen seit Beginn der Industrialisierung“; EIKE, 04.09.2020

8. Roedel „Die Atmosphäre“, 2.Auflage 1992, Springer, Seite 346

9. Vögele, P.: „Der C-Kreislauf – ein umfassender Ansatz“; EIKE, 21.08.2017

10. Scripps Institute, Seawater CO2 Data, published by C.D. Keeling, 1957-1963

11. Macrae, A.; J.D`Aleo: „Die wirkliche Klimakrise ist nicht die globale Erwärmung, sondern die globale Abkühlung und vermutlich hat sie bereits begonnen“; EIKE,05.03.2020

12. Schönfeld, CH.: „Der globale Kohlenstoffhaushalt: schöne Zahlen, vorgetäuschtes Vertrauen, aber höchst fragwürdig“; EIKE, 12.06.2020

13. Köhler, M,: „Ergebnisse der CO2-Messung am Mauna Loa (Hawai), Update: 07.07.2020

14. Allon, C.: „Einsetzendes Grand Solar Minimum“, EIKE, 30.08.2020

15. Bastardi, J.: „Einige Gründe, hinsichtlich Klimaalarm skeptisch zu sein“; EIKE, 17.06.2019

16. McKitrick, R.: „All jene Prophezeiungen bzgl. eines sich erwärmenden Klimas haben plötzlich ein großes Problem“; EIKE, 16.09 2020

17. Zuiderwijk, E.: „Das Wirrwarr der Klimamodelle“; EIKE, 04.07.2020

18. Beppler, E.: „Der industrielle Niedergang Deutschlands wird nun durch den Beschluss des Bundestages zum Kohleausstieg besiegelt, obwohl die Wirkung von CO2 auf den sog. Treibhauseffekt marginal ist“, EIKE, 26.03.2020

19. Beppler, E.: „Der Kohleausstieg ist im Sinne einer Absenkung des CO2-Ausstosses ein Flop – und nun wird auch noch der Hype um die E-Mobilität zum Flop – quo vadis Industrieland Deutschland“; EIKE 06.05.2019

20. Beppler, E.: „Der Stoff hat das Zeug zu einem Hollywoodstreifen (BWMi, Juni 2020)“; EIKE, März 2020

21. Lehr, J.: „Die Stromausfälle kommen“; EIKE, 13.09.2020