1. Einleitung

Der Begriff Treibhauseffekt verleitet zur Annahme, dass man diesen Effekt mit dem Modell eines bestrahlten Gewächshauses, mit und ohne CO2, demonstrieren kann. Bereits 1909 hatte Robert Wood jedoch herausgefunden, dass sich ein Gewächshaus nur deshalb erwärmt, weil es das Aufsteigen und Entweichen erwärmter Luft verhindert. In der Folgezeit wurde Wood‘s Experiment mehrfach wiederholt und seine These bestätigt (Nasif S. Nahle, 2011 [1]; Jan-Eric Solheim, 2017 [2]).

Einen besonders hohen Temperatur-Anstieg konnte Hoimar von Ditfurth 1978 [3] bei einem spektakulären Selbst-Versuch erzielen. Eine Überprüfung des Ditfurth-Experimentes ergab, dass der beobachtete Temperatur-Anstieg einem Schichtungseffekt geschuldet ist, der ähnlich wie eine Mehrfachverglasung von Fenstern eine sehr gute Wärmeisolierung verursacht (M. Schnell, 2020) [4]). Eine solche Schichtung tritt auf, wenn reines CO2 von unten in eine Vorrichtung eingebracht wird. Ist das CO2, wie in der Atmosphäre, gleichmäßig mit der Innenluft vermischt, gibt es bei einem Treibhaus-Modell nur eine minimale oder gar keine Luft-Erwärmung. Mit diesen Treibhaus-Experimenten kann der Treibhauseffekt grundsätzlich nicht nachgewiesen werden, was einen neuen Denkansatz erforderlich macht.

Es ist unbestritten, dass CO2 ein infrarot (IR) aktives Gas ist und Wärmestrahlung absorbieren und auch wieder emittieren kann, was durch eine Vielzahl von IR-Spektren nachgewiesen ist. Diese Daten sind in der HITRAN-Datenbank [5] auch für die Öffentlichkeit zugänglich. Strittig ist, ob und in welchem Umfang die Temperatur der Erde durch CO2 beeinflusst wird (H. Harde, 2014 [6]; H. Harde, 2017 [7]). Der erste Teil dieser Fragen, ob auch kältere Treibhausgase zu einem Temperatur-Anstieg eines wärmeren, beheizten Körpers beitragen können, soll durch eine neue experimentelle Untersuchung geklärt werden.

Zunächst muss man sich bewusst machen, dass Energie in ganz verschiedenen Formen auftreten kann und in der Atmosphäre durch eine Reihe unterschiedlicher Mechanismen transportiert wird. Dazu gehören vertikale und horizontale Luftströmungen, Verdampfung, Kondensation und Gefrieren von Wasser, Wärmeleitung der Luft aber auch Wärmestrahlung (IR-Strahlung). Der Treibhauseffekt betrifft nur den letzten Fall, den Austausch von Wärmestrahlung der Erdoberfläche mit verschiedenen Schichten der Atmosphäre und den dort vorhandenen IR-aktiven Bestandteilen. Diese IR-aktiven Komponenten der Atmosphäre können Treibhausgase, Aerosole oder Wolken sein.

2. Versuchsaufbau

Man benötigt also einen Versuchsaufbau, der einen Strahlungstransport von A nach B realisiert, was in dem vorgestellten Experiment durch eine 30 °C warme und eine -1,8 °C kalte Fläche ermöglicht wurde, die einen Abstand von 1,11 m voneinander besitzen. Im Gegensatz zu den o.g. Treibhaus-Experimenten wird hier keine Bestrahlung mit einer Lichtquelle vom sichtbaren bis zum mittleren infraroten Spektralbereich verwendet, sondern Wärmestrahlung untersucht, die auch bei der Erde und der Atmosphäre in dieser Form auftritt. Wärmeströme, die nicht zum Strahlungsaustausch gehören, müssen durch entsprechende Maßnahmen verhindert oder minimiert werden.

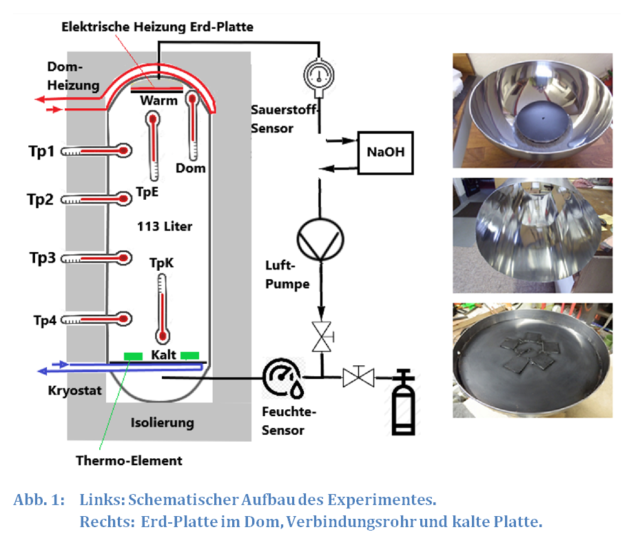

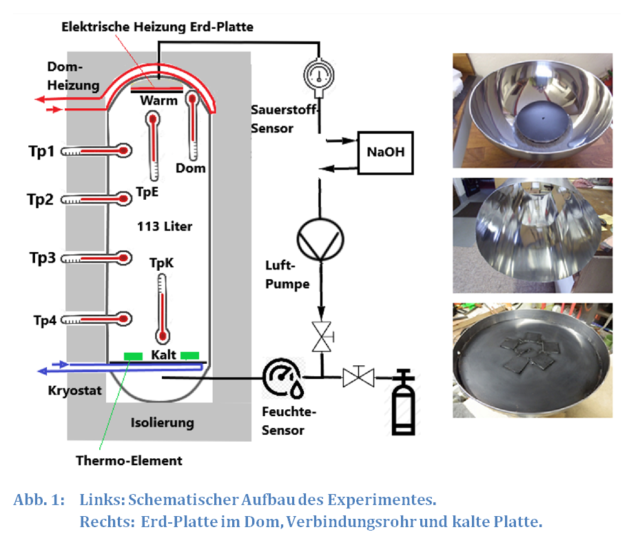

Abb. 1 zeigt den schematischen Aufbau der Apparatur und die wichtigsten Bauteile. Ihre senkrechte Aufstellung, mit der warmen Fläche in oberster Position, erzeugt eine stabile Luftschichtung, die per se eine vertikale Luftbewegung (Wärmestrom durch Konvektion) verhindert (kalte Luft steigt nicht auf).

Ein möglicher Energietransport mittels Wasserdampf (latente Wärme) kann ausgeschlossen werden, da entweder getrocknete Luft oder Argon als Gasfüllung eingesetzt wird (siehe Anhang).

Wärmeleitung, sowohl durch die Gefäßwand oder längs der Gasphase, lässt sich nicht verhindern, wohl aber minimieren. So befindet sich die warme Fläche (Erd-Platte) in einem halbkugelförmigen Raum (Dom) (Abb. 1), der von außen mit einem Vinylschlauch umwickelt ist. Durch diesen Schlauch fließt Wasser mit einer konstanten Temperatur von 29,6 °C. Wegen der geringen Temperatur-Differenz von 0,4 K zwischen Dom und Erd-Platte gibt es in diesem Bereich auch nur eine geringe Wärmeleitung.

Die konstante Dom-Temperatur ist essentiell für diese Untersuchung und wird durch eine konstante elektrische Heizung des Wassers für die Dom-Heizung erreicht.

Die hohe Temperatur des Domes garantiert eine gute thermische Isolierung der Erd-Platte, aber ist auch gleichzeitig eine Orientierungshilfe für die Auswertung der Versuche. Der Dom hat eine polierte Edelstahloberfläche, wodurch sie weitgehend unempfindlich für Wärmestrahlung ist. Eine mögliche Erwärmung der schwarzen Erd-Platte nach Zugabe von Treibhausgasen lässt sich dann visuell am zunehmenden Abstand zur Dom-Temperatur erkennen (Abb. 2 und folgende).

Die Erd-Platte hat von vornherein die höchste Temperatur im Versuchsaufbau (0,4 K höher als der Dom und wesentlich höher als alle anderen Teile der Apparatur und auch höher als die Probengase). Dadurch ergibt sich ein kleiner, unvermeidbarer Wärmestrom von der Erd-Platte hauptsächlich zum Dom aber auch zur Gefäßwand und zur kalten unteren Platte. Erwärmt sich die Erd-Platte, nimmt dieser Wärmeverlust noch zu. Ohne diese Störung wäre ein noch höherer Temperatur-Anstieg möglich, als er hier beobachtet wurde. Der Wärmestrom zum Dom lässt sich verringern, indem man die Dom-Temperatur während eines Versuches parallel zur Erd-Temperatur erhöht. Das soll bei der vorliegenden Untersuchung jedoch nicht geschehen, um jeden Verdacht einer Manipulation kategorisch auszuschließen.

Die Wärmeleitung der Gase, zwischen warmer und kalter Platte, ist von Natur aus sehr gering, da Gase schlechte Wärmeleiter sind. Trotzdem könnte hier ein Einfluss der unterschiedlichen Wärmeleitfähigkeiten von Luft und den Probengasen vermutet werden. Das ist ein ernstzunehmendes Argument, das durch Kontroll-Experimente mit Edelgasen entkräftet werden kann.

Die Methodik der Versuche orientiert sich an der erfolgreichen Untersuchung zum „Ditfurth-Experiment“, das sich durch eine hohe Transparenz auszeichnet (M. Schnell, 2020 [4]). Es geht nicht um eine einzige Temperatur-Angabe, nach dem Motto „Friss oder Stirb“, sondern um eine lange Beobachtungsphase mit mehr als siebzig Temperatur-Daten, die in den Diagrammen auf einer Zeitachse von links nach rechts verfolgt werden können.

Die ersten 90 Minuten, vor Zugabe eines Probegases, sollen zeigen, dass sich die Erd-Platte im thermischen Gleichgewicht befindet. Die elektrische Heizung der Erd-Platte entspricht dem Wärmeverlust durch Wärmestrahlung und Wärmeleitung (Input = Output). Die Erd-Platte hat dabei eine konstante Temperatur von 30,0 °C. Die Anzeige-Genauigkeit beträgt ±0,13 K, d.h. um diesen Wert verändert sich die digitalisierte Temperaturanzeige der Erd-Platte bei Erwärmung. Eine Temperatur-Änderung von ±0,13 K wird deshalb als LOD (limit of detection) gewertet. Der Treibhauseffekt gilt als nachgewiesen, wenn bei einem Experiment ein deutlicher Temperatur-Anstieg ∆TpE >> LOD registriert wird, also ein Mehrfaches des LOD-Wertes.

Nach Ablauf der 90-minütigen Messungen mit der luftbefüllten Apparatur werden die Probengase mit einer Geschwindigkeit von 1 l/min von unten in die Apparatur eingeleitet. Danach wird für kurze Zeit mit einer Aquarien-Pumpe die Innenluft aus dem oberen Gasrohr abgesaugt und in das untere Gasrohr (in den Totraum unterhalb der kalten Platte) wieder eingeleitet (Abb. 1). Durch dieses Umpumpen werden die Probengase aus dem Totraum verdrängt und eindeutig zwischen warmer und kalter Platte positioniert. Die Zugabe der Probengase und das Umpumpen sind die einzigen äußeren Eingriffe während eines Experimentes. Von nun an wird nur noch beobachtet, wie sich die Messwerte verändern.

3. Wirkung der Probengase bei konstanter Heizung der Erd-Platte

3.1 Das CO2-Experiment

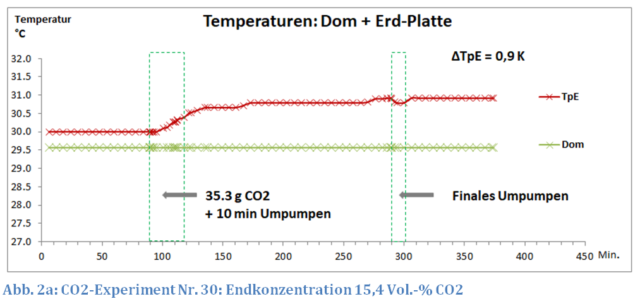

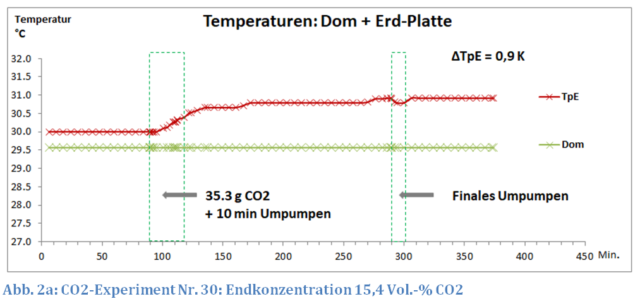

Eine Messung mit CO2 als Probengas bei einer Konzentration von 15,4 Vol.-% in trockener Luft ist in Abb. 2a wiedergegeben.

Zum Vergleich: bei dieser Konzentration und einem Abstand der Platten von 1,1 m entspricht dies etwa der Absorption und Emission, wie dies von 100 ppm CO2 (ohne andere Treibhausgase) in der Atmosphäre zu erwarten wäre.

Unmittelbar nach dem Einleiten und Umpumpen, befindet sich das CO2 im Bereich des Tp4-Sensors bei rund 12 °C, also 18 K kälter als die Erd-Platte (siehe Abb. 2b). Trotzdem reagiert die weit entfernte Erd-Platte nur wenige Minuten nach Beginn der CO2-Einleitung mit einem deutlichen Temperatur-Anstieg. Diese CO2-Schicht dehnt sich langsam durch Diffusion in der gesamten Apparatur aus, wobei immer wärmere Regionen erreicht werden. Die Erd-Platte reagiert hierauf mit einem kontinuierlichen Temperatur-Anstieg, der bei 290 Minuten ein Maximum von ∆TpE = 0,9 K erreicht. Auch ein weiteres 10-minütiges finales Umpumpen verändert diesen Wert nicht mehr.

An dieser Stelle soll erinnert werden, dass bei der Überprüfung des Ditfurth-Experimentes ein finales Umpumpen ein „KO“-Kriterium war. Der ursprüngliche Temperatur-Anstieg verschwand beim Umpumpen, dem Homogenisieren der Gasmischung, und das Ditfurth-Experiment konnte als fake entlarvt werden (M. Schnell, 2020 [4]).

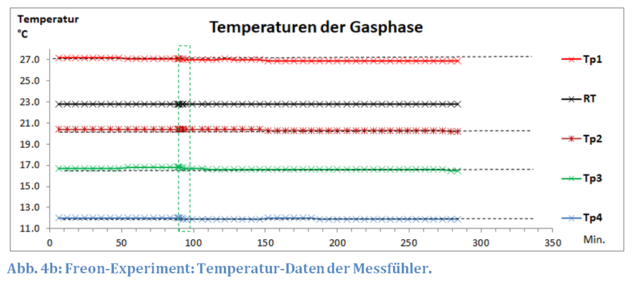

Offensichtlich ist das neue experimentelle Konzept nicht mit den vielen „Treibhaus-Experimenten“ in der Art von Ditfurth & Co. vergleichbar. Auch bei den Temperaturen des Gasraumes zwischen warmer und kalter Platte gibt es gravierende Unterschiede. Über die gesamte Messzeit zeigen die Sensoren eine konstante Temperatur und einen stabilen Gradienten von 27,3 °C bei Tp1 bis 12,6 °C bei Tp4. Die Zugabe von CO2 führt zu keiner signifikanten Temperatur-Änderung an diesen Messpunkten (Abb. 2b).

Die konstanten Temperaturen der Gasphase sollten aber nicht überbewertet werden, da die Dom-Temperatur absichtlich konstant gehalten wurde, um Manipulationsvorwürfe zu vermeiden.

Würde man die Dom-Temperatur im gleichen Abstand zur Temperatur der Erd-Platte erhöhen, würden auch die Temperaturen der benachbarten Luftschichten leicht ansteigen. Das ist allerdings eine andere Geschichte und Gegenstand der laufenden experimentellen Untersuchung zur Klimasensitivität von CO2.

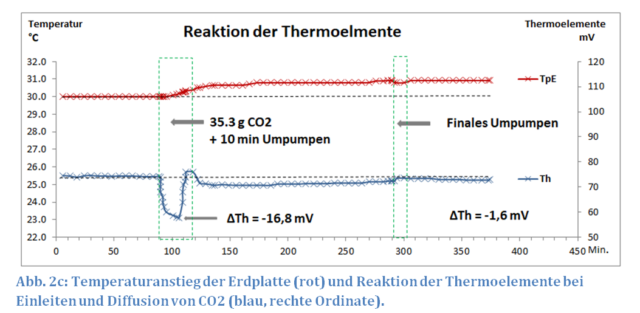

Reaktion der Thermoelemente

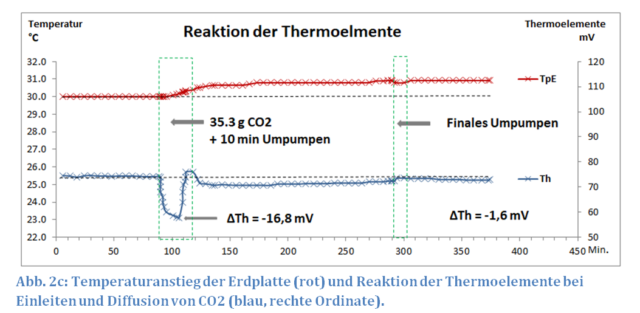

Gemäß dem Seebeck-Effekt entsteht in einem Stromkreis aus zwei verschiedenen elektrischen Leitern eine elektrische Spannung, die u.a. von der Temperaturdifferenz zwischen den Kontaktstellen abhängig ist. Auf die kalte Platte wurden fünf Thermoelemente geklebt, die auf ihrer Unterseite von der Temperatur der kalten Platte und auf ihrer Oberseite von den Wärmeströmungen in der Röhre beeinflusst werden. Diese Elemente sind in Reihe geschaltet, und ihre Klemmspannung wird von einem empfindlichen Voltmeter registriert.

Beim CO2-Einleiten entsteht in den ersten Minuten ein „CO2-See“ oberhalb der kalten Platte, der wegen eines Schichtungs-Effektes und einer geringeren Wärmeleitfähigkeit von CO2 zu einem Wärmestau führt (M. Schnell, 2020 [4]). Das hat zur Folge, dass der kalten Platte weniger Wärme von der wärmeren Röhre (im Bereich von Tp4) zufließt. Die Oberseite der Thermoelemente kühlt sich ab und die ursprüngliche Spannung von Th = 74,6 mV geht um ∆Th = -16,8 mV zurück. Beim Umpumpen wird die CO2-Schicht etwas angehoben und wärmere Luft umströmt die Thermoelemente, wodurch die Spannung kurzzeitig bis auf Th = 76 mV wieder ansteigt. Nach Beendigung des Pumpens bildet sich erneut ein leichter Wärmestau aus, und die Spannung sinkt auf Th = 70,7 mV. Im Verlauf der Diffusion kommt es dann zu einer gleichmäßigen Vermischung von CO2 und der Innenluft, wodurch der Schichtungs-Effekt beseitigt wird und sich die Spannung der Thermoelemente Th langsam dem Ausgangswert von Th = 74,6 mV annähert (Abb. 2c). Die finale Differenz von ∆Th = -1,6 mV ist der geringeren Wärmeleitung einer 15%igen CO2-Luft-Mischung geschuldet.

Die Reaktion der Thermoelemente zeigt, dass man die Einleitung schwerer Gase und ihre anschließende Diffusion sehr gut verfolgen und somit auch dokumentieren kann. Diese Eigenschaft wird sich später beim Argon-Versuch bezahlt machen.

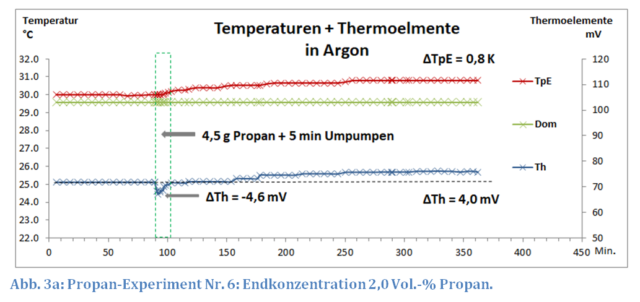

3.2 Das Propan-Experiment

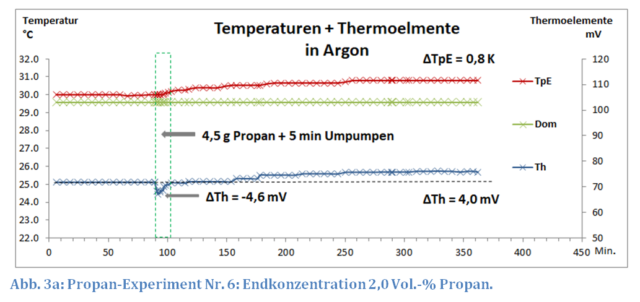

Propan ist ein wesentlich stärkeres Treibhausgas als CO2. Man erreicht mit nur 13 % der CO2-Menge (4,5 g Propan vs. 35,3 g CO2 bzw. 2 Vol.-% Propan vs. 15,4 Vol.-% CO2) einen ungefähr gleichen Temperatur-Anstieg von ∆TpE = 0,8 K wie beim CO2 (Abb. 3a).

Der Versuch wurde in Argon durchgeführt, um den Einfluss der Wärmeleitung auf die Reaktion der Thermoelemente zu untersuchen. Argon hat eine kleinere Wärmeleitfähigkeit als Luft (0,018 vs. 0,026 W/(m∙K)) aber eine etwas größere als Propan (0,015 W/(m∙K)). Demzufolge verursacht die Einleitung von Propan auch nur einen geringen Rückgang der Spannung der Thermoelemente ∆Th = 4,6 mV, der schon beim Umpumpen wieder den Ausgangswert erreicht, was zu beweisen war.

Während der Diffusion des Propans steigt die Spannung der Thermoelemente Th jedoch weiter an und ist am Ende sogar 4,3 mV höher als der Anfangswert, obwohl mit Propan die Wärmeleitung zwischen Wand und kalter Platte weiter leicht reduziert wird und eher eine niedrigere Spannung zu erwarten wäre. Dieser Anstieg von Th ist nur durch die Emission von IR-Strahlung durch Propan in Richtung der kalten Platte zu erklären, da ein Treibhausgas nicht nur Wärmestrahlung absorbiert, sondern in gleichem Maße aufgrund seiner Eigentemperatur auch wieder emittieren kann. Gleichzeitig kühlt sich dabei das Gasgemisch leicht ab (siehe Abb. 3b).

Um einem Missverständnis vorzubeugen, diese zusätzliche Ausstrahlung und die Abkühlung der Gasphase ist ein Phänomen der Labor-Experimente. Dies wird durch die Konstruktion der Apparatur verursacht und soll nur als ein weiterer Beweis des Treibhauseffektes verstanden werden. Dieser Effekt wird durch die geringe Größe der Erd-Platte im Vergleich zum Dom und Röhren-Durchmesser verursacht. Die anderen (verspiegelten) Flächen senden nur eine geringe Wärmestrahlung aus, die in diesem Fall vom Propan übertroffen wird.

In der Atmosphäre gibt es solche Energieströme nicht. Die Temperaturen der Troposphäre werden hauptsächlich durch den Druckgradienten der Atmosphäre (adiabatische Temperaturänderung von Luftpaketen) und Wetterphänomenen bestimmt. Ob und in welchem Umfang Treibhausgase einen Einfluss auf die Temperatur der Troposphäre haben, ist umstritten und kann nicht durch einfache Labor-Experimente entschieden werden.

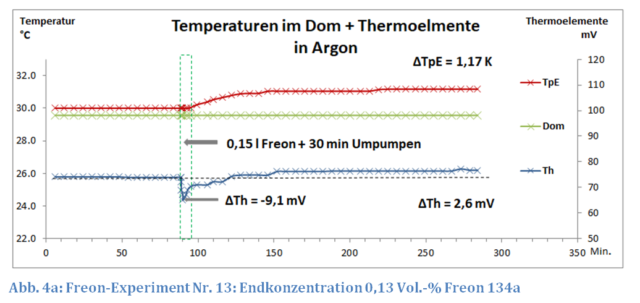

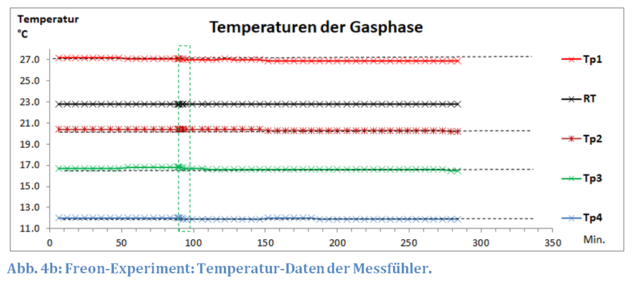

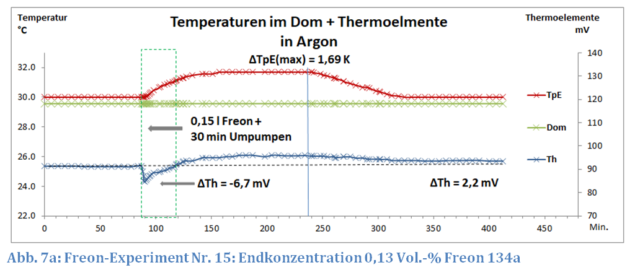

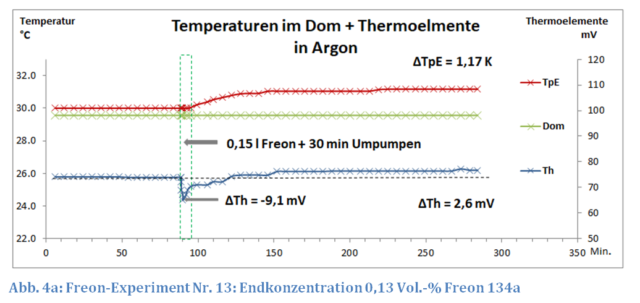

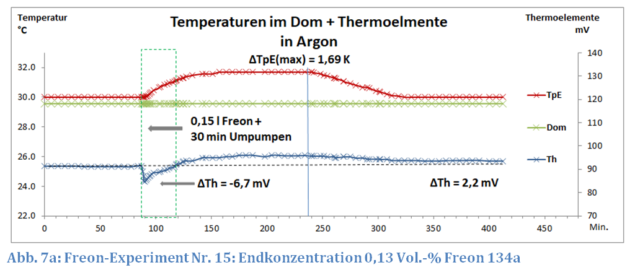

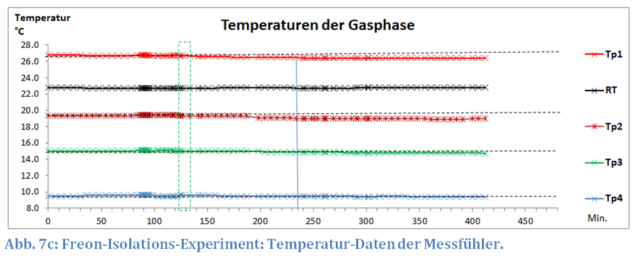

3.3 Das Freon-Experiment

Das Freon-Experiment (Abb. 4a u. 4b) zeigt sowohl bei den Thermoelementen als auch bei den Temperaturen ähnliche Ergebnisse wie das Propan-Experiment. Bemerkenswert ist die sehr kleine Menge an Freon 134a, die mit 0,13 Vol.-% bereits einen Temperatur-Anstieg von knapp 1,2 K verursacht. Die Wärmeleitung von Gasmischungen geringer Konzentration errechnet sich in guter Näherung über den Molenbruch. Eine relevante Veränderung der mechanischen Wärmeflüsse ist angesichts der kleinen Freon-Konzentration bei vollständiger Durchmischung nicht zu erwarten.

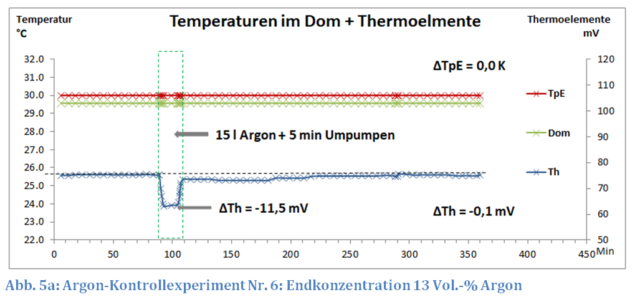

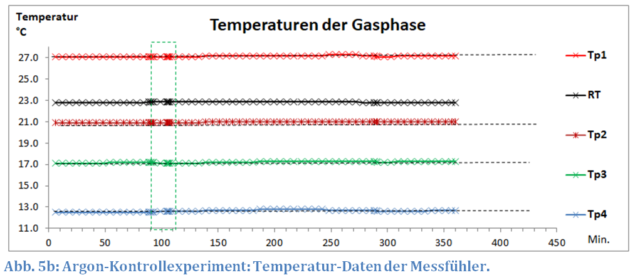

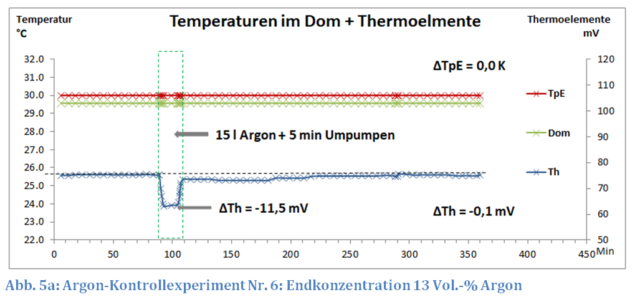

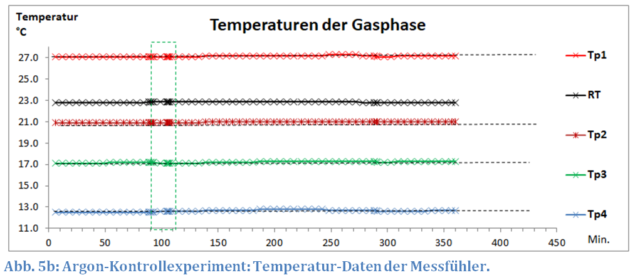

3.4 Das Argon-Kontrollexperiment

Die Zugabe von Argon als Probengas in die mit trockener Luft befüllte Apparatur hat keinen messbaren Einfluss auf die Temperaturen der Erd-Platte und der Luft. Dass überhaupt Argon eingeleitet wurde, wird am vorübergehenden Rückgang der Spannung der Thermoelemente ∆Th = -11,5 mV erkennbar (Abb. 5a). Beim Einleiten bildet sich eine Argon-Schicht, die die Wärmeleitung im Bereich der Thermoelemente durch einen Schichtungseffekt erheblich verringert. Umpumpen und Diffusion beseitigt die Schichtung, und die Spannung der Thermoelemente Th erreicht wieder annähernd den Ausgangswert (siehe Abb. 5b) wie bereits beim CO2 beobachtet (Abb. 2c). Damit wird nachgewiesen, dass der Spannungsrückgang ∆Th durch einen Schichtungs-Effekt beim Einleiten schwerer Gase verursacht wird.

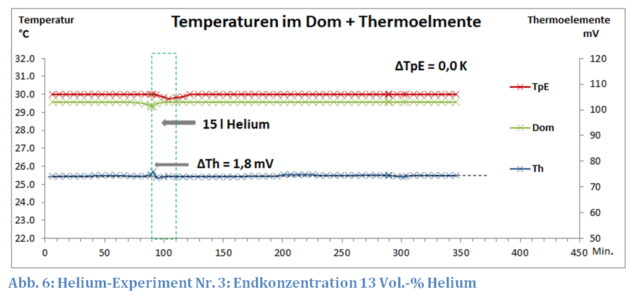

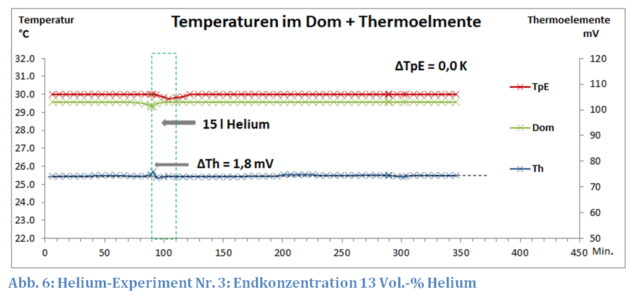

3.5 Das Helium-Kontrollexperiment

Da Helium leichter als Luft ist, wird es von oben unterhalb der Erd-Platte eingeleitet. Ein Umpumpen ist hier nicht erforderlich, da es bei der Erd-Platte keinen Totraum gibt.

Helium hat eine wesentlich höhere Wärmeleitfähigkeit als Luft (0,157 vs. 0,026 W/(m∙K)), trotzdem hat die Temperatur der Erd-Platte auch nach 350 Minuten immer noch den Anfangswert (Abb. 6). Ein deutliches Zeichen, dass die Wärmeleitung der Gase keine Rolle spielt. Damit lässt sich Wärmeleitung als mögliche Erklärung der oben geschilderten Temperatur-Anstiege in Gegenwart von Treibhausgasen endgültig ausschließen.

Nur direkt beim Einleiten von Helium kommt es zu einem leichten Temperatur-Rückgang von TpE, da das kalte Helium an der Erd-Platte vorbeiströmt.

Bemerkenswert sind die Thermoelemente, die bei diesem Versuch, keine Reaktion zeigen. Da das Helium von oben, weit von den Thermoelementen entfernt, eingeleitet wird, kommen diese Sensoren erst nach vollständiger Diffusion in Kontakt mit dem Edelgas. Es gibt somit keinen Schichtungs-Effekt und selbst die 13 %-ige Helium-Luft-Mischung am Ende des Versuches macht sich bei den Thermoelementen nicht bemerkbar.

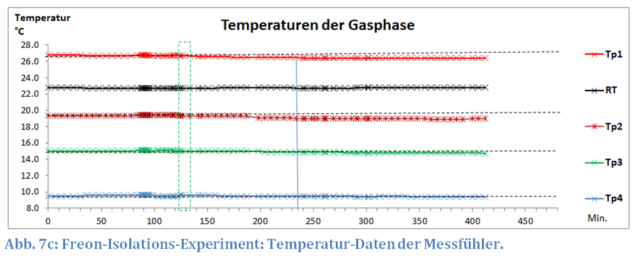

4. Wirkung von Freon 134a bei konstanter Temperatur der Erd-Platte

Bis zur 235. Minute sieht der Versuch Freon Nr. 15 wie eine Wiederholung des Freon-Experimentes Nr. 13 aus (siehe Abb. 7a bis 7c). Aber es gibt einen Unterschied: Die kalte Platte ist rund 10 K kälter als beim vorherigen Experiment. Trotz der geringeren Temperatur der kalten Platte (TpK = -11.4 ° vs. TpK = -1,8 °C) ist der Temperatur-Anstieg ∆TpE der Erd-Platte um 0,55 K größer als beim Experiment 13 (∆TpE = 1,69 vs. ∆TpE = 1,17 K).

Schon früher wurde auf diesen scheinbar paradoxen Zusammenhang hingewiesen (M. Schnell, [8]). Die Temperatur der kalten Platte spielt beim Treibhauseffekt eine wichtige Rolle. Bei einem geringeren Temperatur-Unterschied zwischen den Treibhausgasen und dieser Platte wird die Strahlung der Moleküle stärker durch die Hintergrundstrahlung der kalten Platte überlagert (ähnlich der Hintergrundstrahlung, die durch Wolken in der Atmosphäre verursacht wird, siehe auch H. Harde [7]). Bei identischen Temperaturen gibt es keine Erwärmung der Erdplatte durch das IR aktive Gase. Ein Phänomen, das weiterer experimenteller Untersuchungen bedarf, aber für die aktuelle Fragestellung, bei der es um den prinzipiellen Nachweis des Treibhauseffekts geht, keine Rolle spielt.

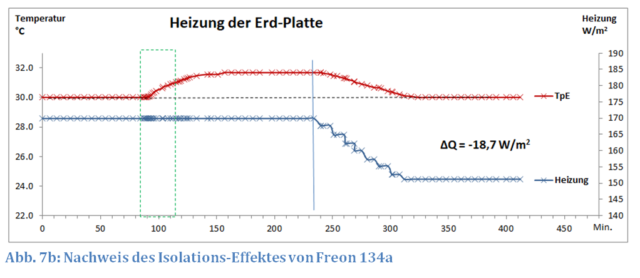

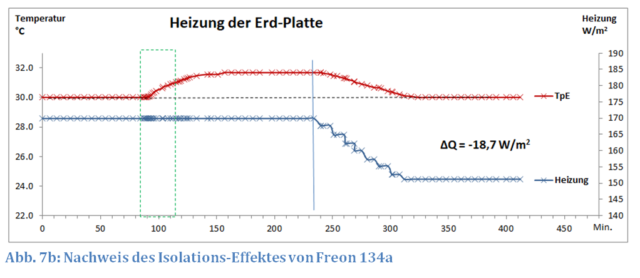

Nach Feststellung der maximalen Temperatur-Erhöhung ∆TpE(max) wird die Heizung schrittweise solange reduziert, bis die Erd-Platte wieder die Anfangs-Temperatur von 30 °C hat. Dabei zeichnet sich Freon durch eine besonders gute „Wärmeisolierung“ aus. Die geringe Konzentration von 0,13 Vol.-% Freon (0,15 l) bewirkt, dass die Heizung der Erd-Platte um rund 11 % von 169,9 W/m2 auf 151,2 W/m2 gesenkt werden muss. Dieser Isolations-Effekt wird jedoch nicht durch Wärmeleitung, sondern durch einen veränderten Strahlungsaustausch verursacht (siehe Kap. 5). Erinnert sei hier an das Argon-Kontrollexperiment (Kap. 3.4), das trotz einer 10-fachen Menge an Argon (15 l) keinen Isolations-Effekt zeigte.

Damit weist dieses Experiment überzeugend nach, dass die von Freon ausgehende Wärmestrahlung von der Erd-Platte als sogenannte Gegenstrahlung aufgenommen wird und dies unter den gegebenen experimentellen Bedingungen (Konzentration des Gases, Temperatur, „eingesehener“ Raumwinkel) zu einer entsprechend geringeren Heizleistung von rund 19 W/m2 führt.

5. Die Heizung der Erd-Platte

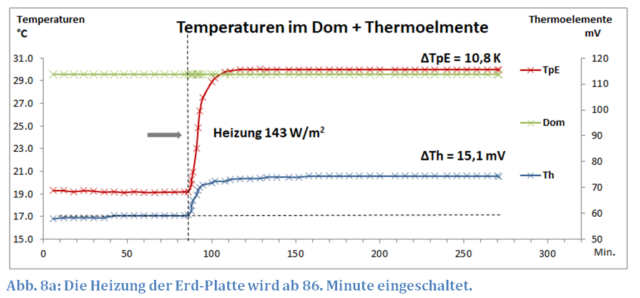

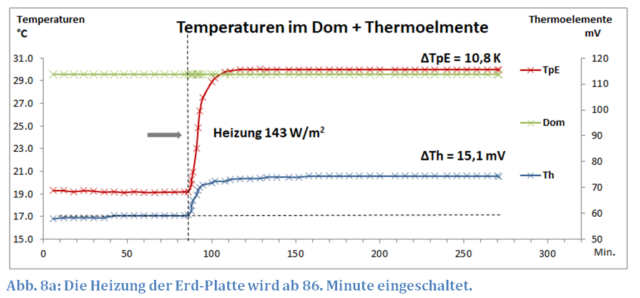

Bei diesem Versuch geht es vordergründig um die Frage: „Wie verändert sich die Temperatur der Erd-Platte, wenn ihre Heizung verzögert eingeschaltet wird?“

Das Experiment beginnt mit den gleichen Vorbereitungen wie in Kap. 2 angegeben, jedoch ohne Heizung der Erd-Platte. Die ersten 86 Minuten zeigen, dass die Erd-Platte im thermischen Gleichgewicht eine Temperatur von 19,2 °C annimmt, wenn ihre Heizung ausgeschaltet ist (Abb. 8a). Sie ist jetzt 10,4 K kälter als ihre unmittelbare Umgebung, dem Dom, der dank seiner Wasser-Heizung 29,6 °C warm ist. Das ist vergleichbar mit der Abkühlung von Körpern, die einem kalten Himmel ausgesetzt sind, was in unseren Breiten z.B. als Strahlungsfrost bekannt ist.

Das Experiment, das man als einen weiteren Test bezeichnen kann, soll nachweisen, dass die Temperatur der Erd-Platte hauptsächlich durch Strahlungsaustausch I mit der 1,11 m entfernten kalten Platte bestimmt wird.

Der Strahlungsaustausch I beschreibt den Wärmeverlust eines warmen Körpers in einer kalten Umgebung. Es ist ein Wärmeverlust, der ausschließlich durch einen gegenseitigen Austausch von Wärmestrahlung verursacht wird. Beim Einschalten der Heizung steigt die Temperatur der Erd-Platte und damit erhöht sich auch ihre Wärmestrahlung. Die Thermoelemente reagieren auf diese zusätzliche Wärmestrahlung mit einem Anstieg der Spannung ∆Th um 15,1 mV, synchron zur Temperatur der Erd-Platte.

Aus dieser Beobachtung lässt sich die Reaktion der Thermoelemente wie folgt erklären:

- Ein Anstieg der Spannung Th zeigt die von oben kommende Wärmestrahlung.

- Ein Absinken von Th zeigt vor allem die geringe Wärmeleitung schwerer Gase bzw. einen Schichtungs-Effekt.

Die Temperatur der ungeheizten Erd-Platte von 19,2 °C ergibt sich aus dem Wärmeverlust durch Strahlungsaustausch I (hauptsächlich mit der kalten Platte) und Zufuhr von Wärme Q aus seiner wärmeren Umgebung (Dom).

Beim Einschalten der Heizung verändern sich die Temperatur-Differenzen zwischen Erd-Platte, Dom und kalter Platte, wodurch der Wärmestrom Q abnimmt und der Strahlungsaustausch I zunimmt. Es stellt sich ein neues Gleichgewicht bei der Erd-Platten-Temperatur von 30 °C ein.

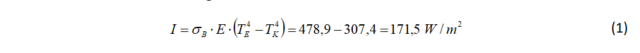

Unter der Annahme, dass bei nahezu gleichen Temperaturen von Dom und Erd-Platte der Wärmestrom Q vernachlässigt werden kann, lässt sich der Strahlungsaustausch I mit der Stefan-Gleichung berechnen (Wikipedia [8]).

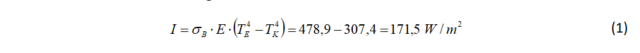

Für E=1 (Emissionsaustauschgrad), TE = 303,15 K (30 °C) und TK = 271,35 K (1,8 °C) errechnet sich eine Intensität I für den Strahlungsaustausch mit B als Boltzmann-Konstante:

Tatsächlich wird für die Temperatur der Erd-Platte von 30 °C aber nur eine elektrische Heizleistung von 143 W/m2 benötigt, also nur 83 % des theoretischen Strahlungsaustausches I. Dieses bestätigt sich auch weitgehend, wenn die kalte Platte auf -11,4 °C gekühlt wird. In diesem Fall beträgt wurde eine Heizleistung von 169,9 W/m2 benötigt, entsprechend 80% des theoretischen Wertes. Diese so ermittelten Leistungen sind ein Qualitätsmerkmal der Apparatur und zeigen, wie die Apparatur auf die Wärmestrahlung der kalten Platte reagiert.

Die Abweichung vom theoretischen Wert entsteht durch einen zweiten Strahlungsaustausch I‘ der Erd-Platte mit der Röhre. Die Röhre hat eine höhere Temperatur als die kalte Platte, wodurch die Erd-Platte weniger Wärme in dieser Richtung verliert.

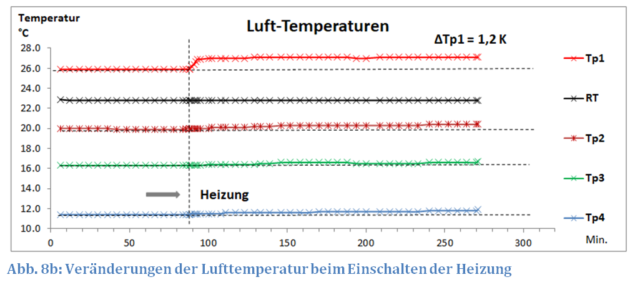

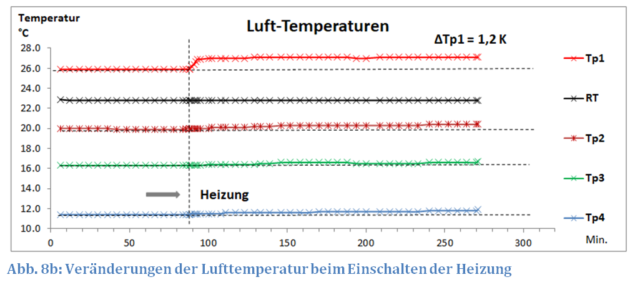

Die Messungen der Lufttemperatur zeigen, dass sich beim Einschalten der Heizung hauptsächlich die Luft in der Nähe der Erd-Platte, im Bereich der Messstelle Tp1, erwärmt (Abb. 8b).

6. Fazit

Der Versuchsaufbau des Experimentes kann als ein Modell bezeichnet werden, das den Strahlungsaustausch der Erdoberfläche unter einer Wolkenschicht abbildet. Die gewählten Temperaturen einschließlich eines Temperatur-Gradienten zwischen Erd- und kalter Platte können auch auf der Erde und in der Atmosphäre gefunden werden.

Andere Parameter wie die Sonnenstrahlung, der Einfluss von Wasserdampf, ein Druckgradient, vertikale und horizontale Luftströmungen, Wärmetransport durch latente Wärme und viele Wetter-Phänomene werden von dem Versuchsaufbau nicht berücksichtigt. Es lassen sich somit auch keine Global-Temperaturen der Erde ableiten oder gar vorhersagen.

Alle ermittelten Temperaturen sind nur Demonstrationen, die zeigen, dass Treibhausgase grundsätzlich zur Erwärmung der Erde beitragen können, dass der Treibhauseffekt physikalisch möglich ist.

Die gezeigten Diagramme sind nur eine kleine Auswahl von rund 50 durchgeführten Experimenten. In allen Fällen, ohne Ausnahme, verursachte die Zugabe eines IR-aktiven Gases eine Temperatur-Erhöhung der Erd-Platte, trotz konstanter Heizung dieser Platte und konstanter Temperatur ihrer unmittelbaren Umgebung.

Bisher vorgebrachte Einwendungen gegen einen Treibhauseffekt wurden bei den Untersuchungen weitgehend berücksichtigt. So konnte eindeutig gezeigt werden, dass ein beheizter Körper, hier die Erd-Platte, sich auch in Gegenwart deutlich kälterer Treibhausgase erwärmt. Es wurde demonstriert, dass der Erwärmungs-Effekt sowohl von der Gas-Temperatur als auch von der Art des Gases abhängt. Auch eine sehr kleine Menge eines IR-aktiven Gases spricht nicht gegen den Treibhauseffekt, der aufgrund der langen Ausbreitungswege von Strahlung in der Atmosphäre auch dann noch einen deutlichen Einfluss verursachen kann.

Die Gastemperaturen sind kleiner als die der Erd-Platte und verändern sich während eines Versuches nicht oder sinken sogar leicht. Die Erwärmung der Erd-Platte kann somit nicht durch einen Wärmestrom aus ihrer Umgebung erklärt werden.

Kontrollexperimente mit den Edelgasen Argon und Helium, zeigen, dass die unterschiedliche Wärmeleitfähigkeit dieser Probengase im Vergleich zu Luft keinen Einfluss auf die Temperatur der Erd-Platte haben.

Die Ursache für die Erwärmung der Erd-Platte ist die Fähigkeit der Treibhausgase, nicht nur IR-Strahlung zu absorbieren, sondern aufgrund ihrer Eigentemperatur auch Strahlung auf den gleichen Wellenlängen wieder zu emittieren. Hierdurch wird die bereits vorhandene Gegenstrahlung der kalten Platte weiter verstärkt. Entsprechend der Stefan-Gleichung wird dadurch bei konstanter Temperatur der Erdplatte der Transport von Energie von der Erd-Platte zur kalten Platte verringert. Das hat allerdings ein Ungleichgewicht von Input und Output zur Folge. Wegen der Energieerhaltung muss sich die Erd-Platte erwärmen, um bei einer höheren Temperatur das Gleichgewicht von Input und Output wieder herzustellen.

Vereinfacht ausgedrückt handelt es sich beim Treibhauseffekt im Grunde um eine Art „Isolations-Effekt“, der beim Austausch von Wärmestrahlung wirksam wird (wie unsere Bettdecke, die uns nachts schön warm hält, nur dass wir hier eine Gasschicht haben und von Wärmestrahlung sprechen).

In einigen weiteren Experimenten konnte diese Wärmestrahlung auch für Propan und Freon 134a nachgewiesen und quantifiziert werden.

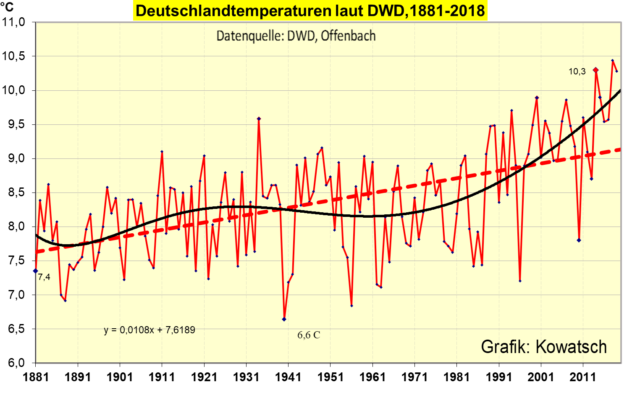

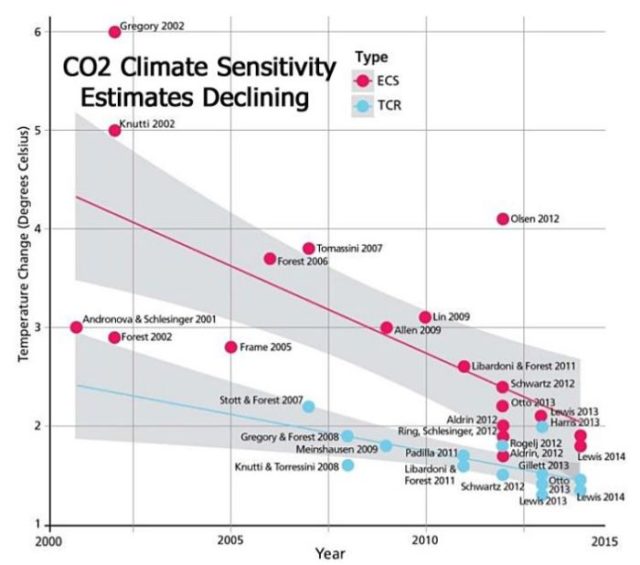

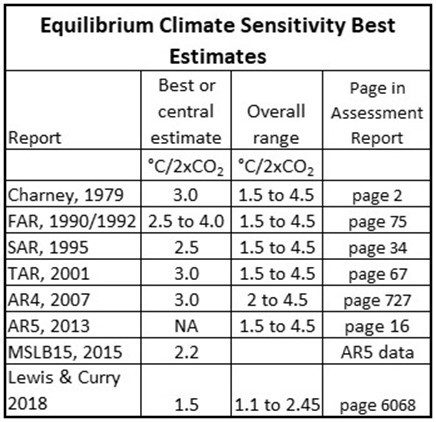

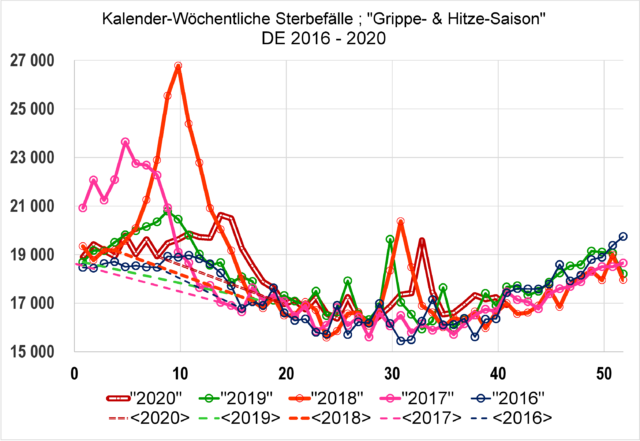

Eine Klimasensitivität kann aus den Versuchen nicht abgeleitet werden, da die Temperatur des Doms, die unmittelbare Umgebung der Erd-Platte, konstant gehalten wurde. Der gefundene Temperatur-Anstieg von 0,9 K bei einer recht hohen CO2 Menge lässt jedoch jetzt schon ahnen, dass die IPCC-Angaben bezüglich der CO2-Wirkung wohl deutlich zu hoch gegriffen sind. Der Streit um die CO2-Klima-Katastrophe wird also weitergehen. Danach lautet die strittige Frage nicht ob, sondern wie hoch der CO2-Treibhauseffekt ist. Das ist jedoch eine andere Geschichte und Gegenstand einer weiteren experimentellen Untersuchung.

Danksagung:

Herrn Ing. Ulrich Tengler danken wir an dieser Stelle für seine Unterstützung und die kostenlose Überlassung des Kryostaten Isotemp 1016S.

Anhang

Versuchsablauf: Am Tag vor einem Experiment wird eine Natronlauge-Kassette zwischen Pumpe und Sauerstoffsensor geschalten und für 4 Stunden die Innenluft mit 1,5 l/min im Kreis gepumpt, wodurch Wasserdampf und CO2 entfernt werden (Siehe Abb. 1). Im Falle von Argon als Gasfüllung, werden 300 Liter Argon von unten in die oben offene Apparatur geleitet, wodurch die Luft verdrängt wird.

Nachts, um 1:30 Uhr werden mit einer Schaltuhr Kühlaggregat, Domheizung und Raum-Thermostatisierung in Betrieb genommen und nach einer gewissen Verzögerung die Heizung der warmen Platte eingeschaltet.

Für die elektrische Heizung der Erd-Platte wird ein digitales Labornetzgerät (KA3005D) im Konstant-Spannungsbetrieb mit einer Auflösung von 0,01 V verwendet. Die erforderliche Heizleistung für die 219 cm2 große Erd-Platte wird mit dem Faktor 45,654 multipliziert, um auf die Heizung einer Fläche von 1 m2 umzurechnen.

Gegen 7:30 Uhr beginnt die computergestützte Aufzeichnung der Messwerte für TpE, TpK und Dom Temperatur im Minutentakt. Alle 6 Minuten wird ein Durchschnittswert der letzten 6 Minuten errechnet und für eine Excel-Tabelle gespeichert. Alle anderen Daten werden manuell in gewissen Zeitabständen abgelesen.

Mit den ersten 90 Minuten wird die Konstanz aller Messwerte innerhalb eines Schwankungsbereiches von ± 0,13 K demonstriert. Gegen 9:00 Uhr wird das Probegas von unten in die Apparatur eingeleitet und danach für kurze Zeit mit einer Aquarium-Pumpe die Luft aus dem Dom abgesaugt und in den unteren Totraum wieder eingeleitet (Umpumpen). Im Falle von CO2 und Propan wird die Menge der Probengase durch Wägung der Gasflaschen ermittelt. Das Volumen von Argon und Helium wird mit Hilfe eines Rotameters ermittelt. Für das Freon 134a wird eine verschließbare Gasmaus mit dem Volumen von 0,15 l verwendet, die zwischen Luftpumpe und Feuchtesensor geschaltet wird.

Interessenten an weiteren Diagrammen oder technischen Details können bei EIKE um einen Kontakt nachfragen.

Referenzen

- N. S. Nahle: Repeatability of Professor Robert W. Wood’s 1909 experiment on the Theory of the Greenhouse,. Biology Cabinet Online-Academic Resources and Principia Scientific International. Monterrey, N. L. , July 5, 2011

http://www.biocab.org/experiment_on_greenhouses__effect.pdf

- J.-E. Solheim: Start des zweitägigen „Al Gore-Experiments“, 10. Internationale Klima- und Energie-Konferenz (10. IKEK), EIKE, Berlin, 12. November 2016

https://eike.institute/2017/02/04/10-ikek-prof-em-jan-erik-solheim-start-des-zweitaegigen-al-gore-experiments/

- H. v. Ditfurth 1977: https://www.youtube.com/watch?v=lORAR1nvfjs

- M. Schnell, 2020: Die falschen Klimaexperimente,

https://eike.institute/2020/11/06/die-falschen-klima-experimente/

- HITRAN-Datenbank: https://www.cfa.harvard.edu/hitran/welcometop.html

- H. Harde, Advanced Two-Layer Climate Model for the Assessment of Global Warming by CO2, Open Journal of Climate Change, Vol. 1, No. 3, Nov. 2014

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.909.4771&rep=rep1&type=pdf

- H. Harde, Radiation Transfer Calculations and Assessment of Global Warming by CO2 , International Journal of Atmospheric Sciences, Volume 2017, Article ID 9251034, pp. 1-30 (2017), https://www.hindawi.com/journals/ijas/2017/9251034/ https://doi.org/10.1155/2017/9251034

- M. Schnell, 2020, Die Hintergrundstrahlung der Wolken und Aerosole

https://eike.institute/2018/06/03/experimentelle-verifikation-des-treibhauseffektes/

- Wikipedia, Strahlungsaustausch: https://de.wikipedia.org/wiki/Strahlungsaustausch

Die englische Version dieses Beitrags ist hier:

Is there a greenhouse effect?