Der Februar verweigert sich der CO2-Klimaerwärmung

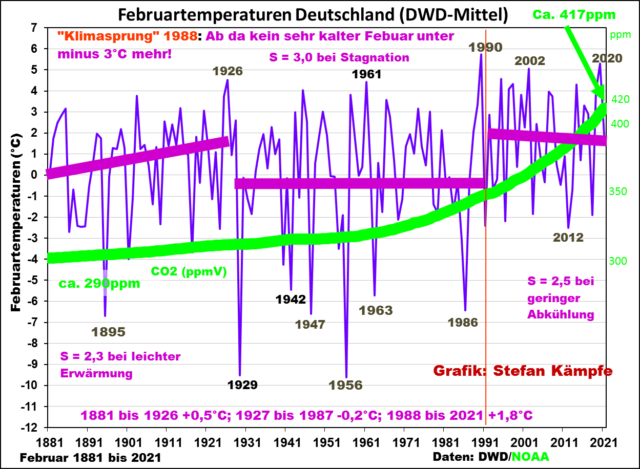

Der Februar 2021 überraschte mit einer atemberaubenden Wetter-Rallye: Nach mit Ausnahme des Nordostens mildem Start raste er durch Schneemassen in den tiefsten Eiskeller, eilte nach Monatsmitte in den warmen Frühling, stürzte aber zum Ende auf ein kühles Vorfrühlingsniveau ab. Sein Temperaturdurchschnitt für Deutschland (DWD-Flächenmittel) lag mit etwa 1,8 Grad Celsius (°C) um ca. 0,3 Kelvin über dem Wert der international gültigen, neuen Referenzperiode von 1991 bis 2020. Im Vergleich zur alten, kälteren Referenzperiode von 1961 bis 1990 war er um ca. 1,4 °C zu mild. Aus den Werten erahnt man bereits einen Temperatursprung, der in den Jahren 1987 bis 1989 stattfand, wie wir im Folgenden zeigen werden. Es handelte sich also keinesfalls um eine kontinuierliche Erwärmung.

Wir fragen uns: Wo ordnet sich dieser Februar 2021 mit seinen 1,8°C in die bis 1881 zurückreichende Klimareihe Deutschlands ein, und wie entwickelten sich die Februar-Temperaturen langfristig? In früheren Beiträgen hatten wir die freilich subjektive Aufteilung längerer Messreihen in Klimasprünge oder Entwicklungsphasen diskutiert.

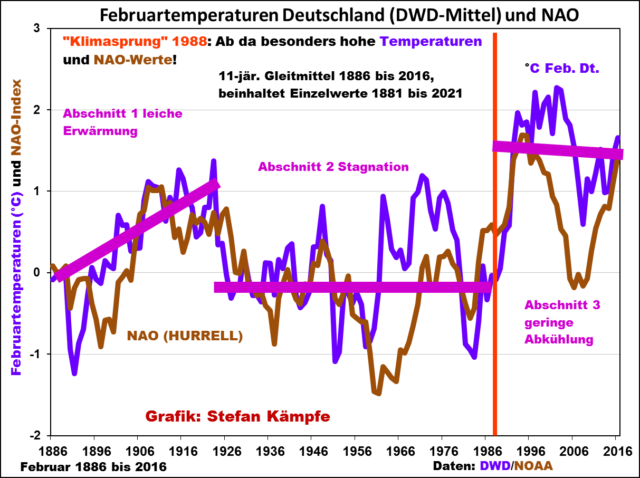

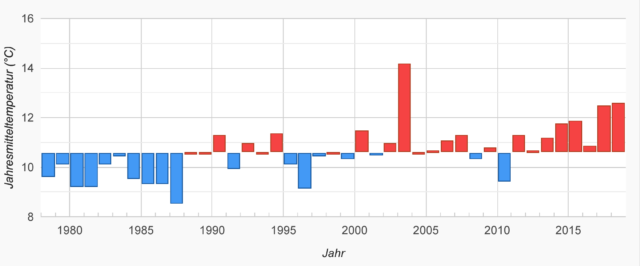

Wir wählen zunächst den DWD-Betrachtungszeitraum seit 1881 und erkennen sofort in Grafik 1, dass die kleine Eiszeit in Mitteleuropa eigentlich erst um 1900 endete. Einzuwenden wäre natürlich, dass um 1900 ein ganz anderes Deutschland mit anderen Grenzen bestand und die Wetterstationen samt ihren Daten von damals mit den heutigen Plätzen nur bedingt vergleichbar sind. Deutschland hatte damals 104 Einwohner pro Quadratkilometer; heuer sind es mit etwa 220 gut doppelt so viele, was erwärmend wirkte. Die Wetterstationen stehen heute in den von Menschen geschaffenen großflächigen Wärmeinseln, auch gab es einst typische ländliche Stationen bei Klöstern oder Forsthäusern am Waldrand oder bei frei stehenden Gutshöfen von Feudalherren. Diese durch Wärmeinseleffekte bedingte Erwärmung lassen wir zunächst außer Betracht. Beim Monat Februar sehen die vom Deutschen Wetterdienst aneinandergereihten Einzelwerte so aus:

Auf der Suche nach Gründen: NAO = Nordatlantische Oszillation. Unter der NAO versteht man in der Meteorologie die Schwankung des Druckverhältnisses zwischen dem Islandtief im Norden und dem Azorenhoch im Süden

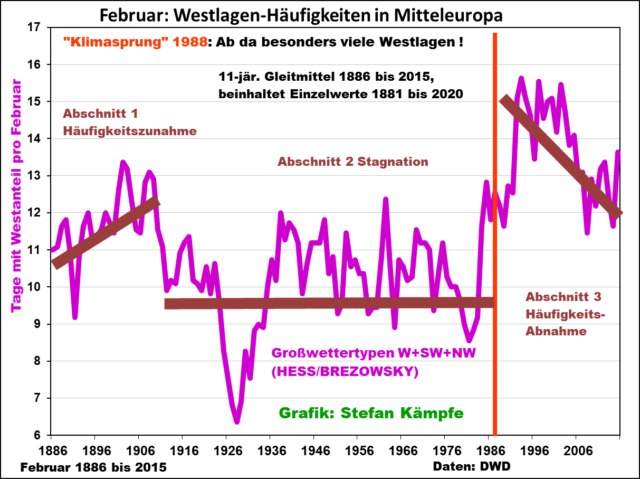

Dieses auffällige Temperaturverhalten in drei Phasen ähnelt grob dem des Januars und lässt sich sehr gut mit dem Verhalten der NAO und der an die NAO gekoppelten Häufigkeit der Großwetterlagen mit Westanteil erklären:

Es ist durchaus typisch, wenngleich nicht immer so lehrbuchhaft eintretend, wie mit dem Wechsel von negativen zu positiven NAO-Werten zur Monatsmitte eine sprunghafte Erwärmung einherging:

Allgemein gilt für den Februar seit 1881: Bei den Standorten der heutigen DWD-Wetterstationen ist es wärmer als bei den viel ländlicheren Standorten der Wetterstationen im Kaiserreich.

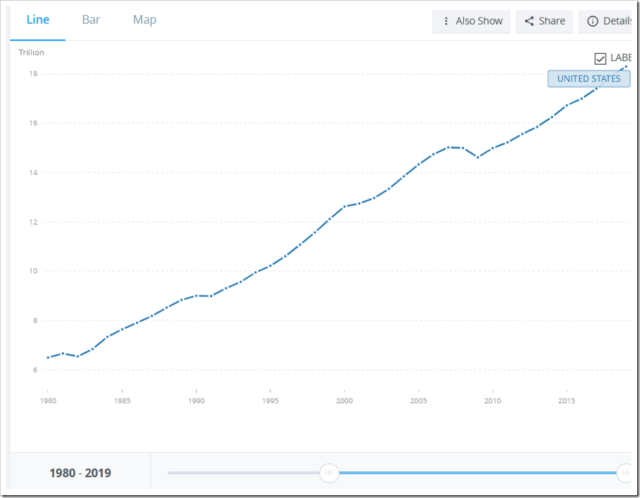

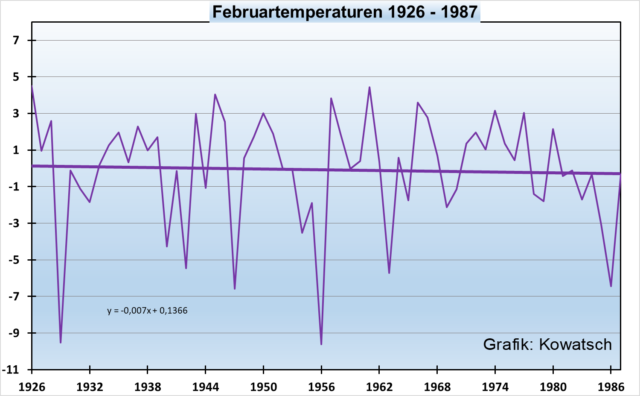

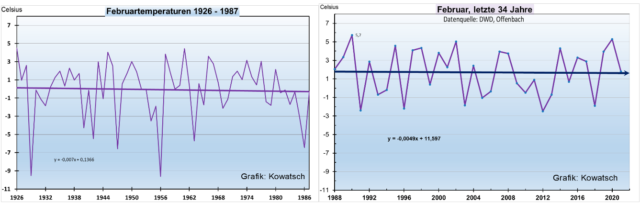

Betrachten wir nun den Zeitraum der beiden letzten Temperatursprünge anhand der DWD-Wetterstation isoliert:

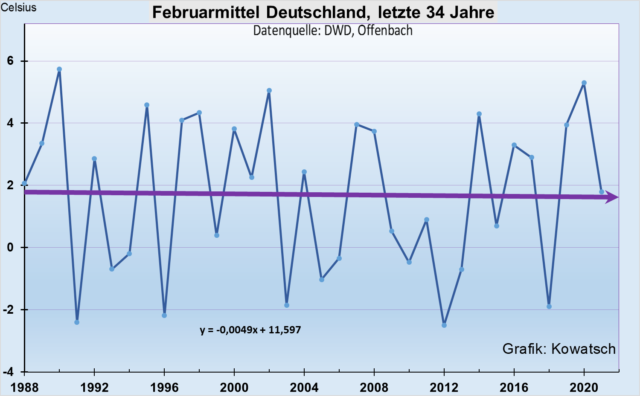

Nach dem Temperatursprung:

Zur besseren Vergleichbarkeit legen wir die beiden Grafiken mit gleichen Intervallen nebeneinander:

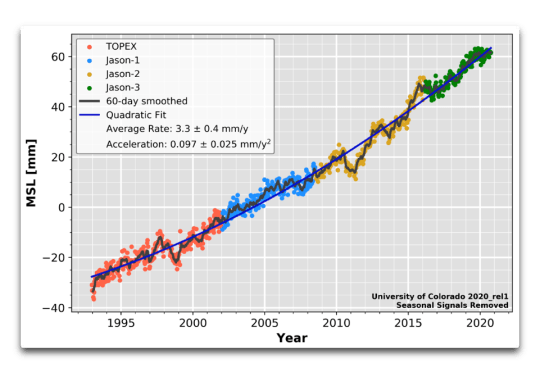

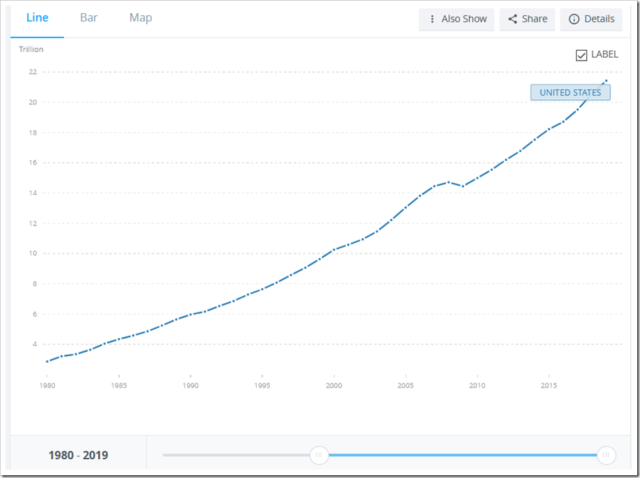

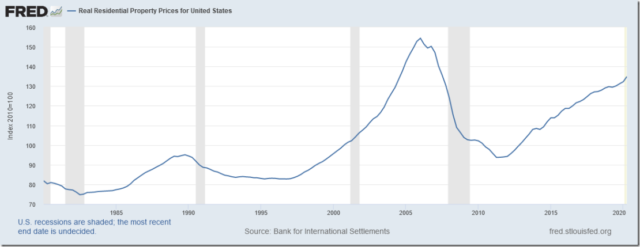

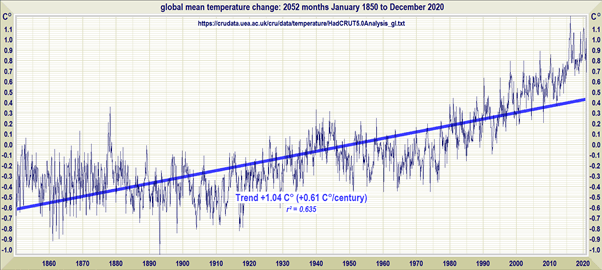

Die CO2-Konzentrationszunahme in der Atmosphäre: Starker Anstieg

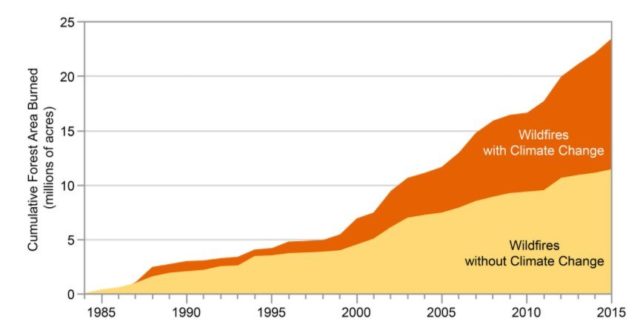

Gebetsmühlenartig werden CO2 und Klimaerwärmung in Zusammenhang gebracht.

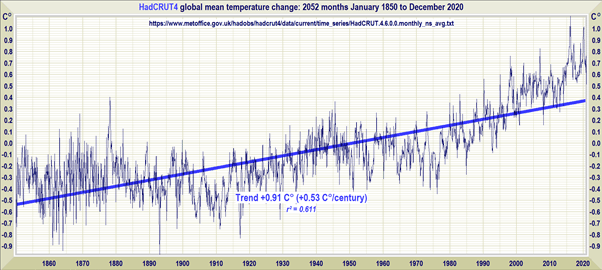

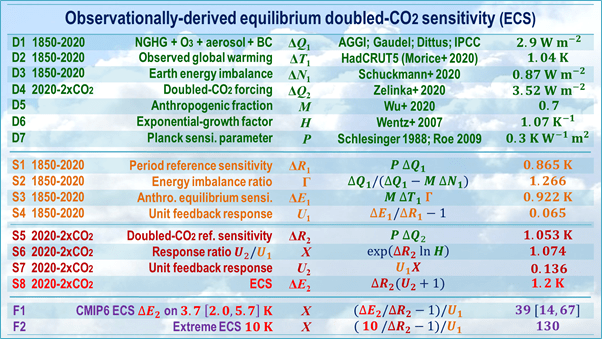

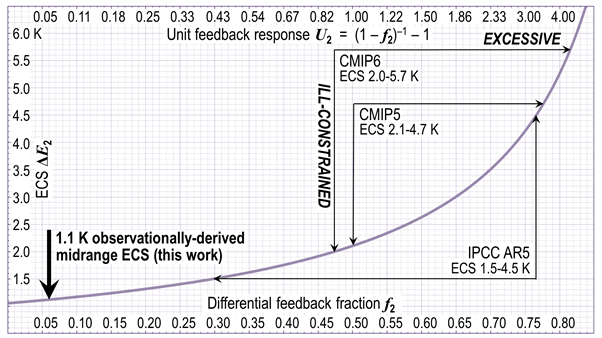

Wir gehen von einer erheblichen CO2-Konzentrationszunahme von mindestens 120 ppm seit 1881 aus, ob diese jedoch ausschließlich anthropogenen Ursprunges ist, wollen wir nicht diskutieren, sondern lediglich die vom PIK-Potsdam behauptete hohe CO2-Kimasensitiviät anhand des Artikels in Frage stellen.

Wir stellen bisher fest:

Die CO2-Kurve der Konzentrationszunahme zeigt im Vergleich zur Entwicklung der deutschen Februartemperaturen keinerlei Ähnlichkeit. Im Gegenteil: Nach dem letzten Temperatursprung nehmen die DWD-Februartemperaturen sogar minimal ab.

Auch für den Temperatursprung im Jahre 1987 auf 1988 kann CO2 nicht verantwortlich sein, das wird allerdings auch nicht behauptet. Der Temperatursprung auf ein wärmeres Plateau hat somit ausschließlich natürliche Ursachen (Zirkulationsverhältnisse – mehr Westwetterlagen bei positiven NAO-Werten).

Aus den Grafiken muss man schließen, dass die vom PIK und vom IPCC verkündete CO2-Klimasensitivität viel zu hoch angesetzt ist. CO2 hat entweder gar keinen Einfluss auf die Temperaturen oder einen nur sehr unbedeutenden. Eine politisch gewollte teure CO2-Einsparung oder CO2-Vernichtung ist wirkungslos.

Der Mensch wirkt mit bei der Temperaturentwicklung durch zunehmende Wärmeinseleffekte (WI). Klima verändert sich seit 4 Milliarden Jahren ohne Zutun des Menschen, es handelt sich um natürliche Klimaänderungen. In der Neuzeit wirkt der Mensch mit durch die ständige Ausbreitung der Wärmeflächen überall auf der Welt. Von Interesse wäre der Temperaturverlauf ohne die wärmenden menschlichen Veränderungen bei den Stationen. Vor allem in den letzten vier Jahrzehnten hat sich die Bebauung in die einst freie Fläche hinein erweitert, derzeit um 60 Hektar täglich und innerhalb der Städte und Gemeinden werden Baulücken weiter geschlossen, damit die Flächenerweiterung ins Umland – eigentlich eine Naturzerstörung – rein statistisch geringer ausfällt, was für die Politik ein Beleg für Naturschutz ist. Derzeit ist ein Siebentel der Gesamtfläche unseres Landes versiegelt. Jede Sekunde wird in der Bundesrepublik Deutschland 5,2 m2 Boden neu als Siedlungs- und Verkehrsfläche beansprucht. Das bringt die Wärme ins Umland der DWD-Wetterstationen. Siehe hier.

Im Winter wärmt zusätzlich die Abwärme der Industrie, der Haushalte und des Verkehrs die Siedlungen und deren näheres Umfeld besonders bei windstillen, kalten Hochdruckwetterlagen auf. Im Umland heizen „Biogas“-, Solar- und Windkraftanlagen ebenfalls. Insgesamt sind die WI- Effekte nach unseren bisherigen Untersuchungen im Winter aber etwas geringer als in den Frühjahrs- und vor allem den Sommermonaten. Jede Straße wirkt vor allem im Sommer wie ein heißes Wärmeband in der Landschaft. Die bäuerliche Trockenlegung der Agrarlandschaft in den letzten 50 Jahren und neuerdings auch im Wald sorgt auch im Sommer für erhöhte Bodentemperaturen außerhalb der Versiegelungsflächen, also auch in der freien Landschaft.

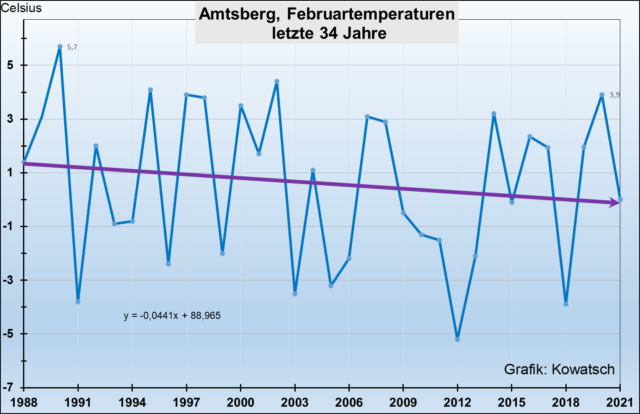

Kurzum, bei den Messstationen des DWD hat der Wärmeeintrag, bedingt durch anthropogene Nutzungsänderungen zugenommen und die Thermometer der Stationen messen diese Zusatzwärme aus den sich ständig vergrößernden Wärmeinseln mit. Natürlich gibt es auch Stationen mit geringen wärmenden Veränderungen. Eine solche ist in Amtsberg-Dittersdorf südlich von Chemnitz, deren Temperaturverlauf wir in der Grafik 7 wiedergeben.

Ähnlich verhalten sich auch viele andere WI-arme Stationen wie Zeitz, Neugersdorf, Alfhausen, Netzstall und dergleichen mehr. Daneben gibt es natürlich stärker WI-belastete Stationen, deren Umfeld sich seit 1988 durch menschliche Bebauung stark verändert hat. Als Beispiel soll hier die einst ländliche Wetterstation Hof, die inzwischen in ein Gewerbegebiet eingewachsen ist im Vergleich zu Zeitz, einer 80 km entfernten Kleinstadt gezeigt werden. Zeitz ist nach der Wende nicht weiter gewachsen ist. Die Stadtwärme erzeugt einen Wärmeinseleffekt, der aber nach der Einheit kaum mehr zugenommen haben dürfte.

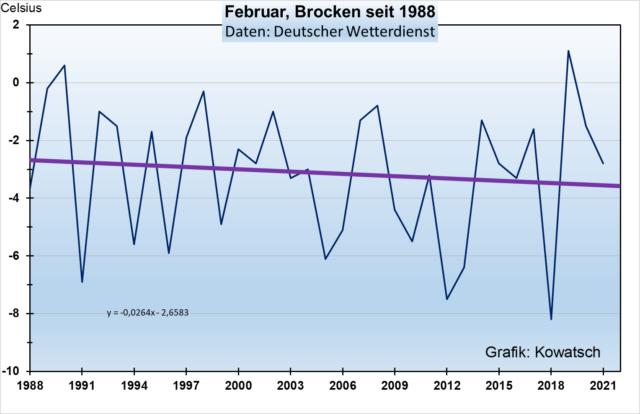

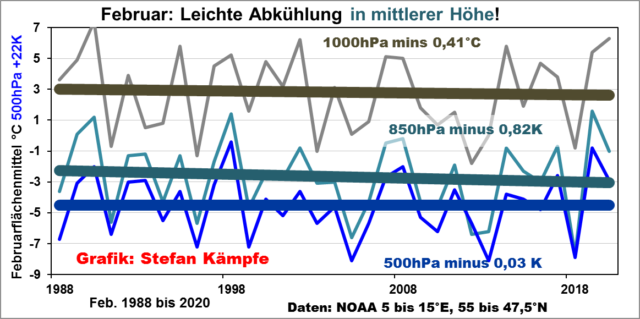

Höher gelegene Wetterstationen: Deutlichere Februarabkühlung – warum?

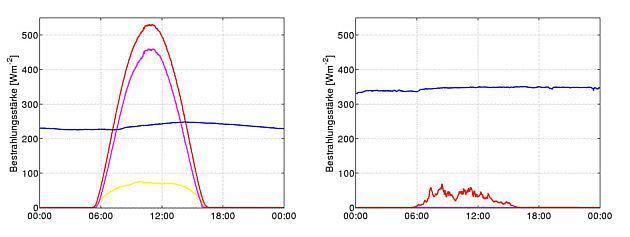

Auf das Phänomen der Höhen-Abkühlung, bedingt durch die verstärkte Advektion von Höhen-Kaltluft, hatten wir schon in unserem Januar-Beitrag hingewiesen. Die Auswertung der NOAA-Daten für den Rasterpunkt Deutschland (nicht identisch mit dem DWD-Flächenmittel) ergab Folgendes:

Einordnung des Februars 2021 in einer langen Zeitreihe

- Die Wetterstation Berlin-Tempelhof

Die Aufzeichnungen beim einstigen Feudalherrengutshof begann bereits um 1700, jedoch noch sehr lückenhaft, seit 1756 sind sie regelmäßig, allerdings nur bedingt vergleichbar mit heute. Grund: Tempelhof war vor 250 Jahren ein großer Gutshof, angeordnet wie ein Tempel, daher der Name. Um den Gutshof herum waren bebaute Felder zur Nahrungsversorgung des damaligen viel kleineren Berlins. Das noch unbebaute Tempelhoffeld zwischen Berlin und dem Gutshof diente als Exerzier- und Ausbildungsplatz für die Truppen Friedrichs des Großen oder auch der sonntäglichen Erholung und Belustigung der damaligen Stadtbevölkerung.

Heute ist Tempelhof ein Stadtteil der Großstadt Berlin mit über 60 000 Bewohnern. Eigentlich handelt es sich beim Temperaturvergleich um zwei völlig verschiedene Orte am selben Fleck und noch mit demselben Namen. Trotzdem ist das Ergebnis erstaunlich.

- Die Wetterstation auf dem Hohenpeißenberg

Wir erwähnten schon, dass 1881, der Beginn der DWD-Messreihen, in einer Kaltphase lag. Die Wetterstation auf dem Hohenpeißenberg geht 100 Jahre weiter zurück. Erwähnt werden muss lediglich, dass die Messstation bis 1936 an der Nordwand der unbeheizten Klosterkirche war, heute steht die Station frei im neu erbauten DWD-Zentrum. Allerdings sind die Wärmeinseleffekte im Winter recht gering, so dass die Standortverlegung weniger Einfluss auf die Temperaturerfassung hatte als etwa im Sommerhalbjahr.

Der Februar-Verlauf ist erstaunlich. Kaum Erwärmung seit über 230 Jahren, trotz starker CO2-Konzentrationszunahme und trotz Stationswechsels an einen wärmeren Standort.

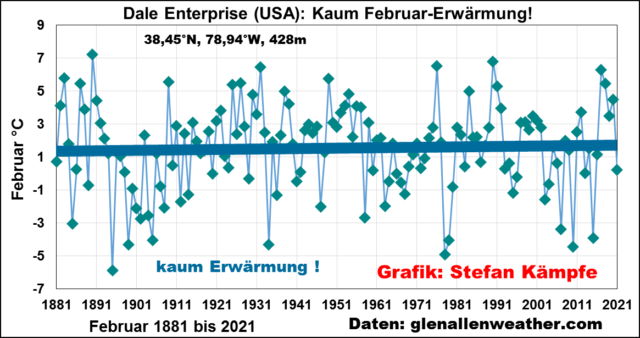

- Die Dale Enterprise Wetterstation mitten auf dem Land in Virginia/USA

Wohin geht der zukünftige Februartrend in Deutschland?

Die langen Reihen zeigen: Kaum Erwärmung in einem langen Zeitraum trotz der gewaltigen wärmenden Landschaftsveränderungen.

Und nach dem Temperatursprung 1988 bis heute? Geringe Abkühlung, diese wird lediglich durch die menschenverursachenden WI-Effekte gebremst. Besonders kalte, windstille Februarnächte werden aus den Siedlungen rausgeheizt und von den Thermometern als weniger kalt registriert.

Und zukünftig in Deutschland? Das weiß niemand.

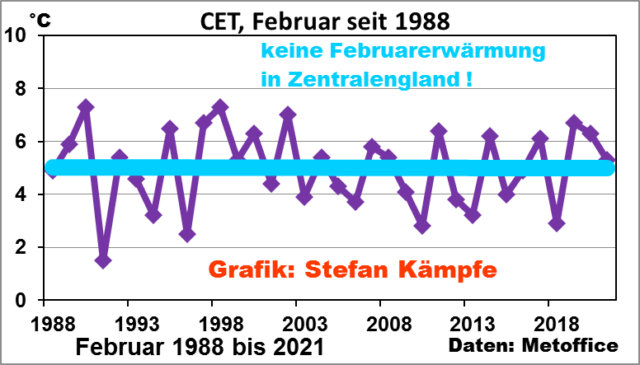

Ist vielleicht Deutschland in den letzten 34 Jahren eine Ausnahme oder gar ein Sonderfall? Wird nur bei uns der Februar in den letzten 34 Jahren minimal kälter? Wir werfen einen Blick nach Zentralengland:

Auch in Teilen Ostasiens und in Teilen der USA blieb seit 1988 eine Februar-Erwärmung aus. Während Deutschland im Februar 2021 eine heftige, aber nur kurze Kältewelle erlebte, hielt der Winter den Südosten der USA, Skandinavien, Osteuropa und Sibirien noch länger in seinem Würgegriff; und nach Mitte Februar suchten Schnee und Kälte gar große Teile Arabiens heim.

Fazit:

Die ständige Zunahme der Wärmeinseleffekte, die Schaffung großflächiger Wärmeregionen sind der einzige menschengemachte Temperaturtreiber. Eine Einwirkung mittels CO2 gibt es nicht oder die Wirkung ist minimal, das zeigen auch alle wissenschaftlich sauber durchgeführten Versuche.

Will der Mensch den menschengemachten Anteil an der Erwärmung bekämpfen, dann muss man die Wetterstationen entweder wieder raus in die Fläche stellen oder aber in den Städten und Gemeinden die Bebauung, Versiegelung der einst freien Landschaft und die Trockenlegung der Agrar-Landschaft rückgängig machen oder zumindest einstellen.

Eine Diskussion über die Reduzierung der menschenerzeugten WI-Effekte, also eine Diskussion zum Erhalt der Natur und Landschaft wäre zu begrüßen.

Politisch verordnete, teure CO2-Einsparungen bewirken nichts. CO2 ist ein lebensnotwendiges Gas, genauso wie Sauerstoff und Wasser. Ohne CO2 wäre die Erde kahl wie der Mond. Mehr CO2 in der Atmosphäre wäre wünschenswert, denn es beschleunigt die Fotosynthese und lässt die Nahrungspflanzen schneller wachsen.

Wirklicher Natur- und Umweltschutz muss endlich in den Mittelpunkt des politischen Handelns gerückt werden. Das wäre zugleich auch Klimaschutz.