U-Battery aus Europa

Interessant ist schon mal die Erschließung völlig neuer Marktsegmente durch die Reaktorleistung (hier 10 MWth und 4 MWel) und die nutzbare Temperatur (hier 750 °C). Diese neue Klasse wird als MMR (.micro modular reactor) bezeichnet. Wie schon die Bezeichnung „Uran-Batterie“ andeutet, wird ferner eine ununterbrochene Betriebszeit von mindestens 5 – 10 Jahren vorgesehen. Hiermit wird das Marktsegment der Kraft-Wärme-Kopplung auf der Basis von „Schiffsdieseln“ und kleinen Gasturbinen angestrebt. Ein sich in der Industrie immer weiter (steigende Strompreise und sinkende Versorgungssicherheit durch Wind und Sonne) verbreitendes Konzept. Hinzu kommen die Inselnetze in abgelegenen Regionen (Kleinstädte), Bergwerke und Produktionsplattformen auf dem Meer, Verdichterstationen in Pipelines usw. Hierfür kann ebenfalls auch die hohe Betriebstemperatur — selbst bei reiner Stromproduktion — von Vorteil sein, da sie problemlos Trockenkühlung (Wüstengebiete) erlaubt.

Die treibende Kraft hinter diesem Projekt ist — in diesem Sinne sicherlich nicht ganz zufällig — das Konsortium URENCO. Ein weltweiter Betreiber von Urananreicherungsanlagen. Solche Kaskaden aus Zentrifugen brauchen kontinuierlich gewaltige Mengen elektrische Energie. Man sucht also selbst nach einer Lösung für die immer teurere Versorgung.

Der Reaktor

Wieder ein neuer „Papierreaktor“ mehr, könnte man denken. Ganz so ist es aber nicht. Man hat von Anfang an auf erprobte Technik gesetzt. Es ist reine Entwicklungsarbeit — insbesondere für die Nachweise in einem erfolgreichen Genehmigungsverfahren — aber keine Forschung mehr zu leisten. Insofern ist der angestrebte Baubeginn 2024 durchaus realisierbar.

Fangen wir mit dem Brennstoff an. Es sind [TRISO] (TRISO) Brennelemente vorgesehen. Dieser Brennstofftyp ist bereits in mehreren Ländernerfolgreich angewendet worden. Diese Brennelemente überstehen problemlos Temperaturen von 1800 °C. Dadurch sind solche Reaktoren inhärent sicher. Gemeint ist damit, daß die Kettenreaktion auf jeden Fall infolge des Temperaturanstiegs zusammenbricht und eine Kernschmelzedurch die Nachzerfallswärme (Fukushima) ausgeschlossen ist. Man braucht somit keine Notkühlsysteme, dies spart Kosten und vor allem: Was man nicht hat, kann auch nicht kaputt gehen oder falsch bedient werden. Der Sicherheitsgewinn ist dadurch so groß, daß sich alle denkbaren Unfälle nur auf den Reaktor und sein schützendes Gebäude beschränken. Nennenswerte Radioaktivität kann nicht austreten und damit beschränken sich alle Sicherheitsanforderungen nur noch auf das Kraftwerksgelände selbst. Eine „revolutionäre Feststellung“, der sich die Genehmigungsbehörden langsam anschließen. Dies hat erhebliche Auswirkungen auf die möglichen Standorte, Versicherungsprämien etc. Ein nicht mehr umkehrbarer Schritt auf dem Weg zu einem „normalen Kraftwerk“ oder einer „üblichen Chemieanlage“. Die Errichtung solcher Reaktoren in unmittelbarer Nähe zu Städten (Fernwärme) oder Industrieanlagen (Chemiepark, Automobilwerk etc.) ist nur noch eine Frage der Zeit.

Als Kühlmittel ist Helium vorgesehen. Der Reaktorkern wird aus sechseckigen Brennelementen als massiver Block aufgebaut. Mit dieser Technik besitzt GB eine jahrzehntelange Erfahrung. Kein Land besitzt mehr Betriebsjahre mit Reaktorgraphit. Der Vorteil gegenüber einem Kugelhaufen sind definierte Kanäle für das Kühlmittel und die Regelstäbe. Vor allen Dingen ergibt sich aber kein Staubproblem aus dem Abrieb der Kugeln während des Betriebs. Die notwendigen Rohrleitungen und das Gebläse zur Umwälzung des Heliums bleiben sauber. Dies erleichtert etwaige Wartungs- und Reparaturarbeiten. Der komplette Reaktor kann in einer Fabrik gebaut und getestet werden und mit einem LKW einsatzbereit auf die Baustelle gebracht werden.

Als Brennstoff dient angereichertes Uran. Die Anreicherung (< 20% U235) erlaubt einen mehrjährigen Betrieb ohne einen Brennstoffwechsel („Batterie“). Ob der Brennstoff vor Ort im Kraftwerk gewechselt werden muß oder der gesamte Reaktor zurück zum Hersteller gebracht werden kann, ist noch nicht abschließend geklärt (Strahlenschutz). Der Ansatz einer „Batterie“ verringert jedenfalls die Größe eines etwaigen Brennelementenlagers am Kraftwerk und schließt eine mißbräuchliche Nutzung praktisch aus (Proliferation). Damit ist ein solches Kraftwerk auch problemlos in „zwielichtigen Staaten“ einsetzbar. Ferner verringert sich der Personalaufwand im Kraftwerk. Ein solches Kraftwerk wäre halbautomatisch und fernüberwacht betreibbar. Was den Umfang des erforderlichen Werkschutzes anbelangt, sind die Genehmigungsbehörden noch gefragt. Eine Chemieanlage — egal wie gefährlich — kommt heutzutage mit einem üblichen Werkschutz aus, während von Kernkraftwerken erwartet wird, eine komplette Privatarmee zu unterhalten. Alles Ausgeburten von „Atomkraftgegnern“ um die Kosten in die Höhe zu treiben. Verkauft wird so etwas als Schutz gegen den Terrorismus.

Der konventionelle Teil

Man plant keinen Dampfkreislauf, sondern eine Gasturbine als Antrieb des Generators. Kein ganz neuer Gedanke, aber bisher ist z. B. Südafrika an der Entwicklung einer Heliumturbine gescheitert. Helium ist thermodynamisch zu eigenwillig und außerdem ist bei einem Kugelhaufenreaktor mit einer radioaktiven Staubbelastung zu rechnen. Bei der U-Battery hat man sich deshalb für einen sekundären Kreislauf mit Stickstoff entschieden. Vordergründig kompliziert und verteuert ein zusätzlicher Wärmeübertrager zwischen Reaktorkreislauf (Helium) und Turbinenkreislauf (Stickstoff) das Kraftwerk, aber man hat es sekundärseitig nur noch mit einem sauberen und nicht strahlenden Gas zur beliebigen Verwendung zu tun. Stickstoff ist nahezu Luft (rund 78% N2) und man kann deshalb handelsübliche Gasturbinen verwenden. Auch an dieser Stelle erscheint das wirtschaftliche Risiko sehr gering. Der Wärmeübertrager Helium/Stickstoff übernimmt lediglich die Funktion der Brennkammer eines Flugzeugtriebwerkes (Leistungsklasse). Bei der vorgesehenen hohen Temperatur von 750°C des Stickstoffs bleibt nach der Turbine noch jegliche Freiheit für die Verwendung der Abwärme (Fernwärme, Prozessdampf etc.). Die immer noch hohe Temperatur am Austritt einer Gasturbine erlaubt problemlos eine Kühlung mit Umgebungsluft ohne große Verschlechterung des Wirkungsgrades. Ein immenser Vorteil für alle ariden Gebiete.

Die Projektierer

Eine zügige Verwirklichung scheint durch die Zusammensetzung der beteiligten Unternehmen nicht unwahrscheinlich: Amec Foster Wheeler (über 40000 Mitarbeiter in 50 Ländern) mit umfangreicher Erfahrung in Öl- und Gasprojekten. Cammel Laird als Werft. Laing O’Rourke als Ingenieurunternehmen. Atkins für Spezialtransporte. Rolls Royce als international führender Produzent von Gasturbinen (Flugzeuge und Schiffe), darüberhinaus mit umfangreicher Erfahrung in der Kerntechnik.

Bemerkenswert ist die Ausweitung des Projektes auf den Commonwealth. Kanada und Indien sind bereits dabei. Läßt der „Brexit“ hier grüßen? Nach bisherigem Stand der Dinge, könnte der erste Reaktor in Chalk River in Kanada gebaut werden. Dies ist auch kein Zufall, da in Kanada bereits über 200 potentielle Standorte für einen solchen MMR ermittelt wurden. Für diese potentiellen Kunden ist bereits ein neuartiges Geschäftsmodell in Arbeit: Sie bezahlen nur die gelieferte Wärme und und die elektrische Energie. Das Kraftwerk wird dann von einer Zweckgesellschaft finanziert, gebaut und betrieben. So kann dem Kunden das wirtschaftliche Risiko abgenommen werden. Es ist nicht anzunehmen, daß irgendein Bergwerk oder eine Ölraffinerie bereit ist in das „Abenteuer Kerntechnik“ einzusteigen. Andererseits sind solche sog. „Betreibermodelle“ in der einschlägigen Industrie lange bekannt und erprobt.

Noch ein paar Daten

Der Reaktor hat einen Durchmesser von etwa 1,8 m und eine Länge von etwa 6 m. Er ist damit problemlos auf einem LKW transportierbar. Das Helium soll einen Betriebsdruck von ca. 40 bar haben und eine Austrittstemperatur von 750 °C. Damit ergibt sich eine notwendige Wandstärke von unter 100 mm. Dies ist wichtig, weil hierfür keine speziellen Schmieden bzw. Rohlinge erforderlich sind. Nur wenige Unternehmen weltweit können demgegenüber Druckbehälter für Leichtwasserreaktoren schmieden.

Als Brennstoff soll auf knapp 20% angereichertes Uran (high assay, low enriched uranium (HALEU)) verwendet werden. Damit werden die TRISO-Kügelchen hergestellt, die zu Tabletten mit einer Höhe von ca. 40 mm und einem Außendurchmesser von ca. 26 mm gepreßt werden. Aus diesen werden die sechseckigen Brennelemente mit einer Kantenlänge von 36 cm und einer Höhe von 80 cm aufgebaut. Sie enthalten alle Kanäle für Regelstäbe, Instrumentierung usw. Der Kern des Reaktors besteht aus je 6 Brennelementen in 4 Lagen übereinander. Er beinhaltet etwa 200 kg Uran. Dies reicht für einen ununterbrochenen Vollastbetrieb von 5 Jahren.

Eine Doppelblockanlage (2 x 4 MWel) erfordert einen Bauplatz von ca. 10 x 12 m (Reaktoren, Wärmeübertrager und Turbinen im „Keller“, Halle für Wartungsarbeiten darüber). Hinzu käme noch Platz für Schaltanlagen, Kühler, Büros etc.

Es wird von Baukosten zwischen 45 bis 78 Millionen € für eine Doppelblockanlage ausgegangen (5600 bis 9750 €/KW). Das mag auf den ersten Blick hoch anmuten, aber man bewegt sich mit dieser Leistung von 8 MWel im Marktsegment der sog. Dieselmotoren-Kraftwerke. Hinzu kommen in entlegenen Standorten noch die meist höheren Kosten für den Dieselkraftstoff. Der für die „U-Battery“ ermittelte Strompreis von 9 Cent/KWh dürfte somit für den angepeilten Kundenkreis sehr attraktiv sein.

Inzwischen gibt es eine sehr enge Kooperation zwischen Kanada und GB. Ein paralleles, aber kooperatives Genehmigungsverfahren zeichnet sich ab. Weiterhin sind Indien, Japan, Polen, USA und Neuseeland bereits mit im Boot. Vielleicht schon die erste Morgendämmerung, wohin die Reise von GB nach dem Brexit geht? Jedenfalls nicht in das Rest-Europa, in dem unsere Kanzlerin so gut und gerne lebt.

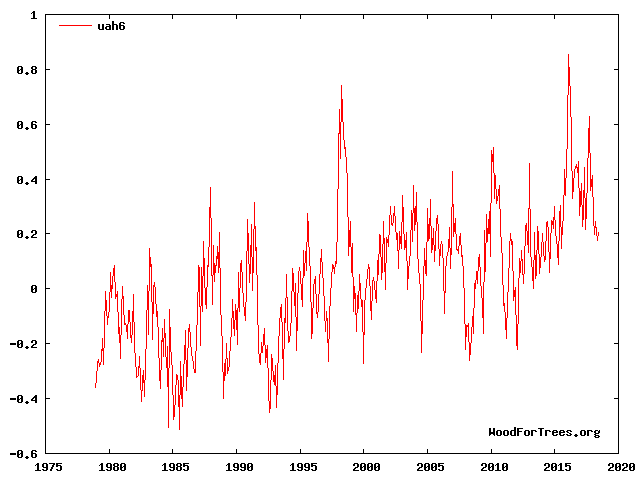

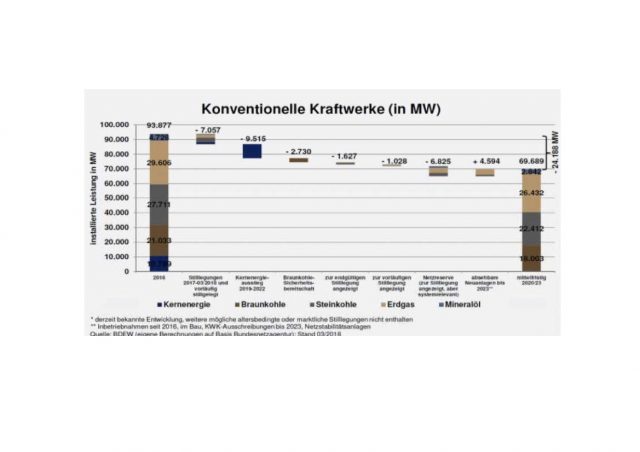

Eine Jahreshöchstlast von über 80 Gigawatt wird schon ab 2023 schwerlich ohne Importe abgesichert werden können. Das Maß erwarteter Überschüsse aus Wind- und Sonnenkraft ist unklar und in jedem Fall nur temporär. Heizen und Fahren erfordert aber Energie zu jeder Zeit. Damit bleiben nur zwei Optionen:

Eine Jahreshöchstlast von über 80 Gigawatt wird schon ab 2023 schwerlich ohne Importe abgesichert werden können. Das Maß erwarteter Überschüsse aus Wind- und Sonnenkraft ist unklar und in jedem Fall nur temporär. Heizen und Fahren erfordert aber Energie zu jeder Zeit. Damit bleiben nur zwei Optionen: