Freunde, ich bin verwirrt. Total und tutto kompletti durcheinander

Merkel bezeichnet die Pandemie als „eine demokratische Zumutung“. Die Maßnahmen, die zur Bekämpfung des Virus beschlossen wurden, hätten „kein historisches Vorbild“, an dem man sich orientieren könne.” Wie jetzt? Noch nie zuvor gab es eine weit verbreitete Seuche? Meint sie das ernst oder sagt sie das nur so in der Gegend herum, wie diese Scherzaussage, dass man Grenzen nicht schützen könne?

Es gibt kein historisches Vorbild für den Umgang mit Seuchen? Ganz Europa wurde mehrfach von der Pest heimgesucht, als Hamburgerin weiß ich, dass im 14. Jahrhundert die Pest dort die Hälfte der Bevölkerung dahinraffte mit einschneidenden Auswirkungen auf das tägliche Leben. Jetzt lebe ich in einem Ort vor den Toren Hamburgs, dort gibt es heute noch eine kleine Kapelle aus dem 15. Jahrhundert, die früher etwas außerhalb der Stadtmauern lag. Dort wurden die Lepra – und die Pestkranken untergebracht. Also so gesehen, historische Vorbilder für Isolation, Quarantäne und seuchenbedingte wirtschaftliche Probleme gibt es durchaus.

Aber das ist nur die eine Hälfte meiner Verwirrung, die andere ist der Umstand, dass neulich noch die Welt an ganz etwas anderem unterging, nämlich am Klima. Oder am CO2, so genau weiß ich es nicht. Das scheint neuerdings ein Gift zu sein, obgleich ich mal gehört habe, dass Pflanzen das irgendwie brauchen, Photosynthese oder so etwas. Es muss jedoch neue Forschung geben, denn neuerdings ist CO2 ein Gift und das Klima wird nicht von verschiedenen Faktoren wechselwirkend beeinflusst, sondern vom Menschen gemacht, der das aber komplett vergeigt. Daher müsse man etwas tun, sonst ginge die Menschheit oder der ganze Planet wenn nicht sogar das Universum unter. Das Klima müsse also, komme was wolle und um jeden Preis gerettet werden, hat die Bundeskanzlerin gesagt.

Es sei eine nie da gewesene Herausforderung, eine „Existenzfrage“, es ginge ums Überleben. Daher müsse eine „Transformation von gigantischem historischem Ausmaß“ her, kleiner ginge es nicht. „Diese Transformation heißt im Grunde, die gesamte Art des Wirtschaftens und des Lebens, wie wir es uns im Industriezeitalter angewöhnt haben, in den nächsten 30 Jahren zu verlassen.“

Da bin ich aber nun baff

Netter Weise fügte die Kanzlerin an, es müsse einen Dialog geben zwischen denjenigen, die von einer höchsten Dringlichkeit ausgingen und den anderen, die eine klimagesteuerte Weltregierung nicht ganz so prall finden. Die Sprachlosigkeit müsse überwunden werden, sagte sie. Finde ich ja auch, Sprachlosigkeit geht gar nicht. Also ihr flugs diese Klimafragen mit Einschreiben geschickt– soll ja keiner sagen, die Kanzlerin wäre vergessen worden! Geantwortet hat sie auch und zwar, dass sie keine fachliche Bewertung abgeben könne.

Ach was? Kann sie nicht? Da bin ich aber nun baff. Sie hat doch in Davos gesagt, es sei alles ganz, ganz schlimm und nun weiß sie nie nix? Hm, heißt das, sie will transformieren, da soll geklotzt und nicht gekleckert werden, sie hat aber ernsthaft keine Ahnung warum und wohin? Ohne quengelig erscheinen zu wollen, aber so ein kleines bisschen suboptimal ist das schon, gell? Immerhin, man muss ihr hoch anrechnen, dass sie erfrischend ehrlich zugibt, dass sie von der Sache keine Ahnung hat, das ist doch schon ein richtig guter Ansatz für ein Gespräch.

Zum Beispiel ich jetzt so: „Also wenn Sie keine Ahnung von den Klimafragen haben aber etwas transformieren wollen, warum dann nicht einfach mal das Wohnzimmer umräumen?“ Sie dann so: “Ähm, also das Wohnzimmer ist eigentlich schön, aber wie wäre es mit dem Kanzleramt?“ Ich dann so: „Ja prima, ist sowieso ein hässlicher Klotz, wie wäre es denn mit abreißen und neu bauen?“ Ich hätte auch super Vorschläge für den geplanten Wehrgraben vor dem Bundestag, den könnte man hübsch mit Zugbrücke und Türmchen als Erlebnispark aufpeppen, gerne auch mit Fanfaren, wenn die Kanzlerin erscheint. Schließlich sind viele Touristen da, denen muss man doch etwas bieten! Man sieht, gut, dass wir mal darüber geredet haben!

Immerhin hat sie uns die Adresse des Umweltministeriums mitgeteilt (Stresemannstraße 128-130, 10117 Berlin.), wo man sich die Antworten auf die Fragen abholen kann, was klar beweist, dass das Gerücht von wegen Servicewüste Deutschland erstunken und erlogen ist. Da die Bürger, die putzigen Kleinen, bestimmt noch nicht mit dem Internet umgehen können, hat sie ihnen ganz fürsorglich den Weg gewiesen. Danke, Mutti!

Kein Drache, sondern nur ein Gummibärchen

Zwei der diversen im Bundestag vertretenen Parteien, nämlich AfD und FDP haben unsere Klimafragenbeantwortet, die anderen (bisher) nicht. Man kann, muss aber nicht Rückschlüsse über das demokratische Verständnis der im Bundestag vertretenen Parteien ziehen.

Die Antworten der AfD gehen gar nicht. Einfache, klare Sätze mit deutlichem Inhalt – so geht doch Politik nicht! Da kann ja jeder kommen, das kann sogar jeder lesen und verstehen, wo kommen wir denn da hin? Von Merkel lernen heißt schwurbeln lernen, Sätze ohne Inhalt, aber dafür viel heiße Luft, so etwas hat noch jeden Ballon nach oben befördert. Und noch etwas: Man darf doch nicht inhaltlich antworten, z. B. dass der IPCC mangels langfristiger Daten gar nicht sagen kann, ob die Temperatur wirklich fällt oder steigt oder ob es nur zwischenzeitliche Wellenbewegungen sind (Börsianer wissen, wovon ich spreche), das fetzt einfach nicht. Bei Heldenepen muss es einen Helden geben, der gegen irgendetwas kämpft, wogegen ist ziemlich egal, Hauptsache es macht fix etwas her. Wenn man einfach so dahin geht und sagt, da ist aber gar kein Drache, sondern nur ein Gummibärchen, tja dann ist es doch kein Wunder, wenn die anderen einen nicht mögen. So etwas von Spielverderber!

Da macht es die FDP deutlich besser. Zunächst einmal schreibt sie viel. Da sieht man den Profi, als Jurist erkenne ich das natürlich sofort, denn ich weiß: Mangelnden Inhalt kann man am besten hinter vielen Worten verstecken. Kurz zusammen gefasst schreibt sie, dass sie allem sowohl als auch und absolut glaubt, weil alles zweifelsfrei und Wissenschaft sei, alles erwiesen usw..

Dabei ist die Frage 1 der Klimafragen mit dem Zitat, das keine belastbaren Prognosen möglich sind, ein gewisses Problem, denn wenn keine belastbare Prognose für die zukünftige klimatische Entwicklung unter dem Einfluss des anthropogenen CO2 erstellt werden kann, gibt es auch keine Berechtigung für eine Große Transformation einschließlich einer Energiewende, die eine gigantische Herausforderung für Deutschland und die gesamte Menschheit darstellt. Die FDP umschifft diese Problematik clever, indem sie sagt: „Wahrscheinlichkeit und statistische Unsicherheiten sind inhärente Merkmale jeder Forschung, die wissenschaftlichen Grundsätzen folgt.“ Und dass man nicht weiß, sei nicht nur gut, sondern ein Qualitätsmerkmal. Den genialen Einfall hätte ich früher bei einer Mathearbeit gut gebraucht. Aber Leute, wenn Nichtwissen ein Qualitätsmerkmal ist, dann bin ich so etwas von qualitativ hochwertig, das gibt es gar nicht! Ihr könnt mich glatt für jeden Spitzenposten nehmen!

Als politische Handlungsanweisung nicht ausreichend

Nun ist es aber so, dass die Ergebnisse des IPCC zwar hochinteressant sind, aber als politische Handlungsanweisung nicht ausreichend belastbar sind. Nur mal als Beispiel: Für die Modellierung des Klimas ist ein extrem kompliziertes System von partiellen nichtlinearen Differentialgleichungen mit stochastischem Anteil numerisch zu lösen. Um überhaupt rechnen zu können, benötigen die Computer Werte für Rand- und Anfangsbedingungen in diesem System – die Ergebnisse hängen entscheidend davon ab. Diese Bedingungen lassen sich zum großen Teil jedoch nur schätzen. Als Beispiel sei hier nur die Aufnahme und Abgabe von CO2 durch die Böden genannt; wozu die Untersuchungen erst in den Anfängen stecken. Bei Wikipedia kann man zur Einarbeitung der Randbedingungen lesen: „Vor allem die Prozesse in der Biosphäre werden im Augenblick noch als Größen und Parameter vorgegeben.“

Das fügt ein Element der Beliebigkeit in die Modellierungen ein, welches die Ergebnisse entscheidend beeinflussen kann. Denn: In den von ungeheuer komplizierten Wechselwirkungen geprägten Systemen kann sich eine kleine Abweichung von der Realität bei den Annahmen zu großen Fehlern im Ergebnis aufschaukeln. Ein solches Problem lässt sich auch nicht durch eine noch so erhebliche Steigerung der Rechenleistung beheben. Bereits dieser Fakt stellt die Prognosetauglichkeit der Modellrechnungen infrage.

Im Gegensatz zu einer Behauptung von Stefan Rahmstorf, dass „die Klimamodelle seit fünfzig Jahren die globale Erwärmung korrekt vorhergesagt haben “ (SPIEGEL vom 31.01.2020), gab es in der Geschichte der Modellierung bemerkenswerte Defizite. Tatsächlich konnte weder der Abfall der Globaltemperatur zwischen 1945 und 1975 (der übrigens damals führende Klimatologen zur Prophezeiung einer neuen Eiszeit veranlasste) noch die zehnjährige „Hiatuspause“ vorher rechnerisch dargestellt werden. Und im Bericht des IPCC von 2007 hieß es noch: „Die Gletscher im Himalaja sind mit hoher Wahrscheinlichkeit bis 2035 oder vielleicht schon früher verschwunden.“ Nach lebhafter Kritik an dieser Aussage brauchte der Weltklimarat drei Jahre, um sie zu revidieren.

Die zutreffende Beschreibung vergangener Klimaverläufe wäre eine notwendige Bedingung für die Fähigkeit von Modellen, zukünftige Entwicklungen zu prognostizieren – hinreichend ist eine solche Modelleigenschaft noch nicht. Wenn die Modellrechnungen Vertrauen verdienten, sollten deren Ergebnisse im Verlauf ihrer Entwicklung sich wenigstens einigermaßen asymptotisch den belastbaren Resultaten annähern. Stattdessen wurde 2018 eine Änderung der bis vom IPCC vertretenen Vorstellungen um mehr als 100 Prozent verkündet.

So unpräzise wie eh und je

Dies zeigt ein Interview des SPIEGEL vom 05. Oktober 2018 mit einem der Leitautoren des letzten Sachstandsberichtes des IPCC, dem Direktor des Max-Planck-Instituts für Meteorologie in Hamburg, Professor Jochem Marotzke. Er erklärt darin: „Unser verbleibendes CO₂-Budget für das 1,5-Grad-Ziel ist wohl mindestens doppelt so groß wie gedacht, fast tausend Gigatonnen. … Offenbar verbleibt ein kleinerer Teil der ausgestoßenen Treibhausgase in der Atmosphäre, weil Wälder und Ozeane mehr davon schlucken als gedacht.“ Gleichzeitig reduzierte das IPCC die tolerable Grenze der Temperaturerhöhung in diesem Jahrhundert von 2 auf 1,5 Grad. Prof. Marotzke stimmte der Klassifizierung dieses Wertes als „politischer Grenzwert“ in dem Interview zu.

Eine ungeschönte Darstellung der Probleme von Klimamodellierung aus berufenem Mund findet sich in der SPIEGEL – Ausgabe vom 22. März 2019: Prognosen zur Erderwärmung, Warum Wolken der Fluch aller Klimaforscher sind. Darin wird der seit 20 Jahren am Hamburger Max-Planck-Institut für Meteorologie auf dem Feld der Klimamodellierung forschende Bjorn Stevens vom SPIEGEL intewiewt. Er schildert die Schwierigkeiten einer Modellierung des Wolkenphänomens; wir geben hier einige seiner Aussagen wieder: „Die Rechenleistung der Computer ist auf das Vielmillionenfache gestiegen, aber die Vorhersage der globalen Erwärmung ist so unpräzise wie eh und je. …..Es ist nicht leicht, dieses Versagen der Öffentlichkeit zu vermitteln. ….Die Temperaturen in der Arktis zum Beispiel klaffen in den verschiedenen Modellen um teilweise mehr als zehn Grad auseinander. Das lässt jede Prognose der Eisbedeckung wie bloße Kaffeesatzleserei erscheinen.“

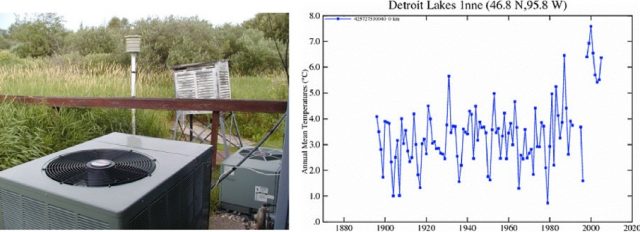

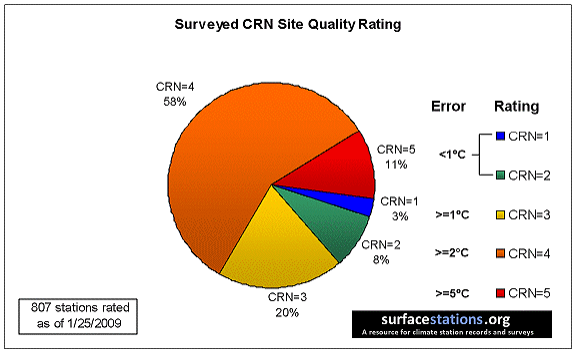

Die Behauptung der FDP, es sei unstrittig und wissenschaftlicher Konsens, dass ohne Minimierung der menschlichen Treibhausgasemissionen nicht verantwortbare Schäden entstünden, stehen im Widerspruch z. B. zu den Fakten aus dem Protokoll einer Anhörung von John R. Christy vor dem Ausschuss für Wissenschaft, Weltraum & Technologie der Vereinigten Staaten am 29. März 2017. John R. Christy ist Klimatologe des Staates Alabama und Professor für Atmosphärenwissenschaft sowie Direktor des Instituts für Wissenschaft des Erdsystems an der Alabama Universität in Huntsville, Leitautor und Peer-Reviewer von Veröffentlichungen des IPCC. Die von ihm präsentierten Ergebnisse von 32 Computermodellen des IPCC für Temperaturverläufe in den Tropen beweisen nicht nur, dass von „korrekter Vorhersage“ keine Rede sein kann, sondern zeigen auch die beste Übereinstimmung von berechneten mit gemessenen Werten, wenn der Treibhauseffekt unberücksichtigt bleibt.

Ein lustiges Grünen-Experiment

Immerhin kann sich die FDP freuen. Schließlich will sie ja nur eine Verlangsamung des Klimawandels, damit die Menschen sich besser anpassen können: „Der Klimawandel muss vor allem besser erforscht, begrenzt und in seiner Geschwindigkeit verlangsamt werden. Nur dann können sich unsere Gesellschaften auch erfolgreich anpassen.“

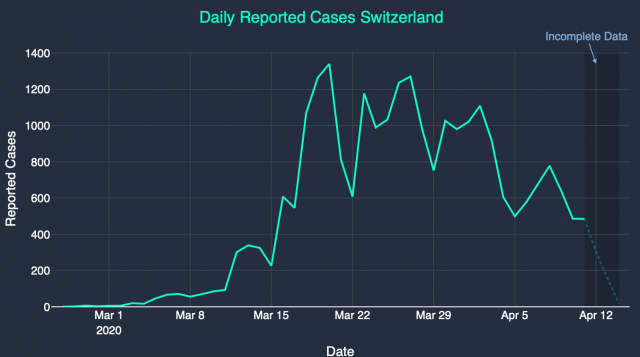

Null Problem, die Verlangsamung der Geschwindigkeit bekommen wir hin, denn wenn alles vom CO2 abhängt, dann haben wir reichlich Zeit gewonnen. Wir haben weltweit nicht nur seit Anfang des Jahres reichlich Zeit eingespart, sondern werden es auch noch ein Weilchen in der Zukunft tun, Corona lässt grüßen. Zugleich fahren wir ein lustiges Grünen – Experiment: Was passiert, wenn wir die Industrie herunterfahren? Wie prall ist es, wenn Reisen eingeschränkt ist? Auch das urbane Leben mit outgoing und socializing ist nicht wirklich klimaneutral, die Einschränkungen konnte man nun testen.

Das neue vegan ist jetzt das „stay home“. Und wie klug ist überhaupt die grüne Vision, zwar gegen Massentierhaltung zu sein, gleichzeitig aber die Massenmenschenhaltung mittels Urbanisierung zu betreiben, damit man richtig super anfällig ist für Viren oder sonstige Ereignisse (Stromausfälle?), die dann ganz einfach mit einem Streich alle Neune kegeln können? Der hochgelobte ÖPNV – die Virenschleuder schlechthin – und fällt es aus, dann sieht der Urbane alt aus. Kann aber passieren, schneller als man denkt.

Was ich aber besonders lustig finde: Kein Klimamodell hat eine Seuche eingepreist, dieser Fall war nicht bedacht. Damit zeigt sich das Problem mit den Vorhersagen der Zukunft bei komplexen Systemen. Es gibt da genau eine, absolut zuverlässige Regel, wonach es erstens anders kommt und zweitens als man denkt.

Anmerkung: Ich danke ausdrücklich und ganz herzlich Herrn Prof. Dr. Dr. Wulf Bennert für seine fachliche Zuarbeit.

Frau Anette Heinisch ist Rechtsanwältin in Hamburg und Mitinitiatorin von Klimafragen.org

Der Beitrag erschien zuerst bei ACHGUT hier