Zwei Analysen sind getrennt durchzuführen, jeweils in zwei Unterkategorien. Erstens die Analyse der Gefährlichkeit der Krankheit selbst, mit den Unterkategorien Risiko für den Erkrankten und Risiko für die Allgemeinheit. Zweitens eine Analyse der möglichen Schutzmaßnahmen, unterteilt in die Unterkategorien Nutzen und Schaden, den sie verursachen. Die erste Risikoanalyse ist eine rein medizinische. Bei der zweiten sind alle möglichen Fächer und Gebiete gefordert.

In den beiden vorangegangenen Coronabeiträgen ging es um die Gefährlichkeit der Erkrankung für die Allgemeinheit. Dies ist die Domäne der Epidemiologen und Immunologen. Und man kann es gar nicht oft genug sagen, nicht die der Virologen, die fälschlicherweise in den Medien dazu stets befragt werden. Sprechen wir nun von der Gefährlichkeit der Krankheit, die den Namen Covid-19 erhalten hat, für den Erkrankten selbst. Und diese Frage können die medizinischen Praktiker beantworten.

Wie gefährlich ist Covid-19 für die daran Erkrankten?

Wie sehen Verlauf und Therapie bei der Krankheit mit namen Covid-19 aus, gibt es Folgeschäden und wer ist davon betroffen? Beginnen wir mit dem Tod. Hic Gaudet Mors Succurrere Vitae(hier freut sich der Tod, dem Leben zu helfen), lautet der Wahlspruch der Pathologie. Sie ist es, die uns vor allen sagen kann, wie man an einer Erkrankung verstirbt bzw. wegen oder mit ihr. Doch dazu benötigt es eine fachgerechte Obduktion, die anfangs regelrecht verhindert wurde, weil als Covidtote geltende Verstorbene panisch sofort in Plastiksäcke verfrachtet und verbrannt wurden. Dies hat sich durch die Intervention der Pathologen geändert. Ich hatte Gelegenheit, Herrn Professor Dr. Peter Schirmacher, Geschäftsführender Direktor der Allgemeinen Pathologie der Universität Heidelberg, dazu zu befragen – hier meine Fragen und seine Antworten:

Sehr geehrter Herr Kollege Prof. Schirmacher, wie viele Verstorbene, die auf dem Totenschein als Todesursache Covid-19 stehen hatten, haben Sie obduziert?

Schirrmacher: Zehn.

Wie viele offiziell an Covid-19 Verstorbene wurden insgesamt in Deutschland obduziert?

An den akademischen Zentren in Deutschland 50, eine geringere Zahl weiterer Obduktionen mag an Prosekturen/Krankenhauspathologien erfolgt sein, sicher weniger, aber genaue Zahlen habe ich hierzu nicht. Zudem haben Obduktionen in der Rechtsmedizin (Prof. Püschel hat darüber berichtet: Meines Wissens nach werden in Hamburg alle COVID Fälle in der Rechtsmedizin obduziert – bislang wohl etwa 100) und in den Zentralkrankenhäusern der Bundeswehr stattgefunden; insgesamt würde ich von etwa 180–200 ausgehen.

Woran sind die Toten verstorben?

Wenn die Verstorbenen sicher an COVID verstorben sind, sind sie an fortgeschrittenen Lungenveränderungen verstorben. Wir haben auch zwei Verstorbene, bei denen zwar COVID Veränderungen vorliegen, die aber m.E. das Versterben nicht hinreichend erklären. Herr Püschel meint, dass etwa ein Viertel seiner COVID-Toten nicht an COVID verstorben sind; auch diese Fälle haben wir.

Woran machen Sie die Krankheit fest?

Wir konnten mittlerweile ein typisches histologisches Bild der Lungenveränderungen und dessen Entwicklung ermitteln, das auch zur Symptomatik passt und das Versterben erklärt. Wir planen, dies schon in der nächsten Woche zusammenzufassen und rasch zu publizieren.

Welche wichtige Rolle spielt aus Ihrer Sicht dabei der Test?

Für uns erst einmal keine; wir reagieren auf das positive/negative Testergebnis entsprechend; fehlt bei einer passenden Symptomatik das Testergebnis, holen wir dies vor Obduktion ein oder warten auf das klinische Testergebnis.

Würden Sie Verstorbene mit typischen Befunden auch der Erkrankung Covid-19 zuordnen, wenn deren Test negativ war.

Die Erkrankung zeigt ein recht einheitliches Bild, das aber nicht spezifisch ist und z.B. bei ARDS/Beatmungslunge [Anmerkung: Überdruckbeatmung] in ähnlicher Form auftreten kann, was sicher auch eine Rolle spielt. Aber natürlich würde sich im Kontext des klinischen Bildes, der Anamnese etc. die Frage stellen. M.W. sind die jetzt durchgeführten Tests sehr sensitiv, so dass ich bei Verstorbenen praktisch kaum mit derartigen Fällen rechne.

Gibt es eine spezielle Risikogruppe, und wie ist die Altersverteilung der Toten?

Wir haben einen Verstorbenen von 41 Jahren obduziert, der jedoch nicht an der Covid-Lungenerkrankung verstorben ist, ansonsten sind alle unsere Verstorbenen und Obduzierten über 76 Jahre mit einem Median von über 80 Jahren. Männer sind auch bei uns häufiger, und natürlich finden sich bei einem signifikanten Teil der Verstorbenen in diesem Alter auch schwere andere Grunderkrankungen, wie durch Bluthochdruck verursachte Herzmuskelerkrankung, chronisch-obstruktive Lungenerkrankung oder auch eine Leberzirrhose [Anmerkung, dies deckt sich mit den Aussagen des Rechtsmediziners Prof. Püschel]. Grundsätzlich ist die altersspezifische Mortalität inzwischen gut bekannt: Sie ist für unter 20-Jährige praktisch null, bei unter 40-Jährigen wohl deutlich unter 1 Promille und geht ab da langsam hoch; signifikant wird sie erst für die über 60-Jährigen, vor allem mit Vorerkrankungen. Natürlich können an Viruserkrankungen auch junge Menschen sterben, das gilt für die Influenza, oder denken sie an eine Cosackievirus-Infektion. Aber diese Fälle sind immer sehr selten.

Fürchten Sie, dass bei Überlebenden schweren Folgeschäden bleiben, z.B. eine Lungenfibrose?

Ja, bei den Beatmeten kann dies je nach Schwere und Beatmungsdauer der Fall sein. M.W. sprechen die Beatmungsmediziner von durchschnittlich 30 Prozent Lungenfunktionsreduktion nach stattgehabter Überdruckbeatmung. Da spielen aber viele Faktoren eine Rolle (Dauer/Art Beatmung, Weening, Vorerkrankungen, Alter etc.). Genaues hierzu kann sicher ein Beatmungsmediziner angeben; zu Spätfolgen kann m.E. bei diesen Patienten noch niemand etwas sagen. Bei den nicht beatmeten Patienten gibt es wenig Anhaltspunkte; gemäß der Neurologen, können die bei etwa 30 Prozent beobachteten neurologischen Ausfälle (überwiegend Geruchs-/Geschmackssinn) wohl in einzelnen Fällen länger anhalten; genaueres können hier sicher die Neurologen sagen.

Früh auf wahrscheinliche Behandlungsfehler hingewiesen

Soweit der Pathologe. Hören wir nun die Meinung der Therapeuten. Hier gibt es kaum Qualifiziertere als die Lungenärzte des Verbandes Pneumologischer Kliniken (VPK), die sehr früh und sehr nachdrücklich auf wahrscheinliche Behandlungsfehler hinwiesen, die inzwischen auch international bestätigt wurden. Allein dafür gebührt diesem Fachverband großer Dank und Anerkennung. Hier nun Fragen an den Präsidenten des VPK, Herrn Dr. med. Thomas Voshaar, Chefarzt der Medizinischen Klinik III des Bethanien Krankenhauses in Moers, nach seiner Erfahrung im Umgang mit an Covid-19 Erkrankten (wie dort eine fachlich hochwertige Covidtherapie umgesetzt wird, können Sie übrigens hier anschauen)

Sehr geehrter Herr Kollege Dr. Voshaar, ist Ihrer Meinung nach Covid-19 eine eigenständige Erkrankung, und woran machen Sie diese Erkrankung fest?

Vosshaar:Sie gehört zur Gruppe der Viruspneumonien, die oft vielgestaltig sind. Covid-19 zeigt aber in den schweren Fällen ein typisches Bild. Die meisten Menschen bemerken eine Infektion mit dem SARS-CoV-2 gar nicht oder erleben eine Woche lang Symptome der oberen Atemwege, wie Halsschmerzen und heilen dann aus. Bei manchen entwickelt sich jedoch in der zweiten Woche eine sich rasch verschlechternde Lungenentzündung mit Atemnot. Wir haben bisher 44 Patienten stationär deswegen behandelt. Gelingt es, eine Intubation [Einführung eines Schlauchs in die Luftröhre unter Narkose] zu vermeiden, gesunden auch diese Patienten fast immer.

Was ist für Sie entscheidend für die Diagnose?

Die Symptomatik der Patienten, dann die typischen Lungenveränderungen in einem CT sowie eine Blutdiagnostik, die z.B. andere Ursachen auszuschließt. Der Test selbst kann durchaus auch negativ sein, wenn beispielsweise die Infektion vom Hals in die Lunge gewandert ist. Dann spricht der Test nicht mehr an.

Wie steckt man sich eigentlich genau an?

Wir glauben, dass die Tröpfchengröße eine wesentliche Rolle spielt. Wenn man z.B. niest, dann fallen die großen Tropfen mit der Viruslast, wir sprechen von Aerosolen, schnell zu Boden. Die winzig kleinen schweben jedoch länger in der Luft. Diese werden auch durch Sprechen freigesetzt. Befinden sich mehrere Menschen in kleinen geschlossenen Räumen, dann können diese winzigen Aerosole auch den Weg direkt in die Lunge finden und sofort eine schwere primäre Pneumonie auslösen. Interessanterweise stecken sich dabei aber bei weitem nicht alle an. Warum? Eine Frage, die sicher noch zu beantworten ist, vielleicht gibt es ja bei manchen eine mögliche Immunität durch andere durchgemachte Coronainfektionen, oder das Virus mutiert schnell, und wir haben in Deutschland eine mildere Variante erlebt. Das sind Spekulationen. Sicher ist, dass winzige Aerosole schnell verweht werden, weshalb eine Ansteckung im Freien sehr selten sein dürfte. Neben den klassischen Regeln der Hygiene ist es essenziell, regelmäßig zu lüften, um die Ansteckung in geschlossenen Räumen zu verhindern.

Gibt es eine spezifische Behandlung?

Nein, aber eine Sache ist sehr wichtig. Man muss versuchen, eine Intubation, für die man die Patienten narkotisieren muss, und eine folgende maschinelle Überdruckbehandlung möglichst zu vermeiden. An einer Viruspneumonie Erkrankte sterben oft 24 Stunden nach einer solchen Behandlung, oder es gelingt oft nicht, sie wieder in eine selbstständige Atmung zurückzuführen. Man sollte deshalb Covid-19 Kranke, solange sie ansprechbar, einigermaßen bei Kräften sind, keine Blutbildauffälligkeiten und kein schwerkrankes Herz haben, nicht intubieren, sondern sie über eine Maske mit Sauerstoffzufuhr frei atmen lassen, sowie lindernde Medikamente geben. Das gelingt fast immer, und nach einer Woche heilen diese Patienten aus. Allerdings sinkt die Sauerstoffsättigung dabei stark ab, in einem Fall bei uns sogar bis 70 Prozent, aber wenn man dann solche Patienten intubiert, zeigt sich, dass sich nahezu alle Patienten direkt schon bei Intubation verschlechtern. Das zeigen auch Berichte aus den USA, der Kreislauf bricht sofort ein, es müssen stützende Medikamente gegeben werden und dann muss auch die Beatmung rasch so angepasst werden, dass gute Werte „entstehen“, dafür hat man schließlich intubiert. Konkret heißt das meist, dass die inspiratorische Sauerstoffkonzentration und der Beatmungsdruck angepasst werden müssen. Beides schädigt aber die Lunge, wie wir schon lange wissen. Die gerade durch ein Virus entzündete Lunge schädigt es möglicherweise noch mehr. Mit den Kreislaufveränderungen kommen nach Intubation auch erst die Probleme an Niere etc. etc.

Kann man einschätzen, für wen diese Erkrankung schwerwiegend verlaufen wird und für wen sie tödlich endet?

Es sind die bekannten Risikofaktoren, die zu Todesfällen führen können, wahrscheinlich vor allem Herz-, Diabetes- oder Krebserkrankungen. Wir haben insgesamt einen Patienten verloren. Dieser litt an einer schweren Muskelerkrankung. Asthma gehört meiner Einschätzung aber nicht dazu. Aber auch die frühe Intubation ist, wie gesagt, ein Risikofaktor. In den USA wird derzeit dieser Fehler erkannt. Dort wurden sogar gut ansprechbare Patienten narkotisiert und intubiert. Ähnlich ist man wahrscheinlich auch in China und Italien verfahren. Ich fürchte, dies macht einen beträchtlichen Teil der Todeszahlen aus.

Sind Folgeschäden wie z.B. eine Lungenfibrose bei überlebenden Schwererkrankten zu erwarten?

Was die Folgeschäden angeht, wissen wir von einigen Patienten, die wir bereits nachuntersucht haben und die alle nicht beatmet wurden, dass es wohl ohne Residuen [Anmerkung: Gewebeverdichtungen] abheilt. Einige Narben bleiben wohl auf der Lunge, das aber ist auch nach bakteriellen Pneumonien so, also nichts Besorgniserregendes. Wurde maschinell beatmet, kommt es auf die Dauer und den Beatmungsdruck an. Je länger und je höher, desto mehr entwickeln sich Folgeschäden. Auffallend ist, dass SARS-CoV-2 auch Nerven befällt, sowohl im Gehirn als auch peripher. Die Riechstörungen sind bekannt. Ein Patient berichtete von Gefühlsstörungen, vielleicht gibt es noch andere Hirnschäden. Die meisten dieser Beschwerden dürften sich wieder zurück entwickeln, aber insgesamt ist die Frage nach Folgeschäden erst nach vielen Monaten wirklich beantwortbar. An dieser Stelle wird auch deutlich, dass eine zentrale Stelle, die schnell interdisziplinäres Wissen bereitstellt, fehlt. Ich muss mir z.B. selbst Neurologen oder Pathologen suchen, um wichtige Informationen außerhalb meines Fachgebietes zu erhalten.

Wären viele der stationär Behandelten auch ambulant behandelbar, welche Ressourcen bräuchte es dazu?

Wir behandeln jetzt viele schon ambulant, wobei wir sie via App oft überwachen. In anderen Fällen sagen wir, dass sie sofort anrufen bzw. kommen sollen, wenn es schlechter geht.

Könnte es sein, dass viele der hochbetagten Verstorbenen sinnvoller palliativ in ihren Pflegeheimen hätten versorgt werden können?

Ja. In diesem Zusammenhang sollte man auch realistisch sehen, dass ein alter Mensch nach einer langen Phase der maschinellen Überdruckbeatmung kaum in ein selbstbestimmtes Leben zurückkehren wird. Nach gründlicher Aufklärung sollte im Erkrankungsfall geklärt sein, und jede Entscheidung ist zu respektieren, ob ein sehr alter Mensch bei Verlust der Entscheidungsfähigkeit, vorher in der Patientenverfügung auch eine Intubation ablehnen kann. Voraussetzung dafür ist eine gute hausärztliche und palliativmedizinische Versorgung in den Pflegeheimen selbst.

Bestand oder besteht die Gefahr, dass es in ihrem Krankenhaus zu einer Überbelegung und Minderversorgung hätte kommen können, oder ist diese Frage nicht beantwortbar?

Wir hatten nie Sorge, in eine bedrohliche Überbelegung zu geraten. Wir konnten uns sicher auch mit mehr Zeit vorbereiten als Italien.

Besteht eine relevante Gefahr für die Behandler, sich selbst zu infizieren und schwer zu erkranken?

Wenn eine professionelle Maskennutzung gewährleistet wird, kaum. Auch einfache Maßnahmen wie regelmäßiges und häufiges Lüften der Zimmer sind sehr wichtig.

Fazit der medizinischen Risikoanalyse

(bezogen auf den Erkrankten und die Allgemeinheit)

Für den Erkrankten ist Covid-19 gefährlicher als eine Grippe. Covid-19 ist eine infektiöse Erkrankung der Lunge. Sie ist als eigenständiges Erscheinungsbild zu sehen und stellt eine neue, schwere Viruserkrankung dar, ausgelöst durch eine Infektion mit dem SARS-CoV-2 Virus. Für die meisten Infizierten stellt sie jedoch keine Bedrohung dar. Ein kleiner Anteil der Infizierten entwickelt jedoch eine gefährliche Lungenentzündung, vor allem ältere Menschen, die aber auch bei jüngeren vorkommt. Dadurch unterscheidet sie sich von einer Influenza (Grippe), bei der Pneumonien auch oft vorkommen, aber nicht in diesem Maße.

Richtig behandelt, vor allem bei Vermeidung einer Intubation mit Narkose und maschineller Überdruckbeatmung trotz niedriger Sauerstoffblutsättigung, heilen fast alle Patienten aus. Wahrscheinlich werden kaum Folgeschäden später zu beobachten sein, das gilt es aber in den nächsten Monaten sicherer zu beurteilen. Problematisch wird es, wenn schwere Begleiterkrankungen vorliegen, wie oft bei alten Menschen. Dann kann die Lungenentzündung tödlich enden oder den Tod durch die Grunderkrankung beschleunigen. Viele als Covid-19 Tote geltende werden an dieser Grunderkrankung gestorben sein und mit Covid. Ganz grundsätzlich können auch gesunde, junge Menschen an Covid-19, wie auch an Influenza, sterben, aber das ist die absolute Ausnahme.

Die tragische Besonderheit von Covid-19, die auch für andere Viruspneumonien gilt, die nicht in einem solch öffentlichen Fokus standen, ist: Die auf vielen Intensivabteilungen übliche, schnelle Intubation bei Sinken der Sauerstoffblutsättigung trotz Ansprechbarkeit der Patienten, mit Narkose und maschineller Überdruckbehandlung, stellt einen eigenen Risikofaktor dar. Die zu frühe Intubation ist für die meisten Folgeschäden und für einen beträchtlichen Teil der Todesopfer verantwortlich zu machen. Diese Erkenntnis scheint sich nun international durchzusetzen und stellt einen bedeutenden Fortschritt für die zukünftige Behandlung von Viruspneumonien dar.

Keine Killerseuche

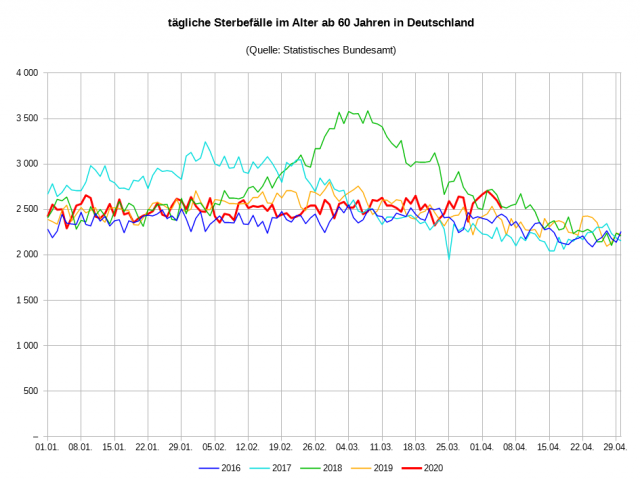

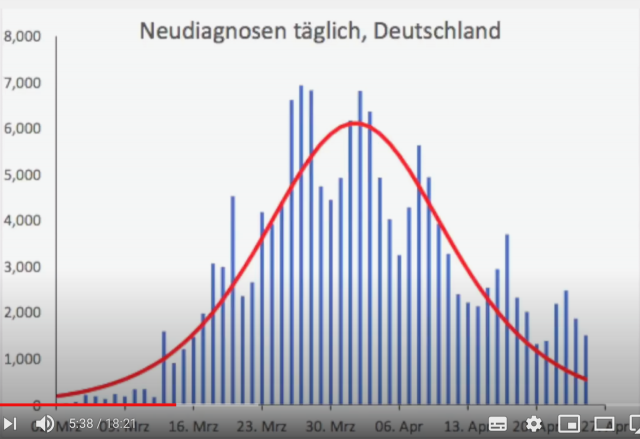

Für die Allgemeinheit ist Covid-19 nicht gefährlicher als eine Grippe (siehe meine beiden vorausgegangenen Beiträge). Covid-19 ist, bezogen auf die Gefahr für die Gesamtgesellschaft, keine Killerseuche. Infektiösität und Letalität sind geringer als vielfach erwartet. Derzeit liegt der Anteil von Covid-Toten in Deutschland, bezogen auf 100.000 Einwohner/Jahr, bei unter 10 und reiht sich weiter hinten ein in der Rangliste der gefährlichen Todesursachen. Dies würde sich auch nicht ändern, wäre der Anteil doppelt oder gar dreifach so hoch. Der Infektionsverlauf ähnelt der einer klassischen Grippe. Die Infektion ist spätestens seit Mitte März im Abklingen.

Die Todeszahlen werden sich länderspezifisch nicht oder wenig dramatisch von den Zahlen der Vorjahre unterscheiden. Die klare Risikogruppe erlaubt ein schützendes Vorgehen, ohne die gesamte Gesellschaft in Quarantäne zu nehmen und den massiven Folgeschäden auszusetzen. Ob nun in den einzelnen Ländern 5.000 mehr oder weniger versterben, ist für jeden einzelnen Toten tragisch, ändert jedoch nichts bezüglich der geringen Gefahr für die Gesamtgesellschaft. Diese belastbare Einschätzung wird auch nicht von Bildern geändert werden können, die überfüllte Intensivabteilungen, gestapelte Särge oder Leichen in Kühllastern zeigen, ohne diese in den Kontext von Umstände und Gesamtzahlen zu setzen.

Hochqualifizierte interdisziplinäre Netzwerke ermöglichen auch bei dünner Datenlage gute Einschätzungen. Die Leserinnen und Leser meiner Beiträge werden feststellen, dass diese Risikoeinschätzung schon vor 50 Tagen möglich war undvier Tage später mit aller Deutlichkeit.

Auch andere kamen bekanntlich früh zu diesen Rückschlüssen. Doch wie ist das möglich, die damalige Datengrundlage war viel dünner? Ganz sicher nicht deshalb, weil man gut geraten hat, sondern deshalb, weil es möglich war, abseits jeder Panikreaktion die wenigen vorhandenen Fakten und Hinweise, die es gab, in den richtigen Kontext zu stellen und sich die jeweils passenden Fachexpertisen einzuholen. Bekannt war zum Beispiel, dass die Hotspots offensichtlich sich nicht weiter in den Ländern verbreiteten (weit vor dem Lockdown), die Daten der Diamant Princess, die Daten von Prof. Hendrik Streeck, die Vergleichszahlen mit den Vorjahren und einiges mehr.

All dies deutete mit ausreichender Klarheit darauf hin, dass es sich hochwahrscheinlich nicht um eine Killerseuche mit zig Millionen möglichen Todesopfern weltweit handelt. Alles, was man dazu benötigt, ist ein interdisziplinäres Denken, welches bei wichtigen Fragen die jeweils zuständige Fachmeinung berücksichtigt. Zur Behandlung von Covid fragt man die Kliniker, aber zur allgemeinen Gefährlichkeit eben die Epidemiologen, wie die des Deutschen Netzwerks Evidenzbasierte Medizin. Solch hochqualifizierte Meinungen lassen sich ohne Weiteres finden, sowohl in Deutschland als auch international, man muss nur danach suchen.

Lauterbach schätzte gefährliche Medikamente falsch ein

Am Ende muss man sich auf die rationale Intuition eines interdisziplinären Teams verlassen. Noch etwas anderes Entscheidendes kommt dazu. Am Ende des Tages, erfolgt eine Risikoeinschätzung auf der Basis dessen, was der Psychologe Prof. Julius Kuhl rationale Intuition nennt. Zu bedenken ist, dass Statistik selbst nur auf Modellen beruht, und Modelle können aus methodischen Gründen keine Hypothese beweisen. Das bedeutet, auch die beste Statistik bildet nie die Wirklichkeit ab, sie nähert sich ihr immer nur an. Deshalb kommt es entscheidend darauf an, mit welcher reflektierten Vorerfahrung die Statistik interpretiert wird. Sind es Fachleute, die ihre Kompetenz genau auf dem infrage kommenden Gebiert belegt haben und – waren sie fähig aus ihren bisherigen Fehlern zu lernen, handeln sie also reflektiert?

Nur ein Beispiel. Wenn der meiner begründeten Meinung nach beste derzeitige Epidemiologie John Iaonnidis davor warnt, die getroffenen Maßnahmen seien übertreiben, weil die Letalität viel niedriger und die Ausbreitung schon viel weiter fortgeschritten sei, dann ist es unverantwortlich, eine solche Stimme mattzusetzen durch die eines auf Viren-RNA-Forschung spezialisierten Virologen, der schon einmal in einem ähnlichen Fall eine falsche Risikoeinschätzung getroffen hat und nie hat erkennen lassen, dass er daraus gelernt hat. Wenn ich wissen will, ob das Dach dicht ist, frage ich den Dachdecker und nicht den Heizungsmonteur. Vor allem, wenn mich der Heizungsmonteur schon einmal falsch bezüglich des Daches beraten hat.

Auch Prof. Karl Lauterbach, der zurzeit in den Medien vorrangig um seine wissenschaftliche Einschätzung gefragt wird, hat in der Vergangenheit bewiesen, dass er gefährliche Medikamente falsch einschätzt und deren Zulassung maßgeblich fördert, obwohl die vorhandene Datenlage davon abriet. Diese Medikamente wurden dann auch wegen ihrer gefährlichen Nebenwirkungen später vom Markt genommen, beispielsweise Cerivastatin (Lipobay) oder Sibutramin (Reductil) (s.a. Gunter Frank, Schlechte Medizin, Knaus Verlag) Deswegen wäre ich hinsichtlich der Fähigkeit einer reflektierten Risikoanalyse bei ihm skeptisch. Experten wie Professor Sucharit Bakhdi oder Professor Stefan Hockertz schätze ich deutlich kompetenter ein, doch sie werden aus den Leitmedien ausgeschlossen.

Es kommt eben darauf an, wen man fragt und welche Meinung man als die maßgebliche auswählt. Im Unvermögen, die passenden Expertenmeinungen zu den jeweils anliegenden, wichtigen Fragestellungen zu identifizieren und zu moderieren, lag von Anfang an der Systemfehler und da liegt er immer noch. Denn es geht weiter. Impfungen? Diese Frage ist derzeit nicht relevant, weil jeder Fachmann weiß, dass ein guter Impfstoff frühestens in einem Jahr genutzt werden kann. Auch Bill Gates kann nicht zaubern. Dazu kommt, dieser Impfstoff müsste dann hochwahrscheinlich vor Covid-20 schützen. Zweite Welle? Mit welchem fachlichen Geheimwissen wird davor gewarnt, mit welchen Quellen? Es ist eine hochspekulative Hypothese, die gerade im geöffneten Österreich faktisch widerlegt wird. Und warum wurde, wenn man so viel Angst davor hat, eine Herdenimmunität durch den Lockdown verhindert? Das alles spricht nicht für ein reflektiertes, kompetenzgesteuertes Krisenmanagement.

Eine kompetente Risikoanalyse hätte den falschen Alarm schon längst abgeblasen. Der Pandemie Krisenstab im Max-Weber-Land, hätte frühzeitig Großveranstaltungen abgesagt und bei den früh bekannten Risikogruppen die entsprechenden Maßnahmen zum Schutz dieser Gruppe diskutiert sowie professionell, konsequent und human umgesetzt (auch mit Hilfe der präventiv angelegten Pandemievorräte). Man hätte Pläne ausgearbeitet für Schwerpunktkrankenhäuser, die von den zuständigen Spezialisten, den Lungenfachärzten geleitet worden wären. Man hätte Hausärzte, Palliativmediziner und Pflegedienste einen eigenen Stab bilden lassen, um gute Lösungen für die ambulante Versorgung der Schwerkranken und Pflegebedürftigen zu finden.

Vor allem hätte der Krisenstab eine umfassende Risikoanalyse der weitergehenden Schutzmaßnahmen durchgeführt und festgestellt, dass deren Schadenspotential extrem hoch ist. Spätesten Mitte März hätte der Krisenstab festgestellt, dass bezüglich einer die Allgemeinheit bedrohenden Pandemie ein falscher Alarm besteht. Weil das Risikopotential von Covid 19 bezogen auf die Allgemeinheit deutlich geringer ist, als das der weiteren Schutzmassnahmen (Schulschliessungen und Lockdown), hätte man diese nicht eingeleitet. Daraufhin hätte der Krisenstab die Politik und diese die Bevölkerung entsprechend informiert. Daraufhin wäre der Krisenstab nach Hause gegangen, um die anderen ihre Arbeit machen zu lassen.

So wäre die Risikoanalyse im Max-Weber-Land verlaufen. In der Bundesrepublik Deutschland und in fast allen anderen Demokratien kam es bekanntlich anders. Warum das so ist, und was wir vor allem Anderen ändern müssen, um solche Desaster in Zukunft zu vermeiden, darum geht es in dem nächsten und für mich abschließenden Corona Beitrag hier auf der Achse des Guten. Es geht vor allem darum wie die Demokratie es geschafft hat, ihre eigentliche Stärke, die offene Debatte, in eine Schwäche zu verwandeln.

Falls sie diesen Beitrag plausibel finden, dann verbreiten Sie ihn bitte weiter.

Der Beitrag erschien zuerst bei ACHGUT hier