Claudia Kemfert bei Lanz: Gut behauptet ist glatt daneben!

Der Teil, in welchem Kemfert Markus Lanz und Friedrich Merz Rede und Antwort steht, ist hier als Video-Ausschnitt verfügbar. Die wesentlichen Aussagen (ab Minute 9:47) zur Energiewende und deren Machbarkeit sind hier transkribiert:

Merz: Wir können das hier alle machen, nur, wenn uns gleichzeitig hier in Deutschland die Wirtschaft kaputtgeht, wenn die Arbeitsplätze verlorengehen.

Kemfert: Das ist genau das Argument, was ich meine…

M.: Sie kriegen mit Windenergie und Sonnenenergie die Arbeitsplätze nicht ersetzt…

K: Doch, natürlich, so, doch, wir sind jetzt hier an einem Punkt…

M.: …die in der Stahlindustrie, der Zementindustrie in der gesamten Papierindustrie und überall ver … Nein, da sind wir an ´nem Punkt, wo wir uns nicht einig werden. Da sind einige unterwegs, die glauben, man könnte das ganze System sozusagen auf den Kopf stellen und dann Umwelt machen, und wir machen hier zwei Prozent der weltweiten Emissionen und drumherum werden die Kernkraftwerke hochgefahren und die Kohlekraftwerke hochgefahren, damit Deutschland mit Strom versorgt werden kann.

K: Das stimmt alles nicht

M.: Die Rechnung geht nicht auf, …

Kemfert: Ja aber, das stimmt [nicht], man muss jetzt wirklich massiv, nein, nein, aber man muss wirklich widersprechen, weil das tatsächlich nicht. … Keiner der Punkte. Also wir können auch dieses Land mit einer Energieversorgung aus erneuerbaren Energien sicherstellen. Sie haben in Ihrer Partei zugelassen, dass wir viele Jobs in der Solarindustrie verloren haben, auch in der Windindustrie. Wir könnten auch Solarenergie auch in Deutschland wieder produzieren, in Europa jetzt auch durch die Wirtschaftshilfen, die dort getätigt werden. Das ist das eine. Jobs entstehen … wichtige Industriejobs, die dort entstehen.

Energiewirtschaftlich macht es auch Sinn, gerade wenn wir die Industrie dekarbonisieren, dass wir auch dort Ökostrom nutzen zur Herstellung von Wasserstoff, grünen Wasserstoff, und da auch die Möglichkeit schaffen, die Industrie hier im Land zu lassen. Wir wollen ja nicht, dass die abwandert. Nur Ihre Argumente sind immer, das muss man auch bezahlen, Sie sagen aber indirekt mit dem Marktinstrument, der Preis, das hab´ ich Ihnen eben schon vorgerechnet, der würde massiv nach oben gehen und das schadet ja der Industrie. Also insofern muss man da schon eine Balance finden, den Preis jetzt so vorzugeben macht dann Sinn, weil sich die Industrie auch auf diese Preisorientierung einstellen kann. Und: Der Strompreis sinkt, um diesen Punkt zu machen, mit einem höheren CO2-Preis sinkt der Strompreis, weil die EEG-Umlage sinkt. […].

Kommentar:

Zu diesem Wortwechsel einige Bemerkungen: Frau Kemfert meint, dass sich die Energieversorgung Deutschlands komplett mittels erneuerbarer Energieträger sicherstellen lasse. Dann springt sie zur Produktion von Solarmodulen und Windkraftanlagen, wo viele Jobs verloren gingen. Das hat mit Energieversorgung allerdings nichts zu tun. Wichtig scheint ihr der Seitenhieb gegen Merz zu sein: Sie haben in Ihrer Partei zugelassen, … „.

Frau Prof. Kemfert macht nun das Fass „Industrie und Verhinderung der Abwanderung, grüner Wasserstoff, Dekarbonisierung und Kosten“ auf. Sie meint wohl den CO2-Preis, der vorgegeben werden sollte. Zwecks Kalkulierbarkeit. Ob und wann nach ihrer Meinung der Preis tragbar ist, darauf geht sie nicht ein.

Vom Zertifikatehandel spricht sie überhaupt nicht. Vor allem aber beantwortet sie nicht, weswegen es nicht stimme, was Friedrich Merz eingeworfen hat und weshalb wir „dieses Land mit einer Energieversorgung aus erneuerbaren Energien sicherstellen“ können. Frau Kemfert belegt ihre Behauptung nicht. Deshalb fragt Markus Lanz höflich, aber bestimmt nach:

Lanz: […] Woher kommt der Strom für die ganzen Elektroautos, die wir demnächst haben? Woher kommt der Strom, für den Wasserstoff, den wir erzeugen müssen, wenn wir CO2-freien Wasserstoff, äh …, Stahl erzeugen wollen? Und so weiter…

K: Richtig!

L.: …und so weiter. Ich kenne Projektionen von Kollegen von Ihnen, die sagen, in den nächsten paar Jahren wird der Energiebedarf einfach sich verdoppeln.

K: Nein, das stimmt nicht!

L.: Exakt verdoppeln.

K: Nein, nein, also da muss man jetzt unterschei …

L.: Kurz, nur ganz kurz, darf ich mal kurz ausreden?

K: Bitte.

L.: Die Frage ist: Wo kommt dieser ganze Strom…

K: Genau!

L.: …her, wenn wir gleichzeitig sagen, wir gehen raus aus der Kohle, wir gehen auch raus aus der…

K: Guter Punkt! Genau!

L.: …Atomkraft.

K.: Genau. Der Strom kommt aus erneuerbaren Energien, weil…

L.: Der gesamte deutsche Strom!

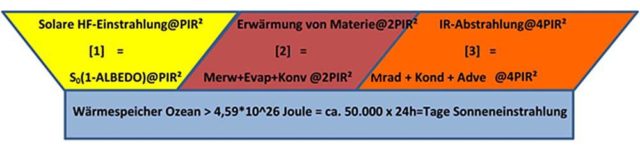

K.: …weil zwei Dinge passieren. Und das ist einmal diese fehlerhafte Annahme, die hier zugrunde gelegt wird. Der sogenannte Primärenergiebedarf, das ist der Energiebedarf, den wir auch für Wärme und Mobilität nutzen, sinkt, wenn wir den Ökostrom sofort nutzen. Das heißt der Ökostrom in die Wärmepumpe plus energetische Gebäudesanierung sinkt der Primärenergiebedarf. Der Öko …, das stimmt, der Ökostrom, die Mobilität, aber auch dort sinkt der Primärenergiebedarf, weil wir eine viel höhere Effizienz haben, weil wir Elektromobilität nutzen … sprich der Primärenergiebedarf halbiert sich, aber der Strombedarf erhöht sich…

L: Ja!

K.: ...und der Strombedarf erhöht sich und da kommt es jetzt darauf an, wie effizient wir sind, wenn wir im großen Stil Wasserstoff produzieren, den in die Autos tun, dann verschwenden wir ganz viel Ökostrom und müssen ganz viel zubauen. Wenn wir den aber direkt in die Ökoau … , Elektroautos tun, den Ökostrom, dann reduzieren wir den Primärenergiebedarf. Und das können wir schon auch in Deutschland sicherstellen. Die Frage mit der Industrie…

L.: Wir sind das einzige Land der Welt, dass das geht.

K.: […] Es ist nicht nur Glauben, wir können´s empirisch belegen. Und wir können´s auch fach…, in der Fachwelt darlegen. Das sind nicht nur wir, das sind die Scientists for Future. Die haben im Rahmen eines umfassenden Projektes das dargelegt, dass das funktioniert und auch wissenschaftlich bewiesen. (bis Minute 13:44)

Kommentar:

Die Antwort von Claudia Kemfert ist ein Konvolut von Sachverhalten, die alle irgendetwas mit Energieversorgung, mit Energiewende und mit regenerativ verfügbar gemachter Energie zu tun haben. Nur mit der Beantwortung der Frage, die Markus Lanz gestellt hat, damit hat die Antwort nichts zu tun.

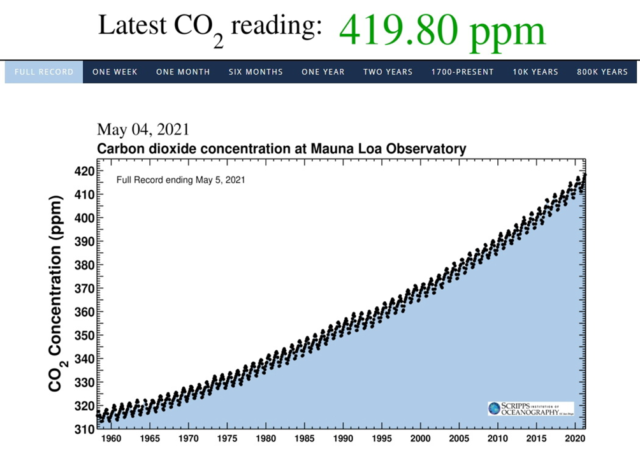

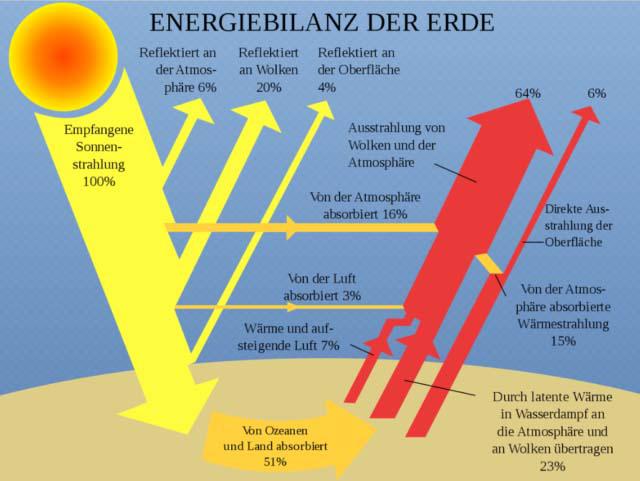

Hinzu kommt, dass die Aussagen in Teilen falsch sind. Wenn Frau Prof. Kemfert davon spricht, dass sich der Primärenergiebedarf halbiert, wenn sich der Strombedarf erhöht, ist das Unfug. Erneuerbar erzeugter Strom ist Teil des Primärenergieverbrauchs. Wobei im grünen Teil des Balkens auch die Gasherstellung und die Verflüssigung von Biomasse und nicht nur die Stromherstellung enthalten ist.

Dass Wasserstoffherstellung und die Rücktransformation in Strom sehr energieintensiv sind, weiß Frau Prof. Kemfert. „Ganz viel zubauen“ hieße konkret eine Versechzehnfachung (!) der installierten Leistung Windkraft und eine Verzweiunddreißigfachung (!) der installierten Leistung Photovoltaik, bezogen auf eine definierte Strommenge zum Laden von Autoakkus.

So viel zusätzliche installierte Leistung ist nötig, um den Strom über den (Um-)Weg „Wasserstoff“ (= aus 100 Prozent Strom werden 25 Prozent) bereitzustellen. Frau Kemfert hat also durchaus recht, wenn sie im Bereich Elektromobilität vom Wasserstoffpfad abrät. Das gilt jedenfalls so lange, wie die erneuerbare Stromerzeugung nicht 100 Prozent und mehr des Bedarfs Deutschlands zumindest im Durchschnitt deckt. Dieses Mehr kann dann als wirklich grüner Wasserstoff gespeichert werden. Das aber ist heute und wird auch in weiterer Zukunft nicht der Fall sein.

Frau Kemfert liegt mit ihrer Behauptung, die komplette Energieversorgung Deutschlands sei praktisch zu Tages- und Nachtzeit regenerativ sicherzustellen, komplett neben der Realität. Zur Frage, ob durch Elektromobilität tatsächlich fossiler Brennstoff eingespart wird, sei das Video mit den Ausführungen von Prof. Hans-Werner Sinn empfohlen.

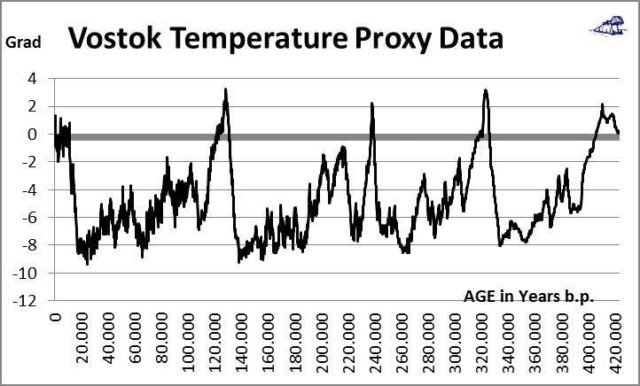

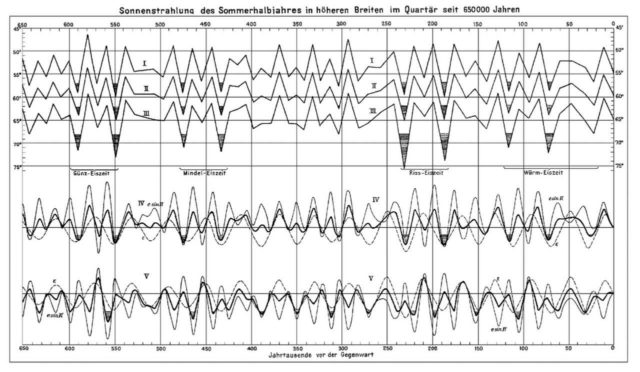

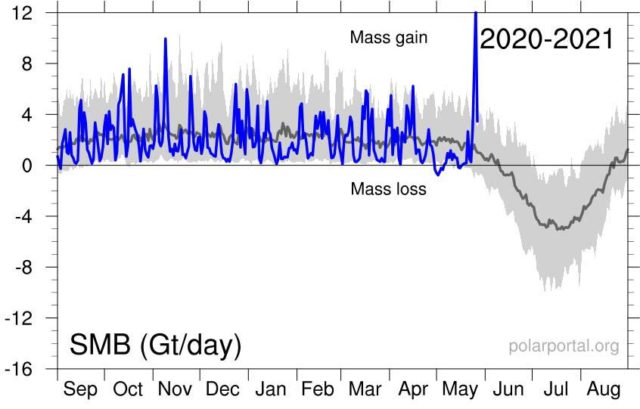

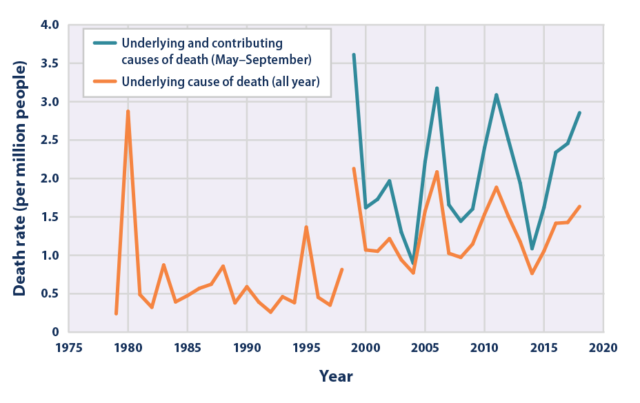

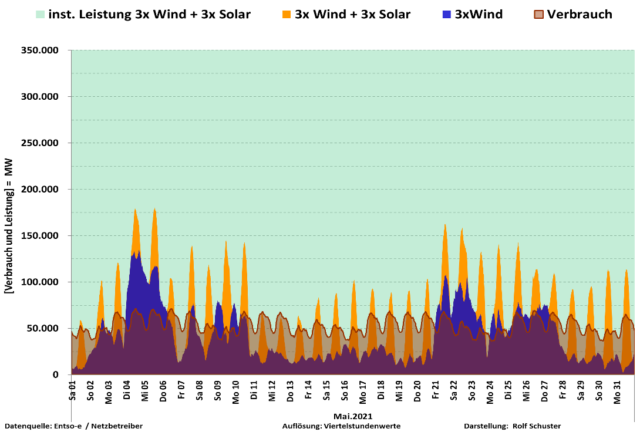

Die regenerative Stromerzeugung sah in den vergangenen Jahren wie dieser Chart aus. Etwa 50 Prozent beträgt die regenerative Stromerzeugung. Sie ist, von den praktisch kaum ausbaubaren Energieträgern Biomasse und Wasserkraft abgesehen, höchst volatil und nur schwer kalkulierbar. Mangels ausreichender Speichermöglichkeiten wird ein weiterer Ausbau der Wind- und Photovoltaik zu zeitweise, vor allem in der Mittagsspitze, erheblichem Überangebot mit starkem Preisverfall führen.

Belege für meine Behauptungen liefern die wöchentlichen Analysen der Kolumne „Woher kommt der Strom?“. Wie Frau Kemfert hingegen etwas fachlich und empirisch belegen will, bleibt bis auf den Verweis auf den 16-Punkte-Diskussionsbeitrag der Scientists for Future ihr Geheimnis. Doch selbst eine Umsetzung von deren Ideen reicht bei weitem nicht aus, um den um mehr als die Hälfte steigenden Strombedarf Deutschlands ab 2030 zu decken. Also hakt Friedrich Merz nach. Friedrich Merz fragt Frau Prof. Kemfert noch mal (Minute 14:51):

Merz: Wo kommt der Strom für die Aluminiumindustrie her, die sekundengenau den Strom braucht?

Kemfert: Das erläutere ich Ihnen gerne, weil es dazu wissenschaftliche Erkenntnisse gibt, die da folgendermaßen sind. Wir müssen in der Tat Solarenergie und Windenergie ausbauen, der Ökostrom, damit produzieren wir Wasserstoff, der auch in die Industrie geht. Die Frage ist in der Tat, ob wir das in Deutschland alleine können, oder ob wir den Wasserstoff importieren müssen. Da gibt es ja auch Kooperationen in Ländern, wo Ökostrom preiswert zur Verfügung steht und diesen Wasserstoff dann zu importieren, halte ich durchaus auch für sinnvoll. Da laufen ja auch Projektevorhaben und Kooperationen. Der Rest der Energie, der Ökostrom, den wir da brauchen, ist zu jeder Tages- und Nachtzeit produzierbar und auch speicherbar.

Es gibt genügend Studien, die belegen, dass wir ausreichend Speicher haben. Schon heute auch im Einsatz hätten, wenn wir den Markt dafür zulassen würden. Also eine Vollversorgung mit erneuerbaren Energien ist möglich

M.: Also ich komm‘ vom Land. Bei mir zuhause scheint nachts die Sonne nicht.

K.: Ja, aber da weht zum Beispiel auch der Wind, auch bei Ihnen. Dazu gibt es empirische Erkenntnisse…

Der Beitrag erschien zuerst bei ACHGUT hier

M: Es gibt Tage, da weht null Wind, wir haben keine Sonne.

K.: …wie auch der Wind… Sie machen ein Extremszenario, was wir nachweisen können, was es einmal im Jahr maximal für zehn Tage gebe. Die restlichen Tage haben wir erneuerbare Energien im Überschuss. Und das ist wissenschaftlich belegt.

Kommentar:

Frau Kemfert meint, mit dem Begriff „wissenschaftlich“ einen Beleg für die Richtigkeit ihrer Aussagen an sich zu haben. Das erinnert an ein Kind, dass die Augen zu macht und glaubt, nicht gesehen zu werden. Der weitere Ausbau von Windkraft- und Photovoltaikanlagen ist keine wissenschaftliche Erkenntnis, sondern für Energiewender eine Binsenweisheit. Dann präsentiert Frau Prof. Kemfert wieder das Thema „Wasserstoff“. Scientists for Future haben die Herstellung von Strom und Wasserstoff (ein feines Feature des Dlf zum Thema) völlig richtig problematisiert. Dass da „Kooperationen und Projektvorhaben“ laufen, ist ja schnell gesagt. Diese werden aber keinesfalls das Wasserstoffvolumen liefern können, das notwendig ist, um z.B die bundesdeutsche Stahl- und Chemieindustrie „grün“ zu machen. Das sind fromme Wünsche, die mit der Wirklichkeit nicht viel zu tun haben. Genauso wie der letzte Satz nach dem Einwurf von Friedrich Merz:

Kemfert: …

(M: Es gibt Tage, da weht null Wind, wir haben keine Sonne)

wie auch der Wind … Sie machen ein Extremszenario, was wir nachweisen können, was es einmal im Jahr maximal für zehn Tage gebe. Die restlichen Tage haben wir erneuerbare Energien im Überschuss. Und das ist wissenschaftlich belegt.

Kommentar:

Die letzten beiden Sätze von Frau Prof. Kemfert sind nicht „wissenschaftlich“. Sie sind falsch. Genau wie die Behauptung, es gäbe „ausreichend Speicher“, die angeblich der Markt nicht zulässt. Das ist Unfug. Ohne Wenn und Aber. Selbstverständlich gibt es Flauten. Auch nachts. Doch selbst wenn der Wind weht. Ohne konventionelle Energieträger, die regelmäßig fehlenden Strom bis zur Deckung des Bedarfs auffüllen, ohne die konventionelle Stromerzeugung wären in Deutschland schon längst die Lichter ausgegangen.