Dass die zurückliegende Trockenheit nicht mehr nur ein Wetterphänomen …

Plötzlich belegen 10 Jahre Wetter ein Klima

Leider stand im langen Artikel [1] nicht, wo diese Statistiken zu finden sind. Vielleicht antwortet der Amtsleiter jedoch auf die Nachfrage des Autors. So lange diese Antwort nicht vorliegt, muss man sich mit den Daten anderer Ämter begnügen, um herauszufinden, was den Amtsleiter zu seiner Aussage bewogen hat.

Nachtrag: Nach Abgabe des Artikels kam die Antwort des Amtsleiters. Da diese Antwort seine Aussage neu darstellt und auch erklärt, ist sie am Ende des Artikels beigefügt.

Dabei soll nicht gesagt werden, dass der Niederschlag während der letzten Zehn Jahre nicht geringer wurde. Doch wie (bewusst) irreführend diese Argumentation im klimahistorischen Gesamtkontext zu sehen ist, sei anbei gezeigt.

Wie unwissend muss ein Redakteur sein, der den Unterschied zwischen 10 % und

90 % nicht bemerkt?

Der Redakteur der Nordbayerischen Nachrichten (Politikredakteur), welcher meinte, sich nach seinen anderen Redakteurskollegen endlich auch einmal mit dem Klima versuchen zu müssen, interviewte neben dem Amtsleiter der Wasserwirtschaftsbehörde auch den Chef der staatlichen Forstbetriebe Nürnberg, wohl überzeugt, dadurch fundierte Information über den schlimmen Klimawandel-Einflusses im Großraum Nürnberg zu erhalten.

Und diese Fachperson belegte ihm auch sofort mit konkreten Zahlen die extreme Trockenheit in Mittelfranken:

[1] Johannes Wurm, Chef des staatlichen Forstbetriebs Nürnberg. Von Januar bis einschließlich April seien schließlich gut 90 Prozent weniger Niederschläge als im sonst üblichen Durchschnitt gefallen …

Leider hat der Redakteur jedoch absolut keine Ahnung vom Thema. Sonst hätte ihm der platte Fehler auch dieser Aussage sofort auffallen müssen. Der Forstbetriebschef (oder war es vielleicht der Redakteur selbst beim Niederschreiben?) hat in seiner Aussage zwei Zahlen vertauscht:

In Nürnberg sind in diesem Zeitraum nicht 90 % weniger Niederschlag gefallen, sondern der Rest zu 100 %, also gerade einmal 10 % weniger. Das macht in der Aussage allerdings einen gewaltigen Unterschied. Ein Leser hat es im Kommentarteil erklärt:

Phileas schrieb am 16.06.2020, 07:10

Die Aussage des Experten „von Januar bis einschließlich April seien schließlich gut 90 Prozent weniger Niederschläge als im sonst üblichen Durchschnitt gefallen. Dieses Defizit ist lange noch nicht ausgeglichen“ ist so etwas von falsch, falscher geht es nicht. Wie man auf der Seite:“ Monats- und Jahreswerte für Nürnberg“ unschwer feststellen kann sind in diesem Zeitraum 92,5 (!) Prozent der sonst üblichen Niederschläge gefallen. Dies deckt sich in etwa auch mit meinen eigenen Messungen. Wenn ich der bis gestern Nachmittag auf dieser Wetterseite angegebene Niederschlagsmenge noch die von mir für heute Nacht gemessenen 3 Liter hinzuzähle sind wir momentan, 5,5 Monate in diesem Jahr, genau bei 100,5 Prozent der üblichen Niederschlagsmenge. Also erstmal absolut normal. Es gibt heuer bis jetzt kein Niederschlagsdefizit in unserer Gegend.

Irgendwie habe ich den Eindruck, dass da manchmal gezielt Panik verbreitet werden soll. Wie kann der angebliche Experte sagen, dass von Januar bis April gut 90 Prozent weniger Niederschläge gefallen sind, wenn es tatsächlich nicht einmal weniger als 10 Prozent waren.

Beim Klimawandel ist Kenntnis in der Redaktion nicht erforderlich, da die „richtige“ Meinung ausreicht

Dabei „warnt“ der Autor die Redaktion der „Nordbayerischen Nachrichten“ schon fast regelmäßig vor ihren Eigentoren infolge ihrer sorgfältig „gepflegten“, fachlichen Unkenntnis zum Thema Klimawandel (und auch Ökoenergie), Beispiele:

EIKE 25. Mai 2020: [Link] Frühjahrstrockenheit mittels CO2-Reduktion bekämpfen. Wenn nicht gehandelt wird, hat die Durststrecke kein Ende

EIKE 08.06.2020: [Link] Corona ist vorbei. Nun hat uns der alltägliche Wahnsinn wieder

Und ganz konkret auch vor den „lokalen“ Förstern und deren (bewusst?) mangelhaften Klimakenntnissen:

EIKE 25. April 2020: [Link] Wenn Medien immer nur Personen mit der gleichen Meinung fragen, können sie (und diese Personen) nie gescheiter werden

… Zwischenzeitlich hat es sich etwas eingespielt, dabei zwischen lokalen Klimamanager*innen und Förstern von Stadt und Land abzuwechseln. Das suggeriert Meinungsvielfalt, obwohl der Autor versichern kann, dass die Antworten der von den Medien ausgesuchten immer auf das Gleiche hinauslaufen: Ja, es kann nur der Klimawandel sein, zumindest scheint es ein deutliches Indiz dafür …

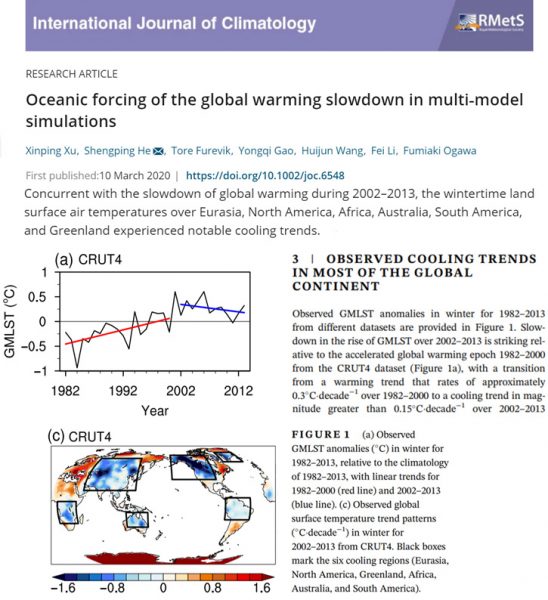

Dabei steht es sogar beim Umweltbundesamt, dass der Niederschlag zunimmt

[3] Umweltbundesamt 20.03.2020: Trends der Niederschlagshöhe

Seit 1881 hat die mittlere jährliche Niederschlagsmenge in Deutschland um rund 10 Prozent zugenommen. Dabei verteilt sich dieser Anstieg nicht gleichmäßig auf die Jahreszeiten. Vielmehr sind insbesondere die Winter deutlich nasser geworden, während die Niederschläge im Sommer geringfügig zurückgegangen sind.

… Die Zeitreihe der jährlichen Niederschläge in Deutschland (Gebietsmittel) zeigt einen leichten Anstieg, der mit einer Irrtumswahrscheinlichkeit von 5 %-Niveau statistisch signifikant ist. Dieser Anstieg ist im Wesentlichen darauf zurückzuführen ist, dass bis etwa 1920 nur selten überdurchschnittlich niederschlagsreiche Jahre aufgetreten sind.

Deutlich stärker noch als bei der Temperatur ist dieser Trend nicht gleichmäßig in allen Jahreszeiten ausgeprägt. Er beruht im Wesentlichen darauf, dass die Winterniederschläge um über 25 % zugenommen haben. Frühling und Herbst zeigen ebenfalls eine leichte, aber im Gegensatz zum Winter nicht signifikante Zunahme, während die Niederschläge im Sommer geringfügig zurückgegangen sind …

Statistiken der Wasserwirtschaftsbehörden

Sind wie der Autor schon sagte, ihm nicht bekannt. Eine Internetsuche danach blieb leider erfolglos. Über einen Link einer der regionalen Wasserwirtschaftsbehörden fand sich allerdings ein ganz aktuelles Dokument, welches vielleicht so etwas sein könnte:

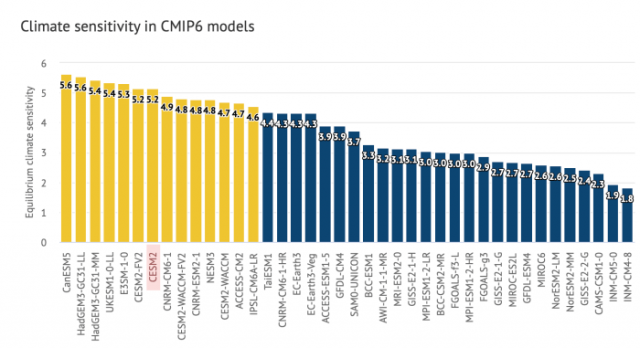

[2] Bayerisches Landesamt für Umwelt, April 2020: Das Bayerische Klimaprojektionsensemble Audit und Ensemblebildung

Wie es schon der Name verrät, findet sich darin allerdings keine Statusdarstellung anhand von Messwerten, sondern – modern nach „Merkel“ ausgedrückt -, ist es die Sammlung einer Klima-Simulationsorgie.

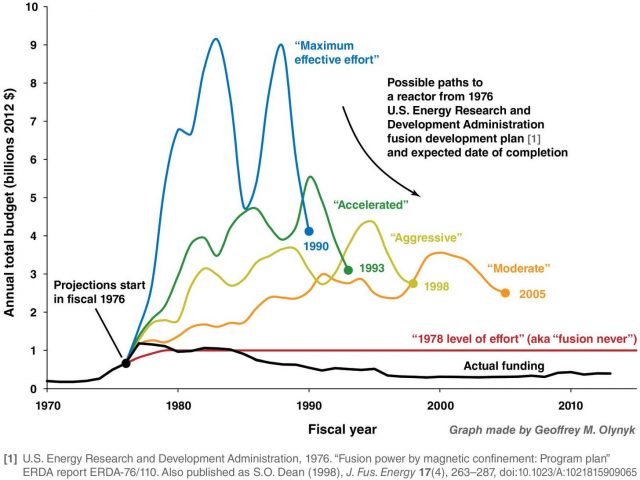

Und das Ergebnis ganz kurz gefasst lautet (rein persönliche Meinung des Autors und durch keine Simulation erhärtet): Die Niederschlagssimulationen für Bayern sind grottenschlecht und können weder den aktuellen Status und sicher auch nicht die Zukunft abbilden. Man macht es aber trotzdem, weil es heute eben üblich ist (und gut bezahlt wird). Um „genauer“ zu werden, lässt man die zu offensichtlich falschen Simulationen weg und verwendet selbstverständlich nur die „richtigen“.

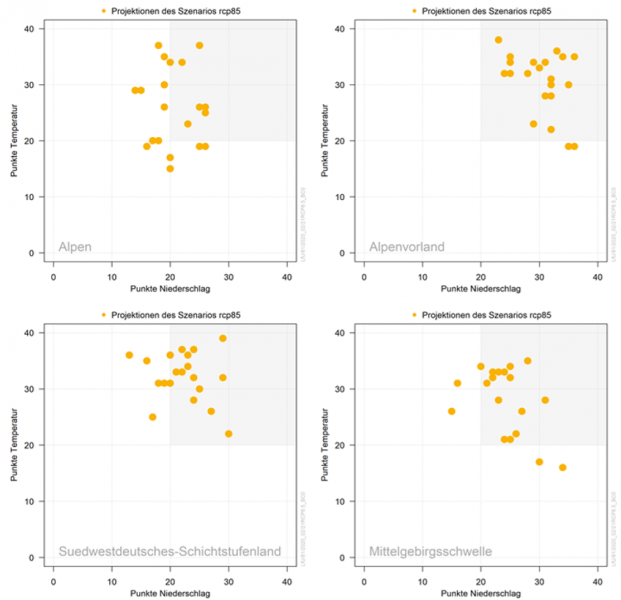

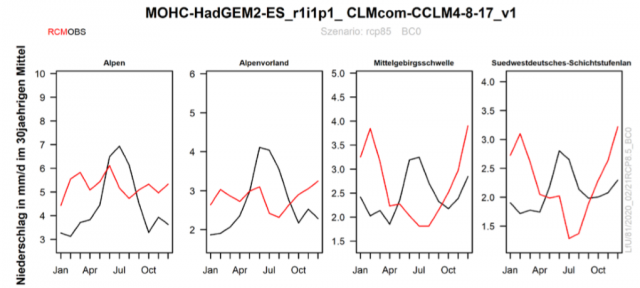

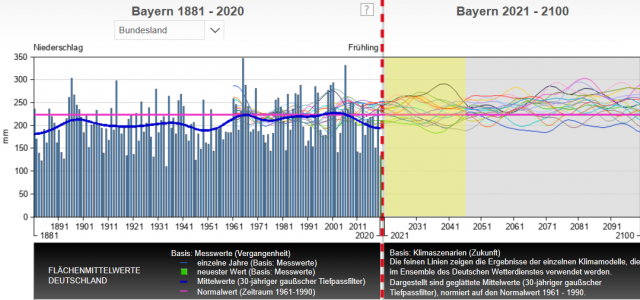

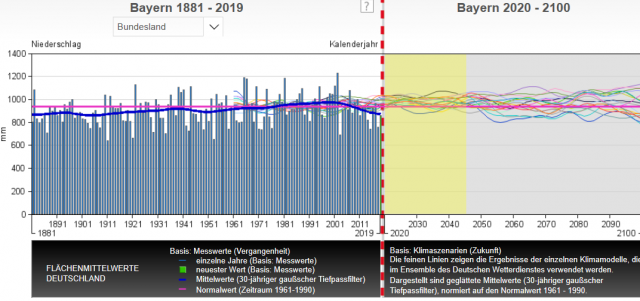

Die folgenden Diagramme zeigen daraus eine „Niederschlagszukunft“ für die Alpen. Erst einmal fällt auf, dass der Niederschlag in Zukunft auch im Frühling zunehmen soll.

Personen mit Ahnung von Statistik erkennen zusätzlich, dass es sich bei den Simulationsergebnissen um Punktwolken handelt. Das ist ein Beleg, dass zwischen den Simulationsergebnissen kein innerer Zusammenhang herrscht, genauer: Die Ergebnisse sind regellos und zufällig, also ohne statistischen Aussagewert. Jeder kann sich das „gewünschte“ Ergebnis heraussuchen und jedes „Ergebnis“ hat die gleiche Wahrscheinlichkeit richtig, oder falsch zu sein.

Obwohl das Bayerische Landesamt für Umwelt auf ihrer Homepage zum Thema „Emissionsszenarien“ [Link] mitteilt: Ein großer Teil der zur Verfügung stehenden und derzeit am Bayerischen Landesamt für Umwelt betrachteten Klimaprojektionen basieren überwiegend auf dem Emissionsszenario A1B …

verwenden die Ersteller von Auftragsprojekten wohl „gerne“ das Extremszenario rcp8.5.

Das macht eigentlich nur (noch) das PIK, um regelmäßig den Weltuntergang vorzuführen. Inzwischen gilt dieses auch offiziell als unseriös, da übertrieben. In Bayern scheint die Verwendung dieses Extremszenarios trotzdem üblich zu sein, zumindest, wenn „Klimazukunft“ in Zusammenarbeit mit der Uni München erstellt wird, denn auch in der von dieser mit erstellten Pilotstudie „Klimawirkungskarten Bayern“ des Landesamtes für Umwelt wird auf Basis dieses extremsten Szenarios simuliert.

[2] … Durch die beiden Modellfamilien (ESD und RCM) wird somit ein sehr breites Spektrum an Änderungssignalen aufgespannt. Dies erschwert eine klare Aussage insbesondere über das zukünftige Niederschlagsverhalten. Am deutlichsten ist die sommerliche Niederschlagsabnahme ausgeprägt, die im Einklang zu Ergebnissen früherer Studien auf Basis von SRES A1B-Projektionen aber auch zu Beobachtungen in anderen Regionen in Deutschland steht (HÜBENER ET AL. 2017a). Weiterhin lässt sich deutlich eine Tendenz zur winterlichen Niederschlagszunahme für Nordbayern ableiten. Für den Süden ist aufgrund der enormen Schwankung des Änderungssignals keine konkrete Aussage möglich.

Und in einem früheren Dokument direkt als Handlungshinweis herausgestellt:

[4] … Zudem wurde im Laufe des Jahres 2018 eine Methode zur Qualitätsprüfung von Klimaprojektionen am LfU entwickelt und angewendet. Mithilfe dieses Audits wurden gravierende Schwächen (z. B. inverse Jahresgänge des Niederschlags) der Projektionen 10 und 11 entdeckt. In-sofern wird von einer Verwendung der Klimawirkungskarten als Planungsgrundlage abgeraten. Vielmehr sollten die Karten als Anregung für vertiefende Untersuchungen und die Pilotstudie zur Erprobung und Bewertung der eingesetzten Methoden dienen …

Im DWD-Klimaviewer sieht man die eklatanten Mängel der Niederschlags-Klimasimulationen augenscheinlicher. Obwohl darin ein Standardszenario Verwendung findet, erfassen nur ganz, ganz wenige Simulationsläufe den aktuellen Niederschlag. Im Jahr 2100 werden ihn einige aber vielleicht trotzdem „erfolgreich“ vorhergesagt haben, denn bei dieser Streuung „trifft“ möglicherweise irgendeine der vielen Simulationsläufe – obwohl man selbst da nicht so ganz sicher sein kann …

In einem Bundesland wird der Bürger darüber auch informiert:

Hessisches Landesamt für Naturschutz, Umwelt und Geologie Niederschlag: [Link] Zeitliche Trends

… Der lineare Trend zeigt für den Sommer –16 % und für die übrigen drei Jahreszeiten +17 % (Frühling) bzw. +12 % (Herbst und Winter). Man sollte diese Trends aber keinesfalls überbewerten: Alle hier aufgeführten Niederschlagstrends sind wegen der sehr großen Variabilität des Niederschlags nicht signifikant (auf dem 95%-Niveau) …

Interessant ist in dem Dokument die Aussage zur (simulierten) zukünftigen Trockenheit für Nordbayern, dass es dort keine Änderungen geben soll: [4] Beeinträchtigung wasserabhängiger Biotope durch Trockenheit

Die letzten 10 Jahre Niederschlag

Zur Erinnerung. Der Amtsleiter erklärte dem Redakteur, warum die gerade vergangene Frühjahrstrockenheit ein Zeichen des Klimawandels wäre: „Dass die zurückliegende Trockenheit nicht mehr nur ein Wetterphänomen, sondern Folge der Klimaveränderung ist, dafür sprechen die Statistiken der Wasserwirtschaftsbehörden. „Wir haben seit zehn Jahren ein Niederschlagsdefizit“, sagt Amtsleiter Fitzthum …

Es verwundert, warum von diesem „Klimafachmann“ ein kurzer Zeitraum von gerade einmal zehn Jahren angezogen wird, wo beim Niederschlag wegen dessen extremer Variabilität nicht einmal der 30-jährige, meteorologische Zeitraum für Trendaussagen ausreicht:

EIKE 03. Mai 2020: [Link] Wie der Bund Naturschutz Bayern vor der schlimmen Frühjahrstrockenheit rettet

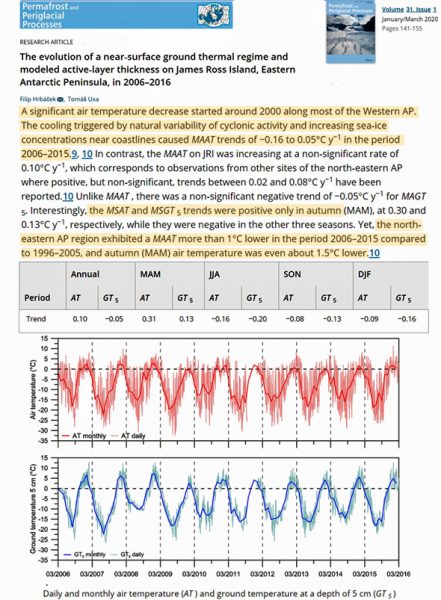

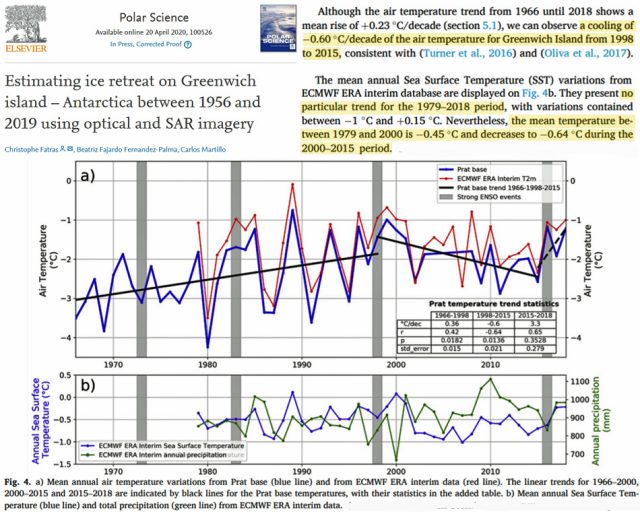

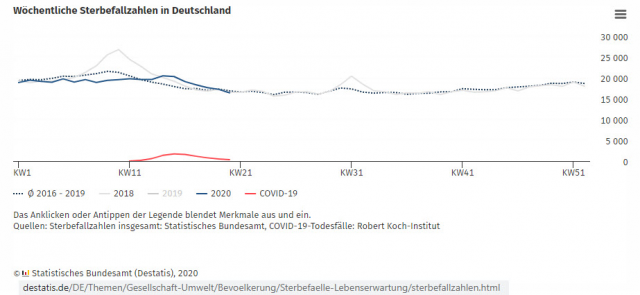

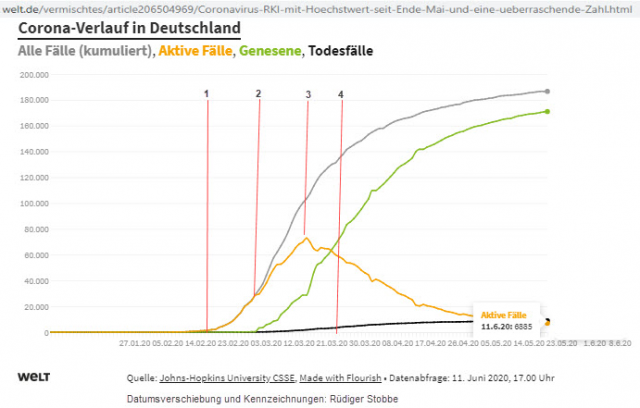

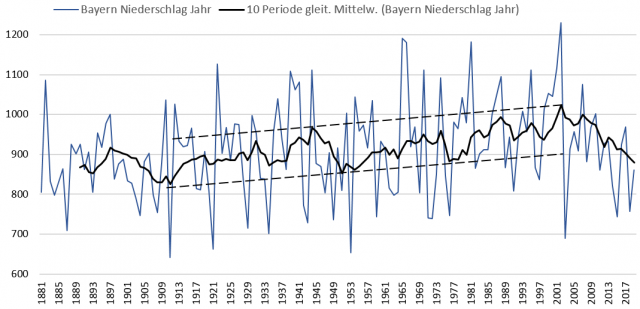

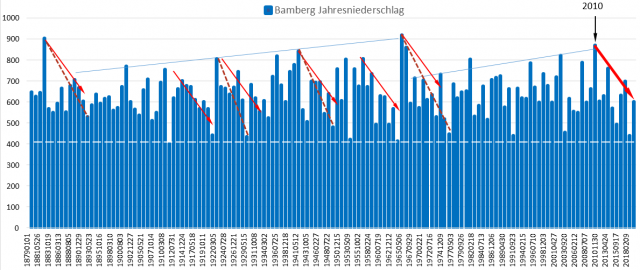

Die folgenden Bilder zeigen jedoch, warum genau dieser, vollkommen unübliche Zeitraum gewählt wurde: Seit ca. 2005 zeigt der Niederschlag eine Abnahme.

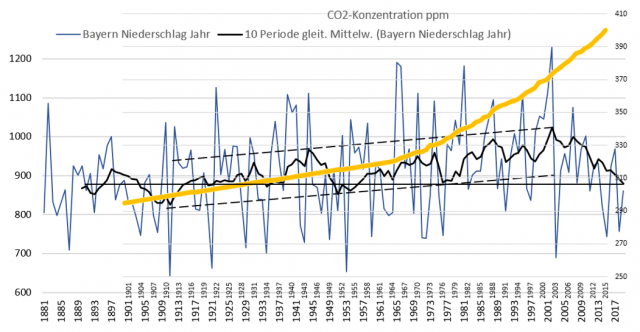

Allerdings stellt sich die Frage, welche Verbindung diese Abnahme mit der globalen CO2-Emission haben soll.

Würde dies stimmen, dann hätte sich der Niederschlag vorher über 100 Jahre lang nach der „falschen“ CO2-Regel verhalten. Und nun, infolge weiteren Emissionsanstiegs durch „Besinnen“ auf die angeblich „richtige“, ausgerechnet den Niederschlag zu Beginn des „Klimawandels“ , mit dem damals geringem CO2-Anteil erreicht.

Unplausibler kann eine Argumentation kaum sein.

Stellt man den Mittelwert des Niederschlags auf den meteorologischen Zeitraum von Dreißig Jahren, sieht man es noch deutlicher:

Nun gibt es zum Glück gerade im (angeblich) austrocknenden Mittelfranken eine sehr lange Niederschlagsreihe. Und diese zeigt geradezu lehrbuchgemäß, wie konsequent der behördliche „Klimafachmann“ des Wasserwirtschaftsamtes den kenntnis- und arglosen Redakteur mit seiner Aussage „über den Tisch“ gezogen hat:

Seit dem Beginn der langen Messreihe gibt es viele, viele Beispiele vergleichbarer, zyklisch niederschlagsreduzierender 10-Jahres-Zeiträume. Nur den angeblichen Beleg, dass ausgerechnet der aktuelle eine Auswirkung und Tendenz unserer CO2-Emission sein soll, findet sich nicht.

Vielleicht ging der Behördenleiter davon aus, im Einflussbereich der sich inzwischen ideologisch eng an der „Alpenprawda“ orientierenden, Nordbayerischen Nachrichten gäbe es keine(n) Leser mehr, dem es auffallen würde.

Der Klimawandel macht dumm

Der Autor hat schon länger vermutet, seitdem man in Deutschland als herausragend intelligent angesehen wird, sofern man Megawatt als Megabyte, Kobalt als Kobolde und Stromnetze als Stromspeicher bezeichnet, oder den zweithöchsten Strompreis der Welt als eine Kostenminderung dank dem billigen Ökostrom erklärt [6]. Er konnte es aber trotz seiner vielen EIKE-Publizierungen als Laie nie ausreichend, wissenschaftlich fundiert belegen.

Mit ausreichender Geduld kann man jedoch sicher sein, dass die enormen Klimawandeleinfluss-Forschungsmittel irgendwann zu jedem Problem rund um den Globus eine wissenschaftlich abgesicherte Expertise generieren.

So geschah es auch und wurde nun von einer Gruppe vorwiegend in der Klimawandelforschung zu findenden, herausragenden Wissenschaftlern in einer bahnbrechenden Publikation beschrieben:

[5] Der Klimawandel könnte uns mehr schaden, als wir vielleicht ahnen. Forscher glauben, dass uns eine „Verdummung“ der Menschheit bevorsteht

Ein Forscherteam der Universität von Colorado Boulder, der Colorado School of Public Health und der Universität von Pennsylvania deutet an, dass wir uns im Rahmen des Klimawandels nicht nur wegen eines möglichen Weltuntergangs Sorgen machen sollten. Stattdessen könnten wir aufgrund der veränderten Umweltbedingungen immer dümmer werden.

Was uns anstelle eines Weltuntergangs, der von vielen Forschern, aber auch Persönlichkeiten wie Elon Musk bereits ab dem Jahr 2050 vorhergesagt wird, bevorstehen soll, ist erstaunlich. Den Forschern zufolge sollen erhöhte Level an CO2 in der Erdatmosphäre zu kognitiven Beeinträchtigungen beim Menschen führen.

… Es gibt bereits Nachweise dafür, dass zu viel CO2 in der Luft zu kognitiven Problemen führen und die Fähigkeit zur Konzentration und zu Lernen senken kann. Frische Luft kann diesen Effekt aufheben, jedoch wird diese im Rahmen des Klimawandels immer knapper werden. Laut den Forschern könnte das zu eine „Verdummung“ der Menschheit führen

… Neben den neuen Erkenntnissen bleibt aber auch die Möglichkeit eines Weltuntergangs durch den Klimwandel ein Zukunftsszenario, dem keiner freudig entgegensieht.

Die Recherchen des Autors lassen vermutet, dass dieser wirklich schlimme und scheinbar nicht umkehrbare Klimawandeleinfluss bereits viel früher, als es diese Wissenschaftler terminieren und dazu noch mit einem Kipppunkt, der bereits eingetreten ist …

Nachtrag und Richtigstellung zur Aussage des Amtsleiters

Nach Abgabe des Artikels kam die Antwort des Amtsleiters vom Nürnberger Wasserwirtschaftsamt auf die Nachfrage zu seinen im Zeitungsartikel angegebenen – und hier heftig kritisierten – Aussagen. Da diese Antwort den Sachverhalt neu darstellt, anbei die Information (Auszüge):

Laut dem Amtsleiter wurde dem Redakteur der Sachverhalt erklärt, dass die letzten Zehn Jahre der Niederschlag abnimmt (Zitierung): … Grundlage meiner Aussage sind die Aufzeichnungen an Niederschlagsmessstationen in unserem Amtsgebiet. Diese ergeben z.B. für die Messstation Buch in Nürnberg für die Zeit 01.01.2010 bis 31.12.2019 einen Gesamtniederschlag von ca. 5978 mm. Im Vergleich zu langjährigen Mittelwerten von ca. 640 mm pro Jahr (1961 – 90: 644 mm, 1981 – 2010: 637 mm) bedeutet das ein Defizit von über 400 mm in zehn Jahren. An anderen Stationen fällt die Differenz noch deutlich negativer aus und beträgt bis zum Eineinhalbfachen des durchschnittlichen Jahresniederschlags. Diese Defizite spüren wir mittlerweile vor allem im Bodenwasserhaushalt …

Zu der weiterführenden – und speziell kritisierten – Aussage im Zeitungsartikel „Dass die zurückliegende Trockenheit nicht mehr nur ein Wetterphänomen, sondern Folge der Klimaveränderung ist“, kam der Hinweis:

„ … Sie deuten an, dass man mit solchen Auswirkungen allein noch nicht den Klimawandel belegen kann, was ich auch nicht getan habe. Von mir stammt die reine Tatsachenfeststellung: „Wir haben seit zehn Jahren ein Niederschlagsdefizit“.

Die Bewertung: „Dass die zurückliegende Trockenheit nicht mehr nur ein Wetterphänomen, sondern Folge der Klimaveränderung ist, dafür sprechen die Statistiken der Wasserwirtschaftsbehörden“ wurde vom Redakteur vorgenommen. Im Artikel ist insofern das erste Anführungszeichen, das ich gelb markiert habe, irreführend. Lässt man es weg, ist der Text zutreffender … „

Damit bleibt die Kritik am Redakteur „hängen“, der aus der nicht konsequent genug eingegrenzten Aussage zum Niederschlagsdefizit wohl eigenmächtig den Klimawandel dazu fabuliert hat, um seinem Artikel die vom GRÜNEN Zeitgeist geforderte Richtung zu geben.

Quellen

[1] nordbayern 16.06.2020: Experten: Regen ist für Felder und Wald „Rettung im letzten Moment“

hans-peter.kastenhuber@pressenetz.de

[2] Bayerisches Landesamt für Umwelt April 2020 Das Bayerische Klimaprojektionsensemble Audit und Ensemblebildung

[3] Umweltbundesamt 20.03.2020: Trends der Niederschlagshöhe

[4] Bayerisches Landesamt für Umwelt: Pilotstudie „Klimawirkungskarten Bayern“

[5] FUTURE ZONE 24.12.2019: Der Klimawandel macht uns dumm – Studie zeigt Erschreckendes

[6] EIKE 08.06.2020: Corona ist vorbei. Nun hat uns der alltägliche Wahnsinn wieder