Gavins falsifizierbare Wissenschaft

Nun hatten Gavin und ich schon früher einige Berührungspunkte. Wir begannen unsere Korrespondenz in Gestalt einer Klima-Mailing-Liste, moderiert von Timo Hameraanta etwa um die Jahrtausendwende, vor Facebook und Twitter.

Der interessante Teil unseres Austausches war das, was mich davon überzeugte, dass er ein miserabler Programmierer war. Ich befragte ihn bzgl. seines Programms, dem GISS globalen Klimamodell. Mich interessierte, wie in diesem Modell die Energieerhaltung sichergestellt wurde. Ich fragte, wie am Ende eines jeden Zeitschritts im Modell verifiziert wird, dass Energie weder erzeugt noch vernichtet wird.

Er erwiderte, was ich bereits aus meiner eigenen Erfahrung wusste beim Schreiben iterativer Modelle, dass es nämlich immer ein gewisses Energie-Ungleichgewicht gibt von Beginn bis Ende des Zeitschritts. Falls sonst nichts weiter stellt die diskrete digitale Natur jeder Berechnung sicher, dass es leichte Rundungsfehler geben dürfte. Falls diesen nicht Rechnung getragen wird, können sie sich leicht akkumulieren und das Modell herabziehen.

Er sagte, dass das GISS-Modell diesem Ungleichgewicht Rechnung trägt mittels gleichmäßiger Verteilung der überschüssigen bzw. der fehlenden Energie über den gesamten Planeten.

Nun, das scheint vernünftig für triviale Größen des Ungleichgewichtes durch Digitalisierung. Aber was ist bei größerem Ungleichgewicht, wenn es durch irgendwelche Probleme bei den Berechnungen auftritt? Was dann?

Also fragte ich ihn, wie groß dieses Energie-Ungleichgewicht typischerweise sei … und zu meinem Erstaunen erwiderte er, dass er es nicht wisse.

Verblüfft fragte ich, ob es irgendeine Computer-Version einer „Murphy Gauge“ bzgl. der überschüssigen Energie gibt. Eine Murphy Gauge (unten) ist ein Messgerät, welches das Murphy’sche Gesetz berücksichtigt, indem es Ihnen erlaubt, einen Alarm ertönen zu lassen, wenn die Variable außerhalb des erwarteten Bereichs liegt … was natürlich der Fall sein wird, Murphy gibt es vor. Im Computer wäre das Äquivalent etwas in seinem Modell, das ihn warnt, falls zu viel oder zu wenig Energie einen gewissen Wert überschreitet.

Nein! Nicht nur, dass er kein Murphy-Messgerät hat, sondern auch, dass er keine Ahnung hat, wie weit sich das Modell von der Realität entfernt hinsichtlich der Energieerhaltung, weder im Mittel noch bei individuellen Zeitschritten. Er brachte es einfach mit jedem Zeitschritt wieder zurück ins Gleichgewicht, drehte sich um und ließ es laufen.

An dieser Stelle kam ich zu der Überzeugung, dass Gavin gegenüber seinem Modell viel zu unkritisch war. Ich schrieb mein erstes Computer-Programm im Jahre 1963, etwa zu der Zeit, als Gavin geboren worden war. Und ich traue Computermodellen nicht ein bisschen über den Weg. Sie beißen die Hand desjenigen, der sie füttert, schon bei der kleinsten Gelegenheit, selbst wenn man sie mit Murphy-Messgeräten eingrenzt … und dieses grundlegende Problem hat Gavin nie verstanden.

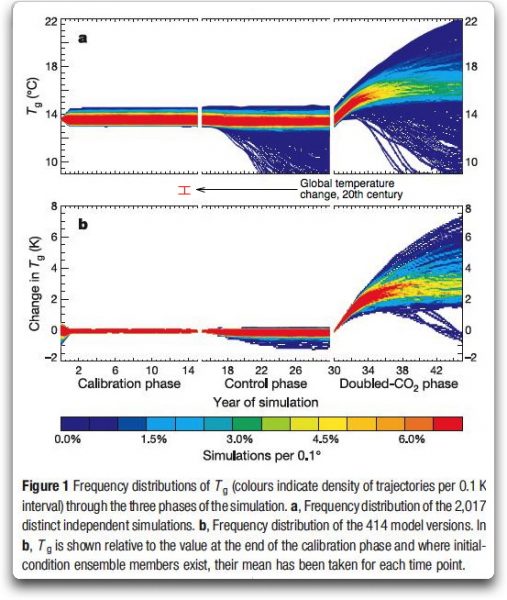

Dieses Problem stellt sich besonders bei dem, was „iterative“ Modelle genannt wird. Hierbei handelt es sich um Modelle, die Schritt für Schritt durch die Zeit rechnen, wobei das Ergebnis eines jeden Zeitschrittes in die Berechnung des nächsten Zeitschrittes eingeht. In solchen Modellen neigen die Fehler dazu, sich zu akkumulieren, so dass sie sehr leicht außer Kontrolle geraten … und Klimamodelle sind durch die Bank iterative Modelle. Die folgende Graphik zeigt eine große Anzahl von Modellläufen eines iterativen Klimamodells:

Abbildung 1b (unten) zeigt die Temperaturänderung. Man beachte, wie während der „Kontrollphase“, wenn es keine Änderung der Eingangsgrößen gibt, selbst ein kleiner kontinuierlicher Temperaturrückgang dazu führen kann, dass das Modell vom Boden des Graphen bis zur „Schneeball-Erde“ hinunterspringt, wie es die Kontrollphase der modellierten Temperatur in Abbildung 1a (oben) zeigt.

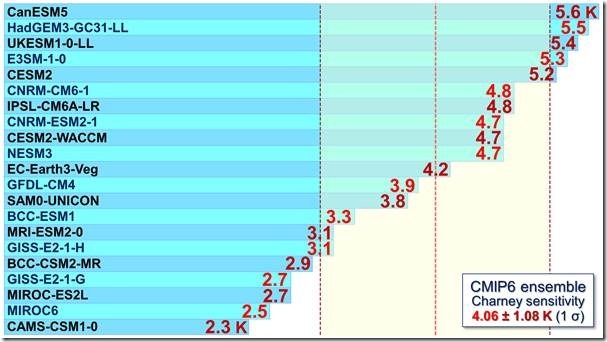

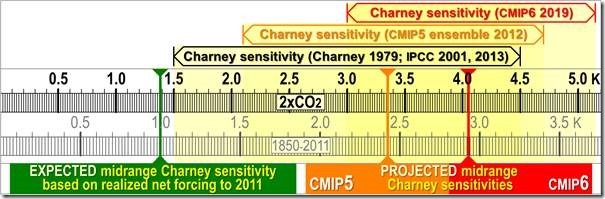

Also bin ich so argwöhnisch wie es nur geht hinsichtlich sämtlicher moderner iterativer Klimamodelle. Sie sind alle frisiert, um zur Vergangenheit zu passen … aber in allen davon sind die Klima-Sensitivitäten unterschiedlich. Wie kann das sein? Nun … es kann nicht sein. Es bedeutet, dass sie sich das nur ausdenken. Ich habe dieses Problem bereits hier beschrieben, und es ist ein großes Problem.

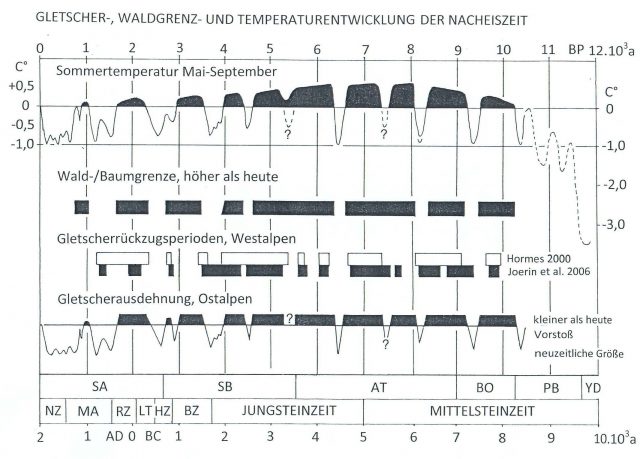

Als Nächstes möchte ich eine Kehrtwende vollziehen, um die Grundlage für eine Übersicht über Änderungen des Klimas in jüngerer Zeit zu bilden. Damals im Mittelalter, etwa im Zeitraum 1300 bis 1500 oder so, war es genauso warm oder sogar wärmer als heute. Aber dann im 17. Jahrhundert kühlte sich die Erde ab und trat in die „Kleine Eiszeit“ ein. Das war eine schwierige Zeit für Pflanzen, Tiere und uns Menschen gleichermaßen. Kürzere Wachstumszeiten, zugefrorene Flüsse und Häfen, Missernten.

Warum war es im Mittelalter so warm? Wir wissen es nicht. Warum gab es so relativ plötzlich den Übergang in die Kleine Eiszeit? Wir wissen es nicht. Warum kam die Abkühlung um das Jahr 1600 und nicht 1400 oder 1800? Wir wissen es nicht.

Nach einem sehr kalten Jahrhundert begann die Temperatur wieder zu steigen. Und seit etwa dem Jahr 1750 oder so setzte sich dieser Anstieg mit Unterbrechungen fort, etwa mit einem halben Grad pro Jahrhundert während der letzten zwei Jahrhunderte.

Warum wurde es nach der Kleinen Eiszeit nicht noch kälter? Wir wissen es nicht. Warum begann es nach der Kleinen Eiszeit wieder wärmer zu werden, anstatt dass die Temperatur auf dem niedrigen Niveau verharrte? Wir wissen es nicht. Warum begann es um das Jahr 1700 wärmer zu werden und nicht erst 1900? Wir wissen es nicht. Warum kam es zu der langsamen Erwärmung seit der Kleinen Eiszeit? Wir wissen es nicht.

Wie man sieht – obwohl wir viel über das Klima wissen … wissen wir aber auch NICHT viel über das Klima.

In jedem Falle, hiermit als Prolog folgt hier eine Kurzversion seiner „falsifizierbaren Wissenschaft“ aus seinem Tweet.

Wir entwickeln Theorien.

1) Strahlungstransport (z. B. Manabe and Wetherald, 1967)

2) Energiebilanz-Modelle (Budyko 1961 und viele nachfolgende Studien)

3) GCMs (Phillips 1956, Hansen et al 1983, CMIP etc.)

Wir geben falsifizierbare Prognosen aus. Hier sind einige davon:

1967: Zunehmendes CO2 wird zur Abkühlung der Stratosphäre führen

1981: Zunehmendes CO2 wird Erwärmung an der Erdoberfläche verursachen, die bis zu den 1990er Jahren messbar sein wird.

1988: Erwärmung durch zunehmende Treibhausgase wird den ozeanischen Wärmegehalt zunehmen lassen.

1991: Der Ausbruch des Pinatubo wird etwa 2 bis 3 Jahre Abkühlung bringen.

2001: Zunehmende Treibhausgase werden in Weltraum-Spektren erkennbar

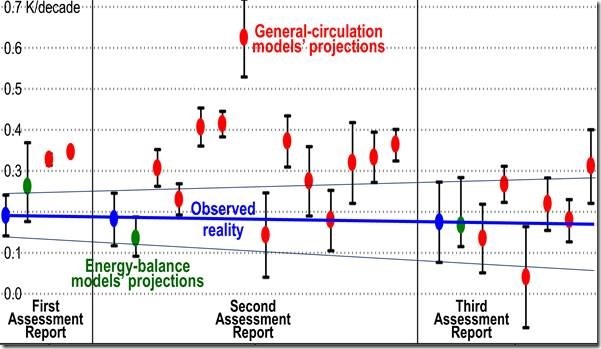

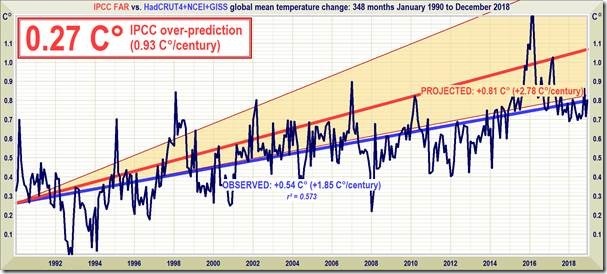

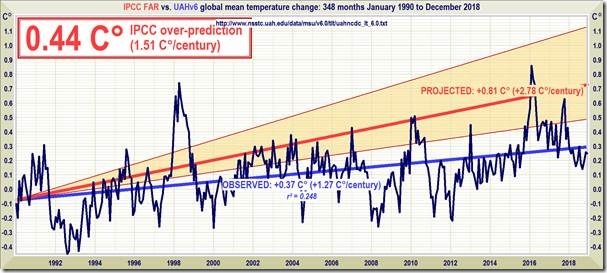

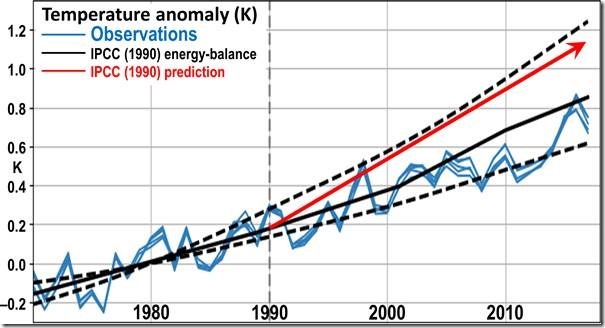

2004: Zunehmende Treibhausgase werden zu einer fortgesetzten Erwärmung um ~0,18°C pro Dekade führen

Wir überprüfen die Prognosen:

Abkühlung der Stratosphäre? ✅

Erkennbare Erwärmung? ✅

Zunahme des ozeanischen Wärmegehaltes? ✅

Abkühlung im Zusammenhang mit dem Pinatubo-Ausbruch? ✅

Weltraum-basierte Änderungen der IR-Absorption? ✅

Erwärmung nach dem Jahr 2004? ✅

Beginnen möchte ich damit, darauf hinzuweisen, dass er drei sehr separate und unterschiedliche Theorien aufbläht:

● Theorie 1: Zunehmendes CO2 lässt die atmosphärische Absorption zunehmen, was die Temperatur insgesamt der verschiedenen atmosphärischen Schichten beeinflusst und die nach unten gerichtete so genannte „Treibhaus“-Strahlung zunehmen lässt.

● Theorie 2: Kurzfristig ändert eine große Änderung der abwärts gerichteten Strahlung die Temperatur am Erdboden.

● Theorie 3: Langfristig führen geringe fortschreitende Zunahmen der abwärts gerichteten Strahlung zu korrespondierenden geringen Steigerungen der globalen Temperatur in den bodennahen Luftschichten.

Und hier die Einwände: Ich denke, dass die ersten beiden zutreffend sind (mit Schwachpunkten), aber wir haben praktisch keinerlei Belege, ob die dritte wahr oder falsch ist.

Gehen wir also durch seine sechs Wege der Beweisführung; betrachten wir, von welche Theorie er gerade redet und sehen wir, ob diese Beweisführung einer kritischen Überprüfung standhält.

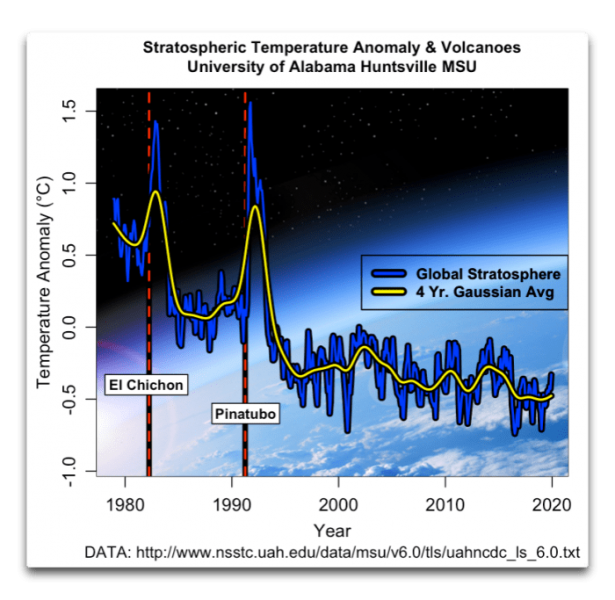

a) Zunehmendes CO2 wird zur Abkühlung der Stratosphäre führen. Dies soll offensichtlich Theorie 1 stützen. Der Verlauf der Temperatur in der Stratosphäre, ermittelt durch Mikrowellen-Sensoren an Bord von Satelliten, sieht so aus:

Wie man sieht, ist es zwar in der Stratosphäre tatsächlich kälter geworden, aber diese Abkühlung war ziemlich komplex. Die zwei Spitzen sind den in der Graphik markierten Vulkanausbrüchen geschuldet. Nach jedem davon ist es in der Stratosphäre etwa fünf Jahre lang wärmer geworden. Jedes Mal scheint sie sich auf einer niedrigeren Temperatur stabilisiert zu haben. Es gab einen geringen Rückgang seit der zweiten Eruption.Vielleicht kann man diese Änderungen Theorie 1 zuschreiben, obwohl das alles andere als klar ist.

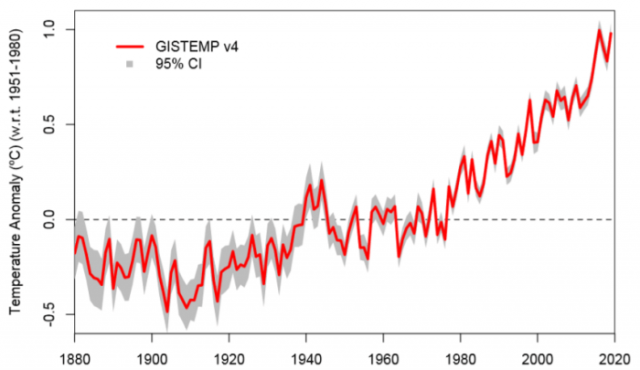

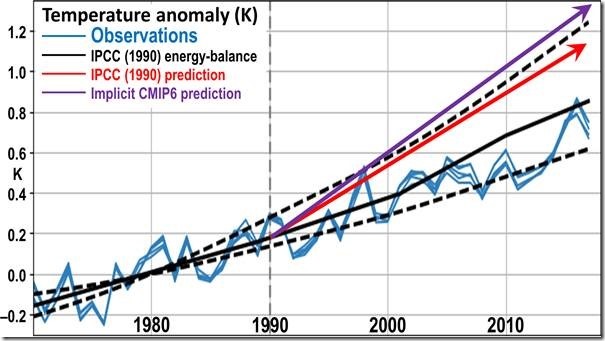

b) Zunehmendes CO2 wird an der Erdoberfläche Erwärmung bringen, die bis zu den 1990er Jahren messbar sein wird. Das soll ein Beleg für Theorie 3 sein. Das ist zwar so, jedoch ist die Temperatur seit mehreren hundert Jahren gestiegen. Glaubt man nicht, dass es in der Kleinen Eiszeit schon SUVs gab, ist dies kein Beweis für die CO2-Temperatur-Theorie.

c) Erwärmung durch zunehmende Treibhausgase wird den ozeanischen Wärmegehalt OHC zunehmen lassen. Das Gleiche wie unter Punkt b) und der gleiche Einwand. Das soll Theorie 3 stützen, aber in einer sich erwärmenden Welt ist ein sich erwärmender Ozean für überhaupt nichts beweiskräftig.

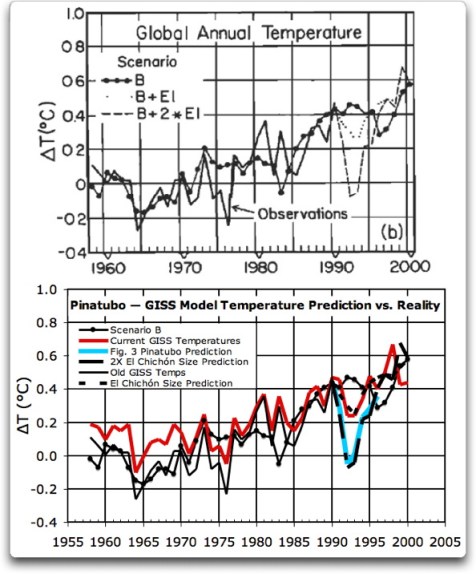

d) Der Ausbruch des Pinatubo wird ~2 bis 3 Jahre Abkühlung bringen. Das soll Theorie 2 belegen … aber die Temperatur steigt auch nach Sonnenaufgang. Wir wissen, dass starke vorübergehende Änderungen der abwärts gerichteten Strahlung (in der Klimawissenschaft „forcing“ genannt) zu Änderungen der Temperatur in den bodennahen Luftschichten führen.

Allerdings waren die Modelle nicht gerade gut bei der Prognose des Ausmaßes der Abkühlung. Hier folgen einige Ergebnisse, die ich bereits vor zehn Jahren angesprochen habe:

Man beachte, dass das Hansen/Schmidt GISS-Modell eine mehr als doppelt so starke Pinatubo-Abkühlung prophezeit hat als in der Realität tatsächlich eingetreten. Es wurde auch prognostiziert, dass die Abkühlung länger dauern sollte als es tatsächlich der Fall war. Ich komme gleich noch einmal hierauf zurück, aber für den Moment wollen wir festhalten, dass Theorie 2 zutreffend ist – kurzfristige Änderungen des Antriebs, erfolgen diese nun täglich, monatlich oder durch Vulkane, ändern in der Tat die Temperatur.

e) Zunahme von Treibhausgasen wird in Weltall-basierten Spektren erkennbar sein. Mit mehr Treibhausgasen in der Atmosphäre kann man erwarten, dass mehr IR-Strahlung absorbiert wird. Wir haben dies auf vielfältige Weise gemessen. Dies ist ein Beleg für Theorie 1.

f) Zunehmende Treibhausgase werden zu einer fortgesetzten Erwärmung von ~0,18°C pro Dekade führen. Das soll Theorie 3 stützen. Allerdings findet die Erwärmung bereits seit zwei oder mehr Jahrhunderten statt, und diese Prognose aus dem Jahr 2004 ist nichts weiter als eine Fortsetzung der dreißig Jahre Erwärmung zuvor. Noch einmal: die Tatsache einer nach wie vor stattfindenden Erwärmung ist kein Beweis für irgendetwas.

Zusammenfassung

● Die Theorien 1 und 2 sind eindeutig zutreffend und durch eine Reihe von Belegen gestützt. Drei seiner sechs Punkte stützen diese beiden Theorien.

● Die anderen drei Beweispunkte sagen, dass nach über zwei Jahrhunderten einer allmählichen Erwärmung … sich die Erwärmung fortsetzt. Das sagt genau gar nichts über Theorie 3.

Und das ist auch das ungelöste Problem mit der CO2-Theorie … es sind wirklich drei sehr unterschiedliche Theorien, zusammengeschustert zu einer Theorie. Während zwei dieser Theorien eindeutig zutreffen, gibt es kaum Belege für das dritte Standbein des Stuhls. Und kein Stuhl kann mit nur zwei Beinen stehen bleiben.

Gavin schließt seine Twitterfolge hiermit:

Wir können auch die überprüfbaren, falsifizierbaren überprüften Theorien betrachten, die sich als falsch herausgestellt haben.

Solarer Antrieb? Scheitert am Test einer stratosphärischen Abkühlung ❌

Änderung der ozeanischen Zirkulation? Keine Zunahme des OHC ❌

Orbitaler Antrieb? Scheitert auf multiplen Ebenen ❌

Falls man eine Theorie hat, von der man nicht glaubt, dass sie falsifiziert worden ist, oder falls man glaubt, die Mainstream-Folgerungen falsifizieren zu können – wunderbar! Das können wir auch überprüfen. (Aber viele Leute haben das bereits versucht, so dass es hierzu demnächst eine Antwort geben könnte).

Tatsächlich ist es noch etwas schwieriger. Nicht nur, dass man eine Theorie finden muss, die genauso gut ist wie die derzeit bestehende Theorie, sondern auch, dass man zeigen muss, warum die bestehende Theorie nicht angewendet werden kann.

Nun, ich habe in der Tat eine Theorie. Ich habe auch einen Haufen Beweise für dieselbe. Aber ich bin kein Klimaskeptiker – ich bin ein Klima-Häretiker; jemand, der deren grundlegende Behauptung leugnet, der zufolge Änderungen der Temperatur einfach eine einfache lineare Funktion von Änderungen des Antriebs sind.

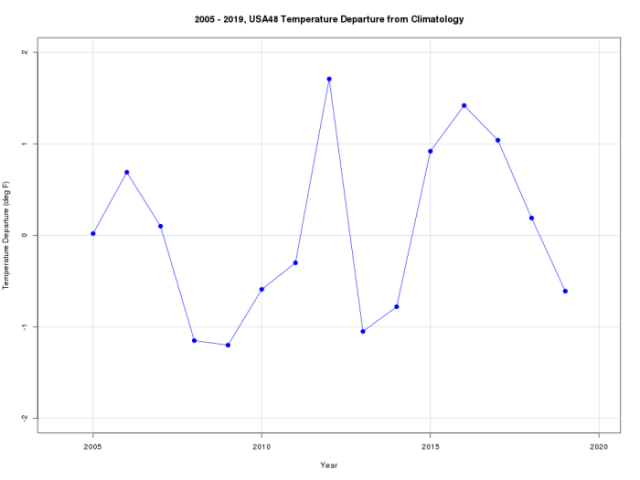

Man ist daran interessiert herauszufinden, warum sich die Temperatur des Planeten mit der Zeit ändert. Das ist das Zentrum der modernen Klimawissenschaft. Meine Theorie andererseits fußt auf einer total anderen Frage bzgl. Klima – warum ist die Temperatur so stabil? Zum Beispiel variierte die Temperatur über das 20. Jahrhundert nur um ±0,3°C. In der gigantischen Wärmemaschine, die das Klima nun einmal ist, die fortwährend die Sonnenenergie nutzt, um Ozeane und Atmosphäre zirkulieren zu lassen, macht diese Variation gerade mal 0,1% aus … für jemanden, der es schon mit vielen Wärmemaschinen zu tun hatte, ist das eine erstaunliche Stabilität. Das System wird durch nichts weiter gesteuert als durch Wellen, Wind und Wasser. Meine Frage lautet also nicht, warum sich das Klima so ändert wie es das tut.

Meine Frage lautet: Warum ist das Klima so stabil?

Und meine Antwort lautet, dass es eine ganze Palette dessen gibt, was „auftauchende Phänomene“ sind, die auftauchen, wenn lokale Temperaturen über eine bestimmte lokale Schwelle steigen. Darunter fällt auch Timing und Menge der sich in den Tropen entwickelnden Kumulusbewölkung, die Bildung von Gewittern, das Auftreten von Staubteufelchen, wenn es zu heiß wird, die Art und Weise, wie El Nino/La Nina warmes Wasser in Richtung der Pole pumpen sowie verschiedene „Oszillationen“ wie etwa die Pazifisch-Dekadische Oszillation PDO.

Diese Phänomene tauchen aus dem Nichts auf, dauern eine Weile und verschwinden dann wieder vollständig. Und im Zusammenwirken arbeiten diese Phänomene daran zu verhindern, dass sich die Erde überhitzt oder zu stark abkühlt. Wie oben schon erwähnt sage ich, dass diese Phänomene auf Länge und Stärke der Folgen des Pinatubo-Ausbruches ihren Einfluss ausübten.

Ursprünglich veröffentlichte ich diese Theorie im Journal Energy and Environment. Dem folgte ein Beitrag mit den gleichen Gedanken hier bei WUWT in einem Beitrag mit dem Titel The Thermostat Hypothesis.

Ich habe diese Mission mit der Abfassung einer Anzahl von Beiträgen während der letzten 20 Jahre fortgesetzt, wobei ich beobachtete Belege der Theorie hinzugefügt und deren Verzweigungen erkundet habe. Darunter sind Beiträge mit der Überschrift „Emergent Climate Phenomena“, in welchem beschrieben wird, was Auftauchen bedeutet und warum das so wichtig ist; „The Details Are In The Devil“, in welchem erklärt wird, warum eine Analyse nach Art von „Klimasensitivität“ in einem thermostatisch kontrollierten System nicht funktioniert; „Watching Thunderstorms Chase The Heat“ worin beschrieben wird, wie Gewitter agieren, um die warmen Gebiete der tropischen Ozeane zu kühlen; und zuletzt „Drying The Sky“, wo die Evolution verschiedener Phasen im tropischen thermischen Regulierungssystem diskutiert wird.

Alles in allem habe ich rund 40 Artikel geschrieben, in welchen es darum ging, mittels dieser Theorie zu erklären, wie das Klima funktioniert. Einen Index zu einer Anzahl davon gibt es hier. Andere Beiträge aus jüngerer Zeit von mir stehen hier.

Nun fürchte ich, dass im Klima-Establishment kaum Interesse an meiner Theorie besteht, weil man dort nach Schlagzeilen Ausschau hält wie THERMAGEDDON! KLIMA-NOTSTAND! In meiner Theorie gibt es dafür keinen Raum, vielmehr ist eigentlich das Gegenteil der Fall. Meiner Theorie zufolge ist die zukünftige Erwärmung langsam und gering. Folglich bin ich von den Mächtigen ausgegrenzt, wie es bei allen guten Häretikern der Fall ist.

Abschließend möchte ich noch sagen, dass ich keinerlei akademische Qualifikationen vorweisen kann. Physik und Chemie auf dem College – das war’s.

Seitdem jedoch habe ich mich selbst hinsichtlich vieler Themen weitergebildet. Neben vielem Anderen habe ich dafür Abertausende Stunden zugebracht, alles über Klima zu erfahren … ohne auch nur ein einziges Zertifikat an meiner Wand hängen zu haben.

…

Link: https://wattsupwiththat.com/2020/01/18/gavins-falsifiable-science/

Übersetzt von Chris Frey EIKE