Der MDR vermeldet: „Bundesforschungsministerin Anja Karliczek (CDU) und Agrarministerin Julia Klöckner (CDU) wollen in den kommenden vier Jahren 3,6 Milliarden Euro in die Förderung der Bioökonomie investieren. „

Agrar heute dazu: „In der „Nationalen Bioökonomiestrategie“ geht es konkret um die verstärkte Erforschung und Nutzung nachwachsender Rohstoffe. Auch die Sicherstellung der Ernährung vor dem Hintergrund von Klimawandel und Bevölkerungswachstum stehe im Fokus. „Biobasierte Materialien stehen den Eigenschaften erdölbasierter Kunststoffe in kaum noch etwas nach“, sagte Karliczek.

„Auf unseren Äckern wächst, was wir sonst importieren müssten“, sagte Klöckner.

Es ist die Rede von Turnschuhen aus Spinnenseide und Autoreifen aus Mais (MDR) oder Löwenzahn (agrar heute).

Ich überprüfe, ob es sich wirklich um eine Nachrichtenmeldung handelt oder ob ich in eine Satiresendung geschaltet habe. Eine versteckte Kamera ist auch nicht im Auto, also mein dümmlich drein blickendes Gesicht wird nicht im TV erscheinen. Die meinen das ernst!

Ich kann mich an eine Dokumentation erinnern, da ging es um Bioplastik. Ein deutscher Herr Gerritsen, Geschäftsführer der deutsch-holländischen Firma Bio4Pack, beschäftigt sich seit 18 Jahren mit Bioverpackungen und ist da schon fleißig dabei. Seine kompostierbaren Lebensmittelverpackungen findet man in den Supermarktketten der Niederlande, die Ihre Filialen auch in Deutschland haben wie Aldi und Lidl. Im supergrünen Deutschland findet man sie nicht, hier die Gründe:

„Bioplastik: Der Begriff ist nicht klar definiert… nicht alles, wo Bio draufsteht, ist auch verträglich für die Umwelt, und Bioplastik heißt nicht automatisch, dass es biologisch abbaubar ist… „ schreibt das Süddeutsche Zeitung Magazin. Und weiter: „Die deutsche Verpackungsverordnung lässt Bioplastik nicht in die Biotonne.“ Es müsste in industriellen Kompostieranlagen zwölf Wochen kompostiert werden. Das geht in Deutschland wohl nicht, in Holland aber offensichtlich schon. Neuste Entwicklungen auf diesem Gebiet sind Bioplastik Produkte, die auf alle Fälle in drei Jahren verschwunden sind, sollten sie in der Natur landen. Wenn Sie nun sagen: „Toll, das müsste man doch fördern und wie viel kostet das den Verbraucher mehr?“. Förderung ist gleich Null, manche Verpackungen kosten nicht mehr, andere zwischen 3-4 Cent, wohlgemerkt pro Verpackung, auf die Erdbeere umgerechnet, ist das nicht viel.

Nun die Damen Bundesministerinnen: Hier muss man vielleicht gar nichts fördern, sondern einfach nur zulassen und die Kompostierung organisieren, im Land der angeblichen Recyclingweltmeister? Ich glaube, das steht in Ihrer Aufgabenbeschreibung. Man spricht von der Hälfte an CO2-Freisetzung bei der Herstellung von Bioplastik im Vergleich zu Petrolplastik. Oder schlagen hier die Lobbyisten der Petrolchemie zu, die sie so gerne bei den „Klimaleugnern“ verorten?

Es ist noch nicht so lange her, im Jahre 2004 in der Kölschen Rundschau:

„Bauern könnten die „Ölscheichs von morgen“ werden, wenn das Potenzial nachwachsender Rohstoffe in Deutschland stärker genutzt würde, sagte Künast (Die Grünen) bei Vorlage des Ernteberichts. Trotz des feuchten Frühsommers hat Künast der bevorstehenden Ernte insgesamt „Spitzenerträge“ bescheinigt.“ Hört, hört: feuchter Frühsommer war nicht gut, heute ist es die Dürre. Geerntet haben wir trotzdem immer mehr. Klingt wie die Ministerinnen von heute. Haben die nur abgeschrieben und statt dem Biosprit die Autoreifen eingesetzt? Heute will man den Biosprit nicht mehr so richtig. Er könnte ja von den regenwaldvernichtenden Palmölplantagen kommen. Man will die sauberen E-Autos! E10 ist gerade teurer geworden, angeblich wegen der gestiegenen Nachfrage. Die Erzeuger sagen, das wäre nicht der Grund …

Palmöl in zahlreichen Kosmetika, Lebensmitteln und Industriestoffen ist dagegen in Ordnung. Es ist also ein Unterschied, wofür der Orang-Utan stirbt! Für den Treibstoff eines SUV ist es abzulehnen, für die Tafel Schokolade eines E-Auto Fahrers ist es „Bio“. Verlogene grüne Welt!

Übrigens Regenwald: Würde man alle Staudammprojekte im Amazonas Regenwald umsetzen, für grünen Strom natürlich (Strom hat heutzutage Farben), sterben laut Experten 1.000 Fischarten aus. Das sind 10% aller Süßwasserfischarten weltweit. Tausende Hektar Regenwald werden überschwemmt. Ein bereits angelegter Stausee produziert durch faulenden, überschwemmten Regenwald 20x mehr „Treibhausgase“, als ein Kohlekraftwerk gleicher Leistung. In der Türkei wird ein Staudamm den Tigris aufstauen und flussabwärts ein riesiges Sumpfgebiet in Wüste verwandeln. Grün ist dann nur noch der Strom. Schade das Strom nicht stinken kann.

Und da gibt es ja noch Biogas. Ursprünglich entwickelt, um aus Gülle oder Festmist Methan zu erzeugen. Später kamen dann organische Stoffe wie Biomüll oder Abfälle aus Schlachtereien, der Gastronomie oder der Lebensmittelindustrie hinzu. Die ganz großen Anlagen benötigen dazu noch Mais oder anderes Getreide. Als Heilsbringer deklariert, der Bauer wurde nun der Gasbaron. Oder doch nicht? Eine Studie des Umweltbundesamtes:

… Seit 2005 sind mindestens 17 Menschen bei Unfällen in Biogasanlagen getötet und 74 verletzt worden

… im Jahr 2017 wurden 32 Unfälle in Biogasanlagen registriert, bei denen rund 5,5 Millionen Liter Jauche, Gülle und Silagesickersäfte sowie Gärsubstrate (JGS) freigesetzt worden

… in den Jahren 2017 und 2018 insgesamt 56 Biogasunfälle, bei denen 38 Mal Gewässer betroffen waren

… Dreiviertel, der von Sachverständigen geprüften Biogasanlagen, weisen erhebliche sicherheitstechnische Mängel auf

… 5 Prozent des in Biogasanlagen produzierten Methans entweicht unkontrolliert in die Atmosphäre

… Damit können Biogasanlagen in der Gesamtbetrachtung sogar mehr Emissionen an klimaschädlichen Gasen verursachen als einsparen

Fazit: „Biogasanlagen sind eine Gefahr für Mensch, Klima und Umwelt“

Zudem werden jetzt die Gärreste zum Dung, der auf den Feldern landet, hinzugerechnet und erschweren die Einhaltung der Düngeverordnung.

In Deutschland laufen derzeit über 9.000 dieser Anlagen, im Glauben an die Bundesminister*innen errichtet. So wird man ein Ungläubiger!

Meldung des MDR: „Bauern demonstrieren vor dem Landtag in Thüringen“

Hintergrund ist die Düngemittelverordnung, die den Einsatz von künstlichem und organischem Dünger erheblich einschränken soll, da sonst zu viel Nitrat in das Grundwasser gelangt. Die Bauern zweifeln die Messmethoden und Ergebnisse zu Recht an. Daraufhin erwidert Thüringens Umweltministerin Anja Siegesmund laut Radio: Sie wolle den unterschiedlichen Messergebnisse der Nitratbelastung des Grundwassers nachgehen.

Ein satirischer Gedanke kriecht in mir hoch: Sollte man das nicht vorher machen oder ist „nachgehen“ wörtlich gemeint? Mit den Nitratgrenzwerten ist es ähnlich wie mit den Stickoxiden. Die Werte sind auf sehr niedrigem Niveau. Das Dreifache stört niemanden, selbst mit dem Siebenfachen können Erwachsene leben, wenn sie denn im Trinkwasser wären, wo sie nie waren, da Trinkwasser aus verschiedenen Grundwasser Quellen gemischt wird. Und: ist der Nitratwert an einigen Messstellen zu hoch, lief bei Industrie, Abwasserwirtschaft UND Bauern etwas schief, aber nicht bei allen und überall!

So und jetzt nochmal von Anfang: Nach Ölscheich und Gasbaron soll jetzt der Bauer zum Autoreifenhersteller werden, aber bitte mit Traktoren ohne Diesel oder E-Fuel und mit wenig Düngung. Wissen unsere Bundesvorturner, dass Mais ein Humuszehrer ist und viel Düngung benötigt. Und was ist mit den veränderten Klimabedingungen? Ach so, man will trocken-resistente Pflanzen züchten. Was ist dann mit den feuchten Frühsommern? Übrigens wäre der Nitratgehalt nicht eine Frage des Düngens sondern eine des Konsums, so Umwelttoxikologin Prof. Heidi Foth von der Universität Halle-Wittenberg. Sie möchte über die Tierproduktion nachdenken. Können wir, habe ich studiert. Die Ställe, die ich bauen würde , bekämen keine Genehmigung, würden das Tierwohl aber viel mehr berücksichtigen. Auf dem Lande darf es nicht mehr nach Tierhaltung riechen, darf kein Hahn krähen und kein Hund bellen. Der neue, der Urbanität entflohene Naturbursche benötigt seinen Schönheitsschlaf. Mit neuester Technik ausgestattet, bekämpft er das wuchernde Ungetüm namens Rasen. Bienen? Ja, Bienen sind gut.

So nun mach was draus, du dummer Bauer!

Die Tierproduktion trägt nicht mal 1% zur deutschen „Treibhaus“-Emission bei. Eine Kuh kann nur einen Teil des durch Photosynthese gebundenen Kohlenstoffs in Methan umwandeln. Vom Rest lebt sie und schenkt uns essentielle Amino- und Fettsäuren und wichtige fettlösliche Vitamine. Wenn ich jetzt noch dagegen rechne, wie viel in tatsächlichen Treibhäusern und Produktion von Fleischersatzprodukten dazu kommt, wird kein Unterschied messbar sein. Der Bio-Ackerbauer muss die doppelte Fläche bewirtschaften bei gleichem Ertrag! Wie macht er das wohl? Verbrauchte er dann nicht mehr „fossile Brennstoffe“?

Soja beurteilen wir ähnlich wie Palmöl. Als Tofu und Sojamilch (für die Laktoseintoleranten) topp, als Tierfutter der Regenwaldvernichter. Vielleicht schädigen die Veganer sogar das Klima mehr als die Karnivoren unter uns, um in deren Sprech zu bleiben? Kaut Bio-Möhren und ihr rettet das Klima oder auch nicht! Das entscheiden die Umweltverbände und Experten, die vorgeschobene Regierung Deutschlands. Wer regiert eigentlich Deutschland?

Wie die Halbwertzeiten der Versprechungen und Förderprogramme aussehen, merkt man jetzt. Die „tausenden Generationen“ der Svenja Schulze gelten hier wohl nicht, es sei denn, sie hat von Feldmäusen gesprochen. Kann man nie wissen. Sie sieht auch das Klima, welches nicht mehr nur Wetter ist, bei ihren Spaziergängen in der Eifel. Manche können CO2 sehen. Bei ihr ist der Klimawandel auch belegt. Sie hat wohl „menschengemacht“ davor vergessen. Kann passieren. Menschen werden oft vergessen. „Belegt“ ist wahrscheinlich nur das Brötchen in der Bundestagskantine. Vielleicht mit norwegischem Lachs, aber halt, Svenja isst vegetarisch. Na dann gibt es Kartoffeln aus Ägypten, Tomaten aus Holland und Gurken aus Spanien. Frau ALB mag vielleicht argentinisches Rinderfilet. Na ja, wenn unsere Bauern aber auch so alte Umweltsäue sind. Da müssen Leitplanken geschmiedet werden.

Übrigens nutzen wir die gleichen Ackerböden schon seit einigen hundert Jahren, trotz steigender Bevölkerungszahl. Wir mussten keine Wälder zusätzlich roden. Das geht nur durch die Aufrechterhaltung der Bodenfruchtbarkeit. Die Ackerfläche ist begrenzt, wollen wir Wald, Wiesen und verbliebene Sumpfgebiete erhalten. Gibt es irgendwo mehr Nachhaltigkeit? Sind Bauern doch nicht so dumm?

Auf Fritz FM, einem Berliner Radiosender, diskutiert man, ob es gut ist, dass jeder Bundesbürger ein Organspender wird. Man könne ja ablehnen und müsse auch keine Angst haben, da man vorher für hirntot erklärt werden muss. Wieder durchzuckt ein böser zur Satire neigender Gedanke mein Verschwörerhirn: Da müssen sich einige Protagonisten unserer Zeit jetzt schon Gedanken machen! Wenn man deren Hirnschale öffnet, klingt es in etwa so wie beim Öffnen eines Gurkenglases. Das Vakuum füllt sich hörbar!

Weiter vermeldet der* Radiosprecher*in, dass man die wirklichen Folgen des Klimawandels im Hainich-Wald erforschen wird, der ja ohne den Eingriff des Menschen wachsen darf. Man will die Obstplantagen der Fahner Höhen an eine Wasserleitung anschließen. Machen übrigens die Weinbauern schon lange und hatten in den deklarierten Dürrejahren sehr gute Jahrgänge. Hört sich gut an!

Die nächste Radiomeldung vom MDR Thüringen: „In Thüringen könnten tausende Arbeitsplätze in der Automobil- und Zulieferindustrie verloren gehen. Der Grund ist der zu langsame Umstieg auf die E-Auto Produktion. Die Hersteller fordern… die Kanzlerin lädt zum Gipfel…“

Die ETH Zürich hat mit einer experimentellen Parabolantenne, die das Sonnenlicht bündelt, im Kopf der Antenne Syngas (H2 + CO) erzeugt. Genutzt wird hier die von der Sonneneinstrahlung erzeugte Hitze von über 1000°C. Aus dem Syngas können synthetische Kraftstoffe erzeugt werden. Erste Spin-Off Firmen versuchen, das Ganze weiter zu entwickeln und zur Marktreife zu bringen. Tim Böltken baut mit seiner Firma Ineratec in Karlsruhe Anlagen, die ebenfalls synthetische Kraftstoffe herstellen können. Aber nun haben die Umweltverbände (wer sonst) etwas dagegen:

„Ökos wettern gegen E-Fuels: Umweltschützer und Grüne wettern sogar gegen künstliche Kraftstoffe. „E-Fuels sind derzeit unbezahlbar teuer und ineffizient“, sagt etwa der Grünen-Bundestagsabgeordnete Oliver Krischer. Ein wichtiges Argument der Gegner: der niedrige Wirkungsgrad. Anstatt Autos direkt mit Ökostrom anzutreiben, wird dieser erst eingesetzt, um Wasserstoff und dann den Treibstoff herzustellen.“ (Rhein-Neckar-Zeitung)

Das klang aber neulich noch ganz anderes, da war Wasserstoff der neue Hoffnungsträger. Power-to-Gas heißt der neue Anglizismus! Entweder wollte man das Gas direkt einsetzen oder in Methan umgewandelt, in unterirdischen Kavernen lagern. Damit will man Kraftwerke betreiben als Back-Up des volatilen Wind- u. PV-Stroms, der dann u.a. die E-Autos lädt. Haben Techniker wie Frau Nestle (Die Grünen) alles durchgerechnet. Die Erkenntnisse der ETH werden ignoriert. Mag sein, dass es noch nicht effektiv ist, aber Nachdenken u. Ausprobieren, sollten erlaubt sein. Von Förderung keine Spur … Turnschuhe aus Spinnenseide … Wie ist es mit der Förderung des Dual-Fluid-Reaktors?

Merken Sie was?

Autos mit Biosprit, E-Fuels u.a. synthetischen Treibstoffen will man nicht, da so der Kolbenmotor am Leben bleiben würde, denke ich einen satirischen Gedanken. Ist bestimmt nur eine wilde Verschwörungstheorie!

Aha, die Autoindustrie ist selber schuld.

„Weitere Klagen vor dem Bundesverfassungsgericht… die DUH klagt im Namen von Bangladesch und Nepal, … Umweltverbände wollen die Verschärfung des Klimapaketes und den beschleunigten Ausbau der erneuerbaren Energien…“, so der MDR. Der Name Luisa Neubauer fällt. „Experten warnen…, der Klimawandel gehört zu den größten Risiken für unsere Erde in den nächsten zehn Jahren…“

Hm, Klimawandel, zehn Jahre denke ich und Gefahr für die Erde, ein wenig kleiner hatten sie´s wohl nicht. Die Erde ist dann eigentlich in permanenter Gefahr. Das ist mir zu …, jedenfalls will sich dazu kein weiterer Gedanke entwickeln. Zu den Ausbau der Erneuerbaren schon eher. Es fallen mir einige Vorträge auf YouTube dazu ein. Den von Prof. Lüdecke kennen wir alle. Ich nehme mal den von Prof. Christian Holler, der nicht im Verdacht steht, der Skeptiker Fraktion anzugehören: „Erneuerbare Energien und die Unbestechlichkeit der Physik“

Er legt 120 kWh als Primärenergiebedarf pro Kopf und Tag eines Bundesbürgers zu Grunde (90-120 kWh).

Um das anschaulich zu machen, hat er für die Luisas dieser Welt ausgerechnet, was es bedeutet, diese durch Erneuerbare darzustellen.

50% aller Dächer werden mit PV-Anlagen bedeckt und 3.600 km² auf anderen Flächen. Die 3.600 km² entsprechen etwa der Fläche Berlins und des Saarlands, etwa 1% der Fläche Deutschlands. Die sprechen sowieso komisch, also …

Über 100.000 WKA müssten on shore gebaut werden und ein 20km tiefer Streifen an der gesamten Ost- und Nordseeküste muss mit off Shore WKA verschönert werden. An Land sind das im Schnitt alle 2km eine WKA. Blöd für die, die Flügel haben! Vielleicht fördert das die Evolution der Laufvögel? Blöd auch für Pflanzen, die von Fluginsekten bestäubt werden müssen. Vielleicht sollten die sich das mit der Wasserleitung zu den Obstplantagen noch einmal überlegen? Wovon ernähren sich dann die Spinnen? Die Spinner ernähren sich von uns, das wissen wir.

Wenn wir die Wasserkraft überall wo möglich einsetzten, kommen nur 1,5 kWh pro Kopf u. Tag hinzu. Bei Trockenheit käme weiter unten kaum noch Wasser an, siehe Australien. Schuld ist dann … Besser wäre das geschickte Anlegen von Wasserreservoirs, um niederschlagsarme Zeiten zu überbrücken.

Nutzt man Biomasse soweit wie es geht, benötigen wir 33% unserer Ackerfläche, 50% des Ertrages unserer Wälder, alle organischen Abfälle. 11,9 Mio. ha haben wir als Ackerfläche zur Verfügung. Wir brauchen aber ca. 15 Mio. ha für unsere Nahrungsmittelproduktion. Also müssen wir jetzt schon Nahrungsmittel für die Bundestagskantine importieren. So langsam dämmert es einem, warum wir kein Fleisch mehr essen sollen! Denn da wo jetzt Futterpflanzen wachsen, müssen Pflanzen für Energie, Autoreifen und Diverses wachsen. Nahrungsmittel importieren wir zukünftig noch mehr. Von „nicht-industrieller“ Landwirtschaft keine Rede mehr. Mal abgesehen davon, dass die organischen Düngungen schwierig würde.

Wie war das: „Auf unseren Äckern wächst, was wir sonst importieren müssten!“ Nun bin ich verwirrt! Sie auch?

Der Professor zählt auch noch Geothermie dazu. Die tiefe Geothermie setzt Tiefenbohrungen voraus, bringt ca. 4 kWh. Die oberflächliche Geothermie, die berühmte Wärmepumpe, erbringt bei 50qm pro Person nochmal 5 kWh. Schauen Sie sich nochmal ihren Vorgarten an, der wird demnächst um gebaggert.

Also das soll der radikale Ausbau der Erneuerbaren sein? Dagegen würde ich klagen, liebe Luisa. Das raubt Zukunft und Landschaft. Es sein denn, man fliegt woanders hin. Kennst Du ja.

Was haben wir vergessen? Die Reserve-Kraftwerke, die wenn kein Wind und so … ach ja, die jetzt nicht mehr so ineffizienten Power-to-Gas Anlagen … Und die vielen Kupferleitungen, Wege und Straßen zu den WKA und PVA, die oft beim Flächenverbrauch weggelassen werden. Den Energieverbrauch für Erstellung und Transport … Jetzt können sich gerne alle wieder streiten, auf ein Windrad, eine PVA oder eine kWh mehr oder weniger, kommt es nicht an … das ist einfach nur Wahnsinn!

Die Lösung: Wir sparen 50% der Energie ein.

Wirtschaftsredakteurin der taz Ulrike Herrmann: „Es gibt keine Alternative zum Ökostrom, aber dieser wird immer knapp und kostbar bleiben. (…) Wenn die Menschheit überleben soll, müssen die Industrieländer ihren Verbrauch schrumpfen.“ Mit „schrumpfen“ meint sie Folgendes: „Es gibt bereits ein historisches Schrumpfungsmodell, an dem man sich orientieren könnte: die britische Kriegswirtschaft zwischen 1940 und 1945.“

Na dann! Und der zukünftige Krieg ist dann der gegen den „Klimawandel“ nach Ausrufung des „Klimanotstandes“? Der Vergleich hinkt gewaltig, die britische Wirtschaft war auf kriegswichtige Dinge ausgerichtet. Sie lief auf Hochtouren zur Abwehr der Okkupation.

In den letzten 30 Jahren haben wir, trotz aller gestiegenen Effizienz, nichts eingespart. Die Wirtschaft hat sie genutzt, um zu wachsen. Unser Wohlstand wuchs mit. Also muss man den Begriff Wohlstand laut Habeck neu definieren, sollten wir ein chinesisches Regierungsmodell einführen, müssen Kontrollen und Verbote her! Eine Gesellschaft in Energiearmut hat sich nie weiter entwickelt. Eigentlich müssten das die Scharen von Geschichts-, Politik- und Sozialwissenschaftler in den Politikerkreisen wissen. Das tun sie auch, denken aber, wir wissen es nicht. Was wäre die größere „Katastrophe“: veränderte Wetterbedingungen infolge einer Klimavariation oder sinkender Wohlstand unter einer Öko-Kontroll-Regierung, an der nur der Name „Öko“ wäre, will man Diktatur nicht verwenden?

Mir fällt gerade ein DDR-Witz ein. Hier in Abwandlung:

Frau Merkel, Frau Esken und Luisa Neubauer (tolle Frauenquote, oder?) fliehen im Urwald vor einem Stamm Kannibalen. Frau Merkel wird nach hinten geschickt, um Verhandlungen aufzunehmen. Sie kommt zurück und die wilde Flucht geht weiter. „Was hast Du denn angeboten?“, wird sie gefragt. „Ich habe ihnen Wirtschaftshilfe in Höhe von 1 Mio. € angeboten! Die wollten sie aber nicht!“ Dann schickt man Frau Esken nach hinten. Auch danach müssen alle weiter rennen. Das Angebot einer bedingungslosen Grundrente und ein paar zähe Nazis als Knabbergebäck, konnten die Wilden nicht überzeugen. Dann ist Luisa dran. Sie kommt schlendernd zurück. Alles ist geklärt. „Wie hast Du das gemacht?“ „Ich habe allen CEO der Kannibalen gedroht, wenn wir so weiter rennen, sind wir bald in Deutschland! Da haben sie sofort kehrt gemacht!“

Dann erzählt man im Hörfunk noch vom Unwort des Jahres. Toll gemacht, ich bin voll im Rahmen (Frame). Erinnern Sie sich noch an Dalli, Dalli mit Hans Rosenthal? Da gab es Dalli-Klick oder so ähnlich, da musste man immer Wortverbindungen finden.

Weltkriege, Klimakatastrophen, Artensterben, Waldbrände … die tägliche Apokalypse gib uns heute. Man wiederholt die Meldungen alle halbe Stunde. Würde man dem Glauben schenken, man müsste den nächsten Parkplatz aufsuchen und laut losheulen. Doch ich sehe keine weinenden Menschen, manche lachen sogar. Begreifen die nicht, in welcher Gefahr wir schweben, offensichtlich nicht. Solange wie heute, gab es lange keinen Frieden auf deutschem Boden, das Klima kennt keine Katastrophen, wir hatten in moderner Zeit noch nie so viele Wildtiere in Deutschland, der Wald war auch seit dem 30jährigen Krieg nicht mehr so groß u. wenn wir ihn besser bewirtschaften würden (keine Monokulturen) würde er weniger brennen. Die Apokalypse gibt es nur in unseren Köpfen, weil es so gewollt ist.

Unsere Zukunft soll schrecklich sein! Damit DIE vorgeben können, uns davor mit allen Mitteln zu schützen. Lückenpresse mit erfundenen, Katastrophenprophezeiungen. Sagt man ihnen das, sind sie beleidigt. Broders Spiegel nennt sie: „Die Möchtegern-Frontberichterstatter!“

Nur, wer beleidigt hier eigentlich wen? Ich muss mir schließlich seit drei Stunden diesen Informationsbrei aus Fakten, Quasi-Fakten, fehlenden Fakten und politischen Meinungen anhören! Gott sei Dank kommt zwischendurch Musik. „Hier erhalten Sie die Informationen, von denen wir wollen, dass Sie sie glauben!“ Wann hat das angefangen?

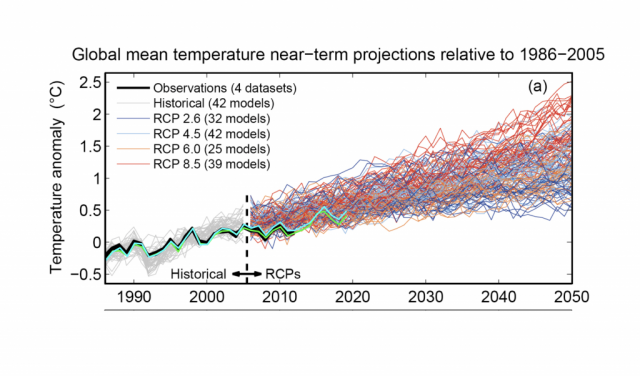

Da halte ich es mit Dieter Nuhr: „Wenn Dir einer die Zukunft in 30 Jahren voraussagen will, weißt Du, genauso wird sie nicht!“ Die hochdeutsche Übersetzung von: „Et hätt noch immer jot jejange!“

Auf die nächste Autofahrt nehme ich mir ein Hörbuch mit, vielleicht Ken Follett: „Die Pfeiler der Macht.“

Satire aus!