GroKo bereitet sich auf Mega-Blackout vor

Damals in Deutschland kaum wahrgenommen. Heute, im Zeitalter der Diskussion um „kleine Renten“ und dem zwangsweisen Abklemmen hunderttausender vom Stromnetz, wäre dies sicherlich schon etwas anders.

Hier geht es um ein Papier mit dem unverfänglichen Titel Be Cautious with the Precautionary Principle: Evidence from Fukushima Daiichi Nuclear Accident. Übersetzt etwa: Vorsicht mit dem Vorsorgeprinzip, Nachweis durch das Unglück in Fukushima. Was man auf den ersten Blick gar nicht vermuten mag, dieses Diskussionspapier stammt vom Institut zur Zukunft der Arbeit (IZA) in Bonn. Eine Wirtschaftsforschungseinrichtung der Deutschen-Post-Stiftung. Sie soll lt. wikipedia etwa 50 Mitarbeiter haben und in einer schmucken Villa in Bonn residieren. Was mag ein Forschungsinstitut zur „Zukunft der Arbeit“ in Deutschland bewegen, eine Studie über den Zusammenhang zwischen Strompreisen und Todesfällen zu veröffentlichen? Ein Schelm, wer dabei spontan an etwas ganz anderes als das Reaktorunglück in Fukushima denkt.

Durch das Erdbeben mit anschließendem Tsunami kam es innerhalb von 14 Monaten zum totalen Abschalten aller Kernkraftwerke in Japan. Eine verständliche und richtige Reaktion. Man wollte in aller Ruhe die Ursachen und Schäden des Reaktorunglücks in Fukushima analysieren und gegebenenfalls Abwehrmaßnahmen einleiten. Bis heute sind noch nicht alle Reaktoren wieder am Netz. Hierdurch kam es zu einem scharfen Preisanstieg. In den ersten vier Jahren nach dem Unglück stieg der Anteil fossiler Energien von 62% auf 88%, parallel ging der Anteil der Kernenergie von 30% auf Null zurück. Bis 2016 war der Strommarkt – ähnlich wie früher in Deutschland auch – stark reguliert. Es gab zehn Versorgungsgebiete, in denen jeweils ein Versorger das Monopol hatte. Dafür mußte der Versorger sich seine Strompreise genehmigen lassen und zu diesem Zweck seine Kalkulationen offen legen. Man kann daher die Ursachen der Strompreisanstiege sehr genau nachvollziehen. Gemäß dem unterschiedlichen Anteil von Kernenergie in den Regionen, bewegte sich der Anstieg in Folge der Abschaltungen zwischen etwa 15% (Okinawa) und 44%. (Hokkaido, Kansai).

Für das Verständnis der Studie sind die gänzlich anderen Abrechnungsmodi für Haushaltsstrom in Japan von Bedeutung. Es gibt einen Grundpreis und einen Zuschlag, der sich aus dem Verbrauch des Vormonates ergibt (ähnlich Arbeits- und Leistungspreis für Industriekunden in Deutschland). Der „Preisdruck“ ist damit viel unmittelbarer als bei uns mit jährlicher Abrechnung und konstanten Monatsabschlägen. Japaner reagieren dadurch sofort mit Sparmaßnahmen. Ein weiterer Unterschied zu Deutschland ist der höhere Anteil elektrischer Energie zu Heizzwecken (ähnlich Frankreich).

Die monatlichen Sterbefälle wurden aus den öffentlichen Registern entnommen und auf Hunderttausend Einwohner normiert. Unterschiedliche Altersstrukturen in den Gemeinden wurden korrigierend berücksichtigt. Die stündlichen Temperaturen wurden von den meteorologischen Stationen verwendet und in acht Temperaturintervallen sortiert und mit den entsprechenden Bevölkerungszahlen gewichtet.

Im ersten Schritt wurde ein mathematisches Modell für die Quantifizierung von Strompreis und Verbrauch erstellt. Hierbei wurden noch zusätzliche Einflüsse berücksichtigt (z. B. die zeitliche Verzögerung durch die Rechnungsstellung, zusätzliche Wetterdaten wie Feuchtigkeit und Wind, Anzahl der Kinder bzw. Rentner im Haushalt usw.). Im zweiten Schritt wurde der Zusammenhang zwischen Sterblichkeit und Außentemperaturen geklärt. Im nächsten Schritt wurde aus diesen Teilmodellen ein Modell gebildet, welches die Sterblichkeit als Funktion von Außentemperatur und Strompreis darstellt. Vereinfacht kann man sagen, daß höhere Strompreise zu einer geringeren Beheizung führten und damit bei extremen Temperaturen das Risiko zu sterben anstieg.

Lange Rede, kurzer Sinn – allen Statistik-Freaks sei der Originalartikel empfohlen – die Studie kommt zu dem Ergebnis, daß infolge des Strompreisanstiegs durch die Abschaltung der Kernkraftwerke im Zeitraum 2011–2014 in Japan zusätzlich mindestens 4500 Menschen gestorben sind.

Bei aller Skepsis, die ein Kerntechniker gegenüber Korrelationen und daraus abgeleiteten Todesursachen hat, bleibt jedoch eine klare – wenn eigentlich triviale – Aussage: Hohe Energiepreise töten. Dies sei allen Anhängern der Öko-Sozialistischen-Verzichtskultur in ihre Gebetbücher geschrieben. Sie tötet nicht virtuell, wie irgendeine (eingebildete) Strahlengefahr, sondern ganz unmittelbar und meßbar. Die „Kältetoten“ sind real und erfaßbar. Kein Obdachloser oder Kleinrentner dem Strom und Gas abgestellt wurde, stirbt freiwillig. Alle Anhänger der „großen Transformation“ müssen sich einst wie ihre ideologischen Vorgänger Hitler, Stalin, Mao und Pol Pot für ihre Ideologie vor Gott und der Menschheit verantworten. Wer Energiepreise in schwindelnde Höhen treibt, rettet nicht die Erde vor einem (eingebildeten) „Hitzetot“, sondern tötet ganz unmittelbar und bewußt Menschen. Dies ist die Gemeinsamkeit aller sozialistischen Hirngespinste: Eine vermeintlich bessere Welt in der fernen Zukunft soll durch einen mit Toten gepflasterten Weg erkauft werden. Und noch etwas sei allen Akteueren ins Stammbuch geschrieben: Preise sind in freier Übereinkunft aus Angebot und Nachfrage gebildete Maßstäbe für die Knappheit eines Gutes. Irgendwelche CO2– Abgaben sind demgegenüber rein planwirtschaftliche Maßnahmen und damit das genaue Gegenteil von Marktwirtschaft und freiheitlicher Gesellschaft. Sie können niemals den Weg in eine bessere Zukunft weisen.

Der Beitrag erschien zuerst auf dem Blog des Autors hier

Der sogenannte „natürliche atmosphärische Treibhauseffekt“ ist die Basis aller Befürchtungen über eine menschengemachte Klimakatastrophe, weil dieser sich durch den technischen CO<sub>2</sub>-Ausstoß der Menschheit angeblich noch weiter verstärken und zu einer globalen Selbstverbrennung führen soll. Für einen solchen „natürlichen atmosphärischen Treibhauseffekt“ gibt es unterschiedliche Modelle, einen experimentellen Ansatz und zwei Widerlegungen. In Teil 1 wurden die unterschiedlichen Thesen/Antithesen vorgestellt und in Teil 2 diskutiert. Dieser Teil 3 behandelt nun die Erkenntnisse und Ergebnisse dieser Analyse.

ERKENNTNIS zu THESE (1) = Der konventionelle globale Stefan-Boltzmann-Ansatz mit einem „natürlichen atmosphärischen Treibhauseffekt“ von 33°C (Dietze, Krüger, Schnell, Heller):

Dieser Ansatz ist grundlegend falsch, weil er die Randbedingung der GLEICHZEITIGKEIT im Stefan-Boltzmann-Gesetz UND den 2. HS der Thermodynamik verletzt. Alle Klimamodelle, die auf diesem Ansatz basieren, sind folglich hoch toxisch.

Denn die fehlerhaft abgeleitete Temperaturgenese muss in diesen Modellen zwangsläufig auf andere Systemkomponenten verlagert werden, um der gemessenen Realität zu entsprechen. Dadurch wiederum ergeben sich rein rechnerische Atmosphäreneffekte (beispielsweise der äquatoriale Hotspot) und Wechselwirkungen (beispielsweise die sogenannten Kipp-Punkte) außerhalb jeder Realität.

In den Geowissenschaften ist bereits seit fast einem Jahrhundert bekannt, dass die Temperaturgenese auf unserer Erde allein von der Sonneneinstrahlung bestimmt wird. Bereits 1924 schrieben Köppen und Wegener in der Einleitung zu ihrem Buch “Die Klimate der geologischen Vorzeit” (Bornträger) auf den Seiten 3 und 4, Zitat mit Heraushebungen und Einfügungen:

„… Unter diesen Voraussetzungen gewinnt die KURVE DER SOMMERLICHEN STRAHLUNGSMENGEN [=Milankovic-Zyklen] für die letzten 6500 000 Jahre den Charakter einer ABSOLUTEN Chronologie des Eiszeitalters. Ihre Einzelheiten stimmen, wie gezeigt werden wird, in weitgehendem Maße mit den Annahmen der hervorragendsten Eiszeitforscher überein, so daß es unnötig erscheint, nach weiteren Ursachen für Klimaänderungen in dieser Zeit zu suchen.

Von den zahlreichen sonstigen Hypothesen, die zur Erklärung von Klimaänderungen aufgestellt worden sind, wird daher in diesem Buche nicht die Rede sein. Insbesondere erblicken wir in dem System der fossilen Klimazeugen KEINEN EMPIRISCHEN ANHALT für die Annahme, daß die von der Sonne ausgehende Strahlung sich im Laufe der Erdgeschichte geändert habe. Desgleichen fehlt es an Tatsachen, welche durch Änderung der DURCHSTRAHLBARKEIT der Atmosphäre (ARRHENIUS) oder des Weltalls (Nölke) zu erklären wären; …“

Der Nachdruck dieses Buches ist bei Schweizerbart erhältlich.

ERKENNTNIS zu THESE (2) = Breitenabhängige Mittelung der solaren Einstrahlung über Tag und Nacht (Kramm et al.):

Kramm et al. können die Temperaturgenese auf unserer Erde mit ihrem Modell weder abbilden noch erklären. Sie sind vielmehr die einzigen Protagonisten, die konkrete Aussagen zur Temperaturgenese auf der Erde vermeiden und zugleich auch eine klare Positionierung zum sogenannten atmosphärischen Treibhauseffekt unterlassen. Insbesondere fehlt dort die sinnstiftende Erklärung, wo denn eigentlich die Energie zur Überwindung des Temperaturunterschieds zwischen den aus einer globalen breitenabhängigen „Faktor-4“-Mittelung der solaren Einstrahlung berechneten Modelltemperaturen und den tatsächlich gemessenen Temperaturen auf der Erde herkommen soll.

Stattdessen invertieren Kramm et al. die primäre physikalische Wirkungskette (Sonneneinstrahlung => Temperatur), um ihr Modell argumentativ zu stützen. Die modellbedingte Verlagerung der globalen „Klimaküche“ auf den geographischen Pol der Sommerhemisphäre bricht dem Modell von Kramm et al. endgültig das Genick, weil diese Verlagerung einen jahreszeitlich wechselnden Verlauf der globalen Zirkulationen vom jeweiligen Sommerpol zum Winterpol der Erde erfordern würde.

Das Modell von Kramm et al. (2017) ist nicht von dieser Welt und enthält Richtiges und Falsches; nur wurde das Richtige nicht erstmals von Kramm et al. veröffentlicht, und das Falsche wurde von Kramm et al. schließlich als deren eigenes „Faktor4“-Strahlungsmodell identifiziert, Zitat:

„These values demonstrate that the power law of Stefan and Boltzmann provides inappropriate results when applied to globally averaged skin temperatures.“ (Seite 283 im unteren Drittel vom letzten Absatz)

Dazu sagt der unparteiische Google-Übersetzer: „Diese Werte zeigen dass das Potenzgesetz von Stefan und Boltzmann unangemessene Ergebnisse liefert, wenn es auf global gemittelte Hauttemperaturen angewendet wird.“

Im Klartext heißt dieses Ergebnis von Kramm et al. (2017) also:

ENTWEDER ist das S-B-Gesetzt falsch ODER die globale Mittelung.

Da aber das Stefan-Boltzmann-Gesetz ein GÜLTIGES physikalisches Gesetz ist, MUSS also die GLOBALE Mittelung FALSCH sein:

Kramm et al. erbringen mit dieser Erkenntnis den Nachweis, dass alle drei Ansätze (1), (2) und (3) falsch sind, weil dort bei (1) und (2) die tagseitige Sonneneinstrahlung (@PIR²) sowie bei (3) das tagseitige S-B-Temperaturäquivalent global über die gesamte Erdoberfläche (@4PIR²) gemittelt wird – und sie bestätigen damit implizit die Richtigkeit meines HEMISPHÄRISCHEN Stefan-Boltzmann-Ansatzes (@2PIR²).

ERKENNTNIS zu THESE (3) = Globale Stefan-Boltzmann-Integration (Gerlich&Tscheuschner):

Gerlich und Tscheuschner beginnen richtig mit einem dreidimensionalen S-B-Rechenmodell und mitteln dieses Ergebnis dann zweidimensional über die gesamte Erdoberfläche. Damit landen sie am Ende wieder bei dem globalen „Faktor4“-Ansatz über Tag- und Nachtseite der Erde aus den Thesen (1) und (2).

Der von Gerlich und Tscheuschner aufgezeigte Widerspruch (33°C # 144°C) ist also konkludent nach dem falschen „Faktor4“-Ansatz für den „natürlichen atmosphärischen Treibhauseffekt“ (Modelle 1 und 2) abgeleitet worden. Damit haben Gerlich & Tscheuschner den „natürlichen atmosphärischen Treibhauseffekt“ direkt aus diesem fehlerhaften THE-Modell heraus widerlegt, allerdings ohne eine konkrete Perspektive für die tatsächliche Temperaturgenese auf der realen Erde aufzuzeigen.

ERKENNTNIS zu THESE (4) = „Hemisphärischer“ Stefan-Boltzmann-Ansatz (Weber):

Mein hemisphärischer Stefan-Boltzmann-Ansatz beruht strenggenommen lediglich auf der unverstandenen Randbedingung einer strengen GLEICHZEITIGKEIT im Stefan-Bolzmann-Gesetz – und diese physikalische Randbedingung spielt offenbar für Laien UND Fachleute keine Rolle.

Jedenfalls unterscheidet mein hemisphärischer S-B-Ansatz dreidimensional zwischen Tag und Nacht und ist in der Lage, die Temperaturgenese auf der Tagseite unserer Erde über das Stefan-Boltzmann-Gesetz und die Abstrahlung der Erde über die S-B-Umgebungsgleichung zu erklären.

ERGEBNIS DIESER ANALYSE UND PERSPEKTIVE FÜR KÜNFTIGE KLIMAMODELLE

Die Erde erhält einen Anteil der solaren Abstrahlung auf einer Kreisfläche von (PI*R²) mit dem Erdradius R und der Solarkonstante 1.367 W/m². Der Fehler bei der konventionellen THE-Berechnung besteht nun darin, diese Solarkonstante über die Tag- und Nachtseite der Erde (@4*PI*R²) zu mitteln.

Die Thesen (1), (2) und (3) stellen also zweidimensionale Modelle der Erde dar, die durch eine realitätswidrige Tag&Nacht-Mittelung der temperaturwirksamen solaren Einstrahlung bzw. dessen S-B-Temperaturäquivalentes charakterisiert werden können. Damit fehlt in allen diesen Ansätzen ein ausreichend großes S-B-Strahlungsäquivalent, um die tatsächlich gemessenen Temperaturen auf der Erde erklären zu können.

Die nachfolgend abgebildete Mollweide Projektion in Abbildung A für eine 2D-Erde veranschaulicht diesen zweidimensionalen Ansatz. Und der vorgebliche „natürliche atmosphärische Treibhauseffekt“ ist genau dieser fehlerhaften Tag&Nacht-Mittelwertbildung geschuldet, um deren Differenz zur vorgeblich „gemessenen“ Globaltemperatur NST zu erklären. Meine hemisphärische S-B-Herleitung (4) ermöglicht als dreidimensionales Modell (Abbildung B) dagegen eine korrekte Implementierung von Tag und Nacht und kommt ohne einen solchen atmosphärischen Treibhauseffekt aus:

Diese eingeschränkte zweidimensionale Sicht auf unsere dreidimensionale Erde ist der tiefere Grund für den gegenwärtigen klimareligiösen Alarmismus. Am 26. September 2019 erschien auf ScienceFiles ein Beitrag mit dem Titel „Klimaalarmisten, das IPCC, die UN denken nachweislich, die Erde sei eine Scheibe [keine Satire]“, Zitat mit Hervorhebungen:

„Dass die Erde eine Scheibe sei, ist nämlich eine Annahme, die allen Klimamodellen, die wiederum Grundlage der Behauptung, der Klimawandel sei menschengemacht sind, eigen ist.

Michael J. Prather und Juno C. Hsu haben in einem brandneuen Beitrag für die Zeitschrift „Proceedings of the National Academy of Science“ (PNAS – peer reviewed) auf diesen zwischenzeitlich vergessenen Umstand aufmerksam gemacht:

„In allen Klimamodellen”, so schreiben sie, “wird angenommen, dass die Oberfläche der Erde flach 2D und nicht 3D ist“ (19330).“

Dr. Paul Berberich hatte in einer bisher leider unveröffentlicht gebliebenen Arbeit den Globus in eine hemisphärische Tag- und Nachtseite aufgeteilt. Eine Verschiebung des Zentralmeridians (nebenstehende Abbildung) führt dann zu beliebig vielen Hemisphären. Dr. Berberich verwendet in seiner Betrachtung 5°-Schritte und erhält somit über den 24-Std.-Tag 72 Hemisphären. Diese Hemisphären sind nicht unabhängig voneinander, sondern ergänzen sich paarweise zur Global-Temperatur.

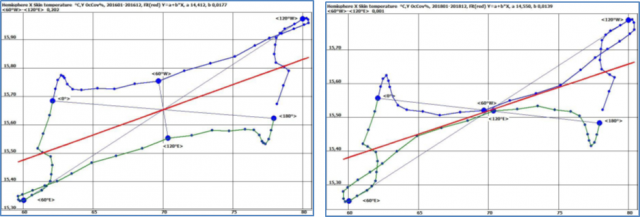

In Bild 8 bis 10 werden dort die Jahres-Mittel- Temperaturen für die Jahre 2016 bis 2018 in hemisphärischer Darstellung dargestellt. Die Temperaturdifferenz zwischen den Hemisphären T60W und T120E („Hysterese“) verringert sich während dieser Jahre beträchtlich von 0,202 auf 0,001 °C:

In 2015/2016 trat ein starker El Niño mit großer „Hysterese“ auf, allerdings tritt bei großer „Hysterese“ nicht immer zwingend ein El Niño-Ereignis ein. Diese hemisphärische „Hysterese“ wäre aber umgekehrt ein guter Negativindikator, denn bei geringer Temperaturdifferenz zwischen den Hemisphären T60W und T120E kann umgekehrt offenbar kein El Niño auftreten. Dr. Berberich leitet aus seiner hemisphärischen Analyse die Aussage ab, dass man die die El Niño-Vorhersage um einen (solchen?) globalen Indikator ergänzen sollte.

Die Basis von zweidimensionalen Klimamodellen hatte zwischenzeitlich auch ein Anonymus namens Aulus Agerius hinterfragt und auf Grundlage meines hemisphärischen S-B-Ansatzes ein alternatives dreidimensionales Klimamodell erstellt. In seinem Buch „Kritische Analyse zur globalen Klimatheorie: Widerlegung der Basisstudie KT97 des IPCC mit den Messwerten des ERBS Satelliten an einem neuen Modell“ deckt er erhebliche Widersprüche in der IPCC-Basisstudie KT97 auf. Deren Mittelbildung zwischen Tag- und Nachtseite der Erde folgen implizit ja auch die hier diskutierten Ansätze (1) bis (3). Diesem IPCC-Modell stellt er sein „Modell 5“ entgegen, das wiederum auf meinem hemisphärischen Strahlungsmodell aufbaut und ohne einen atmosphärischen Treibhauseffekt auskommt:

Zitate aus der Kurzzusammenfassung (mit Hervorhebungen): „Die Studien der letzten 15 Jahre, die die Existenz eines Treibhauseffektes befürworten, beziehen sich mit kleineren Modifikationen final auf eine Studie von J. H. Kiehl und Kevin E. Trenberth aus dem Jahr 1997, bezeichnet als KT971. Die Erderwärmung durch CO2, der Treibhauseffekt, wurde in dieser (Ur-) Studie aus einer Gleichgewichtsberechnung von flächenbezogenen Energieflüssen abgeleitet, die durch die Sonne verursacht werden. Hierbei wurde die Atmosphäre als Modell in einem Gleichgewichtszustand von Energieflüssen, umgangssprachlich Strahlung, betrachtet.

… In Abschnitt 5 wird mit einer modifizierten Modellbildung (Strahlungsverteilung nach Modell Ulrich O. Weber2) die von der Sonne emittierte Strahlung auf die Erde verteilt und neuerlich eine Budget- bzw. Gleichgewichtsbetrachtung vorgenommen.

… Mit Modell 5 wird der Treibhauseffekt mit den Messwerten der Satelliten ERBS, TERRA und AQUA widerlegt. Durch die Eigenschaften der Reflektion von Erde und Atmosphäre kann ein kühlender Effekt, sun umbrella Effekt, festgestellt werden (Abschnitt 6). In Abschnitt 7 wird aufgezeigt, wie sich Strahlungs- und Albedo-Änderungen im Modell nach Abschnitt 5 zu Änderungen der globalen Mitteltemperatur und damit zu Eiszeiten und zu Warmzeiten führen könnten – ohne CO2-Einfluss…“

FAZIT: In einer dreidimensionalen Betrachtung der Temperaturgenese auf unserer Erde macht allein eine Albedosteuerung der solaren Einstrahlung als natürlicher Antrieb des Paläoklimas Sinn, und zwar ganz ohne einen „natürlichen atmosphärischen Treibhauseffekt“.

Denn die spezifische Strahlungsleistung der Solarkonstante von 1.367 W/m² stellt nach dem Stefan-Boltzmann-Gesetz mit etwa 120 Grad Celsius das maximal mögliche Temperaturäquivalent für unsere Erde aus der solaren Einstrahlung dar. Und nur die Albedo der Erde kann ausreichend große Energiemengen der einfallenden Sonneneinstrahlung steuern, um die nachgewiesenen Schwankungen des natürlichen Paläoklimas zu erklären.

Der rechnerische Nachweis für eine solche Albedosteuerung ist in meiner englischsprachigen Veröffentlichung “An Albedo Approach to Paleoclimate Cycles” (Mitteilungen der Deutschen Geophysikalischen Gesellschaft Nr. 2015/3 ab Seite 18) zu finden, die deutsche Übersetzung „Ein natürlicher Albedo-Antrieb erklärt die globale Klimagenese“ in meinem aktuellen Buch „Mehr geht nicht“ und eine deutsche Kurzfassung auf KalteSonne.

Ein grobes Reaktionsmodell für die globale Klimagenese war schließlich auf KalteSonne veröffentlicht worden:

In der EIKE-News vom 28. November 2019 wurde bereits über einen Nuklearia-Artikel berichtet, der sich kritisch mit der Ablehnung der Kernenergie seitens der Leopoldina, Akademieunion und acatech auseinander setzte. Nun hat die EU per Gerichtsbeschluss ein eindeutiges positives Zeichen für den weiteren Ausbau der Kernenergie in der EU gesetzt. Der Artikel in „ERNEUERBARE ENERGIEN“ (Sie lesen richtig, denn Kernenergie zählt zu den Erneuerbaren) mit dem Titel EU untermauert ihre Liebe zur Atomkraft schildert die Einzelheiten.

Wegen der Gefahr von Schnappatmung und den damit verbundenen Gesundheitsgefahren, denen die Verfasser in Leopoldina, Akademieunion und acatech ausgesetzt sein könnten, sollten die Damen und Herren Verfasser der angesprochenen Schrift die folgende Neuigkeit besser ruhig atmend bei einem guten Glas Wein aufnehmen:

Die AfD als größte Oppositionspartei Deutschlands wendet sich nicht nur gegen „Klimaschutz“, sowie die für unsere Volkswirtschaft und Natur katastrophale Energiewende. Sie hat auf ihrem Braunschweiger Parteitag nunmehr mit großer Mehrheit beschlossen, die Kernenergie zu propagieren und in Deutschland wieder zu etablieren. Dies ist aktuell (Montag Abend, den 2.12.2019) noch nicht in den Medien aufzufinden, weil die TV-Übertragung zu früh abbrach, um darüber unmittelbar berichten zu können. Der Autor erfuhr von den Vorgängen in Braunschweig vermittels telefonischer Benachrichtigung.

Heutzutage muss betont werden, dass EIKE politisch neutral und unabhängig ist und mit dieser News ausdrücklich keine politischen Aussagen oder Stellungnahmen zu verbinden beabsichtigt. Allein von der Sache her begrüßt es aber EIKE nachdrücklich, dass sich endlich eine deutsche Volkspartei für die Kernenergie ausspricht und damit der EU folgt. Warum die Kernenergie übrigens eindeutig zu den erneuerbaren Energien zählt, erfahren Sie in

Ein „Wissenschaftserklärer“ und Buchautor ist der Physiker Florian Aigner.

Weltuntergangsgeschichten meint er damit leider nicht. In einem aktuellen Artikel gibt er einen historischen Abriß von technologischen Lösungen der Probleme, die sich in der industriellen Moderne ergaben. So machte man sich im 19. Jahrhundert Sorgen, daß die wachsenden Städte unter Bergen von Pferdeäpfeln begraben würden – das Auto und die Straßenbahn halfen. Als ein Riesenhochhaus in Dubai geplant wurde, gab es keine Technologie, um den Beton kilometerhoch zu pumpen. Wurde im Laufe des Baus gelöst, das Problem. Man hätte den Problemen der Vergangenheit seitens der Politik und Verwaltung mit Verboten und Grenzwerten begegnen können, meint Aigner, was angesichts des technologischen Fortschrittes aber sinnlos war. Selbst den Atommüll heutiger Tage sieht der Autor nicht als ewiges Problem an, da gewiß eine Lösung gefunden werden wird.

Ganz anders sehen die Verhältnisse natürlich beim „menschgemachten Klimawandel“ aus, da kann man mit technischen Mitteln gar nichts ausrichten. Dem stimmen wir zu, weil es den anthropogenen Klimawandel erstens nicht gibt, und zweitens die Gegenmaßnahmen wie Windräder und E-Autos sinnloser Mumpitz sind, die ihrerseits heftige Probleme zeitigen, die gelöst werden müssen.

Physiker Aigner sieht es etwas anders. Er wiederholt wie ein Papagei die apokalyptische Litanei der Polit-Wissenschaftler von UN und PIK und verlangt drastische Kohlendioxideinsparung sofort:

„Und der Grund dafür ist ganz banal: Wir haben keine Zeit. Der Weltklimarat IPCC hat berechnet, wie viel CO2 wir weltweit noch ausstoßen dürfen, um unsere Chancen auf einigermaßen stabile Ökosysteme nicht völlig zu verspielen. Die Grenze, die uns immerhin noch auf eine 66-Prozent-Chance läßt, die Erwärmung auf 1,5°C zu beschränken, werden wir bei gleichbleibendem CO2-Ausstoß in weniger als zehn Jahren erreichen. ….“

Der geneigte EIKE-Leser hört hier Rahmstorf & Co. von ihren Computermodellen und Szenarien reden, die mit der Wirklichkeit, weder in Vergangenheit noch Zukunft, etwas zu tun haben und immer wieder zurechtmanipuliert werden müssen, damit sie zu den Meßdaten passen. Klimagate und Ball-Mann-Prozeß lassen grüßen. Und man darf nicht vergessen, daß die Klima-Kipp-Punkte der „Wissenschaftler“ immer wieder vergessen und neu definiert werden. Nach Al Gore in seinem Film „Eine unbequeme Wahrheit“ sollte die apokalyptische Grenze 2015 erreicht sein, was aber irgendwie kein Journalist oder Rahmstorf im Präsenzgedächtnis hatte. Stattdessen dürfen wir uns von Katastrophen-Gretel heute anhören, daß am Kollaps in zwölf Jahren oder so nichts mehr zu ändern sei. Und in zwölf Jahren dann, wenn Fräulein Thunfisch vergessen ist/wurde, kommt dann jemand anderes mit einem neuen Kipp-Punkt in 15 Jahren oder so.

Das weiß wahrscheinlich auch unser Wissenschaftserklärer im Artikel, aber solche Zweifel läßt man lieber erst gar nicht zu, sonst gibt es keine Jobs als Wissenschafterklärer. Am Ende des Artikels finden sich noch zwei unfreiwillige Pointen, die sich der Klimaleugner nicht besser hätte ausdenken können. Aigner meint allen Ernstes, daß „neue Kraftwerkstypen“ in der Vergangenheit nicht entwickelt worden seien, mit denen man die CO2-Katastrophe hätte aufhalten können. Das soll wohl ein Scherz sein – unser Physiker weiß nichts vom Schnellen Brüter und anderen Konzepten, die in den 1980ern durch grün-mediale Panikmache verdammt wurden uns heute inhärent sicher zuverlässig billige Energie liefern könnten, wegen meiner auch CO2-neutral?

Die zweite Pointe ganz zum Schluß des Artikel ist noch besser: Da steht, daß unser Klimahysteriker sich oft mit „Esoterik und Aberglauben, die sich so gerne als Wissenschaft tarnen“, beschäftigt.

Aufgrund eines behaupteten Klimanotstandes sollen neue Gesetze erlassen werden. Diese schreiben uns unsere Art zu leben vor, haben nachteilige Umweltfolgen und können zur Deindustrialisierung Deutschlands führen. Das bedeutet den Verlust von Wohlstand und sozialer Sicherheit.

Regierung und Parlament veranlassen somit gezielt eine Senkung des Lebensstandards und gefährden damit Arbeitsplätze, Alterssicherung und soziale Hilfen in Notfällen. Dann sollten unsere gewählten Vertreter zumindest nachweisen, dass sie den zugrunde liegenden Sachverhalt vollständig verstehen und die Konsequenzen durchdacht haben.

Wir stellen daher sechzehn Klimafragen an die Abgeordneten des Deutschen Bundestages.

https://www.klimafragen.org/#about

Sehr geehrte Damen und Herren Volksvertreter,

aufgrund eines behaupteten Klimanotstandes wurden von Ihnen verschiedene Gesetze erlassen, deren Verfassungsmäßigkeit umstritten ist. Dabei soll es nicht bleiben. Die Bürger sollen unter anderem auf Flugreisen, auf Kreuzfahrten, auf das Autofahren oder auf fleischhaltige Ernährung verzichten oder all dies signifikant einschränken. Industriezweige von erheblicher volkswirtschaftlicher Bedeutung wie die Automobilherstellung, die Energieerzeugung und die Landwirtschaft sollen radikal umgestaltet werden. Die Folgen werden in vielen Bereichen unumkehrbar sein, mindestens sind sie unkalkulierbar.

Wir haben uns formlos zusammengeschlossen, um als Bürger Fragen zu stellen. Wir möchten die Rationalität anstehender politischer Entscheidungen nachvollziehen können. Wir legen dabei die Maßstäbe an, mit denen wir in unseren Berufen seit Jahrzehnten tagtäglich und sorgfältig arbeiten. Wir selbst fragen hier parteiunabhängig. Wir kommen aus den verschiedensten Berufen und verfügen über unterschiedlichstes Fachwissen. Wir betrachten uns als Teil der kritisch-konstruktiven Zivilgesellschaft. Globale Herausforderungen betreffen alle. Deswegen müssen auch alle an ihrer Bewältigung angemessen mitwirken können.

Ausgehend von der Annahme, eine menschengemachte Klimaerwärmung sei erwiesen und menschliches Reaktionshandeln darauf geboten, muss – vernunftgeleitet – erörtert werden: Welche Folgen ergeben sich aus dieser Erkenntnis und mit welchen möglichen Maßnahmen kann einer schädlichen Klimaerwärmung mit Aussicht auf Erfolg entgegengewirkt werden? Weiter muss abgewogen werden, ob die vorgeschlagenen Maßnahmen in Summe mehr nutzen als schaden. Der einschneidende Umbau der wesentlichen Strukturen eines ganzen Landes kann nur insoweit gerechtfertigt sein, als alle diese Fragenkomplexe eindeutig beantwortet sind. Alles andere verbietet sich schon aus ethisch-moralischen Gründen, denn zu viele Existenzen hängen daran. Gerade im Sinne des Vorsorgeprinzips dürfen funktionierende Strukturen nicht für Ungewisses geopfert werden.

Dies ist keine Petition. Wir sind Teil des Souveräns. Sie sind diejenigen, die von uns gewählt und bezahlt werden. Und Sie schicken sich derzeit an, wesentliche Inhalte unseres Gesellschaftsvertrages abzuändern. Wir halten es daher für angemessen, dass Sie uns fraktionsweise die folgenden Fragen beantworten. Wir werden Ihre Antworten veröffentlichen. Alle Wahlberechtigten sollen Gelegenheit erhalten, sich ein Bild von Ihren Argumenten, von deren Qualität und von Ihren Abwägungsprozessen zu machen.

Mit freundlichen Grüßen

Die Erstunterzeichner und 56 wahlberechtigte Unterstützer

Der „UN-Weltklimarat“ IPCC konstatierte in seinem dritten Report von 2001: „In Sachen Klimaforschung und -modellierung sollten wir anerkennen, dass es sich dabei um ein gekoppeltes, nicht-lineares, chaotisches System handelt. Deshalb sind längerfristige Vorhersagen über die Klimaentwicklung nicht möglich.“ Tatsächlich wohnt Prognosen der klimatischen Entwicklung, die über einen Zeitraum von mehr als zehn Jahren hinausgreifen, keinerlei Vorhersagekraft mehr inne. Die Klimaforschung behilft sich daher mit Szenarien, die zwar plausibel und in sich widerspruchsfrei sind, denen aber aufgrund ihrer Konstruktion keine Eintrittswahrscheinlichkeiten zugeordnet werden können. Allein der unvermeidbare statistische Fehler bei der Bestimmung des Langwellenstrahlungseffekts der Wolkenbildung in Standard-Klimamodellen ist über hundertmal größer als der Effekt, der nach diesen Modellen vom CO2 verursacht sein soll.

Frage 1: Wie wollen Sie angesichts der geschilderten Umstände die Einhaltung eines bestimmten Klimaziels sicherstellen, wenn doch verlässliches Wissen über zukünftige klimatische Entwicklungen prinzipiell nicht erworben werden kann?

Wir haben uns formlos zusammengeschlossen, um als Bürger Fragen zu stellen. Wir möchten die Rationalität politischer Entscheidungen nachvollziehen können. Das gilt insbesondere für Themen, die alle betreffen und die massiv in unsere Lebensweise eingreifen. Wir legen dabei genau die Maßstäbe an, mit denen wir in unseren Berufen seit Jahrzehnten tagtäglich und sorgfältig arbeiten. Wir fragen parteiunabhängig. Wir kommen aus den verschiedensten Berufen und verfügen über unterschiedlichstes Fachwissen.

Der sogenannte „natürliche atmosphärische Treibhauseffekt“ ist die Basis aller Befürchtungen über eine menschengemachte Klimakatastrophe, weil dieser sich durch den technischen CO<sub>2</sub>-Ausstoß der Menschheit angeblich noch weiter verstärken und zu einer globalen Selbstverbrennung führen soll. Für einen solchen „natürlichen atmosphärischen Treibhauseffekt“ gibt es unterschiedliche Modelle, einen experimentellen Ansatz und zwei Widerlegungen. In Teil 1 wurden die unterschiedlichen Thesen/Antithesen vorgestellt, die nachfolgend einzeln diskutiert werden.

MEINE ARGUMENTATION zu THESE (1):

Der Ansatz (1) ist grundlegend FALSCH, weil er über eine Gleichsetzung von Tag und Nacht die STRENGE PHYSIKALISCHE GLEICHZEITIGKEIT im Stefan-Boltzmann-Gesetz verletzt. Mit der Solarkonstanten (S0=1367 W/m²), der Erdalbedo (ALPHA=0,3) und der temperaturwirksamen Strahlungsleistung (Seff = S0*(1-ALPHA) = 940 W/m²) ergibt sich für die Netto-Strahlungsbilanz der Erde:

(IN = 940 W/m² * π R2) = (OUT = 235 W/m² * 4 π R2) @ NST (= 14,8 °C)

Das bedeutet, die Temperaturgenese der Erde erfolgt ausschließlich auf ihrer Tagseite mit (940 W/m² * cos Phi), und die Abstrahlung erfolgt mit durchschnittlich 235 W/m² über ihre gesamte Oberfläche. Und das alles geschieht im Strahlungsgleichgewicht der Klimadefinition (>30 Jahre) bei einer vorgeblich „gemessenen“ konstanten Globaltemperatur NST, in deren Berechnung bereits die tatsächlich gemessene Nachttemperatur eingegangen ist.

Ansatz (1) ignoriert den Unterschied zwischen Tag und Nacht und setzt einfach den Wert für die durchschnittliche globale Abstrahlung in das Stefan-Boltzmann-Gesetz ein. Durch diese globale Mittelung wird aber die temperaturwirksame spezifische Flächenleistung der solaren Einstrahlung verfälscht. Und die daraus abgeleitete „natürliche“ Temperatur der Erde von minus 18°C erfordert wiederum einen „natürlichen atmosphärischen Treibhauseffekt“ von 33°C, um die Differenz zur vorgeblich gemessenen Globaltemperatur NST zu erklären.

Selbst in der Ableitung einer Strahlungstransfergleichung wird unter impliziter Einbeziehung einer Nachttemperatur von minus 273°C die vorgebliche „S-B Gleichgewichtstemperatur“ (Teq = -18°C) als globale Mittelung der temperaturwirksamen solaren Einstrahlung über die gesamte Erdoberfläche benutzt. Und damit führt dieser Ansatz rekursiv auf seine eigene Randbedingung einer globalen „Faktor4-Mittelung“ zurück.

Vielmehr kann man sich physikalischen Randbedingungen des Stefan-Boltzmann-Gesetzes auch so vorstellen, dass die die Temperaturgenese auf unserer Erde ausschließlich dort erfolgt, wo Strahlung GLEICHZEITIG Temperatur erzeugen kann. Bei einer Betrachtung der Temperaturgenese muss man sich also auf die tatsächlich beleuchtete Tagseite unserer Erde beschränken.

BEWEISFÜHRUNG zu (1.1) – Die Erde wird als ein selbstleuchtender Stern betrachtet (Dietze):

Für einen selbst leuchtenden Stern kann man tatsächlich eine S-B-Inversion durchführen, beispielsweise für die Sonne, indem man die spezifische Strahlungsdichte (Solarkonstante) vom Erdbahnradius auf die Oberfläche der Sonne zurückrechnet und darauf das S-B-Gesetz anwendet; dabei bleibt die spezifische Strahlungsleistung auf den jeweils betrachteten Flächen zeitgleich konstant.

Die Erde ist aber kein selbst leuchtender Stern, bei dem man die einfallende Strahlungsleistung der Sonne über die gesamte Oberfläche mitteln könnte; dazu bräuchte es nach These (1.1) vielmehr zwei Sonnen mit halber Strahlkraft, jeweils eine auf der Tagseite und eine auf der Nachtseite der Erde. Denn die Temperaturgenese findet ausschließlich auf der solar bestrahlten Seite der Erde statt, und zwar tageszeit-, breiten- und jahreszeitabhängig. Die Einbeziehung der Nachtseite der Erde in eine Berechnung mit dem Stefan-Boltzmann-Gesetz ist damit physikalisch naiv und hat dieselbe Relevanz wie eine Einbeziehung der Fläche des Experimentiertischs in die Ergebnisrechnung des Stefan-Boltzmann-Experiments – solche unbeleuchteten Flächen haben mit dem S-B-Gesetz nämlich überhaupt nichts zu tun.

BEWEISFÜHRUNG zu (1.2.1) – Die Klimawirksamkeit von Treibhausgasen (Krüger):

TREIBHAUSGASE: Den sogenannten „Treibhausgasen“ (THG), hauptsächlich Wasserdampf, Kohlenstoffdioxid und Methan, wird vom IPCC eine aktive Temperaturwirksamkeit in [W/m²] zugemessen. Diese Zuordnung ist aber grundsätzlich falsch, weil solche Gase keine aktive Strahlungsquelle darstellen. IR-aktive Gase absorbieren zwar passiv Infrarotstrahlung, können eine solche Strahlung aber ohne externe Quelle gar nicht aus eigener Kraft erzeugen. Es handelt sich vielmehr um eine Art „energetischen Staffellauf“ – und damit entfällt auch ein zusätzlicher energetischer Beitrag dieser THG zum sogenannten Treibhauseffekt.

SATELLITENMESSUNGEN: Der Beweis eines atmosphärischen Treibhauseffektes durch Satellitendaten besteht lediglich aus einem VERGLEICH zwischen der theoretischen IR-Abstrahlung der Erde und den vorgeblich von Satelliten „gemessenen“ Spektren, denen ganz erhebliche Rechenprozesse hinterlegt zu sein scheinen: Die veröffentlichten NIMBUS-IR-Spektren überdecken einen deutlich größeren Wellenlängenbereich, als es die dort gemessenen IR-Intervalle hergeben (Fußnote *1). Und beim AERI-Spektrometer werden offenbar lediglich Interferenzsignale für konkrete IR-Intervalle gemessen und über eine Fourier-Transformation spektral analysiert. Daraus wird dann anscheinend im Abgleich mit Vergleichs-Schwarzkörpern ein IR-Gesamtspektrum berechnet (Fußnote *2).

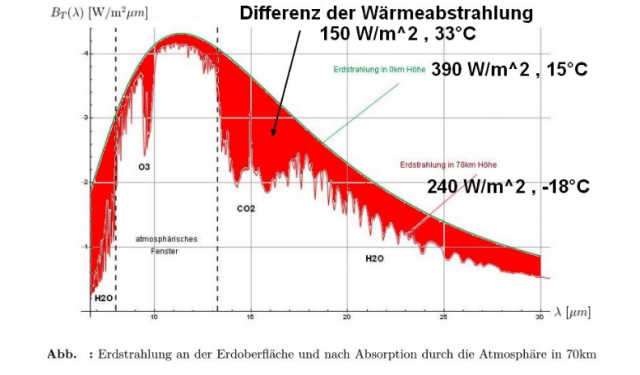

Das abschließende KO-Kriterium für die These (1.2.1): Das vorgelegte IR- Beweisspektrum für diese These zeigt eindeutig globale rechnerische Mittelwerte aus dem konventionellen S-B-Ansatz und stellt daher keine beweiskräftigen Messerwerte dar. Vielmehr bedeutet die exakte Einhaltung der durchschnittlichen THE-Eckwerte (240+150=390) W/m² in dem vorliegenden IR-Spektrum ein eindeutiges KO-Kriterium für die These (1.2.1).

Bei dem IR-Spektrum@70km handelt es sich nicht etwa um echte IR-Messwerte, sondern um ein wohlmeinendes handwerkliches Zirkelkonstrukt. Dieses konstruierte F-Wort-Spektrum kann keinerlei eigene Beweiskraft für einen „natürlichen atmosphärischen Treibhauseffekt“ entwickeln, weil es nämlich umgekehrt rein rechnerisch aus dieser THE-Hypothese abgeleitet worden ist.

Fußnoten zu den „gemessenen“ IR-Spektren (bei tieferem Interesse sei der Google-Übersetzer empfohlen):

*1) Das Nimbus 3 Satellite Infrared Spectrometer (SIRS) misst laut NASA 8 Intervalle, Zitat: „… in seven spectral intervals in the carbon dioxide band (11 to 15 micrometers) and one interval in the atmospheric window centered at 11.1 micrometers“.

*2) Nach dem AERI Handbook scheint es bei solchen Messungen eine Art vergleichendes Dataprocessing zu geben, Zitat mit Hervorhebungen (7.3.1 Theory): „Two blackbody sources, one at ambient temperature and the other at 330K are used to calibrate the instrument. The two sources are used to determine the slope and offset, which define the linear instrument response at each wavenumber. (see reference 1) The AERI views these two blackbodies every two minutes. Magnitude of the difference between these blackbody spectra is then formed to compute the responsivity and offset for the instrument.“

BEWEISFÜHRUNG zu (1.2.2) – Experimenteller Nachweis des „natürlichen atmosphärischen Treibhauseffektes“ (Schnell):

Kernaussage (1.2.2-1): Mit Bezug auf eine abgewandelte Umgebungsgleichung des Stefan-Boltzmann-Gesetzes wird hier der Umgebungstemperatur T0 eine „Gegenstrahlung“ zugeschrieben. Aber anders als beim Stefan-Boltzmann-Gesetz, das eine Umgebung von 0 Kelvin voraussetzt, strahlt ein Schwarzer Körper (T) in einer erwärmten Umgebung (T0) lediglich mit einer verminderten Leistung nach der S-B Umgebungsgleichung DELTA S (=P/A) = SIGMA (T4 – T04). Es handelt sich hierbei physikalisch also eindeutig um eine verminderte Abstrahlung des Schwarzen Körpers und nicht um eine „Gegenstrahlung“ seiner Umgebung.

Die Verminderung der Strahlungsleistung eines Schwarzen Körpers mit (T) in einer Umgebung von (T0>0K) stellt also keinerlei physikalischen Beweis für eine „Gegenstrahlung“ dar, sondern folgt lediglich den bekannten physikalischen Gesetzen.

Kernaussage (1.2.2-2): Um welchen Effekt es sich bei der von Dr. Schnell experimentell festgestellten Temperaturwirkung von CO2 handeln könnte, vermag der Autor nicht zu beurteilen.

Nach den HS der Thermodynamik muss die erforderliche Energie jedenfalls irgendwo herkommen, denn das CO2-Molekül ist nicht in der Lage, aus sich selbst heraus Energie zu erzeugen.

BEWEISFÜHRUNG zu (1.3) – Variable Abstrahlungshöhe der Erde (Heller):

Die „atmosphärische Rückstrahlung“ soll angeblich die Erdoberfläche mit zusätzlich 150 [W/m²] erwärmen, ein kälterer Körper (240 W/m²) erwärmt also fortlaufend einen wärmeren (390 W/m²). Für These (1.3) liegen verschiedene Konformitätsbehauptungen mit den HS der Thermodynamik vor.

Diese Gegenstrahlung bedient sich exakt der konventionellen Stefan-Boltzmann Herleitung von (240 W/m² entspricht -18°C) und (390 W/m² entspricht 15°C) mit einer Temperaturdifferenz von 33 Grad. Aber die Hauptsätze der Thermodynamik schließen ein Perpetuum Mobile jeglicher Art grundsätzlich aus, da hilft auch die Hilfskonstruktion einer „variablen Emissionshöhe“ nicht weiter.

Weiterhin entkoppelt sich das Modell einer „variablen Emissionshöhe“ ausgerechnet von der globalen Durchschnittstemperatur, der es eine grundsätzliche globale Abstrahlung bei minus 18°C entgegensetzt, ohne deren zwingende Relevanz nachgewiesen zu haben. Die „variable Emissionshöhe“ bei minus 18°C stellt damit lediglich eine Rekursion auf den konventionellen S-B-Ansatz selbst dar. Und durch eine „vollautomatische“ Anpassung der Emissionshöhe „deckelt“ dieses Modell alle inneren Widersprüche des konventionellen S-B-Ansatzes (1).

Insbesondere sperrt dieses Modell die tatsächliche Temperaturgenese auf der Tagseite unserer Erde und die nachgewiesenen paläoklimatischen Temperaturschwankungen aus seiner Betrachtung aus.

Umgekehrt wird allerdings ein Schuh daraus: Wenn der gesamte „Körper ERDE“ in der hohen Atmosphäre bei minus 18°C mit 235 W/m² in den Weltraum abstrahlt, dann entspricht die vorgeblich durchschnittlich 14,8°C warme Erdoberfläche zunächst einem S-B-Strahlungsäquivalent von 390 W/m². Gegenüber der hohen Atmosphäre mit minus 18°C ergibt sich damit nach der Umgebungsgleichung des S-B-Gesetzes [Delta S = Sigma * (T4-T04)] aber ein Delta-Wärmefluss vom Wärmeren (Erdoberfläche) zum Kälteren (hohe Atmosphäre) von lediglich 155 W/m²:

(@NST = 14,8°C&390W/m²) 155 W/m² => (@T@70 = -18°C&235W/m²) 235 W/m² => Weltraum

Damit folgt die bekannte Differenz von [Delta S = 155 W/m²] exakt den HS der Thermodynamik und hat gar nichts mit einem „Treibhauseffekt“ oder einer „Gegenstrahlung“ zu tun, sondern ist allein den jeweils behaupteten Ortstemperaturen (T=14,8 °C) und (T0 = -18°C) geschuldet.

MEINE ARGUMENTATION zu THESE (2) – Breitenabhängige Mittelung der solaren Einstrahlung über Tag und Nacht (Kramm et al.):

Dieser Ansatz ist zwar „etwas anders“ als (1), aber auch NICHT richtig. Denn er verletzt durch eine breitenabhängige globale Mittelung ebenfalls die die STRENGE PHYSIKALISCHE GLEICHZEITIGKEIT im Stefan-Boltzmann-Gesetz.

BEWEISFÜHRUNG (2.1): Eigenartig ist, dass Kramm et al (2017) hier mit einem dünnen „Multilayer“ als Modell für unseren „Wasserplaneten“ Erde arbeiten. Diese (begrenzte) Slab-Speicherung bewirkt nämlich lediglich eine leicht verzögerte Abstrahlung, die sich vordergründig allerdings erheblich auf die Ortstemperatur auswirkt, weil die ersten 2 W/m² im S-B-Gesetz bereits ein Temperaturäquivalent von ca. 70 Kelvin liefern.

Aber allein die in den OZEANEN gespeicherte Energie (=Arbeit=Leistung*Zeit) entspricht einer Abstrahlungsleistung unserer Erde von etwa 120 JAHREN bei (IN=OUT@NST). Ein konservativer Vergleich des Wärmeinhalts der Ozeane mit der täglichen und jährlich global eingestrahlten Sonnenenergie zeigt, dass deren Einfluss auf die globale Temperaturgenese nicht vernachlässigt werden darf:

(Tag = 1,05*10^22 Joule) << (Jahr = 3,85*10^24 Joule) << (Ozeane > 4,59*10^26 Joule)

Die Ozeane enthalten also ein Energieäquivalent von etwa 50.000 Tagen Sonneneinstrahlung oder 100.000-mal die notwendige Energie, um auf der Erde eine vergleichbare Nachtabkühlung wie auf dem Mond zu verhindern. Die Interaktion der Ortstemperatur mit den globalen Wärmespeichern Atmosphäre und Ozeanen ist ein wesentlicher Mechanismus in der Temperaturgenese auf unserer Erde, der bei Kramm et al. (2017) lediglich durch eine (begrenzte) Slab-Speicherung in Analogie zum Mond berücksichtigt wird.

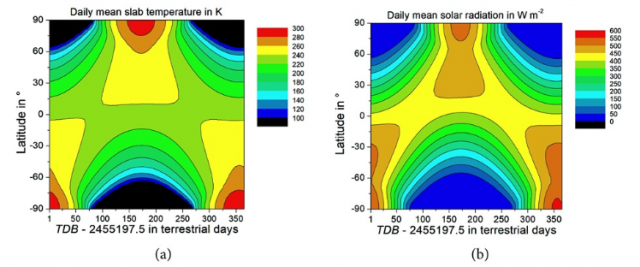

Zur Darstellung des Jahresverlaufs eines breitenabhängigen S-B-Temperaturäquivalentes: Kramm et al. (2017) stellen in Abbildung 22 den breitenabhängigen 24-Stunden-Durchschnitt der solaren Einstrahlung und dessen S-B-Temperaturäquivalent dar. Die Problematik einer solchen 24-stundendurchschnittlichen solaren Strahlungsleistung hatte ich in meinem EIKE-Artikel „Noch ein paar Fragen zum ‚natürlichen‘ atmosphärischen Treibhauseffekt“ vom 23. Juni 2017 anhand einer vergleichbaren Abbildung von Dennis L. Hartmann ausführlich erläutert; insbesondere lässt ein solcher Strahlungsdurchschnitt keinesfalls die Berechnung eines S-B-Temperaturäquivalentes zu. Der korrekte breitenabhängige Jahresverlauf des maximalen S-B-Temperaturäquivalentes ist weiter oben unter THESE (4) abgebildet und bestätigt die globale Klimaküche zwischen den Wendekreisen.

Es ist daher äußerst befremdlich, wenn Kramm et al. (2017) in Abbildung 22a aus einem solchen rechnerischen 24-Stunden-Strahlungsdurchschnitt ein S-B-Temperaturäquivalent ableiten, bei dem sich die globalen Temperatur- und Strahlungsmaxima wegen der Tageslängen im Polarsommer zwangsläufig auf der Polkalotte der jeweiligen Sommerhemisphäre konzentrieren. Die dermaßen fehlerhaft ermittelten Temperaturen liegen folglich im Jahresverlauf um den Äquator zwischen 220K und 240 K und steigen zum jeweiligen Pol der Sommerhemisphäre stark an. Grund dafür ist, dass die temperaturwirksame solare Einstrahlung zwischen den Wendekreisen im 24-Stunden-Durchschnitt praktisch halbiert wird, und sich in diesem Modell von Kramm et al. (2017) die globale „Klimaküche“ dadurch fälschlicherweise von der Äquatorzone zwischen den Wendekreisen auf den geographischen Pol der Sommerhemisphäre verschiebt.

BEWEISFÜHRUNG (2.2): Kramm et al. (2017) umschiffen die Problematik der terrestrischen Temperaturgenese, indem sie in ihrer Kernaussage (2.2) einfach die primäre Wirkungskette (Strahlungsflüsse = Ursache) und (lokale Temperaturen = Wirkung) umkehren. So kommen Kramm et al. (2017) schließlich zu dem Ergebnis, Zitat: „Based on our findings, we may conclude that the effective radiation temperature yields flawed results when used for quantifying the so-called atmospheric greenhouse effect.“ (S. 283 Ende vorletzter Absatz)

Der unparteiische Google-Übersetzer sagt: „Aufgrund unserer Ergebnisse können wir den Schluss ziehen, dass die effektive Strahlungstemperatur bei der Quantifizierung des sogenannten atmosphärischen Treibhauseffekts zu fehlerhaften Ergebnissen führt.“

Das Problem dieser Aussage ist wiederum, dass Kramm et al. gar nicht versucht hatten, den atmosphärischen Treibhauseffekt an einem realistischen Modell der Erde zu quantifizieren, sondern an ihrem nachweislich der BEWEISFÜHRUNG zu (2.1) unzureichenden „Multilayer“-Mond-Modell.

MEINE ARGUMENTATION zu THESE (3) – Globale Stefan-Boltzmann-Integration (Gerlich&Tscheuschner):

Der von Gerlich und Tscheuschner aufgezeigte Widerspruch (33°C # 144°C) ist analog zu dem gängigen „Faktor4“-Ansatz für einen „natürlichen atmosphärischen Treibhauseffekt“ innerhalb dieses Modells (1) korrekt abgeleitet worden.

Damit haben Gerlich&Tscheuschner den „natürlichen atmosphärischen Treibhauseffekt“ widerlegt.

Allerdings ist diese Widerlegung aus dem global gemittelten Modell (1) heraus erfolgt und daher kann dieses Ergebnis nicht auf die reale Erde angewendet werden. Denn lediglich die Tagseite der Erde (2PIR2) darf im Strahlungsgleichgewicht zwischen Sonne und Erde mit dem Stefan-Boltzmann-Gesetz betrachtet werden. Von daher hätte diese Lösung von Gerlich and Tscheuschner (2009) auf die Tagseite der Erde (2PIR2) beschränkt bleiben müssen.

BEWEISFÜHRUNG (3): Die physikalische Globaltemperatur Tphys von Gerlich and Tscheuschner (2009) beträgt -129 °C, respektive 144,15 K für die gesamte Erdoberfläche (4PIR2). Mit dem Stefan-Boltzmann-Gesetz darf aber lediglich die Tagseite der Erde (2PIR2) im Strahlungsgleichgewicht zwischen Sonne und Erde betrachtet werden. Von daher muss diese Lösung von Gerlich and Tscheuschner (2009) auf die Tagseite der Erde (2PIR2) reduziert werden.

Korrektur Weber für die Integrallösung von G&T: Lösung G&T * 4πR2 / 2πR2 = 2 * Lösung G&T

Folglich verdoppelt sich die Lösung von Gerlich and Tscheuschner für die physikalische Temperatur auf Tagseite der Erde zu

Tphys-korr = 288,3 °K oder 15,15 °C (Korrektur Weber für Lösung G&T)

und bestätigt damit wiederum meinen hemisphärischen Stefan-Boltzmann-Ansatz.

MEINE ARGUMENTATION zu THESE (4) – Hemisphärischer Stefan-Boltzmann-Ansatz (Weber):

Hier muss sich der interessierte Leser ein eigenes Urteil bilden, weil es sich um meinen eigenen hemisphärischen Stefan-Boltzmann-Ansatz handelt. Zwecks Arbeitsentlastung der EIKE-Redaktion finden Sie nachfolgend einige Kommentarvorschläge zum Ankreuzen:

O U. Weber, Fachrichtung Science Fictíon – unklar bleibt, warum EIKE einen derartigen Quark veröffentlicht!

O Alles was Sie hier schreiben ist völlig falsch, das hatte ich Ihnen schon vor 2 Jahren in meiner E-Mail nachgewiesen.

O Der „Geophysiker“ Weber verbreitet nun schon zum 14. Mal seinen Quatsch hier auf EIKE und hat den Faktor 4 immer noch nicht verstanden.

O Sie vergessen völlig, dass sich die Erde dreht. Und das so schnell, dass sich der größte Anteil der Erdoberfläche mit Überschallgeschwindigkeit nach Osten bewegt.

O Sie haben da einen Rechtschreibfehler in Ihrem Text. Wenn Sie einen so simplen Fehler machen, muss alles andere auch falsch sein.

O Zum fremdschämen, Herr Weber ist einfach nur peinlich.

O Die Anwendung des Stefan-Boltzmann-Gesetzes auf die Erde ist absurd.

O Was der Autor schreibt ist völliger Unsinn, ich habe das deshalb HIER mal einfach verständlich erklärt…

O Man kann doch nicht eine spezielle Situation der Anwendung des Stefan-Boltzmann Gesetzes herzuziehen, um die Physik der Erde umzukrempeln.

O Sie behaupten also, die Erde sei eine Scheibe und die Sonne scheint auch nachts.

Diese Liste bitte ausdrucken, einen passenden Kommentar ankreuzen, den Zettel zusammenknüllen und dann wegwerfen – Sie werden Sich danach sofort erleichtert fühlen. Die in diesem Beitrag zitierten Protagonisten dürfen selbstverständlich gleich mehrere Kommentare ankreuzen…

BEWEISFÜHRUNG (4): Ich darf an dieser Stelle zunächst nochmals darauf hinweisen, dass das mathematische Gleichheitszeichen im Stefan-Boltzmann-Gesetz die physikalische Randbedingung der GLEICHZEITIGKEIT impliziert.

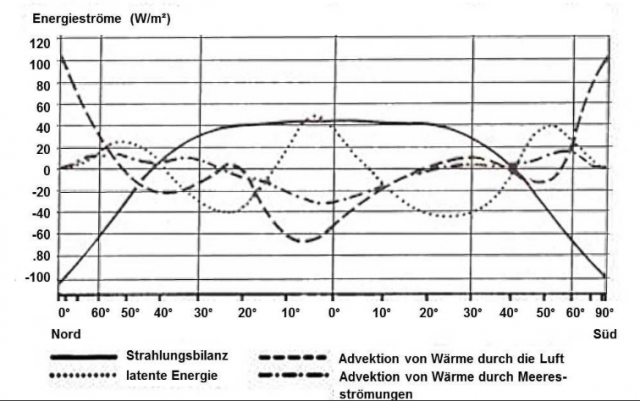

Ein weiteres Argument für meinen hemisphärischen S-B-Ansastz ist die nachfolgende Abbildung „Jahresmittel des Energiehaushaltes der Atmosphäre und seiner Komponenten in Abhängigkeit von der geographischen Breite“ nach Häckel, die das Jahresmittel der advektiven Energieströme auf unserer Erde zeigt:

Diese Abbildung zeigt auf Basis einer globalen Energieabstrahlung von 235 W/m² den im Jahresdurchschnitt von den globalen Zirkulationen aus den äquatorialen Regionen in mittlere und höhere geographische Breiten hinein verfrachteten Wärmestrom. Tatsächlich dürften diese Beträge im jeweiligen Winterhalbjahr der mittleren und höheren Breiten noch deutlich höher ausfallen als der Jahresdurchschnitt selbst. Da die Betrachtung der globalen Abstrahlung über die Umgebungsgleichung des Stefan-Boltzmann-Gesetzes in meinem hemisphärischen S-B-Ansatz ebenfalls auf einer durchschnittlichen globalen Abstrahlung von 235 W/m² beruht, reiht sich diese Abbildung von Häckel widerspruchslos in diese Argumentation ein.

Denn damit ist der Nachweis erbracht, dass die hemisphärisch ermittelten Einstrahlungsdefizite im jeweiligen Winterhalbjahr der mittleren und höheren Breiten aus dem horizontalen Wärmetransport der globalen Zirkulationen abgemildert werden.

In Teil 3 werden die Erkenntnisse zu den einzelnen Thesen/Antithesen und das Ergebnis dieser Analyse vorgestellt.

In der die Studie begleitenden Presseerklärung heißt es: „Hurrikane auf dem US-Festland werden größer, stärker und gefährlicher“ und dass die neue Studie „jedweder Zweifel beseitigt“.

Falls das stimmen sollte, würde die Studie (die ich hier mal nur als G19 bezeichnen möchte) Jahrzehnte lange Forschungen und Beobachtungen über den Haufen werfen, welche gezeigt haben, dass es keinen Aufwärtstrend im vorigen Jahrhundert gibt bzgl. der stärksten Stürme, die auf das Festland übertreten. Diese Schlussfolgerungen sind bestätigt worden durch die Zustandsberichte des IPCC, des U.S. National Climate Assessment und jüngst von der World Meteorological Organization.

Tatsächlich jedoch weist die PNAS-Studie massenhaft grobe Fehler auf. Die Schlussfolgerungen der grundlegenden wissenschaftlichen Forschungen bleiben gültig. Wie ich gleich zeigen werde, enthält G19 viele grundlegende Fehler und sollte infolgedessen zurückgezogen werden.

Das erste große Problem bei G19 ist, dass sich die Studie angeblich über so etwas wie klimatologische Trends bzgl. Hurrikane auslässt, aber tatsächlich werden keinerlei aktuelle Klimadaten dazu genannt. Das stimmt, stattdessen werden Daten bzgl. ökonomischer Verluste durch Hurrikane bemüht, um Schlussfolgerungen bzgl. Klimatrends zu ziehen. Die bemühten ökonomischen Daten in der Studie basieren auf Forschungen, welche ich selbst mit Kollegen seit über zwei Jahrzehnten durchgeführt habe. Daher bin ich befugt, die Fehler in G19 genau hervorzuheben. Man vergleiche die Anzahl von Hurrikanen in G19 mit der Anzahl von Hurrikanen in den Klimadaten der NOAA.

Von 1900 bis 1958, der ersten Hälfte des untersuchten Zeitraumes, listet die NOAA insgesamt 117 Hurrikane, welche auf das US-Festland übergetreten waren. Im Gegensatz dazu nennt G19 nur 92. Es sind also 25 davon einfach weggelassen worden. In der zweiten Hälfte des Datensatzes, also von 1959 bis 2017 zählte die NOAA 91 Hurrikane, G19 dagegen 155. Es wurden also einfach 64 Hurrikane dazu erfunden.

AP gab die falschen Informationen einfach weiter, hatte die Agentur doch berichtet, dass die neue Studie „247 Hurrikane untersucht, welche die USA seit dem Jahr 1900 betroffen haben“ (hier). Der NOAA zufolge wurden in Wirklichkeit jedoch nur 197 Hurrikane gezählt.

Zum Teil kann diese Differenz erklärt werden durch die Tatsache, dass sich G19 auf ökonomische Daten konzentriert und nicht auf Hurrikane. Falls nach einem Hurrikan zu Beginn des 20. Jahrhunderts keine Schäden bekannt geworden waren, dann hat ein solcher Hurrikan laut G29 gar nicht existiert. Das ist einer der Gründe, warum wir gerade nicht ökonomische Daten herangezogen hatten, um Schlussfolgerungen bzgl. Klima zu ziehen. Ein zweiter Grund für die Unstimmigkeiten ist, dass in G19 viele Hurrikane gezählt werden, die gar keine Hurrikane waren, und das unverhältnismäßig in der zweiten Hälfte des Datensatzes.

Das Missverhältnis der Zählung von Hurrikanen in G19 im Vergleich zur NOAA stellt bereits die ganze Studie in Frage. Aber es wird noch viel schlimmer.

Der von G19 benutzte Datensatz ökonomischer Verluste, aus welchem die Autoren ihre führenden Schlussfolgerungen ziehen, basiert auf meinen Forschungen. Jener Datensatz ist zusammen gestellt worden von einem Unternehmen namens ICAT mit Sitz in Colorado. Der ICAT-Datensatz wurde ursprünglich vor etwa einem Jahrzehnt von einem ehemalige Studenten und Mitarbeiter von mir Joel Gratz erstellt, welcher vollständig unseren Datensatz bzgl. Hurrikan-Verlusten aus dem Jahr 2008 zur Grundlage hat (den ich hier P08 nennen möchte).

Während der folgenden Jahre hat ICAT einige signifikante Änderungen am Datensatz vorgenommen. An erster Stelle ist dabei der Ersatz von Verlust-Schätzungen in P08 durch Verlust-Schätzungen aus der „Milliarden-Dollar-Katastrophen“-Tabelle des NOAA National Centers for Environmental Information (NCEI). Die Ersatzdaten beginnen im Jahre 1980 zu Beginn des NCEI-Datensatzes.

Dieses Verfahren erzeugte einen neuen Hybrid-Datensatz, wobei der ICAT-Datensatz von 1900 bis 1980 auf P08 basiert und von 1980 bis 2018 auf NCEI. Dies ist extrem problematisch für G19, weil man sich offensichtlich dieser Details des online gefundenen Datensatzes nicht bewusst war.

In unserer im vorigen Jahr veröffentlichten umfassenden Aktualisierung von P08 (Weinkle et al. 2018, oder W18) erklärten wir, dass in das NCEI-Verfahren zur Berechnung von Verlusten viele Faktoren eingegangen waren, die historisch gar nicht in den Auflistungen des U.S. National Hurricane Center enthalten waren, Z. B. „Katastrophenhilfen der öffentlichen Hand, Versicherungs-Auszahlungen, nationale und internationale landwirtschaftliche Beeinträchtigungen sowie andere makro-ökonomische Auswirkungen“.

Das bedeutete, dass man nicht, wie ICAT es getan hat, einfach den NCEI-Datensatz ab 1980 an den P08-Datensatz mit Beginn im Jahre 1900 anhängen kann. Man vergleicht nicht Äpfel mit Äpfeln. Tatsächlich machte ein Großteil unserer Arbeit bei der W18-Aktualsierung von P08 aus sicherzustellen, dass die Daten wirklich Äpfel mit Äpfeln über den gesamten Datensatz waren. Dazu haben wir viele statistische Konsistenz-Checks durchgeführt, um ganz sicher zu sein.

Die neue PNAS-Studie G19 benutzt unwissentlich den ICAT-Datensatz, welcher P08 und NCEI zusammen schustert. Auf Twitter habe ich mit vielen Graphiken belegt, warum das wichtig ist: Vor 1940 sind die Verlust-Schätzungen von G19 und W18 für individuelle Stürme in etwa identisch (hier). Nach dem Jahr 1980 jedoch sind die G19-Verlust-Schätzungen für individuelle Stürme um etwa 33% höher als die von W18. Das Ergebnis ist eine Daten-Inkonsistenz, welche falsche Trends in den Datensatz einbringt.

Der gesamte Artikel steht hier.

Link: https://wattsupwiththat.com/2019/11/16/no-hurricanes-are-not-bigger-stronger-and-more-dangerous/

Übersetzt von Chris Frey EIKE

„Ein Footballfeld stürmen, um gegen den Klimawandel zu protestieren, weil das Sinn macht, oder? Falsch“, begann Mrs. Lahren in ihrer Fox Nation- Show „Final Thoughts“.

Als die Teams der Ivy League am Samstag zum 136. Mal gegeneinander antraten, stürmten Demonstranten das Feld, um zur Halbzeit einen Klimaprotest zu veranstalten.

Einige hatten Banner dabei, auf denen stand, dass sich die Ivy League-Schulen von [den Subventionen] der fossilen Brennstoffindustrie trennen sollten. Andere schwenkten Tafeln, die Probleme aufwarfen, wie zum Beispiel die puertoricanischen Schulden und die Behandlung der Uiguren in China.

Zunächst standen die Sicherheitsleute in gelben Westen neben den Sitzenden, griffen aber nicht ein. Als die 15-minütige Halbzeit abgelaufen war und der Protest fortgesetzt wurde, strömten weitere Demonstranten auf das Spielfeld.

Der Vorfall dauerte über eine Stunde, bevor die Polizei einige der Demonstranten vom Spielfeld drängen konnte. Schätzungen zufolge wurden 42 weitere Personen festgenommen und wegen „~ Störung der öffentlichen Ordnung“ (..with disorderly conduct ) angezeigt.

In ihrer Empörung über die „Klimawandel-Heulsusen“, stellte die Moderatorin Lahren das Motiv für deren letzten Stunt auf dem Spielfeld in Frage.:

„Anscheinend hielten die Organisatoren ihren Protest für einen Erfolg.

Nun, vielleicht bin ich nicht ‚klimaerweckt‘ genug, um es zu erkennen, aber könnte mir bitte jemand erklären, wenn jemand in der Halbzeit auf ein Spielfeld läuft und sich dann weigert, das Feld zu verlassen, wodurch das Spiel für zivilisierte Spieler, Fans und Zuschauer gestört und verzögert wird – ist damit irgendetwas getan, um unserer Erde zu helfen?

Übrigens„, fuhr sie fort, „das einzige“ Bewusstsein „, das Sie geweckt haben, Ihre epische Unreife für alle sichtbar zu machen.“

Später im Podcast auf Fox Nation hob Frau Lahren die unterschiedlichen Motive zwischen den Klimaprotestierenden und denen in Hongkong hervor, die derzeit „ihr Leben für Freiheit, Demokratie und Menschenrechte riskieren. Dort ist das ein Protest, der für etwas steht, das größer ist als die Protestierenden selbst. Das ist tapfer und wagemutig und bewundernswert.“

„Von einem Haufen weinerlicher Ivy League-College-Studenten, die ein College-Football-Spiel stören, kann man so etwas nicht sagen“.

Lahren fuhr fort in ihrer Kritik an den Klimawandel- Protestierenden und sagte, diese lösen „keine Probleme“ und verwahrte sich gegen mögliche Anschuldigungen, dass sie sich nicht für das Thema interessiere:

„Keine einzige dieser traurigen Heuchler eines Demonstranten hat irgendetwas getan, um der tatsächlichen Umwelt zu helfen, und ehrlich gesagt glaube ich nicht, dass diese traurigen Vorspiegelungen für ‚Aktivisten‘ wirklich wichtig sind“.

„Sie ziehen umher und handeln wie Idioten im Namen des Klimawandels, um Aufmerksamkeit zu erregen und das Gefühl zu haben, etwas getan zu haben, während sie in Wirklichkeit nichts getan und keine Probleme gelöst haben. Unter lautem Krakelen haben sie nur Probleme geschaffen.“

„Und fürs Protokoll“, fuhr sie fort, „wenn Leute wie ich diese wütend vorgetragenen Anfälle wegen des Klimawandels kritisieren, dann nicht, weil wir die Erde hassen und wollen, dass sie zerstört wird. Wir haben es satt, Heulsusen zu haben, zu deren einzigen Lösungen das Schreien gehört, schreien und eine Szene machen. „

Stattdessen schlug Frau Lahren den Demonstranten vor, „etwas Produktives zu tun“. Sie halte es ausserdem für unwahrscheinlich, dass sie für ihre disruptiven Proteste die Aufmerksamkeit der Medien erhalten, die sie haben möchten.

— Tomi Lahren, Fox Nation host findet starke Worte:

„Gehen Sie den Müll an einem Strand aufräumen oder an einer Autobahn oder erfinden Sie saubere Technologien für den freien Markt und den Kapitalismus. Das kann ich respektieren. Da kann ich sogar dahinter stehen … aber ihre Aktivitäten erhalten nicht die Aufmerksamkeit, wonach sich die narzisstischen Baum- Umarmer wirklich sehnen“.

„Was für ein Hohn von Aktivismus“, schloss Lahren. „Auch für 2019 Standards.“

Gefunden auf

https://www.foxnews.com/media/tomi-lahren-climate-protesters-harvard-yale-football

***

Vielleicht sind die Jugendlichen vom amerikanischen Wahlkampf beeinflusst?

Bernie Sanders, Demokratischer Senator von Vermont, setzt zum Gewinnen auf Klimaangst. Er drückte gerade den Schnellvorlaufknopf auf Ocasio-Cortez ‚Weltuntergangsuhr“ [Green New Deal, nur noch 12 Jahre …]. Er beschwört jetzt, dass wir nur noch „8 oder 9 Jahre“ übrig haben, bevor die Städte unter Wasser stehen und Hunderte Millionen Klimaflüchtlinge die nationale Sicherheit destabilisieren.

Hier das Video auf Twitter, dauert nur wenige Sekunden: „Notfall, Notfall …Wir haben nicht mehr eine Dekade lang Zeit, wir haben sie nicht. …“

Antwort: „Das haben wir schon vor dreißig Jahren gehört, es sollte uns schon gar nicht mehr geben, heutzutage, hier sind wir“

Dabei ging es u.a. um den weiteren Ausbau der Windindustrie. Wer in die Sendungen reingehört und -gesehen hat, dem kommen allerdings berechtigte Zweifel, ob Expert(inn)en immer das halten, was sie versprechen. Denn irritiert muss man zur Kenntnis nehmen: physikalisch-technische Unbedarftheit, argumentativer Pfusch, unbelegte Verschwörungstheorien.

Im WDR5 Tagesgespräch behauptet Kemfert, die große Mehrheit der Bevölkerung habe kein Problem mit Windenergieanlagen. Und die wenigen kritischen Bürgerinitiativen würden teilweise von den fossilen Industrien bezahlt. Belege: Fehlanzeige! Damit werden nicht nur grundlegende wissenschaftliche Standards (belastbare Nachweise anstelle von bloßen Behauptungen) missachtet. Vielmehr werden zugleich auch die vielen Bürgerinitiativen verunglimpft, die sich ehrenamtlich für den Erhalt von Lebensqualität auch in Windindustriegebieten einsetzen.

Expert(inn)en sind gehalten, wissenschaftliche Befunde sorgfältig zu recherchieren und gegeneinander abzuwägen, um diese dann in einem nachprüfbaren und überzeugenden argumentativen Zusammenhang der Öffentlichkeit vorzutragen. Und gerade bei der kontroversen Debatte um die Energiewende ist zu konstatieren, dass ein „alternativloses“ Argumentieren nicht angebracht ist. Kemfert ist ein abwägendes Argumentieren jedoch völlig fremd. Es gilt ausschließlich ihre eigene Meinung. Abweichende Positionen sind uninteressant, weil Kemfert selbst alles besser weiß. Angeblich!

Das dürfte damit zusammenhängen, dass der physikalisch- technische Horizont von Kemfert ganz offensichtlich begrenzt ist und/oder allgemein Bekanntes von ihr nicht zur Kenntnis genommen wird, weil es zu den eigenen Vorstellungen nicht passen will. Die Beispiele ließen sich mehren:

Bei Anne Will macht sich Kemfert über die Begriffe „Geisterstrom“ und „Dunkelflaute“ lustig, von denen sie noch nie etwas gehört habe. Allerdings:

„Geisterstrom“ wird bereits seit 2015 in den Medien thematisiert. Es ist der Strom, der überwiegend durch Windkraft aufgrund mangelnder Nachfrage oder technischer Gegebenheiten nicht erzeugt werden kann, aber trotzdem per Gesetz den Betreibern mit 90 % vergütet wird.

Der Begriff „Dunkelflaute“ ist überall in den Medien präsent. Er bezeichnet die Stunden und Tage an denen die Sonne nicht scheint und der Wind nicht weht. Als vielbeschäftigte Politikberaterin und angebliche Energieexpertin sollte sie die Publikation des Wissenschaftlichen Dienstes des Deutschen Bundestages zur Dunkelflaute kennen.

Die volatile Stromerzeugung aus Sonne und Wind kann einen Industriestaat ohne Speicher- technologien nicht versorgen. Dieses volatile Stromangebot wird durch die konventionellen Kraftwerke in Echtzeit ausgeglichen, wie jedermann auf der Homepage der Leipziger Strombörse (aufgrund gesetzlicher Veröffentlichungspflicht) nachsehen kann. Dies sichert die Versorgung Deutschlands. Kemfert aber spricht davon, dass Kohlestrom die Leitungen verstopfe. Das ist kein Expertenniveau, sondern Framing im übelsten Sinn.

Bürgerinnen und Bürger dürfen für ihre Gebühren von den öffentlichen Medien erwarten, dass sie Fakten und Informationen liefern, ergänzt durch argumentativ fundierte Kommentare. Das gilt auch für einen informativen Meinungsaustausch in Talkrunden. Gerne verzichten sie auf Expert(inn)en, die bloß ihren eigenen beschränkten und ideologisch eingefärbten Kenntnisstand als wissenschaftlich fundierte Ein- und Weitsicht verkaufen.

Prof. Dr. Jürgen Baur Dipl.-Ing. Udo Mügge

33100 Paderborn-Dahl

Der offene Brief erschien zuerst bei Vernunftkraft Odenwald hier

Für einen solchen „natürlichen atmosphärischen Treibhauseffekt“ gibt es unterschiedliche Modelle, einen experimentellen Ansatz und zwei Widerlegungen. Nachfolgend werden die wesentlichen THE-Thesen/Antithesen vorgestellt; Nischentheorien werden hier nicht berücksichtigt.

THESE (1): Der konventionelle globale Stefan-Boltzmann-Ansatz mit einem „natürlichen atmosphärischen Treibhauseffekt“ von 33°C, der als Differenz zwischen einer vorgeblich „natürlichen“ theoretischen Temperatur unserer Erde von -18°C aus der der globalen Strahlungsbilanz und einer vorgeblich „gemessenen Globaltemperatur“ NST von 14,8°C abgeleitet wird.

These(1.1): Die Erde wird als ein selbstleuchtender Stern betrachtet. Dazu wird der temperaturwirksame Anteil der Solarstrahlung über die gesamte Erdoberfläche gemittelt und mittels Stefan-Boltzmann-Gesetz eine Art „Abstrahlungstemperatur“ für die Erde umgerechnet. Der „natürliche atmosphärische Treibhauseffekt“ erklärt sich dann als Differenz zur vorgeblich „gemessenen Globaltemperatur“ NST.

Vertreter: IPCC-TAR-Gutachter Dipl.-Ing Peter Dietze

Referenz zu (1.1): Kommentar P. Dietze vom 5. August 2019 um 9:54 auf EIKE

Kernaussage (1.1), Zitat aus der Referenz mit Hervorhebungen: „Herr Schulz, der Geometriefaktor der (rotierenden, gut speichernden und Wärme umverteilenden) Erdkugel ist 4. Wie auch Herr Weber angibt, erhält die Erde 4PiR²*235 W/m2 an mittlerer Einstrahlung. Da 1 W ein Joule/s ist, können Sie Ihre Zahl mit dem Erdradius leicht selbst ausrechnen. Wenn man 235 W/m² in Stefan-Boltzmann einsetzt, ergeben sich knapp 255 K. Die mittlere Bodentemperatur ist aber um 33 K höher – und das ist der Treibhauseffekt, den Herr Weber hinweg zu schummeln versucht.“

Herr Dietze hatte seine Berechnungen in einer E-Mail vom 06.09.2019 um 11:01pm an Dr. Kramm auf dem üblichen Skeptiker-Verteiler noch weiter spezifiziert, Zitat mit Hervorhebungen:

„Die S-B-Gleichung für den Treibhauseffekt lautet für das quasi isotherme Strahlungsmodell der rotierenden Erde mit 30% Wolkenalbedo und ansonsten solar transparenter Atmosphäre im Strahlungsfliessgleichgewicht mit

S=absorbierter Solarstrahlung, im Mittel 240 W/m²

T=solar bedingter Bodentemperatur, im Mittel 255K

G=Gegenstrahlung 150 W/m²

==> S+G = Sigma*(T+deltaT)^4

Daraus ergibt sich deltaT=33 K und somit die Bodentemperatur zu T=288 K (+15 Grad) wie beobachtet. Q.e.d.“

These (1.2): Die Klimawirksamkeit von Treibhausgasen

These (1.2.1): Der „natürliche atmosphärische Treibhauseffekt“ beim konventionellen S-B-Ansatz wird durch Treibhausgase erzeugt.

Vertreter: Der Geophysiker Michael Krüger (ScienceScepticalBlog)

Referenz zu (1.2.1): „Grundlagen des Treibhauseffektes für EIKIANER“ (2016)

Kernaussage (1.2.1), Zitat aus der Referenz mit Hervorhebungen: „Die Erdoberfläche strahlt Wärme mit durchschnittlich 390 Watt pro Quadratmeter ab. Das entspricht der Wärmeabstrahlung eines sog. Schwarzen Körpers bei 15°C. In 70 km Höhe strahlt die Erde nach Absorption durch Treibhausgase und Wolken innerhalb der Atmosphäre nur noch Wärme mit durchschnittlich 240 Watt pro Quadratmeter ab. Das entspricht der Wärmeabstrahlung eines sog. Schwarzen Körpers bei -18°C. Die Differenz zwischen Boden und 70 km beträgt 150 Watt pro Quadratmeter und 33°C. Das ist die sog. Differenz für den natürlichen Treibhauseffekt.“

Und weiter unten heißt es dort, Zitat mit Hervorhebungen: „Sog. Treibhausgase wie CO2 und Wasserdampf und auch Wolken führen durch ihre Absorptions- und Strahlungseigenschaften von Wärmestrahlung dazu, dass wir eine Differenz von ca. 33°C zwischen Erdoberfläche und 70 km Höhe messen.“

These (1.2.2): Der „natürlichen atmosphärische Treibhauseffekt“ durch Treibhausgase konnte experimentell nachgewiesen werden.

Vertreter: Herr Dr. Michael Schnell (EIKE)

Referenz zu (1.2.2): „Experimentelle Verifikation des Treibhauseffektes – 4. Mitteilung: die erdnahe CO2-Strahlung“ (2019)

Kernaussage (1.2.2-1), Zitat aus der Referenz mit Hervorhebungen:

„Anfang des 19. Jahrhunderts suchten verschiedene Forschergruppen einen mathematischen Zusammenhang zwischen Temperatur und IR-Strahlung eines Körpers. Unter anderen Dulong und Petit, die die Abkühlung eines heißen Thermometers (200 – 300 °C) in einem kalten Vakuumgefäß verfolgten (Abb. 3) [9]. Sie entwickelten eine einfache Formel, die hinreichend genau die zeitliche Abkühlung des Thermometers wiedergab. Die Gleichung versagte jedoch, wenn wesentlich heißere Körper, wie die der Sonne, berechnet werden sollten.

Josef Stefan überprüfte die Versuche von Dulong und Petit und anderer Forschergruppen und konnte rein empirisch Gl. 1 ermitteln, womit die Wärmeübertragung P paralleler Oberflächen, auch bei sehr hohen Temperaturen, berechnet werden konnte [8]. Stefan brauchte den sogenannten Strahlungsaustauschgrad „E“ für blanke, also reflektierende Oberflächen (Emissionsgrad ε << 1). Geht man aber von einer Schwarz-Körper-Strahlung mit ε = 1 aus, wird auch E = 1 und wir haben mit Gleichung Gl. 2 den Vorläufer des Stefan-Boltzmann-Gesetzes (Gl. 3) vor uns, das von Ludwig Boltzmann 1884, einem Schüler von Stefan, theoretisch abgeleitet wurde [10].

Mit Gl. 2 legt Stefan die Grundlage für die Berechnung des Treibhauseffektes. Die Abkühlung des Thermometers (Energieverlust) hängt sowohl von der Temperatur T1 als auch von T2 ab, also von der Differenz zwischen Ausstrahlung des Thermometers und Gegenstrahlung der Kupferwand.“

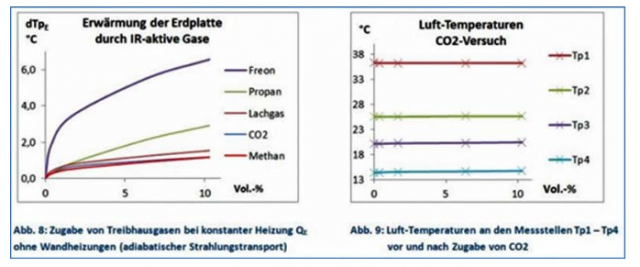

Kernaussage (1.2.2-2), Zitat aus der Referenz mit Hervorhebungen: „… In einem bereits publizierten Demonstrations-Experiment [12], [11] wurden unter adiabatischen Bedingungen (ohne Wandheizung) die Auswirkungen von CO2 (und anderen Treibhausgasen) untersucht. Dabei wurde eine deutliche Erwärmung der Erd-Platte beobachtet, während innerhalb der Röhre, an den Messstellen Tp1 – Tp4, die Temperaturen konstant blieben (Abb. 8 und 9)…“

These (1.3): Gegenüber einer variablen „gemessenen Globaltemperatur“ verändert sich die „Abstrahlungstemperatur“ der Erde nicht. Vielmehr beträgt die Abstrahlungsleistung der Erde beim konventionellen S-B-Ansatz immer 239 W/m². Bei einer Veränderung der Globaltemperatur NST verändert sich lediglich die „Abstrahlungshöhe“ bei -18°C.

Vertreter: Der Astrophysiker Dr. Peter Heller (ScienceScepticalBlog)

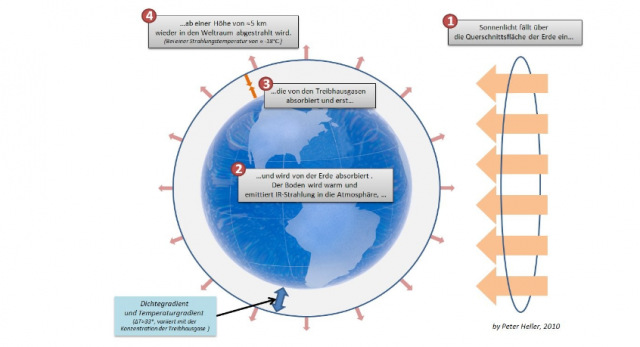

Referenz: „Der Treibhauseffekt“ (2010)

Kernaussage (1.3), Zitat aus der Referenz mit Hervorhebungen: „Der Ansatz der Klimaforschung wird nun deutlich: Wenn man die Menge an Treibhausgasen in der Troposphäre steigert, erhöht sich die „Grenzschicht“, ab der die Atmosphäre für IR-Strahlung durchsichtig wird. Die Temperatur dieser „Grenzschicht“ ist aber immer -18° (aufgrund des oben angenommenen Strahlungsgleichgewichtes). Liegt sie nur 100 Meter höher, steigt dadurch die Temperatur der Luft am Erdboden um im Mittel 0,65° (es liegen dann eben nicht mehr 5 km Luft zwischen dieser Schicht und dem Erdboden, sondern 5,1 km).“

THESE (2): Ein globales Modell analog zum konventionellen S-B-Ansatz mit einem global breitenabhängig gemittelten Strahlungsansatz und einem begrenzten thermischen „Slab“-Zwischenspeicher.

Vertreter: Kramm et al. (2017)

Referenz (2): “Using Earth’s Moon as a Testbed for Quantifying the Effect of the Terrestrial Atmosphere”

Kernaussage (2.1): Zitat aus Kramm et al. (2017) mit Hervorhebungen: “The results of our numerical simulations using the multilayer-force-restore method for the 27.4 times higher angular velocity of the Earth are illustrated in Figure 22. Part (a) of this figure shows the daily mean slab temperature as a function of latitude and terrestrial day of the year.” (S. 281 3. Absatz)

Dazu der unabhängige Google-Übersetzer (mit Korrektur): „Die Ergebnisse unserer numerischen Simulationen unter Verwendung der Multilayer-Force-Restore-Methode für die 27,4-fach höhere Winkelgeschwindigkeit der Erde sind in Abbildung 22 dargestellt. Teil (a) dieser Abbildung zeigt die tägliche mittlere Plattentemperatur als Funktion von Breite und Breite Erdtag des Jahres.“

Kernaussage (2.2): Zitat Kramm et al. (2017) mit Hervorhebungen: “Thus, one has to conclude that concept of the effective radiation temperature oversimplifies the physical processes as it ignores the impact of local temperatures on the fluxes in the planetary radiative balance.” (S. 283 letzter Absatz, letzter Satz)

Dazu der unabhängige Google-Übersetzer: „Daher muss man schließen, dass das Konzept der effektiven Strahlungstemperatur die physikalischen Prozesse zu stark vereinfacht, da der Einfluss lokaler Temperaturen auf die Flüsse im Strahlungshaushalt des Planeten ignoriert wird.“

THESE (3): Eine „globale“ Stefan-Boltzmann-Integration, die in einem Widerspruch mit dem Betrag des „natürlichen atmosphärischen Treibhauseffektes“ von 33°C aus Modell (1) endet.

Vertreter: Prof. Dr. Gerlich (†) und Dr. Ralf D. Tscheuschner, Hamburg

Referenz (3) „Falsifizierung der atmosphärischen CO2 -Treibhauseffekte im Rahmen der Physik“

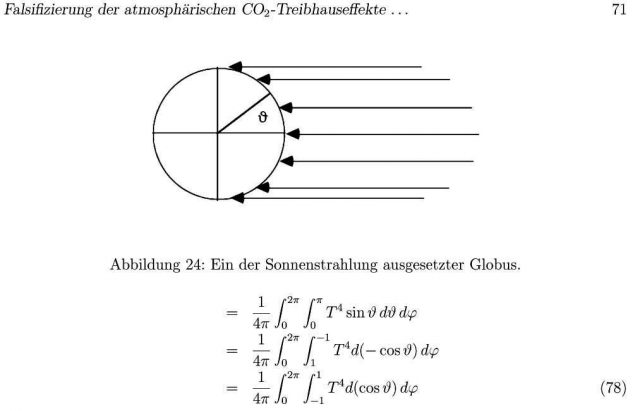

Kernaussage: Gerlich and Tscheuschner (2009) leiten eine Stefan-Boltzmann-Integrallösung für die Durchschnittstemperatur der gesamten Erdoberfläche (4PIR2) her:

Diese berechnete physikalische Globaltemperatur Tphys beträgt -129 °C, respektive 144,15 K für die gesamte Erdoberfläche (4PIR2) und würde daher zur Erklärung der vorgeblich „gemessenen“ globalen Durchschnittstemperatur einen Treibhauseffekt von weiteren 144 °C erfordern. Aus dem Widerspruch (33°C # 144°C) leiten Gerlich und Tscheuschner ab, dass es keinen „natürlichen atmosphärischen Treibhauseffekt“ gibt.

THESE (4): Ein „hemisphärischer“ Stefan-Boltzmann-Ansatz ohne einen atmosphärischen Treibhauseffekt, bei dem die (hemisphärische) Temperaturgenese nach dem S-B-Gesetz auf die Tagseite der Erde beschränkt bleibt, während die Abstrahlung der gesamten Erdoberfläche über dessen Umgebungsgleichung erfolgt.

Vertreter: Uli Weber (DGG und EIKE)

Referenz (4) „Weitere Überlegungen zur hemisphärischen Herleitung einer globalen Durchschnittstemperatur“ @ DGG-Mitteilungen 1/2019:18-25

Anmerkung: Hier wird ein Zweischichtfall für Erde-Atmosphäre mit Seff = 780 W/m² dargestellt, während ich in meinen Blogartikeln einen Einschichtfall mit Seff = 940 W/m² betrachte.

Kernaussage (4): Die Temperaturgenese erfolgt ausschließlich auf der sonnenbeschienenen Tagseite unserer Erde. Zwischen den Wendekreisen und bis in die mittleren Breiten der Sommerhemisphäre werden gleichzeitig die „Energiespeicher“ unserer Erde (Atmosphäre und Ozeane) durch die Sonneneinstrahlung aufgeladen und damit das maximale S-B-Temperaturäquivalent nicht erreicht. Die Nachtseite im Tagesverlauf und die höheren Breiten im Jahresverlauf, insbesondere auf der Winterhemisphäre, profitieren durch Wärmeadvektion von den dort erwärmten globalen Zirkulationen über die S-B-Umgebungsgleichung.

Um es noch einmal ganz deutlich zu machen: Nur in Ausnahmefällen (hocharide Wüstengebiete in niederen Breiten) wird das rechnerische S-B-Temperaturäquivalent (SBT) auf der Tagseite der Erde erreicht. Die Energiedifferenz zwischen dem SBT und der tatsächlichen Ortstemperatur in [W*s=J] fließt üblicherweise in die globalen Zirkulationen (Atmosphäre und Ozeane) – respektive wird die Ortstemperatur nachts und im Winterhalbjahr daraus unterstützt.

In Teil 2 werden die hier vorgestellten Thesen/Antithesen dann ausführlich diskutiert.

Es wäre interessant zu erfahren, welche Prognosen hierzu unsere derzeit besonders aktiven Katastrophen-Propheten des IPCC und die vieler Umweltverbände für das Jahr 2050 und nachfolgend vorsehen. Konnte der Planet tatsächlich gerettet werden mit den CO2-Einsparungen, und gibt es eine ausreichende und gesicherte Energieversorgung, die eine absolute Voraussetzung für ein funktionierendes und sich weiterentwickelndes modernes Gesellschaftssystem darstellt, oder haben sich die Industriestaaten bis dahin verabschiedet und selber zerstört (nach Habeck: der Kampf der Ökonomie gegen die Natur)?

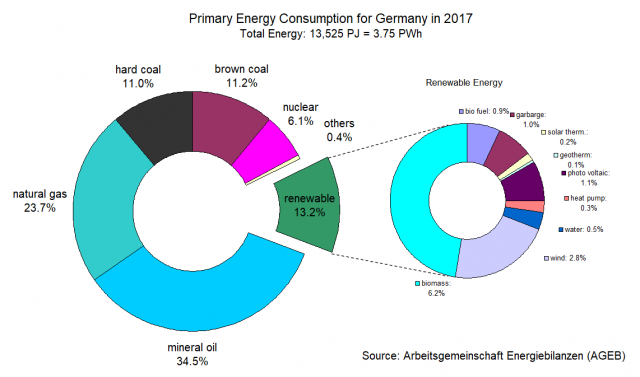

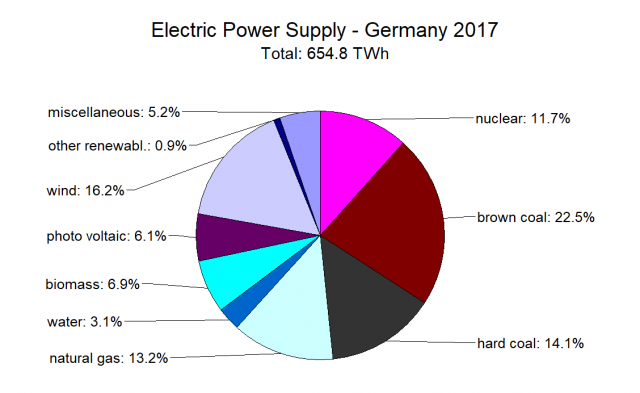

Nach der Talkshow von Anne Willam 17. November habe ich mich kurzfristig entschieden, diesen Artikel zu schreiben, der im Wesentlichen eine Übersetzung einiger Ausführungen auf meiner Homepage ist. In der Talkshow wurde nämlich wieder einmal das Thema Erneuerbare Energien wie in hunderten ähnlicher Runden andiskutiert, und alle anwesenden Politiker (Markus Söder, Annelena Baerbock und Christian Lindner) betonten einhellig die Notwendigkeit eines beschleunigten Ausstiegs aus den fossilen Brennstoffen. Aber leider ging keiner der Anwesenden, auch nicht die so-genannte Energie-, Verkehrs- und Umweltexpertin Claudia Kemfert vom Deutschen Institut für Wirtschaftsforschung auf die Frage ein, woher die ausreichende Energie kommen soll, wenn alle konventionellen Kraftwerke abgeschaltet werden. Den bei weitem größten Sachverstand konnte man immerhin Christian Lindner zubilligen, der sich auch mit Geisterstrom (Flatterstrom) und Dunkelflauten auskannte.

In 2018 veröffentlichte das IntergovernmentalPanel on Climate Change (IPCC– Welt-Klimarat) einen „Sonderbericht zu den möglichen Auswirkungen einer globalen Erwärmung von 1,5°C über dem vorindustriellen Niveau sowie zu hiermit verbundenen Emissionsverläufen von Treibhausgasen“. Dieser Bericht ist eine Fortsetzung früherer Sachstandsberichte, der ‚Assessment Reports‘, der neben vielen alarmistischen Übertreibungen auch Modifikationen der so-genannten Repräsentativen Konzentrationsverläufe (Representative ConcentrationPathways – RCPs) enthält, die vorgeben sollen, wie mit einer reduzierten Emissionen von CO2eine globale Erwärmung von nicht mehr als 1,5°C über das 21ste Jahrhundert erreicht werden könne. Ein maximaler Temperaturanstieg von 2°C, besser nur 1,5°C, war von den Mitgliedern der United Nations Framework Convention on Climate Change (UNFCCC – UN-Klimarahmenkonvention) auf der 21sten Conference of Parties (COP 21) beschlossen worden.

Dieser Beschluss ist bekannt als das Paris-Abkommen vom Dezember 2015 und wird verstanden als Nachfolge-Vereinbarung des Kyoto-Protokolls von 1997.