Inzwischen gibt es viele selbsternannte Klimaexperten. Sie brauchen keinen Abschluss in Physik oder Atmosphärenwissenschaften. Für Anmeldeinformationen müssen sie nur anderen mitteilen, dass sie sich darum kümmern. Sie glauben daran, dass die Erde von Menschen zerstört wird und wollen, dass die Medien das Wort „der Klimakirche“ verbreiten.

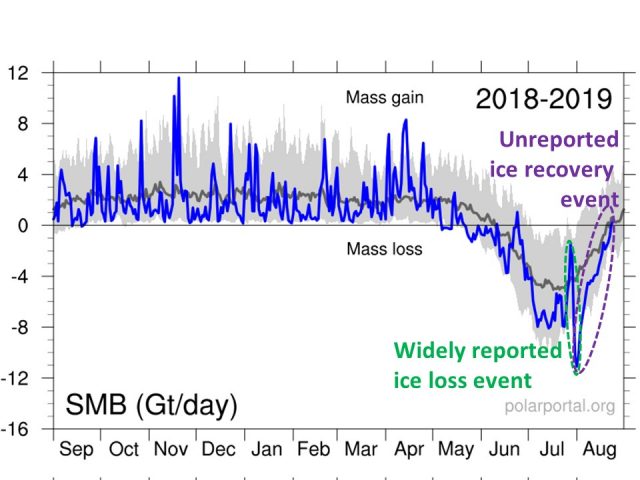

Die meisten Menschen haben leider weder die Zeit noch den Bildungshintergrund, um die Hintergründe und Debatten über die globale Erwärmung zu verstehen und verlassen sich daher auf „den Konsens der Experten“. Sie erkennen auch das Problem nicht, dass ihnen niemand genau sagt, worauf sich die Experten eigentlich einigen.

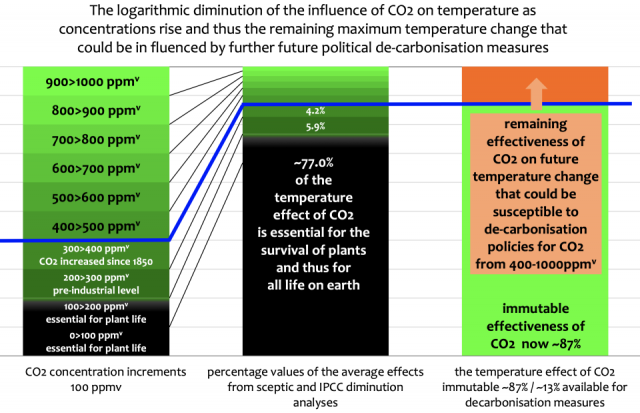

Wenn Sie sich mit den Details befassen, ist es eher nicht weiter bemerkenswert, worauf sich die Experten in ihren offiziellen Erklärungen einigen. Die Erde hat sich seit den 1950er Jahren etwas erwärmt, ein Datum, das gewählt wurde, weil die Menschen zuvor nicht genug CO2 produziert hatten, damit es wirklich eine Rolle spielt. Nicht genug Erwärmung für die meisten Menschen, um es tatsächlich zu fühlen, aber genug für Thermometer, um eventuell ein Signal aufzunehmen, das im Rauschen natürlicher Wetterschwankungen von vielen Dutzend Grad und unechter Erwärmung aufgrund von Urban-Heat-Effekts vergraben ist. Der UN-Konsens ist, dass der größte Teil dieser Erwärmung wahrscheinlich auf die Zunahme des atmosphärischen CO2 durch den Einsatz fossiler Brennstoffe zurückzuführen ist (aber keiner weiß es wirklich genau).

Im Moment stimme ich diesem Konsens eher zu.

Und trotzdem werde ich allgemein als Klimaleugner betrachtet.

Warum? Weil ich nicht bereit bin zu übertreiben und Behauptungen aufzustellen, die nicht durch Daten gestützt werden können.

Nehmen Sie den Forscher Roger Pielke Jr. als ein weiteres Beispiel. Roger sieht sich als Umweltschützer. Er stimmt im Allgemeinen den Vorhersagen des IPCC in Bezug auf die zukünftige Erwärmung zu. Als Experte für Unwetterschäden ist er jedoch nicht bereit, die Lüge zu vertreten, dass sich das Unwetter verschlimmert hat. Ja, die Sturmschäden haben zugenommen, aber das liegt daran, dass wir immer mehr Infrastruktur bauen, die Schaden nehmen kann.

Auch er gilt damit als Klimaleugner.

Was von den Medien über die globale Erwärmung (auch bekannt als Klimawandel, Klimakrise und jetzt Klimanotfall) berichtet wird, ist normalerweise stark übertrieben, sind Halbwahrheiten oder schlicht Unsinn. Genau wie in der Wirtschaft und in den Wirtschaftswissenschaftler ist es nicht schwierig, einen „Experten“ zu finden, der bereit ist, eine Prognose über das Schicksal und die Finsternis abzugeben. Das macht interessante Nachrichten. Aber es verzerrt die öffentliche Wahrnehmung der Gefahren des Klimawandels. Und weil es als „Wissenschaft“ bezeichnet wird, wird es mit der Wahrheit gleichgesetzt.

Im Falle von Nachrichten über den Klimawandel sind die vorhergesagten Auswirkungen fast allgemein auf Armageddon ähnliche Ergebnisse ausgerichtet. Unwetterereignisse, die immer aufgetreten sind (Tornados, Hurrikane, Überschwemmungen, Dürreperioden), werden jetzt gemeldet, und zumindest Ihr SUV wird ein wenig dafür verantwortlich gemacht.

Die großen Medien sind so sehr von der Gerechtigkeit, Rechtschaffenheit und Wahrhaftigkeit ihrer Sache überzeugt, dass sie sich zusammengetan haben, um sicherzustellen, dass der Klimanotfall nicht ignoriert wird. The Guardian berichtet: „Mehr als 60 Nachrichtenagenturen weltweit haben Covering Climate Now unterzeichnet, ein Projekt um die (~)Behandlung des Notfalls zu verbessern“.

Die Übertreibungen beschränken sich nicht nur auf die Wissenschaft. Die Berichterstattung über Ingenieurleistungen im Zusammenhang mit vorgeschlagenen alternativen Energiequellen (z. B. Wind und Sonne) ist ebenfalls voreingenommen. Die berichteten Wirtschaftsdaten sind voreingenommen. Unbegrenzte „freie“ Energie ist angeblich überall um uns herum und wartet nur darauf, vom Baum „der Einhörner“ gepflückt zu werden.[Einhörner = Unicorns, eine Bezeichnung für Start-ups, denen von Investoren eine große Lukrativität angedichtet / geglaubt wird]

Und für die meisten Amerikaner (und die ganze Welt) gilt, dass uns die Berichterstattung nicht schlauer, sondern dümmer macht.

Warum spielt es eine Rolle? Wen kümmert es, wenn die Wissenschaft (oder Technik oder Wirtschaft) übertrieben ist, wenn das Ergebnis ist, dass wir aufhören, die Umwelt zu verschmutzen?

Abgesehen von der Tatsache, dass es keine umweltfreundliche Energiequelle gibt, ist es wichtig, dass die Menschheit von reichlich vorhandener, erschwinglicher Energie abhängt, um Erfolg zu haben. Es gelten nur die Lebenserwartung und der Pro-Kopf-Energieverbrauch. Wohlhabende Gesellschaften sind gesünder und leben länger. Teure Energiequellen, die durch Regierungsbeschlüsse den Massen aufgezwungen werden, töten arme Menschen, einfach weil teure Energie die Armut verschlimmert und Armut zu vorzeitigem Tod führt. Wie der Philosoph Alex Epstein in seinem Buch The Moral Case for Fossil Fuels darlegt, sollten Sie fossile Brennstoffe unterstützen, wenn Sie glauben, dass Menschen ein Recht auf Erfolg haben.

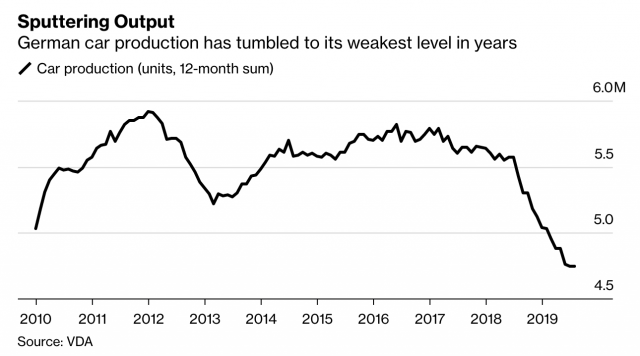

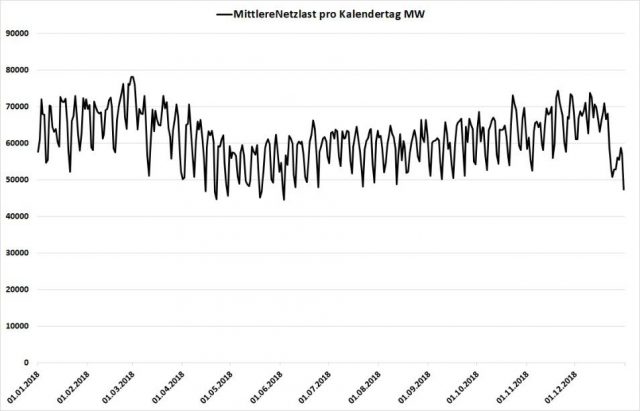

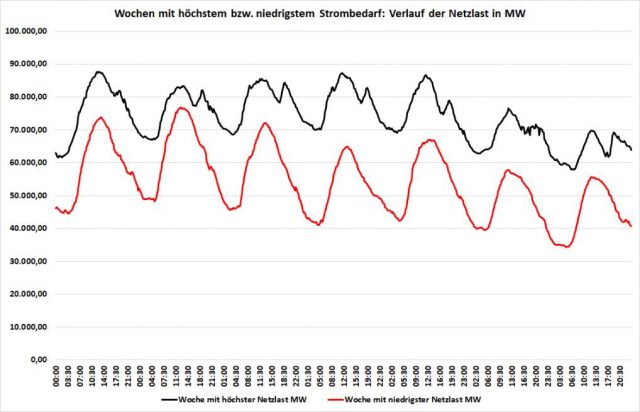

Wir nutzen Wind- und Sonnenenergie nicht, weil sie wirtschaftlich wettbewerbsfähig ist. Wir machen davon Gebrauch, weil die Regierungen beschlossen haben, die Steuerzahler zu zwingen, die damit verbundenen Mehrkosten zu tragen und es den Versorgungsunternehmen gestattet haben, die höheren Kosten an die Verbraucher weiterzugeben. Die Nutzung von Wind und Sonne steigt weiter, aber der globale Energiebedarf wächst noch schneller. Ohne eine neue Energietechnologie (oder eine erneute Einführung der Kernenergie) werden Wind und Sonne in den kommenden Jahrzehnten wahrscheinlich nicht mehr als 10% des weltweiten Energiebedarfs decken. Und wie einige europäische Länder erfahren haben , ist die zwangsweise Nutzung von Sonne und Wind für die Gesellschaft mit hohen Kosten verbunden.

Nicht nur die Medien, sondern auch das öffentliche Bildungssystem sind in dieser Zeit schlampiger wissenschaftlicher Berichterstattung mitschuldig. Ich nehme an, die meisten Lehrer und Journalisten glauben, was sie unterrichten und worüber sie berichten. Trotzdem tragen sie eine gewisse Verantwortung dafür, dass das, was sie melden, relativ unvoreingenommen und sachlich ist.

Ich hätte lieber Lehrer, die mehr Zeit damit verbringen, den Schülern beizubringen wie man denkt und weniger Zeit aufwenden, um ihnen beizubringen was sie denken sollen.

Klimaforscher sind nicht ohne Schuld. Sie sind, wie alle anderen auch, voreingenommen. Praktisch alle mir bekannten Erdwissenschaftler betrachten die Erde als „zerbrechlich“. Ihre Vorurteile wirken sich auf die Analyse unsicherer Daten aus, die auf verschiedene Arten interpretiert werden können. Die meisten wissen relativ wenig über Technik und Wirtschaft. Ich habe Gespräche mit Klimaforschern geführt, die mir sagten: „Nun, wir müssen sowieso weg von fossilen Brennstoffen .

Und vielleicht können wir es ja irgendwann. Aber die Bedrohung zu übertreiben kann mehr schaden als nützen. Der verstorbene Stephen Schneider gab zu, das auch er im Zweifel zwischen korrekten Aussagen einschließlich Unsicherheiten oder eher alarmistischer Vorhersagen war – die dann von den Medien dann weiter aufgebauscht und verfälscht wurden. Sie können hier sein eigenes Zitat lesen und selbst entscheiden, ob Wissenschaftler wie Dr. Schneider ihre Weltanschauung, Politik usw. zu sehr damit aufbauschen, wie sie ihre Wissenschaft der Öffentlichkeit präsentieren. Die ans Licht gebrachte Veröffentlichung der „ClimateGate“ -E-Mails zwischen IPCC-Wissenschaftlern zeigte, wie die alarmistische Erzählung aufrechterhalten wurde, indem alternative Ansichten untergraben und sogar die Herausgeber wissenschaftlicher Zeitschriften unter Druck gesetzt wurden. Sogar The Guardian , als ein eher die AGW-Hypothese puschendes Medium, schien von dem Fehlverhalten geschockt zu sein.

Es ist in Ordnung, die Möglichkeit darzulegen, dass die globale Erwärmung vom Menschen verursacht sein könnte, was in der Tat theoretisch möglich ist. Zu behaupten, dass bereits große und schädliche Veränderungen aufgrund des zunehmenden CO2-Ausstoßes in der Atmosphäre stattgefunden haben, ist ein schlechter Journalismus. Einige Reporter umgehen das Problem, indem sie sagen, dass der jüngste Hurrikan möglicherweise nicht direkt für die globale Erwärmung verantwortlich gemacht wird, sondern für das, was wir in einer sich erwärmenden Welt mehr erwarten können. Abgesehen davon ist auch der IPCC der Vereinten Nationen in diesem Bereich nicht eindeutig.

Medienberichte über den Anstieg des Meeresspiegels erwähnen, soweit ich das beurteilen kann, niemals, dass der Meeresspiegel von Natur aus gestiegen ist, seit wir globale Gezeitenmessungen durchgeführt haben (seit den 1850er Jahren). Vielleicht ist der Mensch für einen Teil des jüngsten Anstiegs verantwortlich, aber wie im Wesentlichen bei allen Klimaberichten wird die Rolle der Natur nur sehr selten erwähnt, und das Ausmaß des Problems ist fast immer übertrieben. Dass sich das periodische Hochwasser in Miami Beach aufgrund des Absinkens von zurückgewonnenem Sumpfland um etwa 50%höher ausfällt, wird nie erwähnt.

Es gibt keine menschlichen Fingerabdrücke der globalen Erwärmung. Keine. Es wird einfach angenommen, dass der Klimawandel größtenteils vom Menschen verursacht wird (was tatsächlich möglich ist), während unser Wissen über den natürlichen Klimawandel fast nicht vorhanden ist.

Klimamodelle sind mit der Annahme programmiert, dass es ausschließlich menschlicher Ursachen gibt. Die Modelle erzeugen einen vom Menschen verursachten Klimawandel, da sie so geschrieben sind, dass es keine Erwärmung ohne CO2 gibt (sich in einem Zustand der Energie-Balance befinden, sofern kein CO2 zugesetzt wird).

Soweit wir wissen, wurde noch nie jemand durch vom Menschen verursachten Klimawandel getötet. Wetterbedingte Todesfälle sind in den letzten 100 Jahren dramatisch gesunken – um über 90%.

Wem wurde das in der Schule beigebracht? Welcher Journalist war mutig genug, über diese guten Nachrichten zu berichten?

In den letzten Jahren erzählten mir immer mehr Menschen, dass ihre Kinder, Enkelkinder oder jungen Bekannten jetzt fest davon überzeugt sind, dass wir den Planeten mit unseren Kohlendioxidemissionen durch die Verbrennung fossiler Brennstoffe zerstören. Sie haben diese Botschaft durch Nachrichtenberichte, Filme, ihre Lehrer und Professoren, ihre Lieblingsstars und eine Handvoll AGW- aktiver Wissenschaftler und Politiker – deren Fachkenntnisse alles beliebige umfassen, aber nur kaum einen Zentimeter tief sind, in ihr Gehirn bohren lassen.

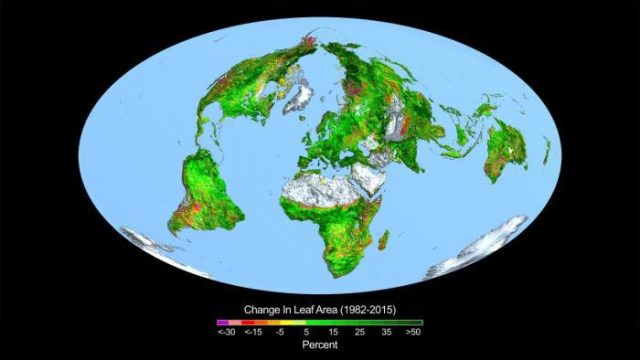

Im Gegensatz dazu, kennen nur wenigen Menschen die wissenschaftlichen Studien, in denen Satellitenbeobachtungen gezeigt werden, dass eine globale Begrünung als Folge von mehr atmosphärischem CO2 auftritt.

Wieder frage ich, wem wurde das in der Schule beigebracht? Welcher Journalist wagt es, über positive CO2-Vorteile zu berichten, ohne die es kein Leben auf der Erde gibt?

Nein, wenn es um Klimanachrichten geht, sind es immer Katastrophen.

Weitere Beispiele für Media Bias

Hier sind nur einige aktuelle (und weniger aktuelle) Beispiele von Medienberichten, die die Angelegenheit nur verschlimmern und die öffentliche Debatte zum Thema Klimawandel beeinträchtigen. Sehr oft werden tatsächlich wetterbedingte Ereignisse gemeldet, die sich in den letzten über 60 Jahren immer wieder verschlechtert haben [sollen] oder häufiger auftraten und bei denen man den Menschen zumindest teilweise die Schuld geben könnte.

Der Amazonas brennt

Vor ein paar Tagen gab The Guardian bekannt, dass große Teile des Amazonas-Regenwaldes brennen. Ich weiß nicht, wie dies plötzlich in das Bewusstsein der Öffentlichkeit gelangt ist, aber für diejenigen von uns, die solche Dinge im Auge behalten, wurde Ackerland und etwas Regenwald in Amazonen und angrenzenden Gebieten in dieser Jahreszeit seit vielen Jahrzehnten von Bauern verbrannt, so dass sie pflanzen können. Dieses Jahr ist in dieser Hinsicht keine Ausnahme, dennoch hat sich jemand entschlossen, dieses Jahr eine Nachricht daraus zu machen. 2019 scheint den Statistiken nach, jedoch eines der niedrigsten Jahre für die Verbrennung von Biomasse zu sein . Die Abholzung dort ist in den letzten 20 Jahren dramatisch zurückgegangen.

Der Regenwald selbst brennt nicht als Reaktion auf die globale Erwärmung und tatsächlich war die Erwärmung in den Tropen so langsam, dass es unwahrscheinlich ist, dass ein Bewohner der Tropen dies je in seinem Leben wahrnehmen würde. Dies ist kein Problem des Klimawandels. Es ist eine Frage der Landwirtschaft und der Landnutzung.

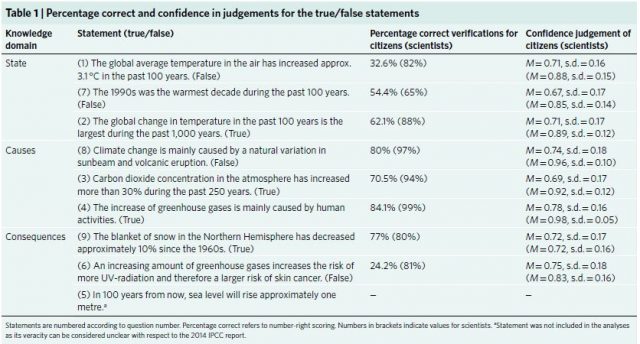

Grönland schmilzt schnell

Die grönländische Eisdecke erhält jedes Jahr [Nachschub durch] neuen Schnee und die Schwerkraft bewirkt, dass die Decke langsam zum Meer fließt, wo das Eis durch das Kalben von Eisbergen verloren geht. Wie viel Eis sich zu einem bestimmten Zeitpunkt auf Grönland befindet, hängt vom Gleichgewicht zwischen Zuwachs und Abgang ab.

In den Sommermonaten Juni, Juli und August schmilzt die Oberfläche stärker als die Schneedecke für Zuwachs sorgt. Die jüngste (wetterbedingte) Episode einer Sahara-Luftmasse, die durch Westeuropa strömte und sogar Grönland erreichte, führte zu einigen Tagen außergewöhnlicher Schmelze. Es wurde weithin berichtet, dass dies schwerwiegende Konsequenzen habe.

Forbes entschloss sich, die Grenzen des verantwortungsvollen Journalismus mit einer Schlagzeile zu überschreiten. Grönlands massive Eisschmelze sollte erst 2070 passieren . Die tatsächlichen Daten zeigen jedoch, dass sich die Bedingungen nach dieser sehr kurzen Zeit (einige Tage) starker Schmelze wieder normalisierten.

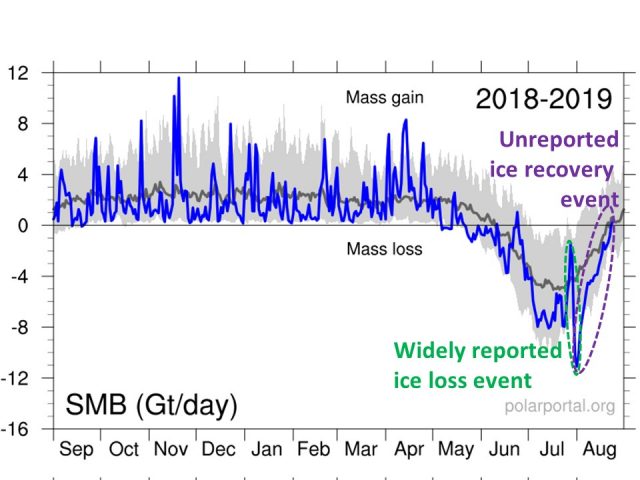

Auf das ausgiebig berichtete Ereignis der grönländischen Oberflächenschmelze um den 1. August 2019 herum, (grünes Oval) folgte in den folgenden Wochen eine Normalisierung (lila Oval), die von den Medien nicht gemeldet wurde.

Natürlich wurde von den Medien nur über die kurze Zeit der Schmelze berichtet, was die beständige Berieselung mit voreingenommenen Klimainformationen, an die wir uns alle gewöhnt haben, weiter stärkte.

Darüber hinaus wurde nach allen Berichten über Rekordwärme auf dem Gipfel der Eiskappe festgestellt, dass die Temperatursensormesswerte zu warm waren und die Temperatur tatsächlich nie über den Gefrierpunkt stieg.

Wurde dies mit der gleichen Intensität wie die ursprüngliche Geschichte berichtet? Natürlich nicht. Der Schaden ist angerichtet und die Tausenden von alarmierenden Nachrichten werden auf ewig weiterleben.

Das soll nicht heißen, dass Grönland nicht mehr Eis verliert als es dazu bekommt, aber der größte Teil dieses Verlusts ist auf das Kalben von Eisbergen am Rand des Festlandes zurückzuführen, die von Eis gespeist wird, das bergab fließt. Da gibt es keine Hochofenheizung der Oberfläche. Es könnte sein, dass der Verlust in den letzten Jahrzehnten eine verspätete Reaktion auf übermäßige Schneeansammlung vor zehn oder hundert Jahren ist (ich habe als Nebenfach an meiner Doktorarbeit in Meteorologie gearbeitet). Niemand weiß es wirklich, weil die Dynamik der Eisdecke mit viel Unsicherheit verbunden ist.

Mein Punkt ist, dass die Öffentlichkeit nur von diesen kurzen Wetterereignissen hört, die fast immer verwendet werden, um eine alarmistische Erzählung zu fördern.

Juli 2019 war der heißeste Monat der Aufzeichnungen

Die jährliche, flächengemittelte Oberflächentemperatur der Erde beträgt um 60°F [15,5°C] Es ist in den letzten Jahrzehnten langsam und unregelmäßig mit einer Geschwindigkeit von etwa 0,1 bis 0,2 ° pro Jahrzehnt angestiegen.

Nehmen wir also an, die propagierte Globale -Durchschnittstemperatur erreicht 60,4 °F [15,7 ° C], was etwas mehr als die als normal angesehenen 60 Grad. F. Ist „heißeste“ wirklich das beste Adjektiv, um die Öffentlichkeit über das, da [angeblich] festgestellt wurde, zu informieren?

Auch zum Thema: https://eike.institute/2017/09/24/temperaturen-der-letzten-150-jahre-wenn-harte-messdaten-nachtraeglich-veraendert-werden/

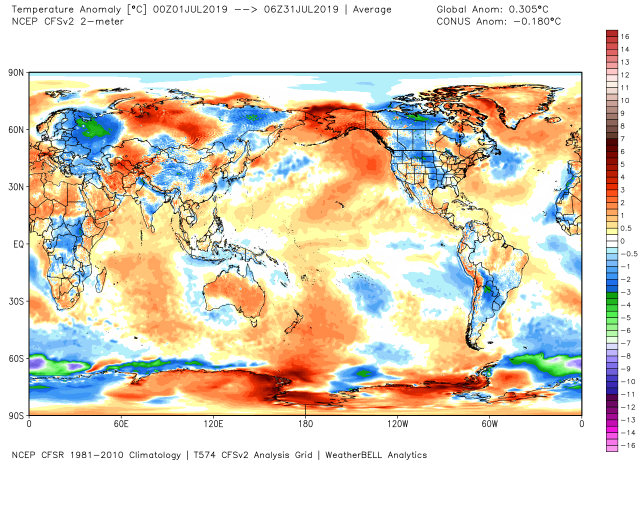

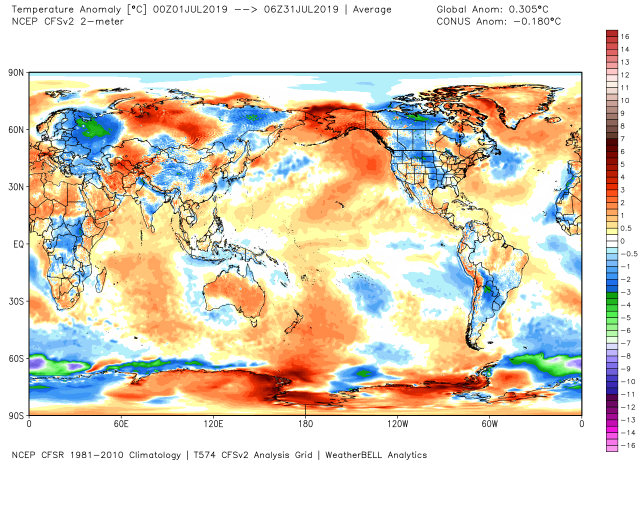

Hier ist eine geografische Darstellung der Abweichungen vom NOAA-Modell für die Klimaprognose im Juli 2019.

Juli 2019, von der Norm abweichende Oberflächentemperaturen. Der globale Durchschnitt ist nur 0,3 Kelvin oberhalb des Durchschnitts zwischen 1981 und 2010, und viele Gebiete wiesen eine Temperatur auf, die unter dem Normalwert lag. (Grafik mit freundlicher Genehmigung von WeatherBell.com ).

Einige Gebiete lagen über dem Normalwert, andere unter dem Normalwert, doch die Schlagzeilen des „heißesten Monats aller Zeiten“ ließen vermuten, dass die ganze Erde zu einem Ofen unerträglicher Hitze geworden war.

Natürlich sind die Temperaturänderungen in den neuen Rekordwärmemonaten so gering, dass sie in der Regel geringer als die Messunsicherheit sind. Verschiedene globale Datensätze liefern unterschiedliche Ergebnisse . Die Überwachung der globalen Erwärmung ist wie die Suche nach einer Nadel in einem Heuhaufen von Wetterunterschieden.

Zum Thema: https://eike.institute/2018/01/25/fake-news-und-temperaturwerte-2017-in-rekordnaehe/

Software und Ergebnis: Modelle, die Beobachtungen ersetzen

Es gibt einen zunehmenden Trend, Klimamodellprojektionen als tatsächliche Beobachtungen in Nachrichten auszugeben. Dies geschah erst vor ein paar Tagen, als ich auf eine Nachricht aufmerksam wurde, in der behauptet wurde, Tuscaloosa in Alabama leidet unter doppelt so vielen 100-plus Fahrenheit [37 °C] Tage wie früher. Zu seiner Ehre korrigierte der Reporter die Geschichte, als er darauf hingewiesen wurde, dass nichts dergleichen passiert ist und es nur eine Klimamodellprojektion war, die (fälschlicherweise) eine solche „Vorhersage“ machte.

Ein weiteres Beispiel war letztes Jahr die Meldung, dass sich die 100. Meridian-Klimagrenze in den USA nach Osten bewegte und allmählich die Trockenheit in den landwirtschaftlichen Gürtel des Mittleren Westens der USA einfiel. Aber die Wahrheit ist, dass so etwas nicht passiert ist. Es war eine Klimamodellprojektion, die als Realität weitergegeben wurde. Nachdem ich fast 10 Jahre lang mit Getreideanbau-Interessenten gearbeitet habe, habe ich diese gefälschten Klimanachrichten hier mit tatsächlichen Niederschlagsmessungen verglichen.

Die globale Erwärmung von Al Gore und Bill Nye in einem Versuch, das durch CO2 zu demonstrieren

Dies ist einer meiner Favoriten.

Im Rahmen von Al Gores Climate Reality Project produzierte Bill Nye das Climate 101Video eines Experiments, bei dem zwei Glasgefäße mit Thermometern innen durch Lampen angestrahlt wurden. In einem Glas war Luft, im anderen reines CO2. Das Video zeigt das Gefäß mit CO2, das angeblich einen größeren Temperaturanstieg erfährt als das Gefäß mit nur Luft.

Damit sollte natürlich demonstriert werden, wie einfach es ist, zu zeigen, dass mehr CO2 die Erwärmung verursacht. Ich bin sicher, es hat viele schulwissenschaftliche Experimente inspiriert. Das Video hatte über 500.000 Aufrufe.

Das Problem ist, dass dieses Experiment einen solchen Effekt überhaupt nicht zeigen kann. Jeder Fachmann für atmosphärischen Strahlungstransfer kann Ihnen dies sagen. Die Gläser sind für Infrarotstrahlung sowieso völlig undurchlässig, die Menge an CO2 ist viel zu gering, die Thermometer waren billig und ungenau, die Lampen können nicht exakt identisch sein, die Gläser sind nicht identisch, und die „Kälte“ des Weltraums war auch nicht drum herum. Der Fernsehmeteorologe Anthony Watts demonstrierte, dass Bill Nye die Ergebnisse durch Videobearbeitung in der Postproduktion vortäuschen musste.

Der Effekt einer Erwärmung durch atmosphärisches CO2 ist überraschend schwer nachzuweisen. Die Demonstration ist größtenteils eine theoretische Übung, die Berechnungen über Strahlungsabsorption und ein Strahlungstransfermodell umfasst. Ich glaube, dass der Effekt existiert; Ich sage nur, dass es keine einfache Möglichkeit gibt, dies zu demonstrieren.

Das Problem ist, dass dieses betrügerische Video immer noch existiert und viele Tausend Menschen in die Irre geführt werden, damit sie glauben, dass das Experiment ein Beweis dafür ist, wie es offensichtlich sein soll.

Greta Thunbergs Segelbootfahrt

Die neue Sprecherin der Weltjugend in Bezug auf die Sorge um die globale Erwärmung ist die 16-jährige Schwedin Greta Thunberg. Greta reist mit einer von CNN als „emissionsfrei“ bezeichneten Yacht über den Atlantik, um am 23. September am UN-Klimagipfel in New York City teilzunehmen.

Zunächst einmal gibt es keine emissionsfreie Yacht. Für die Herstellung der Yacht wurde eine enorme Menge an Energie benötigt, und sie transportiert so wenige Menschen, dass die Yacht während ihrer gesamten Lebensdauer ein wunderbares Beispiel für die Energieverschwendung darstellt, die typisch für den Lebensstil der reichen Elite ist. Vier (!) Menschen müssen von Europa in die USA fliegen, um die Rückkehr der Yacht nach Europa zu unterstützen, nachdem Greta dort abgeliefert wurde.

Die Reise ist nichts weiter als ein Werbegag und führt zu weiteren Desinformationen über den globalen Energieverbrauch. In der Tat funktioniert es viel besser als Satire. Stellen Sie sich vor, jeder, der über den Ozean reiste, benutzte Yachten anstatt Düsenflugzeuge. Nicht weniger, sondern mehr Energie würde benötigt, da Zehntausende von zusätzlichen Yachten hergestellt werden, die auf relativ wenigen, sehr langsamen Fahrten nur wenige Passagiere ineffizient befördern. Im Gegensatz dazu wird das durchschnittliche Düsenflugzeug in seiner Lebensdauer 80 Millionen Kilometer zurücklegen. Die meisten Menschen wissen nicht, dass das Reisen mit dem Jet jetzt sparsamer ist als das Reisen mit dem Auto .

Gretas-Bootsfahrt ist in vielerlei Hinsicht die absolut schlechteste Art, das Bewusstsein für Klimaprobleme zu schärfen, es sei denn, Sie kennen sich mit Naturwissenschaften, Technik oder Wirtschaft aus. Es ist wie mit jemandem, der es ablehnt, Fleisch zu essen, indem er drei McDonalds-Cheeseburger konsumiert, um zu zeigen, wie wir unsere Ernährung ändern sollten. Das ergibt keinen Sinn.

Ich könnte viele weitere Beispiele für die Medien nennen, die dazu beitragen, die Fähigkeit der Öffentlichkeit zu einer rationalen Diskussion über den Klimawandel zu zerstören, wie viel vom Menschen verursacht wird und was dagegen getan werden kann oder sollte.

Stattdessen veröffentlichen die Medien nur die aktuellsten Schlagzeilen und das Thema des Klimawandels wird dann in zwei Extreme unterteilt: Entweder glauben Sie, den „echten Wissenschaftlern“, die sich alle einig sind, dass wir den Planeten zerstören, oder Sie sind ein knuckle-dragging [Anspielung auf gebeugt laufende Neandertaler] Klimaleugnern der 8. Klasse [~Grundschule] mit Waffen und rassistischen Tendenzen.

Gefunden auf Der Webseite von Dr. Roy Spencer vom August 2019

http://www.drroyspencer.com/2019/08/how-the-media-help-to-destroy-rational-climate-debate/

Übersetzt durch Andreas Demmig