Ist der Klimawandel eine Bedrohung für den Panamakanal ?

Im Einleitungstext des Artikels heisst es:

„Wegen der schlimmsten Dürre seit mehr als hundert Jahren ist am Panamakanal der Wasserspiegel so stark gesunken, dass Beschränkungen für Schiffe nötig geworden sind.“

Weiter schreibt der (anonyme) Autor:

„Panama leidet seit Längerem unter den Auswirkungen des sich ändernden Klimas. So droht seine idyllische Inselkette San Blas wegen des steigenden Meeresspiegels innerhalb der kommenden Jahrzehnte im Karibischen Meer zu versinken. Doch die Bedrohung des Panamakanals fügt dem Problem nun eine neue Dimension hinzu. Denn die Wirtschaft des Landes hängt stark von einem reibungslosen Funktionieren des Kanals ab“.

Die DWN darüber hinaus:

„Im Jahr 2016 wurde der Kanal erweitert, um größere Schiffe aufnehmen zu können. Doch nur drei Jahre später sind bereits weitere Modernisierungen in Form eines dritten Sees notwendig, um das durch den Klimawandel zu erwartende extreme Wetter zu meistern.“

Die DWN notieren:

„Die neue Bedrohung für den Kanal kommt in einer Zeit, in der die Handelsbeziehungen zwischen den USA und China eskalieren. Das weltweite Wachstum hat sich verlangsamt und die Aussichten für die weltweite Seefracht haben sich deutlich verschlechtert.“

Der Bericht klingt besorgniserregend. Eine Bedrohung des Panamakanals durch den Klimawandel? Im IFHGK haben wir uns daher ´pro bono publico´ mit diesem Thema befasst. Denn, käme das von den DWN aufgegriffene Szenario tatsächlich auf Panama zu (oder hätte es Panama bereits erreicht?), könnte die Meldung für den internationalen Handel und die Containerschifffahrt tatsächlich ein sehr Ernst zu nehmendes Problem auf die Tagesordnung setzen. Wie gesagt, wenn die Recherche der DWN auf Fakten beruht, die diese brisanten Schlüsse zulassen.

Niederschlag

Beim Thema ´Klimawandel und Panamakanal´ geht es im Kern und in erster Linie um das zur Verfügung stehende Wasserangebot, welches für Schiffspassagen zwischen Atlantik und Pazifik hinreichend zur Verfügung stehen muss. Die Reservoirs u.a. des Gatunsees müssen jederzeit ausreichend gefüllt sein, um einerseits die Schleusungen selbst durchführen zu können und zum weiteren den notwendigen Wasserstand (die Wassertiefe) innerhalb der Kanalstrecke zu gewährleisten.

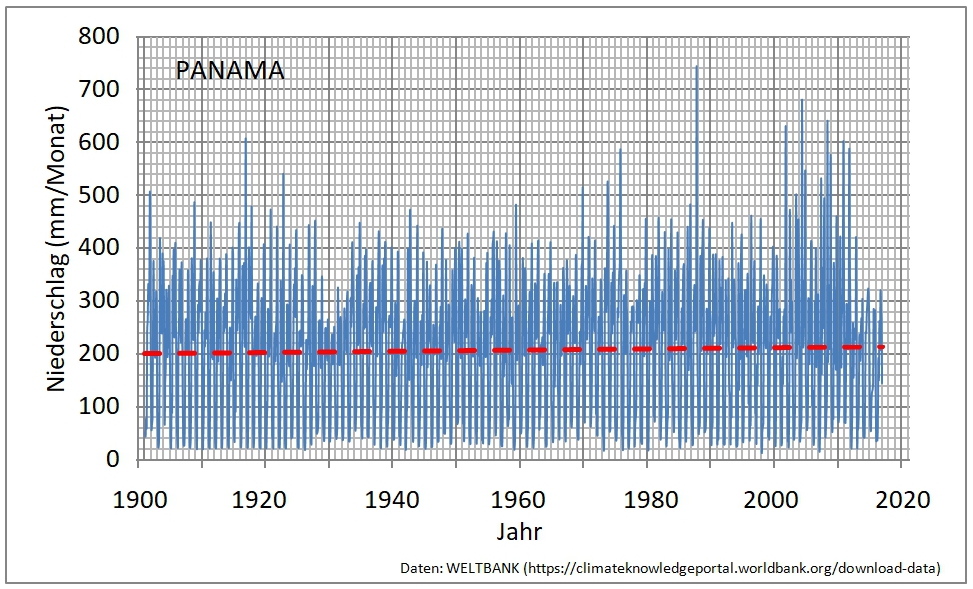

Zunächst betrachten wir die Niederschlagsentwicklung zwischen 1901 und 2016 anhand der Daten der WELTBANK. Mit Blick auf Abb. 1 ist bereits leicht zu erkennen, dass über die letzten 100 Jahre keine signifikante Veränderung des Gesamtniederschlags eingetreten ist … und vor allem auch keine negative Tendenz zu beobachten ist.

Abb. 1 : Gesamtniederschläge zwischen 1901 und 2016 in PANAMA (nach Daten der WELTBANK)

Die Abb. 1 zeigt für die Jahre 2013-2016 zwar leicht unterdurchschnittliche Niederschlagsmengen, indem die Regenvolumina in den Monaten zwischen April und November gegenüber jenen der Jahre zuvor etwas geringer ausgefallen sind. Dies ist allerdings und ganz gewiss kein Zeichen für „Klimawandel“, sondern die Werte bewegen sich absolut im zu erwartenden Spektrum dessen, was nun einmal als ´natürliche Varianz´ bezeichnet werden muss … schon zwischen 1929 und 1933 war beispielsweise eine ganz ähnliche Depression der Niederschläge zu beobachten (1929-1933 = 179mm/Monat und 2013-2016 = 175mm/Monat.

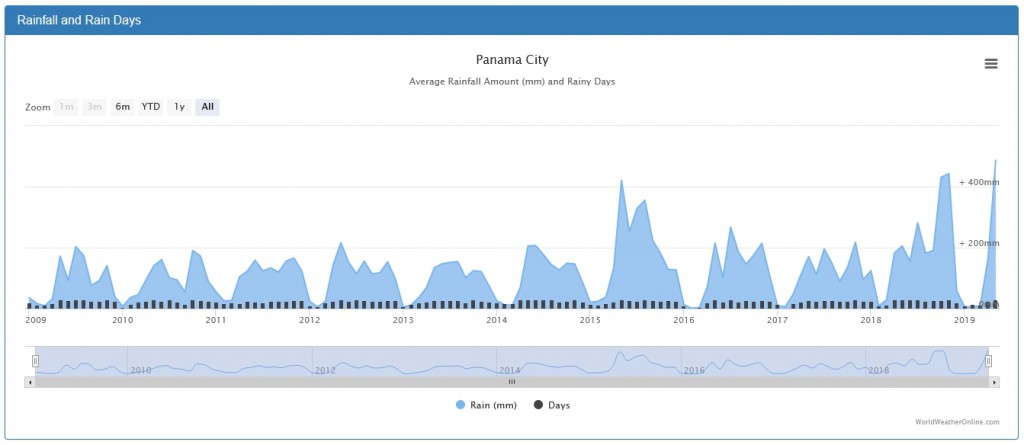

Die DWN führen nun aber für das Jahr 2019 die „schlimmste Dürre seit 100 Jahren“ an, die für ein absinken des Kanal-Wasserspiegels verantwortlich sei. Da die Daten des WELTBANK-Archivs momentan leider nur bis zum Jahr 2016 reichen, haben wir daher die aktuellen Werte aus https://www.worldweatheronline.com/panama-city-weather-averages/panama/pa.aspx hinzugezogen, die in der Abb. 2 Verlauf und Intensität der monatlichen Niederschläge von 2009 bis Anfang 2019 zeigen. Hier müssten die im DWN-Artikel benannten Probleme erkennbar werden.

In der Tat war der Winter 2018-2019 (Dezember 2018 – März 2019) ein vergleichsweise regenärmerer Zeitraum, welcher mit 4 Monaten (statt sonst „üblicher“ 3 Monate) gegenüber den vergangenen Jahren sogar leicht verlängert war … wofür allerdings die Niederschläge der anschliessenden Monate April und Mai 2019 jedoch überdurchschnittlich hoch ausfielen, so, wie auch bereits die Monate Oktober und November 2018 überdurchschnittliche Regenmengen brachten, sodass die vorübergehende „Dürre“ mehr als kompensiert wurde!

Es scheint also wahrhaftig kein Grund zur Sorge um die Schiffbarkeit des Panamakanals zu bestehen. Und, nochmals, von einer „Dürre“ zu sprechen, die seit 100 Jahren noch nicht so schlimm ausgefallen sei, darüber verliert der Autor lieber erst gar kein Wort … .

Abb. 2 : Monatliche Niederschläge in Panama City zwischen 2009 und 05-2019 (Daten aus worldweatheronline)

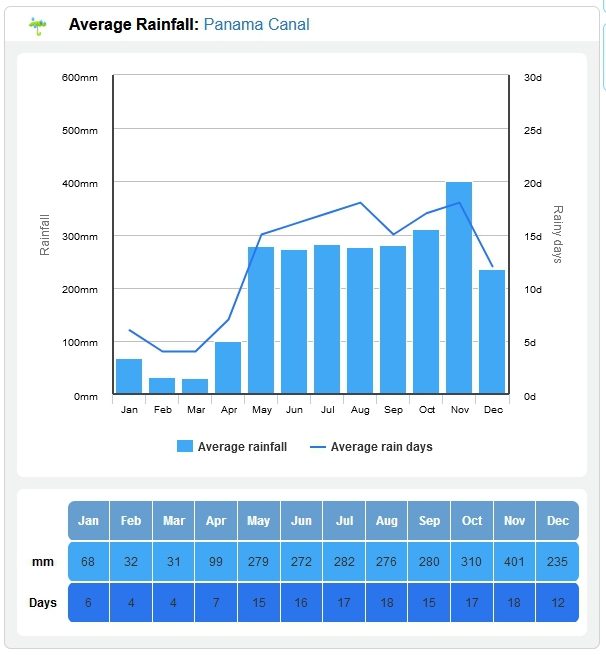

Auch ein zusätzlicher Blick auf die mittlere Verteilung der monatlichen Niederschläge (siehe Abb. 3) bestätigt, dass der Winter 2018-2019 letztlich kein Sonderfall war: Die Monate Januar bis April (4 Monate) sind ganz regulär genau jene Zeit des Jahres, die im Mittel grundsätzlich die regenärmsten im Bereich des Panamakanals ist.

Abb. 3 : Verteilung der monatlichen Niederschlagshöhen bzw. der Regentage zwischen den Monaten Januar und Dezember eines Jahres (Mittelwerte)

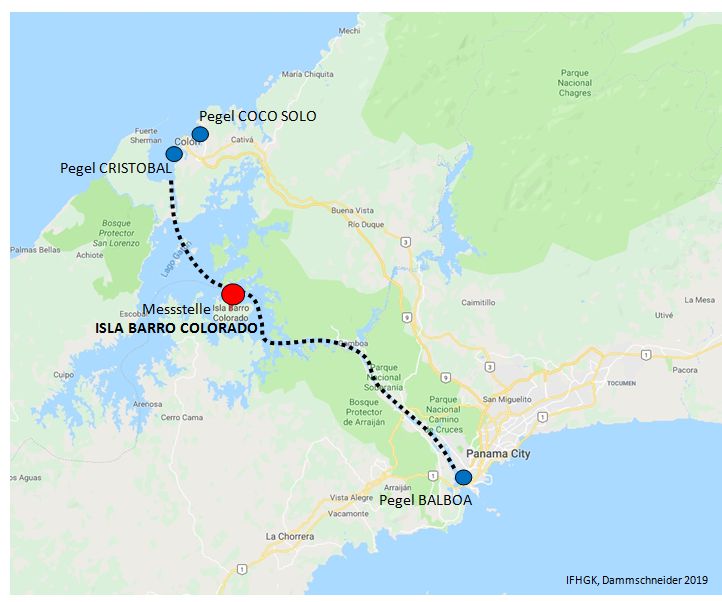

Um das Bild abzurunden, haben wir uns natürlich auch die spezifischen Niederschlagsdaten für den Zentralbereich des Panamakanals angeschaut. Es wurden die Aufzeichnungen der seit über 100 Jahren betriebenen Station „ISLA BARRO COLORADO“ verwendet (Lage der Meßstelle siehe Abb. 4).

Abb. 4 : Lage der meteorologischen Meßstation „Isla Barro Colorado“ (roter Punkt) im Zentralbereich der Strecke des Panamakanals (Gatun-See). Blauer Punkt = Lage der Pegel BALBOA, CRISTOBAL und COCO SOLO. Gepunktete Linie = Streckenverlauf des Panamakanals. Karte: Ausschnitt ´google-maps´.

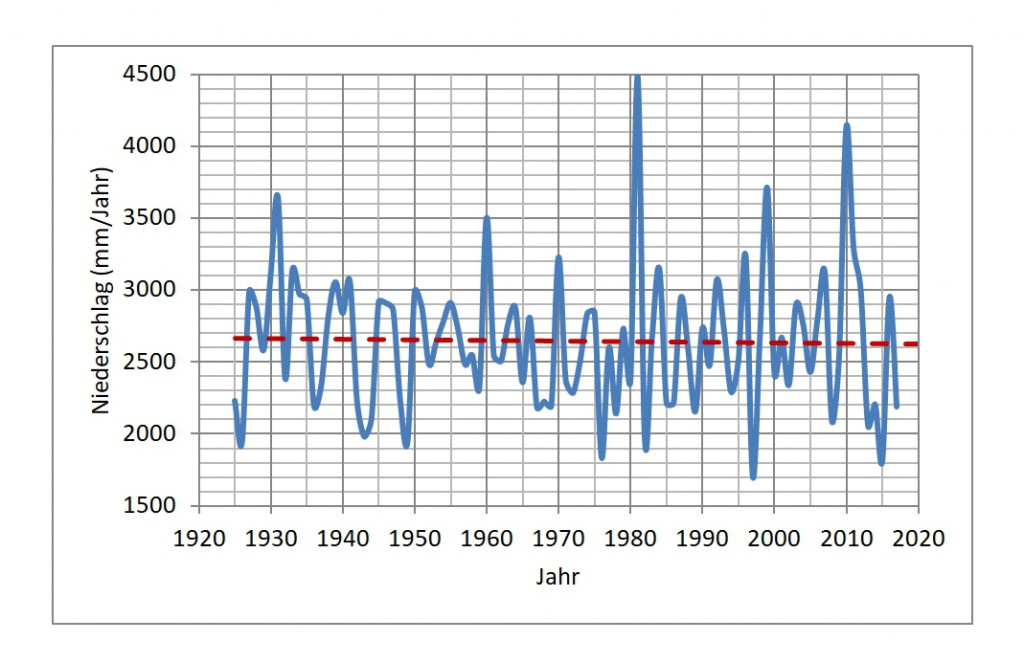

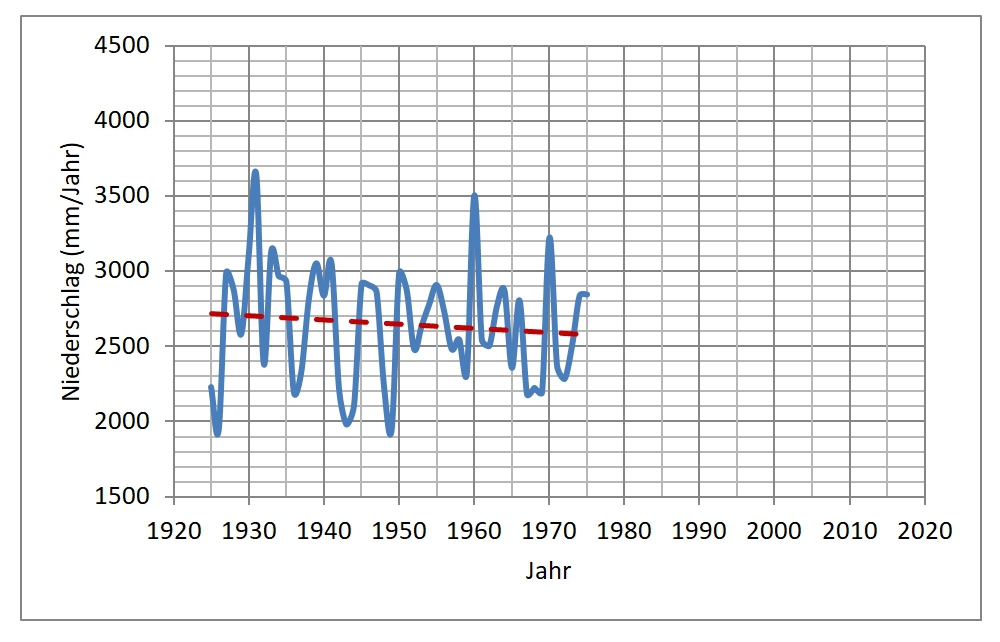

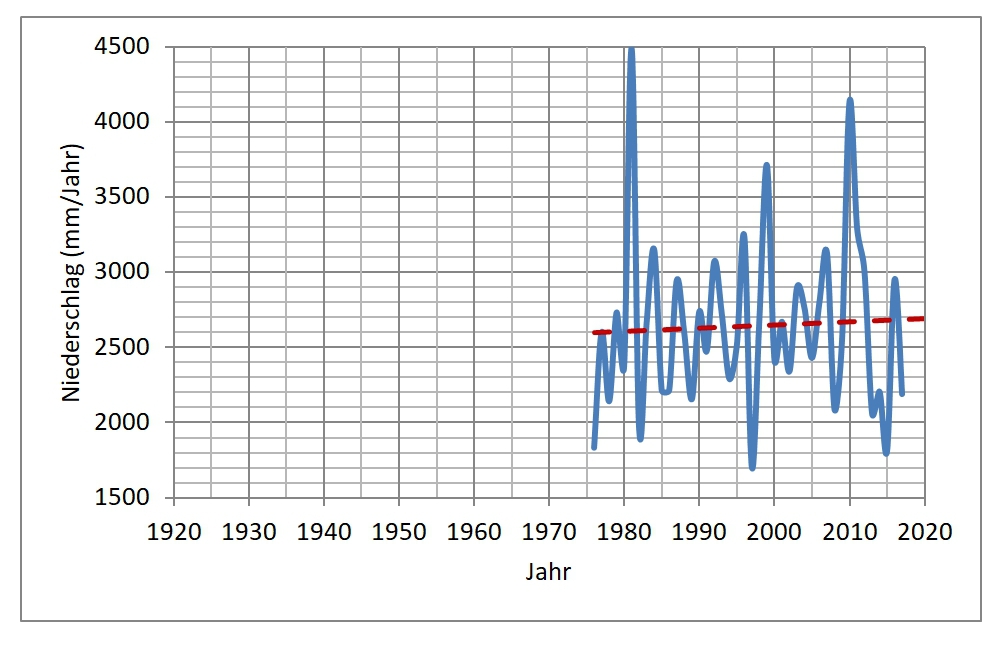

Der Gatunsee und sein Einzugsgebiet versorgen den Panamakanal und seine Schleusen zu ganz überwiegendem Teil mit dem notwendigen Wasser. Die Abb. 5 zeigt, dass die Niederschläge im Bereich des Gatunsees in den letzten rd. 100 Jahren zwar (ganz normal) jährlichen Schwankungen unterliegen, jedoch nahezu keinen Trend besitzen. Zwar ist im Zeitraum 1925 bis 1975 ein ganz leichter Rückgang der Niederschläge zu beobachten (Grafik b), der jedoch danach und bis heute wieder auf das vorherige Niveau zurück gekehrt ist (Grafik c). Auffällig sind zwar die bis 1975 im Vergleich zum Zeitraum 1975-2017 geringeren Amplituden der jährlichen Niederschlagsmengen. Dies jedoch ist mit grosser Wahrscheinlichkeit allein auf natürliche Fluktuationen im System ´Atmosphäre-Ozean´ zurückzuführen (El Nino / PDO / ENSO-Zyklen). Fakt ist auch, dass im Zeitraum 2013-2015 vorübergehend geringere Jahresniederschläge auftraten … hier ist das Phänomen eines „El Nino“ zu beachten. Diese (und andere) mehr oder weniger zyklischen Veränderungen treten im Wetter- und Klimasystem immer und überall fast regelmässig auf. Alle, die beispielsweise mit dem Fischfang Perus zu tun haben (um ein im wahrsten Sinne des Wortes für Panama naheliegendes Beispiel zu bringen), können davon ein Lied singen.

5a:

5b:

5c:

Abb. 5 : Jährliche Niederschlagsmengen 1925-2017, Station „Isla Barro Colorado“ (Panama/Gatunsee). Grafik ´a´ = Gesamtzeitraum, Grafik ´b´ = Zeitraum 1925-1975, Grafik ´c´ = Zeitraum 1975-2017. Daten: Smithonian Tropical Research Institute,„2017 Meteorological and Hydrological Summary for Barro Colorado Island“

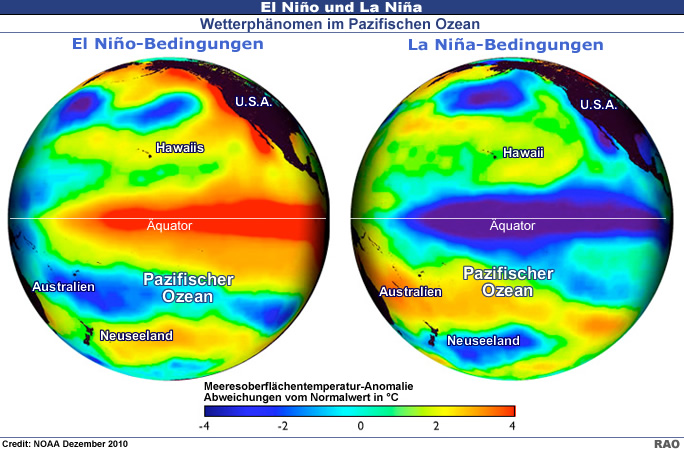

Abb. 6 : Darstellung der typischen Verteilungsmuster von Wassertemperaturen im Pazifik, die sich bei einem vorübergehenden „kippen“ der Strömungsverhältnisse im Zuge eines „El Nino“ einstellen … mit Wirkung auf die atmosphärischen Verhältnisse weltweit

Ein sogenannter ´El Nino´ tritt alle paar Jahre im Pazifik in Erscheinung: Der für den Fischreichtum vor Peru vor allem verantwortliche Humboldstrom, der vor der Südamerikanischen Küste kühleres und nährstoffreiches Wasser aufquellen lässt (siehe in Abb. 6 die Grafik ´b´), bricht dann vorübergehend zusammen und warmes Wasser verbunden mit einem deutlich verringerten Nahrungsangebot für alle Lebewesen im östlichen Pazifik (Fische etc. ) und ´über´ dem Pazifik vor der Peruanischen Küste (Vögel) lässt alle darben … inklusive der davon z.B. abhängigen Fischindustrie. Aber das geht auch wieder vorüber, ein El Nino tritt in Abständen von meist 4-7 Jahren auf. Es darf am Rande vermerkt werden, dass solche zyklischen Vorgänge nahezu das gesamte Weltklima beeinflussen: Selbst die im Zeitraum 2014-2016 in Europa/in Deutschland (!) zu beobachtenden relativ hohen Lufttemperaturen sind nachweislich auf diese zyklischen Vorgänge im Pazifik (und dem Atlantik) zurückzuführen … mit dem Anstieg des CO2 haben diese Vorgänge jedenfalls absolut nichts zu tun. Es mag als Warnung verstanden werden, wenn wir darauf hinweisen, dass aufgeregte Kommentare gerade in deutschen Medien solche Zusammenhänge eher aussparen … .

Fazit aus Sicht des IFHGK: Die im DWN-Bericht für den Panamakanal genannten Probleme, die sich aus angeblichen Veränderungen des natürlichen Wasserangebots ergeben sollen, sind für uns nicht nachvollziehbar bzw. erkennbar.

Meeresspiegel

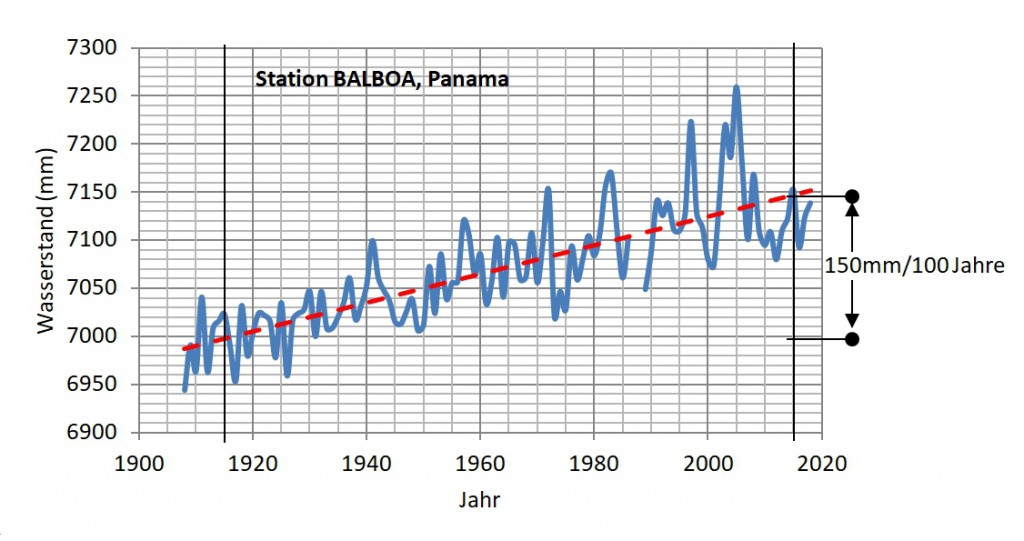

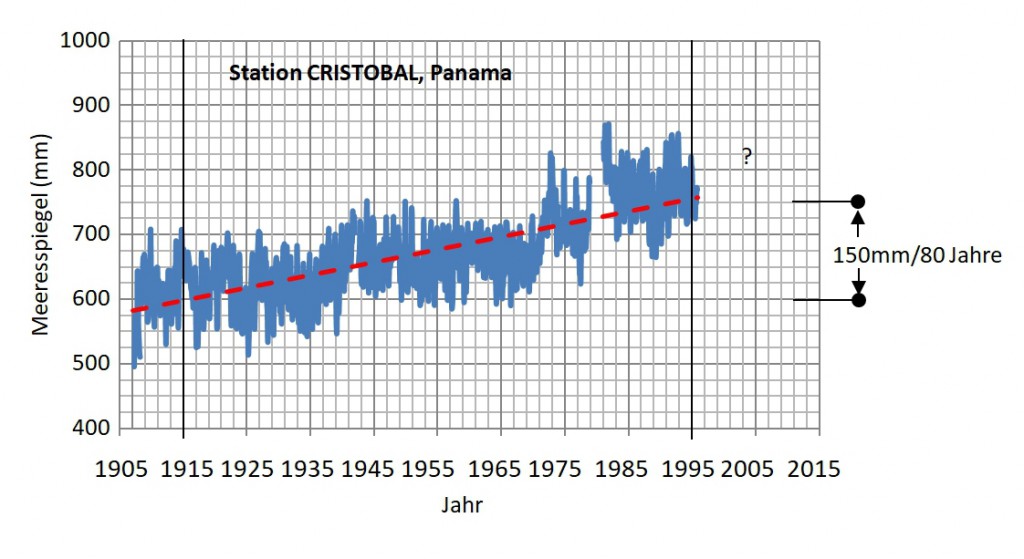

Der nächste Punkt des DWN-Berichts erwähnt den angeblichen Anstieg des Meeresspiegels vor Panama bzw. an Panamas Küsten. Dazu haben wir zwei sogenannte Pegelmeßstellen ausgewertet. Beide, BALBOA für den Pazifik und CRISTOBAL für den Atlantik (Lage siehe Abb. 4 , Daten siehe Abb. 7) zeigen, dass tatsächlich der Meereswasserspiegel ansteigt: Für den Pazifik (BALBOA) sind es durchschnittlich +1,5mm/Jahr, im Atlantik (CRISTOBAL) +1,87mm/Jahr. Beide Werte liegen absolut im üblichen Rahmen der weltweit zu beobachtenden Veränderungen bzw. Zunahmen. Dieser Anstieg des Wasserspiegels ist, wie gesagt, ein weltweites Phänomen. Regional können die Werte (auch vorübergehend!) mal geringer aber auch mal höher ausfallen. Der Anstieg ist grundsätzlich nicht neu, sondern besteht seit Ende der letzten Eiszeit (siehe Abb. 9 aus www.climate4you.com ). Ein Resultat allein des sogenannten aktuellen Klimawandels ist es nicht.

Interessant ist, dass die in den Niederschlagsdaten für die Jahre 2013-2015 sichtbare „Delle“ auch in den Werten bzw. dem Verlauf des Meereswasserspiegels am Pegel BALBOA erkennbar wird: Hier lassen sich die Auswirkungen der zyklischen ozeanischen (und damit klimatischen) Varianzen gut herauslesen.

7a:

7b:

Abb. 7 : Veränderung des Meereswaserspiegels an den panamaischen Messtationen BALBOA (Pazifik) und CRISTOBAL (Atlantik), je seit rd. 100 Jahren. Die Trendlinie in rot zeigt einen Anstieg zwischen 1,87mm/Jahr (CRISTOBAL) und 1,5mm/Jahr (BALBOA). Daten: www.psmsl.org

Anmerkung: Für die Station CRISTOBAL sind gemäss www.psmsl.org die Pegeldaten nach 1995 möglicherweise nicht ordnungsgemäss aufgzeichnet bzw. von den lokalen Behörden nicht korrekt ausgewertet worden. Daher wurde auf die Fortschreibung der Daten ab/nach 1995 verzichtet.

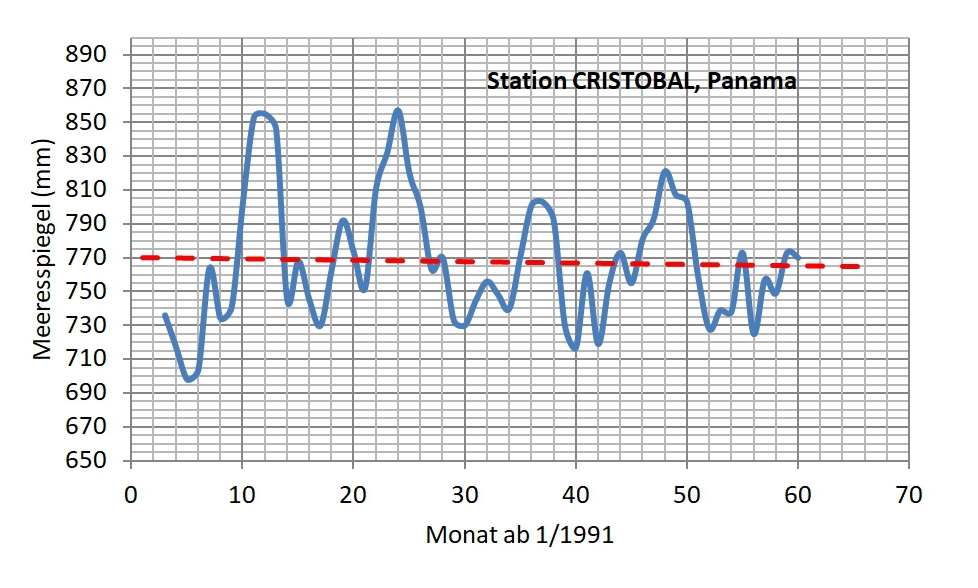

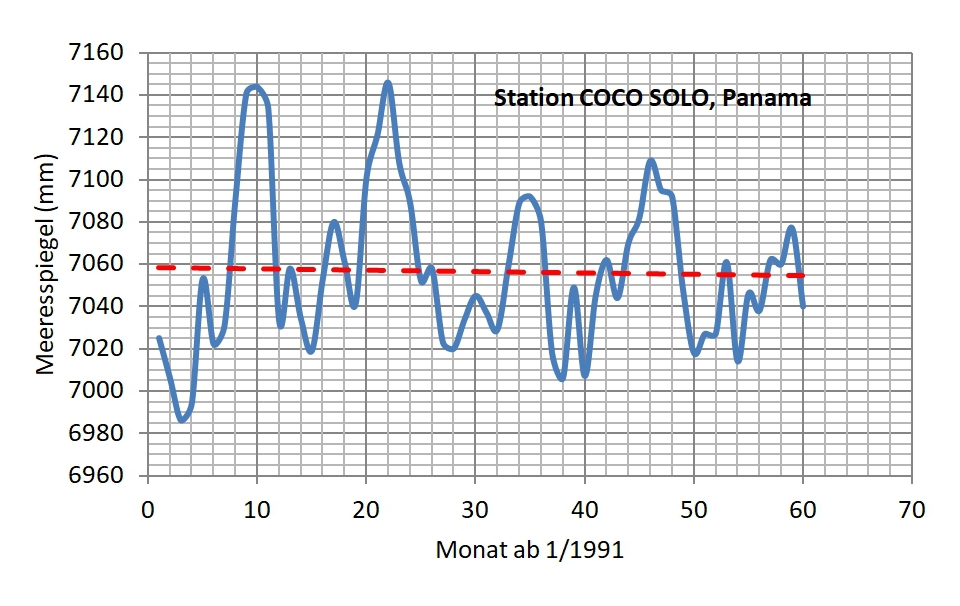

Rd. 5 Kilometer auseinanderliegend, zeigen die Wasserstandsverläufe des Atlantiks bei CRISTOBAL und COCO SOLO sehr ähnliche Grundmuster: Wie am herausgestellten Beispiel der Jahre 1991-1995 (siehe Abb. ![]() erkennbar, sind die Verläufe sehr ähnlich. Man darf also davon ausgehen, dass beide Stationen zwar nicht unbedingt in allen Fällen immer zweifelsfrei ´absolut´ richtig aufzeichnen, jedoch die Tendenzen hinreichend genau erfasst werden. Damit sollte klar sein, dass der in den DWN für die „kommenden Jahrzehnte“ postulierte Untergang der ´idyllischen´ Inselkette SAN BLAS zumindest nicht wegen eines ´steigenden Meeresspiegels´ stattfinden wird … .

erkennbar, sind die Verläufe sehr ähnlich. Man darf also davon ausgehen, dass beide Stationen zwar nicht unbedingt in allen Fällen immer zweifelsfrei ´absolut´ richtig aufzeichnen, jedoch die Tendenzen hinreichend genau erfasst werden. Damit sollte klar sein, dass der in den DWN für die „kommenden Jahrzehnte“ postulierte Untergang der ´idyllischen´ Inselkette SAN BLAS zumindest nicht wegen eines ´steigenden Meeresspiegels´ stattfinden wird … .

8a:

8b:

Abb. 8 : Pegelmessstellen CRISTOBAL (oben) und COCOSOLO (unten), je panamaische Atlantikküste, Zeitraum Januar 1991 bis Dezember 1995 (Daten: www.psmsl.org)

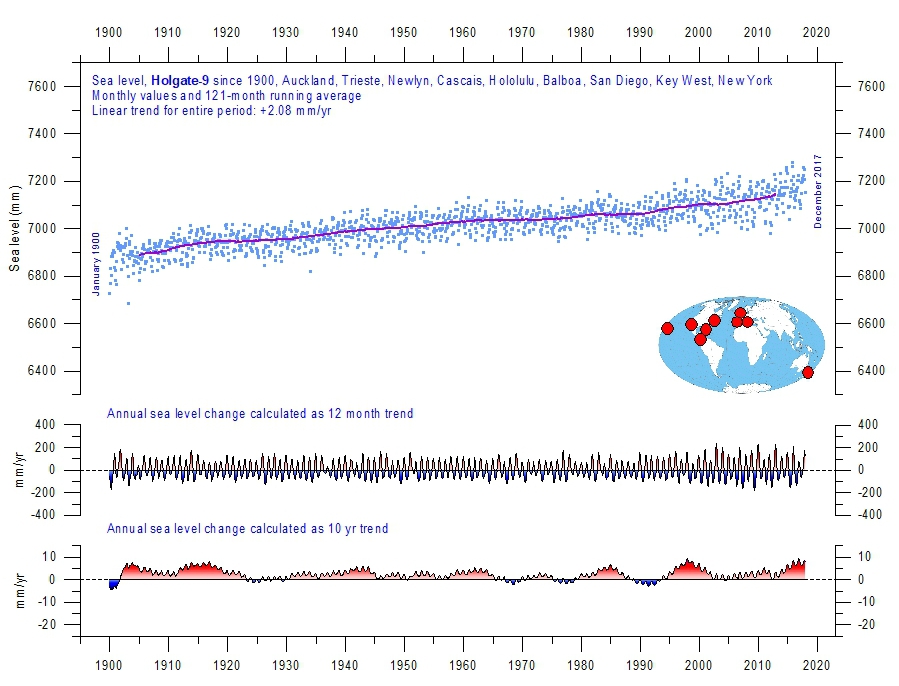

Ergänzend seien an dieser Stelle der mittlere Verlauf bzw. die Veränderungen des weltweiten Meeresspiegels dargestellt (Abb. 9). Die Berechnung erfolgte nach HOLGATE (2007). Es handelt sich um 9 Stationen mit monatlichen Gezeitenmessdaten aus dem PSMSL Data Explorer. Holgate schlug die neun im Diagramm aufgeführten Stationen vor, um die Variabilität zu erfassen, welche in einer größeren Anzahl von Meßstellen im Laufe der letzten 100 Jahre stattgefunden hat bzw. dort zu beobachten ist.

Abb. 9 : Anstieg des weltweiten Meeresspiegels seit 1900 nach Auswertung von 9 weltweiten repräsentativen Pegelstationen (sogenannte „Holgate-9“-Daten, Grafik aus www.climate4you.com )

Bei den blauen Punkten der Abb. 9 handelt es sich um die einzelnen monatlichen Werte der zusammengefassten neun Pegel, die violette Linie repräsentiert das 10-jährige übergreifende Mittel. Die beiden unteren Panels zeigen die jährliche Meeresspiegeländerung, berechnet für 1 bzw. 10 Jahre- Zeitfenster. Die letzte Aktualisierung des Diagramms stammt vom 23. Juni 2018 (www.climate4you.com). In den letzten 100 Jahren stieg hiernach der weltweite mittlere Meeresspiegel um 17 cm bzw. 17 mm/Jahr an. Dies ist sogar mehr (wenn auch geringfügig) als jener bei BALBOA, wo er im gleichen Zeitraum nur um 15 mm zulegt … hiernach hätten die idyllischen SAN BLAS Inseln nicht viel zu befürchten, die Gefahr für diese aus Korallen bestehende Gruppe kommt aus anderer Richtung, die mit ziemlicher Sicherheit nicht klimatisch begründet ist.

Temperaturen

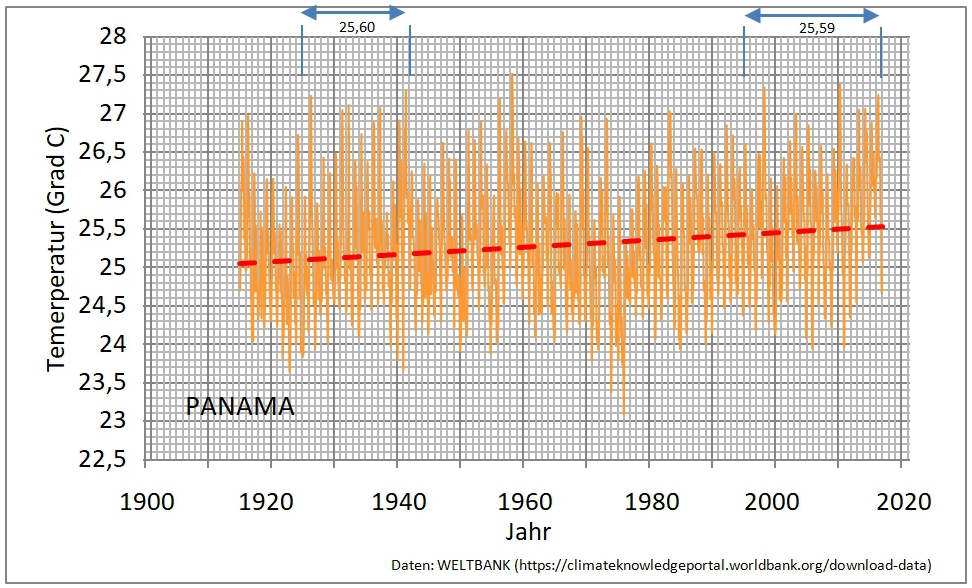

Zur Beurteilung eines möglichen Klimawandels gehört natürlich immer auch die Entwicklung der Temperaturen. Der Bericht der DWN geht hierauf zwar nicht ein, dennoch sollen der Vollständigkeit halber die Werte für PANAMA dargestellt werden.

Die Abb. 10 zeigt, dass zwischen 1915 und 2016 (wiederum nach Werten der WELTBANK) die Lufttemperaturen PANAMAS in diesen 100 Jahren um rd. 0,5 Grad C angestiegen sind. Zum Vergleich: In Deutschland kletterten die Temperaturen im gleichen Zeitraum um rd. 1,0 Grad C nach oben … . . Was für Panama bemerkenswert ist: Während in den letzten 20 Jahren die Temperaturen im Mittel auf 25,59 Grad C lagen, war dies während der Zeit zwischen 1925 und 1942 bereits einmal genau so viel, damals lag die mittlere Temperatur bei 25,60 Grad C ! Wir sehen daran, dass die Aussage „der“ Klimawandel beschleunige sich und der zunehmende CO2-Gehalt der Atmosphäre/der Mensch seien ´ausschliesslich´ für den Anstieg der weltweiten Temperaturen verantwortlich, in dieser Form (und zumindest für Panama) nicht gelten kann. Denn: Während der atmosphärische CO2-Gehalt in den 30er Jahren des letzten Jahrhunderts bei rd. 310ppm lag, beträgt der Wert heute bereits über 400ppm … ein Plus von rd. 30% für´s CO2 innerhalb von rd. 90 Jahren, aber (in Panama) so ziemlich die gleichen Wärmeverhältnisse (als Temperaturen in Grad C) wie damals.

Abb. 10 : Lufttemperaturen PANAMA zwischen 1915 und 2016 (nach Daten der WELTBANK)

Wind, Sonne, Wolken

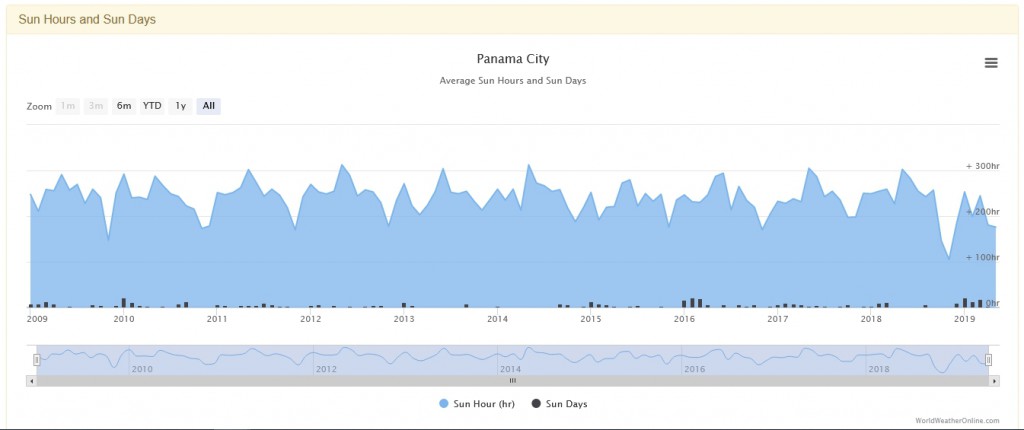

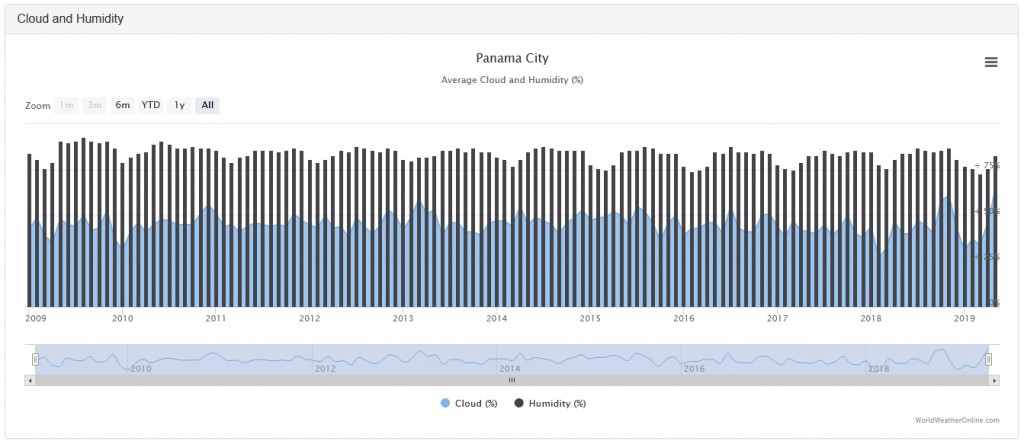

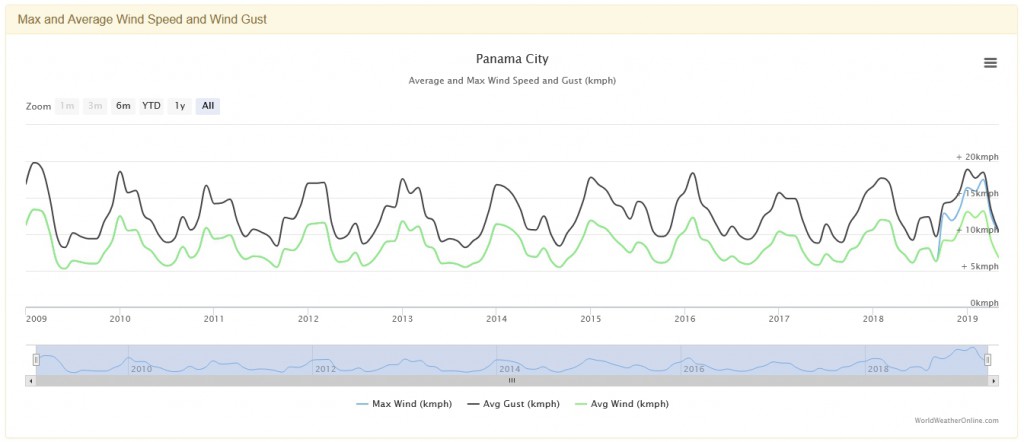

Die DWN schreiben: „ … (für den Panamakanal) sind bereits weitere Modernisierungen in Form eines dritten Sees notwendig, um das durch den Klimawandel zu erwartende extreme Wetter zu meistern“. Wir schauen also auch einmal auf´s Wetter. Aber was ist „Wetter“ eigentlich? Und wieso kommt Wetter nach Klima? Dazu später noch einiges! Zunächst ein Blick auf Faktoren, die beim „Wetter“ eine Rolle spielen und die auch für den Bereich des Panamakanals aufgezeichnet werden. Hier 3 davon:

- Strahlung (Sonne)

- Wolken und Feuchte

- Wind

(alle Grafiken bzw. Daten aus https://www.worldweatheronline.com/panama-city-weather-averages/panama/pa.aspx )

Es führt an dieser Stelle zu weit, alle Daten, die in den o.a. Grafiken zusammengefasst sind, im Detail zu analysieren bzw. zu kommentieren. Mit Blick auf die drei Abbildungen genügt es, festzustellen, dass sich seit 2009 bei allen Parametern nicht wirklich etwas verändert hat bzw. dass nichts in einem Trend liegt, der Anlass zur der Annahme geben könnte, in diesen „Bestandteilen“ des Wetters hätte sich wirklich etwas geändert/verändert … ob zum Negativen (Klimawandel) oder was auch immer. Da ist nichts! Die sichtbaren Schwingungen in den Werteverläufen stellen das absolut normale Mass dessen dar, was die Natur nun mal so bereithält: Da ist mal ein bisschen mehr an Wolken oder Wind, und dann auch mal eine Portion weniger, alles im Verlauf des üblichen Jahresgangs (!), es gibt keinerlei Anlass zur Besorgnis. Wetter eben … .

Gewiss: ´Extremes´ Wetter gab und gibt es immer mal wieder. Es handelt sich aber immer um Vorgänge, die sozusagen im System verankert sind … sie kommen und gehen, periodische Vorgänge addieren (oder subtrahieren) sich. Wellenförmige „Fernwirkungen“ aus ENSO oder PDO modulieren das Wetter darüber hinaus. Es gibt dabei Zeiten von Ruhe, und es gibt Zeiten mit für den Menschen (und seine Behausungen) gefährlichen Konstellationen. Hinweise auf die Zunahme von Extremwetter finden sich für Panama jedoch nicht … nicht einmal bei Hurricans (siehe kaltesonne).

Es muss klar festgestellt werden: Klima ist sozusagen das mittlere Wetter einer Region! Wetter findet statt als ein dynamischer Prozess, der aus unzähligen physikalischen Parametern besteht und der sich chaotisch (!) und nicht deterministisch im (fast) offenen Raum der Atmosphäre abspielt. Wetter als Oberbegriff des Zusammenspiels unterschiedlichster atmosphärischer Faktoren (die eigentlich alle miteinander in Beziehung stehen und oftmals sogar ´rückgekoppelt´ sind) wird gemessen in Form von „Temperatur“, „Niederschlag“ oder „Wind“ u.a.m. und dabei (teils!) dokumentiert. Dies geschieht an bestimmten Punkten/Messstellen (!), aber niemals in der Fläche … obwohl Wetterkarten dies suggerieren. Alles das geschieht von Tag zu Tag, von Woche zu Woche, von Monat zu Monat … und dann über Jahre.

Erst nach 30 Jahren und der statistischen Mittelung aller in diesem Zeitraum aufgezeichneten Werte bekommen wir einen Begriff vom Klima eines Ortes! Erst dann, nach Ablauf eines (gerade für uns Menschen!) sehr langen Zeitraums können wir uns einen ersten (aber auch nur einen allerersten!) Eindruck vom mittleren Wetter oder (eben) dem Klima machen. Und die Entwicklung dieses Klimas, welches wiederum überall auf der Erde unterschiedlich ist (ein „Welt“-Klima gibt es nicht!) erkennt man erst dann, wenn viele Dekaden mit „Wetter“ stattgefunden haben … zu mutmassen, dass man bereits auf einen nachhaltigen Klimawandel schliessen könne, wenn man auf den Zeitraum zurück nur bis 1850 schaut, ist zwar inzwischen üblich geworden, kann aber ganz gewiss nicht seriös ausreichen, um einen wirklichen „Wandel“ beurteilen zu können. Klima verläuft nicht von heute auf morgen, Klima unterliegt langfrístigen Zyklen, Klimawandel kann man erst dann feststellen, wenn … Zeit vergangen ist.

Der Irrtum der in den Medien ganz überwiegend zitierten Klimaexperten besteht darin, dass man glaubt, aus der bisherigen Klimavergangenheit (die wir Menschen in Zahlen (!) erst seit Mitte des 19.Jahrhunderts zu Papier gebracht haben) auf die Zukunft hochrechnen zu können, indem man Szenarien auf Grosscomputern ´laufen´ lässt. Doch dahinter steckt ein Irrtum. Ein Irrtum, der davon ausgeht, dass wir die Natur und das Klima schon umfassend kennen würden bzw. ´verstanden´ hätten und damit ´systematisch´ beurteilen könnten. Und das wir dieses Klima mit Mass und Zahl tatsächlich berechnen können oder, anders ausgedrückt, dass das Klima eine berechenbare Grösse sei.

Sagen wir es offen: Das ist nicht nur Hybris, es ist erwiesenermassen auch mehr als nur ungenau … ein einziger Blick auf die Ergebnisse bisheriger Klimaprognosen, die mittels unterschiedlicher Rechenmodelle erstellt wurden, zeigt, dass bisher weder eine auch nur annähernde Übereinstimmung der Modelle besteht noch überhaupt eine Nähe zu den tatsächlich beobachteten Naturdaten erreicht werden konnte.

Dies ist möglichweise ein sehr folgenschwerer Irrweg und Irrtum, mit dem für oftmals vollkommen ungeeignete Massnahmen zur „Vermeidung von Klimawandel“ (?)Milliarden von Euro oder Dollar ausgegeben werden, nur damit man eventuell am Ende feststellt … die Erde dreht sich weiter, die Sau, die man durch´s Dorf getrieben hat, ist gestorben, aber nichts hat sich wirklich verändert. Und schon gar nicht das Klima. Oder besser: Das Klima ändert sich durchaus, aber eben nicht nur in eine Richtung, wie man momentan glaubt sehen zu können. Es wird sich zeigen, was kommt … aber für Klima-Panik besteht definitiv kein Grund. Greta for Nobel Prize ? Wir warnen vor dieser Erhöhung.

Der Panamakanal … neue Schleusen und Technik seit 2016

Nun stellt sich jedoch die Frage, was sich denn dann hinter den sicherlich nicht zu leugnenden Problemen der Wasserstrasse verbergen könnte. Was könnte zu den ohne Frage eher ungewöhnlichen (Tiefgangs-) Beschränkungen für die Schifffahrt geführt haben, die die Kanalverwaltung aussprechen musste. Denn Tatsache ist: Beim Panamakanal handelt es sich um ein Wirtschaftsunternehmen; hier Einschränkungen im laufenden Betrieb auszusprechen bedeutet auf Einnahmen zu verzichten. Das macht man nicht freiwillig.

Den wirklichen Ursachen kommt folgender Bericht vermutlich näher auf die Spur (https://www.bluewin.ch/de/news/wissen-technik/extreme-duerre-am-panama-kanal-veranschaulicht-klimawandel-sorgen-244862.html ): „Die Beschränkungen betreffen (…) die Schleusen Cocoli und Agua Clara, (beide) entstanden im Rahmen des 2016 in Betrieb genommenen, milliardenschweren Ausbauprojekts, das den grösseren Neopanamax-Schiffen die Passage ermöglicht. Im Durchschnitt durchfahren täglich siebeneinhalb Schiffe diese Schleusen, zuweilen auch bis zu zwölf“.

Nun, da gäbe es einen Verdacht, und der hat nichts mit den Klimawandel zu tun, sondern fusst auf den erst 2016 abgeschlossenen baulichen Erweiterungen mit den erheblich vergrösserten Schleusen des ´neuen´ Panamakanals (siehe Abb. 11). Man muss wissen, dass bei jeder Schleusung Wasser sozusagen verbraucht wird. Das liegt daran, dass beim füllen bzw. entleeren von Schleusen immer auch Wasser dem Schleusenabstieg/-gefälle entsprechend in Richtung Meer abläuft. Der Kanal verliert also (Frisch-)Wasser an den Atlantik bzw. den Pazifik. Mit den alten, vergleichsweise kleinen Schleusenkammern war dies kein grosses Problem. Die seit 2016 im Betrieb befindlichen erheblich grösseren Schleusenkammern jedoch verursachen (neben den auch weiterhin betriebenen alten Schleusenkammern!) einen grösseren Durchsatz an Oberflächenwasser, das natürlich immer noch „nur“ aus dem Einzugsgebiet bzw. dem Niederschlagsgebiet des Gatunsees stammt. Während der Regenzeit ist der ´Verlust´ an Wasser kein Problem. Wenn allerdings (und ganz normal!) eine etwas längere Phase geringerer Niederschläge eintritt, dann kommt die Vorratshaltung des aktuellen Panamakanals, zusammen mit dem Weiterbetrieb der alten Schleusen, offenbar an Grenzen.

Abb. 11: Panamakanal, Schleusenanlage „Gatun“/Colon, neue Schleusen (seit 2016) mitte-rechts im Bild, „alte“ Schleusenkammern mitte-links. Gut erkennbar die grossen Vorratsbecken für Schleusungswasser bei den neuen Schleusenkammern (Bildquelle:GOOGLE EARTH)

Das ist, man muss es ausdrücklich betonen, also kein Klimaproblem … sondern „man made“. Wie die Abb. 11 zeigt, hat man bereits ganz bewusst die neuen Schleusen des Panamakanals mit deutlich grösseren Vorratsbecken für Schleusungswasser ausgestattet. Auch ein „Recycling“ von Wasser ist durch eine neue Technik eingeführt worden. Allein die Grössenverhältnisse der Schleusenkammern, die einem schon mit einfachem vergleichenden Blick zwischen „altem“ und „neuem“ Bereich in´s Auge springen (siehe Abb. 11), lassen ahnen, welche Volumina an Wasser täglich benötigt werden … auch in den natürlichen jährlich wiederkehrenden Trockenphasen der Monate Januar bis April. Mit anderen Worten: Die Anzahl der tatsächlichen Schleusungen während der Trockenzeit kommt an die Grenzen der Wasserbereitstellung bzw. der Wasserstand im Gatunsee (dem Lieferanten des Schleusungswassers) sinkt markant ab. Da trägt, nochmals gesagt, der „Klimawandel“ keine Schuld … .

Aber der Hinweis in den DWN, dass nun „nur drei Jahre später (…) bereits weitere Modernisierungen in Form eines dritten Seesnotwendig (sind)“ lässt immerhin aufhorchen: Genau dies ist nämlich nichts anderes als ein Eingeständnis der Kanalverwaltung, dass die Wasserreservoirs in der Praxis nicht ausreichen … jedenfalls in den üblichen (!) Trockenzeiten des tropischen Panamaischen Klimas nicht, während der Regenzeit besteht ohnehin kein Problem.

Leider ist der Hinweis auf aktuelle Nutzungseinschränkungen des Panamakanals, die mit dem Bau der neuen Schleusen verbunden sind, offenbar nur von BLUEWIN übernommen worden. Alle deutschsprachigen Berichte entstammen gemeinsam einem einzigen AP-Bericht von Juan Zamorano und Arnulfo Franco. Die Autoren haben zwar, wie es aussieht, tatsächlich auch auf das Problem der vergrösserten Schleusenvolumen hingewiesen, wenn auch nur nebenbei. Vom AP-Gesamttext übernommen haben jedoch nahezu alle Presseorgane (einschliesslich der DWN, dem ZDF u.a.) ausschliesslich das Thema „Klimawandel“ … und das ist im Sinne der Kanal-Probleme irrelevant!

Fairerweise muss man sagen, dass zumindest der Fachinformationskanal THB (Täglicher Hafenbericht, https://www.thb.info/rubriken/single-view/news/wassermangel-im-panamakanal.html) nicht in die Spekulationen einstimmt, sondern nüchtern über unzureichende Wasserversorgung bzw. die Passageeinschränkungen beim Panamakanal berichtet, ohne hierfür den Klimawandel verantwortlich zu machen. Auch RAonline berichtet, ohne den Klimawandel anzuführen, über das El Nino-Phänomen, welches zu verringerten Niederschlägen in Panama führt (https://www.raonline.ch/pages/edu/st4/wawakanal03a6.html ).

Dennoch ist dies alles ein zum Nachdenken anregendes Fallbeispiel, da die allermeisten Presseorgane ungeprüft einen AP-Bericht übernommen haben, der primär den Klimawandel als Grundlage einer Bedrohungsthese sieht … auf die Fehlplanung, die bei „mehr“ Schleusen aber gleicher Wassermenge ein „weniger“ an Schleusungskapazität in Trockenzeiten ergibt, hat niemand bzw. einer und dort auch nur sehr, sehr versteckt hingewiesen.

´Fake news´ sind nicht zwingend immer böse Absicht, oft sind sie schlicht und einfach unzureichender bzw. (auch schon mal bewusst?) einseitiger Recherche geschuldet.

Fazit

Was bleibt vom Bericht „Beschränkungen für die Schifffahrt – Klimawandel ist Bedrohung für den Panamakanal“? Es ist die Feststellung, dass nicht nur (aber auch) die DWN offenbar einer (zumindest) oberflächlichen Recherche Platz gegeben haben. Man ist sogar versucht „Fake news“ dazu zu sagen.

Woher auch immer die Neigung selbst eigentlich als seriös einzustufender Medien kommt, dem Schlagwort Klimawandel aufgeregt aber faktenarm hinterher zu laufen, bleibt der Spekulation eines jeden überlassen. Tatsache ist jedenfalls, dass zumindest der Zustand von „Wetter“ und Klima im Bereich des Panamakanals keinerlei Anlass zur Sorge bietet.

Fakt ist ohne Frage, dass weltweit Handelskonflikte, manche würden sogar Handelskriege dazu sagen, stattfinden. Den vermeintlichen oder echten wirtschaftlichen und politischen Gegner dabei zu täuschen oder zumindest gehörig zu verwirren gehört zu diesen Auseinandersetzungen dazu. Selbst scheinbare Randdaten können hierbei eingesetzt werden … auch beim Klima handelt es sich inzwischen um einen Faktor, der strategisch genutzt werden kann bzw. der tatsächlich auch gezielt eingesetzt wird.

Einen interessanten Hinweis darauf, dass diese Aussage nicht aus der Luft gegriffen ist, liefert ein aktueller Artikel aus SPON (Spiegel-online, https://www.spiegel.de/politik/ausland/klimawandel-wettlauf-um-erdgas-oel-und-seltene-erden-in-der-arktis-a-1274371.html ) vom 27.Juni 2019, der sich mit dem Klimawandel (sic!) und den Perspektiven einer zukünftigen Befahrbarkeit der arktischen Nordroute (Nordwestpassage) beschäftigt. Hier heisst es u.a.: „Die langfristige Strategie Russlands besteht darin, diese arktische Wasserstraße zu nutzen, um seine Rohstoffe ganzjährig nach Europa zu schaffen“ und, das sei angemerkt, darüber hinaus einen Seeweg als Ersatz bzw. Ergänzung für die Routen anzubieten, die bisher den Panamakanal bzw. den Suezkanal durchfahren.

Weiter schreibt SPON:

„Das bedeutet sicherlich nicht, dass der (Panama)Kanal durch die konkurrierende Route am Pol in absehbarer Zeit bedeutungslos würde“.

Man ist hier geneigt einzufügen „Nein, aber “. Man darf sicher feststellen, dass es durchaus dem einen (Staat) oder anderen (Handelsorganisation) gut zu Pass käme, sollte der Panamakanal z.B. aus „klimatischen“ Gründen an Reputation verlieren … mögen ´Düren´ und steigende Temperaturen dem Panamakanal schaden, für den arktischen Seeweg wäre ein „Klimawandel“ gewiss sehr nützlich.

Man kann es beklagen, aber, zum ersten genannt, verwenden ganze Länder den vermeintlichen Klimawandel (und die angeblich dadurch entstehenden Schäden an Natur und Gesellschaft) auch, um einem breiten aber uninformierten Publikum vorzuhalten, es kümmere sich offenbar keiner genügend um die „belasteten“ Länder dieser Welt.

Zum zweiten setzen viele Länder den sogenannten Klimawandel ganz gezielt ein, um zu demonstrieren, dass es in diesem angeblichen Desaster ohne die finanzielle Unterstützung der wohlhabenden Europäer ganz einfach „nicht geht“ … auch ein Panamakanal kann danach quasi zusammenbrechen und Wirtschaftswege verelenden, wenn man ´den´ Klimawandel nicht berücksichtigt. Aber wer zahlt den Preis dafür … denn ´kosten´ tut es ganz gewiss!?

Zum dritten haben auch Unternehmen, nicht nur aber vor allem auch die weltweit vernetzten, erkannt, dass mittels Klimawandel-Argumenten Profite generiert werden können, die man ansonsten vielleicht nicht einbringen könnte … zumindest alles das, was aufgrund eines angeblichen Klimawandels sozusagen unvermeidbare zusätzliche Kosten verursacht, kann man mit dem Argument „wir geben nur weiter, was die Gesellschaft auf dem Gewissen hat“ in die Kalkulationen einpflegen.

Das ist nützlich … und die Leser von DWN/ZDF u.a. sind in diesem Sinne ´nützliche Idioten´ (Lenin zugeschrieben)? ´Fake news´ als Mittel zum Zweck? Aber vielleicht ist alles auch viel trivialer: Schlechte Recherche bei unkritisch übernommenen Agentur-Artikeln, hier von AP: Auch so kommen Artikel zustande, die mehr Schaden anrichten als Nutzen bringen.

Für seriöse Unternehmen, seien es Reedereien oder Handelsorganisationen, sollte jedoch gelten, sich auf wirklich belastbare Informationen zu stützen und politisch fehldeutbare Veröffentlichungen zumindest kritisch zu sehen bzw. diese, sachkundig unterstützt, zu hinterfragen. Die Tatsache, dass der „neue“ Panamakanal mit seinen deutlich grösseren Schleusenkammern (im Zusammenspiel mit den weiter in Betrieb stehenden alten Schleusen) auch erheblich mehr Wasser verbraucht, sollte nicht vergessen gehen. Hierauf hinzuweisen wäre Pflicht einer seriösen Veröffentlichung. Das die DWN wie auch fast alle anderen deutschsprachigen Publikationen versäumt haben, den offenbar von AP (Associated Press, New York) stammenden Grundbericht zu prüfen, ist kein Ausweis von gutem Journalismus.

Dr. Hans-J. Dammschneider

IFHGK

Über das IFHGK

(Inst. f. Hydrographie, Geoökologie und Klimawissenschaften; Aegeri/Zug, Schweiz; www.ifhgk.org ):

Das IFHGK steht für Rückfragen gerne zur Verfügung. Bitte nehmen Sie bei Interesse am Thema oder an einer individuellen Beratung Kontakt mit uns auf. Das Institut arbeitet frei von jedweder politischen Einflussnahme. Allein auf Basis gesicherter wissenschaftlicher Daten bzw. anerkannter internationaler Veröffentlichungen übernimmt das IFHGK auf Wunsch Aus- und Bewertungen für hydrographische, geoökologische sowie klimatologische Fragen, die sich beispielweise im Rahmen von Unternehmensstrategien stellen oder auch nur der Suche nach praktischen Lösungen innerhalb von Wirtschaftsvorgängen entstammen bzw. einer eventuell notwendigen vorausschauenden „Beweissicherung“ dienen. Wir sind eine nonprofit-Organisation und arbeiten unabhängig von staatlichen sowie unternehmerischen Einflüssen und Interessen. Das IFHGK finanziert sich allein aus Mitgliederbeiträgen und Spenden.

Senden Sie uns eine email über dr.dammschneider@ifhgk.org , wir werden Ihnen antworten!

Der Beitrag erschien zuerst bei die kalte Sonne hier