Der Kohlendioxid-Hoax!?

von Dipl-Soz. Michael Klein, Sciencefiles

Wann immer Kritik an dem zur Wahrheit erklärten Ergebnis, in Bausch und Bogen verdammt wird, Kritiker lächerlich gemacht werden, ihnen die „Verschwörungstheorie“ entgegen geschleudert wird, sie zum Outcast gemacht werden, der den angeblichen wissenschaftlichen Konsens ignoriert, dann sind Vorsicht und Skepsis gefordert.

Wann immer Politiker sich auf wissenschaftliche Ergebnisse stürzen, diese Ergebnisse in ihre Ideologie inkorporieren und sie ins Feld führen, um die Lauterkeit und die Gutheit der eigenen Ideologie und daraus folgenden Absichten zu belegen, sind nicht nur Vorsicht und Skepsis gefragt, was gefragt ist, mehr denn je, ist die Prüfung der angeblichen Wahrheit.

Die Begründungen für diese drei simplen Regeln sind einfach:

Wissenschaft findet keine Wahrheit. Das Beste, was es geben kann, sind gut bestätigte Theorien, auf denen man sich aber nicht wirklich ausruhen kann, wie man am Beispiel der Äthertheorie schnell sehen kann. Kaum ein Physiker des 18. Jahrhunderts hätte an der Äthertheorie gezweifelt. Licht war erstmals als elektromagnetische Welle beschrieben worden. Die Wellentheorie verlangte, dass Wellen sich durch ein Medium verbreiten, ergo musste sich auch Licht durch ein Medium verbreiten: den Äther. Und dann kamen Albert A. Michelson und Edward E. Morley und haben die Äthertheorie in Experimenten als falsch erwiesen.

Wissenschaft findet keine Wahrheit. Das Beste, was es geben kann, sind gut bestätigte Theorien, auf denen man sich aber nicht wirklich ausruhen kann, wie man am Beispiel der Äthertheorie schnell sehen kann. Kaum ein Physiker des 18. Jahrhunderts hätte an der Äthertheorie gezweifelt. Licht war erstmals als elektromagnetische Welle beschrieben worden. Die Wellentheorie verlangte, dass Wellen sich durch ein Medium verbreiten, ergo musste sich auch Licht durch ein Medium verbreiten: den Äther. Und dann kamen Albert A. Michelson und Edward E. Morley und haben die Äthertheorie in Experimenten als falsch erwiesen.

Deshalb ist es wichtig, dass Wissenschaftler selbst dann, wenn Sie denken, eine gut bestätigte Theorie gefunden zu haben, versuchen, die Theorie zu widerlegen. Nur so funktioniert Erkenntnisfortschritt. Nur so kann man falsche Theorien ausmerzen. Deshalb ist es unglaublich und mit wissenschaftlicher Erkenntnissuche nicht vereinbar, wenn Wissenschaftler oder Forscher, die nachvollziehbare und begründete Zweifel an einer vom Mainstream als gut begründet angesehenen Theorie anmelden, ausgegrenzt werden, lächerlich gemacht werden, als Häretiker abgestempelt werden. Und es ist vor allem seltsam, denn: Wenn die so gut bestätigte Theorie tatsächlich so gut bestätigt ist, wie behauptet, dann sollte es ein Leichtes sein, Kritik als falsch auszuweisen, sie zu widerlegen. Warum sollte man einen Angriff auf die Person des Kritikers starten, einen ad-hominem-Fehlschluss begehen, wenn man sicher ist, im Besitz der besseren Theorie zu sein?

Schließlich ist es mit Wissenschaft überhaupt nicht zu vereinbaren, wenn ihre Ergebnisse nicht nur zur Wahrheit erklärt, sondern in politische Ideologien eingebaut und entsprechend missbraucht werden. Fast immer, wenn Politiker sich wissenschaftlicher Erkenntnisse bemächtigen, ist der Missbrauch gewiss. Erst wird die Theorie als Teil der eigenen Ideologie inkorporiert, dann wird sie zur Grundlage des gesellschaftlichen Heils erklärt, das die Politdarsteller gleich welcher Couleur zu bringen versprechen, dann werden Maßnahmen umgesetzt, Strukturen und Netzwerke der gegenseitigen Abhängigkeit geschaffen und am Ende ist eine Industrie vorhanden, deren Mitglieder ausschließlich auf Grundlage angeblicher wissenschaftlicher Ergebnisse stehen und dafür von Steuerzahlern fürstlich entgolten werden. Die Global Warming / Klimawandel-Industrie wurde bereits 2015 von der Washington Post als 1,5 Billionen US-Dollar: 1.500.000.000.000 US-Dollar-Industrie geschätzt.

Wenn sich derart immense wirtschaftliche Interessen mit einer angeblichen wissenschaftlichen Wahrheit verbinden und die angebliche wissenschaftliche Wahrheit, in deren Besitz man sich wähnt, zur Grundlage von inszenierten Kampagnen wie z.B. #FridaysForFuture oder dem Global Warming-Konferenz-Tourismus wird, wenn die angebliche wissenschaftliche Wahrheit genutzt wird, um Medien gleichzuschalten und eine öffentliche Mainstream-Meinung zu inszenieren, die jeden der zweifelt, zum Irren oder zum Verschwörungstheoretiker oder zu beidem erklärt, dann müssten bei Wissenschaftlern eigentlich alle Alarmglocken läuten, vielleicht tun sie das auch, aber das führt bei den meisten nicht dazu, dass sie das, was zwischenzeitlich Wahrheit geworden sein soll, obwohl es nur ein sehr wackeliges Ergebnis ist, das auf einer Vielzahl von Annahmen und Ausblendungen basiert, nicht in Frage stellen, hat mehrere Gründe:

Erstens sind Wissenschaftler sehr zurückhaltend, wenn Forschungsergebnisse die Gefahr mit sich bringen, ihre früheren Forschungsergebnisse in Frage zu stellen. Die meisten wollen sich nicht selbst korrigieren.

Zweitens sind Wissenschaftler, die in einem Bereich arbeiten, der zur Mainstream-Wahrheit erklärt und zum Bestandteil politischer Ideologie geworden ist, in der Regel so tief in Netzwerke verstrickt, profitieren so sehr von ihrer regelmäßigen Bestätigung der angeblichen Wahrheit, dass auch ökonomische Gründe der wissenschaftlichen Lauterkeit entgegen stehen.

Drittens sind Wissenschaftler zumeist in öffentlichen Institutionen angestellt, die von genau den Politdarstellern abhängig sind, die in z.B. der Wahrheit des Global Warming schwelgen. Kritik bringt sie nicht nur in Gegensatz zu diesen, sie schafft auch die Möglichkeit für den opportunistischen Rest der wissenschaftlichen Konkurrenz, sich im Kampf um Professuren oder öffentliche Fördergelder einen Vorteil durch Anbiederung zu verschaffen.

Das alles sind Strukturen, die der Wissenschaft schaden.

Nicht nur aus diesem Grund haben wir uns entschlossen immer einmal wieder Wissenschaftler zu Wort kommen zu lassen, die eine andere Sicht auf das haben, was zur Wahrheit erklärt wurde. Schließlich ist auch das geozentrische Weltbild lange Zeit als Wahrheit verkauft, seine Kritiker zuweilen verbrannt worden. Und wo wären wir heute, ohne mutige Männer wie Galileo Galilei.

Im Folgenden präsentieren wir ein Video von Ben Davidson, den man als Erich von Däneken der Klimaforschung bezeichnen könnte. Und so wie von Däniken mit seinen Ideen die Vertreter der Archäologie wieder und wieder in Erklärungsnot bringt, so bringt Davidson diejenigen, die die Theorie des Global Warming als Wahrheit ausgeben und CO2 zum Todbringer des Planeten erklärt haben, in Erklärungsnot. Das folgende Video ist leider in englischer Sprache. Vielleicht finden wir in absehbarer Zeit eine Möglichkeit, es zu übersetzen.

Bis dahin wollen wir denjenigen, die der englischen Sprache nicht mächtig sind, zumindest das Folgende mit auf den Weg geben.

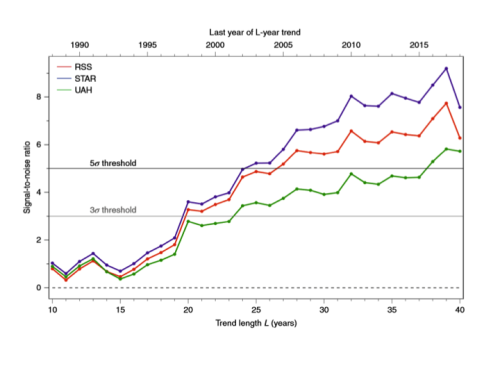

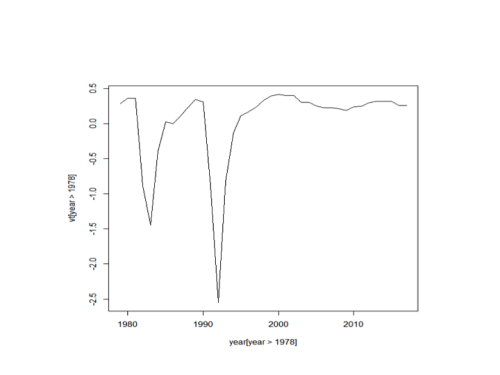

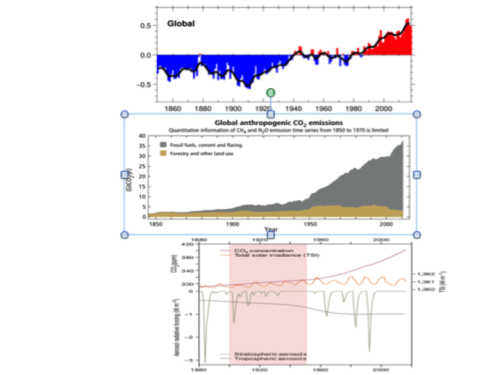

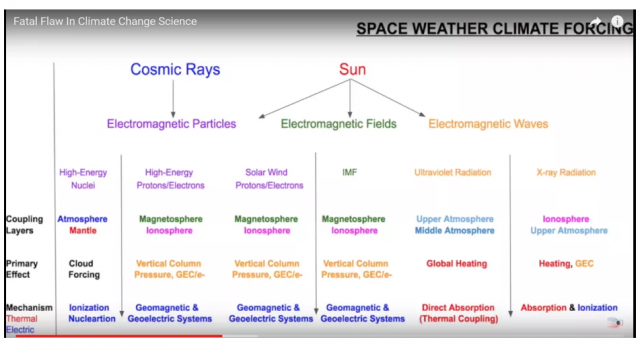

Links sehen Sie die von der Sonne ausgehenden Einflüsse auf das Erdklima, die in den herkömmlichen Klimamodellen berücksichtigt werden.

Rechts sehen Sie die entsprechenden Einflüsse, von denen ein belegter Effekt auf das Klima der Erde ausgeht.

Der Unterschied ist frappierend und erklärungsbedürftig. Vor allem ist erklärungsbedürftig, warum Effekte, die von der Sonne ausgehen, von Sonnenstürmen oder vom Sonnenwind, in herkömmlichen Klimamodellen zu menschengemachten Effekten werden, die Global Warming hervorbringen.

Wenn man das Video von Davidson gesehen hat, dann kann man den Eindruck gewinnen, Global Warming und die derzeitige Hatz auf CO2 sei ein großer inszenierter Hoax. Aber sicher werden Mainstream-Wissenschaftler erklären, warum die ARGUMENTE, die Davidson vorbringt, FALSCH sind, sofern sie Wissenschaftler sind, die sich der wissenschaftlichen Methode bedienen, die es vorsieht, Kritik zu prüfen und ihr argumentativ zu begegnen, was diejenigen, die Kritik wie die von Davidson in Bausch und Bogen als Verschwörungstheorie oder was auch immer abtun wollen, erstens als Nicht-Wissenschaftler ausweist und zweitens als armselige Gläubige, die ihren Glauben nicht einmal gegen einfach Argumente wie die, die Davidson vorbringt, verteidigen können.

Wohlgemerkt, wir sprechen hier von Wissenschaftlern, nicht von Aktivisten oder Politikdarstellern, die in der Regel eine Kompression nicht von einer Regression unterscheiden können und bar jeder Idee sind, was in einem Klimamodell eigentlich passiert, was wie berechnet wird.

Und nun viel Spaß mit Ben Davidson (und wir sind schon gespannt auf die Erklärungen dafür, warum das alles falsch ist/sein soll).

Mit freundlicher Genehmigung von Sciencefiles.