Der größte Teil Deutschlands ist für die Windkraftnutzung ungeeignet.

Das ist ein weiteres unbeeinflussbares Problem, das von der Geographie Deutschlands bestimmt wird:

Schon in den vergangenen Jahren hatten Windparkbetreiber schmerzlich erfahren müssen, dass die ihnen von viel zu optimistischen Gutachten über die „Windhöffigkeit“ eines Standortes prophezeiten Erlöse ihrer Windräder nicht eintraten und statt dessen Verluste zu verzeichnen waren (9)..

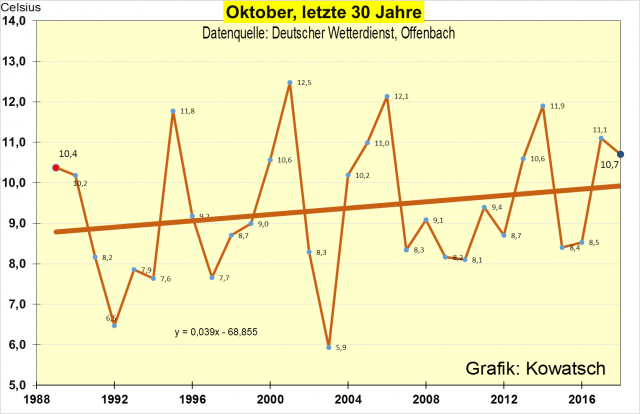

Wenn man das Windangebot in Deutschland betrachtet, zeigt sich die für jeden ohnehin klare Situation, dass im Norden größere Windstärken zu verzeichnen sind. Keine Frage, dass sich diese Tatsache auf den Stromertrag und damit auch auf die Rentabilität von Windparks auswirkt. Die Regierung hat das zum Anlass genommen, die Fördersätze für ungeeignete Windenergie-Standorte zu erhöhen.

Zusammen mit den „negativen Strompreisen“ (Zuzahlungen für den Export von bereits teuer subventioniertem Überschuß-Windstrom an Abnehmer in Nachbarländern) hat Deutschland damit den planwirtschaftlichen Irrsinn in ein selbst in den ehemals sozialistischen Ostblockländern nie gesehenes Extrem weiterentwickelt.

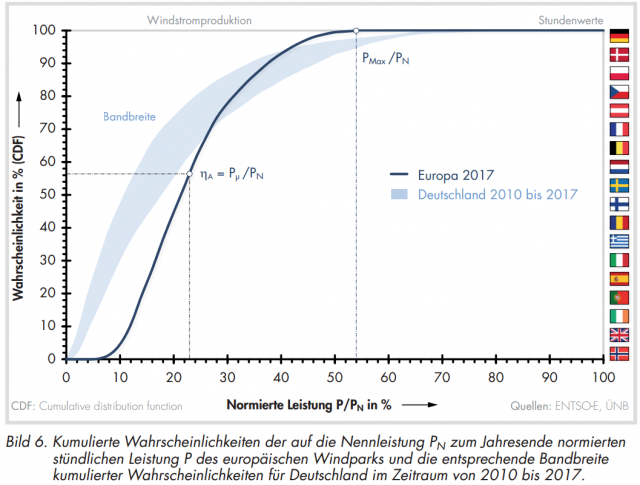

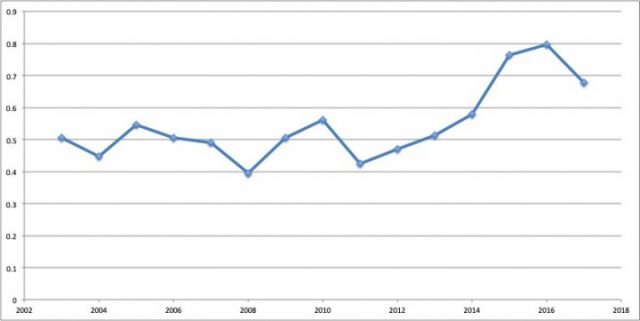

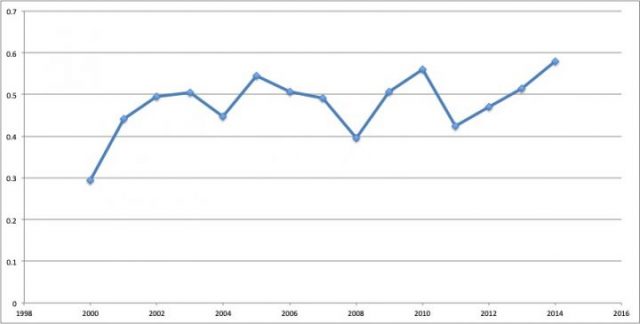

Die Zahlen der mittleren Windgeschwindigkeiten in Deutschland zeigen sowohl den sehr deutlichen Unterschied zwischen den nördlichen und südlichen Bundesländern, aber auch die ebenfalls deutlichen Unterschiede zwischen den „Windjahren“, die gelegentlich zu frustrierenden Windstrom-„Ernten“ führen. Sie vermitteln jedoch noch eine für Investoren weitaus wichtigere Information, wenn man die Feststellung des Deutschen Windenergieinstituts Wilhelmshaven (DEWI) beachtet, die auf umfangreichen Untersuchungen basiert:

Die Schwelle zu einer wirtschaftlichen Nutzung der Windenergie liegt bei ca. 2.000 Volllaststunden oder bei einem sich daraus ergebenden Auslastungsgrad von 22,8 Prozent. Das bedeutet, dass sich die Windstromerzeugung nur im hohen Norden Deutschlands ohne Subventionen rentiert – und das auch nur in guten bis mittelguten Windjahren.

Ein klares Bild von dieser Situation vermitteln die jährlich vom BDEW (Bundesverband ser Energie- und Wasserwirtschaft) unter der Überschrift „BDEW-Energie-Info: Erneuerbare Energien und das EEG“ veröffentlichten .Grafiken und Tabellen. Aus den Darstellungen der Windstromerträge – gemessen in Jahresvolllaststunden (Definition siehe unter (11)) – in den Bundesländern erkennt man gut das Gefälle des nutzbaren Windangebots von Nord- nach Süddeutschland.

Aus diesen BDEW-Berichten für die Jahre 2014 und 2015 werden hier die höchsten und die niedrigsten Zahlen der erreichten Jahresvolllaststunden vorgestellt:

2014: 1934 h in Schleswig-Holstein; 1171 h in Bayern = 61%

2015: 2003 h in Mecklenburg-VP; 1362 h in Baden-Württemberg = 68%

Das bedeutet:

– Die mindest-notwendige Zahl von 2000 h wird nur in den nördlichsten

Bundesländern knapp erreicht – und das auch nicht in jedem Jahr.

– In der südlichen Ländern ist der Ertrag 30 -40% niedriger als im Norden.

Die Unrentabilität von Windparks ist dort garantiert. Deshalb hat die Regierung

für die unrentablen Standorte höhere Subventionen beschlossen.

– Weil ein Jahr 8760 Stunden hat, bedeuten die genannten Zahlen, dass die

Windräder zwar respektable Maximalleistungen haben, diese aber im realen

Betrieb niemals oder allenfalls kurzzeitig bei Starkwind erreichen – und statt

dessen nur einen geringen Bruchteil ihrer installierten Leistungsfähigkeit

nutzen können. Und bei wenig Wind oder Flaute nutzlos (aber keineswegs

kostenlos) in der Landschaft stehen.

Deutschland ist nun einmal ein sehr ungeeigneter Standort für Windenergieanlagen, was man aber schon immer wusste.

Die Folge: Ein großer Teil der Windparks ist unrentabel.

Es ist das Verdienst des Bundesverbands WindEnergie BWE, gründlich der Frage nachgegangen zu sein, ob sich eine Investition in Windparks selbst mit Subventionen überhaupt lohnt und welche Risiken auf Anleger lauern. Der BWE ist eine Windkraft-Lobby, steht aber klar auf der Seite der Investoren von Windparks – oft Kommunen und Stadtwerke – und weniger auf der Seite der WKA-Hersteller, der Fondsmanager, der Berater, der Reparaturbetriebe und der Verpächter der Standortflächen.

Der BWE hat mehr als 1200 Jahresabschlüsse von Windparks in einem Zeitraum von 13 Jahren verglichen. Sein Fazit: Mehr als zwei Drittel der Windparks im Binnenland machen Verluste – trotz der Subventionen.

Dazu erklärte der stv. Vorsitzende im Anlegerbeirat des BWE Dr. Christian Herz:

„80 Prozent der deutschen Land-Windparks sind defizitär. Völlig überhöhte Windprognosen. Das bedeutet, es ist zu wenig Geld da, gleichzeitig ist die Anlagetechnik in einem Großteil der Anlagen und Projekte so schlecht, dass die Reparaturkosten-Ansätze verdoppelt bis verdreifacht werden müssen – und das bei der Masse im jetzt achten bis zwölften Betriebsjahr, und sie sollten ja eigentlich 20 Jahre halten.“(10).

In einem „Ratgeber für Windpark-Anleger“ (9) haben Werner Daldorf und weitere 6 BWE-Vorstandsmitglieder eine sehr harte Kritik an den Praktiken der Windkraft-Fonds publiziert, in dem alle Tricks und Täuschungen beschrieben werden, mit denen die Anleger in äußerst verlustreiche Investitionen hineingelockt werden.

Zitate: „Es darf nicht übersehen werden, dass es in deutlichem Umfang Fonds gibt, die sich inzwischen als Finanzdesaster entpuppen. Von der angestrebten Zielrendite aus bestimmte Überbewertungen der Windertragspotentiale, oft unausgereifte Anlagentechnik und zu niedrig angesetzte Wartungskosten, völlig überzogene weiche Kosten (Provisionen, Aufschläge, usw.) und nicht selten ein inkompetentes und wenig engagiertes oder gar trickreich-unredliches Management ernüchtern den Anleger zunehmend.“

Es gibt eine Reihe von Stadtwerken, die von den Rathauspolitikern ihrer Kommunen gezwungen wurden, in Windparks zu investieren, weil sie dann Ökostrom anbieten könnten. Über die damit erlittenen hohen Verluste spricht man ungern.

Diese Warnungen stammen noch aus der Zeit, als die Ausschreibungsverfahren zwar diskutiert wurden, aber noch nicht eingeführt waren.

Und schließlich ein weiteres ernstes und vermutlich kaum vermeidbares Problem – außer, man verzichtet auf den Einsatz dieser Technik:

Negative Auswirkungen auf die Umwelt und auf die Menschen wurden ignoriert – jedoch nicht von den Betroffenen

Dass Aktivitäten der Wirtschaft Auswirkungen auf die Umwelt haben und auf der Grundlage von Umweltgesetzen auch Konsequenzen für die Akteure, ist nicht neu. Wenn eine Industriebranche wie die Hersteller von Windenergieanlagen durch die Errichtung und die Anwendung ihrer Produkte zwangsläufig und teilweise sogar unvermeidlich in mehrfacher Hinsicht negative Auswirkungen auf die belebte wie auch die unbelebte Umwelt verursachen, dann gehört diese Thematik zu der Gruppe ihrer prioritär anzugehenden Aufgaben.

Die Auswirkungen von Windenergieanlagen auf die Umwelt:

1. Schall- und Infraschall-Emissionen und deren gesundheitliche Auswirkungen

Es genügt nicht, umweltpolitische Entscheidungen zu kritisieren wie es der BDEW-Chef Kapferer in seiner Beurteilung der 10H-Abstandsregel in Bayern getan hat und vor einer Anwendung ähnlicher Regeln in anderen Bundesländern zu warnen. In seiner Presseinformation vom 24.8.2017 argumentiert er allein damit, dass diese Regel „zu einem faktischen Ausbaustopp der Windenergie in Bayern“ geführt habe.

Dass diese Entscheidung der bayrischen Staatsregierung eine Reaktion auf die anhaltenden Protestaktionen der zahlreichen Bürgerinitiativen war und dass diese Bürger ihre Gründe dafür hatten, wird nicht kommentiert. Die Bewertung der Abstandsregelung durch Herrn Kapferer als „politischer Spielball“ sagt aus, dass er diese von der Landesregierung getroffene Entscheidung als Spielerei von Berufspolitikern betrachtet.

Die ernsten Gründe für die Bürgerproteste sind bequem zu erfahren. Wer sich darüber informieren möchte, findet eine große Fülle an seriösen Fachartikeln und Studien, die die Auswirkungen von Windrädern und vor allem von Anlagen-Gruppen (Windparks) auf Menschen, aber auch auf geschützte Tierarten behandeln.

In Dänemark hatten Vorfälle, bei denen Anrainer von Windenergieanlagen über gesundheitliche Probleme berichteten, bereits 2013 eine von der Regierung veranlasste umfangreiche experimentelle Untersuchung ausgelöst, die vom Kopenhagener Krebsforschungsinstitut „Kraeftens Bekaempelse“ durchgeführt und Anfang 2018 abgeschlossen worden ist. Im Kürze soll die akademische Kontrolle (Peer Review) abgeschlossen sein. Dann folgt die Veröffentlichung, die auch in Deutschland von Kommunen und auch von Bürgern in den Windkraftgebieten mit Spannung erwartet wird. Anders als in Deutschland erlauben die recht weit gefassten dänischen Datenschutzgesetze eine auf jede einzelne Windturbine bezogene Auswertung persönlicher medizinischer Daten der Anwohner.

Die öffentliche Debatte dürfte dann sehr lebhaft werden, auch in unserem Land (18).

2. Windräder in Wäldern

Die verstärkte Errichtung von Windrädern in Wäldern, die von mehreren Bundesländern erlaubt wird, ist die Folge von knapper gewordenen Standorten in Norddeutschland. Die Auswirkungen sind beträchtlich, weil die Größe dieser Anlagen die Rodung größerer Flächen für Zufahrten und für den Standort. notwendig macht. Mächtige Stahlbeton-Fundamente werden in den Waldboden gesetzt. Naturschützer beklagen die Tötung geschützter Greifvogelarten (Roter Milan) und ebenso von Fledermäusen.

Eine Entwicklung, die zahlreiche neue Anti-Windkraft-Bürgerinitiativen ins Leben gerufen hat. Der Antrag der FDP-Bundestagsfraktion richtet sich auf diese Auswirkungen (15).

3. Landschaftsbeeinträchtigung

Inzwischen gibt es viele Dokumentationen von Landschaften, die mit Windrädern „verspargelt“ sind. Viele Bürgerinitiativen sind aus diesem Grund entstanden. Über Erfolge bei der Verhinderung neuer Windparks wird im Internet berichtet – ein besonderes Erfolgserlebnis hatten die BI im Rheingau/ Hessen, wo mit einem jahrelangen Kampf die „Verschandelung“ des Rheingaus (darin die Region Lorch-Stephanshausen, die UNESCO-Weltkulturerbe ist) endgültig verhindert werden konnte.

- Enormer Flächenverbrauch

Jeder kann durch Betrachten der großen Kahlschlagsflächen in Wäldern den Zusammenhang von beanspruchter Landfläche in Relation zu der elektrischen Erzeugung eines Windrades berechnen.

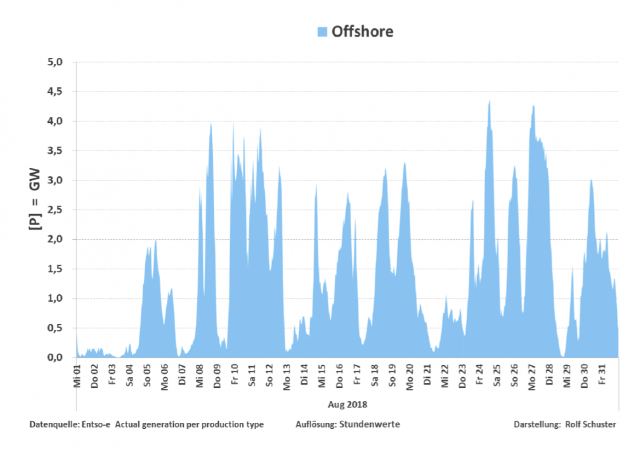

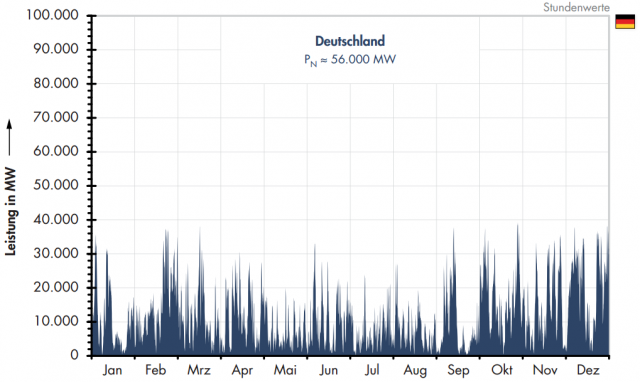

Die oben angegebenen, im Grunde deprimierenden Zahlen der Jahres-Volllaststunden von im Durchschnitt 1500h/a bei 8760 Stunden eines Jahres besagen, dass eine wetterabhängige Windkraftanlage, die 2 MW Maximalleistung hat, in einem Jahr so viel bzw. so wenig Strom liefert, wie ein dauerhaft arbeitendes Miniaturkraftwerk von 0,36 MW.

Bei einem Flächenverbrauch von 60×60=3.600 m2und dieser Leistung von 0,36 MW ergeben sich 100 Watt an mittlerer Leistung pro Quadratmeter.

Zum Vergleich: Ein 1000-MW Steinkohlekraftwerk mit einer Fläche von 300×300=90.000 m2hätte eine Leistungsdichte von 11.000 Watt pro Quadratmeter .

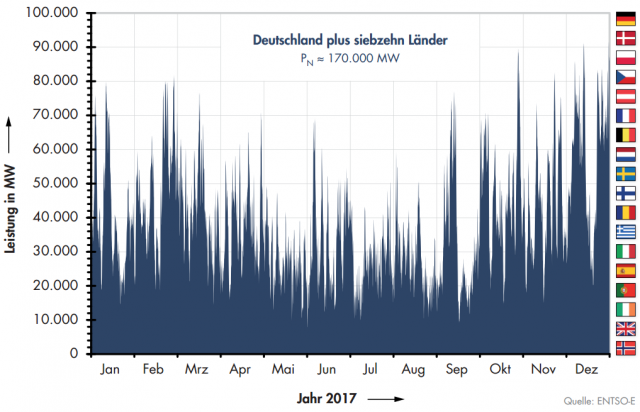

Um die durchschnittliche jährliche Stromerzeugung eines 1000-MW-Steinkohlenkraftwerks durch 2 MW-Windräder zu erreichen, müssten 2.800 dieser Anlagen errichtet werden. Die dann gleich große durchschnittliche Jahreserzeugung täuscht jedoch über den außerordentlich problematischen Nachteil für die Verbraucher hinweg: In Perioden geringer Windstärken, die häufig vorkommen (unter Windstärke 3), stehen sämtliche Windräder still.

Wenn die Verbraucher dann überhaupt noch Strom geliefert bekommen, stammt der aus sog. konventionellen Kraftwerken.

Diese 2.800 Windräder benötigten – verglichen mit dem Kohlekraftwerk – das 110-fache an dessen Flächenbedarf.

Und dann müsste noch der notwendige Abstand der Wohnhäuser zu diesen Windenergieanlagen einbezogen werden.

5. Was geschieht mit stillgelegten Windrädern?

Wenn nach 20 Jahren die Förderung tausender älterer Anlagen ausläuft, stellt sich vor allem die Frage, wie man mit den Betonfundamenten umgeht. Die Betreiber sind zu einem vollständigen Abbau auch dieser Fundamente verpflichtet. Im Internet wird über Fälle berichtet, wo die Eigentümer der Standortflächen gegen Bezahlung auf den kompletten Rückbau verzichten und mit einer Entfernung nur der oberen 1 Meter-Schicht der Betonmassen einverstanden sind. Ob diese Vorgehensweise zulässig ist, wird wohl erst noch geklärt.

Der Widerstand gegen neue Windkraftanlagen hat die Parteien erreicht.

Es hat einige Zeit gedauert, bis die Politiker – insbesondere Landespolitiker – auf den inzwischen mächtigen Widerstand von inzwischen über 1000 Bürgerinitiativen gegen die Errichtung von Windrädern in ihrer Region reagierten. Wie bereits berichtet wurde, gab es im Zusammenhang mit der beabsichtigten Einführung der oben erwähnten Sonderabschreibungen einen Widerstand von zwei SPD- und CDU- geführten Ländern sowie von der FDP-Fraktion im Bundestag, in dem als Voraussetzung ihrer Zustimmung Änderungen für das gesamte bisherige Genehmigungsverfahren für die Errichtung von Windkraftanlagen gefordert wurden:

– In der Bundesratsinitiative von Brandenburg wurde vom Ministerpräsidenten Dietmar Woidke gefordert, dass die im Baugesetzbuch verankerten baurechtlichen Privilegierungen von Windenergieanlagen im Außenbereich abzuschaffen sind.

– Auch der Vorsitzende der CDU/CSU-Mittelstandsvereinigung und stv. Fraktionsvorsitzender Carsten Linnemann schloss sich dieser Forderung an – und verlangte „einen besseren Ausgleich zwischen der Erneuerten-Branche und den Anwohnerinteressen. Wir sprechen hier insbesondere über Mindestabstände zur Wohnbebauung und über ein Ende der nächtlichen Dauerbefeuerung von Windrädern.“

– NRW strebt mit seiner Bundesratsinitiative die Wiederauflage der sogenannten Länderöffnungsklausel an, nach der jedes Bundesland eigene Abstandsregelungen (zu einer Wohnbebauung) für Windräder einführen könnte.

– Die Bundestagsfraktion der FDP brachte am 26.9.18 den Antrag ein (15), den Stopp der Rodungen in Wäldern, die sowohl für die Schaffung von Freiflächen für Windturbinen als auch für das Schlagen von Schneisen für den Transport des Baumaterials sowie der Kräne und Maschinen benötigt werden. Ferner wird die Bundesregierung in dem Antrag aufgefordert, einen Gesetzentwurf vorzulegen, der Waldflächen, Nationalparke, Naturschutzgebiete und Biosphärenreservate als Standorte von Windenergieanlagen dauerhaft ausschließt. Ferner sollten Abstandsgrenzen zu Brutstätten und Nahrungshabitaten gefährdeter Vogelarten verbindlich…,geregelt werden.

Der Industrieverband BDEW kritisiert die Länderinitiativen

Die Reaktion des BDEW auf die Bundesratsinitiativen von Brandenburg und Nordrhein-Westfalen ist in zwei Presseinformationen vom 24. August und vom 18. Oktober 2018 nachzulesen: https://www.bdew.de/presse/presseinformationen/

Beide Pressemitteilungen zitieren den Vorsitzenden der BDEW Geschäftsführung Stefan Kapferer.

Es folgen Zitate:

Zur:Presseinformation des BDEW vom 24.8.18

– Zur Forderung von MP Dietmar Woidke zur Abschaffung der Privilegierungen und zur Forderung vom Land NRW, die Länderöffnungsklausel wieder einzuführen (s.o.) äußerte sich Herr Kapferer wie folgt (Auszüge):

„Ohne die jetzigen Regelungen (Anm.: die Privilegierung betreffend) wären Windkraftprojekte zunächst automatisch unzulässig….Ohne die Privilegierung wären Windenergievorhaben im Außenbereich nur noch zulässig, wenn Kommunen entsprechende Flächen im Zuge der Bauleitplanung ausweisen. Projektierer müssten dann für jedes individuelle Projekt als Bittsteller an die kommunalen Verantwortlichen herantreten, um eine Flächenausweisung zu erwirken.Der Fortschritt der Energiewende wäre dann vom Gutdünken jeder einzelnen Kommune abhängig.“…

„Ebenso kritisch sehen wir die Forderungen, die Länderöffnungsklausel wieder aufzugreifen. Was diese Klausel verursacht, haben wir am faktischen Ausbaustopp der Windenergie in Bayern gesehen. Es ist schlichtweg bedenklich, dass die Abstandsregelungen zu einem politischen Spielball wurden, der bei jeder Landtagswahl neu gespielt zu werden scheint.“

(Unterstreichungen vom Autor G.K.).

Zur Presseinformation des BDEW vom 18.10.2018

Zur Befassung des Bundesrats mit den Länderinitiativen von Brandenburg und Nordrhein-Westfalen (s.o.) äußerte sich Herr Kapferer wie folgt (Auszüge):

„Die Bundesratsinitiativen der Landesregierungen von Brandenburg und Nordrhein-Westfalen laufen den energie- und klimapolitischen Anstrengungen zuwider und vergiften das Investitionsklima. Die Umsetzung der ‚10H-Regelung‘ in Bayern hat eindrücklich gezeigt, dass derartige Restriktionen den Erneuerbaren-Ausbau drastisch ausbremsen. Nun strebt NRW eine Wiederauflage der sogenannten Länderöffnungsklausel an, nach der jedes Bundesland eigene Abstandsregelungen für Windräder einführen könnte.“……

Zum Thema Abschaffung der Privilegierung im Baugesetzbuch wird ausgeführt:

„Ein noch drastischerer Einschnitt wäre mit der Abschaffung der baurechtlichen Privilegierung von Windenergieanlagen verbunden, wie sie das Land Brandenburg vorschlägt. Das würde zu einem abrupten Fadenriss bei der Neuaufstellung von Windrädern führen…..

Neue Restriktionen würden zudem die Bemühungen der Energiewirtschaft vor Ort umdie dringend benötigte Akzeptanz der Bevölkerung für den Windkraftausbau konterkarieren. Sie würden Protestbewegungen befeuern und ihnen ein politisches Gütesiegel aufsetzen.

(Unterstreichungen vom Autor G.K.)

Es ist anzunehmen, dass die Anti-Windkraft-Bürgerinitiativen diese klaren Äußerungen als durchaus hilfreich und eine Bestätigung für die Richtigkeit ihres Kampfes betrachten werden.

Aus diesen beiden Presseinformationen, die man sich von der Webseite des BDEW vollständig herunterladen und ausdrucken kann, sind mehrere grundsätzliche Argumentationslinien erkennbar:

1. Argumentationslinie Nr.1: Der BDEW unterstützt die Energiewendepolitik absolut, denn es ist nicht ein Hauch von Kritik erkennbar. Die beiden Länderinitiativen werden als gezielte Schädigung der Windkraftbranche bewertet („Fadenriss“) und mit deren auch stets von der Regierung betonten entscheidenden Wichtigkeit für die Energiewende stellen sie – in dieser Logik – einen Angriff auf die Energiewendepolitik der Regierung dar.

Diese derzeit von keinen Zweifeln getrübte eindeutige Unterstützung der Energiewendepolitik seitens des BDEW-Cefs stimmt allerdings nicht mit seiner Präsentation der von seinem Verband durchgeführten Untersuchung „Verfügbarkeit ausländischer Kraftwerkskapazitäten für die Versorgung in Deutschland“ vom 28.5.2018 überein, die er bei der Jahrestagung seines Verbandes vorstellte (16) und die anschließend in der Presse unter der Überschrift „„Die deutsche Energiewende verliert ihren Risikopuffer“ der Öffentlichkeit in deutlichen Worten erläutert wurde (17).

.

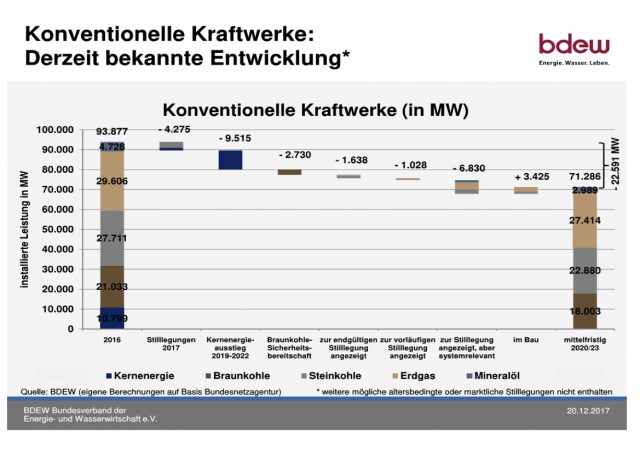

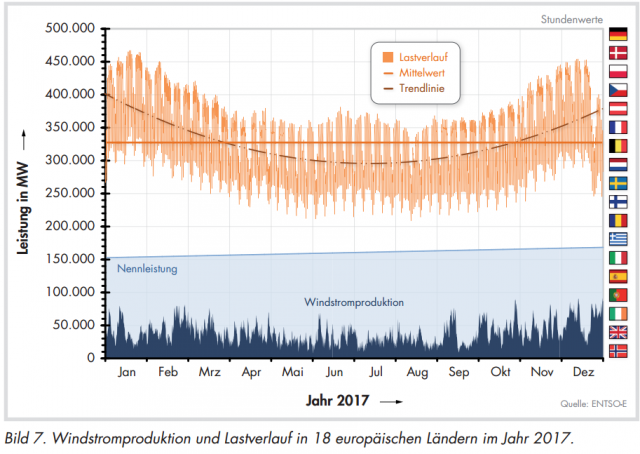

Diese Studie zerstörte die bis zu diesem Zeitpunkt von der Regierung, speziell vom BMWi, benutzte beruhigende Aussage, dass im Falle einer angespannten Situation (Sturm, Flaute, großer Wärmebedarf bei tiefen Temperaturen, Ausfälle von Kraftwerken, Schaltanlagen oder Leitungen) die Nachbarländer eine ausreichende Hilfe durch Stromexporte leisten könnten, weil sie angeblich über ausreichende Kraftwerks-Überkapazitäten verfügten. Die Untersuchung des BDEW auf der Grundlage der Daten der Organisation europäischer Netzbetreiber ENTSO-E belegte jedoch, dass es diese Überkapazitäten tatsächlich nicht gibt.

Die jahrelang verbreitete Falschmeldung sei angeblich ein „Rechenfehler“ um den Faktor 3 bis 4 (!) bei der Ermittlung der verfügbaren Reservekapazitäten gewesen, wie das Ministerium einräumte.

Dadurch haben die Beschwichtigungsversuche der Regierung hinsichtlich der Abwendung eines katastrophalen „Blackouts“ durch rettende Stromimporte aus unseren Nachbarländern ihr letztes Argument verloren.

Der BDEW unter der Leitung von Stefan Kapferer hatte damit der Regierung das einzige verbliebene und nun als grob unwahr festgestellte Ausrede- und Beschwichtigungsargument aus den Händen geschlagen.

Bei dieser verdienstvollen Aktion, die harte Entscheidungen der Netzbetreiber in kritischen Situationen zu untermauern hilft und die daher den Interessen der Verbandsmitglieder entsprach, hatte sich der Verbandschef nicht als ein Unterstützer der Energiepolitik erwiesen; sehr wohl aber als Verbandschef, der seine Aufgaben kennt. Das war im Mai. Und jetzt naht die von den Übertragungsnetz-Betreibern ungeliebte kritische Wintersaison mit Dunkelflauten, Redispatch-Aktionen und weiteren Schwierigkeiten – ohne die im Ernstfall rettenden Erzeuger jenseits der Grenzen.

Zu den verzögerten Sonderausschreibungen und den Bundesrats-Initiativen:

Erstaunlicherweise fiel dem BDEW-Chef in seinen Presseinformationen kein Motiv für den Vorstoß der beiden Bundesländer ein. Das absichtliche Anrichten von Schäden verbunden mit der Unfähigkeit, die bösen Folgen ihres Tuns zu begreifen, steht zwar als Vorwurf für die beiden Ministerpräsidenten (der eine SPD, der andere CDU) deutlich zwischen den Zeilen, aber das wäre ja wohl wenig glaubhaft. Also, welche Motive sind es dann? Könnte es nicht sein, dass der Druck der Bürger in diesen Bundesländern deren Vorstoß auslöste?

2. Argumentationslinie Nr.2: Die Projektierer als Bittsteller bei der kommunalen Verwaltung. Diese Bezeichnung beschreibt diejenigen Kommunen als Hindernis gegen höherrangige Ziele, die sich eine eigene Meinung leisten – und das vermutlich auch noch auf der Grundlage der Mehrheitsmeinung der Bürgerschaft. Wo die Regierung doch nur ihr Bestes will. Und die Projektierer ebenfalls. Wenn andere Unternehmen – ein Sägewerk, ein Outlet-Center, ein Möbellager, ein Containerhof – in einer Kommune Bauwerke errichten möchten, müssen die ebenfalls als „Bittsteller“ auftreten? Sie sind Interessenten bzw. Antragsteller. Die kommunale Planung entscheidet in diesen Fällen, wie es immer gehandhabt wird. Kein Landrat, kein Regierungspräsident und auch kein Minister. Selbstverwaltung.

Dagegen halfen bis jetzt Privilegien im Baugesetzbuch – aber nur für politisch unterstützte Branchen. Das sieht wie eine fragwürdige Praxis aus, die es in Friedenszeiten nicht geben sollte. Privilegien bedeuten Tempo, Durchsetzung eigener Pläne, keine Diskussionen, höhere Renditen. Ein Erfolgsrezept – in China.

3. Argumentationslinie Nr.3: Der schlimmste Störfaktor für die Windbranche ist offensichtlich die Bevölkerung. Die Logik der vorgelegten Argumente verwirrt allerdings. Die „dringend nötige“ Akzeptanz der Bevölkerung würde „konterkariert“ werden. Und zwar durch „neue Restriktionen“. Wenn also die Bürger mitreden dürfen, wenn ihre gewählten Ratsmitglieder mitentscheiden dürfen, ob es eine Flächenausweisung für Windräder geben soll, dann „würde die dringend nötige Akzeptanz dieser Bürger konterkariert.“ Zutreffender wäre die Aussage, „dass die Mitsprachemöglichkeit für die Bürger einer Kommune gestärkt würde.“

Und Protestbewegungen würden nicht etwa überflüssig, weil die Kommune durch die Restriktionen das letzte Wort behält – nein, diese „Protestbewegungen würden befeuert“ und bekämen noch „ein politisches Gütesiegel“ aufgesetzt.

Für die enorme Zahl der Bürgerinitiativen – wie Gegenwind, Windwahn, Pro Natur, Windvernunft, BI Pro Tauschwald, Wattenrat Ostfriesland, Rettet Brandenburg, Bundesverband Landschaftsschutz, Aktion Gegenwind Allgäu, ArGe windradfreie Heimat, Vernunftkraft und weitere 1000 BI-Gruppen – aber auch für Kommunalpolitiker sind diese zwei verbandspolitischen Texte wichtig.

Sie zeigen die Denkmuster sehr deutlich, aber wichtiger sind vermutlich die großen Lücken in der gesamten Argumentation. Man registriert im Verband, dass es Gegner der Energiewendepolitik gibt und dass sich diese Haltung gegen die industriellen Vollzugskräfte und (vorübergehend) Profiteure dieser Politik wendet. Und plötzlich droht ein Absturz, ausgelöst durch ein eher geringfügiges Versagen des Gesetzgebers, aber tatsächlich verursacht von den zahlreichen, ernsten und zumeist nicht steuerbaren Problemen, die hier aufgezählt wurden.

Selbstverständlich ist der kürzlich der Regierung vom Bundesrechnungshof

amtlich bestätigte Kontrollverlust der zahlreichen, unkoordiniert mit der (planwirtschaftlichen) Regulierung und Steuerung der Energiewende befassten Teile des Regierungsapparates von erheblicher Bedeutung (5, 6, 7, 8).

Aber auch wenn das Management der Energiewende weniger kritikwürdig wäre, würden deren inhärente Fehlkonstruktionen dennoch alle „ehrgeizigen“ Ziele („ehrgeizig“ ist das politisch korrekte Synonym für „unerreichbar“) zum Scheitern verurteilen.

Schlussbemerkungen – nicht nur an die Adresse der Windenergiebranche

Eigentlich kennt beinahe jeder die „Randbedingungen“, die uns die Natur bei unseren Versuchen, die „Erneuerbaren Energien“ zu nutzen, gesetzt hat.

Die Energiedichte, die Wind, Sonnenlicht, Meeresströmungen oder Erdwärme aufweisen, ist gering, weshalb man große Flächen und entsprechend große Anlagen braucht, um nennenswerte Energieernten zu erzielen. Das wiederum führt zu hohen Kosten.

Wo man große nutzbare Flächen zur Verfügung hat und auch hohe Kosten für die Energiemenge 1 Kilowattstunde nicht scheut, kann man in die Nutzung dieser regenerativen Energiequellen einsteigen.

In einem dichtbesiedelten Land wie Deutschland, das zudem eine starke, exportabhängige Industrie besitzt, deren Wirtschaftlichkeit stark von ihren Stromkosten abhängt, und das außerdem von der Natur durch seine geografische Lage weder mit viel Sonne noch viel Wind und auch nicht mit reichlicher Geothermie ausgestattet ist, benötigt man genau die Stromerzeugungstechniken, die man bis zur Jahrtausendwende nutzte – und von denen gerade noch ausreichende Kapazitäten existieren. Deren Weiterentwicklung ist beendet worden; ihre Stilllegung politisch gewollt.

Wie das enden wird, wissen die Experten in den Wirtschaftsverbänden sehr genau.

Aus der langen Liste der verschiedenen ernsten Probleme, denen sich die Windenergiebranche gegenüber sieht – und fast alle sind grundsätzlicher Natur und sowohl lange bekannt als auch nicht ausräumbar – kann man feststellen, dass das aktuell beklagte administrative Problem im Vergleich mit dem unüberwindlichen Berg der tatsächlich ernsten Grundsatzprobleme nicht in den Vordergrund der Debatten gehört.

Die heute sehr wahrscheinlich in ihrer Existenz bedrohte Windenergie-Branche ist nicht die Verursacherin ihrer Schwierigkeiten, sondern Opfer einer bestimmten Politik. Aber das Ignorieren der aussichtslosen Situation, in die die gesamte Energiewirtschaft Deutschlands durch die rein ideologisch begründete, aber fachlich-betriebswirtschaftlich und planerisch inkompetente Administration gebracht worden ist, verschlechtert die Lage für jede beteiligte und abhängige Branche. Auf künftig noch mehr Förderung zu hoffen, wäre gewagt.

Die Gegner, über die man sich heute beklagt, sind erst durch die Defizite der Politik und deren zahlreiche Nebenwirkungen geschaffen worden. Auch eine kompetentere Planung und ein effizienteres Management hätte die Probleme nicht beheben, sondern allenfalls Begleitschäden verringern können.

Auch bei einem vorübergehend weitergehenden Ausbau der Windkraft werden diese Gegner nur zahlreicher und stärker. Wenn deren Sorgen und Beschwerden berechtigt sind, ist das Erzielen von Akzeptanz keine vernünftige Strategie.

Wann beginnt der BDEW, sich umfassend über die Ursachen der beginnenden Schwierigkeiten, die nur den Beginn einer Abwärtsspirale andeuten, zu informieren? Sämtliche Fakten liegen auf dem Tisch.

Die Industrieverbände sollten sich entscheiden: Zwischen unkritischer Regierungsfrommheit oder klarer, selbstbewusster Vertretung der berechtigten Interessen ihrer Mitglieder auf der Grundlage kritischer und kompetenter Analysen der Politik.

Quellen:

(1): Kathrin Witsch: „Die deutsche Windbranche steht vor einer schweren

Krise“, Handelsblatt Online, 2.8.2018.

(2): Birgit Marschall: „Union und SPD streiten sich über Ausbau der Windenergie“,

Rheinische Post Online, 10.8.2018; https://rp-online.de/politik/deutschland/groessere-abstaende-fuer-windraeder-union-und-spd-streiten-sich-ueber-ausbau-der-windenergie_aid-24778049/

(3): Helmut Alt (Prof.Dr.-Ing.): „Windkraft: Angriff auf die Privilegierung“, Leserbrief in

der ZfK (Zeitschr. f. Kommunale Wirtschaft), September 2018

(4): Daniel Wetzel:“Windkraft-Booster der Bundesregierung kommt zu spät“;

DIE WELT, 4.10.2018

(5): Bundesrechnungshof (BRH) : „Bericht – nach §99 BHO

(Bundeshaushaltsordnung) – über die Koordinierung und Steuerung zur

Umsetzung der Energiewende durch das Bundesministerium für Wirtschaft und

Energie“ (BMWi), Langfassung; Hrsg. Bundesrechnungshof, Referat Presse- und

Öffentlichkeitsarbeit, Bonn 28.09.2018; www.bundesrechnungshof.de

(6): Bundesrechnungshof: „Energiewende droht zu scheitern. Bundesrechnungshof

bilanziert Stand und Umsetzung der Energiewende“; Pressemitteilung vom

28.09.2018;

(7): Bundesrechnungshof: „2018 Sonderbericht – Koordination und Steuerung zur

Umsetzung der Energiewende durch das Bundesministerium für Wirtschaft und

Energie“, – Zusammenfassung– Pressemitteilung – Statement. 28.09.2018.

Mit Stellungnahme des BMWi zum Bericht des BRH.

(8): Daniel Wetzel: „Bei der Energiewende droht Deutschland der endgültige

Kontrollverlust“, Untertitel: „Deutschlands Defizite bei der Umsetzung der

Energiewende.“ DIE WELT, 28.09.2018;

https://www.welt.de/wirtschaft/article181690102/Bundesrechnungshof-wirft-

Regierung-Versagen-bei-Energiewende-vor.html

(9): W. Daldorf, R. Ernst, H. Feddersen, Chr. Herz, H. Visel, J. Bonorden, J. Vry:

„Ratgeber für Windpark-Anleger“, Bundesverband Windenergie,

Version 18.3.2011;

http://www.energieverbraucher.de/files_db/1300471869_4207_12.pdf

(10):bund der energieverbraucher: „Bundesverband WindEnergie will mit

neuem Anlegerinfo für mehr Transparenz auf dem Kapitalmarkt sorgen“,

2014 ;

http://www.energieverbraucher.de/de/windkraftfonds_pruefen_584#con1082

(11): Was Jahresvollaststunden bedeuten, erklärt der BDEW:

„Eine wichtige Kenngröße für die Nutzbarkeit einer Energiequelle ist die Anzahl

der Jahresvolllaststunden. Diese gibt an, in wieviel Stunden eine Anlage ihre

(tatsächliche) Jahresstromerzeugung erbracht hätte, wenn sie ständig (ihre)

maximale Leistung erbracht hätte.“

(12): Stefan Lakeband: „Rettung bei Senvion gescheitert.“; Weser-Kurier; 11.7.2018;

https://www.weser-kurier.de/bremen/bremen-wirtschaft_artikel,-rettung-bei-senvion-gescheitert-_arid,1623675.html

(13): Friederike Liebscher und Markus Minten: „Kündigung für 420 Mitarbeiter“;

NWZ Online; 21.12.2017; https://www.nwzonline.de/wirtschaft/lemwerder-carbon-rotec-in-lemwerder-kuendigung-fuer-420-mitarbeiter_a_50,0,1746237949.hmtl/

(14): Ulrich Schlüter: „Carbon-Rotec-Gelände hat neuen Besitzer“; NWZ; 4.7.2018

https://www.nwzonline.de/wirtschaft/…

(15): FDP-Fraktion im Deutschen Bundestag: Antrag vom 27.9.2018: „Wälder

schützen – Rodungen für die Windkraft stoppen“, Drucksache 19/2802;

https://www.bundestag.de/dokumente/textarchiv/2018/kw39-de-waldrodung-

windkraft/570240

(16): BDEW Bundesverband der Energie- und Wasserwirtschaft e.V.:

„Verfügbarkeit ausländischer Kraftwerkskapazitäten für die Versorgung in

Deutschland“, Studie; Berlin, 28.5.2018; www.bdew.de

(17): Daniel Wetzel: „Die deutsche Energiewende verliert ihren Risikopuffer“,

DIE WELT, 23.4.18

(18): Günter Keil: „Infraschall von Windturbinen: Dänemark geht den Wirkungen auf

den Grund“; 25.05.2018,

http://ageu-die-realisten.com/archives/2787

St. Augustin, den 27.10.2018