[Anmerkung des Übersetzers: Bei der folgenden Übersetzung ist mir bei einigen Begriffen keine sinnvolle Übersetzung ins Deutsche eingefallen. Diese Begriffe sind kursiv gesetzt. Alle anderen Hervorhebungen sind vom Original übernommen. – Ende Anmerkung]

Hier möchte ich unsere Beweiskette für Laien erklären (weil ich auch genau das bin). Falls man einen detaillierteren Einstieg in die dahinter stehende Physik wünscht, dann findet man den in diesem PDF mit dem Titel error-summary.

Nach einer kurzen Darstellung unserer Argumentation möchte ich nur so zum Spaß die prinzipiellen Einwände der Begutachter einflechten, zusammen mit unseren Antworten darauf. Mögen die Leser entscheiden, ob wir oder die Begutachter richtig liegen.

Wie Klimatologen vergessen, dass die Sonne schien

Klimatologen, die globale Erwärmung zu prophezeien versuchen, haben in ihren Ergüssen den Sonnenschein vergessen. Nach der Korrektur dieses groben physikalischen Fehlers ergab sich die globale Erwärmung nicht zu 2 bis 4,5 K pro CO2-Verdoppelung, wie es die Klimamodelle simulieren. Vielmehr ergab sich ein geringer, langsamer, harmloser und insgesamt vorteilhafter Anstieg von 1,17 K.

Das Climate Model Intercomparison Project (CMIP5: Andrews+ 2012) hatte prophezeit, dass eine Verdoppelung des CO2-Gehaltes der Luft die Welt um 1,04 ±1,5 K erwärmen würde (vor Einwirkung von Rückkopplungen) und 3,37 ±1,3 K nach Berücksichtigung von Rückkopplungen. Das IPCC sagt 3,0 ±1,5 K. Einige Studien (z. B. Murphy 2009) prophezeien sogar Schätzungen bis 10 K pro CO2-Verdoppelung.

Klimatologen liegen falsch, wenn sie die Rückkopplungs-Mathematik aus der Regeungsl-Theorie heranziehen, ohne diese überhaupt verstanden zu haben. Sie wendeten eine abgewandelte Rückkopplungs-System-Verstärkungs-Gleichung an, welche sich allein auf geringe Änderungen der Referenztemperatur vor der Rückkopplung stützt und auf die Gleichgewichts-Temperatur nach der Rückkopplung. Aber in die Grundgleichung, welche sie sich aus der Regelungs-Theorie ausgeliehen haben, gehen absolute Temperaturwerte in Kelvin ein und nicht einfach nur Änderungen der Temperatur.

Ihre abgewandelte Gleichung ist eine valide Gleichung, weil sie die Differenz zwischen zwei Fällen der Grundgleichung konstituiert. Allerdings subtrahierten sie effektiv den Term für die 243,3 K Emissionstemperatur heraus, welche auf der Erde ohne nicht kondensierende Treibhausgase herrschen würde, getrieben durch die Tatsache, dass die Sonne scheint. Gleiches gilt für den Term der Erwärmung um 11,5 K durch vorindustrielle Treibhausgase.

Weil sie diese vitale Information verloren haben, kann ihre abgewandelte Gleichung nicht zuverlässig den wahren System-Verstärkungs-Faktor abbilden, also das Verhältnis der Gleichgewichts- zur Referenz-Temperatur. Stattdessen versuchten sie, den Heiligen Gral aus den Studien zur globalen Erwärmung zu finden, indem sie individuellen Rückkopplungen aus den Computermodell-Ergebnissen nachjagten. Sie suchten nach stumpfen Nadeln im falschen Heuhaufen, obwohl sie doch alles, was sie brauchten bereits hatten (wenn sie es denn nur gewusst hätten).

Messungen und Beobachtungen können uns keinen Aufschluss über die Größenordnungen individueller Rückkopplungen geben, und sie können uns nicht dabei helfen zu unterscheiden zwischen individuellen Rückkopplungen der menschengemachten Erwärmung, welche sie hervorrief.

Fügt man den fehlenden Sonnenschein und die vorindustrielle Treibhausgas-Erwärmung wieder ein, kann jeder den wahren System-Verstärkungs-Faktor berechnen. Die Berechnung geht schnell und ist direkt und genau. Man muss nicht einmal die Größenordnung einer jeden individuellen Rückkopplung kennen. Alles, was man braucht, ist die gesamte Referenztemperatur (vor der Rückkopplung) und die Gleichgewichtstemperatur (nach der Rückkopplung) in irgendeinem ausgewählten Jahr.

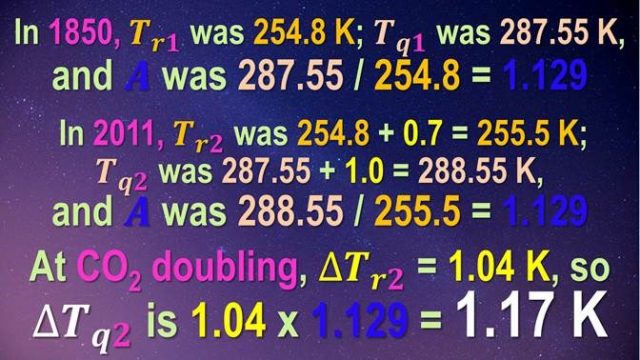

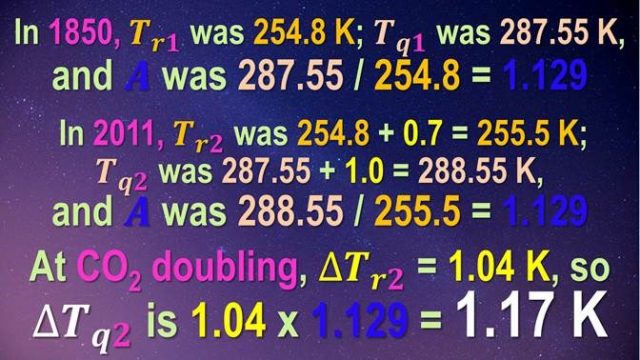

Im Jahre 1850 betrug die Referenztemperatur – also die Summe der Erwärmung von 243,3 K durch die Sonne und weiteren 11,5 K durch die nicht kondensierenden Treibhausgase vor der industriellen Revolution – 254,8 K. Die gemessene Gleichgewichtstemperatur betrug 287,5 K (HadCRUT4). Daher beträgt der System-Verstärkungs-Faktor für jenes Jahr 287,5/254,8 oder 1,13.

Aus der Anwendung der abgewandelten Gleichung kann man jedoch in keiner Weise den System-Verstärkungs-Faktor des Jahres 1850 ableiten.

Bis zum Jahr 2011 hatten menschengemachte Einflüsse die Referenztemperatur um 0,68 K auf 255,5 K steigen lassen. Die gemessene Temperatur ist um 0,75 K gestiegen, doch müssen noch weitere 0,27 K aufgrund eines imaginären „Strahlungs-Ungleichgewichtes“ zugelassen werden, die sich noch nicht manifestiert haben. Dies würde die Gleichgewichts-Temperatur um 1,02 K auf 288,5 K steigen lassen. Folglich betrug der System-Verstärkungs-Faktor für das Jahr 2011 288,5/255,5 oder 1,13.

Jener Wert für 2011 ist nun genau der Gleiche wie der im Jahre 1850. Der Grund ist einfach zu erkennen. Die 254,8 K Referenztemperatur des Jahres 1850, welche bei den Summen der Klimatologen außen vor gelassen worden ist, beträgt 375 mal die menschengemachte Referenz-Erwärmung um 0,68K von 1850 bis 2011. Das ist der Grund, warum unsere Einwirkung auf den System-Verstärkungs-Faktor minimal ist.

Die Stabilität des Klimas, die sich nach der Korrektur des groben Fehlers der Klimatologen zeigt, sollte keine Überraschung sein. Seit über 800.000 Jahren hat die globale mittlere Temperatur um kaum mehr als 3 K beiderseits der mittleren Temperatur jenes Zeitraumes variiert, wie aus der Analyse von Luftbläschen in historischem Eis hervorgeht.

Obwohl der Begriff „Rückkopplung“ im jüngsten IPCC-Bericht (2013) über 1000 mal auftaucht, kann die Rückkopplung getrost ignoriert werden; man würde nur einen sehr geringen Fehler erhalten. Der System-Verstärkungs-Faktor kann konstant mit 1,13 angenommen werden. Die von den Klimatologen angenommene Nicht-Linearität in den Rückkopplungen macht da kaum einen Unterschied.

Zieht man die abgewandelte Gleichung heran, würde der System-Verstärkungs-Faktor 1,02 / 0,68 oder 1,50 betragen, und die Gleichgewichts-Erwärmung bei CO2-Verdoppelung würde folglich 1,50 mal größer sein als die Referenz-Erwärmung von 1,04 K als Reaktion auf eine CO2-Verdoppelung, d. h. 1,55 K. Aber selbst dieser Wert ist nur etwa halb so groß wie Schätzung von 3,37 K in den CMIP5-Modellen.

Wendet man jedoch die Grundgleichung an, wäre die wahre Gleichgewichts-Erwärmung bei CO2-Verdoppelung noch geringer und läge beim 1,13-fachen der Referenz-Erwärmung von 1,04 K, d. h. harmlose 1,17 K. Um auf der sicheren Seite zu sein, wurden zehn separate offizielle Schätzungen des menschengemachten Strahlungsantriebs untersucht. In jedem einzelnen Fall betrug die globale Erwärmung bei CO2-Verdoppelung 1,17 K.

Eine statistische Monte-Carlo-Simulation zeigt die wahre Bandbreite der globalen Erwärmung zwischen 1,08 und 1,25 K. Die diesem Ergebnis zugrunde liegende Regelungs-Theorie wurde mit zwei Testläufen verifiziert, einer davon in einem Laboratorium der Regierung.

Klimatologen hatten sich vorgestellt, dass individuelle Temperatur-Rückkopplungen sich selbst aufheben würden, außer für Wasserdampf, der größten Rückkopplung. Mit jedem zusätzlichen K Erwärmung kann die Atmosphäre 7% mehr Wasserdampf aufnehmen. Kann, muss aber nicht. Die meisten Modelle hatten prophezeit, dass falls die Erwärmung vom Menschen verursacht wäre und nur dann sich die Luft höheren Luftschichten über dem Äquator dreimal so stark erwärmen würden wie an der Oberfläche. Und doch ist der Wasserdampfgehalt dort oben rückläufig. Folglich ist der mitteltroposphärische „Hot Spot“ nicht existent.

Unter dem Strich: Globale Erwärmung ist also überhaupt kein Problem. Man genieße den Sonnenschein, den die Klimatologen vergessen haben!

Kommentare der Begutachter und unsere Antworten darauf

„Die einfache Einfügung der Emissionstemperatur in die Gleichungen an die Stelle der anthropogenen Erwärmung an der Oberfläche und dann so weitermachen wie zuvor ist eine massive Verletzung des Energieerhaltungssatzes“.

Mit Verlaub, nein! Einer meiner Mitautoren, nämlich John Whitfield, konstruierte einen Testlauf – im Grunde ein Analog-Computer – um die unserer Argumentation zugrunde liegende Regelungs-Theorie zu verifizieren. Es gab mit Sicherheit keine „massive Verletzung des Energieerhaltungssatzes“. Stattdessen bestätigten die Ergebnisse des Testlaufes bei 23 unterschiedlichen Experimenten unser Ergebnis in jeder Hinsicht.

Um dies hieb- und stichfest zu machen, beauftragten wir ein Laboratorium der Regierung, einen Testlauf nach ihrem eigenen Design zu konstruieren und die gleichen 23 Experimente durchzuführen. Die Ergebnisse stimmten mit dem überein, was wir aufgrund der Theorie vorhergesagt hatten, und zwar jeweils bis auf ein Zehntel Kelvin genau. Falls es wirklich eine „massive Verletzung des Energieerhaltungssatzes“ gegeben hätte, wäre diese in den Experimenten sicher zutage getreten.

Abgesehen davon – die Begutachter haben keinerlei Beweise oder Argumente irgendeiner Art hervorgebracht, welche die unsinnige Vermutung rechtfertigen würde, dass unser Verfahren eine „massive Verletzung des Energieerhaltungssatzes“ war.

Anstatt die Störungs- (perturbation)-Temperatur eingehen zu lassen und zu fragen, was die Durchdringung im Energiehaushalt an der Oberfläche der Atmosphäre ist, schaufeln sie ohne physikalische Rechtfertigung die gesamte Temperaturdifferenz von absolut Null in die Gleichung. Das ist blanker Unsinn“.

Die physikalische Rechtfertigung ist Folgende: Rückkopplungs-Prozesse können nicht unterscheiden zwischen einer vorher herrschenden Temperatur und einer Störung jener Temperatur. Sie haben keine Mittel, sich zu entscheiden, ob sie überhaupt nicht auf Erstere reagieren sollen und doch heftig auf Letzteres reagieren sollen. Auch sind diese unbelebten Prozesse nicht mit der Frage befasst, was hätte sein können, wenn die Sonne nicht scheinen würde. Denn die Sonne – ob sie es nun mögen oder nicht – scheint.

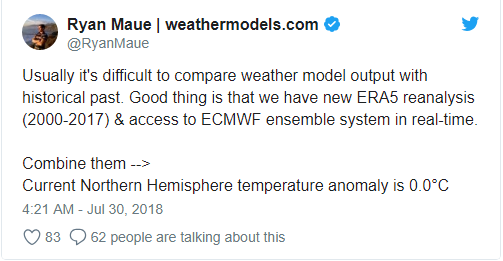

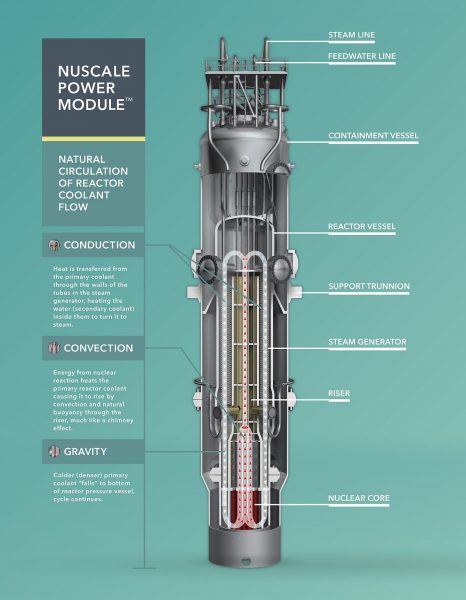

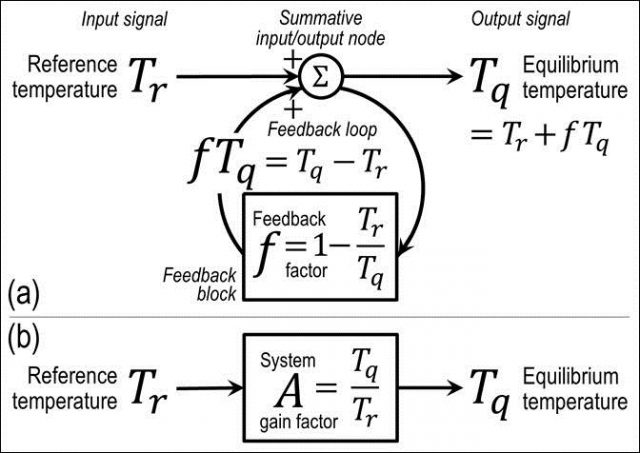

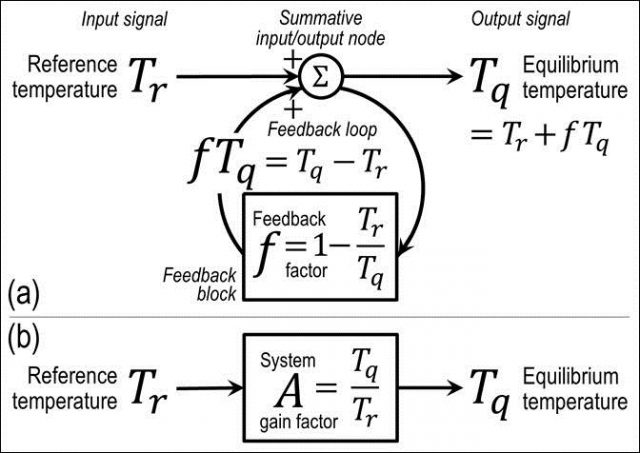

Rückkopplungs-Prozesse reagieren einfach auf die Temperatur, die sie vorfinden. Auf dem folgenden Blockdiagramm einer Rückkopplungsschleife (Feedback loop) ist der Grund dafür zu erkennen:

Die Referenz-Temperatur (d. h. die Temperatur vor Einwirkung von Rückkopplungen) geht von links oben ein und ist Eingangssignal für den summierenden Knoten zwischen Eingangs- und Ausgangssignal. Aus diesem Knoten läuft der Anteil der Ausgangstemperatur, repräsentiert durch die Rückkopplungs-Reaktion, um die Rückkopplungsschleife herum und zurück zum Knoten zwischen Eingangs- und Ausgangssignal. Dort wird sie der ursprünglichen Referenz-Temperatur hinzugefügt und ergibt die Gleichgewichts-Sensitivität.

Jetzt erhöhe man die Referenz-Temperatur durch irgendeinen Zusatzbetrag. Dann ist das Eingangssignal in die Rückkopplungsschleife etwas größer als zuvor. Der Rückkopplungsprozess trägt der höheren Referenz-Temperatur einfach Rechnung. Es gibt selbstverständlich keinen physikalischen Mechanismus, damit jene Prozesse „wissen“ können, dass sie nicht reagieren dürfen auf eine irgendwie höhere Referenztemperatur als vorher.

Die Analogie mit einem Bode-Verstärker, welche die Autoren so stark betonen, ist keine Analogie. Falls es eine Störungsspannung wäre, die isoliert wurde und es diese Störungsspannung wäre, aufgrund derer die Rückkopplungen ablaufen, würde die Analogie enger sein.

Um zu verstehen, warum die Begutachter das alles so sehen, wie sie es sehen, wollen wir uns die offizielle Definition des IPCC einer „Klima-Rückkopplung“ in Erinnerung rufen (IPCC, 2013, glossary, p. 1450):

„Klima-Rückkopplung“: Eine Wechselwirkung, bei der eine Störung einer Klimagröße eine Änderung einer zweiten Klimagröße verursacht und die Änderung der zweiten Klimagröße wiederum ultimativ zu einer Änderung der ersten Größe führt. Bei einer negativen Rückkopplung wird die initiale Störung geschwächt durch die verursachten Änderungen; bei einer positiven Rückkopplung wird die Störung verstärkt. In diesem Zustandsbericht wird oft eine enger gefasste Definition herangezogen, in welcher die Klimagröße, die durchdrungen wird, die globale mittlere Temperatur ist, welche wiederum zu Änderungen des globalen Strahlungshaushaltes führt. In jedem Falle kann die initiale Störung entweder extern getrieben sein oder sich in der Folge der internen Variabilität erheben“.

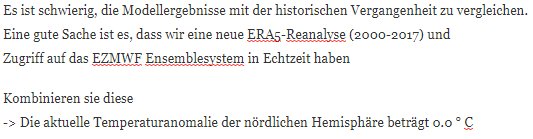

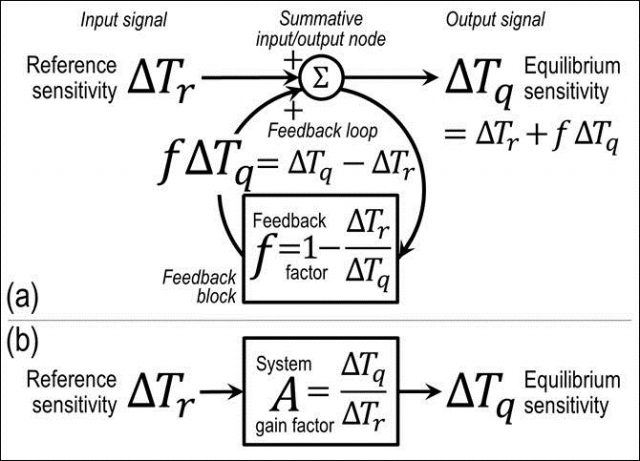

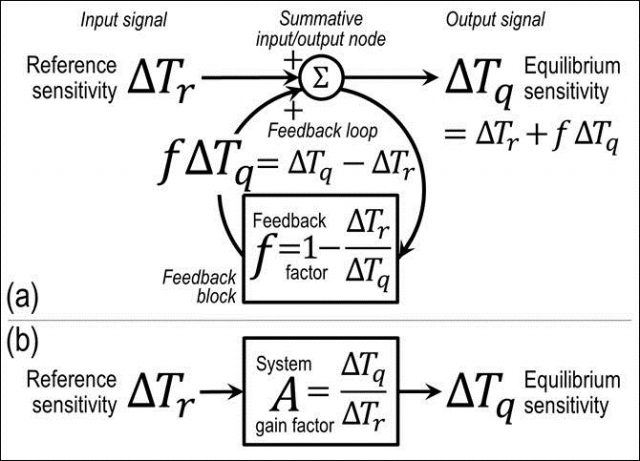

Man beachte, dass die Begriffe „gestört (perturbed)” oder “Störung (perturbation)” allein in diesem kurzen und aus Berechnung gestrafften Definition fünf mal auftauchen. Zeichnen wir einmal das Blockdiagramm des variierenden Rückkopplungsscheife (feedback loop), wie ihn sich die offizielle Klimatologie vorstellt:

Im gesamten Diagramm ist hier kaum eine absolute Größe zu finden. Was ist also los? Nun, die normale Rückkopplungssystem Gleichung der offiziellen Klimatologie ergibt, dass die Änderung der Gleichgewichts-Temperatur gleich ist der Summe der Änderung der Referenztemperatur und dem Produkt aus Rückkopplungs-Verstärkungs-Faktor und der Änderung der Gleichgewichts-Temperatur.

Nun ist die abgewandelte Gleichung der Klimatologie eine perfekt valide Gleichung. Im Wesentlichen repräsentiert sie die Differenz zwischen zwei aufeinanderfolgenden Beispielen der Mainstream-Gleichung der Regelungs-Theorie, welche feststellt, dass die Gleichgewichts-Temperatur gleich ist der Summe der Änderung der Referenztemperatur und dem Produkt aus Rückkopplungs-Faktor und der Änderung der Gleichgewichts-Temperatur.

Aber die abgewandelte Gleichung ist unbrauchbar zum Auffinden von Gleichgewichts-Sensitivitäten, weil man sie nicht zuverlässig ableiten kann aus dem Heiligen Gral der Studien bzgl. globaler Erwärmung – nämlich dem Rückkopplung-Verstärkungsfaktor, welcher das Verhältnis ist zwischen Gleichgewichts- und Referenz-Temperatur.

In unserem Falle hier ist jedoch nur erforderlich, das zu beobachten, da die abgewandelte Gleichung der Klimatologie eine valide Gleichung ist ebenso wie die Mainstream Gleichung der Regelungs-Theorie, aus der die abgewandelte Gleichung abgeleitet ist.

Wir wollen die offizielle Definition einer „Klima-Rückkopplung“ wie folgt korrigieren:

„Positive Rückkopplung in dynamischen Systemen verstärkt das Ausgangssignal. Negative Rückkopplung schwächt es ab. Bzgl. Klima ist das Eingangssignal die globale mittlere Gleichgewichts-Temperatur Tq nach Einwirkung von Rückkopplung. Die Rückkopplungs-Reaktion fTq konstituiert die gesamte Differenz Tq – Tr zwischen Gleichgewichts- und Referenz-Temperaturen, so dass der Rückkopplungsfaktor f, also der Bruchteil der Gleichgewichts-Temperatur, der die Rückkopplungs-Reaktion konstituiert, gleich ist 1 – Tr/Tq. Der System Verstärkungsfaktor A ist gleich Tq/Tr, d. h. (1 – f)-1“.

Man beachte als Nebeneffekt, dass die Rückkopplungs-Schleifen-Diagramme (a) vereinfachend sind zu den System-Versärkungs-Blockdiagrammen (b) sind. Das bedeutet, dass man alles, was man braucht, das Auffinden des System-Versärkungs-Faktors A für jedes gegebene Jahr ist. Das ist dann die Referenz-Temperatur (vor Rückkopplung) und die gemessene Gleichgewichts-Temperatur (nach Rückkopplung) in jenem Jahr. Man muss nicht den Wert irgendeiner individuellen Rückkopplung kennen.

Test-Läufe sind ja gut und schön, zeigen aber einfach nur, dass man Systeme konstruieren kann, für welche die eindimensionalen Energie-Gleichgewichts-Gleichungen genau wahr sind. Darin ist keine Information enthalten, um zu sagen, ob diese Modelle relevant sind hinsichtlich des realen Klimas“.

Falls die Rückkopplungs-Mathematik, welche sich die offizielle Klimatologie aus der Regelungs-Theorie entliehen hat, so unanwendbar ist wie der Begutachter sagt, dann gibt es keine legitime Grundlage für den derzeitigen irrigen Glauben der Klimatologie, dass Rückkopplungs-Reaktionen verantwortlich sind für mindestens zwei Drittel der Gleichgewichts-Sensitivität. Studie für Studie (z. B. Hansen 1984, Schlesinger 1985, Bony 2006, Roe 2009) wendet Rückkopplungs-Mathematik an mit dem expliziten Hinweis auf Bode. Aber diese und gleichartige Studien verwenden Bode auf eine Art und Weise, welche die genaue Ableitung des System-Versärkungs-Faktors verhindert. Im IPCC-Bericht 2013 taucht das Wort „Rückkopplung“ (feedback) über 1000 mal auf.

Diese und zahlreiche andere Autoren haben akzeptiert, dass die Rückkopplungs-Mathematik relevant ist zur Ableitung der Gleichgewichts-Temperatur. Auch richtig: Weil die Gleichgewichts-Temperatur höher liegt als die Referenz-Temperatur und die Rückkopplungs-Reaktion die gesamte Differenz zwischen beiden konstituiert.

Es ist interessant zu sehen, wie bereitwillig die Begutachter die „settled Science“ verwerfen, welche seit Jahrzehnten durch die Literatur geistert, wann immer sie diese unbequem finden.

Die von der Klimawissenschaft verwendete Energie-Gleichgewichts-Gleichung ist nichts als eine erweiterte Taylor-Reihe der Differenz zwischen dem globalen mittleren Energie-Ungleichgewicht an der Obergrenze der Atmosphäre und dem Strahlungsantrieb. Darum taucht die Emissions-Temperatur in der null-dimensionalen Energie-Gleichgewichts-Gleichung nicht auf. Ich kann kein dem entgegen stehendes Argument erkennen, welche dieser Interpretation der Gleichung widerspricht.

Da die abgewandelte Gleichung der Klimatologie eine valide Gleichung ist, gibt es nichts, was an dieser selbst falsch ist. Sie ist valide abgeleitet aus der Energie-Gleichgewichts-Gleichung, und die Tatsache, dass sie abgeleitet ist via einer leading order-Erweiterung der Taylor-Reihe, widerspricht in keiner Weise unserem Argument: weil eine Erweiterung einer Taylor-Reihe lediglich ein Mechanismus ist, um der Form einer Kurve über einen bestimmten Punkt Ausdruck zu verleihen.

Aber wenn man den Sonnenschein-Term außen vor lässt, ist es unmöglich, den System-Versärkungs-Faktors akkurat aus der abgewandelten Gleichung abzuleiten.

Nichts bei der Ableitung der abgewandelten Gleichung der Energie-Gleichgewichts-Gleichung an der Obergrenze der Atmosphäre sagt uns irgendetwas über die Größenordnung des System-Versärkungs-Faktors. Aus genau diesem Grunde haben die Klimamodellierer Jahrzehnte damit zugebracht, vergeblich zu versuchen, das Intervall von Charney-Sensitivitäten zu begrenzen, welches im IPCC-Bericht (2013) (1,5 bis 4,5) K ausmachte, also genau wie vor vier Jahrzehnten in Charney (1979).

Die Autoren würden besser daran tun, sich hinsichtlich der Literatur zu informieren, welche die Linearität von Rückkopplungen evaluiert.

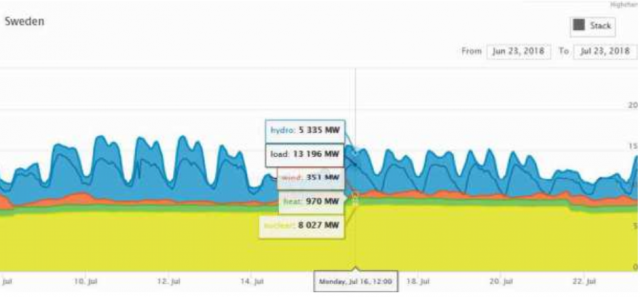

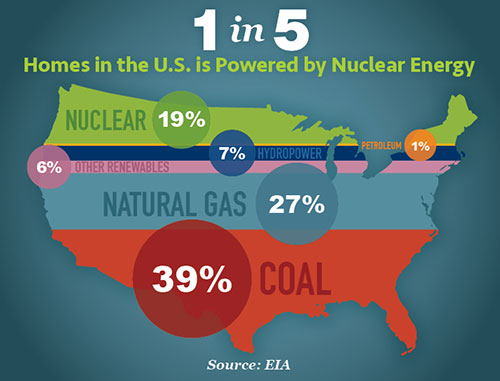

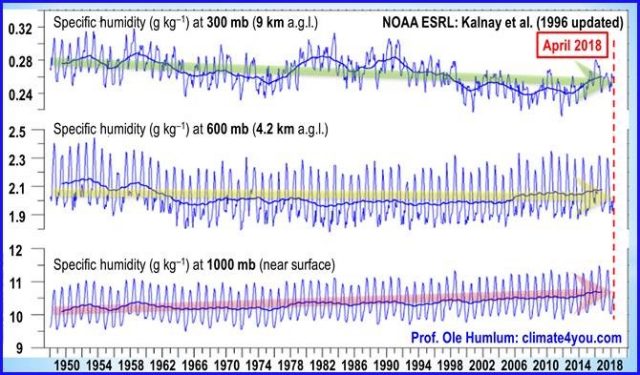

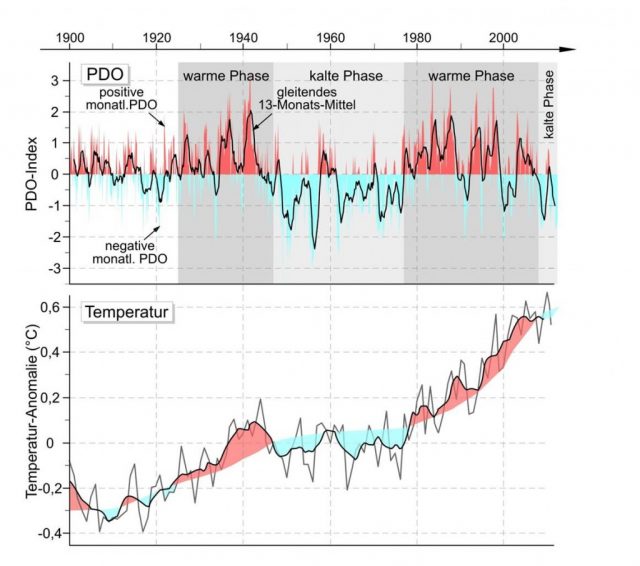

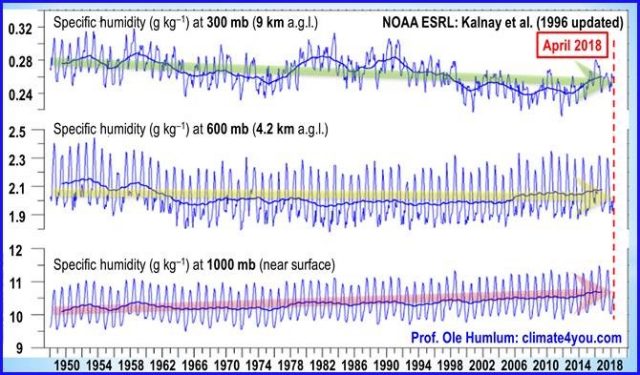

Jawohl, einige Rückkopplungs-Reaktionen sind nicht linear. Wasserdampf ist ein primäres Beispiel. Wenn sich der Raum, den die Atmosphäre einnimmt, erwärmt, kann sie 7% mehr Wasserdampf pro Kelvin aufnehmen. Und tatsächlich ist genau das nahe der Erdoberfläche im 1000 hPa-Niveau der Fall:

Im 600-hPa-Niveau jedoch gibt es keine Zunahme der spezifischen Feuchtigkeit mit Erwärmung. Und in der entscheidenden mitteltroposphärischen Höhe von 300 hPa geht die spezifische Feuchtigkeit zurück. Warum ist das bedeutsam? Weil die offizielle Klimatologie alle individuellen Rückkopplungen außer Wasserdampf als sich umfassend selbst auslöschend betrachtet. Es ist allein die Wasserdampf-Rückkopplung, welche den Vorwand für die Aussage liefert, dass wegen der Rückkopplungen die Gleichgewichts-Erwärmung drei bis vier, ja bis zu zehn mal größer ist als die Referenz-Erwärmung.

Und doch liegt die einzige Höhe, in der die prophezeite Rate der Zunahme der spezifischen Feuchtigkeit die Realität spiegelt, sehr nahe der Oberfläche, wo Harde (2017) zufolge die Spektrallinien von Wasserdampf nahezu gesättigt sind.

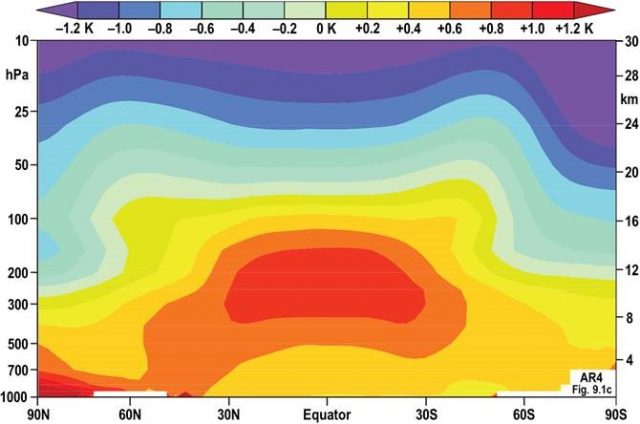

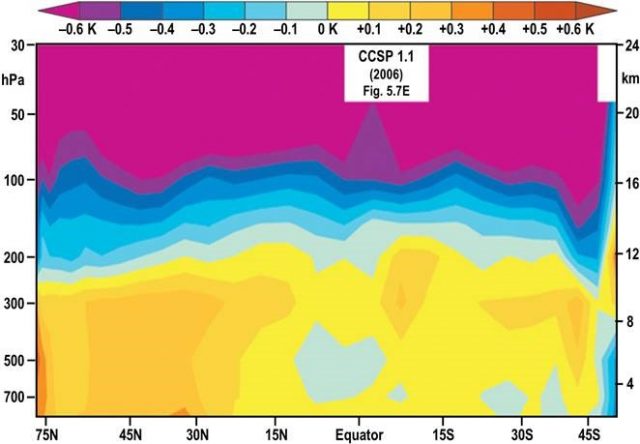

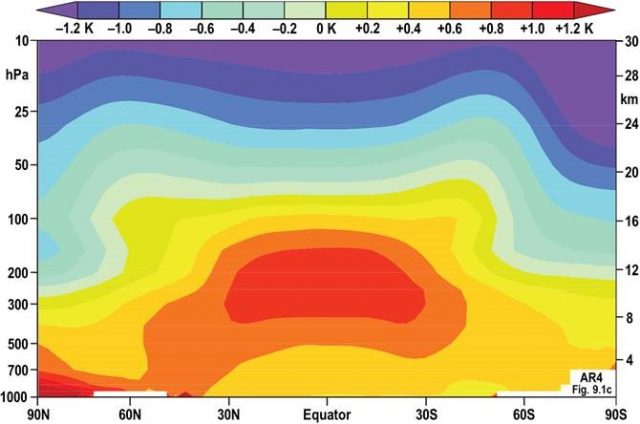

Man betrachte Abbildung 9.1c im IPCC-Bericht 2007. Dort wird der prophezeite mitteltroposphärische „Hot Spot“ – den so zu nennen ich die Ehre hatte – über den Tropen in der Art und Weise dargestellt, die uns inzwischen sattsam bekannt ist: in grellen Farben:

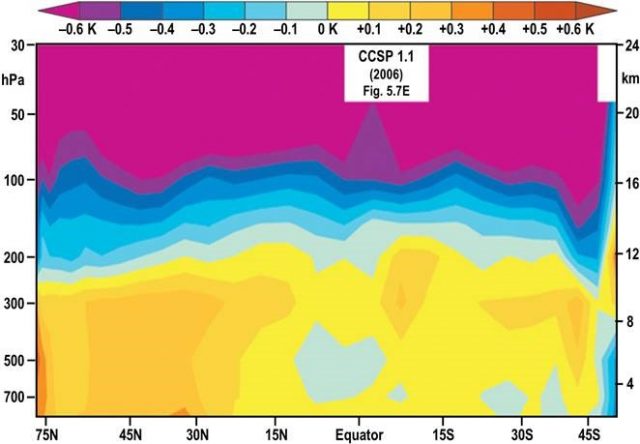

So viel zu den Prophezeiungen. Ich könnte Dutzende weitere ähnliche Abbildungen von verschiedenen Modellen der allgemeinen Zirkulation zeigen. In Wirklichkeit jedoch ist der prophezeite „Hot Spot“ auffällig infolge seines kompletten Fehlens:

Nun erzeugte das Klimawandel-Wissenschaftsprogramm der USA seine Daten der realen Welt, in denen ein Jahr, bevor das IPCC auf seiner falschen Behauptung beharrte, dass der „Hot Spot“ existiert, nicht einmal ansatzweise ein solcher erkennbar war. Und warum sollte er existieren? Weil die spezifische Feuchtigkeit, die hätte zunehmen sollen, um die prophezeite schnellere Erwärmung als an der Oberfläche zu erreichen, in Wirklichkeit abgenommen hat.

Mit unserem Verfahren, den Rückkopplungs-System-Versärkungs-Faktors zu finden, muss man überhaupt nichts wissen über individuelle Rückkopplungen. Alles, was man braucht, ist die Referenz-Temperatur (vor Rückkopplung) und die Gleichgewichts-Temperatur (nach Rückkopplung) in irgendeinem gegebenen Jahr.

Und um herauszufinden, ob Nicht-Linearitäten bei individuellen Rückkopplungen den System-Versärkungs-Faktors mit der Zeit und mit der Temperatur variieren lassen, muss man lediglich diesen System-Versärkungs-Faktors für zwei verschiedene Jahre finden – den einen kurz vor Beginn der industriellen Ära und einen nahe deren Ende. Also haben wir genau das getan. Und wir ließen sogar das (möglicherweise imaginäre) „Strahlungs-Ungleichgewicht“ zu, welche die menschengemachte Erwärmung bis heute um etwa ein Viertel verzögert haben könnte.

Sowohl im Jahre 1850 als auch im Jahre 2011 betrug der System-Versärkungs-Faktors auf drei Dezimalstellen genau 1,129. Selbst in der dritten Dezimalstelle hat er sich nicht verändert. Er hat sich nicht verändert, weil die kombinierte Temperatur von der Sonne und von nicht kondensierenden Treibhausgasen der vorindustriellen Ära 375 mal größer war als die Referenz-Sensitivität von 0,68 K zwischen jenen beiden Jahren. Nichtlinearität? Schmonlinearity.

„Die Tatsache, dass Rückkopplungen, ordentlich aus den Modellen berechnet, die richtige Bandbreite der Klimasensitivität in den Modelle angeben, sollte die Autoren nachdenklich gemacht haben hinsichtlich ihrer Überzeugung, dass sie (in ihrer Analyse) fundamental fehlerhaft ist“.

Und dies, verehrter Leser, ist unser alter Freund in dem Zirkelschluss, nämlich dem argumentum ad petitionem principii [d. h. eine Behauptung wird durch Aussagen begründet wird, welche die zu beweisende Behauptung schon als wahr voraussetzen. Mehr. Anm. d. Übers.], einem der paar dutzend am meisten verbreiteten Trugschlüsse. Aus diesem Trugschluss könnte man höchstens als einzige valide Schlussfolgerung ziehen, dass der Eindringling [perpetrator] unzureichend gebildet ist, um es besser zu wissen.

Um die Brauchbarkeit der einfachen System-Verstärkungs-Gleichung zu zeigen bei der Untersuchung von Gleichgewichts-Sensitivitäten haben wir die von der Klimatologie abgewandelte Gleichung herangezogen und gezeigt, dass bei Anwendung der Bandbreite von Rückkopplungs-Faktoren, welche von Vial et al. (2013) aus den Modellen abgeleitet worden waren, das veröffentlichte Intervall der Gleichgewichts-Sensitivitäten herauskommen würde. Aber dieses Vorgehen sagt uns nichts über den korrekten Wert des Rückkopplungs-Faktors oder dessen nahen Verwandten, den System-Versärkungs-Faktors Um die korrekten Werte dieser Variablen abzuleiten, muss man aus dem Fenster schauen und erkennen, dass die Sonne scheint. Und man muss angemessen dieser Tatsache Rechnung tragen, indem man den Normalsystemverstärkung in die Berechnungen eingehen lässt.

Die Sensitivität jedweden Klimamodells ist so, wie sie ist – sie kann sich nicht ändern durch irgendeine Nach-Analyse von deren Rückkopplungen. In einem Modell wird der CO2-Gehalt verdoppelt, die Berechnung das Strahlungs-Transfers verändert, und Temperaturen, Wasserdampf, Zirkulation, Wolken usw. ändern sich. Das simulierte Klimasystem stabilisiert sich eventuell und die daraus resultierende Gesamtänderung der Temperatur ist die Sensitivität jenes Modells.

Und genau das ist der fundamentale relevante Trugschluss, bekannt als das Strohmann-Argument. Und zwar weil wir keinerlei Nach-Analyse durchgeführt haben von irgendwelchen Modell-Rückkopplungen. Anstatt das zum Scheitern verurteilte von-unten-nach-oben-Verfahren der Modelle zu übernehmen, um die Gleichgewichts-Sensitivität abzuleiten mittels Erratens der Werte irgendwelcher Rückkopplungen, haben wir das weitaus einfachere und robustere von-oben-nach-unten-Verfahren angewendet, um Referenz- und Gleichgewichts-Temperatur für zwei unterschiedliche Jahre in der industriellen Ära zu finden. Dabei haben wir entdeckt, dass die aus diesen Werten abgeleiteten System-Versärkungs-Faktors die gleichen waren. Wir haben den System-Versärkungs-Faktorsauf die Referenz-Sensitivität eines verdoppelten CO2-Gehaltes angewendet und über alle Zweifel erhaben gezeigt, dass die Gleichgewichts-Sensitivität bei doppeltem CO2-Gehalt lediglich 1,17 K beträgt, plus/minus einem Zehntel Kelvin.

Im Grunde sagt der Begutachter, dass die Modelle richtig sein müssen. Nun, wie aufwändig diese auch sind, sie haben unrecht. Sie sind schlicht und ergreifend falsch, wie unsere Analyse gezeigt hat.

Es werden keine physikalischen Argumente angeführt, warum die Sensitivität so gering sein soll, und diese einfach Schätzung als plausibel zu akzeptieren würde bedeuten, dass man sämtliche früheren Arbeiten von Wissenschaftlern bzgl. des Verständnisses der Physik des Klimawandels zurückweisen müsse, von denen viele jenseits aller Zweifel bewiesen sind. Die hier vorgelegte Analyse ist sowohl rudimentär als auch fundamental falsch, und ich kann deren Veröffentlichung in einem seriösen Journal nicht empfehlen.

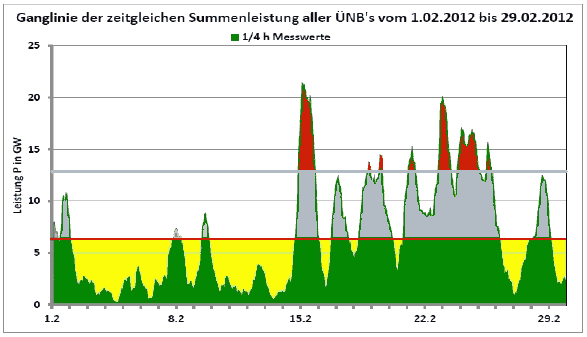

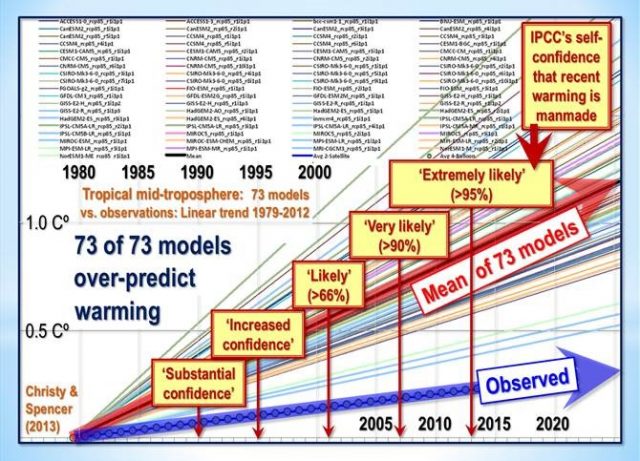

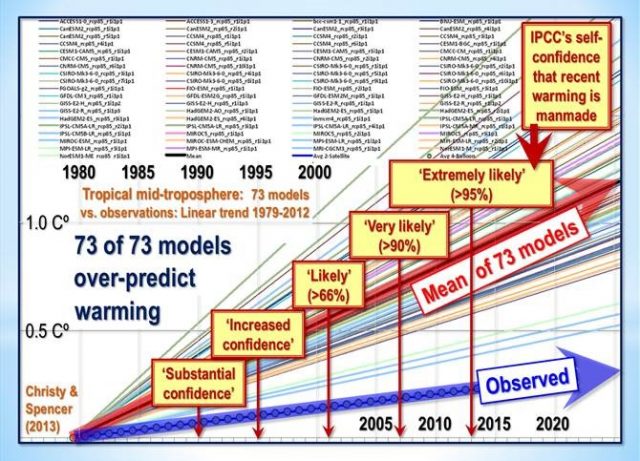

Man betrachte noch einmal die Analyse der Wasserdampf-Rückkopplung oben. Die Größenordnung jener Rückkopplung ist nicht „jenseits aller Zweifel bewiesen“: sie ist jenseits aller Zweifel widerlegt worden. Man betrachte beispielsweise die faszinierende Graphik von Dr. John Christie der prophezeiten mitteltroposphärischen Temperaturänderung über den Tropen in 73 Modellen von 1979 bis 2012. Alle 73 Modelle simulierten eine Erwärmung mit einer mittleren Rate, die etwa vier mal höher war als die beobachtete Erwärmung. Kein einziges Modell zeigt eine geringere als die beobachtete Rate:

Es ist daher sehr wahrscheinlich, dass der Hauptgrund dafür, dass der korrigierte Wert des system-gain-Faktors und damit die Gleichgewichts-Sensitivität so weit unterhalb aller offiziellen Schätzungen liegt, das Überkochen des Wasserdampf-Puddings in den Modellen ist. Aber wir brauchen nicht zu wissen, was die Modelle falsch berechnet haben – es reicht aufzuzeigen, dass sie falsch sind – was unserer Einreichung zufolge unwiderlegbar ist.

In einer Hinsicht hat der Begutachter jedoch recht. Wir weisen in der Tat alle Arbeiten von Wissenschaftlern zur Ableitung der Gleichgewichts-Sensitivität zurück, einfach weil diese Arbeiten – wenngleich ehrlich und gewissenhaft durchgeführt – inkompatibel sind mit den richtigen Ergebnissen, zu welchen wir mit einem weit einfacheren und zuverlässigeren Verfahren gekommen sind.

Man betrachte noch einmal den Rückkopplungs-Faktor oben, und wundere sich über das, was sie gemacht haben. Die perturbation des Klimaantriebs, welchen sie zur Abschätzung der Rückkopplungen heranziehen, ist buchstäblich Anknipsen der Sonne. Man beginne mit der Erde bei Null Kelvin. Nun schalte man die Sonne an, verbiete alle Rückkopplungen, und wir bekommen eine Referenz-Temperatur von 255 K. Jetzt lasse man Rückkopplungen wirken, und unserer jetzigen Welt kommen wir tatsächlich auf eine Gleichgewichts-Temperatur von 287 K.

Vielleicht sind alle Klimatologen Schotten. Es ist nämlich eine große Überraschung für uns, dass immer, wenn wir den Weg nach England einschlagen – oder die Schiffsreise an die Eisküste von Grönland oder einen Flug nach irgendwohin – wir zu unserer Freude feststellen, dass das Land oftmals in die Strahlung eines großen, hellen, warmen gelben Objekts am Himmel getaucht ist. Wir sehen davon nicht so viel im Gaidhealtachd.

Wir müssen die Sonne nicht anknipsen. Weil sie nämlich dank der Großzügigkeit von Divine Providence bereits für uns angeknipst ist (außer in Schottland), und die Engel – in Gestalt der intergalaktischen Mechaniker [grease-monkeys], welche sich das Universum so entfalten lassen, wie es das tut – leisten einen ausgezeichneten Job hinsichtlich Wartung und Fürsorge.

Denn die Sonne scheint nun mal. Liegen wir falsch, wenn wir diese Tatsache berücksichtigen? Wir glauben nicht. Die heute wirksamen Rückkopplungs-Prozesse scheren sich nicht darum, welche Rückkopplungs-Prozesse bei Null Kelvin agierten. Sie reagieren einfach auf die Temperatur, die sie vorfinden. Und das bedeutet, dass es besser ist, die Tatsache zu berücksichtigen, dass die Sonne scheint, als sie zu ignorieren.

Es waren nicht nur die vom begutachtenden Journal nominierten Begutachter, welche unsere Studie begutachtet hatten. Auf irgendwelchen Wegen erreichte eine Kopie unserer Studie den Vizekanzler der University of East Anglia, welcher sofort nach Lektüre der Studie sämtliche 65 Professoren und Doktoren seiner Fakultät Umweltwissenschaften zusammen trommelte und ihnen zurief:

„Moncktons Studie ist eine Katastrophe für uns. Falls die allgemeine Öffentlichkeit jemals davon hören würde, dann würde die Hölle losbrechen!“

Er ordnete an, dass die Fakultät alles zurückstellen und sich nur der Widerlegung der Studie widmen sollten – welche zu jener Zeit 2000 Wörter lang war und jetzt in voller Länge 6000 Wörter umfasst. Er leugnete später, dass dieses Treffen stattgefunden hatte, aber wir hörten davon seitens eines Teilnehmers an dem Treffen.

Und schließlich gibt es einen Kommentar von einem notorisch jähzornigen skeptischen Blogger (natürlich nicht unser genialer Gastgeber hier):

„Nein, wir werden Moncktons Studie hier nicht besprechen. Wir machen es uns nicht so einfach!“

Was ich in Mathematik und Physik gelernt habe, führte mich zu der Vorstellung – die vielleicht falsch ist – dass es viel besser ist, mit einem einfachen Verfahren ein korrektes Ergebnis abzuleiten als mit der Anwendung eines heillos komplexen Modells ein Ergebnis abzuleiten, welches sich nicht zuletzt aufgrund der Komplexität als falsch herausstellt.

Noch ein paar abschließende Fragen für all jene, die die Geduld hatten, bis hierher zu lesen. Haben die Begutachter recht, oder haben wir recht? Und würden Sie gerne von Entwicklungen wie diesem Beitrag auf dem Laufenden bleiben? Die Studie bleibt immer noch zur Begutachtung draußen, und in angemessener Zeit werden wir sehen, ob sie zur Veröffentlichung genehmigt ist. Wir wurden auch eingeladen, ein Buch zuschreiben, in welchem wir unsere Ergebnisse zusammenfassen und beschreiben, wie wir zu eben diesen Ergebnissen gekommen sind.

Und wir haben dem IPCC eine formelle Notiz zukommen lassen, dass alle seine Zustandsberichte gravierend falsch sind. Obwohl wir minuziös dem eigenen, vom IPCC festgelegten Protokoll der Einreichung von Fehlern gefolgt sind, haben wir bisher vom Sekretariat noch nicht den Erhalt der Notiz bestätigt bekommen, obwohl die IPCC-Regeln genau dies vorschreiben. Daher übergeben wir den Fall dem Bureau de l’Escroquerie, dem Swiss Fraud Office via dem Schweizer Botschafter in England, also in der Nation, wo das IPCC sein Hauptquartier hat.

Eine 45 Minuten lange Youtube-Präsentation, in welcher ich unser Ergebnis erkläre, gibt es hier. Ich bin John Charleston sehr dankbar, dass er diesen meinen Vortrag in seinem eigenen Studio gefilmt und bearbeitet hat.

Und hier ist die Einzelfolie aus meinem Vortrag, den ich nächste Woche am Camp Constitution in Connecticut halte. Sie bringt das gesamte Theater der globalen Erwärmung zu einem Ende, und niemand trauert dem nach:

Link: https://wattsupwiththat.com/2018/07/30/climatologys-startling-error-an-update/

Übersetzt von Chris Frey EIKE