Die Sendung befasst sich mit Wetterextremen und leitet daraus salopp Klimaveränderungen ab. Ein heißer und ungewöhnlich trockener Sommer genügt. Wirklich? Die Wissenschaft versteht unter „Klimawandel“ maßgebende Wetteränderungen über mindestens 30 Jahre. Davon lässt sich MONITOR freilich nicht beirren. Zeuge von MONITOR ist der „renommierteste Klimaforscher unserer Zeit“, Prof. Hans-Joachim Schellnhuber, der kleinliche Kritiker an einer globalen Klimakatastrophe als „Profilneurotiker“ (O-Ton MONITOR) diffamiert.

Ist also der in der internationalen Fachwelt wirklich renommierteste Klimaforscher, Prof. Richard Lindzen vom MIT (hier), ein Profilneurotiker? Lindzen war Initiator einer Petition an Donald Trump, die empfahl, aus dem Pariser Klimaabkommen auszusteigen – Petition und ihre Unterzeichner (hier). Alle wissenschaftlich ausgewiesenen Klimaforscher, inklusive ihrer Institute oder Universitäten sind dort namentlich aufgeführt – die Liste liest sich wie ein Who is Who der US-Klimaforschung. Sind alle diese Klimaexperten Profilneurotiker?

Sucht man in Google Scholar (hier sind alle wissenschaftlichen Veröffentlichungen dokumentiert) nach Fachstudien von Schellnhuber, entstehen Zweifel an der MONITOR-Laudatio über Schellnhuber. Als Erstautor in rein wissenschaftlichen Fachaufsätzen ohne politischen Bezug ist Schellnhuber ausgesprochen selten aufzufinden, seine Fachaufsätze sind eher allgemeiner und ins Politische gehend, die harte Arbeit der physikalischen Detailforschung scheint ihm weniger zu liegen. Mit bahnbrechenden neuen Forschungsergebnissen ist Schellnhuber jedenfalls noch nicht hervorgetreten. Um Missverständnisse zu vermeiden: Der Unterschied zwischen einem echten wissenschaftlichen Renomée unter Fachleuten und der von den deutschen Medien aus welchen Gründen auch immer verliehenen Bezeichnung, ist sorgsam zu beachten. Wir kommen auf Schellnhuber noch einmal zurück.

Natürlich kommen in MONITOR auch noch andere Experten zu Wort, so beispielsweise der Schweizer Klimaforscher Prof. Reto Knutti. Bei seiner Aufzählung von Hinweisen für einen menschgemachten Klimawandel ist man leicht verwirrt. „Mehr Regen, weniger Regen“, ist seine Aussage im O-Ton MONITOR. Hmmm, mal regnet’s, mal nicht, was ist daran so besonderes, und warum ist diese meteorologische Selbstverständlichkeit als Zeichen des menschgemachten Klimawandels zu werten?

Wissenschaftliche Fakten waren jedenfalls nicht der Schwerpunkt von MONITOR. Es ging um sog. Klimaskeptiker, die sich einem angeblichen wissenschaftlichen Konsens verweigern und zu einer globalweiten Verschwörungspest ausgewachsen seien. Dazu wurde schweres Geschütz aufgefahren. Ein stellvertretendes Beispiel mag genügen: Vor Jahren hat die Erölindustrie kritische Institutionen finanziell unterstützt. Nun nicht mehr. Was macht daraus eine Sympathie einflößende Dame namens Naomi Oreskes aus den USA im Ferninterview von MONITOR? Es werde eben jetzt nur geschickter gemacht, die Gelder flössen immer noch.

Einen Beweis für diese Vermutung blieb die Lady schuldig. Das Nächstliegende, nämlich dass keine Gelder mehr fließen, kam nicht in Betracht. Nun ist es ja so: Ohne Erdölindustrie könnten wir kein Auto fahren, nicht in den Urlaub fliegen etc. Und ohne Kohle gingen bei uns die Lichter aus. Diese Industrien zahlen ihre Steuern wie alle anderen auch, stellen Arbeitsplätze und kleine Kinder fressen sie auch nicht, jedenfalls ist bis jetzt darüber nichts bekannt. Warum werden sie dann von MONITOR im „Reich des Bösen“ verortet? EIKE hätte absolut keine Probleme damit, von der Erdöl- oder Kohleindustrie finanziell unterstützt zu werden. Leider erfolgt dies nicht.

Die MONITOR-Sendung betraf auch mich persönlich. Nicht nur durch einen eingespielten Interview-Ausschnitt, sondern durch das geführte Interview selbst. Es wurde von MONITOR etwa eine Woche vor der Sendung nachgefragt und 2 Tage davor gemäß meinen gestellten Bedingungen in Heidelberg in einem vom WDR gemieteten Konferenzraum durchgeführt. Ich machte zur weiteren Bedingung des Interviews einen eigenen Tonmitschnitt. War nach einigem Hin- und Her in Ordnung. Natürlich war von vornherein klar, dass nicht das ganze Interview von einer knappen Stunde Dauer, sondern nur Ausschnitte in der Sendung gezeigt werden konnten. Was dann tatsächlich kam, lässt allerdings interessante Schlussfolgerungen über MONITOR, seine Redaktion und die Vorgaben des WDR für die Sendung zu.

Hier den vollen Tonmitschnitt zu bringen wäre zu langatmig und langweilig. Meine „Informations-Kompression“ des Interviews ist allerdings eine andere als die des WDR: ich gebe alle Fragen der Interviewerin, Frau Shafagh Laghai, und meine Antworten zumindest dem Sinne nach wieder. Nur sachlich Unwesentliches, Wiederholungen, zu Längliches etc. lasse ich weg, damit die Mitschnittschilderung „verdaulich“ wird. Ich füge ferner meinen Antworten gelegentlich Anmerkungen oder auch Internetlinks hinzu, die durch den Vorsatz „Anmerkung“ und kursive Schrift von Aussagen unterschieden werden. Auf die Existenz dieser Internetquellen wies ich in meinen Interviewantworten stets deutlich hin, hier sind sie nun real vorhanden.

Trotz mehrfachen Insistierens seitens Frau Laghai habe ich nur Antworten zu sachlichen Fragen gegeben, nicht aber über so etwas wie beispielweise „wie hoch ist die Zahl der EIKE-Mitglieder“ und ähnliches mehr. Meine schriftliche Wiedergabe des Interviews enthält die betreffenden Zeiten in Minuten von Interviewbeginn an. Die hier erkennbaren Lücken erklären sich aus den nicht beantworteten Fragen und dem begleitenden Drum-Herum, weil Frau Laghai unbedingt Antworten wünschte, deswegen zeitverbrauchend insistierte aber dennoch keine bekam.

Über die Motive, das Vorgehen und das Ergebnis der Sendung hatte ich keine Illusionen, denn aus Interviews der Süddeutschen Zeitung (hier) und der ZEIT (hier, hier) lag mir bereits ein ausreichender Erfahrungsschatz über den aktuellen deutschen Qualitätsjournalismus vor.

Warum also diesen nutzlosen Unsinn noch einmal über sich ergehen lassen? Ganz einfach: ich erkenne in solchen Interviews interessante Zeugen der aktuellen Entwicklung Deutschlands. Einer Entwicklung, die durch Qualitätsverlust des Journalismus und sinkendes Demokratieverständnis gekennzeichnet ist. Wir haben heute bereits (noch milde) mediale Zustände wie in der ehemaligen DDR. Die herrschende Politik hat über die von ihr in die Beiratsgremien lanzierten, gut dotierten Regierungslobbyisten dem ehemals freien Journalismus konsequent den Garaus gemacht. Nur links/grün ist noch genehm. Ältere erinnern sich noch an den SPIEGEL, der sich nicht scheute, sogar Regierungen zu Fall zu bringen – heute undenkbar. Und das Fernsehen war damals noch vorwiegend ein Medium der Faktenschilderung und nicht des Meinungs-Oktroi.

Im Vorfeld des Interviews rief mich Frau Laghai an. Als Resultat dieses Gesprächs fand ich es im Hinblick auf die von mir geplante und hier vorliegende Dokumentation zielstellend, Frau Laghai folgende Mail mit Unterlagen zu schicken, wobei mir klar war, dass diese Unterlagen allenfalls überflogen und vermutlich nicht verstanden wurden. Eine Chance sollte die Dame wenigstens haben, denn zumindest am Telefon hörte sie scheinbar interessiert zu. Eventuelles Nichtverstehen lag sicher nicht an bösem Willen von Frau Laghai sondern an ihrem fehlenden naturwissenschaftlichen Bildungshintergrung:

—— Mail an Frau Laghai —————

Sehr geehrte Frau Laghai,

vorbereitende Unterlagen, wie tel. besprochen.

1) Zum „wissenschaftlichen Konsens“: H. von Storch, D. Bray, http://www.hvonstorch.de/klima/pdf/GKSS_2007_11.pdf ferner

Kepplinger und Post,

http://www.kepplinger.de/files/Der_Einfluss_der_Medien_auf_die_Klimaforschung.pdf sowie

https://www.welt.de/welt_print/article1210902/Die-Klimaforscher-sind-sich-laengst-nicht-sicher.html

2) Stimmen gegen das IPCC (Anhang)

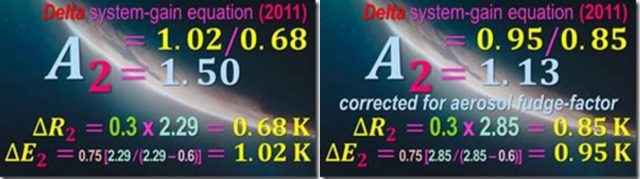

3) Fachveröffentlichung „Schellnhuber_PRE-2003-1.pdf“ mit Schellnhuber als Koautor (Anhang). Der relevante Teil ist gelb markiert – in einer weltweiten Untersuchung hat man keine globale Erwärmung gefunden. Dagegen Schellhubers ZEIT-Interview „DOS-Schellnhuber.pdf“ (ebenfalls Anhang). Zwischen beiden sich widersprechenden Aussagen liegen nur 6 Jahre! Dazwischen ist nichts passiert.

4) Um einen Überblick zu erhalten, meine gutachterliche Stellungnahme zur Klimafrage im Landtag von Nordrhein-Westphalen. Sie können diese Stellungnahme auch vom Regierungsserver herunterladen, die angehängte Version hat aber den Vorteil, dass dort alle Quelle direkt verlinkt sind.

Zum Interview draußen im Park: prinzipiell kein Problem, aber praktisch doch, denn leider ist Heidelberg nicht München mit seinen unzähligen Biergärten. Den Schlosspark kann ich nicht empfehlen, der quillt über von Touristen.

freundliche Grüße

——- Mail-Ende ——————-

Die in der Mail genannten Anhänge sind: Schellnhuber_PRE-2003-1, Gutachterliche Stellungnahme Lüdecke 4April2018, (ZEIT-Interview Schellnhuber), Fachstimmen gegen das IPCC.

Video der MONITOR-Sendung vom 18.8.18 im WDR. Übernommen von YouTube

Nun zum Interview:

Beginn der meiner Tonaufzeichnung = Minute ~2.40

Laghai: Erklären Sie bitte, warum Sie die Hypothese vom menschgemachten Klimawandel ablehnen.

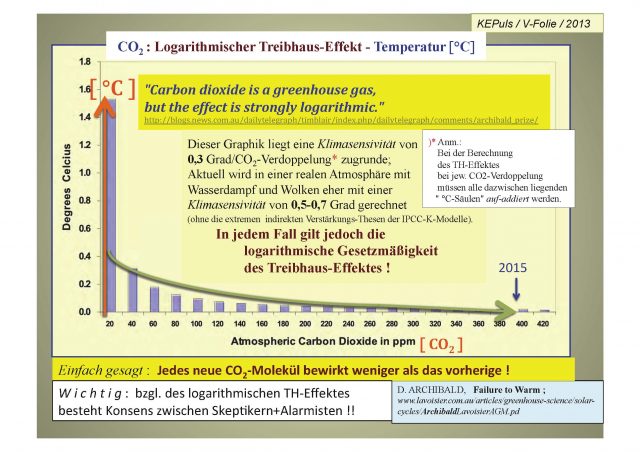

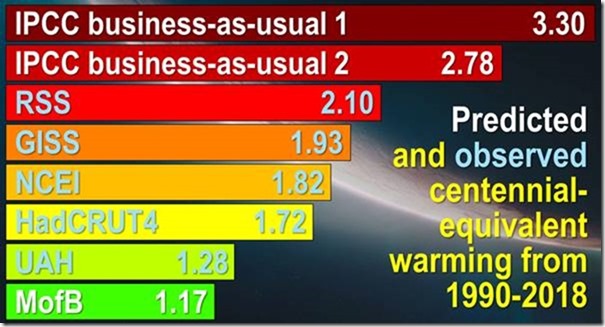

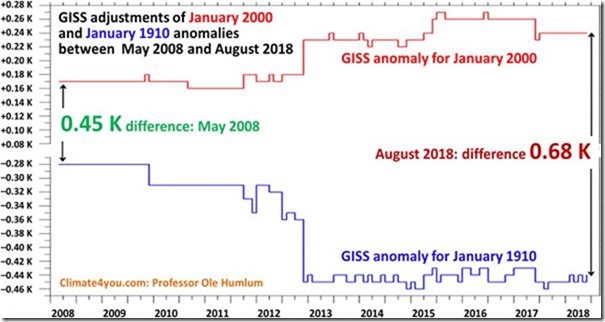

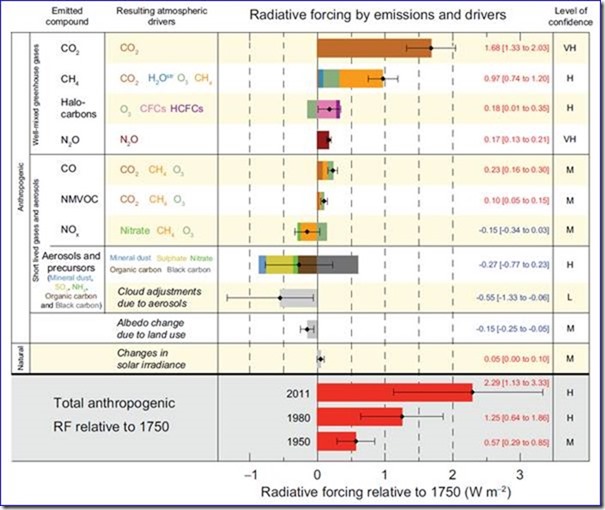

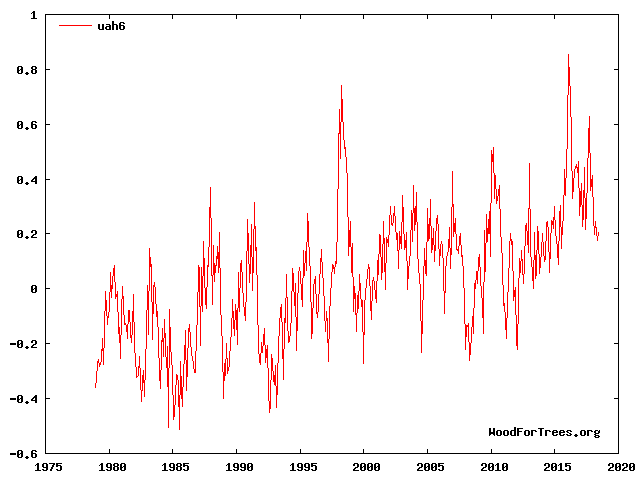

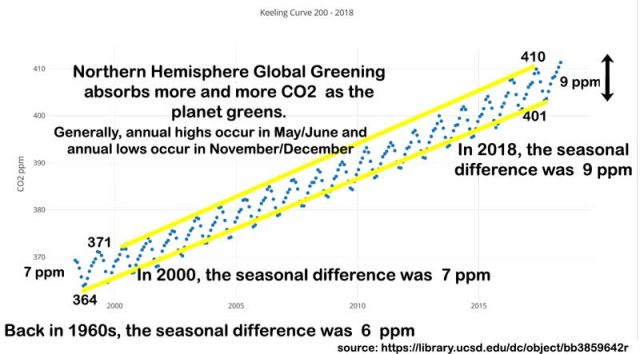

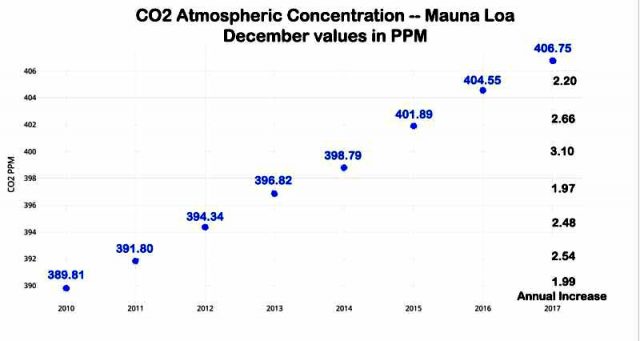

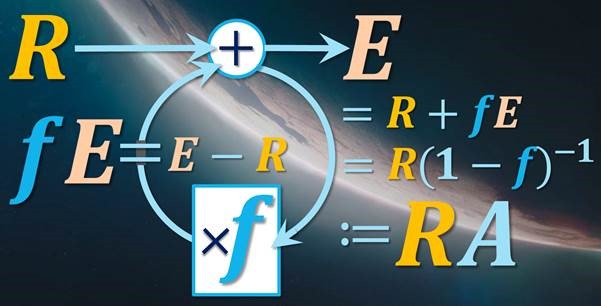

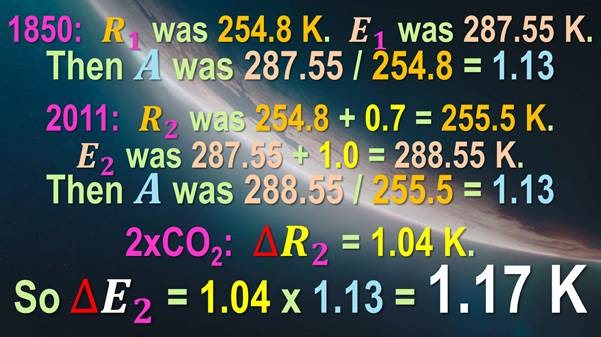

Antwort: Weil es keinen eindeutigen wissenschaftlichen Nachweis gibt, dass menschgemachtes CO2 einen maßgebenden Einfluss auf die Klimaentwicklung hat. Es gibt ausreichend viele Fachveröffentlichungen zu dieser Frage – für und wider. Die entscheidende Größe ist die sog. Klimasensitivität. Sie besagt, um wieviel Grad Celsius die globale Mitteltemperatur bei hypothetischer Verdoppelung des CO2 Gehalts der Luft ansteigt. Ihr Zahlenwert ist unbekannt. Heute vermutet ihn die Klimawissenschaft zwischen 1 bi 1,5 °C – also einer unbedenklichen Größe. Sein Wert war in früheren Fachveröffentlichungen schon wesentlich größer und ist in der Fachliteratur mit der Zeit immer kleiner berechnet bzw. eingeschätzt geworden. Wenn es so weitergehen sollte, wird irgendwann das Resultat Null sein. Kurz: Man weiß nicht, ob das menschgemachte CO2 eine maßgebende globale Erwärmung auslöst. Wahrscheinlich ist, dass eine solche Erwärmung allenfalls unmaßgeblich klein ist.

Interviewzeit = Minute ~5

Laghai: Bitte erklären Sie, warum viele Wissenschaftler das Gegenteil von Ihnen aussagen und davor warnen, dass die menschgemachte globale Erwärmung bis 6 °C erreichen könnte.

Antwort: Es gibt diese Wissenschaftler. Man muss aber unterscheiden zwischen dem, was diese Leute wissenschaftlich publizieren und was sie zwar privat, aber gefühlt „ex cathdra“ in den Medien kommunizieren. Man bezeichnet sie oft auch als Wissenschaftsadvokaten. Das wohl bekannteste Beispiel ist Prof. Schellnhuber. Zwischen dem, was er fachlich veröffentlicht und dem, was er privat und medial wirksam aussagt, gibt es in der Regel keine Schnittmenge. So war Schellnhuber in 2003 Mitautor in einem begutachteten Fachjournalartikel, welcher keine globale Erwärmung auffand (Schellnhuber_PRE-2003-1), die betreffende Stelle ist zum besseren Auffinden gelb markiert. Und gerade einmal 6 Jahre später ruft Schellnhuber in einem ZEIT-Interview den Klimanotstand aus (ZEIT-Interview Schellnhuber). Daher: Es zählt nur das, was in der Fachliteratur steht und nicht, was deutsche Medien an Unsinn schreiben.

Interviewzeit = Minute ~7:30

Laghai: Herr Schellnhuber hat eine Studie veröffentlicht, in welcher der Begriff „Heißzeit“ fiel. Was halten Sie davon? (Anmerkung: Frau Laghai kennt vermutlich nicht den Unterschied zwischen einem Medien-Artikel und einem begutachteten Fachartikel. Daher ihre Frage, was ich vom Begriff „Heißzeit“ hielte).

Antwort: Gar nichts. (Anmerkung: Darauf schilderte ich kurz die Temperaturentwicklung der letzten 9000 Jahre nach Ende der letzten Eiszeit und wies auf das, verglichen mit heute, etwa gleichwarme römische und mittelalterliche Optimum hin. Die beiden Holozän-Warmzeiten, etwa 4500 Jahre und 6500 Jahre vor unserer Zeit waren sogar noch wesentlich wärmer als heute (in Abb. A2-4, hier). In diesen Zeiten entstanden die ersten Hochkulturen, Warmzeiten waren immer positiv für die Menschheit, Kaltzeiten dagegen stets katastrophal, Völkerwanderungen und Seuchen waren ihre Begleiter usw. usw.). Kurz, heute von einer katastrophalen Heißzeit zu sprechen, ist unseriös.

Interviewzeit = Minute 9:30

Laghai: Herr Schellnhuber spricht von einem internationalen Konsens über den menschgemachten Klimawandel. Warum sind Sie dagegen?

Antwort: Aus zwei Gründen. Erstens gibt es den so oft beschworenen Klimakonsens nicht (Anmerkung: folgenden Beispiele belegen es Fachstimmen gegen das IPCC). Es gibt weltweit jede Menge renommierter Klimaexperten, die meine Meinung teilen. Man braucht sich nur die Namen in den von mir aufgeführten Petitionen anzusehen, an welchen Universitäten sie lehren und was sie in Fachzeitschriften veröffentlichten. Zum zweiten hat Wissenschaft mit Konsens nichts zu tun, im Konsens stirbt sie. Nur Abweichler vom Mainstream bringen die Wissenschaft voran. Das wohl bekannteste Beispiel ist die Plattentektonik von Alfred Wegener, die erst posthum gewürdigt wurde.

Interviewzeit = Minute ~14:20

Laghai: Leisten Sie in EIKE wissenschaftliche Pionierarbeit?

Antwort: EIKE ist ein gemeinnütziger Verein von Freiwilligen, meist von Naturwissenschaftlern, Ingenieuren und weiteren Akademikern, der es sich zum Ziel gesetzt hat, die Öffentlichkeit über die Klima- und Energie-Fakten aufzuklären. Dies ist allein deswegen schon nicht schwierig, weil die deutschen Medien, weit mehrheitlich, ihrem Auftrag nach neutraler Aufklärung nicht mehr nachkommen. Es sei hier nur an den zutreffenden Begriff „Lückenmedien“ erinnert. In Deutschland wird einseitig berichtet, dies war die Veranlassung EIKE zu gründen und dies erklärt auch seinen Erfolg.

Interviewzeit = Minute ~15:4

Laghai: Was ist das erklärte Ziel von EIKE?

Antwort: Aufklärung. Daneben gibt es auch noch Forschungstätigkeit in EIKE, mit Fachaufsätzen, die in begutachteten Fachzeitschriften veröffentlicht werden (Anmerkung: hier die Liste unserer Begutachteten EIKE-Veröffentlichungen)

Interviewzeit = Minute ~18

Laghai: Wie wichtig ist die Arbeit von EIKE für die Aufklärung in Deutschland?

Antwort: Sehr wichtig, weil sie im Kontrast zu dem steht, was die deutschen Medien entweder falsch oder gar nicht berichten. EIKE ist unpolitisch und unabhängig. EIKE-Mitglieder decken das gesamte Parteienspektrum ab, ähnlich wie die durchschnittliche Bevölkerung. Bloß Partei-Grüne gibt es meines Wissens bei uns nicht, denn die Grünen sind unsere eigentlichen Gegner.

Interviewzeit = Minute ~19

Laghai: Fragen über Interna von EIKE, wieviel Mitarbeiter hat EIKE (Anmerkung: Frau Laghai meinte wohl Mitglieder).

Antwort: (Anmerkung: Ich gab hierauf keine Antworten).

Interviewzeit = Minute ~20:10

Laghai.: Wo finden Sie politisches Gehör?

Antwort: früher nur bei der Partei der Vernunft, die sich inzwischen aufgelöst hat. Aktuell vielleicht in einigen Strömungen der FDP aber voll und ganz bei der AfD. Sonst bisher in keiner anderen Partei. (Anmerkung: Bei dieser Gelegenheit wies ich auf den verschwindenden Effekt von teuren CO2-Einsparungen Deutschlands hin, nachzulesen in Gutachterliche Stellungnahme Lüdecke 4April2018 auf S. 8 unter „Was bewirken die gesetzlichen CO2 Einparungen Nordrhein-Wetsphalens?“. Diese Stellungnahme ist auch vom Server der NRW-Landesregierung abgreifbar, aber dort sind leider nicht die Quellen verlinkt, hier ist es der Fall. Einsparungen von CO2 schädigt alle Bereiche unseres Lebens vom Autoverkehr bis zur Ernährung. Ich wies auch auf die gleiche Größenordnung von menschlicher Ausatmung und weltweitem CO Ausstoß durch Autoverkehr hin, ebenfalls auf S. 8 in der o.g. gutachterlichen Stellungnahme).

Interviewzeit = Minute ~23

Laghai: Arbeiten Sie mit der AfD zusammen?

Antwort: Jedem der zu uns kommt, um sachliche Auskunft oder gar Mithilfe bittet, wird geholfen – soweit dies möglich ist. Dies sehen wir als unsere gemeinnützige Verpflichtung an.

Interviewzeit = Minute ~24:30

Laghai: Warum beeinflussen Sie die AfD mit Ihrer Meinung?

Antwort: Es ist umgekehrt, die AfD übernimmt unsere Auffassung, wir informieren nur. Auf die aus unseren Sachaussagen gebildete politische Aussage kann, darf und will EIKE keinen Einfluss nehmen. Wenn EIKE-Mitglieder gleichzeitig AfD-Mitglieder sind, ist es ihre private Angelegenheit, wenn sie ihre Expertise in entsprechende AfD-Fachgremien einbringen.

Interviewzeit = Minute ~25:

Laghai: Kennen Sie CFACT und Hartlandinstitut?

Antwort: ich kenne diese beiden Institutionen nicht, habe nur von ihnen gehört, sind anscheinend ähnliche Vereine wie wir in den USA. (Anmerkung: dies ist neben meiner vorangegangenen kurzen Erklärung über EIKE der einzige weitere Interviewpunkt, der in der MONITOR-Sendung gebracht wurde. Der Frage nach CFACT und Hartland folgten noch weitere insistierende Fragen zu ähnlichen sachfremden Themen, zu denen ich keine Antworten gab. Ich betrachte meine Funktion als Pressesprecher als Experte für Sachfragen, nicht für Organisation oder EIKE-Interna. Schade um die verplemperte Zeit).

Interviewzeit = Minute ~34

Laghai. Was werfen sie Wissenschaftlern wie Herrn Schellnhuber vor?

Antwort: Persönlich gar nichts, ich habe Herrn Schellnhuber einmal persönlich kennengelernt, er hat mir auf meine Bitte hin sogar ein Buch mit ihm als Mitautor zukommen lassen. Vorzuwerfen ist Herrn Schellnhuber und seinen wissenschaftlichen Mitstreitern weltweit der permanente Mißbrauch ihrer wissenschaftlichen Arbeiten für politische Zwecke. Wissenschaftler sollten jedem Fragenden, insbesondere auch Politikern neutral Auskunft erteilen aber niemals selbst ihre Arbeiten politisch aktiv instrumentalisieren. (Anmerkung: Ich nannte Frau Laghai als Extrembeispiele den Lyssenkoismus (hier) und die Eugenik der National-Sozialisten (hier), um zu zeigen, wie gefährlich in solchen Extremfällen fehlgegangener Wissenschaft die Einmischung in die Politik werden kann).

Interviewzeit = Minute ~35, Pause wegen Kassettenwechsel bis ~40

Laghai: Was würde passieren, wenn sich die internationale Völkergemeinschaft von den Klimaschutzzielen verabschiedet?

Antwort: Gar nichts. Der Mensch kann die globale Klimaentwicklung nicht beeinflussen. Zu diesem Anlass wies ich auf die sachlich total verfehlte deutsche Klima- und Energiepolitik hin, die mit der Schleifung von CO2 freien Kernkraftwerken begann. Deutschland hat seine selbstgesteckten Klimaziele verfehlt, aber ausgerechnet die USA unter Präsident Trump haben ihre CO2-Emissionen durch vermehrte Gasverbrennung verringert.

Interviewzeit = Minute ~41

Laghai: Was wäre die Gefahr, wenn man an den Klimaschutzzielen festhalten würde?

Antwort: Die Deindustrialisierung Deutschlands durch die jetzt schon katastrophale deutsche Energiewende, die mit deutscher Gründlichkeit vermutlich bis zum bitteren Ende durchgezogen wird. Die Energiewende hat höchste Strompreise, unzuverlässige Stromversorgung, Naturzerstörungen und gesundheitliche Infraschallschädigungen von Anrainern durch Windräder gebracht, sonst nichts. Wenn auch noch die Kohle wegfallen sollte, was hoffentlich verhindert werden kann, müssen wir auch noch teures russisches Gas zur Stromerzeugung kaufen und begeben uns in die Abhängigkeit Russlands. Dabei könnte North Stream, falls mit dem Gas nur Strom erzeugt würde, durch gerade einmal 15 Kernkraftwerke der 1,5 GW-Klasse ersetzt werden. Was in Deutschland in Sachen Klima und Energie unternommen wird ist mit „purer Wahnsinn“ fast noch euphemistisch bezeichnet.

Interviewzeit = Minute 42

Laghai: Also soll sich Deutschland von seinen Klimazielen verabschieden?

Antwort: Selbstverständlich, Klimaziele sind sachlicher Unfug, man kann Klima nicht schützen.

Interviewzeit = Minute ~42:30

Laghai: EIKE wird vorgeworfen, dass es eine politische Agenda habe.

Antwort: Darauf hatte ich schon schon geantwortet. Wir haben keine politische Agenda in Richtung irgend einer politischen Partei Deutschlands. Wenn Sie allerdings unsere sachliche Forderung nach Aufgabe von Klimaschutz und Energiewende als politische Agenda definieren, dann haben wir eine Agenda. Denn Klimaschutz und Energiewende sind sachlicher Irrsinn.

Interviewzeit = Minute ~43:20

Laghai: Was ist Ihre Forderung

Antwort: Abschaffung von Klimaschutz und Energiewende. Rückkehr zur Nutzung der Kernkraft durch Ausnutzung der technisch sinnvollen Laufzeiten unserer noch vorhandenen KKW. Ferner die Forschung an der Generation IV von KKW wieder aufnehmen, die keinen nennenswerten Abfall mehr verursachen, weil sie das Uran fast vollständig verbrennen. Bei Bedarf neue Kohlekraftwerke bauen und Gas nicht für die Stromerzeugung verwenden, es ist zu teuer. Kurz, technische Vernunft und Zukunftsfähigkeit in Deutschland wieder herstellen.

Interviewzeit = Minute ~44

Laghai: Die Wissenschaft ist sich einig, dass es einen menschgemachten Klimawandel gibt, wie sollen wir darauf politisch reagieren?

Antwort: ich sagte bereits, dass Ihre Aussage nicht zutrifft und hatte Ihnen auch die zahlreichen Petitionen und Manifeste von Klimawissenschaftlern gegen die IPCC-Hypothese genannt.

Interviewzeit = Minute ~45

Laghai (Anmerkung: wiederholt und jetzt vorsichtiger formuliert): Es gibt viele Wissenschaftler, die sagen, dass wir eine gefährliche globale Erwärmung durch menschgemachtes CO2 haben. Wir müssen darauf reagieren. Sind Sie damit einverstanden?

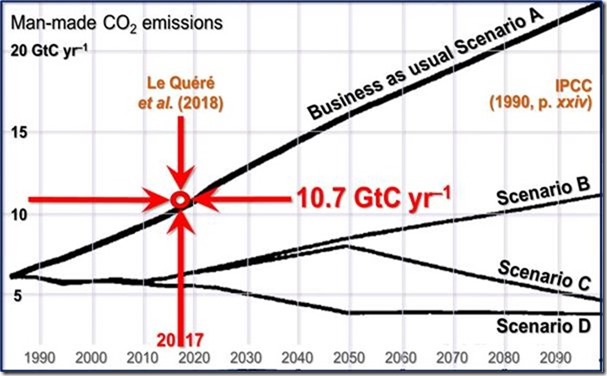

Antwort: Nein, ich weise nochmals auf die entsprechenden Manifeste und Petitionen hin (Fachstimmen gegen das IPCC). Aber selbst dann, wenn – sozusagen hilfsweise – die Klima-Alarmisten recht hätten, wie sollen wir reagieren? CO2 Reduktionen weltweit sind völlig illusorisch, China baut im Wochentakt neue Kohlekraftwerke, die können gar nicht anders, wenn sie ihre Entwicklung vorantreiben wollen. Wenn man tatsächlich weltweite CO2-Einsparungen durchsetzen könnte, würden das Milliarden Menschen nicht überleben.

Interviewzeit = Minute ~46:30

Laghai: Also Sie sagen, dass der CO2-Ausstoß nichts mit der Erderwärmung zu tun hat.

Antwort: Genau dies sage ich. Es gibt keinen wissenschaftlichen Beleg dafür. Die aktuelle Klimaerwärmung ist normal und kam allein nach Ende der letzten Eiszeit sogar oft stärker vor.

Interviewzeit = Minute 47

Laghai: würden Sie sagen, Eike ist ein wissenschaftliches Institut?

Antwort: Ja und nein. Ja, weil EIKE-Mitglieder in begutachteten wissenschaftlichen Fachjournalen veröffentlichen. Nein, weil wir keine Lehre betreiben und daher auch keine Diplomanden oder Doktoranten ausbilden.

Interviewzeit = Minute ~48

Laghai: Sind Sie ein Lobbyverein

Antwort: Nein (Anmerkung: ich war versucht zu sagen „wir sind ein Lobbyverein und zwar für die wissenschaftliche Wahrheit“, unterließ es aber, weil ich befürchtete, dass dann nur der erste Teil des Satzes veröffentlicht und der zweite weggeschnitten wird).

Interviewzeit-Ende = Minute ~49

Fazit zur MONITOR-Sendung

Man könnte viel über die MONITOR-Sendung schreiben. Ich unterlasse es, denn die Sendung spricht für sich. Mir fällt allenfalls dazu der Physiknobelpreisträger Werner Heisenberg ein, der in seinem Buch „Der Teil und das Ganze“ etwas Bemerkenswertes sagte:

„Will man den Wahrheitsgehalt einer Aussage erkennen, sollte man sich zuerst die Methoden des Aussagenden ansehen“