Die elementaren physikalischen Fehler, welche zur Globale-Erwärmungs-Angst führten

Der Richter: Richter William Haskell Alsup, welcher den Vorsitz führen wird in der Causa „People of California“ vs. British Petroleum plc et al. darf man nicht unterschätzen. Er darf als leitendes Mitglied des Northern California Bench (was er seit fast zwei Jahrzehnten war) die Fälle aussuchen, die für ihn am interessantesten aussehen. Er ist kein gewöhnlicher Jurist mit Pudding-Gesicht. Bevor er sich der Jura zuwandte (wo er der Bürgerrechtsbewegung helfen wollte) legte er einen B.S. [Bachelor of Science] im Ingenieurswesen an der Mississippi State University ab.

Vor sechs Jahren stritten sich die beiden Silicon-Valley-Riesen Oracle und Google in einer erbitterten Anhörung über neun Zeilen in einem Computer-Code, von dem Oracle sagte, dass Google diesen Code von Oracle gestohlen hat. Zur Vorbereitung hat Oracle 15 Millionen Zeilen des Android-Code getestet und herausgefunden, dass gerade mal neun Linien – eine Subroutine mit der Bezeichnung rangeCheck – Zeile für Zeile kopiert worden ist. Oracles Klage lautete, dass diese neun Zeilen des Codes ein entscheidendes Element im System waren, obwohl sie gerade mal 0,00006% der gesamten Android-Software ausmachten. Richter Alsup hat ihnen dieses Argument nicht abgenommen.

Um große Männer ranken sich Gerüchte. Hinter vorgehaltener Hand sagen Personen über Richter Alsup, dass er sich selbst die Programmiersprache Java beigebracht habe, so dass er in der Causa rangeCheck entscheidungsfähig war. Tatsächlich ist er mit Java nicht vertraut, aber er schreibt Computer-Programme mittels qBasic, welche normalerweise mit MS-DOS einhergeht. …

Damit ist er ein technisch erfahrener Richter – eine sehr seltene Kombination. Und er hat – was lobenswert, aber ebenfalls sehr selten ist – sich die Mühe gemacht und beiden Seiten neun wissenschaftliche Fragen zum Thema Klimawandel gestellt, was er als „Lehrstunde“ zum Thema verstanden wissen wollte.

Nachdem ich von diesem Verfahren sowie von Bill Alsups Rolle dabei gehört hatte, fragte ich mich, welche Argumentationskette einen wissenschaftlich gebildeten Richter davon überzeugen könnte, dass die Kläger, also zwei kalifornische Städte, die von den fünf weltgrößten Ölgesellschaften Geld haben wollen, um sich an den steigenden Meeresspiegel anzupassen, keinen Grund für einen Alarm bzgl. einer vom Menschen verursachten globalen Erwärmung haben.

Richter Alsup könnte die Klage der beiden Städte verwerfen unter der Voraussetzung, dass die Beklagten in der Lage sind, definitiv klarzumachen, dass Befürchtungen bzgl. einer globalen Erwärmung drastisch übertrieben worden sind.

Dazu zwei Vorschläge: Falls die folgenden zwei Vorschläge befolgt werden, könnte Richter Alsup entscheiden – und jeder außer ein paar Irredentisten* würden überzeugt werden und dem zustimmen – dass globale Erwärmung kein Problem war und dass die Angstmache vorbei ist.

[*Falls jemand – wie ich selbst – nicht weiß, was Irredentismus ist, steht hier bei Wikipedia etwas dazu. Anm. d. Übers.]

1. Man kann beweisen, dass ein elementarer physikalischer Fehler die einzige Ursache des Alarms um die globale Erwärmung ist – elementar deshalb, weil anderenfalls Nicht-Klimatologen es nicht begreifen würden.

2. Man kann mit Bezug auf diesen elementaren Fehler beweisen, dass die gegenwärtigen mittelfristigen Schätzungen der Gleichgewichts-Sensitivität bzgl. anthropogener Aktivitäten mindestens zweimal das sind, was es sein sollte.

Regelmäßig hier Lesende werden wissen, dass ich hier im vorigen Jahr seltener Beiträge gepostet habe. Grund hierfür ist, dass ich die Ehre hatte, ein Team von bedeutenden klimatologischen Forschern zu leiten, die im Stillen, aber sehr fleißig untersuchten, wie viel globale Erwärmung wir verursachen könnten. Bekannt ist dies als die „Gleichgewichts-Sensitivitäts“-Frage.

Wir können jetzt beide oben angesprochenen Punkte beweisen, und wir haben ausführlicher als gewöhnlich mittels multipler empirischer Verfahren gestützt, was wir zuvor mit einem theoretischen Verfahren gezeigt hatten. Alle sechs Verfahren kommen zur gleichen Abschätzung.

Drei Tage, bevor Richter Alsup seine Fragen zur Klimawissenschaft bekannt gegeben hat, hatte mein Team eine Studie mit unseren Ergebnissen einem führenden klimatologischen Journal zugeleitet (die Konvention verpflichtet mich, nicht vor der Veröffentlichung zu sagen, welches Journal das ist).

Frage des Richters:

Als mir die achte Frage des Richters vor Augen kam, die da lautet: „welches sind die Haupt-Wärmequellen, welche für den Temperaturanstieg auf der Erde verantwortlich sind?“, kontaktierte ich meine acht Ko-Autoren. Diese stimmten allesamt zu, eine amicus curiae oder „friend-of-the-court”-Antwort einzureichen.

Unsere Antwort:

Unsere amicus-Antwort, für uns übergeben von einem guten Freund des so wertvollen Heartland Institutes, schließt mit der ehrerbietigen Empfehlung, dass das Gericht die Klage abweisen sollte und dass es auch die Ölunternehmen dazu verurteilen sollte, ihre eigenen Kosten zu benennen, weil ihre öffentlichen me too-Statements mit der Aussage, dass globale Erwärmung ein „Problem“ ist, welchem man entgegen treten muss, auf genau dem gleichen elementaren Fehler beruhen wie die Klage der Kläger.

Tatsächlich haben die Ölgesellschaften zu juristischen Verfahren wie diesem eingeladen um zu klären, weshalb sie für die Kosten ihrer Sünden übernehmen sollten in Übereinstimmung mit dem historischen Prinzip volenti non fit injuria – falls sie ihre Haut zeigen und jemanden dazu auffordern, sie zu schlagen, soll man sich nicht beklagen, falls sie von jemandem getroffen wird.

Der Richter hat das Recht, die Antwort anzunehmen oder zurückzuweisen. Darum fügten wir unserer Antwort den üblichen kurzen Antrag an das Gericht bei, es zur Veröffentlichung anzunehmen. Da die Regeln des Gerichts verlangen, die Antwort als einen Anhang an dem Antrag bekannt zu machen, ist die Antwort in jedem Falle Teil der Gerichtspapiere. Sie wurde allen Parteien zugestellt und ist jetzt von der Öffentlichkeit einsehbar bei PACER, der Datenbasis für die Öffentlichkeit.

Darum kann ich jetzt endlich enthüllen, was wir entdeckt haben. Es gibt in der Tat einen elementaren physikalischen Fehler im Zentrum der Berechnungen der Gleichgewichts-Sensitivität seitens der Modelle. Nach der Korrektur dieses Fehlers und unter der großzügigen Annahme, dass die offizielle Klimatologie keinen anderen Fehler begangen hat außer dem, den wir entdeckt haben, wird die globale Erwärmung nicht 3,3 ± 1,2 K betragen, sondern lediglich 1,2 ± 0,15K. Und das können wir beweisen.

Der Beweis:

Diesen Beweis möchte ich jetzt umreißen. Beginnen wir mit dem Abstract der zugrunde liegenden Studie. Sie besteht aus lediglich [im englischen Original] 70 Wörtern, weil der Fehler wirklich erstaunlich elementar ist (obwohl ich etwa ein Dutzend Jahre gebraucht habe, um ihn dingfest zu machen):

Abstract: In einem dynamischen System induziert selbst ein nicht verstärktes Eingangssignal eine Reaktion auf jedwede Rückkopplung. Bislang jedoch wurde die große Rückkopplungs-Reaktion auf die Emissions-Temperatur fälschlich der Erwärmung durch die natürlich auftretenden, nicht kondensierten Treibhausgase zugeordnet. Nach der Korrektur konnte gezeigt werden, dass der theoretisch abgeleitete vorindustrielle Rückkopplungs-Anteil mit dem empirisch abgeleiteten Wert aus der industriellen Ära zusammenhängt, und zwar um eine Größenordnung unter den vorherigen Schätzungen, was die Reduktion der projizierten Charney-Sensitivität von 3,3 ± 1,2 K auf 1,2 ± 1,5 K erfordert.

Gleichungen: um das Folgende nachvollziehen zu können, brauchen wir drei Gleichungen:

Die Null-Dimensions-Modellgleichung (1) besagt, dass die Gleichgewichts-Sensitivität oder finale Erwärmung ΔTeq das Verhältnis ist der Referenz-Sensitivität oder der initialen Erwärmung ΔTref zu (1 – f ) ist, wobei f der Rückkopplungs-Anteil ist, d. h. der Anteil von ΔTeq,welcher von der Rückkopplungs-Reaktion von ΔT(ref) auf ΔTref repräsentiert wird. Der gesamten Differenz zwischen Referenz und Gleichgewichts-Sensitivität wird durch die Rückkopplungs-Reaktion ΔT(ref) Rechnung getragen (der eingeklammerte Term zeigt eine Rückkopplungs-Reaktion).

ΔTeq = ΔTref / (1 – f ). (1)

Das null-dimensionale Modell findet in den Allgemeinen Zirkulations-Modellen keine explizite Anwendung. Allerdings ist es der einfachste Ausdruck für die Differenz zwischen Gleichgewichts-Sensitivität vor Berücksichtigung der Rückkopplung sowie der Gleichgewichts-Sensitivität nach Berücksichtigung der Rückkopplungen. Gleichung (1), eine vereinfachte Form der Rückkopplungs-Verstärkungs-Gleichung, welche ihren Ursprung in der elektronischen Netzwerk-Analyse hat, kann allgemein angewendet werden, wenn man die Rückkopplungs-Reaktionen in allen dynamischen Systemen ableitet, welche Rückkopplungen enthalten. Die Modelle müssen dies notwendigerweise reflektieren.

Gleichung (1) wird diagnostisch angewendet, und nicht nur zur Ableitung der Gleichgewichts-Sensitivität (d. h. der finalen Erwärmung) aus offiziellen Eingangssignalen beizutragen, sondern auch zur Ableitung derjenigen Gleichgewichts-Sensitivität, welche die Modelle prophezeien würden, falls die Eingangssignale (wie etwa der Rückkopplungs-Anteil f) variiert werden. Wir führten eine sorgfältige Kalibrierung durch, um bestätigen zu können, dass die offizielle Referenz-Sensitivität und das offizielle Intervall des Rückkopplungs-Anteils tatsächlich das offizielle Intervall der Gleichgewichts-Sensitivität zeigt, falls sie in Gleichung (1) eingehen.

Die Gleichung des Rückkopplungs-Anteils (2): Falls die Referenz-Sensitivität ΔTref und die Gleichgewichts-Sensitivität ΔTeq spezifiziert werden, ergibt sich der Rückkopplungs-Anteil f durch die Formulierung von Gleichung (1) als Gleichung (2):

f = 1 – ΔTref / ΔTeq. (2)

Die Gleichung der Referenz-Sensitivität (3): Die Referenz-Sensitivität ΔTref ist das Produkt eines Strahlungsantriebs ΔQ0 in W/m² und des Planck’schen Referenz-Sensitivitäts-Parameters λ0 in K/W/m².

ΔTref = λ0 ΔQ0. (3)

Der Planck’sche Parameter λ0 wird gegenwärtig mit etwa 0,3125 oder 3,2–1 K W–1 m2 geschätzt (Soden & Held 2006; Bony 2006, Appendix A; IPCC 2007, p. 631 fn.). Der CO2-Strahlungsantrieb ΔQ0 beträgt 3,5 W/m² (Andrews 2012). Damit ergibt sich aus Gleichung (3) eine Referenz-Sensitivität ΔTref bei einer Verdoppelung der CO2-Konzentration von etwa 1,1 K.

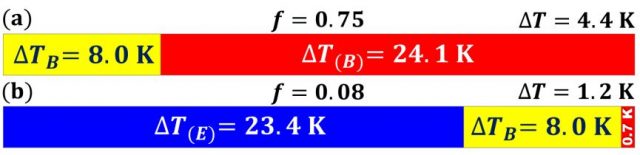

Der „natürliche Treibhauseffekt“ beträgt nicht 32 K: Von der Differenz von 32 K zwischen der natürlichen Temperatur TN (= 287.6 K) im Jahre 1850 und der Emissionstemperatur TE (= 255.4 K) ohne Treibhausgase oder Temperatur-Rückkopplungen stellte man sich bislang vor, dass sie eine Grunderwärmung ΔTB von 8 K (25%) umfasst, direkt getrieben durch natürlich vorkommende, nicht kondensierende Treibhausgase sowie eine Rückkopplungs-Reaktion von 24 K (75%) ΔT(B) to ΔTB, was einem vorindustriellen Rückkopplungs-Anteil von f ≈ 24 / 32 = 0.75 (Lacis et al., 2010) entspricht.

Ähnlich ist es bei der mittelfristigen Referenz-Sensitivität der CMIP 3/5-Modelle ΔTS (= 3.5 x 0.3125 = 1.1 K) und der Charney-Sensitivität ΔT (= 3.3 K). Dabei ist die Charney-Sensitivität die Gleichgewichts-Sensitivität bei einer Verdoppelung des CO2-Gehaltes. Hier wird ein Rückkopplungs-Anteil von f = 1 – 1.1 / 3.3 = 0.67 (Gleichung 2) in der industriellen Ära impliziert.

Der Fehler: Klimatologen haben jedoch den schweren Fehler begangen, nicht zu erkennen, dass die Emissionstemperatur TE (= 255 K) selbst eine substantielle Rückkopplung induziert. Um diesen seit Langem bestehenden Fehler zu korrigieren, haben wir konkretisierend angenommen, dass die Rückkopplungs-Anteile f als Reaktion auf TE und ΔTB identisch seien. Dann haben wir f abgeleitet, indem wir die Delta-Werte ΔTref, ΔTeq in Gleichung 2 einfach ersetzt haben durch die zugrunde liegenden gesamten Quantitäten Tref, Teq, wobei wir Tref = TE + ΔTB und Teq = TN (Eq. 4) setzen:

f = 1 –Tref / Teq = 1 – (TE + ΔTB) / TN

= 1 – (255.4 + 8) / 287.6 = 0.08. (4)

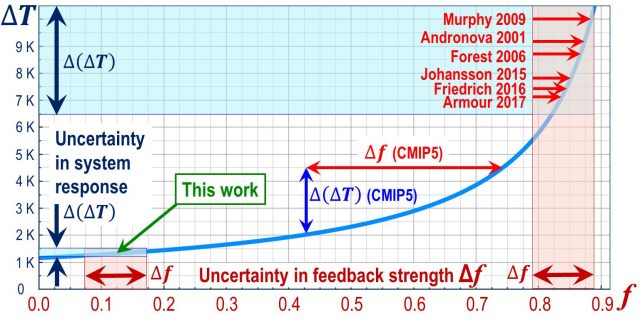

Man vergleiche diesen wahren vorindustriellen Wert f = 0,08 mit der gegenwärtigen mittelfristigen Schätzung von f = 1 – 1.1 / 3.3 = 0.67 (Gleichung 2) seitens der CMIP5-Modelle und mit dem Wert f = 0,75, wie er von Lacis et al. (2010) nicht nur auf den „gesamten natürlichen Treibhauseffekt“ von 32 K, sondern auch auf das „gegenwärtige Klima“ angewendet worden ist.

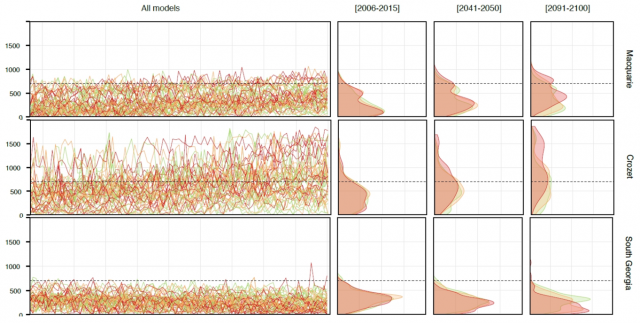

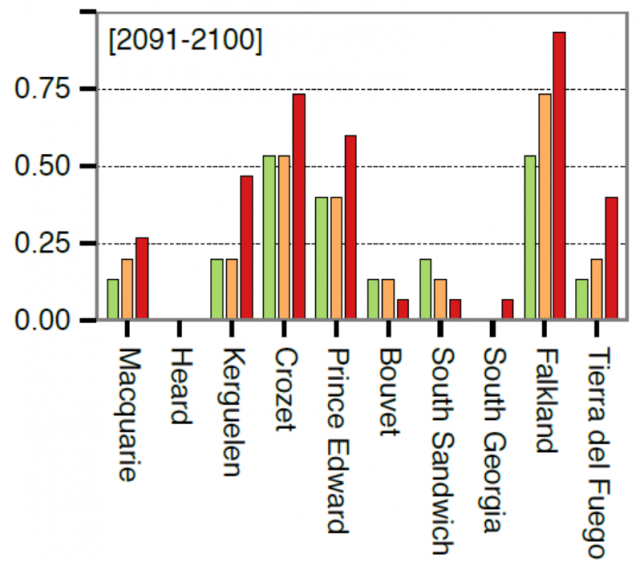

Verifikation: Wir haben uns sehr viel Arbeit gemacht, um mit multiplen empirischen Verfahren das durch das theoretische Verfahren in Gleichung 4 abgeleitete Ergebnis zu verifizieren.

Test 1: Das best estimate des IPCC (IPCC 2013, Abb. SPM.5) lautet, dass etwa 2,29 W/m² des gesamten anthropogenen Antriebs während der industriellen Ära bis 2011 auftraten. Das Produkt dieses Wertes und dem Planck-Parameter ist die Referenz-Erwärmung von 0,72 K (Gleichung 3).

Jedoch wurde eine Erwärmung von 0,76 K beobachtet (als linearer Trend der monatlichen globalen mittleren Temperaturanomalien nach HadCRUT4 von 1850 bis 2011).

Daher ist der Rückkopplungs-Anteil f gleich 1 – 0.72 / 0.76. oder 0.05 (Gleichung 2). Das liegt nahe dem vorindustriellen Wert f = 0,08, jedoch um eine Größenordnung (d. h. um das Zehnfache) unter dem Modellwert von 0,67 oder dem Wert von Lacis 0,75.

Es gibt kaum eine Änderung, dass einige Rückkopplungen nicht in vollem Umfang aktiv waren. Die vom IPCC für die Ableitung der Gleichgewichts-Sensitivität als relevant gelisteten Rückkopplungen (2013, S. 818, Tabelle 9.5) werden vom IPCC (2013, S. 128, Abb. 1.29) mit folgender Dauer beschrieben: Wasserdampf- und Temperaturgefälle-Rückkopplung [lapse-rate feedback] mit Stunden, Wolken-Rückkopplungen mit Tagen und Oberflächen-Albedo-Rückkopplung mit Jahren.

Die neue Charney-Sensitivität: Die Charney-Sensitivität beträgt folglich nicht 1.1 / (1 – 0.67) = 3.3 K (Gleichung 1), wie es sich die CMIP5-Modelle ihrer mittelfristigen Schätzung nach vorgestellt haben (Andrews 2012). Stattdessen, egal ob f = 0,05 oder 0,08 ist, die Charney-Sensitivität ΔTeq = 1.1 / (1 – f ) beträgt 1,2 K (Gleichung 2). Dieser neue Wert [headline value] ist viel zu klein, um sich darüber Sorgen machen zu müssen.

Test 2: Wir stellten Mainstream-Schätzungen des gesamt-anthropogenen Antriebs über zehn verschiedene Zeiträume in der industriellen Ära zusammen und konvertierten jede einzelne davon mittels Gleichung 3 zu der Referenz-Sensitivität. Danach berechneten wir den Rückkopplungs-Anteil f für jeden Zeitraum mittels Gleichung 2.

Das Mittel der zehn Werte von f betrug 0,12, das ist um Einiges höher als der Wert von 0,05 auf der Grundlage der mittelfristigen IPCC-Schätzung von 2,29 W/m² des gesamt-anthropogenen Antriebs in der industriellen Ära. Die Differenz kam zustande durch drei Ausreißer [high-end outliers] in unserer Tabelle der zehn Ergebnisse. Wie auch immer dem sei, die Charney-Sensitivtät für f beträgt lediglich 1,25 K.

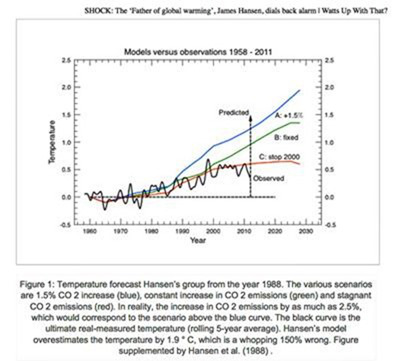

Test 3: Wir untersuchten, wie stark die Erwärmung seit 1950 war, als dem IPCC zufolge unser Einfluss auf das Klima erkennbar war. Die mittelfristige Vorhersage der Charney-Sensitivität seitens der CMIP5-Modelle bei 3,3 K ist gleich der ursprünglichen mittelfristigen Vorhersage der globalen Erwärmung im 21. Jahrhundert in IPCC 1990, S. xiv). Dort wird eine Erwärmung von 1,8 K vorhergesagt, verglichen mit der vorindustriellen Ära (äquivalent mit 1,35 K Erwärmung im Vergleich zu 1990) für den 40-jährigen Zeitraum von 1990 bis 2030. Dies ergibt eine Erwärmungsrate von 1,35 / (40 / 100) = 3,3 K pro Jahrhundert..

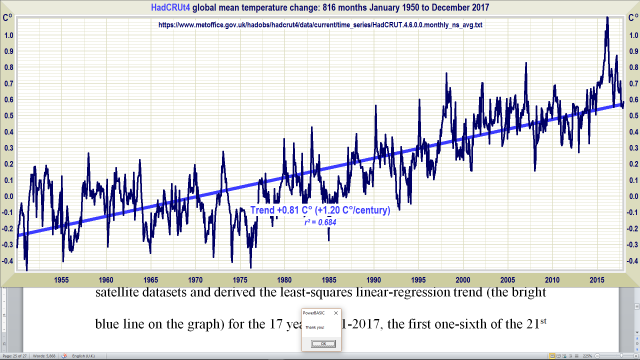

Diese Kongruenz der Werte erlaubt es uns, die aus f (0,05; 0,12) in Gleichung 4 abgeleitete Charney-Sensitivität zu vergleichen mit dem linearen Regressionstrend kleinster Quadrate in den monatlichen globalen mittleren Temperaturanomalien nach HadCRUT4, und zwar während der 68 Jahre von 1950 bis 2017. Die Jahrhundert-äquivalente Erwärmung betrug 1,2 K pro Jahrhundert:

Test 4: Wir verifizierten, dass die Jahrhundert-äquivalente Erwärmungsrate während der ersten 17 Jahre des 21. Jahrhunderts (ein Sechstel des Jahrhunderts) nicht signifikant größer war als die Rate seit 1950. Wir mittelten die monatlichen globalen mittleren Temperaturanomalien an der Oberfläche und in der untere Troposphäre aus den HadCRUT4 und UAH-Satelliten-Datensätzen und leiteten den linearen Regressionstrend kleinster Quadrate ab (die blaue Linie in der nachfolgenden Graphik).

Die Satellitendaten wurden mit übernommen, weil sie einen 8 km hohen Teil der Atmosphäre unmittelbar über der Oberfläche erfassen, und außerdem ist die räumliche Abdeckung größer als die der terrestrischen Messungen. Es ergab sich ein Trend von 0,22 K, äquivalent mit 1,3 K pro Jahrhundert:

Test 5: Um zu bestätigen, dass wir die Rückkopplungs-Theorie richtig verstanden haben, hörte einer meiner herausragenden Ko-Autoren, ein praktischer Elektronik-Ingenieur, von unseren Ergebnissen und konstruierte einen Aufbau, mit dem wir in der Lage waren, das Eingangssignal (d. h. die Emissionstemperatur TE) zu spezifizieren als ein Potential, ebenso wie den direct-gain-Faktor μ unter Beachtung der direkten natürlichen oder anthropogenen Antriebe sowie des Rückkopplungs-Anteils β (wir nutzen die präzisere Form von Gleichung 1, was bei einer elektronischen Netzwerk-Analyse normal ist). Dann war es eine ziemlich einfache Angelegenheit, das Ausgangssignal direkt zu messen (d. h. die Gleichgewichts-Sensitivität ΔTeq).

Das entscheidendste aller Experimente, welche wir mit diesem Aufbau durchführten war es, μ einheitlich zu setzen, was überhaupt keinen Treibhaus-Antrieb impliziert. Wir setzten den Rückkopplungs-Anteil β auf einen Wert ungleich Null und verifizierten dann, dass das Ausgangssignal um das erwartete Ausmaß über das Eingangssignal hinausging. Darüber waren wir in keiner Weise überrascht. Dieses Experiment bewies, dass die Emissionstemperatur allein eine Rückkopplungs-Reaktion induzierte, welche die Klimatologie bislang völlig übersehen hatte.

Das war der elementare Fehler der Klimatologen, den diese ein halbes Jahrhundert lang begingen und der seine verheerenden Auswirkungen hatte. Man betrachte noch einmal Abbildung 1. Das Eingangssignal fehlt vollständig. Obwohl es akzeptabel ist, mittels Gleichung 1 die Gleichgewichts-Sensitivitäten aus den Referenz-Sensitivitäten abzuleiten, war es der Fehler der Modellierer anzunehmen, wie es auch auch Lacis et al. 2010 und viele andere angenommen haben, dass die gesamte Differenz von 32 K zwischen der natürlichen Temperatur TN im Jahre 1850 und der Emissions-Temperatur TE dem natürlichen Treibhauseffekt zugeschrieben worden war unter Einbeziehung einer direkten Treibhaus-Erwärmung ΔTB = 8 K und einer sehr hohen Rückkopplungs-Reaktion ΔT(B) = 24 K auf ΔTB.

In Wirklichkeit jedoch – und das ist der entscheidende Punkt – induziert die Emissions-Temperatur TE (= 255 K) selbst beim Fehlen jedweder Treibhausgase eine starke Rückkopplungs-Reaktion ΔTE. Diese Rückkopplungs-Reaktion auf das Eingangssignal ist bei einer elektronischen Netzwerk-Analyse völlig unstrittig ebenso wie in der Regelungs-Technik allgemein. In der Klimatologie haben wir jedoch keinerlei Hinweise darauf gefunden, dass sie existiert.

Genau wie Lacis (2010) haben die Modellierer angenommen, dass der Rückkopplungs-Anteil der industriellen Ära in jeder Einzelheit genauso hoch sein muss wie der vorindustrielle Rückkopplungs-Anteil, den sie fälschlich aufgebläht haben mittels Hinzufügung der großen, von der Emissionstemperatur induzierten Rückkopplungs-Reaktion zu der geringen, von der Präsenz natürlicher Treibhausgase induzierten Rückkopplungs-Reaktion.

Es war diese Hypothese, welche die Modellierer dazu gebracht hat anzunehmen, dass es irgendwelche sehr stark positive Rückkopplungen geben muss, unter denen die größte die Wasserdampf-Rückkopplung ist. Obwohl jedoch die Clausius-Clapeyron’sche Gleichung zeigt, dass der von der Atmosphäre eingenommene Raum bei Erwärmung nahezu exponentiell mehr Wasserdampf aufnehmen kann, ist damit jedoch nicht gesagt, dass sie das muss.

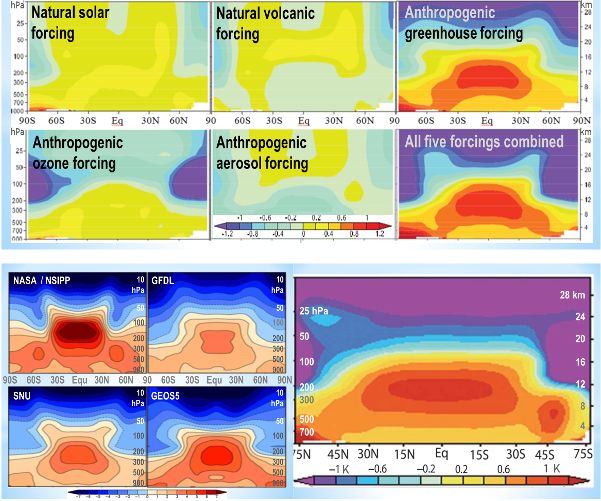

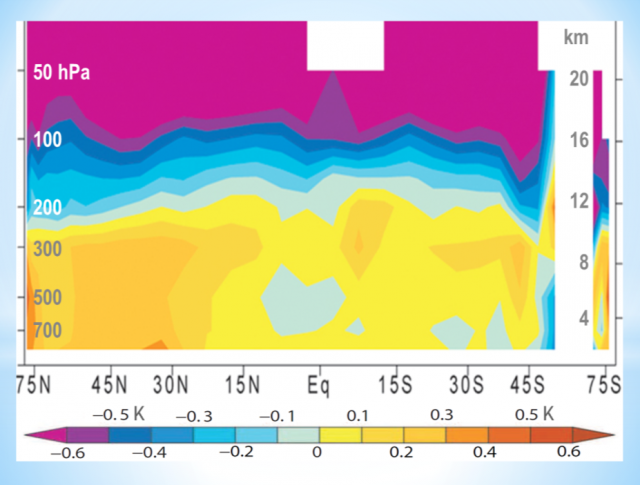

Nehmen wir einmal an, es gäbe tatsächlich eine so große Wasserdampf-Rückkopplung wie die Modelle annehmen. (Diese haben eine sehr große Rückkopplung nur deswegen angenommen, weil sie versucht haben zu erklären, dass der hohe, aber fiktive Rückkopplungs-Anteil ihrer irrigen Annahme einer Emissionstemperatur von 255 K überhaupt keine Rückkopplungs-Reaktion induziert, während die nächsten 8 K Erwärmung auf magische Weise eine Rückkopplungs-Reaktion von 24 K induzieren). In diesem Falle verlangt die atmosphärische Dynamik, dass es einen tropischen mitteltroposphärischen „Hot Spot“ geben muss (ich hatte die Ehre, diese Bezeichnung einzuführen), in welchem die Erwärmungsrate zwei- bis dreimal so hoch sein sollte wie an der tropischen Erdoberfläche. Allerdings wird dieser „Hot Spot“ in der realen Welt nicht gefunden (siehe unten), außer in einem verdächtigen Datensatz, den Dr. Fred Singer vor einigen Jahren eingehend überprüft und dann nachgewiesen hatte, dass er falsch war.

Dieser „Hot Spot“ ist in der gemessenen Wirklichkeit jedoch nicht aufzufinden (siehe unten). Unsere Ergebnisse zeigen den Grund dafür. Der „Hot Spot“ ist ein Artefakt des Fehlers der Modellierer, die von der Emissionstemperatur induzierte substantielle Rückkopplungs-Reaktion zu der von den natürlich auftretenden Treibhausgasen induzierten sehr geringen Rückkkopplungs-Reaktion hinzuzufügen.

Test 6: Sogar noch nachdem wir unseren eigenen Testaufbau konstruiert und betrieben haben, waren wir nicht zufrieden damit, dass irgendetwas anderes als ein unter rigorosen Bedingungen durchgeführter Test in einem Laboratorium der Regierung weithin akzeptiert werden würde. Soweit wir wissen ist dies das erste Mal, dass jemand versucht hat, die klimatologische Rückkopplungs-Theorie empirisch zu testen anstatt sie einfach nur zu modellieren.

Außerdem konstruierten wir auf der Grundlage unserer Ergebnisse im bisherigen Testaufbau eine ausgeklügeltere Spezifikation für einen neuen Testaufbau, zusammen mit unseren vier Testgruppen, welche 23 Sätze von drei Quantitäten umfassen – das Eingangssignal, der direct-gain-Faktor und der Rückkopplungsanteil. Mit dieser Spezifikation beauftragte ich ein Laboratorium der Regierung mit der Durchführung der Experimente.

Jedoch tauchte augenblicklich ein Problem auf – tatsächlich war es ein Problem, mit dem schon unser eigener Ingenieur gekämpft hatte. Die von der schon lange etablierten Regelungs-Theorie vorhergesagten Rückkopplungs-Reaktionen waren so gering, dass selbst die Gegenwart des Operators im gleichen Raum wie der Testaufbau dazu neigte, die Ergebnisse zu verzerren.

Außerdem arbeitete ich ein paar Monate lang mit einem geduldigen und liebenswerten Wissenschaftler des Laboratoriums zusammen. Indem ich die spezifizierten Werte des Ausgangszustandes der 23 Sätze etwas veränderte, war ich in der Lage, dem Wissenschaftler Werte präsentieren zu können, welche die Ergebnisse bis auf die geforderte Präzision genau berechnen konnte, aber ohne Einschränkung der experimentellen Integrität.

Nach angemessener Zeit ging der Bericht des Labors ein, und die Ergebnisse aller 23 Tests lagen bis auf ein Zehntel Kelvin genau bei den Werten, die wir theoretisch vorhergesagt hatten. Auch hier ergaben sich die wichtigsten Ergebnisse in der Testgruppe, in welcher der direct-gain-Faktor einheitlich gesetzt war. Damit konnten wir uns versichern, dass die Regelungs-Theorie korrekt war hinsichtlich der Prognose, dass selbst ein nicht verstärktes Eingangssignal bei Gegenwart eines Rückkopplungs-Anteils ungleich Null eine Rückkopplungs-Reaktion zeigt, welche es entweder verstärken oder es dämpfen würde.

Dann ergab sich eine andere Schwierigkeit. In meiner ursprünglichen Anfrage an das Laboratorium hatte ich nicht erwähnt, dass die Forschung irgendetwas mit Klimawandel zu tun hat, weil alles, was ich wollte war, festzustellen, ob wir die relevante Regelungs-Theorie richtig verstanden hatten.

Nach dem Bericht des Laboratoriums sandte ich demselben einen Entwurf unserer Studie, in welche dessen Ergebnisse Eingang gefunden hatten. Das Laboratorium geriet in Panik und sagte, dass wir den Bericht des Laboratoriums nicht verwenden dürfen.

Allerdings hatte ich in den Vertrag einen Terminus untergebracht, dem zufolge wir beabsichtigten, die Ergebnisse des Laboratoriums sowie eine Diskussion über dieselben in eine akademischen Studie einfließen zu lassen. Ein Kompromiss wurde erzielt, dem zufolge wir die Ergebnisse in unserer Studie nach Belieben anführen dürfen, solange wir nur weder den Namen des Laboratoriums noch den Namen des Wissenschaftlers nennen, welcher den hoch spezifizierten Testaufbau für uns konstruiert und betrieben hatte.

Das Laboratorium bestätigte freundlicherweise auch, dass wir die Ergebnisse ausgewogen in unserer Studie verwendet und daraus gerechtfertigte Schlussfolgerungen gezogen haben. Außerdem beförderte es den Wissenschaftler, der uns assistiert hatte, worüber wir uns sehr freuten. Er schrieb uns einen freundlichen Brief des Inhalts, dass er nicht zugelassen hatte und auch nie zulassen würde, dass sich die Politik in die Arbeit einmischt, welche er für uns gemacht hat.

Mit diesen Ergebnissen eines nationalen Laboratoriums (wir dürfen nicht einmal erwähnen, wo es lag) waren wir endlich zufrieden, weil wir eine hinreichend untermauerte Schlussfolgerung gezogen hatten.

Das wahre Bild: Wie sollte die Differenz von 32 K zwischen Emissions-Temperatur und natürlicher Temperatur aufgeteilt werden? Angenähert sind etwa 23,4 K dieser 32 K der Rückkopplungs-Reaktion der Emissions-Temperatur geschuldet, 8 K ist die direkt getriebene Erwärmung durch die natürlichen Treibhausgase, und lediglich 0,7 K sind die Rückkopplungs-Reaktion auf jene 8 K Erwärmung (Tafel B):

(a) Falsche Aufteilung der 32 K-Differenz zwischen natürlicher Temperatur im Jahre 1850 und Emissions-Temperatur beim Fehlen von Treibhausgasen, nach Lacis et al. 2010.

(b) Korrigierte Aufteilung der 32 K unter Berücksichtigung der Rückkopplungs-Reaktion (blau) auf die Emissions-Temperatur, die direkt getriebene Erwärmung durch die natürlich vorhandenen, nicht kondensierenden Treibhausgase (gelb) und die Rückkopplungs-Reaktion auf jene Treibhaus-Erwärmung (rot).

Nimmt man einmal die andere Sichtweise an, dann würde die Emissions-Temperatur der Erde von 255,4 K eine Rückkopplungs-Reaktion von 766,2 K induzieren, falls der Rückkopplungs-Anteil wirklich so groß wäre wie von Lacis et al. 2010 angenommen, also 0,75. Dann würden die 8 K Treibhauserwärmung eine Rückkopplungs-Reaktion von 24 K induzieren. Damit hätte die vorindustrielle oder natürliche Temperatur im Jahre 1850 255,4 + 766,2 + 8 + 24 ≈ 1054 K betragen müssen, das ist dreieinhalb mal so viel wie der wahre Wert von 287,6 K.

Wir berücksichtigten außerdem, ob Nicht-Linearitäten in individuellen Rückkopplungen unsere Ergebnisse vielleicht beeinträchtigen. Um jedoch die vom IPCC prophezeite Minimum-Charney-Sensitivität zu erhalten, müsste man den empirisch abgeleiteten Rückkopplungs-Anteil f = 0,05 der industriellen Ära mindestens mit fünf multiplizieren.

Der Grund dafür, warum selbst eine sehr große Nicht-Linearität in der Summe der Rückkopplungen und als Konsequenz davon im Rückkopplungs-Anteil kaum einen Unterschied der Gleichgewichts-Sensitivitäten bewirkt ist, dass die Kurve der Gleichgewichts-Sensitivitäten beim Vorhandensein verschiedener Rückkopplungs-Faktoren hyperbolisch verläuft (siehe unten). Unsere Ergebnisse zeigen, dass die Berechnung der Sensitivität nicht wie jetzt ziemlich nahe der Singularität f = 1 durchgeführt worden ist (man beachte, dass für f > 1 in Gleichung 1 Abkühlung vorhergesagt wird). Stattdessen wird die Berechnung am linken Rand der Kurve durchgeführt, wo die Sensitivität nur sehr langsam mit f zunimmt.

Was könnte nun vor Gericht herauskommen? Was wird der Richter aus all dem machen? Meine Vermutung ist, dass er unseren gutachterlichen Bericht zulassen wird. Mit seinem Hintergrund als Ingenieur wird es nicht schwierig für ihn sein zu verstehen, wenn wir sagen, dass die Brandmarkung einer globalen Erwärmung als ,katastrophal‘ anstatt als ,moderat‘ ihren Ursprung in dem elementaren physikalischen Fehler hat, den wir entdeckt haben.

Darum hoffen wir, dass der Richter alle beteiligten Parteien zu formalen Erwiderungen auf unseren Bericht auffordert. Egal wie man es betrachtet, es erhebt sich einfach die ernste Frage, ob die globale Erwärmung überhaupt irgendeine Rolle spielt – eine Frage, die nicht nur im Zentrum des Prozesses liegt, sondern auch für zahlreiche andere Verfahren gilt, zu denen es jetzt in der Rechtsprechung allgemein kommt – und die eine sorgfältige Koordination beweist.

Die beteiligten Parteien dürften kaum in der Lage sein, unser Ergebnis einfach vom Tisch zu wischen. Um es zu widerlegen, müssten sie zeigen, dass unser vorindustrieller Rückkopplungs-Anteil f = 0,08 falsch ist, den wir theoretisch aus der Mainstream-Regelungs-Theorie abgeleitet hatten; dass unser Wert von f = 0,05 aus der industriellen Ära ebenfalls falsch ist, den wir empirisch aus der IPCC-Abschätzung des gesamt-anthropogenen Antriebs und aus HadCRUT4 abgeleitet haben; dass unsere Kampagne mit zehn empirischen Berechnungen falsch ist, aus denen sich ein Rückkopplungs-Anteil f = 0,12 ergeben hatte; dass die Rate der gemessenen Erwärmung während der letzten 68 Jahre entweder falsch oder irrelevant ist; dass die Rate der gemessenen Erwärmung in diesem Jahrhundert bis heute ebenfalls falsch oder irrelevant ist; dass die Ergebnisse unseres Testaufbaus nicht anwendbar sind; dass die Ergebnisse eines Regierungs-Laboratoriums ebenfalls nicht anwendbar sind; und – über allem –, dass es gerechtfertigt ist anzunehmen, dass die Regelungs-Theorie falsch ist und dass eine Emissionstemperatur von 255,4 K überhaupt keine Rückkopplung erzeugt, während die nächsten 8 K Erwärmung plötzlich wie von Zauberhand eine Rückkopplung von 24 K verursachen soll.

Wir glauben nicht an Zauberei.

Schlussfolgerung: Die anthropogene globale Erwärmung, die man erwarten kann, wird gering sein, allmählich erfolgen und sogar insgesamt vorteilhaft sein. Sie wird in diesem Jahrhundert nur etwa 1,2 K betragen, ebenso wie 1,2 K durch CO2-Verdoppelung. Falls es den Parteien nicht gelingt zu zeigen, dass wir falsch liegen, und falls der Richter akzeptiert, dass wir unsere Ergebnisse hier zum ersten Mal öffentlich und detailliert bewiesen haben, dann beruht die Angstmache bzgl. der globalen Erwärmung tatsächlich auf einem atemberaubenden elementaren physikalischen Fehler.

Die von Regierungen und internationalen bürokratischen Institutionen viel zu schnell übernommene alarmistische Position hat zur ungeheuerlichsten Fehlleitung von Ressourcen in der Geschichte geführt.

Meine Damen und Herren, wir fordern ein Ende eines 50 Jahre alten Betrugs, in welchem eine kleine Zahl korrupter und politisierter Wissenschaftler, bezahlt von wissenschaftlich ahnungslosen Regierungen, die wiederum von fragwürdigen Lobbygruppen in Panik versetzt worden sind; Lobbygruppen, finanziert von zweifelhaften Milliardären und auswärtigen Regierungen, die Interesse am Niedergang des Westens haben und begleitet von plumpen und zunehmend totalitären Medien – all diese haben konspiriert, um eine einzelne Lüge voranzutreiben: das die Wissenschaft settled sei.

Nun, das ist sie nicht.

Übersetzt von Chris Frey EIKE

Anmerkung des Übersetzers: Dieser Beitrag ging einige Mal bis an die Grenzen des Verständnisses des Übersetzers. Außerdem geht aus den Schlussabsätzen hervor, dass Lord Monckton von einer Erwärmung durch CO2 ausgeht, wenn auch von einer geringen. Oder habe ich das falsch verstanden? – C. F.