Diesel-Verteufelung: Krieg gegen das eigene Volk – Die Lückenmedien im Glashaus (12)

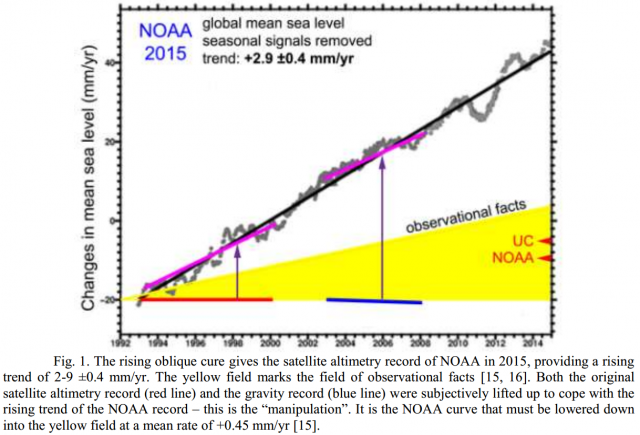

In den bisherigen Teilen dieses Aufsatzes wurde nachgewiesen, dass die NO2-Belastung der Luft in ganz Deutschland und auch an den sogenannten „Hotspots“ in den Städten auf im Prinzip unbedeutende Werte zurückgegangen ist. Wichtiger Grund hierfür ist die stetige Ablösung älterer durch jüngere Fahrzeuge mit besseren Abgasbehandlungssystemen. Dieser Trend wird sich auch in den nächsten Jahren fortsetzen. Auch wurde aufgedeckt, wie fragwürdig die Messmethoden sind und welche Tricks und Manipulationen zum Einsatz kommen. Im dritten Teil wurden die teils grotesk übertriebenen Behauptungen über die gesundheitlichen Auswirkungen von Stickstoffdioxid sowie die offensichtliche Parteilichkeit sowohl der öffentlich-rechtlichen Medien als auch industriefeindlicher Behörden behandelt. Im vierten Teil wurde festgestellt, dass das Auto auch in der Stadt der Zukunft unverzichtbar bleibt und Elektromobilität zurzeit nicht realisierbar ist. Außerdem wurden Widersprüche in den Aussagen des Umweltbundesamtes beleuchtet und anrüchige Querverbindungen zwischen der Deutschen Umwelthilfe sowie Ministerien und Behörden thematisiert. Im fünften Teil wurde gezeigt, dass an der angeblichen Gesundheitsgefährdung selbst durch geringste NO2-Konzentrationen nichts dran ist und die Horror-Stories über zigtausende Tote durch Dieselabgase nicht wissenschaftlich fundiert sind. Zahlreiche Studien basieren sogar auf gefälschten Zahlenwerten. Im sechsten Teil wurden grobe Mängel bei den Studien der US-Umweltschutzbehörde EPA und der WHO dargelegt, mit denen behauptete Gesundheitsgefahren von Stickoxiden „belegt“ werden sollen. Im siebten Teil wird anhand von umfassenden Abgasuntersuchungen in bayrischen Großstädten nachgewiesen, dass selbst an den „Brennpunkten“ des Abgasgeschehens keinerlei Gründe für Fahrverbote für Diesel-PKW vorliegen. Anschließend wurde im achten Teil nachgewiesen, dass die Grenzwertüberschreitungen der Luft punktuell extrem beschränkt sind und der Anteil der betroffenen Bewohner selbst an den Brennpunkten im Zehntel-Promille-Bereich liegt. Der neunte Teil zeigte, wie gering die Beaufschlagung der Anwohner einer Straße mit über dem Grenzwert liegenden NO2-Konzentrationen in Wirklichkeit ist. Im zehnten Teil wurde gezeigt, dass die NO2-Beaufschlagung im eigenen Wohnbereich teilweise sehr viel höher liegt als selbst an den am stärksten befrachteten Brennpunkten des Autoverkehrs. Im elften Teil werfen wir einen kritischen Blick auf die Glaubwürdigkeit einiger Epidemiologinnen, die sich in Deutschland als Anti-Diesel-Aktivistinnen hervortun. Der vorliegende zwölfte Teil beschäftigt sich mit dem Vergleich der Standpunkte in Deutschland im Vergleich zu den USA, dem „gelobten Land“ der Anti-Diesel-Frondeure und geht der Frage nach, wie es die Behörden dort mit Schutz des Volkes vor den vorgeblich so gefährlichen NO2-Belastungen aus Dieselabgasen halten.

Der „#NO2-Aufschrei“ von drei deutschen Epidemiologinnen…

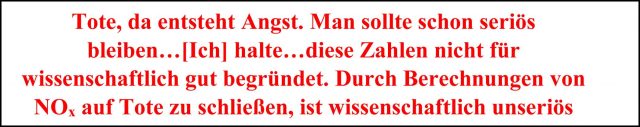

Wie bereits in der letzten Folge ausgeführt, befand der Diesel-Untersuchungsausschuss des Bundestages:

„Es gibt keine wissenschaftlich erwiesenen Zahlen dazu, wie viele Menschen aufgrund grenzwertüberschreitender NO2-Expositionen erkrankt oder gar gestorben sind“.

Dies veranlasste drei deutsche Epidemiologinnen zu einer geharnischten Gegenstellungnahme [KURZ], die sie nicht nur über wissenschaftliche Kanäle, sondern vor allem auch über die Medien breit an die Öffentlichkeit trugen [EPIDE, RBBHO]. Dabei bedienten sie sich der gleichen Methoden und Kanäle wie beispielsweise auch DUH, Greenpeace & Co. Bei den drei Damen handelte es sich um:

- Barbara Hoffmann, Universität Düsseldorf

- Alexandra Schneider vom Helmholtz Zentrum München – Institut für Epidemiologie II

- Claudia Hornberg, Universität Bielefeld

In ihrer Stellungnahme nahmen sie für sich in Anspruch, im Namen der gesamten Wissenschaft zu sprechen: „Unsere Ausführungen basieren dabei nicht auf Einzelmeinungen sondern auf der Gesamtheit der aktuellen wissenschaftlichen Literatur“. Eine der Hauptquellen, auf die dabei Bezug genommen wurde, ist das 1.148 Seiten dicke Kompendium „Integrated Science Assessment for Oxides of Nitrogen – Health Criteria“ der U.S. amerikanischen Umweltbehörde (U.S. EPA) aus dem Jahr 2016. Für diese „Bibel“ der Gesundheitsbewertung des NO2 wurden rund 1.700 Forschungsarbeiten ausgewertet. Die drei genannten Forscherinnen ziehen aus dieser sowie weiteren Dokumentationen folgende Schlüsse:

- „Der Zusammenhang zwischen kurzfristiger Exposition mit Stickstoffdioxid und erhöhter Sterblichkeit, Krankenhauseinweisungen sowie einem erhöhten Risiko für die Atemwegsgesundheit ist wissenschaftlich belegt“.

- „Epidemiologische Befunde belegen negative gesundheitliche Wirkungen von Stickstoffdioxid bereits bei Konzentrationen von 20 µg/m3 im Jahresmittel oder darunter“.

- „Stickoxide haben auch als Vorläufer von Feinstaub und Ozon gesundheitliche Relevanz“.

Bild 2. Prof Dr. med. Hans Drexler, stellvertretender Vorsitzender der MAK-Kommission und Präsident Präsident der Deutschen Gesellschaft für Arbeitsmedizin und Umweltmedizin [DREX]

…erregt in den USA nicht einmal milde Heiterkeit

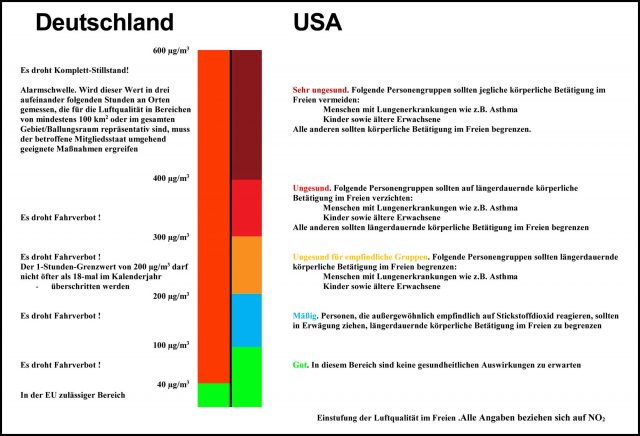

Die USA und ihr Umweltministerium EPA gelten in Kreisen der angeblichen „Umweltschützer“ hier in Europa seit langem als tonangebend. Schließlich sind die USA und insbesondere Kalifornien seit Jahrzehnten die weltweiten Taktgeber im Kampf für saubere Luft und gegen Umweltverschmutzung sowie Klimaerwärmung. Von dort wurde ja auch der sogenannte Dieselskandal angestoßen, mit dessen Hilfe die US-Autoindustrie alle Register zieht, um sich der lästigen deutschen Konkurrenz zu entledigen. Das EPA, das mit der WHO in engem fachlichem Austausch steht, hat natürlich auch eigene Vorgaben und Regeln für die Begrenzung von NO2 bzw. NOx aufgestellt. Diese sind jedoch Welten von dem entfernt, was Europa seinen Bürgern und seiner Autoindustrie anzutun bereit ist. Stichworte wie „Fahrverbot“ oder „Umweltplakette“ finden sich in den entsprechenden Dokumenten nicht. Die in den USA geltenden nationalen Vorgaben sind sehr weit oberhalb dessen angesiedelt, was die EU-Länder vorschreiben [NO2EPA]. So weit, dass es schon seit mehreren Jahren in ganz Deutschland keine Messstelle gibt, die auch nur über der niedrigsten Stufe der US-Vorgaben läge. Die Liste der Maßnahmen bei Überschreitungen beschränkt sich lediglich auf Empfehlungen für das Verhalten der Anwohner – und das selbst bei NO2-Pegeln, bei denen man in Deutschland schon ganze Regionen stillsetzen müsste, Bild 3.

Bild 3. Vergleich der Einstufungen und der zu ergreifenden Maßnahmen für NO2-Immissionswerte in Deutschland und in den USA (Grafik: Autor)

Wer hoch klettert…(korrigiert am 25.2.18 13:42)

In diesem Zusammenhang ist es von Interesse, auf die zeitliche Abfolge der Ereignisse hinzuweisen. Der Bericht des Bundestagsuntersuchungsausschusses stammt vom 22. 6. 2017. Die Gegenerklärung der drei Forscherinnen erschien nach nur wenigen Tagen am 30. 06. 17. Nochmals nur wenige Tage später – 4.7. 2017 – begann sich mit einem Artikel im „Gesundheitsstadt Berlin – das Hauptstadtnetzwerk“ [EPIDE] die Pressekampagne abzuzeichnen, die ihren vorläufigen Höhepunkt mit den Auslassungen von Prof. Hoffmann bei einer massiven Kampagne des RBB gegen den Diesel [RBBHO] erreichte. Auch der gegenwärtige Medienfeldzug im Zusammenhang mit den angeblich sogar noch bis weit unter die aktuellen Grenzwerte hinabreichenden Gefährlichkeit des NO2 [JENA, SWR2] trägt die Handschrift des Umfeldes der drei Epidemiologinnen.

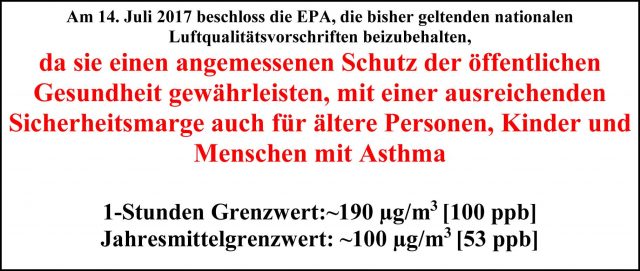

Ganz anders als dieser Schnellschuss sieht dagegen das Timing bei der EPA aus. Zufällig ging man dort mit der Neubewertung der NO2-Risiken nach der Erstellung des entsprechenden Kompendiums fast zeitgleich, nämlich am 14. 7. 2017 an die Öffentlichkeit. Anders als hierzulande, wo gegen die umfassende Arbeit des Untersuchungsausschusses schon nach wenigen Tagen losgepoltert wurde, hatte sich das dort für die gesundheitliche Beurteilung von NO2 zuständige Gremium jedoch anderthalb Jahre Zeit genommen, um die Anfang 2016 veröffentlichte Studie gründlich zu studieren und zu bewerten. Immerhin ist diese Dokumentation, auf die sich auch die europäischen Feinde des Autos gerne beziehen, die derzeit neueste und vollständigste ihrer Art. Doch nach umfassender Bewertung der hierin enthaltenen Zusammenstellung der quasi-Gesamtheit der wissenschaftlichen Erkenntnisse kam das Gremium der EPA – in krassem Widerspruch zu den Schlussfolgerungen der drei deutschen Epidemiologinnen, die sich zu erheblichen Teilen ja auf die gleiche Arbeit berufen – zu einer völlig anderen Bewertung, Bild 4.

Bild 4. Unter Berücksichtigung des neuesten Standes der Wissenschaft hat das US-EPA beschlossen, den bisherigen Jahresgrenzwert von ca. 100 µg/m3 unverändert beizubehalten

Sinngemäß übersetzt lautet die Aussage der EPA-Fachleute wie folgt: „Am 14. Juli 2017 hat die EPA, gestützt auf eine Überprüfung der Gesamtheit der wissenschaftlichen Erkenntnisse, vorgeschlagen, die derzeit geltenden nationalen Luftqualitätsvorschriften für NO2 in der Luft im Freien (NAAQS) beizubehalten. Das EPA vertritt den Standpunkt, dass diese Qualitätsvorschriften nicht geändert zu werden brauchen, da sie einen angemessenen Schutz der öffentlichen Gesundheit gewährleisten, mit einer ausreichenden Sicherheitsmarge auch für ältere Personen, Kinder und Menschen mit Asthma. (Im englischen Original: “On July 14, 2017, based on a review of the full body of scientific evidence, EPA proposed to retain the current national ambient air quality standards (NAAQS) for oxides of nitrogen (NOx). EPA proposes that the current NAAQS don’t need to be changed because they provide the appropriate public health protection, with an adequate margin of safety, including for older adults, children and people with asthma”).

…kann umso tiefer fallen (korrigiert am 25.2.18 13:42)

Wie lautete nochmals der Anspruch der drei obengenannten Wissenschaftlerinnen: „Unsere Ausführungen basieren dabei nicht auf Einzelmeinungen sondern auf der Gesamtheit der aktuellen wissenschaftlichen Literatur“. Sie behaupten sogar, dass „negative gesundheitliche Wirkungen von Stickstoffdioxid bereits bei Konzentrationen von 20 µg/m3 im Jahresmittel oder darunter“ belegt seien. In dem bereits erwähnten Artikel zu den Ergebnissen des Bundestags-Untersuchungsausschusses [EPIDE] finden sich harte Worte wie „Wissenschaftler halten das für absurd“. Ein stolzer Anspruch.

Nur deckt sich ihre Meinung absolut nicht mit den Positionen des EPA, dessen wissenschaftliche Kompetenz nicht zuletzt durch die Herausgabe des bereits erwähnten Kompendiums völlig außer Frage steht. Dass man dort zu völlig anderen Schlüssen kommt als die drei deutschen Forscherinnen, zeigt lediglich, auf welch dünnes Eis sich diese durch ihren Anspruch, „die Wissenschaft“ zu vertreten, begeben haben. Immerhin hält man beim EPA NO2-Gehalte, die um 250 %(!) über dem europäischen Grenzwert liegt, noch für „Gut“ und erwartet selbst bei moderat darüber hinausgehenden Werten keine die Gesundheit oder gar das Leben beeinträchtigenden Gefahren.

Im Rahmen dieser Gegenüberstellung sei noch eine weitere Fachmeinung angeführt, und zwar die des Umweltmediziners Prof. Dr. med. Hans Drexler, Direktor des Instituts und der Poliklinik der Universität Erlangen-Nürnberg, stellvertretender Vorsitzender der MAK-Kommission und Präsident der Deutschen Gesellschaft für Arbeitsmedizin und Umweltmedizin, Bild 5

Bild 5. Prof Dr. med. Hans Drexler, stellvertretender Vorsitzender der MAK-Kommission und Präsident Präsident der Deutschen Gesellschaft für Arbeitsmedizin und Umweltmedizin [DREX]

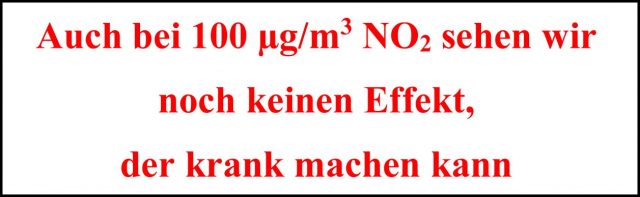

In einem Interview über Effekte des NO2 auf den Menschen sagte er im Zusammenhang mit dem häufig verwendeten Schlagwort vom „messbaren Effekt“ von NO2 auf Menschen: „Ein messbarer Effekt beim Treppensteigen ist ein Anstieg von Puls- und Atemfrequenz. Das macht den Menschen aber nicht krank. Ein Grenzwert soll verhindern, dass messbare Effekte Menschen krank machen. Auch bei 100 µg/m3 NO2 sehen wir noch keinen Effekt, der krank machen kann“ [DREX].

Die Frage, wer hier tatsächlich „die Wissenschaft“ repräsentiert, dürfte sich nach diesen Gegenüberstellungen erübrigen.

Fakten und „Faktenfinder“

Die hier dargelegten Probleme wurden bisher von den Medien ignoriert. Stattdessen hat man sich dort einen regelrechten Wettbewerb in der Frage geliefert, wer am tollsten auf den Dieselmotor und die Individualmobilität eindreschen konnte, wie sich ja auch kürzlich bei der perfiden Diffamierungskampagne gegen Wissenschaftler der medizinischen Fakultät an der RWTH Aachen gezeigt hat.

Bisher hat man sich dort alles andere als kritisch-investigativ mit dem Thema NO2-Belastung des Bürgers beschäftigt. Stattdessen übernimmt man einfach die Positionen von Ministerin Hendricks und dem UBA, als seien deren Ansichten der Weisheit letzter Schluss. Eine eigenständige kritische Wertung von Daten und Hintergründen ist nicht einmal in Ansätzen erkennbar. Dies bestätigt die bereits bisher gemachte Erfahrung, dass die Mehrzahl der Medien – allen voran die Fernsehanstalten ARD, ZDF und ihre Landesdependancen – beim sogenannten „Diesel-Skandal“ einseitig, parteiisch und irreführend berichtet. Statt um Ausgewogenheit und Sorgfalt bemüht man sich offenkundig eher darum, das Thema so darzustellen, wie bestimmte Bundesbehörden sowie die etablierten Parteien es gerne haben möchten. Abweichende Meinungen von Fachleuten, Medien, Journalisten oder Bloggern werden ignoriert. So leistet man dem ideologischen Ziel der Deindustrialisierung Deutschlands durch „Dekarbonisierung der Volkswirtschaft“ Vorschub. Der Diesel ist dabei nur das erste Opfer. Die Vernichtung der deutschen Automobilindustrie wird anschließend auch beim Benziner weitergehen, und zwar alternativlos. Die jetzt wohl unausweichliche „GroKo“ ist für Deutschland ein sehr schlechtes Omen.

Fred F. Mueller

Demnächst folgt Teil 13

Quellen

[DREX] https://www.merkur.de/wirtschaft/umweltmediziner-fahrverbote-medizinisch-nicht-begruendbar-9612595.html

[EPA] https://www.epa.gov/isa/integrated-science-assessment-isa-nitrogen-dioxide-health-criteria

[EPIDE] https://www.gesundheitsstadt-berlin.de/wissenschaftler-widersprechen-berliner-diesel-untersuchungsausschuss-11501/

[JENA] http://www.spiegel.de/gesundheit/diagnose/stickoxide-rascher-anstieg-scheint-herzinfarkt-risiko-zu-erhoehen-a-1194249.html

[KURZ] https://www.uni-duesseldorf.de/home/fileadmin/redaktion/Oeffentliche_Medien/Presse/Pressemeldungen/Dokumente/Kurzstellungnahme_Experten_Umweltepidemiologie.pdf

[NO2EPA] https://cfpub.epa.gov/airnow/index.cfm?action=pubs.aqiguidenox

[RBBHO] https://www.rbb24.de/politik/thema/2017/abgasalarm/beitraege/interview-umweltmedizinerin-barbara-hoffmann.html

[STOE] http://www.spiegel.de/wissenschaft/mensch/kostenloser-nahverkehr-holen-wir-uns-die-welt-zurueck-a-1193916.html

[SWR2] https://www.swr.de/report/presse/unveroeffentlichte-studie-des-umweltbundesamtes-auch-niedrige-stickstoffdioxid-werte-verursachen-bis-zu-8000-vorzeitige-todesfaelle-pro-jahr-in-deutschland/-/id=1197424/did=21207488/nid=1197424/1ak3uh3/index.html