In den bisherigen Teilen dieses Aufsatzes wurde nachgewiesen, dass die NO2-Belastung der Luft in ganz Deutschland und auch an den sogenannten „Hotspots“ in den Städten auf im Prinzip unbedeutende Werte zurückgegangen ist. Wichtiger Grund hierfür ist die stetige Ablösung älterer durch jüngere Fahrzeuge mit besseren Abgasbehandlungssystemen. Dieser Trend wird sich auch in den nächsten Jahren fortsetzen. Auch wurde aufgedeckt, wie fragwürdig die Messmethoden sind und welche Tricks und Manipulationen zum Einsatz kommen. Im dritten Teil wurden die teils grotesk übertriebenen Behauptungen über die gesundheitlichen Auswirkungen von Stickstoffdioxid sowie die offensichtliche Parteilichkeit sowohl der öffentlich-rechtlichen Medien als auch industriefeindlicher Behörden behandelt. Im vierten Teil wurde festgestellt, dass das Auto auch in der Stadt der Zukunft unverzichtbar bleibt und Elektromobilität zurzeit nicht realisierbar ist. Außerdem wurden Widersprüche in den Aussagen des Umweltbundesamtes beleuchtet und anrüchige Querverbindungen zwischen der Deutschen Umwelthilfe sowie Ministerien und Behörden thematisiert. Im fünften Teil wurde gezeigt, dass an der angeblichen Gesundheitsgefährdung selbst durch geringste NO2-Konzentrationen nichts dran ist und die Horror-Stories über zigtausende Tote durch Dieselabgase nicht wissenschaftlich fundiert sind. Zahlreiche Studien basieren sogar auf gefälschten Zahlenwerten. Im sechsten Teil wurden grobe Mängel bei den Studien der US-Umweltschutzbehörde EPA und der WHO dargelegt, mit denen behauptete Gesundheitsgefahren von Stickoxiden „belegt“ werden sollen. Im siebten Teil wird anhand von umfassenden Abgasuntersuchungen in bayrischen Großstädten nachgewiesen, dass selbst an den „Brennpunkten“ des Abgasgeschehens keinerlei Gründe für Fahrverbote für Diesel-PKW vorliegen. Anschließend wurde im achten Teil nachgewiesen, dass die Grenzwertüberschreitungen der Luft punktuell extrem beschränkt sind und der Anteil der betroffenen Bewohner selbst an den Brennpunkten im Zehntel-Promille-Bereich liegt. Der neunte Teil zeigte, wie gering die Beaufschlagung der Anwohner einer Straße mit über dem Grenzwert liegenden NO2-Konzentrationen in Wirklichkeit ist. Im vorliegenden zehnten Teil wird nachgewiesen, dass die NO2-Beaufschlagung im eigenen Wohnbereich teilweise sehr viel höher liegt als selbst an den am stärksten befrachteten Brennpunkten des Autoverkehrs.

Die heilste Welt ist auf der Straße…

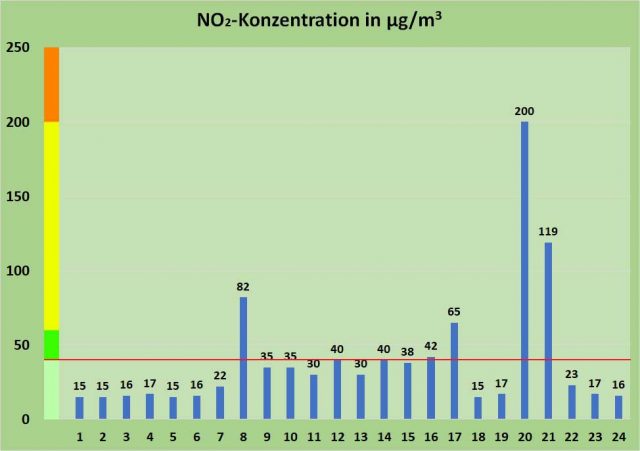

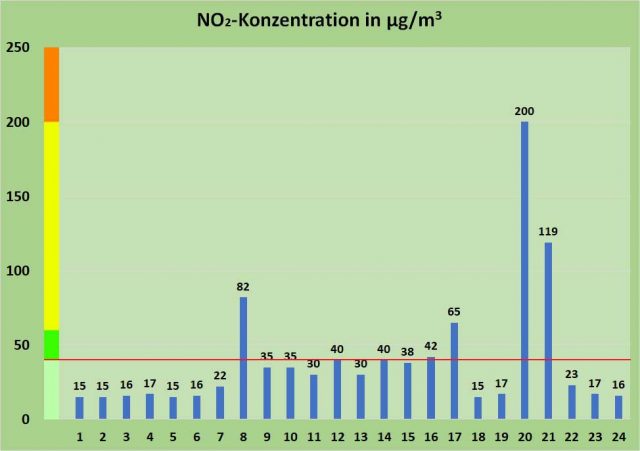

Wie wir im vorigen Teil dieser Artikelserie gesehen haben, spielen die kurzen Aufenthalte auf Straßen mit nennenswert über dem Immissionsgrenzwert von 40 µg/m3 liegenden NO2-Gehalten für das tatsächliche Langzeit-Expositionsbudget der dort wohnenden Bevölkerung de facto keine Rolle. Im Bereich niedriger Gehalte unterhalb der Alarmschwelle von 200 µg/m3 gehen die NO2-Alarmisten der DUH und ihre ideologischen Einflüsterer von der US-amerikanischen Umweltschutzbehörde EPA sowie der Weltgesundheitsbehörde WHO von einer linearen kumulativen Gefährdung aus. Anders ausgedrückt. Es kommt nicht auf den Spitzenwert an, sondern auf den Mittelwert aus abwechselnd höheren und tieferen Gehalten, Bild 2.

Bild 2. Angenommener Expositionsverlauf eines werktätigen Anwohners des Straßenbereichs „Am Neckartor“ in Stuttgart. Nachts Schlafzimmer, Morgens 8 Uhr Straßenluft, Tagsüber Büro, 17 Uhr Straßenluft + Tee, 20 Uhr Dinner bei Kerzenschein im Lokal. Hellgrün: Zulässiger Konzentrationsbereich auf der Straße, Dunkelgrün: Zulässig für Innenräume, Gelb: Bereich unterhalb des 1-Stunden-Grenzwerts für den Schutz der menschlichen Gesundheit, Orange: als gefährlich definierter Bereich zwischen 1-Stunden-Grenzwert und MAK-Wert. Die rote Linie markiert den Grenzwert für die Luft auf der Straße

In diesem Mittelwert sehen die Behörden das entscheidende Kriterium für die Beurteilung einer gesundheitlichen Gefährdung. Liegt dieser oberhalb von 40 µg/m3, so halten sie drastischste Maßnahmen, die auf eine Enteignung von Millionen Besitzern von Diesel-PKW sowie die faktische Zerstörung wesentlicher Teile unserer wichtigsten Exportindustrie hinauslaufen, für gerechtfertigt. Wird auf der Straße jedoch besagter Jahresmittelwert von 40 µg/m3 eingehalten, so ist für sie die Welt in Ordnung. Was zu Hause oder in der Firma los ist, scheint aus ihrer Sicht keine Rolle zu spielen. Trotz wortreicher Gegenbeteuerungen geht es ihnen im Kern nur um ein Ziel: Das Auto als Symbol unserer technischen Zivilisation anzugreifen und zu verteufeln.

…doch Zuhause…

Diese Haltung ist an Heuchelei nicht zu überbieten. Denn in Innenräumen, zu denen neben Büros auch das eigene Heim, Krankenhäuser und Gaststätten zählen, verbringen wir rund 90 % unserer gesamten Lebenszeit. Und in diesen Räumen ist selbst für diejenigen, die keine Berufe wie Schweißer oder Chemietechniker ausüben, sowohl beruflich als auch zuhause eine Konzentrationen von 60 µg/m3 zulässig [HIST, AIR]. Das sind 50 % mehr als das, was auf den Straßen angeblich niemals überschritten werden dürfte, wenn man nicht die Schuld an zigtausendfachem Tod auf sich laden möchte [RBBA]. Ginge es dem UBA oder der DUH wirklich um die Volksgesundheit, so müsste letztere in flammendem Protest gegen diese um 50 % höheren zulässigen Konzentrationen in Innenräumen auf die Straße gehen, statt sich ausschließlich auf den Dieselfahrer zu stürzen. Von den insgesamt 519 offiziellen Messtellen des Umweltbundesamtes gab es 2016 in ganz Deutschland nur ganze sieben, an denen überhaupt ein Jahresmittelwert von mehr als 60 µg/m3 gemessen wurde, also dem Wert, den man in unseren Wohn-, Schlaf- und Kinderzimmern als normal und zulässig einstuft [MESS]. Dabei hält sich auf diesen wenigen hoch beaufschlagten Straßenabschnitten schon aufgrund des hohen Verkehrsaufkommens niemand länger auf als unbedingt notwendig.

…gelten andere Regeln…

Die Pharisäer von der DUH machen sich die Tatsache zunutze, dass so gut wie niemand in der allgemeinen Bevölkerung weiß, dass die NO2-Konzentration gerade im privaten Bereich oft deutlich höher liegt als alles, was der heutige Verkehr überhaupt verursachen kann. Das ist deswegen viel gravierender, weil der Bürger dort im Normalfall gute 13,5 Stunden des Tages verbringt, weit mehr als die 8 Stunden, die er sich am Arbeitsplatz aufhält oder die vielleicht 20 Minuten Verweilzeit auf stärker beaufschlagten Straßenabschnitten. Und in Gebäuden kommen die NO2-Gehalte beileibe nicht nur von der Straße, selbst wenn dort zufälligerweise einer der relativ seltenen „Hotspots“ mit Werten oberhalb des zulässigen Limits von 40 µg/m3 liegen sollte [HIST, DIMI].

In der Realität verhält es sich genau andersherum: In vielen Innenräumen – sowohl im privaten Bereich als auch in öffentlich zugänglichen Räumen wie z.B. Gaststätten – liegen die NO2-Gehalte der Luft teils sogar erheblich über beiden Grenzwerten (40 µg/m3 für draußen, 60 µg/m3 für drinnen). Das ist den Dieselgegnern sehr unangenehm, da es ihrer Ideologie widerspricht. Sie behaupten ja, dass rund 75 % des „NO2-Übels“ in unseren Städten von den Diesel-PKW auf den Straßen kommt [LOHS, FAKT]. Deshalb versuchen sie so zu tun, als stammten auch erhöhte NO2-Gehalte in Wohnungen im Wesentlichen von den Dieselabgasen der Straße. Zuzugeben, dass dem nicht so ist, würde insbesondere die Hauptlinie der Argumentation unzähliger epidemiologischer Studien infrage stellen. Deren Ansatz stützt sich nämlich sehr häufig vor allem auf den Abstand der Wohnung der untersuchten Personengruppe zu stark befahrenen Straßen.

Diejenigen NO2-Anteile der Außenluft, die in Innenräume gelangen, werden dort nämlich durch Selbstreinigungsprozesse in erheblichem Umfang abgebaut. Deshalb weist die Luft in Wohnungen und sonstigen Innenräumen selbst an sehr stark befahrenen Straßen im Vergleich zur Außenluft in der Regel erheblich niedrigere NO2-Gehalte auf. Es sei denn, es kommen andere NO2-Quellen ins Spiel, die sich im Inneren des Gebäudes befinden und mit dem Verkehr gar nichts zu tun haben. Diese Tatsache ist den diversen „aktivistischen“ Epidemiologen, die unsere Medien mit Panikmeldungen über angebliche Gefahren des NO2 füttern, natürlich bestens bekannt. Entsprechende Kenntnisse sollte man auch von Professorin Annette Peters, Direktorin des Instituts für Epidemiologie am Helmholtz Zentrum München, erwarten dürfen. Umso verwunderlicher der Text eines Artikels in der FAZ über die „Gefahren“ des NO2 in der Luft unserer Städte, der auf einem Gespräch mit Prof. Peters beruht. Sinngemäß steht dort, es sei noch nicht erforscht, in welchem Umfang die Stickoxide durch die Fenster in die Innenräume der Wohnungen dringen [PEHO].

Sollte der Journalist der FAZ Prof. Peters richtig wiedergegeben haben, so wäre diese Stellungnahme dem Ruf der Dame ebenso wie dem ihrer beiden Institute in höchstem Maße abträglich. Denn schon 1998 stellte der Ausschuss für Innenraumrichtwerte in seiner bis heute gültigen Stellungnahme zu NO2 in Innenräumen [AIR] [AIR] folgendes fest: „In Innenräumen liegen die gemessenen NO2-Konzentrationen meist unter den Außenluftkonzentrationen, da NO2 sich an Oberflächen abbaut….Im Rahmen einer internationalen Untersuchung mit Passivsammlern, die im Winter 1996 in 13 Ländern in insgesamt 17 Städten durchgeführt wurde, wurden in Erfurt und Berlin als Innenraumkonzentrationen 17 bzw. 23 µg/m3, in der Außenluft 28 bzw. 70 µg/m3….als NO2-Mittelwerte gemessen“.

Einem Institut, dessen Leiterin derartige Unkenntnis grundlegender Fakten ihres Forschungsgebiets offenbaren würde, dürfte man eigentlich weder Aufträge des Umweltbundesamtes noch Berufungen in beratender Funktion z.B. für Bundestagsausschüsse zukommen lassen.

…denn dort lauern regelrechte NO2-Bomben

In Wirklichkeit sollen derartige Statements vor allem von einer Tatsache ablenken, die für die Dieselgegner sehr unangenehm ist: Die wirklich hohen NO2-Expositionen lauern nicht auf der Straße, und sie kommen nicht aus dem Auspuff der Diesel-PKW, sondern sie kommen aus den Wohnungen selbst. Und sie liegen bis zu mehr als dem Hundertfachen (!) über dem Straßen-Grenzwert, ab dem man bei uns das halbe Land zum Stillstand bringen will. Schauen wir solche Quellen einmal näher an, Bild 3.

Bild 3. Das Kerzenlicht eines Adventskranzes vermittelt ein starkes Gefühl von Heimeligkeit und familiärer Geborgenheit

Adventsstimmung, Wärme – und Stickoxide in rauen Mengen

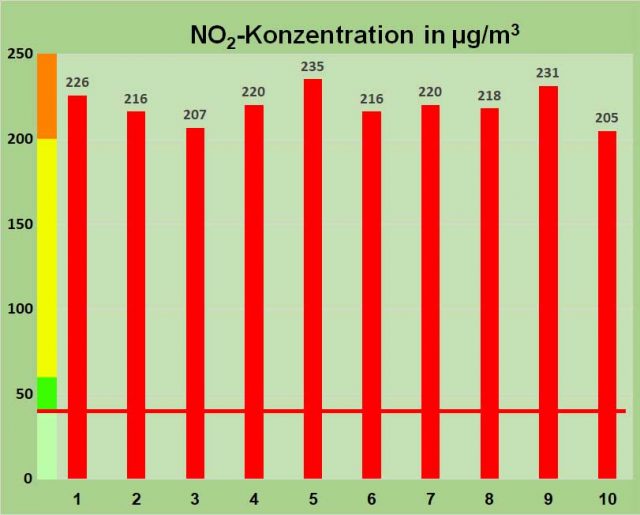

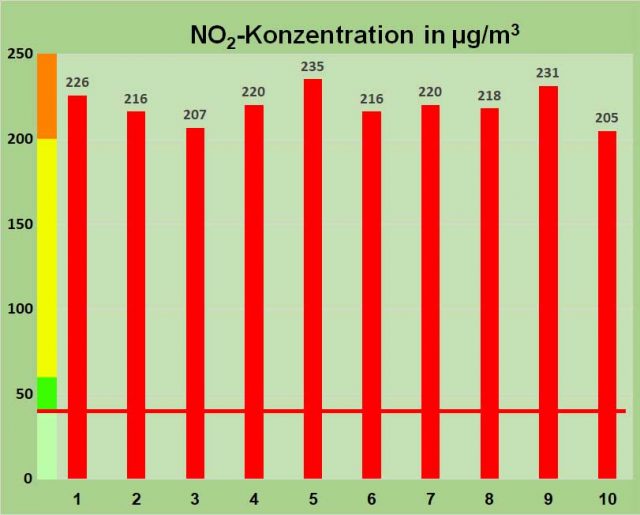

Es gibt so gut wie keinen Haushalt, in dem keine Kerzen verwendet werden. Kerzen verbreiten anheimelnde Stimmung, spenden ein besonderes, lebendig wirkendes Licht und werden auch gerne zum Warmhalten von Getränken oder Speisen eingesetzt. Manche bevorzugen auch spezielle Duftkerzen. Wer weiß denn schon, dass in einer Kerze im Prinzip ähnliche Vorgänge ablaufen wie in einem Dieselmotor, d.h. eine Verbrennung mit einem vergleichsweise hohen Luftüberschuss. Von Grömping et al. durchgeführte Untersuchungen der NO2-Konzentration im Abgas einer Kerze [GROEM] ergaben Werte zwischen 205 und 235 µg/m3, Bild 4.

Bild 4. Bei mehrfachen Untersuchungen des Abgases einer Kerze fanden Grömping et al. NO2-Konzentrationen zwischen 205 und 235 µg/m3 (Daten: [GROEM]) Hellgrün: Zulässiger Konzentrationsbereich auf der Straße, Dunkelgrün: Zulässig für Innenräume, Gelb: Bereich unterhalb des 1-Stunden-Grenzwerts für den Schutz der menschlichen Gesundheit, Orange: als gefährlich definierter Bereich zwischen 1-Stunden-Grenzwert und MAK-Wert. Die rote Linie markiert den Grenzwert für die Luft auf der Straße

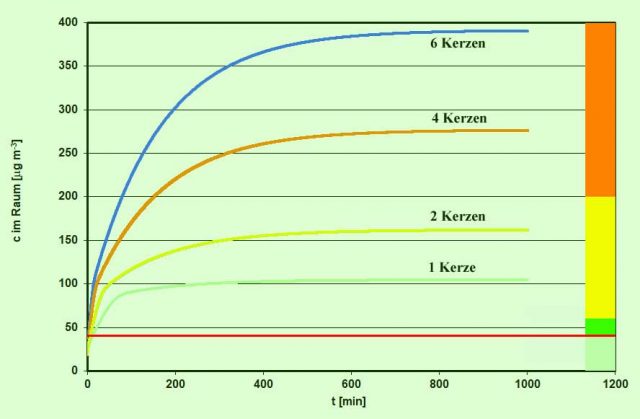

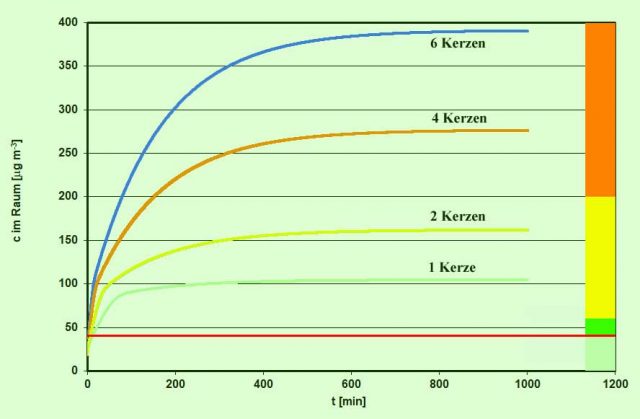

Im Rahmen einer anderen Untersuchung ermittelten Bartolomei et al. [BART] für Kerzen Stickoxidemissionen zwischen 3,4-5,0 mg/h für NO und 1,8-3,4 mg/h für NO2. Rechnet man die NO2-Emissionswerte auf ein Wohnzimmer mit einer Fläche von 50 m2 und einem Volumen von 125 m3 um, so ergibt sich ein stündlicher direkter NO2-Eintrag von bis zu 27 µg/m3, der sich im ungünstigsten Fall ca. verdoppeln kann, wenn man berücksichtigt, dass auch das emittierte NO durch die Reaktion mit Ozon (O3) in NO2 umgewandelt wird. Natürlich reduziert sich dies durch Abbauprozesse sowie den Luftwechsel, doch ist es durchaus realistisch anzunehmen, dass schon vier längerfristig brennende Kerzen ausreichen können, die NO2-Konzentration der Raumluft weit über die zulässige Grenze (bis auf mehr als 250 µg/m3) anzuheben. Bestätigt wird dies durch Simulationen, die in der Arbeitsgruppe Physikalische & Theoretische Chemie der Fakultät für Mathematik und Naturwissenschaften der Universität Wuppertal erstellt wurde. Dabei werden auch die Reaktion des von den Kerzen zusätzlich emittierten NO mit von außen eindringendem Ozon sowie die Abbaureaktion des NO2 mit den Raumwänden berücksichtigt. Die Ergebnisse für verschiedene Kerzenanzahlen zeigt Bild 5.

Bild 5. Simulation der NO2-Konzentration in einem 50-qm-Wohnzimmer beim Abbrennen von Kerzen (Grafik: Uni Wuppertal/ Kleffmann) Hellgrün: Zulässiger Konzentrationsbereich auf der Straße, Dunkelgrün: Zulässig für Innenräume, Gelb: Bereich unterhalb des 1-Stunden-Grenzwerts für den Schutz der menschlichen Gesundheit, Orange: als gefährlich definierter Bereich zwischen 1-Stunden-Grenzwert und MAK-Wert. Die rote Linie markiert den Grenzwert für die Luft auf der Straße

Die wirklichen Gesundheitsgefahren lauern bei Kerzen allerdings in den zahlreichen anderen Emissionen, welche sie produzieren. So weist der US-Mediziner Michael Segal darauf hin, dass Kerzen auf gleich drei verschiedene Arten Asthma auslösen können: Durch flüchtige Paraffinbestandteile, durch Rauch (=Feinstaub, FFM) sowie durch die vor allem in Duftkerzen enthaltenen Parfums [KERZ]. Gefahren gehen darüber hinaus auch von Streichhölzern sowie von allen Arten von Räucherwerk aus, die ebenfalls Feinstaub und NO2 erzeugen [RAUCH].

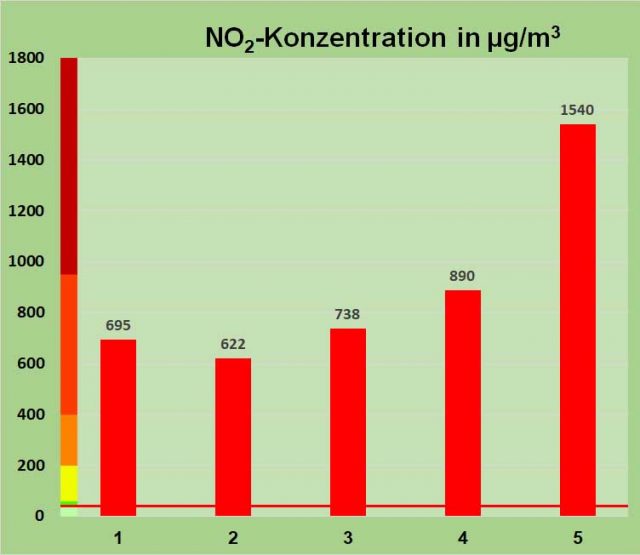

Zigaretten: Genuss, Entspannung – und Stickoxide bis weit oberhalb des MAK-Werts

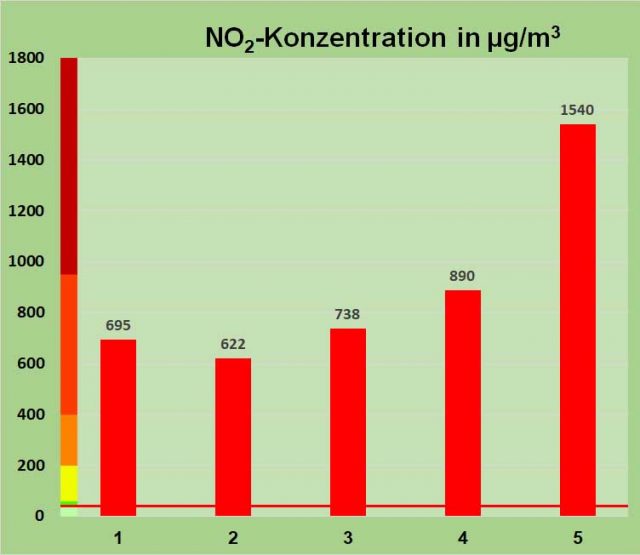

Eine ganz massive NO2-Quelle in Innenräumen sind Zigaretten. Während ihre gesundheitsschädlichen Wirkungen allgemein bekannt und bestens dokumentiert sind, dürfte die Tatsache, dass ihr Rauch auch erkleckliche Mengen an NO2 enthält, nur den wenigsten bekannt sein. Von den gesundheitlichen Auswirkungen her spielt das NO2 in diesem Giftcocktail im Prinzip keine wirkliche Rolle, aber angesichts der geradezu hysterischen Angstmache, die derzeit zu diesem Thema in den Medien betrieben wird, soll eben auch dieser Aspekt hier entsprechend gewürdigt werden. Hierfür wurden die Untersuchungsergebnisse von zwei Forschergruppen herangezogen und in einem Diagramm zusammengefasst, Bild 6.

Bild 6. Sowohl Grömping et al. (Nr. 1-3) [GROEM] als auch Shen Yi et al. (Nr. 4-5) [ZIGA] untersuchten die Konzentration von NO2 in Zigarettenrauch. Hellgrün: Zulässiger Konzentrationsbereich auf der Straße, Dunkelgrün: Zulässig für Innenräume, Gelb: Bereich unterhalb des 1-Stunden-Grenzwerts für den Schutz der menschlichen Gesundheit, Orange: als gefährlich definierter Bereich zwischen 1-Stunden-Grenzwert und MAK-Wert, Rot: Bereich bis MAK-Wert, Braun: Werte oberhalb der zulässigen Maximalen Arbeitsplatzkonzentration. Die rote Linie markiert den Grenzwert für die Luft auf der Straße

Aus Bild 6 geht hervor, dass Zigarettenrauch NO2-Gehalte aufweist, die weit über den üblichen Limits liegen und in einem Fall sogar deutlich über die maximale Arbeitsplatzkonzentration (MAK-Wert) von 950 µg/m3 hinausgehen.

Kochen – die Küche als NO2-Gaskammer

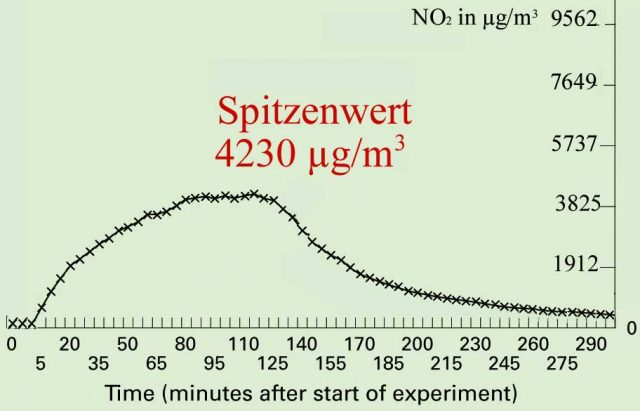

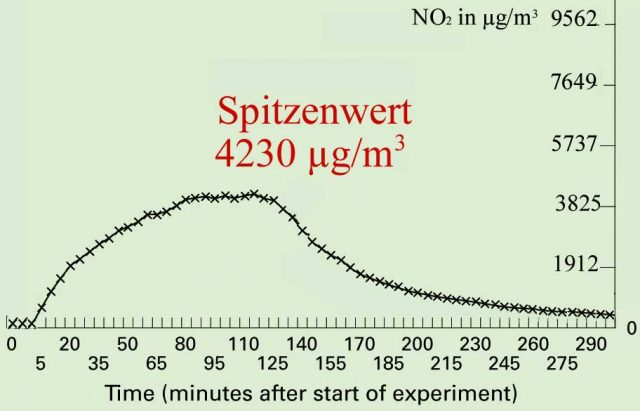

Als Top-Gefährder entpuppt sich bei solchen Untersuchungen allerdings ein Raum, an dem sich viele Menschen täglich bis zu einer Stunde oder noch länger aufhalten: Die Küche mit dem vielfach gerühmten heimischen Herd, vielfach sogar der Mittelpunkt des sozialen Geschehens im Haushalt. Vor allem dann, wenn dieser Herd mit Gas betrieben wird. Das ist in Deutschland zwar nicht allzu verbreitet, trifft jedoch in anderen westlichen Ländern wie z.B. Großbritannien oder den USA auf bis zu 50 % aller Haushalte zu. Jedem ist bewusst, dass ein Gasherd um ein Vielfaches mehr an Wärme erzeugt als eine Kerze. Dies betrifft natürlich auch den Ausstoß an Stickstoffdioxid. Hinzu kommt die Tatsache, dass eine solche Kochstelle je nach Art der Speisen und ihrer Zubereitung auch erhebliche Mengen Feinstaub mit z.T. hohem krebserzeugendem Potenzial in die Luft wirbelt. Hierzu gibt es eine ganze Reihe von Untersuchungen, wobei die Ergebnisse stark davon abhängen, ob und mit welcher Intensität eine Dunstabzugshaube zum Einsatz kommt. Da es Fälle gibt, wo eine Abzugshaube entweder nicht vorhanden ist oder nicht eingesetzt wird, wird hier eine entsprechende Untersuchung aufgeführt, Bild 7.

Bild 7. Langzeitverlauf der NO2-Konzentration in einer Küche, deren vierflammiger Gasherd für zwei Stunden auf volle Leistung gestellt wurde (Ursprung der modifizierten Grafik: [DENN])

Die Spitzenwerte, die bei diesen Tests gefunden wurden, sind erschreckend und liegen nach heutigen Maßstäben extrem hoch im gesundheitsgefährlichen Bereich. Im Versuch überschritt die Konzentration über Stunden mehr als das Hundertfache dessen, was nach Ansicht der betreffenden Ministerialbehörden den Grenzwert darstellt, ab dem es gerechtfertigt erscheint, wesentliche Teile der deutschen Industrie zum wirtschaftlichen Untergang zu verurteilen. Jeder Gewerbebetrieb, der seine Mitarbeiter solchen atmosphärischen Bedingungen aussetzen würde, müsste normalerweise mit sofortigen Maßnahmen der Gewerbeaufsicht rechnen. Wenn das UBA sowie das Umweltministerium tatsächlich auch nur einen Funken Interesse an der Gesundheit der Bevölkerung hätten, würde man auf der UBA-Webseite zum Thema Kochen nicht folgende Empfehlung finden: „Gas oder Strom? Kochen mit Gas ist energieeffizienter, denn die Stromerzeugung in Großkraftwerken ist mit hohen Umwandlungsverlusten verbunden. Die Umwandlungsverluste für Gas sind nur halb so hoch wie bei Strom. Auf der anderen Seite erfordert die offene Gasflamme auch häufigeres Lüften“ [UBAGA].

Allerdings verkneift sich das UBA jegliche Warnung vor dem ansonsten doch so erbittert bekämpften NO2. Es wird noch nicht einmal ein Hinweis gegeben, warum man denn „häufigeres Lüften“ empfiehlt. Eine klassische Selbstentlarvung einer Behörde, der es bei der Anti-Diesel-Kampagne offensichtlich nicht um vorgebliche Gesundheitsgefahren, sondern um den „Rückbau“ der verhassten freien Individualmobilität des Bürgers geht.

Die Realität in unseren Wohnungen

Das, was hier beispielhaft für drei häufig anzutreffende Emissionsquellen für Stickstoffdioxid aufgezeigt wurde, trifft natürlich auch für zahlreiche andere und ebenso alltägliche Einsatzfälle zu. Hierzu gehören beispielsweise brennstoffbetriebene Heizgeräte, insbesondere mobile Gas- oder Kerosinheizgeräte ohne Lüftungseinrichtung, wie sie vor allem in Wohnungen der ärmeren Bevölkerungsschichten selbst in Schlafzimmern oder zum Trocknen von Kleidung häufig zum Einsatz kommen. Es betrifft aber genauso auch gängige Events aller anderen Bevölkerungsschichten vom Dinner bei Kerzenschein über den Genuss von Fondue oder von Speisezubereitungen „auf dem heißen Stein“ bis hin zum Grillen, das gerade als Indoor-Variante groß in Mode zu kommen scheint. Das hat Konsequenzen: Während das UBA samt ihren Hetzhunden von der DUH und den Medien auf den Straßen den Verkehr mit der dicken Keule zur Räson bringen wollen, werden die Vorgänge im Privatleben offenbar völlig ausgeklammert. Dabei offenbart sich bei Untersuchungen in Wohnungen ein Stickoxid-Abgrund, der sehr gut und umfassend dokumentiert ist. Nachfolgend nur einige Stichproben.

In Großbritannien fand man bei der Untersuchung von Küchen mit Gasherd durchschnittliche NO2-Konzentrationen von 71 µg/m3, in zwei Wohnzimmern mit kerosinbetriebenen Heizgeräten Werte von 72 bzw. 92 µg/m3. In einem Schlafzimmer mit dem gleichen Heizsystem wurden sogar 126 µg/m3 gemessen [GBARM]. Bei der Besprechung der Befunde hoben die Autoren noch hervor, dass die Werte aufgrund des milden Winterwetters niedriger als erwartet ausfielen.

In den USA ist das Heizen mit sogenannten Kerosinheizern weit verbreitet. Erwähnt werden Verkaufszahlen von 10 Mio. Stück für das Jahr 1985. Bei einer Untersuchung in drei Haushalten, in denen solche Geräte genutzt wurden, fand man NO2-Konzentrationen bis zu 224 µg/m3 [INDO]. Auch die Weltgesundheitsorganisation WHO stellt fest, dass der weitverbreitete Einsatz von Heiz- und Kochgeräten ohne Abzug dazu führt, dass die NO2-Konzentrationen in Wohnungen fallweise recht erheblich über den Werten liegen, die im Freien gemessen werden. In solchen Wohnungen könne die mittlere NO2-Konzentration auch über mehrere Tage hinweg oberhalb von 200 μg/m3 liegen, auch wenn die Mittelwerte tiefer lägen. Beim Kochen könnten über Zeiträume von Minuten bis einer Stunde Konzentrationen zwischen 230 bis 2.055 μg/m3 auftreten, der höchste 15-Minuten-Wert erreichte 2.716 μg/m3 [WHO2].

Ungelöste Probleme in Innenräumen sieht auch der Wissenschaftler Brett Singer vom Lawrence Berkeley National Laboratory (LBNL). Allein in Kalifornien seien schätzungsweise zwölf Millionen Menschen überhöhten NO2-Expositionen ausgesetzt. Zwar behaupte das EPA, dass man in Kalifornien keine Probleme mit NO2 habe, weil die mittleren Konzentrationen im Freien deutlich unterhalb des nationalen Sicherheitsgrenzwerts von ca. 60 (Kalifornien) bis 100 mg/m3 (Rest USA) lägen. Das Problem gebe es dennoch, nur betreffe es eben die Innenraumwerte und nicht die im Freien. Wäre letzteres der Fall, würde das EPA sich an die Beseitigung machen. Für Innenräume gebe es dagegen keinerlei Vorschriften, die irgendjemanden zur Abhilfe verpflichten [COOK].

Restaurants und Bratereien: Gefahr beim Tête a Tête

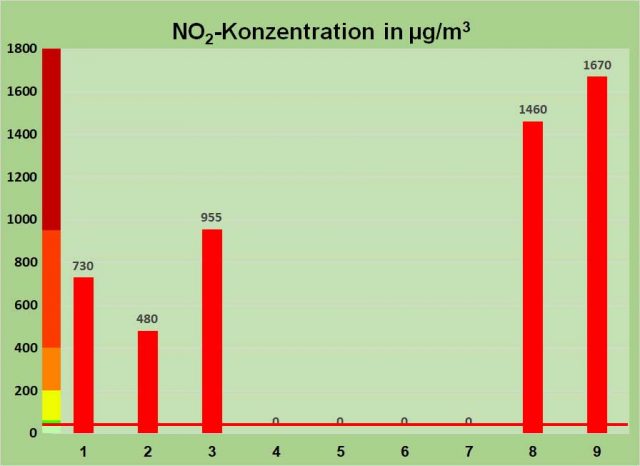

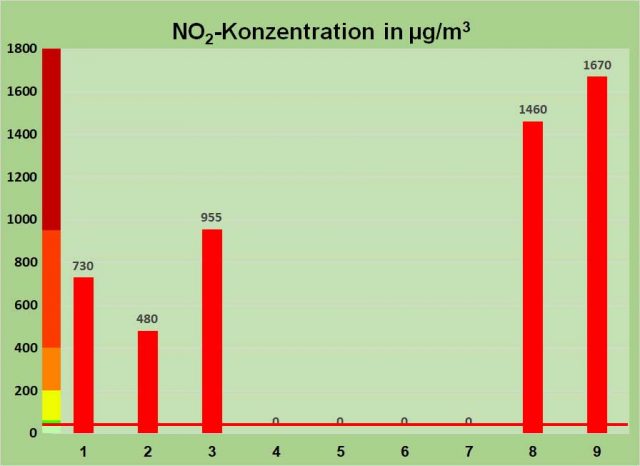

Besonders hohen NO2-Expositionen sind sowohl die Gäste als auch das Personal übrigens in Restaurants und Bratereien ausgesetzt, insbesondere dann, wenn die Zubereitung der Speisen im gleichen Raum erfolgt. Viele Gaststätten legen Wert auf romantische Atmosphäre, wozu fast stets Kerzenschein gehört, und das Warmhalten der Speisen erfolgt in zahlreichen Etablissements auf kerzenbeheizten Stövchen. Entsprechend hoch sind die Werte, die in solchen Räumen gemessen werden können, Bild 8.

Bild 8. In verschiedenen Restaurants gemessene NO2-Konzentrationen (Daten: [GROEM]). Hellgrün: Zulässiger Konzentrationsbereich auf der Straße, Dunkelgrün: Zulässig für Innenräume, Gelb: Bereich unterhalb des 1-Stunden-Grenzwerts für den Schutz der menschlichen Gesundheit, Orange: als gefährlich definierter Bereich zwischen 1-Stunden-Grenzwert und MAK-Wert, Rot: Bereich bis MAK-Wert, Braun: Werte oberhalb der zulässigen Maximalen Arbeitsplatzkonzentration. Die rote Linie markiert den Grenzwert für die Luft auf der Straße

Die Datenerhebungen zu Bild 8 erfolgten zu einer Zeit, als das heute nahezu flächendeckende Rauchverbot in Gaststätten noch nicht in Kraft war. Dennoch dürfte sich das Niveau auch heutzutage weit oberhalb des Innenraum-Grenzwerts von 60 µg/m3 bewegen. Dies gilt insbesondere für Lokalitäten, wo z.B. Speisen am Tisch flambiert werden oder wo WOK-Zubereitungen über der Gasflamme erfolgen. Noch schlimmer dürfte die Lage in den heute so beliebten Shisha-Lokalen sein, vom Shishagebrauch im privaten Umfeld gar nicht zu reden.

Aufforderung zum Handeln

Politik, Medien und NGO’s sind dabei, mit ihren Schreckensszenarien über Dieselabgase ein Fass aufzumachen, das sie besser geschlossen halten würden. Alles, was unsere Autos und Industrieprozesse an NO2-Exposition auf der Straße erzeugen, ist ein armseliger Klacks im Vergleich zu den hier aufgezeigten NO2-Quellen und vor allem zu den Konzentrationen, denen die Bevölkerung in Innenräumen über teils sehr lange Zeiträume ausgesetzt ist. Nähme man die Horrorgeschichten, welche DUH und deutsche Medien von ARD und ZDF über RBB und SWR bis hin zum Spiegel verbreiten, für bare Münze, so vollzöge sich in unseren Wohnungen und Gaststätten fast schon ein organisierter Völkermord. Schließlich muss man hierbei ja noch berücksichtigen, dass sich der Durchschnittsbürger eher selten und wenn, dann höchstens viertelstundenweise in stark mit NO2 beaufschlagten Straßenabschnitten aufhält, dagegen zu 90 % seiner Zeit in Innenräumen.

Angesichts der Millionen vom Staat durch willkürliche Festsetzung viel zu niedriger Emissionswerte geschädigter Dieselfahrer dürfte es nicht schwerfallen, einen schlagkräftigen Verein auf die Beine zu stellen, der sich einmal die Situation in Wohnungen und Gaststätten mit Messgeräten näher ansieht und als Gegenwehrmaßnahme die Wohnungswirtschaft (Vermieter) sowie das Gaststättengewerbe ebenso an die Wand fährt, wie man dies aktuell mit der Automobilindustrie und den Dieselbesitzern macht.

Bild 9. Künftig ein Grund, die Polizei wegen schwerer Körperverletzung zu rufen? Beim Grillen entstehen erhebliche Mengen NO2 und ziehen hochkonzentriert zu den Nachbarn, insbesondere die auf dem Balkon darüber. Das gilt auch für die geruchsärmeren Gasgrills

Ein künftiges Dorado für Anwälte

Einen interessanten juristischen Ansatzpunkt hierfür könnte man in der aktuellen Gesetzgebung zur Innenraumluft finden. Der aktuell geltende NO2-Grenzwert für die Innenraumluft von 60 µg/m3 ist ein sogenannter Richtwert II L, d.h. ein Langzeitrichtwert. Nach Definition ist dies „ein wirkungsbezogener Wert, der sich auf die gegenwärtigen toxikologischen und epidemiologischen Kenntnisse zur Wirkungsschwelle eines Stoffes unter Einführung von Unsicherheitsfaktoren stützt. Er stellt die Konzentration eines Stoffes dar, bei deren Erreichen beziehungsweise Überschreiten unverzüglich zu handeln ist. Diese höhere Konzentration kann, besonders für empfindliche Personen bei Daueraufenthalt in den Räumen, eine gesundheitliche Gefährdung sein….Aus Gründen der Vorsorge sollte auch im Konzentrationsbereich zwischen Richtwert I (den es aus praktischen Erwägungen beim NO2 nicht gibt) und Richtwert II gehandelt werden, sei es durch technische und bauliche Maßnahmen am Gebäude (handeln muss in diesem Fall der Gebäudebetreiber) oder durch verändertes Nutzerverhalten“ [AIR]. Diese Regelung liefert einen hervorragenden Ansatz für Juristen, um den Rest Deutschlands im Gegenzug auch noch lahmzulegen, sollte die Bundesregierung nicht imstande sein, gesetzliche Änderungen – vorzugsweise Anpassungen der NO2-Grenzwertvorgaben – auf den Weg zu bringen, welche die DUH endlich stoppen. Es muss endlich Schluss sein mit der unerträglichen Situation, dass eine unserer wichtigsten Schlüsselindustrien zerstört wird. Und das nur, weil politische Eitelkeiten der Revision einer Fehlentscheidung im Wege stehen, während man andere, nach den gleichen Maßstäben um ein Vielfaches gesundheitsschädlichere Emissionen einfach achselzuckend zur Kenntnis nimmt.

Stromsperren – ein Beinahe-Todesurteil?

Im gleichen Zusammenhang ist auch darauf hinzuweisen, dass die bisher übliche Praxis des „Abdrehens“ der Stromzufuhr bei Zahlungsrückständen aus humanitären Gründen nicht mehr hingenommen werden kann. Die Politik hat uns durch das EEG die zweithöchsten Strompreise in Europa beschert. Da immer mehr Familien aus einkommensschwachen Schichten ihre Stromrechnungen nicht mehr bezahlen können, kommt es jährlich zu rund 300.000 solcher Stromsperren, von denen teils ganze Familien samt Kindern und Kranken betroffen wurden. Ohne Strom haben diese Bewohner keine Heizung, kein Warmwasser und kein Licht mehr. Sie müssen daher zwangsweise auf Kerzen und (Flaschen)-Gas ausweichen. Zusätzlich versagen bei ihnen aufgrund der Stromsperre auch noch die eventuell vorhandenen Ablufteinrichtungen. Dies hat zwangsläufig extrem hohe NO2-Gehalte in der Atemluft zur Folge, vor allem in der kalten Jahreszeit. Man sollte diese Umstände aggressiv an Kirchen, Wohlfahrtsverbände und soziale wie karitative Organisationen herantragen und sie auffordern, schnellstmöglich Schritte einzuleiten, wie man diesen Personen helfen kann, ohne sie und ihre Kinder solch unerträglichen Lebensbedingungen auszusetzen. Die gleichen Überlegungen treffen auch auf Behelfs- und Flüchtlingsunterkünfte zu, wo sich die Bewohner in ihrer Not ebenfalls häufig mit gas- oder spiritusbetriebenen Heiz- und Kocheinrichtungen behelfen.

Fakten und „Faktenfinder“

Die hier dargelegten Probleme wurden bisher von den Medien ignoriert. Stattdessen hat man sich dort einen regelrechten Wettbewerb in der Frage geliefert, wer am tollsten auf den Dieselmotor und die Individualmobilität eindreschen konnte. Bisher hat man sich dort alles andere als kritisch-investigativ mit dem Thema NO2-Belastung des Bürgers beschäftigt. Stattdessen übernimmt man einfach die Positionen von Hendricks und dem UBA, als seien deren Ansichten der Weisheit letzter Schluss. Eine eigenständige kritische Wertung von Daten und Hintergründen ist nicht einmal in Ansätzen erkennbar. Dies bestätigt die bereits bisher gemachte Erfahrung, dass die Mehrzahl der Medien – allen voran die Fernsehanstalten ARD, ZDF und ihre Landesdependancen – beim sogenannten „Diesel-Skandal“ einseitig, parteiisch und irreführend berichtet. Statt um Ausgewogenheit und Sorgfalt bemüht man sich offenkundig eher darum, das Thema so darzustellen, wie bestimmte Bundesbehörden sowie die etablierten Parteien es gerne haben möchten. Abweichende Meinungen von Fachleuten, Medien, Journalisten oder Bloggern werden ignoriert. So leistet man dem ideologischen Ziel der Deindustrialisierung Deutschlands durch „Dekarbonisierung der Volkswirtschaft“ Vorschub. Der Diesel ist dabei nur das erste Opfer. Die Vernichtung der deutschen Automobilindustrie wird anschließend auch beim Benziner weitergehen, und zwar alternativlos. Die sich jetzt abzeichnende „GroKo“ – egal ob sie als echte oder als wilde (Duldungs-) Ehe zustande kommen sollte – ist für Deutschland ein sehr schlechtes Omen.

Fred F. Mueller

Demnächst folgt Teil 11

Quellen

[AIR] https://www.umweltbundesamt.de/themen/gesundheit/kommissionen-arbeitsgruppen/ausschuss-fuer-innenraumrichtwerte-vormals-ad-hoc#textpart-1

[BART] Bartolomei, et al, Combustion Processes as a Source of High Levels of Indoor Hydroxyl Radicals through the Photolysis of Nitrous Acid. Environ. Sci. Technol. 2015, 49, 6599−6607, DOI: 10.1021/acs.est.5b01905

[BELA] https://www.ncbi.nlm.nih.gov/pubmed/16254270?dopt=Citation

[BLFU] Bayerisches Landesamt für Umwelt: Untersuchung der räumlichen Verteilung der NOX-Belastung im Umfeld von vorhandenen, hochbelasteten Luftmessstationen. Abschlussbericht. September 2015.

[COOK] https://ehp.niehs.nih.gov/122-a154/

[DENN] Dennekamp et al, Ultrafine particles and nitrogen oxides generated by gas and electric cooking. Occup Environ Med 2001;58:511–516

[DIMI] Dimitroulopoulou C, Ashmore MR, Byrne MA, et al. Modelling of indoor exposure to nitrogen dioxide in the UK. Atmosphere and Environment 2001;35:269–79.

[FAKT] http://faktenfinder.tagesschau.de/inland/stickstoffdioxid-111.html

[FFMD8] http://ruhrkultour.de/diesel-lueckenmedien-im-glashaus-8/

[GBARM] http://www.sciencedirect.com/science/article/pii/095712729090023N

[GODI] Godish.: Indoor Environmental Quality

[GROEM] Grömping, H.-J.; Cammann, K.: Field evaluation and automation of a method for the simultaneous determination of nitrogen oxides, aldehydes and ketones in air. Journal of Automatic Chemistry, Vol. 18, No. 3 (May-June 1996), pp. 121-126

[HIST] Bundesgesundheitsbl. 1/98, Richtwerte für die Innenraumluft: Stickstoffdioxid, S. 9-12.

[INDO] http://enhs.umn.edu/current/5103/air/combustion.html

[JURUBA] https://www.umweltbundesamt.de/themen/gesundheit/kommissionen-arbeitsgruppen/ausschuss-fuer-innenraumrichtwerte-vormals-ad-hoc

[KERZ] http://www.segal.org/asthma/

[LOHS] https://eike.institute/2017/09/06/diesel-verteufelung-krieg-gegen-das-eigene-volk-diesel-wie-die-politik-das-volk-irrefuehrt/

[MESS] https://www.umweltbundesamt.de/sites/default/files/medien/358/dokumente/no2_2016.pdf

[NOPRO] Office of Air and Radiation (6301A) EPA-456/F-11-003 www.airnow.gov February 2011, updated June 23, 2016.

[PEHO] http://www.faz.net/aktuell/wissen/leben-gene/fakten-zur-dieseldebatte-wie-ungesund-sind-stickoxide-15138424-p3.html

[RAUCH] https://www.researchgate.net/publication/272911848

[RBBA] https://www.rbb24.de/politik/thema/2017/abgasalarm/beitraege/abgasalarm-Stickoxid-Werte-in-Berlin-flaechendeckend-zu-hoch.html#top

[UBAGA] https://www.umweltbundesamt.de/umwelttipps-fuer-den-alltag/elektrogeraete/herd-kochfelder#textpart-2

[WHO2] http://www.euro.who.int/__data/assets/pdf_file/0017/123083/AQG2ndEd_7_1nitrogendioxide.pdf

[ZDF] ZDF Heute – Sendung vom 2.9.2017, Sendeminuten 03:55 bis 04:11

[ZIGA] Shen Yi, et al, Measurement of NO2 in Cigarette Main Smoke by Differential Optical Absorption Spectroscopy. Acta Optica Sinica. 28. 1934-1937. 10.3788/AOS20082810.1934.