Das in der Vergangenheit vorgenommene vollmundige Versprechen, den CO2-Ausstoß in Deutschland als Vorbild für die Weltgemeinschaft drastisch zu vermindern, ist einer Ernüchterung gewichen. Die u.a. nun diskutierte Anhebung der erneuerbaren Energien auf 65% bereits bis 2030 auf Kosten der Kohle soll das Versprechen retten – kann es das?

Dieses Ansinnen fußt auf dem Glauben an den Weltuntergang durch einen überhöhten CO2-Gehalt in der Atmosphäre, auf vom IPCC ausgelösen Fake News. Zudem kann durch die „Deutsche Energiewende“ für den Bereich der Stromherstellung der CO2-Gehalt in der Atmosphäre von z.Z. 0,040% CO2 (400 ppm) nur um 0,000 013% CO2 (0,13 ppm) abgesenkt werden bei einem durch die Photosynthese verursachten Schwankungsbereich zwischen Sommer und Winter je nach örtlichem Bewuchs von bis zu 0,010% CO2 (100 ppm). Am Äquator liegt der Schwankungsbereich bei 0,0040% CO2 (40 ppm).

Das Wort des Jahres 2016 „postfaktisch“ – inzwischen gepaart mit Fake News und Fake-Wissenschaften – bestimmt weiter die politische Agenda.

——————————————————————-

- Die Phantasie der Deutschen für ständig neue Energiewenden ist ungebrochen

Es hat in Deutschland in den letzten Jahren – wie in keinem anderen Land – nicht an Maßnahmen zur Absenkung des CO2-Ausstoßes gefehlt:

– „Energiewende 2010“

– „Energiewende 2014“

– Eckpunkte für die geplante Novelle EEG in 2016

– „Klimaschutzplan 2050“ in 2016 (Dekarbonisierung neben der Stromerzeugung für alle Sektoren wie „Industrie und Gewerbe, Handel und Dienstleistungen“, „Gebäude“, „Verkehr“, „Landnutzung, Land- und Forstwirtschaft“).

– Koaltionsvertrag vom 14. März, 2018, mit neben dem „Klimaschutzplan 2050“ erweiterten Zielen wie die Anhebung der erneuerbaren Energien auf 65% bereits bis 2030 und damit einem vorgezogenen Kohleausstieg.

In der nun folgenden Diskussion soll ausschließlich die Dekarbonisierung im Bereich der Stromerzeugung betrachtet werden.

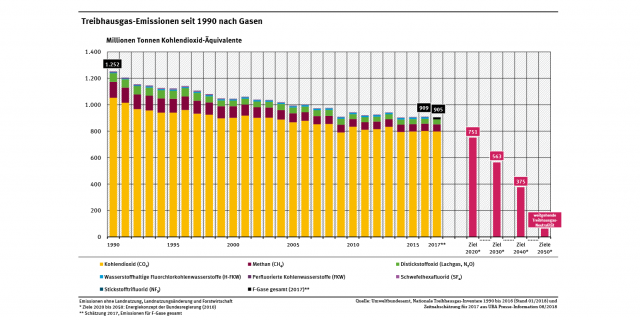

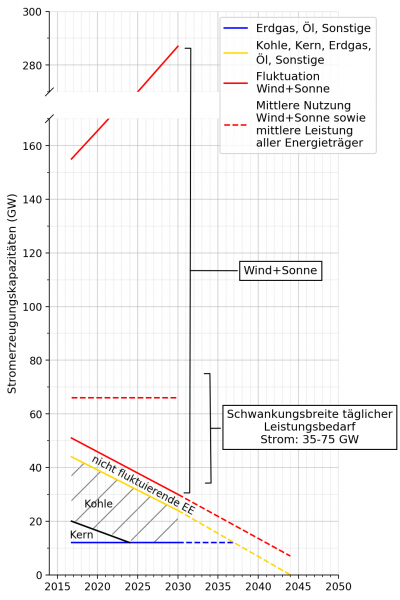

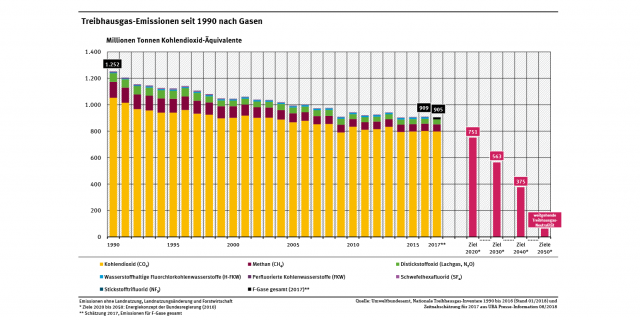

Da die „Klimaschutzziele“ hinsichtlich des CO2-Aussoßes in der Vergangenheit in Deutschland nicht zuletzt durch die Stilllegung der Kernkraftanlagen nicht eingehalten werden konnten (Bild 1), sollen nun über Wind, Sonne, Wasserkraft und Biomasse nicht mehr nur 50% sondern 65% des Strombedarfes bis 2030 gedeckt werden, in 2050 praktisch 100%.

Bild 1

Da die Kernkraft bis 2022 ausläuft, stellt sich die Frage bei der vorgesehenen Erhöhung des Stromanteiles über erneuerbare Energien auf 65% bis 2030 nach dem Ausmaß der Rücknahme des Kohleanteiles im Strommix.

Zu dieser Frage wurde bereits eine Kohlekommission gegründet, die ihre Tätigkeit bereits aufgenommen hat.

- Kohlekommission

Eine aus 42 Migliedern bestehende Mammutkommission soll nun den Ausstieg aus der Kohle vorbereiten, bestehend nicht zuletzt aus NGO´s wie z.B. Greenpeace, BUND, etc.

Die Marschrichtung dieser Kommission erinnert in ihrer Zusammensetzung und Vorgehensweise an die Ethikkommission in 2011 zum Ausstieg aus der Kernenergie, die aus geistlichen Würdeträgern und Geisteswissenschaftlern bestand.

Andere Länder wie z.B. China, Indien steigern die Kohlekraftwerkskapazitäten beträchtlich: in China kommen 280 Gigawatt hinzu, in Indien 174 GW. Insgesamt wird die Kohlekraftwerkskapazität weltweit um 43% erweitert.

Und Deutschland zerfleischt sich bei nur 22,6 GW Braunkohle und 14,4 GW Steinkohle im Strommix bis hin zu militanten Protesten (vgl. später).

- Quantifizierung des Strommixes bei Anhebung der erneuerbaren Energien auf 65% bis 2030 auf Kosten des Kohleanteiles

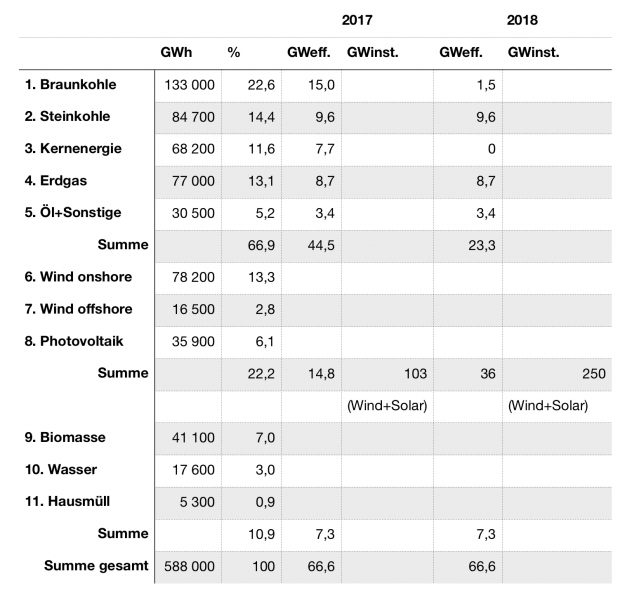

3.1 Auswirkung auf die Stromversorgungssicherheit und die Erfordernis von Stromspeichern

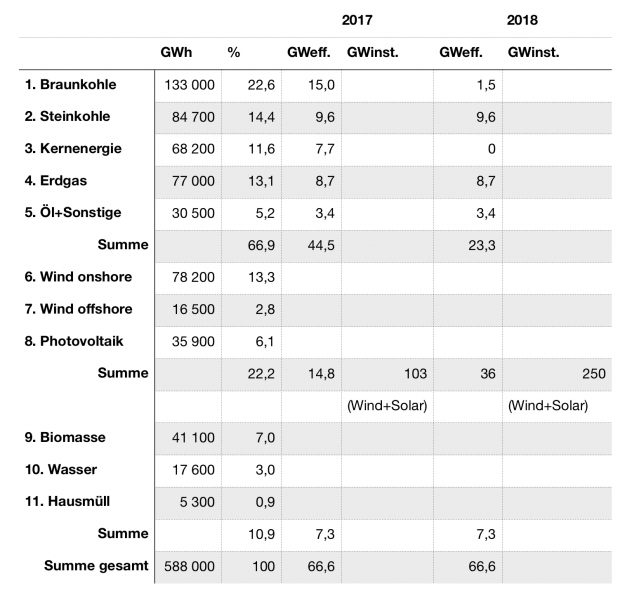

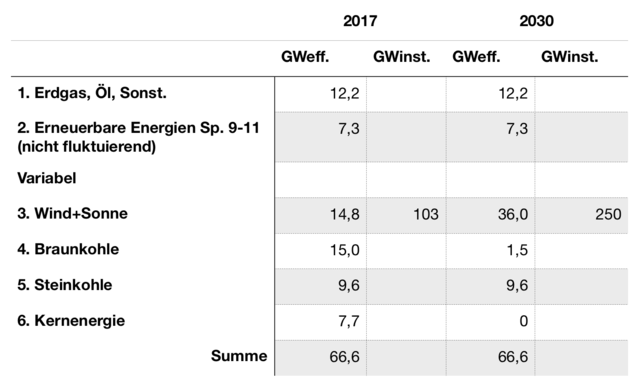

Deutschlands Strommix lag in 2017 wie im Folgenden beschrieben und soll 2030 auf einen Anteil an erneuerbaren Energien von 65% angehoben werden. In 2017 wurden insgesamt brutto 654 000 GWh erzeugt. (AGEB e.V.) Die Bruttoerzeugung schließt den Stromverbrauch der Kohlekraftwerke von etwa 10% mit ein. Da in den folgenden Betrachtungen der Anteil der Stromerzeugung über Kohle gegen null geht, wird im Folgenden der Nettostromverbrauch von 588 000 GWh in 2017 zugrunde gelegt.

Berechnung der Daten für 2030 siehe unten.

Regenerativ wurden in 2017 194 600 GWh oder 33,1% (Punkte 6-11), 393 400 GWh oder 66,9% über konventionelle Stromerzeuger (Punkte 1-5) erzeugt.

In den folgenden Betrachtungen werden die Punkte 5 bei der konventionellen Stromerzeugung sowie die Punkte 9-11 bei den Regenerativen als nicht variabel angenommen.

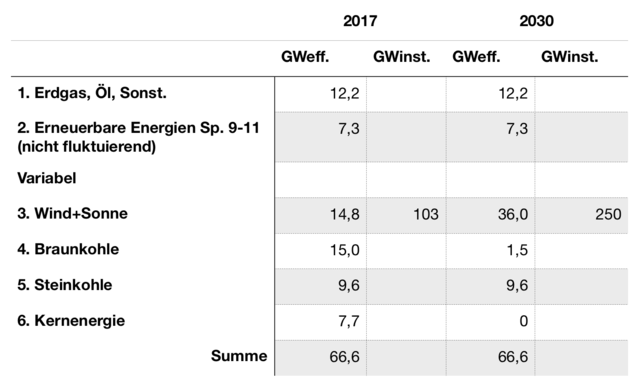

Davon ausgehend errechnen sich für 2030 bei einem Anteil von 65% erneuerbarer Energien bei gleichbleibenem Verhältnis von Wind- zu Sonnenstrom und einem mittleren Nutzungsgrad von Wind+Sonne von 14,4% (Durchschnittswert 2011-2016) (1) folgende Werte:

In dieser Übersicht gelten die Beziehungen

a) 7,3 GW Spalte 9-11 + X GW Wind+Sonne (2030) = 65%/100 x 66,6 GW

X = 36 GW Wind+Sonne (2030)

b) 36 GW Wind+Sonne (2030) – 14,8 GW Wind+Sonne (2017) = 21,2 GW,

die über Kern (7,7 GW) und BK (13,5 GW) ausgetauscht werden müssen.

15,0 GW BK (2017) – 13,5 GW BK = 1,5 GW BK (2030)

Um 65% erneuerbare Energien einsetzen zu können, muß dann die Stromerzeugung über Wind+Sonne von 14,8 auf 36 GW erhöht werden auf Kosten von 13,5 GW Braunkohle und den ausgelaufenden 7,7 GW über Kernenergie.

Das bedeutet für Wind+Sonne von 2017 bis 2030 eine Erhöhung der zu installierenden Leistung von 103 auf 250 GW. Die Stromerzeugung wird bis 2030 wie in 2017 angesetzt, auch wenn alleine über die vorgesehene Sektorkopplung von einer deutlichen Zunahme des Stromverbrauches ausgegangen werden muß, was die im Folgenden aufgezeigten Probleme noch deutlich verschärfen wird.

In 2030 müssen dann bei einer Einstellung von 65% erneuerbarer Energien im Mittel nur noch 1,5 GW über Braunkohle und 9.6 GW über Steinkohle beigestellt werden.

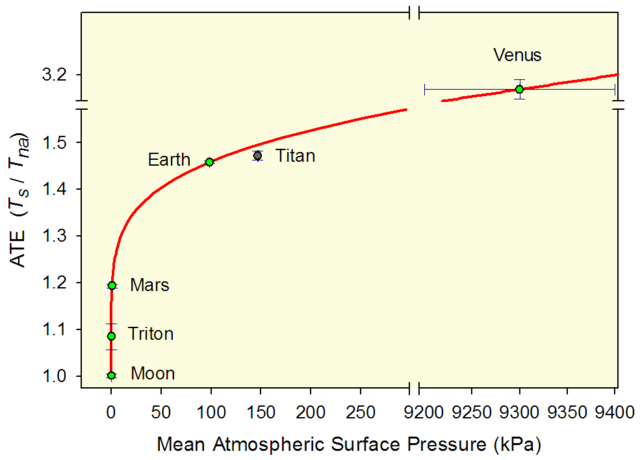

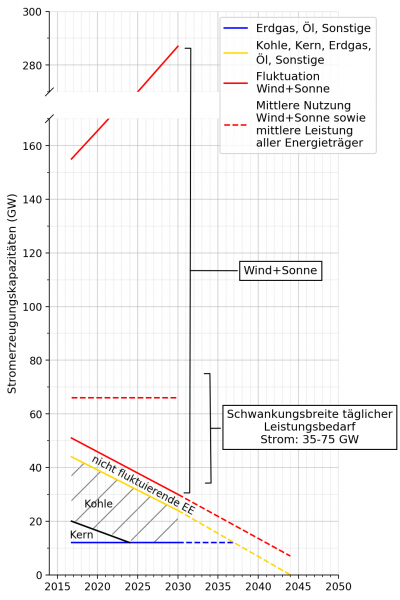

In Bild 2sind nun ausgehend von einer mittleren erforderlichen Stromleistung von 66,6 GW in 2017 bei gleichbleibender Stromleistung bis 2030 die Verteilung der Stromträger graphisch dargestellt.

Bild 2

Zunächst sind die konventionellen Stromträger Erdgas, Öl, Sonst. sowie die gemäß der erforderlichen Dekarbonisierung abnehmenden Erzeuger Kern und Kohle zugunsten des auf 65% zunehmenden Anteiles von Wind+Sonne sowie der nicht fluktuierenden erneuerbaren Energien aufgetragen.

Zudem ist der wesentliche Schwankungsbereich des täglichen Leistungsbedarfes von 35 bis 75 GW sichtbar gemacht. (1)

Die Linie der mittleren Nutzung von Wind+Sonne besagt (66,6 GW), dass der oberhalb dieser Linie anfallenden Strom gespeichert werden muß, um ihn bei Bedarf unterhalb der mittleren Nutzung von Wind+Sonne wieder einspeisen zu können.

Zur Speicherung der flatternden Strommengen ist eine Armada an Stromspeichern erforderlich, was einer kaum machbaren Logistik bedürfte – und neben anderen Argumenten die Stromversorgungssicherheit in Frage stellt.

Bei 66,6 GW in 2030 bzw. einer Gesamtstromerzeugung von 588 000 GWh/a bzw. 1610 GWh/Tag und einer nur auf Wind+Sonne bezogenen Leistung von 36 GW bzw. 317 800 GWh/a (871 GWh/Tag) müssen dann 871/2= 435 GWh/Tag (36/2=18 GW) im Mittel gespeichert werden können.

Das größte deutsche Pumpspeicherwerk Goldisthal hat eine Leistung von 8,4 GWh/Tag, d.h. es wären im Mittel täglich 52 Pumpspeicher dieser Größenordnung erforderlich.

Um eine 14-tägige Windflaute im Winter überbrücken zu können, müßten etwa

14 x 871 GWh/Tag = 12 194 GWh

mit etwa 1452 Speicher der Goldisthalgröße zur Verfügung stehen – ein hoffnungsloser Fall. Andere Stromspeicher (z.B. Power to Gas) sind für solche Strommengen weder geeignet noch bezahlbar. (2)

In 2017 kann die Differenz zwischen mittlerer Leistungsdeckung (66,6 GW) und einem Ausfall der Stromerzugung über Wind +Sonne von 14,8 GW noch soeben über Reservekraftwerke, Stromimporte, etc. abgedeckt werden – sicher nur bedingt im Winter -, in 2030 liegt diese Differenz bei 36 GW, wo nur noch die beschriebenen Stromspeicher helfen. Da die täglichen Leistungsanforderungen bis etwa 80 GW ansteigen können, müssen dann nach Gleichung a) 44,7 GW abgedeckt werden mit zu installierenden Wind-und Solaranlagen von 310 GW.

Ohne Stromspeicher kann nur in geringen Mengen Strom an Nachbarländer abgegeben werden, d.h. die Wind-und Solaranlagen müssen vermehrt still gesetzt werden, was in der Vergangenheit bereits stark zunehmend der Fall war. Die Nachbarländer schotten sich z.T. durch technische Maßnahmen ab oder freuen sich über den mit negativen Preisen abgeschobenen Strom, um damit ihre Wasserspeicher aufzufüllen, um uns anschließend diesen Strom wieder teuer zu verkaufen (z.B. Österreich).

Gleichzeitig muß ein Großteil des Stromes über riesige Stromleitungen von Nord nach Süd geschaufelt werden, die wiederum die gleiche Streubreite im Gepäck haben und im Mittel nur mäßige 14,4% Nutzungsgrad liefern können – bei reinem Windstrom in der Gegend von 20-30%.

Dafür werden dann erschreckend hohe Milliardenbeträge ausgegeben!

3.2 Betrachtung des Zeitraumes ohne jeden Kohleeinsatz

Bei der Beschreibung der auf Deutschland zukommeneden Schwierigkeiten bei einer Anhebung der erneuerbaren Energien auf 65% bis 2030 erübrigt sich eine Diskussion der zu erwartenden Probleme bei einer weiteren Anhebung der Erneuerbaren. Nur so viel:

Aus Bild 2läßt sich leicht abgreifen, in welchem Jahr unter Beibehaltung der Geschwindigkeit der Anhebung der erneuerbaren Energien bei gleichbleibendem Anteil Erdgas, Öl, Sonst. keine Kohle mehr eingesetzt werden kann: bereits im Jahre 2037.

Die dann erforderliche Installation von Wind+Solaranlagen läge dann bei:

66,6 GW – 12,2 GW (Erdgas, Öl, Sonst.) – 7,3 GW (nicht fluktierende EE) / 0,144 = 327 GW. (Für eine Leistungsanforderung von 80 GW errechnen sich zu installierende Wind-und Solaranlagen von 420 GW).

Werden auch noch die letzten Kohlenstoffträger Erdgas, Öl, Sonst. gegen die Erneuerbaren ausgetauscht, wäre theoretisch in 2044 eine Stromerzeugung von 100% über erneuerbare Energien möglich mit einer Installation von Wind-+Solaranlagen von:

66,6 GW – 7,3 GW „Nicht fluktuierende EE“ /0,144 = 412 GW (für eine Leistungsanforderung von 80 GW ergeben sich dann 505 GW),

wo auch immer diese erforderliche Fläche freigeschaufelt werden könnte.

3.3 Netzkapazität

Durch das volatile Verhalten der Stromerzeuger Wind+Sonne muß die Netzkapazität von etwa 80 GW beträchlich erweitert werden, mit welchen Kosten auch immer (vgl. Bild 2).

- Die CO2-Apokalypse

„Postfaktisch“ war das Wort des Jahres 2016: Fakten, die nicht zum eigenen Glauben passen, werden ignoriert oder für falsch erklärt. Der Begriff der „Fake News“ wurde gleichzeitig gegenwärtig und schließlich kamen die „Fake-Wissenschaften“ in jüngster Zeit ins Gerede, ohne wissenschaftliche „Peer Reviews“ geprüfte Veröffentlichungen, die in „Fake Journalen“ (England: „Predatory Journals“) veröffentlicht werden. Weltweit, auch in Deutschland, haben Tausende Wissenschaftler in solchen scheinwissenschaftlichen Journalen gegen Bezahlung publiziert, z.T. reinen Schrott (FAZ, 20.07.2018).

Das gilt auch für Fragen der „Globalen Erwärmung“. (3) Auch die IPCC-Berichte sind nicht unabhängig begutachtet, wie es für wissenschaftliche Publikationen verbindlich ist (4).

Teile der IPCC-Berichte waren sogar von NGO-Aktivisten verfaßt worden, die über keinen ausreichenden Fachhintergrund verfügten, (5) ganz zu schweigen von der mangels Begutachtung fehlender Wissenschaftlichkeit und Vertrauenswürdigkeit des Vorhabens „Deutsche Energiewende“.

Kürzlich gab es einen weiteren Aufschrei über das Unwesen der „Predatory Journals“. Nach Recherchen der „Die kalte Sonne“ (6) reichte Schellnhuber (PIK, Potsdam) 16 Veröffentlichungen bei der Zeitschrift der National Academy of Science (PNAS), einem Predatory-Verlag (?), ein (wo Schellnhuber auch Mitglied ist) und suchte seine Gutachter selbst aus.

Aber nun zur Geschichte der „CO2-Apokalypse“:

Am Beginn der „CO2-Hysterie“ stand der „Klimarat der Vereinten Nationen“, der „Intergovernmental Panel on Climate Change“ (IPCC) vor 30 Jahren, dessen Aussagen gewaltige Spuren hinterlassen haben. Was muß man vom IPCC wissen?

1. Aufgabe des IPCC: Zusammenfassung der Ergebnisse von Hunderten von Wissenschaflern aus verschiedenen Disziplinen zu gemeinsamen Berichten, ausschließlich zum anthropogenen Klimawandel.

2. Struktur des IPCC: IPCC-Funktionäre, also die Vertreter der Nationalstaaten, wählen die Wissenschaftler aus. Bei der Endformulierung der Berichte dominieren die IPCC-Funktionäre, nicht die Wissenschafler.

Das heißt: Das IPCC ist ein politisches Gremium, kein wissenschafliches.

So wurden im Rahmen des IPCC schon früh unwissenschaftliche Modelle zum Einfluß von CO2 auf das Klima entwickelt (ausschließlich anthropogenes CO2 versteht sich), die die Vergangenheit nicht nachvollziehen konnten, wohl aber dazu mißbraucht wurden, die Zukunft aber in Form von Untergangsszenarien (Weltuntergang durch Verglühen) zu beschreiben. Das hatte durch die damit erzeugte Angst zur Folge, dass ungeheuere Geldmengen von den verschiedenen Regierungen den „Wissenschaflern“ zur Verfügung gestellt wurden, um die Welt vor ihrem Menschen-gemachten Untergang durch das anthropogene CO2 zu retten. Die Folge war eine weltweite Errichtung von Forschungsinstituten mit Milliarden von Euros/Dollar zur Untersuchung des vom Menschen verursachten CO2 auf das Klima.

Die Ergebnisse der vielen Forschungsinstitute entsprachen selbstredend – naturgemäß zum Selbsterhalt der Forschungsinstitute – der Aufgabenstellung des IPCC: nämlich die unsinnige Ausarbeitung der lebensbedrohenden Wirkung der Menschheit durch den ausschließlich anthropogenen CO2-Ausstoß.

Eine nähere kritische Betrachtung zu den Vorstellungen des IPCC und seiner Modelle führt nämlich schnell zu dem Ergebnis, dass sich diese Modelle erwartungsgemäß durch eine Reihe von Fehlern hervortun, so dass ihre Mitteilungen an die Welt schlicht als Fake News einzuordnen sind:

1. Die Treibhauswirkung von H2O, dem Gas mit der höchsten Treibhauswirkung (H20 36-70%, CO2 9-26%), wurden nicht eingebaut.

2. Das Gleiche gilt für den Einfluß der Wolken. Die Wolkenbildung ist bei einem mittleren Bedeckungsgrad von 50-60% immerhin für 50% der Strahlung verantwortlich.

3. Basierend u.a. auf einer nicht korrekten Anwendung des Planckschen Strahlungsgesetzes/Stefan-Boltzmann-Gesetzes (Mißachtung des Gleichgewichtszustandes) wurde dem Gas CO2 ein überhöhter Treibhauseffekt zugesprochen, der die Temperatur der Erde von -18° C ohne Atmosphäre auf +15°C anheben soll.

4. Bei einem CO2-Gehalt in der Atmosphäre von 0,040% (400 ppm) werden jedoch nur etwa 3% vom Menschen verursacht, was weltweit 0,0012% CO2 (12 ppm) in der Atmosphäre ausmacht.

Der vom Menschen verursachten CO2-Mengen werden teilweise durch die übrigen, weit stärkeren Stoffströme (Ozeane, Photosynthese, etc.) wieder aufgenommen.

Im Sinne des Treibhauseffektes a la IPCC sollen diese marginalen Spuren, 0,0012% CO2, in der Lage sein, 324 W/m2 aus der Atmosphäre zurück zur Erde zu bewegen: ein wärmebilanzmäßiges und thermodynamisches Wunderwerk (u.a. 2. Hauptsatz der Thermodynamik). Einwände gegen diesen Unsinn werden in dem grün-linken Milieu in Deutschland hypermoralisch in die rechte Ecke gestellt.

Der Anteil Deutschlands an diesen 3% weltweit liegt bei 2,7% entsprechend 0,000 032% CO2 (0,32 ppm) in der Atmosphäre, nicht mehr meßbar.

Der Gedanke in Deutschland, mit dem Abbau von 0,000 032% CO2 einen wesentlichen Beitrag zum Treibhauseffekt beisteuern zu können, ist geradezu absurd, zumal wenn man bedenkt, dass durch den „Klimaschutzplan 2050“ bezogen auf die Stromerzeugung (verantwortlich für etwa 50% des CO2-Ausstoßes) der mögliche CO2-Abbau gerade bei 0.000 013% (0,13 ppm) läge. (1)

Dennoch verschleißt sich Deutschland mit dem „Klimaschutzplan 2050“, dem Abbau des CO2-Ausstoßes in allen Sektoren wie Strom, Verkehr, Industrie, etc., gegen null, um das nicht mehr Meßbare abzusenken, u.a. durch den geplanten Ausstieg aus der Kohle.

5. Der CO2-Gehalt in der Atmosphäre schwankt durch die Photosynthese zwischen Sommer und Winter je nach örtlichem Bewuchs bis zu 0,010% (100 ppm). Am Äquator liegt der Schwankungsbereich bei 0,0040% (40 ppm). (1) Damit liegt der vom Menschen verursachte CO2-Ausstoß mit 0,0012% (12 ppm) weit unter der jährlichen Schwankungsbreite, ohne auf die von Deutschland zu verantwortenden 0,000 032% (0,32 ppm) eingehen zu wollen.

6. In den Berechnungen des IPCC zum Treibhauseffekt durch CO2 wird von einem Strahlungsgleichgewicht zwischen Sonnenstrahlung und der Abstahlung der Erde/Atmosphäre ausgegangen, obwohl das System Erde/Atmosphäre zum Weltraum hin offen ist, d.h. der Energieerhaltungssatz ist nicht anwendbar.

7. Schließlich wurden in die IPCC-Modelle überhöhte Klimasensitivitäten eingebaut.

8. Zusammenfassend bleibt fetzuhalten, dass es keinen Beweis für den Einfluß von CO2 auf das Klima gibt, die IPCC-Modelle sind völlig wertlos. Sicher ist nur, dass eine Erhöhung der Temperatur des Meerwassers zu einer Freisetzung des CO2 führt (Löslichkeit von CO2 in Wasser), so dass die CO2-Gehalte der Atmosphäre ansteigen (vgl. Untersuchungen an Eisbohrkernen aus Kalt- und Warmzeiten).

Für die nicht meßbaren CO2-Absenkungen in der Atmosphäre durch die deutschen Energiewenden zahlt Deutschland in Form des EEG z.Z. etwa 25 Mrd. €/a. Das „Institut für Wettbewerbsökonomik“ an der Uni Düsseldorf schätzt die zwischen 2015 bis 2025 anfallenden Kosten auf 520 Mrd. € (7), die „Wissenschaftsakademien Leopoldina, Acatech und Union“ bis 2050 auf 2 000 Mrd. €. (8)

Schließlich sei noch angemerkt, dass sich das Klima der Erde in einem ständigen Wandel befindet, ein Einfluß von CO2 auf das Klima kann in der Erdgeschichte nicht nachgewiesen werden – die Erde hat um Potenzen höhere CO2-Gehalte bestens verkraftet.

Außerdem verdanken wir der Anwesenheit von CO2 in der Atmosphäre unser Leben durch die Photosynthese

6 CO2 + 6 H2O = C6H12O16 + 6 O2 ,

also sogar den Sauerstoff.

Trotz all dieser Argumente leben von diesem „politogenen“ Gas CO2 (Kirstein) weltweit ganze Heerscharen von Medienleuten, Politikern, Klimawissenschaftlern, etc. prächtig.

Da ist es schon verwunderlich, wenn unsere Kanzlerin nach dem Atomausstieg nun im Sinne einer Rechtfertigung der Energiewenden Aussagen vernehmen läßt wie: „Nicht jeder Generation ist es gegeben, solche technische Umbrüche zu erleben und dabei zu sein, ist schön“.

- Politik und Medien

Ungeachtet aller Fakten werden ungebremst immer höhere Anforderungen an die Absenkung des CO2-Ausstoßes gestellt – im Sinne des „Klimaschutzplanes 2050“ für alle Sektoren (nicht zuletzt auch durch die neuesten unmäßigen Forderungen der EU an den CO2-Ausstoß von Verbrennungsmotoren).

Trotz der Aussage vieler Sachverständiger bleibt die Regierung völlig ungerührt. Eine deutliche Interessenverfilzung der Akteure der Energiewende (Klimapolitiker, einschlägige Industrie , Landwirte, etc.) ist erkennbar zu Lasten der Allgemeinheit.

Eine wünschenswerte Medienlandschaft mit kritischem investikativem Journalismus gibt es nicht, stattdessen ein im Gleichklang im Sinne einer „political correctness“ mit den Regierenden verbandeltes Staatsfernsehen. In den vielen auf rudimentären Kenntnissen zu Klimafragen agierenden Talkshows werden Klimarealisten nicht zugelassen.

So entstand im Gleichklang zwischen Regierenden und den Medien im Mainstream ein „postfaktisches Gebilde“, genannt Energiewende, basierend auf den Fake News des IPCC zum Einfluß von CO2 auf das Klima, auf das sich auch die Universitäten meist haben einlassen müssen, um nicht von geldlichen Zuwendungen abgeschnitten zu werden.

Wie die Vergangenheit zeigt, jagen die meisten Medien ein Thema nach dem anderen vor sich her. Es geht um Einschaltquoten/Auflagen nach dem Motto: „Only bad news are good news“.

So wetteiferten z.B. im Jahre 1975 die Medien, als die Globaltemperaturen seit 1940 leicht abgefallen waren, mit Warnungen vor der nächsten Eiszeit mit Eisbergen vor Portugal – später kam das Waldsterben, Vogelgrippe, etc.

Es stellt sich die Frage, weshalb der intelligendere Teil der Gesellschaft nicht gegen das Treiben dieser Medien gerade in den essentiellen Klimafragen und dem daraus resultierenden Unternehmen Energiewende angehen kann. Ist es die „German Angst“ oder sind wir inzwischen vergleichbar geworden mit den USA, wo ihr President vermerkte: „We won with poorly educated, I love the poorly educated“.

So erstarren wir über 30 Jahre auf der Suche nach Möglichkeiten, unseren wertvollen „Atommüll“ zu vergraben, während andere Länder 51 Kernkraftwerke im Bau haben und in schnellen Brütern die Energie aus dem wertvollen „Atommüll“ wieder nutzbar machen.

Die Angst vor CO2 durch ein mögliches Verglühen der Erde sowie den Meeresspiegelanstieg ist inzwischen bei vielen zu einer religiösen Vorstellung geworden. So wie das Christentum die Menschen über 2000 Jahren durch die Angst vor dem Höllenfeuer steuerte, ist es nun die Angst vor dem Verglühen der Erde durch CO2.

Gegen Emotionen haben Fakten nur schwer eine Chance. Wie sagte noch der Philosoph Luhmann: „Wer Angst hat, ist moralisch im Recht“.

„Denk ich an Deutschland in der Nacht…..“.

Quellen

- Beppler, E.: „Die Vorstellungen der Regierung/Parteien zur Absenkung des CO2-Ausstoßes im Lichte einer technischen Analyse“; EIKE, 27.12.2017

2. Beppler, E.: „Energiebranche jetzt für Kohleausstieg bis 2030- aber wo bleiben die Stromspeicher?“; EIKE, 02.07.2018

3. Watts, A.: „Da schau her: „Deckel abgesprengt vom Topf der Vertrauenswürdigkeit wissenschaftlicher Begutachter“; EIKE, 23 07.2018

4. Lüdecke, H.-J.: „Kleine Inspektion der Klimadampfer“; EIKE, 13.08.2018

5. Buch Laframboise, D.: „Von einem Jugendstraftäter, der mit dem besten Klimaexperten der Welt verwechselt wurde“

6. „Die kalte Sonne“: „PNAS ein „Predator“-Verlag? Ex- PIK Chef Schellnhuber reicht 16 papers ein und sucht seine Gutachter selber aus“; EIKE, 13.08.2018

7. Limburg, M.: Mitteilung EIKE vom 10.10.2016

8. Studien der Wissenschaftsakademien Leopoldina, Acatech und Union; FAZ, 15.11.2017